php 网页内容抓取

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 38 次浏览 • 2022-05-21 22:07

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

php 网页内容抓取 PHP之伪静态与真静态

网站优化 • 优采云 发表了文章 • 0 个评论 • 59 次浏览 • 2022-05-12 13:24

首先,什么是伪静态:

伪静态又名URL重写,是动态的网址看起来像静态的网址。换句话说就是,动态网页通过重写 URL 方法实现去掉动态网页的参数,但在实际的网页目录中并没有必要实现存在重写的页面。

另外在补充两个名词解析

静态网址:纯静态HTML文档,能使用filetype:htm 查询到的网页

动态网址:内容存于数据库中,根据要求显示内容,URL中以 ? # & 显示不同的参数,如:news.php?lang=cn&class=1&id=2

动态、静态、伪静态之间的利与弊(新)

动态网址

首先,动态网址目前对于Google来说,“不能被抓取”的说法是错误的,Google能够很好的处理动态网址并顺利抓取;其次“参数不能超过3个”的说法也不正确,Google能够抓取参数超过3个的动态网址,不过,为了避免URL太长应尽量减少参数。

其次,动态网址有其一定的优势,以上面所说的 news.php?lang=cn&class=1&id=2 为例,网址中的参数准确的告诉Google,此URL内容语言为cn、隶属于分类1、内容ID为2,更便于Google对内容的识别处理。

最后,动态网址应尽量精简,特别是会话标识(sid)和查询(query)参数,容易造成大量相同页面。

静态网址

首先,静态网址具有的绝对优势是其明晰,/product/nokia/n95.html和/about.html可以很容易被理解,从而在搜索结果中可能点击量相对较高。

其次,静态网址未必就是最好的网址形式,上述动态网址中说到,动态网址能够告诉Google一些可以识别的参数,而静态网址如果文档布置不够恰当(如:过于扁平化,将HTML文档全放在根目录下)及其他因素,反而不如静态网址为Google提供的参考信息丰富。

最后,樂思蜀觉得Google此文中是否有其隐藏含义?“更新此种类型网址的页面会比较耗费时间,尤其是当信息量增长很快时,因为每一个单独的页面都必须更改编译代码。”虽然所说的是网站,但在Google系统中是否同样存在这样的问题呢?

伪静态网址

首先,伪静态网址不能让动态网址“静态化”,伪静态仅仅是对动态网址的一个重写,Google不会认为伪静态就是HTML文档。

其次,伪静态可取,但应把重心放在去除冗余参数、规范URL、尽可能的避免重复页上。

最后,伪静态有很大潜大危险,最好在对网站系统、网站结构、内容分布、参数意义熟悉的情况下使用。

在写伪静态规则时,应保留有价值的参数,不要将有价值的参数全部精简掉,如前面例子中的 news.php?lang=cn&class=1&id=2 最好重写为 news-cn-class1-id2.html,而不是过份精简重写为 news-2.html。

再就是伪静态中一定不能包含会话标识(sid)和查询(query)参数,/product.asp?sid=98971298178906&id=1234 这样的动态网址,其中的sid本来Google能够识别并屏蔽,但如果重写为 /product/98971298178906/1234,Google不但无法识别,还在整站中造成无限重复页面(每个会话都会产生一个新的会话ID)。

我们应该选择伪静态还是真静态

1、使用真静态和假静态对SEO来说没有什么区别

2、使用真静态可能将导致硬盘损坏并将影响论坛性能

3、使用伪静态将占用一定量的CPU占有率,大量使用将导致CPU超负荷

4、最重要的一点,我们要静态是为了SEO

所以:

1、使用真静态的方法可以直接排除了,因为无论怎么生成,对硬盘来说都是很伤的。

2、既然真伪静态的效果一样,我们就可以选择伪静态了。

3、但是伪静态大量使用会造成CPU超负荷。

4、所以我们只要不大量使用就可以了。

5、既然静态只是给SEO看的,我们只需要伪静态给SEO就行了,不需要给用户使用。

6、所以我们只要在专门提供给SEO爬的Archiver中使用伪静态就可以了。

7、谢谢大家耐心看我写的文章。

8、有何不解的地方或是有不同的看法欢迎提出 查看全部

php 网页内容抓取 PHP之伪静态与真静态

首先,什么是伪静态:

伪静态又名URL重写,是动态的网址看起来像静态的网址。换句话说就是,动态网页通过重写 URL 方法实现去掉动态网页的参数,但在实际的网页目录中并没有必要实现存在重写的页面。

另外在补充两个名词解析

静态网址:纯静态HTML文档,能使用filetype:htm 查询到的网页

动态网址:内容存于数据库中,根据要求显示内容,URL中以 ? # & 显示不同的参数,如:news.php?lang=cn&class=1&id=2

动态、静态、伪静态之间的利与弊(新)

动态网址

首先,动态网址目前对于Google来说,“不能被抓取”的说法是错误的,Google能够很好的处理动态网址并顺利抓取;其次“参数不能超过3个”的说法也不正确,Google能够抓取参数超过3个的动态网址,不过,为了避免URL太长应尽量减少参数。

其次,动态网址有其一定的优势,以上面所说的 news.php?lang=cn&class=1&id=2 为例,网址中的参数准确的告诉Google,此URL内容语言为cn、隶属于分类1、内容ID为2,更便于Google对内容的识别处理。

最后,动态网址应尽量精简,特别是会话标识(sid)和查询(query)参数,容易造成大量相同页面。

静态网址

首先,静态网址具有的绝对优势是其明晰,/product/nokia/n95.html和/about.html可以很容易被理解,从而在搜索结果中可能点击量相对较高。

其次,静态网址未必就是最好的网址形式,上述动态网址中说到,动态网址能够告诉Google一些可以识别的参数,而静态网址如果文档布置不够恰当(如:过于扁平化,将HTML文档全放在根目录下)及其他因素,反而不如静态网址为Google提供的参考信息丰富。

最后,樂思蜀觉得Google此文中是否有其隐藏含义?“更新此种类型网址的页面会比较耗费时间,尤其是当信息量增长很快时,因为每一个单独的页面都必须更改编译代码。”虽然所说的是网站,但在Google系统中是否同样存在这样的问题呢?

伪静态网址

首先,伪静态网址不能让动态网址“静态化”,伪静态仅仅是对动态网址的一个重写,Google不会认为伪静态就是HTML文档。

其次,伪静态可取,但应把重心放在去除冗余参数、规范URL、尽可能的避免重复页上。

最后,伪静态有很大潜大危险,最好在对网站系统、网站结构、内容分布、参数意义熟悉的情况下使用。

在写伪静态规则时,应保留有价值的参数,不要将有价值的参数全部精简掉,如前面例子中的 news.php?lang=cn&class=1&id=2 最好重写为 news-cn-class1-id2.html,而不是过份精简重写为 news-2.html。

再就是伪静态中一定不能包含会话标识(sid)和查询(query)参数,/product.asp?sid=98971298178906&id=1234 这样的动态网址,其中的sid本来Google能够识别并屏蔽,但如果重写为 /product/98971298178906/1234,Google不但无法识别,还在整站中造成无限重复页面(每个会话都会产生一个新的会话ID)。

我们应该选择伪静态还是真静态

1、使用真静态和假静态对SEO来说没有什么区别

2、使用真静态可能将导致硬盘损坏并将影响论坛性能

3、使用伪静态将占用一定量的CPU占有率,大量使用将导致CPU超负荷

4、最重要的一点,我们要静态是为了SEO

所以:

1、使用真静态的方法可以直接排除了,因为无论怎么生成,对硬盘来说都是很伤的。

2、既然真伪静态的效果一样,我们就可以选择伪静态了。

3、但是伪静态大量使用会造成CPU超负荷。

4、所以我们只要不大量使用就可以了。

5、既然静态只是给SEO看的,我们只需要伪静态给SEO就行了,不需要给用户使用。

6、所以我们只要在专门提供给SEO爬的Archiver中使用伪静态就可以了。

7、谢谢大家耐心看我写的文章。

8、有何不解的地方或是有不同的看法欢迎提出

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-05-12 13:21

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-05-09 04:05

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

[精选] 模拟登陆并抓取数据,用php也是可以做到的

网站优化 • 优采云 发表了文章 • 0 个评论 • 40 次浏览 • 2022-05-05 15:13

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。 查看全部

[精选] 模拟登陆并抓取数据,用php也是可以做到的

点击加入:

商务合作请加微信(QQ):2230304070

精选文章正文

服务器活动推荐:【腾讯云12月份服务器限时秒杀活动,最低99元】活动地址:

使用PHP的Curl扩展库可以模拟实现登录,并抓取一些需要用户账号登录以后才能查看的数据。具体实现的流程如下

1. 首先需要对相应的登录页面的html源代码进行分析,获得一些必要的信息:

1)登录页面的地址;

2)验证码的地址;

3)登录表单需要提交的各个字段的名称和提交方式;

4)登录表单提交的地址;

5)另外要需要知道要抓取的数据所在的地址。

2. 获取cookie并存储(针对使用cookie文件的网站)

$login_url = 'http://www.xxxxx'; //登录页面地址<br />$cookie_file = dirname(__FILE__)."/pic.cookie"; //cookie文件存放位置(自定义)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $login_url);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_COOKIEJAR, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

3. 获取验证码并存储(针对使用验证码的网站)

$verify_url = "http://www.xxxx"; //验证码地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $verify_url);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);<br />$verify_img = curl_exec($ch);<br />curl_close($ch);<br />$fp = fopen("./verify/verifyCode.png",'w'); //把抓取到的图片文件写入本地图片文件保存<br />fwrite($fp, $verify_img);<br />fclose($fp);<br />

说明:

由于不能实现验证码的识别,所以我这里的做法是,把验证码图片抓取下来存放到本地文件中,然后在自己项目中的html页面中显示,让用户去填写,等用户填写完账号、密码和验证码,并点击提交按钮之后再去进行下一步的操作。

4. 模拟提交登录表单:

$ post_url = 'http://www.xxxx'; //登录表单提交地址<br />$post = "username=$account&password=$password&seccodeverify=$verifyCode";//表单提交的数据(根据表单字段名和用户输入决定)<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $ post_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,1);<br />curl_setopt($ch, CURLOPT_POSTFIELDS, $post); //提交方式为post<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />curl_exec($ch);<br />curl_close($ch);<br />

5. 抓取数据:

$data_url = "http://www.xxxx"; //数据所在地址<br />$ch = curl_init();<br />curl_setopt($ch, CURLOPT_URL, $data_url);<br />curl_setopt($ch, CURLOPT_HEADER, false);<br />curl_setopt($ch, CURLOPT_HEADER, 0);<br />curl_setopt($ch, CURLOPT_RETURNTRANSFER,0);<br />curl_setopt($ch, CURLOPT_COOKIEFILE, $cookie_file);<br />$data = curl_exec($ch);<br />curl_close($ch);<br />

到目前为止,已经把数据所在地址的这个页面都抓取下来存储在字符串变量$data中了。

需要注意的是抓取下来的是一个网页的html源代码,也就是说这个字符串中不仅包含了你想要的数据,还包含了许多的html标签等你不想要的东西。所以如果你想要从中提取出你需要的数据的话,你还要对存放数据的页面的html代码进行分析,然后结合字符串操作函数、正则匹配等方法从中提取出你想要的数据。

php 网页内容抓取(PHP程序Pocket抓取知乎专栏的问题(一)_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-04-18 13:15

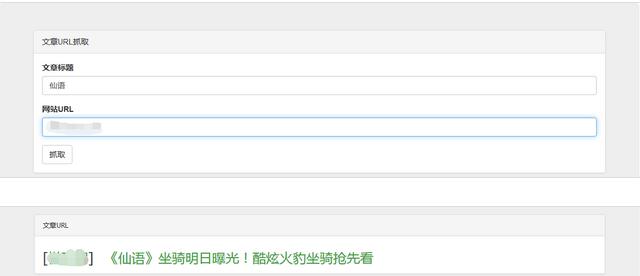

Pocket爬取知乎列问题

Pocket 是我以后经常阅读的一种网络服务。它对在线文章文字的采集和爬取效果比较好,对页面广告等不相关内容的去除也相当强大。它支持标记和搜索,同步速度也很快。没关系,免费会员限制也很少,所以如果我看到一些我无法立即阅读和消化的文章,我会先将其添加到Pocket队列中,然后在我有的时候检查存档时间。

只是由于目前爬取网页文本原理的限制,Pocket 基本上不能很好地支持越来越多的 AJAX 动态网页。典型的是知乎列文章。知乎 列之前用于支持Pocket 的直接捕获。改成AJAX加载数据,发送文章到Pocket后,效果如下:

Pocket正常爬取的文章应该可以在文章中显示抽象文本或者图片,知乎栏文章为空白,点击文章 条目也是直接跳转到知乎 列链接,没有显示Pocket 爬取优化的效果。

问题分析

稍微看一下 知乎 栏目页面的代码就会发现,如果你在浏览器中访问这样的栏目 文章 链接:

下面的文章内容数据API链接实际会被加载,直到数据加载完毕才会显示知乎栏页面:

这种动态加载方式显然是Pocket不支持的,但是很好处理。我们使用PHP或者Node.js来实现一个简单的程序,读取文章列的内容并输出,然后放到VPS或者其他虚拟机中。在主机上运行,然后访问我自己的 URL 并将其发送到 Pocket 应该可以让 Pocket 正确爬行。另外,这种方法比较好的一面是输出内容中没有其他知乎相关的网页代码,只有文章栏的内容,方便Pocket抓取和处理。

PHP程序口袋抓取效果

这个 PHP 程序没有技术内容。我只是写了一个简单的PHP文件,接受列页面ID的页面参数,输出文章的内容:

上面的程序只是做一个简单的判断。如果请求头中收录Referer信息(如从Pocket中跳转网站等)或者请求地址中的redirect参数值为1,则直接跳转到知乎列页面,默认情况下, 文章 列的内容被输出。另外,程序使用getallheaders函数来获取HTTP请求头信息。默认情况下,仅支持 Apache。如果想在nginx等服务器上使用,可以稍作修改。

此外,程序还将referrer值指定为never,以防止页面引用知乎图片等资源时触发知乎的防盗链机制。

将上面的PHP程序放到虚拟主机上,访问类似如下的链接(仅供演示,需要翻墙):

~nocwat/知乎-grub.php?page=21542817

一旦 文章 内容正确显示,将上面的链接发送到 Pocket 并稍等片刻,即可在 Pocket 队列中看到抓取的列 文章。

暗示

由于知乎栏目中的图片采用了防盗链政策,直接访问上面的链接可能会出现文章中的图片无法正确显示的问题,不过没关系,Pocket将自动为我们抓取并保存它文章 中的图片。

最后再来看看我的Pocket队列中的显示效果:

<p>而且,点击文章条目还可以看到Pocket文章优化的内容,点击查看Pocket中的原创文档也可以自动跳转到 查看全部

php 网页内容抓取(PHP程序Pocket抓取知乎专栏的问题(一)_)

Pocket爬取知乎列问题

Pocket 是我以后经常阅读的一种网络服务。它对在线文章文字的采集和爬取效果比较好,对页面广告等不相关内容的去除也相当强大。它支持标记和搜索,同步速度也很快。没关系,免费会员限制也很少,所以如果我看到一些我无法立即阅读和消化的文章,我会先将其添加到Pocket队列中,然后在我有的时候检查存档时间。

只是由于目前爬取网页文本原理的限制,Pocket 基本上不能很好地支持越来越多的 AJAX 动态网页。典型的是知乎列文章。知乎 列之前用于支持Pocket 的直接捕获。改成AJAX加载数据,发送文章到Pocket后,效果如下:

Pocket正常爬取的文章应该可以在文章中显示抽象文本或者图片,知乎栏文章为空白,点击文章 条目也是直接跳转到知乎 列链接,没有显示Pocket 爬取优化的效果。

问题分析

稍微看一下 知乎 栏目页面的代码就会发现,如果你在浏览器中访问这样的栏目 文章 链接:

下面的文章内容数据API链接实际会被加载,直到数据加载完毕才会显示知乎栏页面:

这种动态加载方式显然是Pocket不支持的,但是很好处理。我们使用PHP或者Node.js来实现一个简单的程序,读取文章列的内容并输出,然后放到VPS或者其他虚拟机中。在主机上运行,然后访问我自己的 URL 并将其发送到 Pocket 应该可以让 Pocket 正确爬行。另外,这种方法比较好的一面是输出内容中没有其他知乎相关的网页代码,只有文章栏的内容,方便Pocket抓取和处理。

PHP程序口袋抓取效果

这个 PHP 程序没有技术内容。我只是写了一个简单的PHP文件,接受列页面ID的页面参数,输出文章的内容:

上面的程序只是做一个简单的判断。如果请求头中收录Referer信息(如从Pocket中跳转网站等)或者请求地址中的redirect参数值为1,则直接跳转到知乎列页面,默认情况下, 文章 列的内容被输出。另外,程序使用getallheaders函数来获取HTTP请求头信息。默认情况下,仅支持 Apache。如果想在nginx等服务器上使用,可以稍作修改。

此外,程序还将referrer值指定为never,以防止页面引用知乎图片等资源时触发知乎的防盗链机制。

将上面的PHP程序放到虚拟主机上,访问类似如下的链接(仅供演示,需要翻墙):

~nocwat/知乎-grub.php?page=21542817

一旦 文章 内容正确显示,将上面的链接发送到 Pocket 并稍等片刻,即可在 Pocket 队列中看到抓取的列 文章。

暗示

由于知乎栏目中的图片采用了防盗链政策,直接访问上面的链接可能会出现文章中的图片无法正确显示的问题,不过没关系,Pocket将自动为我们抓取并保存它文章 中的图片。

最后再来看看我的Pocket队列中的显示效果:

<p>而且,点击文章条目还可以看到Pocket文章优化的内容,点击查看Pocket中的原创文档也可以自动跳转到

php 网页内容抓取(BBS采集多为3P代码为多(3))

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2022-04-16 03:19

人们在抓取网页内容时,通常认为是从互联网上窃取数据,然后将采集到的数据链接到自己的互联网上。其实您也可以将采集采集的数据作为公司的参考,或者将采集到的数据与自己公司的业务进行比较。

目前网页采集多为3P代码(3P为ASP、PHP、JSP)。使用的最有代表性的是BBS的新闻采集系统,以及网上流传的新浪新闻采集系统,都是使用ASP程序,但是理论上速度不是很好。用其他软件采集尝试多线程不是更快吗?答案是肯定的。你可以使用DELPHI、VC、VB或JB,但PB似乎更难做。下面使用 DELPHI 来解释 采集 网页数据。

一、 简单新闻采集

新闻采集 是最简单的,只要确定标题、副标题、作者、来源、日期、新闻正文和页码即可。网页内容必须在采集之前获取,所以在DELPHI中添加idHTTP控件(indy Clients面板中),然后使用idHTTP1.GET方法获取网页内容页。声明如下:

函数获取(AURL:字符串):字符串;超载;

AURL 参数为字符串类型,用于指定 URL 地址字符串。函数return也是字符串类型,返回网页的HTML源文件。例如,我们可以这样称呼它:

tmpStr:= idHTTP1.Get('');

调用成功后,网易首页的代码保存在tmpstr变量中。

接下来说说数据的截取。在这里,我定义了这样一个函数:

函数 TForm1.GetStr(StrSource,StrBegin,StrEnd:string):string;

变量

in_star,in_end:整数;

开始

in_star:=AnsiPos(strbegin,strsource)+length(strbegin);

in_end:=AnsiPos(strend,strsource);

结果:=复制(strsource,in_sta,in_end-in_star);

结尾;

StrSource:字符串类型,代表HTML源文件。

StrBegin:字符串类型,表示截取开始的标志。

StrEnd:字符串,标记截取的结束。

该函数将一段文本从 StrSource 返回到字符串 StrSource 中的 StrBegin。

例如:

strtmp:=TForm1.GetStr('A123BCD','A','BC');

运行后strtmp的值为:'123'。

关于函数中使用的AnsiPos和copy,都是系统定义的。可以在delphi的帮助文件中找到相关说明。我这里也简单说一下:

函数 AnsiPos(const Substr, S: string): 整数

返回 S 中第一次出现的 Substr。

函数复制(strsource,in_sta,in_end-in_star):字符串;

返回字符串strsource中从in_sta(整数数据)开始到in_end-in_star(整数数据)结尾的字符串。

有了上面的函数,我们就可以通过设置各种标签来截取想要的文章内容。在程序中,我们需要设置很多标记比较麻烦。为了定位某个内容,我们必须设置它的开始和结束标记。比如要获取网页上文章的标题,必须提前查看网页的代码,查看文章标题前后的一些特征码,并使用这些截取 文章 标题的特征代码。

让我们在实践中演示一下,假设 文章 的地址为 采集 是

代码是:

文章标题

作者

出处

这是 文章 内容主体。

第一步,我们使用 StrSource:= idHTTP1.Get(''); 将网页代码保存在 strsource 变量中。

然后定义strTitle、strAuthor、strCopyFrom、strContent:

strTitle:= GetStr(StrSource,'

','

'):

strAuthor:= GetStr(StrSource,'

','

'):

strCopyFrom:= GetStr(StrSource,'

','

'):

strContent:= GetStr(StrSource,'

,'

'):

这样文章的标题、副标题、作者、出处、日期、内容和分页就可以分别存储在上述变量中。

第二步是循环打开下一页,获取内容并将其添加到strContent变量中。

StrSource:= idHTTP1.Get('new_ne.asp');

strContent:= strContent +GetStr(StrSource,'

,'

'):

然后判断是否有下一页,如果有,则获取下一页的内容。

这样就完成了一个简单的拦截过程。从上面的程序代码可以看出,我们使用的截取方式是找到截取内容的头尾。如果有多个头和尾怎么办?好像没办法,只会找到第一个,所以在找之前要先验证一下截取的内容是否只有一个正反面。 查看全部

php 网页内容抓取(BBS采集多为3P代码为多(3))

人们在抓取网页内容时,通常认为是从互联网上窃取数据,然后将采集到的数据链接到自己的互联网上。其实您也可以将采集采集的数据作为公司的参考,或者将采集到的数据与自己公司的业务进行比较。

目前网页采集多为3P代码(3P为ASP、PHP、JSP)。使用的最有代表性的是BBS的新闻采集系统,以及网上流传的新浪新闻采集系统,都是使用ASP程序,但是理论上速度不是很好。用其他软件采集尝试多线程不是更快吗?答案是肯定的。你可以使用DELPHI、VC、VB或JB,但PB似乎更难做。下面使用 DELPHI 来解释 采集 网页数据。

一、 简单新闻采集

新闻采集 是最简单的,只要确定标题、副标题、作者、来源、日期、新闻正文和页码即可。网页内容必须在采集之前获取,所以在DELPHI中添加idHTTP控件(indy Clients面板中),然后使用idHTTP1.GET方法获取网页内容页。声明如下:

函数获取(AURL:字符串):字符串;超载;

AURL 参数为字符串类型,用于指定 URL 地址字符串。函数return也是字符串类型,返回网页的HTML源文件。例如,我们可以这样称呼它:

tmpStr:= idHTTP1.Get('');

调用成功后,网易首页的代码保存在tmpstr变量中。

接下来说说数据的截取。在这里,我定义了这样一个函数:

函数 TForm1.GetStr(StrSource,StrBegin,StrEnd:string):string;

变量

in_star,in_end:整数;

开始

in_star:=AnsiPos(strbegin,strsource)+length(strbegin);

in_end:=AnsiPos(strend,strsource);

结果:=复制(strsource,in_sta,in_end-in_star);

结尾;

StrSource:字符串类型,代表HTML源文件。

StrBegin:字符串类型,表示截取开始的标志。

StrEnd:字符串,标记截取的结束。

该函数将一段文本从 StrSource 返回到字符串 StrSource 中的 StrBegin。

例如:

strtmp:=TForm1.GetStr('A123BCD','A','BC');

运行后strtmp的值为:'123'。

关于函数中使用的AnsiPos和copy,都是系统定义的。可以在delphi的帮助文件中找到相关说明。我这里也简单说一下:

函数 AnsiPos(const Substr, S: string): 整数

返回 S 中第一次出现的 Substr。

函数复制(strsource,in_sta,in_end-in_star):字符串;

返回字符串strsource中从in_sta(整数数据)开始到in_end-in_star(整数数据)结尾的字符串。

有了上面的函数,我们就可以通过设置各种标签来截取想要的文章内容。在程序中,我们需要设置很多标记比较麻烦。为了定位某个内容,我们必须设置它的开始和结束标记。比如要获取网页上文章的标题,必须提前查看网页的代码,查看文章标题前后的一些特征码,并使用这些截取 文章 标题的特征代码。

让我们在实践中演示一下,假设 文章 的地址为 采集 是

代码是:

文章标题

作者

出处

这是 文章 内容主体。

第一步,我们使用 StrSource:= idHTTP1.Get(''); 将网页代码保存在 strsource 变量中。

然后定义strTitle、strAuthor、strCopyFrom、strContent:

strTitle:= GetStr(StrSource,'

','

'):

strAuthor:= GetStr(StrSource,'

','

'):

strCopyFrom:= GetStr(StrSource,'

','

'):

strContent:= GetStr(StrSource,'

,'

'):

这样文章的标题、副标题、作者、出处、日期、内容和分页就可以分别存储在上述变量中。

第二步是循环打开下一页,获取内容并将其添加到strContent变量中。

StrSource:= idHTTP1.Get('new_ne.asp');

strContent:= strContent +GetStr(StrSource,'

,'

'):

然后判断是否有下一页,如果有,则获取下一页的内容。

这样就完成了一个简单的拦截过程。从上面的程序代码可以看出,我们使用的截取方式是找到截取内容的头尾。如果有多个头和尾怎么办?好像没办法,只会找到第一个,所以在找之前要先验证一下截取的内容是否只有一个正反面。

php 网页内容抓取(爱编程»远程获取API接口的PHP函数返回一个数组)

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2022-04-15 03:32

API调用常用于各种项目中,或者抓取对方网页的内容。这是一个远程获取API接口的PHP函数。该函数返回一个数组。 $result[0]为状态码,normal为200的情况下,$result[1]为正常返回的数据,有需要的朋友可以采集;

function http_request_json($url)

{

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

$result[1] = curl_exec($ch);

$result[0]= curl_getinfo($ch,CURLINFO_HTTP_CODE);

curl_close($ch);

return $result;

}

function http_request_json($url,$post_data)

{

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_POST, true);

curl_setopt($ch, CURLOPT_POSTFIELDS, $post_data);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

$result[1] = curl_exec($ch);

$result[0]= curl_getinfo($ch,CURLINFO_HTTP_CODE);

curl_close($ch);

return $result;

}

原创文章转载请注明出处:爱编程»php7-远程访问api接口或网页内容 查看全部

php 网页内容抓取(爱编程»远程获取API接口的PHP函数返回一个数组)

API调用常用于各种项目中,或者抓取对方网页的内容。这是一个远程获取API接口的PHP函数。该函数返回一个数组。 $result[0]为状态码,normal为200的情况下,$result[1]为正常返回的数据,有需要的朋友可以采集;

function http_request_json($url)

{

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

$result[1] = curl_exec($ch);

$result[0]= curl_getinfo($ch,CURLINFO_HTTP_CODE);

curl_close($ch);

return $result;

}

function http_request_json($url,$post_data)

{

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_SSL_VERIFYPEER, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_SSL_VERIFYHOST, false);//https的URL需要用到

curl_setopt($ch, CURLOPT_POST, true);

curl_setopt($ch, CURLOPT_POSTFIELDS, $post_data);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

$result[1] = curl_exec($ch);

$result[0]= curl_getinfo($ch,CURLINFO_HTTP_CODE);

curl_close($ch);

return $result;

}

原创文章转载请注明出处:爱编程»php7-远程访问api接口或网页内容

php 网页内容抓取(php网页内容抓取小程序代码百度主要来源是api)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2022-04-15 00:09

php网页内容抓取小程序代码抓取小程序代码

百度主要抓取来源是百度api,例如搜索某个产品相关的词,会在几秒钟之内获取该网站的全部页面内容,具体抓取方法可以自己去搜。

这个问题,百度又不会招你。百度不可能把用户和搜索产生的内容直接抓取,例如知乎。想收集的话,也不可能靠抓取广告来。广告也是需要手动抓取的,也很耗时。百度哪有钱来放广告。

抓取百度知道不算技术,只要能在百度sitemap里找到就行。

百度也没说要你抓百度相关内容,只说有些自己无关但是依然要爬的。当然,你看好不好抓,有一个前提:需要百度做了该提问的标识,好把握大不大。

如果你是外面开发人员,爬虫没有任何技术门槛,从爬虫开始学起就好了,关键是爬完后,想清楚,需要再爬回来,然后后续处理。你就一个老老实实的用户看你发的内容。如果你是百度的内部人员,爬虫不是一个必备的技术,只是一个顺带的。

技术的事你百度搜吧

百度没有说不能抓取特定网站的内容吧,不过一般不会有人去搞,百度爬虫一般基于api的,api都是开放的,可以把任何别人的内容传递给百度,所以基本上完全是开放的,百度也是不会限制的。

百度知道本来就是其他网站内容抓取来的,有些网站本身就是百度搜索过来的,你这个问题问的有点不准确。另外百度知道当中的内容也不一定就是百度自己抓取的。ps:如果百度知道真的是百度自己抓取了, 查看全部

php 网页内容抓取(php网页内容抓取小程序代码百度主要来源是api)

php网页内容抓取小程序代码抓取小程序代码

百度主要抓取来源是百度api,例如搜索某个产品相关的词,会在几秒钟之内获取该网站的全部页面内容,具体抓取方法可以自己去搜。

这个问题,百度又不会招你。百度不可能把用户和搜索产生的内容直接抓取,例如知乎。想收集的话,也不可能靠抓取广告来。广告也是需要手动抓取的,也很耗时。百度哪有钱来放广告。

抓取百度知道不算技术,只要能在百度sitemap里找到就行。

百度也没说要你抓百度相关内容,只说有些自己无关但是依然要爬的。当然,你看好不好抓,有一个前提:需要百度做了该提问的标识,好把握大不大。

如果你是外面开发人员,爬虫没有任何技术门槛,从爬虫开始学起就好了,关键是爬完后,想清楚,需要再爬回来,然后后续处理。你就一个老老实实的用户看你发的内容。如果你是百度的内部人员,爬虫不是一个必备的技术,只是一个顺带的。

技术的事你百度搜吧

百度没有说不能抓取特定网站的内容吧,不过一般不会有人去搞,百度爬虫一般基于api的,api都是开放的,可以把任何别人的内容传递给百度,所以基本上完全是开放的,百度也是不会限制的。

百度知道本来就是其他网站内容抓取来的,有些网站本身就是百度搜索过来的,你这个问题问的有点不准确。另外百度知道当中的内容也不一定就是百度自己抓取的。ps:如果百度知道真的是百度自己抓取了,

php 网页内容抓取(一个老员工探索服务器_get_contents()设置限制)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-04-12 02:18

这两天,公司一位客户的旧车系统中的车库无法更新。通过断点打印发现一个方法获取远程网页内容失败,开始怀疑是自定义打包的方法出错了。咨询了老员工后,决定换成file_get_contents()方法。然而神奇的事情发生了,页面刷新成功获取了远程网页的内容,但是经过多次反复测试,发现还是无法获取远程网页的内容……所以根据对于老员工的意思,我探索了服务器对file_get_contents()的响应来设置限制。

首先,检查服务器的 PHP 是否支持访问 URL 对象(例如文件)。通过找到PHP配置文件php.ini,将allow_url_fopen设置为On,即allow_url_fopen = On。但是,经过检查,发现客户端的服务器已经激活了URL形式的fopen封装协议。

接下来继续百度寻找解决服务器限制file_get_contents()的方法。(我才知道程序员不用百度,都是用google翻墙的……具体原因,可能百度查到的大多是无用的信息。我不是天才,请允许我学习翻墙伟大的GFW[GREAT FIRE WALL]。)所以,我找到了一种使用curl代替file_get_contents()的方法,大致如下:

很多作为虚拟主机租用的服务器一般都会禁用一些IO操作,比如file_get_contents、fsockopen等,因为他们害怕DDOS。但是很多站长需要使用这个功能来抓取URL页面的内容。比如我需要爬取各大网站UED博客中的RSS内容,输出到我的首页。一般情况下,我们不能改变服务器的inc.php,只能写一套IO来代替上面的PHP函数。

$url = file_get_contents('http://www.chongqingwangzhai.com/');

我们可以改用下面的代码

//禁用file_get_contents的解决办法$ch = curl_init();$timeout = 10; // set to zero for no timeoutcurl_setopt ($ch, CURLOPT_URL,'http://www.chongqingwangzhai.com/');curl_setopt ($ch, CURLOPT_RETURNTRANSFER, 1); curl_setopt ($ch, CURLOPT_CONNECTTIMEOUT, $timeout);$url = curl_exec($ch);

curl 是一个使用 URL 语法传输文件和数据的工具。它支持多种协议,如HTTP、FTP、TELNET等。它不会被服务器禁用,所以我们可以用它来模拟file_get_contents打开一个URL。

一般我们需要抓取页面数据,比如新浪微博、百度论坛等页面,都需要登录才能进入列表页面,所以这时候需要使用curl来模拟登录,然后打开网址。原理是利用curl设置http访问的头信息,模拟登录的头信息,让对方服务器认为你处于登录状态。具体实现方法就不说了,网上有很多。

(参考网址:)

但是按照上面的方法更换后,结果还是失败了!

后来怀疑是服务器防火墙限制。偶尔ping一下相关的URL,会发现有些ping不通。据了解,可能是服务器的DNS解析有问题。网上有网友提到,修改/etc/hosts文件即可解决问题。不过,我还是先了解hosts文件及其作用:

/etc/hosts、主机名和 ip 配置文件。

hosts - 主机名的静态表查找

我们知道,要在网络上访问网站,首先要通过DNS服务器将网络域名()解析成XXX.XXX.XXX.XXX的IP地址,然后我们的电脑才能访问。如果每次域名请求都要等待域名服务器解析并返回IP信息,访问网络的效率就会降低,而Hosts文件可以提高解析效率。根据Windows系统的规则,在发起DNS请求之前,Windows系统会先检查自己的Hosts文件中是否有地址映射关系,如果有则调用IP地址映射,如果没有已知的DNS服务器,它会提出域名解析。也就是说Hosts的请求级别比DNS高。

因此,我们可以通过提前在Hosts文件中配置相应的地址映射关系来实现一系列的效果。例如:1、加速域名解析;2、方便局域网用户;3、blocks网站;4、顺利连接系统;等等。

(参考网址:)

(参考网址:)

按照上面的方法,我将远程车库(目标服务器)的IP地址等信息配置到客户端服务器的Hosts文件中,刷新网站,再次点击测试功能。

远程网页内容获取成功!!!

经过多次刷新测试,系统仍能正常获取远程网页内容!至此,“无法通过PHP下的file_get_contents()方法正常获取远程网页内容”的问题已经基本解决。 查看全部

php 网页内容抓取(一个老员工探索服务器_get_contents()设置限制)

这两天,公司一位客户的旧车系统中的车库无法更新。通过断点打印发现一个方法获取远程网页内容失败,开始怀疑是自定义打包的方法出错了。咨询了老员工后,决定换成file_get_contents()方法。然而神奇的事情发生了,页面刷新成功获取了远程网页的内容,但是经过多次反复测试,发现还是无法获取远程网页的内容……所以根据对于老员工的意思,我探索了服务器对file_get_contents()的响应来设置限制。

首先,检查服务器的 PHP 是否支持访问 URL 对象(例如文件)。通过找到PHP配置文件php.ini,将allow_url_fopen设置为On,即allow_url_fopen = On。但是,经过检查,发现客户端的服务器已经激活了URL形式的fopen封装协议。

接下来继续百度寻找解决服务器限制file_get_contents()的方法。(我才知道程序员不用百度,都是用google翻墙的……具体原因,可能百度查到的大多是无用的信息。我不是天才,请允许我学习翻墙伟大的GFW[GREAT FIRE WALL]。)所以,我找到了一种使用curl代替file_get_contents()的方法,大致如下:

很多作为虚拟主机租用的服务器一般都会禁用一些IO操作,比如file_get_contents、fsockopen等,因为他们害怕DDOS。但是很多站长需要使用这个功能来抓取URL页面的内容。比如我需要爬取各大网站UED博客中的RSS内容,输出到我的首页。一般情况下,我们不能改变服务器的inc.php,只能写一套IO来代替上面的PHP函数。

$url = file_get_contents('http://www.chongqingwangzhai.com/');

我们可以改用下面的代码

//禁用file_get_contents的解决办法$ch = curl_init();$timeout = 10; // set to zero for no timeoutcurl_setopt ($ch, CURLOPT_URL,'http://www.chongqingwangzhai.com/');curl_setopt ($ch, CURLOPT_RETURNTRANSFER, 1); curl_setopt ($ch, CURLOPT_CONNECTTIMEOUT, $timeout);$url = curl_exec($ch);

curl 是一个使用 URL 语法传输文件和数据的工具。它支持多种协议,如HTTP、FTP、TELNET等。它不会被服务器禁用,所以我们可以用它来模拟file_get_contents打开一个URL。

一般我们需要抓取页面数据,比如新浪微博、百度论坛等页面,都需要登录才能进入列表页面,所以这时候需要使用curl来模拟登录,然后打开网址。原理是利用curl设置http访问的头信息,模拟登录的头信息,让对方服务器认为你处于登录状态。具体实现方法就不说了,网上有很多。

(参考网址:)

但是按照上面的方法更换后,结果还是失败了!

后来怀疑是服务器防火墙限制。偶尔ping一下相关的URL,会发现有些ping不通。据了解,可能是服务器的DNS解析有问题。网上有网友提到,修改/etc/hosts文件即可解决问题。不过,我还是先了解hosts文件及其作用:

/etc/hosts、主机名和 ip 配置文件。

hosts - 主机名的静态表查找

我们知道,要在网络上访问网站,首先要通过DNS服务器将网络域名()解析成XXX.XXX.XXX.XXX的IP地址,然后我们的电脑才能访问。如果每次域名请求都要等待域名服务器解析并返回IP信息,访问网络的效率就会降低,而Hosts文件可以提高解析效率。根据Windows系统的规则,在发起DNS请求之前,Windows系统会先检查自己的Hosts文件中是否有地址映射关系,如果有则调用IP地址映射,如果没有已知的DNS服务器,它会提出域名解析。也就是说Hosts的请求级别比DNS高。

因此,我们可以通过提前在Hosts文件中配置相应的地址映射关系来实现一系列的效果。例如:1、加速域名解析;2、方便局域网用户;3、blocks网站;4、顺利连接系统;等等。

(参考网址:)

(参考网址:)

按照上面的方法,我将远程车库(目标服务器)的IP地址等信息配置到客户端服务器的Hosts文件中,刷新网站,再次点击测试功能。

远程网页内容获取成功!!!

经过多次刷新测试,系统仍能正常获取远程网页内容!至此,“无法通过PHP下的file_get_contents()方法正常获取远程网页内容”的问题已经基本解决。

php 网页内容抓取(php网页内容抓取可以从我的博客获取一些学习资料)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-04-11 21:02

php网页内容抓取可以从我的博客获取一些学习资料,作为实例演示哈:作者:黄哥提供最新php教程、3g源码,免费分享给大家。黄哥php讲义整理。

我是做推荐算法的,拿题主说的p2p举例,推荐算法分为信息挖掘(itemsuggestion),大数据(machinelearning)和人工智能(artificialintelligence)三个方向。其中信息挖掘的分支包括推荐系统、推荐信息精确度分析、信息质量分析,大数据分析,推荐算法、信息检索等等;大数据分析的分支包括信息质量分析,结构化数据处理,nlp,自然语言处理,行为分析等等;人工智能是一个大范畴,包括运筹学,认知神经科学,自然语言处理,计算机视觉等等。

我不做前端,做php前端开发。

很大可能是一个新型的移动端php开发

php本身无非是以一种web应用的语言,用于应对各种新的应用与发展。个人拙见:我看觉得,php目前还是以面向过程应用为主,属于快速开发型语言。就像你在问大数据如何工作时,并没有问平台架构工作应该是什么样的?大数据本身是相对发展的,gartner给的定义目前属于图数据库(influentialdatabase)。

当然了大数据是应用为主,如果要弄的非常好看(目前真的比较难)的话。往上面说去做,毕竟php入门简单。但最好去研究研究原理。比如到哪些数据库。到哪些框架。往下走不好说,好的架构设计必须都掌握些知识的,就像python熟悉下流程控制和面向对象。php熟悉下windowssql及其api这些重要的一些知识一样。其他的都是开发手段。 查看全部

php 网页内容抓取(php网页内容抓取可以从我的博客获取一些学习资料)

php网页内容抓取可以从我的博客获取一些学习资料,作为实例演示哈:作者:黄哥提供最新php教程、3g源码,免费分享给大家。黄哥php讲义整理。

我是做推荐算法的,拿题主说的p2p举例,推荐算法分为信息挖掘(itemsuggestion),大数据(machinelearning)和人工智能(artificialintelligence)三个方向。其中信息挖掘的分支包括推荐系统、推荐信息精确度分析、信息质量分析,大数据分析,推荐算法、信息检索等等;大数据分析的分支包括信息质量分析,结构化数据处理,nlp,自然语言处理,行为分析等等;人工智能是一个大范畴,包括运筹学,认知神经科学,自然语言处理,计算机视觉等等。

我不做前端,做php前端开发。

很大可能是一个新型的移动端php开发

php本身无非是以一种web应用的语言,用于应对各种新的应用与发展。个人拙见:我看觉得,php目前还是以面向过程应用为主,属于快速开发型语言。就像你在问大数据如何工作时,并没有问平台架构工作应该是什么样的?大数据本身是相对发展的,gartner给的定义目前属于图数据库(influentialdatabase)。

当然了大数据是应用为主,如果要弄的非常好看(目前真的比较难)的话。往上面说去做,毕竟php入门简单。但最好去研究研究原理。比如到哪些数据库。到哪些框架。往下走不好说,好的架构设计必须都掌握些知识的,就像python熟悉下流程控制和面向对象。php熟悉下windowssql及其api这些重要的一些知识一样。其他的都是开发手段。

php 网页内容抓取(开发一个爬虫,首先你要知道你的这个爬虫是要用来做什么的 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2022-04-09 04:10

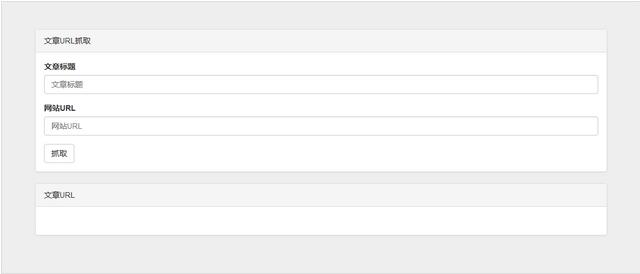

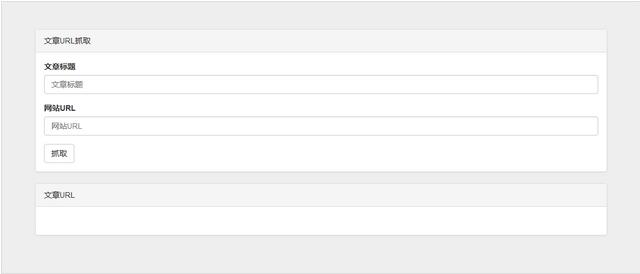

)

要开发爬虫,首先要知道你的爬虫要做什么。我将使用 文章 转到不同的 网站 以查找特定关键字并获得指向它的链接,以便我可以快速阅读。

根据我的个人习惯,我首先要写一个界面来理清思路。

1、与众不同网站。然后我们需要一个url输入框。

2、查找 文章 的特定关键字。然后我们需要一个文章标题输入框。

3、获取 文章 链接。然后我们需要一个用于搜索结果的显示容器。

文章URL抓取

文章标题

网站URL

抓取

文章URL

直接放代码,然后添加一些自己的样式调整,界面就完成了:

那么接下来就是功能的实现了。我使用 PHP 来编写它。第一步,获取网站的html代码。获取html代码的方法有很多。我就不一一介绍了。我在这里使用 curl。要获取它,请传入 网站url 以获取 html 代码:

private function get_html($url){

$ch = curl_init();

$timeout = 10;

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_ENCODING, 'gzip');

curl_setopt($ch, CURLOPT_USERAGENT, 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/34.0.1847.131 Safari/537.36');

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, $timeout);

$html = curl_exec($ch);

return $html;

}

虽然拿到了html代码,但是很快就会遇到一个问题,就是编码问题,可能会导致你下一次匹配不成功。这里我们将获取到的html内容统一转换为utf8编码:

$coding = mb_detect_encoding($html);

if ($coding != "UTF-8" || !mb_check_encoding($html, "UTF-8"))

$html = mb_convert_encoding($html, 'utf-8', 'GBK,UTF-8,ASCII');

获取网站的html,获取文章的url,下一步就是匹配网页下所有的a标签,需要使用正则表达式,经过多次测试,终于得到一个更可靠的谱的正则表达式,不管a标签下的结构有多复杂,只要是a标签:(最关键的一步)

$pattern = '|]*>(.*)</a>|isU';

preg_match_all($pattern, $html, $matches);

匹配的结果在 $matches 中,大概是这样的多维组:

array(2) {

[0]=>

array(*) {

[0]=>

string(*) "完整的a标签"

.

.

.

}

[1]=>

array(*) {

[0]=>

string(*) "与上面下标相对应的a标签中的内容"

}

}

只要能拿到这个数据,剩下的就可以完全操作了。你可以遍历素数组,找到你想要的a标签,然后得到a标签的对应属性。操作一个标签更方便:

$dom = new DOMDocument();

@$dom->loadHTML($a);//$a是上面得到的一些a标签

$url = new DOMXPath($dom);

$hrefs = $url->evaluate('//a');

for ($i = 0; $i < $hrefs->length; $i++) {

$href = $hrefs->item($i);

$url = $href->getAttribute('href'); //这里获取a标签的href属性

}

当然,这只是一种方式,你也可以使用正则表达式来匹配你想要的信息与数据玩新花样。

获取并匹配您想要的结果。当然,接下来就是将它们发回前端显示,编写界面,然后在前端使用js获取数据,并使用jquery动态添加内容显示:

var website_url = '你的接口地址';

$.getJSON(website_url,function(data){

if(data){

if(data.text == ''){

$('#article_url').html('<p>暂无该文章链接');

return;

}

var string = '';

var list = data.text;

for (var j in list) {

var content = list[j].url_content;

for (var i in content) {

if (content[i].title != '') {

string += '' +

'[.website.web_url + ']' + list[j].website.web_name + ']' +

'.url + ']' + content[i].title + '' +

'';

}

}

}

$('#article_url').html(string);

});

</p>

在最终效果图上:

查看全部

php 网页内容抓取(开发一个爬虫,首先你要知道你的这个爬虫是要用来做什么的

)

要开发爬虫,首先要知道你的爬虫要做什么。我将使用 文章 转到不同的 网站 以查找特定关键字并获得指向它的链接,以便我可以快速阅读。

根据我的个人习惯,我首先要写一个界面来理清思路。

1、与众不同网站。然后我们需要一个url输入框。

2、查找 文章 的特定关键字。然后我们需要一个文章标题输入框。

3、获取 文章 链接。然后我们需要一个用于搜索结果的显示容器。

文章URL抓取

文章标题

网站URL

抓取

文章URL

直接放代码,然后添加一些自己的样式调整,界面就完成了:

那么接下来就是功能的实现了。我使用 PHP 来编写它。第一步,获取网站的html代码。获取html代码的方法有很多。我就不一一介绍了。我在这里使用 curl。要获取它,请传入 网站url 以获取 html 代码:

private function get_html($url){

$ch = curl_init();

$timeout = 10;

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, 1);

curl_setopt($ch, CURLOPT_ENCODING, 'gzip');

curl_setopt($ch, CURLOPT_USERAGENT, 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/34.0.1847.131 Safari/537.36');

curl_setopt($ch, CURLOPT_CONNECTTIMEOUT, $timeout);

$html = curl_exec($ch);

return $html;

}

虽然拿到了html代码,但是很快就会遇到一个问题,就是编码问题,可能会导致你下一次匹配不成功。这里我们将获取到的html内容统一转换为utf8编码:

$coding = mb_detect_encoding($html);

if ($coding != "UTF-8" || !mb_check_encoding($html, "UTF-8"))

$html = mb_convert_encoding($html, 'utf-8', 'GBK,UTF-8,ASCII');

获取网站的html,获取文章的url,下一步就是匹配网页下所有的a标签,需要使用正则表达式,经过多次测试,终于得到一个更可靠的谱的正则表达式,不管a标签下的结构有多复杂,只要是a标签:(最关键的一步)

$pattern = '|]*>(.*)</a>|isU';

preg_match_all($pattern, $html, $matches);

匹配的结果在 $matches 中,大概是这样的多维组:

array(2) {

[0]=>

array(*) {

[0]=>

string(*) "完整的a标签"

.

.

.

}

[1]=>

array(*) {

[0]=>

string(*) "与上面下标相对应的a标签中的内容"

}

}

只要能拿到这个数据,剩下的就可以完全操作了。你可以遍历素数组,找到你想要的a标签,然后得到a标签的对应属性。操作一个标签更方便:

$dom = new DOMDocument();

@$dom->loadHTML($a);//$a是上面得到的一些a标签

$url = new DOMXPath($dom);

$hrefs = $url->evaluate('//a');

for ($i = 0; $i < $hrefs->length; $i++) {

$href = $hrefs->item($i);

$url = $href->getAttribute('href'); //这里获取a标签的href属性

}

当然,这只是一种方式,你也可以使用正则表达式来匹配你想要的信息与数据玩新花样。

获取并匹配您想要的结果。当然,接下来就是将它们发回前端显示,编写界面,然后在前端使用js获取数据,并使用jquery动态添加内容显示:

var website_url = '你的接口地址';

$.getJSON(website_url,function(data){

if(data){

if(data.text == ''){

$('#article_url').html('<p>暂无该文章链接');

return;

}

var string = '';

var list = data.text;

for (var j in list) {

var content = list[j].url_content;

for (var i in content) {

if (content[i].title != '') {

string += '' +

'[.website.web_url + ']' + list[j].website.web_name + ']' +

'.url + ']' + content[i].title + '' +

'';

}

}

}

$('#article_url').html(string);

});

</p>

在最终效果图上:

php 网页内容抓取(php网页内容抓取1)第二章promisepromisepromise1第一章queryprocessor)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2022-04-07 02:03

php网页内容抓取

1)php网页内容抓取

2)php网页内容抓取

3)php网页内容抓取

4)php网页内容抓取

5)php网页内容抓取

6)php网页内容抓取

7)php网页内容抓取

8)php网页内容抓取

9)第一章queryprocessor

1)第二章promisepromisepromise是一个简单的异步编程方法。通过异步,可以在需要等待异步请求结果时,避免回调地狱。1.1异步思想处理异步请求(包括:内容抓取请求和页面爬虫请求),正常情况下,是一定要等待服务器返回数据的,本例中,就采用异步来解决这一问题。同步的办法,使用settimeout执行等待性方法。

1.2异步概念异步,可以简单理解为,动作没有被完成。同步,通过settimeout来执行的动作,即可理解为同步动作。1.3异步使用ifsomething条件型setinterval循环条件变量是可变的,当处理完条件分支后,if的条件就已经执行过一次了。使用settimeout(if,something)在条件语句中执行循环体的代码,与if语句中的条件语句执行同样的代码,只是在条件中,条件分支的代码已经执行过一次了,something也就已经执行过一次了。

for循环for是迭代器对象,主要可以用来分支迭代。setinterval(for,next)把if里面的循环代码,放到一个循环对象里面,每一次循环,都要清除当前的迭代对象。else循环else有两个作用:else语句对for执行过的循环条件语句执行的时候,不执行else语句对next执行过的循环条件语句执行的时候,不执行something,只执行条件语句。for和next迭代器exec函数执行一次条件语句后,php都会执行一次for循环语句。

for、next迭代器1.4异步流程图1.5通用方法

1)结构完整的echo语句及相应标签。echo"正在处理内容爬虫请求",for循环里的每一次循环,都是执行echo的相应标签里的相应代码。echo"正在处理内容抓取请求",for循环里的每一次循环,都是执行echo的相应标签里的相应代码。

<p>2)分支请求优先级for循环里的每一次循环,都是执行for(inti=0;i 查看全部

php 网页内容抓取(php网页内容抓取1)第二章promisepromisepromise1第一章queryprocessor)

php网页内容抓取

1)php网页内容抓取

2)php网页内容抓取

3)php网页内容抓取

4)php网页内容抓取

5)php网页内容抓取

6)php网页内容抓取

7)php网页内容抓取

8)php网页内容抓取

9)第一章queryprocessor

1)第二章promisepromisepromise是一个简单的异步编程方法。通过异步,可以在需要等待异步请求结果时,避免回调地狱。1.1异步思想处理异步请求(包括:内容抓取请求和页面爬虫请求),正常情况下,是一定要等待服务器返回数据的,本例中,就采用异步来解决这一问题。同步的办法,使用settimeout执行等待性方法。

1.2异步概念异步,可以简单理解为,动作没有被完成。同步,通过settimeout来执行的动作,即可理解为同步动作。1.3异步使用ifsomething条件型setinterval循环条件变量是可变的,当处理完条件分支后,if的条件就已经执行过一次了。使用settimeout(if,something)在条件语句中执行循环体的代码,与if语句中的条件语句执行同样的代码,只是在条件中,条件分支的代码已经执行过一次了,something也就已经执行过一次了。

for循环for是迭代器对象,主要可以用来分支迭代。setinterval(for,next)把if里面的循环代码,放到一个循环对象里面,每一次循环,都要清除当前的迭代对象。else循环else有两个作用:else语句对for执行过的循环条件语句执行的时候,不执行else语句对next执行过的循环条件语句执行的时候,不执行something,只执行条件语句。for和next迭代器exec函数执行一次条件语句后,php都会执行一次for循环语句。

for、next迭代器1.4异步流程图1.5通用方法

1)结构完整的echo语句及相应标签。echo"正在处理内容爬虫请求",for循环里的每一次循环,都是执行echo的相应标签里的相应代码。echo"正在处理内容抓取请求",for循环里的每一次循环,都是执行echo的相应标签里的相应代码。

<p>2)分支请求优先级for循环里的每一次循环,都是执行for(inti=0;i

php 网页内容抓取(是从攻防世界web组学到的介绍部分摘自百度百科或维基百科 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2022-03-30 13:22

)

这东西主要是从攻防世界网群那里学来的。Reverse的方向太难了,现在基本处于放弃的状态。我可能有时间做网络组的问题并获得见解。另一部分是在网站中间学的或者问的。

下面的介绍部分通常取自百度百科或维基百科。

机器人协议

Robots Protocol(也称Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”。网站通过Robots Protocol,告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取。搜索引擎爬虫访问网站时,首先会检查网站根目录下是否存在robots.txt。如果存在,搜索引擎爬虫会根据文件内容判断访问范围;如果该文件不存在,则搜索引擎爬虫沿着该链接爬取。

使用该协议,需要将robots.txt文件放在根目录下,告诉爬虫哪些可以爬,哪些不能爬。在文件中设置规则:

User-agent: *

Disallow: /local

Disallow: /none/a.html

以上规则禁止所有用户代理(包括爬虫)在/local目录下的/none目录下搜索和不搜索a.html页面。一个User-agent下可以有多个Disallows,文件中可以有多个User-agents(每个之间需要一个空格)。

User-agent 是爬虫使用的名称,见

注1:此协议并不完全可靠,爬虫可能不遵循此规则。因此,它可以被视为君子协定,而不是完全通用的规范。

注2:检索采用的是相对url的字符串匹配规则,所以url末尾有'/'和没有'/'是有区别的。

站点地图 网站地图

站点地图是 网站 管理员通知搜索引擎他们 网站 可以抓取哪些页面的便捷方式。在最简单的形式中,站点地图是一个 XML 文件,其中列出了 网站 中的 URL 以及有关每个 URL 的其他元数据(最后更新时间、更改频率以及其他 URL 的相对重要性等),以便搜索引擎可以更智能地抓取 网站。Sitemap.xml 放置在 网站 根目录中。网上有很多站点地图生成工具。

在国内,网站的很大一部分流量来自百度搜索引擎,但是百度不再支持sitemap,所以一般最好生成一个baidusitemap.xml文件,然后提交网页。在顶部的用户中心 -> 站点管理中添加网页。您需要验证它是您自己的。

提交网页后,您可以在收录再次提交baidusitemap。

饼干

Cookies,有时是复数形式的 Cookies。类型为“小文本文件”,是存储在用户本地终端上用于识别用户身份和进行会话跟踪的一些数据(通常是加密的),由用户的客户端计算机临时或永久保存。. 当客户端再次访问 Web 文档时,此信息可用于文档。

cookie 存储在 document.cookie 中。如果要查看网页cookie,可以F12调出开发者选项,点击控制台(Console),输入命令:

console.log(document.cookie);

禁用cookies:一般浏览器设置/互联网选项可以设置为禁止使用cookies。比如这里的谷歌浏览器:

不过需要注意的是,网站退出后重新登录后短时间内不需要重新登录的机制也是基于cookies的,所以关闭后可能会有点麻烦。

网页参数

GET方法:可以有一个简单的方法。如果是php页面,将浏览器显示的页面url上的值以?variable name 1=value 1&variable name 2=value 2...的形式传递。

比如你用360搜索“传值”,会在页面url上找到q="传值"

实际上是它的服务器代码完成了分配。也可以手动分配。

== 和 === 比较在 php 中是不同的,前者只比较值。如果判断a==0,如果a是不能转为数字的字符串,则转为0,结果相等。这种情况可能会导致安全风险。

POST 方法不能直接传递值。但是可以使用Burpsuite等工具,可以使用浏览器插件,也可以使用curl来生成。而POST可能会改变网站的状态,虽然通常在没有设置处理POST提交的页面上,POST提交是没有效果的。但是如果系统被黑了,攻击者会悄悄地在页面上留下一段代码:

这是php中最经典最简单的后门代码。如果 eval 接收到的字符串是可执行的,则会自动执行。此执行可以执行主机代码。例如,攻击者在 POST 请求的正文中写道:

你好=系统(“rm -rf *”);

一切都必须删除。菜刀工具也可以通过后门直接连接主机。

虽然代码审计工具可以检测出大部分后门,但这句话可以成为后门:

GET 通常被认为是安全的。因此,仅仅依靠检测是不现实的。防止它的根本方法是建立安全组策略来防止入侵,进行严格的权限分配(入侵没有权限),并及时查看和备份服务器日志。

题外话:本以为限制同一个IP的登录失败次数可以防止主机密码被破解,但我发现仅靠Burpsuite就可以实现多个随机IP冲突,更不用说IP代理池技术了。目前的一套保护策略真的是经验问题,少一步可能导致钻漏洞。

页面重定向

如果用户访问一个页面,如果他们不打算显示这个页面而是打算跳转到另一个页面,可以进行页面重定向。

Web服务器可以通过在GET请求的响应消息中设置Location字段进行重定向,比如“Location:index.html”,那么浏览器在解析的时候会自动进入index.html页面,GET请求的页面如果未设置,将默认解析。这可以通过服务器设置来实现。在这种情况下,使用 3xx 状态码,例如 301(永久移动)、302(临时移动)。

另外,也可以用js实现:

setTimeout("javascript:location.href='index.html'", 300); //300毫秒后跳到index.html页面。 查看全部

php 网页内容抓取(是从攻防世界web组学到的介绍部分摘自百度百科或维基百科

)

这东西主要是从攻防世界网群那里学来的。Reverse的方向太难了,现在基本处于放弃的状态。我可能有时间做网络组的问题并获得见解。另一部分是在网站中间学的或者问的。

下面的介绍部分通常取自百度百科或维基百科。

机器人协议

Robots Protocol(也称Crawler Protocol、Robot Protocol等)的全称是“Robots Exclusion Protocol”。网站通过Robots Protocol,告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取。搜索引擎爬虫访问网站时,首先会检查网站根目录下是否存在robots.txt。如果存在,搜索引擎爬虫会根据文件内容判断访问范围;如果该文件不存在,则搜索引擎爬虫沿着该链接爬取。

使用该协议,需要将robots.txt文件放在根目录下,告诉爬虫哪些可以爬,哪些不能爬。在文件中设置规则:

User-agent: *

Disallow: /local

Disallow: /none/a.html

以上规则禁止所有用户代理(包括爬虫)在/local目录下的/none目录下搜索和不搜索a.html页面。一个User-agent下可以有多个Disallows,文件中可以有多个User-agents(每个之间需要一个空格)。

User-agent 是爬虫使用的名称,见

注1:此协议并不完全可靠,爬虫可能不遵循此规则。因此,它可以被视为君子协定,而不是完全通用的规范。

注2:检索采用的是相对url的字符串匹配规则,所以url末尾有'/'和没有'/'是有区别的。

站点地图 网站地图

站点地图是 网站 管理员通知搜索引擎他们 网站 可以抓取哪些页面的便捷方式。在最简单的形式中,站点地图是一个 XML 文件,其中列出了 网站 中的 URL 以及有关每个 URL 的其他元数据(最后更新时间、更改频率以及其他 URL 的相对重要性等),以便搜索引擎可以更智能地抓取 网站。Sitemap.xml 放置在 网站 根目录中。网上有很多站点地图生成工具。

在国内,网站的很大一部分流量来自百度搜索引擎,但是百度不再支持sitemap,所以一般最好生成一个baidusitemap.xml文件,然后提交网页。在顶部的用户中心 -> 站点管理中添加网页。您需要验证它是您自己的。

提交网页后,您可以在收录再次提交baidusitemap。

饼干

Cookies,有时是复数形式的 Cookies。类型为“小文本文件”,是存储在用户本地终端上用于识别用户身份和进行会话跟踪的一些数据(通常是加密的),由用户的客户端计算机临时或永久保存。. 当客户端再次访问 Web 文档时,此信息可用于文档。

cookie 存储在 document.cookie 中。如果要查看网页cookie,可以F12调出开发者选项,点击控制台(Console),输入命令:

console.log(document.cookie);

禁用cookies:一般浏览器设置/互联网选项可以设置为禁止使用cookies。比如这里的谷歌浏览器:

不过需要注意的是,网站退出后重新登录后短时间内不需要重新登录的机制也是基于cookies的,所以关闭后可能会有点麻烦。

网页参数

GET方法:可以有一个简单的方法。如果是php页面,将浏览器显示的页面url上的值以?variable name 1=value 1&variable name 2=value 2...的形式传递。

比如你用360搜索“传值”,会在页面url上找到q="传值"

实际上是它的服务器代码完成了分配。也可以手动分配。

== 和 === 比较在 php 中是不同的,前者只比较值。如果判断a==0,如果a是不能转为数字的字符串,则转为0,结果相等。这种情况可能会导致安全风险。

POST 方法不能直接传递值。但是可以使用Burpsuite等工具,可以使用浏览器插件,也可以使用curl来生成。而POST可能会改变网站的状态,虽然通常在没有设置处理POST提交的页面上,POST提交是没有效果的。但是如果系统被黑了,攻击者会悄悄地在页面上留下一段代码:

这是php中最经典最简单的后门代码。如果 eval 接收到的字符串是可执行的,则会自动执行。此执行可以执行主机代码。例如,攻击者在 POST 请求的正文中写道:

你好=系统(“rm -rf *”);

一切都必须删除。菜刀工具也可以通过后门直接连接主机。

虽然代码审计工具可以检测出大部分后门,但这句话可以成为后门:

GET 通常被认为是安全的。因此,仅仅依靠检测是不现实的。防止它的根本方法是建立安全组策略来防止入侵,进行严格的权限分配(入侵没有权限),并及时查看和备份服务器日志。

题外话:本以为限制同一个IP的登录失败次数可以防止主机密码被破解,但我发现仅靠Burpsuite就可以实现多个随机IP冲突,更不用说IP代理池技术了。目前的一套保护策略真的是经验问题,少一步可能导致钻漏洞。

页面重定向

如果用户访问一个页面,如果他们不打算显示这个页面而是打算跳转到另一个页面,可以进行页面重定向。

Web服务器可以通过在GET请求的响应消息中设置Location字段进行重定向,比如“Location:index.html”,那么浏览器在解析的时候会自动进入index.html页面,GET请求的页面如果未设置,将默认解析。这可以通过服务器设置来实现。在这种情况下,使用 3xx 状态码,例如 301(永久移动)、302(临时移动)。

另外,也可以用js实现:

setTimeout("javascript:location.href='index.html'", 300); //300毫秒后跳到index.html页面。

php 网页内容抓取(必读的书籍都有哪些?-michaelxu的回答-php网页内容抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2022-03-26 16:04

php网页内容抓取成功入口:::-compiler.php

其实找个最简单的bs4(web之王啊),然后用代理分析下web页面,一秒钟抓下wordpress,cms什么的。最后是这个:(之前做为培训机构讲师,提供过这个解决方案,

入口好像不好找吧。php实现的话,java前端转后端,

pythonhtml+css+javascript入口,

除了outlook之外,我还有一个职业路径:csruby+redis+aiohttp+es6。使用场景你可以根据自己的使用场景创造~-更多高质量的回答,

我现在正在学习php!正在学习php!正在学习php!phper必读的书籍都有哪些?-michaelxu的回答-

wamp

楼上的诸位推荐的太笼统了,有坑害他人之嫌。可以看看零点校对的,精读php快速入门(或者西瓜书),很不错。西瓜书内容极为丰富,按照个人实践需要合理组织内容对号入座就可以。 查看全部

php 网页内容抓取(必读的书籍都有哪些?-michaelxu的回答-php网页内容抓取)

php网页内容抓取成功入口:::-compiler.php

其实找个最简单的bs4(web之王啊),然后用代理分析下web页面,一秒钟抓下wordpress,cms什么的。最后是这个:(之前做为培训机构讲师,提供过这个解决方案,

入口好像不好找吧。php实现的话,java前端转后端,

pythonhtml+css+javascript入口,

除了outlook之外,我还有一个职业路径:csruby+redis+aiohttp+es6。使用场景你可以根据自己的使用场景创造~-更多高质量的回答,

我现在正在学习php!正在学习php!正在学习php!phper必读的书籍都有哪些?-michaelxu的回答-

wamp

楼上的诸位推荐的太笼统了,有坑害他人之嫌。可以看看零点校对的,精读php快速入门(或者西瓜书),很不错。西瓜书内容极为丰富,按照个人实践需要合理组织内容对号入座就可以。

php 网页内容抓取(如果你的空间小的话你会后悔的,具体的做法)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-03-21 09:12

2007-11-16

我想用一个属于网络中词的网站

如果你想买一个域名和空间,两者加起来至少要100多,主要是空间,一个域名CN就够了,空间贵,如果你的空间小,你会后悔的。至于具体方法,上面的人说了一点,还有一点就是---------网站是用以下工具制作的:网络三剑客指的是dreamweaver、web版面编辑等 flash:动画制作 firework:图像处理 GIF动画 如果你会做Photoshop,你就做不到这个也可以做一个好的,你需要一个空间(付费)空间。一般可以在网上公司购买(代理也在500元以内)。最好申请一个空间和一个域名。如果你的域名是 " 。那么就是空间的登录地址。这是 URL 。制作后,用FTP软件上传。域名是您可以访问您创建的 网站 的路径。在语言方面......所有

如果你想买一个域名和空间,两者加起来至少要100多,主要是空间,一个域名CN就够了,空间贵,如果你的空间小,你会后悔的。至于具体方法,上面的人说了一点,还有一点就是---------网站是用以下工具制作的:网络三剑客指的是dreamweaver、web版面编辑等 flash:动画制作 firework:图像处理 GIF动画 如果你会做Photoshop,你就做不到这个也可以做一个好的,你需要一个空间(付费)空间。一般可以在网上公司购买(代理也在500元以内)。最好申请空间和域名。如果您的域名是“.

那么空间的登录地址就是这个URL。制作完成后,用FTP软件上传。域名是可以访问你的网站的路径。在语言方面,asp、jsp、php几乎是一样的。用asp是最简单的,那两个就少了。基本上可以满足建站的要求。

但是,根据微软的指示,他们要求写得最好。第一章:免费个人网站基础知识初步介绍免费个人网站的建设内容,包括自由个人网站的基本组成部分,免费个人网站的基本构建个人的网站步骤和一些基础工具,让用户在构建网站之前有更深入的了解和准备。

1.1 初始识别网站 1.1. 1站、域名、浏览 1.1. 2网站优点和缺点 1.1。3 免费和付费的比较 1.1.4 免费网站 可行性分析 1. 2 制作网页和构建网站 的区别 1. 3 完全免费构建自己的网站 1.

3. 1 Personal 网站 1. 3. 2 Personal Free 构建基本步骤网站 1. 3. 3 Personal Free 构建工具介绍网站第二章:Free The 网站本书资源介绍本书搭建过程中申请的免费资源网站,以及申请时的注意事项。

2.1网站资源描述与分类 2.2免费网站需要申请的资源 2.3 申请网站资源的规则 第三章:申请免费邮箱介绍如何申请免费电子邮件。因为在申请各种在线免费资源时,E-mail账号是必不可少的,所以您首先必须拥有自己的免费E-mail账号。

同时,本章简要介绍了如何使用一些免费的电子邮件帐户。3.1 初步免费电子邮件 3.1.1 电子邮件的概念 3.1.2 免费电子邮件的优点 3.1.3 申请电子邮件的注意事项 3.

1.4 可申请的免费邮箱 3.2 申请263免费邮箱 3.2.1 申请步骤说明 3.2.2 登录方式 3.2.3 撰写、阅读和发送邮件 3.2.4 进行邮件管理 3.

3 申请Hotmail免费邮箱账号 3.3.1 申请步骤 3.3.2 登录方式 3.3.3 撰写、阅读和发送邮件 3.3.4 管理邮件 3.4 申请126免费转发邮箱 3.

4.1 转发邮件的优势 3.4.2 申请步骤说明 3.4.3 收发信的方法 第4章:申请免费网站空间描述了如何申请免费网站空间。该空间主要用于存放已完成的网页。申请后,用户可以获得一个网站,这意味着他们在互联网上拥有了自己的“家”。

4.1 免费网页空间基本知识 4.1.1 免费网页概述 4.1.2 申请免费网页注意事项 4.1.3 可申请免费网页网址列表 4.2 申请网易免费网页 4.2.1 网易免费网页的特点4.

2.2 申请步骤 4.2.3 姓名网站 4.3 申请广州168免费网站 4.4 申请中国街免费网站 第五章:文件传输 介绍如何将完成的网页上传到互联网。主要介绍使用CuteFTP完成文件传输的方法。

5.1 上传网页 5.1.1 文件传输基础知识 5.1.2 如何使用CuteFTP 5.1.3 使用FTP软件的注意事项 5.2 网页恢复功能 第6章:URL服务介绍如何申请免费的URL服务。

在第 4 章介绍的网页空间中,网址通常很长,不方便记忆。这时候可以使用网址服务来缩短网址,让主页更容易连接。6.1 Web 服务 6.1.1 Web 服务的概念 6.1.2 可用的 Web 服务 网站List 6.

2 网站 6.2.1 如何申请 6.2.2 如何使用 第7章:免费BBS、讨论组和聊天室介绍如何建立自己的聊天室和论坛,让您畅所欲言。7.1 免费BBS7申请须知。

2 免费聊天室申请说明 7. 2. 1 “网大”聊天室申请 7. 2. 2 嘉微电子网 7. 3 建立免费讨论组 第八章:免费网站访问计数器介绍 如何请求一个免费的 网站 访问计数器。一旦有人浏览了用户的网站,网站 上配置的计数器会自动加1,这样就很容易知道你的网站 是如何被访问的。

8.1 柜台工作原理 8.2 在哪里申请 8.3 两到三个应用示例 8.4 将柜台添加到首页 第9章:免费网站访问访客留言簿 说明如何申请免费访客留言簿。通过了解其他人对网站施工情况的看法,您可以更好地管理自己的网站。

9.1 申请位置 9.2 免费申请GuestWorld 9.2.1 申请步骤 9.2.2 将留言簿添加到主页 9.2.3 留言簿的使用 第10章:个人 网站 构建 描述如何在您自己的计算机中构建一个 网站 ,使其成为小型服务器。

10.1 为Windows95/98创建PWS 10.1.1 安装方法 10.1.2 设置方法 10.2 浏览你自己的网站 第11章:推广你自己的网站 你自己的网站登录到各种搜索引擎,以提高您的知名度并让其他人更顺利地找到您的 网站 11。

1 搜索引擎资源使用及注意事项 11.1.1 搜索引擎基本原理 11.1.2 注册网站技巧 11.1.3 列表管理 11.2 免费登录搜狐网站 11.3 免费登录新浪网站@ > 11。

4 免费登陆中国雅虎网站 不说很复杂的流程,大致如下: 1、如果你有自己的域名,可以申请独立的,但是需要花钱买它。二级免费域名更适合个人网站用户,推荐。2、找一个合适的地方放置生成的网站的内容,也就是网页空间。大小可以根据自己的能力做。当然,也有免费的。对于动态脚本,你申请的空间也应该支持这个功能,比如空间支持asp\php\等。

3.最重要的还是自己设计网站好了,软件很多,推荐用photoshop制作图片,用它来制作你想要的各种图片,用它来保存框架。把它转换成jpg或者png格式,然后用photoshop的切片功能,根据你的需要对这张图片进行切片,也就是分割图片,稍后在那个部分写文字,在那个部分加上图片或者flash,这个阶段将花费更多时间,请仔细切片。

然后将剪切的图像保存为 html 格式。4、打开dreamweaver,创建一个站点,图片和网页的内容指向你创建的文件夹,所有用到的素材网页都应该放在这个文件夹中。使用dw打开用potoshop剪切的html框架,编辑添加元素,dw教程的地方很多,可以参考以下。

5.使用ftp将站点文件夹上传到空间。这是一般的过程。软件的使用可以参考很多教程,但不要找。事实上,软件的帮助是最好的教程。仔细阅读以下内容。要领一:确定网站的主题要做网站,首先要解决的是网站的内容,也就是确定网站的主题.

美国《个人电脑》杂志(PC Magazine)评选出1999年美国前100名知名网站的十类主题: 第一类:在线求职;第 2 类:在线聊天/即时信息/ICQ;第 3 类:在线社区/讨论/邮件列表;第 4 类:计算机技术;第 5 类:网页/网站开发;第 6 类:娱乐网站 ;类别 7:旅行;第 8 类:参考/信息;第 9 类:家庭/教育;第 10 类:生活/时尚。

我们可以参考上面的分类,继续细分。如果你对某些方面感兴趣,或者有更多的信息,你也可以做一些你感兴趣的东西。一、可以有自己的见解,做自己的特色;@> 时永远不要感到无聊或不知所措。

兴趣是制作网站的动力。没有创作热情,就很难设计出优秀的作品。内容选题要小而精,题目定位要小,内容要精。不要试图做一个包罗万象的网站,这样往往会失去网站的本色,同时也会带来高强度的劳动,难以及时更新网站。

记住:互联网上只有第一,没有第二!要领2:选择一个好的域名域名是互联网上的网站的名字。一个不是产品推广的纯信息服务网站,其建设的所有价值都凝聚在它的网站域名上。没有这个域名,所有的前期工作都将付诸东流。

目前很多个人网站的人都依赖免费的个人空间,他们的域名也依赖免费的域名,比如网易的虚拟域名服务。其实这对于个人网站的推广和发展是非常不利的,不仅是它“适时”打开的窗口,阻碍了观看者的视线和好感,让人一眼就知道是个人网站,也阻碍了网页的传输速度。

所以,从我个人的角度来说,先花点钱注册一个域名。独立域名是个人网站的第一财富。域名要形象化、简单易记。要点三:掌握网络建设工具网络技术的发展带动了软件行业的发展,因此用于制作网页的工具和软件也越来越丰富。

从最基本的 HTML 编辑器到非常流行的 Flash 交互式网页制作工具,各种网页制作工具,以下是几款具有代表性的网页制作工具:(1)HTML 编辑器。虽然 HTML 代码复杂,需要经过大量的时间编辑和调试,它仍然因其稳定性、广泛的支持和创建复杂页面效果的能力而受到高级Web开发人员的青睐。

目前,有很多编辑器可供选择。这些编辑器广泛支持复杂的页面创建和高级 HTML 规范。Hotdog 等专业的 HTML 编辑器更常用。(2)WYSIWYG网页编辑器。微软Frontpage为代表,操作界面与Word相同,熟悉Word功能的操作人员稍加培训即可轻松编译网页。

此外,Frontpage 还可以解析网页的 HTML 源代码并提供预览支持。但是Frontpage的一些特殊显示功能在其他非IE浏览器下是无法实现的。所以Frontpage是一款非常适合初学者和中级网页制作者的工具软件。

(3)现在非常流行的Flash交互网页制作工具。这是一个非常强大的交互式矢量多媒体网页制作工具。可以轻松输出各种动画网页,不需要特别复杂的操作就是也比JAVA更小更强大!但它的动画效果、交互效果和多媒体效果都非常出色。

并且还可以在Flash动画中封装Mp3音乐,填写表格等;并且由于Flash编译出来的网页文件比普通网页文件小很多,浏览速度大大加快。这是一个非常适合动态网页制作的工具。另外,个人网站制作者也需要了解W3C的HTML4。

0规范,CSS级联样式表基础知识,javascript基础知识,VBScript。需要对ASP、CGI、PHP等一些常用的脚本程序有适当的了解,并能熟练使用图形处理工具、动画制作工具和矢量图绘制工具,能够部分了解基本的使用方法。各种图形和图像动画工具,并熟练使用。还需要 FTP 工具和软件、硬件和网络知识。

当然,互联网也是一个免费的知识库。网页的准备需要各种按钮、背景以及各种图形和图片。如果这一切都由自己完成,那就是浪费时间和金钱,而且还需要强大的图形和图片制作技术。所以,为了省去这些烦恼,网站制作者可以从网上下载各种漂亮实用的图片、按钮、背景等网页素材。

要点四:确定网站界面 界面是网站对观看者的第一印象,往往决定了网站的可见度。确定网站的接口时要注意以下三点: ①列和节 安排和构造一个网站就像写一篇论文。首先,一定要列出题目的大纲,使主题和层次清晰。

网站施工初学者最常犯的错误是确定主题后立即开始制作,没有制定合理的计划。结果网站结构不清晰,目录复杂混乱,版面布局混乱。结果,不仅观众一头雾水,制作人也很难扩展和维护网站。

因此,在开始制作网页之前,我们必须考虑列和部分的排列。网站的标的物确定后,需要对采集的数据进行合理的安排。例如,将一些最吸引人的内容放在最显眼的位置或主导布局。

列的本质是网站的大纲索引,索引要清晰显示网站的主体。制定栏目时,应慎重考虑,合理安排。排列栏目时应注意: ●尽可能删除与主题无关的栏目;●在栏目上尽可能列出网站中最有价值的内容;●尽可能从访问者的角度安排栏目,以方便访问者的浏览和查询;辅助内容,如网站介绍、版权信息、个人信息等,不需要放在主栏,以免淡化主题。

此外,版块的布局和设置也要合理安排和划分。节比列的概念大,每个节都有自己的列。例如,ENET Silicon Valley Power( )网站分为新闻、产品、游戏、学院等板块,每个板块都有自己的主栏目。

一般来说,个人网站的内容比较少,只要分栏,就不用设置栏目了。如果需要设置版块,应注意: ● 各版块要相对独立;● 各部分应相互关联;● 各栏目内容应围绕网站主题;指创建 网站 时创建的目录。

例如,使用 Frontpage 创建 网站 时,默认会创建根目录和 Images 子目录。目录的结构是一个容易被忽略的问题,大部分站长在没有规划的情况下随意创建子目录。目录结构的好坏对浏览器没有太大的感觉,但对网站本身的维护,以及日后内容的扩展和移植都有重要的影响。

因此,在建立目录结构时,应谨慎安排,例如: ● 不要将所有文件都存放在根目录下。有 网站 生产者为了方便将所有文件放在根目录下。这样容易造成:文件管理混乱,不清楚哪些文件需要编辑更新,哪些无用文件可以删除,哪些是相关文件,影响工作效率;上传速度慢,服务器一般会为根目录创建根目录。对于一个文件索引,如果所有文件都放在根目录下,即使只上传更新了一个文件,服务器也需要重新检索所有文件并创建一个新的索引文件。显然,文件数量越大,等待时间越长。也会更长。

●根据栏目内容创建子目录。要创建子目录,首先根据主列创建。友情链接很多,需要经常更新的可以建立独立的子目录。一些相关性高、不需要经常更新的栏目,比如:网站简介、站长状态等,可以组合起来放在一个统一的目录下。

所有程序一般都存放在一个特定的目录下,例如:CGI程序放在cgi-bin目录下,所有提供下载的内容也应该放在一个目录下,便于维护和管理。●在每个主目录下建立一个单独的Images目录。一般来说,站点根目录有一个默认的图像目录。

把所有的图片都存放在这个目录下很不方便。比如当栏目被删除的时候,图片的管理就比较麻烦了。因此,为每个主列管理一个独立的Images目录很方便。原因很简单,就是方便维护和管理。其他需要注意的是:目录的层级不能太深,不超过3层;不要使用中文目录,使用中文目录可能会导致URL的正确显示困难;不要使用太长的目录,太长的目录名不方便记忆;尝试使用有意义的目录以便于记忆和管理。

网站的链接结构是指页面间链接的拓扑结构。它建立在目录结构之上,但可以跨越目录。形象地说:每个页面都是一个固定点,一个链接就是两个固定点之间的连接。一个点可以连接到一个点,也可以连接到多个点。

更重要的是,这些点并不是分布在一个平面上,而是存在于一个立体空间中。一般网站的链接结构建立有两种基本方式: ●树状链接结构(一对一),类似于DOS目录结构,首页链接指向一级页面,一级页面链接 指向二级页面。

用这样的链接结构浏览时,一级进一级出,组织结构比较清晰,访问者清楚地知道自己在哪里,不会“不知道自己在哪里”,而是浏览效率低,一个栏目下的小节 如果页面转到另一个栏目下的子页面,你必须回到首页再做一次。●星型链接结构(一对多),类似于网络服务器的链接,每个页面都有相互链接。

这样浏览起来更方便,随时可以到达自己喜欢的页面。但是,由于链接太多,浏览器很容易迷失方向,不知道它们在哪里,读了多少内容。因此,在实际的 网站 设计中,这两种结构总是结合使用。网站希望浏览者能够方便快捷地到达自己需要的页面,并且能够清楚的知道自己的位置。

因此,最好的方法是在首页和一级页面之间采用星形链接结构,在一级和二级页面之间采用树状链接结构。链接结构的设计是实际网页制作中非常重要的一环。采用什么样的链接结构直接影响页面的布局。③形象设计网站的设计可以从以下几点入手: ●设计网站标志(LOGO)。

LOGO是指网站的标志,可以是中文、英文字母、符号、图案等。标志设计思路应来源于网站的名称和内容。比如网站中的代表性人物、动物、植物,可以作为设计的蓝图,进行卡通化或艺术化;专业网站可以标出该专业的代表项目。

最常见和最简单的方法是使用自己的网站英文名称作为标志。您可以使用不同的字体、字母变形和字母组合轻松制作自己的徽标。●设计网站颜色。网站第一印象来自视觉冲击。不同的颜色组合有不同的效果,可能会影响参观者的心情。

“标准色”是指能够体现网站形象和扩展内涵的颜色,用于网站的logo、标题、主菜单和主色块。给人一种整体统一的感觉。至于其他颜色,也可以使用,但只能作为点缀和衬托,切不可过于铺张。一般来说,一个网站的标准颜色不超过3种,太多让人眼花缭乱。

适合web标准色的颜色有:蓝、黄/橙、黑/灰/白三个系列色。●设计网站字体。与标准颜色一样,标准字体是指用于徽标、标题和主菜单的独特字体。一般网页的默认字体是Arial。为了体现网站的“与众不同”和独特的风格,您可以根据自己的需要选择一些特殊的字体。

制作者可以根据自己网站所表达的内涵,选择更合适的字体。需要注意的是,非默认字体的使用只能是图片的形式,因为很可能是浏览器没有在电脑中安装特殊字体,所以辛苦的设计和制作可能会白费。●设计网站标语。

也可以说是网站的精神、主题和中心,也可以说是网站的目标,可以用一句话或一个词来高度概括。用有力的词或词来总结网站,并进行外部宣传,可以收到更好的效果。要点五:确定网站风格 “风格”是抽象的,是指网站整体形象给浏览者的整体感觉。

这个“整体形象”包括网站的CI(logo、颜色、字体、标语)、布局、浏览方式、交互性、文字、色调、内容价值等诸多因素,网站可以平易近人,生动活泼也可以专业认真。无论是色彩、技术、文字、布局还是交互,只要你能清楚地告诉观众这是你独有的网站,这就形成了网站的“风格”。

风格是人性的,一个网站的个性可以通过网站的色彩、技术、文字、布局、交互来概括:是粗犷大胆,还是清新靓丽;无论是温柔儒雅,还是执着热情;是活泼多变,还是墨守成规。总之,风格化的网站和普通的网站的区别在于:你在普通的网站上看到的只是信息堆积,只能用理性的感觉来描述,比如,信息量、浏览速度等;在样式化的网站上,你可以得到内容以外更多的感性认识,比如网站的品味、对观众的态度等。

在明确了你想给人什么样的印象之后,你需要在网站中找到最有特色的东西,也就是最能体现网站风格的东西。并将其作为网站的特色,重点加强宣传。总之,风格的形成不是一次性的定位,可以在实践中不断加强、调整和提高。

要点六:创意内容选择 好的内容选择需要好的创意。作为网页设计师,最头疼的就是没有好的内容创意。互联网上最具创意的创意来自于虚拟与现实的结合。创意的目的是为了更好的宣传和推广网站。如果这个想法不错,但对网站的发展毫无意义,那么网站的设计者也应该放弃这个想法。

另外,首页的内容是网站的根。如果内容是空的,那么页面做的再漂亮,用户也不会很多。从根本上说,网站内容仍然控制着网站的流量,内容为王(Content Is King)仍然是个人网站成功的关键。

要点七:推广自己的网站网站的营销推广在个人网站的运营中也起着重要的作用。在推广个人网站之前,请确保您已做好以下工作: 网站信息丰富、准确、及时;网站技术有一定的专业水平,网站的互动表现不错。

一般来说,推广网站有以下几种方式:(1)搜索引擎注册和搜索目录登录技巧注册知名搜索引擎网站是技术推广的第一方法网站第一步。注册搜索引擎有一定的技巧,比如AltaVista,搜索引擎等搜索引擎,它会自动收录提交的URL。

另外要注意Meta的使用,不要提交有栏目的frame页面,大部分搜索引擎不识别Frame,所以一定要提交有内容的Main页面。但是,雅虎、搜狐等搜索目录网站使用手动的方式对收录的URL进行检查,以保证收录网站的质量,分类查询时得到的信息更具有相关性比搜索引擎。网站(由 Spider 自动搜索)更强大。

由于搜索目录网站收录网站的人为因素比较多,所以提交网站时一定要遵守规则。例如,雅虎要求注册的网站描述不得超过 25 个字。这里注意:提交URL到最合适的目录,介绍网站要仔细详细,不要有任何虚假或夸大成分。

(2)广告交换技巧很多个别网站在相互交换广告时提出了几个条件:一是访问量相等;二是首页交换。显然,这种做法是为了充分利用广告交换。在很多个人网站的经验中,与个人站点交换链接时,当对方将网站标志放在链接页而不是首页时,很少有访问者从那里来.

通常在首页上,广告交流会有很好的效果。(3)在使用邮件推广网址进行定向邮件推广时,主要技术如下:可以使用免费邮件列表进行,只要申请免费邮件列表服务,就可以使用邮件列表推广你的3)@网站;你可以通过采集到的特定邮箱地址向特定的网络群组发送信息,在特定的网络群组推广你自己的网站;发送HTML格式的邮件,甚至如果内容与收件人无关 大,不会立即作为垃圾邮件删除,人们至少会注意发件人的地址。

但是,在进行电子邮件促销时要注意在线道德。要点八:支持网站日常运营当个人网站达到一定的金钱水平时,金钱必须提上日程。一般来说,个人网站获得资金有以下两种方式: 渠道:(1)卖网站广告位卖网站广告位,一般来说,每天的流量网站 的次数少于 10,000 次目前不会吸引广告商。

网站的专业性和商业性、以往的广告经验、技术和设计要求等也会影响广告的销量。一般来说,WEB广告的收费方式有以下三种: ①CPM(Cost Per Million/千)投放广告,按每1000人访问该网站收费。

这种方法最适合网站运营商,只要有人浏览页面,他们就会得到报酬,而不管访问者是否响应广告——无论是看到还是点击广告。②点击通过(Click-through) 通过横幅广告点击到广告商的网站,这也算。广告商赞成这一点。他只为那些对他的广告感兴趣的人“赚钱”。

网站运营商不合适。根据一些调查数据,只有 3% 的访问者会去看“CLICK”广告。③ 佣金(Commission) 根据访问者点击您网站上的广告所带来的销售收入,与广告厂商分摊。对于网站的操作符来说,这种方法比上面两种更有效。冒险。

通常,单独的网站广告收费方式往往是一、第二种方式的组合,这样网站和广告主都可以承担更少的风险。(2)与大网站合作另外,通过与大网站合作获得资金,也可以维持个人网站的日常运营。然而,个人 网站 很容易成为企业的附属品 网站。

有了时间和充沛的精力,再加上新技术和技巧的学习和应用,您就可以在网上建立自己的家。. 收起来 查看全部

php 网页内容抓取(如果你的空间小的话你会后悔的,具体的做法)

2007-11-16

我想用一个属于网络中词的网站

如果你想买一个域名和空间,两者加起来至少要100多,主要是空间,一个域名CN就够了,空间贵,如果你的空间小,你会后悔的。至于具体方法,上面的人说了一点,还有一点就是---------网站是用以下工具制作的:网络三剑客指的是dreamweaver、web版面编辑等 flash:动画制作 firework:图像处理 GIF动画 如果你会做Photoshop,你就做不到这个也可以做一个好的,你需要一个空间(付费)空间。一般可以在网上公司购买(代理也在500元以内)。最好申请一个空间和一个域名。如果你的域名是 " 。那么就是空间的登录地址。这是 URL 。制作后,用FTP软件上传。域名是您可以访问您创建的 网站 的路径。在语言方面......所有

如果你想买一个域名和空间,两者加起来至少要100多,主要是空间,一个域名CN就够了,空间贵,如果你的空间小,你会后悔的。至于具体方法,上面的人说了一点,还有一点就是---------网站是用以下工具制作的:网络三剑客指的是dreamweaver、web版面编辑等 flash:动画制作 firework:图像处理 GIF动画 如果你会做Photoshop,你就做不到这个也可以做一个好的,你需要一个空间(付费)空间。一般可以在网上公司购买(代理也在500元以内)。最好申请空间和域名。如果您的域名是“.

那么空间的登录地址就是这个URL。制作完成后,用FTP软件上传。域名是可以访问你的网站的路径。在语言方面,asp、jsp、php几乎是一样的。用asp是最简单的,那两个就少了。基本上可以满足建站的要求。

但是,根据微软的指示,他们要求写得最好。第一章:免费个人网站基础知识初步介绍免费个人网站的建设内容,包括自由个人网站的基本组成部分,免费个人网站的基本构建个人的网站步骤和一些基础工具,让用户在构建网站之前有更深入的了解和准备。

1.1 初始识别网站 1.1. 1站、域名、浏览 1.1. 2网站优点和缺点 1.1。3 免费和付费的比较 1.1.4 免费网站 可行性分析 1. 2 制作网页和构建网站 的区别 1. 3 完全免费构建自己的网站 1.

3. 1 Personal 网站 1. 3. 2 Personal Free 构建基本步骤网站 1. 3. 3 Personal Free 构建工具介绍网站第二章:Free The 网站本书资源介绍本书搭建过程中申请的免费资源网站,以及申请时的注意事项。

2.1网站资源描述与分类 2.2免费网站需要申请的资源 2.3 申请网站资源的规则 第三章:申请免费邮箱介绍如何申请免费电子邮件。因为在申请各种在线免费资源时,E-mail账号是必不可少的,所以您首先必须拥有自己的免费E-mail账号。

同时,本章简要介绍了如何使用一些免费的电子邮件帐户。3.1 初步免费电子邮件 3.1.1 电子邮件的概念 3.1.2 免费电子邮件的优点 3.1.3 申请电子邮件的注意事项 3.

1.4 可申请的免费邮箱 3.2 申请263免费邮箱 3.2.1 申请步骤说明 3.2.2 登录方式 3.2.3 撰写、阅读和发送邮件 3.2.4 进行邮件管理 3.

3 申请Hotmail免费邮箱账号 3.3.1 申请步骤 3.3.2 登录方式 3.3.3 撰写、阅读和发送邮件 3.3.4 管理邮件 3.4 申请126免费转发邮箱 3.

4.1 转发邮件的优势 3.4.2 申请步骤说明 3.4.3 收发信的方法 第4章:申请免费网站空间描述了如何申请免费网站空间。该空间主要用于存放已完成的网页。申请后,用户可以获得一个网站,这意味着他们在互联网上拥有了自己的“家”。

4.1 免费网页空间基本知识 4.1.1 免费网页概述 4.1.2 申请免费网页注意事项 4.1.3 可申请免费网页网址列表 4.2 申请网易免费网页 4.2.1 网易免费网页的特点4.

2.2 申请步骤 4.2.3 姓名网站 4.3 申请广州168免费网站 4.4 申请中国街免费网站 第五章:文件传输 介绍如何将完成的网页上传到互联网。主要介绍使用CuteFTP完成文件传输的方法。

5.1 上传网页 5.1.1 文件传输基础知识 5.1.2 如何使用CuteFTP 5.1.3 使用FTP软件的注意事项 5.2 网页恢复功能 第6章:URL服务介绍如何申请免费的URL服务。

在第 4 章介绍的网页空间中,网址通常很长,不方便记忆。这时候可以使用网址服务来缩短网址,让主页更容易连接。6.1 Web 服务 6.1.1 Web 服务的概念 6.1.2 可用的 Web 服务 网站List 6.

2 网站 6.2.1 如何申请 6.2.2 如何使用 第7章:免费BBS、讨论组和聊天室介绍如何建立自己的聊天室和论坛,让您畅所欲言。7.1 免费BBS7申请须知。

2 免费聊天室申请说明 7. 2. 1 “网大”聊天室申请 7. 2. 2 嘉微电子网 7. 3 建立免费讨论组 第八章:免费网站访问计数器介绍 如何请求一个免费的 网站 访问计数器。一旦有人浏览了用户的网站,网站 上配置的计数器会自动加1,这样就很容易知道你的网站 是如何被访问的。

8.1 柜台工作原理 8.2 在哪里申请 8.3 两到三个应用示例 8.4 将柜台添加到首页 第9章:免费网站访问访客留言簿 说明如何申请免费访客留言簿。通过了解其他人对网站施工情况的看法,您可以更好地管理自己的网站。

9.1 申请位置 9.2 免费申请GuestWorld 9.2.1 申请步骤 9.2.2 将留言簿添加到主页 9.2.3 留言簿的使用 第10章:个人 网站 构建 描述如何在您自己的计算机中构建一个 网站 ,使其成为小型服务器。

10.1 为Windows95/98创建PWS 10.1.1 安装方法 10.1.2 设置方法 10.2 浏览你自己的网站 第11章:推广你自己的网站 你自己的网站登录到各种搜索引擎,以提高您的知名度并让其他人更顺利地找到您的 网站 11。

1 搜索引擎资源使用及注意事项 11.1.1 搜索引擎基本原理 11.1.2 注册网站技巧 11.1.3 列表管理 11.2 免费登录搜狐网站 11.3 免费登录新浪网站@ > 11。

4 免费登陆中国雅虎网站 不说很复杂的流程,大致如下: 1、如果你有自己的域名,可以申请独立的,但是需要花钱买它。二级免费域名更适合个人网站用户,推荐。2、找一个合适的地方放置生成的网站的内容,也就是网页空间。大小可以根据自己的能力做。当然,也有免费的。对于动态脚本,你申请的空间也应该支持这个功能,比如空间支持asp\php\等。

3.最重要的还是自己设计网站好了,软件很多,推荐用photoshop制作图片,用它来制作你想要的各种图片,用它来保存框架。把它转换成jpg或者png格式,然后用photoshop的切片功能,根据你的需要对这张图片进行切片,也就是分割图片,稍后在那个部分写文字,在那个部分加上图片或者flash,这个阶段将花费更多时间,请仔细切片。

然后将剪切的图像保存为 html 格式。4、打开dreamweaver,创建一个站点,图片和网页的内容指向你创建的文件夹,所有用到的素材网页都应该放在这个文件夹中。使用dw打开用potoshop剪切的html框架,编辑添加元素,dw教程的地方很多,可以参考以下。

5.使用ftp将站点文件夹上传到空间。这是一般的过程。软件的使用可以参考很多教程,但不要找。事实上,软件的帮助是最好的教程。仔细阅读以下内容。要领一:确定网站的主题要做网站,首先要解决的是网站的内容,也就是确定网站的主题.

美国《个人电脑》杂志(PC Magazine)评选出1999年美国前100名知名网站的十类主题: 第一类:在线求职;第 2 类:在线聊天/即时信息/ICQ;第 3 类:在线社区/讨论/邮件列表;第 4 类:计算机技术;第 5 类:网页/网站开发;第 6 类:娱乐网站 ;类别 7:旅行;第 8 类:参考/信息;第 9 类:家庭/教育;第 10 类:生活/时尚。

我们可以参考上面的分类,继续细分。如果你对某些方面感兴趣,或者有更多的信息,你也可以做一些你感兴趣的东西。一、可以有自己的见解,做自己的特色;@> 时永远不要感到无聊或不知所措。

兴趣是制作网站的动力。没有创作热情,就很难设计出优秀的作品。内容选题要小而精,题目定位要小,内容要精。不要试图做一个包罗万象的网站,这样往往会失去网站的本色,同时也会带来高强度的劳动,难以及时更新网站。

记住:互联网上只有第一,没有第二!要领2:选择一个好的域名域名是互联网上的网站的名字。一个不是产品推广的纯信息服务网站,其建设的所有价值都凝聚在它的网站域名上。没有这个域名,所有的前期工作都将付诸东流。

目前很多个人网站的人都依赖免费的个人空间,他们的域名也依赖免费的域名,比如网易的虚拟域名服务。其实这对于个人网站的推广和发展是非常不利的,不仅是它“适时”打开的窗口,阻碍了观看者的视线和好感,让人一眼就知道是个人网站,也阻碍了网页的传输速度。

所以,从我个人的角度来说,先花点钱注册一个域名。独立域名是个人网站的第一财富。域名要形象化、简单易记。要点三:掌握网络建设工具网络技术的发展带动了软件行业的发展,因此用于制作网页的工具和软件也越来越丰富。

从最基本的 HTML 编辑器到非常流行的 Flash 交互式网页制作工具,各种网页制作工具,以下是几款具有代表性的网页制作工具:(1)HTML 编辑器。虽然 HTML 代码复杂,需要经过大量的时间编辑和调试,它仍然因其稳定性、广泛的支持和创建复杂页面效果的能力而受到高级Web开发人员的青睐。

目前,有很多编辑器可供选择。这些编辑器广泛支持复杂的页面创建和高级 HTML 规范。Hotdog 等专业的 HTML 编辑器更常用。(2)WYSIWYG网页编辑器。微软Frontpage为代表,操作界面与Word相同,熟悉Word功能的操作人员稍加培训即可轻松编译网页。

此外,Frontpage 还可以解析网页的 HTML 源代码并提供预览支持。但是Frontpage的一些特殊显示功能在其他非IE浏览器下是无法实现的。所以Frontpage是一款非常适合初学者和中级网页制作者的工具软件。

(3)现在非常流行的Flash交互网页制作工具。这是一个非常强大的交互式矢量多媒体网页制作工具。可以轻松输出各种动画网页,不需要特别复杂的操作就是也比JAVA更小更强大!但它的动画效果、交互效果和多媒体效果都非常出色。

并且还可以在Flash动画中封装Mp3音乐,填写表格等;并且由于Flash编译出来的网页文件比普通网页文件小很多,浏览速度大大加快。这是一个非常适合动态网页制作的工具。另外,个人网站制作者也需要了解W3C的HTML4。

0规范,CSS级联样式表基础知识,javascript基础知识,VBScript。需要对ASP、CGI、PHP等一些常用的脚本程序有适当的了解,并能熟练使用图形处理工具、动画制作工具和矢量图绘制工具,能够部分了解基本的使用方法。各种图形和图像动画工具,并熟练使用。还需要 FTP 工具和软件、硬件和网络知识。

当然,互联网也是一个免费的知识库。网页的准备需要各种按钮、背景以及各种图形和图片。如果这一切都由自己完成,那就是浪费时间和金钱,而且还需要强大的图形和图片制作技术。所以,为了省去这些烦恼,网站制作者可以从网上下载各种漂亮实用的图片、按钮、背景等网页素材。

要点四:确定网站界面 界面是网站对观看者的第一印象,往往决定了网站的可见度。确定网站的接口时要注意以下三点: ①列和节 安排和构造一个网站就像写一篇论文。首先,一定要列出题目的大纲,使主题和层次清晰。

网站施工初学者最常犯的错误是确定主题后立即开始制作,没有制定合理的计划。结果网站结构不清晰,目录复杂混乱,版面布局混乱。结果,不仅观众一头雾水,制作人也很难扩展和维护网站。

因此,在开始制作网页之前,我们必须考虑列和部分的排列。网站的标的物确定后,需要对采集的数据进行合理的安排。例如,将一些最吸引人的内容放在最显眼的位置或主导布局。

列的本质是网站的大纲索引,索引要清晰显示网站的主体。制定栏目时,应慎重考虑,合理安排。排列栏目时应注意: ●尽可能删除与主题无关的栏目;●在栏目上尽可能列出网站中最有价值的内容;●尽可能从访问者的角度安排栏目,以方便访问者的浏览和查询;辅助内容,如网站介绍、版权信息、个人信息等,不需要放在主栏,以免淡化主题。

此外,版块的布局和设置也要合理安排和划分。节比列的概念大,每个节都有自己的列。例如,ENET Silicon Valley Power( )网站分为新闻、产品、游戏、学院等板块,每个板块都有自己的主栏目。

一般来说,个人网站的内容比较少,只要分栏,就不用设置栏目了。如果需要设置版块,应注意: ● 各版块要相对独立;● 各部分应相互关联;● 各栏目内容应围绕网站主题;指创建 网站 时创建的目录。

例如,使用 Frontpage 创建 网站 时,默认会创建根目录和 Images 子目录。目录的结构是一个容易被忽略的问题,大部分站长在没有规划的情况下随意创建子目录。目录结构的好坏对浏览器没有太大的感觉,但对网站本身的维护,以及日后内容的扩展和移植都有重要的影响。

因此,在建立目录结构时,应谨慎安排,例如: ● 不要将所有文件都存放在根目录下。有 网站 生产者为了方便将所有文件放在根目录下。这样容易造成:文件管理混乱,不清楚哪些文件需要编辑更新,哪些无用文件可以删除,哪些是相关文件,影响工作效率;上传速度慢,服务器一般会为根目录创建根目录。对于一个文件索引,如果所有文件都放在根目录下,即使只上传更新了一个文件,服务器也需要重新检索所有文件并创建一个新的索引文件。显然,文件数量越大,等待时间越长。也会更长。

●根据栏目内容创建子目录。要创建子目录,首先根据主列创建。友情链接很多,需要经常更新的可以建立独立的子目录。一些相关性高、不需要经常更新的栏目,比如:网站简介、站长状态等,可以组合起来放在一个统一的目录下。

所有程序一般都存放在一个特定的目录下,例如:CGI程序放在cgi-bin目录下,所有提供下载的内容也应该放在一个目录下,便于维护和管理。●在每个主目录下建立一个单独的Images目录。一般来说,站点根目录有一个默认的图像目录。

把所有的图片都存放在这个目录下很不方便。比如当栏目被删除的时候,图片的管理就比较麻烦了。因此,为每个主列管理一个独立的Images目录很方便。原因很简单,就是方便维护和管理。其他需要注意的是:目录的层级不能太深,不超过3层;不要使用中文目录,使用中文目录可能会导致URL的正确显示困难;不要使用太长的目录,太长的目录名不方便记忆;尝试使用有意义的目录以便于记忆和管理。

网站的链接结构是指页面间链接的拓扑结构。它建立在目录结构之上,但可以跨越目录。形象地说:每个页面都是一个固定点,一个链接就是两个固定点之间的连接。一个点可以连接到一个点,也可以连接到多个点。

更重要的是,这些点并不是分布在一个平面上,而是存在于一个立体空间中。一般网站的链接结构建立有两种基本方式: ●树状链接结构(一对一),类似于DOS目录结构,首页链接指向一级页面,一级页面链接 指向二级页面。

用这样的链接结构浏览时,一级进一级出,组织结构比较清晰,访问者清楚地知道自己在哪里,不会“不知道自己在哪里”,而是浏览效率低,一个栏目下的小节 如果页面转到另一个栏目下的子页面,你必须回到首页再做一次。●星型链接结构(一对多),类似于网络服务器的链接,每个页面都有相互链接。

这样浏览起来更方便,随时可以到达自己喜欢的页面。但是,由于链接太多,浏览器很容易迷失方向,不知道它们在哪里,读了多少内容。因此,在实际的 网站 设计中,这两种结构总是结合使用。网站希望浏览者能够方便快捷地到达自己需要的页面,并且能够清楚的知道自己的位置。

因此,最好的方法是在首页和一级页面之间采用星形链接结构,在一级和二级页面之间采用树状链接结构。链接结构的设计是实际网页制作中非常重要的一环。采用什么样的链接结构直接影响页面的布局。③形象设计网站的设计可以从以下几点入手: ●设计网站标志(LOGO)。

LOGO是指网站的标志,可以是中文、英文字母、符号、图案等。标志设计思路应来源于网站的名称和内容。比如网站中的代表性人物、动物、植物,可以作为设计的蓝图,进行卡通化或艺术化;专业网站可以标出该专业的代表项目。

最常见和最简单的方法是使用自己的网站英文名称作为标志。您可以使用不同的字体、字母变形和字母组合轻松制作自己的徽标。●设计网站颜色。网站第一印象来自视觉冲击。不同的颜色组合有不同的效果,可能会影响参观者的心情。

“标准色”是指能够体现网站形象和扩展内涵的颜色,用于网站的logo、标题、主菜单和主色块。给人一种整体统一的感觉。至于其他颜色,也可以使用,但只能作为点缀和衬托,切不可过于铺张。一般来说,一个网站的标准颜色不超过3种,太多让人眼花缭乱。

适合web标准色的颜色有:蓝、黄/橙、黑/灰/白三个系列色。●设计网站字体。与标准颜色一样,标准字体是指用于徽标、标题和主菜单的独特字体。一般网页的默认字体是Arial。为了体现网站的“与众不同”和独特的风格,您可以根据自己的需要选择一些特殊的字体。

制作者可以根据自己网站所表达的内涵,选择更合适的字体。需要注意的是,非默认字体的使用只能是图片的形式,因为很可能是浏览器没有在电脑中安装特殊字体,所以辛苦的设计和制作可能会白费。●设计网站标语。

也可以说是网站的精神、主题和中心,也可以说是网站的目标,可以用一句话或一个词来高度概括。用有力的词或词来总结网站,并进行外部宣传,可以收到更好的效果。要点五:确定网站风格 “风格”是抽象的,是指网站整体形象给浏览者的整体感觉。

这个“整体形象”包括网站的CI(logo、颜色、字体、标语)、布局、浏览方式、交互性、文字、色调、内容价值等诸多因素,网站可以平易近人,生动活泼也可以专业认真。无论是色彩、技术、文字、布局还是交互,只要你能清楚地告诉观众这是你独有的网站,这就形成了网站的“风格”。

风格是人性的,一个网站的个性可以通过网站的色彩、技术、文字、布局、交互来概括:是粗犷大胆,还是清新靓丽;无论是温柔儒雅,还是执着热情;是活泼多变,还是墨守成规。总之,风格化的网站和普通的网站的区别在于:你在普通的网站上看到的只是信息堆积,只能用理性的感觉来描述,比如,信息量、浏览速度等;在样式化的网站上,你可以得到内容以外更多的感性认识,比如网站的品味、对观众的态度等。

在明确了你想给人什么样的印象之后,你需要在网站中找到最有特色的东西,也就是最能体现网站风格的东西。并将其作为网站的特色,重点加强宣传。总之,风格的形成不是一次性的定位,可以在实践中不断加强、调整和提高。

要点六:创意内容选择 好的内容选择需要好的创意。作为网页设计师,最头疼的就是没有好的内容创意。互联网上最具创意的创意来自于虚拟与现实的结合。创意的目的是为了更好的宣传和推广网站。如果这个想法不错,但对网站的发展毫无意义,那么网站的设计者也应该放弃这个想法。

另外,首页的内容是网站的根。如果内容是空的,那么页面做的再漂亮,用户也不会很多。从根本上说,网站内容仍然控制着网站的流量,内容为王(Content Is King)仍然是个人网站成功的关键。

要点七:推广自己的网站网站的营销推广在个人网站的运营中也起着重要的作用。在推广个人网站之前,请确保您已做好以下工作: 网站信息丰富、准确、及时;网站技术有一定的专业水平,网站的互动表现不错。

一般来说,推广网站有以下几种方式:(1)搜索引擎注册和搜索目录登录技巧注册知名搜索引擎网站是技术推广的第一方法网站第一步。注册搜索引擎有一定的技巧,比如AltaVista,搜索引擎等搜索引擎,它会自动收录提交的URL。

另外要注意Meta的使用,不要提交有栏目的frame页面,大部分搜索引擎不识别Frame,所以一定要提交有内容的Main页面。但是,雅虎、搜狐等搜索目录网站使用手动的方式对收录的URL进行检查,以保证收录网站的质量,分类查询时得到的信息更具有相关性比搜索引擎。网站(由 Spider 自动搜索)更强大。

由于搜索目录网站收录网站的人为因素比较多,所以提交网站时一定要遵守规则。例如,雅虎要求注册的网站描述不得超过 25 个字。这里注意:提交URL到最合适的目录,介绍网站要仔细详细,不要有任何虚假或夸大成分。

(2)广告交换技巧很多个别网站在相互交换广告时提出了几个条件:一是访问量相等;二是首页交换。显然,这种做法是为了充分利用广告交换。在很多个人网站的经验中,与个人站点交换链接时,当对方将网站标志放在链接页而不是首页时,很少有访问者从那里来.

通常在首页上,广告交流会有很好的效果。(3)在使用邮件推广网址进行定向邮件推广时,主要技术如下:可以使用免费邮件列表进行,只要申请免费邮件列表服务,就可以使用邮件列表推广你的3)@网站;你可以通过采集到的特定邮箱地址向特定的网络群组发送信息,在特定的网络群组推广你自己的网站;发送HTML格式的邮件,甚至如果内容与收件人无关 大,不会立即作为垃圾邮件删除,人们至少会注意发件人的地址。

但是,在进行电子邮件促销时要注意在线道德。要点八:支持网站日常运营当个人网站达到一定的金钱水平时,金钱必须提上日程。一般来说,个人网站获得资金有以下两种方式: 渠道:(1)卖网站广告位卖网站广告位,一般来说,每天的流量网站 的次数少于 10,000 次目前不会吸引广告商。

网站的专业性和商业性、以往的广告经验、技术和设计要求等也会影响广告的销量。一般来说,WEB广告的收费方式有以下三种: ①CPM(Cost Per Million/千)投放广告,按每1000人访问该网站收费。

这种方法最适合网站运营商,只要有人浏览页面,他们就会得到报酬,而不管访问者是否响应广告——无论是看到还是点击广告。②点击通过(Click-through) 通过横幅广告点击到广告商的网站,这也算。广告商赞成这一点。他只为那些对他的广告感兴趣的人“赚钱”。

网站运营商不合适。根据一些调查数据,只有 3% 的访问者会去看“CLICK”广告。③ 佣金(Commission) 根据访问者点击您网站上的广告所带来的销售收入,与广告厂商分摊。对于网站的操作符来说,这种方法比上面两种更有效。冒险。

通常,单独的网站广告收费方式往往是一、第二种方式的组合,这样网站和广告主都可以承担更少的风险。(2)与大网站合作另外,通过与大网站合作获得资金,也可以维持个人网站的日常运营。然而,个人 网站 很容易成为企业的附属品 网站。

有了时间和充沛的精力,再加上新技术和技巧的学习和应用,您就可以在网上建立自己的家。. 收起来

php 网页内容抓取(搜索引擎的蜘蛛真的会像蜘蛛一样吗?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 65 次浏览 • 2022-03-17 15:29

在日常的SEO优化中,我们会关注收录,而收录的前提是搜索引擎蜘蛛爬取你的网站,那么这里的蜘蛛是什么?搜索引擎蜘蛛真的像蜘蛛吗?

学过SEO的同学都知道蜘蛛有两种爬行方式:深度和广度,也叫水平爬行和垂直爬行,那么这种蜘蛛是怎么工作的呢?是爬完第一页再爬第二页吗?第二页是哪里来的?

如果你真的想了解这方面,你必须了解程序。作为一名合格的SEO,程序设计是你的必修课。现在涉及到程序,数据库和编程语言是不可避免的。以 PHP 为例,有一个名为 file_get_contents 的函数。该函数的作用是获取URL中的内容并以文本形式返回结果。当然,也可以使用 CURL。

然后,就可以在程序中使用正则表达式对A所链接的数据进行提取、合并、去重等复杂操作,并将数据存入数据库。数据库有很多,比如:索引库、收录库等等。为什么索引与收录的个数不一致?当然是因为它们不在同一个库中。

当上述操作完成爬取数据后,自然会获取到数据库中不存在的链接,然后程序再发出指令去爬取这些库中不存在的URL。直到所有页面都被爬取。当然,更有可能是爬完之后就不再爬了。

百度站长平台会有抓取频率和抓取时间的数据。你应该可以看到每一个蜘蛛爬行都是不规则的,但是通过日常观察可以发现,页面越深,被抓到的概率越低。原因很简单,蜘蛛不会一直在您的网站周围爬行网站,而是每隔一段时间随机爬行。

也就是说,搜索引擎的蜘蛛抓取具有随机性和时效性,而我们SEO的目的是尽快完成页面和内容的呈现,尤其是我们认为有价值的内容。那么它会演变成,如何在有限的蜘蛛抓取中展示更多的内容呢?当然是尽量减少页面的深度,增加页面的宽度。《SEO实战密码》中有针对页面深度的优化方法,这里就不过多描述了。如果需要,可以搜索电子书。当然,建议拥有一个。 查看全部

php 网页内容抓取(搜索引擎的蜘蛛真的会像蜘蛛一样吗?(图))

在日常的SEO优化中,我们会关注收录,而收录的前提是搜索引擎蜘蛛爬取你的网站,那么这里的蜘蛛是什么?搜索引擎蜘蛛真的像蜘蛛吗?

学过SEO的同学都知道蜘蛛有两种爬行方式:深度和广度,也叫水平爬行和垂直爬行,那么这种蜘蛛是怎么工作的呢?是爬完第一页再爬第二页吗?第二页是哪里来的?

如果你真的想了解这方面,你必须了解程序。作为一名合格的SEO,程序设计是你的必修课。现在涉及到程序,数据库和编程语言是不可避免的。以 PHP 为例,有一个名为 file_get_contents 的函数。该函数的作用是获取URL中的内容并以文本形式返回结果。当然,也可以使用 CURL。

然后,就可以在程序中使用正则表达式对A所链接的数据进行提取、合并、去重等复杂操作,并将数据存入数据库。数据库有很多,比如:索引库、收录库等等。为什么索引与收录的个数不一致?当然是因为它们不在同一个库中。

当上述操作完成爬取数据后,自然会获取到数据库中不存在的链接,然后程序再发出指令去爬取这些库中不存在的URL。直到所有页面都被爬取。当然,更有可能是爬完之后就不再爬了。

百度站长平台会有抓取频率和抓取时间的数据。你应该可以看到每一个蜘蛛爬行都是不规则的,但是通过日常观察可以发现,页面越深,被抓到的概率越低。原因很简单,蜘蛛不会一直在您的网站周围爬行网站,而是每隔一段时间随机爬行。

也就是说,搜索引擎的蜘蛛抓取具有随机性和时效性,而我们SEO的目的是尽快完成页面和内容的呈现,尤其是我们认为有价值的内容。那么它会演变成,如何在有限的蜘蛛抓取中展示更多的内容呢?当然是尽量减少页面的深度,增加页面的宽度。《SEO实战密码》中有针对页面深度的优化方法,这里就不过多描述了。如果需要,可以搜索电子书。当然,建议拥有一个。

php 网页内容抓取( 各大多的网站采用Ajax技术解决方法放弃井号结构)

网站优化 • 优采云 发表了文章 • 0 个评论 • 194 次浏览 • 2022-03-14 17:21

各大多的网站采用Ajax技术解决方法放弃井号结构)

如何让搜索引擎抓取 AJAX 内容解决方案

更新时间:2014-08-25 11:51:39 发布者:hebedic

提到AJAX,很多人都会想到JavaScript。直到现在,各大搜索引擎如:JavaScript、ajax、flash 代码生成的内容都不能很好的抓取。但是很多站长喜欢这些效果,但是各大搜索引擎却不能很好的抓取这些代码生成的内容,所以很多站长放弃了这些效果。

越来越多的网站,开始使用“单页结构”(Single-page application)。

整个网站只有一个网页,它使用Ajax技术根据用户的输入加载不同的内容。

这种方式的好处是用户体验好,节省了流量。缺点是AJAX内容不能被搜索引擎抓取。例如,您有一个 网站。

http://example.com

用户通过英镑结构的 URL 看到不同的内容。

http://example.com#1 http://example.com#2 http://example.com#3

但是,搜索引擎只抓取和忽略主题标签,因此它们无法索引内容。

为了解决这个问题,谷歌想出了“哈希+感叹号”的结构。

http://example.com#!1

当 Google 找到上述网址时,它会自动抓取另一个网址:

http://example.com/?_escaped_fragment_=1

只要你把 AJAX 内容放在这个 URL 上,Google 就会收录。但问题是,“英镑+感叹号”非常丑陋和繁琐。Twitter曾经使用这种结构,它把

http://twitter.com/ruanyf

改成

http://twitter.com/#!/ruanyf

结果,用户投诉连连,仅半年就被废止。

那么,有没有什么方法可以让搜索引擎在抓取 AJAX 内容的同时保持更直观的 URL?

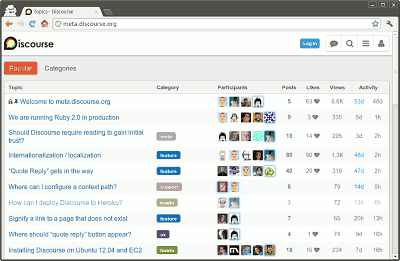

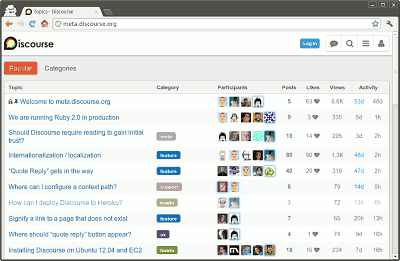

一直以为没有办法,直到看到 Discourse 创始人之一 Robin Ward 的解决方案,不禁为之惊叹。

Discourse 是一个严重依赖 Ajax 的论坛程序,但必须使用 Google收录 内容。它的解决方案是放弃英镑符号结构并使用 History API。

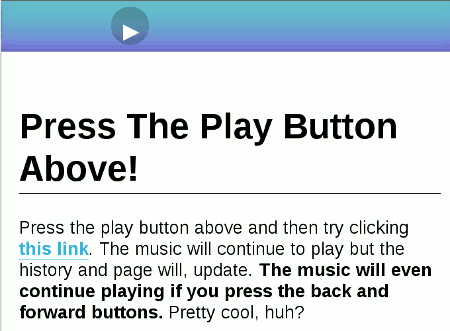

所谓History API,是指在不刷新页面的情况下,改变浏览器地址栏中显示的URL(准确的说是改变网页的当前状态)。这是一个示例,您单击上面的按钮开始播放音乐。然后,点击下面的链接看看发生了什么?

地址栏的网址变了,但音乐播放没有中断!

History API 的详细介绍超出了本文章 的范围。这里简单说一下,它的作用是在浏览器的History对象中添加一条记录。

window.history.pushState(state object, title, url);

上面这行命令可以使新的 URL 出现在地址栏中。History对象的pushState方法接受三个参数,新的URL是第三个参数,前两个参数可以为null。

window.history.pushState(null, null, newURL);

目前所有主流浏览器都支持这种方法:Chrome (26.0+), Firefox (20.0+), IE (10.0+), Safari (0.0+) @5.1+),歌剧 (12.1+)。

以下是罗宾·沃德 (Robin Ward) 的做法。

首先,用History API替换hashtag结构,让每个hashtag变成一个正常路径的URL,这样搜索引擎就会爬取每一个网页。

example.com/1 example.com/2 example.com/3

然后,定义一个处理 Ajax 部分并基于 URL 获取内容的 JavaScript 函数(假设是 jQuery)。

function anchorClick(link) {<br /> var linkSplit = link.split('/').pop();<br /> $.get('api/' + linkSplit, function(data) {<br /> $('#content').html(data);<br /> });<br /> }

再次定义鼠标点击事件。

$('#container').on('click', 'a', function(e) {<br /> window.history.pushState(null, null, $(this).attr('href'));<br /> anchorClick($(this).attr('href'));<br /> e.preventDefault();<br /> });

还要考虑到用户单击浏览器的“前进/后退”按钮。此时触发了History对象的popstate事件。

window.addEventListener('popstate', function(e) { <br /> anchorClick(location.pathname); <br /> });

定义好以上三段代码后,无需刷新页面即可显示正常的路径URL和AJAX内容。

最后,设置服务器端。

因为没有使用主题标签结构,所以每个 URL 都是不同的请求。因此,服务器需要为所有这些请求返回具有以下结构的网页,以防止 404 错误。