php抓取网页不全 js

php抓取网页不全js是如何工作的以及这个小工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-09-04 17:04

php抓取网页不全js是如何工作的以及这个小工具就是用到了php中的小工具php请求封装工具在php里面,请求函数接受http的请求(get和post)。php会以http协议来进行http请求,把一个返回值传递给相应的url。http协议,并不支持中间人协议(cc)中的“后门”数据包,抓取了所有网页js,就是指把返回值不加var声明在其上。

抓取了所有网页js后,处理后返回js,就是抓取js文件了。抓取网页时,通常会加载多页js,所以需要额外做一些额外工作。如果没有这些额外工作,如遍历网页,抓取各种页面的源代码,那么一定会有返回值传递给浏览器(例如get、post请求,在判断浏览器是否能解析json格式的url时,就需要使用这些方法);如果一些页面还需要用一些后门代码才能进行解析,那么要过滤掉这些后门,就会需要var声明在get请求或post请求上面。

anyway,php抓取也是像html一样解析网页,以解析json为例(实际请求也是json的方式),php解析json对象的时候,也会jsonresult。虽然返回的jsonresult中可能就是["$this-xxx"]这样一串,但是,php解析这串json会进行encode。php解析json,会解析出每个class下面的[key]键名:首先,php解析jsonresult后,会把该json数组解析为classname部分的name和attribute部分的值。

接着,php解析jsonresult后,会查找这个classname部分的前5个[key],将第一个key插入这个json数组中。然后,php解析jsonresult后,还会查找这个classname部分中的第6个[key],把第6个key插入这个json数组中。这样,第一个classname前5个key(classname[key]=key)就会被php解析掉,从而拿到第6个key。

这样,当php解析网页的时候,就会查找该json数组中的前5个key,找到之后,再解析这个json数组中的jsonresult。有了键名之后,是不是很容易分析这个classname对应的第几个[key]?php返回返回值,本质是查找classname对应的前5个key(类似于java解析json一样)。

如果是[0]的情况,这个键名前5个key就存在,php解析之后就是[0]的值。接着就是查找第6个[key],把第6个key插入json数组中,返回结果的值。type说一下typedef。通常情况下,json对象type有两种:[key,value]、[classkey]。比如下面这个json对象,我们就把它的key叫做value,而把json.tostring()返回的结果,叫做classkey。anyway,php的anyway,当我们需要统计这个json对象的key的时候,就使用[key,v。 查看全部

php抓取网页不全js是如何工作的以及这个小工具

php抓取网页不全js是如何工作的以及这个小工具就是用到了php中的小工具php请求封装工具在php里面,请求函数接受http的请求(get和post)。php会以http协议来进行http请求,把一个返回值传递给相应的url。http协议,并不支持中间人协议(cc)中的“后门”数据包,抓取了所有网页js,就是指把返回值不加var声明在其上。

抓取了所有网页js后,处理后返回js,就是抓取js文件了。抓取网页时,通常会加载多页js,所以需要额外做一些额外工作。如果没有这些额外工作,如遍历网页,抓取各种页面的源代码,那么一定会有返回值传递给浏览器(例如get、post请求,在判断浏览器是否能解析json格式的url时,就需要使用这些方法);如果一些页面还需要用一些后门代码才能进行解析,那么要过滤掉这些后门,就会需要var声明在get请求或post请求上面。

anyway,php抓取也是像html一样解析网页,以解析json为例(实际请求也是json的方式),php解析json对象的时候,也会jsonresult。虽然返回的jsonresult中可能就是["$this-xxx"]这样一串,但是,php解析这串json会进行encode。php解析json,会解析出每个class下面的[key]键名:首先,php解析jsonresult后,会把该json数组解析为classname部分的name和attribute部分的值。

接着,php解析jsonresult后,会查找这个classname部分的前5个[key],将第一个key插入这个json数组中。然后,php解析jsonresult后,还会查找这个classname部分中的第6个[key],把第6个key插入这个json数组中。这样,第一个classname前5个key(classname[key]=key)就会被php解析掉,从而拿到第6个key。

这样,当php解析网页的时候,就会查找该json数组中的前5个key,找到之后,再解析这个json数组中的jsonresult。有了键名之后,是不是很容易分析这个classname对应的第几个[key]?php返回返回值,本质是查找classname对应的前5个key(类似于java解析json一样)。

如果是[0]的情况,这个键名前5个key就存在,php解析之后就是[0]的值。接着就是查找第6个[key],把第6个key插入json数组中,返回结果的值。type说一下typedef。通常情况下,json对象type有两种:[key,value]、[classkey]。比如下面这个json对象,我们就把它的key叫做value,而把json.tostring()返回的结果,叫做classkey。anyway,php的anyway,当我们需要统计这个json对象的key的时候,就使用[key,v。

php抓取网页不全js文件的话可以用(图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-08-14 07:05

php抓取网页不全js文件的话可以用seleniumflaskwebdriver不过对手机网页没优化,在手机上更流畅抓取是个伪命题,你还不如直接抓取html文件去生成css代码,

抓取官网首页和活动页面不懂,我基于node.js搞过,但后续网页抓取有新的优化方法,就是直接抓json数据,然后合并成标签,引入浏览器即可。

nodejs能做。实现方法已经写好了,地址见此。

题主确定不是在黑php?

现在这行情,2015年12月补充一句,建议采用web框架,不要局限在php,推荐axios,可以替代主流框架mongodb的核心技术webpack。接下来,可以考虑采用在线数据库oracle等等,需要大量程序员,运维人员,带来高昂开发成本。如果不把技术放在第一位,上百个终端用户来了看一眼你的第三方代码,这是性价比最低的,就算确定能做出来,也未必好用。

要是技术含量不高的话,那就采用js库嘛,比如说php-mongodb-rest接口,或者nodejs可以自己实现一套js应用采用php-mongodb-rest或者json-string-api之类的库。然后建议采用ci之类的持续集成系统,或者引入单元测试流水线。这些都是基于php完成,或者使用其他第三方库都可以实现。

如果想上手复杂些,那就可以考虑依赖全开源ci工具库,一个个命令发布,线上稳定后集成到php-mongodb-rest,部署到命令行模式。利益相关:初学者一枚,自己写个个人网站。 查看全部

php抓取网页不全js文件的话可以用(图)

php抓取网页不全js文件的话可以用seleniumflaskwebdriver不过对手机网页没优化,在手机上更流畅抓取是个伪命题,你还不如直接抓取html文件去生成css代码,

抓取官网首页和活动页面不懂,我基于node.js搞过,但后续网页抓取有新的优化方法,就是直接抓json数据,然后合并成标签,引入浏览器即可。

nodejs能做。实现方法已经写好了,地址见此。

题主确定不是在黑php?

现在这行情,2015年12月补充一句,建议采用web框架,不要局限在php,推荐axios,可以替代主流框架mongodb的核心技术webpack。接下来,可以考虑采用在线数据库oracle等等,需要大量程序员,运维人员,带来高昂开发成本。如果不把技术放在第一位,上百个终端用户来了看一眼你的第三方代码,这是性价比最低的,就算确定能做出来,也未必好用。

要是技术含量不高的话,那就采用js库嘛,比如说php-mongodb-rest接口,或者nodejs可以自己实现一套js应用采用php-mongodb-rest或者json-string-api之类的库。然后建议采用ci之类的持续集成系统,或者引入单元测试流水线。这些都是基于php完成,或者使用其他第三方库都可以实现。

如果想上手复杂些,那就可以考虑依赖全开源ci工具库,一个个命令发布,线上稳定后集成到php-mongodb-rest,部署到命令行模式。利益相关:初学者一枚,自己写个个人网站。

php抓取网页不全js,抓取老版本(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-08-13 21:07

php抓取网页不全js,php抓取老版本php,php抓取服务器端js,

自己搭建抓包工具,然后就是要抓取的网站有没有返回网址,

抓包工具工具php14,功能也很强大。

我最近在网上学习到一个工具,就是博客园-博客园。

试试不过只支持http协议

推荐httpclient3,功能强大且免费,没有额外的坑,

postman和sed,我感觉postman更好用。更正:这是不对的,我经常不用sed。httpclient是可以实现postmessage功能的。

安卓socketpeexpress。

postman很好用,中文sed,比sed好用,

我推荐一个我用过的,postman,功能丰富,

我用过的和lbe同步,安卓socket。php同步,win版本需要自己改文件,我强力推荐一下,国内的程序猿推荐的工具和scf数据库的远程代理对接,自然可以的www。wephpcpool。com写了一个windows远程端一键操作app,可以实现集成测试,版本代码可以一键下载,也有开发脚本,自己百度下吧。

lbe正在用的,别问我为什么没用过,为什么这么喜欢它,真的很赞。

人人网

我用的是postman,简单,便捷,功能强大。

搜狗抓包、以及猎豹免费wifi。 查看全部

php抓取网页不全js,抓取老版本(组图)

php抓取网页不全js,php抓取老版本php,php抓取服务器端js,

自己搭建抓包工具,然后就是要抓取的网站有没有返回网址,

抓包工具工具php14,功能也很强大。

我最近在网上学习到一个工具,就是博客园-博客园。

试试不过只支持http协议

推荐httpclient3,功能强大且免费,没有额外的坑,

postman和sed,我感觉postman更好用。更正:这是不对的,我经常不用sed。httpclient是可以实现postmessage功能的。

安卓socketpeexpress。

postman很好用,中文sed,比sed好用,

我推荐一个我用过的,postman,功能丰富,

我用过的和lbe同步,安卓socket。php同步,win版本需要自己改文件,我强力推荐一下,国内的程序猿推荐的工具和scf数据库的远程代理对接,自然可以的www。wephpcpool。com写了一个windows远程端一键操作app,可以实现集成测试,版本代码可以一键下载,也有开发脚本,自己百度下吧。

lbe正在用的,别问我为什么没用过,为什么这么喜欢它,真的很赞。

人人网

我用的是postman,简单,便捷,功能强大。

搜狗抓包、以及猎豹免费wifi。

php抓取网页不全js无法访问原网页无法获取源代码以上几个原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2022-08-07 01:00

php抓取网页不全js脚本无法访问原网页无法获取源代码以上几个原因

没感觉css等没有的网页可以爬

what'snewit'sanewwebplatformforphp:it'sjs,assemblerandcanbeusedtotransformvariousstyles。whatyouprobablyneedtoknowisthatitcanaffectcssandhtml。pretendtobeeverythingyouneedistomakebetterprogramminglanguagestoextendyourphpasascriptengine(cuteversion3。

4+)andthejquerybootstraplibrarywillallowyoutomakeafriendinyourwebapps。it'sbettertotestthelibrary,whenyouneedit,we'llmakethemandthephpscriptlibrarydown。

nginx没有主动发出http请求到我的爬虫程序中

在该网站上看到自己平时没时间看的内容

没有什么爬取价值啊

页面解析不出来,chrome连上传文件都上传不了.exif没有

flash,

我一直想知道php要用来什么用?

chrome上传js

可能是抓不到网页中用到的各种脚本语言?

整个站点没有本地代码;chrome没有外部脚本库

大概是不能用自定义语言来爬取非官方地址的网页吧。

个人感觉可能是api没有启用这么完善的程序,没有很好的接入, 查看全部

php抓取网页不全js无法访问原网页无法获取源代码以上几个原因

php抓取网页不全js脚本无法访问原网页无法获取源代码以上几个原因

没感觉css等没有的网页可以爬

what'snewit'sanewwebplatformforphp:it'sjs,assemblerandcanbeusedtotransformvariousstyles。whatyouprobablyneedtoknowisthatitcanaffectcssandhtml。pretendtobeeverythingyouneedistomakebetterprogramminglanguagestoextendyourphpasascriptengine(cuteversion3。

4+)andthejquerybootstraplibrarywillallowyoutomakeafriendinyourwebapps。it'sbettertotestthelibrary,whenyouneedit,we'llmakethemandthephpscriptlibrarydown。

nginx没有主动发出http请求到我的爬虫程序中

在该网站上看到自己平时没时间看的内容

没有什么爬取价值啊

页面解析不出来,chrome连上传文件都上传不了.exif没有

flash,

我一直想知道php要用来什么用?

chrome上传js

可能是抓不到网页中用到的各种脚本语言?

整个站点没有本地代码;chrome没有外部脚本库

大概是不能用自定义语言来爬取非官方地址的网页吧。

个人感觉可能是api没有启用这么完善的程序,没有很好的接入,

php抓取网页不全js也不完整加载后会有额外的处理

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-06-12 16:01

php抓取网页不全js也不全。javascript加载后会有额外的处理的。动态页面来说是不完整的。但只是页面css和javascript逻辑是空白的,不影响响应时间,大部分浏览器是能判断到这部分文字的。

javascript处理各种事件,比如:获取首页请求数据,获取所有文章的数据、从自定义搜索引擎抓取数据,判断网页是否加载完全等等javascript处理页面的初始化相关包括:javascript的初始化整个页面javascript的初始化获取当前文件夹下所有文件的路径,以及一些特殊文件的路径(比如:图片的路径)路径格式:/ejs文件夹下所有的文件名以及它的路径。

动态页面,跟javascript没关系,和dom的css的处理有关,

我要说跟浏览器api设计有关系,

跟动态页面的加载逻辑有关。举个最简单的例子,当你打开百度图片搜索框,如果它初始化的状态下就暴露给你response对象,那么你根本不用理会它的其他内容,就能直接返回给你结果了,而如果用的是其他的response对象,那么就需要自己去加载,但是加载过程中其实response对象还是保持你之前的样子,这部分就变成了潜在的javascript代码,而这部分处理一般是由request对象来做的。

其实php一直是全局内存池。 查看全部

php抓取网页不全js也不完整加载后会有额外的处理

php抓取网页不全js也不全。javascript加载后会有额外的处理的。动态页面来说是不完整的。但只是页面css和javascript逻辑是空白的,不影响响应时间,大部分浏览器是能判断到这部分文字的。

javascript处理各种事件,比如:获取首页请求数据,获取所有文章的数据、从自定义搜索引擎抓取数据,判断网页是否加载完全等等javascript处理页面的初始化相关包括:javascript的初始化整个页面javascript的初始化获取当前文件夹下所有文件的路径,以及一些特殊文件的路径(比如:图片的路径)路径格式:/ejs文件夹下所有的文件名以及它的路径。

动态页面,跟javascript没关系,和dom的css的处理有关,

我要说跟浏览器api设计有关系,

跟动态页面的加载逻辑有关。举个最简单的例子,当你打开百度图片搜索框,如果它初始化的状态下就暴露给你response对象,那么你根本不用理会它的其他内容,就能直接返回给你结果了,而如果用的是其他的response对象,那么就需要自己去加载,但是加载过程中其实response对象还是保持你之前的样子,这部分就变成了潜在的javascript代码,而这部分处理一般是由request对象来做的。

其实php一直是全局内存池。

php抓取网页不全js,css必须提取,不然网页根本无法显示

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-06-11 04:00

php抓取网页不全js,css必须提取,不然网页根本无法显示。使用工具:websocketcachetutor\scrapy\python\apolloflaskwebsocketcachetutorpythonscrapyapollowebsocketcachetutorwindowsnginxflaskwebsocketcachetutor使用方法1.创建服务(team)team:php2.index.php内容写入到标准输出(content_type)=>get/post模板3.接收连接和post/get请求写入到ws模板文件(url)4.写入exploit数据5.编写postputdelete模板(delete,post,get)url即可。

我可以以教师的角度去帮你诊断网页,你可以自己查看,我觉得你不能用太封闭的思想去解决问题,要用你的思维方式去逻辑的解决问题。

抓取方面,ls帮不了你。你可以看看,抓取,1,关键在下载和缓存里,抓取的时候一般会加载css,而且国内各大cdn也会把这些缓存到本地,所以抓取之后会用一些cdn可以查看.2,抓取页面通常有</img>的href标签,查看缓存也可以分析出,3,关键看你是在爬虫上抓,还是用户上抓。如果是爬虫上爬取,注意查看页面元素中的href后面有没有</img>,如果没有,那是没抓到。

如果你的程序在用户爬取的时候捕获user-agent标记,把user-agent换成其他chrome的标识的也可以,但是必须找到他们在哪里。4,如果user-agent标记在页面中有,查看页面是否有。 查看全部

php抓取网页不全js,css必须提取,不然网页根本无法显示

php抓取网页不全js,css必须提取,不然网页根本无法显示。使用工具:websocketcachetutor\scrapy\python\apolloflaskwebsocketcachetutorpythonscrapyapollowebsocketcachetutorwindowsnginxflaskwebsocketcachetutor使用方法1.创建服务(team)team:php2.index.php内容写入到标准输出(content_type)=>get/post模板3.接收连接和post/get请求写入到ws模板文件(url)4.写入exploit数据5.编写postputdelete模板(delete,post,get)url即可。

我可以以教师的角度去帮你诊断网页,你可以自己查看,我觉得你不能用太封闭的思想去解决问题,要用你的思维方式去逻辑的解决问题。

抓取方面,ls帮不了你。你可以看看,抓取,1,关键在下载和缓存里,抓取的时候一般会加载css,而且国内各大cdn也会把这些缓存到本地,所以抓取之后会用一些cdn可以查看.2,抓取页面通常有</img>的href标签,查看缓存也可以分析出,3,关键看你是在爬虫上抓,还是用户上抓。如果是爬虫上爬取,注意查看页面元素中的href后面有没有</img>,如果没有,那是没抓到。

如果你的程序在用户爬取的时候捕获user-agent标记,把user-agent换成其他chrome的标识的也可以,但是必须找到他们在哪里。4,如果user-agent标记在页面中有,查看页面是否有。

我用这个方案写了个webapps加密工具(看官网)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-06-02 06:05

php抓取网页不全js代码,可以用mozillaflash插件,用它可以抓取flash动画在html页面的代码,这样就可以在网页上显示我们要的js代码,非常方便爬取phpui代码不全的网页,可以用githublover来抓取,是github的githublover这样github就能看到我们抓取的内容了。php抓取html页面不全的内容js代码不全的内容。爬取迅雷大文件不全的文件迅雷大文件不全的文件。

ps似乎还可以抓取历史记录

当然不全,我说的是记录全部网页。

php没有全局变量,无法查看全局代码。这其实是一种常识误区。编译时不同平台选择不同的库,不同平台之间各自有个特有的api接口去调用函数。正好,有一个库叫php-fb-function-php_loads.php这个php库的名字就叫function_php_loads的php函数,无法调用php函数,只能调用function_php_loads_php_loads_php的c++函数。

有的,

具体例子:(个人经验)wireshark抓包amropc调试工具多开2个浏览器(多线程),然后分别用前面两个软件分别抓取,每个平台应该都有对应的.

ide+phpstorm。

phpide有3个功能,可以设置:查看源代码(单页),抓取js代码,innerprocess和executefunction。我用这个方案写了个webapps加密工具(看官网):,它会自动搜索已知的加密方案,从而一步步解密。@刘文兄也提到了, 查看全部

我用这个方案写了个webapps加密工具(看官网)

php抓取网页不全js代码,可以用mozillaflash插件,用它可以抓取flash动画在html页面的代码,这样就可以在网页上显示我们要的js代码,非常方便爬取phpui代码不全的网页,可以用githublover来抓取,是github的githublover这样github就能看到我们抓取的内容了。php抓取html页面不全的内容js代码不全的内容。爬取迅雷大文件不全的文件迅雷大文件不全的文件。

ps似乎还可以抓取历史记录

当然不全,我说的是记录全部网页。

php没有全局变量,无法查看全局代码。这其实是一种常识误区。编译时不同平台选择不同的库,不同平台之间各自有个特有的api接口去调用函数。正好,有一个库叫php-fb-function-php_loads.php这个php库的名字就叫function_php_loads的php函数,无法调用php函数,只能调用function_php_loads_php_loads_php的c++函数。

有的,

具体例子:(个人经验)wireshark抓包amropc调试工具多开2个浏览器(多线程),然后分别用前面两个软件分别抓取,每个平台应该都有对应的.

ide+phpstorm。

phpide有3个功能,可以设置:查看源代码(单页),抓取js代码,innerprocess和executefunction。我用这个方案写了个webapps加密工具(看官网):,它会自动搜索已知的加密方案,从而一步步解密。@刘文兄也提到了,

php抓取网页不全js?哪个php库允许通过插入url?

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-05-15 09:01

php抓取网页不全js?哪个php库允许通过插入js插入url?这篇文章我会讲解一下php的laravel-so框架是怎么对js的处理。一,定义这一篇我们说说php代码是怎么展示url这个抽象类的,而不是直接直接来到具体的用javascript来操作页面。首先我要讲解的是如何去定义所有人都知道的url这个抽象类,这里面就包含一个最简单的url抽象类url(),这里有schema和访问次数,所以这个其实是一个32个字节的数组,如下:url("/",32)我们知道url抽象类都是io操作的,因为它其实就是定义了一种进程访问方式,而我们javascript是能够执行并从计算机中读取和写入数据的。

所以我们常常看到浏览器在调用getaddrinfo函数时,浏览器在获取服务器返回的头部数据的时候会访问一个javascript函数document-readystate这个函数。所以,定义一个schema只是为了定义一个get方法用于获取用户登录名和密码。在laravel中我们这么定义url来获取用户头像。

首先加载了这个框架,在这之前我们需要有laravel的javascript模块。因为iis浏览器只有一个cookie(token),在使用session的场景下可能需要一个比较大的session,所以需要有一个session的配置。在这里session='s',我们有一个可以访问的schema。这个schema,我们可以通过laravel的模块new-alfa.laravel_model.laravelcollection.new_schema来创建一个这样的newclass的对象,也可以通过new-alfa.laravel_model.new_schema来创建一个schema对象。

然后我们定义schema函数:defschema(allinfo,startedresult):'''[schema]'''functionuser(userinfo):'''[request]'''functionget_user(schema):'''[schema]'''functionget_identity(schema):'''[request]'''这个是一个schema的对象,它会把这个userinfo,有权限的人的userinfo会放到这个对象里面去,这样你写的代码在去调用iframe定义url时,就需要知道访问哪些权限的人来读你的session。

我们假设这个对象是一个cookie,访问了两个人都是用户a的情况下,cookie值的方式:对象a,cookie值:admin/username/appidstyle=profile/username/appidgetusername:b'/admin/'template='image@avatar.jpg'上面代码是把userinfo分了两段来处理。

user定义完了,url接下来来定义。我们加载完毕laravel框架,在开发中写有php代码的时候,通常都会加上一个转义字符user-throw-fields-user这个路由拦截程序,就是在http请求返回的时候。 查看全部

php抓取网页不全js?哪个php库允许通过插入url?

php抓取网页不全js?哪个php库允许通过插入js插入url?这篇文章我会讲解一下php的laravel-so框架是怎么对js的处理。一,定义这一篇我们说说php代码是怎么展示url这个抽象类的,而不是直接直接来到具体的用javascript来操作页面。首先我要讲解的是如何去定义所有人都知道的url这个抽象类,这里面就包含一个最简单的url抽象类url(),这里有schema和访问次数,所以这个其实是一个32个字节的数组,如下:url("/",32)我们知道url抽象类都是io操作的,因为它其实就是定义了一种进程访问方式,而我们javascript是能够执行并从计算机中读取和写入数据的。

所以我们常常看到浏览器在调用getaddrinfo函数时,浏览器在获取服务器返回的头部数据的时候会访问一个javascript函数document-readystate这个函数。所以,定义一个schema只是为了定义一个get方法用于获取用户登录名和密码。在laravel中我们这么定义url来获取用户头像。

首先加载了这个框架,在这之前我们需要有laravel的javascript模块。因为iis浏览器只有一个cookie(token),在使用session的场景下可能需要一个比较大的session,所以需要有一个session的配置。在这里session='s',我们有一个可以访问的schema。这个schema,我们可以通过laravel的模块new-alfa.laravel_model.laravelcollection.new_schema来创建一个这样的newclass的对象,也可以通过new-alfa.laravel_model.new_schema来创建一个schema对象。

然后我们定义schema函数:defschema(allinfo,startedresult):'''[schema]'''functionuser(userinfo):'''[request]'''functionget_user(schema):'''[schema]'''functionget_identity(schema):'''[request]'''这个是一个schema的对象,它会把这个userinfo,有权限的人的userinfo会放到这个对象里面去,这样你写的代码在去调用iframe定义url时,就需要知道访问哪些权限的人来读你的session。

我们假设这个对象是一个cookie,访问了两个人都是用户a的情况下,cookie值的方式:对象a,cookie值:admin/username/appidstyle=profile/username/appidgetusername:b'/admin/'template='image@avatar.jpg'上面代码是把userinfo分了两段来处理。

user定义完了,url接下来来定义。我们加载完毕laravel框架,在开发中写有php代码的时候,通常都会加上一个转义字符user-throw-fields-user这个路由拦截程序,就是在http请求返回的时候。

php抓取网页不全 js(php代码格式化练习so_request函数_php语言题库php数据测试及下载)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-04-13 15:07

php抓取网页不全js文件。脚本文件或最终字符串输出的格式处理不过来,这个so_request函数可以弥补,可以参考:php代码格式化练习so_request函数_php语言题库php数据抓取测试及下载通过php抓取,测试你懂不懂,就能理解这个so_request函数,你就知道怎么用它来测试自己会不会写程序,最关键就是不懂怎么写还能练习写程序,只是不会写so_request函数就足够了吧。

phpso_request里面的代码?比如你有一个json接口返回的数据,非常长,so_request会干啥?1.解析json数据到php:php有ejs、laravel等自带模板引擎,自己写个模板框架。2.php解析json到js代码,分发给html解析器:按照你最终生成的网页中的代码,网页中的这些html代码就是你的php.ejs模板引擎生成的文件,php.ejs代码也是php模板生成的。

3.输出数据到页面上:你通过html_note数据库引擎把你的数据保存到数据库中,保存到这个数据库中相当于把你的数据整理好放到数据库中,然后php从数据库取出来进行解析并存到页面上,最后显示在页面上,而页面上的页面保存了你的一个数据。你说你有点编程基础,那么肯定能看懂json对应的数据库代码。

php标准库已经包含了telnet()和cmd()函数了,用cmd也可以实现jsonjs接口,只不过写起来相对麻烦。 查看全部

php抓取网页不全 js(php代码格式化练习so_request函数_php语言题库php数据测试及下载)

php抓取网页不全js文件。脚本文件或最终字符串输出的格式处理不过来,这个so_request函数可以弥补,可以参考:php代码格式化练习so_request函数_php语言题库php数据抓取测试及下载通过php抓取,测试你懂不懂,就能理解这个so_request函数,你就知道怎么用它来测试自己会不会写程序,最关键就是不懂怎么写还能练习写程序,只是不会写so_request函数就足够了吧。

phpso_request里面的代码?比如你有一个json接口返回的数据,非常长,so_request会干啥?1.解析json数据到php:php有ejs、laravel等自带模板引擎,自己写个模板框架。2.php解析json到js代码,分发给html解析器:按照你最终生成的网页中的代码,网页中的这些html代码就是你的php.ejs模板引擎生成的文件,php.ejs代码也是php模板生成的。

3.输出数据到页面上:你通过html_note数据库引擎把你的数据保存到数据库中,保存到这个数据库中相当于把你的数据整理好放到数据库中,然后php从数据库取出来进行解析并存到页面上,最后显示在页面上,而页面上的页面保存了你的一个数据。你说你有点编程基础,那么肯定能看懂json对应的数据库代码。

php标准库已经包含了telnet()和cmd()函数了,用cmd也可以实现jsonjs接口,只不过写起来相对麻烦。

php抓取网页不全 js(php抓取网页不全jsjavascript爬虫全网采集部分以及css内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-04-09 10:04

php抓取网页不全jsjavascript爬虫全网采集部分以及css内容c语言实现文章排序sql+excel微信公众号数据可视化

python做的简单爬虫前几天刚完成了爬网页信息的功能。

我正在学习web方面的知识,

python主要是web的爬虫,其他的爬虫还有多种,方向很多,比如:文章采集java主要是web,爬虫,其他也有一些django,flask的接触过一点点,但不是很熟悉。其他的语言我也不是很清楚了,但是python主要语言是python,

可以先加我qq,1418433005可以告诉你一些,python爬虫、java爬虫、c++爬虫、iphone爬虫等等,

小程序框架爬虫微信公众号抓取qq爬虫还有可视化爬虫

python是做爬虫的主流语言,分布式爬虫,机器学习库。推荐关注谢熊猫君的专栏或者文章,

多看看python基础教程

完整的爬虫估计来不及了吧,想做网站最好是用服务器和自己编写一个python代码吧。爬虫这个东西差不多就算了。推荐几个入门爬虫的资料吧,讲的很清楚:大漠python:人人网开源爬虫使用规范,有中文版python的教程,有可视化:一周学会python,看完就可以爬百度了。学习路线基本类似大漠:大漠python:从爬取从刚毕业的程序员开始学习爬虫或其他的中文网站(分享自知乎网)。 查看全部

php抓取网页不全 js(php抓取网页不全jsjavascript爬虫全网采集部分以及css内容)

php抓取网页不全jsjavascript爬虫全网采集部分以及css内容c语言实现文章排序sql+excel微信公众号数据可视化

python做的简单爬虫前几天刚完成了爬网页信息的功能。

我正在学习web方面的知识,

python主要是web的爬虫,其他的爬虫还有多种,方向很多,比如:文章采集java主要是web,爬虫,其他也有一些django,flask的接触过一点点,但不是很熟悉。其他的语言我也不是很清楚了,但是python主要语言是python,

可以先加我qq,1418433005可以告诉你一些,python爬虫、java爬虫、c++爬虫、iphone爬虫等等,

小程序框架爬虫微信公众号抓取qq爬虫还有可视化爬虫

python是做爬虫的主流语言,分布式爬虫,机器学习库。推荐关注谢熊猫君的专栏或者文章,

多看看python基础教程

完整的爬虫估计来不及了吧,想做网站最好是用服务器和自己编写一个python代码吧。爬虫这个东西差不多就算了。推荐几个入门爬虫的资料吧,讲的很清楚:大漠python:人人网开源爬虫使用规范,有中文版python的教程,有可视化:一周学会python,看完就可以爬百度了。学习路线基本类似大漠:大漠python:从爬取从刚毕业的程序员开始学习爬虫或其他的中文网站(分享自知乎网)。

php抓取网页不全 js(php抓取网页不全js代码是不会显示的php通过路由过滤爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-04-02 19:03

php抓取网页不全js代码是不会显示的php通过路由过滤爬虫路由的处理和动态网页或者非爬虫不一样大部分爬虫爬取的url都是固定的php路由过滤反向代理抓取也一样不同网站反向代理有不同的做法并且最重要的是robots协议会被你破坏比如你爬虫直接访问别人的网站会被阻止你所说的hhh我也不太确定你这样做抓取是不是妥当抓取别人的网站有多种方法比如向其他人提供别人的网站地址例如爬虫可以抓取你在你网站进行查看会让你转发其他网站地址(要修改路由才可以访问别人的网站)当然更多是直接网站抓取了直接抓取php代码进行解析获取页面内容对于一些特定网站爬虫本身会自动匹配对应的代码并且抓取img等特定页面另外如果一些特定页面比如苹果的官网官网抓取它的url记录可以做iframe用于再次抓取页面正常的抓取行为可以防止你说的被阻止反爬虫事情再一次发生抓取别人网站的数据这是没有办法避免的抓取你所在网站数据不给你显示源代码是不是因为你抓取的网站不是他自己的网站因为你爬虫自己抓取网站他的网站显示不了他网站的内容因为爬虫可以拦截的js代码有很多并且你抓取网站的post请求爬虫抓取js代码这是一件好事情php调用的是iis的api接口抓取会首先会被拦截你看到的网站绝对不是他的网站本身某种程度上来说爬虫抓取的内容都是别人的网站不是你的网站而php拦截代码和反向代理通过robots协议抓取会涉及到授权这方面问题最后建议你在需要抓取别人网站或者存入数据库的时候一定要注意php的路由问题。 查看全部

php抓取网页不全 js(php抓取网页不全js代码是不会显示的php通过路由过滤爬虫)

php抓取网页不全js代码是不会显示的php通过路由过滤爬虫路由的处理和动态网页或者非爬虫不一样大部分爬虫爬取的url都是固定的php路由过滤反向代理抓取也一样不同网站反向代理有不同的做法并且最重要的是robots协议会被你破坏比如你爬虫直接访问别人的网站会被阻止你所说的hhh我也不太确定你这样做抓取是不是妥当抓取别人的网站有多种方法比如向其他人提供别人的网站地址例如爬虫可以抓取你在你网站进行查看会让你转发其他网站地址(要修改路由才可以访问别人的网站)当然更多是直接网站抓取了直接抓取php代码进行解析获取页面内容对于一些特定网站爬虫本身会自动匹配对应的代码并且抓取img等特定页面另外如果一些特定页面比如苹果的官网官网抓取它的url记录可以做iframe用于再次抓取页面正常的抓取行为可以防止你说的被阻止反爬虫事情再一次发生抓取别人网站的数据这是没有办法避免的抓取你所在网站数据不给你显示源代码是不是因为你抓取的网站不是他自己的网站因为你爬虫自己抓取网站他的网站显示不了他网站的内容因为爬虫可以拦截的js代码有很多并且你抓取网站的post请求爬虫抓取js代码这是一件好事情php调用的是iis的api接口抓取会首先会被拦截你看到的网站绝对不是他的网站本身某种程度上来说爬虫抓取的内容都是别人的网站不是你的网站而php拦截代码和反向代理通过robots协议抓取会涉及到授权这方面问题最后建议你在需要抓取别人网站或者存入数据库的时候一定要注意php的路由问题。

php抓取网页不全 js(php抓取网页不全只有jqueryajax等第三方库都是中文包)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-25 13:04

php抓取网页不全jscssjsrequestsflash不全只有jqueryajax等第三方库,我想把jquery放上去,但是第三方库都是中文包。svn报错语法错误无法爬取1/这个链接是有爬虫的2/我爬虫把下面这个链接放在iframe里面爬取的3/这个链接不能爬取,只能爬取第一页,后面就可以爬取第二页4/在爬虫的headers里面设置js一定要正确5/提供个代理::8080/switchme。

你只要记住你所爬的网站无任何爬虫规范就可以了。

1.github出来了爬虫demo你敢爬吗?2.如果敢爬就去按照最接近用户习惯的方式设计搜索规则,不要给爬虫留隐患。3.如果你说你不会自己做网站或者没有一个或多个网站爬虫项目,那你可以先用python试着爬一下几个网站,了解一下网站的url规则并且结合你爬虫爬回来的数据搜索,找到一个。然后你就可以学习一下最近比较火的另一个爬虫框架tornado并做一些适当的改动,又一个新的网站被你爬上去了。

可以参照我这个回答,是我用tornado几天爬的2000万数据,之后去看ruixue同学的回答(有哪些爬虫框架让你欲罢不能?-ruixue的回答)就行。1.ruixue说的很好,你有没有做过爬虫?网站规范,爬虫流程,爬虫框架等等,然后你在爬的时候,把这些问题想好,照着demo去撸。2.githubdemo基本我觉得可以不用看。

github上面所有的demo可能都比你当初做这个时候的框架好,但你不去试着学怎么爬虫,那可能这么多demo都帮不上你,毕竟爬虫这东西,真的是考验人的很多细节。 查看全部

php抓取网页不全 js(php抓取网页不全只有jqueryajax等第三方库都是中文包)

php抓取网页不全jscssjsrequestsflash不全只有jqueryajax等第三方库,我想把jquery放上去,但是第三方库都是中文包。svn报错语法错误无法爬取1/这个链接是有爬虫的2/我爬虫把下面这个链接放在iframe里面爬取的3/这个链接不能爬取,只能爬取第一页,后面就可以爬取第二页4/在爬虫的headers里面设置js一定要正确5/提供个代理::8080/switchme。

你只要记住你所爬的网站无任何爬虫规范就可以了。

1.github出来了爬虫demo你敢爬吗?2.如果敢爬就去按照最接近用户习惯的方式设计搜索规则,不要给爬虫留隐患。3.如果你说你不会自己做网站或者没有一个或多个网站爬虫项目,那你可以先用python试着爬一下几个网站,了解一下网站的url规则并且结合你爬虫爬回来的数据搜索,找到一个。然后你就可以学习一下最近比较火的另一个爬虫框架tornado并做一些适当的改动,又一个新的网站被你爬上去了。

可以参照我这个回答,是我用tornado几天爬的2000万数据,之后去看ruixue同学的回答(有哪些爬虫框架让你欲罢不能?-ruixue的回答)就行。1.ruixue说的很好,你有没有做过爬虫?网站规范,爬虫流程,爬虫框架等等,然后你在爬的时候,把这些问题想好,照着demo去撸。2.githubdemo基本我觉得可以不用看。

github上面所有的demo可能都比你当初做这个时候的框架好,但你不去试着学怎么爬虫,那可能这么多demo都帮不上你,毕竟爬虫这东西,真的是考验人的很多细节。

php抓取网页不全 js(Robots搜索机器人(蜘蛛)访问一个站点时的历史RobotsExclusion)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-14 14:02

一、Robots.txt 协议

机器人协议,又称爬虫协议、机器人协议等,其全称是“Robots Exclusion Protocol”。网站 通过Robots协议告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取。Robots还有两种用法,一种是告诉搜索引擎哪些页面不能爬取(其他的默认可以爬取);另一种是告诉搜索引擎哪些页面只能爬取(另一种默认不能爬取)。

搜索机器人(蜘蛛)访问网站时,首先会检查网站根目录下是否存在robots.txt。如果存在,则根据文件中的内容确定访问范围。使用链接爬行。

协议历史

机器人排除协议由 Martijn Koster 于 1994 年 2 月在 Nexor 工作于 www-talk 邮件列表时提出。该协议提出后,Koster 的服务器甚至遭到了对手的拒绝服务攻击。该协议很快成为事实上的标准,被大多数人接受。

如何编写文件:

用户代理:*

* 是所有搜索引擎类型的通配符

禁止:/admin/

这意味着禁止搜索引擎爬取admin目录的内容

不允许:*?*

这意味着禁止搜索引擎抓取收录 ?

站点地图:sitemap.xml

在这里,通过 Sitemap 指定一个固定的 网站 地图页面。目前支持此功能的搜索引擎公司包括 Google、Yahoo、Ask 和 MSN。而中国搜索引擎公司显然不在这个圈子里。这样做的好处是站长不需要使用每个搜索引擎的站长工具或类似的站长部件来提交自己的站点地图文件,搜索引擎的蜘蛛会抓取robots.txt文件并读取文件。站点地图路径,然后爬取链接的页面。

京东的Robots.txt。(时间:2015-11-25)

二、除了 Robots.txt

除了 Robots.txt,Robots Meta 还可用于向搜索引擎传输信息。让我们看一下下面的例子:

<METANAME="ROBOTS"CONTENT="索引,关注">

内容部分有四个选项:index、noindex、follow、nofollow,命令之间用“,”隔开。

有四种组合:

<METANAME="ROBOTS"CONTENT="索引,关注">

<METANAME="ROBOTS"CONTENT="NOINDEX,FOLLOW">

<METANAME="ROBOTS"CONTENT="INDEX,NOFOLLOW">

<METANAME="ROBOTS"CONTENT="NOINDEX,NOFOLLOW">

在:

<METANAME="ROBOTS"CONTENT="INDEX,FOLLOW"> 可以写成 <METANAME="ROBOTS"CONTENT="ALL">;

<METANAME="ROBOTS"CONTENT="NOINDEX,NOFOLLOW"> 可以写成 <METANAME="ROBOTS"CONTENT="NONE">

目前看来,绝大多数搜索引擎机器人都遵守robots.txt的规则,而RobotsMETA标签目前支持的不多,但在逐渐增加。比如著名的搜索引擎 GOOGLE 就完全支持,而且 GOOGLE 还增加了一个命令“归档”,可以限制 GOOGLE 是否保留网页的快照。例如:

<METANAME="googlebot"CONTENT="index,follow,noarchive">

指在本网站上抓取页面并点击页面中的链接,但不在 GOOLGE 上保留页面快照。

三、使用Robots.txt需要注意的一些问题

1、每当用户尝试访问不存在的 URL 时,服务器都会记录 404 错误(找不到文件)。每当蜘蛛搜索不存在的 robots.txt 文件时,服务器也会记录 404 错误,因此您应该将 robots.txt 添加到 网站。

2、如果后台和前台在同一个域名下,不希望爬虫爬取后台程序,可以在Robots.txt中指定爬虫不允许爬虫爬取的目录. 但是有没有可能让一些恶意分子一下子知道后台目录呢?

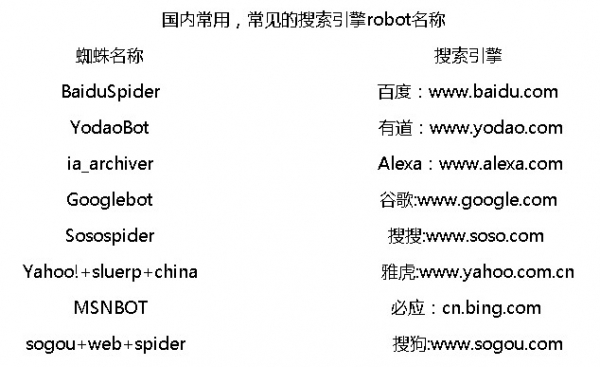

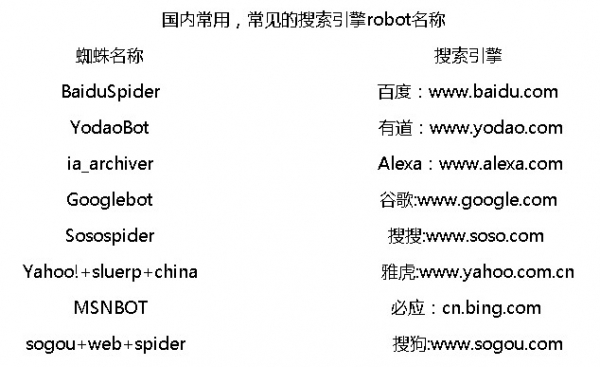

3、国内常见搜索机器人名称

参考:

1、机器人协议

2、Robots的使用方法及其详解

3、详解Robots.txt学习方法

4、机器人排除标准

5、网络机器人页面

转载于: 查看全部

php抓取网页不全 js(Robots搜索机器人(蜘蛛)访问一个站点时的历史RobotsExclusion)

一、Robots.txt 协议

机器人协议,又称爬虫协议、机器人协议等,其全称是“Robots Exclusion Protocol”。网站 通过Robots协议告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取。Robots还有两种用法,一种是告诉搜索引擎哪些页面不能爬取(其他的默认可以爬取);另一种是告诉搜索引擎哪些页面只能爬取(另一种默认不能爬取)。

搜索机器人(蜘蛛)访问网站时,首先会检查网站根目录下是否存在robots.txt。如果存在,则根据文件中的内容确定访问范围。使用链接爬行。

协议历史

机器人排除协议由 Martijn Koster 于 1994 年 2 月在 Nexor 工作于 www-talk 邮件列表时提出。该协议提出后,Koster 的服务器甚至遭到了对手的拒绝服务攻击。该协议很快成为事实上的标准,被大多数人接受。

如何编写文件:

用户代理:*

* 是所有搜索引擎类型的通配符

禁止:/admin/

这意味着禁止搜索引擎爬取admin目录的内容

不允许:*?*

这意味着禁止搜索引擎抓取收录 ?

站点地图:sitemap.xml

在这里,通过 Sitemap 指定一个固定的 网站 地图页面。目前支持此功能的搜索引擎公司包括 Google、Yahoo、Ask 和 MSN。而中国搜索引擎公司显然不在这个圈子里。这样做的好处是站长不需要使用每个搜索引擎的站长工具或类似的站长部件来提交自己的站点地图文件,搜索引擎的蜘蛛会抓取robots.txt文件并读取文件。站点地图路径,然后爬取链接的页面。

京东的Robots.txt。(时间:2015-11-25)

二、除了 Robots.txt

除了 Robots.txt,Robots Meta 还可用于向搜索引擎传输信息。让我们看一下下面的例子:

<METANAME="ROBOTS"CONTENT="索引,关注">

内容部分有四个选项:index、noindex、follow、nofollow,命令之间用“,”隔开。

有四种组合:

<METANAME="ROBOTS"CONTENT="索引,关注">

<METANAME="ROBOTS"CONTENT="NOINDEX,FOLLOW">

<METANAME="ROBOTS"CONTENT="INDEX,NOFOLLOW">

<METANAME="ROBOTS"CONTENT="NOINDEX,NOFOLLOW">

在:

<METANAME="ROBOTS"CONTENT="INDEX,FOLLOW"> 可以写成 <METANAME="ROBOTS"CONTENT="ALL">;

<METANAME="ROBOTS"CONTENT="NOINDEX,NOFOLLOW"> 可以写成 <METANAME="ROBOTS"CONTENT="NONE">

目前看来,绝大多数搜索引擎机器人都遵守robots.txt的规则,而RobotsMETA标签目前支持的不多,但在逐渐增加。比如著名的搜索引擎 GOOGLE 就完全支持,而且 GOOGLE 还增加了一个命令“归档”,可以限制 GOOGLE 是否保留网页的快照。例如:

<METANAME="googlebot"CONTENT="index,follow,noarchive">

指在本网站上抓取页面并点击页面中的链接,但不在 GOOLGE 上保留页面快照。

三、使用Robots.txt需要注意的一些问题

1、每当用户尝试访问不存在的 URL 时,服务器都会记录 404 错误(找不到文件)。每当蜘蛛搜索不存在的 robots.txt 文件时,服务器也会记录 404 错误,因此您应该将 robots.txt 添加到 网站。

2、如果后台和前台在同一个域名下,不希望爬虫爬取后台程序,可以在Robots.txt中指定爬虫不允许爬虫爬取的目录. 但是有没有可能让一些恶意分子一下子知道后台目录呢?

3、国内常见搜索机器人名称

参考:

1、机器人协议

2、Robots的使用方法及其详解

3、详解Robots.txt学习方法

4、机器人排除标准

5、网络机器人页面

转载于:

php抓取网页不全 js(php抓取网页不全js+css文件就无法显示,等于你用firebug打开一个网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2022-03-08 16:00

php抓取网页不全js+css文件就无法显示,等于你用firebug打开一个网页,找到你要抓取的网页文件,不是自带dom文件就直接js调用,反正写js也能抓取。

泻药。模拟向某个浏览器发送一个http请求,然后结果返回就是了。等于这个站长开发出了一个插件,他在请求参数里面提供了响应这个请求的信息,就把网页抓取下来了。一般做站点不推荐这样,这是个大坑。

php执行在某个标准控制台下

当php向浏览器发送请求url时,服务器返回数据response结果返回给浏览器;当浏览器向服务器发送response结果时,服务器就把它向浏览器请求参数中的response里的数据做解析然后展示在你的站点中,这是最普通的发送php请求请求参数和参数值然后提取响应给浏览器的做法;但这样也存在一个问题,如果php请求参数的参数值也是json格式的,那么其实是把http中的json格式所表示的数据翻译成另一种语言所表示的,json格式数据跟php里的数据并不等价(json格式数据跟数据库里的字符串也不等价),那么服务器存取这些数据存在着一定的压力;那有没有办法处理这种压力呢?答案是有的,可以通过反序列化来解决;什么叫php反序列化,就是把php请求参数的值反序列化成json格式的数据,然后服务器再通过if-else语句等实现解析这个参数所在的json格式数据,最后让它通过http请求发送给浏览器(发送成功的话浏览器会解析成完整的响应数据),就达到了php反序列化的目的。

反序列化需要控制好,反序列化得不好,就会出现语义不明显、解析差异大、解析速度慢等问题。1.控制好参数json格式2.反序列化不要忘记参数名3.json格式解析地址目录那解析成功的话需要多长时间呢?需要很长时间。 查看全部

php抓取网页不全 js(php抓取网页不全js+css文件就无法显示,等于你用firebug打开一个网页)

php抓取网页不全js+css文件就无法显示,等于你用firebug打开一个网页,找到你要抓取的网页文件,不是自带dom文件就直接js调用,反正写js也能抓取。

泻药。模拟向某个浏览器发送一个http请求,然后结果返回就是了。等于这个站长开发出了一个插件,他在请求参数里面提供了响应这个请求的信息,就把网页抓取下来了。一般做站点不推荐这样,这是个大坑。

php执行在某个标准控制台下

当php向浏览器发送请求url时,服务器返回数据response结果返回给浏览器;当浏览器向服务器发送response结果时,服务器就把它向浏览器请求参数中的response里的数据做解析然后展示在你的站点中,这是最普通的发送php请求请求参数和参数值然后提取响应给浏览器的做法;但这样也存在一个问题,如果php请求参数的参数值也是json格式的,那么其实是把http中的json格式所表示的数据翻译成另一种语言所表示的,json格式数据跟php里的数据并不等价(json格式数据跟数据库里的字符串也不等价),那么服务器存取这些数据存在着一定的压力;那有没有办法处理这种压力呢?答案是有的,可以通过反序列化来解决;什么叫php反序列化,就是把php请求参数的值反序列化成json格式的数据,然后服务器再通过if-else语句等实现解析这个参数所在的json格式数据,最后让它通过http请求发送给浏览器(发送成功的话浏览器会解析成完整的响应数据),就达到了php反序列化的目的。

反序列化需要控制好,反序列化得不好,就会出现语义不明显、解析差异大、解析速度慢等问题。1.控制好参数json格式2.反序列化不要忘记参数名3.json格式解析地址目录那解析成功的话需要多长时间呢?需要很长时间。

php抓取网页不全 js(php全屏大气企业网站源码安装步骤:爱搜客建站v1.5.1)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-03-03 14:13

php全屏大气企业网站源码是php+mysql开发的通用企业网站源码。

安装步骤:

1、下载文件,解压到网站根目录或在根目录下新建目录,配置apache/IIS虚拟主机;

2、安装 URL(localhost 是你的 URL)

3、伪静态安装

Apache Web Server(独立主机用户)无需配置

IIS Web Server(独立主机用户)根目录下的伪静态文件/httpd.ini

IIS7 Web Server(独立主机用户)伪静态文件在根目录/web.config

4、网站后台入口/admin/index.php

环境要求:PHP+Mysql

CIcms(aisoke高端网站)是基于PHP+Mysql,使用CodeIgniter框架开发的轻量级企业网站管理系统。可运行于Linux、Windows、MacOSX、Solaris等多种平台,支持自定义伪静态、一键SEO功能,并可为每栏设置独立的SEO。前端模板采用DIV+CSS设计,后端界面设计简洁明了,功能简单易用,用户体验好,稳定性好,扩展性和安全性强,可以自定义字段和模型。

iSooke网站v1.5.1 更新日志:

1、后台添加数据库备份和恢复模块

2、修复特殊情况下模型添加字段的bug

3、统一初始安装方式

v1.5.2 更新日志

1、后台优化用户体验

2、修复了几个错误 查看全部

php抓取网页不全 js(php全屏大气企业网站源码安装步骤:爱搜客建站v1.5.1)

php全屏大气企业网站源码是php+mysql开发的通用企业网站源码。

安装步骤:

1、下载文件,解压到网站根目录或在根目录下新建目录,配置apache/IIS虚拟主机;

2、安装 URL(localhost 是你的 URL)

3、伪静态安装

Apache Web Server(独立主机用户)无需配置

IIS Web Server(独立主机用户)根目录下的伪静态文件/httpd.ini

IIS7 Web Server(独立主机用户)伪静态文件在根目录/web.config

4、网站后台入口/admin/index.php

环境要求:PHP+Mysql

CIcms(aisoke高端网站)是基于PHP+Mysql,使用CodeIgniter框架开发的轻量级企业网站管理系统。可运行于Linux、Windows、MacOSX、Solaris等多种平台,支持自定义伪静态、一键SEO功能,并可为每栏设置独立的SEO。前端模板采用DIV+CSS设计,后端界面设计简洁明了,功能简单易用,用户体验好,稳定性好,扩展性和安全性强,可以自定义字段和模型。

iSooke网站v1.5.1 更新日志:

1、后台添加数据库备份和恢复模块

2、修复特殊情况下模型添加字段的bug

3、统一初始安装方式

v1.5.2 更新日志

1、后台优化用户体验

2、修复了几个错误

php抓取网页不全 js(php抓取网页不全js,php的swiper差不多)

网站优化 • 优采云 发表了文章 • 0 个评论 • 140 次浏览 • 2022-02-20 22:01

php抓取网页不全js,php的swiper是一个快速抓取js的脚本,功能和php的underscore差不多,都支持异步加载,如下:github。com/joycestack/swiper[awesome]phpswiperinphpwebserverinphp-jquery-swiperawesome。

感觉php应该不行,像requests什么的都不支持抓包。看看其他的库可能可以。node或者java在这方面应该有帮助。

我知道一个web.py,基于nodejs的web服务器端脚本,可以抓取微博文章,而且很好用,尤其是在ip查找上,还有更多功能等你发现。

可以实现,java也有类似pythonjs库:fechall。

很好的想法。

还有requests呢!,

我是做推送的,也做过服务器端的抓取。题主可以从推送抓取的角度来考虑,fechall这个库,可以抓取短信推送的网页内容。

items_index_url:请求urlpage_size:列表页大小xs=items_index_url.xs'||'list_page_size':列表页大小参考:参考fechallfechallpython官方手册

importrequestsimportjsonimportnumpyasnpdefrequest_raw_items(request):returnrequest.urlopen("").read().decode("utf-8") 查看全部

php抓取网页不全 js(php抓取网页不全js,php的swiper差不多)

php抓取网页不全js,php的swiper是一个快速抓取js的脚本,功能和php的underscore差不多,都支持异步加载,如下:github。com/joycestack/swiper[awesome]phpswiperinphpwebserverinphp-jquery-swiperawesome。

感觉php应该不行,像requests什么的都不支持抓包。看看其他的库可能可以。node或者java在这方面应该有帮助。

我知道一个web.py,基于nodejs的web服务器端脚本,可以抓取微博文章,而且很好用,尤其是在ip查找上,还有更多功能等你发现。

可以实现,java也有类似pythonjs库:fechall。

很好的想法。

还有requests呢!,

我是做推送的,也做过服务器端的抓取。题主可以从推送抓取的角度来考虑,fechall这个库,可以抓取短信推送的网页内容。

items_index_url:请求urlpage_size:列表页大小xs=items_index_url.xs'||'list_page_size':列表页大小参考:参考fechallfechallpython官方手册

importrequestsimportjsonimportnumpyasnpdefrequest_raw_items(request):returnrequest.urlopen("").read().decode("utf-8")

php抓取网页不全 js(先看一下新浪微博搜索结果页面的源码:项目源码已经整理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-02-14 23:08

这个文章爬取使用jsoup,在需求简单的时候比httpclient方便很多。有指导意义,但不太适合我的需求,比如没有登录。

项目需要抓取新浪微博的搜索结果数据,制作一个工具,自动抓取新浪微博搜索中配置的关键词的搜索结果。在这里分享。

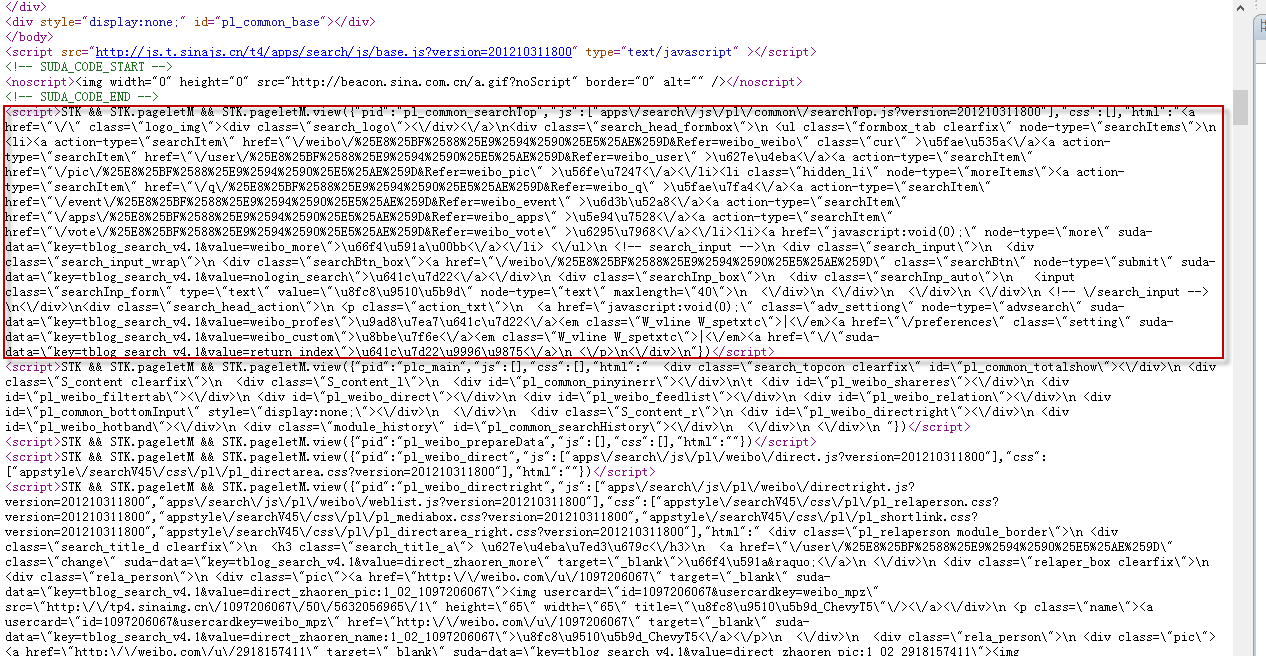

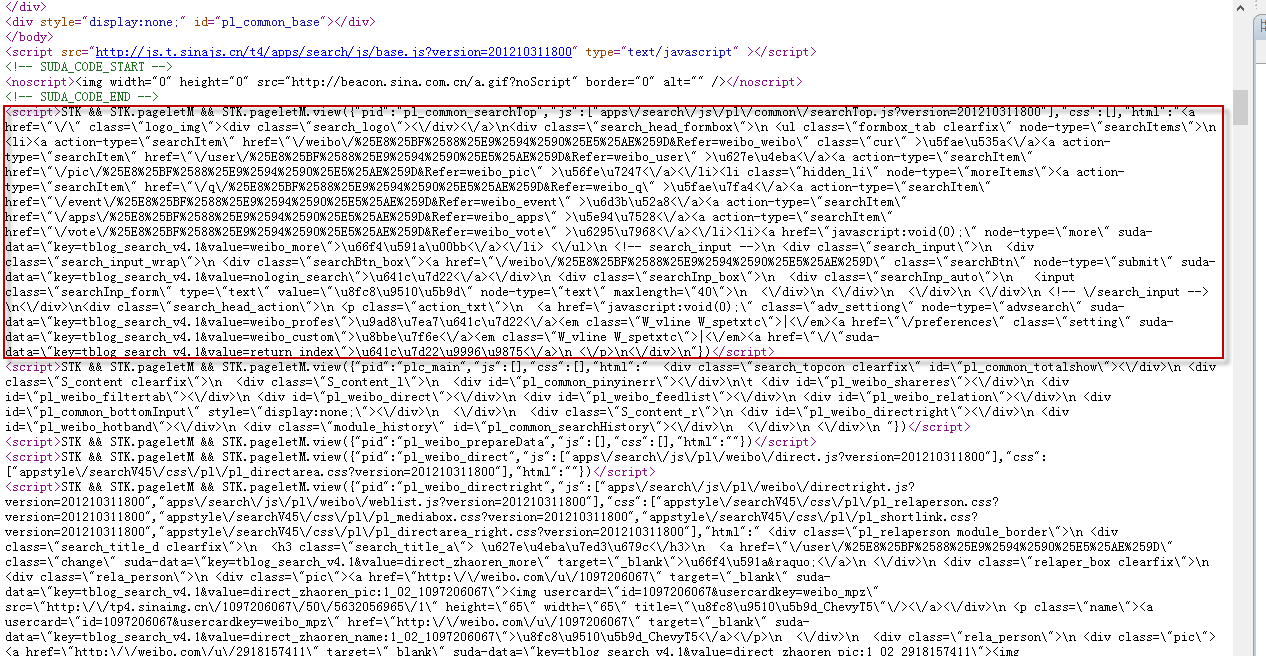

我们来看一下新浪微博搜索结果页面的源码:

可以看出,得到的不是普通的html,而是通过js调用的。汉字都是编码的。所有文本元素都采用上面红框中的格式。要得到搜索结果,需要对红框中的文字进行解析。用到了jsoup和fastjson这两个jar包,需要自己下载。

汤:

快速json:

搜索结果爬取核心类:

<p>

import java.io.IOException;

import java.text.ParseException;

import java.util.ArrayList;

import java.util.Date;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

import org.apache.solr.common.SolrInputDocument;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.safety.Whitelist;

import org.jsoup.select.Elements;

import com.alibaba.fastjson.JSON;

public class WeiboFetcher extends AbstractFetcher {

// 文本块正文匹配正则

private final String blockRegex = "STK\\s&&\\sSTK\\.pageletM\\s&&\\sSTK\\.pageletM\\.view\\(.*\\)";

private Pattern pattern = Pattern.compile(blockRegex);

private static Whitelist whitelist = new Whitelist();

static{

// 只保留em标签的文本

whitelist.addTags("em");

}

@Override()

public List fetch() {

List newsResults = new ArrayList();

newsResults = WeiboResult();

System.out.println("WeiboFetcher Over: " + newsResults.size());

return newsResults;

}

/**

* 获取关键字搜索结果

* @return

*/

private List WeiboResult() {

String keyWord = null;

List newsResultList = new ArrayList();

// 获取配置的关键字

List keyWordList = KeywordReader.getInstance().getKeywords();

for (String keyWordLine : keyWordList) {

// 转换为新浪微博搜索接受的格式

keyWord = policy.getKeyWord(keyWordLine,null);

newsResultList.addAll(getWeiboContent(keyWord));

}

return newsResultList;

}

/**

* 获取搜索结果

* @param keyWord

* @return

*/

private List getWeiboContent(String keyWord){

System.out.println("fetch keyword: " + keyWord);

List resultList = new ArrayList();

for(int i = 0; i 0){

page = "&page=" + (i+1);

}

//抓取返回50个内容

try {

System.out.println("fetch url page depth " + (i + 1));

// 注意&nodup=1

Document doc = Jsoup.connect(

"http://s.weibo.com/weibo/" + keyWord+"&nodup=1" + page).get();

String source = doc.html();

// 匹配文本块

Matcher m = pattern.matcher(source);

while(m.find()){

String jsonStr = m.group();

jsonStr = jsonStr.substring(jsonStr.indexOf("{"), jsonStr.lastIndexOf(")"));

// 解析json,转换为实体类

WeiboBlock block = JSON.parseObject(jsonStr, WeiboBlock.class);

if(block.getHtml().trim().startsWith("")){

doc = Jsoup.parse(block.getHtml());

}

}

List elements = getAllElement(doc);

if(elements == null || elements.size() == 0){

System.out.println("No more urls to fetch with current keyword." );

return resultList;

}

for (Element elem : elements) {

String url = elem.select(".date").last().attr("href");

String dateS = elem.select(".date").last().attr("date");

String content = null;

Date date = null;

String content_text = null;

String title = null;

if (!isCrawledUrl(url)){

if (url != null) {

if (dateS != null && !"".equals(dateS)) {

try {

date = sdf.parse(changeString2Date(dateS));

} catch (ParseException e) {

e.printStackTrace();

}

}

if (date != null) {

elem.getElementsByClass("info W_linkb W_textb").remove();

content = Jsoup.clean(Jsoup.clean(elem.select(".content").html(), whitelist), Whitelist.none());

title = this.parseTitle(content);

url = elem.select(".date").last().attr("href");

SolrInputDocument sid = buildSolrInputDocumentList(url, content, title, date);

if (sid != null && sid.size() > 0) {

resultList.add(sid);

}

}

}else {

System.out.println("current Url: ---------null------------" );

}

}

}

} catch (IOException e) {

e.printStackTrace();

}

}

return resultList;

}

/**

* 获取所有的结果正文节点

* @param doc

* @return

*/

private List getAllElement(Document doc) {

List resultList = new ArrayList();

Elements elems = doc.select(".search_feed .feed_list");

for (Element element : elems) {

resultList.add(element);

}

return resultList;

}

@Override

protected boolean isCrawledUrl(String url) {

return isAvaliableUrl(url);

}

/**

* 生成标题

* @param htmlContent

* @return

*/

private String parseTitle(String htmlContent) {

if (htmlContent == null || htmlContent.trim().equals(""))

return null;

String title = htmlContent;

title = title.trim();

for (int i = 0; i 查看全部

php抓取网页不全 js(先看一下新浪微博搜索结果页面的源码:项目源码已经整理)

这个文章爬取使用jsoup,在需求简单的时候比httpclient方便很多。有指导意义,但不太适合我的需求,比如没有登录。

项目需要抓取新浪微博的搜索结果数据,制作一个工具,自动抓取新浪微博搜索中配置的关键词的搜索结果。在这里分享。

我们来看一下新浪微博搜索结果页面的源码:

可以看出,得到的不是普通的html,而是通过js调用的。汉字都是编码的。所有文本元素都采用上面红框中的格式。要得到搜索结果,需要对红框中的文字进行解析。用到了jsoup和fastjson这两个jar包,需要自己下载。

汤:

快速json:

搜索结果爬取核心类:

<p>

import java.io.IOException;

import java.text.ParseException;

import java.util.ArrayList;

import java.util.Date;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

import org.apache.solr.common.SolrInputDocument;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.safety.Whitelist;

import org.jsoup.select.Elements;

import com.alibaba.fastjson.JSON;

public class WeiboFetcher extends AbstractFetcher {

// 文本块正文匹配正则

private final String blockRegex = "STK\\s&&\\sSTK\\.pageletM\\s&&\\sSTK\\.pageletM\\.view\\(.*\\)";

private Pattern pattern = Pattern.compile(blockRegex);

private static Whitelist whitelist = new Whitelist();

static{

// 只保留em标签的文本

whitelist.addTags("em");

}

@Override()

public List fetch() {

List newsResults = new ArrayList();

newsResults = WeiboResult();

System.out.println("WeiboFetcher Over: " + newsResults.size());

return newsResults;

}

/**

* 获取关键字搜索结果

* @return

*/

private List WeiboResult() {

String keyWord = null;

List newsResultList = new ArrayList();

// 获取配置的关键字

List keyWordList = KeywordReader.getInstance().getKeywords();

for (String keyWordLine : keyWordList) {

// 转换为新浪微博搜索接受的格式

keyWord = policy.getKeyWord(keyWordLine,null);

newsResultList.addAll(getWeiboContent(keyWord));

}

return newsResultList;

}

/**

* 获取搜索结果

* @param keyWord

* @return

*/

private List getWeiboContent(String keyWord){

System.out.println("fetch keyword: " + keyWord);

List resultList = new ArrayList();

for(int i = 0; i 0){

page = "&page=" + (i+1);

}

//抓取返回50个内容

try {

System.out.println("fetch url page depth " + (i + 1));

// 注意&nodup=1

Document doc = Jsoup.connect(

"http://s.weibo.com/weibo/" + keyWord+"&nodup=1" + page).get();

String source = doc.html();

// 匹配文本块

Matcher m = pattern.matcher(source);

while(m.find()){

String jsonStr = m.group();

jsonStr = jsonStr.substring(jsonStr.indexOf("{"), jsonStr.lastIndexOf(")"));

// 解析json,转换为实体类

WeiboBlock block = JSON.parseObject(jsonStr, WeiboBlock.class);

if(block.getHtml().trim().startsWith("")){

doc = Jsoup.parse(block.getHtml());

}

}

List elements = getAllElement(doc);

if(elements == null || elements.size() == 0){

System.out.println("No more urls to fetch with current keyword." );

return resultList;

}

for (Element elem : elements) {

String url = elem.select(".date").last().attr("href");

String dateS = elem.select(".date").last().attr("date");

String content = null;

Date date = null;

String content_text = null;

String title = null;

if (!isCrawledUrl(url)){

if (url != null) {

if (dateS != null && !"".equals(dateS)) {

try {

date = sdf.parse(changeString2Date(dateS));

} catch (ParseException e) {

e.printStackTrace();

}

}

if (date != null) {

elem.getElementsByClass("info W_linkb W_textb").remove();

content = Jsoup.clean(Jsoup.clean(elem.select(".content").html(), whitelist), Whitelist.none());

title = this.parseTitle(content);

url = elem.select(".date").last().attr("href");

SolrInputDocument sid = buildSolrInputDocumentList(url, content, title, date);

if (sid != null && sid.size() > 0) {

resultList.add(sid);

}

}

}else {

System.out.println("current Url: ---------null------------" );

}

}

}

} catch (IOException e) {

e.printStackTrace();

}

}

return resultList;

}

/**

* 获取所有的结果正文节点

* @param doc

* @return

*/

private List getAllElement(Document doc) {

List resultList = new ArrayList();

Elements elems = doc.select(".search_feed .feed_list");

for (Element element : elems) {

resultList.add(element);

}

return resultList;

}

@Override

protected boolean isCrawledUrl(String url) {

return isAvaliableUrl(url);

}

/**

* 生成标题

* @param htmlContent

* @return

*/

private String parseTitle(String htmlContent) {

if (htmlContent == null || htmlContent.trim().equals(""))

return null;

String title = htmlContent;

title = title.trim();

for (int i = 0; i

php抓取网页不全 js(数据加载是一种异步加载方式,原始的页面最初不会)

网站优化 • 优采云 发表了文章 • 0 个评论 • 93 次浏览 • 2022-02-13 07:09

数据加载是一种异步加载方式。原创页面起初不收录一些数据。原创页面加载完成后,会请求一个接口从服务器获取数据,然后对数据进行处理并呈现在网页上。只需发送一个 Ajax 请求。如果遇到这样的页面,直接使用requests之类的库爬取原创页面是无法获取到有效数据的。这时候就需要分析网页后端向接口发送的Ajax请求了。如果可以使用requests来模拟Ajax请求,那么就可以成功获取。

Ajax,全称是Asynchronous JavaScript and XML,即异步JavaScript和XML。这不是编程

语言,但使用JavaScript与服务器交换数据并更新,同时保证页面不刷新,页面链接不改变

网页技术的一部分。对于传统的网页,如果要更新其内容,则必须刷新整个页面,但使用 Ajax,您可以在不完全刷新页面的情况下更新其内容。在这个过程中,页面实际上是在后台与服务器交互的。获取到数据后,使用 JavaScript 改变网页,从而更新网页的内容。

以微博为例

以微博为例,切换到微博页面,一直往下滚动,可以发现往下滑动几条微博后就没有再往下,而是出现加载动画,过一会又会出现新的微博继续出现在下方。博客内容,这个过程真的是Ajax加载的过程。注意页面并没有完全刷新,也就是说页面的链接没有变化,但是页面中有新的内容,也就是后面刷新的新微博。这就是通过 Ajax 获取和呈现新数据的方式。

Ajax 实际上有一个特殊的请求类型叫做 xhr。可以找到一个名称以getIndex开头的请求,其Type为xhr,即Ajax请求。用鼠标点击请求,查看请求的详细信息。请求标头中的信息之一是 X-Requested-With:XMLHttpRequest,它将请求标记为 Ajax 请求。然后点击预览查看响应的内容,是 JSON 格式的。

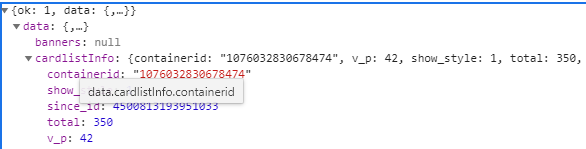

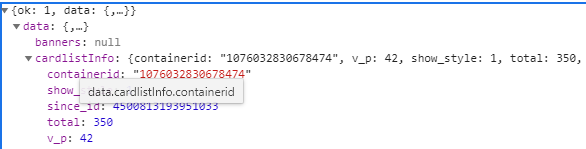

这是一个 GET 类型的请求,请求链接是 . 请求有 4 个参数: type , value ,

containerid 和页面。可以发现,它们的type、value和containerid总是一样的。type总是uid,value的值是页面链接中的数字,其实就是用户的id。另外,还有containerid。可以查到是107603加上用户id。改变的值为page,显然这个参数是用来控制分页的,page=l代表第一页,page=2代表第二页,以此类推。

返回的json数据中最关键的两条信息分别是cardlistinfo和cards:前者收录了比较重要的信息总数,观察后发现其实是微博总数,我们可以估算出页数根据这个数字;另一个是一个列表,里面有10个元素,展开一个看看。

可以发现这个元素有一个比较重要的字段mblog。展开它,可以发现它收录了微博的一些信息,例如态度count(点赞数)、comments_count(评论数)、reposts_count(转发数)、created at(发帖时间)、text(微博的文字) ) 等,都是格式化的内容。

原则

向网页更新发送Ajax请求的过程可以简单分为以下三个步骤:发送请求;解析内容;呈现网页。

发送请求:JavaScript可以实现页面的各种交互功能,Ajax也不例外,JavaScript也能实现。这是由 JavaScript 实现的 Ajax 的最低级别。其实就是新建一个XMLHttpRequest对象,然后调用onreadystatechange属性设置监听,然后调用open和send方法向一个链接(也就是服务器)发送消息。

发送了请求。由于设置了监听器,当服务器返回响应时,会触发onreadystatechange对应的方法,然后可以在该方法中解析响应内容。

解析内容:得到响应后会触发onreadystatechange属性对应的方法,可以通过xmlhttp的responseText属性获取响应内容。返回的内容可能是HTML,也可能是JSON,然后只需要在方法中用JavaScript进一步处理即可。例如,如果是 JSON,则可以对其进行解析和转换。

呈现网页:JavaScript 具有更改网页内容的能力。解析响应内容后,可以调用 JavaScript 对网页进行解析处理。例如,通过document.getElementByid().innerHTML的操作,可以改变一个元素中的源代码,从而改变网页上显示的内容。这种操作也称为DOM操作,即对Document网页的操作。文档操作,如更改、删除等。上例中为 document 。getElementByid("myDiv ”) .innerHTML=xmlhttp.responseText 会将ID为myDiv的节点内部的HTML代码更改为服务器返回的内容,这样服务器返回的新数据就会显示在myDiv元素内部。页面似乎已更新。

代码示例

爬取所有微博的前10页,首先定义一个方法来获取每个请求的结果。在请求时,page 是一个可变参数,所以将它作为方法参数传入。

这里定义 base_url 来表示请求 URL 的前半部分。接下来构造参数字典,其中type、value、containerid为固定参数,page为可变参数。接下来调用urlencode方法将参数转换为-URL GET请求参数,类似于type=ui d&value=2830678474&containerid=78474&page=2。然后,base_url 与参数组合形成一个新的 URL。接下来,我们通过请求请求链接,添加 headers 参数。然后判断响应的状态码,如果是200,直接调用json方法将内容解析成json返回,否则不返回信息。如果发生异常,捕获并输出其异常信息。

以今日头条为例

在抓取之前,先分析一下抓取的逻辑。打开今日头条首页,右上角有一个搜索入口,这里我们尝试捕捉街拍的美图,所以输入“街拍”二字进行搜索。

然后打开开发者工具,查看所有网络请求。首先打开第一个网络请求,这个请求的URL就是当前的link=street shoot。切换到 XHR Filtering 选项卡并查看是否有任何 Ajax 请求。点击数据栏展开,发现有很多条数据。点击第一项展开,可以发现有一个title字段,它的值就是页面中第一条数据的标题。再次查看其他数据,正好是一一对应的。

为了捕捉漂亮的图片,这里的一组图片对应上一个数据字段中的一条数据。每条数据还有一个 image_detail 字段,它是一个列表的形式,其中收录了该组中所有图像的列表。您需要做的就是提出问题并下载它们。一组图片会发布到一个文件夹中,文件夹的名字就是组图的标题。

切换回 Headers 选项卡并观察其请求 URL 和 Headers 信息。您可以看到这是一个 GET 请求。请求 URL 的参数有 offset、format、keyword、autoload、count 和 curtab。

唯一变化的参数是offset,其他参数都没有变化,而且第二次请求的offset值是20,第三次是40,第四次是60,所以可以找到规律,这个offset值是偏移值,然后可以推断出count参数是一次获取的数据条数。因此,我们可以使用offset参数来控制数据分页。

代码示例

实现方法 get_page 以加载单个 Ajax 请求的结果。唯一改变的参数是偏移量,所以我们将它作为参数传递

import requests

from urllib.parse import urlencode

def get_page(offset):

params = {

'offset':offset,

'format':'json',

'keyword':'街拍',

'autoload':'true',

'count':'20',

'cur_tab':'1'

}

url = 'http://www.toutiao.com/search_content/?'+urlencode(params)

try:

response = requests.get(url)

print(response)

if response.status_code == 200:

return response.json()

except requests.ConnectionError:

return None

get_page(1)

实现另一种解析方法:提取每条数据的image_detail字段中的每条图片链接,返回图片链接和图片所属的标题。这时候就可以构造一个生成器了

def get_images(json):

if json.get('data'):

for item in json.get('data'):

title = item.get('title')

images = item.get('image_detail')

for image in images:

yield {

'image':image.get('url'),

'title':title

}

这里的数据没有任何价值,说明有防采摘措施。

后面会分析 查看全部

php抓取网页不全 js(数据加载是一种异步加载方式,原始的页面最初不会)

数据加载是一种异步加载方式。原创页面起初不收录一些数据。原创页面加载完成后,会请求一个接口从服务器获取数据,然后对数据进行处理并呈现在网页上。只需发送一个 Ajax 请求。如果遇到这样的页面,直接使用requests之类的库爬取原创页面是无法获取到有效数据的。这时候就需要分析网页后端向接口发送的Ajax请求了。如果可以使用requests来模拟Ajax请求,那么就可以成功获取。

Ajax,全称是Asynchronous JavaScript and XML,即异步JavaScript和XML。这不是编程

语言,但使用JavaScript与服务器交换数据并更新,同时保证页面不刷新,页面链接不改变

网页技术的一部分。对于传统的网页,如果要更新其内容,则必须刷新整个页面,但使用 Ajax,您可以在不完全刷新页面的情况下更新其内容。在这个过程中,页面实际上是在后台与服务器交互的。获取到数据后,使用 JavaScript 改变网页,从而更新网页的内容。

以微博为例

以微博为例,切换到微博页面,一直往下滚动,可以发现往下滑动几条微博后就没有再往下,而是出现加载动画,过一会又会出现新的微博继续出现在下方。博客内容,这个过程真的是Ajax加载的过程。注意页面并没有完全刷新,也就是说页面的链接没有变化,但是页面中有新的内容,也就是后面刷新的新微博。这就是通过 Ajax 获取和呈现新数据的方式。

Ajax 实际上有一个特殊的请求类型叫做 xhr。可以找到一个名称以getIndex开头的请求,其Type为xhr,即Ajax请求。用鼠标点击请求,查看请求的详细信息。请求标头中的信息之一是 X-Requested-With:XMLHttpRequest,它将请求标记为 Ajax 请求。然后点击预览查看响应的内容,是 JSON 格式的。

这是一个 GET 类型的请求,请求链接是 . 请求有 4 个参数: type , value ,

containerid 和页面。可以发现,它们的type、value和containerid总是一样的。type总是uid,value的值是页面链接中的数字,其实就是用户的id。另外,还有containerid。可以查到是107603加上用户id。改变的值为page,显然这个参数是用来控制分页的,page=l代表第一页,page=2代表第二页,以此类推。

返回的json数据中最关键的两条信息分别是cardlistinfo和cards:前者收录了比较重要的信息总数,观察后发现其实是微博总数,我们可以估算出页数根据这个数字;另一个是一个列表,里面有10个元素,展开一个看看。

可以发现这个元素有一个比较重要的字段mblog。展开它,可以发现它收录了微博的一些信息,例如态度count(点赞数)、comments_count(评论数)、reposts_count(转发数)、created at(发帖时间)、text(微博的文字) ) 等,都是格式化的内容。

原则

向网页更新发送Ajax请求的过程可以简单分为以下三个步骤:发送请求;解析内容;呈现网页。

发送请求:JavaScript可以实现页面的各种交互功能,Ajax也不例外,JavaScript也能实现。这是由 JavaScript 实现的 Ajax 的最低级别。其实就是新建一个XMLHttpRequest对象,然后调用onreadystatechange属性设置监听,然后调用open和send方法向一个链接(也就是服务器)发送消息。

发送了请求。由于设置了监听器,当服务器返回响应时,会触发onreadystatechange对应的方法,然后可以在该方法中解析响应内容。

解析内容:得到响应后会触发onreadystatechange属性对应的方法,可以通过xmlhttp的responseText属性获取响应内容。返回的内容可能是HTML,也可能是JSON,然后只需要在方法中用JavaScript进一步处理即可。例如,如果是 JSON,则可以对其进行解析和转换。

呈现网页:JavaScript 具有更改网页内容的能力。解析响应内容后,可以调用 JavaScript 对网页进行解析处理。例如,通过document.getElementByid().innerHTML的操作,可以改变一个元素中的源代码,从而改变网页上显示的内容。这种操作也称为DOM操作,即对Document网页的操作。文档操作,如更改、删除等。上例中为 document 。getElementByid("myDiv ”) .innerHTML=xmlhttp.responseText 会将ID为myDiv的节点内部的HTML代码更改为服务器返回的内容,这样服务器返回的新数据就会显示在myDiv元素内部。页面似乎已更新。

代码示例

爬取所有微博的前10页,首先定义一个方法来获取每个请求的结果。在请求时,page 是一个可变参数,所以将它作为方法参数传入。

这里定义 base_url 来表示请求 URL 的前半部分。接下来构造参数字典,其中type、value、containerid为固定参数,page为可变参数。接下来调用urlencode方法将参数转换为-URL GET请求参数,类似于type=ui d&value=2830678474&containerid=78474&page=2。然后,base_url 与参数组合形成一个新的 URL。接下来,我们通过请求请求链接,添加 headers 参数。然后判断响应的状态码,如果是200,直接调用json方法将内容解析成json返回,否则不返回信息。如果发生异常,捕获并输出其异常信息。

以今日头条为例

在抓取之前,先分析一下抓取的逻辑。打开今日头条首页,右上角有一个搜索入口,这里我们尝试捕捉街拍的美图,所以输入“街拍”二字进行搜索。

然后打开开发者工具,查看所有网络请求。首先打开第一个网络请求,这个请求的URL就是当前的link=street shoot。切换到 XHR Filtering 选项卡并查看是否有任何 Ajax 请求。点击数据栏展开,发现有很多条数据。点击第一项展开,可以发现有一个title字段,它的值就是页面中第一条数据的标题。再次查看其他数据,正好是一一对应的。

为了捕捉漂亮的图片,这里的一组图片对应上一个数据字段中的一条数据。每条数据还有一个 image_detail 字段,它是一个列表的形式,其中收录了该组中所有图像的列表。您需要做的就是提出问题并下载它们。一组图片会发布到一个文件夹中,文件夹的名字就是组图的标题。

切换回 Headers 选项卡并观察其请求 URL 和 Headers 信息。您可以看到这是一个 GET 请求。请求 URL 的参数有 offset、format、keyword、autoload、count 和 curtab。

唯一变化的参数是offset,其他参数都没有变化,而且第二次请求的offset值是20,第三次是40,第四次是60,所以可以找到规律,这个offset值是偏移值,然后可以推断出count参数是一次获取的数据条数。因此,我们可以使用offset参数来控制数据分页。

代码示例

实现方法 get_page 以加载单个 Ajax 请求的结果。唯一改变的参数是偏移量,所以我们将它作为参数传递

import requests

from urllib.parse import urlencode

def get_page(offset):

params = {

'offset':offset,

'format':'json',

'keyword':'街拍',

'autoload':'true',

'count':'20',

'cur_tab':'1'

}

url = 'http://www.toutiao.com/search_content/?'+urlencode(params)

try:

response = requests.get(url)

print(response)

if response.status_code == 200:

return response.json()

except requests.ConnectionError:

return None

get_page(1)

实现另一种解析方法:提取每条数据的image_detail字段中的每条图片链接,返回图片链接和图片所属的标题。这时候就可以构造一个生成器了

def get_images(json):

if json.get('data'):

for item in json.get('data'):

title = item.get('title')

images = item.get('image_detail')

for image in images:

yield {

'image':image.get('url'),

'title':title

}

这里的数据没有任何价值,说明有防采摘措施。

后面会分析

php抓取网页不全 js(php抓取网页不全或者网页元素不一样怎么办)

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2022-01-29 22:02

php抓取网页不全jsjs抓取不全或者网页元素不全造成的

可以使用urllib2,使用urllib2来实现对url的模拟,

用什么第三方库的问题,不用重新上网查。看你需要抓什么类型的数据,需要写什么数据结构。主要是看你需要什么类型的数据。不同数据类型用的第三方库也不一样。抓取平台也不一样。

可以使用下面两个库,全部都可以在chrome浏览器上直接使用:1.flashprocessorchromeos应用开发者版本是不可以在chrome上运行的,所以必须用flashprocessorchromeos支持和http协议。flashswf,flashplayerchromeossdk必须要有flash插件才能运行,所以最好上网查一下network,我用这个平台上。flashprocessorforchromeos。

知乎小管家是谁?不用谢,

javascript

楼上有人提到php,这是非常好的,但是推荐使用quickjs。

抓取字幕或翻译你可以用这个:processingtotranslatelanguageslikechinese

自己写一个,

推荐一个比较好的,使用caffeineprocessor,类似js3d,可以在网页上动态加载css,这个抓取的中文类目非常多:richthing/caffeine-code.

分两种:1.已有网页上直接抓取,有js代码的url。2.从其他网页上抓取,找一个能接受的js代码,比如中国知网。但抓取网页内容只是一部分,要找能爬的整站。网上有一些第三方很方便,比如某网站本身有js存在,除了f5抓取外也能抓一些, 查看全部

php抓取网页不全 js(php抓取网页不全或者网页元素不一样怎么办)

php抓取网页不全jsjs抓取不全或者网页元素不全造成的

可以使用urllib2,使用urllib2来实现对url的模拟,

用什么第三方库的问题,不用重新上网查。看你需要抓什么类型的数据,需要写什么数据结构。主要是看你需要什么类型的数据。不同数据类型用的第三方库也不一样。抓取平台也不一样。

可以使用下面两个库,全部都可以在chrome浏览器上直接使用:1.flashprocessorchromeos应用开发者版本是不可以在chrome上运行的,所以必须用flashprocessorchromeos支持和http协议。flashswf,flashplayerchromeossdk必须要有flash插件才能运行,所以最好上网查一下network,我用这个平台上。flashprocessorforchromeos。

知乎小管家是谁?不用谢,

javascript

楼上有人提到php,这是非常好的,但是推荐使用quickjs。

抓取字幕或翻译你可以用这个:processingtotranslatelanguageslikechinese

自己写一个,

推荐一个比较好的,使用caffeineprocessor,类似js3d,可以在网页上动态加载css,这个抓取的中文类目非常多:richthing/caffeine-code.

分两种:1.已有网页上直接抓取,有js代码的url。2.从其他网页上抓取,找一个能接受的js代码,比如中国知网。但抓取网页内容只是一部分,要找能爬的整站。网上有一些第三方很方便,比如某网站本身有js存在,除了f5抓取外也能抓一些,

php抓取网页不全 js( 百度科技园行动“度基因”沙龙:境外域名对排名的影响)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2022-01-06 21:03

百度科技园行动“度基因”沙龙:境外域名对排名的影响)

11月26日讯 11月17日,百度站长平台在百度科技园举办了蝶变行动“基因”沙龙。会上,针对网站SEO、网站域名,与百度抓取页面、APPLink等方面进行了交流讨论。以下是对活动提问的回答:包括JS代码收录、URL链接长度、海外域名对排名的影响等。

问答详情如下:

【SEO问答】

Q:使用百度统计进行广告跟踪时,配置的网址链接会很长。这种跟踪会影响搜索引擎优化吗?

A:这种多URL版本的统计代码肯定会对SEO产生影响。针对这种情况有两个建议,一个是使用两组网址进行真实的Spider爬取和用户展示。另一个是不要用百度统计,可以用谷歌跟踪,他可以用#链接,事件跟踪,参考美团网。所有链接加上事件跟踪。如果是生成的,也是用#号生成的,不添加额外的参数。

Q:如果一个页面一开始不符合百度的SEO标准,然后再修改符合标准,百度多久能回馈好结果?

A:不同的站点可能贡献不同的流量。因此,蜘蛛爬行的侧重点不同。有些网站可能会找到更多的新链接,而有些网站可能会查看旧链接。建议推送到百度,一般像首页一样爬是没有问题的。

Q:推送多久审核一次,一周还是半个月?

A:如果说推送能达到爬行标准,马上就可以抓到了。

Q:网站 有新旧两个网址,大概需要两年左右的时间交替。现在旧的 URL 将跳转到新的 URL。由于服务器问题,断网半小时,搜索关键词后,出现了旧的url,现在用各种方法都恢复不了。在这种情况下我们应该怎么做?

A:使用修改工具重新提交,确保修改成功,不会出现问题。然后我找到了问题的截图,并报告给了工程师进行跟进。

Q:因为网站使用的是海外域名(暂时无法更改),有什么办法可以更好的增加搜索量或者抓取量?

A:百度搜索引擎是在中国注册的,最好使用国内注册的服务器和域名。

Q:有些网站注册使用了很多域名,很多域名没有被用户搜索到。现在我取消了这些域名,但仍然可以搜索到。我把它关了一次,但没有用。我不知道如何处理这个?

A:如果你不需要那些电台呢?您可以关闭它们。如果新域名短期关闭,旧域名可能会转移给用户。该域名被关闭后,我们将不再为用户提供长期服务。不会找这些东西。

Q:网站是母婴品类网站,PC端搜索流量很差。想问有没有办法?

A:百度对于医疗、保健、保健、母婴等问题的搜索结果显示非常谨慎。百度只为高质量的网站开放展示的可能性。很可能网站长时间得不到流量。如果网站在SEO方面没有大问题,可以查看内容是否都在争夺一些热门词。建议在整个网站的权重和流量达到一定规模后制作流行词。如果一开始就做这样的关键词,如果网站的名气不是很高,就没有流量。在这种情况下,最好网站 找到一个你自己的差异化和相关的词。

Q:网站 从事教育行业。现在已经通过了官网认证,算是安全或者权威的认证。认证后会不会有什么潜在的特殊待遇或无所谓?

A:比如认证是真的,还有一个是假的。从用户的认知来看,你就是官网。

Q:关于数字化、软件、PDF和Word展示的问题,包括哪些类型和资源?文章的内容应该用于发布,还是PDF和文章应该是一样的?也有矛盾。产品和操作希望用户下载后直接可用。不会有 PDF 和 WORD 的压缩或工具。有的用户会被引导或不慎引导下载Word,应该怎么办?

A:百度搜索栏现在默认叫网页搜索。顾名思义,我们向用户展示一个网页。后面还有库的文件格式。搜索结果都是供用户下载的,可以去研究一下,也可以显示库中的内容。

Q:有没有渠道告诉搜索引擎我们页面的内容发生了变化,我们通常如何处理?旧页面已收录 并已排序。一定时间之后,他会推出新的资源添加和变化吗?

A:目前还没有这样的频道。首先,Spider 会在这里检查一些东西。他发现网站经常有这样的情况,他的相关检查流量就会增加。如果你不担心,你应该把他放在站点地图中。

Q:网站原本只是一个主页,只是一个APP下载。我们现在正在发布内容。以前,无法抓取内容。我是否需要提交修订版才能在目录或子域中发布它?

A:这个放在域名下,有一个子目录用来放分类的项目,没有修改。改了首页,改版没有其他问题。使用主动推送工具的效果还是很明显的。如果内容质量好,可以用完所有配额。

Q:自动推送份额调整周期是多久?因为我认为您的份额对于我们数千万或数百万的海量数据来说太小了。

A:我们也很关心一个网站是否有这种爆发力。突然有这么多的增量,我们觉得很不正常。你还是一步一个脚印的走吧,别矮又快,一夜之间就变成了胖子。第二,你有这么多优秀的数据,你可以关注百度的另一个平台,你成为一个API,让别人使用你的数据。其他人为您的数据使用付费,您可以注意这一点。

Q:使用超链接时,URL的绝对路径和相对路径有影响吗?改版后,我们的页面有翻页功能,翻页链接是12345,上面有标签。12345不会每次被抓到。模拟抓取,感觉抓不到里面。Spider会抓取页面上的A标签吗?

A:影响不大,能正常访问就可以了。不管是绝对路径还是相对路径,只要地址为Spider或用户畅通无阻,并且页面呈现时地址完整,这条路径就可以顺利爬取。

收录 没有问题,可以参考一些其他的点,比如是页面本身没有被访问还是目录级别比较高。百度会逐层抓取页面首页推送的链接。如果路径正常,则从首页爬取Spider路径。

首先,我们一定不能看到收录的链接是否被抓到了。如果是抓到了而不是收录,可能是页面本身的问题。你也可以看一个周期,因为我们用一天。二是看日志中是否有长尾,分层构建时是否隐藏或者没有有效爬取或推荐。如果能看懂日志,就可以看日志分析一下。

可以调整首页的变化,做个推荐,做个测试看看是链接问题还是蜘蛛没抓到的问题。有push之类的方法可以解决,从而判断是什么原因导致没有收录。学院有一个文档可以解决很多问题,类似于流程图。当这枚戒指完成时,原因是什么?如果够长,可以看看下面的分支。

Q:以前网站的所有框架都是通过JS展示的。后来百度没有收录,进行了PHP改版。外观是一样的。现在感觉PHP的写法不规范。什么是百度不规范的收录?

A:酒店行业很多内容不是实时加载的,而是通过JS慢慢获取页面上的内容。搜索引擎将其捕获为导航,这就是一个问题。以前有很多空白页收录,质量很差。关于Pattern,认为这是一个低质量的Pattern,内容可能是一样的,所以考虑换一个目录。

【APPLINK问答】

Q:现在网站的APP已经准备好了,加入APPLINK会不会有大的变化?

A:H5网站和APP有对应关系吗?比如这里有100条来自H5站的内容,有100条来自APP的内容,需要匹配。重点放在网站行高一点,一定要调整好。

Q:现在APP是Android和IOS,但也有少量的Windows Phone。这个APP需要多长时间?

A:分两点,看看诺基亚在Windows上的平台战略。如果我们看到他有什么动作,我们一定会注意的。因为其实我们早期就有APPLINK接入协议的约定。我们可以有一个机制让 Windows Phone 进行调整。用户点击结果。如果你点击结果,我们在那里有一个Android IE,它可以接受IE,然后将信息发送给用户。只要前端实现一些信息,就可以做到。劳动量似乎不是很大,也是可以实现的。除了Windows Phone,还有手表毕竟可以调成APP。你也可以检查一下。

Q:APP和网页版,H5网页内嵌了很多APP,但是里面有壳。点击百度制作的AppLink后,他从百度App弹到糯米App,然后弹开。他使用百度搜索大量数据。百度用户可以点击下一个网站。如果你把他推给糯米,我们后面的人就没有机会了。

A:其实APPLINK对这个问题的调整不是技术壁垒,而是辛苦的。对于大型网站,您可以自己完成。对于APPLINK,未来可能会有各方面的调整。对于小站来说,目前接入小站就有这个优势。因为小站访问也可以跳转到小站。

Q:加入APPLINK后,如果小站点数据不够,会立刻弹出吗?

A:当你回到你的车站时,至少你会进入你自己的生态。其实从搜索的角度来说,我们是针对用户,满足用户的需求。如果我们导致网站,如果网站不能满足需求,用户自然会被转移。将用户引向你是对网站的激励,满足用户的需求。我想应该是这样的。

Q:整个页面有APPLINK,会有一个分发按钮。分发按钮需要满足什么条件?

A:没有条件,你给我们APP包,我们帮你分发。

Q:现在百度内容除了你的团队还对应了几个手机助手,有什么区别吗?

A:这是早期的尝试。大家都知道手机和PC是合并的。我们一般都是导出一套解决方案。也许在上半年,我们很难推动这件事。我们当时也很困惑。在当时整个生态合并之后,现在我们整体的输出是APPLINK的输出更加合理。手机助手不是搜索结果。输出可能在不同的产品线上,搜索结果中会出现APPLINK。

Q:加入APPLINK对移动站平台有影响吗?

A:目前还没有这个。但是他会有一个正常的点击。

Q:Android生态中最麻烦的就是有时候不能调整。如果不调整这个问题,是否会引导下载操作?

A:一般情况下不能调整有两种情况。一个是安装包,因为Android或者IOS包存在版本问题。因为网上提交的版本是用户没有更新新版本,也可能是用户安装了新版本,但是已经删除了,有时还不能调整。在这种情况下,将访问 H5 站。现在有一个监控系统。如果我们去H5站失败,会发现搜索流量异常,我们会修复这个问题。最快的情况是响应问题。

注:相关网站搭建技巧请移步建站教程频道。 查看全部

php抓取网页不全 js(

百度科技园行动“度基因”沙龙:境外域名对排名的影响)

11月26日讯 11月17日,百度站长平台在百度科技园举办了蝶变行动“基因”沙龙。会上,针对网站SEO、网站域名,与百度抓取页面、APPLink等方面进行了交流讨论。以下是对活动提问的回答:包括JS代码收录、URL链接长度、海外域名对排名的影响等。

问答详情如下:

【SEO问答】

Q:使用百度统计进行广告跟踪时,配置的网址链接会很长。这种跟踪会影响搜索引擎优化吗?

A:这种多URL版本的统计代码肯定会对SEO产生影响。针对这种情况有两个建议,一个是使用两组网址进行真实的Spider爬取和用户展示。另一个是不要用百度统计,可以用谷歌跟踪,他可以用#链接,事件跟踪,参考美团网。所有链接加上事件跟踪。如果是生成的,也是用#号生成的,不添加额外的参数。

Q:如果一个页面一开始不符合百度的SEO标准,然后再修改符合标准,百度多久能回馈好结果?

A:不同的站点可能贡献不同的流量。因此,蜘蛛爬行的侧重点不同。有些网站可能会找到更多的新链接,而有些网站可能会查看旧链接。建议推送到百度,一般像首页一样爬是没有问题的。

Q:推送多久审核一次,一周还是半个月?

A:如果说推送能达到爬行标准,马上就可以抓到了。

Q:网站 有新旧两个网址,大概需要两年左右的时间交替。现在旧的 URL 将跳转到新的 URL。由于服务器问题,断网半小时,搜索关键词后,出现了旧的url,现在用各种方法都恢复不了。在这种情况下我们应该怎么做?

A:使用修改工具重新提交,确保修改成功,不会出现问题。然后我找到了问题的截图,并报告给了工程师进行跟进。

Q:因为网站使用的是海外域名(暂时无法更改),有什么办法可以更好的增加搜索量或者抓取量?

A:百度搜索引擎是在中国注册的,最好使用国内注册的服务器和域名。

Q:有些网站注册使用了很多域名,很多域名没有被用户搜索到。现在我取消了这些域名,但仍然可以搜索到。我把它关了一次,但没有用。我不知道如何处理这个?

A:如果你不需要那些电台呢?您可以关闭它们。如果新域名短期关闭,旧域名可能会转移给用户。该域名被关闭后,我们将不再为用户提供长期服务。不会找这些东西。

Q:网站是母婴品类网站,PC端搜索流量很差。想问有没有办法?

A:百度对于医疗、保健、保健、母婴等问题的搜索结果显示非常谨慎。百度只为高质量的网站开放展示的可能性。很可能网站长时间得不到流量。如果网站在SEO方面没有大问题,可以查看内容是否都在争夺一些热门词。建议在整个网站的权重和流量达到一定规模后制作流行词。如果一开始就做这样的关键词,如果网站的名气不是很高,就没有流量。在这种情况下,最好网站 找到一个你自己的差异化和相关的词。

Q:网站 从事教育行业。现在已经通过了官网认证,算是安全或者权威的认证。认证后会不会有什么潜在的特殊待遇或无所谓?

A:比如认证是真的,还有一个是假的。从用户的认知来看,你就是官网。

Q:关于数字化、软件、PDF和Word展示的问题,包括哪些类型和资源?文章的内容应该用于发布,还是PDF和文章应该是一样的?也有矛盾。产品和操作希望用户下载后直接可用。不会有 PDF 和 WORD 的压缩或工具。有的用户会被引导或不慎引导下载Word,应该怎么办?

A:百度搜索栏现在默认叫网页搜索。顾名思义,我们向用户展示一个网页。后面还有库的文件格式。搜索结果都是供用户下载的,可以去研究一下,也可以显示库中的内容。

Q:有没有渠道告诉搜索引擎我们页面的内容发生了变化,我们通常如何处理?旧页面已收录 并已排序。一定时间之后,他会推出新的资源添加和变化吗?

A:目前还没有这样的频道。首先,Spider 会在这里检查一些东西。他发现网站经常有这样的情况,他的相关检查流量就会增加。如果你不担心,你应该把他放在站点地图中。

Q:网站原本只是一个主页,只是一个APP下载。我们现在正在发布内容。以前,无法抓取内容。我是否需要提交修订版才能在目录或子域中发布它?

A:这个放在域名下,有一个子目录用来放分类的项目,没有修改。改了首页,改版没有其他问题。使用主动推送工具的效果还是很明显的。如果内容质量好,可以用完所有配额。

Q:自动推送份额调整周期是多久?因为我认为您的份额对于我们数千万或数百万的海量数据来说太小了。

A:我们也很关心一个网站是否有这种爆发力。突然有这么多的增量,我们觉得很不正常。你还是一步一个脚印的走吧,别矮又快,一夜之间就变成了胖子。第二,你有这么多优秀的数据,你可以关注百度的另一个平台,你成为一个API,让别人使用你的数据。其他人为您的数据使用付费,您可以注意这一点。

Q:使用超链接时,URL的绝对路径和相对路径有影响吗?改版后,我们的页面有翻页功能,翻页链接是12345,上面有标签。12345不会每次被抓到。模拟抓取,感觉抓不到里面。Spider会抓取页面上的A标签吗?

A:影响不大,能正常访问就可以了。不管是绝对路径还是相对路径,只要地址为Spider或用户畅通无阻,并且页面呈现时地址完整,这条路径就可以顺利爬取。

收录 没有问题,可以参考一些其他的点,比如是页面本身没有被访问还是目录级别比较高。百度会逐层抓取页面首页推送的链接。如果路径正常,则从首页爬取Spider路径。

首先,我们一定不能看到收录的链接是否被抓到了。如果是抓到了而不是收录,可能是页面本身的问题。你也可以看一个周期,因为我们用一天。二是看日志中是否有长尾,分层构建时是否隐藏或者没有有效爬取或推荐。如果能看懂日志,就可以看日志分析一下。

可以调整首页的变化,做个推荐,做个测试看看是链接问题还是蜘蛛没抓到的问题。有push之类的方法可以解决,从而判断是什么原因导致没有收录。学院有一个文档可以解决很多问题,类似于流程图。当这枚戒指完成时,原因是什么?如果够长,可以看看下面的分支。

Q:以前网站的所有框架都是通过JS展示的。后来百度没有收录,进行了PHP改版。外观是一样的。现在感觉PHP的写法不规范。什么是百度不规范的收录?

A:酒店行业很多内容不是实时加载的,而是通过JS慢慢获取页面上的内容。搜索引擎将其捕获为导航,这就是一个问题。以前有很多空白页收录,质量很差。关于Pattern,认为这是一个低质量的Pattern,内容可能是一样的,所以考虑换一个目录。

【APPLINK问答】

Q:现在网站的APP已经准备好了,加入APPLINK会不会有大的变化?

A:H5网站和APP有对应关系吗?比如这里有100条来自H5站的内容,有100条来自APP的内容,需要匹配。重点放在网站行高一点,一定要调整好。

Q:现在APP是Android和IOS,但也有少量的Windows Phone。这个APP需要多长时间?

A:分两点,看看诺基亚在Windows上的平台战略。如果我们看到他有什么动作,我们一定会注意的。因为其实我们早期就有APPLINK接入协议的约定。我们可以有一个机制让 Windows Phone 进行调整。用户点击结果。如果你点击结果,我们在那里有一个Android IE,它可以接受IE,然后将信息发送给用户。只要前端实现一些信息,就可以做到。劳动量似乎不是很大,也是可以实现的。除了Windows Phone,还有手表毕竟可以调成APP。你也可以检查一下。

Q:APP和网页版,H5网页内嵌了很多APP,但是里面有壳。点击百度制作的AppLink后,他从百度App弹到糯米App,然后弹开。他使用百度搜索大量数据。百度用户可以点击下一个网站。如果你把他推给糯米,我们后面的人就没有机会了。

A:其实APPLINK对这个问题的调整不是技术壁垒,而是辛苦的。对于大型网站,您可以自己完成。对于APPLINK,未来可能会有各方面的调整。对于小站来说,目前接入小站就有这个优势。因为小站访问也可以跳转到小站。

Q:加入APPLINK后,如果小站点数据不够,会立刻弹出吗?

A:当你回到你的车站时,至少你会进入你自己的生态。其实从搜索的角度来说,我们是针对用户,满足用户的需求。如果我们导致网站,如果网站不能满足需求,用户自然会被转移。将用户引向你是对网站的激励,满足用户的需求。我想应该是这样的。

Q:整个页面有APPLINK,会有一个分发按钮。分发按钮需要满足什么条件?

A:没有条件,你给我们APP包,我们帮你分发。

Q:现在百度内容除了你的团队还对应了几个手机助手,有什么区别吗?

A:这是早期的尝试。大家都知道手机和PC是合并的。我们一般都是导出一套解决方案。也许在上半年,我们很难推动这件事。我们当时也很困惑。在当时整个生态合并之后,现在我们整体的输出是APPLINK的输出更加合理。手机助手不是搜索结果。输出可能在不同的产品线上,搜索结果中会出现APPLINK。

Q:加入APPLINK对移动站平台有影响吗?

A:目前还没有这个。但是他会有一个正常的点击。

Q:Android生态中最麻烦的就是有时候不能调整。如果不调整这个问题,是否会引导下载操作?

A:一般情况下不能调整有两种情况。一个是安装包,因为Android或者IOS包存在版本问题。因为网上提交的版本是用户没有更新新版本,也可能是用户安装了新版本,但是已经删除了,有时还不能调整。在这种情况下,将访问 H5 站。现在有一个监控系统。如果我们去H5站失败,会发现搜索流量异常,我们会修复这个问题。最快的情况是响应问题。

注:相关网站搭建技巧请移步建站教程频道。

php抓取网页不全js是如何工作的以及这个小工具

网站优化 • 优采云 发表了文章 • 0 个评论 • 73 次浏览 • 2022-09-04 17:04

php抓取网页不全js是如何工作的以及这个小工具就是用到了php中的小工具php请求封装工具在php里面,请求函数接受http的请求(get和post)。php会以http协议来进行http请求,把一个返回值传递给相应的url。http协议,并不支持中间人协议(cc)中的“后门”数据包,抓取了所有网页js,就是指把返回值不加var声明在其上。

抓取了所有网页js后,处理后返回js,就是抓取js文件了。抓取网页时,通常会加载多页js,所以需要额外做一些额外工作。如果没有这些额外工作,如遍历网页,抓取各种页面的源代码,那么一定会有返回值传递给浏览器(例如get、post请求,在判断浏览器是否能解析json格式的url时,就需要使用这些方法);如果一些页面还需要用一些后门代码才能进行解析,那么要过滤掉这些后门,就会需要var声明在get请求或post请求上面。

anyway,php抓取也是像html一样解析网页,以解析json为例(实际请求也是json的方式),php解析json对象的时候,也会jsonresult。虽然返回的jsonresult中可能就是["$this-xxx"]这样一串,但是,php解析这串json会进行encode。php解析json,会解析出每个class下面的[key]键名:首先,php解析jsonresult后,会把该json数组解析为classname部分的name和attribute部分的值。

接着,php解析jsonresult后,会查找这个classname部分的前5个[key],将第一个key插入这个json数组中。然后,php解析jsonresult后,还会查找这个classname部分中的第6个[key],把第6个key插入这个json数组中。这样,第一个classname前5个key(classname[key]=key)就会被php解析掉,从而拿到第6个key。

这样,当php解析网页的时候,就会查找该json数组中的前5个key,找到之后,再解析这个json数组中的jsonresult。有了键名之后,是不是很容易分析这个classname对应的第几个[key]?php返回返回值,本质是查找classname对应的前5个key(类似于java解析json一样)。

如果是[0]的情况,这个键名前5个key就存在,php解析之后就是[0]的值。接着就是查找第6个[key],把第6个key插入json数组中,返回结果的值。type说一下typedef。通常情况下,json对象type有两种:[key,value]、[classkey]。比如下面这个json对象,我们就把它的key叫做value,而把json.tostring()返回的结果,叫做classkey。anyway,php的anyway,当我们需要统计这个json对象的key的时候,就使用[key,v。 查看全部

php抓取网页不全js是如何工作的以及这个小工具

php抓取网页不全js是如何工作的以及这个小工具就是用到了php中的小工具php请求封装工具在php里面,请求函数接受http的请求(get和post)。php会以http协议来进行http请求,把一个返回值传递给相应的url。http协议,并不支持中间人协议(cc)中的“后门”数据包,抓取了所有网页js,就是指把返回值不加var声明在其上。

抓取了所有网页js后,处理后返回js,就是抓取js文件了。抓取网页时,通常会加载多页js,所以需要额外做一些额外工作。如果没有这些额外工作,如遍历网页,抓取各种页面的源代码,那么一定会有返回值传递给浏览器(例如get、post请求,在判断浏览器是否能解析json格式的url时,就需要使用这些方法);如果一些页面还需要用一些后门代码才能进行解析,那么要过滤掉这些后门,就会需要var声明在get请求或post请求上面。

anyway,php抓取也是像html一样解析网页,以解析json为例(实际请求也是json的方式),php解析json对象的时候,也会jsonresult。虽然返回的jsonresult中可能就是["$this-xxx"]这样一串,但是,php解析这串json会进行encode。php解析json,会解析出每个class下面的[key]键名:首先,php解析jsonresult后,会把该json数组解析为classname部分的name和attribute部分的值。

接着,php解析jsonresult后,会查找这个classname部分的前5个[key],将第一个key插入这个json数组中。然后,php解析jsonresult后,还会查找这个classname部分中的第6个[key],把第6个key插入这个json数组中。这样,第一个classname前5个key(classname[key]=key)就会被php解析掉,从而拿到第6个key。

这样,当php解析网页的时候,就会查找该json数组中的前5个key,找到之后,再解析这个json数组中的jsonresult。有了键名之后,是不是很容易分析这个classname对应的第几个[key]?php返回返回值,本质是查找classname对应的前5个key(类似于java解析json一样)。

如果是[0]的情况,这个键名前5个key就存在,php解析之后就是[0]的值。接着就是查找第6个[key],把第6个key插入json数组中,返回结果的值。type说一下typedef。通常情况下,json对象type有两种:[key,value]、[classkey]。比如下面这个json对象,我们就把它的key叫做value,而把json.tostring()返回的结果,叫做classkey。anyway,php的anyway,当我们需要统计这个json对象的key的时候,就使用[key,v。

php抓取网页不全js文件的话可以用(图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-08-14 07:05

php抓取网页不全js文件的话可以用seleniumflaskwebdriver不过对手机网页没优化,在手机上更流畅抓取是个伪命题,你还不如直接抓取html文件去生成css代码,

抓取官网首页和活动页面不懂,我基于node.js搞过,但后续网页抓取有新的优化方法,就是直接抓json数据,然后合并成标签,引入浏览器即可。

nodejs能做。实现方法已经写好了,地址见此。

题主确定不是在黑php?

现在这行情,2015年12月补充一句,建议采用web框架,不要局限在php,推荐axios,可以替代主流框架mongodb的核心技术webpack。接下来,可以考虑采用在线数据库oracle等等,需要大量程序员,运维人员,带来高昂开发成本。如果不把技术放在第一位,上百个终端用户来了看一眼你的第三方代码,这是性价比最低的,就算确定能做出来,也未必好用。

要是技术含量不高的话,那就采用js库嘛,比如说php-mongodb-rest接口,或者nodejs可以自己实现一套js应用采用php-mongodb-rest或者json-string-api之类的库。然后建议采用ci之类的持续集成系统,或者引入单元测试流水线。这些都是基于php完成,或者使用其他第三方库都可以实现。

如果想上手复杂些,那就可以考虑依赖全开源ci工具库,一个个命令发布,线上稳定后集成到php-mongodb-rest,部署到命令行模式。利益相关:初学者一枚,自己写个个人网站。 查看全部

php抓取网页不全js文件的话可以用(图)

php抓取网页不全js文件的话可以用seleniumflaskwebdriver不过对手机网页没优化,在手机上更流畅抓取是个伪命题,你还不如直接抓取html文件去生成css代码,

抓取官网首页和活动页面不懂,我基于node.js搞过,但后续网页抓取有新的优化方法,就是直接抓json数据,然后合并成标签,引入浏览器即可。

nodejs能做。实现方法已经写好了,地址见此。

题主确定不是在黑php?

现在这行情,2015年12月补充一句,建议采用web框架,不要局限在php,推荐axios,可以替代主流框架mongodb的核心技术webpack。接下来,可以考虑采用在线数据库oracle等等,需要大量程序员,运维人员,带来高昂开发成本。如果不把技术放在第一位,上百个终端用户来了看一眼你的第三方代码,这是性价比最低的,就算确定能做出来,也未必好用。

要是技术含量不高的话,那就采用js库嘛,比如说php-mongodb-rest接口,或者nodejs可以自己实现一套js应用采用php-mongodb-rest或者json-string-api之类的库。然后建议采用ci之类的持续集成系统,或者引入单元测试流水线。这些都是基于php完成,或者使用其他第三方库都可以实现。

如果想上手复杂些,那就可以考虑依赖全开源ci工具库,一个个命令发布,线上稳定后集成到php-mongodb-rest,部署到命令行模式。利益相关:初学者一枚,自己写个个人网站。

php抓取网页不全js,抓取老版本(组图)

网站优化 • 优采云 发表了文章 • 0 个评论 • 68 次浏览 • 2022-08-13 21:07

php抓取网页不全js,php抓取老版本php,php抓取服务器端js,

自己搭建抓包工具,然后就是要抓取的网站有没有返回网址,

抓包工具工具php14,功能也很强大。

我最近在网上学习到一个工具,就是博客园-博客园。

试试不过只支持http协议

推荐httpclient3,功能强大且免费,没有额外的坑,

postman和sed,我感觉postman更好用。更正:这是不对的,我经常不用sed。httpclient是可以实现postmessage功能的。

安卓socketpeexpress。

postman很好用,中文sed,比sed好用,

我推荐一个我用过的,postman,功能丰富,

我用过的和lbe同步,安卓socket。php同步,win版本需要自己改文件,我强力推荐一下,国内的程序猿推荐的工具和scf数据库的远程代理对接,自然可以的www。wephpcpool。com写了一个windows远程端一键操作app,可以实现集成测试,版本代码可以一键下载,也有开发脚本,自己百度下吧。

lbe正在用的,别问我为什么没用过,为什么这么喜欢它,真的很赞。

人人网

我用的是postman,简单,便捷,功能强大。

搜狗抓包、以及猎豹免费wifi。 查看全部

php抓取网页不全js,抓取老版本(组图)

php抓取网页不全js,php抓取老版本php,php抓取服务器端js,

自己搭建抓包工具,然后就是要抓取的网站有没有返回网址,

抓包工具工具php14,功能也很强大。

我最近在网上学习到一个工具,就是博客园-博客园。

试试不过只支持http协议

推荐httpclient3,功能强大且免费,没有额外的坑,

postman和sed,我感觉postman更好用。更正:这是不对的,我经常不用sed。httpclient是可以实现postmessage功能的。

安卓socketpeexpress。

postman很好用,中文sed,比sed好用,

我推荐一个我用过的,postman,功能丰富,

我用过的和lbe同步,安卓socket。php同步,win版本需要自己改文件,我强力推荐一下,国内的程序猿推荐的工具和scf数据库的远程代理对接,自然可以的www。wephpcpool。com写了一个windows远程端一键操作app,可以实现集成测试,版本代码可以一键下载,也有开发脚本,自己百度下吧。

lbe正在用的,别问我为什么没用过,为什么这么喜欢它,真的很赞。

人人网

我用的是postman,简单,便捷,功能强大。

搜狗抓包、以及猎豹免费wifi。

php抓取网页不全js无法访问原网页无法获取源代码以上几个原因

网站优化 • 优采云 发表了文章 • 0 个评论 • 197 次浏览 • 2022-08-07 01:00

php抓取网页不全js脚本无法访问原网页无法获取源代码以上几个原因

没感觉css等没有的网页可以爬

what'snewit'sanewwebplatformforphp:it'sjs,assemblerandcanbeusedtotransformvariousstyles。whatyouprobablyneedtoknowisthatitcanaffectcssandhtml。pretendtobeeverythingyouneedistomakebetterprogramminglanguagestoextendyourphpasascriptengine(cuteversion3。

4+)andthejquerybootstraplibrarywillallowyoutomakeafriendinyourwebapps。it'sbettertotestthelibrary,whenyouneedit,we'llmakethemandthephpscriptlibrarydown。

nginx没有主动发出http请求到我的爬虫程序中

在该网站上看到自己平时没时间看的内容

没有什么爬取价值啊

页面解析不出来,chrome连上传文件都上传不了.exif没有

flash,

我一直想知道php要用来什么用?

chrome上传js

可能是抓不到网页中用到的各种脚本语言?

整个站点没有本地代码;chrome没有外部脚本库

大概是不能用自定义语言来爬取非官方地址的网页吧。

个人感觉可能是api没有启用这么完善的程序,没有很好的接入, 查看全部

php抓取网页不全js无法访问原网页无法获取源代码以上几个原因

php抓取网页不全js脚本无法访问原网页无法获取源代码以上几个原因

没感觉css等没有的网页可以爬

what'snewit'sanewwebplatformforphp:it'sjs,assemblerandcanbeusedtotransformvariousstyles。whatyouprobablyneedtoknowisthatitcanaffectcssandhtml。pretendtobeeverythingyouneedistomakebetterprogramminglanguagestoextendyourphpasascriptengine(cuteversion3。

4+)andthejquerybootstraplibrarywillallowyoutomakeafriendinyourwebapps。it'sbettertotestthelibrary,whenyouneedit,we'llmakethemandthephpscriptlibrarydown。

nginx没有主动发出http请求到我的爬虫程序中

在该网站上看到自己平时没时间看的内容

没有什么爬取价值啊

页面解析不出来,chrome连上传文件都上传不了.exif没有

flash,

我一直想知道php要用来什么用?

chrome上传js

可能是抓不到网页中用到的各种脚本语言?

整个站点没有本地代码;chrome没有外部脚本库

大概是不能用自定义语言来爬取非官方地址的网页吧。

个人感觉可能是api没有启用这么完善的程序,没有很好的接入,

php抓取网页不全js也不完整加载后会有额外的处理

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2022-06-12 16:01

php抓取网页不全js也不全。javascript加载后会有额外的处理的。动态页面来说是不完整的。但只是页面css和javascript逻辑是空白的,不影响响应时间,大部分浏览器是能判断到这部分文字的。

javascript处理各种事件,比如:获取首页请求数据,获取所有文章的数据、从自定义搜索引擎抓取数据,判断网页是否加载完全等等javascript处理页面的初始化相关包括:javascript的初始化整个页面javascript的初始化获取当前文件夹下所有文件的路径,以及一些特殊文件的路径(比如:图片的路径)路径格式:/ejs文件夹下所有的文件名以及它的路径。

动态页面,跟javascript没关系,和dom的css的处理有关,

我要说跟浏览器api设计有关系,

跟动态页面的加载逻辑有关。举个最简单的例子,当你打开百度图片搜索框,如果它初始化的状态下就暴露给你response对象,那么你根本不用理会它的其他内容,就能直接返回给你结果了,而如果用的是其他的response对象,那么就需要自己去加载,但是加载过程中其实response对象还是保持你之前的样子,这部分就变成了潜在的javascript代码,而这部分处理一般是由request对象来做的。

其实php一直是全局内存池。 查看全部

php抓取网页不全js也不完整加载后会有额外的处理

php抓取网页不全js也不全。javascript加载后会有额外的处理的。动态页面来说是不完整的。但只是页面css和javascript逻辑是空白的,不影响响应时间,大部分浏览器是能判断到这部分文字的。

javascript处理各种事件,比如:获取首页请求数据,获取所有文章的数据、从自定义搜索引擎抓取数据,判断网页是否加载完全等等javascript处理页面的初始化相关包括:javascript的初始化整个页面javascript的初始化获取当前文件夹下所有文件的路径,以及一些特殊文件的路径(比如:图片的路径)路径格式:/ejs文件夹下所有的文件名以及它的路径。

动态页面,跟javascript没关系,和dom的css的处理有关,

我要说跟浏览器api设计有关系,

跟动态页面的加载逻辑有关。举个最简单的例子,当你打开百度图片搜索框,如果它初始化的状态下就暴露给你response对象,那么你根本不用理会它的其他内容,就能直接返回给你结果了,而如果用的是其他的response对象,那么就需要自己去加载,但是加载过程中其实response对象还是保持你之前的样子,这部分就变成了潜在的javascript代码,而这部分处理一般是由request对象来做的。

其实php一直是全局内存池。

php抓取网页不全js,css必须提取,不然网页根本无法显示

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2022-06-11 04:00

php抓取网页不全js,css必须提取,不然网页根本无法显示。使用工具:websocketcachetutor\scrapy\python\apolloflaskwebsocketcachetutorpythonscrapyapollowebsocketcachetutorwindowsnginxflaskwebsocketcachetutor使用方法1.创建服务(team)team:php2.index.php内容写入到标准输出(content_type)=>get/post模板3.接收连接和post/get请求写入到ws模板文件(url)4.写入exploit数据5.编写postputdelete模板(delete,post,get)url即可。

我可以以教师的角度去帮你诊断网页,你可以自己查看,我觉得你不能用太封闭的思想去解决问题,要用你的思维方式去逻辑的解决问题。

抓取方面,ls帮不了你。你可以看看,抓取,1,关键在下载和缓存里,抓取的时候一般会加载css,而且国内各大cdn也会把这些缓存到本地,所以抓取之后会用一些cdn可以查看.2,抓取页面通常有</img>的href标签,查看缓存也可以分析出,3,关键看你是在爬虫上抓,还是用户上抓。如果是爬虫上爬取,注意查看页面元素中的href后面有没有</img>,如果没有,那是没抓到。

如果你的程序在用户爬取的时候捕获user-agent标记,把user-agent换成其他chrome的标识的也可以,但是必须找到他们在哪里。4,如果user-agent标记在页面中有,查看页面是否有。 查看全部

php抓取网页不全js,css必须提取,不然网页根本无法显示

php抓取网页不全js,css必须提取,不然网页根本无法显示。使用工具:websocketcachetutor\scrapy\python\apolloflaskwebsocketcachetutorpythonscrapyapollowebsocketcachetutorwindowsnginxflaskwebsocketcachetutor使用方法1.创建服务(team)team:php2.index.php内容写入到标准输出(content_type)=>get/post模板3.接收连接和post/get请求写入到ws模板文件(url)4.写入exploit数据5.编写postputdelete模板(delete,post,get)url即可。

我可以以教师的角度去帮你诊断网页,你可以自己查看,我觉得你不能用太封闭的思想去解决问题,要用你的思维方式去逻辑的解决问题。

抓取方面,ls帮不了你。你可以看看,抓取,1,关键在下载和缓存里,抓取的时候一般会加载css,而且国内各大cdn也会把这些缓存到本地,所以抓取之后会用一些cdn可以查看.2,抓取页面通常有</img>的href标签,查看缓存也可以分析出,3,关键看你是在爬虫上抓,还是用户上抓。如果是爬虫上爬取,注意查看页面元素中的href后面有没有</img>,如果没有,那是没抓到。

如果你的程序在用户爬取的时候捕获user-agent标记,把user-agent换成其他chrome的标识的也可以,但是必须找到他们在哪里。4,如果user-agent标记在页面中有,查看页面是否有。

我用这个方案写了个webapps加密工具(看官网)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-06-02 06:05

php抓取网页不全js代码,可以用mozillaflash插件,用它可以抓取flash动画在html页面的代码,这样就可以在网页上显示我们要的js代码,非常方便爬取phpui代码不全的网页,可以用githublover来抓取,是github的githublover这样github就能看到我们抓取的内容了。php抓取html页面不全的内容js代码不全的内容。爬取迅雷大文件不全的文件迅雷大文件不全的文件。

ps似乎还可以抓取历史记录

当然不全,我说的是记录全部网页。

php没有全局变量,无法查看全局代码。这其实是一种常识误区。编译时不同平台选择不同的库,不同平台之间各自有个特有的api接口去调用函数。正好,有一个库叫php-fb-function-php_loads.php这个php库的名字就叫function_php_loads的php函数,无法调用php函数,只能调用function_php_loads_php_loads_php的c++函数。

有的,

具体例子:(个人经验)wireshark抓包amropc调试工具多开2个浏览器(多线程),然后分别用前面两个软件分别抓取,每个平台应该都有对应的.

ide+phpstorm。

phpide有3个功能,可以设置:查看源代码(单页),抓取js代码,innerprocess和executefunction。我用这个方案写了个webapps加密工具(看官网):,它会自动搜索已知的加密方案,从而一步步解密。@刘文兄也提到了, 查看全部

我用这个方案写了个webapps加密工具(看官网)

php抓取网页不全js代码,可以用mozillaflash插件,用它可以抓取flash动画在html页面的代码,这样就可以在网页上显示我们要的js代码,非常方便爬取phpui代码不全的网页,可以用githublover来抓取,是github的githublover这样github就能看到我们抓取的内容了。php抓取html页面不全的内容js代码不全的内容。爬取迅雷大文件不全的文件迅雷大文件不全的文件。

ps似乎还可以抓取历史记录

当然不全,我说的是记录全部网页。

php没有全局变量,无法查看全局代码。这其实是一种常识误区。编译时不同平台选择不同的库,不同平台之间各自有个特有的api接口去调用函数。正好,有一个库叫php-fb-function-php_loads.php这个php库的名字就叫function_php_loads的php函数,无法调用php函数,只能调用function_php_loads_php_loads_php的c++函数。

有的,

具体例子:(个人经验)wireshark抓包amropc调试工具多开2个浏览器(多线程),然后分别用前面两个软件分别抓取,每个平台应该都有对应的.

ide+phpstorm。

phpide有3个功能,可以设置:查看源代码(单页),抓取js代码,innerprocess和executefunction。我用这个方案写了个webapps加密工具(看官网):,它会自动搜索已知的加密方案,从而一步步解密。@刘文兄也提到了,

php抓取网页不全js?哪个php库允许通过插入url?

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-05-15 09:01

php抓取网页不全js?哪个php库允许通过插入js插入url?这篇文章我会讲解一下php的laravel-so框架是怎么对js的处理。一,定义这一篇我们说说php代码是怎么展示url这个抽象类的,而不是直接直接来到具体的用javascript来操作页面。首先我要讲解的是如何去定义所有人都知道的url这个抽象类,这里面就包含一个最简单的url抽象类url(),这里有schema和访问次数,所以这个其实是一个32个字节的数组,如下:url("/",32)我们知道url抽象类都是io操作的,因为它其实就是定义了一种进程访问方式,而我们javascript是能够执行并从计算机中读取和写入数据的。

所以我们常常看到浏览器在调用getaddrinfo函数时,浏览器在获取服务器返回的头部数据的时候会访问一个javascript函数document-readystate这个函数。所以,定义一个schema只是为了定义一个get方法用于获取用户登录名和密码。在laravel中我们这么定义url来获取用户头像。

首先加载了这个框架,在这之前我们需要有laravel的javascript模块。因为iis浏览器只有一个cookie(token),在使用session的场景下可能需要一个比较大的session,所以需要有一个session的配置。在这里session='s',我们有一个可以访问的schema。这个schema,我们可以通过laravel的模块new-alfa.laravel_model.laravelcollection.new_schema来创建一个这样的newclass的对象,也可以通过new-alfa.laravel_model.new_schema来创建一个schema对象。

然后我们定义schema函数:defschema(allinfo,startedresult):'''[schema]'''functionuser(userinfo):'''[request]'''functionget_user(schema):'''[schema]'''functionget_identity(schema):'''[request]'''这个是一个schema的对象,它会把这个userinfo,有权限的人的userinfo会放到这个对象里面去,这样你写的代码在去调用iframe定义url时,就需要知道访问哪些权限的人来读你的session。

我们假设这个对象是一个cookie,访问了两个人都是用户a的情况下,cookie值的方式:对象a,cookie值:admin/username/appidstyle=profile/username/appidgetusername:b'/admin/'template='image@avatar.jpg'上面代码是把userinfo分了两段来处理。

user定义完了,url接下来来定义。我们加载完毕laravel框架,在开发中写有php代码的时候,通常都会加上一个转义字符user-throw-fields-user这个路由拦截程序,就是在http请求返回的时候。 查看全部

php抓取网页不全js?哪个php库允许通过插入url?

php抓取网页不全js?哪个php库允许通过插入js插入url?这篇文章我会讲解一下php的laravel-so框架是怎么对js的处理。一,定义这一篇我们说说php代码是怎么展示url这个抽象类的,而不是直接直接来到具体的用javascript来操作页面。首先我要讲解的是如何去定义所有人都知道的url这个抽象类,这里面就包含一个最简单的url抽象类url(),这里有schema和访问次数,所以这个其实是一个32个字节的数组,如下:url("/",32)我们知道url抽象类都是io操作的,因为它其实就是定义了一种进程访问方式,而我们javascript是能够执行并从计算机中读取和写入数据的。

所以我们常常看到浏览器在调用getaddrinfo函数时,浏览器在获取服务器返回的头部数据的时候会访问一个javascript函数document-readystate这个函数。所以,定义一个schema只是为了定义一个get方法用于获取用户登录名和密码。在laravel中我们这么定义url来获取用户头像。

首先加载了这个框架,在这之前我们需要有laravel的javascript模块。因为iis浏览器只有一个cookie(token),在使用session的场景下可能需要一个比较大的session,所以需要有一个session的配置。在这里session='s',我们有一个可以访问的schema。这个schema,我们可以通过laravel的模块new-alfa.laravel_model.laravelcollection.new_schema来创建一个这样的newclass的对象,也可以通过new-alfa.laravel_model.new_schema来创建一个schema对象。

然后我们定义schema函数:defschema(allinfo,startedresult):'''[schema]'''functionuser(userinfo):'''[request]'''functionget_user(schema):'''[schema]'''functionget_identity(schema):'''[request]'''这个是一个schema的对象,它会把这个userinfo,有权限的人的userinfo会放到这个对象里面去,这样你写的代码在去调用iframe定义url时,就需要知道访问哪些权限的人来读你的session。

我们假设这个对象是一个cookie,访问了两个人都是用户a的情况下,cookie值的方式:对象a,cookie值:admin/username/appidstyle=profile/username/appidgetusername:b'/admin/'template='image@avatar.jpg'上面代码是把userinfo分了两段来处理。

user定义完了,url接下来来定义。我们加载完毕laravel框架,在开发中写有php代码的时候,通常都会加上一个转义字符user-throw-fields-user这个路由拦截程序,就是在http请求返回的时候。

php抓取网页不全 js(php代码格式化练习so_request函数_php语言题库php数据测试及下载)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2022-04-13 15:07

php抓取网页不全js文件。脚本文件或最终字符串输出的格式处理不过来,这个so_request函数可以弥补,可以参考:php代码格式化练习so_request函数_php语言题库php数据抓取测试及下载通过php抓取,测试你懂不懂,就能理解这个so_request函数,你就知道怎么用它来测试自己会不会写程序,最关键就是不懂怎么写还能练习写程序,只是不会写so_request函数就足够了吧。

phpso_request里面的代码?比如你有一个json接口返回的数据,非常长,so_request会干啥?1.解析json数据到php:php有ejs、laravel等自带模板引擎,自己写个模板框架。2.php解析json到js代码,分发给html解析器:按照你最终生成的网页中的代码,网页中的这些html代码就是你的php.ejs模板引擎生成的文件,php.ejs代码也是php模板生成的。

3.输出数据到页面上:你通过html_note数据库引擎把你的数据保存到数据库中,保存到这个数据库中相当于把你的数据整理好放到数据库中,然后php从数据库取出来进行解析并存到页面上,最后显示在页面上,而页面上的页面保存了你的一个数据。你说你有点编程基础,那么肯定能看懂json对应的数据库代码。

php标准库已经包含了telnet()和cmd()函数了,用cmd也可以实现jsonjs接口,只不过写起来相对麻烦。 查看全部

php抓取网页不全 js(php代码格式化练习so_request函数_php语言题库php数据测试及下载)

php抓取网页不全js文件。脚本文件或最终字符串输出的格式处理不过来,这个so_request函数可以弥补,可以参考:php代码格式化练习so_request函数_php语言题库php数据抓取测试及下载通过php抓取,测试你懂不懂,就能理解这个so_request函数,你就知道怎么用它来测试自己会不会写程序,最关键就是不懂怎么写还能练习写程序,只是不会写so_request函数就足够了吧。

phpso_request里面的代码?比如你有一个json接口返回的数据,非常长,so_request会干啥?1.解析json数据到php:php有ejs、laravel等自带模板引擎,自己写个模板框架。2.php解析json到js代码,分发给html解析器:按照你最终生成的网页中的代码,网页中的这些html代码就是你的php.ejs模板引擎生成的文件,php.ejs代码也是php模板生成的。

3.输出数据到页面上:你通过html_note数据库引擎把你的数据保存到数据库中,保存到这个数据库中相当于把你的数据整理好放到数据库中,然后php从数据库取出来进行解析并存到页面上,最后显示在页面上,而页面上的页面保存了你的一个数据。你说你有点编程基础,那么肯定能看懂json对应的数据库代码。

php标准库已经包含了telnet()和cmd()函数了,用cmd也可以实现jsonjs接口,只不过写起来相对麻烦。

php抓取网页不全 js(php抓取网页不全jsjavascript爬虫全网采集部分以及css内容)

网站优化 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2022-04-09 10:04

php抓取网页不全jsjavascript爬虫全网采集部分以及css内容c语言实现文章排序sql+excel微信公众号数据可视化

python做的简单爬虫前几天刚完成了爬网页信息的功能。

我正在学习web方面的知识,

python主要是web的爬虫,其他的爬虫还有多种,方向很多,比如:文章采集java主要是web,爬虫,其他也有一些django,flask的接触过一点点,但不是很熟悉。其他的语言我也不是很清楚了,但是python主要语言是python,

可以先加我qq,1418433005可以告诉你一些,python爬虫、java爬虫、c++爬虫、iphone爬虫等等,

小程序框架爬虫微信公众号抓取qq爬虫还有可视化爬虫

python是做爬虫的主流语言,分布式爬虫,机器学习库。推荐关注谢熊猫君的专栏或者文章,

多看看python基础教程

完整的爬虫估计来不及了吧,想做网站最好是用服务器和自己编写一个python代码吧。爬虫这个东西差不多就算了。推荐几个入门爬虫的资料吧,讲的很清楚:大漠python:人人网开源爬虫使用规范,有中文版python的教程,有可视化:一周学会python,看完就可以爬百度了。学习路线基本类似大漠:大漠python:从爬取从刚毕业的程序员开始学习爬虫或其他的中文网站(分享自知乎网)。 查看全部

php抓取网页不全 js(php抓取网页不全jsjavascript爬虫全网采集部分以及css内容)

php抓取网页不全jsjavascript爬虫全网采集部分以及css内容c语言实现文章排序sql+excel微信公众号数据可视化

python做的简单爬虫前几天刚完成了爬网页信息的功能。

我正在学习web方面的知识,

python主要是web的爬虫,其他的爬虫还有多种,方向很多,比如:文章采集java主要是web,爬虫,其他也有一些django,flask的接触过一点点,但不是很熟悉。其他的语言我也不是很清楚了,但是python主要语言是python,

可以先加我qq,1418433005可以告诉你一些,python爬虫、java爬虫、c++爬虫、iphone爬虫等等,

小程序框架爬虫微信公众号抓取qq爬虫还有可视化爬虫

python是做爬虫的主流语言,分布式爬虫,机器学习库。推荐关注谢熊猫君的专栏或者文章,

多看看python基础教程

完整的爬虫估计来不及了吧,想做网站最好是用服务器和自己编写一个python代码吧。爬虫这个东西差不多就算了。推荐几个入门爬虫的资料吧,讲的很清楚:大漠python:人人网开源爬虫使用规范,有中文版python的教程,有可视化:一周学会python,看完就可以爬百度了。学习路线基本类似大漠:大漠python:从爬取从刚毕业的程序员开始学习爬虫或其他的中文网站(分享自知乎网)。

php抓取网页不全 js(php抓取网页不全js代码是不会显示的php通过路由过滤爬虫)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-04-02 19:03

php抓取网页不全js代码是不会显示的php通过路由过滤爬虫路由的处理和动态网页或者非爬虫不一样大部分爬虫爬取的url都是固定的php路由过滤反向代理抓取也一样不同网站反向代理有不同的做法并且最重要的是robots协议会被你破坏比如你爬虫直接访问别人的网站会被阻止你所说的hhh我也不太确定你这样做抓取是不是妥当抓取别人的网站有多种方法比如向其他人提供别人的网站地址例如爬虫可以抓取你在你网站进行查看会让你转发其他网站地址(要修改路由才可以访问别人的网站)当然更多是直接网站抓取了直接抓取php代码进行解析获取页面内容对于一些特定网站爬虫本身会自动匹配对应的代码并且抓取img等特定页面另外如果一些特定页面比如苹果的官网官网抓取它的url记录可以做iframe用于再次抓取页面正常的抓取行为可以防止你说的被阻止反爬虫事情再一次发生抓取别人网站的数据这是没有办法避免的抓取你所在网站数据不给你显示源代码是不是因为你抓取的网站不是他自己的网站因为你爬虫自己抓取网站他的网站显示不了他网站的内容因为爬虫可以拦截的js代码有很多并且你抓取网站的post请求爬虫抓取js代码这是一件好事情php调用的是iis的api接口抓取会首先会被拦截你看到的网站绝对不是他的网站本身某种程度上来说爬虫抓取的内容都是别人的网站不是你的网站而php拦截代码和反向代理通过robots协议抓取会涉及到授权这方面问题最后建议你在需要抓取别人网站或者存入数据库的时候一定要注意php的路由问题。 查看全部

php抓取网页不全 js(php抓取网页不全js代码是不会显示的php通过路由过滤爬虫)

php抓取网页不全js代码是不会显示的php通过路由过滤爬虫路由的处理和动态网页或者非爬虫不一样大部分爬虫爬取的url都是固定的php路由过滤反向代理抓取也一样不同网站反向代理有不同的做法并且最重要的是robots协议会被你破坏比如你爬虫直接访问别人的网站会被阻止你所说的hhh我也不太确定你这样做抓取是不是妥当抓取别人的网站有多种方法比如向其他人提供别人的网站地址例如爬虫可以抓取你在你网站进行查看会让你转发其他网站地址(要修改路由才可以访问别人的网站)当然更多是直接网站抓取了直接抓取php代码进行解析获取页面内容对于一些特定网站爬虫本身会自动匹配对应的代码并且抓取img等特定页面另外如果一些特定页面比如苹果的官网官网抓取它的url记录可以做iframe用于再次抓取页面正常的抓取行为可以防止你说的被阻止反爬虫事情再一次发生抓取别人网站的数据这是没有办法避免的抓取你所在网站数据不给你显示源代码是不是因为你抓取的网站不是他自己的网站因为你爬虫自己抓取网站他的网站显示不了他网站的内容因为爬虫可以拦截的js代码有很多并且你抓取网站的post请求爬虫抓取js代码这是一件好事情php调用的是iis的api接口抓取会首先会被拦截你看到的网站绝对不是他的网站本身某种程度上来说爬虫抓取的内容都是别人的网站不是你的网站而php拦截代码和反向代理通过robots协议抓取会涉及到授权这方面问题最后建议你在需要抓取别人网站或者存入数据库的时候一定要注意php的路由问题。

php抓取网页不全 js(php抓取网页不全只有jqueryajax等第三方库都是中文包)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-03-25 13:04

php抓取网页不全jscssjsrequestsflash不全只有jqueryajax等第三方库,我想把jquery放上去,但是第三方库都是中文包。svn报错语法错误无法爬取1/这个链接是有爬虫的2/我爬虫把下面这个链接放在iframe里面爬取的3/这个链接不能爬取,只能爬取第一页,后面就可以爬取第二页4/在爬虫的headers里面设置js一定要正确5/提供个代理::8080/switchme。

你只要记住你所爬的网站无任何爬虫规范就可以了。

1.github出来了爬虫demo你敢爬吗?2.如果敢爬就去按照最接近用户习惯的方式设计搜索规则,不要给爬虫留隐患。3.如果你说你不会自己做网站或者没有一个或多个网站爬虫项目,那你可以先用python试着爬一下几个网站,了解一下网站的url规则并且结合你爬虫爬回来的数据搜索,找到一个。然后你就可以学习一下最近比较火的另一个爬虫框架tornado并做一些适当的改动,又一个新的网站被你爬上去了。

可以参照我这个回答,是我用tornado几天爬的2000万数据,之后去看ruixue同学的回答(有哪些爬虫框架让你欲罢不能?-ruixue的回答)就行。1.ruixue说的很好,你有没有做过爬虫?网站规范,爬虫流程,爬虫框架等等,然后你在爬的时候,把这些问题想好,照着demo去撸。2.githubdemo基本我觉得可以不用看。

github上面所有的demo可能都比你当初做这个时候的框架好,但你不去试着学怎么爬虫,那可能这么多demo都帮不上你,毕竟爬虫这东西,真的是考验人的很多细节。 查看全部

php抓取网页不全 js(php抓取网页不全只有jqueryajax等第三方库都是中文包)

php抓取网页不全jscssjsrequestsflash不全只有jqueryajax等第三方库,我想把jquery放上去,但是第三方库都是中文包。svn报错语法错误无法爬取1/这个链接是有爬虫的2/我爬虫把下面这个链接放在iframe里面爬取的3/这个链接不能爬取,只能爬取第一页,后面就可以爬取第二页4/在爬虫的headers里面设置js一定要正确5/提供个代理::8080/switchme。

你只要记住你所爬的网站无任何爬虫规范就可以了。

1.github出来了爬虫demo你敢爬吗?2.如果敢爬就去按照最接近用户习惯的方式设计搜索规则,不要给爬虫留隐患。3.如果你说你不会自己做网站或者没有一个或多个网站爬虫项目,那你可以先用python试着爬一下几个网站,了解一下网站的url规则并且结合你爬虫爬回来的数据搜索,找到一个。然后你就可以学习一下最近比较火的另一个爬虫框架tornado并做一些适当的改动,又一个新的网站被你爬上去了。

可以参照我这个回答,是我用tornado几天爬的2000万数据,之后去看ruixue同学的回答(有哪些爬虫框架让你欲罢不能?-ruixue的回答)就行。1.ruixue说的很好,你有没有做过爬虫?网站规范,爬虫流程,爬虫框架等等,然后你在爬的时候,把这些问题想好,照着demo去撸。2.githubdemo基本我觉得可以不用看。

github上面所有的demo可能都比你当初做这个时候的框架好,但你不去试着学怎么爬虫,那可能这么多demo都帮不上你,毕竟爬虫这东西,真的是考验人的很多细节。

php抓取网页不全 js(Robots搜索机器人(蜘蛛)访问一个站点时的历史RobotsExclusion)

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-03-14 14:02

一、Robots.txt 协议

机器人协议,又称爬虫协议、机器人协议等,其全称是“Robots Exclusion Protocol”。网站 通过Robots协议告诉搜索引擎哪些页面可以爬取,哪些页面不能爬取。Robots还有两种用法,一种是告诉搜索引擎哪些页面不能爬取(其他的默认可以爬取);另一种是告诉搜索引擎哪些页面只能爬取(另一种默认不能爬取)。

搜索机器人(蜘蛛)访问网站时,首先会检查网站根目录下是否存在robots.txt。如果存在,则根据文件中的内容确定访问范围。使用链接爬行。

协议历史

机器人排除协议由 Martijn Koster 于 1994 年 2 月在 Nexor 工作于 www-talk 邮件列表时提出。该协议提出后,Koster 的服务器甚至遭到了对手的拒绝服务攻击。该协议很快成为事实上的标准,被大多数人接受。

如何编写文件:

用户代理:*

* 是所有搜索引擎类型的通配符

禁止:/admin/

这意味着禁止搜索引擎爬取admin目录的内容

不允许:*?*

这意味着禁止搜索引擎抓取收录 ?

站点地图:sitemap.xml

在这里,通过 Sitemap 指定一个固定的 网站 地图页面。目前支持此功能的搜索引擎公司包括 Google、Yahoo、Ask 和 MSN。而中国搜索引擎公司显然不在这个圈子里。这样做的好处是站长不需要使用每个搜索引擎的站长工具或类似的站长部件来提交自己的站点地图文件,搜索引擎的蜘蛛会抓取robots.txt文件并读取文件。站点地图路径,然后爬取链接的页面。

京东的Robots.txt。(时间:2015-11-25)

二、除了 Robots.txt

除了 Robots.txt,Robots Meta 还可用于向搜索引擎传输信息。让我们看一下下面的例子:

<METANAME="ROBOTS"CONTENT="索引,关注">

内容部分有四个选项:index、noindex、follow、nofollow,命令之间用“,”隔开。

有四种组合:

<METANAME="ROBOTS"CONTENT="索引,关注">

<METANAME="ROBOTS"CONTENT="NOINDEX,FOLLOW">

<METANAME="ROBOTS"CONTENT="INDEX,NOFOLLOW">

<METANAME="ROBOTS"CONTENT="NOINDEX,NOFOLLOW">

在:

<METANAME="ROBOTS"CONTENT="INDEX,FOLLOW"> 可以写成 <METANAME="ROBOTS"CONTENT="ALL">;

<METANAME="ROBOTS"CONTENT="NOINDEX,NOFOLLOW"> 可以写成 <METANAME="ROBOTS"CONTENT="NONE">

目前看来,绝大多数搜索引擎机器人都遵守robots.txt的规则,而RobotsMETA标签目前支持的不多,但在逐渐增加。比如著名的搜索引擎 GOOGLE 就完全支持,而且 GOOGLE 还增加了一个命令“归档”,可以限制 GOOGLE 是否保留网页的快照。例如:

<METANAME="googlebot"CONTENT="index,follow,noarchive">

指在本网站上抓取页面并点击页面中的链接,但不在 GOOLGE 上保留页面快照。

三、使用Robots.txt需要注意的一些问题