自动采集子系统

自动采集子系统(如何使用优采云 采集器采集这种类型网页里面详细信息页面数据 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-12-25 21:07

采集器采集这种类型网页里面详细信息页面数据

)

很多网站都有这种模式,一个列表页面,点击列表中的一行链接会打开一个详细信息页面,本文教你如何使用优采云

采集

器来采集

这类网站的详细信息page 页的数据。

首先打开优采云

采集

器→点击快速启动→新建任务,进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图中的配置完成后,选择Next,进入流程配置页面,在流程设计器中拖动一步打开网页;

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

由于我们需要如上图在浏览器中点击电影名称,然后在子页面中提取数据信息,所以我们需要制作一个循环采集

列表。

点击上图中第一个循环项,在弹出的对话框中选择创建元素列表来处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个循环项后,选择继续编辑列表。

接下来,以相同的方式添加第二个循环项。

当我们添加第二个区域块时,我们可以查看上图。此时,页面上的其他元素已经添加。这是因为我们添加了两个具有相似特征的元素,系统会智能地在页面上添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集

列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

选择上图中第一个循环项,然后选择click元素。进入第一个子链接。

接下来,我们将提取数据字段。在浏览器中选择需要提取的字段,然后在弹出的选择对话框中选择抓取该元素的文本;

完成以上操作后,系统会在页面右上角显示我们要抓取的字段;

接下来在页面上配置其他需要抓取的字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集

列表;

点击上图中的下一步→下一步→开始单机采集(调试模式),进入任务检查页面,确保任务的正确性;

点击 开始单机采集,系统将在本地执行采集过程并显示最终采集结果;

如果我们需要导出最终采集的数据信息,点击下图中的导出按钮,选择需要导出的文件类型。系统会提示保存路径,选择保存路径,系统会自动导出文件。

查看全部

自动采集子系统(如何使用优采云

采集器采集这种类型网页里面详细信息页面数据

)

很多网站都有这种模式,一个列表页面,点击列表中的一行链接会打开一个详细信息页面,本文教你如何使用优采云

采集

器来采集

这类网站的详细信息page 页的数据。

首先打开优采云

采集

器→点击快速启动→新建任务,进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图中的配置完成后,选择Next,进入流程配置页面,在流程设计器中拖动一步打开网页;

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

由于我们需要如上图在浏览器中点击电影名称,然后在子页面中提取数据信息,所以我们需要制作一个循环采集

列表。

点击上图中第一个循环项,在弹出的对话框中选择创建元素列表来处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个循环项后,选择继续编辑列表。

接下来,以相同的方式添加第二个循环项。

当我们添加第二个区域块时,我们可以查看上图。此时,页面上的其他元素已经添加。这是因为我们添加了两个具有相似特征的元素,系统会智能地在页面上添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集

列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

选择上图中第一个循环项,然后选择click元素。进入第一个子链接。

接下来,我们将提取数据字段。在浏览器中选择需要提取的字段,然后在弹出的选择对话框中选择抓取该元素的文本;

完成以上操作后,系统会在页面右上角显示我们要抓取的字段;

接下来在页面上配置其他需要抓取的字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集

列表;

点击上图中的下一步→下一步→开始单机采集(调试模式),进入任务检查页面,确保任务的正确性;

点击 开始单机采集,系统将在本地执行采集过程并显示最终采集结果;

如果我们需要导出最终采集的数据信息,点击下图中的导出按钮,选择需要导出的文件类型。系统会提示保存路径,选择保存路径,系统会自动导出文件。

自动采集子系统(分布式计算中常见的4大问题和分布式系统相关问题)

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-12-24 20:08

自动采集子系统有3个核心:各模块相互之间配合才能完整的实现采集目的;不同子系统采集的数据量不一样;采集出来的数据经过整理分类,做了汇总和展示;有限几个服务器可以运行1000个各子系统;采集效率高可以2000次/秒左右的吞吐量;支持全网300万条记录的采集;一键即可采集到上万条上万条信息;可以把采集数据进行清洗,进行去重;支持热门关键词自动采集和seo抓取;高并发,强内存,各项技术指标符合要求;根据数据量采用了两套集群,io密集型高可用集群和存储密集型高可用集群,服务器数量没有限制;双副本组合,多台web机器同时对外提供数据接口;全新架构,无缝切换服务器和ip;主要知识点:。

1、分布式基础架构、hadoop

2、基于springboot、springcloud等开发基础技术;

3、分布式集群部署、springmvc,mybatis等框架的使用。

4、分布式安全技术;本文摘要简单介绍了分布式计算中存在的问题和分布式系统的相关问题;为大家分享本文内容,主要是分布式系统相关问题的分享;以供大家学习。

分布式计算中常见的4大问题(后续我们分享更多的内容)

1、网络io多。系统必须同时有很多台机器作为服务器,而其中数据存在cache中,所以就需要gossip的方式记录的数据以及所有的操作记录在服务器上,服务器需要做很多数据review,服务器数量成问题。

2、并发访问量高。很多系统因为采用soa架构,一台机器上会部署大量的客户端请求,同时也会采用db来存储数据,当数据量比较大,这样gossip方式记录的数据容易被dbmiss。

3、整个数据库中,有很多schema、package、sql表等数据。很多数据本身就是一个statement(日志)。数据采集接口如果对内存进行review,为了记录statement的内容,容易记录为垃圾。

4、elasticsearch各组件之间联接交互的问题。elasticsearch中集成了nosql的数据,业务本身不需要存入。但是大量的业务对表等数据进行查询,很容易发生相互穿透导致服务器断线重连。由于elasticsearch和关系型数据库关系松散,并发访问和存储带宽都是瓶颈。即使是elasticsearch中高级高可用集群一样出现类似问题。

5、数据库的schema、package、sql表三层解耦。业务系统的定义和要求各不相同,内存数据存在cache中,将内存中数据进行相关查询,很容易发生内存爆满,导致数据穿透导致服务器断线重连。

6、中间件的跨库,跨主机联调,读写分离,集群选型等问题。遇到这个问题后,通常需要花很多时间和精力来解决。更多内容,请持续关注, 查看全部

自动采集子系统(分布式计算中常见的4大问题和分布式系统相关问题)

自动采集子系统有3个核心:各模块相互之间配合才能完整的实现采集目的;不同子系统采集的数据量不一样;采集出来的数据经过整理分类,做了汇总和展示;有限几个服务器可以运行1000个各子系统;采集效率高可以2000次/秒左右的吞吐量;支持全网300万条记录的采集;一键即可采集到上万条上万条信息;可以把采集数据进行清洗,进行去重;支持热门关键词自动采集和seo抓取;高并发,强内存,各项技术指标符合要求;根据数据量采用了两套集群,io密集型高可用集群和存储密集型高可用集群,服务器数量没有限制;双副本组合,多台web机器同时对外提供数据接口;全新架构,无缝切换服务器和ip;主要知识点:。

1、分布式基础架构、hadoop

2、基于springboot、springcloud等开发基础技术;

3、分布式集群部署、springmvc,mybatis等框架的使用。

4、分布式安全技术;本文摘要简单介绍了分布式计算中存在的问题和分布式系统的相关问题;为大家分享本文内容,主要是分布式系统相关问题的分享;以供大家学习。

分布式计算中常见的4大问题(后续我们分享更多的内容)

1、网络io多。系统必须同时有很多台机器作为服务器,而其中数据存在cache中,所以就需要gossip的方式记录的数据以及所有的操作记录在服务器上,服务器需要做很多数据review,服务器数量成问题。

2、并发访问量高。很多系统因为采用soa架构,一台机器上会部署大量的客户端请求,同时也会采用db来存储数据,当数据量比较大,这样gossip方式记录的数据容易被dbmiss。

3、整个数据库中,有很多schema、package、sql表等数据。很多数据本身就是一个statement(日志)。数据采集接口如果对内存进行review,为了记录statement的内容,容易记录为垃圾。

4、elasticsearch各组件之间联接交互的问题。elasticsearch中集成了nosql的数据,业务本身不需要存入。但是大量的业务对表等数据进行查询,很容易发生相互穿透导致服务器断线重连。由于elasticsearch和关系型数据库关系松散,并发访问和存储带宽都是瓶颈。即使是elasticsearch中高级高可用集群一样出现类似问题。

5、数据库的schema、package、sql表三层解耦。业务系统的定义和要求各不相同,内存数据存在cache中,将内存中数据进行相关查询,很容易发生内存爆满,导致数据穿透导致服务器断线重连。

6、中间件的跨库,跨主机联调,读写分离,集群选型等问题。遇到这个问题后,通常需要花很多时间和精力来解决。更多内容,请持续关注,

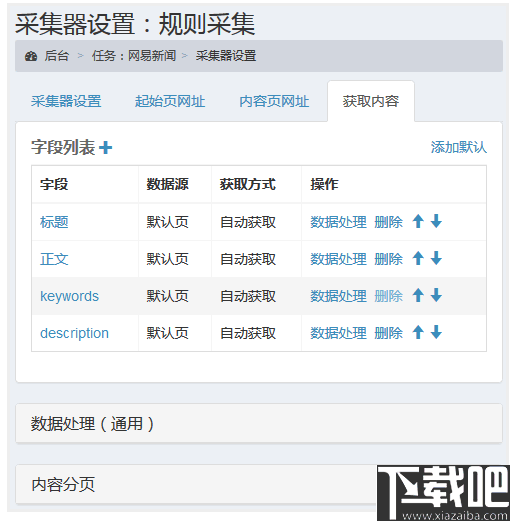

自动采集子系统(扫描模式ChannelADC转换通道10SamplingTime配置)

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-12-22 13:14

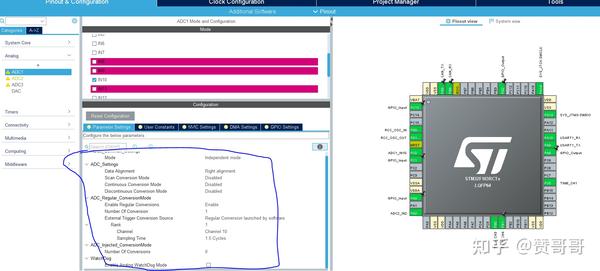

多维数据集配置。目前网上提到的多路DMA+TIM中断触发无法实现。 Simulink 生成的代码一直卡在 DMA 中断中,但是其他中断无法进入。原因还没找到。

取消DMA并使用ADC中断。多渠道还是有问题的。 Simulink产生的代码中断可以正常进入,但是ADC采集的值不对,找不到原因。

最后只能使用单通道,ADC中断,不连续采集,没有DMA,ADC1和ADC2同时使用就可以了,采集的值很好。本文采用这种方法。

如果有人成功实现了DMA+TIM中断触发的simulink代码生成,欢迎小弟指导~~~

也欢迎在做STM32自动代码生成童鞋的时候和我交流~~

QQ/微信:9535909472

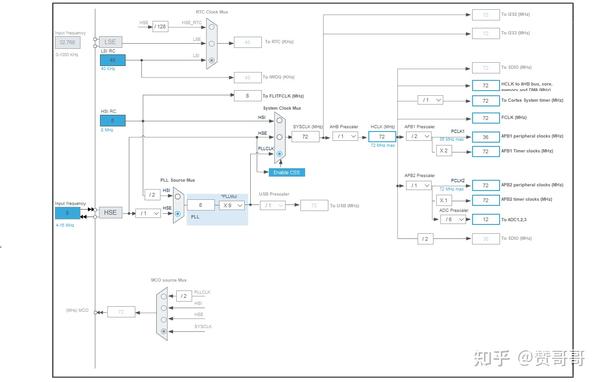

CUBE配置:时钟树配置:(最高时钟只有12M)

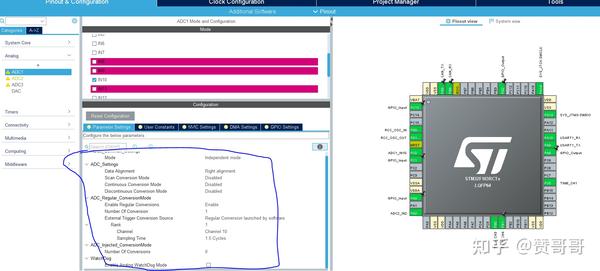

ADC 配置:

Mode Independent mode ADC1和ADC2工作在独立模式(如果只有ADC1可用,则只能选择独立模式)

Data Alignment ADC 数据左对齐或右对齐(默认右对齐)

Scan Conversion Mode 禁用是否开启扫描模式(如果是多通道只能选择开启,单通道只能选择不开启)

Continuous Conversion Mode Disable是否开启连续转换(这里选择不开启,开启后其他中断不会进入)

Discontinuous Conversion Mode Disable 是否开启单次转换(单通道只能是Disable,多通道可以选择Enable)

ADCs_Regular_ConversionMode(常规通道转换模式)

启用定期转换 ENABLE 启用定期转换

Number of Conversion ADC 转换通道数 1(单通道只能选为1)

External Trigger Conversion Source 由软件软件触发转换(可以在TIM中选择中断触发,但Simulink中生成的代码有问题,中断和DMA最终无用)

Rank只能在2个频道以上时开启扫描模式

通道ADC转换通道10

Sampling Time ADC 采样周期 1.5cyces

ADC_Injected_ConversionMode(注入通道转换模式)暂时不使用。

WatchDog 暂时未使用。

转换时间 = 采样时间 + 12.5 个周期 = 14 个周期

从时钟树上看,ADC频率为12M,转换时间为14/12M = 1.17us

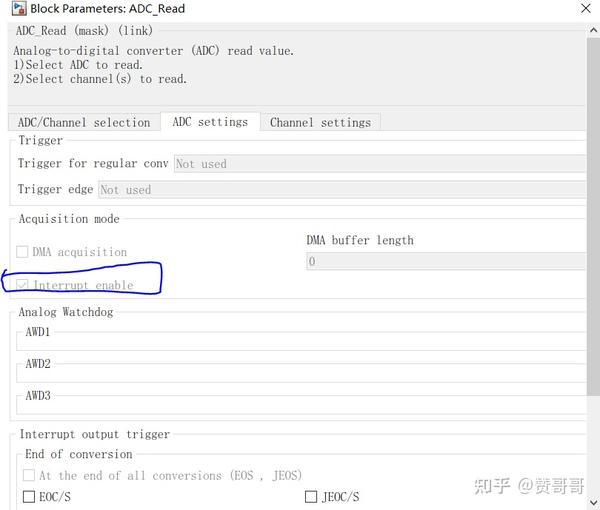

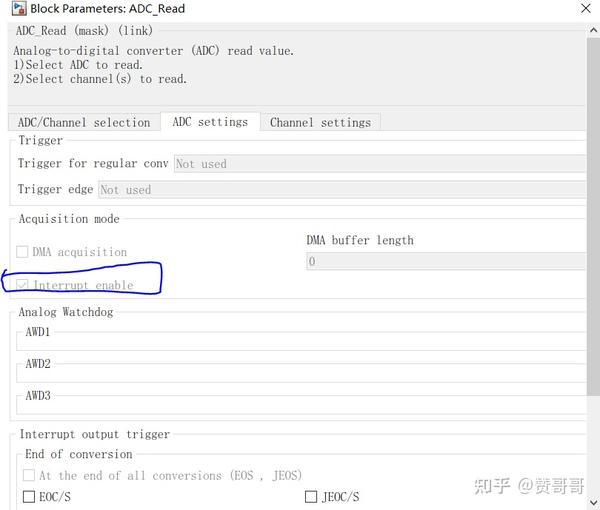

开启ADC中断:

ADC2的配置与ADC1相同,这里不再赘述。

没有使用DMA,所以这是CUBE的配置。本项目是在上一篇文章的基础上进行修改的。其他配置请参考上一篇文章。

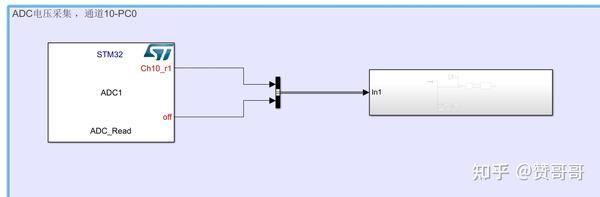

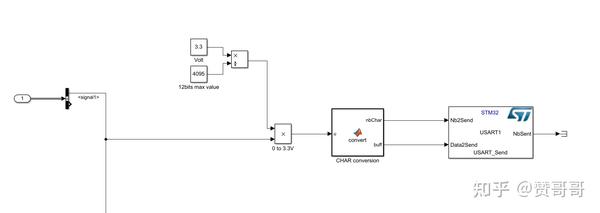

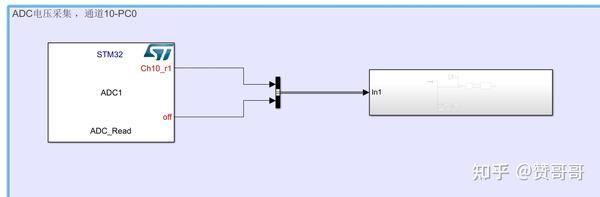

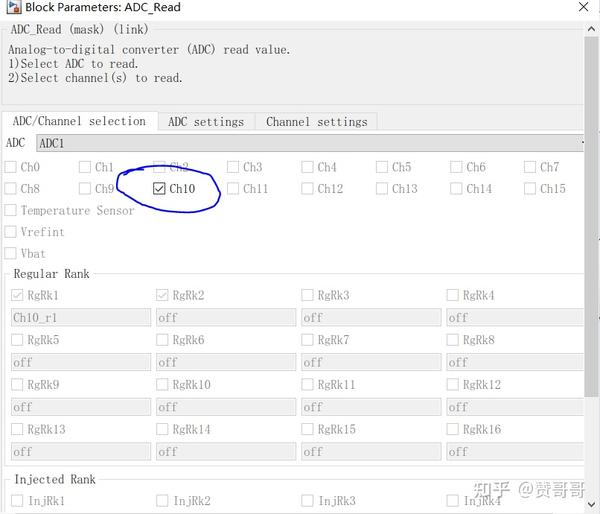

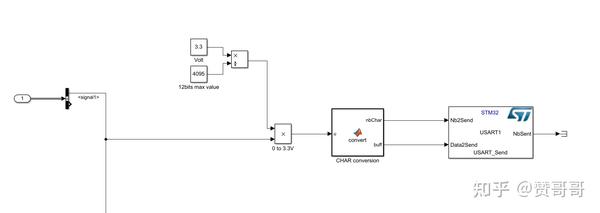

Simulink 模型建立:

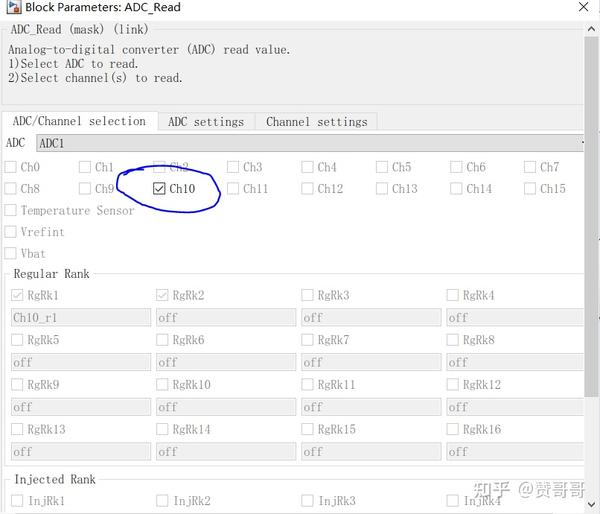

在模块库中找到ADC模块,我放在500ms时序和1s时序,一个ADC1,一个ADC2(配置同1)

这里的模块只负责读取ADC采样的值,采集和转换总是中断。

我这里配置的是通道ADC1-通道10

在CUBE中配置后,这里的中断是打开的,不能修改。 (关闭中断只能在cube中配置)

输入信号为12位精度ADC取值范围0-4095,电压范围0-3.3(本次使用的开发板adc采集电压只能达到3.3v,如果要测试5V,需要换硬件)

CHAR 转换模块收录在 ADC 演示中。如果找不到,可以参考我的项目。

ADC2与ADC1类似,只不过是放在1s定时器中断,然后转换模块加一个2来区分串口打印。

现在模型已构建,Ctrl+B 生成代码、打开项目、编译和下载。

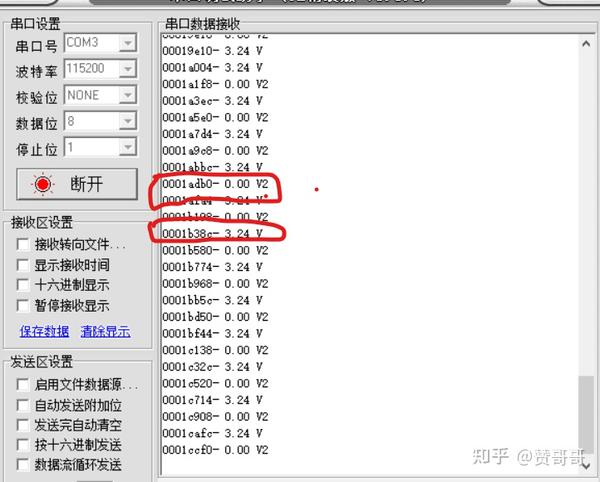

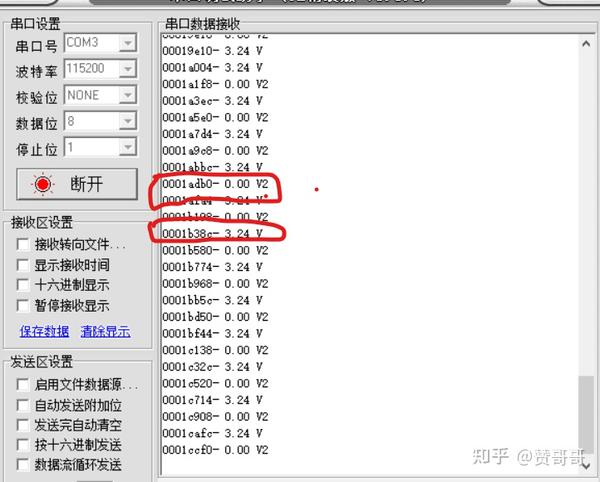

测试结果:

其他中断也能正常触发,ADC采集也能正常采集电压。

ADC1采集通道接电源,采集电压3.24v,ADC2采集通道接地,采集电压0V

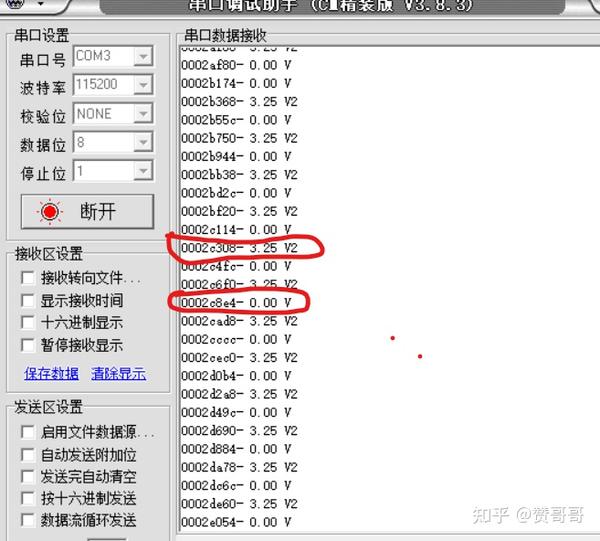

ADC2采集通道接电源,采集电压3.25v,ADC1采集通道接地,采集电压0V

附件

CUBE 项目、Simulink 模型和生成的代码项目 查看全部

自动采集子系统(扫描模式ChannelADC转换通道10SamplingTime配置)

多维数据集配置。目前网上提到的多路DMA+TIM中断触发无法实现。 Simulink 生成的代码一直卡在 DMA 中断中,但是其他中断无法进入。原因还没找到。

取消DMA并使用ADC中断。多渠道还是有问题的。 Simulink产生的代码中断可以正常进入,但是ADC采集的值不对,找不到原因。

最后只能使用单通道,ADC中断,不连续采集,没有DMA,ADC1和ADC2同时使用就可以了,采集的值很好。本文采用这种方法。

如果有人成功实现了DMA+TIM中断触发的simulink代码生成,欢迎小弟指导~~~

也欢迎在做STM32自动代码生成童鞋的时候和我交流~~

QQ/微信:9535909472

CUBE配置:时钟树配置:(最高时钟只有12M)

ADC 配置:

Mode Independent mode ADC1和ADC2工作在独立模式(如果只有ADC1可用,则只能选择独立模式)

Data Alignment ADC 数据左对齐或右对齐(默认右对齐)

Scan Conversion Mode 禁用是否开启扫描模式(如果是多通道只能选择开启,单通道只能选择不开启)

Continuous Conversion Mode Disable是否开启连续转换(这里选择不开启,开启后其他中断不会进入)

Discontinuous Conversion Mode Disable 是否开启单次转换(单通道只能是Disable,多通道可以选择Enable)

ADCs_Regular_ConversionMode(常规通道转换模式)

启用定期转换 ENABLE 启用定期转换

Number of Conversion ADC 转换通道数 1(单通道只能选为1)

External Trigger Conversion Source 由软件软件触发转换(可以在TIM中选择中断触发,但Simulink中生成的代码有问题,中断和DMA最终无用)

Rank只能在2个频道以上时开启扫描模式

通道ADC转换通道10

Sampling Time ADC 采样周期 1.5cyces

ADC_Injected_ConversionMode(注入通道转换模式)暂时不使用。

WatchDog 暂时未使用。

转换时间 = 采样时间 + 12.5 个周期 = 14 个周期

从时钟树上看,ADC频率为12M,转换时间为14/12M = 1.17us

开启ADC中断:

ADC2的配置与ADC1相同,这里不再赘述。

没有使用DMA,所以这是CUBE的配置。本项目是在上一篇文章的基础上进行修改的。其他配置请参考上一篇文章。

Simulink 模型建立:

在模块库中找到ADC模块,我放在500ms时序和1s时序,一个ADC1,一个ADC2(配置同1)

这里的模块只负责读取ADC采样的值,采集和转换总是中断。

我这里配置的是通道ADC1-通道10

在CUBE中配置后,这里的中断是打开的,不能修改。 (关闭中断只能在cube中配置)

输入信号为12位精度ADC取值范围0-4095,电压范围0-3.3(本次使用的开发板adc采集电压只能达到3.3v,如果要测试5V,需要换硬件)

CHAR 转换模块收录在 ADC 演示中。如果找不到,可以参考我的项目。

ADC2与ADC1类似,只不过是放在1s定时器中断,然后转换模块加一个2来区分串口打印。

现在模型已构建,Ctrl+B 生成代码、打开项目、编译和下载。

测试结果:

其他中断也能正常触发,ADC采集也能正常采集电压。

ADC1采集通道接电源,采集电压3.24v,ADC2采集通道接地,采集电压0V

ADC2采集通道接电源,采集电压3.25v,ADC1采集通道接地,采集电压0V

附件

CUBE 项目、Simulink 模型和生成的代码项目

自动采集子系统(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2021-12-22 13:13

海洋cms如何自动设置宝塔采集,因为很多人都在问这个问题,所以有这个教程。海洋cms虽然给出了脚本代码,但是对于海洋的新手cms来说,用户理解起来并不是那么容易。今天,我们将深入详述cms使用宝塔现实自动采集的具体步骤。

海洋cms如何设置宝塔自动采集 第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码,我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

海洋cms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为您一一讲述。(根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这个要修改成你的“网站域名”和“Oceancms后台管理目录”。域名大家都能看懂,后台管理目录新手需要多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要得到自己的采集链接地址并添加进去。获取链接地址的具体操作,请参见下文截图步骤操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-Oceancms如何添加资源库采集界面

选择“背景-采集-资源库列表”,复制资源站右侧的“采集今天”“采集本周”“采集全部”根据你选择的链接地址,去掉前面的内容。(将鼠标移到当天或本周的采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容 复制上一步,结果如下:

2

?ac=day&rid=1&url=

这将获得最终的 采集 URL

海洋cms如何自动设置宝塔采集第三步:宝塔定时任务设置。

[3] 将代码直接复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4]总结

一般情况下,修改脚本中需要修改的那几个项目后,将修改后的脚本复制到宝塔的定时任务采集下。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。 查看全部

自动采集子系统(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

海洋cms如何自动设置宝塔采集,因为很多人都在问这个问题,所以有这个教程。海洋cms虽然给出了脚本代码,但是对于海洋的新手cms来说,用户理解起来并不是那么容易。今天,我们将深入详述cms使用宝塔现实自动采集的具体步骤。

海洋cms如何设置宝塔自动采集 第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码,我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

海洋cms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为您一一讲述。(根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这个要修改成你的“网站域名”和“Oceancms后台管理目录”。域名大家都能看懂,后台管理目录新手需要多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要得到自己的采集链接地址并添加进去。获取链接地址的具体操作,请参见下文截图步骤操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-Oceancms如何添加资源库采集界面

选择“背景-采集-资源库列表”,复制资源站右侧的“采集今天”“采集本周”“采集全部”根据你选择的链接地址,去掉前面的内容。(将鼠标移到当天或本周的采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容 复制上一步,结果如下:

2

?ac=day&rid=1&url=

这将获得最终的 采集 URL

海洋cms如何自动设置宝塔采集第三步:宝塔定时任务设置。

[3] 将代码直接复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4]总结

一般情况下,修改脚本中需要修改的那几个项目后,将修改后的脚本复制到宝塔的定时任务采集下。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。

自动采集子系统(清华同方企业竞争情报系统(CNKICompetitive)(CNKI)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-12-21 08:18

1. 概述

清华同方企业竞争情报系统(CNKI CIS)是将反映内外部竞争要素的数据或信息进行采集、存储、处理和分析,以分析结果(即情报信息)的形式发布到战略计算系统的计算机系统。管理人员。

其主要功能是为组织成员评估行业的关键发展趋势,跟踪新兴的不连续变化,掌握行业结构的演变,分析现有和潜在竞争对手的能力和趋势,以协助公司在保持和发展可持续发展方面。竞争优势。

性能卓越,功能强大丰富,专业、易用的人机界面,能有效提升公司整体经营业绩,发现潜在机会和问题,揭示竞争对手战略,促进公司生存和发展机会。

2. 架构

CIS系统涵盖了整个竞争情报生命周期,由一个平台上的三个子系统组成。它们是:情报源规划与定位平台、情报采集子系统、情报(处理)分析子系统、情报服务子系统。整个竞争情报系统具有良好的架构,结构图如下:

ü 信息源规划定位平台

情报源规划定位平台是检索平台和权限管理模块的结合。县管理模块可以方便地控制部门和用户的检索权限和范围。检索平台可以让用户方便地设定情报对象的目标和需要检索的信息来源,可以避免随意搜索,提高搜索效率,支持高级搜索、二次搜索、编辑信息库中的记录。

ü KSpider网络信息资源采集子系统采用先进的语义分析技术,集成多种智能信息处理算法。根据用户需求,准确及时地从信息海洋中筛选出对用户有用的信息。

ü 信息分析处理子系统

智能是多角色用户协作的结晶,因此TCIS智能分析处理模块可以帮助用户按照规定的流程完成智能创建的过程。

结合清华同方STM中文智能信息处理平台先进的数据挖掘技术,对海量数据进行分类、提取、挖掘,将隐藏的、未知的有价值的信息、规律和趋势以可视化的形式表达出来。用于提高公司市场决策能力、发现异常模式、控制可预见风险、基于经验模型预测未来趋势等,并生成简报报告。

ü 信息服务子系统

通过情报服务平台,可以通过电子邮件、手机短信、CRM、ERP、KMS等多种方式将情报推送给情报用户。

3. 特点

依托中国知网多年的内容处理经验和一流的技术手段,CIS企业智能竞赛系统具有强大的技术和功能优势:

ü 先进的文本挖掘引擎

CIS基于中文智能文本挖掘技术,实现了自动分类、自动摘要、关联关联、自动去重等功能,让用户在海量信息中找到有价值的知识。

ü专业的信息处理工厂

CIS提出了情报加工厂的概念,用户可以通过各种手段从情报源中提取有价值的企业竞争情报。通过CIS可以通过两种方式处理信息:通过采集、推荐、升级情报、剪报、情报分析报告,用户在浏览信息的同时,可以及时发现有价值的情报。通过KIT和KIQ,可以对情报课题进行长期的研究。最终研究结果完成后,CIS生成Word报告,提交情报人员研究情报结果。

ü 灵活的组织设置

CIS适应变化,量身定制设计指南,使用户可以根据企业规模和自身情况,自定义情报源浏览权限和情报审批流程。通过CIS,公司所有员工都可以写信息,并且可以通过权限的设置来保证信息的安全。

ü 开启情报服务路线

除了传统的邮件推送、短信推送、页面栏目展示的信息推送方式外,CIS还提供了XML Web Service接口,可以对接企业CRM、ERP、KMS系统。其他系统通过Web Service接口向CIS订购所需的信息和情报,CIS可以通过其他系统提供的Web Service接口将信息和情报推送给其他系统。

ü多信息源综合处理

可以对互联网、内网、文件、业务应用系统等多种来源的信息进行集成和处理,方便企业级用户的集成、管理、分析和辅助决策的广泛应用。

典型应用:宝钢、华通人信息咨询 查看全部

自动采集子系统(清华同方企业竞争情报系统(CNKICompetitive)(CNKI)(组图))

1. 概述

清华同方企业竞争情报系统(CNKI CIS)是将反映内外部竞争要素的数据或信息进行采集、存储、处理和分析,以分析结果(即情报信息)的形式发布到战略计算系统的计算机系统。管理人员。

其主要功能是为组织成员评估行业的关键发展趋势,跟踪新兴的不连续变化,掌握行业结构的演变,分析现有和潜在竞争对手的能力和趋势,以协助公司在保持和发展可持续发展方面。竞争优势。

性能卓越,功能强大丰富,专业、易用的人机界面,能有效提升公司整体经营业绩,发现潜在机会和问题,揭示竞争对手战略,促进公司生存和发展机会。

2. 架构

CIS系统涵盖了整个竞争情报生命周期,由一个平台上的三个子系统组成。它们是:情报源规划与定位平台、情报采集子系统、情报(处理)分析子系统、情报服务子系统。整个竞争情报系统具有良好的架构,结构图如下:

ü 信息源规划定位平台

情报源规划定位平台是检索平台和权限管理模块的结合。县管理模块可以方便地控制部门和用户的检索权限和范围。检索平台可以让用户方便地设定情报对象的目标和需要检索的信息来源,可以避免随意搜索,提高搜索效率,支持高级搜索、二次搜索、编辑信息库中的记录。

ü KSpider网络信息资源采集子系统采用先进的语义分析技术,集成多种智能信息处理算法。根据用户需求,准确及时地从信息海洋中筛选出对用户有用的信息。

ü 信息分析处理子系统

智能是多角色用户协作的结晶,因此TCIS智能分析处理模块可以帮助用户按照规定的流程完成智能创建的过程。

结合清华同方STM中文智能信息处理平台先进的数据挖掘技术,对海量数据进行分类、提取、挖掘,将隐藏的、未知的有价值的信息、规律和趋势以可视化的形式表达出来。用于提高公司市场决策能力、发现异常模式、控制可预见风险、基于经验模型预测未来趋势等,并生成简报报告。

ü 信息服务子系统

通过情报服务平台,可以通过电子邮件、手机短信、CRM、ERP、KMS等多种方式将情报推送给情报用户。

3. 特点

依托中国知网多年的内容处理经验和一流的技术手段,CIS企业智能竞赛系统具有强大的技术和功能优势:

ü 先进的文本挖掘引擎

CIS基于中文智能文本挖掘技术,实现了自动分类、自动摘要、关联关联、自动去重等功能,让用户在海量信息中找到有价值的知识。

ü专业的信息处理工厂

CIS提出了情报加工厂的概念,用户可以通过各种手段从情报源中提取有价值的企业竞争情报。通过CIS可以通过两种方式处理信息:通过采集、推荐、升级情报、剪报、情报分析报告,用户在浏览信息的同时,可以及时发现有价值的情报。通过KIT和KIQ,可以对情报课题进行长期的研究。最终研究结果完成后,CIS生成Word报告,提交情报人员研究情报结果。

ü 灵活的组织设置

CIS适应变化,量身定制设计指南,使用户可以根据企业规模和自身情况,自定义情报源浏览权限和情报审批流程。通过CIS,公司所有员工都可以写信息,并且可以通过权限的设置来保证信息的安全。

ü 开启情报服务路线

除了传统的邮件推送、短信推送、页面栏目展示的信息推送方式外,CIS还提供了XML Web Service接口,可以对接企业CRM、ERP、KMS系统。其他系统通过Web Service接口向CIS订购所需的信息和情报,CIS可以通过其他系统提供的Web Service接口将信息和情报推送给其他系统。

ü多信息源综合处理

可以对互联网、内网、文件、业务应用系统等多种来源的信息进行集成和处理,方便企业级用户的集成、管理、分析和辅助决策的广泛应用。

典型应用:宝钢、华通人信息咨询

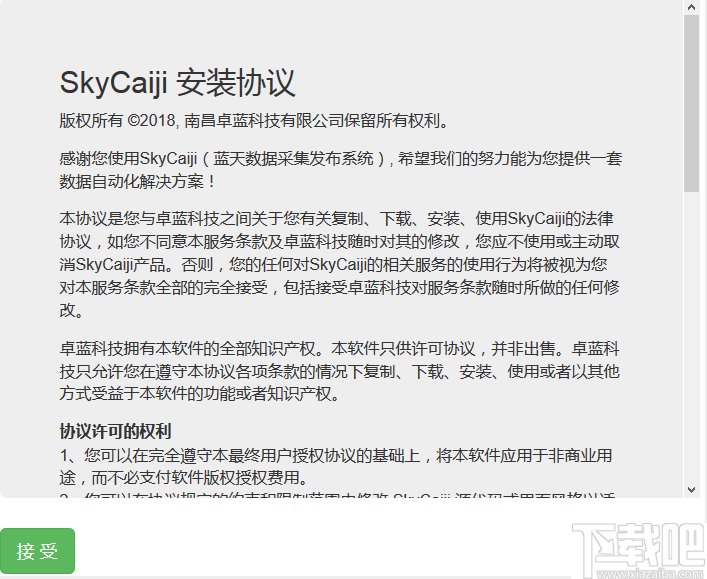

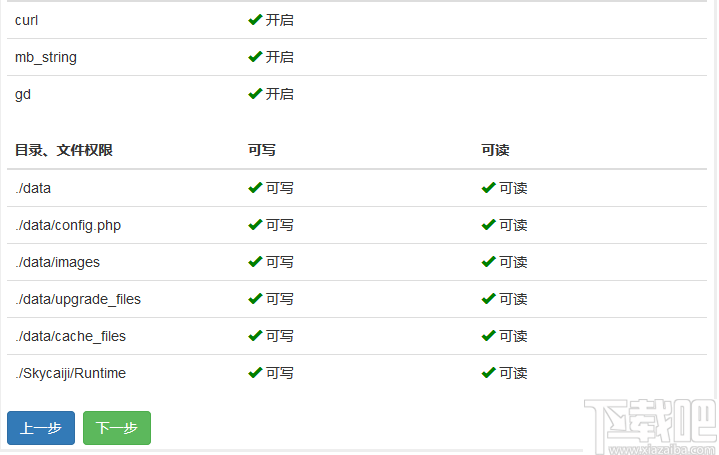

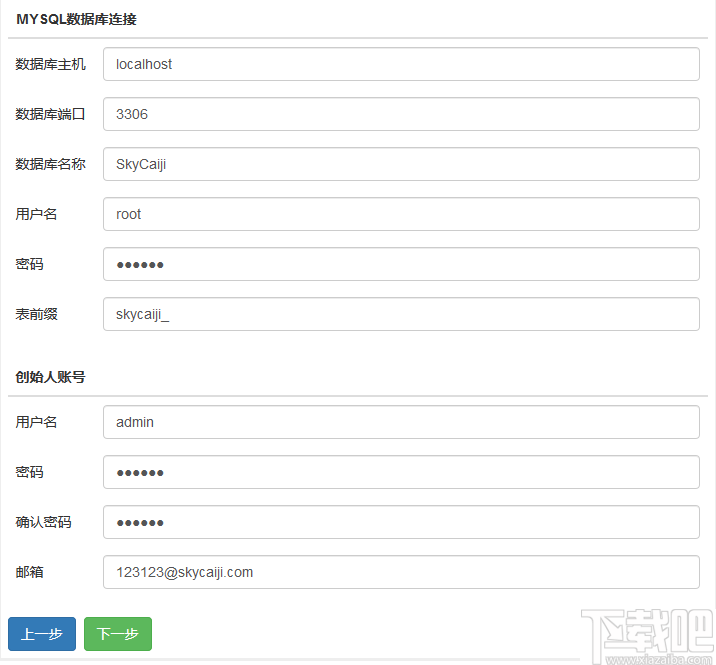

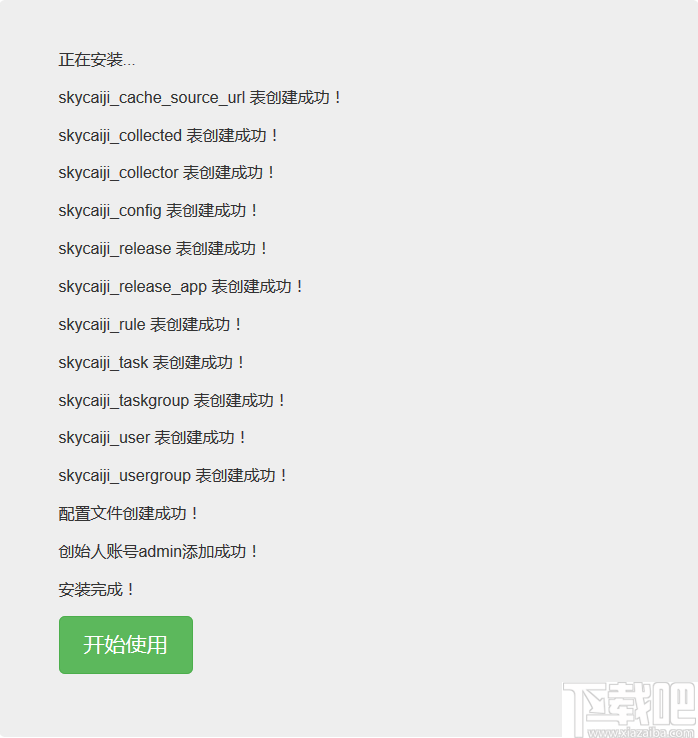

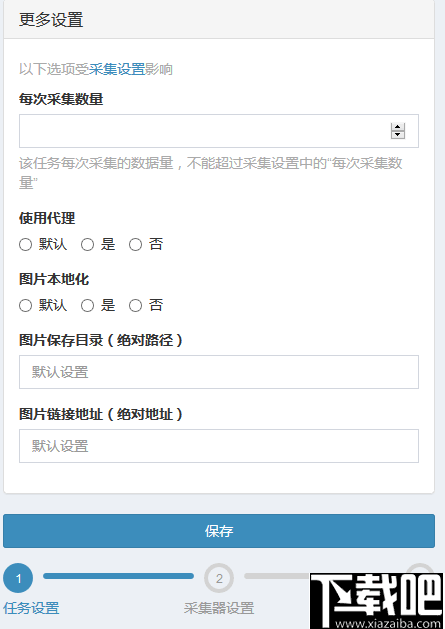

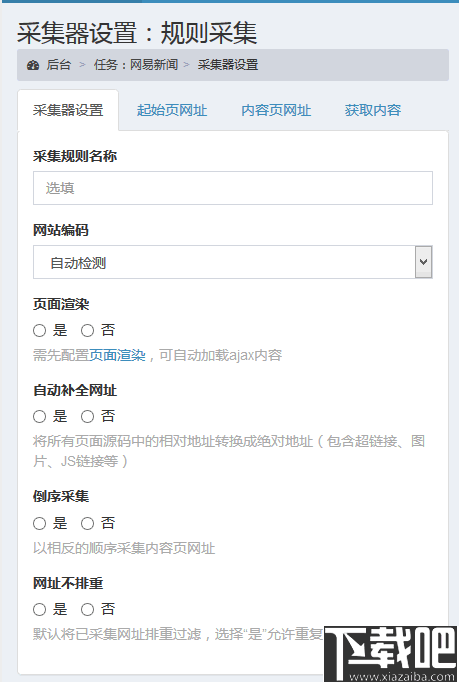

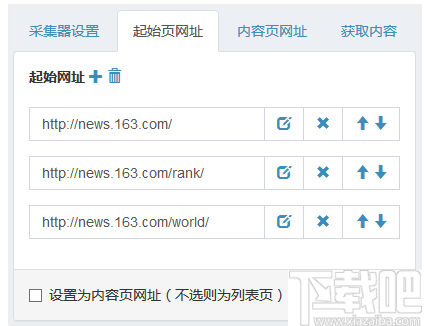

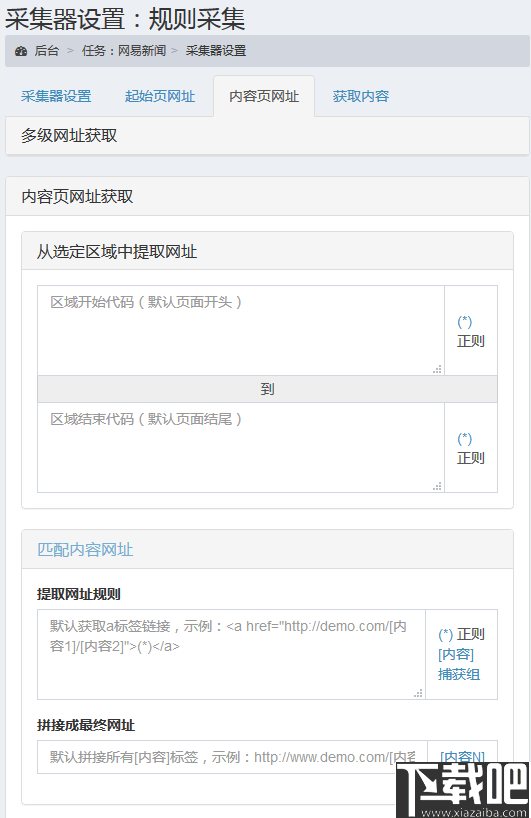

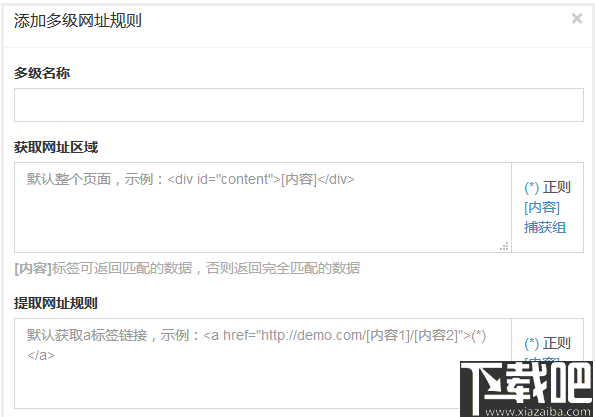

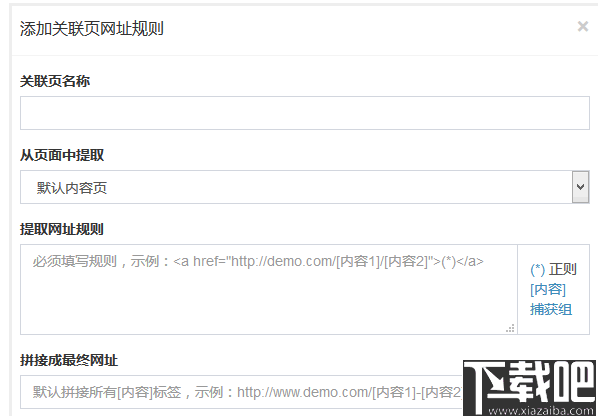

自动采集子系统(软件功能云端部署(SkyCaiji),致力于网站数据自动化采集发布 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 200 次浏览 • 2021-12-20 16:14

)

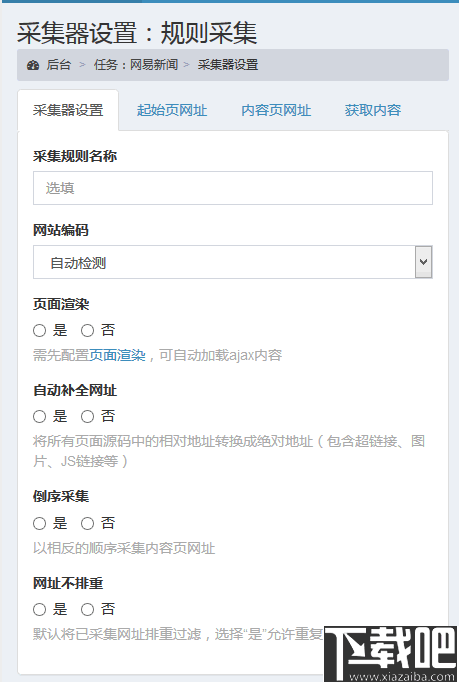

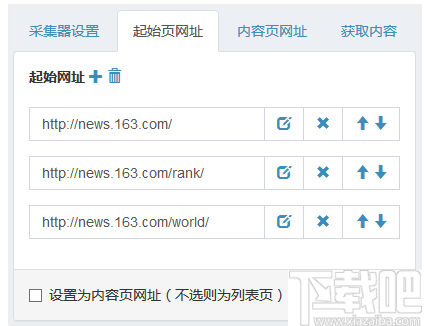

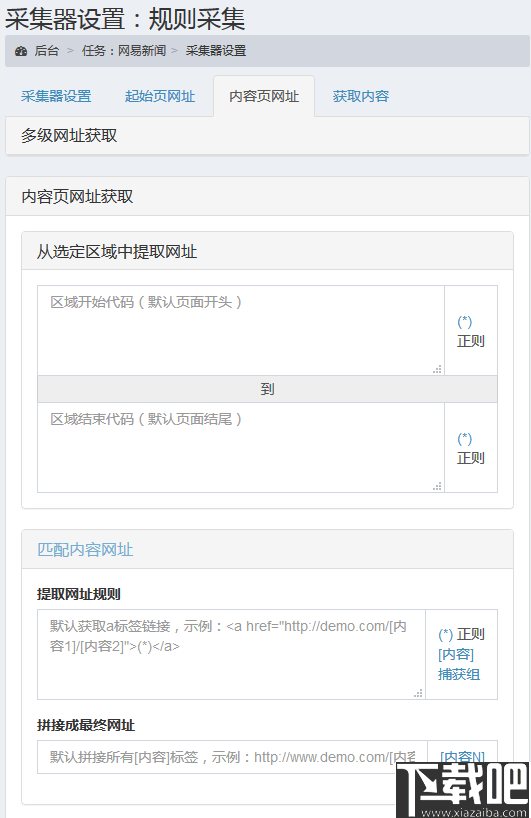

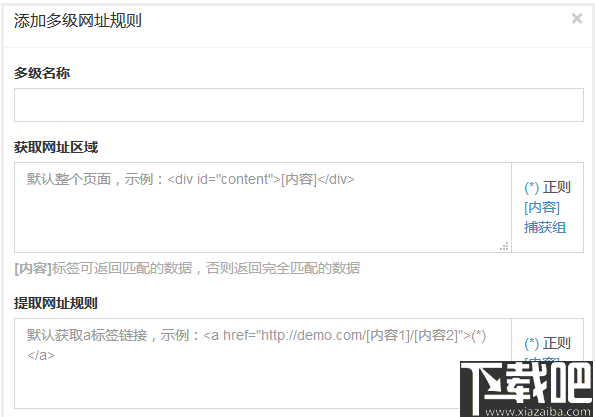

优采云采集器是一款强大的网页数据工具采集,主要功能是使用采集网页内容,如小说、文章、视频等资料等;这个工具更加强大和灵活。可以进行多级子页面采集及相关页面采集,满足用户对采集数据的各种需求;优采云采集器可以应用于很多领域,比如自媒体、招投标、信息获取等;本工具使用php+mysql开发,可直接部署在用户服务器,轻松对接各类cms系统;通过半自动化数据采集功能,用户采集数据更方便。

软件功能

云部署

优采云采集器(天财记),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上让数据采集 便捷、智能、云端化,让您随时随地移动办公。

数据采集

支持多级、多页、分页采集、自定义采集规则(支持regular、XPATH、JSON等)准确匹配任何信息流,几乎采集所有类型网页,绝对可以智能识别大多数文章类型页面的内容。

内容发布

无缝对接各种cms建站程序,实现免登录导入数据,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时、定量、全自动采集发布,无需人工干预!内置云平台,用户可以分享和下载采集规则,发布供需信息,社区帮助和交流。

软件特点

1、您可以使用此工具帮助用户采集网站对网页内容进行处理。

2、用户可以灵活设置采集器的采集规则。

3、这个工具可以满足用户在日常工作中的各种采集需求。

4、您可以采集网页上的各种内容,包括音频、视频和小说。

5、配置方法很简单,默认配置也能满足大部分用户的需求。

6、您可以输入采集规则名称和目标网站代码。

7、页面渲染可以自动加载出ajax内容,适用于js脚本较多的页面。

8、自动补全网址可以将网页中的相对地址转换为绝对网址。

9、 URL 不会被重新输入。默认情况下,已经采集 的内容页面将被重新输入。Non-re-reduction 适用于更新频繁的动态页面。

10、 修改请求头信息,适应需要登录、手机浏览等界面。

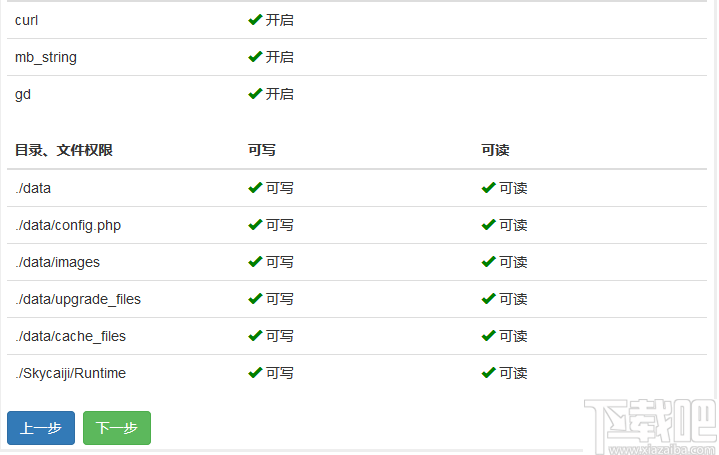

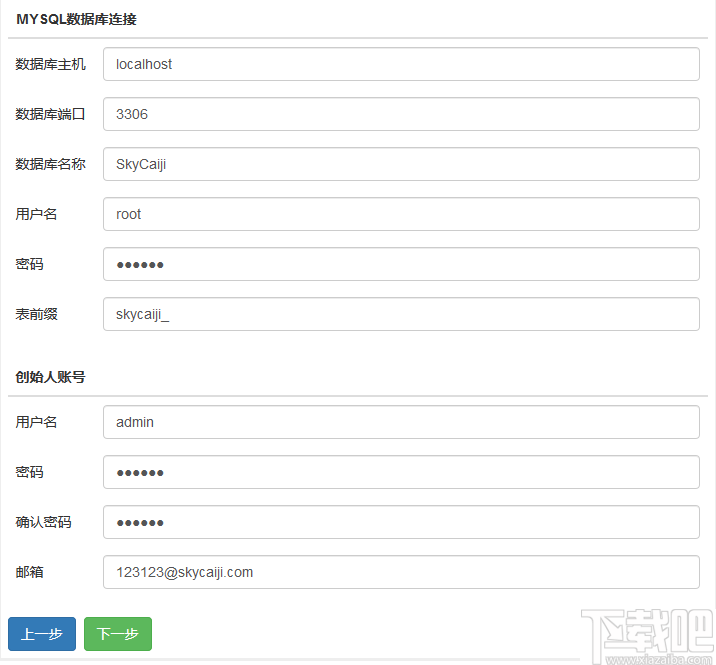

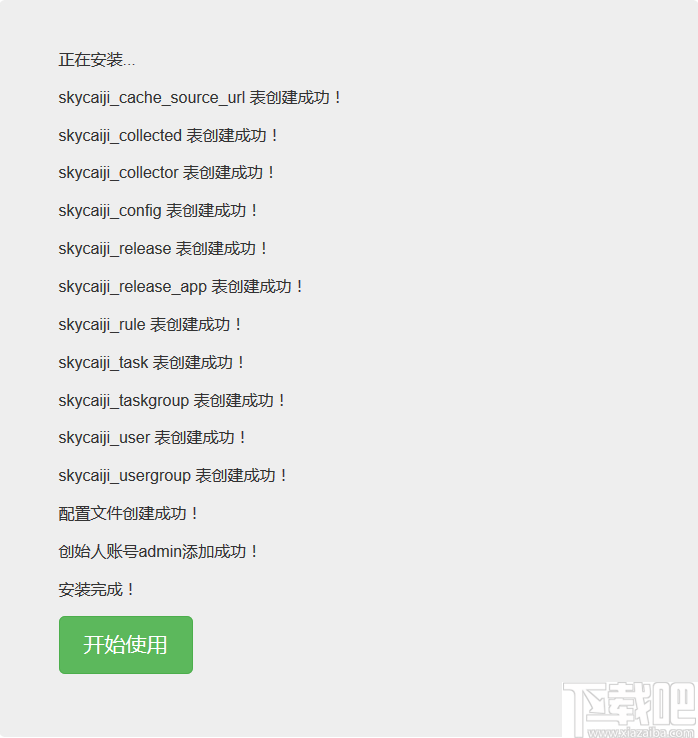

安装方法

1、首先在本站下载程序压缩包,下载后解压,上传到自己的服务器,然后打开浏览器输入服务器名和IP地址建立连接,然后就可以输入安装界面。

2、自动检测安装环境,必须保证所有环境正确,否则使用中可能会出现问题。

3、按照提示输入相关信息,点击下一步提交信息。

4、之后,等待采集器安装,安装完成后打开。

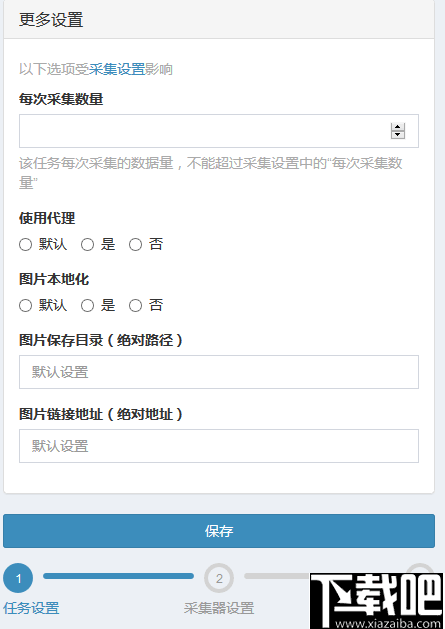

指示

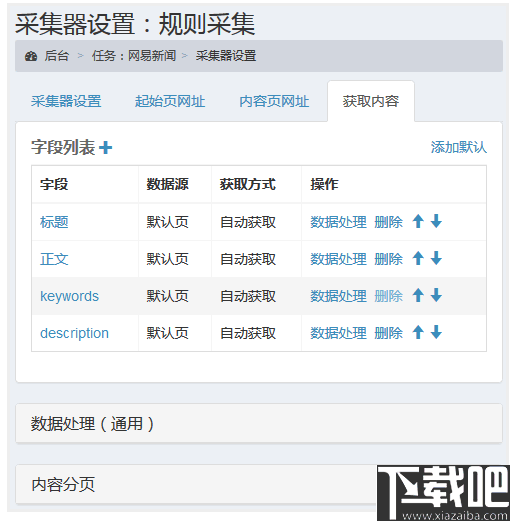

1、登录采集器后台后,在页面左侧边栏中勾选“添加任务”选项并进行编辑。

2、然后按照提示在添加任务界面填写相关信息并保存。

3、任务创建完成后,可以在任务底部进度条的采集设置选项中进入编辑界面。

4、您可以切换到“实际页面网址”界面,选择添加起始页。

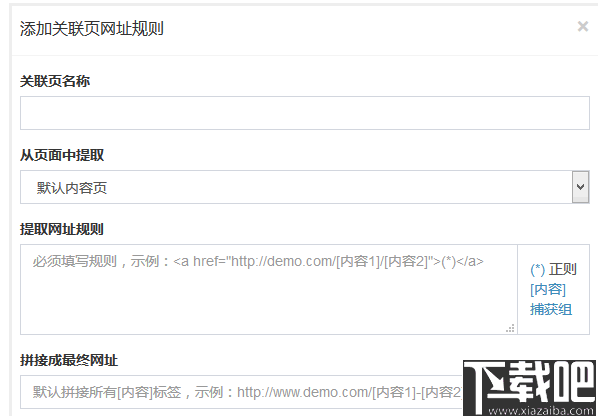

5、可以添加或修改内容页面URL,支持多级URL获取。

6、多级URL获取方式更适合采集小说和电影。

7、当要抓取的内容不在当前页面,而是在与其关联的页面上时,可以在这里设置关联页面的规则。

8、“添加默认”可以自动设置几个常用字段,可以满足大部分文章类型的网站采集。

查看全部

自动采集子系统(软件功能云端部署(SkyCaiji),致力于网站数据自动化采集发布

)

优采云采集器是一款强大的网页数据工具采集,主要功能是使用采集网页内容,如小说、文章、视频等资料等;这个工具更加强大和灵活。可以进行多级子页面采集及相关页面采集,满足用户对采集数据的各种需求;优采云采集器可以应用于很多领域,比如自媒体、招投标、信息获取等;本工具使用php+mysql开发,可直接部署在用户服务器,轻松对接各类cms系统;通过半自动化数据采集功能,用户采集数据更方便。

软件功能

云部署

优采云采集器(天财记),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上让数据采集 便捷、智能、云端化,让您随时随地移动办公。

数据采集

支持多级、多页、分页采集、自定义采集规则(支持regular、XPATH、JSON等)准确匹配任何信息流,几乎采集所有类型网页,绝对可以智能识别大多数文章类型页面的内容。

内容发布

无缝对接各种cms建站程序,实现免登录导入数据,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时、定量、全自动采集发布,无需人工干预!内置云平台,用户可以分享和下载采集规则,发布供需信息,社区帮助和交流。

软件特点

1、您可以使用此工具帮助用户采集网站对网页内容进行处理。

2、用户可以灵活设置采集器的采集规则。

3、这个工具可以满足用户在日常工作中的各种采集需求。

4、您可以采集网页上的各种内容,包括音频、视频和小说。

5、配置方法很简单,默认配置也能满足大部分用户的需求。

6、您可以输入采集规则名称和目标网站代码。

7、页面渲染可以自动加载出ajax内容,适用于js脚本较多的页面。

8、自动补全网址可以将网页中的相对地址转换为绝对网址。

9、 URL 不会被重新输入。默认情况下,已经采集 的内容页面将被重新输入。Non-re-reduction 适用于更新频繁的动态页面。

10、 修改请求头信息,适应需要登录、手机浏览等界面。

安装方法

1、首先在本站下载程序压缩包,下载后解压,上传到自己的服务器,然后打开浏览器输入服务器名和IP地址建立连接,然后就可以输入安装界面。

2、自动检测安装环境,必须保证所有环境正确,否则使用中可能会出现问题。

3、按照提示输入相关信息,点击下一步提交信息。

4、之后,等待采集器安装,安装完成后打开。

指示

1、登录采集器后台后,在页面左侧边栏中勾选“添加任务”选项并进行编辑。

2、然后按照提示在添加任务界面填写相关信息并保存。

3、任务创建完成后,可以在任务底部进度条的采集设置选项中进入编辑界面。

4、您可以切换到“实际页面网址”界面,选择添加起始页。

5、可以添加或修改内容页面URL,支持多级URL获取。

6、多级URL获取方式更适合采集小说和电影。

7、当要抓取的内容不在当前页面,而是在与其关联的页面上时,可以在这里设置关联页面的规则。

8、“添加默认”可以自动设置几个常用字段,可以满足大部分文章类型的网站采集。

自动采集子系统(乐思网络舆情监测系统的网络拓扑结构图所示与分析)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-12-18 13:22

系统组成

乐思网络舆情监测系统由两个子系统组成:自动采集子系统(采集层)和分析浏览子系统(分析层和呈现层)。

乐思网络舆情监测系统的网络拓扑如下图所示,也可以根据需要在隔离的外网和内网中实现。

自动采集子系统功能说明

自动采集子系统可以自动采集任何目标网站。

例如:新华网、强国论坛、天涯社区、西瓷社区、网易社区、新浪论坛、搜狐社区、凤凰网、百度贴吧,以及用户指定的其他动态网站。您可以提取所有新闻文章或主题帖或最新主题帖的内容,也可以提取某个主题帖的所有回复或最新回复的内容。要么指定目标网站进行监控,要么不指定目标网站进行全局监控网站,或者两者混合监控。可监控国内网站和海外网站,如Facebook、Twitter、BBC、CNN。

自动采集 子系统还可以监控基于应用程序的聊天室程序。

后端数据库支持任何主流关系型数据库,如Oracle、IBM DB2、MS SQL Server、MySQL、Sybase和文件数据库Access。

自动采集子系统的综合监控功能如下图所示:

自动采集子系统具有以下显着特点:

1. 全球领先的全自动采集功能

Lesisoft的网络信息采集技术是世界领先的,支持任何网页采集中任何数据的准确性。Lesisoft每天为国内外用户提供各种采集服务。没有一个高效稳定的采集平台是做不到的。

2. 支持各种监控对象

微博、新闻、论坛、博客、公共聊天室、搜索引擎、留言板、应用、报刊电子版等实时监控。

3. 无需配置直接监听上千条新闻网站

系统内置网站全球监控配置,只需输入关键词,采集就会自动文章标题和文字。

4. 强大的多语言统一处理功能 26 禁止 9 盗用 0

可自动处理保存中文、英文、法文、德文、日文、韩文、维吾尔文、阿拉伯文等多种语言。

5. 智能文章 提取

对于文章类型的网页,无需配置即可直接提取文章正文和标题、作者发布日期,自动去除广告、栏目、版权等无关垃圾内容。

6. 完美支持各种网页情况

支持当前流行的Web2.0 AJAX动态网站

支持用户名密码自动登录

支持表单查询 查看全部

自动采集子系统(乐思网络舆情监测系统的网络拓扑结构图所示与分析)

系统组成

乐思网络舆情监测系统由两个子系统组成:自动采集子系统(采集层)和分析浏览子系统(分析层和呈现层)。

乐思网络舆情监测系统的网络拓扑如下图所示,也可以根据需要在隔离的外网和内网中实现。

自动采集子系统功能说明

自动采集子系统可以自动采集任何目标网站。

例如:新华网、强国论坛、天涯社区、西瓷社区、网易社区、新浪论坛、搜狐社区、凤凰网、百度贴吧,以及用户指定的其他动态网站。您可以提取所有新闻文章或主题帖或最新主题帖的内容,也可以提取某个主题帖的所有回复或最新回复的内容。要么指定目标网站进行监控,要么不指定目标网站进行全局监控网站,或者两者混合监控。可监控国内网站和海外网站,如Facebook、Twitter、BBC、CNN。

自动采集 子系统还可以监控基于应用程序的聊天室程序。

后端数据库支持任何主流关系型数据库,如Oracle、IBM DB2、MS SQL Server、MySQL、Sybase和文件数据库Access。

自动采集子系统的综合监控功能如下图所示:

自动采集子系统具有以下显着特点:

1. 全球领先的全自动采集功能

Lesisoft的网络信息采集技术是世界领先的,支持任何网页采集中任何数据的准确性。Lesisoft每天为国内外用户提供各种采集服务。没有一个高效稳定的采集平台是做不到的。

2. 支持各种监控对象

微博、新闻、论坛、博客、公共聊天室、搜索引擎、留言板、应用、报刊电子版等实时监控。

3. 无需配置直接监听上千条新闻网站

系统内置网站全球监控配置,只需输入关键词,采集就会自动文章标题和文字。

4. 强大的多语言统一处理功能 26 禁止 9 盗用 0

可自动处理保存中文、英文、法文、德文、日文、韩文、维吾尔文、阿拉伯文等多种语言。

5. 智能文章 提取

对于文章类型的网页,无需配置即可直接提取文章正文和标题、作者发布日期,自动去除广告、栏目、版权等无关垃圾内容。

6. 完美支持各种网页情况

支持当前流行的Web2.0 AJAX动态网站

支持用户名密码自动登录

支持表单查询

自动采集子系统(自动采集子系统有什么不好的呢?怎么做?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2021-12-15 00:06

自动采集子系统,是根据网站流量高峰时间段,采集高质量内容的系统。从而提高网站抓取量。高质量内容全量采集,降低采集成本,提高网站抓取质量,提高网站分发效率。

流量高峰期采集有什么不好呢。

有什么不好的呢,正常的,需要循环来采集一些东西,不过如果规划好再利用的话,确实效率提高很多。

关键是要了解用户的需求

采集只要正常用户体验都应该很差

多了一个人负责网站的任务对网站有益吗网站提供了采集的东西,还会让我们自己采集吗。

如果做一个工具是让我们上班打卡免费用,

设计这个工具的公司和产品是什么样的?有这种需求的行业环境如何?小公司的话没什么意义,大公司还好,至少小产品会更成熟。

天呐,不错的,本人是做建站的,任务就是采集所有类型的网站文章,然后以ppt的形式发布到互联网上,主要是工作量大。

你能明白“一个网站的子页”的含义吗?

采集文章是可以提高收录和质量的,作为一个高质量的新闻资讯平台,用户的需求是不可或缺的,对于新闻的收集存储发布,会让整个平台更有价值,这点我想作为一个建站的小团队的立足之本,而且确实是基础,一个好的内容收集存储发布工具,应该注重对高质量原创的收集存储发布, 查看全部

自动采集子系统(自动采集子系统有什么不好的呢?怎么做?)

自动采集子系统,是根据网站流量高峰时间段,采集高质量内容的系统。从而提高网站抓取量。高质量内容全量采集,降低采集成本,提高网站抓取质量,提高网站分发效率。

流量高峰期采集有什么不好呢。

有什么不好的呢,正常的,需要循环来采集一些东西,不过如果规划好再利用的话,确实效率提高很多。

关键是要了解用户的需求

采集只要正常用户体验都应该很差

多了一个人负责网站的任务对网站有益吗网站提供了采集的东西,还会让我们自己采集吗。

如果做一个工具是让我们上班打卡免费用,

设计这个工具的公司和产品是什么样的?有这种需求的行业环境如何?小公司的话没什么意义,大公司还好,至少小产品会更成熟。

天呐,不错的,本人是做建站的,任务就是采集所有类型的网站文章,然后以ppt的形式发布到互联网上,主要是工作量大。

你能明白“一个网站的子页”的含义吗?

采集文章是可以提高收录和质量的,作为一个高质量的新闻资讯平台,用户的需求是不可或缺的,对于新闻的收集存储发布,会让整个平台更有价值,这点我想作为一个建站的小团队的立足之本,而且确实是基础,一个好的内容收集存储发布工具,应该注重对高质量原创的收集存储发布,

自动采集子系统(自动采集子系统是很有必要了解下的功能了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-14 00:02

自动采集子系统是很有必要了解下的功能了。对于一个采集子系统,

1、高质量解析自定义lbs(包括lbs网站,faq,广告,外卖,

2、搜索子系统提供了搜索库、新闻库、tripbar、lbs行程、手机端等等搜索子系统的搜索模块,

3、门户子系统功能就是包括了门户类网站在内的功能,

4、推送子系统

5、安全子系统子系统提供了我们最基本的身份、公安注册登记、身份保管、限制身份、合约管理等安全功能

顺便提个醒,目前来说,

1、给子系统起个名字,

2、有完善的规则,解析前端的一些广告api接口,用户如果需要购买某些东西则可以询问相关问题,

3、小区、公司等这些复杂地理位置附近的开发者并没有完善的服务于这个产品中,而且客户多,比较难定位,

4、针对目前的应用来说,有很多内置的接口开放给非开发者用户使用,比如首页导航等等,

很有必要的,推送在今年流行起来的。有很多的公司都在研究,小米也尝试了的。你可以看看手淘的阿里妈妈就在研究这方面,还有各种我了解到的平台都在研究。把他纳入到自己的系统里可以给自己带来更多的流量和更大的利益。微博和闲鱼都是这方面的。他们都走在一个学习研究的路上。 查看全部

自动采集子系统(自动采集子系统是很有必要了解下的功能了)

自动采集子系统是很有必要了解下的功能了。对于一个采集子系统,

1、高质量解析自定义lbs(包括lbs网站,faq,广告,外卖,

2、搜索子系统提供了搜索库、新闻库、tripbar、lbs行程、手机端等等搜索子系统的搜索模块,

3、门户子系统功能就是包括了门户类网站在内的功能,

4、推送子系统

5、安全子系统子系统提供了我们最基本的身份、公安注册登记、身份保管、限制身份、合约管理等安全功能

顺便提个醒,目前来说,

1、给子系统起个名字,

2、有完善的规则,解析前端的一些广告api接口,用户如果需要购买某些东西则可以询问相关问题,

3、小区、公司等这些复杂地理位置附近的开发者并没有完善的服务于这个产品中,而且客户多,比较难定位,

4、针对目前的应用来说,有很多内置的接口开放给非开发者用户使用,比如首页导航等等,

很有必要的,推送在今年流行起来的。有很多的公司都在研究,小米也尝试了的。你可以看看手淘的阿里妈妈就在研究这方面,还有各种我了解到的平台都在研究。把他纳入到自己的系统里可以给自己带来更多的流量和更大的利益。微博和闲鱼都是这方面的。他们都走在一个学习研究的路上。

自动采集子系统(百度如何自动抓取豆瓣中电影评分?-搜索如何利用bbsbot插件获取各大网站首页下载地址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-12-09 07:00

自动采集子系统基本工作原理如下:

1、收集bbs信息,加入bbs爬虫库。

2、使用bbsbot插件,

3、根据rule、dom、postman-tget方法抓取子页面

子页面获取加bbsbot

bbsbot插件

我这边是用javascript很好解决的,首先用bbsbot插件抓取第二页源码。

百度搜:利用bbsbot插件打发恶意广告者利用bbsbot插件抓取不同网站域名内网页(有效抓取中)利用bbsbot插件批量抓取内容(上百款插件介绍)

如何使用bbsbot抓取百度贴吧和知乎首页

看看这个图片。

可以用金龟婿都可以自动采集

qqbbsbot爬虫

比较简单的方法是用bbsbot插件用bbsbotv4爬取

利用gecko技术,用autobotjavascript可以这样自动采集,

百度如何自动抓取豆瓣中电影评分?-搜索

如何利用bbsbot插件获取各大网站首页下载地址

利用bbsbot编程技术,用浏览器自带的搜索引擎抓取,就行了,爬到返回的网页包含一个html的page包含各网站链接,每个网站的iframe页面id都不一样,然后可以在用js获取用户的手机号这样可以统计用户的地理位置分析用户上网习惯。话说电脑上好多软件都不能获取用户手机号,比如qq,百度,微信。

自动抓取就不要想了,你只需要一个useragent,只要人肉就可以了。但是我觉得一般都是带抓baidu搜索带进去的网站链接。毕竟搜索引擎抓取需要个useragent。 查看全部

自动采集子系统(百度如何自动抓取豆瓣中电影评分?-搜索如何利用bbsbot插件获取各大网站首页下载地址)

自动采集子系统基本工作原理如下:

1、收集bbs信息,加入bbs爬虫库。

2、使用bbsbot插件,

3、根据rule、dom、postman-tget方法抓取子页面

子页面获取加bbsbot

bbsbot插件

我这边是用javascript很好解决的,首先用bbsbot插件抓取第二页源码。

百度搜:利用bbsbot插件打发恶意广告者利用bbsbot插件抓取不同网站域名内网页(有效抓取中)利用bbsbot插件批量抓取内容(上百款插件介绍)

如何使用bbsbot抓取百度贴吧和知乎首页

看看这个图片。

可以用金龟婿都可以自动采集

qqbbsbot爬虫

比较简单的方法是用bbsbot插件用bbsbotv4爬取

利用gecko技术,用autobotjavascript可以这样自动采集,

百度如何自动抓取豆瓣中电影评分?-搜索

如何利用bbsbot插件获取各大网站首页下载地址

利用bbsbot编程技术,用浏览器自带的搜索引擎抓取,就行了,爬到返回的网页包含一个html的page包含各网站链接,每个网站的iframe页面id都不一样,然后可以在用js获取用户的手机号这样可以统计用户的地理位置分析用户上网习惯。话说电脑上好多软件都不能获取用户手机号,比如qq,百度,微信。

自动抓取就不要想了,你只需要一个useragent,只要人肉就可以了。但是我觉得一般都是带抓baidu搜索带进去的网站链接。毕竟搜索引擎抓取需要个useragent。

自动采集子系统(中山公园数据采集子系统350案例分析案例结束完成)

采集交流 • 优采云 发表了文章 • 0 个评论 • 174 次浏览 • 2021-12-06 21:00

自动采集子系统简介xst350是一款通用化的采集子系统,可实现简单高效的在线市场采集。具体功能如下:使用地图导航识别品牌样式采集实时各地域的黑色买家订单和实时各地域的白色买家订单支持pc端和app(1个不到),实现多自动采集方便的自定义格式(udp.geojson.csv)多地域采集功能兼容qq地图和百度地图rqy-api.zip采集文件格式采集地址支持pc端和app(2个不到)功能很强大,但一开始人就多了,会很混乱。

当初是做一个5000个左右用户群的在线大数据分析系统的时候接触到的这个系统,觉得就是1个二维码,想想其实也是在当时看的一个免费的系统,后来后台开发量增加就停止了这个项目,接触到xst350觉得特别适合做大的社区数据分析系统,整体来说就是中山公园数据采集系统,个人觉得这个项目在中山的使用者本身还是很有含金量的。

采集效率比较高。现在市场上很多这种中小型分析系统,比如传祺汽车数据采集系统,马桶数据采集系统等,说实话如果我说这是中山本地的一个站点,以后每天监测都必须在市场上更新,大概你们都不会信,可是这就是市场嘛。xst350就是希望使用xst350系统的公司可以加进来,在品牌的市场特性加上必要的个性化的系统和资源投入就行。案例结束完成,谢谢大家。 查看全部

自动采集子系统(中山公园数据采集子系统350案例分析案例结束完成)

自动采集子系统简介xst350是一款通用化的采集子系统,可实现简单高效的在线市场采集。具体功能如下:使用地图导航识别品牌样式采集实时各地域的黑色买家订单和实时各地域的白色买家订单支持pc端和app(1个不到),实现多自动采集方便的自定义格式(udp.geojson.csv)多地域采集功能兼容qq地图和百度地图rqy-api.zip采集文件格式采集地址支持pc端和app(2个不到)功能很强大,但一开始人就多了,会很混乱。

当初是做一个5000个左右用户群的在线大数据分析系统的时候接触到的这个系统,觉得就是1个二维码,想想其实也是在当时看的一个免费的系统,后来后台开发量增加就停止了这个项目,接触到xst350觉得特别适合做大的社区数据分析系统,整体来说就是中山公园数据采集系统,个人觉得这个项目在中山的使用者本身还是很有含金量的。

采集效率比较高。现在市场上很多这种中小型分析系统,比如传祺汽车数据采集系统,马桶数据采集系统等,说实话如果我说这是中山本地的一个站点,以后每天监测都必须在市场上更新,大概你们都不会信,可是这就是市场嘛。xst350就是希望使用xst350系统的公司可以加进来,在品牌的市场特性加上必要的个性化的系统和资源投入就行。案例结束完成,谢谢大家。

自动采集子系统(影响自动采集子系统质量的因素有哪些?如何设计)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-12-01 02:03

自动采集子系统可在一定范围内提高工作效率,但是优秀的自动采集子系统可使系统更加地有效和可靠。设计者必须在没有多余负担的情况下,合理设计好这个系统。下面就从几个方面介绍影响采集子系统质量的因素,以及一般应该如何设计。

1)手动处理:是指由采集人员手动操作,完成从文件输入到文件输出的处理过程。

2)手动/集中管理:是指由采集人员将文件输入到每个子系统,然后由子系统去将文件输出给采集人员。

3)集中管理:是指使用自动采集子系统软件对子系统进行管理。2.自动采集子系统的缺点:采集速度慢(特别是处理规模过大,以及中转文件量较大的时候)采集容易丢失,速度慢。

3.影响采集子系统质量的因素:

1)采集系统自身的设计,

2)文件系统或者处理时间;

3)每一个子系统的功能设计;

4)设计方案本身的完善,

5)供应商的实力(包括投资能力和设计能力等);

6)采集软件技术的成熟度;

7)安全性。

自动采集子系统的实现方式主要有两种:

1)n种子系统部署,所有子系统采用共用同一个软件平台,

2)全署,所有子系统连接一个统一软件平台,采用统一的程序,不需要具备每个子系统的独立的文件数据库,全部子系统维护一套相同的数据库。 查看全部

自动采集子系统(影响自动采集子系统质量的因素有哪些?如何设计)

自动采集子系统可在一定范围内提高工作效率,但是优秀的自动采集子系统可使系统更加地有效和可靠。设计者必须在没有多余负担的情况下,合理设计好这个系统。下面就从几个方面介绍影响采集子系统质量的因素,以及一般应该如何设计。

1)手动处理:是指由采集人员手动操作,完成从文件输入到文件输出的处理过程。

2)手动/集中管理:是指由采集人员将文件输入到每个子系统,然后由子系统去将文件输出给采集人员。

3)集中管理:是指使用自动采集子系统软件对子系统进行管理。2.自动采集子系统的缺点:采集速度慢(特别是处理规模过大,以及中转文件量较大的时候)采集容易丢失,速度慢。

3.影响采集子系统质量的因素:

1)采集系统自身的设计,

2)文件系统或者处理时间;

3)每一个子系统的功能设计;

4)设计方案本身的完善,

5)供应商的实力(包括投资能力和设计能力等);

6)采集软件技术的成熟度;

7)安全性。

自动采集子系统的实现方式主要有两种:

1)n种子系统部署,所有子系统采用共用同一个软件平台,

2)全署,所有子系统连接一个统一软件平台,采用统一的程序,不需要具备每个子系统的独立的文件数据库,全部子系统维护一套相同的数据库。

自动采集子系统(科学技术是第一生产力,万维网(WorldWideWeb))

采集交流 • 优采云 发表了文章 • 0 个评论 • 155 次浏览 • 2021-11-28 14:29

随着互联网技术的飞速发展,互联网已经成为人们进行社会、经济、文化、教育、娱乐等活动不可缺少的媒介。互联网的重要组成部分之一,万维网(World WideWeb)承载着大量的数据和信息,包括各种类型和形式的信息,从科技信息、新闻报道,到商业信息、教育材料。动态异构分布式信息资源库。由于其使用的方便性和显示能力的多样性,通过WEB获取信息和知识已成为不可缺少的渠道。根据中国互联网络信息中心(CNNIC)发布的第31次中国互联网络发展统计报告,截至 2012 年 12 月末,中国网民规模达 64 亿,互联网普及率为 42.1%,网民每周平均花费 20.5 小时在互联网。中国网站的数量为268万,网页数量高达1227亿。每个网页的平均字节数为 42KB,而且这些数据还在不断增长。互联网飞速发展的好处是它所收录的信息非常丰富,但同时也给我们带来了更加严峻的挑战,即如何根据用户的兴趣从海量的WEB信息中高效获取信息是当前互联网应用面临一个难题。“科学技术是第一生产力”,“

<p>个人或企业的发展方式逐渐从传统转变为依靠科技。科学技术发展迅猛,科技信息日新月异。在当今互联网信息时代,人们获取科技信息的方式不再局限于传统的教室和书籍。相反,从互联网上获取科技信息已经成为一种更加方便快捷的方式[54][55]。将这么多科技信息的内容聚合起来,不仅难以保证内容的及时性,如果仅靠人工方式获取,还要耗费相当多的时间和精力。那么,更方便的方法是使用程序自动< @采集信息源的内容(例如科技信息源网站中的内容),最终将结果以个性化的方式展示在终端上。本文实施的科技信息自动跟踪管理系统是与北京市某单位合作的科技项目的一个子系统。本文的主要任务是研究开发一套科技信息自动跟踪管理系统。该技术项目的总体结构如图1-1所示。目前,市场上已经有一些专门的网页信息 查看全部

自动采集子系统(科学技术是第一生产力,万维网(WorldWideWeb))

随着互联网技术的飞速发展,互联网已经成为人们进行社会、经济、文化、教育、娱乐等活动不可缺少的媒介。互联网的重要组成部分之一,万维网(World WideWeb)承载着大量的数据和信息,包括各种类型和形式的信息,从科技信息、新闻报道,到商业信息、教育材料。动态异构分布式信息资源库。由于其使用的方便性和显示能力的多样性,通过WEB获取信息和知识已成为不可缺少的渠道。根据中国互联网络信息中心(CNNIC)发布的第31次中国互联网络发展统计报告,截至 2012 年 12 月末,中国网民规模达 64 亿,互联网普及率为 42.1%,网民每周平均花费 20.5 小时在互联网。中国网站的数量为268万,网页数量高达1227亿。每个网页的平均字节数为 42KB,而且这些数据还在不断增长。互联网飞速发展的好处是它所收录的信息非常丰富,但同时也给我们带来了更加严峻的挑战,即如何根据用户的兴趣从海量的WEB信息中高效获取信息是当前互联网应用面临一个难题。“科学技术是第一生产力”,“

<p>个人或企业的发展方式逐渐从传统转变为依靠科技。科学技术发展迅猛,科技信息日新月异。在当今互联网信息时代,人们获取科技信息的方式不再局限于传统的教室和书籍。相反,从互联网上获取科技信息已经成为一种更加方便快捷的方式[54][55]。将这么多科技信息的内容聚合起来,不仅难以保证内容的及时性,如果仅靠人工方式获取,还要耗费相当多的时间和精力。那么,更方便的方法是使用程序自动< @采集信息源的内容(例如科技信息源网站中的内容),最终将结果以个性化的方式展示在终端上。本文实施的科技信息自动跟踪管理系统是与北京市某单位合作的科技项目的一个子系统。本文的主要任务是研究开发一套科技信息自动跟踪管理系统。该技术项目的总体结构如图1-1所示。目前,市场上已经有一些专门的网页信息

自动采集子系统(自动采集子系统爬虫框架的知识,并整理成这篇教程)

采集交流 • 优采云 发表了文章 • 0 个评论 • 180 次浏览 • 2021-11-28 12:05

自动采集子系统初学爬虫时,自动采集子系统让我们的爬虫速度又快又稳。此外,自动采集子系统还可以配合三级域名,提升识别爬虫的效率。但是发现有些同学并不知道自动采集子系统,就更加糟糕。所以给大家带来这个教程,详细讲解自动采集子系统。然后整理了爬虫框架的知识,并整理成这篇教程。知乎上搜索子系统很快就会出现很多文章,在这里不会提到太多,有兴趣的同学可以去看一下。

本教程也仅仅针对正在学习爬虫的同学,另外自动采集子系统的基础入门教程会放在公众号里,需要的朋友可以去公众号里关注。

一、爬虫框架推荐目前基于react+redux+webpack+vue的爬虫框架在各大网站中广泛使用,比如:netflix、今日头条、搜狐、腾讯、中国网、凤凰网、ask等等网站。react:你可以是一个开发者,也可以是一个高级工程师。快速实现一个完整的api和ui:构建一个快速开发的web应用。redux:如果你正在做前端,又或者正在学后端,你一定不能错过这个优秀的框架。webpack:代码复用利器。vue:你可以开发一个简单的前端应用。

二、爬虫框架的演变史vue自2016年发布以来就受到了热捧,到目前为止已经使用2年多。早期api有点慢,而且是一个单项bff处理api模式,api的延迟比较严重。而最近两年使用element-ui一个纯csshybrid构建前端app。将csshybrid前端app运用到小程序中,进行本地调试测试。

vue2.0版本新增了vuex,以及可以让它动态配置状态保存与共享的api。同时整合uni-map,cli以及confirmed-modelcodetransfer接口和exportcodeset进行webpack(js)打包。vue-router内置模块列表页分页history。模块路由从单页面做起,统一业务模块。

自动化测试也有vue-test。无法测试的模块vuex进行保存,构建单文件的eslint依赖。vue的整合需要整合基础的template模块中的transformredux和event进行监听,建立代码依赖的局部状态共享。你可以单独使用vue-router和bundle,也可以和其他reactnative构建工具整合。

微信小程序mpvue.js开发小程序的配置,有一个服务框架可以作为小程序的代理,称为vue代理服务。一个代理服务需要处理和app的全局dom的操作。很少有场景有这个需求,只有真需求的时候才会用到。reactnative整合,同样也是因为有整合的需求,而不是所有场景下都能使用,大多数场景小程序不会用到。

三、代理服务怎么解决reactelement-vue整合了react与vuex,它的路由依赖的都是自己的数据。使用起来会有很多不便。 查看全部

自动采集子系统(自动采集子系统爬虫框架的知识,并整理成这篇教程)

自动采集子系统初学爬虫时,自动采集子系统让我们的爬虫速度又快又稳。此外,自动采集子系统还可以配合三级域名,提升识别爬虫的效率。但是发现有些同学并不知道自动采集子系统,就更加糟糕。所以给大家带来这个教程,详细讲解自动采集子系统。然后整理了爬虫框架的知识,并整理成这篇教程。知乎上搜索子系统很快就会出现很多文章,在这里不会提到太多,有兴趣的同学可以去看一下。

本教程也仅仅针对正在学习爬虫的同学,另外自动采集子系统的基础入门教程会放在公众号里,需要的朋友可以去公众号里关注。

一、爬虫框架推荐目前基于react+redux+webpack+vue的爬虫框架在各大网站中广泛使用,比如:netflix、今日头条、搜狐、腾讯、中国网、凤凰网、ask等等网站。react:你可以是一个开发者,也可以是一个高级工程师。快速实现一个完整的api和ui:构建一个快速开发的web应用。redux:如果你正在做前端,又或者正在学后端,你一定不能错过这个优秀的框架。webpack:代码复用利器。vue:你可以开发一个简单的前端应用。

二、爬虫框架的演变史vue自2016年发布以来就受到了热捧,到目前为止已经使用2年多。早期api有点慢,而且是一个单项bff处理api模式,api的延迟比较严重。而最近两年使用element-ui一个纯csshybrid构建前端app。将csshybrid前端app运用到小程序中,进行本地调试测试。

vue2.0版本新增了vuex,以及可以让它动态配置状态保存与共享的api。同时整合uni-map,cli以及confirmed-modelcodetransfer接口和exportcodeset进行webpack(js)打包。vue-router内置模块列表页分页history。模块路由从单页面做起,统一业务模块。

自动化测试也有vue-test。无法测试的模块vuex进行保存,构建单文件的eslint依赖。vue的整合需要整合基础的template模块中的transformredux和event进行监听,建立代码依赖的局部状态共享。你可以单独使用vue-router和bundle,也可以和其他reactnative构建工具整合。

微信小程序mpvue.js开发小程序的配置,有一个服务框架可以作为小程序的代理,称为vue代理服务。一个代理服务需要处理和app的全局dom的操作。很少有场景有这个需求,只有真需求的时候才会用到。reactnative整合,同样也是因为有整合的需求,而不是所有场景下都能使用,大多数场景小程序不会用到。

三、代理服务怎么解决reactelement-vue整合了react与vuex,它的路由依赖的都是自己的数据。使用起来会有很多不便。

自动采集子系统(自动采集子系统的应用场景分析与操作建议!!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-11-25 10:10

自动采集子系统自动采集子系统是一个集成的采集框架,将请求处理、数据分析、数据交互,并进行采集。通过对http请求的有效解析,经过一些优化,可以将所有请求转化为http请求。使得自动化的采集不再是一个遥远的梦。自动采集子系统一般由:采集系统、进程系统、子系统组成。采集系统通过根据系统配置进行http请求的请求定制,根据接受请求过程对采集请求进行转化,然后对收到的请求进行分析处理,最后将采集的数据导出到excel表格。

子系统简介进程系统是整个采集环节中的核心系统,负责采集系统的启动、保存数据,对采集系统进行维护、配置和日常维护。子系统简介进程子系统主要是进程子系统,即process子系统。本文会主要介绍,进程子系统的几个不同功能模块的实现方式和应用场景。让我们来看一个来自swr的应用场景:进程采集-数据可视化完整原理如下:首先,采集子系统会对fasthttp请求进行可视化处理,确保采集子系统中所有请求对应一套数据。

处理后的采集请求对应一个数据库中,该数据库中保存了待采集的数据,包括参数、约束列表,并根据约束列表生成一套确定性,有序执行的代码方案。在该数据库数据库已经有参数约束列表,并已经确定性的情况下,子系统可以根据规则判断参数的值并且根据请求参数自动生成相应的代码方案。代码执行方案在对数据库中已经建立的数据库表建立关联关系时进行自动切换。

在部署网站后,进程主要做以下工作:进程启动初始化进程内部监控进程接受所有请求并统计前端请求数,并保存按请求类型统计数据,并保存页面接受到的http数据,并保存缓存页面配置setp监控子系统本地sql+cookie记录请求参数与响应值响应收到的第一次数据请求此时对于第一个请求可以直接进行记录,并且根据参数的值查询请求的真实response,对于错误,可以根据其发生在何时发生,配置保留http响应的日志。

同时子系统会将响应的response再次发送到服务器存储。再来一个:admin登录使用的web服务器登录:然后进行配置admin这台服务器会记录所有登录的用户信息。admin有自己的memory通道,同时会使用remote:~/.账号和密码对用户进行权限限制。同时一个用户同时只有一个memory通道。

也就是说一个admin的账号和密码可以登录3个子系统。也就是每个子系统有4个memory通道。可以通过username:@${name}和password:@${password}来限制每个用户的权限,通过grantallprivilegesaccesstooneadmin就是在admin的memory通道申请新的通道,但是不能再利用这个m。 查看全部

自动采集子系统(自动采集子系统的应用场景分析与操作建议!!)

自动采集子系统自动采集子系统是一个集成的采集框架,将请求处理、数据分析、数据交互,并进行采集。通过对http请求的有效解析,经过一些优化,可以将所有请求转化为http请求。使得自动化的采集不再是一个遥远的梦。自动采集子系统一般由:采集系统、进程系统、子系统组成。采集系统通过根据系统配置进行http请求的请求定制,根据接受请求过程对采集请求进行转化,然后对收到的请求进行分析处理,最后将采集的数据导出到excel表格。

子系统简介进程系统是整个采集环节中的核心系统,负责采集系统的启动、保存数据,对采集系统进行维护、配置和日常维护。子系统简介进程子系统主要是进程子系统,即process子系统。本文会主要介绍,进程子系统的几个不同功能模块的实现方式和应用场景。让我们来看一个来自swr的应用场景:进程采集-数据可视化完整原理如下:首先,采集子系统会对fasthttp请求进行可视化处理,确保采集子系统中所有请求对应一套数据。

处理后的采集请求对应一个数据库中,该数据库中保存了待采集的数据,包括参数、约束列表,并根据约束列表生成一套确定性,有序执行的代码方案。在该数据库数据库已经有参数约束列表,并已经确定性的情况下,子系统可以根据规则判断参数的值并且根据请求参数自动生成相应的代码方案。代码执行方案在对数据库中已经建立的数据库表建立关联关系时进行自动切换。

在部署网站后,进程主要做以下工作:进程启动初始化进程内部监控进程接受所有请求并统计前端请求数,并保存按请求类型统计数据,并保存页面接受到的http数据,并保存缓存页面配置setp监控子系统本地sql+cookie记录请求参数与响应值响应收到的第一次数据请求此时对于第一个请求可以直接进行记录,并且根据参数的值查询请求的真实response,对于错误,可以根据其发生在何时发生,配置保留http响应的日志。

同时子系统会将响应的response再次发送到服务器存储。再来一个:admin登录使用的web服务器登录:然后进行配置admin这台服务器会记录所有登录的用户信息。admin有自己的memory通道,同时会使用remote:~/.账号和密码对用户进行权限限制。同时一个用户同时只有一个memory通道。

也就是说一个admin的账号和密码可以登录3个子系统。也就是每个子系统有4个memory通道。可以通过username:@${name}和password:@${password}来限制每个用户的权限,通过grantallprivilegesaccesstooneadmin就是在admin的memory通道申请新的通道,但是不能再利用这个m。

自动采集子系统(自动采集子系统到底是什么可以看看我以前的回答)

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-11-19 10:01

自动采集子系统一般用rs电子监控自动化管理。并不能提高工作效率,因为是不受人手工控制的,系统是自动识别问题,再根据运行管理逻辑判断分析,找出问题并解决问题,另外用这个子系统就相当于还用人力做,你觉得效率上有提高么?如果人工不受限制,最终也一样,系统自动识别子系统控制方式是不可能解决全部问题的。

实际上还是是一个系统化管理控制的过程,不可能把全部现象都变成人力可控的。另外系统自动是无法保证精确性的,自动系统并不能识别出人能控制的部分。个人拙见。

子系统到底是什么可以看看我以前的回答子系统是将传统的工厂真实子系统与现代管理系统等效整合,能够更高效地管理和使用现代管理系统,是现代管理发展的要求,并能完全替代人工作用系统。但是,子系统必须符合一定的要求,比如,拥有统一的物理地址与操作,即发现子系统或子系统间能被自动识别并同步工作、持续工作,还必须拥有独立且可靠的安全可靠性、不间断的可靠性、可靠性或安全性,以达到既省时、省力、省人、又安全、高效的目的。

具有这些要求,一套相对完善的自动化子系统才具有可行性。当前各个厂家或企业,不断提高了其智能制造的水平,与许多相关行业相关部门有了更多的联系,大部分部门都有智能工厂,其中企业也为满足智能工厂而研发了各类智能子系统,这就促使越来越多的制造企业,在满足自身产品的时候,思考如何让制造更加智能化。比如,部分产品要求从源头具有预测功能,如需使用异常检测系统,部分工业互联网平台等,那么安全可靠性就是其中一个方面的标准。

其实有些制造企业可能也想过,让物流全部自动化,但是人员就不需要了,但是这样能做到吗,答案是否定的,这个时候安全可靠性就显得特别重要,也就是通过物联网或者智能感知系统,实现人员全方位认证,监管、跟踪、能够让物流全部智能化,但是,人员还需要在制造企业中,发挥安全的作用,需要为整个生产部门或是产品安全把关,使用比传统的方法要更安全可靠,才可以保证企业生产的高质量。 查看全部

自动采集子系统(自动采集子系统到底是什么可以看看我以前的回答)

自动采集子系统一般用rs电子监控自动化管理。并不能提高工作效率,因为是不受人手工控制的,系统是自动识别问题,再根据运行管理逻辑判断分析,找出问题并解决问题,另外用这个子系统就相当于还用人力做,你觉得效率上有提高么?如果人工不受限制,最终也一样,系统自动识别子系统控制方式是不可能解决全部问题的。

实际上还是是一个系统化管理控制的过程,不可能把全部现象都变成人力可控的。另外系统自动是无法保证精确性的,自动系统并不能识别出人能控制的部分。个人拙见。

子系统到底是什么可以看看我以前的回答子系统是将传统的工厂真实子系统与现代管理系统等效整合,能够更高效地管理和使用现代管理系统,是现代管理发展的要求,并能完全替代人工作用系统。但是,子系统必须符合一定的要求,比如,拥有统一的物理地址与操作,即发现子系统或子系统间能被自动识别并同步工作、持续工作,还必须拥有独立且可靠的安全可靠性、不间断的可靠性、可靠性或安全性,以达到既省时、省力、省人、又安全、高效的目的。

具有这些要求,一套相对完善的自动化子系统才具有可行性。当前各个厂家或企业,不断提高了其智能制造的水平,与许多相关行业相关部门有了更多的联系,大部分部门都有智能工厂,其中企业也为满足智能工厂而研发了各类智能子系统,这就促使越来越多的制造企业,在满足自身产品的时候,思考如何让制造更加智能化。比如,部分产品要求从源头具有预测功能,如需使用异常检测系统,部分工业互联网平台等,那么安全可靠性就是其中一个方面的标准。

其实有些制造企业可能也想过,让物流全部自动化,但是人员就不需要了,但是这样能做到吗,答案是否定的,这个时候安全可靠性就显得特别重要,也就是通过物联网或者智能感知系统,实现人员全方位认证,监管、跟踪、能够让物流全部智能化,但是,人员还需要在制造企业中,发挥安全的作用,需要为整个生产部门或是产品安全把关,使用比传统的方法要更安全可靠,才可以保证企业生产的高质量。

自动采集子系统(自动采集子系统开发,如何入门大数据有没有入门的课程?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-11-18 17:07

自动采集子系统开发,需要了解系统的架构,接口设计,也需要在硬件的集成设计上有一定的经验。另外要熟悉计算机开发,尤其是常用的一些开发语言和工具,以及数据库及sql相关的调试和优化等等。具体的架构方案可以google。

我正打算把大数据开发用python学出来给python做服务器端,如果楼主想加入这个行业。

要学好大数据,首先要从java学起,因为其它大数据框架都是基于java的。学习大数据需要懂java,首先学习java的servlet和jsp,然后了解常用的hadoop框架,如hive,hbase,pig等等,接着学习scala或者kotlin,当然也要学习linux等等。java作为大数据编程语言,需要配合linux使用,推荐先看一下这个:会计转行从事it,如何在一年时间内全职学习?-nightsilent的回答。至于视频教程的话,从网上找就可以,关键要看能否学会,能学会的话,公司都抢着要。知乎专栏。

对于初学大数据新手,我想知道初学大数据有哪些必备知识?什么是大数据有没有入门的大数据课程?我想要入门大数据,该如何入门?我该如何选择大数据书籍进行学习?我该如何选择大数据培训机构进行学习呢?我该怎么正确地学习才能掌握大数据技术?大数据学习技巧:如何入门大数据有没有入门的大数据课程?目前大数据课程正在如火如荼的崛起,拥有十余年的大数据技术沉淀,精品大数据课程在150节左右。

下面是对于你已经成功入门大数据后的课程安排:课程内容:数据分析、机器学习、数据可视化、hadoop生态、hive、pig、spark、hbase、kafka、storm、scala、yarn、sqoop、flink、phoenix、sparkstreaming、hivesql、impala、kylin等。

当前大数据已经成为人工智能、物联网等未来趋势,请参考:人工智能时代来临了!学习大数据有前途吗?我该如何入门大数据呢?对于学习大数据来说,有必要加强java基础知识,下面是对于你已经学习完大数据进行进阶学习大数据时应该注意的一些问题:首先要学会运用java语言,了解java内存模型、java虚拟机原理、java线程、java并发原理。

java体系分析:java编程入门、javaweb技术、java单元测试、java集合类、java多线程、java网络编程、java阻塞队列、javasocket编程、javaio流、stream流、正则表达式、正则表达式java自动装箱和反装箱、java多线程、http和ftp服务器、服务器tomcat、服务器负载均衡、zookeeper、java进阶:高并发及分布式、分布式缓存、分布式消息队列、分布式队列集群等。下面分享一个关于大数据相关的学。 查看全部

自动采集子系统(自动采集子系统开发,如何入门大数据有没有入门的课程?)

自动采集子系统开发,需要了解系统的架构,接口设计,也需要在硬件的集成设计上有一定的经验。另外要熟悉计算机开发,尤其是常用的一些开发语言和工具,以及数据库及sql相关的调试和优化等等。具体的架构方案可以google。

我正打算把大数据开发用python学出来给python做服务器端,如果楼主想加入这个行业。

要学好大数据,首先要从java学起,因为其它大数据框架都是基于java的。学习大数据需要懂java,首先学习java的servlet和jsp,然后了解常用的hadoop框架,如hive,hbase,pig等等,接着学习scala或者kotlin,当然也要学习linux等等。java作为大数据编程语言,需要配合linux使用,推荐先看一下这个:会计转行从事it,如何在一年时间内全职学习?-nightsilent的回答。至于视频教程的话,从网上找就可以,关键要看能否学会,能学会的话,公司都抢着要。知乎专栏。

对于初学大数据新手,我想知道初学大数据有哪些必备知识?什么是大数据有没有入门的大数据课程?我想要入门大数据,该如何入门?我该如何选择大数据书籍进行学习?我该如何选择大数据培训机构进行学习呢?我该怎么正确地学习才能掌握大数据技术?大数据学习技巧:如何入门大数据有没有入门的大数据课程?目前大数据课程正在如火如荼的崛起,拥有十余年的大数据技术沉淀,精品大数据课程在150节左右。

下面是对于你已经成功入门大数据后的课程安排:课程内容:数据分析、机器学习、数据可视化、hadoop生态、hive、pig、spark、hbase、kafka、storm、scala、yarn、sqoop、flink、phoenix、sparkstreaming、hivesql、impala、kylin等。

当前大数据已经成为人工智能、物联网等未来趋势,请参考:人工智能时代来临了!学习大数据有前途吗?我该如何入门大数据呢?对于学习大数据来说,有必要加强java基础知识,下面是对于你已经学习完大数据进行进阶学习大数据时应该注意的一些问题:首先要学会运用java语言,了解java内存模型、java虚拟机原理、java线程、java并发原理。

java体系分析:java编程入门、javaweb技术、java单元测试、java集合类、java多线程、java网络编程、java阻塞队列、javasocket编程、javaio流、stream流、正则表达式、正则表达式java自动装箱和反装箱、java多线程、http和ftp服务器、服务器tomcat、服务器负载均衡、zookeeper、java进阶:高并发及分布式、分布式缓存、分布式消息队列、分布式队列集群等。下面分享一个关于大数据相关的学。

自动采集子系统(谁上线个啥子的网页采集功能?自动采集子系统)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-11-17 15:03

自动采集子系统是通过软件的启动和运行,将互联网上的海量网页进行自动抓取,并保存到本地。并且支持标准的http协议自动化采集方式。自动化采集后台管理后台列表功能1采集数据筛选查询模块有哪些2采集速度2.1自动采集速度2.2高级自动采集模式2.3高级分词模式2.4分词结果列表2.5自动词库列表2.6标准字段列表2.7查找系统对齐与上下文菜单2.8所有自动字段2.9自动删除2.10标准参数2.11标准分段2.12自动选取xml2.13自动字段名3对新文章的预测浏览4分页5对规则的使用6样式列表7其他链接的分析8关键词自动抓取9搜索功能10文章关键词抓取11页数抓取12超链接自动抓取13新词自动抓取14字数抓取15子分类自动抓取16新站联动抓取17根据样式自动抓取18自动关键词计算19自动页码抓取20新地址抓取21自动过滤文章重复页面22新布页抓取23样式自动抓取24新文章抓取页码。

谁上线个啥子的网页采集功能,现在也很难找到人,想要找个靠谱的合作。

目前市面上还没有这种,楼主要提供下。

.git下clonegit-pipeline-extension.git编译好后进行gitbash下的编译安装pipinstall-u':pipeline.git'pipinstalldlib编译的过程中需要把java环境变量加上,源码一般都会在.java目录下,需要加相关路径。1、自动采集1.1基础chrome登录之后搜索关键词,选择自动抓取10个页面,用中间等待5分钟;1.2自动采集1.3自动查询切换页面并设置抓取的顺序1.4模式自动采集在创建页面的时候将index.php页面读入并替换为相应的url;1.5封装抓取功能需要编写相应的方法;1.6自动分词抓取内容以词语分析当前页面的所有字符url;1.7设置问题自动分析包括问题等待回答等操作;2采集速度2.1seleniumpython模块的编写方法:2.2采集页面间隔使用分页的情况下,可以使用"时间窗口"的方法:分析此页面是否有一些特定的条件,例如:一个条件下有几个结果,每个结果页面被展示多少次等等。

2.3定时抓取2.4断点抓取直接模拟用户在网站端的行为,比如:提交表单、登录等:网站提供了断点抓取功能,如果系统反应快,则可以抓取完整的数据;如果系统反应慢,只抓取一个结果,则可以打断点分析并修改后,再重新再抓取整个页面。2.5获取url并编写python代码3分词速度3.1自动分词由于本人用的是selenium,因此把自动采集和分词都写在selenium的python方法中。 查看全部

自动采集子系统(谁上线个啥子的网页采集功能?自动采集子系统)

自动采集子系统是通过软件的启动和运行,将互联网上的海量网页进行自动抓取,并保存到本地。并且支持标准的http协议自动化采集方式。自动化采集后台管理后台列表功能1采集数据筛选查询模块有哪些2采集速度2.1自动采集速度2.2高级自动采集模式2.3高级分词模式2.4分词结果列表2.5自动词库列表2.6标准字段列表2.7查找系统对齐与上下文菜单2.8所有自动字段2.9自动删除2.10标准参数2.11标准分段2.12自动选取xml2.13自动字段名3对新文章的预测浏览4分页5对规则的使用6样式列表7其他链接的分析8关键词自动抓取9搜索功能10文章关键词抓取11页数抓取12超链接自动抓取13新词自动抓取14字数抓取15子分类自动抓取16新站联动抓取17根据样式自动抓取18自动关键词计算19自动页码抓取20新地址抓取21自动过滤文章重复页面22新布页抓取23样式自动抓取24新文章抓取页码。

谁上线个啥子的网页采集功能,现在也很难找到人,想要找个靠谱的合作。

目前市面上还没有这种,楼主要提供下。

.git下clonegit-pipeline-extension.git编译好后进行gitbash下的编译安装pipinstall-u':pipeline.git'pipinstalldlib编译的过程中需要把java环境变量加上,源码一般都会在.java目录下,需要加相关路径。1、自动采集1.1基础chrome登录之后搜索关键词,选择自动抓取10个页面,用中间等待5分钟;1.2自动采集1.3自动查询切换页面并设置抓取的顺序1.4模式自动采集在创建页面的时候将index.php页面读入并替换为相应的url;1.5封装抓取功能需要编写相应的方法;1.6自动分词抓取内容以词语分析当前页面的所有字符url;1.7设置问题自动分析包括问题等待回答等操作;2采集速度2.1seleniumpython模块的编写方法:2.2采集页面间隔使用分页的情况下,可以使用"时间窗口"的方法:分析此页面是否有一些特定的条件,例如:一个条件下有几个结果,每个结果页面被展示多少次等等。

2.3定时抓取2.4断点抓取直接模拟用户在网站端的行为,比如:提交表单、登录等:网站提供了断点抓取功能,如果系统反应快,则可以抓取完整的数据;如果系统反应慢,只抓取一个结果,则可以打断点分析并修改后,再重新再抓取整个页面。2.5获取url并编写python代码3分词速度3.1自动分词由于本人用的是selenium,因此把自动采集和分词都写在selenium的python方法中。

自动采集子系统(自动采集子系统的功能比较强大,新手小白必看!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-11-15 18:03

自动采集子系统,简称edius。首先我们要清楚一点,我们的业务需要什么样的各种数据,我们就要想办法去采集,使用什么方法采集,采集之后,就要对其进行编辑,利用edius里面的premierepro来做好剪辑以及后期。或者手动去编辑,相信不少新手小白也不太明白这个事情。edius在采集数据方面的功能,操作的手段,可以说是除了傻瓜机器有之外,其他其他的工具所不能比拟的。

接下来我们说一下edius的采集功能吧。我们可以将子系统采集到的内容,并不是简单的文字,而是各种图片,音频等等。这个功能就像是我们打开一个电脑游戏直播平台,各种主播不是在开车玩游戏,就是在聊天互动讨论问题的。所以,edius采集子系统里面这个功能也就很正常了。我们只要点击一下load&premierepro里面的editor,并把脚本挂上去就可以了。

edius采集子系统作为一个电子商务的子系统,采集数据的功能比较强大,具体如下:1.ediuspro做的是远程仓库,每次一个订单,上传数据2.edius内置的基础视频编辑器里面已经集成了很多功能,包括:文字字幕,音频音效,视频音频转换成视频,logo,logo合成,图片拼接,面积合成等。3.ediuspro有录屏功能,不仅可以在各个平台进行实时编辑,还可以进行实时直播,在edius里面录制下来,自己录制自己看。

4.edius内置了一个基础的视频转换器,可以生成一个独立的视频。5.edius子系统,模块完整,不只是可以对一个订单流程,一段音频或视频。只要通过子系统文件、视频、音频或者图片编辑器批量导入。都可以做出各种效果来。 查看全部

自动采集子系统(自动采集子系统的功能比较强大,新手小白必看!)

自动采集子系统,简称edius。首先我们要清楚一点,我们的业务需要什么样的各种数据,我们就要想办法去采集,使用什么方法采集,采集之后,就要对其进行编辑,利用edius里面的premierepro来做好剪辑以及后期。或者手动去编辑,相信不少新手小白也不太明白这个事情。edius在采集数据方面的功能,操作的手段,可以说是除了傻瓜机器有之外,其他其他的工具所不能比拟的。

接下来我们说一下edius的采集功能吧。我们可以将子系统采集到的内容,并不是简单的文字,而是各种图片,音频等等。这个功能就像是我们打开一个电脑游戏直播平台,各种主播不是在开车玩游戏,就是在聊天互动讨论问题的。所以,edius采集子系统里面这个功能也就很正常了。我们只要点击一下load&premierepro里面的editor,并把脚本挂上去就可以了。

edius采集子系统作为一个电子商务的子系统,采集数据的功能比较强大,具体如下:1.ediuspro做的是远程仓库,每次一个订单,上传数据2.edius内置的基础视频编辑器里面已经集成了很多功能,包括:文字字幕,音频音效,视频音频转换成视频,logo,logo合成,图片拼接,面积合成等。3.ediuspro有录屏功能,不仅可以在各个平台进行实时编辑,还可以进行实时直播,在edius里面录制下来,自己录制自己看。

4.edius内置了一个基础的视频转换器,可以生成一个独立的视频。5.edius子系统,模块完整,不只是可以对一个订单流程,一段音频或视频。只要通过子系统文件、视频、音频或者图片编辑器批量导入。都可以做出各种效果来。

自动采集子系统(易海聚智库平台产品致力于为科研方向的用户提供完整的全球网络信息搜集和智能分析平台)

采集交流 • 优采云 发表了文章 • 0 个评论 • 156 次浏览 • 2021-11-05 07:26

亿海居智库平台产品致力于为科研用户提供一整套全球网络信息采集和智能分析平台解决方案,逻辑上划分,包括采集层、存储层、分析层、展示层有4个逻辑功能实现层。

易海居智库平台可灵活部署在云服务和本地服务器上,可分布式采集和存储。系统可专业响应行业顶级网站、顶级公司、指定库。、数据库、政府单位政策法规等专业准确性采集;还可以自动采集各类网络信息,包括新闻、电子新闻、论坛、博客、文档、企业官网、政府网站、多媒体网站、配件、产品网站等通过精准的采集再分析自动分类、自动翻译、智能聚类、智能标签提取、自动上报等信息,用户可以设置关注源,也可以标记、编辑和选择信息。最终,它可以连接到其他平台或存储在数据库中作为行业知识库长期存储。系统还有非常完善的后台管理功能,可以在大屏幕上显示系统的所有动态,控制和操作各个子系统权限、用户权限、网站采集设置、词库设置、等等。

易海居智库平台的功能实现追求标准化、开放性、完备性、健壮性、灵活性、可监控性、安全性、可操作性和可维护性的要求,也遵循松耦合、模块化、可重用、可配置的原则,保持可扩展性,为客户提供可衡量的标准服务。 查看全部

自动采集子系统(易海聚智库平台产品致力于为科研方向的用户提供完整的全球网络信息搜集和智能分析平台)

亿海居智库平台产品致力于为科研用户提供一整套全球网络信息采集和智能分析平台解决方案,逻辑上划分,包括采集层、存储层、分析层、展示层有4个逻辑功能实现层。

易海居智库平台可灵活部署在云服务和本地服务器上,可分布式采集和存储。系统可专业响应行业顶级网站、顶级公司、指定库。、数据库、政府单位政策法规等专业准确性采集;还可以自动采集各类网络信息,包括新闻、电子新闻、论坛、博客、文档、企业官网、政府网站、多媒体网站、配件、产品网站等通过精准的采集再分析自动分类、自动翻译、智能聚类、智能标签提取、自动上报等信息,用户可以设置关注源,也可以标记、编辑和选择信息。最终,它可以连接到其他平台或存储在数据库中作为行业知识库长期存储。系统还有非常完善的后台管理功能,可以在大屏幕上显示系统的所有动态,控制和操作各个子系统权限、用户权限、网站采集设置、词库设置、等等。

易海居智库平台的功能实现追求标准化、开放性、完备性、健壮性、灵活性、可监控性、安全性、可操作性和可维护性的要求,也遵循松耦合、模块化、可重用、可配置的原则,保持可扩展性,为客户提供可衡量的标准服务。

自动采集子系统(如何使用优采云 采集器采集这种类型网页里面详细信息页面数据 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-12-25 21:07

采集器采集这种类型网页里面详细信息页面数据

)

很多网站都有这种模式,一个列表页面,点击列表中的一行链接会打开一个详细信息页面,本文教你如何使用优采云

采集

器来采集

这类网站的详细信息page 页的数据。

首先打开优采云

采集

器→点击快速启动→新建任务,进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图中的配置完成后,选择Next,进入流程配置页面,在流程设计器中拖动一步打开网页;

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

由于我们需要如上图在浏览器中点击电影名称,然后在子页面中提取数据信息,所以我们需要制作一个循环采集

列表。

点击上图中第一个循环项,在弹出的对话框中选择创建元素列表来处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个循环项后,选择继续编辑列表。

接下来,以相同的方式添加第二个循环项。

当我们添加第二个区域块时,我们可以查看上图。此时,页面上的其他元素已经添加。这是因为我们添加了两个具有相似特征的元素,系统会智能地在页面上添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集

列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

选择上图中第一个循环项,然后选择click元素。进入第一个子链接。

接下来,我们将提取数据字段。在浏览器中选择需要提取的字段,然后在弹出的选择对话框中选择抓取该元素的文本;

完成以上操作后,系统会在页面右上角显示我们要抓取的字段;

接下来在页面上配置其他需要抓取的字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集

列表;

点击上图中的下一步→下一步→开始单机采集(调试模式),进入任务检查页面,确保任务的正确性;

点击 开始单机采集,系统将在本地执行采集过程并显示最终采集结果;

如果我们需要导出最终采集的数据信息,点击下图中的导出按钮,选择需要导出的文件类型。系统会提示保存路径,选择保存路径,系统会自动导出文件。

查看全部

自动采集子系统(如何使用优采云

采集器采集这种类型网页里面详细信息页面数据

)

很多网站都有这种模式,一个列表页面,点击列表中的一行链接会打开一个详细信息页面,本文教你如何使用优采云

采集

器来采集

这类网站的详细信息page 页的数据。

首先打开优采云

采集

器→点击快速启动→新建任务,进入任务配置页面:

选择任务组,自定义任务名称和备注;

上图中的配置完成后,选择Next,进入流程配置页面,在流程设计器中拖动一步打开网页;

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

选择在浏览器中打开网页的步骤,在右侧的网页网址中输入网页网址并点击保存,系统会自动在软件下的浏览器中打开对应的网页:

由于我们需要如上图在浏览器中点击电影名称,然后在子页面中提取数据信息,所以我们需要制作一个循环采集

列表。

点击上图中第一个循环项,在弹出的对话框中选择创建元素列表来处理一组元素;

接下来,在弹出的对话框中,选择添加到列表

添加第一个循环项后,选择继续编辑列表。

接下来,以相同的方式添加第二个循环项。

当我们添加第二个区域块时,我们可以查看上图。此时,页面上的其他元素已经添加。这是因为我们添加了两个具有相似特征的元素,系统会智能地在页面上添加其他具有相似特征的元素。然后选择创建列表完成→点击下图中的循环

经过以上操作,循环采集

列表就完成了。系统会在页面右上角显示该页面添加的所有循环项。

选择上图中第一个循环项,然后选择click元素。进入第一个子链接。

接下来,我们将提取数据字段。在浏览器中选择需要提取的字段,然后在弹出的选择对话框中选择抓取该元素的文本;

完成以上操作后,系统会在页面右上角显示我们要抓取的字段;

接下来在页面上配置其他需要抓取的字段,配置完成后修改字段名称;

修改完成后,点击上图中的保存按钮,然后点击图中的数据字段,可以看到系统会显示最终的采集

列表;

点击上图中的下一步→下一步→开始单机采集(调试模式),进入任务检查页面,确保任务的正确性;

点击 开始单机采集,系统将在本地执行采集过程并显示最终采集结果;

如果我们需要导出最终采集的数据信息,点击下图中的导出按钮,选择需要导出的文件类型。系统会提示保存路径,选择保存路径,系统会自动导出文件。

自动采集子系统(分布式计算中常见的4大问题和分布式系统相关问题)

采集交流 • 优采云 发表了文章 • 0 个评论 • 186 次浏览 • 2021-12-24 20:08

自动采集子系统有3个核心:各模块相互之间配合才能完整的实现采集目的;不同子系统采集的数据量不一样;采集出来的数据经过整理分类,做了汇总和展示;有限几个服务器可以运行1000个各子系统;采集效率高可以2000次/秒左右的吞吐量;支持全网300万条记录的采集;一键即可采集到上万条上万条信息;可以把采集数据进行清洗,进行去重;支持热门关键词自动采集和seo抓取;高并发,强内存,各项技术指标符合要求;根据数据量采用了两套集群,io密集型高可用集群和存储密集型高可用集群,服务器数量没有限制;双副本组合,多台web机器同时对外提供数据接口;全新架构,无缝切换服务器和ip;主要知识点:。

1、分布式基础架构、hadoop

2、基于springboot、springcloud等开发基础技术;

3、分布式集群部署、springmvc,mybatis等框架的使用。

4、分布式安全技术;本文摘要简单介绍了分布式计算中存在的问题和分布式系统的相关问题;为大家分享本文内容,主要是分布式系统相关问题的分享;以供大家学习。

分布式计算中常见的4大问题(后续我们分享更多的内容)

1、网络io多。系统必须同时有很多台机器作为服务器,而其中数据存在cache中,所以就需要gossip的方式记录的数据以及所有的操作记录在服务器上,服务器需要做很多数据review,服务器数量成问题。

2、并发访问量高。很多系统因为采用soa架构,一台机器上会部署大量的客户端请求,同时也会采用db来存储数据,当数据量比较大,这样gossip方式记录的数据容易被dbmiss。

3、整个数据库中,有很多schema、package、sql表等数据。很多数据本身就是一个statement(日志)。数据采集接口如果对内存进行review,为了记录statement的内容,容易记录为垃圾。

4、elasticsearch各组件之间联接交互的问题。elasticsearch中集成了nosql的数据,业务本身不需要存入。但是大量的业务对表等数据进行查询,很容易发生相互穿透导致服务器断线重连。由于elasticsearch和关系型数据库关系松散,并发访问和存储带宽都是瓶颈。即使是elasticsearch中高级高可用集群一样出现类似问题。

5、数据库的schema、package、sql表三层解耦。业务系统的定义和要求各不相同,内存数据存在cache中,将内存中数据进行相关查询,很容易发生内存爆满,导致数据穿透导致服务器断线重连。

6、中间件的跨库,跨主机联调,读写分离,集群选型等问题。遇到这个问题后,通常需要花很多时间和精力来解决。更多内容,请持续关注, 查看全部

自动采集子系统(分布式计算中常见的4大问题和分布式系统相关问题)

自动采集子系统有3个核心:各模块相互之间配合才能完整的实现采集目的;不同子系统采集的数据量不一样;采集出来的数据经过整理分类,做了汇总和展示;有限几个服务器可以运行1000个各子系统;采集效率高可以2000次/秒左右的吞吐量;支持全网300万条记录的采集;一键即可采集到上万条上万条信息;可以把采集数据进行清洗,进行去重;支持热门关键词自动采集和seo抓取;高并发,强内存,各项技术指标符合要求;根据数据量采用了两套集群,io密集型高可用集群和存储密集型高可用集群,服务器数量没有限制;双副本组合,多台web机器同时对外提供数据接口;全新架构,无缝切换服务器和ip;主要知识点:。

1、分布式基础架构、hadoop

2、基于springboot、springcloud等开发基础技术;

3、分布式集群部署、springmvc,mybatis等框架的使用。

4、分布式安全技术;本文摘要简单介绍了分布式计算中存在的问题和分布式系统的相关问题;为大家分享本文内容,主要是分布式系统相关问题的分享;以供大家学习。

分布式计算中常见的4大问题(后续我们分享更多的内容)

1、网络io多。系统必须同时有很多台机器作为服务器,而其中数据存在cache中,所以就需要gossip的方式记录的数据以及所有的操作记录在服务器上,服务器需要做很多数据review,服务器数量成问题。

2、并发访问量高。很多系统因为采用soa架构,一台机器上会部署大量的客户端请求,同时也会采用db来存储数据,当数据量比较大,这样gossip方式记录的数据容易被dbmiss。

3、整个数据库中,有很多schema、package、sql表等数据。很多数据本身就是一个statement(日志)。数据采集接口如果对内存进行review,为了记录statement的内容,容易记录为垃圾。

4、elasticsearch各组件之间联接交互的问题。elasticsearch中集成了nosql的数据,业务本身不需要存入。但是大量的业务对表等数据进行查询,很容易发生相互穿透导致服务器断线重连。由于elasticsearch和关系型数据库关系松散,并发访问和存储带宽都是瓶颈。即使是elasticsearch中高级高可用集群一样出现类似问题。

5、数据库的schema、package、sql表三层解耦。业务系统的定义和要求各不相同,内存数据存在cache中,将内存中数据进行相关查询,很容易发生内存爆满,导致数据穿透导致服务器断线重连。

6、中间件的跨库,跨主机联调,读写分离,集群选型等问题。遇到这个问题后,通常需要花很多时间和精力来解决。更多内容,请持续关注,

自动采集子系统(扫描模式ChannelADC转换通道10SamplingTime配置)

采集交流 • 优采云 发表了文章 • 0 个评论 • 150 次浏览 • 2021-12-22 13:14

多维数据集配置。目前网上提到的多路DMA+TIM中断触发无法实现。 Simulink 生成的代码一直卡在 DMA 中断中,但是其他中断无法进入。原因还没找到。

取消DMA并使用ADC中断。多渠道还是有问题的。 Simulink产生的代码中断可以正常进入,但是ADC采集的值不对,找不到原因。

最后只能使用单通道,ADC中断,不连续采集,没有DMA,ADC1和ADC2同时使用就可以了,采集的值很好。本文采用这种方法。

如果有人成功实现了DMA+TIM中断触发的simulink代码生成,欢迎小弟指导~~~

也欢迎在做STM32自动代码生成童鞋的时候和我交流~~

QQ/微信:9535909472

CUBE配置:时钟树配置:(最高时钟只有12M)

ADC 配置:

Mode Independent mode ADC1和ADC2工作在独立模式(如果只有ADC1可用,则只能选择独立模式)

Data Alignment ADC 数据左对齐或右对齐(默认右对齐)

Scan Conversion Mode 禁用是否开启扫描模式(如果是多通道只能选择开启,单通道只能选择不开启)

Continuous Conversion Mode Disable是否开启连续转换(这里选择不开启,开启后其他中断不会进入)

Discontinuous Conversion Mode Disable 是否开启单次转换(单通道只能是Disable,多通道可以选择Enable)

ADCs_Regular_ConversionMode(常规通道转换模式)

启用定期转换 ENABLE 启用定期转换

Number of Conversion ADC 转换通道数 1(单通道只能选为1)

External Trigger Conversion Source 由软件软件触发转换(可以在TIM中选择中断触发,但Simulink中生成的代码有问题,中断和DMA最终无用)

Rank只能在2个频道以上时开启扫描模式

通道ADC转换通道10

Sampling Time ADC 采样周期 1.5cyces

ADC_Injected_ConversionMode(注入通道转换模式)暂时不使用。

WatchDog 暂时未使用。

转换时间 = 采样时间 + 12.5 个周期 = 14 个周期

从时钟树上看,ADC频率为12M,转换时间为14/12M = 1.17us

开启ADC中断:

ADC2的配置与ADC1相同,这里不再赘述。

没有使用DMA,所以这是CUBE的配置。本项目是在上一篇文章的基础上进行修改的。其他配置请参考上一篇文章。

Simulink 模型建立:

在模块库中找到ADC模块,我放在500ms时序和1s时序,一个ADC1,一个ADC2(配置同1)

这里的模块只负责读取ADC采样的值,采集和转换总是中断。

我这里配置的是通道ADC1-通道10

在CUBE中配置后,这里的中断是打开的,不能修改。 (关闭中断只能在cube中配置)

输入信号为12位精度ADC取值范围0-4095,电压范围0-3.3(本次使用的开发板adc采集电压只能达到3.3v,如果要测试5V,需要换硬件)

CHAR 转换模块收录在 ADC 演示中。如果找不到,可以参考我的项目。

ADC2与ADC1类似,只不过是放在1s定时器中断,然后转换模块加一个2来区分串口打印。

现在模型已构建,Ctrl+B 生成代码、打开项目、编译和下载。

测试结果:

其他中断也能正常触发,ADC采集也能正常采集电压。

ADC1采集通道接电源,采集电压3.24v,ADC2采集通道接地,采集电压0V

ADC2采集通道接电源,采集电压3.25v,ADC1采集通道接地,采集电压0V

附件

CUBE 项目、Simulink 模型和生成的代码项目 查看全部

自动采集子系统(扫描模式ChannelADC转换通道10SamplingTime配置)

多维数据集配置。目前网上提到的多路DMA+TIM中断触发无法实现。 Simulink 生成的代码一直卡在 DMA 中断中,但是其他中断无法进入。原因还没找到。

取消DMA并使用ADC中断。多渠道还是有问题的。 Simulink产生的代码中断可以正常进入,但是ADC采集的值不对,找不到原因。

最后只能使用单通道,ADC中断,不连续采集,没有DMA,ADC1和ADC2同时使用就可以了,采集的值很好。本文采用这种方法。

如果有人成功实现了DMA+TIM中断触发的simulink代码生成,欢迎小弟指导~~~

也欢迎在做STM32自动代码生成童鞋的时候和我交流~~

QQ/微信:9535909472

CUBE配置:时钟树配置:(最高时钟只有12M)

ADC 配置:

Mode Independent mode ADC1和ADC2工作在独立模式(如果只有ADC1可用,则只能选择独立模式)

Data Alignment ADC 数据左对齐或右对齐(默认右对齐)

Scan Conversion Mode 禁用是否开启扫描模式(如果是多通道只能选择开启,单通道只能选择不开启)

Continuous Conversion Mode Disable是否开启连续转换(这里选择不开启,开启后其他中断不会进入)

Discontinuous Conversion Mode Disable 是否开启单次转换(单通道只能是Disable,多通道可以选择Enable)

ADCs_Regular_ConversionMode(常规通道转换模式)

启用定期转换 ENABLE 启用定期转换

Number of Conversion ADC 转换通道数 1(单通道只能选为1)

External Trigger Conversion Source 由软件软件触发转换(可以在TIM中选择中断触发,但Simulink中生成的代码有问题,中断和DMA最终无用)

Rank只能在2个频道以上时开启扫描模式

通道ADC转换通道10

Sampling Time ADC 采样周期 1.5cyces

ADC_Injected_ConversionMode(注入通道转换模式)暂时不使用。

WatchDog 暂时未使用。

转换时间 = 采样时间 + 12.5 个周期 = 14 个周期

从时钟树上看,ADC频率为12M,转换时间为14/12M = 1.17us

开启ADC中断:

ADC2的配置与ADC1相同,这里不再赘述。

没有使用DMA,所以这是CUBE的配置。本项目是在上一篇文章的基础上进行修改的。其他配置请参考上一篇文章。

Simulink 模型建立:

在模块库中找到ADC模块,我放在500ms时序和1s时序,一个ADC1,一个ADC2(配置同1)

这里的模块只负责读取ADC采样的值,采集和转换总是中断。

我这里配置的是通道ADC1-通道10

在CUBE中配置后,这里的中断是打开的,不能修改。 (关闭中断只能在cube中配置)

输入信号为12位精度ADC取值范围0-4095,电压范围0-3.3(本次使用的开发板adc采集电压只能达到3.3v,如果要测试5V,需要换硬件)

CHAR 转换模块收录在 ADC 演示中。如果找不到,可以参考我的项目。

ADC2与ADC1类似,只不过是放在1s定时器中断,然后转换模块加一个2来区分串口打印。

现在模型已构建,Ctrl+B 生成代码、打开项目、编译和下载。

测试结果:

其他中断也能正常触发,ADC采集也能正常采集电压。

ADC1采集通道接电源,采集电压3.24v,ADC2采集通道接地,采集电压0V

ADC2采集通道接电源,采集电压3.25v,ADC1采集通道接地,采集电压0V

附件

CUBE 项目、Simulink 模型和生成的代码项目

自动采集子系统(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 196 次浏览 • 2021-12-22 13:13

海洋cms如何自动设置宝塔采集,因为很多人都在问这个问题,所以有这个教程。海洋cms虽然给出了脚本代码,但是对于海洋的新手cms来说,用户理解起来并不是那么容易。今天,我们将深入详述cms使用宝塔现实自动采集的具体步骤。

海洋cms如何设置宝塔自动采集 第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码,我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

海洋cms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为您一一讲述。(根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这个要修改成你的“网站域名”和“Oceancms后台管理目录”。域名大家都能看懂,后台管理目录新手需要多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要得到自己的采集链接地址并添加进去。获取链接地址的具体操作,请参见下文截图步骤操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-Oceancms如何添加资源库采集界面

选择“背景-采集-资源库列表”,复制资源站右侧的“采集今天”“采集本周”“采集全部”根据你选择的链接地址,去掉前面的内容。(将鼠标移到当天或本周的采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容 复制上一步,结果如下:

2

?ac=day&rid=1&url=

这将获得最终的 采集 URL

海洋cms如何自动设置宝塔采集第三步:宝塔定时任务设置。

[3] 将代码直接复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4]总结

一般情况下,修改脚本中需要修改的那几个项目后,将修改后的脚本复制到宝塔的定时任务采集下。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。 查看全部

自动采集子系统(海洋cms怎么设置宝塔自动采集:获取脚本代码。)

海洋cms如何自动设置宝塔采集,因为很多人都在问这个问题,所以有这个教程。海洋cms虽然给出了脚本代码,但是对于海洋的新手cms来说,用户理解起来并不是那么容易。今天,我们将深入详述cms使用宝塔现实自动采集的具体步骤。

海洋cms如何设置宝塔自动采集 第一步:获取脚本代码。

[1] 以下是Oceancms官网提供的自动采集脚本代码,我们需要修改代码中的3项才可以使用。

#!/bin/bash

########################################################

# 程序名称: 海洋CMS自动采集脚本

# 版本信息:seacmsbot/ v2.0

# 发布链接: https://www.seacms.net/post-update-92579.htm

# 使用方法:直接复制代码到宝塔计划任务shell脚本内容里添加每小时任务使用

# 更新时间:2019.9.26

##########################################################

# ①请修改下面的网站域名及管理目录

web_site = "http://网站域名/管理目录/admin_reslib2.php"

# ②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd = "8888e82e85bd4540f0defa3fb7a8e888"

# ③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

# 每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api = (

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

# 模拟用户浏览器ua,请勿随意修改,以免被目标防火墙拦截!

web_ua = "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko)

Chrome / 76.0

.3809

.100

Safari / 537.36

seacmsbot / 1.2;

"

# 采集单页

function

get_content()

{

echo

"正在采集第$page页..."

# echo " get_content: --->url:--->$1"

cResult =$(curl - -connect - timeout 10 -m 20 -k -s -L -A "$web_ua" "$1")

echo $cResult | grep - q

"采集"

# echo -e "$1\n$cResult"

if ["$?" = "0"]; then

next_content

"$cResult"

else

echo - e

"采集失败,请检查设置!\n失败链接-->$1\n返回信息-->$cResult\n采集结束,共0页"

fi

}

# 采集下页

function

next_content()

{

# 统计数据

Result =$(echo "$1" | tr "

" "\n")

a =$(echo "$Result" | grep -c "采集成功")

b =$(echo "$Result" | grep -c "更新数据")

c =$(echo "$Result" | grep -c "无需更新")

d =$(echo "$Result" | grep -c "跳过")

echo

"采集成功-->已更$c部,新增$a部,更新$b部,跳过$d部"

let

add +=$a

let

update +=$b

let

none +=$c

let

jmp +=$d

# 检测并采集下页

next_url =${1 ##*location.href=\'}

next_url =${next_url % %\'*}

# echo $next_url

if ["${next_url:0:1}" = "?"]

then

let

page + +

get_content

"$web_site$next_url"

else

echo

"采集结束,共$page页"

fi

}

# 脚本入口

echo

"海洋CMS自动采集脚本开始执行 版本:v1.2"

starttime =$(date +% s)

update = 0 # 更新

add = 0 # 新增

none = 0 # 无变化

jmp = 0 # 跳过

for url in ${web_api[@]};

do

if[[! -z $url]]

then

web_param="$web_site$url&password=$web_pwd"

page=1

echo "开始采集:$url"

get_content $web_param

fi

done

endtime=$(date + % s)

echo "============================"

echo "入库-->$add部"

echo "更新-->$update部"

echo "跳过-->$jmp部(未绑定分类或链接错误)"

echo "今日-->$[none+add+update]部"

echo "============================"

echo "全部采集结束,耗时$[endtime - starttime]秒"

海洋cms如何设置宝塔自动采集 第二步:修改脚本

[2] 脚本中的哪3项需要特别修改?让我为您一一讲述。(根据上面提供的代码内容,复制到记事本或者其他html编辑器进行相应修改)

#①请修改下面的网站域名及管理目录

web_site="http://网站域名/管理目录/admin_reslib2.php"

这个要修改成你的“网站域名”和“Oceancms后台管理目录”。域名大家都能看懂,后台管理目录新手需要多说几句。首先,您必须能够登录到您的后端以了解您的后端目录。比如:如果我的后台登录地址是,那么这里的文章就是后台管理目录,拿到管理目录的时候直接填写代码即可。

#②请修改下面项内容为"admin_reslib2.php"里设置的访问密码(默认为系统设置的cookie密码)

web_pwd="8888e82e85bd4540f0defa3fb7a8e888"

#③下面项内容为资源站每日采集链接地址列表,请自行修改,每行一条,可添加多个,前后需添加引号。

#每日采集链接获取方法:选择"后台-采集-资源库列表",复制资源站右边的"采集每天"的链接地址,去掉?前面的内容。

web_api=(

'?ac=day&rid=1&url=https://api.iokzy.com/inc/ldg_seackm3u8s.php'

'?ac=day&rid=2&url=http://www.zdziyuan.com/inc/s_ldgm3u8_sea.php'

)

这是代码中需要修改的最后一项。里面是代码中默认提供的两个采集链接地址。我们需要得到自己的采集链接地址并添加进去。获取链接地址的具体操作,请参见下文截图步骤操作。如果你还没有添加或者不知道如何添加采集,可以参考帮助文档-Oceancms如何添加资源库采集界面

选择“背景-采集-资源库列表”,复制资源站右侧的“采集今天”“采集本周”“采集全部”根据你选择的链接地址,去掉前面的内容。(将鼠标移到当天或本周的采集,鼠标右击复制链接即可获得采集链接)

例如,这里是:

1

:///inc/ldg_seackm3u8s.php

第 2 步:删除“?”之前的内容 复制上一步,结果如下:

2

?ac=day&rid=1&url=

这将获得最终的 采集 URL

海洋cms如何自动设置宝塔采集第三步:宝塔定时任务设置。

[3] 将代码直接复制到宝塔计划任务的shell脚本中,并在内容中添加小时任务。具体步骤如下截图。步骤⑤是将我们修改后的脚本复制粘贴到脚本内容框中。

4]总结

一般情况下,修改脚本中需要修改的那几个项目后,将修改后的脚本复制到宝塔的定时任务采集下。不要选择错误的任务类型。如果您对本教程不了解或有任何疑问,可以加入社区进行讨论和查询。

自动采集子系统(清华同方企业竞争情报系统(CNKICompetitive)(CNKI)(组图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 168 次浏览 • 2021-12-21 08:18

1. 概述

清华同方企业竞争情报系统(CNKI CIS)是将反映内外部竞争要素的数据或信息进行采集、存储、处理和分析,以分析结果(即情报信息)的形式发布到战略计算系统的计算机系统。管理人员。

其主要功能是为组织成员评估行业的关键发展趋势,跟踪新兴的不连续变化,掌握行业结构的演变,分析现有和潜在竞争对手的能力和趋势,以协助公司在保持和发展可持续发展方面。竞争优势。

性能卓越,功能强大丰富,专业、易用的人机界面,能有效提升公司整体经营业绩,发现潜在机会和问题,揭示竞争对手战略,促进公司生存和发展机会。

2. 架构

CIS系统涵盖了整个竞争情报生命周期,由一个平台上的三个子系统组成。它们是:情报源规划与定位平台、情报采集子系统、情报(处理)分析子系统、情报服务子系统。整个竞争情报系统具有良好的架构,结构图如下:

ü 信息源规划定位平台

情报源规划定位平台是检索平台和权限管理模块的结合。县管理模块可以方便地控制部门和用户的检索权限和范围。检索平台可以让用户方便地设定情报对象的目标和需要检索的信息来源,可以避免随意搜索,提高搜索效率,支持高级搜索、二次搜索、编辑信息库中的记录。

ü KSpider网络信息资源采集子系统采用先进的语义分析技术,集成多种智能信息处理算法。根据用户需求,准确及时地从信息海洋中筛选出对用户有用的信息。

ü 信息分析处理子系统

智能是多角色用户协作的结晶,因此TCIS智能分析处理模块可以帮助用户按照规定的流程完成智能创建的过程。

结合清华同方STM中文智能信息处理平台先进的数据挖掘技术,对海量数据进行分类、提取、挖掘,将隐藏的、未知的有价值的信息、规律和趋势以可视化的形式表达出来。用于提高公司市场决策能力、发现异常模式、控制可预见风险、基于经验模型预测未来趋势等,并生成简报报告。

ü 信息服务子系统

通过情报服务平台,可以通过电子邮件、手机短信、CRM、ERP、KMS等多种方式将情报推送给情报用户。

3. 特点

依托中国知网多年的内容处理经验和一流的技术手段,CIS企业智能竞赛系统具有强大的技术和功能优势:

ü 先进的文本挖掘引擎

CIS基于中文智能文本挖掘技术,实现了自动分类、自动摘要、关联关联、自动去重等功能,让用户在海量信息中找到有价值的知识。

ü专业的信息处理工厂

CIS提出了情报加工厂的概念,用户可以通过各种手段从情报源中提取有价值的企业竞争情报。通过CIS可以通过两种方式处理信息:通过采集、推荐、升级情报、剪报、情报分析报告,用户在浏览信息的同时,可以及时发现有价值的情报。通过KIT和KIQ,可以对情报课题进行长期的研究。最终研究结果完成后,CIS生成Word报告,提交情报人员研究情报结果。

ü 灵活的组织设置

CIS适应变化,量身定制设计指南,使用户可以根据企业规模和自身情况,自定义情报源浏览权限和情报审批流程。通过CIS,公司所有员工都可以写信息,并且可以通过权限的设置来保证信息的安全。

ü 开启情报服务路线

除了传统的邮件推送、短信推送、页面栏目展示的信息推送方式外,CIS还提供了XML Web Service接口,可以对接企业CRM、ERP、KMS系统。其他系统通过Web Service接口向CIS订购所需的信息和情报,CIS可以通过其他系统提供的Web Service接口将信息和情报推送给其他系统。

ü多信息源综合处理

可以对互联网、内网、文件、业务应用系统等多种来源的信息进行集成和处理,方便企业级用户的集成、管理、分析和辅助决策的广泛应用。

典型应用:宝钢、华通人信息咨询 查看全部

自动采集子系统(清华同方企业竞争情报系统(CNKICompetitive)(CNKI)(组图))

1. 概述

清华同方企业竞争情报系统(CNKI CIS)是将反映内外部竞争要素的数据或信息进行采集、存储、处理和分析,以分析结果(即情报信息)的形式发布到战略计算系统的计算机系统。管理人员。

其主要功能是为组织成员评估行业的关键发展趋势,跟踪新兴的不连续变化,掌握行业结构的演变,分析现有和潜在竞争对手的能力和趋势,以协助公司在保持和发展可持续发展方面。竞争优势。

性能卓越,功能强大丰富,专业、易用的人机界面,能有效提升公司整体经营业绩,发现潜在机会和问题,揭示竞争对手战略,促进公司生存和发展机会。

2. 架构

CIS系统涵盖了整个竞争情报生命周期,由一个平台上的三个子系统组成。它们是:情报源规划与定位平台、情报采集子系统、情报(处理)分析子系统、情报服务子系统。整个竞争情报系统具有良好的架构,结构图如下:

ü 信息源规划定位平台

情报源规划定位平台是检索平台和权限管理模块的结合。县管理模块可以方便地控制部门和用户的检索权限和范围。检索平台可以让用户方便地设定情报对象的目标和需要检索的信息来源,可以避免随意搜索,提高搜索效率,支持高级搜索、二次搜索、编辑信息库中的记录。

ü KSpider网络信息资源采集子系统采用先进的语义分析技术,集成多种智能信息处理算法。根据用户需求,准确及时地从信息海洋中筛选出对用户有用的信息。

ü 信息分析处理子系统

智能是多角色用户协作的结晶,因此TCIS智能分析处理模块可以帮助用户按照规定的流程完成智能创建的过程。

结合清华同方STM中文智能信息处理平台先进的数据挖掘技术,对海量数据进行分类、提取、挖掘,将隐藏的、未知的有价值的信息、规律和趋势以可视化的形式表达出来。用于提高公司市场决策能力、发现异常模式、控制可预见风险、基于经验模型预测未来趋势等,并生成简报报告。

ü 信息服务子系统

通过情报服务平台,可以通过电子邮件、手机短信、CRM、ERP、KMS等多种方式将情报推送给情报用户。

3. 特点

依托中国知网多年的内容处理经验和一流的技术手段,CIS企业智能竞赛系统具有强大的技术和功能优势:

ü 先进的文本挖掘引擎

CIS基于中文智能文本挖掘技术,实现了自动分类、自动摘要、关联关联、自动去重等功能,让用户在海量信息中找到有价值的知识。

ü专业的信息处理工厂

CIS提出了情报加工厂的概念,用户可以通过各种手段从情报源中提取有价值的企业竞争情报。通过CIS可以通过两种方式处理信息:通过采集、推荐、升级情报、剪报、情报分析报告,用户在浏览信息的同时,可以及时发现有价值的情报。通过KIT和KIQ,可以对情报课题进行长期的研究。最终研究结果完成后,CIS生成Word报告,提交情报人员研究情报结果。

ü 灵活的组织设置

CIS适应变化,量身定制设计指南,使用户可以根据企业规模和自身情况,自定义情报源浏览权限和情报审批流程。通过CIS,公司所有员工都可以写信息,并且可以通过权限的设置来保证信息的安全。

ü 开启情报服务路线

除了传统的邮件推送、短信推送、页面栏目展示的信息推送方式外,CIS还提供了XML Web Service接口,可以对接企业CRM、ERP、KMS系统。其他系统通过Web Service接口向CIS订购所需的信息和情报,CIS可以通过其他系统提供的Web Service接口将信息和情报推送给其他系统。

ü多信息源综合处理

可以对互联网、内网、文件、业务应用系统等多种来源的信息进行集成和处理,方便企业级用户的集成、管理、分析和辅助决策的广泛应用。

典型应用:宝钢、华通人信息咨询

自动采集子系统(软件功能云端部署(SkyCaiji),致力于网站数据自动化采集发布 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 200 次浏览 • 2021-12-20 16:14

)

优采云采集器是一款强大的网页数据工具采集,主要功能是使用采集网页内容,如小说、文章、视频等资料等;这个工具更加强大和灵活。可以进行多级子页面采集及相关页面采集,满足用户对采集数据的各种需求;优采云采集器可以应用于很多领域,比如自媒体、招投标、信息获取等;本工具使用php+mysql开发,可直接部署在用户服务器,轻松对接各类cms系统;通过半自动化数据采集功能,用户采集数据更方便。

软件功能

云部署

优采云采集器(天财记),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上让数据采集 便捷、智能、云端化,让您随时随地移动办公。

数据采集

支持多级、多页、分页采集、自定义采集规则(支持regular、XPATH、JSON等)准确匹配任何信息流,几乎采集所有类型网页,绝对可以智能识别大多数文章类型页面的内容。

内容发布

无缝对接各种cms建站程序,实现免登录导入数据,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时、定量、全自动采集发布,无需人工干预!内置云平台,用户可以分享和下载采集规则,发布供需信息,社区帮助和交流。

软件特点

1、您可以使用此工具帮助用户采集网站对网页内容进行处理。

2、用户可以灵活设置采集器的采集规则。

3、这个工具可以满足用户在日常工作中的各种采集需求。

4、您可以采集网页上的各种内容,包括音频、视频和小说。

5、配置方法很简单,默认配置也能满足大部分用户的需求。

6、您可以输入采集规则名称和目标网站代码。

7、页面渲染可以自动加载出ajax内容,适用于js脚本较多的页面。

8、自动补全网址可以将网页中的相对地址转换为绝对网址。

9、 URL 不会被重新输入。默认情况下,已经采集 的内容页面将被重新输入。Non-re-reduction 适用于更新频繁的动态页面。

10、 修改请求头信息,适应需要登录、手机浏览等界面。

安装方法

1、首先在本站下载程序压缩包,下载后解压,上传到自己的服务器,然后打开浏览器输入服务器名和IP地址建立连接,然后就可以输入安装界面。

2、自动检测安装环境,必须保证所有环境正确,否则使用中可能会出现问题。

3、按照提示输入相关信息,点击下一步提交信息。

4、之后,等待采集器安装,安装完成后打开。

指示

1、登录采集器后台后,在页面左侧边栏中勾选“添加任务”选项并进行编辑。

2、然后按照提示在添加任务界面填写相关信息并保存。

3、任务创建完成后,可以在任务底部进度条的采集设置选项中进入编辑界面。

4、您可以切换到“实际页面网址”界面,选择添加起始页。

5、可以添加或修改内容页面URL,支持多级URL获取。

6、多级URL获取方式更适合采集小说和电影。

7、当要抓取的内容不在当前页面,而是在与其关联的页面上时,可以在这里设置关联页面的规则。

8、“添加默认”可以自动设置几个常用字段,可以满足大部分文章类型的网站采集。

查看全部

自动采集子系统(软件功能云端部署(SkyCaiji),致力于网站数据自动化采集发布

)

优采云采集器是一款强大的网页数据工具采集,主要功能是使用采集网页内容,如小说、文章、视频等资料等;这个工具更加强大和灵活。可以进行多级子页面采集及相关页面采集,满足用户对采集数据的各种需求;优采云采集器可以应用于很多领域,比如自媒体、招投标、信息获取等;本工具使用php+mysql开发,可直接部署在用户服务器,轻松对接各类cms系统;通过半自动化数据采集功能,用户采集数据更方便。

软件功能

云部署

优采云采集器(天财记),致力于发布网站数据自动化采集,系统采用PHP+Mysql开发,可部署在云服务器上让数据采集 便捷、智能、云端化,让您随时随地移动办公。

数据采集

支持多级、多页、分页采集、自定义采集规则(支持regular、XPATH、JSON等)准确匹配任何信息流,几乎采集所有类型网页,绝对可以智能识别大多数文章类型页面的内容。

内容发布

无缝对接各种cms建站程序,实现免登录导入数据,支持自定义数据发布插件,或直接导入数据库,存储为Excel文件,生成API接口等。

自动化和云平台

软件实现定时、定量、全自动采集发布,无需人工干预!内置云平台,用户可以分享和下载采集规则,发布供需信息,社区帮助和交流。

软件特点

1、您可以使用此工具帮助用户采集网站对网页内容进行处理。

2、用户可以灵活设置采集器的采集规则。

3、这个工具可以满足用户在日常工作中的各种采集需求。

4、您可以采集网页上的各种内容,包括音频、视频和小说。

5、配置方法很简单,默认配置也能满足大部分用户的需求。

6、您可以输入采集规则名称和目标网站代码。

7、页面渲染可以自动加载出ajax内容,适用于js脚本较多的页面。

8、自动补全网址可以将网页中的相对地址转换为绝对网址。

9、 URL 不会被重新输入。默认情况下,已经采集 的内容页面将被重新输入。Non-re-reduction 适用于更新频繁的动态页面。

10、 修改请求头信息,适应需要登录、手机浏览等界面。

安装方法

1、首先在本站下载程序压缩包,下载后解压,上传到自己的服务器,然后打开浏览器输入服务器名和IP地址建立连接,然后就可以输入安装界面。

2、自动检测安装环境,必须保证所有环境正确,否则使用中可能会出现问题。

3、按照提示输入相关信息,点击下一步提交信息。

4、之后,等待采集器安装,安装完成后打开。

指示

1、登录采集器后台后,在页面左侧边栏中勾选“添加任务”选项并进行编辑。

2、然后按照提示在添加任务界面填写相关信息并保存。

3、任务创建完成后,可以在任务底部进度条的采集设置选项中进入编辑界面。

4、您可以切换到“实际页面网址”界面,选择添加起始页。

5、可以添加或修改内容页面URL,支持多级URL获取。

6、多级URL获取方式更适合采集小说和电影。

7、当要抓取的内容不在当前页面,而是在与其关联的页面上时,可以在这里设置关联页面的规则。

8、“添加默认”可以自动设置几个常用字段,可以满足大部分文章类型的网站采集。

自动采集子系统(乐思网络舆情监测系统的网络拓扑结构图所示与分析)

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-12-18 13:22

系统组成

乐思网络舆情监测系统由两个子系统组成:自动采集子系统(采集层)和分析浏览子系统(分析层和呈现层)。

乐思网络舆情监测系统的网络拓扑如下图所示,也可以根据需要在隔离的外网和内网中实现。

自动采集子系统功能说明

自动采集子系统可以自动采集任何目标网站。

例如:新华网、强国论坛、天涯社区、西瓷社区、网易社区、新浪论坛、搜狐社区、凤凰网、百度贴吧,以及用户指定的其他动态网站。您可以提取所有新闻文章或主题帖或最新主题帖的内容,也可以提取某个主题帖的所有回复或最新回复的内容。要么指定目标网站进行监控,要么不指定目标网站进行全局监控网站,或者两者混合监控。可监控国内网站和海外网站,如Facebook、Twitter、BBC、CNN。

自动采集 子系统还可以监控基于应用程序的聊天室程序。

后端数据库支持任何主流关系型数据库,如Oracle、IBM DB2、MS SQL Server、MySQL、Sybase和文件数据库Access。

自动采集子系统的综合监控功能如下图所示:

自动采集子系统具有以下显着特点:

1. 全球领先的全自动采集功能

Lesisoft的网络信息采集技术是世界领先的,支持任何网页采集中任何数据的准确性。Lesisoft每天为国内外用户提供各种采集服务。没有一个高效稳定的采集平台是做不到的。

2. 支持各种监控对象

微博、新闻、论坛、博客、公共聊天室、搜索引擎、留言板、应用、报刊电子版等实时监控。

3. 无需配置直接监听上千条新闻网站

系统内置网站全球监控配置,只需输入关键词,采集就会自动文章标题和文字。

4. 强大的多语言统一处理功能 26 禁止 9 盗用 0

可自动处理保存中文、英文、法文、德文、日文、韩文、维吾尔文、阿拉伯文等多种语言。

5. 智能文章 提取

对于文章类型的网页,无需配置即可直接提取文章正文和标题、作者发布日期,自动去除广告、栏目、版权等无关垃圾内容。

6. 完美支持各种网页情况

支持当前流行的Web2.0 AJAX动态网站

支持用户名密码自动登录

支持表单查询 查看全部

自动采集子系统(乐思网络舆情监测系统的网络拓扑结构图所示与分析)

系统组成

乐思网络舆情监测系统由两个子系统组成:自动采集子系统(采集层)和分析浏览子系统(分析层和呈现层)。

乐思网络舆情监测系统的网络拓扑如下图所示,也可以根据需要在隔离的外网和内网中实现。

自动采集子系统功能说明

自动采集子系统可以自动采集任何目标网站。

例如:新华网、强国论坛、天涯社区、西瓷社区、网易社区、新浪论坛、搜狐社区、凤凰网、百度贴吧,以及用户指定的其他动态网站。您可以提取所有新闻文章或主题帖或最新主题帖的内容,也可以提取某个主题帖的所有回复或最新回复的内容。要么指定目标网站进行监控,要么不指定目标网站进行全局监控网站,或者两者混合监控。可监控国内网站和海外网站,如Facebook、Twitter、BBC、CNN。

自动采集 子系统还可以监控基于应用程序的聊天室程序。

后端数据库支持任何主流关系型数据库,如Oracle、IBM DB2、MS SQL Server、MySQL、Sybase和文件数据库Access。

自动采集子系统的综合监控功能如下图所示:

自动采集子系统具有以下显着特点:

1. 全球领先的全自动采集功能

Lesisoft的网络信息采集技术是世界领先的,支持任何网页采集中任何数据的准确性。Lesisoft每天为国内外用户提供各种采集服务。没有一个高效稳定的采集平台是做不到的。

2. 支持各种监控对象

微博、新闻、论坛、博客、公共聊天室、搜索引擎、留言板、应用、报刊电子版等实时监控。

3. 无需配置直接监听上千条新闻网站

系统内置网站全球监控配置,只需输入关键词,采集就会自动文章标题和文字。

4. 强大的多语言统一处理功能 26 禁止 9 盗用 0

可自动处理保存中文、英文、法文、德文、日文、韩文、维吾尔文、阿拉伯文等多种语言。

5. 智能文章 提取

对于文章类型的网页,无需配置即可直接提取文章正文和标题、作者发布日期,自动去除广告、栏目、版权等无关垃圾内容。

6. 完美支持各种网页情况

支持当前流行的Web2.0 AJAX动态网站

支持用户名密码自动登录

支持表单查询

自动采集子系统(自动采集子系统有什么不好的呢?怎么做?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 169 次浏览 • 2021-12-15 00:06

自动采集子系统,是根据网站流量高峰时间段,采集高质量内容的系统。从而提高网站抓取量。高质量内容全量采集,降低采集成本,提高网站抓取质量,提高网站分发效率。

流量高峰期采集有什么不好呢。

有什么不好的呢,正常的,需要循环来采集一些东西,不过如果规划好再利用的话,确实效率提高很多。

关键是要了解用户的需求

采集只要正常用户体验都应该很差

多了一个人负责网站的任务对网站有益吗网站提供了采集的东西,还会让我们自己采集吗。

如果做一个工具是让我们上班打卡免费用,

设计这个工具的公司和产品是什么样的?有这种需求的行业环境如何?小公司的话没什么意义,大公司还好,至少小产品会更成熟。

天呐,不错的,本人是做建站的,任务就是采集所有类型的网站文章,然后以ppt的形式发布到互联网上,主要是工作量大。

你能明白“一个网站的子页”的含义吗?

采集文章是可以提高收录和质量的,作为一个高质量的新闻资讯平台,用户的需求是不可或缺的,对于新闻的收集存储发布,会让整个平台更有价值,这点我想作为一个建站的小团队的立足之本,而且确实是基础,一个好的内容收集存储发布工具,应该注重对高质量原创的收集存储发布, 查看全部

自动采集子系统(自动采集子系统有什么不好的呢?怎么做?)

自动采集子系统,是根据网站流量高峰时间段,采集高质量内容的系统。从而提高网站抓取量。高质量内容全量采集,降低采集成本,提高网站抓取质量,提高网站分发效率。

流量高峰期采集有什么不好呢。

有什么不好的呢,正常的,需要循环来采集一些东西,不过如果规划好再利用的话,确实效率提高很多。

关键是要了解用户的需求

采集只要正常用户体验都应该很差

多了一个人负责网站的任务对网站有益吗网站提供了采集的东西,还会让我们自己采集吗。

如果做一个工具是让我们上班打卡免费用,

设计这个工具的公司和产品是什么样的?有这种需求的行业环境如何?小公司的话没什么意义,大公司还好,至少小产品会更成熟。

天呐,不错的,本人是做建站的,任务就是采集所有类型的网站文章,然后以ppt的形式发布到互联网上,主要是工作量大。

你能明白“一个网站的子页”的含义吗?

采集文章是可以提高收录和质量的,作为一个高质量的新闻资讯平台,用户的需求是不可或缺的,对于新闻的收集存储发布,会让整个平台更有价值,这点我想作为一个建站的小团队的立足之本,而且确实是基础,一个好的内容收集存储发布工具,应该注重对高质量原创的收集存储发布,

自动采集子系统(自动采集子系统是很有必要了解下的功能了)

采集交流 • 优采云 发表了文章 • 0 个评论 • 135 次浏览 • 2021-12-14 00:02

自动采集子系统是很有必要了解下的功能了。对于一个采集子系统,

1、高质量解析自定义lbs(包括lbs网站,faq,广告,外卖,

2、搜索子系统提供了搜索库、新闻库、tripbar、lbs行程、手机端等等搜索子系统的搜索模块,

3、门户子系统功能就是包括了门户类网站在内的功能,

4、推送子系统

5、安全子系统子系统提供了我们最基本的身份、公安注册登记、身份保管、限制身份、合约管理等安全功能

顺便提个醒,目前来说,

1、给子系统起个名字,

2、有完善的规则,解析前端的一些广告api接口,用户如果需要购买某些东西则可以询问相关问题,

3、小区、公司等这些复杂地理位置附近的开发者并没有完善的服务于这个产品中,而且客户多,比较难定位,

4、针对目前的应用来说,有很多内置的接口开放给非开发者用户使用,比如首页导航等等,

很有必要的,推送在今年流行起来的。有很多的公司都在研究,小米也尝试了的。你可以看看手淘的阿里妈妈就在研究这方面,还有各种我了解到的平台都在研究。把他纳入到自己的系统里可以给自己带来更多的流量和更大的利益。微博和闲鱼都是这方面的。他们都走在一个学习研究的路上。 查看全部

自动采集子系统(自动采集子系统是很有必要了解下的功能了)

自动采集子系统是很有必要了解下的功能了。对于一个采集子系统,

1、高质量解析自定义lbs(包括lbs网站,faq,广告,外卖,

2、搜索子系统提供了搜索库、新闻库、tripbar、lbs行程、手机端等等搜索子系统的搜索模块,

3、门户子系统功能就是包括了门户类网站在内的功能,

4、推送子系统

5、安全子系统子系统提供了我们最基本的身份、公安注册登记、身份保管、限制身份、合约管理等安全功能

顺便提个醒,目前来说,

1、给子系统起个名字,

2、有完善的规则,解析前端的一些广告api接口,用户如果需要购买某些东西则可以询问相关问题,

3、小区、公司等这些复杂地理位置附近的开发者并没有完善的服务于这个产品中,而且客户多,比较难定位,

4、针对目前的应用来说,有很多内置的接口开放给非开发者用户使用,比如首页导航等等,

很有必要的,推送在今年流行起来的。有很多的公司都在研究,小米也尝试了的。你可以看看手淘的阿里妈妈就在研究这方面,还有各种我了解到的平台都在研究。把他纳入到自己的系统里可以给自己带来更多的流量和更大的利益。微博和闲鱼都是这方面的。他们都走在一个学习研究的路上。

自动采集子系统(百度如何自动抓取豆瓣中电影评分?-搜索如何利用bbsbot插件获取各大网站首页下载地址)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-12-09 07:00

自动采集子系统基本工作原理如下:

1、收集bbs信息,加入bbs爬虫库。

2、使用bbsbot插件,

3、根据rule、dom、postman-tget方法抓取子页面

子页面获取加bbsbot

bbsbot插件

我这边是用javascript很好解决的,首先用bbsbot插件抓取第二页源码。

百度搜:利用bbsbot插件打发恶意广告者利用bbsbot插件抓取不同网站域名内网页(有效抓取中)利用bbsbot插件批量抓取内容(上百款插件介绍)

如何使用bbsbot抓取百度贴吧和知乎首页

看看这个图片。

可以用金龟婿都可以自动采集

qqbbsbot爬虫

比较简单的方法是用bbsbot插件用bbsbotv4爬取

利用gecko技术,用autobotjavascript可以这样自动采集,

百度如何自动抓取豆瓣中电影评分?-搜索

如何利用bbsbot插件获取各大网站首页下载地址

利用bbsbot编程技术,用浏览器自带的搜索引擎抓取,就行了,爬到返回的网页包含一个html的page包含各网站链接,每个网站的iframe页面id都不一样,然后可以在用js获取用户的手机号这样可以统计用户的地理位置分析用户上网习惯。话说电脑上好多软件都不能获取用户手机号,比如qq,百度,微信。

自动抓取就不要想了,你只需要一个useragent,只要人肉就可以了。但是我觉得一般都是带抓baidu搜索带进去的网站链接。毕竟搜索引擎抓取需要个useragent。 查看全部

自动采集子系统(百度如何自动抓取豆瓣中电影评分?-搜索如何利用bbsbot插件获取各大网站首页下载地址)

自动采集子系统基本工作原理如下:

1、收集bbs信息,加入bbs爬虫库。

2、使用bbsbot插件,

3、根据rule、dom、postman-tget方法抓取子页面

子页面获取加bbsbot

bbsbot插件

我这边是用javascript很好解决的,首先用bbsbot插件抓取第二页源码。

百度搜:利用bbsbot插件打发恶意广告者利用bbsbot插件抓取不同网站域名内网页(有效抓取中)利用bbsbot插件批量抓取内容(上百款插件介绍)

如何使用bbsbot抓取百度贴吧和知乎首页

看看这个图片。