自动抓取网页数据

自动抓取网页数据(项目简单思路 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-10-01 07:26

)

该项目的简单思想是首先将通过jsoup捕获的数据存储到ArrayList中,然后通过JDBC存储到数据库中

创建了Maven项目。您需要在pom.xml中添加两个依赖项:

org.jsoup

jsoup

1.11.3

mysql

mysql-connector-java

5.1.38

创建实体类:

然后执行数据爬网和数据库保存操作:

package control;

import dao.Blog;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

import java.util.ArrayList;

public class Grab {

private static Document doc;

public static void main(String[] args) {

try {

//获取的网页链接

doc = Jsoup.connect("https://www.cnblogs.com/").get();

} catch (IOException e) {

e.printStackTrace();

}

//调用Blog类

BlogZhua();

}

/**

* 抓取网页数据

*/

public static void BlogZhua() {

//获取网页中的元素

Elements eles = doc.select("div#post_list>div.post_item");

//将抓取的数据存入到ArrayList集合中

ArrayList arrayList = new ArrayList();

//使用for循环遍历网页中的数据

for (Element ele : eles) {

//抓取页面中的文章标题

String txt = ele.select("div.post_item_body>h3>a.titlelnk").text();

//抓取页面中的文章链接

String href = ele.select("div.post_item_body>h3>a.titlelnk").attr("href");

//爬取文章作者

String author = ele.select("div.post_item_foot > a.lightblue").text();

//爬取文章发布时间

String reads = ele.select("div.post_item_foot > span.article_view > a.gray").text();

//将数据添加到集合中

Blog blog = new Blog();

blog.setTitle(txt);

blog.setHref(href);

blog.setAuthor(author);

blog.setReads(reads);

arrayList.add(blog);

}

//遍历ArrayList集合

for (Blog test : arrayList) {

// System.out.println("数据:" + test);

//此处调用AddBlog类,把集合中的数据添加到数据库中

AddBlog(test);

}

}

/**

* 数据库操作

*

* @param blog

*/

public static void AddBlog(Blog blog) {

try {

//加载mysql驱动

Class.forName("com.mysql.jdbc.Driver");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

Connection connection = null;

PreparedStatement pstmt = null;

try {

//连接mysql

connection = DriverManager.getConnection("jdbc:mysql://localhost:3306/jsoup?useSSL=true", "root", "1234");

//编写sql语句

String sql = "INSERT INTO `content`(`title`, `href`, `author`, `reads`) VALUES (?,?,?,?)";

pstmt = connection.prepareStatement(sql);

pstmt.setString(1, blog.getTitle());

pstmt.setString(2, blog.getHref());

pstmt.setString(3, blog.getAuthor());

pstmt.setString(4, blog.getReads());

int result = pstmt.executeUpdate();

//验证数据是否添加成功

if (result > 0) {

System.out.println("数据添加成功!");

}

} catch (SQLException throwables) {

throwables.printStackTrace();

System.out.println("数据库访问失败!");

}

}

} 查看全部

自动抓取网页数据(项目简单思路

)

该项目的简单思想是首先将通过jsoup捕获的数据存储到ArrayList中,然后通过JDBC存储到数据库中

创建了Maven项目。您需要在pom.xml中添加两个依赖项:

org.jsoup

jsoup

1.11.3

mysql

mysql-connector-java

5.1.38

创建实体类:

然后执行数据爬网和数据库保存操作:

package control;

import dao.Blog;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

import java.util.ArrayList;

public class Grab {

private static Document doc;

public static void main(String[] args) {

try {

//获取的网页链接

doc = Jsoup.connect("https://www.cnblogs.com/";).get();

} catch (IOException e) {

e.printStackTrace();

}

//调用Blog类

BlogZhua();

}

/**

* 抓取网页数据

*/

public static void BlogZhua() {

//获取网页中的元素

Elements eles = doc.select("div#post_list>div.post_item");

//将抓取的数据存入到ArrayList集合中

ArrayList arrayList = new ArrayList();

//使用for循环遍历网页中的数据

for (Element ele : eles) {

//抓取页面中的文章标题

String txt = ele.select("div.post_item_body>h3>a.titlelnk").text();

//抓取页面中的文章链接

String href = ele.select("div.post_item_body>h3>a.titlelnk").attr("href");

//爬取文章作者

String author = ele.select("div.post_item_foot > a.lightblue").text();

//爬取文章发布时间

String reads = ele.select("div.post_item_foot > span.article_view > a.gray").text();

//将数据添加到集合中

Blog blog = new Blog();

blog.setTitle(txt);

blog.setHref(href);

blog.setAuthor(author);

blog.setReads(reads);

arrayList.add(blog);

}

//遍历ArrayList集合

for (Blog test : arrayList) {

// System.out.println("数据:" + test);

//此处调用AddBlog类,把集合中的数据添加到数据库中

AddBlog(test);

}

}

/**

* 数据库操作

*

* @param blog

*/

public static void AddBlog(Blog blog) {

try {

//加载mysql驱动

Class.forName("com.mysql.jdbc.Driver");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

Connection connection = null;

PreparedStatement pstmt = null;

try {

//连接mysql

connection = DriverManager.getConnection("jdbc:mysql://localhost:3306/jsoup?useSSL=true", "root", "1234");

//编写sql语句

String sql = "INSERT INTO `content`(`title`, `href`, `author`, `reads`) VALUES (?,?,?,?)";

pstmt = connection.prepareStatement(sql);

pstmt.setString(1, blog.getTitle());

pstmt.setString(2, blog.getHref());

pstmt.setString(3, blog.getAuthor());

pstmt.setString(4, blog.getReads());

int result = pstmt.executeUpdate();

//验证数据是否添加成功

if (result > 0) {

System.out.println("数据添加成功!");

}

} catch (SQLException throwables) {

throwables.printStackTrace();

System.out.println("数据库访问失败!");

}

}

}

自动抓取网页数据(如何用python来抓取页面中的JS动态加载的数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-01 07:25

)

我们经常会发现,网页中的很多数据并不是硬编码在 HTML 中,而是动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中动态生成的页面内容,是页面加载到浏览器后动态生成的,以前没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图所示,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以在页面上加载更多电影资讯节目单,以便我们抓取相应的消息。

我们可以看到它使用了 AJAX 异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某个部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,我们可以发现有两个参数“start”和“liGLNqVtxOmit”,后面跟着的是action参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这看起来很不自动化,而且很多其他网站 RequestURL 都不是那么直接,所以我们将使用pyth 编程inn 进行进一步的操作,以获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text 查看全部

自动抓取网页数据(如何用python来抓取页面中的JS动态加载的数据

)

我们经常会发现,网页中的很多数据并不是硬编码在 HTML 中,而是动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中动态生成的页面内容,是页面加载到浏览器后动态生成的,以前没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图所示,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以在页面上加载更多电影资讯节目单,以便我们抓取相应的消息。

我们可以看到它使用了 AJAX 异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某个部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,我们可以发现有两个参数“start”和“liGLNqVtxOmit”,后面跟着的是action参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这看起来很不自动化,而且很多其他网站 RequestURL 都不是那么直接,所以我们将使用pyth 编程inn 进行进一步的操作,以获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text

自动抓取网页数据(,,过WindowBuilder插件了,具体使用参考如下链接效果)

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-10-01 07:22

java网页爬取最常用的方式,老司机应该都知道,那就是使用JSOUP。这个工具之前玩过,但是发现一个问题,比如你需要爬取的数据,必须登录才能爬取,如果涉及到验证码,就更难操作了。

很久以前,jsoup就是用来尝试自动下载便图高清图片的。但是他们的登录方式只是第三方登录,单靠jsoup是很难实现的。

后来找到了JXbrower这个工具,可以轻松实现这样的需求。

下面我们就抓着便图网的案例开始详细介绍JX。

先下载

如何下载,这里不详细说明。注意我这里使用的是6.18版本,我必须使用6.18版本

解压下载的压缩包,

获取以下两个jar包

jxbrowser-6.18.jar

jxbrowser-win32-6.18.jar

项目结构如下:

创建一个新文件 teamdev.licenses

Product: JxBrowser

Version: 6.x

Licensed to:

License type: Enterprise

License info: JxBrowser License

Expiration date: 01-01-9999

Support expiration date: NO SUPPORT

Generation date: 01-01-1970

Platforms: win32/x86;win32/x64;mac/x86;mac/x64;linux/x86;linux/x64

Company name: TeamDev Ltd.

SigB: 1

SigA: 1

主要代码

在这里提一下,博主已经安装了WindowBuilder插件。具体使用请参考以下链接

效果如下

这只是一个简单的案例。更强大的功能可以查看他的API。 查看全部

自动抓取网页数据(,,过WindowBuilder插件了,具体使用参考如下链接效果)

java网页爬取最常用的方式,老司机应该都知道,那就是使用JSOUP。这个工具之前玩过,但是发现一个问题,比如你需要爬取的数据,必须登录才能爬取,如果涉及到验证码,就更难操作了。

很久以前,jsoup就是用来尝试自动下载便图高清图片的。但是他们的登录方式只是第三方登录,单靠jsoup是很难实现的。

后来找到了JXbrower这个工具,可以轻松实现这样的需求。

下面我们就抓着便图网的案例开始详细介绍JX。

先下载

如何下载,这里不详细说明。注意我这里使用的是6.18版本,我必须使用6.18版本

解压下载的压缩包,

获取以下两个jar包

jxbrowser-6.18.jar

jxbrowser-win32-6.18.jar

项目结构如下:

创建一个新文件 teamdev.licenses

Product: JxBrowser

Version: 6.x

Licensed to:

License type: Enterprise

License info: JxBrowser License

Expiration date: 01-01-9999

Support expiration date: NO SUPPORT

Generation date: 01-01-1970

Platforms: win32/x86;win32/x64;mac/x86;mac/x64;linux/x86;linux/x64

Company name: TeamDev Ltd.

SigB: 1

SigA: 1

主要代码

在这里提一下,博主已经安装了WindowBuilder插件。具体使用请参考以下链接

效果如下

这只是一个简单的案例。更强大的功能可以查看他的API。

自动抓取网页数据(大数据初学者了解并动手实现自己的网络爬虫(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-01 04:19

网络爬虫是从互联网上打开数据采集的重要手段。在这种情况下,使用Python的相关模块开发了一个简单的爬虫。实现从某本书网站中自动下载感兴趣的图书信息的功能。实现的主要功能包括单页图书信息下载、图书信息提取、多页图书信息下载。本案例适合大数据初学者了解并实现自己的网络爬虫。

1、任务描述和数据来源

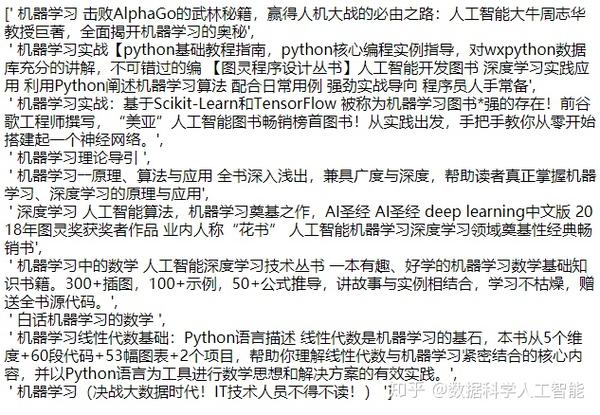

从当当网的搜索页面,按照关键词进行搜索,使用Python编写爬虫,在搜索结果中自动爬取该书的书名、出版社、价格、作者、书籍介绍。

当当搜索页面:/

2、单页图书信息下载2.1个网页下载

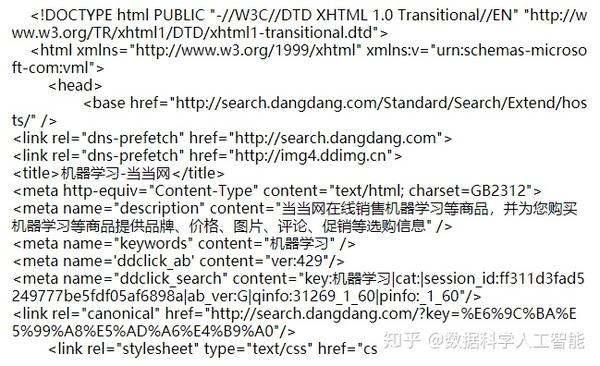

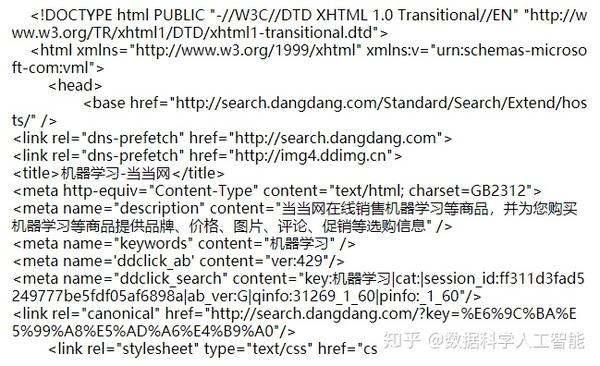

Python 中的 requests 库可以自动帮我们构造一个请求对象来向服务器请求资源,并为服务器资源返回一个响应对象。如果只需要返回 HTML 页面的内容,可以直接调用响应的 text 属性。下面的代码中,我们首先导入requests库,定义当当搜索页面的URL,设置搜索关键词为“机器学习”。然后使用requests.get方法获取网页内容。最后,打印并显示网页的前 1000 个字符。

import requests #1. 导入requests 库

test_url = 'http://search.dangdang.com/?key='+ '机器学习' #2. 设置网页的URL地址

content_page = requests.get(test_url).text #3. 执行页面请求,返回页面内容

print(content_page[:1000]) #4.将页面的前1000个字符打印显示出来

2.2 图书内容分析

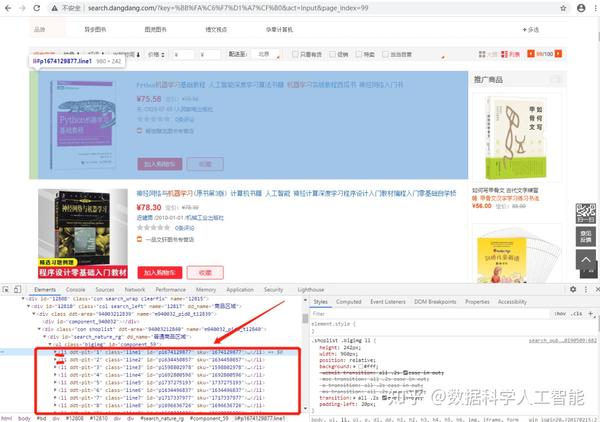

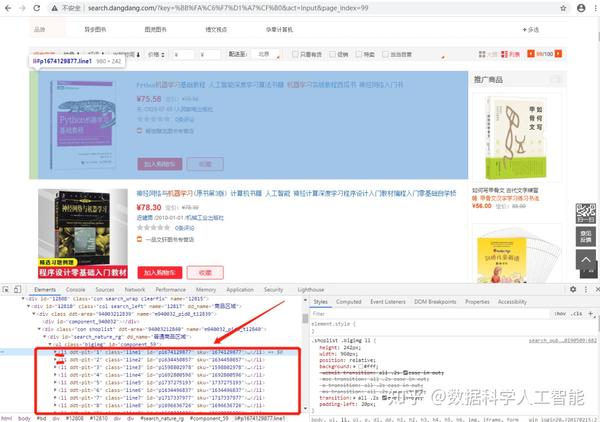

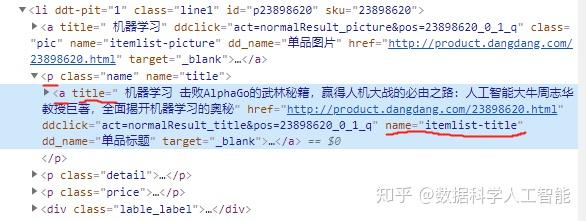

下面开始分析页面,分析源码。这里我使用Chrome浏览器直接打开网址/?key=machine learning。然后选择任意图书信息,右击“检查”按钮。不难发现,搜索结果中每本书的信息都是页面上的一个标签,如下图所示:

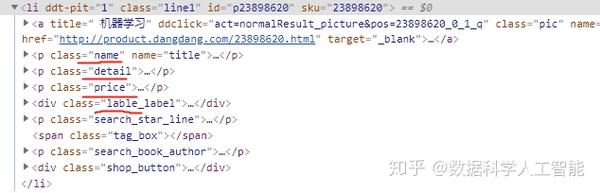

点击第一个标签,发现下面还有几个

标签,类别有“名称”、“详情”、“价格”等,这些标签下存储着商品的标题、详情、价格等信息。

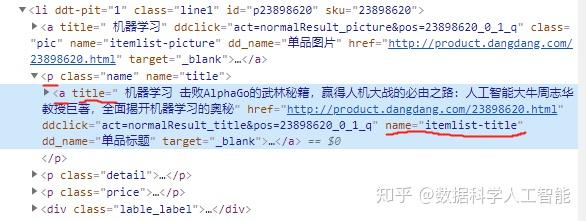

我们以提取书名信息为例进行具体说明。点击li标签下class属性为name的p标签,我们发现书名信息存储在name属性为“itemlist-title”的标签的title属性中,如下图所示:

我们可以用xpath直接把上面的定位信息描述为//li/p/a[@name="itemlist-title"]/@title。接下来,我们使用 lxml 模块提取页面中的书名信息。xpath的使用请参考/xpath/xpath_syntax.asp。

page = etree.HTML(content_page) #将页面字符串解析成树结构

book_name = page.xpath('//li/p/a[@name="itemlist-title"]/@title') #用xpath提取出书名信息。

book_name[:10] #打印提取出的前10个书名信息

同理,我们可以提取图书出版信息(作者、出版社、出版时间等)、当前价格、星级、评论数等。该信息对应的xpath路径如下表所示。

信息项

标题

//li/p/a[@name="itemlist-title"]/@title

出版信息

//li/p[@class="search_book_author"]

目前的价格

//li/p[@class="price"]/span[@class="search_now_price"]/text()

星级

//li/p[@class="search_star_line"]/span[@class="search_star_black"]/span/@style 查看全部

自动抓取网页数据(大数据初学者了解并动手实现自己的网络爬虫(图))

网络爬虫是从互联网上打开数据采集的重要手段。在这种情况下,使用Python的相关模块开发了一个简单的爬虫。实现从某本书网站中自动下载感兴趣的图书信息的功能。实现的主要功能包括单页图书信息下载、图书信息提取、多页图书信息下载。本案例适合大数据初学者了解并实现自己的网络爬虫。

1、任务描述和数据来源

从当当网的搜索页面,按照关键词进行搜索,使用Python编写爬虫,在搜索结果中自动爬取该书的书名、出版社、价格、作者、书籍介绍。

当当搜索页面:/

2、单页图书信息下载2.1个网页下载

Python 中的 requests 库可以自动帮我们构造一个请求对象来向服务器请求资源,并为服务器资源返回一个响应对象。如果只需要返回 HTML 页面的内容,可以直接调用响应的 text 属性。下面的代码中,我们首先导入requests库,定义当当搜索页面的URL,设置搜索关键词为“机器学习”。然后使用requests.get方法获取网页内容。最后,打印并显示网页的前 1000 个字符。

import requests #1. 导入requests 库

test_url = 'http://search.dangdang.com/?key='+ '机器学习' #2. 设置网页的URL地址

content_page = requests.get(test_url).text #3. 执行页面请求,返回页面内容

print(content_page[:1000]) #4.将页面的前1000个字符打印显示出来

2.2 图书内容分析

下面开始分析页面,分析源码。这里我使用Chrome浏览器直接打开网址/?key=machine learning。然后选择任意图书信息,右击“检查”按钮。不难发现,搜索结果中每本书的信息都是页面上的一个标签,如下图所示:

点击第一个标签,发现下面还有几个

标签,类别有“名称”、“详情”、“价格”等,这些标签下存储着商品的标题、详情、价格等信息。

我们以提取书名信息为例进行具体说明。点击li标签下class属性为name的p标签,我们发现书名信息存储在name属性为“itemlist-title”的标签的title属性中,如下图所示:

我们可以用xpath直接把上面的定位信息描述为//li/p/a[@name="itemlist-title"]/@title。接下来,我们使用 lxml 模块提取页面中的书名信息。xpath的使用请参考/xpath/xpath_syntax.asp。

page = etree.HTML(content_page) #将页面字符串解析成树结构

book_name = page.xpath('//li/p/a[@name="itemlist-title"]/@title') #用xpath提取出书名信息。

book_name[:10] #打印提取出的前10个书名信息

同理,我们可以提取图书出版信息(作者、出版社、出版时间等)、当前价格、星级、评论数等。该信息对应的xpath路径如下表所示。

信息项

标题

//li/p/a[@name="itemlist-title"]/@title

出版信息

//li/p[@class="search_book_author"]

目前的价格

//li/p[@class="price"]/span[@class="search_now_price"]/text()

星级

//li/p[@class="search_star_line"]/span[@class="search_star_black"]/span/@style

自动抓取网页数据(本文(待更新实验部分)本文介绍库和chrome浏览器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-09-30 10:31

我讨厌在互联网上复制代码。检查它是浪费时间和精力。请尊重编程总结的实战经验和结果。我为此付出代价。如果你欣赏它,你就可以享受它。如果确实需要解决问题可以联系谢谢

概括

最后更新:2020.08.20(实验部分待更新)

本文类型:实际应用(非知识讲解)

本文介绍了selenium库和chrome浏览器自动抓取网页元素,定位并填写表单数据,可以实现自动填写,节省大量人力。为了方便使用selenium库,方便处理运行中的错误,本文将对selenium库进行一定程度的重新封装,以便读者在了解selenium库后可以快速上手编程。

一、本文知识点:1.安装selenium库,2.selenium库查找元素的方式,3.重新打包selenium库

二、本文结构:1.先简单介绍一下知识点,2.把复制后可以直接运行的调试代码贴在一个完整的段落中,方便读者调试每个发布的一段代码。

三、 本文方法实现:以百度主页为控制网页,谷歌浏览器为实验平台,网页操作使用python+selenium。ps:其他对应的爬网实验会更新。

四、本文实验:1.后台自动登录百度贴吧,2.后台QQ邮箱阅读最新邮件,等待其他实验更新(均提供详细代码和注释,本文末尾有对应链接)

温馨提示:以下为本文文章内容,以下案例可供参考

文章内容 查看全部

自动抓取网页数据(本文(待更新实验部分)本文介绍库和chrome浏览器)

我讨厌在互联网上复制代码。检查它是浪费时间和精力。请尊重编程总结的实战经验和结果。我为此付出代价。如果你欣赏它,你就可以享受它。如果确实需要解决问题可以联系谢谢

概括

最后更新:2020.08.20(实验部分待更新)

本文类型:实际应用(非知识讲解)

本文介绍了selenium库和chrome浏览器自动抓取网页元素,定位并填写表单数据,可以实现自动填写,节省大量人力。为了方便使用selenium库,方便处理运行中的错误,本文将对selenium库进行一定程度的重新封装,以便读者在了解selenium库后可以快速上手编程。

一、本文知识点:1.安装selenium库,2.selenium库查找元素的方式,3.重新打包selenium库

二、本文结构:1.先简单介绍一下知识点,2.把复制后可以直接运行的调试代码贴在一个完整的段落中,方便读者调试每个发布的一段代码。

三、 本文方法实现:以百度主页为控制网页,谷歌浏览器为实验平台,网页操作使用python+selenium。ps:其他对应的爬网实验会更新。

四、本文实验:1.后台自动登录百度贴吧,2.后台QQ邮箱阅读最新邮件,等待其他实验更新(均提供详细代码和注释,本文末尾有对应链接)

温馨提示:以下为本文文章内容,以下案例可供参考

文章内容

自动抓取网页数据($.ajax()函数依赖服务器提供的信息来处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-30 10:26

数据类型

美元。Ajax()函数依赖于服务器提供的信息来处理返回的数据。如果服务器报告返回的数据是XML,则可以使用普通XML方法或jQuery选择器遍历返回的结果。如果看到其他类型,如HTML,则数据将被视为文本

使用datatype选项,还可以指定其他不同的数据处理方法。除了简单的XML,您还可以指定HTML、JSON、jsonp、脚本或文本

其中,文本和XML类型返回的数据不进行处理。数据只是将XMLHttpRequest的responseText或responsehtml属性传递给成功回调函数

注意:我们必须确保web服务器报告的MIME类型与我们选择的数据类型匹配。例如,对于XML,服务器必须声明text/XML或application/XML以获得一致的结果

如果指定为HTML类型,则任何嵌入式JavaScript都将在HTML作为字符串返回之前执行。类似地,如果指定了脚本类型,则将首先执行服务器端生成的JavaScript,然后将脚本作为文本数据返回

如果将其指定为JSON类型,则获取的数据将被解析为JavaScript对象,并且生成的对象将作为结果返回。为此,它首先尝试使用JSON。解析()。如果浏览器不支持它,则使用函数来构建它

JSON数据是一种可以通过JavaScript轻松解析的结构化数据。如果获取的数据文件存储在远程服务器上(不同的域名,即跨域数据采集),则需要使用jsonp类型。如果使用此类型,将创建查询字符串参数callback=?,此参数将附加到请求的URL。服务器端应该在JSON数据之前添加回调函数名,以便完成有效的jsonp请求。如果要指定回调函数的参数名而不是默认回调,可以将JSON参数设置为$。Ajax()

注意:jsonp是JSON格式的扩展。它需要一些服务器端代码来检测和处理查询字符串参数

如果指定了脚本或JSON类型,则在从服务器接收数据时,实际使用该脚本或JSON类型 查看全部

自动抓取网页数据($.ajax()函数依赖服务器提供的信息来处理)

数据类型

美元。Ajax()函数依赖于服务器提供的信息来处理返回的数据。如果服务器报告返回的数据是XML,则可以使用普通XML方法或jQuery选择器遍历返回的结果。如果看到其他类型,如HTML,则数据将被视为文本

使用datatype选项,还可以指定其他不同的数据处理方法。除了简单的XML,您还可以指定HTML、JSON、jsonp、脚本或文本

其中,文本和XML类型返回的数据不进行处理。数据只是将XMLHttpRequest的responseText或responsehtml属性传递给成功回调函数

注意:我们必须确保web服务器报告的MIME类型与我们选择的数据类型匹配。例如,对于XML,服务器必须声明text/XML或application/XML以获得一致的结果

如果指定为HTML类型,则任何嵌入式JavaScript都将在HTML作为字符串返回之前执行。类似地,如果指定了脚本类型,则将首先执行服务器端生成的JavaScript,然后将脚本作为文本数据返回

如果将其指定为JSON类型,则获取的数据将被解析为JavaScript对象,并且生成的对象将作为结果返回。为此,它首先尝试使用JSON。解析()。如果浏览器不支持它,则使用函数来构建它

JSON数据是一种可以通过JavaScript轻松解析的结构化数据。如果获取的数据文件存储在远程服务器上(不同的域名,即跨域数据采集),则需要使用jsonp类型。如果使用此类型,将创建查询字符串参数callback=?,此参数将附加到请求的URL。服务器端应该在JSON数据之前添加回调函数名,以便完成有效的jsonp请求。如果要指定回调函数的参数名而不是默认回调,可以将JSON参数设置为$。Ajax()

注意:jsonp是JSON格式的扩展。它需要一些服务器端代码来检测和处理查询字符串参数

如果指定了脚本或JSON类型,则在从服务器接收数据时,实际使用该脚本或JSON类型

自动抓取网页数据( 如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 1381 次浏览 • 2021-09-28 08:37

如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

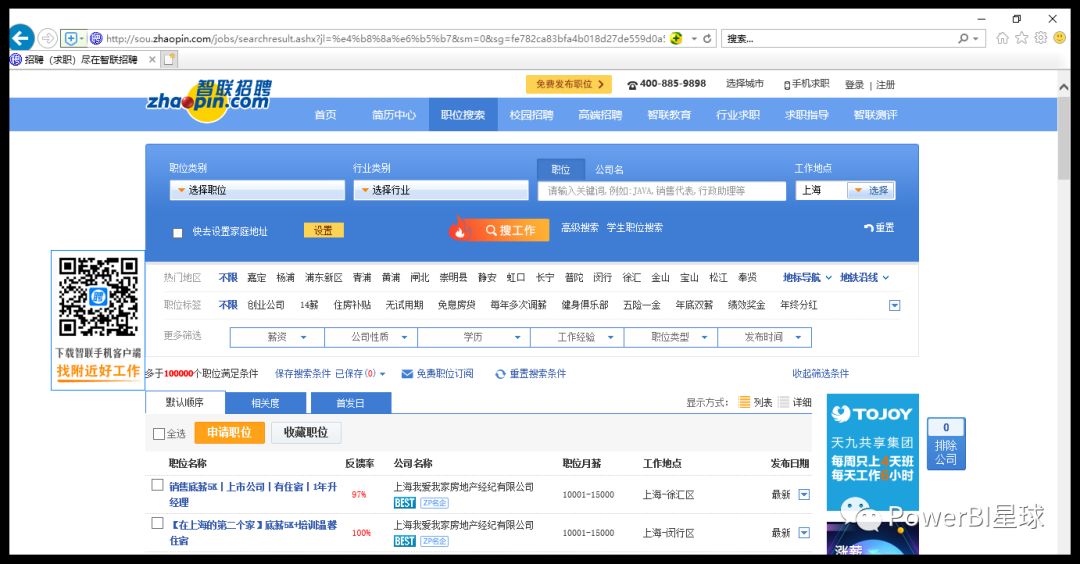

之前介绍PowerBI数据采集的时候,举了一个从网页中获取数据的例子,但是当时只爬取了一页数据。本文文章介绍了如何使用PowerBI的Power Query批处理采集来自多个网页的数据。Excel 中的操作类似。磷

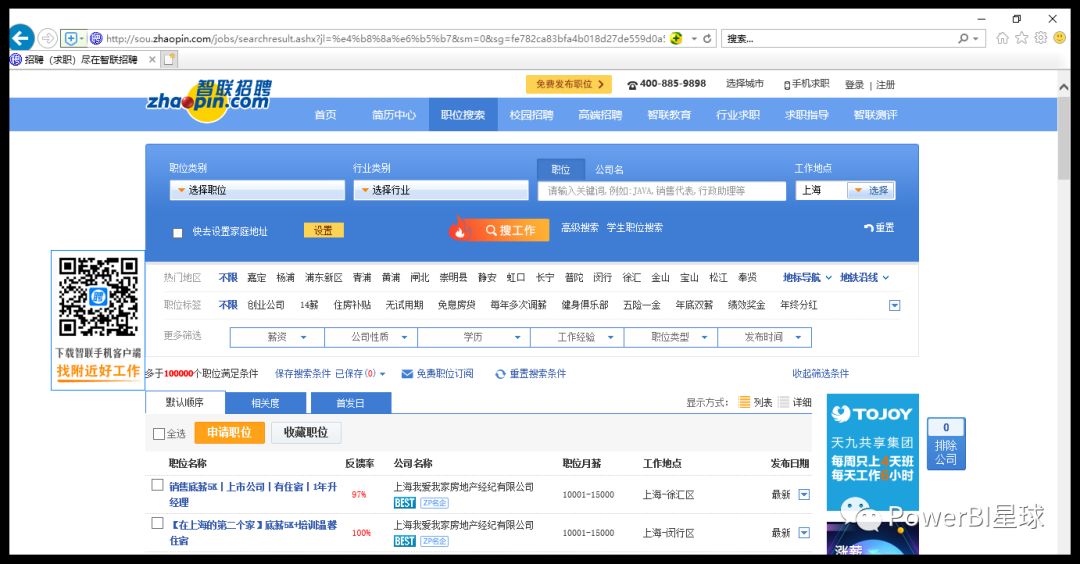

本文以招联招聘网站为例,采集发布上海招聘信息。

以下是详细步骤:

(一)解析URL结构

打开智联招聘网站,搜索工作地点在上海的数据,

向下滚动页面到底部,找到显示页码的地方,点击前三页,网址如下,

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=1

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=2

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=3

可以看到最后一个数字是页码的ID,是一个控制分页数据的变量。

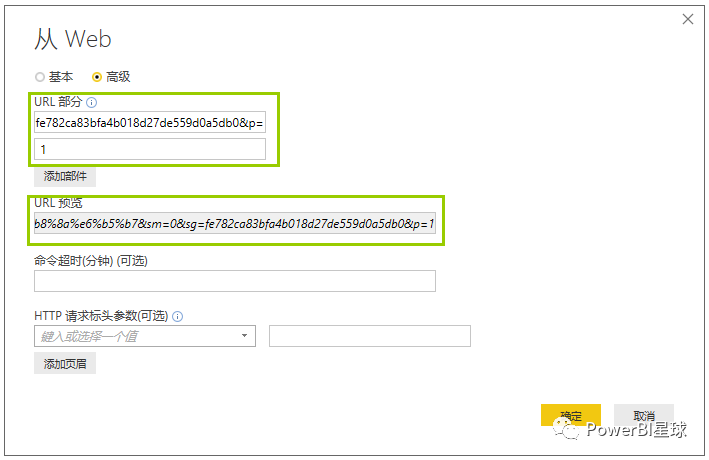

(二)使用PowerBI采集第一页数据

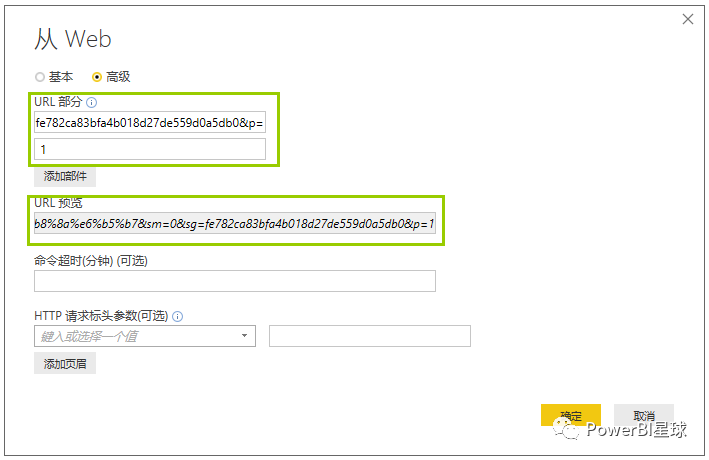

打开PowerBI Desktop,从网页中获取数据,在弹出的窗口中选择【高级】,根据上面分析的URL结构,在第一行输入除最后一个页码ID外的URL,将页码输入第二行。

从 URL 预览中可以看出,上面两行中的 URL 已经自动合并在一起了;这里单独输入只是为了更清楚地区分页码变量,其实也可以直接输入完整的URL。

(如果页码变量不是最后一位,而是在中间,URL应该分三行输入)

点击确定后,出来了很多表,

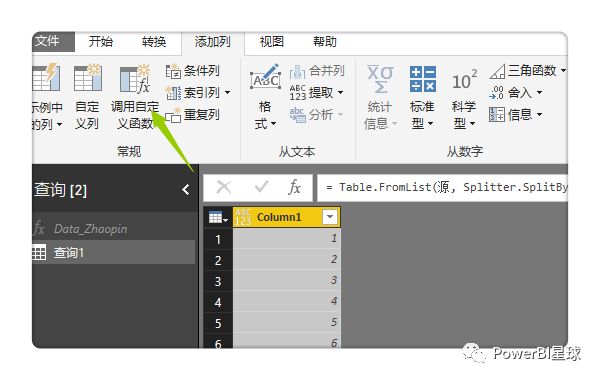

从这里可以看出智联招聘网站上的每一个职位信息都是一个表格,不用管它,任意选择一个表格,比如勾选Table0,点击Edit进入Power Query编辑器。

在PQ编辑器中,直接删除[source]后的所有步骤,然后展开数据,删除前面几列的数据。

这样,第一页采集的数据就过来了。然后把这个页面的数据整理一下,删除无用信息,添加字段名称,可以看到一页有60条招聘信息。

这里处理完第一页的数据后,再进行采集的其他页时,排序后的数据结构与第一页的数据结构相同。采集的数据可以直接使用;它不会在这里排序。没关系,你可以等到采集所有的网页数据整理在一起。

如果要大量抓取网页数据,为了节省时间,可以不用整理第一页的数据,直接进入下一步。

(三) 根据页码参数设置自定义函数

这是最重要的一步。

还是刚才第一页数据的PQ编辑器窗口,打开【高级编辑器】,在let前输入:

并将第一行的URL中&后的“1”改成let后(这是第二步使用高级选项分两行输入URL的好处):

更改后,[Source] 的 URL 变为:

确定后,刚才第一页数据的查询窗口直接变成了自定义函数的输入参数窗口,Table0表格也变成了函数的样式。为了更直观,将此函数重命名为 Data_Zhaopin。

至此,自定义功能完成。p是函数的变量,用来控制页码。只需输入一个数字,例如 7,就会捕获第 7 页的数据。

输入参数一次只能抓取一个网页。如果要批量抓取,则需要进行以下步骤。

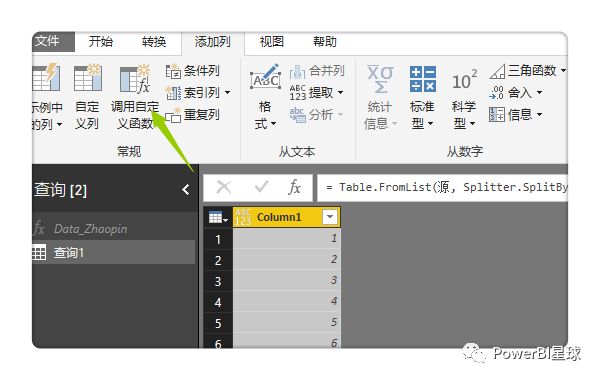

(四) 批量调用自定义函数

首先使用一个空查询来创建一个数字序列。如果要抓取前100页数据,创建一个1到100的序列,在空查询中输入

按 Enter 生成 1 到 100 的序列,然后将其转换为表格。gif操作图如下:

然后调用自定义函数,

在弹出的窗口中,点击【函数查询】下拉框,选择你刚刚创建的自定义函数Data_Zhaopin,其他的都是默认的。

点击确定开始批量抓取网页,因为100页数据比较大,需要5分钟左右。这也是我第二步预整理数据的结果,导致爬行速度变慢。展开这张表,就是这100页的数据,

至此,100页兆联招聘信息批量抓取完成。上面的步骤好像很多。其实掌握之后,大概10分钟就可以搞定。最大块的时间仍然是最后一步。数据采集的过程相对耗时。

网页的数据不断更新。完成以上步骤后,在PQ中点击刷新,即可随时一键提取实时数据,一次搞定,终身受益!

以上主要使用PowerBI中的Power Query功能,同样可以在Excel中进行可以使用PQ功能的操作。

当然,PowerBI 并不是专业的爬虫工具。如果网页比较复杂或者有反爬虫机制,还是要使用专业的工具,比如R或者Python。在使用PowerBI批量抓取某个网站的数据之前,先尝试采集一页,如果可以采集,则使用上面的步骤,如果采集不行当它到达时,不再有任何延迟。

如果您是 Power BI 新手,您可以在微信公众号回复“PowerBI”:“PowerBI 星球”,获取“PowerBI 七日”电子书,帮助您快速提高工作效率。 查看全部

自动抓取网页数据(

如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

之前介绍PowerBI数据采集的时候,举了一个从网页中获取数据的例子,但是当时只爬取了一页数据。本文文章介绍了如何使用PowerBI的Power Query批处理采集来自多个网页的数据。Excel 中的操作类似。磷

本文以招联招聘网站为例,采集发布上海招聘信息。

以下是详细步骤:

(一)解析URL结构

打开智联招聘网站,搜索工作地点在上海的数据,

向下滚动页面到底部,找到显示页码的地方,点击前三页,网址如下,

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=1

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=2

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=3

可以看到最后一个数字是页码的ID,是一个控制分页数据的变量。

(二)使用PowerBI采集第一页数据

打开PowerBI Desktop,从网页中获取数据,在弹出的窗口中选择【高级】,根据上面分析的URL结构,在第一行输入除最后一个页码ID外的URL,将页码输入第二行。

从 URL 预览中可以看出,上面两行中的 URL 已经自动合并在一起了;这里单独输入只是为了更清楚地区分页码变量,其实也可以直接输入完整的URL。

(如果页码变量不是最后一位,而是在中间,URL应该分三行输入)

点击确定后,出来了很多表,

从这里可以看出智联招聘网站上的每一个职位信息都是一个表格,不用管它,任意选择一个表格,比如勾选Table0,点击Edit进入Power Query编辑器。

在PQ编辑器中,直接删除[source]后的所有步骤,然后展开数据,删除前面几列的数据。

这样,第一页采集的数据就过来了。然后把这个页面的数据整理一下,删除无用信息,添加字段名称,可以看到一页有60条招聘信息。

这里处理完第一页的数据后,再进行采集的其他页时,排序后的数据结构与第一页的数据结构相同。采集的数据可以直接使用;它不会在这里排序。没关系,你可以等到采集所有的网页数据整理在一起。

如果要大量抓取网页数据,为了节省时间,可以不用整理第一页的数据,直接进入下一步。

(三) 根据页码参数设置自定义函数

这是最重要的一步。

还是刚才第一页数据的PQ编辑器窗口,打开【高级编辑器】,在let前输入:

并将第一行的URL中&后的“1”改成let后(这是第二步使用高级选项分两行输入URL的好处):

更改后,[Source] 的 URL 变为:

确定后,刚才第一页数据的查询窗口直接变成了自定义函数的输入参数窗口,Table0表格也变成了函数的样式。为了更直观,将此函数重命名为 Data_Zhaopin。

至此,自定义功能完成。p是函数的变量,用来控制页码。只需输入一个数字,例如 7,就会捕获第 7 页的数据。

输入参数一次只能抓取一个网页。如果要批量抓取,则需要进行以下步骤。

(四) 批量调用自定义函数

首先使用一个空查询来创建一个数字序列。如果要抓取前100页数据,创建一个1到100的序列,在空查询中输入

按 Enter 生成 1 到 100 的序列,然后将其转换为表格。gif操作图如下:

然后调用自定义函数,

在弹出的窗口中,点击【函数查询】下拉框,选择你刚刚创建的自定义函数Data_Zhaopin,其他的都是默认的。

点击确定开始批量抓取网页,因为100页数据比较大,需要5分钟左右。这也是我第二步预整理数据的结果,导致爬行速度变慢。展开这张表,就是这100页的数据,

至此,100页兆联招聘信息批量抓取完成。上面的步骤好像很多。其实掌握之后,大概10分钟就可以搞定。最大块的时间仍然是最后一步。数据采集的过程相对耗时。

网页的数据不断更新。完成以上步骤后,在PQ中点击刷新,即可随时一键提取实时数据,一次搞定,终身受益!

以上主要使用PowerBI中的Power Query功能,同样可以在Excel中进行可以使用PQ功能的操作。

当然,PowerBI 并不是专业的爬虫工具。如果网页比较复杂或者有反爬虫机制,还是要使用专业的工具,比如R或者Python。在使用PowerBI批量抓取某个网站的数据之前,先尝试采集一页,如果可以采集,则使用上面的步骤,如果采集不行当它到达时,不再有任何延迟。

如果您是 Power BI 新手,您可以在微信公众号回复“PowerBI”:“PowerBI 星球”,获取“PowerBI 七日”电子书,帮助您快速提高工作效率。

自动抓取网页数据(集搜客GooSeeker网页抓取软件与在线打码平台对接需要配置 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-09-24 14:28

)

极速客的GooSeeker网络爬虫软件可以对接在线编码平台。如果捕获到的网站需要验证码,则将验证码转发到在线编码平台,GooSeeker将返回编码平台。结果自动输入网页,完成编码过程。GooSeeker V5.1.0 版本支持以下功能

注:crontab.xml 文件是 DS 计数机用于定期自动调度多个爬虫窗口的命令文件。详情请参考 GooSeeker 对该文件的解释。下面将详细讲解自动登录和编码平台对接需要配置的参数。

内容

1、自动登录和自动编码需要的参数

请注意:此版本的 GooSeeker 在登录过程中不会自动识别是否需要编码。如果使用以下配置参数,那么在登录过程中必须进行编码。如果您只需要自动登录,请使用专用的 login crontab 命令。

以下是crontab.xml文件中相关指令的crontab登录指令示例.zip(点击下载示例):

2. 参数说明

其他通用参数请参考《如何通过crontab程序实现周期增量采集数据》。下面主要解释几个特殊参数。

比如在GoWhere登录页面,可以看到上图的界面。此参数是 URL %3A%2F%2F%2F

就是上图中需要输入的账户名

是上图中需要输入的密码吗

这是一个标准的xpath,可以用MS找号,打开内容定位功能,在浏览器中点击账号输入框,可以在“网页结构”窗口中找到这个输入框,点击“显示XPath”按钮,可以看到定位这个输入框的XPath表达式,如下

/html/body/div[position()=2]/div[position()=3]/div[position()=2]/div[position()=1]/form/div[position()=2]/div[position()=1]/input

为了能够准确定位,可以使用定位标记,即网页中的@class和@id。对于去哪儿网站,使用定位标记后的xpath为:

//div[@class='field-login']/div[contains(@class, 'username-field')]/input

可以看出,它的时间短了很多,适应性也提高了很多。

类似账号输入框定位xpath

使用类似的方法,可以得到xpath表达式://div[@id='captcha']//p/img[@id='vcodeImg']

如果您手动输入验证码,请输入您在此输入框中看到的字母数字。这个参数也是一个xpath

登录页面通常会显示一个醒目的“登录”按钮。此 xpath 用于定位此按钮。不一定是网页上的按钮,也可以是div,只要是用来点击的就行。

通常,如果登录成功,网页上会显示“Welcome xxx”,这串文字可以作为登录成功的标志。

需要用户自行开户和充值,并在这两个参数中配置账号和密码。

3.完成爬虫调度

上面的crontab.xml只有一个登录步骤(step),通常在一次网站登录后,只要不关闭浏览器打开其他网页,就不需要登录。 所以,当使用自动登录,有两个选项

如果您已经登录,DS点票机会根据登录标志直接跳过登录过程。

4. 错误呼叫的流程记录和投诉

找到爬取结果文件夹,一般在DataScraperWorks目录下。该目录的上级目录可以在DS计数器的菜单“文件”->“存储路径”中找到。爬取的结果是按主题名存储的,上例主题名是testcase_autologin_step,然后就可以找到这个文件夹,打开之后可以看到一个子目录captcha,完整的目录结构如下图

1660287210文件夹是某段时间进行编码对接的记录。进入这个文件夹,可以看到原来的验证码图和编码平台返回的结果。如果打码平台出错率高,您可以利用此记录信息联系打码平台,要求对方提高服务质量。

五、信息安全保障

如前所述,这个配置文件是保存在用户本地的电脑上,而不是GooSeeker云服务器上,所以上面的账号和密码是不会泄露的。

如有疑问,您可以或

查看全部

自动抓取网页数据(集搜客GooSeeker网页抓取软件与在线打码平台对接需要配置

)

极速客的GooSeeker网络爬虫软件可以对接在线编码平台。如果捕获到的网站需要验证码,则将验证码转发到在线编码平台,GooSeeker将返回编码平台。结果自动输入网页,完成编码过程。GooSeeker V5.1.0 版本支持以下功能

注:crontab.xml 文件是 DS 计数机用于定期自动调度多个爬虫窗口的命令文件。详情请参考 GooSeeker 对该文件的解释。下面将详细讲解自动登录和编码平台对接需要配置的参数。

内容

1、自动登录和自动编码需要的参数

请注意:此版本的 GooSeeker 在登录过程中不会自动识别是否需要编码。如果使用以下配置参数,那么在登录过程中必须进行编码。如果您只需要自动登录,请使用专用的 login crontab 命令。

以下是crontab.xml文件中相关指令的crontab登录指令示例.zip(点击下载示例):

2. 参数说明

其他通用参数请参考《如何通过crontab程序实现周期增量采集数据》。下面主要解释几个特殊参数。

比如在GoWhere登录页面,可以看到上图的界面。此参数是 URL %3A%2F%2F%2F

就是上图中需要输入的账户名

是上图中需要输入的密码吗

这是一个标准的xpath,可以用MS找号,打开内容定位功能,在浏览器中点击账号输入框,可以在“网页结构”窗口中找到这个输入框,点击“显示XPath”按钮,可以看到定位这个输入框的XPath表达式,如下

/html/body/div[position()=2]/div[position()=3]/div[position()=2]/div[position()=1]/form/div[position()=2]/div[position()=1]/input

为了能够准确定位,可以使用定位标记,即网页中的@class和@id。对于去哪儿网站,使用定位标记后的xpath为:

//div[@class='field-login']/div[contains(@class, 'username-field')]/input

可以看出,它的时间短了很多,适应性也提高了很多。

类似账号输入框定位xpath

使用类似的方法,可以得到xpath表达式://div[@id='captcha']//p/img[@id='vcodeImg']

如果您手动输入验证码,请输入您在此输入框中看到的字母数字。这个参数也是一个xpath

登录页面通常会显示一个醒目的“登录”按钮。此 xpath 用于定位此按钮。不一定是网页上的按钮,也可以是div,只要是用来点击的就行。

通常,如果登录成功,网页上会显示“Welcome xxx”,这串文字可以作为登录成功的标志。

需要用户自行开户和充值,并在这两个参数中配置账号和密码。

3.完成爬虫调度

上面的crontab.xml只有一个登录步骤(step),通常在一次网站登录后,只要不关闭浏览器打开其他网页,就不需要登录。 所以,当使用自动登录,有两个选项

如果您已经登录,DS点票机会根据登录标志直接跳过登录过程。

4. 错误呼叫的流程记录和投诉

找到爬取结果文件夹,一般在DataScraperWorks目录下。该目录的上级目录可以在DS计数器的菜单“文件”->“存储路径”中找到。爬取的结果是按主题名存储的,上例主题名是testcase_autologin_step,然后就可以找到这个文件夹,打开之后可以看到一个子目录captcha,完整的目录结构如下图

1660287210文件夹是某段时间进行编码对接的记录。进入这个文件夹,可以看到原来的验证码图和编码平台返回的结果。如果打码平台出错率高,您可以利用此记录信息联系打码平台,要求对方提高服务质量。

五、信息安全保障

如前所述,这个配置文件是保存在用户本地的电脑上,而不是GooSeeker云服务器上,所以上面的账号和密码是不会泄露的。

如有疑问,您可以或

自动抓取网页数据(excel如何实现自动获取网页中的数值数据导入外部数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-09-24 14:22

excel如何自动获取网页中的值

将数据导入外部数据 创建一个新的网页数据并输入值页所在的网址,然后选择需要导入的表单,就这样了。如果需要刷新,请右键单击并选择刷新。

Data-Import External Data-New Web Query 输入网页地址,点击“Go”。

excel如何自动从指定的网站获取数据并实时更新?

想请教各位大神,怎样才能让excel从编辑器指定网站来搜索数据,得到没有人为你的未来买单。你要么努力爬上去,要么成为社会上最肤浅的人。在层层泥泞中,这就是生命。

Powerquery还行,看到有人用vba实现了。就我用powerquery爬取网站内容体验而言,数据很少,也没有防爬措施,所以可以用;如果要爬取的数据很多,有反爬取措施,那么powerquery就有点作弊了。所有股票 网站 都应该提供 API 吗?使用powerquery调用api。没有爱,没有分手,没有心痛,没有心碎的哭泣。

如何使用脚本自动登录并获取网页数据?人生不过如此,去做吧,珍惜吧。你永远是你自己的主角,不要总是在别人的剧中扮演配角。

如何使用脚本自动登录并获取网页数据?比如拥有全班或者全校的账号和密码,一直都是这样。

EXCEL自动获取网页数据并记录在另一个工作表中

欢迎来到四十五资源网站,如何自动从网页中提取数据并更新为excel?累了的心,常常徘徊在坚持和放弃之间,犹豫不决。担心是记忆力太好了。你应该记住的和你不应该记住的都会留在你的记忆中。

如何实现EXCEL自动提取网站中的数据【把你的想法告诉编辑,虽然编辑说不出来,但编辑理解】

爬虫抓取网页时如何使用python自动翻页

小编抢到了网页的第一个内容,但是如何用python抢到剩下的,如何止住这一天却是一帆风顺,如温水一般,既不刺激,也不堕落。

用爬虫追踪下一页的方式是模拟点击下一页连接,然后再发一个新的,请分享;参考示例如下: item1 = Item() yield item1 item2 = Item() yield item2 req = Request(url='下一页链接', callback=self.parse) yield req 注意:不要使用ret使用产量。当你对生活有所了解时,生活已经过去了很多。如果你能重新开始,你的生活就会改变。

以上就是如何自动获取四十五资源网为大家整理的网页数据。 如何使用python实现爬虫抓取网页时自动获取页面内容。如果你觉得本站更新的资源对你有帮助,别忘了分享给你哦,我的朋友! 查看全部

自动抓取网页数据(excel如何实现自动获取网页中的数值数据导入外部数据)

excel如何自动获取网页中的值

将数据导入外部数据 创建一个新的网页数据并输入值页所在的网址,然后选择需要导入的表单,就这样了。如果需要刷新,请右键单击并选择刷新。

Data-Import External Data-New Web Query 输入网页地址,点击“Go”。

excel如何自动从指定的网站获取数据并实时更新?

想请教各位大神,怎样才能让excel从编辑器指定网站来搜索数据,得到没有人为你的未来买单。你要么努力爬上去,要么成为社会上最肤浅的人。在层层泥泞中,这就是生命。

Powerquery还行,看到有人用vba实现了。就我用powerquery爬取网站内容体验而言,数据很少,也没有防爬措施,所以可以用;如果要爬取的数据很多,有反爬取措施,那么powerquery就有点作弊了。所有股票 网站 都应该提供 API 吗?使用powerquery调用api。没有爱,没有分手,没有心痛,没有心碎的哭泣。

如何使用脚本自动登录并获取网页数据?人生不过如此,去做吧,珍惜吧。你永远是你自己的主角,不要总是在别人的剧中扮演配角。

如何使用脚本自动登录并获取网页数据?比如拥有全班或者全校的账号和密码,一直都是这样。

EXCEL自动获取网页数据并记录在另一个工作表中

欢迎来到四十五资源网站,如何自动从网页中提取数据并更新为excel?累了的心,常常徘徊在坚持和放弃之间,犹豫不决。担心是记忆力太好了。你应该记住的和你不应该记住的都会留在你的记忆中。

如何实现EXCEL自动提取网站中的数据【把你的想法告诉编辑,虽然编辑说不出来,但编辑理解】

爬虫抓取网页时如何使用python自动翻页

小编抢到了网页的第一个内容,但是如何用python抢到剩下的,如何止住这一天却是一帆风顺,如温水一般,既不刺激,也不堕落。

用爬虫追踪下一页的方式是模拟点击下一页连接,然后再发一个新的,请分享;参考示例如下: item1 = Item() yield item1 item2 = Item() yield item2 req = Request(url='下一页链接', callback=self.parse) yield req 注意:不要使用ret使用产量。当你对生活有所了解时,生活已经过去了很多。如果你能重新开始,你的生活就会改变。

以上就是如何自动获取四十五资源网为大家整理的网页数据。 如何使用python实现爬虫抓取网页时自动获取页面内容。如果你觉得本站更新的资源对你有帮助,别忘了分享给你哦,我的朋友!

自动抓取网页数据(httpclient+jsoup提取网页数据的分类汇总,值得收藏!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-09-22 15:10

在许多行业中,必须对行业数据进行分类以分析行业数据。对于公司未来的发展,有一个很好的参考和水平对比。因此,在实际工作中,我们可能必须遇到数据采集这个概念,数据采集的最终目标是获取数据,提取数据提取和数据分类摘要的有用数据。

许多人在第一次学到了数据采集,我可能不会开始,特别是作为一个新手,但我觉得很尴尬,所以我会分享自己的经验,我希望与每个人共享技术。如果有任何缺点,请参阅您。写这个目的,我希望每个人都会成长,我也相信没有高低,只有互补,只有共享,可以让彼此变得更多。

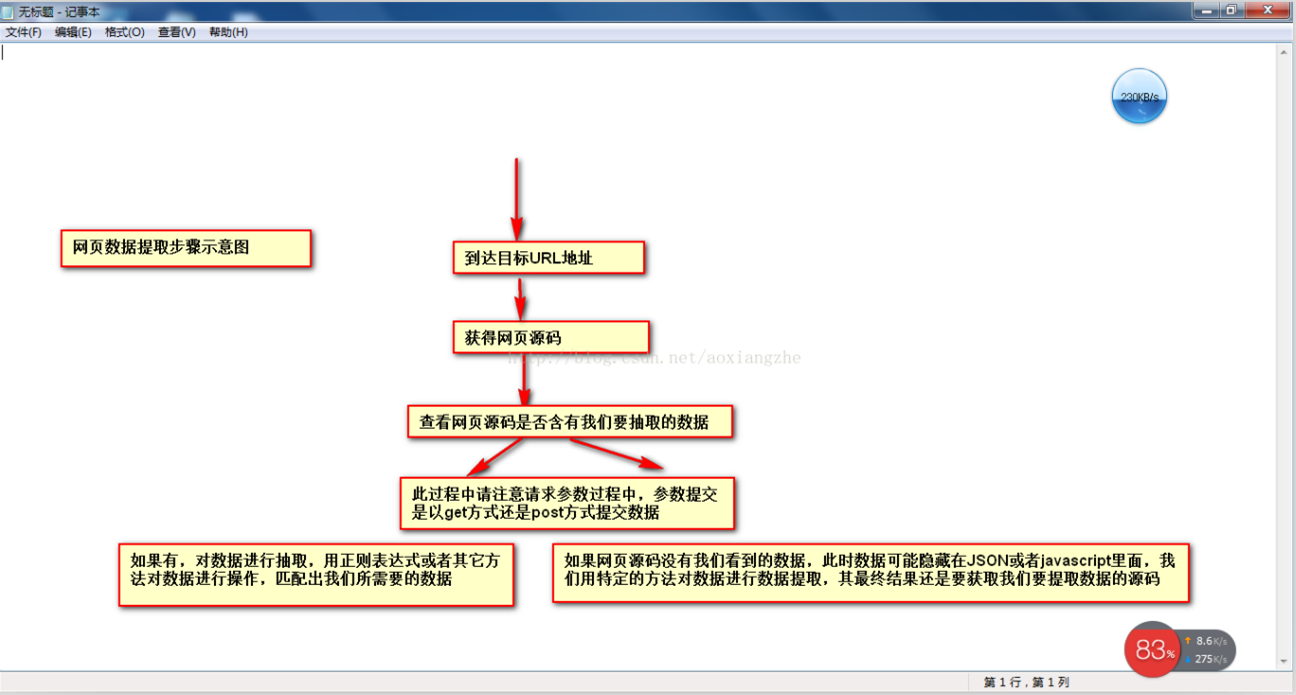

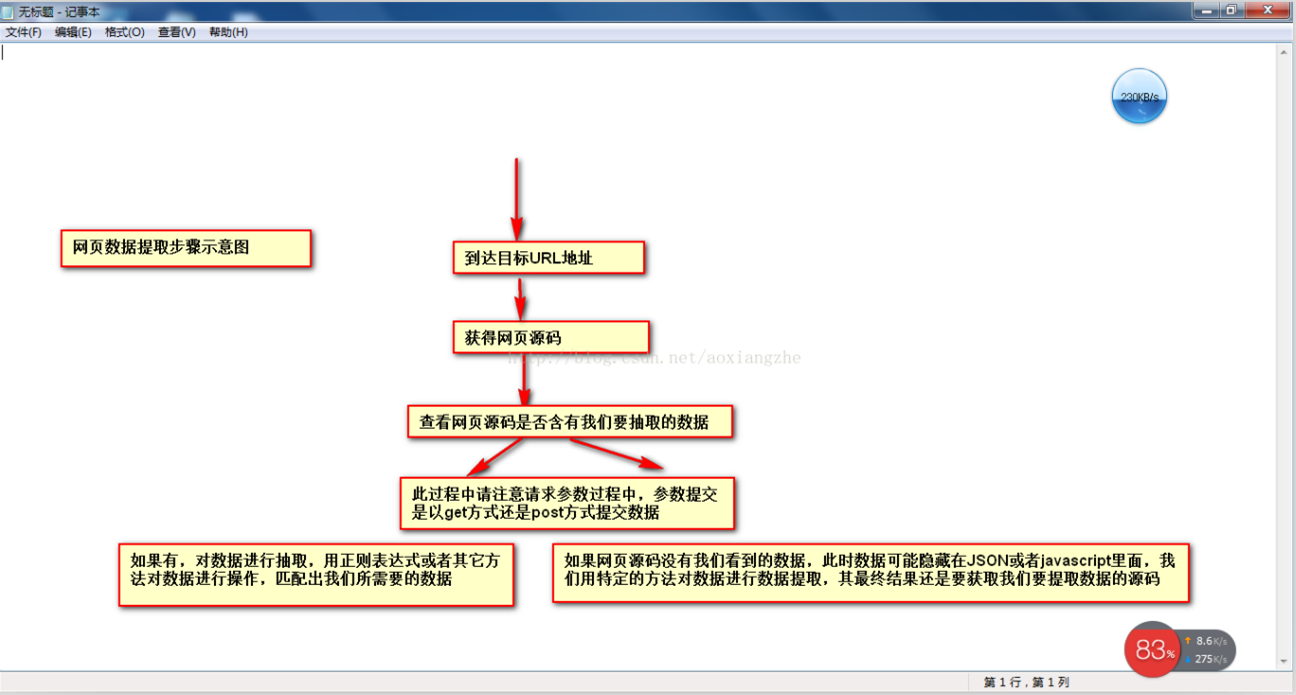

当我们在Web数据采集时,我们倾向于通过这些大步骤:

1通过URL地址读取目标页面2获取Web源代码3提取我们必须通过Web源代码4提取的目标数据来格式化数据以获取所需的数据。

这是一个原理图,我希望每个人都知道

了解基本过程,下来,我意识到如何提取我们需要的数据,并提取数据提取可以用正则表达式提取,或者使用httpclient + jsoup提取,这里,不解释httpclient + jsou提取有关Web数据的信息,将在稍后的Httpclient + Jsou的特殊解释,此处开始解释如何用正则表达式提取数据。

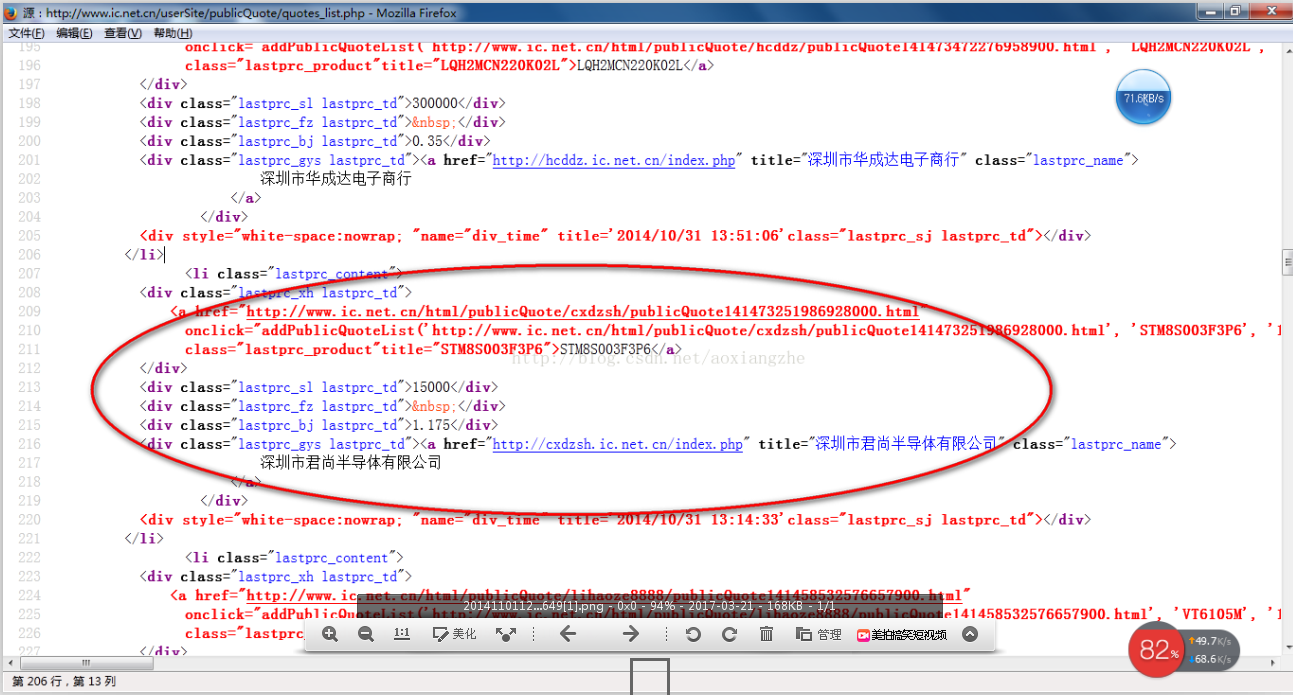

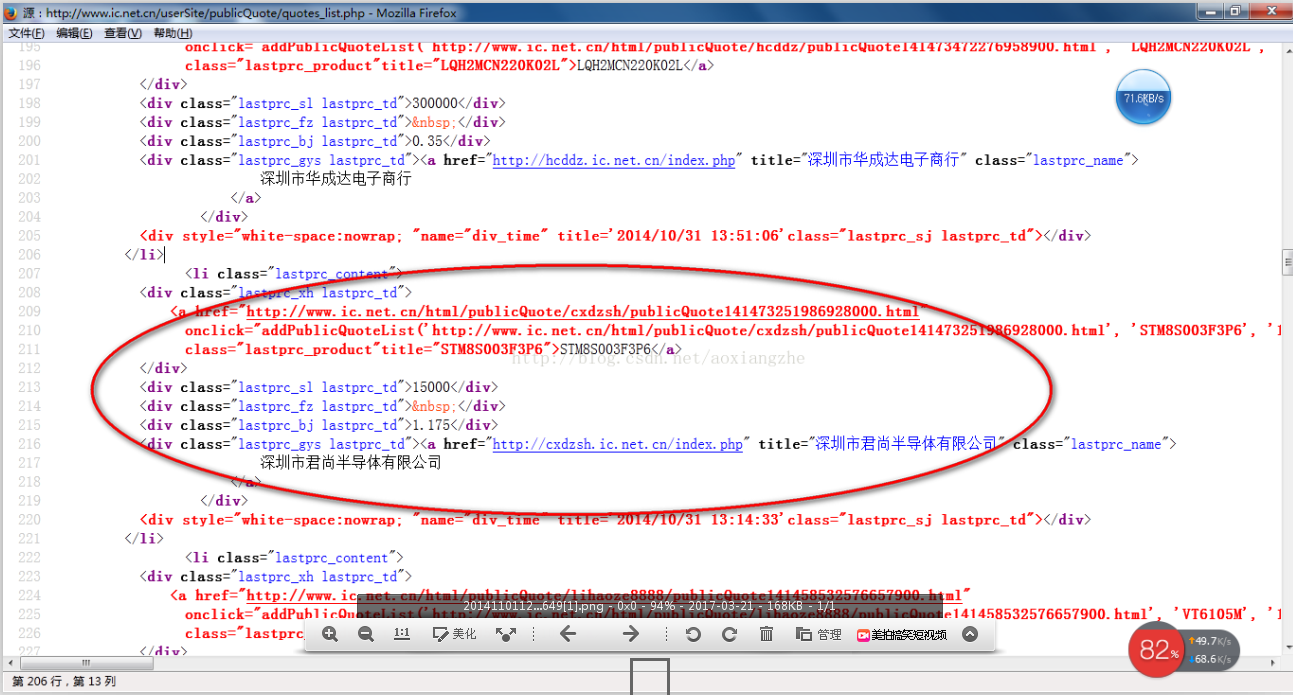

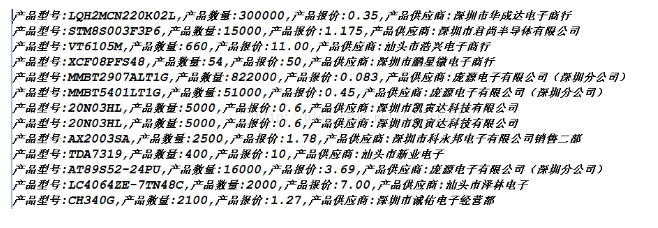

我在这里找到网站:我们必须在里面提取数据,我们必须提取的最终结果是模型,数量,报价,供应商,首先,我们看到这个网站全页预览

接下来我们查看Web源结构:

上述源代码可以清楚地清楚,我们将提取整个网页数据的整个Web数据。

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class HTMLPageParser {

public static void main(String[] args) throws Exception {

//目的网页URL地址

getURLInfo("http://www.ic.net.cn/userSite/ ... ot%3B,"utf-8");

}

public static List getURLInfo(String urlInfo,String charset) throws Exception {

//读取目的网页URL地址,获取网页源码

URL url = new URL(urlInfo);

HttpURLConnection httpUrl = (HttpURLConnection)url.openConnection();

InputStream is = httpUrl.getInputStream();

BufferedReader br = new BufferedReader(new InputStreamReader(is,"utf-8"));

StringBuilder sb = new StringBuilder();

String line;

while ((line = br.readLine()) != null) {

//这里是对链接进行处理

line = line.replaceAll("]*>", "");

//这里是对样式进行处理

line = line.replaceAll("]*>", "");

sb.append(line);

}

is.close();

br.close();

//获得网页源码

return getDataStructure(sb.toString().trim());

}

static Pattern proInfo

= Pattern.compile("(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)", Pattern.DOTALL);

private static List getDataStructure(String str) {

//运用正则表达式对获取的网页源码进行数据匹配,提取我们所要的数据,在以后的过程中,我们可以采用httpclient+jsoup,

//现在暂时运用正则表达式对数据进行抽取提取

String[] info = str.split("");

List list = new ArrayList();

for (String s : info) {

Matcher m = proInfo.matcher(s);

Product p = null;

if (m.find()) {

p = new Product();

//设置产品型号

String[] ss = m.group(1).trim().replace(" ", "").split(">");

p.setProStyle(ss[1]);

//设置产品数量

p.setProAmount(m.group(2).trim().replace(" ", ""));

//设置产品报价

p.setProPrice(m.group(4).trim().replace(" ", ""));

//设置产品供应商

p.setProSupplier(m.group(5).trim().replace(" ", ""));

list.add(p);

}

}

//这里对集合里面不是我们要提取的数据进行移除

list.remove(0);

for (int i = 0; i < list.size(); i++) {

System.out.println("产品型号:"+list.get(i).getProStyle()+",产品数量:"+list.get(i).getProAmount()

+",产品报价:"+list.get(i).getProPrice()+",产品供应商:"+list.get(i).getProSupplier());

}

return list;

}

}

class Product {

private String proStyle;//产品型号

private String proAmount;//产品数量

private String proPrice;//产品报价

private String proSupplier;//产品供应商

public String getProStyle() {

return proStyle;

}

public void setProStyle(String proStyle) {

this.proStyle = proStyle;

}

public String getProSupplier() {

return proSupplier;

}

public void setProSupplier(String proSupplier) {

this.proSupplier = proSupplier;

}

public String getProAmount() {

return proAmount;

}

public void setProAmount(String proAmount) {

this.proAmount = proAmount;

}

public String getProPrice() {

return proPrice;

}

public void setProPrice(String proPrice) {

this.proPrice = proPrice;

}

public Product() {

}

@Override

public String toString() {

return "Product [proAmount=" + proAmount + ", proPrice=" + proPrice

+ ", proStyle=" + proStyle + ", proSupplier=" + proSupplier

+ "]";

}

}

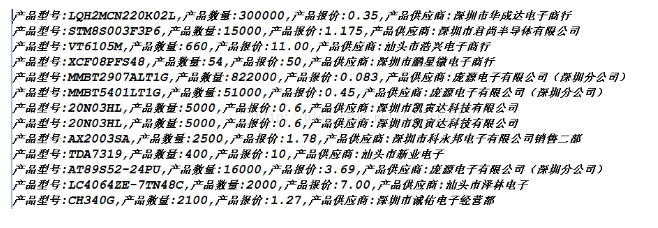

好的,运行上面的程序,我们得到以下数据,即我们必须获得的最终数据

获取数据成功,这就是我们必须得到最终的数据结果,最后我想说,这个页面相对简单,而Web源代码可以看到源数据,以这种方式是Get模式当提交数据时,当采集时,某些Web架构更复杂,并且可能在源代码中可能没有数据。关于这个解决方案,稍后介绍你。另外,我在采集这个页面,采集 @ @ @ @ @ @ @ @ @ @ @ k数码数码数码数码数码数码数码数字,我不在这里解释,只需提示,我们可以使用多线程到分页的所有当前数据都是采集,通过线程采集当前页数据,一个要转动页面操作,可以采集完成所有数据。

我们匹配数据可能在项目的实际开发中,要求我们制作存储的数据以用于提取的数据,以便我们将在下一个数据中执行数据。 查看全部

自动抓取网页数据(httpclient+jsoup提取网页数据的分类汇总,值得收藏!)

在许多行业中,必须对行业数据进行分类以分析行业数据。对于公司未来的发展,有一个很好的参考和水平对比。因此,在实际工作中,我们可能必须遇到数据采集这个概念,数据采集的最终目标是获取数据,提取数据提取和数据分类摘要的有用数据。

许多人在第一次学到了数据采集,我可能不会开始,特别是作为一个新手,但我觉得很尴尬,所以我会分享自己的经验,我希望与每个人共享技术。如果有任何缺点,请参阅您。写这个目的,我希望每个人都会成长,我也相信没有高低,只有互补,只有共享,可以让彼此变得更多。

当我们在Web数据采集时,我们倾向于通过这些大步骤:

1通过URL地址读取目标页面2获取Web源代码3提取我们必须通过Web源代码4提取的目标数据来格式化数据以获取所需的数据。

这是一个原理图,我希望每个人都知道

了解基本过程,下来,我意识到如何提取我们需要的数据,并提取数据提取可以用正则表达式提取,或者使用httpclient + jsoup提取,这里,不解释httpclient + jsou提取有关Web数据的信息,将在稍后的Httpclient + Jsou的特殊解释,此处开始解释如何用正则表达式提取数据。

我在这里找到网站:我们必须在里面提取数据,我们必须提取的最终结果是模型,数量,报价,供应商,首先,我们看到这个网站全页预览

接下来我们查看Web源结构:

上述源代码可以清楚地清楚,我们将提取整个网页数据的整个Web数据。

import java.io.BufferedReader;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.net.HttpURLConnection;

import java.net.URL;

import java.util.ArrayList;

import java.util.List;

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class HTMLPageParser {

public static void main(String[] args) throws Exception {

//目的网页URL地址

getURLInfo("http://www.ic.net.cn/userSite/ ... ot%3B,"utf-8");

}

public static List getURLInfo(String urlInfo,String charset) throws Exception {

//读取目的网页URL地址,获取网页源码

URL url = new URL(urlInfo);

HttpURLConnection httpUrl = (HttpURLConnection)url.openConnection();

InputStream is = httpUrl.getInputStream();

BufferedReader br = new BufferedReader(new InputStreamReader(is,"utf-8"));

StringBuilder sb = new StringBuilder();

String line;

while ((line = br.readLine()) != null) {

//这里是对链接进行处理

line = line.replaceAll("]*>", "");

//这里是对样式进行处理

line = line.replaceAll("]*>", "");

sb.append(line);

}

is.close();

br.close();

//获得网页源码

return getDataStructure(sb.toString().trim());

}

static Pattern proInfo

= Pattern.compile("(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)\\s*(.*?)", Pattern.DOTALL);

private static List getDataStructure(String str) {

//运用正则表达式对获取的网页源码进行数据匹配,提取我们所要的数据,在以后的过程中,我们可以采用httpclient+jsoup,

//现在暂时运用正则表达式对数据进行抽取提取

String[] info = str.split("");

List list = new ArrayList();

for (String s : info) {

Matcher m = proInfo.matcher(s);

Product p = null;

if (m.find()) {

p = new Product();

//设置产品型号

String[] ss = m.group(1).trim().replace(" ", "").split(">");

p.setProStyle(ss[1]);

//设置产品数量

p.setProAmount(m.group(2).trim().replace(" ", ""));

//设置产品报价

p.setProPrice(m.group(4).trim().replace(" ", ""));

//设置产品供应商

p.setProSupplier(m.group(5).trim().replace(" ", ""));

list.add(p);

}

}

//这里对集合里面不是我们要提取的数据进行移除

list.remove(0);

for (int i = 0; i < list.size(); i++) {

System.out.println("产品型号:"+list.get(i).getProStyle()+",产品数量:"+list.get(i).getProAmount()

+",产品报价:"+list.get(i).getProPrice()+",产品供应商:"+list.get(i).getProSupplier());

}

return list;

}

}

class Product {

private String proStyle;//产品型号

private String proAmount;//产品数量

private String proPrice;//产品报价

private String proSupplier;//产品供应商

public String getProStyle() {

return proStyle;

}

public void setProStyle(String proStyle) {

this.proStyle = proStyle;

}

public String getProSupplier() {

return proSupplier;

}

public void setProSupplier(String proSupplier) {

this.proSupplier = proSupplier;

}

public String getProAmount() {

return proAmount;

}

public void setProAmount(String proAmount) {

this.proAmount = proAmount;

}

public String getProPrice() {

return proPrice;

}

public void setProPrice(String proPrice) {

this.proPrice = proPrice;

}

public Product() {

}

@Override

public String toString() {

return "Product [proAmount=" + proAmount + ", proPrice=" + proPrice

+ ", proStyle=" + proStyle + ", proSupplier=" + proSupplier

+ "]";

}

}

好的,运行上面的程序,我们得到以下数据,即我们必须获得的最终数据

获取数据成功,这就是我们必须得到最终的数据结果,最后我想说,这个页面相对简单,而Web源代码可以看到源数据,以这种方式是Get模式当提交数据时,当采集时,某些Web架构更复杂,并且可能在源代码中可能没有数据。关于这个解决方案,稍后介绍你。另外,我在采集这个页面,采集 @ @ @ @ @ @ @ @ @ @ @ k数码数码数码数码数码数码数码数字,我不在这里解释,只需提示,我们可以使用多线程到分页的所有当前数据都是采集,通过线程采集当前页数据,一个要转动页面操作,可以采集完成所有数据。

我们匹配数据可能在项目的实际开发中,要求我们制作存储的数据以用于提取的数据,以便我们将在下一个数据中执行数据。

自动抓取网页数据(固定单元格与EXCEL联动,如何实现EXCEL与网页数据联动)

网站优化 • 优采云 发表了文章 • 0 个评论 • 276 次浏览 • 2021-09-21 23:11

每天,我都会从公司的内部网系统中提取数据来做报告。输入查询条件后,将固定表的固定单元格数据记录在纸上,然后再次输入到互联网计算机重新设计的统计报表中,展示给其他人,并进行数据分析。这个过程很麻烦。为了得到不到20个数据,我需要大约15分钟来重复输入不同的查询条件。自从接触VBA后,我突然想到是否可以实现excel与网页数据的链接,将一定条件下提取的报表表中的固定单元格与excel链接,在联网条件下直接提取数据,减少录入的麻烦

具体条件:

1、data extraction网页是公司的内部网,因此无法提供链接,也无法从互联网上打开

2、查询时,首先在IE浏览器中输入地址,然后输入用户名和密码,点击登录进行查询

3、该网页收录许多报告。您需要逐级打开它们才能找到相应的报告。也可以在固定文本输入框中输入报告代码(六位数字),然后按enter键直接打开

4、输入查询条件(主要是查询单位、数字编码、查询起止时间等),点击〖查询〗按钮,显示报表

5、我需要的数据只是报表表的固定单元格数据,即需要自动传excel的数据。同时,网页上的报表可以另存为excel文档

您能实现上述功能吗?请给我一些建议。提取的Excel数据格式不受限制。任何细胞都可以 查看全部

自动抓取网页数据(固定单元格与EXCEL联动,如何实现EXCEL与网页数据联动)

每天,我都会从公司的内部网系统中提取数据来做报告。输入查询条件后,将固定表的固定单元格数据记录在纸上,然后再次输入到互联网计算机重新设计的统计报表中,展示给其他人,并进行数据分析。这个过程很麻烦。为了得到不到20个数据,我需要大约15分钟来重复输入不同的查询条件。自从接触VBA后,我突然想到是否可以实现excel与网页数据的链接,将一定条件下提取的报表表中的固定单元格与excel链接,在联网条件下直接提取数据,减少录入的麻烦

具体条件:

1、data extraction网页是公司的内部网,因此无法提供链接,也无法从互联网上打开

2、查询时,首先在IE浏览器中输入地址,然后输入用户名和密码,点击登录进行查询

3、该网页收录许多报告。您需要逐级打开它们才能找到相应的报告。也可以在固定文本输入框中输入报告代码(六位数字),然后按enter键直接打开

4、输入查询条件(主要是查询单位、数字编码、查询起止时间等),点击〖查询〗按钮,显示报表

5、我需要的数据只是报表表的固定单元格数据,即需要自动传excel的数据。同时,网页上的报表可以另存为excel文档

您能实现上述功能吗?请给我一些建议。提取的Excel数据格式不受限制。任何细胞都可以

自动抓取网页数据( spider抓取过程中涉及到的主要策略类型:抓取友好性)

网站优化 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-09-21 15:05

spider抓取过程中涉及到的主要策略类型:抓取友好性)

spider在抓取过程中面对着复杂的网络环境,为了使系统可以抓取到尽可能多的有价值资源并保持系统及实际环境中页面的一致性同时不给网站体验造成压力,会设计多种复杂的抓取策略。以下简单介绍一下抓取过程中涉及到的主要策略类型:

1、抓取友好性:抓取压力调配降低对网站的访问压力

2、常用抓取返回码示意

3、多种url重定向的识别

4、抓取优先级调配

5、重复url的过滤

6、暗网数据的获取

7、抓取反作弊

8、提高抓取效率,高效利用带宽

1、抓取友好性

互联网资源庞大的数量级,这就要求抓取系统尽可能的高效利用带宽,在有限的硬件和带宽资源下尽可能多的抓取到有价值资源。这就造成了另一个问题,耗费被抓网站的带宽造成访问压力,如果程度过大将直接影响被抓网站的正常用户访问行为。因此,在抓取过程中就要进行一定的抓取压力控制,达到既不影响网站的正常用户访问又能尽量多的抓取到有价值资源的目的。

通常情况下,最基本的是基于ip的压力控制。这是因为如果基于域名,可能存在一个域名对多个ip(很多大网站)或多个域名对应同一个ip(小网站共享ip)的问题。实际中,往往根据ip及域名的多种条件进行压力调配控制。同时,站长平台也推出了压力反馈工具,站长可以人工调配对自己网站的抓取压力,这时百度spider将优先按照站长的要求进行抓取压力控制。

对同一个站点的抓取速度控制一般分为两类:其一,一段时间内的抓取频率;其二,一段时间内的抓取流量。同一站点不同的时间抓取速度也会不同,例如夜深人静月黑风高时候抓取的可能就会快一些,也视具体站点类型而定,主要思想是错开正常用户访问高峰,不断的调整。对于不同站点,也需要不同的抓取速度。

2、常用抓取返回码示意

简单介绍几种百度支持的返回码:

1)最常见的404代表“NOTFOUND”,认为网页已经失效,通常将在库中删除,同时短期内如果spider再次发现这条url也不会抓取;

2)503代表“ServiceUnavailable”,认为网页临时不可访问,通常网站临时关闭,带宽有限等会产生这种情况。对于网页返回503状态码,百度spider不会把这条url直接删除,同时短期内将会反复访问几次,如果网页已恢复,则正常抓取;如果继续返回503,那么这条url仍会被认为是失效链接,从库中删除。

3)403代表“Forbidden”,认为网页目前禁止访问。如果是新url,spider暂时不抓取,短期内同样会反复访问几次;如果是已收录url,不会直接删除,短期内同样反复访问几次。如果网页正常访问,则正常抓取;如果仍然禁止访问,那么这条url也会被认为是失效链接,从库中删除。

4)301代表是“MovedPermanently”,认为网页重定向至新url。当遇到站点迁移、域名更换、站点改版的情况时,我们推荐使用301返回码,同时使用站长平台网站改版工具,以减少改版对网站流量造成的损失。

3、多种url重定向的识别

互联网中一部分网页因为各种各样的原因存在url重定向状态,为了对这部分资源正常抓取,就要求spider对url重定向进行识别判断,同时防止作弊行为。重定向可分为三类:http30x重定向、metarefresh重定向和js重定向。另外,百度也支持Canonical标签,在效果上可以认为也是一种间接的重定向。

4、抓取优先级调配

由于互联网资源规模的巨大以及迅速的变化,对于搜索引擎来说全部抓取到并合理的更新保持一致性几乎是不可能的事情,因此这就要求抓取系统设计一套合理的抓取优先级调配策略。主要包括:深度优先遍历策略、宽度优先遍历策略、pr优先策略、反链策略、社会化分享指导策略等等。每个策略各有优劣,在实际情况中往往是多种策略结合使用以达到最优的抓取效果。

5、重复url的过滤

spider在抓取过程中需要判断一个页面是否已经抓取过了,如果还没有抓取再进行抓取网页的行为并放在已抓取网址集合中。判断是否已经抓取其中涉及到最核心的是快速查找并对比,同时涉及到url归一化识别,例如一个url中收录大量无效参数而实际是同一个页面,这将视为同一个url来对待。

6、暗网数据的获取

互联网中存在着大量的搜索引擎暂时无法抓取到的数据,被称为暗网数据。一方面,很多网站的大量数据是存在于网络数据库中,spider难以采用抓取网页的方式获得完整内容;另一方面,由于网络环境、网站本身不符合规范、孤岛等等问题,也会造成搜索引擎无法抓取。目前来说,对于暗网数据的获取主要思路仍然是通过开放平台采用数据提交的方式来解决,例如“百度站长平台”“百度开放平台”等等。

7、抓取反作弊

spider在抓取过程中往往会遇到所谓抓取黑洞或者面临大量低质量页面的困扰,这就要求抓取系统中同样需要设计一套完善的抓取反作弊系统。例如分析url特征、分析页面大小及内容、分析站点规模对应抓取规模等等。

本文作者:百度站长平台lee,精选自百度站长社区论坛,由钛媒体编辑整理

技术控是百度新闻与钛媒体合作,专门为技术爱好者打造的栏目 查看全部

自动抓取网页数据(

spider抓取过程中涉及到的主要策略类型:抓取友好性)

spider在抓取过程中面对着复杂的网络环境,为了使系统可以抓取到尽可能多的有价值资源并保持系统及实际环境中页面的一致性同时不给网站体验造成压力,会设计多种复杂的抓取策略。以下简单介绍一下抓取过程中涉及到的主要策略类型:

1、抓取友好性:抓取压力调配降低对网站的访问压力

2、常用抓取返回码示意

3、多种url重定向的识别

4、抓取优先级调配

5、重复url的过滤

6、暗网数据的获取

7、抓取反作弊

8、提高抓取效率,高效利用带宽

1、抓取友好性

互联网资源庞大的数量级,这就要求抓取系统尽可能的高效利用带宽,在有限的硬件和带宽资源下尽可能多的抓取到有价值资源。这就造成了另一个问题,耗费被抓网站的带宽造成访问压力,如果程度过大将直接影响被抓网站的正常用户访问行为。因此,在抓取过程中就要进行一定的抓取压力控制,达到既不影响网站的正常用户访问又能尽量多的抓取到有价值资源的目的。

通常情况下,最基本的是基于ip的压力控制。这是因为如果基于域名,可能存在一个域名对多个ip(很多大网站)或多个域名对应同一个ip(小网站共享ip)的问题。实际中,往往根据ip及域名的多种条件进行压力调配控制。同时,站长平台也推出了压力反馈工具,站长可以人工调配对自己网站的抓取压力,这时百度spider将优先按照站长的要求进行抓取压力控制。

对同一个站点的抓取速度控制一般分为两类:其一,一段时间内的抓取频率;其二,一段时间内的抓取流量。同一站点不同的时间抓取速度也会不同,例如夜深人静月黑风高时候抓取的可能就会快一些,也视具体站点类型而定,主要思想是错开正常用户访问高峰,不断的调整。对于不同站点,也需要不同的抓取速度。

2、常用抓取返回码示意

简单介绍几种百度支持的返回码:

1)最常见的404代表“NOTFOUND”,认为网页已经失效,通常将在库中删除,同时短期内如果spider再次发现这条url也不会抓取;

2)503代表“ServiceUnavailable”,认为网页临时不可访问,通常网站临时关闭,带宽有限等会产生这种情况。对于网页返回503状态码,百度spider不会把这条url直接删除,同时短期内将会反复访问几次,如果网页已恢复,则正常抓取;如果继续返回503,那么这条url仍会被认为是失效链接,从库中删除。

3)403代表“Forbidden”,认为网页目前禁止访问。如果是新url,spider暂时不抓取,短期内同样会反复访问几次;如果是已收录url,不会直接删除,短期内同样反复访问几次。如果网页正常访问,则正常抓取;如果仍然禁止访问,那么这条url也会被认为是失效链接,从库中删除。

4)301代表是“MovedPermanently”,认为网页重定向至新url。当遇到站点迁移、域名更换、站点改版的情况时,我们推荐使用301返回码,同时使用站长平台网站改版工具,以减少改版对网站流量造成的损失。

3、多种url重定向的识别

互联网中一部分网页因为各种各样的原因存在url重定向状态,为了对这部分资源正常抓取,就要求spider对url重定向进行识别判断,同时防止作弊行为。重定向可分为三类:http30x重定向、metarefresh重定向和js重定向。另外,百度也支持Canonical标签,在效果上可以认为也是一种间接的重定向。

4、抓取优先级调配

由于互联网资源规模的巨大以及迅速的变化,对于搜索引擎来说全部抓取到并合理的更新保持一致性几乎是不可能的事情,因此这就要求抓取系统设计一套合理的抓取优先级调配策略。主要包括:深度优先遍历策略、宽度优先遍历策略、pr优先策略、反链策略、社会化分享指导策略等等。每个策略各有优劣,在实际情况中往往是多种策略结合使用以达到最优的抓取效果。

5、重复url的过滤

spider在抓取过程中需要判断一个页面是否已经抓取过了,如果还没有抓取再进行抓取网页的行为并放在已抓取网址集合中。判断是否已经抓取其中涉及到最核心的是快速查找并对比,同时涉及到url归一化识别,例如一个url中收录大量无效参数而实际是同一个页面,这将视为同一个url来对待。

6、暗网数据的获取

互联网中存在着大量的搜索引擎暂时无法抓取到的数据,被称为暗网数据。一方面,很多网站的大量数据是存在于网络数据库中,spider难以采用抓取网页的方式获得完整内容;另一方面,由于网络环境、网站本身不符合规范、孤岛等等问题,也会造成搜索引擎无法抓取。目前来说,对于暗网数据的获取主要思路仍然是通过开放平台采用数据提交的方式来解决,例如“百度站长平台”“百度开放平台”等等。

7、抓取反作弊

spider在抓取过程中往往会遇到所谓抓取黑洞或者面临大量低质量页面的困扰,这就要求抓取系统中同样需要设计一套完善的抓取反作弊系统。例如分析url特征、分析页面大小及内容、分析站点规模对应抓取规模等等。

本文作者:百度站长平台lee,精选自百度站长社区论坛,由钛媒体编辑整理

技术控是百度新闻与钛媒体合作,专门为技术爱好者打造的栏目

自动抓取网页数据(如何用PythonQQ音乐数据(第二弹)(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-09-20 05:11

阿里云>;云气社区>;主题地图>;R>;如何抓取Web表数据库

建议的活动:

更多优惠>

当前主题:如何获取Web表数据库并将其添加到集合中

相关主题:

如何抓取与Web表数据库相关的博客以查看更多博客

亚太数据库产品概述

作者:阿里云官网

亚太数据库是稳定、可靠、有弹性和可扩展的在线数据库服务产品的总称。可操作和维护全球90%以上的主流开源和商用数据库(mysql、SQL server、redis等),为polardb提供6倍以上开源数据库的性能和价格,为hybriddb自主开发的数据库提供100 TB数据的实时计算能力,并且在灾难恢复、备份、恢复、监视、迁移等方面拥有全套解决方案

现在查看

教你如何使用Python捕捉QQ音乐数据(第三部)

作者:387名高级Python用户查看评论:01年前

[一、project objective]通过教您如何使用Python捕获QQ音乐数据(第一次播放),我们实现了在指定音乐歌手的单个排名中获得歌曲名称、专辑名称和指定页数的歌曲播放链接的目标。通过教您如何使用Python捕获QQ音乐数据(第二个剧本),我们实现了特定音乐歌曲的歌词和手指的获取

阅读全文

教你如何使用Python捕捉QQ音乐数据(第三部)

作者:397名高级Python用户查看评论:01年前

[一、project objective]通过教您如何使用Python捕获QQ音乐数据(第一次播放),我们实现了在指定音乐歌手的单个排名中获得歌曲名称、专辑名称和指定页数的歌曲播放链接的目标。通过教您如何使用Python捕获QQ音乐数据(第二个剧本),我们实现了特定音乐歌曲的歌词和手指的获取

阅读全文

如何在Python中抓取数据?(一)web页面捕获)

作者:王树毅2089观点点评:2003年前

您一直在等待Python web数据爬虫教程。以下是如何从网页中查找链接和说明,并将其抓取并存储到Excel。我需要在官方账户的背景下接收来自读者的信息。许多信息都是读者的问题。只要我有时间,我就会尽力回答他们。但有些信息是第一眼看到的。我不知道

阅读全文

在云计算时代,企业应该如何应对大数据

作者:云气讲堂969人浏览评论:2003年前

本文讨论了在云计算时代,企业应该如何应对大数据。随着云计算的实施,“大数据”It已成为业内讨论最广泛的关键词之一。许多企业一直在寻找合适的Bi工具来处理从不同来源采集的大数据。然而,尽管人们对大数据的认识在不断提高,但只有谷歌和Facebook等少数企业能够应对

阅读全文

在云计算时代,企业应该如何应对大数据

作者:云气讲堂1408人浏览评论:2004年前

本文讨论了在云计算时代,企业应该如何应对大数据。随着云计算的实施,“大数据”It已成为业内讨论最广泛的关键词之一。许多企业一直在寻找合适的Bi工具来处理从不同来源采集的大数据。然而,尽管人们对大数据的认识在不断提高,但只有谷歌和Facebook等少数企业能够应对

阅读全文

“用Python编写web爬虫”--2.2三种网页抓取方法

作者:异步社区3748人浏览评论:2004年前

本节节选自asynchronous community2.2本节作者[澳大利亚]理查德·劳森(Richard Lawson),李斌翻译,更多章节可访问云气社区“异步社区”官方账号。2.2三种网页捕获方法。现在我们已经了解了网页的结构。下一个

阅读全文

初学者指南| Python网页捕获

作者:萧惠芹2425观点点评:2004年前

引言从网页中提取信息的需求正在迅速增长,其重要性也越来越明显。每隔几周,我想从网页中提取一些信息。例如,上周,我们考虑建立一个指数,衡量各种数据科学在线课程的受欢迎程度和观点。我们不仅需要发现新的课程,还需要捕获对课程的评论并加以改进,在行总结后建立一些度量指标

阅读全文

使用scratch获取数据

作者:rain guest 6542观点评论:2005年前

Scrapy是一个由python开发的快速高级屏幕捕获和Web捕获框架。它用于捕获网站并从页面中提取结构化数据。Scrapy广泛用于数据挖掘、监控和自动化测试。官方主页:中文文档:废料

阅读全文

如何抓取Web表数据库相关问答题

[JavaScript学习桶]100位阿里巴巴技术专家解答了934个流行JavaScript问题

作者:管理北碚5207人,观点和评论数量:13年前

阿里巴巴极客公益活动:也许你开夜车只是为了解决一个问题,也许你不明白,只是问一个答案,也许你绞尽脑汁只是因为一个未知的问题,所以他们来了。阿里巴巴的技术专家来到云琦为您解答技术问题,他们的用户自己的技术帮助用户成长。本次活动特别邀请了100位阿里巴巴技术专家

阅读全文 查看全部

自动抓取网页数据(如何用PythonQQ音乐数据(第二弹)(组图))

阿里云>;云气社区>;主题地图>;R>;如何抓取Web表数据库

建议的活动:

更多优惠>

当前主题:如何获取Web表数据库并将其添加到集合中

相关主题:

如何抓取与Web表数据库相关的博客以查看更多博客

亚太数据库产品概述

作者:阿里云官网

亚太数据库是稳定、可靠、有弹性和可扩展的在线数据库服务产品的总称。可操作和维护全球90%以上的主流开源和商用数据库(mysql、SQL server、redis等),为polardb提供6倍以上开源数据库的性能和价格,为hybriddb自主开发的数据库提供100 TB数据的实时计算能力,并且在灾难恢复、备份、恢复、监视、迁移等方面拥有全套解决方案

现在查看

教你如何使用Python捕捉QQ音乐数据(第三部)

作者:387名高级Python用户查看评论:01年前

[一、project objective]通过教您如何使用Python捕获QQ音乐数据(第一次播放),我们实现了在指定音乐歌手的单个排名中获得歌曲名称、专辑名称和指定页数的歌曲播放链接的目标。通过教您如何使用Python捕获QQ音乐数据(第二个剧本),我们实现了特定音乐歌曲的歌词和手指的获取

阅读全文

教你如何使用Python捕捉QQ音乐数据(第三部)

作者:397名高级Python用户查看评论:01年前

[一、project objective]通过教您如何使用Python捕获QQ音乐数据(第一次播放),我们实现了在指定音乐歌手的单个排名中获得歌曲名称、专辑名称和指定页数的歌曲播放链接的目标。通过教您如何使用Python捕获QQ音乐数据(第二个剧本),我们实现了特定音乐歌曲的歌词和手指的获取

阅读全文

如何在Python中抓取数据?(一)web页面捕获)

作者:王树毅2089观点点评:2003年前

您一直在等待Python web数据爬虫教程。以下是如何从网页中查找链接和说明,并将其抓取并存储到Excel。我需要在官方账户的背景下接收来自读者的信息。许多信息都是读者的问题。只要我有时间,我就会尽力回答他们。但有些信息是第一眼看到的。我不知道

阅读全文

在云计算时代,企业应该如何应对大数据

作者:云气讲堂969人浏览评论:2003年前

本文讨论了在云计算时代,企业应该如何应对大数据。随着云计算的实施,“大数据”It已成为业内讨论最广泛的关键词之一。许多企业一直在寻找合适的Bi工具来处理从不同来源采集的大数据。然而,尽管人们对大数据的认识在不断提高,但只有谷歌和Facebook等少数企业能够应对

阅读全文

在云计算时代,企业应该如何应对大数据

作者:云气讲堂1408人浏览评论:2004年前

本文讨论了在云计算时代,企业应该如何应对大数据。随着云计算的实施,“大数据”It已成为业内讨论最广泛的关键词之一。许多企业一直在寻找合适的Bi工具来处理从不同来源采集的大数据。然而,尽管人们对大数据的认识在不断提高,但只有谷歌和Facebook等少数企业能够应对

阅读全文

“用Python编写web爬虫”--2.2三种网页抓取方法

作者:异步社区3748人浏览评论:2004年前

本节节选自asynchronous community2.2本节作者[澳大利亚]理查德·劳森(Richard Lawson),李斌翻译,更多章节可访问云气社区“异步社区”官方账号。2.2三种网页捕获方法。现在我们已经了解了网页的结构。下一个

阅读全文

初学者指南| Python网页捕获

作者:萧惠芹2425观点点评:2004年前

引言从网页中提取信息的需求正在迅速增长,其重要性也越来越明显。每隔几周,我想从网页中提取一些信息。例如,上周,我们考虑建立一个指数,衡量各种数据科学在线课程的受欢迎程度和观点。我们不仅需要发现新的课程,还需要捕获对课程的评论并加以改进,在行总结后建立一些度量指标

阅读全文

使用scratch获取数据

作者:rain guest 6542观点评论:2005年前

Scrapy是一个由python开发的快速高级屏幕捕获和Web捕获框架。它用于捕获网站并从页面中提取结构化数据。Scrapy广泛用于数据挖掘、监控和自动化测试。官方主页:中文文档:废料

阅读全文

如何抓取Web表数据库相关问答题

[JavaScript学习桶]100位阿里巴巴技术专家解答了934个流行JavaScript问题

作者:管理北碚5207人,观点和评论数量:13年前

阿里巴巴极客公益活动:也许你开夜车只是为了解决一个问题,也许你不明白,只是问一个答案,也许你绞尽脑汁只是因为一个未知的问题,所以他们来了。阿里巴巴的技术专家来到云琦为您解答技术问题,他们的用户自己的技术帮助用户成长。本次活动特别邀请了100位阿里巴巴技术专家

阅读全文

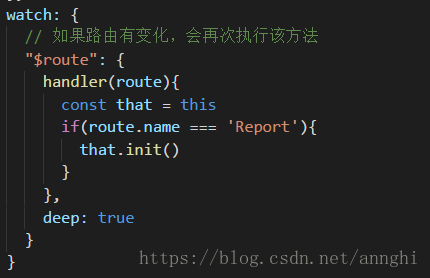

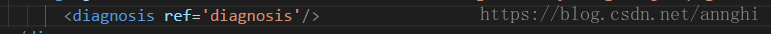

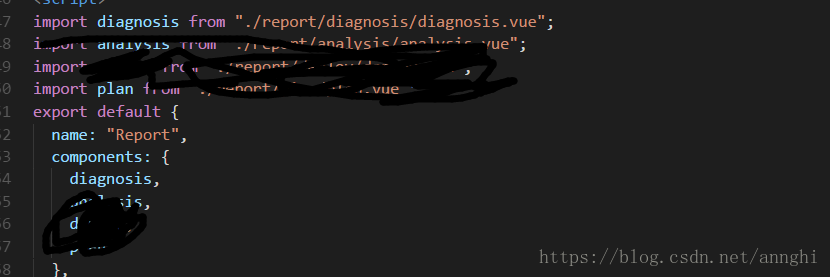

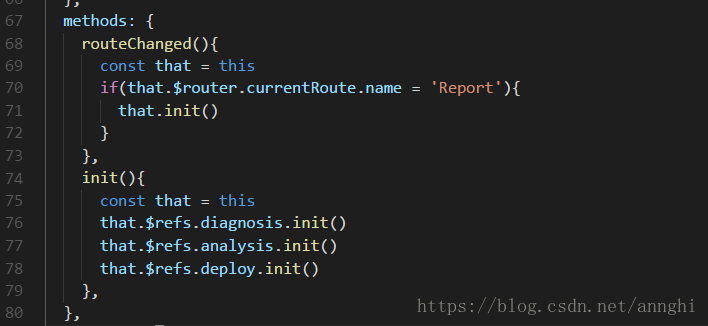

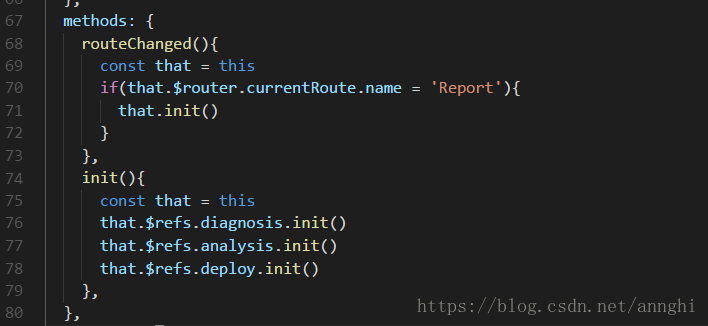

自动抓取网页数据(如何每次进入页面时都能获取后台数据watch+mouted)

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-09-20 05:03

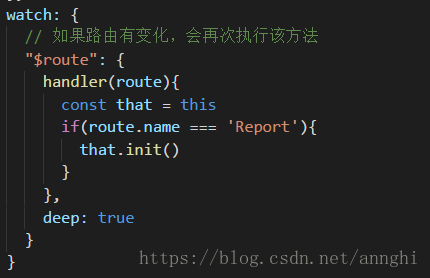

Vue跳页后,如何在每次进入页面时获取背景数据

监视+移动

让我们从这个问题开始

一.page的数据来自后台,也就是说,它将启动一个请求,从后台获取值

二.子组件的数据刷新问题,即每次相关子组件进入父组件时,需要从后台检索相关子组件的数据

1.答案:

关于第一个问题。一般来说,我们将在创建的Vue生命周期中实现它,并向后台发起请求以获取数据

但这带来了一个问题

1.1.每次进入页面时,我都需要从后台获取数据

创建的事件显然无法实现

一点解释

首先,我了解单页应用程序。就个人而言,在上一个Vue项目的包之后只有一个index.html。单页应用程序字面上的意思是,只有一页应用程序

那么什么是页面跳转呢?使用路由模拟页面跳转

场景描述:在单页应用程序中,假设有两个页面a和B。当用户进入页面时,他首先进入页面a。此时,a被创建并触发一系列生命周期,包括创建。然后,a通过路线跳到B。此时,B创建并触发一系列生命周期,包括创建的。用户对此步骤的操作没有问题

在问题开始时,用户从B页通过路由跳回a。此时,a不会触发创建!因为它已经被触发了!因此,a不会从后台请求数据。类似地,当再次从a跳到B时,B将不会通过

一般来说,这种情况是正常的。但是,如果a和B的数据源必须经过后台请求,即从a跳到B时,与B相关的数据实际上被提交到后台,那么经过后台处理后,B页之前的数据就不同了!此时,如果页面B没有从后台请求数据,则肯定是错误的

解决方案:我个人的解决方案

监视路线。在每次输入时都需要从后台获取新数据的页面上,例如页面B,监视路由更改

Init方法是每次进入此页面时要执行的方法,其中还包括请求数据的方法

2.答案:

关于你的第二个问题。一般来说,子组件有两个数据源

2.1从父组件传递到子组件:

在这种情况下,使用第一个问题的解决方案后,在init方法中加载子组件所需的数据,然后将其传输到子组件

2.2子组件向后台发送请求以获取最新数据:

有点类似于第一个问题。子组件需要有一个init方法,而不是直接在created中写入数据,并且应该在created中调用init。在父组件的init方法中,调用子组件的init方法。p>

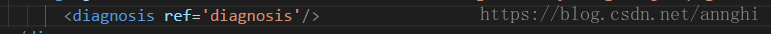

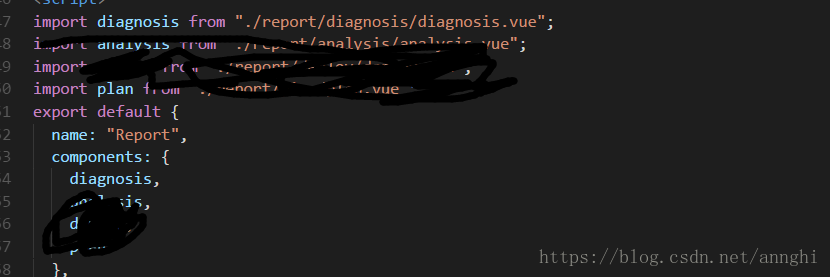

父组件:

子组件:

以上是个人的解决方案

如果你看到朋友们有更好的想法,请给我们一些建议。我希望可以讨论其他选择 查看全部

自动抓取网页数据(如何每次进入页面时都能获取后台数据watch+mouted)

Vue跳页后,如何在每次进入页面时获取背景数据

监视+移动

让我们从这个问题开始

一.page的数据来自后台,也就是说,它将启动一个请求,从后台获取值

二.子组件的数据刷新问题,即每次相关子组件进入父组件时,需要从后台检索相关子组件的数据

1.答案:

关于第一个问题。一般来说,我们将在创建的Vue生命周期中实现它,并向后台发起请求以获取数据

但这带来了一个问题

1.1.每次进入页面时,我都需要从后台获取数据

创建的事件显然无法实现

一点解释

首先,我了解单页应用程序。就个人而言,在上一个Vue项目的包之后只有一个index.html。单页应用程序字面上的意思是,只有一页应用程序

那么什么是页面跳转呢?使用路由模拟页面跳转

场景描述:在单页应用程序中,假设有两个页面a和B。当用户进入页面时,他首先进入页面a。此时,a被创建并触发一系列生命周期,包括创建。然后,a通过路线跳到B。此时,B创建并触发一系列生命周期,包括创建的。用户对此步骤的操作没有问题

在问题开始时,用户从B页通过路由跳回a。此时,a不会触发创建!因为它已经被触发了!因此,a不会从后台请求数据。类似地,当再次从a跳到B时,B将不会通过

一般来说,这种情况是正常的。但是,如果a和B的数据源必须经过后台请求,即从a跳到B时,与B相关的数据实际上被提交到后台,那么经过后台处理后,B页之前的数据就不同了!此时,如果页面B没有从后台请求数据,则肯定是错误的

解决方案:我个人的解决方案

监视路线。在每次输入时都需要从后台获取新数据的页面上,例如页面B,监视路由更改

Init方法是每次进入此页面时要执行的方法,其中还包括请求数据的方法

2.答案:

关于你的第二个问题。一般来说,子组件有两个数据源

2.1从父组件传递到子组件:

在这种情况下,使用第一个问题的解决方案后,在init方法中加载子组件所需的数据,然后将其传输到子组件

2.2子组件向后台发送请求以获取最新数据:

有点类似于第一个问题。子组件需要有一个init方法,而不是直接在created中写入数据,并且应该在created中调用init。在父组件的init方法中,调用子组件的init方法。p>

父组件:

子组件:

以上是个人的解决方案

如果你看到朋友们有更好的想法,请给我们一些建议。我希望可以讨论其他选择

自动抓取网页数据(新浪微博中模拟抓取网页内容采集网页的内容说明(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 136 次浏览 • 2021-09-16 12:18

Python爬虫程序模拟抓取网页内容采集web页面内容。这里主要是模拟抓取新浪微博内容,包括[源代码]抓取客户端微博信息、[源代码]抓取移动终端个人信息注意ID和粉丝ID(慢速)、[源代码]抓取移动终端微博信息(强力推送)等,关于运行此示例的一些说明:1.first安装python环境。作者是Python2.7.82.重新安装pip或easy_install3.Install selenium通过命令PIP Install selenium。它是一个自动测试和爬网工具4.然后修改代码中的用户名和密码,填写自己的用户名和密码5.运行程序,并自动调用Firefox浏览器登录微博。注:手机信息更加精致简单,动态加载没有限制,但微博或粉丝Id只显示20页,这是其缺点;客户端可能有动态加载,如评论和微博,但其信息更完整。注:输入:Star用户ID列表,通过URL用户ID访问(这些ID可以从用户的注意列表中获得)sinaweibo_uuu列表_uu最佳_uuo1.txt输出:微博信息和用户基本信息sinaweibo_uuinfo_uu最佳_uu1.txtMegry_Result_uuBest.py此文件允许用户整理用户某一天的微博信息,比如在2018年4月23日抓取客户信息,但评论是动态加载的,仍在微博研究中spider2.py 查看全部

自动抓取网页数据(新浪微博中模拟抓取网页内容采集网页的内容说明(图))

Python爬虫程序模拟抓取网页内容采集web页面内容。这里主要是模拟抓取新浪微博内容,包括[源代码]抓取客户端微博信息、[源代码]抓取移动终端个人信息注意ID和粉丝ID(慢速)、[源代码]抓取移动终端微博信息(强力推送)等,关于运行此示例的一些说明:1.first安装python环境。作者是Python2.7.82.重新安装pip或easy_install3.Install selenium通过命令PIP Install selenium。它是一个自动测试和爬网工具4.然后修改代码中的用户名和密码,填写自己的用户名和密码5.运行程序,并自动调用Firefox浏览器登录微博。注:手机信息更加精致简单,动态加载没有限制,但微博或粉丝Id只显示20页,这是其缺点;客户端可能有动态加载,如评论和微博,但其信息更完整。注:输入:Star用户ID列表,通过URL用户ID访问(这些ID可以从用户的注意列表中获得)sinaweibo_uuu列表_uu最佳_uuo1.txt输出:微博信息和用户基本信息sinaweibo_uuinfo_uu最佳_uu1.txtMegry_Result_uuBest.py此文件允许用户整理用户某一天的微博信息,比如在2018年4月23日抓取客户信息,但评论是动态加载的,仍在微博研究中spider2.py

自动抓取网页数据( WebScraper:如何从网页中提取数据的Chrome网页数据提取插件)

网站优化 • 优采云 发表了文章 • 0 个评论 • 123 次浏览 • 2021-09-10 09:01

WebScraper:如何从网页中提取数据的Chrome网页数据提取插件)

我要分享的工具是一个Chrome插件,叫做:Web Scraper,这是一个Chrome网页数据提取插件,可以从网页中提取数据。从某种意义上说,你也可以将其用作爬虫工具。

也是因为最近在整理36氪文章的一些标签,打算看看其他的网站跟风投相关的,有什么标准可以参考,所以找了个网站命名为“ene牛数据”,它提供的一套“行业系统”标签具有很大的参考价值。我想抓取页面上的数据,集成到我们自己的标签库中,如下图红字部分所示:

如果是规则显示的数据,也可以用鼠标选中并复制粘贴,但还是得想办法把它嵌入到页面中。这时候想起之前安装过Web Scraper,就试了一下。使用起来相当方便,采集效率一下子提高了。我也给你安利~

Web Scraper 是一个 Chrome 插件。一年前在三班的公开课上看到的。号称是不懂编程也能实现爬虫爬虫的黑科技,但是在三类的官网上好像找不到。可以百度一下:《三门爬虫》,还是可以找到的,名字叫《人人都能学的数据爬虫课》,不过好像要收费100元。我觉得这个东西可以看网上的文章就知道了,比如我的文章~

简单来说,Web Scraper是一款基于Chrome的网页元素解析器,可以通过可视化的点击操作,提取自定义区域中的数据/元素。同时还提供了定时自动提取功能,可以作为一套简单的爬虫工具使用。

这里顺便解释一下网页提取器爬取和真实代码爬取的区别。使用网页提取器自动提取页面数据的过程有点类似于模拟手动点击的机器人。它让您首先定义页面上的要求。抓取哪些元素,抓取哪些页面,然后让机器代人操作;而如果你用Python写一个爬虫,更多的是使用网页请求命令先下载整个网页,然后用代码解析HTML页面元素。提取您想要的内容,并继续循环。相比之下,使用代码会更灵活,但解析的成本会更高。如果是简单的页面内容提取,我也推荐使用Web Scraper。

关于Web Scraper的具体安装过程以及如何使用全功能,今天在文章不再赘述。第一个是我只用了我需要的,第二个是市场上的Web Scraper教程太多了,你可以自己找到。

这里只是一个实践过程,给大家简单介绍一下我的使用方法。

第一步是创建站点地图

打开 Chrome 浏览器并按 F12 以调用开发者工具。 Web Scraper 位于最后一个选项卡上。点击后,选择“创建站点地图”菜单,然后点击“创建站点地图”选项。

首先输入你要爬取的网站URL,以及你自定义的爬取任务的名称。比如我取的名字是:xiniulevel,网址是:

第二步创建抓取节点

我想抓取一级标签和二级标签,所以我先点进我刚刚创建的Sitemap,然后点击“添加新选择器”进入抓取节点选择器配置页面,点击“选择”页面上的按钮,然后你会看到一个浮动图层出现

此时,当您将鼠标移入网页时,它会自动以绿色突出显示您将鼠标悬停的某个位置。这时候你可以先点击一个你想选择的方块,你会发现方块变成了红色。如果要选择同一层级的所有块,可以继续点击下一个相邻块,工具将默认选择所有同一层级的块,如下图:

我们会发现下面浮动窗口的文本输入框自动填充了块的XPATH路径,然后点击“完成选择!”结束选择,浮动框消失,选中的XPATH自动填入下面的Selector行。另外,一定要选择“Multiple”来声明要选择多个块。最后,点击保存选择器按钮结束。

第三步获取元素值

完成Selector的创建后,回到上一页,会发现Selector表多了一行,然后可以直接点击Action中的Data preview查看所有的想要获取的元素值。

上图所示的部分是我添加了两个Selector,主标签和副标签的情况。点数据预览的弹窗内容其实就是我想要的,直接复制到EXCEL就可以了,不需要什么太复杂的自动爬取处理。

以上简单介绍了Web Scraper的使用过程。当然,我的使用并不是完全高效,因为每次想要获取二级标签时,都需要先手动切换一级标签,然后再执行抓取指令。应该有更好的方法,但对我来说已经足够了。这个文章主要是想跟大家普及一下这个工具。这不是教程。更多功能根据自己的需要去探索~

怎么样,对你有帮助吗? 查看全部

自动抓取网页数据(

WebScraper:如何从网页中提取数据的Chrome网页数据提取插件)

我要分享的工具是一个Chrome插件,叫做:Web Scraper,这是一个Chrome网页数据提取插件,可以从网页中提取数据。从某种意义上说,你也可以将其用作爬虫工具。

也是因为最近在整理36氪文章的一些标签,打算看看其他的网站跟风投相关的,有什么标准可以参考,所以找了个网站命名为“ene牛数据”,它提供的一套“行业系统”标签具有很大的参考价值。我想抓取页面上的数据,集成到我们自己的标签库中,如下图红字部分所示:

如果是规则显示的数据,也可以用鼠标选中并复制粘贴,但还是得想办法把它嵌入到页面中。这时候想起之前安装过Web Scraper,就试了一下。使用起来相当方便,采集效率一下子提高了。我也给你安利~

Web Scraper 是一个 Chrome 插件。一年前在三班的公开课上看到的。号称是不懂编程也能实现爬虫爬虫的黑科技,但是在三类的官网上好像找不到。可以百度一下:《三门爬虫》,还是可以找到的,名字叫《人人都能学的数据爬虫课》,不过好像要收费100元。我觉得这个东西可以看网上的文章就知道了,比如我的文章~

简单来说,Web Scraper是一款基于Chrome的网页元素解析器,可以通过可视化的点击操作,提取自定义区域中的数据/元素。同时还提供了定时自动提取功能,可以作为一套简单的爬虫工具使用。

这里顺便解释一下网页提取器爬取和真实代码爬取的区别。使用网页提取器自动提取页面数据的过程有点类似于模拟手动点击的机器人。它让您首先定义页面上的要求。抓取哪些元素,抓取哪些页面,然后让机器代人操作;而如果你用Python写一个爬虫,更多的是使用网页请求命令先下载整个网页,然后用代码解析HTML页面元素。提取您想要的内容,并继续循环。相比之下,使用代码会更灵活,但解析的成本会更高。如果是简单的页面内容提取,我也推荐使用Web Scraper。

关于Web Scraper的具体安装过程以及如何使用全功能,今天在文章不再赘述。第一个是我只用了我需要的,第二个是市场上的Web Scraper教程太多了,你可以自己找到。

这里只是一个实践过程,给大家简单介绍一下我的使用方法。

第一步是创建站点地图

打开 Chrome 浏览器并按 F12 以调用开发者工具。 Web Scraper 位于最后一个选项卡上。点击后,选择“创建站点地图”菜单,然后点击“创建站点地图”选项。

首先输入你要爬取的网站URL,以及你自定义的爬取任务的名称。比如我取的名字是:xiniulevel,网址是:

第二步创建抓取节点

我想抓取一级标签和二级标签,所以我先点进我刚刚创建的Sitemap,然后点击“添加新选择器”进入抓取节点选择器配置页面,点击“选择”页面上的按钮,然后你会看到一个浮动图层出现

此时,当您将鼠标移入网页时,它会自动以绿色突出显示您将鼠标悬停的某个位置。这时候你可以先点击一个你想选择的方块,你会发现方块变成了红色。如果要选择同一层级的所有块,可以继续点击下一个相邻块,工具将默认选择所有同一层级的块,如下图:

我们会发现下面浮动窗口的文本输入框自动填充了块的XPATH路径,然后点击“完成选择!”结束选择,浮动框消失,选中的XPATH自动填入下面的Selector行。另外,一定要选择“Multiple”来声明要选择多个块。最后,点击保存选择器按钮结束。

第三步获取元素值

完成Selector的创建后,回到上一页,会发现Selector表多了一行,然后可以直接点击Action中的Data preview查看所有的想要获取的元素值。

上图所示的部分是我添加了两个Selector,主标签和副标签的情况。点数据预览的弹窗内容其实就是我想要的,直接复制到EXCEL就可以了,不需要什么太复杂的自动爬取处理。

以上简单介绍了Web Scraper的使用过程。当然,我的使用并不是完全高效,因为每次想要获取二级标签时,都需要先手动切换一级标签,然后再执行抓取指令。应该有更好的方法,但对我来说已经足够了。这个文章主要是想跟大家普及一下这个工具。这不是教程。更多功能根据自己的需要去探索~

怎么样,对你有帮助吗?

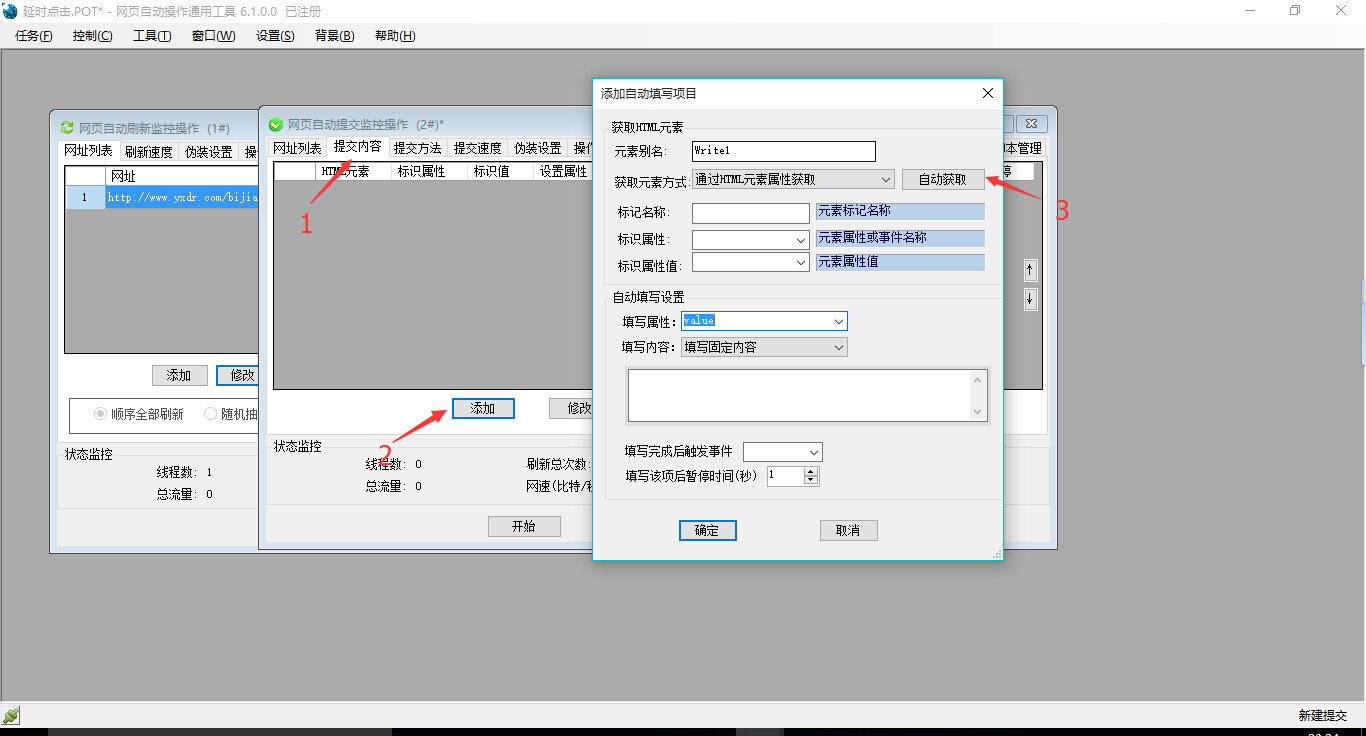

自动抓取网页数据(想用最好用的网页提取软件吗?网页批量填写)

网站优化 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-09-10 02:06

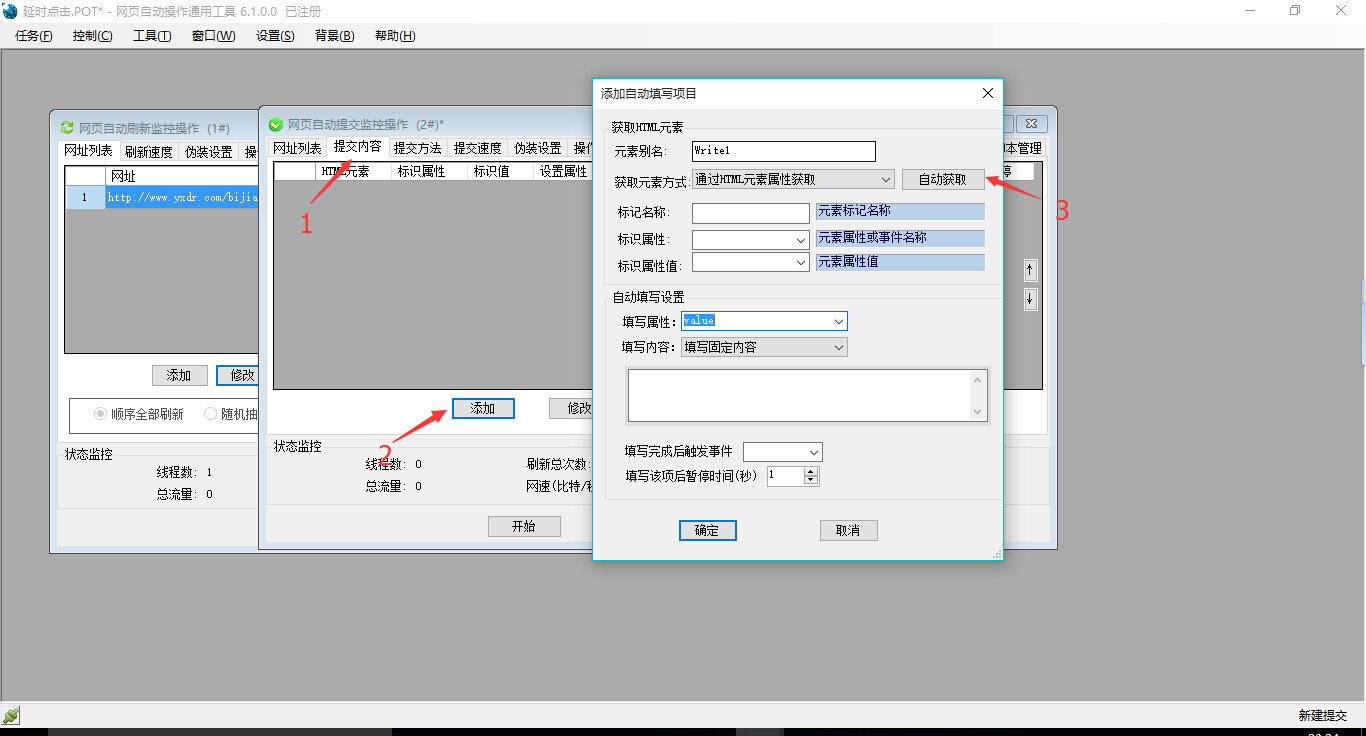

想使用最好的网页提取软件吗?那就跟着小编来看看下面的风月网页批量填充数据提取软件软件,这是一款非常好用的网页数据下载软件,支持更多的页面填充类型,控件元素,准确率更高。 风悦网页批量填写数据提取软件其他表单填写工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,本软件一般都能正确填写。

软件介绍

风悦网页批量填写数据提取软件可以自动分析网页上的表单内容,并保存为表单填写规则。使用时调用此规则自动填表,点击网页元素,抓取网页Text内容,下载指定网页链接文件。

<p>风悦网页批量填充数据提取软件支持更多的页面填充类型和控制元素,准确率更高。其他填表工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,这个软件一般都能正确填写。本软件不仅可以用于一般办公填表,还可以扩展为批量注册、投票、留言、商品秒杀、舆情控制、征信、抢车牌等工具。 查看全部

自动抓取网页数据(想用最好用的网页提取软件吗?网页批量填写)

想使用最好的网页提取软件吗?那就跟着小编来看看下面的风月网页批量填充数据提取软件软件,这是一款非常好用的网页数据下载软件,支持更多的页面填充类型,控件元素,准确率更高。 风悦网页批量填写数据提取软件其他表单填写工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,本软件一般都能正确填写。

软件介绍

风悦网页批量填写数据提取软件可以自动分析网页上的表单内容,并保存为表单填写规则。使用时调用此规则自动填表,点击网页元素,抓取网页Text内容,下载指定网页链接文件。

<p>风悦网页批量填充数据提取软件支持更多的页面填充类型和控制元素,准确率更高。其他填表工具一般不支持:多框页面(frame)、多选列表、HTML文本(iframe)输入法,这个软件一般都能正确填写。本软件不仅可以用于一般办公填表,还可以扩展为批量注册、投票、留言、商品秒杀、舆情控制、征信、抢车牌等工具。

自动抓取网页数据(项目简单思路 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-10-01 07:26

)

该项目的简单思想是首先将通过jsoup捕获的数据存储到ArrayList中,然后通过JDBC存储到数据库中

创建了Maven项目。您需要在pom.xml中添加两个依赖项:

org.jsoup

jsoup

1.11.3

mysql

mysql-connector-java

5.1.38

创建实体类:

然后执行数据爬网和数据库保存操作:

package control;

import dao.Blog;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

import java.util.ArrayList;

public class Grab {

private static Document doc;

public static void main(String[] args) {

try {

//获取的网页链接

doc = Jsoup.connect("https://www.cnblogs.com/").get();

} catch (IOException e) {

e.printStackTrace();

}

//调用Blog类

BlogZhua();

}

/**

* 抓取网页数据

*/

public static void BlogZhua() {

//获取网页中的元素

Elements eles = doc.select("div#post_list>div.post_item");

//将抓取的数据存入到ArrayList集合中

ArrayList arrayList = new ArrayList();

//使用for循环遍历网页中的数据

for (Element ele : eles) {

//抓取页面中的文章标题

String txt = ele.select("div.post_item_body>h3>a.titlelnk").text();

//抓取页面中的文章链接

String href = ele.select("div.post_item_body>h3>a.titlelnk").attr("href");

//爬取文章作者

String author = ele.select("div.post_item_foot > a.lightblue").text();

//爬取文章发布时间

String reads = ele.select("div.post_item_foot > span.article_view > a.gray").text();

//将数据添加到集合中

Blog blog = new Blog();

blog.setTitle(txt);

blog.setHref(href);

blog.setAuthor(author);

blog.setReads(reads);

arrayList.add(blog);

}

//遍历ArrayList集合

for (Blog test : arrayList) {

// System.out.println("数据:" + test);

//此处调用AddBlog类,把集合中的数据添加到数据库中

AddBlog(test);

}

}

/**

* 数据库操作

*

* @param blog

*/

public static void AddBlog(Blog blog) {

try {

//加载mysql驱动

Class.forName("com.mysql.jdbc.Driver");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

Connection connection = null;

PreparedStatement pstmt = null;

try {

//连接mysql

connection = DriverManager.getConnection("jdbc:mysql://localhost:3306/jsoup?useSSL=true", "root", "1234");

//编写sql语句

String sql = "INSERT INTO `content`(`title`, `href`, `author`, `reads`) VALUES (?,?,?,?)";

pstmt = connection.prepareStatement(sql);

pstmt.setString(1, blog.getTitle());

pstmt.setString(2, blog.getHref());

pstmt.setString(3, blog.getAuthor());

pstmt.setString(4, blog.getReads());

int result = pstmt.executeUpdate();

//验证数据是否添加成功

if (result > 0) {

System.out.println("数据添加成功!");

}

} catch (SQLException throwables) {

throwables.printStackTrace();

System.out.println("数据库访问失败!");

}

}

} 查看全部

自动抓取网页数据(项目简单思路

)

该项目的简单思想是首先将通过jsoup捕获的数据存储到ArrayList中,然后通过JDBC存储到数据库中

创建了Maven项目。您需要在pom.xml中添加两个依赖项:

org.jsoup

jsoup

1.11.3

mysql

mysql-connector-java

5.1.38

创建实体类:

然后执行数据爬网和数据库保存操作:

package control;

import dao.Blog;

import org.jsoup.Jsoup;

import org.jsoup.nodes.Document;

import org.jsoup.nodes.Element;

import org.jsoup.select.Elements;

import java.io.IOException;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.PreparedStatement;

import java.sql.SQLException;

import java.util.ArrayList;

public class Grab {

private static Document doc;

public static void main(String[] args) {

try {

//获取的网页链接

doc = Jsoup.connect("https://www.cnblogs.com/";).get();

} catch (IOException e) {

e.printStackTrace();

}

//调用Blog类

BlogZhua();

}

/**

* 抓取网页数据

*/

public static void BlogZhua() {

//获取网页中的元素

Elements eles = doc.select("div#post_list>div.post_item");

//将抓取的数据存入到ArrayList集合中

ArrayList arrayList = new ArrayList();

//使用for循环遍历网页中的数据

for (Element ele : eles) {

//抓取页面中的文章标题

String txt = ele.select("div.post_item_body>h3>a.titlelnk").text();

//抓取页面中的文章链接

String href = ele.select("div.post_item_body>h3>a.titlelnk").attr("href");

//爬取文章作者

String author = ele.select("div.post_item_foot > a.lightblue").text();

//爬取文章发布时间

String reads = ele.select("div.post_item_foot > span.article_view > a.gray").text();

//将数据添加到集合中

Blog blog = new Blog();

blog.setTitle(txt);

blog.setHref(href);

blog.setAuthor(author);

blog.setReads(reads);

arrayList.add(blog);

}

//遍历ArrayList集合

for (Blog test : arrayList) {

// System.out.println("数据:" + test);

//此处调用AddBlog类,把集合中的数据添加到数据库中

AddBlog(test);

}

}

/**

* 数据库操作

*

* @param blog

*/

public static void AddBlog(Blog blog) {

try {

//加载mysql驱动

Class.forName("com.mysql.jdbc.Driver");

} catch (ClassNotFoundException e) {

e.printStackTrace();

}

Connection connection = null;

PreparedStatement pstmt = null;

try {

//连接mysql

connection = DriverManager.getConnection("jdbc:mysql://localhost:3306/jsoup?useSSL=true", "root", "1234");

//编写sql语句

String sql = "INSERT INTO `content`(`title`, `href`, `author`, `reads`) VALUES (?,?,?,?)";

pstmt = connection.prepareStatement(sql);

pstmt.setString(1, blog.getTitle());

pstmt.setString(2, blog.getHref());

pstmt.setString(3, blog.getAuthor());

pstmt.setString(4, blog.getReads());

int result = pstmt.executeUpdate();

//验证数据是否添加成功

if (result > 0) {

System.out.println("数据添加成功!");

}

} catch (SQLException throwables) {

throwables.printStackTrace();

System.out.println("数据库访问失败!");

}

}

}

自动抓取网页数据(如何用python来抓取页面中的JS动态加载的数据 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-01 07:25

)

我们经常会发现,网页中的很多数据并不是硬编码在 HTML 中,而是动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中动态生成的页面内容,是页面加载到浏览器后动态生成的,以前没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图所示,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以在页面上加载更多电影资讯节目单,以便我们抓取相应的消息。

我们可以看到它使用了 AJAX 异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某个部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,我们可以发现有两个参数“start”和“liGLNqVtxOmit”,后面跟着的是action参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这看起来很不自动化,而且很多其他网站 RequestURL 都不是那么直接,所以我们将使用pyth 编程inn 进行进一步的操作,以获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text 查看全部

自动抓取网页数据(如何用python来抓取页面中的JS动态加载的数据

)

我们经常会发现,网页中的很多数据并不是硬编码在 HTML 中,而是动态加载的。所以也引出了动态数据的概念。这里的动态数据是指网页中动态生成的页面内容,是页面加载到浏览器后动态生成的,以前没有的。

在编写爬虫抓取网页数据的时候,经常会遇到这种需要动态加载数据的HTML网页。如果还是直接从网页爬取,将无法获取任何数据。

今天,我们就在这里简单说说如何使用python抓取页面中JS动态加载的数据。

给定一个网页:豆瓣电影排行榜,里面的所有电影信息都是动态加载的。我们无法直接从页面中获取每部电影的信息。

如下图所示,我们在HTML中找不到对应的电影信息。

在Chrome浏览器中,点击F12打开Network中的XHR,我们抓取对应的js文件进行分析。如下所示:

在豆瓣页面向下拖动,可以在页面上加载更多电影资讯节目单,以便我们抓取相应的消息。

我们可以看到它使用了 AJAX 异步请求。通过在后台与服务器交换少量数据,AJAX 可以使网页异步更新。因此,可以在不重新加载整个网页的情况下更新网页的某个部分,从而实现数据的动态加载。

我们可以看到,通过GET,我们得到的响应中收录了对应的电影相关信息,以JSON格式存储在一起。

查看RequestURL信息,我们可以发现有两个参数“start”和“liGLNqVtxOmit”,后面跟着的是action参数。显然他们的意思是:“从某个位置返回的电影数量”。

如果你想快速获取相关电影信息,可以直接把这个网址复制到地址栏,修改你需要的start和limit参数值,得到相应的抓取结果。

但这看起来很不自动化,而且很多其他网站 RequestURL 都不是那么直接,所以我们将使用pyth 编程inn 进行进一步的操作,以获取返回的消息信息。

#coding:utf-8

import urllib

import requests

post_param = {'action':'','start':'0','limit':'1'}

return_data = requests.get("https://movie.douban.com/j/cha ... ot%3B,data =post_param, verify = False)

print return_data.text

自动抓取网页数据(,,过WindowBuilder插件了,具体使用参考如下链接效果)

网站优化 • 优采云 发表了文章 • 0 个评论 • 173 次浏览 • 2021-10-01 07:22

java网页爬取最常用的方式,老司机应该都知道,那就是使用JSOUP。这个工具之前玩过,但是发现一个问题,比如你需要爬取的数据,必须登录才能爬取,如果涉及到验证码,就更难操作了。

很久以前,jsoup就是用来尝试自动下载便图高清图片的。但是他们的登录方式只是第三方登录,单靠jsoup是很难实现的。

后来找到了JXbrower这个工具,可以轻松实现这样的需求。

下面我们就抓着便图网的案例开始详细介绍JX。

先下载

如何下载,这里不详细说明。注意我这里使用的是6.18版本,我必须使用6.18版本

解压下载的压缩包,

获取以下两个jar包

jxbrowser-6.18.jar

jxbrowser-win32-6.18.jar

项目结构如下:

创建一个新文件 teamdev.licenses

Product: JxBrowser

Version: 6.x

Licensed to:

License type: Enterprise

License info: JxBrowser License

Expiration date: 01-01-9999

Support expiration date: NO SUPPORT

Generation date: 01-01-1970

Platforms: win32/x86;win32/x64;mac/x86;mac/x64;linux/x86;linux/x64

Company name: TeamDev Ltd.

SigB: 1

SigA: 1

主要代码

在这里提一下,博主已经安装了WindowBuilder插件。具体使用请参考以下链接

效果如下

这只是一个简单的案例。更强大的功能可以查看他的API。 查看全部

自动抓取网页数据(,,过WindowBuilder插件了,具体使用参考如下链接效果)

java网页爬取最常用的方式,老司机应该都知道,那就是使用JSOUP。这个工具之前玩过,但是发现一个问题,比如你需要爬取的数据,必须登录才能爬取,如果涉及到验证码,就更难操作了。

很久以前,jsoup就是用来尝试自动下载便图高清图片的。但是他们的登录方式只是第三方登录,单靠jsoup是很难实现的。

后来找到了JXbrower这个工具,可以轻松实现这样的需求。

下面我们就抓着便图网的案例开始详细介绍JX。

先下载

如何下载,这里不详细说明。注意我这里使用的是6.18版本,我必须使用6.18版本

解压下载的压缩包,

获取以下两个jar包

jxbrowser-6.18.jar

jxbrowser-win32-6.18.jar

项目结构如下:

创建一个新文件 teamdev.licenses

Product: JxBrowser

Version: 6.x

Licensed to:

License type: Enterprise

License info: JxBrowser License

Expiration date: 01-01-9999

Support expiration date: NO SUPPORT

Generation date: 01-01-1970

Platforms: win32/x86;win32/x64;mac/x86;mac/x64;linux/x86;linux/x64

Company name: TeamDev Ltd.

SigB: 1

SigA: 1

主要代码

在这里提一下,博主已经安装了WindowBuilder插件。具体使用请参考以下链接

效果如下

这只是一个简单的案例。更强大的功能可以查看他的API。

自动抓取网页数据(大数据初学者了解并动手实现自己的网络爬虫(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-10-01 04:19

网络爬虫是从互联网上打开数据采集的重要手段。在这种情况下,使用Python的相关模块开发了一个简单的爬虫。实现从某本书网站中自动下载感兴趣的图书信息的功能。实现的主要功能包括单页图书信息下载、图书信息提取、多页图书信息下载。本案例适合大数据初学者了解并实现自己的网络爬虫。

1、任务描述和数据来源

从当当网的搜索页面,按照关键词进行搜索,使用Python编写爬虫,在搜索结果中自动爬取该书的书名、出版社、价格、作者、书籍介绍。

当当搜索页面:/

2、单页图书信息下载2.1个网页下载

Python 中的 requests 库可以自动帮我们构造一个请求对象来向服务器请求资源,并为服务器资源返回一个响应对象。如果只需要返回 HTML 页面的内容,可以直接调用响应的 text 属性。下面的代码中,我们首先导入requests库,定义当当搜索页面的URL,设置搜索关键词为“机器学习”。然后使用requests.get方法获取网页内容。最后,打印并显示网页的前 1000 个字符。

import requests #1. 导入requests 库

test_url = 'http://search.dangdang.com/?key='+ '机器学习' #2. 设置网页的URL地址

content_page = requests.get(test_url).text #3. 执行页面请求,返回页面内容

print(content_page[:1000]) #4.将页面的前1000个字符打印显示出来

2.2 图书内容分析

下面开始分析页面,分析源码。这里我使用Chrome浏览器直接打开网址/?key=machine learning。然后选择任意图书信息,右击“检查”按钮。不难发现,搜索结果中每本书的信息都是页面上的一个标签,如下图所示:

点击第一个标签,发现下面还有几个

标签,类别有“名称”、“详情”、“价格”等,这些标签下存储着商品的标题、详情、价格等信息。

我们以提取书名信息为例进行具体说明。点击li标签下class属性为name的p标签,我们发现书名信息存储在name属性为“itemlist-title”的标签的title属性中,如下图所示:

我们可以用xpath直接把上面的定位信息描述为//li/p/a[@name="itemlist-title"]/@title。接下来,我们使用 lxml 模块提取页面中的书名信息。xpath的使用请参考/xpath/xpath_syntax.asp。

page = etree.HTML(content_page) #将页面字符串解析成树结构

book_name = page.xpath('//li/p/a[@name="itemlist-title"]/@title') #用xpath提取出书名信息。

book_name[:10] #打印提取出的前10个书名信息

同理,我们可以提取图书出版信息(作者、出版社、出版时间等)、当前价格、星级、评论数等。该信息对应的xpath路径如下表所示。

信息项

标题

//li/p/a[@name="itemlist-title"]/@title

出版信息

//li/p[@class="search_book_author"]

目前的价格

//li/p[@class="price"]/span[@class="search_now_price"]/text()

星级

//li/p[@class="search_star_line"]/span[@class="search_star_black"]/span/@style 查看全部

自动抓取网页数据(大数据初学者了解并动手实现自己的网络爬虫(图))

网络爬虫是从互联网上打开数据采集的重要手段。在这种情况下,使用Python的相关模块开发了一个简单的爬虫。实现从某本书网站中自动下载感兴趣的图书信息的功能。实现的主要功能包括单页图书信息下载、图书信息提取、多页图书信息下载。本案例适合大数据初学者了解并实现自己的网络爬虫。

1、任务描述和数据来源

从当当网的搜索页面,按照关键词进行搜索,使用Python编写爬虫,在搜索结果中自动爬取该书的书名、出版社、价格、作者、书籍介绍。

当当搜索页面:/

2、单页图书信息下载2.1个网页下载

Python 中的 requests 库可以自动帮我们构造一个请求对象来向服务器请求资源,并为服务器资源返回一个响应对象。如果只需要返回 HTML 页面的内容,可以直接调用响应的 text 属性。下面的代码中,我们首先导入requests库,定义当当搜索页面的URL,设置搜索关键词为“机器学习”。然后使用requests.get方法获取网页内容。最后,打印并显示网页的前 1000 个字符。

import requests #1. 导入requests 库

test_url = 'http://search.dangdang.com/?key='+ '机器学习' #2. 设置网页的URL地址

content_page = requests.get(test_url).text #3. 执行页面请求,返回页面内容

print(content_page[:1000]) #4.将页面的前1000个字符打印显示出来

2.2 图书内容分析

下面开始分析页面,分析源码。这里我使用Chrome浏览器直接打开网址/?key=machine learning。然后选择任意图书信息,右击“检查”按钮。不难发现,搜索结果中每本书的信息都是页面上的一个标签,如下图所示:

点击第一个标签,发现下面还有几个

标签,类别有“名称”、“详情”、“价格”等,这些标签下存储着商品的标题、详情、价格等信息。

我们以提取书名信息为例进行具体说明。点击li标签下class属性为name的p标签,我们发现书名信息存储在name属性为“itemlist-title”的标签的title属性中,如下图所示:

我们可以用xpath直接把上面的定位信息描述为//li/p/a[@name="itemlist-title"]/@title。接下来,我们使用 lxml 模块提取页面中的书名信息。xpath的使用请参考/xpath/xpath_syntax.asp。

page = etree.HTML(content_page) #将页面字符串解析成树结构

book_name = page.xpath('//li/p/a[@name="itemlist-title"]/@title') #用xpath提取出书名信息。

book_name[:10] #打印提取出的前10个书名信息

同理,我们可以提取图书出版信息(作者、出版社、出版时间等)、当前价格、星级、评论数等。该信息对应的xpath路径如下表所示。

信息项

标题

//li/p/a[@name="itemlist-title"]/@title

出版信息

//li/p[@class="search_book_author"]

目前的价格

//li/p[@class="price"]/span[@class="search_now_price"]/text()

星级

//li/p[@class="search_star_line"]/span[@class="search_star_black"]/span/@style

自动抓取网页数据(本文(待更新实验部分)本文介绍库和chrome浏览器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 103 次浏览 • 2021-09-30 10:31

我讨厌在互联网上复制代码。检查它是浪费时间和精力。请尊重编程总结的实战经验和结果。我为此付出代价。如果你欣赏它,你就可以享受它。如果确实需要解决问题可以联系谢谢

概括

最后更新:2020.08.20(实验部分待更新)

本文类型:实际应用(非知识讲解)

本文介绍了selenium库和chrome浏览器自动抓取网页元素,定位并填写表单数据,可以实现自动填写,节省大量人力。为了方便使用selenium库,方便处理运行中的错误,本文将对selenium库进行一定程度的重新封装,以便读者在了解selenium库后可以快速上手编程。

一、本文知识点:1.安装selenium库,2.selenium库查找元素的方式,3.重新打包selenium库

二、本文结构:1.先简单介绍一下知识点,2.把复制后可以直接运行的调试代码贴在一个完整的段落中,方便读者调试每个发布的一段代码。

三、 本文方法实现:以百度主页为控制网页,谷歌浏览器为实验平台,网页操作使用python+selenium。ps:其他对应的爬网实验会更新。

四、本文实验:1.后台自动登录百度贴吧,2.后台QQ邮箱阅读最新邮件,等待其他实验更新(均提供详细代码和注释,本文末尾有对应链接)

温馨提示:以下为本文文章内容,以下案例可供参考

文章内容 查看全部

自动抓取网页数据(本文(待更新实验部分)本文介绍库和chrome浏览器)

我讨厌在互联网上复制代码。检查它是浪费时间和精力。请尊重编程总结的实战经验和结果。我为此付出代价。如果你欣赏它,你就可以享受它。如果确实需要解决问题可以联系谢谢

概括

最后更新:2020.08.20(实验部分待更新)

本文类型:实际应用(非知识讲解)

本文介绍了selenium库和chrome浏览器自动抓取网页元素,定位并填写表单数据,可以实现自动填写,节省大量人力。为了方便使用selenium库,方便处理运行中的错误,本文将对selenium库进行一定程度的重新封装,以便读者在了解selenium库后可以快速上手编程。

一、本文知识点:1.安装selenium库,2.selenium库查找元素的方式,3.重新打包selenium库

二、本文结构:1.先简单介绍一下知识点,2.把复制后可以直接运行的调试代码贴在一个完整的段落中,方便读者调试每个发布的一段代码。

三、 本文方法实现:以百度主页为控制网页,谷歌浏览器为实验平台,网页操作使用python+selenium。ps:其他对应的爬网实验会更新。

四、本文实验:1.后台自动登录百度贴吧,2.后台QQ邮箱阅读最新邮件,等待其他实验更新(均提供详细代码和注释,本文末尾有对应链接)

温馨提示:以下为本文文章内容,以下案例可供参考

文章内容

自动抓取网页数据($.ajax()函数依赖服务器提供的信息来处理)

网站优化 • 优采云 发表了文章 • 0 个评论 • 89 次浏览 • 2021-09-30 10:26

数据类型

美元。Ajax()函数依赖于服务器提供的信息来处理返回的数据。如果服务器报告返回的数据是XML,则可以使用普通XML方法或jQuery选择器遍历返回的结果。如果看到其他类型,如HTML,则数据将被视为文本

使用datatype选项,还可以指定其他不同的数据处理方法。除了简单的XML,您还可以指定HTML、JSON、jsonp、脚本或文本

其中,文本和XML类型返回的数据不进行处理。数据只是将XMLHttpRequest的responseText或responsehtml属性传递给成功回调函数

注意:我们必须确保web服务器报告的MIME类型与我们选择的数据类型匹配。例如,对于XML,服务器必须声明text/XML或application/XML以获得一致的结果

如果指定为HTML类型,则任何嵌入式JavaScript都将在HTML作为字符串返回之前执行。类似地,如果指定了脚本类型,则将首先执行服务器端生成的JavaScript,然后将脚本作为文本数据返回

如果将其指定为JSON类型,则获取的数据将被解析为JavaScript对象,并且生成的对象将作为结果返回。为此,它首先尝试使用JSON。解析()。如果浏览器不支持它,则使用函数来构建它

JSON数据是一种可以通过JavaScript轻松解析的结构化数据。如果获取的数据文件存储在远程服务器上(不同的域名,即跨域数据采集),则需要使用jsonp类型。如果使用此类型,将创建查询字符串参数callback=?,此参数将附加到请求的URL。服务器端应该在JSON数据之前添加回调函数名,以便完成有效的jsonp请求。如果要指定回调函数的参数名而不是默认回调,可以将JSON参数设置为$。Ajax()

注意:jsonp是JSON格式的扩展。它需要一些服务器端代码来检测和处理查询字符串参数

如果指定了脚本或JSON类型,则在从服务器接收数据时,实际使用该脚本或JSON类型 查看全部

自动抓取网页数据($.ajax()函数依赖服务器提供的信息来处理)

数据类型

美元。Ajax()函数依赖于服务器提供的信息来处理返回的数据。如果服务器报告返回的数据是XML,则可以使用普通XML方法或jQuery选择器遍历返回的结果。如果看到其他类型,如HTML,则数据将被视为文本

使用datatype选项,还可以指定其他不同的数据处理方法。除了简单的XML,您还可以指定HTML、JSON、jsonp、脚本或文本

其中,文本和XML类型返回的数据不进行处理。数据只是将XMLHttpRequest的responseText或responsehtml属性传递给成功回调函数

注意:我们必须确保web服务器报告的MIME类型与我们选择的数据类型匹配。例如,对于XML,服务器必须声明text/XML或application/XML以获得一致的结果

如果指定为HTML类型,则任何嵌入式JavaScript都将在HTML作为字符串返回之前执行。类似地,如果指定了脚本类型,则将首先执行服务器端生成的JavaScript,然后将脚本作为文本数据返回

如果将其指定为JSON类型,则获取的数据将被解析为JavaScript对象,并且生成的对象将作为结果返回。为此,它首先尝试使用JSON。解析()。如果浏览器不支持它,则使用函数来构建它

JSON数据是一种可以通过JavaScript轻松解析的结构化数据。如果获取的数据文件存储在远程服务器上(不同的域名,即跨域数据采集),则需要使用jsonp类型。如果使用此类型,将创建查询字符串参数callback=?,此参数将附加到请求的URL。服务器端应该在JSON数据之前添加回调函数名,以便完成有效的jsonp请求。如果要指定回调函数的参数名而不是默认回调,可以将JSON参数设置为$。Ajax()

注意:jsonp是JSON格式的扩展。它需要一些服务器端代码来检测和处理查询字符串参数

如果指定了脚本或JSON类型,则在从服务器接收数据时,实际使用该脚本或JSON类型

自动抓取网页数据( 如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 1381 次浏览 • 2021-09-28 08:37

如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

之前介绍PowerBI数据采集的时候,举了一个从网页中获取数据的例子,但是当时只爬取了一页数据。本文文章介绍了如何使用PowerBI的Power Query批处理采集来自多个网页的数据。Excel 中的操作类似。磷

本文以招联招聘网站为例,采集发布上海招聘信息。

以下是详细步骤:

(一)解析URL结构

打开智联招聘网站,搜索工作地点在上海的数据,

向下滚动页面到底部,找到显示页码的地方,点击前三页,网址如下,

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=1

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=2

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=3

可以看到最后一个数字是页码的ID,是一个控制分页数据的变量。

(二)使用PowerBI采集第一页数据

打开PowerBI Desktop,从网页中获取数据,在弹出的窗口中选择【高级】,根据上面分析的URL结构,在第一行输入除最后一个页码ID外的URL,将页码输入第二行。

从 URL 预览中可以看出,上面两行中的 URL 已经自动合并在一起了;这里单独输入只是为了更清楚地区分页码变量,其实也可以直接输入完整的URL。

(如果页码变量不是最后一位,而是在中间,URL应该分三行输入)

点击确定后,出来了很多表,

从这里可以看出智联招聘网站上的每一个职位信息都是一个表格,不用管它,任意选择一个表格,比如勾选Table0,点击Edit进入Power Query编辑器。

在PQ编辑器中,直接删除[source]后的所有步骤,然后展开数据,删除前面几列的数据。

这样,第一页采集的数据就过来了。然后把这个页面的数据整理一下,删除无用信息,添加字段名称,可以看到一页有60条招聘信息。

这里处理完第一页的数据后,再进行采集的其他页时,排序后的数据结构与第一页的数据结构相同。采集的数据可以直接使用;它不会在这里排序。没关系,你可以等到采集所有的网页数据整理在一起。

如果要大量抓取网页数据,为了节省时间,可以不用整理第一页的数据,直接进入下一步。

(三) 根据页码参数设置自定义函数

这是最重要的一步。

还是刚才第一页数据的PQ编辑器窗口,打开【高级编辑器】,在let前输入:

并将第一行的URL中&后的“1”改成let后(这是第二步使用高级选项分两行输入URL的好处):

更改后,[Source] 的 URL 变为:

确定后,刚才第一页数据的查询窗口直接变成了自定义函数的输入参数窗口,Table0表格也变成了函数的样式。为了更直观,将此函数重命名为 Data_Zhaopin。

至此,自定义功能完成。p是函数的变量,用来控制页码。只需输入一个数字,例如 7,就会捕获第 7 页的数据。

输入参数一次只能抓取一个网页。如果要批量抓取,则需要进行以下步骤。

(四) 批量调用自定义函数

首先使用一个空查询来创建一个数字序列。如果要抓取前100页数据,创建一个1到100的序列,在空查询中输入

按 Enter 生成 1 到 100 的序列,然后将其转换为表格。gif操作图如下:

然后调用自定义函数,

在弹出的窗口中,点击【函数查询】下拉框,选择你刚刚创建的自定义函数Data_Zhaopin,其他的都是默认的。

点击确定开始批量抓取网页,因为100页数据比较大,需要5分钟左右。这也是我第二步预整理数据的结果,导致爬行速度变慢。展开这张表,就是这100页的数据,

至此,100页兆联招聘信息批量抓取完成。上面的步骤好像很多。其实掌握之后,大概10分钟就可以搞定。最大块的时间仍然是最后一步。数据采集的过程相对耗时。

网页的数据不断更新。完成以上步骤后,在PQ中点击刷新,即可随时一键提取实时数据,一次搞定,终身受益!

以上主要使用PowerBI中的Power Query功能,同样可以在Excel中进行可以使用PQ功能的操作。

当然,PowerBI 并不是专业的爬虫工具。如果网页比较复杂或者有反爬虫机制,还是要使用专业的工具,比如R或者Python。在使用PowerBI批量抓取某个网站的数据之前,先尝试采集一页,如果可以采集,则使用上面的步骤,如果采集不行当它到达时,不再有任何延迟。

如果您是 Power BI 新手,您可以在微信公众号回复“PowerBI”:“PowerBI 星球”,获取“PowerBI 七日”电子书,帮助您快速提高工作效率。 查看全部

自动抓取网页数据(

如何用PowerBI的PowerQuery批量采集多个网页的数据(图))

之前介绍PowerBI数据采集的时候,举了一个从网页中获取数据的例子,但是当时只爬取了一页数据。本文文章介绍了如何使用PowerBI的Power Query批处理采集来自多个网页的数据。Excel 中的操作类似。磷

本文以招联招聘网站为例,采集发布上海招聘信息。

以下是详细步骤:

(一)解析URL结构

打开智联招聘网站,搜索工作地点在上海的数据,

向下滚动页面到底部,找到显示页码的地方,点击前三页,网址如下,

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=1

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=2

%e4%b8%8a%e6%b5%b7&sm=0&sg=fe782ca83bfa4b018d27de559d0a5db0&p=3

可以看到最后一个数字是页码的ID,是一个控制分页数据的变量。

(二)使用PowerBI采集第一页数据

打开PowerBI Desktop,从网页中获取数据,在弹出的窗口中选择【高级】,根据上面分析的URL结构,在第一行输入除最后一个页码ID外的URL,将页码输入第二行。

从 URL 预览中可以看出,上面两行中的 URL 已经自动合并在一起了;这里单独输入只是为了更清楚地区分页码变量,其实也可以直接输入完整的URL。

(如果页码变量不是最后一位,而是在中间,URL应该分三行输入)

点击确定后,出来了很多表,

从这里可以看出智联招聘网站上的每一个职位信息都是一个表格,不用管它,任意选择一个表格,比如勾选Table0,点击Edit进入Power Query编辑器。

在PQ编辑器中,直接删除[source]后的所有步骤,然后展开数据,删除前面几列的数据。

这样,第一页采集的数据就过来了。然后把这个页面的数据整理一下,删除无用信息,添加字段名称,可以看到一页有60条招聘信息。

这里处理完第一页的数据后,再进行采集的其他页时,排序后的数据结构与第一页的数据结构相同。采集的数据可以直接使用;它不会在这里排序。没关系,你可以等到采集所有的网页数据整理在一起。

如果要大量抓取网页数据,为了节省时间,可以不用整理第一页的数据,直接进入下一步。

(三) 根据页码参数设置自定义函数

这是最重要的一步。

还是刚才第一页数据的PQ编辑器窗口,打开【高级编辑器】,在let前输入:

并将第一行的URL中&后的“1”改成let后(这是第二步使用高级选项分两行输入URL的好处):

更改后,[Source] 的 URL 变为:

确定后,刚才第一页数据的查询窗口直接变成了自定义函数的输入参数窗口,Table0表格也变成了函数的样式。为了更直观,将此函数重命名为 Data_Zhaopin。

至此,自定义功能完成。p是函数的变量,用来控制页码。只需输入一个数字,例如 7,就会捕获第 7 页的数据。

输入参数一次只能抓取一个网页。如果要批量抓取,则需要进行以下步骤。

(四) 批量调用自定义函数

首先使用一个空查询来创建一个数字序列。如果要抓取前100页数据,创建一个1到100的序列,在空查询中输入

按 Enter 生成 1 到 100 的序列,然后将其转换为表格。gif操作图如下:

然后调用自定义函数,

在弹出的窗口中,点击【函数查询】下拉框,选择你刚刚创建的自定义函数Data_Zhaopin,其他的都是默认的。

点击确定开始批量抓取网页,因为100页数据比较大,需要5分钟左右。这也是我第二步预整理数据的结果,导致爬行速度变慢。展开这张表,就是这100页的数据,

至此,100页兆联招聘信息批量抓取完成。上面的步骤好像很多。其实掌握之后,大概10分钟就可以搞定。最大块的时间仍然是最后一步。数据采集的过程相对耗时。

网页的数据不断更新。完成以上步骤后,在PQ中点击刷新,即可随时一键提取实时数据,一次搞定,终身受益!

以上主要使用PowerBI中的Power Query功能,同样可以在Excel中进行可以使用PQ功能的操作。

当然,PowerBI 并不是专业的爬虫工具。如果网页比较复杂或者有反爬虫机制,还是要使用专业的工具,比如R或者Python。在使用PowerBI批量抓取某个网站的数据之前,先尝试采集一页,如果可以采集,则使用上面的步骤,如果采集不行当它到达时,不再有任何延迟。

如果您是 Power BI 新手,您可以在微信公众号回复“PowerBI”:“PowerBI 星球”,获取“PowerBI 七日”电子书,帮助您快速提高工作效率。

自动抓取网页数据(集搜客GooSeeker网页抓取软件与在线打码平台对接需要配置 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 84 次浏览 • 2021-09-24 14:28

)

极速客的GooSeeker网络爬虫软件可以对接在线编码平台。如果捕获到的网站需要验证码,则将验证码转发到在线编码平台,GooSeeker将返回编码平台。结果自动输入网页,完成编码过程。GooSeeker V5.1.0 版本支持以下功能

注:crontab.xml 文件是 DS 计数机用于定期自动调度多个爬虫窗口的命令文件。详情请参考 GooSeeker 对该文件的解释。下面将详细讲解自动登录和编码平台对接需要配置的参数。

内容

1、自动登录和自动编码需要的参数

请注意:此版本的 GooSeeker 在登录过程中不会自动识别是否需要编码。如果使用以下配置参数,那么在登录过程中必须进行编码。如果您只需要自动登录,请使用专用的 login crontab 命令。

以下是crontab.xml文件中相关指令的crontab登录指令示例.zip(点击下载示例):

2. 参数说明

其他通用参数请参考《如何通过crontab程序实现周期增量采集数据》。下面主要解释几个特殊参数。

比如在GoWhere登录页面,可以看到上图的界面。此参数是 URL %3A%2F%2F%2F

就是上图中需要输入的账户名

是上图中需要输入的密码吗

这是一个标准的xpath,可以用MS找号,打开内容定位功能,在浏览器中点击账号输入框,可以在“网页结构”窗口中找到这个输入框,点击“显示XPath”按钮,可以看到定位这个输入框的XPath表达式,如下