网站内容抓取

网站内容抓取(如何在web主机上强制重定向的做法中使用以下代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-31 16:10

正确的方法是:其中一个重定向到另一个而不是两个。如果两个同时加载,那么站点的版本安全就会有问题。如果您在浏览器中输入网站的网址,请分别测试和测试。

如果两个 URL 都加载了,则会显示两个版本的内容,重复的 URL 可能会导致重复的内容。

为确保您不再遇到此问题,您需要根据站点的平台执行以下操作之一:

在HTACCESS中创建完整的重定向模式(在Apache/CPanel服务器上);

使用 WordPress 中的重定向插件强制重定向。

4、如何在Apache/Cpanel服务器的htaccess中创建重定向

您可以在 Apache/CPanel 服务器的 .htaccess 中执行服务器级全局重定向。Inmotionhosting 有一个很好的教程,教你如何在你的虚拟主机上强制重定向。

如果强制所有网络流量使用HTTPS,则需要使用以下代码。

确保将此代码添加到具有类似前缀(RewriteEngineOn、RewriteCond 等)的代码之上。

重写引擎开启

RewriteCond%{HTTPS}!on

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

RewriteRule(.*)%{HTTP_HOST}%{REQUEST_URI}[L,R=301]

如果只想重定向到特定域,则需要在 htaccess 文件中使用以下代码行:

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

重写引擎开启

RewriteCond%{HTTP_HOST}^example\.com[NC]

RewriteCond%{SERVER_PORT}80

重写规则^(.*)$$1[R=301,L]

注意:如果您不确定对服务器进行正确的更改,请确保您的服务器公司或 IT 人员执行这些维修。

5、如果你运行的是WordPress网站,请使用插件

解决这些重定向问题的简单方法是使用插件,尤其是在运行 WordPress网站 时。

许多插件可以强制重定向,但这里有一些插件可以使这个过程尽可能简单:CMHTTPSPro、WPForceSSL、EasyHTTPSRedirection。

关于插件的注意事项:如果您使用了过多的插件,请不要添加。

您可能需要调查您的服务器是否可以使用上述类似的重定向规则(例如,如果您使用的是基于 NGINX 的服务器)。

这里需要声明:插件的权重会对网站的速度产生负面影响,所以不要总认为新插件会对你有帮助。

6、所有网站链接都应该从

即使执行了上述重定向,也应执行此步骤。

如果您使用绝对 URL 而不是相对 URL,则应该这样做。因为前者总是显示你正在使用的超文本传输协议,如果你使用的是后者,那么你就不需要多注意这个了。

为什么在使用绝对 URL 时需要更改实时链接?因为 Google 会抓取所有这些链接,所以这可能会导致重复的内容。

这似乎是在浪费时间,但事实并非如此。您需要确保 Google 可以准确捕获您的 网站。

7、确保从到的转换,没有404页面

404页面的突然增加可能会让你的网站无法操作,尤其是有页面链接的时候。

另外,由于显示的404页面过多,谷歌没有找到应该抓取的页面,会造成抓取预算的浪费。

Google 负责人 John Mueller 指出,爬取预算并不重要,除非是针对大型网站。

John Mueller 在 Twitter 上表示,他认为爬行预算优化被高估了。对于大多数网站,它没有任何作用,只能帮助大规模的网站。

“IMO 的抓取预算被高估了。实际上,大多数 网站 不需要担心。如果您正在抓取网页或运行具有数十亿个 URL 的 网站,这一点非常重要,但是对于普通的网站来说并不是很重要。”

SEOPowerSuite相关负责人YauhenKhutarniuk的文章文章也对这一点进行了阐述:

”按道理来说,你应该注意抓取预算,因为你希望谷歌在你的网站上发现尽可能多的重要页面。你也希望它在你的网站上快速找到新的内容,您的抓取预算越大(管理越聪明),这将发生得越快。”

优化你的抓取预算非常重要,因为在网站上快速找到新内容是一项重要的任务,你需要在网站上发现尽可能多的优先页面。

8、如何修复可能出现的 404 页面

首先,将 404 从旧 URL 重定向到新的现有 URL。

一个更简单的方法是,如果你有WordPress网站,使用ScreamingFrog抓取网站,使用WordPress重定向插件进行301重定向规则批量上传。

9、URL结构不要太复杂

在准备技术 SEO 时,URL 的结构是一个重要的考虑因素。

这些东西你也一定要注意,比如随机生成索引的动态参数、不易理解的URL,以及其他在技术SEO实施中可能会出现问题的因素。

这些都是重要的因素,因为它们可能会导致索引问题,从而损害 网站 的性能。

10、 更人性化的网址

创建 URL 时,您可以考虑相关内容,然后自动创建 URL。然而,这可能并不合理。

原因是自动生成的 URL 可以遵循几种不同的格式,没有一种是非常用户友好的。

例如:

(1)/内容/日期/时间/关键字

(2)/Content/Date/Time/Number string

(3)/内容/类别/日期/时间/

(4)/content/category/date/time/parameter/

正确传达 URL 背后的内容是关键。由于可访问性,它在今天变得更加重要。

URL 的可读性越高越好:如果有人在搜索结果中看到您的 URL,他们可能更愿意点击它,因为他们会确切地看到 URL 与他们搜索的内容的相关性。简而言之,URL 需要匹配用户的搜索意图。

许多现有的 网站 使用过时或混乱的 URL 结构,导致用户参与度低。如果您有一个对用户更友好的 URL,您的 网站 可能会有更高的用户参与度。

11、 重复的 URL

在构建任何链接之前需要考虑的一个 SEO 技术问题是:内容重复。

说到内容重复,主要有以下几个原因:

(1)在网站的各个部分显着重复的内容。

(2) 从其他 网站 抓取内容。

(3) 重复的 URL,其中只存在一个内容。

因为当多个 URL 代表一个内容时,它确实会混淆搜索引擎。搜索引擎很少同时显示相同的内容,重复的 URL 会削弱其搜索能力。

12、避免使用动态参数

尽管动态参数本身不是 SEO 问题,但如果您无法管理它们的创建并使其在使用中保持一致,它们将来可能会成为潜在威胁。

JesScholz在搜索引擎杂志文章上发表了一篇文章,内容涉及动态参数和URL处理的基础知识以及它如何影响SEO。

Scholz 解释说,参数用于以下目的:跟踪、重新排序、过滤、识别、分页、搜索、翻译。

当您发现问题是由 URL 的动态参数引起时,通常将其归因于 URL 的基本管理不善。

在跟踪的情况下,创建搜索引擎抓取的链接时可以使用不同的动态参数。在重新排序的情况下,使用这些不同的动态参数对列表和项目组进行重新排序,然后创建可索引的重复页面,然后由搜索引擎抓取。

如果动态参数没有保持在可管理的水平,可能会在不经意间导致过多重复的内容。

如果不仔细管理一部分内容的创建,这些动态URL的创建实际上会随着时间的推移而积累,这会稀释内容的质量,削弱搜索引擎的执行能力。

还会造成关键词“同类相食”,相互影响,在足够大的范围内严重影响你的竞争力。

13、 短网址比长网址好

长期 SEO 实践的结果是,较短的 URL 优于较长的 URL。

Google 的 John Mueller 说:“当我们有两个内容相同的 URL 时,我们需要选择其中一个显示在搜索结果中,我们会选择较短的一个,这就是规范化。当然,长度不是主要的影响因素,但是如果我们有两个网址,一个很简洁,另一个有很长的附加参数,当它们显示相同的内容时,我们更喜欢选择短的。有很多例子,比如不同的因素在起作用,但其他条件相同——你有一个较短的和一个较长的,我们也会选择较短的。”

还有证据表明,谷歌优先考虑短网址而不是较长的网址。

如果您的 网站 收录很长的 URL,您可以将它们优化为更短、更简洁的 URL,以更好地反映 文章 的主题和用户意图。

热门标签 查看全部

网站内容抓取(如何在web主机上强制重定向的做法中使用以下代码)

正确的方法是:其中一个重定向到另一个而不是两个。如果两个同时加载,那么站点的版本安全就会有问题。如果您在浏览器中输入网站的网址,请分别测试和测试。

如果两个 URL 都加载了,则会显示两个版本的内容,重复的 URL 可能会导致重复的内容。

为确保您不再遇到此问题,您需要根据站点的平台执行以下操作之一:

在HTACCESS中创建完整的重定向模式(在Apache/CPanel服务器上);

使用 WordPress 中的重定向插件强制重定向。

4、如何在Apache/Cpanel服务器的htaccess中创建重定向

您可以在 Apache/CPanel 服务器的 .htaccess 中执行服务器级全局重定向。Inmotionhosting 有一个很好的教程,教你如何在你的虚拟主机上强制重定向。

如果强制所有网络流量使用HTTPS,则需要使用以下代码。

确保将此代码添加到具有类似前缀(RewriteEngineOn、RewriteCond 等)的代码之上。

重写引擎开启

RewriteCond%{HTTPS}!on

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

RewriteRule(.*)%{HTTP_HOST}%{REQUEST_URI}[L,R=301]

如果只想重定向到特定域,则需要在 htaccess 文件中使用以下代码行:

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

重写引擎开启

RewriteCond%{HTTP_HOST}^example\.com[NC]

RewriteCond%{SERVER_PORT}80

重写规则^(.*)$$1[R=301,L]

注意:如果您不确定对服务器进行正确的更改,请确保您的服务器公司或 IT 人员执行这些维修。

5、如果你运行的是WordPress网站,请使用插件

解决这些重定向问题的简单方法是使用插件,尤其是在运行 WordPress网站 时。

许多插件可以强制重定向,但这里有一些插件可以使这个过程尽可能简单:CMHTTPSPro、WPForceSSL、EasyHTTPSRedirection。

关于插件的注意事项:如果您使用了过多的插件,请不要添加。

您可能需要调查您的服务器是否可以使用上述类似的重定向规则(例如,如果您使用的是基于 NGINX 的服务器)。

这里需要声明:插件的权重会对网站的速度产生负面影响,所以不要总认为新插件会对你有帮助。

6、所有网站链接都应该从

即使执行了上述重定向,也应执行此步骤。

如果您使用绝对 URL 而不是相对 URL,则应该这样做。因为前者总是显示你正在使用的超文本传输协议,如果你使用的是后者,那么你就不需要多注意这个了。

为什么在使用绝对 URL 时需要更改实时链接?因为 Google 会抓取所有这些链接,所以这可能会导致重复的内容。

这似乎是在浪费时间,但事实并非如此。您需要确保 Google 可以准确捕获您的 网站。

7、确保从到的转换,没有404页面

404页面的突然增加可能会让你的网站无法操作,尤其是有页面链接的时候。

另外,由于显示的404页面过多,谷歌没有找到应该抓取的页面,会造成抓取预算的浪费。

Google 负责人 John Mueller 指出,爬取预算并不重要,除非是针对大型网站。

John Mueller 在 Twitter 上表示,他认为爬行预算优化被高估了。对于大多数网站,它没有任何作用,只能帮助大规模的网站。

“IMO 的抓取预算被高估了。实际上,大多数 网站 不需要担心。如果您正在抓取网页或运行具有数十亿个 URL 的 网站,这一点非常重要,但是对于普通的网站来说并不是很重要。”

SEOPowerSuite相关负责人YauhenKhutarniuk的文章文章也对这一点进行了阐述:

”按道理来说,你应该注意抓取预算,因为你希望谷歌在你的网站上发现尽可能多的重要页面。你也希望它在你的网站上快速找到新的内容,您的抓取预算越大(管理越聪明),这将发生得越快。”

优化你的抓取预算非常重要,因为在网站上快速找到新内容是一项重要的任务,你需要在网站上发现尽可能多的优先页面。

8、如何修复可能出现的 404 页面

首先,将 404 从旧 URL 重定向到新的现有 URL。

一个更简单的方法是,如果你有WordPress网站,使用ScreamingFrog抓取网站,使用WordPress重定向插件进行301重定向规则批量上传。

9、URL结构不要太复杂

在准备技术 SEO 时,URL 的结构是一个重要的考虑因素。

这些东西你也一定要注意,比如随机生成索引的动态参数、不易理解的URL,以及其他在技术SEO实施中可能会出现问题的因素。

这些都是重要的因素,因为它们可能会导致索引问题,从而损害 网站 的性能。

10、 更人性化的网址

创建 URL 时,您可以考虑相关内容,然后自动创建 URL。然而,这可能并不合理。

原因是自动生成的 URL 可以遵循几种不同的格式,没有一种是非常用户友好的。

例如:

(1)/内容/日期/时间/关键字

(2)/Content/Date/Time/Number string

(3)/内容/类别/日期/时间/

(4)/content/category/date/time/parameter/

正确传达 URL 背后的内容是关键。由于可访问性,它在今天变得更加重要。

URL 的可读性越高越好:如果有人在搜索结果中看到您的 URL,他们可能更愿意点击它,因为他们会确切地看到 URL 与他们搜索的内容的相关性。简而言之,URL 需要匹配用户的搜索意图。

许多现有的 网站 使用过时或混乱的 URL 结构,导致用户参与度低。如果您有一个对用户更友好的 URL,您的 网站 可能会有更高的用户参与度。

11、 重复的 URL

在构建任何链接之前需要考虑的一个 SEO 技术问题是:内容重复。

说到内容重复,主要有以下几个原因:

(1)在网站的各个部分显着重复的内容。

(2) 从其他 网站 抓取内容。

(3) 重复的 URL,其中只存在一个内容。

因为当多个 URL 代表一个内容时,它确实会混淆搜索引擎。搜索引擎很少同时显示相同的内容,重复的 URL 会削弱其搜索能力。

12、避免使用动态参数

尽管动态参数本身不是 SEO 问题,但如果您无法管理它们的创建并使其在使用中保持一致,它们将来可能会成为潜在威胁。

JesScholz在搜索引擎杂志文章上发表了一篇文章,内容涉及动态参数和URL处理的基础知识以及它如何影响SEO。

Scholz 解释说,参数用于以下目的:跟踪、重新排序、过滤、识别、分页、搜索、翻译。

当您发现问题是由 URL 的动态参数引起时,通常将其归因于 URL 的基本管理不善。

在跟踪的情况下,创建搜索引擎抓取的链接时可以使用不同的动态参数。在重新排序的情况下,使用这些不同的动态参数对列表和项目组进行重新排序,然后创建可索引的重复页面,然后由搜索引擎抓取。

如果动态参数没有保持在可管理的水平,可能会在不经意间导致过多重复的内容。

如果不仔细管理一部分内容的创建,这些动态URL的创建实际上会随着时间的推移而积累,这会稀释内容的质量,削弱搜索引擎的执行能力。

还会造成关键词“同类相食”,相互影响,在足够大的范围内严重影响你的竞争力。

13、 短网址比长网址好

长期 SEO 实践的结果是,较短的 URL 优于较长的 URL。

Google 的 John Mueller 说:“当我们有两个内容相同的 URL 时,我们需要选择其中一个显示在搜索结果中,我们会选择较短的一个,这就是规范化。当然,长度不是主要的影响因素,但是如果我们有两个网址,一个很简洁,另一个有很长的附加参数,当它们显示相同的内容时,我们更喜欢选择短的。有很多例子,比如不同的因素在起作用,但其他条件相同——你有一个较短的和一个较长的,我们也会选择较短的。”

还有证据表明,谷歌优先考虑短网址而不是较长的网址。

如果您的 网站 收录很长的 URL,您可以将它们优化为更短、更简洁的 URL,以更好地反映 文章 的主题和用户意图。

热门标签

网站内容抓取(就是网站内容无法被百度搜索引擎有排名的,这是为什么呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-30 23:08

网站在互联网企业的发展中扮演着重要的角色。如果网站能够在搜索引擎首页上排名,那么看到网站的用户就会很多,网站会获得更多的流量,转化率也会相应提高。

但是有的SEO人员在做企业网站排名优化时会遇到这样的情况,即网站正常更新,百度搜索引擎不抓取网站的内容,所以 网站 不会被排名。为什么?

1、网站低重量

如果网站的权重很低,会导致百度搜索引擎无法抓取网站的内容。因此,想要百度搜索引擎抓取网站的内容,需要提高网站的整体质量和权重,这也有利于网站的排名。

2、网站服务器

如果网站服务器不稳定,安全性相对较差,百度搜索引擎将无法抓取网站的内容。所以在选择服务器时一定要选择独立、稳定、安全性高的服务器,这样的服务器才有利于网站收录的内容。

3、网站被处罚

一些SEO人员在做网站优化时会过度优化网站,这样不仅不会提升网站的排名,而且网站还会被搜索引擎惩罚. 这样一来,网站 的内容就不会是 收录。如果遇到这种情况,一定要及时调整优化策略。只有这样才能再次搜索网站的内容收录。

4、动态页面

如果网站页面是动态的,百度搜索引擎很难抓取页面内容。因此,有必要将页面调整为静态和伪静态页面,以方便百度搜索引擎抓取网站的内容。

5、经常修改网站

如果SEO人员经常修改网站的版本,也会造成这种情况。因此,在确定网站的结构后,一定不要轻易修改网站的版本,以免发生这种情况。

总之,当网站的内容无法被百度搜索引擎抓取时,你必须详细检查网站,找出原因,然后解决问题。只有这样,网站才有更好的发展空间。

蝙蝠侠 IT

转载需授权! 查看全部

网站内容抓取(就是网站内容无法被百度搜索引擎有排名的,这是为什么呢?)

网站在互联网企业的发展中扮演着重要的角色。如果网站能够在搜索引擎首页上排名,那么看到网站的用户就会很多,网站会获得更多的流量,转化率也会相应提高。

但是有的SEO人员在做企业网站排名优化时会遇到这样的情况,即网站正常更新,百度搜索引擎不抓取网站的内容,所以 网站 不会被排名。为什么?

1、网站低重量

如果网站的权重很低,会导致百度搜索引擎无法抓取网站的内容。因此,想要百度搜索引擎抓取网站的内容,需要提高网站的整体质量和权重,这也有利于网站的排名。

2、网站服务器

如果网站服务器不稳定,安全性相对较差,百度搜索引擎将无法抓取网站的内容。所以在选择服务器时一定要选择独立、稳定、安全性高的服务器,这样的服务器才有利于网站收录的内容。

3、网站被处罚

一些SEO人员在做网站优化时会过度优化网站,这样不仅不会提升网站的排名,而且网站还会被搜索引擎惩罚. 这样一来,网站 的内容就不会是 收录。如果遇到这种情况,一定要及时调整优化策略。只有这样才能再次搜索网站的内容收录。

4、动态页面

如果网站页面是动态的,百度搜索引擎很难抓取页面内容。因此,有必要将页面调整为静态和伪静态页面,以方便百度搜索引擎抓取网站的内容。

5、经常修改网站

如果SEO人员经常修改网站的版本,也会造成这种情况。因此,在确定网站的结构后,一定不要轻易修改网站的版本,以免发生这种情况。

总之,当网站的内容无法被百度搜索引擎抓取时,你必须详细检查网站,找出原因,然后解决问题。只有这样,网站才有更好的发展空间。

蝙蝠侠 IT

转载需授权!

网站内容抓取(我如何删除此异常并运行我的代码预先感谢解决方案 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-10-30 07:27

)

问题

嗨,我正在尝试获取网站的数据。我为此编写了代码。想抓取按钮点击事件中的数据,但是运行程序时,抛出异常。

异常是:java.lang.NoClassDefFoundError: com/google/common/base/Function

如何删除此异常并运行我的程序

这是我试过的代码

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import org.openqa.selenium.support.ui.Select;

public class GetData {

public static void main(String args[]) throws InterruptedException {

WebDriver driver = new FirefoxDriver();

driver.get("http://www.upmandiparishad.in/ ... 6quot;);

Thread.sleep(5000);

// select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

// click button

Thread.sleep(3000);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(5000);

//get only table tex

WebElement findElement = driver.findElement(By.className("grid-view"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText);

driver.close();

driver.quit();

}

}

提前致谢

解决方案

希望对你有帮助。

//select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

String sDate = "12/04/2014"; //What date you want

driver.findElement(By.id("ctl00_ContentPlaceHolder1_txt_rate")).sendKeys(sDate);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(3000);

WebElement findElement = driver.findElement(By.id("ctl00_ContentPlaceHolder1_GridView1"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText); 查看全部

网站内容抓取(我如何删除此异常并运行我的代码预先感谢解决方案

)

问题

嗨,我正在尝试获取网站的数据。我为此编写了代码。想抓取按钮点击事件中的数据,但是运行程序时,抛出异常。

异常是:java.lang.NoClassDefFoundError: com/google/common/base/Function

如何删除此异常并运行我的程序

这是我试过的代码

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import org.openqa.selenium.support.ui.Select;

public class GetData {

public static void main(String args[]) throws InterruptedException {

WebDriver driver = new FirefoxDriver();

driver.get("http://www.upmandiparishad.in/ ... 6quot;);

Thread.sleep(5000);

// select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

// click button

Thread.sleep(3000);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(5000);

//get only table tex

WebElement findElement = driver.findElement(By.className("grid-view"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText);

driver.close();

driver.quit();

}

}

提前致谢

解决方案

希望对你有帮助。

//select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

String sDate = "12/04/2014"; //What date you want

driver.findElement(By.id("ctl00_ContentPlaceHolder1_txt_rate")).sendKeys(sDate);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(3000);

WebElement findElement = driver.findElement(By.id("ctl00_ContentPlaceHolder1_GridView1"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText);

网站内容抓取(如何解决搜索引擎爬虫对我们的网页重复抓取的问题?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2021-10-30 06:09

对于每一个SEO从业者来说,每天都有爬虫来我们网站来爬取网页,这是非常宝贵的资源。但是,由于爬虫的无序爬行,难免会浪费爬虫的一些爬取资源。同时,我们需要解决搜索引擎爬虫反复抓取我们网页的问题。接下来,赵延刚就和大家谈谈如何解决这个问题。

在谈论这个问题之前,我们需要了解一个概念。首先,爬虫本身就是一个无序爬行。他不知道先抓什么,后抓什么。他只知道他看到了什么,经过计算,他认为有价值的话就会去抢。

对我们来说,在整个爬取过程中,必须解决以下几类

和上面的分类一样,我们根据顺序定义爬虫最需要爬取的分类。

对于大型网站,搜索引擎爬虫的抓取资源过多,而对于小型网站,抓取资源稀缺。所以在这里我们强调,我们并不是要解决搜索导致的重复爬行问题,而是要解决搜索引擎爬虫对我们想要爬取的页面的最快爬取。这个想法必须纠正!

接下来,我们来谈谈如何让搜索引擎爬虫以最快的速度抓取我们想要被抓取的页面。

爬虫是抓取网页并从该网页中找到更多链接的过程。那么我们就需要知道,如果我们想要被爬虫以更大的概率爬取,就必须给搜索引擎更多的链接。爬虫找到我们要爬取的网页。这里我以上面提到的第一种情况为例:

新生成的页面,尚未被抓取

这种类型的页面通常是文章页面,而我们这种类型页面的网站每天都会大量生产,所以我们会在更多的网页上给出这部分的链接。比如首页、频道页、栏目/列表页、专题聚合页,甚至文章页本身,都需要有一个最新的文章栏目等待爬虫抓取我们的任何网页。可以找到最新的文章。

同时,想象一下这么多页面都有新的文章的链接,链接传递权重。然后新的文章已经爬过了,权重不低。成为收录的速度将得到显着提升。

对于很久没有收录的,也可以考虑是不是权重过低。我会提供更多的内部链条支撑并传递一些重量。应该有收录的可能。当然也可能不是收录,那你就得靠内容本身的质量了。之前有一篇文章文章专门讲了内容质量,欢迎大家阅读:哪些内容容易被百度判断为优质内容?.

因此,为了解决搜索引擎爬虫重复爬取的问题,并不是我们最终的解决方案。由于搜索引擎爬虫本质上是无序的,我们只能针对网站的架构、推荐算法、运营策略进行干预。爬虫给了我们更理想的爬虫效果。如果没有根据爬虫自身的爬取效果进行优化网站,也可以联系我。

延伸阅读

原创文章:《如何解决搜索引擎爬虫重复爬行的问题》,作者:赵延刚。未经许可请勿转载。如转载请注明出处: 查看全部

网站内容抓取(如何解决搜索引擎爬虫对我们的网页重复抓取的问题?)

对于每一个SEO从业者来说,每天都有爬虫来我们网站来爬取网页,这是非常宝贵的资源。但是,由于爬虫的无序爬行,难免会浪费爬虫的一些爬取资源。同时,我们需要解决搜索引擎爬虫反复抓取我们网页的问题。接下来,赵延刚就和大家谈谈如何解决这个问题。

在谈论这个问题之前,我们需要了解一个概念。首先,爬虫本身就是一个无序爬行。他不知道先抓什么,后抓什么。他只知道他看到了什么,经过计算,他认为有价值的话就会去抢。

对我们来说,在整个爬取过程中,必须解决以下几类

和上面的分类一样,我们根据顺序定义爬虫最需要爬取的分类。

对于大型网站,搜索引擎爬虫的抓取资源过多,而对于小型网站,抓取资源稀缺。所以在这里我们强调,我们并不是要解决搜索导致的重复爬行问题,而是要解决搜索引擎爬虫对我们想要爬取的页面的最快爬取。这个想法必须纠正!

接下来,我们来谈谈如何让搜索引擎爬虫以最快的速度抓取我们想要被抓取的页面。

爬虫是抓取网页并从该网页中找到更多链接的过程。那么我们就需要知道,如果我们想要被爬虫以更大的概率爬取,就必须给搜索引擎更多的链接。爬虫找到我们要爬取的网页。这里我以上面提到的第一种情况为例:

新生成的页面,尚未被抓取

这种类型的页面通常是文章页面,而我们这种类型页面的网站每天都会大量生产,所以我们会在更多的网页上给出这部分的链接。比如首页、频道页、栏目/列表页、专题聚合页,甚至文章页本身,都需要有一个最新的文章栏目等待爬虫抓取我们的任何网页。可以找到最新的文章。

同时,想象一下这么多页面都有新的文章的链接,链接传递权重。然后新的文章已经爬过了,权重不低。成为收录的速度将得到显着提升。

对于很久没有收录的,也可以考虑是不是权重过低。我会提供更多的内部链条支撑并传递一些重量。应该有收录的可能。当然也可能不是收录,那你就得靠内容本身的质量了。之前有一篇文章文章专门讲了内容质量,欢迎大家阅读:哪些内容容易被百度判断为优质内容?.

因此,为了解决搜索引擎爬虫重复爬取的问题,并不是我们最终的解决方案。由于搜索引擎爬虫本质上是无序的,我们只能针对网站的架构、推荐算法、运营策略进行干预。爬虫给了我们更理想的爬虫效果。如果没有根据爬虫自身的爬取效果进行优化网站,也可以联系我。

延伸阅读

原创文章:《如何解决搜索引擎爬虫重复爬行的问题》,作者:赵延刚。未经许可请勿转载。如转载请注明出处:

网站内容抓取(搜索引擎会没有派出蜘蛛通过访问网站进行抓取内容页面收录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-10-29 21:15

我们都知道搜索引擎不会通过访问网站发送蜘蛛抓取内容页面。如果你的网站没有被爬取,会影响到收录,所以我们需要了解为什么会出现不爬取的问题。

一、网站 建筑垃圾消耗蜘蛛资源

搜索引擎对网站有蜘蛛配额,不同权重的网站获得的蜘蛛配额数量差别很大。如果你确定你的网站每日蜘蛛访问是正常的,如果页面没有被抓取,很可能是网站结构问题导致蜘蛛资源浪费在抓取收录 页。

二、 每天提交大量不合规页面

有时候,为了加快一些陈旧抄袭的文章收录,我们每天都会重复提交大量这样的页面。这无疑是在告诉搜索引擎抓取指定页面,但不会有蜘蛛抓取新页面。如果拿了,也是对蜘蛛配额资源的消耗。

三、网站 出现异常问题

有些网站有一些不易察觉的异常。这样一来,蜘蛛在访问之后出现问题就不会爬行了。这就像一个人看到了死胡同,不会去。

四、网站速度问题

如果网站的打开访问速度不够快,只会被蜘蛛访问,不会被爬取。原因是蜘蛛已经了解到这个页面的速度和效率不足以爬取内容参数属性进行分析收录。

五、网站安全问题

网站 除了异常和速度,安全等级也会影响蜘蛛是否会爬取页面。这是一个比喻,避免偷窃小偷进入商店并损害他们的用户和利益。

六、网站 有违规行为

网站 如果有其他不规范的营销、广告、设计不合理、布局不友好等,也会影响搜索引擎蜘蛛对页面的抓取。

七、网站SEO水平太差

访问网站后,蜘蛛发现规范性和正确性太差,不符合内容页收录的要求。如果网站只有收录首页和少量内容页,你应该检查SEO优化。

除了上面爬不出来的问题,还有爬取后失败的问题,可以参考:网站内容页爬取失败导致不收录的原因

SEO私馆结束语:将蜘蛛爬取资源分配给最需要的页面的URL地址收录。不要错误地认为更多的蜘蛛访问意味着更多的爬行。不要小看当前搜索引擎的AI技术处理能力。

《网站排名不上去的原因_没有关键词_没有收录内容页》

《搜索引擎蜘蛛访问与爬行的区别》

《搜索引擎无法访问网站的原因总结》 查看全部

网站内容抓取(搜索引擎会没有派出蜘蛛通过访问网站进行抓取内容页面收录)

我们都知道搜索引擎不会通过访问网站发送蜘蛛抓取内容页面。如果你的网站没有被爬取,会影响到收录,所以我们需要了解为什么会出现不爬取的问题。

一、网站 建筑垃圾消耗蜘蛛资源

搜索引擎对网站有蜘蛛配额,不同权重的网站获得的蜘蛛配额数量差别很大。如果你确定你的网站每日蜘蛛访问是正常的,如果页面没有被抓取,很可能是网站结构问题导致蜘蛛资源浪费在抓取收录 页。

二、 每天提交大量不合规页面

有时候,为了加快一些陈旧抄袭的文章收录,我们每天都会重复提交大量这样的页面。这无疑是在告诉搜索引擎抓取指定页面,但不会有蜘蛛抓取新页面。如果拿了,也是对蜘蛛配额资源的消耗。

三、网站 出现异常问题

有些网站有一些不易察觉的异常。这样一来,蜘蛛在访问之后出现问题就不会爬行了。这就像一个人看到了死胡同,不会去。

四、网站速度问题

如果网站的打开访问速度不够快,只会被蜘蛛访问,不会被爬取。原因是蜘蛛已经了解到这个页面的速度和效率不足以爬取内容参数属性进行分析收录。

五、网站安全问题

网站 除了异常和速度,安全等级也会影响蜘蛛是否会爬取页面。这是一个比喻,避免偷窃小偷进入商店并损害他们的用户和利益。

六、网站 有违规行为

网站 如果有其他不规范的营销、广告、设计不合理、布局不友好等,也会影响搜索引擎蜘蛛对页面的抓取。

七、网站SEO水平太差

访问网站后,蜘蛛发现规范性和正确性太差,不符合内容页收录的要求。如果网站只有收录首页和少量内容页,你应该检查SEO优化。

除了上面爬不出来的问题,还有爬取后失败的问题,可以参考:网站内容页爬取失败导致不收录的原因

SEO私馆结束语:将蜘蛛爬取资源分配给最需要的页面的URL地址收录。不要错误地认为更多的蜘蛛访问意味着更多的爬行。不要小看当前搜索引擎的AI技术处理能力。

《网站排名不上去的原因_没有关键词_没有收录内容页》

《搜索引擎蜘蛛访问与爬行的区别》

《搜索引擎无法访问网站的原因总结》

网站内容抓取(网站怎么快速被爬虫?外链也能影响权重导入链接)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-29 03:04

在这个互联网时代,很多人在购买新品之前都会上网查资料,看看哪些品牌的口碑和评价比较好。这时候,排名靠前的产品就会占据绝对优势。据调查,87%的网民会使用搜索引擎服务寻找自己需要的信息,其中近70%的搜索者会直接在搜索结果自然排名的第一页找到自己需要的信息。

可见,目前SEO对于企业和产品具有不可替代的意义。接下来,我将告诉你如何在网站中快速被爬虫爬取。

1.关键词 是重中之重

我们经常听到人们谈论关键词,但是关键词的具体用途是什么?关键词是SEO的核心,也是网站在搜索引擎中排名的重要因素。

2. 外链也会影响权重

导入链接也是网站优化的一个非常重要的过程,可以间接影响网站在搜索引擎中的权重。目前常用的链接分为:锚文本链接、超链接、纯文本链接和图片链接。

3.如何被爬虫抓取?

爬虫是自动提取网页的程序,比如百度的蜘蛛。如果你想让你的网站页面更多的成为收录,你必须先让网页被爬虫抓取。

如果你的网站页面更新频繁,爬虫会更频繁地访问该页面,高质量的内容是爬虫喜欢爬取的目标,尤其是原创内容。

网站如何快速被蜘蛛爬取

1.网站 和页面权重。

这必须是第一要务。网站 权重高、资历老、权限大的蜘蛛,一定要特别对待。这样网站的爬取频率是非常高的,大家都知道搜索引擎蜘蛛为了保证Efficient,并不是所有的页面都会被网站爬取,而且网站的权重越高,爬取的深度越高,对应的可以爬取的页面也就越多,这样可以网站@收录也会有更多的页面。

2.网站 服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那就谢天谢地了,蜘蛛想来也来不来。百度蜘蛛也是网站的访客。如果你的服务器不稳定或者卡住了,蜘蛛每次都很难爬到,有时只能爬到一个页面的一部分。这样一来,随着时间的推移,百度蜘蛛你的体验越来越差,你对网站的评价会越来越低,自然会影响你对网站的爬取,所以你一定愿意选择空间服务器。没有很好的基础。,再好的房子也会穿越。

3. 网站 的更新频率。

每次蜘蛛爬行时,都会存储页面数据。如果第二次爬取发现页面和第一次收录完全一样,说明页面没有更新,蜘蛛不需要频繁爬取。页面内容更新频繁,蜘蛛会更频繁地访问页面,但蜘蛛不是你一个人的,不可能蹲在这里等你更新,所以一定要主动展示给蜘蛛文章更新,让蜘蛛按照你的规则有效爬取,不仅让你的更新文章被更快的捕获,而且不会导致蜘蛛频繁跑徒然。

4.文章的原创性质。

高质量的原创内容对百度蜘蛛来说非常有吸引力。蜘蛛的目的是寻找新的东西,所以网站更新文章不要采集,不要天天转载。我们需要给蜘蛛提供真正有价值的 原创 内容。蜘蛛如果能拿到自己喜欢的东西,自然会对你的网站产生好感,经常来找吃的。

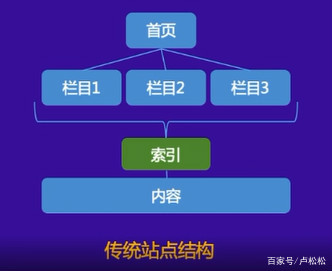

5.扁平的网站结构。

蜘蛛爬行也有自己的路线。在你给他铺路之前,网站结构不要太复杂,链接层次不要太深。如果链接层次太深,后面的页面就很难被蜘蛛抓取到。获得。

6.网站 程序。

在网站程序中,有很多程序可以创建大量的重复页面。这个页面一般是通过参数实现的。当一个页面对应多个URL时,会造成网站重复的内容,可能导致网站被降级,严重影响蜘蛛的爬取。因此,程序必须确保一个页面只有一个 URL。如果已经生成,请尝试使用301重定向、Canonical标签或Robots流程,以确保蜘蛛只抓取一个标准网址。

7.外链建设。

大家都知道外链可以吸引蜘蛛到网站,尤其是新网站的时候,网站还不是很成熟,蜘蛛访问量比较少,外链可以在网站页面添加网站暴露在蜘蛛面前可以防止蜘蛛无法找到页面。在外链建设的过程中,需要注意外链的质量。不要为了省事而做无用的事情。百度现在相信大家都知道外链的管理。

8.内部链构建。

蜘蛛爬行是跟着链接走的,所以合理优化内链可以要求蜘蛛爬取更多的页面,促进网站的收录。内链建设过程中应给予用户合理的建议。除了在文章中添加锚文本,还可以设置相关推荐、热门文章、更多喜欢等栏目,这个很多网站都在使用,让蜘蛛爬取一个更广泛的页面。 查看全部

网站内容抓取(网站怎么快速被爬虫?外链也能影响权重导入链接)

在这个互联网时代,很多人在购买新品之前都会上网查资料,看看哪些品牌的口碑和评价比较好。这时候,排名靠前的产品就会占据绝对优势。据调查,87%的网民会使用搜索引擎服务寻找自己需要的信息,其中近70%的搜索者会直接在搜索结果自然排名的第一页找到自己需要的信息。

可见,目前SEO对于企业和产品具有不可替代的意义。接下来,我将告诉你如何在网站中快速被爬虫爬取。

1.关键词 是重中之重

我们经常听到人们谈论关键词,但是关键词的具体用途是什么?关键词是SEO的核心,也是网站在搜索引擎中排名的重要因素。

2. 外链也会影响权重

导入链接也是网站优化的一个非常重要的过程,可以间接影响网站在搜索引擎中的权重。目前常用的链接分为:锚文本链接、超链接、纯文本链接和图片链接。

3.如何被爬虫抓取?

爬虫是自动提取网页的程序,比如百度的蜘蛛。如果你想让你的网站页面更多的成为收录,你必须先让网页被爬虫抓取。

如果你的网站页面更新频繁,爬虫会更频繁地访问该页面,高质量的内容是爬虫喜欢爬取的目标,尤其是原创内容。

网站如何快速被蜘蛛爬取

1.网站 和页面权重。

这必须是第一要务。网站 权重高、资历老、权限大的蜘蛛,一定要特别对待。这样网站的爬取频率是非常高的,大家都知道搜索引擎蜘蛛为了保证Efficient,并不是所有的页面都会被网站爬取,而且网站的权重越高,爬取的深度越高,对应的可以爬取的页面也就越多,这样可以网站@收录也会有更多的页面。

2.网站 服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那就谢天谢地了,蜘蛛想来也来不来。百度蜘蛛也是网站的访客。如果你的服务器不稳定或者卡住了,蜘蛛每次都很难爬到,有时只能爬到一个页面的一部分。这样一来,随着时间的推移,百度蜘蛛你的体验越来越差,你对网站的评价会越来越低,自然会影响你对网站的爬取,所以你一定愿意选择空间服务器。没有很好的基础。,再好的房子也会穿越。

3. 网站 的更新频率。

每次蜘蛛爬行时,都会存储页面数据。如果第二次爬取发现页面和第一次收录完全一样,说明页面没有更新,蜘蛛不需要频繁爬取。页面内容更新频繁,蜘蛛会更频繁地访问页面,但蜘蛛不是你一个人的,不可能蹲在这里等你更新,所以一定要主动展示给蜘蛛文章更新,让蜘蛛按照你的规则有效爬取,不仅让你的更新文章被更快的捕获,而且不会导致蜘蛛频繁跑徒然。

4.文章的原创性质。

高质量的原创内容对百度蜘蛛来说非常有吸引力。蜘蛛的目的是寻找新的东西,所以网站更新文章不要采集,不要天天转载。我们需要给蜘蛛提供真正有价值的 原创 内容。蜘蛛如果能拿到自己喜欢的东西,自然会对你的网站产生好感,经常来找吃的。

5.扁平的网站结构。

蜘蛛爬行也有自己的路线。在你给他铺路之前,网站结构不要太复杂,链接层次不要太深。如果链接层次太深,后面的页面就很难被蜘蛛抓取到。获得。

6.网站 程序。

在网站程序中,有很多程序可以创建大量的重复页面。这个页面一般是通过参数实现的。当一个页面对应多个URL时,会造成网站重复的内容,可能导致网站被降级,严重影响蜘蛛的爬取。因此,程序必须确保一个页面只有一个 URL。如果已经生成,请尝试使用301重定向、Canonical标签或Robots流程,以确保蜘蛛只抓取一个标准网址。

7.外链建设。

大家都知道外链可以吸引蜘蛛到网站,尤其是新网站的时候,网站还不是很成熟,蜘蛛访问量比较少,外链可以在网站页面添加网站暴露在蜘蛛面前可以防止蜘蛛无法找到页面。在外链建设的过程中,需要注意外链的质量。不要为了省事而做无用的事情。百度现在相信大家都知道外链的管理。

8.内部链构建。

蜘蛛爬行是跟着链接走的,所以合理优化内链可以要求蜘蛛爬取更多的页面,促进网站的收录。内链建设过程中应给予用户合理的建议。除了在文章中添加锚文本,还可以设置相关推荐、热门文章、更多喜欢等栏目,这个很多网站都在使用,让蜘蛛爬取一个更广泛的页面。

网站内容抓取(集搜客网络爬虫软件是一款免费的网页数据工具。)

网站优化 • 优采云 发表了文章 • 0 个评论 • 98 次浏览 • 2021-10-29 03:02

第三步:提取内容。上面两步我们使用requests向网页请求数据,使用bs4解析页面。现在我们来到最关键的一步:。

它可以帮助我们快速采集互联网的海量内容,进行深入的数据分析和挖掘。比如抓取各大网站的排名,抓取各大购物的价格信息网站等等。而我们每天常用的搜索引擎都是“网络爬虫”。但毕竟。

爬取网页内容的一个例子来自于通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。例如,我们有一个。

极手客网络爬虫软件是一款免费的网络数据爬取工具,可将网络内容转化为excel表格,进行内容分析、文本分析、策略分析和文档分析。自动分词、社交网络分析、情感分析软件于研究生设计和行业研究。

URL就像网站和搜索引擎爬虫之间的桥梁:为了能够抓取你的网站内容,爬虫需要能够找到并跨越这些桥梁(即找到并抓取你的URLs )。如果您的 URL 复杂或冗长。

如何爬取不同分页类型的数据网站,因为内容比较多,我会放到本文下一节详细介绍。3.过滤表单类型的网页在网站上比较常见,这种网页最大的特点就是过滤项很多,不同的选择不会加载。

优采云采集器免费网络爬虫软件_网络大数据爬虫工具。

网页抓取工具是一种方便易用的网站内容抓取工具。该软件主要帮助用户抓取网站中的各种内容,如JS、CSS、图片、背景图片、音乐、Flash等,非常适合仿站人员... 查看全部

网站内容抓取(集搜客网络爬虫软件是一款免费的网页数据工具。)

第三步:提取内容。上面两步我们使用requests向网页请求数据,使用bs4解析页面。现在我们来到最关键的一步:。

它可以帮助我们快速采集互联网的海量内容,进行深入的数据分析和挖掘。比如抓取各大网站的排名,抓取各大购物的价格信息网站等等。而我们每天常用的搜索引擎都是“网络爬虫”。但毕竟。

爬取网页内容的一个例子来自于通过程序自动读取其他网站网页上显示的信息,类似于爬虫程序。例如,我们有一个。

极手客网络爬虫软件是一款免费的网络数据爬取工具,可将网络内容转化为excel表格,进行内容分析、文本分析、策略分析和文档分析。自动分词、社交网络分析、情感分析软件于研究生设计和行业研究。

URL就像网站和搜索引擎爬虫之间的桥梁:为了能够抓取你的网站内容,爬虫需要能够找到并跨越这些桥梁(即找到并抓取你的URLs )。如果您的 URL 复杂或冗长。

如何爬取不同分页类型的数据网站,因为内容比较多,我会放到本文下一节详细介绍。3.过滤表单类型的网页在网站上比较常见,这种网页最大的特点就是过滤项很多,不同的选择不会加载。

优采云采集器免费网络爬虫软件_网络大数据爬虫工具。

网页抓取工具是一种方便易用的网站内容抓取工具。该软件主要帮助用户抓取网站中的各种内容,如JS、CSS、图片、背景图片、音乐、Flash等,非常适合仿站人员...

网站内容抓取(1.外链,留下链接引导蜘蛛进入你的网站外链也不是)

网站优化 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-10-28 23:14

1.网站地图

定期将网站链接放入Sitemap,然后将Sitemap提交给百度。百度会定期抓取检查您提交的Sitemap,并处理其中的链接,但收录的速度比主动推送要慢。

2.朋友链

友情链接一定要做好。一个新网站要想快速站稳脚跟,迅速收录,很大一部分需要友情链接,而且是优质友情链接。寻找友情链接的标准一定要及时更新内容,百度的收录数量正常,网站好友链不多,内容质量高,权重不低于自己的网站成为好友链,记得及时查看好友链。

3.外部链接

除了朋友链,就是外链。发送外链的目的是为了吸引蜘蛛来抓我们网站。在各大外链平台发布自己的优质外链,留下链接引导蜘蛛进入你的网站,外链不随意。找相关网站发布外链,权重重要,收录一定要快,快照一定要及时更新网站,外链不行只看数量,重要的是质量。

4.推送

主动推送可以让百度更快的找到你的网站和收录。这也是最快的提交方式。网站上新生成的链接会立即通过这种方式推送给百度,以保证新链接可以被百度及时收录。

5.内容

网站 没有内容,不管做多少外链都是徒劳的。网站的内容是吸引搜索引擎蜘蛛的根源。搜索引擎蜘蛛之所以来找你网站,就是为了抓取优质内容。如果你的网站没有做过任何推广,而你的网站内容质量高,每天更新及时,那么百度蜘蛛每天都会来找你的网站。

6.内链

这是大多数网站 忽略的事情。内部链接和内部链接的作用其实很重要。蜘蛛的爬行轨迹是跟随一个链接到另一个链接。我们想让搜索引擎蜘蛛更好的爬网一般需要有反向链接的引导,但是内页的爬取需要好的内链。如果不注意死链和断链的形成,蜘蛛就爬不上去,也不好。收录 up。

7.更新

这里所说的更新是指网站内容更新的频率和数量。为了让蜘蛛在每天的某个时间从你的网站 抓取内容,你必须先有一个更新内容的规则。,比如每天早上更新几篇文章,下午更新几篇文章。久而久之,搜索引擎蜘蛛找出你的更新模式后,他会跟着你网站从你的网站中抓取内容,如果你三五天不更新,你会突然一天更新很多内容。这样只会让搜索引擎蜘蛛想你很久才来找你网站一次。 查看全部

网站内容抓取(1.外链,留下链接引导蜘蛛进入你的网站外链也不是)

1.网站地图

定期将网站链接放入Sitemap,然后将Sitemap提交给百度。百度会定期抓取检查您提交的Sitemap,并处理其中的链接,但收录的速度比主动推送要慢。

2.朋友链

友情链接一定要做好。一个新网站要想快速站稳脚跟,迅速收录,很大一部分需要友情链接,而且是优质友情链接。寻找友情链接的标准一定要及时更新内容,百度的收录数量正常,网站好友链不多,内容质量高,权重不低于自己的网站成为好友链,记得及时查看好友链。

3.外部链接

除了朋友链,就是外链。发送外链的目的是为了吸引蜘蛛来抓我们网站。在各大外链平台发布自己的优质外链,留下链接引导蜘蛛进入你的网站,外链不随意。找相关网站发布外链,权重重要,收录一定要快,快照一定要及时更新网站,外链不行只看数量,重要的是质量。

4.推送

主动推送可以让百度更快的找到你的网站和收录。这也是最快的提交方式。网站上新生成的链接会立即通过这种方式推送给百度,以保证新链接可以被百度及时收录。

5.内容

网站 没有内容,不管做多少外链都是徒劳的。网站的内容是吸引搜索引擎蜘蛛的根源。搜索引擎蜘蛛之所以来找你网站,就是为了抓取优质内容。如果你的网站没有做过任何推广,而你的网站内容质量高,每天更新及时,那么百度蜘蛛每天都会来找你的网站。

6.内链

这是大多数网站 忽略的事情。内部链接和内部链接的作用其实很重要。蜘蛛的爬行轨迹是跟随一个链接到另一个链接。我们想让搜索引擎蜘蛛更好的爬网一般需要有反向链接的引导,但是内页的爬取需要好的内链。如果不注意死链和断链的形成,蜘蛛就爬不上去,也不好。收录 up。

7.更新

这里所说的更新是指网站内容更新的频率和数量。为了让蜘蛛在每天的某个时间从你的网站 抓取内容,你必须先有一个更新内容的规则。,比如每天早上更新几篇文章,下午更新几篇文章。久而久之,搜索引擎蜘蛛找出你的更新模式后,他会跟着你网站从你的网站中抓取内容,如果你三五天不更新,你会突然一天更新很多内容。这样只会让搜索引擎蜘蛛想你很久才来找你网站一次。

网站内容抓取(《Python即时网络爬虫项目说明》一文谋数台生成XSLT)

网站优化 • 优采云 发表了文章 • 0 个评论 • 67 次浏览 • 2021-10-28 23:13

一、项目背景

在《Python Instant Web Crawler Project 说明》一文中,我们说过要做一个通用的网络爬虫,可以节省程序员的大部分时间。重点是提取器使用的爬取规则需要快速生成。在python中使用xslt提取网页数据的文章中,我们已经看到提取规则是xslt程序。示例程序中,将xslt的一长段直接赋值给了一个变量,但是没有提到xslt的这一段是怎么来的。

网友难免会质疑:这个xslt这么长,是不是要写很久?

实际情况是这个xslt是由GooSeeker的MS直观的标注功能自动生成的。如果你熟练,它会在1分钟内完成。

2. MS 能找到什么

MS 牟书台具有图形界面,集成了一系列 html 解析工具,包括:

MS Moshutai 的界面分为三个部分:DOM 数据窗口、嵌入式浏览器窗口和工作台。在工作台上定义 xslt 转换规则。

3.使用MS生成XSLT

假设我们要抓取一个论坛帖子列表,下面是操作方法的分步说明:

第一步,打开GooSeeker的MS平台,输入要爬取的URL;

第二步,直接在MS Muzushi浏览器显示窗口中选择要提取的内容,并命名,点击确定;

第三步,点击工作台上的“测试”按钮,就会生成xslt并显示在“数据规则”窗口中。

通过以上操作,无需编程,使用图形界面直接在页面上进行标注,1分钟即可生成xslt。

4. 如何使用 XSLT

在python中使用xslt提取网页数据的文章中,我们将生成的xslt作为字符串交给了程序,感觉一下子回到了史前文明。上面说的太好了,最后我们用了一个非常原创的副本。其实不然,那只是一个例子。在《Python Instant Web Crawler Project:Content Extractor的定义》一文中,注入xslt的方式有很多种,最自动化的方式是api,后续文章会详细讲解。

5. 文档修改历史

2016-05-28:V3.0,增加第二章

2016-05-27:V2.0,添加文字说明 查看全部

网站内容抓取(《Python即时网络爬虫项目说明》一文谋数台生成XSLT)

一、项目背景

在《Python Instant Web Crawler Project 说明》一文中,我们说过要做一个通用的网络爬虫,可以节省程序员的大部分时间。重点是提取器使用的爬取规则需要快速生成。在python中使用xslt提取网页数据的文章中,我们已经看到提取规则是xslt程序。示例程序中,将xslt的一长段直接赋值给了一个变量,但是没有提到xslt的这一段是怎么来的。

网友难免会质疑:这个xslt这么长,是不是要写很久?

实际情况是这个xslt是由GooSeeker的MS直观的标注功能自动生成的。如果你熟练,它会在1分钟内完成。

2. MS 能找到什么

MS 牟书台具有图形界面,集成了一系列 html 解析工具,包括:

MS Moshutai 的界面分为三个部分:DOM 数据窗口、嵌入式浏览器窗口和工作台。在工作台上定义 xslt 转换规则。

3.使用MS生成XSLT

假设我们要抓取一个论坛帖子列表,下面是操作方法的分步说明:

第一步,打开GooSeeker的MS平台,输入要爬取的URL;

第二步,直接在MS Muzushi浏览器显示窗口中选择要提取的内容,并命名,点击确定;

第三步,点击工作台上的“测试”按钮,就会生成xslt并显示在“数据规则”窗口中。

通过以上操作,无需编程,使用图形界面直接在页面上进行标注,1分钟即可生成xslt。

4. 如何使用 XSLT

在python中使用xslt提取网页数据的文章中,我们将生成的xslt作为字符串交给了程序,感觉一下子回到了史前文明。上面说的太好了,最后我们用了一个非常原创的副本。其实不然,那只是一个例子。在《Python Instant Web Crawler Project:Content Extractor的定义》一文中,注入xslt的方式有很多种,最自动化的方式是api,后续文章会详细讲解。

5. 文档修改历史

2016-05-28:V3.0,增加第二章

2016-05-27:V2.0,添加文字说明

网站内容抓取(百度资源平台直播一节公开课,抓取友好性优化(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 105 次浏览 • 2021-10-28 23:12

大家好,今天百度资源平台正式直播了一堂公开课,主要跟大家聊一聊网站抓取和收录的原理,这里我给大家做个详细的笔记(一个字不要小姐),看完可以说,做收录基本上问题不大。

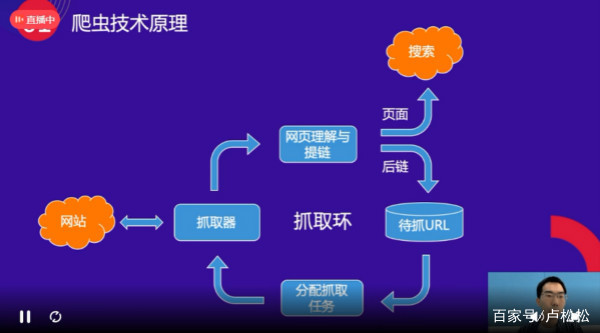

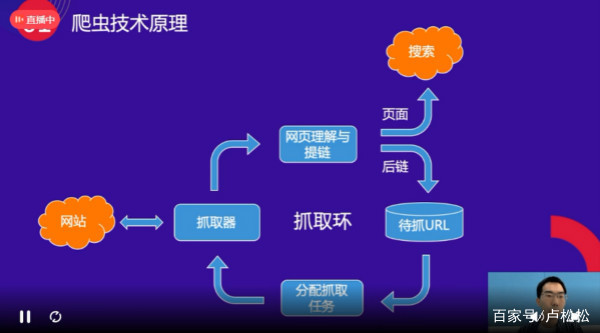

百度爬虫的工作原理

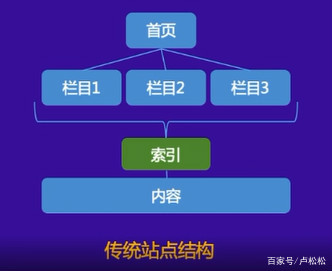

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。如下图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

抓取友好度优化

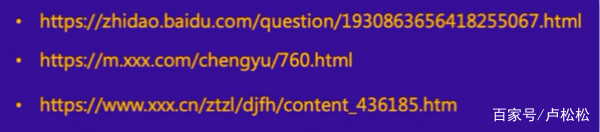

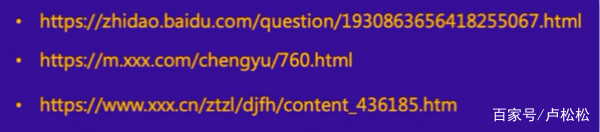

1、网址规范:

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“要爬取的网址”的环境下,爬虫在首页的时候,并不知道这个网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

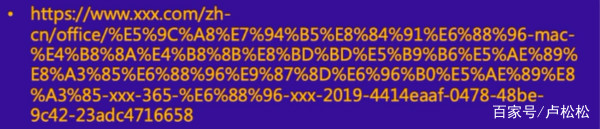

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种网址中含有字符,而且这个网址中含有文章的标题,导致网址很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理的链接发现:

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

要编辑搜索图片,请点击输入图片说明(最多18个字符)

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

Feed流推荐:大多数进行Feed流的站点在后端都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容。爬虫相当于一个用户。爬虫不可能用这种方式爬取网站的所有内容,所以会导致部分页面被爬取。就算你有100万的内容,也可能只能抢到1-200万。

唯一搜索入口:如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但爬虫不能输入关键词再爬,所以爬虫只能爬到首页,没有回链。自然爬行和 收录 不会是理想的。

解决方法:索引页下的内容按发布时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页面抓取您的网站 最新资源。另外,新发布的资源应该是实时的。索引页已同步。很多纯静态网页更新了内容,但是首页(索引页)出不来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是反向链接(最新的文章)URL需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城号,基本上只用首页作为索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好:

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:建议加载时间控制在2S以内,这样无论是用户还是爬虫,打开速度更快的网站都会更受青睐,其次是避免不必要的跳转,虽然这样情况很少见。部分,但是网站里面还是有很多层次的跳转,所以对于爬虫来说,很可能会在多层次跳转的同时断开。一般是把没有www的域名重定向到带WWW的域名,然后再把带WWW的域名重定向到https,最后更换新站点。在这种情况下,存在第三或第四级重定向。如果有类似网站的修改,建议直接跳转到新域名。

标准化http返回码:正确使用我们常见的301/302和正确使用404主要是常规问题。使用常规方法来解决它们。例如,如果遇到无效资源,则使用 404 代替某些 返回特殊状态代码。

访问稳定性优化:一是尽量选择国内大型DNS服务,保证站点的稳定性。对于域名DNS,阿里云其实是比较稳定可靠的。然后,其次,使用技术手段小心地阻止爬虫爬行。如果有不希望在百度上显示的特定资源,可以使用机器人进行屏蔽。比如网站的后台链接,大多被机器人屏蔽。如果爬取频率过高,造成服务器压力过大,影响用户正常访问,可以通过资源平台的工具降低爬取频率。二是为了防止防火墙误禁止爬虫,所以建议您可以将搜索引擎的UA加入白名单。最后一点是服务器的稳定性,尤其是在短时间内提交大量优质资源的时候。这时候一定要注意服务器的稳定性,因为当你提交大量资源时,爬虫也会相应增加。这个时候会不会导致你的服务器?打开压力太大,这个问题需要站长注意。

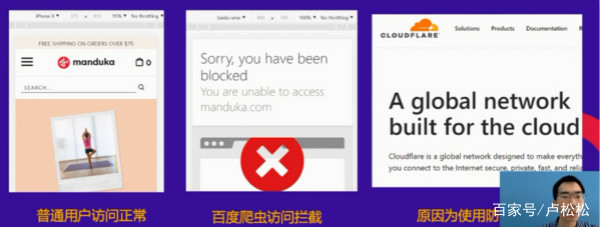

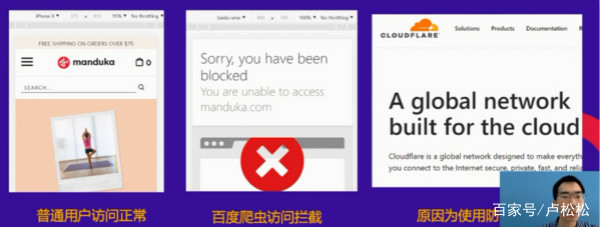

如上图所示,这三个例子都是被第三方防火墙拦截的状态。当一个普通用户在这种状态下打开,搜索引擎抓取的时候也会处于这种状态,所以如果遇到CC或者DDOS,我们打开防火墙的前提,一定要放开搜索引擎的UA .

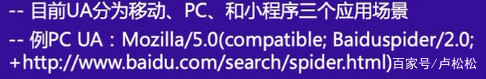

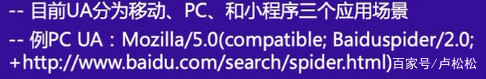

4、 识别百度爬虫

对于一些网站来说,可能会有针对用户的特殊优化,也可能有网站想要区分用户和爬虫进行优化,所以这时候就需要识别百度爬虫了。

首先,简单来说,我们可以通过百度的UA来识别百度爬虫。所以目前百度PC、手机、小程序是三个不同的UA。然后通过简单的识别方法,有第三方的。爬虫模拟百度爬虫,所以你认不出来。那么这时候我们就可以通过双向DNS解析认证来区分了。详情请参考《简单两步:教你快速识别百度蜘蛛》。

提问时间

问:新网站是否有爬网限制?

A:对于任何新网站,都没有抓取限制,但从去年开始,我们开始支持新网站,让你的网站,先收录上百度。然后进行价值判断。那么如何让百度知道你是一个新站点,有两个快捷方式。一是提交到百度资源平台,二是去工信部备案。我们可以从工业和信息化部获得。ICP备案数据后,我们知道有人建了一个新站点,这样我们就可以给新站点一个基本的流量支持。

Q:各个站点的蜘蛛爬取配额会有所调整。多久会调整一次?

答:确实会有调整。对于新资源,它与你的抓取频率有关,对于旧资源,它与你的内容质量有关。如果新资源的质量发生变化,那么爬取的频率也会发生变化,网站如果>的规模发生变化,那么爬取的频率也会发生变化。如果有大的改版,那么爬取的频率也会相对变化。

Q:网站掉电可以恢复吗?

A:网站彻底修复的前提是我们会重新评估网站,看看网站是否已经整改,如果有整改,是不是404并提交到资源如果说平台完全符合要求,搜索引擎会进行评估,恢复没有违规的网站。

问:新站点是否有评估期?

A:对我们来说,没有评估期这样的东西。正如我们之前提到的,支持新站点的流量是可能的。假设一个新站点的流量支持是1-2个月后,发现网站继续保持这个状态,那么不会有大的调整。当我们发现网站的质量有明显提升时,我们会相应提高百度排名。

Q:百度对待国外服务器和国内服务器有区别吗?

A:从战略上来说,没有硬性区分。但是很多国外服务器在国内部分地区已经禁止,从国外服务器网站备案来看,国产服务器有优势。

Q:新展的老域名更有优势吗?

A:如果旧域名和新站的内容一样,在初期确实有一定的优势,但只是初期,后期要考虑内容的质量。应特别关注旧域名的行业和行业。您新的 网站 的内容无关紧要。即使是所谓的高能老域名也会适得其反。百度会认为,今天这个明天那个,效果还不如做一个新域名。

Q:蜘蛛有重量吗,比如220和116这样的高重量蜘蛛?

答:蜘蛛没有重量。网站的排名主要由网站的质量决定。 查看全部

网站内容抓取(百度资源平台直播一节公开课,抓取友好性优化(组图))

大家好,今天百度资源平台正式直播了一堂公开课,主要跟大家聊一聊网站抓取和收录的原理,这里我给大家做个详细的笔记(一个字不要小姐),看完可以说,做收录基本上问题不大。

百度爬虫的工作原理

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。如下图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

抓取友好度优化

1、网址规范:

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“要爬取的网址”的环境下,爬虫在首页的时候,并不知道这个网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种网址中含有字符,而且这个网址中含有文章的标题,导致网址很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理的链接发现:

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

要编辑搜索图片,请点击输入图片说明(最多18个字符)

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

Feed流推荐:大多数进行Feed流的站点在后端都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容。爬虫相当于一个用户。爬虫不可能用这种方式爬取网站的所有内容,所以会导致部分页面被爬取。就算你有100万的内容,也可能只能抢到1-200万。

唯一搜索入口:如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但爬虫不能输入关键词再爬,所以爬虫只能爬到首页,没有回链。自然爬行和 收录 不会是理想的。

解决方法:索引页下的内容按发布时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页面抓取您的网站 最新资源。另外,新发布的资源应该是实时的。索引页已同步。很多纯静态网页更新了内容,但是首页(索引页)出不来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是反向链接(最新的文章)URL需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城号,基本上只用首页作为索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好:

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:建议加载时间控制在2S以内,这样无论是用户还是爬虫,打开速度更快的网站都会更受青睐,其次是避免不必要的跳转,虽然这样情况很少见。部分,但是网站里面还是有很多层次的跳转,所以对于爬虫来说,很可能会在多层次跳转的同时断开。一般是把没有www的域名重定向到带WWW的域名,然后再把带WWW的域名重定向到https,最后更换新站点。在这种情况下,存在第三或第四级重定向。如果有类似网站的修改,建议直接跳转到新域名。

标准化http返回码:正确使用我们常见的301/302和正确使用404主要是常规问题。使用常规方法来解决它们。例如,如果遇到无效资源,则使用 404 代替某些 返回特殊状态代码。

访问稳定性优化:一是尽量选择国内大型DNS服务,保证站点的稳定性。对于域名DNS,阿里云其实是比较稳定可靠的。然后,其次,使用技术手段小心地阻止爬虫爬行。如果有不希望在百度上显示的特定资源,可以使用机器人进行屏蔽。比如网站的后台链接,大多被机器人屏蔽。如果爬取频率过高,造成服务器压力过大,影响用户正常访问,可以通过资源平台的工具降低爬取频率。二是为了防止防火墙误禁止爬虫,所以建议您可以将搜索引擎的UA加入白名单。最后一点是服务器的稳定性,尤其是在短时间内提交大量优质资源的时候。这时候一定要注意服务器的稳定性,因为当你提交大量资源时,爬虫也会相应增加。这个时候会不会导致你的服务器?打开压力太大,这个问题需要站长注意。

如上图所示,这三个例子都是被第三方防火墙拦截的状态。当一个普通用户在这种状态下打开,搜索引擎抓取的时候也会处于这种状态,所以如果遇到CC或者DDOS,我们打开防火墙的前提,一定要放开搜索引擎的UA .

4、 识别百度爬虫

对于一些网站来说,可能会有针对用户的特殊优化,也可能有网站想要区分用户和爬虫进行优化,所以这时候就需要识别百度爬虫了。

首先,简单来说,我们可以通过百度的UA来识别百度爬虫。所以目前百度PC、手机、小程序是三个不同的UA。然后通过简单的识别方法,有第三方的。爬虫模拟百度爬虫,所以你认不出来。那么这时候我们就可以通过双向DNS解析认证来区分了。详情请参考《简单两步:教你快速识别百度蜘蛛》。

提问时间

问:新网站是否有爬网限制?

A:对于任何新网站,都没有抓取限制,但从去年开始,我们开始支持新网站,让你的网站,先收录上百度。然后进行价值判断。那么如何让百度知道你是一个新站点,有两个快捷方式。一是提交到百度资源平台,二是去工信部备案。我们可以从工业和信息化部获得。ICP备案数据后,我们知道有人建了一个新站点,这样我们就可以给新站点一个基本的流量支持。

Q:各个站点的蜘蛛爬取配额会有所调整。多久会调整一次?

答:确实会有调整。对于新资源,它与你的抓取频率有关,对于旧资源,它与你的内容质量有关。如果新资源的质量发生变化,那么爬取的频率也会发生变化,网站如果>的规模发生变化,那么爬取的频率也会发生变化。如果有大的改版,那么爬取的频率也会相对变化。

Q:网站掉电可以恢复吗?

A:网站彻底修复的前提是我们会重新评估网站,看看网站是否已经整改,如果有整改,是不是404并提交到资源如果说平台完全符合要求,搜索引擎会进行评估,恢复没有违规的网站。

问:新站点是否有评估期?

A:对我们来说,没有评估期这样的东西。正如我们之前提到的,支持新站点的流量是可能的。假设一个新站点的流量支持是1-2个月后,发现网站继续保持这个状态,那么不会有大的调整。当我们发现网站的质量有明显提升时,我们会相应提高百度排名。

Q:百度对待国外服务器和国内服务器有区别吗?

A:从战略上来说,没有硬性区分。但是很多国外服务器在国内部分地区已经禁止,从国外服务器网站备案来看,国产服务器有优势。

Q:新展的老域名更有优势吗?

A:如果旧域名和新站的内容一样,在初期确实有一定的优势,但只是初期,后期要考虑内容的质量。应特别关注旧域名的行业和行业。您新的 网站 的内容无关紧要。即使是所谓的高能老域名也会适得其反。百度会认为,今天这个明天那个,效果还不如做一个新域名。

Q:蜘蛛有重量吗,比如220和116这样的高重量蜘蛛?

答:蜘蛛没有重量。网站的排名主要由网站的质量决定。

网站内容抓取(慈溪网站建设分享蜘蛛是如何爬取网页内容由新鸿儒小编整理发布!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 74 次浏览 • 2021-10-28 23:10

你在找吗?北京新鸿儒提供慈溪网站施工、网站设计、网站制作、APP开发等服务。你可以通过网站在慈溪找到新鸿儒。

慈溪是高端网站,选择新鸿儒。我们为36家世界500强品牌公司提供服务和技术支持,为中国58家世界500强品牌公司提供整站开发、品牌策划等服务。如; SOHO中国、中联重科、雅戈尔、泸州老窖、清华大学、奥克斯集团等,更多信息请联系新鸿儒客服。

蜘蛛首先抓取百度白名单网站或者一些高度信任的站点和页面(例如:一些高权重的网站和网站主页),然后抓取这些页面我发现了一些链接到其他页面。蜘蛛会将这些链接保存在自己的数据库中,然后按照爬取顺序对这些网页进行一一爬取。

1、蜘蛛抓取网页的规则:

对于蜘蛛来说,网页的权重越高,可信度越高,被抓取的频率就越高,比如网站的首页和内页。蜘蛛先爬取网站的首页,因为首页权重较高,大部分链接都指向首页。然后通过首页爬取网站的内页,并不是所有的内页都会被蜘蛛爬取。

搜索引擎认为,对于一般的中小型网站,三层足以承载所有内容,所以蜘蛛经常爬取的内容是前三层,超过三层的内容蜘蛛认为内容不是重要,因此它们不会频繁爬行。. 所以一定要根据自己的网站比例来确定页面的层次。

2、如何看蜘蛛爬行?

通过iis日志,可以看到蜘蛛爬取了什么内容。iis日志包括百度蜘蛛、谷歌蜘蛛等,从iis日志可以分析蜘蛛类型、抓取时间、抓取页面、抓取内容大小、返回页面代码。200 表示抓取成功。

慈溪网站 建设分享蜘蛛是如何抓取网页内容的?新鸿儒编辑整理出版! 查看全部

网站内容抓取(慈溪网站建设分享蜘蛛是如何爬取网页内容由新鸿儒小编整理发布!)

你在找吗?北京新鸿儒提供慈溪网站施工、网站设计、网站制作、APP开发等服务。你可以通过网站在慈溪找到新鸿儒。

慈溪是高端网站,选择新鸿儒。我们为36家世界500强品牌公司提供服务和技术支持,为中国58家世界500强品牌公司提供整站开发、品牌策划等服务。如; SOHO中国、中联重科、雅戈尔、泸州老窖、清华大学、奥克斯集团等,更多信息请联系新鸿儒客服。

蜘蛛首先抓取百度白名单网站或者一些高度信任的站点和页面(例如:一些高权重的网站和网站主页),然后抓取这些页面我发现了一些链接到其他页面。蜘蛛会将这些链接保存在自己的数据库中,然后按照爬取顺序对这些网页进行一一爬取。

1、蜘蛛抓取网页的规则:

对于蜘蛛来说,网页的权重越高,可信度越高,被抓取的频率就越高,比如网站的首页和内页。蜘蛛先爬取网站的首页,因为首页权重较高,大部分链接都指向首页。然后通过首页爬取网站的内页,并不是所有的内页都会被蜘蛛爬取。

搜索引擎认为,对于一般的中小型网站,三层足以承载所有内容,所以蜘蛛经常爬取的内容是前三层,超过三层的内容蜘蛛认为内容不是重要,因此它们不会频繁爬行。. 所以一定要根据自己的网站比例来确定页面的层次。

2、如何看蜘蛛爬行?

通过iis日志,可以看到蜘蛛爬取了什么内容。iis日志包括百度蜘蛛、谷歌蜘蛛等,从iis日志可以分析蜘蛛类型、抓取时间、抓取页面、抓取内容大小、返回页面代码。200 表示抓取成功。

慈溪网站 建设分享蜘蛛是如何抓取网页内容的?新鸿儒编辑整理出版!

网站内容抓取(百度资源平台直播一节公开课,抓取友好性优化(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2021-10-28 19:07

大家好,今天百度资源平台正式直播了一堂公开课,主要跟大家聊一聊网站抓取和收录的原理,这里我给大家做个详细的笔记(一个字不要小姐),看完可以说,做收录基本上问题不大。

百度爬虫的工作原理

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。如下图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

抓取友好度优化

1、网址规范:

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“要爬取的网址”的环境下,爬虫在首页的时候,并不知道这个网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种网址中含有字符,而且这个网址中含有文章的标题,导致网址很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理的链接发现:

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

Feed流推荐:大多数进行Feed流的站点在后端都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容。爬虫相当于一个用户。爬虫不可能用这种方式爬取网站的所有内容,所以会导致部分页面被爬取。就算你有100万的内容,也可能只能抢到1-200万。

唯一搜索入口:如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但爬虫不能输入关键词再爬,所以爬虫只能爬到首页,没有回链。自然爬行和 收录 不会是理想的。

解决方法:索引页下的内容按发布时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页面抓取您的网站 最新资源。另外,新发布的资源应该是实时的。索引页已同步。很多纯静态网页更新了内容,但是首页(索引页)出不来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是反向链接(最新的文章)URL需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城号,基本上只用首页作为索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好:

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:建议加载时间控制在2S以内,这样无论是用户还是爬虫,打开速度更快的网站都会更受青睐,其次是避免不必要的跳转,虽然这样情况很少见。部分,但是网站里面还是有很多层次的跳转,所以对于爬虫来说,很可能会在多层次跳转的同时断开。一般是把没有www的域名重定向到带WWW的域名,然后再把带WWW的域名重定向到https,最后更换新站点。在这种情况下,存在第三或第四级重定向。如果有类似网站的修改,建议直接跳转到新域名。

标准化http返回码:正确使用我们常见的301/302和正确使用404主要是常规问题。使用常规方法来解决它们。例如,如果遇到无效资源,则使用 404 代替某些 返回特殊状态代码。

访问稳定性优化:一是尽量选择国内大型DNS服务,保证站点的稳定性。对于域名DNS,阿里云其实是比较稳定可靠的。然后,其次,使用技术手段小心地阻止爬虫爬行。如果有不希望在百度上显示的特定资源,可以使用机器人进行屏蔽。比如网站的后台链接,大多被机器人屏蔽。如果爬取频率过高,造成服务器压力过大,影响用户正常访问,可以通过资源平台的工具降低爬取频率。二是为了防止防火墙误禁止爬虫,所以建议您可以将搜索引擎的UA加入白名单。最后一点是服务器的稳定性,尤其是在短时间内提交大量优质资源的时候。这时候一定要注意服务器的稳定性,因为当你提交大量资源时,爬虫也会相应增加。这个时候会不会导致你的服务器?打开压力太大,这个问题需要站长注意。

如上图所示,这三个例子都是被第三方防火墙拦截的状态。当一个普通用户在这种状态下打开,搜索引擎抓取的时候也会处于这种状态,所以如果遇到CC或者DDOS,我们打开防火墙的前提,一定要放开搜索引擎的UA .

4、 识别百度爬虫

对于一些网站来说,可能会有针对用户的特殊优化,也可能有网站想要区分用户和爬虫进行优化,所以这时候就需要识别百度爬虫了。

首先,简单来说,我们可以通过百度的UA来识别百度爬虫。所以目前百度PC、手机、小程序是三个不同的UA。然后通过简单的识别方法,有第三方的。爬虫模拟百度爬虫,所以你认不出来。那么这时候我们就可以通过双向DNS解析认证来区分了。详情请参考《简单两步:教你快速识别百度蜘蛛》。

提问时间

问:新网站是否有爬网限制?

A:对于任何新网站,都没有抓取限制,但从去年开始,我们开始支持新网站,让你的网站,先收录上百度。然后进行价值判断。那么如何让百度知道你是一个新站点,有两个快捷方式。一是提交到百度资源平台,二是去工信部备案。我们可以从工业和信息化部获得。ICP备案数据后,我们知道有人建了一个新站点,这样我们就可以给新站点一个基本的流量支持。

Q:各个站点的蜘蛛爬取配额会有所调整。多久会调整一次?

答:确实会有调整。对于新资源,它与你的抓取频率有关,对于旧资源,它与你的内容质量有关。如果新资源的质量发生变化,那么爬取的频率也会发生变化,网站如果>的规模发生变化,那么爬取的频率也会发生变化。如果有大的改版,那么爬取的频率也会相对变化。

Q:网站掉电可以恢复吗?

A:网站彻底修复的前提是我们会重新评估网站,看看网站是否已经整改,如果有整改,是不是404并提交到资源如果说平台完全符合要求,搜索引擎会进行评估,恢复没有违规的网站。

问:新站点是否有评估期?

A:对我们来说,没有评估期这样的东西。正如我们之前提到的,支持新站点的流量是可能的。假设一个新站点的流量支持是1-2个月后,发现网站继续保持这个状态,那么不会有大的调整。当我们发现网站的质量有明显提升时,我们会相应提高百度排名。

Q:百度对待国外服务器和国内服务器有区别吗?

A:从战略上来说,没有硬性区分。但是很多国外服务器在国内部分地区已经禁止,从国外服务器网站备案来看,国产服务器有优势。

Q:新展的老域名更有优势吗?

A:如果旧域名和新站的内容一样,在初期确实有一定的优势,但只是初期,后期要考虑内容的质量。应特别关注旧域名的行业和行业。您新的 网站 的内容无关紧要。即使是所谓的高能老域名也会适得其反。百度会认为,今天这个明天那个,效果还不如做一个新域名。

Q:蜘蛛有重量吗,比如220和116这样的高重量蜘蛛?

答:蜘蛛没有重量。网站的排名主要由网站的质量决定。 查看全部

网站内容抓取(百度资源平台直播一节公开课,抓取友好性优化(组图))

大家好,今天百度资源平台正式直播了一堂公开课,主要跟大家聊一聊网站抓取和收录的原理,这里我给大家做个详细的笔记(一个字不要小姐),看完可以说,做收录基本上问题不大。

百度爬虫的工作原理

首先,百度的爬虫会与网站的首页进行交互。拿到网站的主页后,会理解页面,理解收录(类型,值计算),其次,网站把主页上的所有超链接都提取出来。如下图所示,首页上的超链接称为“post-links”。下一轮爬虫的时候,爬虫会继续和这些超链接的页面进行交互,得到页面进行细化,一层一层的继续下去。抓取一层,构成一个抓取循环。

抓取友好度优化

1、网址规范:

任何资源都是通过 URL 获取的。URL是相对于网站的门牌号,所以URL规划很重要。尤其是在如上图所示的“要爬取的网址”的环境下,爬虫在首页的时候,并不知道这个网址长什么样子。

优秀网址的特点是主流、简单,你可能不想做出一些让人看起来直观的非主流风格。

优秀 URL 示例:

如上图,第一个是百度知道的链接。整个链接分为三个部分。第一部分是网站的站点,第二部分是资源类型,第三部分是资源ID。这种网址很简单,爬虫看起来很不错。

如上图,第三篇文章比百度多了一段。首先,第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最后一段是内容ID的网站。像这样的 URL 也符合标准。

不友好 URL 的示例:

如上图所示,这种链接乍一看很长很复杂。有经验的站长可以看到,这种网址中含有字符,而且这个网址中含有文章的标题,导致网址很长。相对较长的 URL 并不优于简单的 URL。百度站长平台规则明确规定网址不能超过256字节。我个人建议 URL 长度控制在 100 字节和 100 个字符以内。足以显示资源的 URL。

如上图所示,该网址收录统计参数,可能导致重复爬取,浪费站点权限。因此,可能不使用参数。如果必须使用参数,也可以保留必要的参数。参数字符可以使用常规字符。连接器,例如“?” 和“&”,避免非主流连接器。

2、 合理的链接发现:

爬虫从首页一层一层的爬取,所以需要搞好首页和资源页的URL关系。这种爬虫爬行比较省力。

如上图所示,从首页到具体内容的超链接路径关系称为发现链接。目前大部分移动站不太重视发现链接关系,因此爬虫无法抓取到内容页面。

如上图所示,这两个站点是常见的移动网站构建方式。从链接发现的角度来看,这两类网站并不友好。

Feed流推荐:大多数进行Feed流的站点在后端都有大量数据。用户不断刷新时会出现新的内容,但无论刷新多少次,可能只能刷新到1%左右的内容。爬虫相当于一个用户。爬虫不可能用这种方式爬取网站的所有内容,所以会导致部分页面被爬取。就算你有100万的内容,也可能只能抢到1-200万。

唯一搜索入口:如上图所示,首页只有一个搜索框。用户需要输入关键词才能找到对应的内容,但爬虫不能输入关键词再爬,所以爬虫只能爬到首页,没有回链。自然爬行和 收录 不会是理想的。

解决方法:索引页下的内容按发布时间倒序排列。这样做的好处是搜索引擎甚至可以通过索引页面抓取您的网站 最新资源。另外,新发布的资源应该是实时的。索引页已同步。很多纯静态网页更新了内容,但是首页(索引页)出不来。这会导致搜索引擎甚至无法通过索引页面抓取最新的资源。第三点是反向链接(最新的文章)URL需要在源码中直接暴露出来,方便搜索引擎抓取。最后,索引页不要越多越好。几个高质量的索引页就够了,比如长城号,基本上只用首页作为索引页。

最后,这里给大家一个更高效的解决方案,就是直接通过百度站长资源平台主动提交资源,让搜索引擎绕过索引页,直接抓取最新的资源。这里有两点需要注意。

Q:提交更多资源更好吗?

A:收录 效果的核心永远是内容的质量。如果大量低质量、泛滥的资源被提交,将导致惩罚性打击。

Q:为什么我提交了普通的收录却没有被抓到?

A:资源提交只能加速资源发现,不能保证短期抓取。当然,百度表示不断优化算法,让优质内容更快被抓取。

3、访问友好:

抓取器必须与网站进行交互并保证网站的稳定性,这样抓取器才能正常抓取。那么访问友好性主要包括以下几个方面。

访问速度优化:建议加载时间控制在2S以内,这样无论是用户还是爬虫,打开速度更快的网站都会更受青睐,其次是避免不必要的跳转,虽然这样情况很少见。部分,但是网站里面还是有很多层次的跳转,所以对于爬虫来说,很可能会在多层次跳转的同时断开。一般是把没有www的域名重定向到带WWW的域名,然后再把带WWW的域名重定向到https,最后更换新站点。在这种情况下,存在第三或第四级重定向。如果有类似网站的修改,建议直接跳转到新域名。

标准化http返回码:正确使用我们常见的301/302和正确使用404主要是常规问题。使用常规方法来解决它们。例如,如果遇到无效资源,则使用 404 代替某些 返回特殊状态代码。

访问稳定性优化:一是尽量选择国内大型DNS服务,保证站点的稳定性。对于域名DNS,阿里云其实是比较稳定可靠的。然后,其次,使用技术手段小心地阻止爬虫爬行。如果有不希望在百度上显示的特定资源,可以使用机器人进行屏蔽。比如网站的后台链接,大多被机器人屏蔽。如果爬取频率过高,造成服务器压力过大,影响用户正常访问,可以通过资源平台的工具降低爬取频率。二是为了防止防火墙误禁止爬虫,所以建议您可以将搜索引擎的UA加入白名单。最后一点是服务器的稳定性,尤其是在短时间内提交大量优质资源的时候。这时候一定要注意服务器的稳定性,因为当你提交大量资源时,爬虫也会相应增加。这个时候会不会导致你的服务器?打开压力太大,这个问题需要站长注意。

如上图所示,这三个例子都是被第三方防火墙拦截的状态。当一个普通用户在这种状态下打开,搜索引擎抓取的时候也会处于这种状态,所以如果遇到CC或者DDOS,我们打开防火墙的前提,一定要放开搜索引擎的UA .

4、 识别百度爬虫

对于一些网站来说,可能会有针对用户的特殊优化,也可能有网站想要区分用户和爬虫进行优化,所以这时候就需要识别百度爬虫了。

首先,简单来说,我们可以通过百度的UA来识别百度爬虫。所以目前百度PC、手机、小程序是三个不同的UA。然后通过简单的识别方法,有第三方的。爬虫模拟百度爬虫,所以你认不出来。那么这时候我们就可以通过双向DNS解析认证来区分了。详情请参考《简单两步:教你快速识别百度蜘蛛》。

提问时间

问:新网站是否有爬网限制?

A:对于任何新网站,都没有抓取限制,但从去年开始,我们开始支持新网站,让你的网站,先收录上百度。然后进行价值判断。那么如何让百度知道你是一个新站点,有两个快捷方式。一是提交到百度资源平台,二是去工信部备案。我们可以从工业和信息化部获得。ICP备案数据后,我们知道有人建了一个新站点,这样我们就可以给新站点一个基本的流量支持。

Q:各个站点的蜘蛛爬取配额会有所调整。多久会调整一次?

答:确实会有调整。对于新资源,它与你的抓取频率有关,对于旧资源,它与你的内容质量有关。如果新资源的质量发生变化,那么爬取的频率也会发生变化,网站如果>的规模发生变化,那么爬取的频率也会发生变化。如果有大的改版,那么爬取的频率也会相对变化。

Q:网站掉电可以恢复吗?

A:网站彻底修复的前提是我们会重新评估网站,看看网站是否已经整改,如果有整改,是不是404并提交到资源如果说平台完全符合要求,搜索引擎会进行评估,恢复没有违规的网站。

问:新站点是否有评估期?

A:对我们来说,没有评估期这样的东西。正如我们之前提到的,支持新站点的流量是可能的。假设一个新站点的流量支持是1-2个月后,发现网站继续保持这个状态,那么不会有大的调整。当我们发现网站的质量有明显提升时,我们会相应提高百度排名。

Q:百度对待国外服务器和国内服务器有区别吗?

A:从战略上来说,没有硬性区分。但是很多国外服务器在国内部分地区已经禁止,从国外服务器网站备案来看,国产服务器有优势。

Q:新展的老域名更有优势吗?

A:如果旧域名和新站的内容一样,在初期确实有一定的优势,但只是初期,后期要考虑内容的质量。应特别关注旧域名的行业和行业。您新的 网站 的内容无关紧要。即使是所谓的高能老域名也会适得其反。百度会认为,今天这个明天那个,效果还不如做一个新域名。

Q:蜘蛛有重量吗,比如220和116这样的高重量蜘蛛?

答:蜘蛛没有重量。网站的排名主要由网站的质量决定。

网站内容抓取(网站建站公司对搜索引擎抓取收录有什么规则进行一个分享)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-10-28 18:18

说起爬虫和收录是站长永远分不开的话题,我们做网站是为了获取流量。获取流量的前提是排名,排名的前提是收录,而收录的前提是内容被爬取。所以一切都来自爬行和收录。跟大家分享一下搜索引擎爬取收录的规则是什么!

搜索引擎喜欢什么样的网站?

在 Internet 上,每天都会生成数以千计的新内容页面。面对这些页面,百度会根据规则进行抓取并决定是否收录。不过,面对庞大的数据源,百度也会有优先规则。一般百度会优先抓取和收录large网站,因为large网站的内容丰富度和质量都非常高,所以搜索引擎会优先抓取和收录。所以这也是对我们站长的一个提醒,每天都会有更多的内容出现在网站的首页。频繁的更新和输出会使百度搜索引擎抓取更加频繁。

什么内容会有收录?

百度会根据爬取的内容判断内容是否为收录,而百度要求收录页面上的内容是高质量的。但是高质量这个词太宽泛了。一般我们一开始就可以把优质的内容拆分成这些:网站content原创性、网站内容可读性网站内容的时效性、对内容的投票网站。这几点是对什么是优质内容的综合分析。

1、网站 原创的内容:

百度会截取获取的内容与库中的内容进行比较。如果内容一模一样,就属于采集的内容,采集的内容不会很好。收录。但是我们作为站长可以适配我们的采集返回的内容,也就是伪原创。

2、内容的可读性:

这主要是关于内容页面的句子是否流畅,页面的格式是否对用户友好。这主要是为了给用户提供良好的用户体验。

3、 内容时效性:

及时性是指网站的内容是否是最新的,或者网站的内容是否对回答最新的问题有效。如果别人问的内容是20年高考中文题,你回答18年中文高考题,这是没有时效性的内容。

4、网站 内容投票

其中,这个投票行是外链和内链,因为你的内容每次指向另一个页面,就相当于对你的页面进行一次投票。票数越高,你的网站 人气越高。但是,这个外链特指优质外链,而不是批量发布。

以上是我们对牛商网搜索引擎爬取规则收录的理解。如果我们继续用上面的方法来维护和生产内容,网站的收录自然会提升。我们的站长也会善于分析网站的变化,分析搜索引擎抓取的内容和收录的规则,以便我们更好地制作出符合搜索引擎要求的内容。 查看全部

网站内容抓取(网站建站公司对搜索引擎抓取收录有什么规则进行一个分享)

说起爬虫和收录是站长永远分不开的话题,我们做网站是为了获取流量。获取流量的前提是排名,排名的前提是收录,而收录的前提是内容被爬取。所以一切都来自爬行和收录。跟大家分享一下搜索引擎爬取收录的规则是什么!

搜索引擎喜欢什么样的网站?

在 Internet 上,每天都会生成数以千计的新内容页面。面对这些页面,百度会根据规则进行抓取并决定是否收录。不过,面对庞大的数据源,百度也会有优先规则。一般百度会优先抓取和收录large网站,因为large网站的内容丰富度和质量都非常高,所以搜索引擎会优先抓取和收录。所以这也是对我们站长的一个提醒,每天都会有更多的内容出现在网站的首页。频繁的更新和输出会使百度搜索引擎抓取更加频繁。

什么内容会有收录?

百度会根据爬取的内容判断内容是否为收录,而百度要求收录页面上的内容是高质量的。但是高质量这个词太宽泛了。一般我们一开始就可以把优质的内容拆分成这些:网站content原创性、网站内容可读性网站内容的时效性、对内容的投票网站。这几点是对什么是优质内容的综合分析。

1、网站 原创的内容:

百度会截取获取的内容与库中的内容进行比较。如果内容一模一样,就属于采集的内容,采集的内容不会很好。收录。但是我们作为站长可以适配我们的采集返回的内容,也就是伪原创。

2、内容的可读性:

这主要是关于内容页面的句子是否流畅,页面的格式是否对用户友好。这主要是为了给用户提供良好的用户体验。

3、 内容时效性:

及时性是指网站的内容是否是最新的,或者网站的内容是否对回答最新的问题有效。如果别人问的内容是20年高考中文题,你回答18年中文高考题,这是没有时效性的内容。

4、网站 内容投票

其中,这个投票行是外链和内链,因为你的内容每次指向另一个页面,就相当于对你的页面进行一次投票。票数越高,你的网站 人气越高。但是,这个外链特指优质外链,而不是批量发布。

以上是我们对牛商网搜索引擎爬取规则收录的理解。如果我们继续用上面的方法来维护和生产内容,网站的收录自然会提升。我们的站长也会善于分析网站的变化,分析搜索引擎抓取的内容和收录的规则,以便我们更好地制作出符合搜索引擎要求的内容。

网站内容抓取(就是网站内容无法被百度搜索引擎有排名的,这是为什么呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2021-10-28 10:16

网站在互联网企业的发展中扮演着重要的角色。如果网站能够在搜索引擎首页上排名,那么看到网站的用户就会很多,网站会获得更多的流量,转化率也会相应提高。

但是有些SEO人员在做企业网站排名优化时会遇到这样的情况,即网站正常更新,百度搜索引擎不抓取网站的内容,所以 网站 不会被排名。为什么?

1、网站低重量

如果网站的权重很低,会导致百度搜索引擎无法抓取网站的内容。因此,想要百度搜索引擎抓取网站的内容,需要提高网站的整体质量和权重,这也有利于网站的排名。

2、网站服务器

如果网站服务器不稳定,安全性相对较差,百度搜索引擎将无法抓取网站的内容。所以在选择服务器时一定要选择独立、稳定、安全性高的服务器,这样的服务器才有利于网站收录的内容。

3、网站被处罚

一些SEO人员在做网站优化时会过度优化网站,这样不仅不会提升网站的排名,而且网站还会被搜索引擎惩罚. 这样一来,网站 的内容就不会是 收录。如果遇到这种情况,一定要及时调整优化策略。只有这样才能再次搜索网站的内容收录。

4、动态页面

如果网站页面是动态的,百度搜索引擎很难抓取页面内容。因此,有必要将页面调整为静态和伪静态页面,以方便百度搜索引擎抓取网站的内容。

5、经常修改网站

如果SEO人员经常修改网站的版本,也会造成这种情况。因此,在确定网站的结构后,一定不要轻易修改网站的版本,以免发生这种情况。

总之,当网站的内容无法被百度搜索引擎抓取时,你必须详细检查网站,找出原因,然后解决问题。只有这样,网站才有更好的发展空间。

蝙蝠侠IT转载需要授权! 查看全部

网站内容抓取(就是网站内容无法被百度搜索引擎有排名的,这是为什么呢?)

网站在互联网企业的发展中扮演着重要的角色。如果网站能够在搜索引擎首页上排名,那么看到网站的用户就会很多,网站会获得更多的流量,转化率也会相应提高。

但是有些SEO人员在做企业网站排名优化时会遇到这样的情况,即网站正常更新,百度搜索引擎不抓取网站的内容,所以 网站 不会被排名。为什么?

1、网站低重量

如果网站的权重很低,会导致百度搜索引擎无法抓取网站的内容。因此,想要百度搜索引擎抓取网站的内容,需要提高网站的整体质量和权重,这也有利于网站的排名。

2、网站服务器

如果网站服务器不稳定,安全性相对较差,百度搜索引擎将无法抓取网站的内容。所以在选择服务器时一定要选择独立、稳定、安全性高的服务器,这样的服务器才有利于网站收录的内容。

3、网站被处罚

一些SEO人员在做网站优化时会过度优化网站,这样不仅不会提升网站的排名,而且网站还会被搜索引擎惩罚. 这样一来,网站 的内容就不会是 收录。如果遇到这种情况,一定要及时调整优化策略。只有这样才能再次搜索网站的内容收录。

4、动态页面

如果网站页面是动态的,百度搜索引擎很难抓取页面内容。因此,有必要将页面调整为静态和伪静态页面,以方便百度搜索引擎抓取网站的内容。

5、经常修改网站

如果SEO人员经常修改网站的版本,也会造成这种情况。因此,在确定网站的结构后,一定不要轻易修改网站的版本,以免发生这种情况。

总之,当网站的内容无法被百度搜索引擎抓取时,你必须详细检查网站,找出原因,然后解决问题。只有这样,网站才有更好的发展空间。

蝙蝠侠IT转载需要授权!

网站内容抓取(怎么分析网站内容抓取、爬虫?网页开发的开始)

网站优化 • 优采云 发表了文章 • 0 个评论 • 77 次浏览 • 2021-10-28 06:04

网站内容抓取、爬虫。大家最早接触http协议应该就是去、京东买东西的时候吧,你会看到很多类似小广告一样的网站。在这些网站上,我们买东西是通过浏览器来完成,那么怎么分析这些页面呢?通过爬虫程序,我们可以知道以往很多购物网站分类的数据。后来随着互联网的发展,网站越来越多,我们抓取的信息也越来越多,从最开始的webdom获取页面内容,到解析网页内容然后分析出所需要的数据。

这就是大家称之为python网页开发的开始。大家都知道http协议,在这个协议上我们要保证传输的数据是安全的,所以一般情况下,端对端的传输才是不可逆的,再加上网站之间不断的调用,就相当于无数台服务器同时读取一个网页内容。所以,在这些特殊的网络环境下面,我们就需要爬虫程序,让程序去保证网页协议上的安全性。

当然,我们也有可能碰到同样的情况,一段时间内我们可能无法爬取到想要的数据。那么我们先来思考一下,什么样的网页需要保证协议的安全性,所以爬虫的设计要尽量从安全角度出发。列举三个可能存在的情况:网站跳转网页抓取网站抓取完即将停止时收到重新加载的连接通过抓取部分结果分析发现,跳转是比较常见的一种。举个例子,比如我们在百度看到的一个页面,按钮的箭头指向我们进入到百度的另一个页面,这个我们称之为“回流”。

如果我们还不能保证数据安全的情况下,还是会跳转的,至于什么时候跳转,可以根据需要来设置一个引导页面,在这个页面抓取出自己想要的内容。有的网站将网页存在多个页面,可能有的是一个静态页面,有的是一个动态页面,在一个静态页面下我们是可以抓取到全部数据的,在一个动态页面的顶部,会抓取到这个页面所有的数据,而在动态页面的底部或者最下方,是可以抓取到部分数据的。

这是动态页面一个比较容易的例子,而静态页面非常难抓取。再比如我们在百度的首页看到一个悬浮窗,这个是指向百度的新页面或者某个独立的页面,如果我们将每个页面都抓取一遍的话,就要抓到这些页面。而且还得考虑不同的服务器的速度是不同的,对速度要求不高的话,可以用selenium。再比如我们在百度的后续页面看到一个按钮,我们在后续页面看到一个链接,这个链接是一个静态页面,这种情况也是可以抓取到所有数据的。

所以,我们在爬取一个页面的时候要先将这个页面分析出来,分析页面的时候可以先弄清楚爬取这个页面到底需要哪些信息,比如上面提到的跳转情况、是否分析到独立的页面、页面内容等信息。如果你对爬虫有兴趣,或者想入行,可以看看猴子聊人物第6期《爬虫精讲》, 查看全部

网站内容抓取(怎么分析网站内容抓取、爬虫?网页开发的开始)

网站内容抓取、爬虫。大家最早接触http协议应该就是去、京东买东西的时候吧,你会看到很多类似小广告一样的网站。在这些网站上,我们买东西是通过浏览器来完成,那么怎么分析这些页面呢?通过爬虫程序,我们可以知道以往很多购物网站分类的数据。后来随着互联网的发展,网站越来越多,我们抓取的信息也越来越多,从最开始的webdom获取页面内容,到解析网页内容然后分析出所需要的数据。

这就是大家称之为python网页开发的开始。大家都知道http协议,在这个协议上我们要保证传输的数据是安全的,所以一般情况下,端对端的传输才是不可逆的,再加上网站之间不断的调用,就相当于无数台服务器同时读取一个网页内容。所以,在这些特殊的网络环境下面,我们就需要爬虫程序,让程序去保证网页协议上的安全性。

当然,我们也有可能碰到同样的情况,一段时间内我们可能无法爬取到想要的数据。那么我们先来思考一下,什么样的网页需要保证协议的安全性,所以爬虫的设计要尽量从安全角度出发。列举三个可能存在的情况:网站跳转网页抓取网站抓取完即将停止时收到重新加载的连接通过抓取部分结果分析发现,跳转是比较常见的一种。举个例子,比如我们在百度看到的一个页面,按钮的箭头指向我们进入到百度的另一个页面,这个我们称之为“回流”。

如果我们还不能保证数据安全的情况下,还是会跳转的,至于什么时候跳转,可以根据需要来设置一个引导页面,在这个页面抓取出自己想要的内容。有的网站将网页存在多个页面,可能有的是一个静态页面,有的是一个动态页面,在一个静态页面下我们是可以抓取到全部数据的,在一个动态页面的顶部,会抓取到这个页面所有的数据,而在动态页面的底部或者最下方,是可以抓取到部分数据的。

这是动态页面一个比较容易的例子,而静态页面非常难抓取。再比如我们在百度的首页看到一个悬浮窗,这个是指向百度的新页面或者某个独立的页面,如果我们将每个页面都抓取一遍的话,就要抓到这些页面。而且还得考虑不同的服务器的速度是不同的,对速度要求不高的话,可以用selenium。再比如我们在百度的后续页面看到一个按钮,我们在后续页面看到一个链接,这个链接是一个静态页面,这种情况也是可以抓取到所有数据的。

所以,我们在爬取一个页面的时候要先将这个页面分析出来,分析页面的时候可以先弄清楚爬取这个页面到底需要哪些信息,比如上面提到的跳转情况、是否分析到独立的页面、页面内容等信息。如果你对爬虫有兴趣,或者想入行,可以看看猴子聊人物第6期《爬虫精讲》,

网站内容抓取(如何让搜索引擎完全爱上你的营销网站优化效果?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 96 次浏览 • 2021-10-27 06:11

要获得良好的网站优化效果,必须让网站满足搜索引擎爬取优化的条件,让搜索引擎蜘蛛喜欢爬你的网站。看看如何让搜索引擎爱上你的营销网站

众所周知,一直以来都说网站优化是内容为王,也就是说内容是网站优化的核心要素,是提升网站的有效手段之一优化效果。这是因为经常更新的网站会有很多新鲜的内容,搜索引擎更喜欢新鲜的内容,这样网站可以得到更好的优化效果。但是需要注意的是,网站的更新内容必须是优质的原创内容才有效,搜索引擎对来自采集的内容非常反感。

在网站优化中,内、外链也是非常重要的一环。一般来说,新上线的网站搜索引擎收录的有效途径是通过外链解决。这是因为网站新上线的搜索引擎并不知道它的存在,通过构建外链,让搜索引擎通过外链来到我们的网站进行抓取和记录。当然,外链也需要一个相关性和质量都高的平台,将彼此的网站的权重转移到自己的网站上,从而增加自己的网站的优化效果.

如何让搜索引擎爱上你的营销网站

当搜索引擎进入网站时,一个好的、合理的网站结构会使其在爬取和爬取网站的过程中非常顺畅,到达网站任何页面。这样搜索引擎会抓取尽可能多的页面,更多的页面会被收录搜索到。但是,如果网站的组合不合理,搜索引擎在爬行时将无法辨别方向,迷失自我。一旦遇到障碍,就会离开网站,这也会对搜索引擎产生负面影响。

用户体验似乎与搜索引擎无关,但却密不可分。这是因为如果网站具有良好的用户体验效果,用户在浏览网站时会觉得非常方便好用,同时也可以解决用户的需求,用户会觉得< @网站 会有很好的感觉。对于搜索引擎来说,它们存在的价值在于为用户提供有价值的结果,解决用户的需求。因此,一个具有良好用户体验的网站,不仅会让用户开心,还会满足搜索引擎的需求。 查看全部

网站内容抓取(如何让搜索引擎完全爱上你的营销网站优化效果?(图))

要获得良好的网站优化效果,必须让网站满足搜索引擎爬取优化的条件,让搜索引擎蜘蛛喜欢爬你的网站。看看如何让搜索引擎爱上你的营销网站

众所周知,一直以来都说网站优化是内容为王,也就是说内容是网站优化的核心要素,是提升网站的有效手段之一优化效果。这是因为经常更新的网站会有很多新鲜的内容,搜索引擎更喜欢新鲜的内容,这样网站可以得到更好的优化效果。但是需要注意的是,网站的更新内容必须是优质的原创内容才有效,搜索引擎对来自采集的内容非常反感。

在网站优化中,内、外链也是非常重要的一环。一般来说,新上线的网站搜索引擎收录的有效途径是通过外链解决。这是因为网站新上线的搜索引擎并不知道它的存在,通过构建外链,让搜索引擎通过外链来到我们的网站进行抓取和记录。当然,外链也需要一个相关性和质量都高的平台,将彼此的网站的权重转移到自己的网站上,从而增加自己的网站的优化效果.

如何让搜索引擎爱上你的营销网站

当搜索引擎进入网站时,一个好的、合理的网站结构会使其在爬取和爬取网站的过程中非常顺畅,到达网站任何页面。这样搜索引擎会抓取尽可能多的页面,更多的页面会被收录搜索到。但是,如果网站的组合不合理,搜索引擎在爬行时将无法辨别方向,迷失自我。一旦遇到障碍,就会离开网站,这也会对搜索引擎产生负面影响。

用户体验似乎与搜索引擎无关,但却密不可分。这是因为如果网站具有良好的用户体验效果,用户在浏览网站时会觉得非常方便好用,同时也可以解决用户的需求,用户会觉得< @网站 会有很好的感觉。对于搜索引擎来说,它们存在的价值在于为用户提供有价值的结果,解决用户的需求。因此,一个具有良好用户体验的网站,不仅会让用户开心,还会满足搜索引擎的需求。

网站内容抓取(搜外问答:文章里面都设置了内链,但是蜘蛛还是不抓取)

网站优化 • 优采云 发表了文章 • 0 个评论 • 82 次浏览 • 2021-10-26 17:16

搜外 Q&A 有人提过这个问题:每一个文章都有内链,但是蜘蛛还是不抓取!言外之意是文章中的内链并没有有效增加爬取的蜘蛛数量。其实爬取的蜘蛛数量与内链没有直接关系!

正常情况下,每个网站的每一页都可以被蜘蛛抓取,因为网站中通常有分类页面、网站地图等,足以提供一个链接入口。

那为什么在文章里面设置了内链,蜘蛛还是不抓取呢?原因不是文章有没有内链,而是网站更新的频率,网站的更新次数,网站的权重。理论上,当网站服务器稳定时,网站的权重越高,更新频率越大,更新越多,爬虫越频繁,爬取越多.

当然,合理设置内部链接也可以起到提供链接入口的作用,让蜘蛛可以更多的收入目标页面的链接到被抓取的链接库。只是这里需要注意一下。提取链接并不意味着所有链接都会被抓取。是否抓取需要抓取的链接库的链接以及何时抓取取决于搜索引擎的抓取策略。

总之,爬取的蜘蛛数量与内链没有直接关系!在网站页面有链接入口的情况下,内链的作用更多的是权重循环,尤其是文章主要内容中的相关锚文本内链,可以有效传递重量。所以在设置文章内链的时候,需要更多的考虑用户体验,关注链接的相关性,而不是考虑增加蜘蛛爬取的量。 查看全部

网站内容抓取(搜外问答:文章里面都设置了内链,但是蜘蛛还是不抓取)

搜外 Q&A 有人提过这个问题:每一个文章都有内链,但是蜘蛛还是不抓取!言外之意是文章中的内链并没有有效增加爬取的蜘蛛数量。其实爬取的蜘蛛数量与内链没有直接关系!

正常情况下,每个网站的每一页都可以被蜘蛛抓取,因为网站中通常有分类页面、网站地图等,足以提供一个链接入口。

那为什么在文章里面设置了内链,蜘蛛还是不抓取呢?原因不是文章有没有内链,而是网站更新的频率,网站的更新次数,网站的权重。理论上,当网站服务器稳定时,网站的权重越高,更新频率越大,更新越多,爬虫越频繁,爬取越多.

当然,合理设置内部链接也可以起到提供链接入口的作用,让蜘蛛可以更多的收入目标页面的链接到被抓取的链接库。只是这里需要注意一下。提取链接并不意味着所有链接都会被抓取。是否抓取需要抓取的链接库的链接以及何时抓取取决于搜索引擎的抓取策略。

总之,爬取的蜘蛛数量与内链没有直接关系!在网站页面有链接入口的情况下,内链的作用更多的是权重循环,尤其是文章主要内容中的相关锚文本内链,可以有效传递重量。所以在设置文章内链的时候,需要更多的考虑用户体验,关注链接的相关性,而不是考虑增加蜘蛛爬取的量。

网站内容抓取(人人都用得上webscraper进阶教程,人人用得上数据教程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 88 次浏览 • 2021-10-26 15:20

如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。

相关 文章:

最简单的数据采集教程,大家都可以用

进阶网页爬虫教程,人人都能用

如果你正在使用网络爬虫抓取数据,你很可能会遇到以下一个或多个问题,这些问题可能会直接打乱你的计划,甚至让你放弃网络爬虫。

下面列出了您可能遇到的几个问题,并解释了解决方案。

1、有时候我们想选择一个链接,但是鼠标点击会触发页面跳转。如何处理?

当我们选择页面元素时,勾选“启用键”,然后将鼠标移动到要选择的元素上,按S键。

另外勾选“启用键”后,会出现三个字母,分别是S、P、C。按S选择当前元素,按P选择当前元素的父元素,按C选择子元素当前元素的。当前元素是指鼠标所在的元素。

2、 分页数据或滚动加载的数据无法完整抓取,如知乎 和推特等?

这种问题多半是网络问题。在数据可以加载之前,网络爬虫开始解析数据,但由于没有及时加载,网络爬虫误认为抓取已经完成。

因此,适当增加延迟大小,延长等待时间,并留出足够的时间来加载数据。默认延迟2000,也就是2秒,可以根据网速调整。

但是,当数据量比较大的时候,不完整的数据抓取也很常见。因为只要在延迟时间内没有完成翻页或者下拉加载,那么爬取就结束了。

3、获取数据的顺序和网页上的顺序不一致?

webscraper默认是乱序的,可以安装CouchDB保证数据的顺序。

或者使用其他替代方法。最后,我们将数据导出为 CSV 格式。CSV在Excel中打开后,可以按照某一列进行排序。按发布时间排序,或者知乎上的数据按点赞数排序。

4、有些页面元素无法通过网络爬虫提供的选择器进行选择?

出现这种情况的原因可能是网站页面本身不符合页面布局规范,或者你想要的数据是动态的,比如只有鼠标悬停时才会显示的元素。在这些情况下,您也需要使用其他方法。

其实就是通过鼠标操作选择元素,最后找到元素对应的xpath。Xpath对应网页解释,是定位某个元素的路径,通过元素的类型、唯一标识符、样式名称、从属关系来查找某个元素或某种类型的元素。

如果你没有遇到过这个问题,那么就没有必要了解xpath。当您遇到问题时,您可以开始学习它。

这里只列举几个在使用网络爬虫过程中常见的问题。如果遇到其他问题,可以在文章下留言。 查看全部

网站内容抓取(人人都用得上webscraper进阶教程,人人用得上数据教程)

如果你想爬取数据又懒得写代码,可以试试网络爬虫爬取数据。

相关 文章:

最简单的数据采集教程,大家都可以用

进阶网页爬虫教程,人人都能用

如果你正在使用网络爬虫抓取数据,你很可能会遇到以下一个或多个问题,这些问题可能会直接打乱你的计划,甚至让你放弃网络爬虫。

下面列出了您可能遇到的几个问题,并解释了解决方案。

1、有时候我们想选择一个链接,但是鼠标点击会触发页面跳转。如何处理?

当我们选择页面元素时,勾选“启用键”,然后将鼠标移动到要选择的元素上,按S键。

另外勾选“启用键”后,会出现三个字母,分别是S、P、C。按S选择当前元素,按P选择当前元素的父元素,按C选择子元素当前元素的。当前元素是指鼠标所在的元素。

2、 分页数据或滚动加载的数据无法完整抓取,如知乎 和推特等?

这种问题多半是网络问题。在数据可以加载之前,网络爬虫开始解析数据,但由于没有及时加载,网络爬虫误认为抓取已经完成。

因此,适当增加延迟大小,延长等待时间,并留出足够的时间来加载数据。默认延迟2000,也就是2秒,可以根据网速调整。

但是,当数据量比较大的时候,不完整的数据抓取也很常见。因为只要在延迟时间内没有完成翻页或者下拉加载,那么爬取就结束了。

3、获取数据的顺序和网页上的顺序不一致?

webscraper默认是乱序的,可以安装CouchDB保证数据的顺序。

或者使用其他替代方法。最后,我们将数据导出为 CSV 格式。CSV在Excel中打开后,可以按照某一列进行排序。按发布时间排序,或者知乎上的数据按点赞数排序。

4、有些页面元素无法通过网络爬虫提供的选择器进行选择?

出现这种情况的原因可能是网站页面本身不符合页面布局规范,或者你想要的数据是动态的,比如只有鼠标悬停时才会显示的元素。在这些情况下,您也需要使用其他方法。

其实就是通过鼠标操作选择元素,最后找到元素对应的xpath。Xpath对应网页解释,是定位某个元素的路径,通过元素的类型、唯一标识符、样式名称、从属关系来查找某个元素或某种类型的元素。

如果你没有遇到过这个问题,那么就没有必要了解xpath。当您遇到问题时,您可以开始学习它。

这里只列举几个在使用网络爬虫过程中常见的问题。如果遇到其他问题,可以在文章下留言。

网站内容抓取(上海网站建设:网站抓取频率对SEO有哪些重要意义)

网站优化 • 优采云 发表了文章 • 0 个评论 • 50 次浏览 • 2021-10-26 05:21

每天都有数以万计的网址被搜索引擎抓取和抓取。它们通过相互联系形成我们现有的互联网关系。对于seo人员,我们经常讲一个术语:网站爬取频率。

上海网站建设认为网站爬取频率在SEO日常工作中起着重要作用,为网站优化提供宝贵建议。

那么,网站爬取频率对SEO有什么意义呢?

根据以往的工作经验,我们知道网页收录的一个基本流程主要是:

爬取网址->内容质量评价->索引库筛选->网页收录(显示在搜索结果中)

其中,如果你的内容质量比较低,会直接放入低质量索引库,那么就很难被百度收录。从这个过程不难看出,对网站的抓取频率会直接影响网站的收录率和内容质量评价。

影响网站爬取频率的因素:

①入站链接:理论上,只要是外部链接,无论其质量和形态,都会起到引导蜘蛛爬行和爬行的作用。

② 网站 结构:网站建设首选短域名,简化目录层次,网址过长,出现动态参数过多。

③ 页面速度:移动优先指标被百度不止一次提及。最重要的指标是首页加载,控制在3秒以内。

④ 主动提交:网站地图、官方API提交、JS访问提交等。

⑤ 内容更新:优质内容的更新频率,大规模网站排名的核心因素。

⑥百度熊掌账号:如果你的网站配置了熊掌账号,如果内容足够优质,抓取率几乎可以达到100%。

如何查看网站的爬取频率:

① cms 系统自带的“百度蜘蛛”分析插件。

②定期做“网站日志分析”比较方便。

页面抓取对网站的影响:

1、网站修订版

如果你的网站升级修改了,部分网址已经修改,可能急需搜索引擎对页面内容进行抓取和重新评估。

其实这时候有个方便的窍门:就是主动把网址加入站点地图,在百度后台更新,第一时间通知搜索引擎自己的变化。

2、网站 排名

大多数站长认为,百度熊掌自推出以来,就解决了收录的问题。事实上,只有不断抓取目标网址,才能不断重新评估其权重,提高排名。

因此,当您有一个页面需要进行排名时,您需要将其放置在抓取频率较高的列中。

3、压力控制

页面抓取频率高不一定好。来自恶意的采集爬虫,往往会造成服务器资源的严重浪费甚至宕机,尤其是一些外链分析爬虫。

如有必要,可能需要合理使用 Robots.txt 进行有效屏蔽。

4、异常诊断

如果你发现某个页面很久没有收录,那你就需要了解一下:百度蜘蛛的可访问性,可以通过百度官方后台的爬取诊断来查看具体原因。

总结:页面爬取频率对索引、收录、排名、二级排名起着至关重要的作用。作为SEO人员,您可能需要注意它。以上内容仅供参考。 查看全部

网站内容抓取(上海网站建设:网站抓取频率对SEO有哪些重要意义)

每天都有数以万计的网址被搜索引擎抓取和抓取。它们通过相互联系形成我们现有的互联网关系。对于seo人员,我们经常讲一个术语:网站爬取频率。

上海网站建设认为网站爬取频率在SEO日常工作中起着重要作用,为网站优化提供宝贵建议。

那么,网站爬取频率对SEO有什么意义呢?

根据以往的工作经验,我们知道网页收录的一个基本流程主要是:

爬取网址->内容质量评价->索引库筛选->网页收录(显示在搜索结果中)

其中,如果你的内容质量比较低,会直接放入低质量索引库,那么就很难被百度收录。从这个过程不难看出,对网站的抓取频率会直接影响网站的收录率和内容质量评价。

影响网站爬取频率的因素:

①入站链接:理论上,只要是外部链接,无论其质量和形态,都会起到引导蜘蛛爬行和爬行的作用。

② 网站 结构:网站建设首选短域名,简化目录层次,网址过长,出现动态参数过多。

③ 页面速度:移动优先指标被百度不止一次提及。最重要的指标是首页加载,控制在3秒以内。

④ 主动提交:网站地图、官方API提交、JS访问提交等。

⑤ 内容更新:优质内容的更新频率,大规模网站排名的核心因素。

⑥百度熊掌账号:如果你的网站配置了熊掌账号,如果内容足够优质,抓取率几乎可以达到100%。

如何查看网站的爬取频率:

① cms 系统自带的“百度蜘蛛”分析插件。

②定期做“网站日志分析”比较方便。

页面抓取对网站的影响:

1、网站修订版

如果你的网站升级修改了,部分网址已经修改,可能急需搜索引擎对页面内容进行抓取和重新评估。

其实这时候有个方便的窍门:就是主动把网址加入站点地图,在百度后台更新,第一时间通知搜索引擎自己的变化。

2、网站 排名

大多数站长认为,百度熊掌自推出以来,就解决了收录的问题。事实上,只有不断抓取目标网址,才能不断重新评估其权重,提高排名。

因此,当您有一个页面需要进行排名时,您需要将其放置在抓取频率较高的列中。

3、压力控制

页面抓取频率高不一定好。来自恶意的采集爬虫,往往会造成服务器资源的严重浪费甚至宕机,尤其是一些外链分析爬虫。

如有必要,可能需要合理使用 Robots.txt 进行有效屏蔽。

4、异常诊断

如果你发现某个页面很久没有收录,那你就需要了解一下:百度蜘蛛的可访问性,可以通过百度官方后台的爬取诊断来查看具体原因。

总结:页面爬取频率对索引、收录、排名、二级排名起着至关重要的作用。作为SEO人员,您可能需要注意它。以上内容仅供参考。

网站内容抓取(网站不被收录的原因是什么,如何解决网站收录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-25 22:07

收录 是排名的前提。如果不包括网站,就谈不上排名。所以,很困扰我们的是网站的收录。网站不成为收录的原因是什么,如何解决成为网站成为收录的问题?

1、 网站收录三部曲

检查robots 文件以查看是否禁止爬行。

如果你的 网站 内容是空的,那就没必要抢了。另一种情况是将内容放在 flash 和 frame 中。这时候蜘蛛是抓不住的。

这是指网站的内容质量是否符合标准。如果质量不好,是不会被抓到的。搜索引擎综合评分你的网站,有必要抓你吗?

2、 收录 的目的

搜索引擎本身不产生内容。内容来自网站管理员和用户。搜索引擎的作用是获取内容,经过排序后提供给用户。目的是为了给用户带来方便。您收录的内容越多,您的 网站 就越有价值。

搜索引擎不包括所有内容。它会首先过滤和选择一些常规的、有价值的信息,这样有些内容会被收录,有些内容不会被收录。

解决网站no收录问题,需要熟悉蜘蛛爬行的原理

3、 网站seo收录 标准

事实上,这个标准只是一个通用的标准,并不是真正的标准。这是我们总结出来的一个标准,主要包括:

(1)需要满足什么,用户需要满足什么主要看行业。

(2)要解决什么问题,比如用户要装修,需要效果图,价格,预算表等。

(3)有什么知识分享。比如PS怎么学。

作为网站 管理员,了解用户需要什么并满足他们的需求很重要。

(1)如何用有限的存储空间存储无限的内容资源?尽量做高质量的内容。

(3)稀缺程度。内容是否稀缺不是整个行业都提供的,但是如果你提供了,那么你的内容就是稀缺的。但是稀缺不等于创造力,它是相对的,其他都是没有,但是你有,所以比较稀缺。

(4)综合得分。网站的综合得分就是权重值。如果网站的权重值高,采集自然会更好。

判断内容的质量。我们需要按照百度的标准来判断内容的质量。

4、 低质量内容

什么是低质量内容?

在优化过程中,网站的收录是一个必须解决的问题。如果网站不是收录,首先分析原因,是否允许蜘蛛爬取,是否满足用户需求,内容是否优质等,这些是导致拒绝 网站 。 查看全部

网站内容抓取(网站不被收录的原因是什么,如何解决网站收录)

收录 是排名的前提。如果不包括网站,就谈不上排名。所以,很困扰我们的是网站的收录。网站不成为收录的原因是什么,如何解决成为网站成为收录的问题?

1、 网站收录三部曲

检查robots 文件以查看是否禁止爬行。

如果你的 网站 内容是空的,那就没必要抢了。另一种情况是将内容放在 flash 和 frame 中。这时候蜘蛛是抓不住的。

这是指网站的内容质量是否符合标准。如果质量不好,是不会被抓到的。搜索引擎综合评分你的网站,有必要抓你吗?

2、 收录 的目的

搜索引擎本身不产生内容。内容来自网站管理员和用户。搜索引擎的作用是获取内容,经过排序后提供给用户。目的是为了给用户带来方便。您收录的内容越多,您的 网站 就越有价值。

搜索引擎不包括所有内容。它会首先过滤和选择一些常规的、有价值的信息,这样有些内容会被收录,有些内容不会被收录。

解决网站no收录问题,需要熟悉蜘蛛爬行的原理

3、 网站seo收录 标准

事实上,这个标准只是一个通用的标准,并不是真正的标准。这是我们总结出来的一个标准,主要包括:

(1)需要满足什么,用户需要满足什么主要看行业。

(2)要解决什么问题,比如用户要装修,需要效果图,价格,预算表等。

(3)有什么知识分享。比如PS怎么学。

作为网站 管理员,了解用户需要什么并满足他们的需求很重要。

(1)如何用有限的存储空间存储无限的内容资源?尽量做高质量的内容。

(3)稀缺程度。内容是否稀缺不是整个行业都提供的,但是如果你提供了,那么你的内容就是稀缺的。但是稀缺不等于创造力,它是相对的,其他都是没有,但是你有,所以比较稀缺。

(4)综合得分。网站的综合得分就是权重值。如果网站的权重值高,采集自然会更好。

判断内容的质量。我们需要按照百度的标准来判断内容的质量。

4、 低质量内容

什么是低质量内容?

在优化过程中,网站的收录是一个必须解决的问题。如果网站不是收录,首先分析原因,是否允许蜘蛛爬取,是否满足用户需求,内容是否优质等,这些是导致拒绝 网站 。

网站内容抓取(如何在web主机上强制重定向的做法中使用以下代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-31 16:10

正确的方法是:其中一个重定向到另一个而不是两个。如果两个同时加载,那么站点的版本安全就会有问题。如果您在浏览器中输入网站的网址,请分别测试和测试。

如果两个 URL 都加载了,则会显示两个版本的内容,重复的 URL 可能会导致重复的内容。

为确保您不再遇到此问题,您需要根据站点的平台执行以下操作之一:

在HTACCESS中创建完整的重定向模式(在Apache/CPanel服务器上);

使用 WordPress 中的重定向插件强制重定向。

4、如何在Apache/Cpanel服务器的htaccess中创建重定向

您可以在 Apache/CPanel 服务器的 .htaccess 中执行服务器级全局重定向。Inmotionhosting 有一个很好的教程,教你如何在你的虚拟主机上强制重定向。

如果强制所有网络流量使用HTTPS,则需要使用以下代码。

确保将此代码添加到具有类似前缀(RewriteEngineOn、RewriteCond 等)的代码之上。

重写引擎开启

RewriteCond%{HTTPS}!on

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

RewriteRule(.*)%{HTTP_HOST}%{REQUEST_URI}[L,R=301]

如果只想重定向到特定域,则需要在 htaccess 文件中使用以下代码行:

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

重写引擎开启

RewriteCond%{HTTP_HOST}^example\.com[NC]

RewriteCond%{SERVER_PORT}80

重写规则^(.*)$$1[R=301,L]

注意:如果您不确定对服务器进行正确的更改,请确保您的服务器公司或 IT 人员执行这些维修。

5、如果你运行的是WordPress网站,请使用插件

解决这些重定向问题的简单方法是使用插件,尤其是在运行 WordPress网站 时。

许多插件可以强制重定向,但这里有一些插件可以使这个过程尽可能简单:CMHTTPSPro、WPForceSSL、EasyHTTPSRedirection。

关于插件的注意事项:如果您使用了过多的插件,请不要添加。

您可能需要调查您的服务器是否可以使用上述类似的重定向规则(例如,如果您使用的是基于 NGINX 的服务器)。

这里需要声明:插件的权重会对网站的速度产生负面影响,所以不要总认为新插件会对你有帮助。

6、所有网站链接都应该从

即使执行了上述重定向,也应执行此步骤。

如果您使用绝对 URL 而不是相对 URL,则应该这样做。因为前者总是显示你正在使用的超文本传输协议,如果你使用的是后者,那么你就不需要多注意这个了。

为什么在使用绝对 URL 时需要更改实时链接?因为 Google 会抓取所有这些链接,所以这可能会导致重复的内容。

这似乎是在浪费时间,但事实并非如此。您需要确保 Google 可以准确捕获您的 网站。

7、确保从到的转换,没有404页面

404页面的突然增加可能会让你的网站无法操作,尤其是有页面链接的时候。

另外,由于显示的404页面过多,谷歌没有找到应该抓取的页面,会造成抓取预算的浪费。

Google 负责人 John Mueller 指出,爬取预算并不重要,除非是针对大型网站。

John Mueller 在 Twitter 上表示,他认为爬行预算优化被高估了。对于大多数网站,它没有任何作用,只能帮助大规模的网站。

“IMO 的抓取预算被高估了。实际上,大多数 网站 不需要担心。如果您正在抓取网页或运行具有数十亿个 URL 的 网站,这一点非常重要,但是对于普通的网站来说并不是很重要。”

SEOPowerSuite相关负责人YauhenKhutarniuk的文章文章也对这一点进行了阐述:

”按道理来说,你应该注意抓取预算,因为你希望谷歌在你的网站上发现尽可能多的重要页面。你也希望它在你的网站上快速找到新的内容,您的抓取预算越大(管理越聪明),这将发生得越快。”

优化你的抓取预算非常重要,因为在网站上快速找到新内容是一项重要的任务,你需要在网站上发现尽可能多的优先页面。

8、如何修复可能出现的 404 页面

首先,将 404 从旧 URL 重定向到新的现有 URL。

一个更简单的方法是,如果你有WordPress网站,使用ScreamingFrog抓取网站,使用WordPress重定向插件进行301重定向规则批量上传。

9、URL结构不要太复杂

在准备技术 SEO 时,URL 的结构是一个重要的考虑因素。

这些东西你也一定要注意,比如随机生成索引的动态参数、不易理解的URL,以及其他在技术SEO实施中可能会出现问题的因素。

这些都是重要的因素,因为它们可能会导致索引问题,从而损害 网站 的性能。

10、 更人性化的网址

创建 URL 时,您可以考虑相关内容,然后自动创建 URL。然而,这可能并不合理。

原因是自动生成的 URL 可以遵循几种不同的格式,没有一种是非常用户友好的。

例如:

(1)/内容/日期/时间/关键字

(2)/Content/Date/Time/Number string

(3)/内容/类别/日期/时间/

(4)/content/category/date/time/parameter/

正确传达 URL 背后的内容是关键。由于可访问性,它在今天变得更加重要。

URL 的可读性越高越好:如果有人在搜索结果中看到您的 URL,他们可能更愿意点击它,因为他们会确切地看到 URL 与他们搜索的内容的相关性。简而言之,URL 需要匹配用户的搜索意图。

许多现有的 网站 使用过时或混乱的 URL 结构,导致用户参与度低。如果您有一个对用户更友好的 URL,您的 网站 可能会有更高的用户参与度。

11、 重复的 URL

在构建任何链接之前需要考虑的一个 SEO 技术问题是:内容重复。

说到内容重复,主要有以下几个原因:

(1)在网站的各个部分显着重复的内容。

(2) 从其他 网站 抓取内容。

(3) 重复的 URL,其中只存在一个内容。

因为当多个 URL 代表一个内容时,它确实会混淆搜索引擎。搜索引擎很少同时显示相同的内容,重复的 URL 会削弱其搜索能力。

12、避免使用动态参数

尽管动态参数本身不是 SEO 问题,但如果您无法管理它们的创建并使其在使用中保持一致,它们将来可能会成为潜在威胁。

JesScholz在搜索引擎杂志文章上发表了一篇文章,内容涉及动态参数和URL处理的基础知识以及它如何影响SEO。

Scholz 解释说,参数用于以下目的:跟踪、重新排序、过滤、识别、分页、搜索、翻译。

当您发现问题是由 URL 的动态参数引起时,通常将其归因于 URL 的基本管理不善。

在跟踪的情况下,创建搜索引擎抓取的链接时可以使用不同的动态参数。在重新排序的情况下,使用这些不同的动态参数对列表和项目组进行重新排序,然后创建可索引的重复页面,然后由搜索引擎抓取。

如果动态参数没有保持在可管理的水平,可能会在不经意间导致过多重复的内容。

如果不仔细管理一部分内容的创建,这些动态URL的创建实际上会随着时间的推移而积累,这会稀释内容的质量,削弱搜索引擎的执行能力。

还会造成关键词“同类相食”,相互影响,在足够大的范围内严重影响你的竞争力。

13、 短网址比长网址好

长期 SEO 实践的结果是,较短的 URL 优于较长的 URL。

Google 的 John Mueller 说:“当我们有两个内容相同的 URL 时,我们需要选择其中一个显示在搜索结果中,我们会选择较短的一个,这就是规范化。当然,长度不是主要的影响因素,但是如果我们有两个网址,一个很简洁,另一个有很长的附加参数,当它们显示相同的内容时,我们更喜欢选择短的。有很多例子,比如不同的因素在起作用,但其他条件相同——你有一个较短的和一个较长的,我们也会选择较短的。”

还有证据表明,谷歌优先考虑短网址而不是较长的网址。

如果您的 网站 收录很长的 URL,您可以将它们优化为更短、更简洁的 URL,以更好地反映 文章 的主题和用户意图。

热门标签 查看全部

网站内容抓取(如何在web主机上强制重定向的做法中使用以下代码)

正确的方法是:其中一个重定向到另一个而不是两个。如果两个同时加载,那么站点的版本安全就会有问题。如果您在浏览器中输入网站的网址,请分别测试和测试。

如果两个 URL 都加载了,则会显示两个版本的内容,重复的 URL 可能会导致重复的内容。

为确保您不再遇到此问题,您需要根据站点的平台执行以下操作之一:

在HTACCESS中创建完整的重定向模式(在Apache/CPanel服务器上);

使用 WordPress 中的重定向插件强制重定向。

4、如何在Apache/Cpanel服务器的htaccess中创建重定向

您可以在 Apache/CPanel 服务器的 .htaccess 中执行服务器级全局重定向。Inmotionhosting 有一个很好的教程,教你如何在你的虚拟主机上强制重定向。

如果强制所有网络流量使用HTTPS,则需要使用以下代码。

确保将此代码添加到具有类似前缀(RewriteEngineOn、RewriteCond 等)的代码之上。

重写引擎开启

RewriteCond%{HTTPS}!on

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

RewriteRule(.*)%{HTTP_HOST}%{REQUEST_URI}[L,R=301]

如果只想重定向到特定域,则需要在 htaccess 文件中使用以下代码行:

RewriteCond%{REQUEST_URI}!^/[0-9]+\..+\.cpaneldcv$

RewriteCond%{REQUEST_URI}!^/\.well-known/pki-validation/[A-F0-9]{32}\.txt(?:\Comodo\DCV)?$

重写引擎开启

RewriteCond%{HTTP_HOST}^example\.com[NC]

RewriteCond%{SERVER_PORT}80

重写规则^(.*)$$1[R=301,L]

注意:如果您不确定对服务器进行正确的更改,请确保您的服务器公司或 IT 人员执行这些维修。

5、如果你运行的是WordPress网站,请使用插件

解决这些重定向问题的简单方法是使用插件,尤其是在运行 WordPress网站 时。

许多插件可以强制重定向,但这里有一些插件可以使这个过程尽可能简单:CMHTTPSPro、WPForceSSL、EasyHTTPSRedirection。

关于插件的注意事项:如果您使用了过多的插件,请不要添加。

您可能需要调查您的服务器是否可以使用上述类似的重定向规则(例如,如果您使用的是基于 NGINX 的服务器)。

这里需要声明:插件的权重会对网站的速度产生负面影响,所以不要总认为新插件会对你有帮助。

6、所有网站链接都应该从

即使执行了上述重定向,也应执行此步骤。

如果您使用绝对 URL 而不是相对 URL,则应该这样做。因为前者总是显示你正在使用的超文本传输协议,如果你使用的是后者,那么你就不需要多注意这个了。

为什么在使用绝对 URL 时需要更改实时链接?因为 Google 会抓取所有这些链接,所以这可能会导致重复的内容。

这似乎是在浪费时间,但事实并非如此。您需要确保 Google 可以准确捕获您的 网站。

7、确保从到的转换,没有404页面

404页面的突然增加可能会让你的网站无法操作,尤其是有页面链接的时候。

另外,由于显示的404页面过多,谷歌没有找到应该抓取的页面,会造成抓取预算的浪费。

Google 负责人 John Mueller 指出,爬取预算并不重要,除非是针对大型网站。

John Mueller 在 Twitter 上表示,他认为爬行预算优化被高估了。对于大多数网站,它没有任何作用,只能帮助大规模的网站。

“IMO 的抓取预算被高估了。实际上,大多数 网站 不需要担心。如果您正在抓取网页或运行具有数十亿个 URL 的 网站,这一点非常重要,但是对于普通的网站来说并不是很重要。”

SEOPowerSuite相关负责人YauhenKhutarniuk的文章文章也对这一点进行了阐述:

”按道理来说,你应该注意抓取预算,因为你希望谷歌在你的网站上发现尽可能多的重要页面。你也希望它在你的网站上快速找到新的内容,您的抓取预算越大(管理越聪明),这将发生得越快。”

优化你的抓取预算非常重要,因为在网站上快速找到新内容是一项重要的任务,你需要在网站上发现尽可能多的优先页面。

8、如何修复可能出现的 404 页面

首先,将 404 从旧 URL 重定向到新的现有 URL。

一个更简单的方法是,如果你有WordPress网站,使用ScreamingFrog抓取网站,使用WordPress重定向插件进行301重定向规则批量上传。

9、URL结构不要太复杂

在准备技术 SEO 时,URL 的结构是一个重要的考虑因素。

这些东西你也一定要注意,比如随机生成索引的动态参数、不易理解的URL,以及其他在技术SEO实施中可能会出现问题的因素。

这些都是重要的因素,因为它们可能会导致索引问题,从而损害 网站 的性能。

10、 更人性化的网址

创建 URL 时,您可以考虑相关内容,然后自动创建 URL。然而,这可能并不合理。

原因是自动生成的 URL 可以遵循几种不同的格式,没有一种是非常用户友好的。

例如:

(1)/内容/日期/时间/关键字

(2)/Content/Date/Time/Number string

(3)/内容/类别/日期/时间/

(4)/content/category/date/time/parameter/

正确传达 URL 背后的内容是关键。由于可访问性,它在今天变得更加重要。

URL 的可读性越高越好:如果有人在搜索结果中看到您的 URL,他们可能更愿意点击它,因为他们会确切地看到 URL 与他们搜索的内容的相关性。简而言之,URL 需要匹配用户的搜索意图。

许多现有的 网站 使用过时或混乱的 URL 结构,导致用户参与度低。如果您有一个对用户更友好的 URL,您的 网站 可能会有更高的用户参与度。

11、 重复的 URL

在构建任何链接之前需要考虑的一个 SEO 技术问题是:内容重复。

说到内容重复,主要有以下几个原因:

(1)在网站的各个部分显着重复的内容。

(2) 从其他 网站 抓取内容。

(3) 重复的 URL,其中只存在一个内容。

因为当多个 URL 代表一个内容时,它确实会混淆搜索引擎。搜索引擎很少同时显示相同的内容,重复的 URL 会削弱其搜索能力。

12、避免使用动态参数

尽管动态参数本身不是 SEO 问题,但如果您无法管理它们的创建并使其在使用中保持一致,它们将来可能会成为潜在威胁。

JesScholz在搜索引擎杂志文章上发表了一篇文章,内容涉及动态参数和URL处理的基础知识以及它如何影响SEO。

Scholz 解释说,参数用于以下目的:跟踪、重新排序、过滤、识别、分页、搜索、翻译。

当您发现问题是由 URL 的动态参数引起时,通常将其归因于 URL 的基本管理不善。

在跟踪的情况下,创建搜索引擎抓取的链接时可以使用不同的动态参数。在重新排序的情况下,使用这些不同的动态参数对列表和项目组进行重新排序,然后创建可索引的重复页面,然后由搜索引擎抓取。

如果动态参数没有保持在可管理的水平,可能会在不经意间导致过多重复的内容。

如果不仔细管理一部分内容的创建,这些动态URL的创建实际上会随着时间的推移而积累,这会稀释内容的质量,削弱搜索引擎的执行能力。

还会造成关键词“同类相食”,相互影响,在足够大的范围内严重影响你的竞争力。

13、 短网址比长网址好

长期 SEO 实践的结果是,较短的 URL 优于较长的 URL。

Google 的 John Mueller 说:“当我们有两个内容相同的 URL 时,我们需要选择其中一个显示在搜索结果中,我们会选择较短的一个,这就是规范化。当然,长度不是主要的影响因素,但是如果我们有两个网址,一个很简洁,另一个有很长的附加参数,当它们显示相同的内容时,我们更喜欢选择短的。有很多例子,比如不同的因素在起作用,但其他条件相同——你有一个较短的和一个较长的,我们也会选择较短的。”

还有证据表明,谷歌优先考虑短网址而不是较长的网址。

如果您的 网站 收录很长的 URL,您可以将它们优化为更短、更简洁的 URL,以更好地反映 文章 的主题和用户意图。

热门标签

网站内容抓取(就是网站内容无法被百度搜索引擎有排名的,这是为什么呢?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 75 次浏览 • 2021-10-30 23:08

网站在互联网企业的发展中扮演着重要的角色。如果网站能够在搜索引擎首页上排名,那么看到网站的用户就会很多,网站会获得更多的流量,转化率也会相应提高。

但是有的SEO人员在做企业网站排名优化时会遇到这样的情况,即网站正常更新,百度搜索引擎不抓取网站的内容,所以 网站 不会被排名。为什么?

1、网站低重量

如果网站的权重很低,会导致百度搜索引擎无法抓取网站的内容。因此,想要百度搜索引擎抓取网站的内容,需要提高网站的整体质量和权重,这也有利于网站的排名。

2、网站服务器

如果网站服务器不稳定,安全性相对较差,百度搜索引擎将无法抓取网站的内容。所以在选择服务器时一定要选择独立、稳定、安全性高的服务器,这样的服务器才有利于网站收录的内容。

3、网站被处罚

一些SEO人员在做网站优化时会过度优化网站,这样不仅不会提升网站的排名,而且网站还会被搜索引擎惩罚. 这样一来,网站 的内容就不会是 收录。如果遇到这种情况,一定要及时调整优化策略。只有这样才能再次搜索网站的内容收录。

4、动态页面

如果网站页面是动态的,百度搜索引擎很难抓取页面内容。因此,有必要将页面调整为静态和伪静态页面,以方便百度搜索引擎抓取网站的内容。

5、经常修改网站

如果SEO人员经常修改网站的版本,也会造成这种情况。因此,在确定网站的结构后,一定不要轻易修改网站的版本,以免发生这种情况。

总之,当网站的内容无法被百度搜索引擎抓取时,你必须详细检查网站,找出原因,然后解决问题。只有这样,网站才有更好的发展空间。

蝙蝠侠 IT

转载需授权! 查看全部

网站内容抓取(就是网站内容无法被百度搜索引擎有排名的,这是为什么呢?)

网站在互联网企业的发展中扮演着重要的角色。如果网站能够在搜索引擎首页上排名,那么看到网站的用户就会很多,网站会获得更多的流量,转化率也会相应提高。

但是有的SEO人员在做企业网站排名优化时会遇到这样的情况,即网站正常更新,百度搜索引擎不抓取网站的内容,所以 网站 不会被排名。为什么?

1、网站低重量

如果网站的权重很低,会导致百度搜索引擎无法抓取网站的内容。因此,想要百度搜索引擎抓取网站的内容,需要提高网站的整体质量和权重,这也有利于网站的排名。

2、网站服务器

如果网站服务器不稳定,安全性相对较差,百度搜索引擎将无法抓取网站的内容。所以在选择服务器时一定要选择独立、稳定、安全性高的服务器,这样的服务器才有利于网站收录的内容。

3、网站被处罚

一些SEO人员在做网站优化时会过度优化网站,这样不仅不会提升网站的排名,而且网站还会被搜索引擎惩罚. 这样一来,网站 的内容就不会是 收录。如果遇到这种情况,一定要及时调整优化策略。只有这样才能再次搜索网站的内容收录。

4、动态页面

如果网站页面是动态的,百度搜索引擎很难抓取页面内容。因此,有必要将页面调整为静态和伪静态页面,以方便百度搜索引擎抓取网站的内容。

5、经常修改网站

如果SEO人员经常修改网站的版本,也会造成这种情况。因此,在确定网站的结构后,一定不要轻易修改网站的版本,以免发生这种情况。

总之,当网站的内容无法被百度搜索引擎抓取时,你必须详细检查网站,找出原因,然后解决问题。只有这样,网站才有更好的发展空间。

蝙蝠侠 IT

转载需授权!

网站内容抓取(我如何删除此异常并运行我的代码预先感谢解决方案 )

网站优化 • 优采云 发表了文章 • 0 个评论 • 86 次浏览 • 2021-10-30 07:27

)

问题

嗨,我正在尝试获取网站的数据。我为此编写了代码。想抓取按钮点击事件中的数据,但是运行程序时,抛出异常。

异常是:java.lang.NoClassDefFoundError: com/google/common/base/Function

如何删除此异常并运行我的程序

这是我试过的代码

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import org.openqa.selenium.support.ui.Select;

public class GetData {

public static void main(String args[]) throws InterruptedException {

WebDriver driver = new FirefoxDriver();

driver.get("http://www.upmandiparishad.in/ ... 6quot;);

Thread.sleep(5000);

// select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

// click button

Thread.sleep(3000);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(5000);

//get only table tex

WebElement findElement = driver.findElement(By.className("grid-view"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText);

driver.close();

driver.quit();

}

}

提前致谢

解决方案

希望对你有帮助。

//select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

String sDate = "12/04/2014"; //What date you want

driver.findElement(By.id("ctl00_ContentPlaceHolder1_txt_rate")).sendKeys(sDate);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(3000);

WebElement findElement = driver.findElement(By.id("ctl00_ContentPlaceHolder1_GridView1"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText); 查看全部

网站内容抓取(我如何删除此异常并运行我的代码预先感谢解决方案

)

问题

嗨,我正在尝试获取网站的数据。我为此编写了代码。想抓取按钮点击事件中的数据,但是运行程序时,抛出异常。

异常是:java.lang.NoClassDefFoundError: com/google/common/base/Function

如何删除此异常并运行我的程序

这是我试过的代码

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.firefox.FirefoxDriver;

import org.openqa.selenium.support.ui.Select;

public class GetData {

public static void main(String args[]) throws InterruptedException {

WebDriver driver = new FirefoxDriver();

driver.get("http://www.upmandiparishad.in/ ... 6quot;);

Thread.sleep(5000);

// select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

// click button

Thread.sleep(3000);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(5000);

//get only table tex

WebElement findElement = driver.findElement(By.className("grid-view"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText);

driver.close();

driver.quit();

}

}

提前致谢

解决方案

希望对你有帮助。

//select barge

new Select(driver.findElement(By.id("ctl00_ContentPlaceHolder1_ddl_commodity"))).selectByVisibleText("Jo");

String sDate = "12/04/2014"; //What date you want

driver.findElement(By.id("ctl00_ContentPlaceHolder1_txt_rate")).sendKeys(sDate);

driver.findElement(By.id("ctl00_ContentPlaceHolder1_btn_show")).click();

Thread.sleep(3000);

WebElement findElement = driver.findElement(By.id("ctl00_ContentPlaceHolder1_GridView1"));

String htmlTableText = findElement.getText();

// do whatever you want now, This is raw table values.

System.out.println(htmlTableText);

网站内容抓取(如何解决搜索引擎爬虫对我们的网页重复抓取的问题?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 85 次浏览 • 2021-10-30 06:09

对于每一个SEO从业者来说,每天都有爬虫来我们网站来爬取网页,这是非常宝贵的资源。但是,由于爬虫的无序爬行,难免会浪费爬虫的一些爬取资源。同时,我们需要解决搜索引擎爬虫反复抓取我们网页的问题。接下来,赵延刚就和大家谈谈如何解决这个问题。

在谈论这个问题之前,我们需要了解一个概念。首先,爬虫本身就是一个无序爬行。他不知道先抓什么,后抓什么。他只知道他看到了什么,经过计算,他认为有价值的话就会去抢。

对我们来说,在整个爬取过程中,必须解决以下几类

和上面的分类一样,我们根据顺序定义爬虫最需要爬取的分类。

对于大型网站,搜索引擎爬虫的抓取资源过多,而对于小型网站,抓取资源稀缺。所以在这里我们强调,我们并不是要解决搜索导致的重复爬行问题,而是要解决搜索引擎爬虫对我们想要爬取的页面的最快爬取。这个想法必须纠正!

接下来,我们来谈谈如何让搜索引擎爬虫以最快的速度抓取我们想要被抓取的页面。

爬虫是抓取网页并从该网页中找到更多链接的过程。那么我们就需要知道,如果我们想要被爬虫以更大的概率爬取,就必须给搜索引擎更多的链接。爬虫找到我们要爬取的网页。这里我以上面提到的第一种情况为例:

新生成的页面,尚未被抓取

这种类型的页面通常是文章页面,而我们这种类型页面的网站每天都会大量生产,所以我们会在更多的网页上给出这部分的链接。比如首页、频道页、栏目/列表页、专题聚合页,甚至文章页本身,都需要有一个最新的文章栏目等待爬虫抓取我们的任何网页。可以找到最新的文章。

同时,想象一下这么多页面都有新的文章的链接,链接传递权重。然后新的文章已经爬过了,权重不低。成为收录的速度将得到显着提升。

对于很久没有收录的,也可以考虑是不是权重过低。我会提供更多的内部链条支撑并传递一些重量。应该有收录的可能。当然也可能不是收录,那你就得靠内容本身的质量了。之前有一篇文章文章专门讲了内容质量,欢迎大家阅读:哪些内容容易被百度判断为优质内容?.

因此,为了解决搜索引擎爬虫重复爬取的问题,并不是我们最终的解决方案。由于搜索引擎爬虫本质上是无序的,我们只能针对网站的架构、推荐算法、运营策略进行干预。爬虫给了我们更理想的爬虫效果。如果没有根据爬虫自身的爬取效果进行优化网站,也可以联系我。

延伸阅读

原创文章:《如何解决搜索引擎爬虫重复爬行的问题》,作者:赵延刚。未经许可请勿转载。如转载请注明出处: 查看全部

网站内容抓取(如何解决搜索引擎爬虫对我们的网页重复抓取的问题?)

对于每一个SEO从业者来说,每天都有爬虫来我们网站来爬取网页,这是非常宝贵的资源。但是,由于爬虫的无序爬行,难免会浪费爬虫的一些爬取资源。同时,我们需要解决搜索引擎爬虫反复抓取我们网页的问题。接下来,赵延刚就和大家谈谈如何解决这个问题。

在谈论这个问题之前,我们需要了解一个概念。首先,爬虫本身就是一个无序爬行。他不知道先抓什么,后抓什么。他只知道他看到了什么,经过计算,他认为有价值的话就会去抢。

对我们来说,在整个爬取过程中,必须解决以下几类

和上面的分类一样,我们根据顺序定义爬虫最需要爬取的分类。

对于大型网站,搜索引擎爬虫的抓取资源过多,而对于小型网站,抓取资源稀缺。所以在这里我们强调,我们并不是要解决搜索导致的重复爬行问题,而是要解决搜索引擎爬虫对我们想要爬取的页面的最快爬取。这个想法必须纠正!

接下来,我们来谈谈如何让搜索引擎爬虫以最快的速度抓取我们想要被抓取的页面。

爬虫是抓取网页并从该网页中找到更多链接的过程。那么我们就需要知道,如果我们想要被爬虫以更大的概率爬取,就必须给搜索引擎更多的链接。爬虫找到我们要爬取的网页。这里我以上面提到的第一种情况为例:

新生成的页面,尚未被抓取

这种类型的页面通常是文章页面,而我们这种类型页面的网站每天都会大量生产,所以我们会在更多的网页上给出这部分的链接。比如首页、频道页、栏目/列表页、专题聚合页,甚至文章页本身,都需要有一个最新的文章栏目等待爬虫抓取我们的任何网页。可以找到最新的文章。

同时,想象一下这么多页面都有新的文章的链接,链接传递权重。然后新的文章已经爬过了,权重不低。成为收录的速度将得到显着提升。

对于很久没有收录的,也可以考虑是不是权重过低。我会提供更多的内部链条支撑并传递一些重量。应该有收录的可能。当然也可能不是收录,那你就得靠内容本身的质量了。之前有一篇文章文章专门讲了内容质量,欢迎大家阅读:哪些内容容易被百度判断为优质内容?.

因此,为了解决搜索引擎爬虫重复爬取的问题,并不是我们最终的解决方案。由于搜索引擎爬虫本质上是无序的,我们只能针对网站的架构、推荐算法、运营策略进行干预。爬虫给了我们更理想的爬虫效果。如果没有根据爬虫自身的爬取效果进行优化网站,也可以联系我。

延伸阅读

原创文章:《如何解决搜索引擎爬虫重复爬行的问题》,作者:赵延刚。未经许可请勿转载。如转载请注明出处:

网站内容抓取(搜索引擎会没有派出蜘蛛通过访问网站进行抓取内容页面收录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-10-29 21:15

我们都知道搜索引擎不会通过访问网站发送蜘蛛抓取内容页面。如果你的网站没有被爬取,会影响到收录,所以我们需要了解为什么会出现不爬取的问题。

一、网站 建筑垃圾消耗蜘蛛资源

搜索引擎对网站有蜘蛛配额,不同权重的网站获得的蜘蛛配额数量差别很大。如果你确定你的网站每日蜘蛛访问是正常的,如果页面没有被抓取,很可能是网站结构问题导致蜘蛛资源浪费在抓取收录 页。

二、 每天提交大量不合规页面

有时候,为了加快一些陈旧抄袭的文章收录,我们每天都会重复提交大量这样的页面。这无疑是在告诉搜索引擎抓取指定页面,但不会有蜘蛛抓取新页面。如果拿了,也是对蜘蛛配额资源的消耗。

三、网站 出现异常问题

有些网站有一些不易察觉的异常。这样一来,蜘蛛在访问之后出现问题就不会爬行了。这就像一个人看到了死胡同,不会去。

四、网站速度问题

如果网站的打开访问速度不够快,只会被蜘蛛访问,不会被爬取。原因是蜘蛛已经了解到这个页面的速度和效率不足以爬取内容参数属性进行分析收录。

五、网站安全问题

网站 除了异常和速度,安全等级也会影响蜘蛛是否会爬取页面。这是一个比喻,避免偷窃小偷进入商店并损害他们的用户和利益。

六、网站 有违规行为

网站 如果有其他不规范的营销、广告、设计不合理、布局不友好等,也会影响搜索引擎蜘蛛对页面的抓取。

七、网站SEO水平太差

访问网站后,蜘蛛发现规范性和正确性太差,不符合内容页收录的要求。如果网站只有收录首页和少量内容页,你应该检查SEO优化。

除了上面爬不出来的问题,还有爬取后失败的问题,可以参考:网站内容页爬取失败导致不收录的原因

SEO私馆结束语:将蜘蛛爬取资源分配给最需要的页面的URL地址收录。不要错误地认为更多的蜘蛛访问意味着更多的爬行。不要小看当前搜索引擎的AI技术处理能力。

《网站排名不上去的原因_没有关键词_没有收录内容页》

《搜索引擎蜘蛛访问与爬行的区别》

《搜索引擎无法访问网站的原因总结》 查看全部

网站内容抓取(搜索引擎会没有派出蜘蛛通过访问网站进行抓取内容页面收录)

我们都知道搜索引擎不会通过访问网站发送蜘蛛抓取内容页面。如果你的网站没有被爬取,会影响到收录,所以我们需要了解为什么会出现不爬取的问题。

一、网站 建筑垃圾消耗蜘蛛资源

搜索引擎对网站有蜘蛛配额,不同权重的网站获得的蜘蛛配额数量差别很大。如果你确定你的网站每日蜘蛛访问是正常的,如果页面没有被抓取,很可能是网站结构问题导致蜘蛛资源浪费在抓取收录 页。

二、 每天提交大量不合规页面

有时候,为了加快一些陈旧抄袭的文章收录,我们每天都会重复提交大量这样的页面。这无疑是在告诉搜索引擎抓取指定页面,但不会有蜘蛛抓取新页面。如果拿了,也是对蜘蛛配额资源的消耗。

三、网站 出现异常问题

有些网站有一些不易察觉的异常。这样一来,蜘蛛在访问之后出现问题就不会爬行了。这就像一个人看到了死胡同,不会去。

四、网站速度问题

如果网站的打开访问速度不够快,只会被蜘蛛访问,不会被爬取。原因是蜘蛛已经了解到这个页面的速度和效率不足以爬取内容参数属性进行分析收录。

五、网站安全问题

网站 除了异常和速度,安全等级也会影响蜘蛛是否会爬取页面。这是一个比喻,避免偷窃小偷进入商店并损害他们的用户和利益。

六、网站 有违规行为

网站 如果有其他不规范的营销、广告、设计不合理、布局不友好等,也会影响搜索引擎蜘蛛对页面的抓取。

七、网站SEO水平太差

访问网站后,蜘蛛发现规范性和正确性太差,不符合内容页收录的要求。如果网站只有收录首页和少量内容页,你应该检查SEO优化。

除了上面爬不出来的问题,还有爬取后失败的问题,可以参考:网站内容页爬取失败导致不收录的原因

SEO私馆结束语:将蜘蛛爬取资源分配给最需要的页面的URL地址收录。不要错误地认为更多的蜘蛛访问意味着更多的爬行。不要小看当前搜索引擎的AI技术处理能力。

《网站排名不上去的原因_没有关键词_没有收录内容页》

《搜索引擎蜘蛛访问与爬行的区别》

《搜索引擎无法访问网站的原因总结》

网站内容抓取(网站怎么快速被爬虫?外链也能影响权重导入链接)

网站优化 • 优采云 发表了文章 • 0 个评论 • 92 次浏览 • 2021-10-29 03:04

在这个互联网时代,很多人在购买新品之前都会上网查资料,看看哪些品牌的口碑和评价比较好。这时候,排名靠前的产品就会占据绝对优势。据调查,87%的网民会使用搜索引擎服务寻找自己需要的信息,其中近70%的搜索者会直接在搜索结果自然排名的第一页找到自己需要的信息。

可见,目前SEO对于企业和产品具有不可替代的意义。接下来,我将告诉你如何在网站中快速被爬虫爬取。

1.关键词 是重中之重

我们经常听到人们谈论关键词,但是关键词的具体用途是什么?关键词是SEO的核心,也是网站在搜索引擎中排名的重要因素。

2. 外链也会影响权重

导入链接也是网站优化的一个非常重要的过程,可以间接影响网站在搜索引擎中的权重。目前常用的链接分为:锚文本链接、超链接、纯文本链接和图片链接。

3.如何被爬虫抓取?

爬虫是自动提取网页的程序,比如百度的蜘蛛。如果你想让你的网站页面更多的成为收录,你必须先让网页被爬虫抓取。

如果你的网站页面更新频繁,爬虫会更频繁地访问该页面,高质量的内容是爬虫喜欢爬取的目标,尤其是原创内容。

网站如何快速被蜘蛛爬取

1.网站 和页面权重。

这必须是第一要务。网站 权重高、资历老、权限大的蜘蛛,一定要特别对待。这样网站的爬取频率是非常高的,大家都知道搜索引擎蜘蛛为了保证Efficient,并不是所有的页面都会被网站爬取,而且网站的权重越高,爬取的深度越高,对应的可以爬取的页面也就越多,这样可以网站@收录也会有更多的页面。

2.网站 服务器。

网站服务器是网站的基石。如果网站服务器长时间打不开,那就谢天谢地了,蜘蛛想来也来不来。百度蜘蛛也是网站的访客。如果你的服务器不稳定或者卡住了,蜘蛛每次都很难爬到,有时只能爬到一个页面的一部分。这样一来,随着时间的推移,百度蜘蛛你的体验越来越差,你对网站的评价会越来越低,自然会影响你对网站的爬取,所以你一定愿意选择空间服务器。没有很好的基础。,再好的房子也会穿越。

3. 网站 的更新频率。

每次蜘蛛爬行时,都会存储页面数据。如果第二次爬取发现页面和第一次收录完全一样,说明页面没有更新,蜘蛛不需要频繁爬取。页面内容更新频繁,蜘蛛会更频繁地访问页面,但蜘蛛不是你一个人的,不可能蹲在这里等你更新,所以一定要主动展示给蜘蛛文章更新,让蜘蛛按照你的规则有效爬取,不仅让你的更新文章被更快的捕获,而且不会导致蜘蛛频繁跑徒然。

4.文章的原创性质。

高质量的原创内容对百度蜘蛛来说非常有吸引力。蜘蛛的目的是寻找新的东西,所以网站更新文章不要采集,不要天天转载。我们需要给蜘蛛提供真正有价值的 原创 内容。蜘蛛如果能拿到自己喜欢的东西,自然会对你的网站产生好感,经常来找吃的。

5.扁平的网站结构。