抓取网页数据 php

抓取网页数据 php(244.2系统功能的实现24结论32致谢33参考文献34)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-19 04:18

二十四

4.2 系统功能的实现24

结论 32

谢谢 33

参考文献 34

1 简介

本文主要介绍了基于网页分析和爬虫技术的金融数据采集系统的开发平台和开发环境,以及实现主要功能所需的方法。同时介绍了程序开发过程中可能存在的问题和解决方法。纸网

1.1 项目背景

当今社会,计算机和互联网技术的飞速发展给人们带来了极大的便利。互联网时代的到来,给传统的信息传输方式带来了翻天覆地的变化。互联网技术的包容性使得网站网页数量呈爆炸式增长,各种网站中的信息海量复杂。在金融信息行业,信息量大的特点尤为突出。

对于接触金融的人来说,需要面对各种各样的金融信息,金融网站和金融数据等等。金融数据对于企业和用户来说都是非常重要的。金融数据种类繁多[11](如股票、债券、指数等),数据量大,准确度要求高,而且不同的金融交易市场、不同类型的金融数据都有自己的数据更新时间段关于财经网站,用户想要快速获取有价值的信息并不容易。作为用户,如果你想在海量的网页和海量的数据信息中找到你需要的财务信息,没有专门的搜索工具就像大海捞针。因此,如何让用户获得采集

在此背景下,我们需要找到满足用户对金融信息需求的途径,信息采集技术应运而生。对于一般网页信息的提取,需要利用网页信息采集技术来设计和实现网页采集和数据处理系统[3]。网页信息抓取技术是指通过一系列操作从特定网页中抓取您需要的信息,然后对数据进行处理,最终实现用户所需的数据和表示。网页信息爬取技术在特定领域和特定人群中会有不同的应用形式。本文就是将该技术应用到金融信息中,设计并实现一个金融信息采集系统,

1.2 研究现状

1.3 研究目的、内容及意义

传统Web信息采集的目标是在目标网页上获取尽可能多的信息,甚至是获取全网资源,而这里的重点是采集到数量和信息速度,对采集的主题相关性要求不高。在现代网络活动中,人们更加关注与自身需求相关的部分信息,在有限的条件下获取数据。文献综述

由于财务信息庞大而复杂,常规的获取和处理流程会比较繁琐,所以我们需要一个新的工具来帮助用户快速抓取相应网页中的财务数据信息,同时自动化处理,提高工作效率. 本文以Web数据采集和数据处理技术为基础,从相关网站(如雅虎财经,金融世界)中提取金融数据作为应用实例,采用网页自动访问,在线提取和动态分析。方法,学习如何从目标网站中快速、大量地提取预定义的目标数据。

在财务数据采集系统的设计中,需要解决以下问题:首先要了解目标网站的结构,分析网站的URL;然后选择合适的网络数据采集技术,实现功能,获取网站的相应信息,提高系统对网络数据的抓取效率;最后,要做一个交互式的采集网站数据信息应用。财务数据采集系统(2): 查看全部

抓取网页数据 php(244.2系统功能的实现24结论32致谢33参考文献34)

二十四

4.2 系统功能的实现24

结论 32

谢谢 33

参考文献 34

1 简介

本文主要介绍了基于网页分析和爬虫技术的金融数据采集系统的开发平台和开发环境,以及实现主要功能所需的方法。同时介绍了程序开发过程中可能存在的问题和解决方法。纸网

1.1 项目背景

当今社会,计算机和互联网技术的飞速发展给人们带来了极大的便利。互联网时代的到来,给传统的信息传输方式带来了翻天覆地的变化。互联网技术的包容性使得网站网页数量呈爆炸式增长,各种网站中的信息海量复杂。在金融信息行业,信息量大的特点尤为突出。

对于接触金融的人来说,需要面对各种各样的金融信息,金融网站和金融数据等等。金融数据对于企业和用户来说都是非常重要的。金融数据种类繁多[11](如股票、债券、指数等),数据量大,准确度要求高,而且不同的金融交易市场、不同类型的金融数据都有自己的数据更新时间段关于财经网站,用户想要快速获取有价值的信息并不容易。作为用户,如果你想在海量的网页和海量的数据信息中找到你需要的财务信息,没有专门的搜索工具就像大海捞针。因此,如何让用户获得采集

在此背景下,我们需要找到满足用户对金融信息需求的途径,信息采集技术应运而生。对于一般网页信息的提取,需要利用网页信息采集技术来设计和实现网页采集和数据处理系统[3]。网页信息抓取技术是指通过一系列操作从特定网页中抓取您需要的信息,然后对数据进行处理,最终实现用户所需的数据和表示。网页信息爬取技术在特定领域和特定人群中会有不同的应用形式。本文就是将该技术应用到金融信息中,设计并实现一个金融信息采集系统,

1.2 研究现状

1.3 研究目的、内容及意义

传统Web信息采集的目标是在目标网页上获取尽可能多的信息,甚至是获取全网资源,而这里的重点是采集到数量和信息速度,对采集的主题相关性要求不高。在现代网络活动中,人们更加关注与自身需求相关的部分信息,在有限的条件下获取数据。文献综述

由于财务信息庞大而复杂,常规的获取和处理流程会比较繁琐,所以我们需要一个新的工具来帮助用户快速抓取相应网页中的财务数据信息,同时自动化处理,提高工作效率. 本文以Web数据采集和数据处理技术为基础,从相关网站(如雅虎财经,金融世界)中提取金融数据作为应用实例,采用网页自动访问,在线提取和动态分析。方法,学习如何从目标网站中快速、大量地提取预定义的目标数据。

在财务数据采集系统的设计中,需要解决以下问题:首先要了解目标网站的结构,分析网站的URL;然后选择合适的网络数据采集技术,实现功能,获取网站的相应信息,提高系统对网络数据的抓取效率;最后,要做一个交互式的采集网站数据信息应用。财务数据采集系统(2):

抓取网页数据 php(日发百万外链就是如何搭建蜘蛛池?多IP服务器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-04-18 19:34

<p>搜索引擎的搜索引擎可以访问和搜索页面被程序称为蜘蛛,也叫爬虫。引擎它因为到了互联网上,甚至是互联网的屏幕数据(还有一些网络,他很像是在抓取网页)到的)把数据放到搜索引擎自己的数据库中。或者外推数据没有搜索引擎然后就不会发这些帖子的URL,那么@k10@@这样的页面,搜索更不用说字迹而池子的原理就是将生成的网页内容,按照我们的大部分网址添加的网页内容,让其在整个网页中添加大量的网址,让其在页面中抓取,而将需要收录在蜘蛛开发站的一块块中。这样使用特定的@我们需要@我们需要有大量的蜘蛛网址> 查看全部

抓取网页数据 php(日发百万外链就是如何搭建蜘蛛池?多IP服务器)

<p>搜索引擎的搜索引擎可以访问和搜索页面被程序称为蜘蛛,也叫爬虫。引擎它因为到了互联网上,甚至是互联网的屏幕数据(还有一些网络,他很像是在抓取网页)到的)把数据放到搜索引擎自己的数据库中。或者外推数据没有搜索引擎然后就不会发这些帖子的URL,那么@k10@@这样的页面,搜索更不用说字迹而池子的原理就是将生成的网页内容,按照我们的大部分网址添加的网页内容,让其在整个网页中添加大量的网址,让其在页面中抓取,而将需要收录在蜘蛛开发站的一块块中。这样使用特定的@我们需要@我们需要有大量的蜘蛛网址>

抓取网页数据 php(web服务器(浏览器和web)传递数据学习记录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-04-14 01:01

抓取网页数据php学习记录正如吴恩达老师所说,php是一门开源的计算机语言,用于在web服务器和各种网络应用之间传递数据。在开始php学习之前,让我们先了解下web服务器。web服务器包括:浏览器web服务器(浏览器和web服务器)浏览器,我们的浏览器,上网时可以访问web服务器浏览器中的get和post方法post方法,向服务器传递一定数据格式或类型的信息send方法,将服务器的数据发送给浏览器对于没有安装浏览器的电脑php是无法访问的socket:用于把两个不同的操作系统之间传递信息的一个程序(用来处理数据)后面展开讲php后台编程接下来,让我们来学习下php的后台编程。

我们先来看下开始php的时候,如何使用phpdump来抓取web数据。这个抓取数据的方法,是通过php调用unix下的文件系统或者bash脚本执行来实现的。然后我们来解决php打印错误信息问题。我们先打印字符串让用户分享内容,php利用sendmessage对象来通过循环调用unix下的文件系统打印输出phpdemo1打印浏览器缓存错误信息,我们也来举个栗子。

我们看下php抓取keepalive:这个参数打印的是内容,不是错误信息。修改文件的名字,把它改成新的名字,然后替换phpdemo2(或者其他名字,都可以),而且每次替换phpdemo1的内容的时候,替换值都要打印出来。修改浏览器缓存文件名我们也来例个栗子吧。我们看下php自动将的post发送给浏览器,然后浏览器将post的内容打印出来。

phpdump-d-ppost-tdict-e3bff2114ee1ceccdce2a88cab11ddcee281fac326e5fe1f48708fa2b35d812f08cb592d725a3b9e7d3fb3fdc83b97761317e6ba61e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e62。 查看全部

抓取网页数据 php(web服务器(浏览器和web)传递数据学习记录)

抓取网页数据php学习记录正如吴恩达老师所说,php是一门开源的计算机语言,用于在web服务器和各种网络应用之间传递数据。在开始php学习之前,让我们先了解下web服务器。web服务器包括:浏览器web服务器(浏览器和web服务器)浏览器,我们的浏览器,上网时可以访问web服务器浏览器中的get和post方法post方法,向服务器传递一定数据格式或类型的信息send方法,将服务器的数据发送给浏览器对于没有安装浏览器的电脑php是无法访问的socket:用于把两个不同的操作系统之间传递信息的一个程序(用来处理数据)后面展开讲php后台编程接下来,让我们来学习下php的后台编程。

我们先来看下开始php的时候,如何使用phpdump来抓取web数据。这个抓取数据的方法,是通过php调用unix下的文件系统或者bash脚本执行来实现的。然后我们来解决php打印错误信息问题。我们先打印字符串让用户分享内容,php利用sendmessage对象来通过循环调用unix下的文件系统打印输出phpdemo1打印浏览器缓存错误信息,我们也来举个栗子。

我们看下php抓取keepalive:这个参数打印的是内容,不是错误信息。修改文件的名字,把它改成新的名字,然后替换phpdemo2(或者其他名字,都可以),而且每次替换phpdemo1的内容的时候,替换值都要打印出来。修改浏览器缓存文件名我们也来例个栗子吧。我们看下php自动将的post发送给浏览器,然后浏览器将post的内容打印出来。

phpdump-d-ppost-tdict-e3bff2114ee1ceccdce2a88cab11ddcee281fac326e5fe1f48708fa2b35d812f08cb592d725a3b9e7d3fb3fdc83b97761317e6ba61e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e62。

抓取网页数据 php(互联网-java使用浏览器内核模拟浏览器操作驱动包下载地址)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-04-09 16:17

互联网提供了大量的数据,有时需要抓取网页上的数据。通过程序采集的数据可实现自动化处理。与手动打开网页查看和处理数据相比,效率显着提高。

因为有些网页的内容是通过ajax方式通过js请求后端数据后在页面上设置的,所以此时无法通过httpclient的方式获取页面的数据。此时,您可以使用模拟浏览器访问该页面。浏览器下载页面的js后,会解析并执行相关操作。

通过selenium-java,使用浏览器内核模拟浏览器操作,访问网页,解析并执行js,生成完整的页面内容,然后通过接口解析返回的数据。

1. 下载驱动包

下载地址为:CNPM Binaries Mirror

这里使用的是谷歌浏览器,所以下载了对应版本的windows和linux驱动。此外,可以使用诸如 firefox 之类的浏览器内核。

2. 创建maven项目并配置依赖

org.seleniumhq.selenium

selenium-java

3.141.59

3. 配置驱动程序

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/tools/chromedriver_win32/chromedriver.exe");

驱动程序的位置需要在代码中指定。windows和linux平台下,需要分别指定对应的驱动路径。

4. 代码实现

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

import org.openqa.selenium.chrome.ChromeOptions;

public class FindDataDemo {

private void seleniumProcess() {

String uri = "http://tools.2345.com/rili.htm";

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/sdks/tools/chromedriver_win32/chromedriver.exe");

// 设置浏览器参数

ChromeOptions chromeOptions = new ChromeOptions();

chromeOptions.addArguments("--no-sandbox");//禁用沙箱

chromeOptions.addArguments("--disable-dev-shm-usage");//禁用开发者shm

chromeOptions.addArguments("--headless"); //无头浏览器,这样不会打开浏览器窗口

WebDriver webDriver = new ChromeDriver(chromeOptions);

webDriver.get(uri);

WebElement webElements = webDriver.findElement(By.id("yi"));

System.out.println("webElements = " + webElements);

System.out.println("webElements.getText() = " + webElements.getText());

String pageSource = webDriver.getPageSource();

System.out.println("webElements = " + pageSource);

webDriver.close();

}

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

FindDataDemo findDataDemo = new FindDataDemo();

findDataDemo.seleniumProcess();

long endTime = System.currentTimeMillis();

System.out.println("(endTime - startTime) = " + (endTime - startTime));

}

}

执行测试程序,可以看到获取到页面上的内容。 查看全部

抓取网页数据 php(互联网-java使用浏览器内核模拟浏览器操作驱动包下载地址)

互联网提供了大量的数据,有时需要抓取网页上的数据。通过程序采集的数据可实现自动化处理。与手动打开网页查看和处理数据相比,效率显着提高。

因为有些网页的内容是通过ajax方式通过js请求后端数据后在页面上设置的,所以此时无法通过httpclient的方式获取页面的数据。此时,您可以使用模拟浏览器访问该页面。浏览器下载页面的js后,会解析并执行相关操作。

通过selenium-java,使用浏览器内核模拟浏览器操作,访问网页,解析并执行js,生成完整的页面内容,然后通过接口解析返回的数据。

1. 下载驱动包

下载地址为:CNPM Binaries Mirror

这里使用的是谷歌浏览器,所以下载了对应版本的windows和linux驱动。此外,可以使用诸如 firefox 之类的浏览器内核。

2. 创建maven项目并配置依赖

org.seleniumhq.selenium

selenium-java

3.141.59

3. 配置驱动程序

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/tools/chromedriver_win32/chromedriver.exe");

驱动程序的位置需要在代码中指定。windows和linux平台下,需要分别指定对应的驱动路径。

4. 代码实现

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

import org.openqa.selenium.chrome.ChromeOptions;

public class FindDataDemo {

private void seleniumProcess() {

String uri = "http://tools.2345.com/rili.htm";

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/sdks/tools/chromedriver_win32/chromedriver.exe");

// 设置浏览器参数

ChromeOptions chromeOptions = new ChromeOptions();

chromeOptions.addArguments("--no-sandbox");//禁用沙箱

chromeOptions.addArguments("--disable-dev-shm-usage");//禁用开发者shm

chromeOptions.addArguments("--headless"); //无头浏览器,这样不会打开浏览器窗口

WebDriver webDriver = new ChromeDriver(chromeOptions);

webDriver.get(uri);

WebElement webElements = webDriver.findElement(By.id("yi"));

System.out.println("webElements = " + webElements);

System.out.println("webElements.getText() = " + webElements.getText());

String pageSource = webDriver.getPageSource();

System.out.println("webElements = " + pageSource);

webDriver.close();

}

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

FindDataDemo findDataDemo = new FindDataDemo();

findDataDemo.seleniumProcess();

long endTime = System.currentTimeMillis();

System.out.println("(endTime - startTime) = " + (endTime - startTime));

}

}

执行测试程序,可以看到获取到页面上的内容。

抓取网页数据 php(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-04-07 22:17

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在开发php中,也需要在服务器端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。看了下官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后我找到了另一个类库,Snoopy。我对这个类库了解不多,但是网上的反响还不错,所以我决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com");

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时,他还传递了cookies的请求头、对应头以及相关操作函数,功能非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn")) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页爬取和数据分析,非常实用。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。 查看全部

抓取网页数据 php(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在开发php中,也需要在服务器端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。看了下官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后我找到了另一个类库,Snoopy。我对这个类库了解不多,但是网上的反响还不错,所以我决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com";);

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时,他还传递了cookies的请求头、对应头以及相关操作函数,功能非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn";)) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页爬取和数据分析,非常实用。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。

抓取网页数据 php(php转型大数据应该是最容易的,但是感觉谁更容易)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-04-02 06:06

抓取网页数据php爬虫业务逻辑pythonweb开发这三门我都有涉及,但是感觉php转型大数据应该是最容易的。

1.爬虫相关(如python爬虫)2.hadoop3.分布式4.机器学习5.大数据开发6.云计算7.测试8.项目管理。再说一个老生常谈,什么东西都是人在做,而人有不同的角色,谁负责,谁主导,谁更关心,谁更愿意去做,谁能挣到更多的钱,

从2017来看,

1、数据资源整合服务提供商

2、第三方数据分析处理服务提供商

3、数据平台(hadoop)创建和使用服务提供商

4、大数据交易平台(dmt)服务提供商

5、数据服务平台(hive、spark、flink、zookeeper等)

6、大数据教育培训

7、大数据培训机构

8、大数据团队管理

9、大数据并行运算1

0、大数据实验环境1

1、大数据分析大屏设计1

2、大数据文本存储1

3、大数据图片存储1

4、大数据计算机视觉处理1

5、数据分析处理(机器学习算法、数据挖掘等)1

6、分布式计算1

7、数据挖掘平台架构1

8、区块链1

9、云计算服务2

0、大数据开发、数据平台、大数据培训2

1、大数据分析2

2、大数据开发2

3、大数据营销、广告服务2

4、大数据开发平台,云计算等。

根据行业的不同大数据的侧重点也不一样。比如大数据信息服务商,就侧重于大数据的数据的处理、可视化、分析。而涉及的编程语言也不一样,比如大数据软件开发,就侧重于处理的语言,而大数据技术支持平台就侧重于编程语言语言的使用。其次,大数据技术除了语言的处理,关注的还有数据流管理,数据类型转换,数据地理布局等相关的内容。

从这个角度来看,如果要选择学什么语言来学习大数据,可以结合自己的掌握的数据的范围来决定,使用的语言很多,但数据类型的转换方面基本上就靠语言提供的基础数据格式了,这个方面重点掌握语言的技术部分,能够简单使用就行了。对于大数据在不同领域的应用,大数据开发、大数据分析技术同样重要,需要对大数据技术重点学习。 查看全部

抓取网页数据 php(php转型大数据应该是最容易的,但是感觉谁更容易)

抓取网页数据php爬虫业务逻辑pythonweb开发这三门我都有涉及,但是感觉php转型大数据应该是最容易的。

1.爬虫相关(如python爬虫)2.hadoop3.分布式4.机器学习5.大数据开发6.云计算7.测试8.项目管理。再说一个老生常谈,什么东西都是人在做,而人有不同的角色,谁负责,谁主导,谁更关心,谁更愿意去做,谁能挣到更多的钱,

从2017来看,

1、数据资源整合服务提供商

2、第三方数据分析处理服务提供商

3、数据平台(hadoop)创建和使用服务提供商

4、大数据交易平台(dmt)服务提供商

5、数据服务平台(hive、spark、flink、zookeeper等)

6、大数据教育培训

7、大数据培训机构

8、大数据团队管理

9、大数据并行运算1

0、大数据实验环境1

1、大数据分析大屏设计1

2、大数据文本存储1

3、大数据图片存储1

4、大数据计算机视觉处理1

5、数据分析处理(机器学习算法、数据挖掘等)1

6、分布式计算1

7、数据挖掘平台架构1

8、区块链1

9、云计算服务2

0、大数据开发、数据平台、大数据培训2

1、大数据分析2

2、大数据开发2

3、大数据营销、广告服务2

4、大数据开发平台,云计算等。

根据行业的不同大数据的侧重点也不一样。比如大数据信息服务商,就侧重于大数据的数据的处理、可视化、分析。而涉及的编程语言也不一样,比如大数据软件开发,就侧重于处理的语言,而大数据技术支持平台就侧重于编程语言语言的使用。其次,大数据技术除了语言的处理,关注的还有数据流管理,数据类型转换,数据地理布局等相关的内容。

从这个角度来看,如果要选择学什么语言来学习大数据,可以结合自己的掌握的数据的范围来决定,使用的语言很多,但数据类型的转换方面基本上就靠语言提供的基础数据格式了,这个方面重点掌握语言的技术部分,能够简单使用就行了。对于大数据在不同领域的应用,大数据开发、大数据分析技术同样重要,需要对大数据技术重点学习。

抓取网页数据 php(抓取网页数据怎么设置抓取页面地址,实现调试!!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 42 次浏览 • 2022-03-26 02:03

抓取网页数据php是最好的选择,而ip地址就是抓取网页数据常用的一个web头,我们可以设置ip地址抓取某个网页数据,那么怎么设置抓取的页面地址呢,本教程教大家如何设置抓取页面地址,实现调试。你需要准备以下的工具,1.phpstorm2.nginx文件管理器3.curl命令行工具4.curl编程模拟器第一步:我们要安装phpstorm,这里我们以windows为例首先我们打开phpstorm,输入set-url,修改phpstorm中的url为set-url然后我们要在第一页面中选择要抓取数据的网页。

然后我们就可以打开网页了,你可以直接点击下拉菜单,看到url这一页面要抓取的内容然后我们右键这一页,复制这一页面的url然后进入nginx浏览器然后输入这一页面的url地址,当浏览器打开网页,你就会看到url的加载网页的方式url地址格式url目录名(是用户自己定义的,就是指定文件所在的位置)默认文件所在的位置index.php目录所在的文件夹index.phpphp代码的源码是一定要提前准备好然后我们把刚才的代码放进nginx里面,接着我们就可以通过中键来调用nginx的源码下面是set-url方法的参数第二步:我们想要把url地址重定向到指定的目录,只需要在index.php中输入url地址,然后就可以直接返回目录页面然后我们通过中键来调用nginx,接着返回目录页面。

<p>url地址在程序中是经常使用的,比如在做成文件管理的时候,存储文件夹,然后我们也可以把index.php中的php代码放进web.php文件里,当你有一个文件夹的时候,你就可以调用url_post这个命令,这个命令会把index.php文件的内容传给web.php,然后再把index.php里面的内容拿过来传给你想要抓取的页面。而nginx的源码如下: 查看全部

抓取网页数据 php(抓取网页数据怎么设置抓取页面地址,实现调试!!)

抓取网页数据php是最好的选择,而ip地址就是抓取网页数据常用的一个web头,我们可以设置ip地址抓取某个网页数据,那么怎么设置抓取的页面地址呢,本教程教大家如何设置抓取页面地址,实现调试。你需要准备以下的工具,1.phpstorm2.nginx文件管理器3.curl命令行工具4.curl编程模拟器第一步:我们要安装phpstorm,这里我们以windows为例首先我们打开phpstorm,输入set-url,修改phpstorm中的url为set-url然后我们要在第一页面中选择要抓取数据的网页。

然后我们就可以打开网页了,你可以直接点击下拉菜单,看到url这一页面要抓取的内容然后我们右键这一页,复制这一页面的url然后进入nginx浏览器然后输入这一页面的url地址,当浏览器打开网页,你就会看到url的加载网页的方式url地址格式url目录名(是用户自己定义的,就是指定文件所在的位置)默认文件所在的位置index.php目录所在的文件夹index.phpphp代码的源码是一定要提前准备好然后我们把刚才的代码放进nginx里面,接着我们就可以通过中键来调用nginx的源码下面是set-url方法的参数第二步:我们想要把url地址重定向到指定的目录,只需要在index.php中输入url地址,然后就可以直接返回目录页面然后我们通过中键来调用nginx,接着返回目录页面。

<p>url地址在程序中是经常使用的,比如在做成文件管理的时候,存储文件夹,然后我们也可以把index.php中的php代码放进web.php文件里,当你有一个文件夹的时候,你就可以调用url_post这个命令,这个命令会把index.php文件的内容传给web.php,然后再把index.php里面的内容拿过来传给你想要抓取的页面。而nginx的源码如下:

抓取网页数据 php(php中curl_setopt函数是怎么设置的呢传输选项?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 76 次浏览 • 2022-03-15 14:14

php中的curl_setopt函数是php中的一个重要函数,它用来设置一个cURL传输选项。那么它是如何设置的呢?参数是什么?这些用法示例在哪里?这篇文章文章会给你一个总结。

一.php curl_setopt函数概念及使用示例介绍

这篇文章主要介绍了php curl_setopt函数的语法,以及如何根据php curl_setopt函数语法中第二个值的不同来设置不同的值。得到不同的结果。

二.使用php curl_setopt()函数抓取网页和POST数据的简单例子

这篇文章主要介绍如何使用php curl_setopt函数抓取网页。curl_setopt函数的概念,它是PHP的一个扩展库,使用curl_setopt()函数可以方便快捷的抓取网页(可以在采集中使用),需要在php.ini中启用。php curl_setopt函数只有开启才能使用

三.php curl_setopt函数模拟用户登录示例

php curl_setopt() 函数将为 CURL 会话设置选项。它是php中的一个重要功能。它可以模仿一些用户行为,比如模仿用户登录、注册等用户可操作的行为。这个 文章 将带你了解一个

php中如何使用curl_setopt函数模拟用户登录的例子

四.Warning: curl_setopt() [function.curl-setopt]: CURLO...error 使用php curl函数报错如何解决

如果在 PHP 中运行 CURLOPT_FOLLOWLOCATION 时,您会收到来自 PHP 的错误消息:

警告:curl_setopt() [function.curl-setopt]:CURLOPT_FOLLOWLOCATION 在安全模式下或设置了 open_basedir 时无法激活……

该错误提到了两个关键的 safe_mode 和 open_basedir。如果你是虚拟主机并且没有设置APPCHE的权限,你不能通过修改服务器配置来解决问题。一般来说,服务器配置safe_mode是关闭的,然后为了一些安全有一些限制,通过设置open_basedir来限制虚拟主机用户的PHP执行文件夹,所以当你使用CURLOPT_FOLLOWLOCATION(php curl函数,深度抓取数据)时,一旦出现301重定向,就会出现文章中提到的错误信息。,查了相关资料后,很快就找到了解决办法。具体方法可以查看这个文章。

【curl_setopt函数相关Q&A】

php 的 curl_setopt 页面显示 500

php - curl_setopt($ch, CURLOPT_RETURNTRANSFER,1); 不输出任何内容

以上就是php curl_setopt()函数使用方法的详细总结。更多详情请关注龙方网其他相关方面文章! 查看全部

抓取网页数据 php(php中curl_setopt函数是怎么设置的呢传输选项?)

php中的curl_setopt函数是php中的一个重要函数,它用来设置一个cURL传输选项。那么它是如何设置的呢?参数是什么?这些用法示例在哪里?这篇文章文章会给你一个总结。

一.php curl_setopt函数概念及使用示例介绍

这篇文章主要介绍了php curl_setopt函数的语法,以及如何根据php curl_setopt函数语法中第二个值的不同来设置不同的值。得到不同的结果。

二.使用php curl_setopt()函数抓取网页和POST数据的简单例子

这篇文章主要介绍如何使用php curl_setopt函数抓取网页。curl_setopt函数的概念,它是PHP的一个扩展库,使用curl_setopt()函数可以方便快捷的抓取网页(可以在采集中使用),需要在php.ini中启用。php curl_setopt函数只有开启才能使用

三.php curl_setopt函数模拟用户登录示例

php curl_setopt() 函数将为 CURL 会话设置选项。它是php中的一个重要功能。它可以模仿一些用户行为,比如模仿用户登录、注册等用户可操作的行为。这个 文章 将带你了解一个

php中如何使用curl_setopt函数模拟用户登录的例子

四.Warning: curl_setopt() [function.curl-setopt]: CURLO...error 使用php curl函数报错如何解决

如果在 PHP 中运行 CURLOPT_FOLLOWLOCATION 时,您会收到来自 PHP 的错误消息:

警告:curl_setopt() [function.curl-setopt]:CURLOPT_FOLLOWLOCATION 在安全模式下或设置了 open_basedir 时无法激活……

该错误提到了两个关键的 safe_mode 和 open_basedir。如果你是虚拟主机并且没有设置APPCHE的权限,你不能通过修改服务器配置来解决问题。一般来说,服务器配置safe_mode是关闭的,然后为了一些安全有一些限制,通过设置open_basedir来限制虚拟主机用户的PHP执行文件夹,所以当你使用CURLOPT_FOLLOWLOCATION(php curl函数,深度抓取数据)时,一旦出现301重定向,就会出现文章中提到的错误信息。,查了相关资料后,很快就找到了解决办法。具体方法可以查看这个文章。

【curl_setopt函数相关Q&A】

php 的 curl_setopt 页面显示 500

php - curl_setopt($ch, CURLOPT_RETURNTRANSFER,1); 不输出任何内容

以上就是php curl_setopt()函数使用方法的详细总结。更多详情请关注龙方网其他相关方面文章!

抓取网页数据 php(百度统计追踪会不会影响SEO?A:用改版工具重新提交一下)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2022-03-05 09:15

【SEO问答】

Q:使用百度统计进行广告跟踪时,配置的URL链接会很长。这种跟踪会影响搜索引擎优化吗?

A:这种有多个URL版本的统计代码肯定会对SEO产生影响。对于这种情况有两个建议,一个是使用两组url进行真正的蜘蛛抓取和用户展示。另一种选择是停止使用百度统计,你可以使用谷歌中的跟踪,他可以使用#链接,事件跟踪,并参考美团网。所有链接加上事件跟踪。如果是生成的,也是用#号生成的,不加额外的参数。

Q:如果一个页面一开始不符合百度的SEO标准,后来改成符合标准,百度需要多长时间才能提供好的结果?

A:不同的站点可能会贡献不同的流量。因此,Spider 爬行的侧重点不同。有些站可能会发现更多新链接,有些站可能会查看旧链接。建议推到百度上,像首页一样抓取一般是没有问题的。

Q:推送审核需要多长时间,一周还是半个月?

A:如果说推送符合抓取标准,可以立即抓取。

问:网站有两种 URL,旧的和新的。更换大约需要两年时间。现在旧 URL 将跳转到新 URL。由于服务器问题,网络中断了半个小时。搜索 关键词 后,旧的 url 出现了。现在基本上所有方法都无法恢复。在这种情况下我们应该怎么做?

A:使用修改工具重新提交,保证修改成功,不会有问题。如有问题,截图并报告给工程师排查。

Q:由于网站使用的是海外域名(暂时无法更改),有什么办法可以提高搜索量或爬取量?

A:百度搜索引擎都是在中国备案的,最好使用国内的服务器和域名。

Q:有些网站注册使用了很多域名,很多域名并不是供用户搜索的。现在这些域名都被注销了,但是还是可以找到的。我关了一次,但是没有用。我不知道如何处理这个?

A:如果不需要那些站?你可以把它们关掉。短时间关闭新域名可能会为用户调用旧域名。当这个域名被关闭时,我们不会为用户进行长期调用。这些东西也不会被发现。

Q:网站是母婴类网站,PC端搜索流量很差。想知道有没有办法?

A:与医疗、养生、保健、母婴等问题类似,百度对搜索结果的展示非常谨慎。百度只对优质的网站开放他们的展示可能性,网站很可能很长时间都得不到流量。如果网站在SEO方面没有大问题,可以检查一下内容是否在争抢一些热门词。建议整个网站的权重和流量达到一定规模后再做热词。如果一开始就这样做关键词,当网站名声不是很高的时候,就不会有流量了。在这种情况下,网站 可能会更好地找到他们自己的区分和相关词之一。

问:网站 从事教育行业。现在通过官网的认证是安全或权威的认证。认证后会有潜在的特殊待遇或无所谓。

A:比如认证方面,你是真的,还有一个是假的。从用户的认知来看,你就是官网。

问:关于数据化、软件和PDF和Word显示的问题,包括哪些类型和多少资源?应该和文章的内容一起发布,还是PDF和文章一样?也有矛盾。产品及操作希望用户下载后直接使用,不会对PDF、WORD产生一些压缩或工具处理。有些用户会被引导到 Word,无论他们是无意还是无意。我该怎么办?

A:百度搜索栏现在默认称为网页搜索。顾名思义,我们向用户展示了一个网页。后面的库还有一种文件格式。搜索结果都是供用户下载使用的,他们可以去学习和展示图书馆的内容。

Q:有没有渠道告诉搜索引擎我们的页面内容发生了变化,我们通常如何处理?一个老页面已经收录,排序了,过了一段时间他发起了新资源的添加和更改?

A:目前还没有这样的渠道。首先,Spider 会检查一些东西。他发现网站经常出现在这种情况下,他的相关检查流量会增加。如果你担心,你应该把他放在站点地图中。

Q:网站原本只是一个主页,一个APP下载。我们现在正在发布内容。过去,这些内容无法被抓取。现在,我们是否需要提交修订以将其发布到目录或子域中?

A:这个是放在域名下的,一个子目录用来放分类的东西,没有修改。改首页,改版就没有其他问题了。使用主动推送工具的效果还是很明显的。如果内容质量非常好,您可以使用所有配额。

Q:自动推送份额多久调整一次?因为我觉得你的份额对于我们几千万或几百万的海量数据来说太小了。

A:我们也很关心一个网站有没有这种爆发力,突然增加这么多,我们觉得很不正常。你要循序渐进,不要又短又快,一夜之间吃成胖子。第二,你有这么多优秀的数据,你可以关注百度的另一个平台,你就变成了一个API,让别人使用你的数据。其他人为您的数据使用付费,您可以注意这一点。

Q:URL的绝对路径和相对路径是否会受到超链接的影响?修改后我们的页面有翻页,翻页链接是12345,上面有标签。每次抓到12345都抓不到。模拟抓,感觉抓不到。Spider会抓取页面上的A标签吗?

A:影响不大,能正常访问就可以了。不管是绝对路径还是相对路径,只要地址为Spider或者用户畅通无阻,并且页面渲染时地址完整,这条路径就可以顺利爬取。

对于not收录的问题,可以参考其他的点,比如页面本身没有被访问或者目录级别比较高。页面首页推送的链接会被百度一层一层抓到。如果路径正常,会从首页爬取Spider路径。

首先要做的是查看不是收录的链接日志是否已经被捕获。如果它被捕获而不是 收录,则可能是页面本身的问题。你也可以看一个周期,因为我们用一天。二是看日志中是否有长尾,是否隐藏或没有有效抓取或建关时推荐。如果你能看到日志,你可以看看日志来分析它。

可以调整首页的变化,提出建议,做个测试看看是链接问题还是蜘蛛没有抓到的问题。还有push等方法可以解决,从而判断不收录是什么原因。学院有一个解决许多问题的文件,类似于流程图。当这个戒指出现时,为什么?如果够长,可以看看下面的树枝。

Q:站点之前,所有的框架都是通过JS来展示的。后来百度没有收录,进行了PHP改版。外观是一样的。现在感觉这个PHP不是很规范。什么是百度非标收录?

A:酒店行业很多内容不是实时加载的,而是通过JS慢慢获取页面上的内容。如果搜索引擎捕捉到它,那就是导航,这就是问题所在。以前有很多空白页收录,质量很差。关于 Pattern 认为质量低的模式,内容可能是一样的,所以考虑换个目录。

【APPLINK问答】

Q:现在网站的APP已经准备好了,加入APPLINK会不会有什么大的变化?

A:H5网站和APP有对应关系吗?比如这里是100条H5站的内容,有100条APP的内容,应该是匹配的。关键是把网站放在行首,一定要调整好。

Q:目前APP引流是Android和IOS,但有一小部分是Windows Phone。这个APP需要多长时间?

A:分两点,我们来看看诺基亚的Windows平台战略。如果我们看到他的一些动作,我们一定会注意的。因为其实我们早期有一个关于APPLINK接入协议的协议。我们可以有WindowsPhone调用的机制。用户点击了一个结果,如果点击了结果,我们那里就有一个Android IE,它可以接受IE并将信息发回给用户。只要在前端实现一些信息,就可以做好。劳动量似乎不是很大,是可以实现的。除了WindowsPhone和手表,毕竟还可以调APP,大家可以看看。

Q:APP和网页版,很多APP都嵌入在H5网页中,里面只是一个外壳。百度做的AppLink,他点击后,从百度APP弹到糯米APP,然后弹走。他用百度搜索了很多数据。百度用户可以点击下一个网站。如果你把他推到糯米,我们后面的人就没有机会了。

A:其实APPLINK不是技术壁垒的问题,是努力的问题。对于大型网站,您可以自己做。对于APPLINK,未来可能会有各方面的调整。对于小站来说,如果小站连接起来,目前就有这个优势。因为小站访问也可以跳转到小站。

Q:加入APPLINK后,如果小站数据不够,会一下子弹出来吗?

A:当你回到你的站,至少进入你自己的生态。事实上,从搜索的角度来看,我们的目标是满足用户的需求。如果我们引导到网站,如果网站不能满足需求,用户自然会被转移。将用户引向你是网站满足用户需求的动力。我认为应该是这样的。

Q:如果整个页面有APPLINK,会有一个分发按钮。分配按钮的条件是什么?

A:没有条件,你把APP包给我们,我们给你分发。

Q:目前除了你的团队之外,还有几个百度内容的手机助手。有什么区别吗?

A:这是一个早期的尝试。我们都知道移动端和PC端已经合并了。作为一个整体,我们输出了一组解决方案。可能上半年我们把这件事推的很紧。当时我们也很困惑。那个时候整个生态合并之后,现在我们整体的输出是由APPLINK来做比较合理。移动助手不是搜索结果。输出可能在不同的产品线中,APPLINK 出现在搜索结果中。

Q:加入APPLINK对移动站平台有影响吗?

答:还没有。但他会有一个正常的点击。

Q:Android生态最麻烦的就是有时候不能调整。这种问题不调整,会不会指导下载操作?

A:一般有两种情况是不能调整的。一个是安装包,因为安卓或者IOS包还有一个版本问题。因为网上提交的版本是用户没有更新新版本,或者有可能出现用户安装了新版本,但又删除了,有时无法调整的情况。在这种情况下,将访问 H5 站。现在有监控系统。如果我们不能去H5站,我们会发现搜索流量异常,我们会修复它。最快的情况是处理问题反馈。 查看全部

抓取网页数据 php(百度统计追踪会不会影响SEO?A:用改版工具重新提交一下)

【SEO问答】

Q:使用百度统计进行广告跟踪时,配置的URL链接会很长。这种跟踪会影响搜索引擎优化吗?

A:这种有多个URL版本的统计代码肯定会对SEO产生影响。对于这种情况有两个建议,一个是使用两组url进行真正的蜘蛛抓取和用户展示。另一种选择是停止使用百度统计,你可以使用谷歌中的跟踪,他可以使用#链接,事件跟踪,并参考美团网。所有链接加上事件跟踪。如果是生成的,也是用#号生成的,不加额外的参数。

Q:如果一个页面一开始不符合百度的SEO标准,后来改成符合标准,百度需要多长时间才能提供好的结果?

A:不同的站点可能会贡献不同的流量。因此,Spider 爬行的侧重点不同。有些站可能会发现更多新链接,有些站可能会查看旧链接。建议推到百度上,像首页一样抓取一般是没有问题的。

Q:推送审核需要多长时间,一周还是半个月?

A:如果说推送符合抓取标准,可以立即抓取。

问:网站有两种 URL,旧的和新的。更换大约需要两年时间。现在旧 URL 将跳转到新 URL。由于服务器问题,网络中断了半个小时。搜索 关键词 后,旧的 url 出现了。现在基本上所有方法都无法恢复。在这种情况下我们应该怎么做?

A:使用修改工具重新提交,保证修改成功,不会有问题。如有问题,截图并报告给工程师排查。

Q:由于网站使用的是海外域名(暂时无法更改),有什么办法可以提高搜索量或爬取量?

A:百度搜索引擎都是在中国备案的,最好使用国内的服务器和域名。

Q:有些网站注册使用了很多域名,很多域名并不是供用户搜索的。现在这些域名都被注销了,但是还是可以找到的。我关了一次,但是没有用。我不知道如何处理这个?

A:如果不需要那些站?你可以把它们关掉。短时间关闭新域名可能会为用户调用旧域名。当这个域名被关闭时,我们不会为用户进行长期调用。这些东西也不会被发现。

Q:网站是母婴类网站,PC端搜索流量很差。想知道有没有办法?

A:与医疗、养生、保健、母婴等问题类似,百度对搜索结果的展示非常谨慎。百度只对优质的网站开放他们的展示可能性,网站很可能很长时间都得不到流量。如果网站在SEO方面没有大问题,可以检查一下内容是否在争抢一些热门词。建议整个网站的权重和流量达到一定规模后再做热词。如果一开始就这样做关键词,当网站名声不是很高的时候,就不会有流量了。在这种情况下,网站 可能会更好地找到他们自己的区分和相关词之一。

问:网站 从事教育行业。现在通过官网的认证是安全或权威的认证。认证后会有潜在的特殊待遇或无所谓。

A:比如认证方面,你是真的,还有一个是假的。从用户的认知来看,你就是官网。

问:关于数据化、软件和PDF和Word显示的问题,包括哪些类型和多少资源?应该和文章的内容一起发布,还是PDF和文章一样?也有矛盾。产品及操作希望用户下载后直接使用,不会对PDF、WORD产生一些压缩或工具处理。有些用户会被引导到 Word,无论他们是无意还是无意。我该怎么办?

A:百度搜索栏现在默认称为网页搜索。顾名思义,我们向用户展示了一个网页。后面的库还有一种文件格式。搜索结果都是供用户下载使用的,他们可以去学习和展示图书馆的内容。

Q:有没有渠道告诉搜索引擎我们的页面内容发生了变化,我们通常如何处理?一个老页面已经收录,排序了,过了一段时间他发起了新资源的添加和更改?

A:目前还没有这样的渠道。首先,Spider 会检查一些东西。他发现网站经常出现在这种情况下,他的相关检查流量会增加。如果你担心,你应该把他放在站点地图中。

Q:网站原本只是一个主页,一个APP下载。我们现在正在发布内容。过去,这些内容无法被抓取。现在,我们是否需要提交修订以将其发布到目录或子域中?

A:这个是放在域名下的,一个子目录用来放分类的东西,没有修改。改首页,改版就没有其他问题了。使用主动推送工具的效果还是很明显的。如果内容质量非常好,您可以使用所有配额。

Q:自动推送份额多久调整一次?因为我觉得你的份额对于我们几千万或几百万的海量数据来说太小了。

A:我们也很关心一个网站有没有这种爆发力,突然增加这么多,我们觉得很不正常。你要循序渐进,不要又短又快,一夜之间吃成胖子。第二,你有这么多优秀的数据,你可以关注百度的另一个平台,你就变成了一个API,让别人使用你的数据。其他人为您的数据使用付费,您可以注意这一点。

Q:URL的绝对路径和相对路径是否会受到超链接的影响?修改后我们的页面有翻页,翻页链接是12345,上面有标签。每次抓到12345都抓不到。模拟抓,感觉抓不到。Spider会抓取页面上的A标签吗?

A:影响不大,能正常访问就可以了。不管是绝对路径还是相对路径,只要地址为Spider或者用户畅通无阻,并且页面渲染时地址完整,这条路径就可以顺利爬取。

对于not收录的问题,可以参考其他的点,比如页面本身没有被访问或者目录级别比较高。页面首页推送的链接会被百度一层一层抓到。如果路径正常,会从首页爬取Spider路径。

首先要做的是查看不是收录的链接日志是否已经被捕获。如果它被捕获而不是 收录,则可能是页面本身的问题。你也可以看一个周期,因为我们用一天。二是看日志中是否有长尾,是否隐藏或没有有效抓取或建关时推荐。如果你能看到日志,你可以看看日志来分析它。

可以调整首页的变化,提出建议,做个测试看看是链接问题还是蜘蛛没有抓到的问题。还有push等方法可以解决,从而判断不收录是什么原因。学院有一个解决许多问题的文件,类似于流程图。当这个戒指出现时,为什么?如果够长,可以看看下面的树枝。

Q:站点之前,所有的框架都是通过JS来展示的。后来百度没有收录,进行了PHP改版。外观是一样的。现在感觉这个PHP不是很规范。什么是百度非标收录?

A:酒店行业很多内容不是实时加载的,而是通过JS慢慢获取页面上的内容。如果搜索引擎捕捉到它,那就是导航,这就是问题所在。以前有很多空白页收录,质量很差。关于 Pattern 认为质量低的模式,内容可能是一样的,所以考虑换个目录。

【APPLINK问答】

Q:现在网站的APP已经准备好了,加入APPLINK会不会有什么大的变化?

A:H5网站和APP有对应关系吗?比如这里是100条H5站的内容,有100条APP的内容,应该是匹配的。关键是把网站放在行首,一定要调整好。

Q:目前APP引流是Android和IOS,但有一小部分是Windows Phone。这个APP需要多长时间?

A:分两点,我们来看看诺基亚的Windows平台战略。如果我们看到他的一些动作,我们一定会注意的。因为其实我们早期有一个关于APPLINK接入协议的协议。我们可以有WindowsPhone调用的机制。用户点击了一个结果,如果点击了结果,我们那里就有一个Android IE,它可以接受IE并将信息发回给用户。只要在前端实现一些信息,就可以做好。劳动量似乎不是很大,是可以实现的。除了WindowsPhone和手表,毕竟还可以调APP,大家可以看看。

Q:APP和网页版,很多APP都嵌入在H5网页中,里面只是一个外壳。百度做的AppLink,他点击后,从百度APP弹到糯米APP,然后弹走。他用百度搜索了很多数据。百度用户可以点击下一个网站。如果你把他推到糯米,我们后面的人就没有机会了。

A:其实APPLINK不是技术壁垒的问题,是努力的问题。对于大型网站,您可以自己做。对于APPLINK,未来可能会有各方面的调整。对于小站来说,如果小站连接起来,目前就有这个优势。因为小站访问也可以跳转到小站。

Q:加入APPLINK后,如果小站数据不够,会一下子弹出来吗?

A:当你回到你的站,至少进入你自己的生态。事实上,从搜索的角度来看,我们的目标是满足用户的需求。如果我们引导到网站,如果网站不能满足需求,用户自然会被转移。将用户引向你是网站满足用户需求的动力。我认为应该是这样的。

Q:如果整个页面有APPLINK,会有一个分发按钮。分配按钮的条件是什么?

A:没有条件,你把APP包给我们,我们给你分发。

Q:目前除了你的团队之外,还有几个百度内容的手机助手。有什么区别吗?

A:这是一个早期的尝试。我们都知道移动端和PC端已经合并了。作为一个整体,我们输出了一组解决方案。可能上半年我们把这件事推的很紧。当时我们也很困惑。那个时候整个生态合并之后,现在我们整体的输出是由APPLINK来做比较合理。移动助手不是搜索结果。输出可能在不同的产品线中,APPLINK 出现在搜索结果中。

Q:加入APPLINK对移动站平台有影响吗?

答:还没有。但他会有一个正常的点击。

Q:Android生态最麻烦的就是有时候不能调整。这种问题不调整,会不会指导下载操作?

A:一般有两种情况是不能调整的。一个是安装包,因为安卓或者IOS包还有一个版本问题。因为网上提交的版本是用户没有更新新版本,或者有可能出现用户安装了新版本,但又删除了,有时无法调整的情况。在这种情况下,将访问 H5 站。现在有监控系统。如果我们不能去H5站,我们会发现搜索流量异常,我们会修复它。最快的情况是处理问题反馈。

抓取网页数据 php( 如何使用浏览器渲染方法将爬取动态网页变成爬取静态网页)

网站优化 • 优采云 发表了文章 • 0 个评论 • 56 次浏览 • 2022-02-15 12:17

如何使用浏览器渲染方法将爬取动态网页变成爬取静态网页)

此时,可以确定评论区的位置:

...

其实这就是所谓的网页分析。通过检查元素,可以确定要提取的内容的位置,然后可以通过标签id、name、class或者其他属性来提取内容!

继续阅读:

这收录一个列表,评论就在其中。这时候我们可以在网页上右键查看网页的源代码,然后Ctrl+F,输入“comment-list-box”找到这部分:

我们会发现源代码里什么都没有!这个时候,你明白了吗?

而如果我们要提取这部分动态内容,仅靠上一篇文章中的方法是不可能做到的。除非我们能够分析动态网页的url,否则如何简单高效地抓取动态网页内容呢?这里需要用到动态网页抓取神器:Selenium

Selenium其实是一个web自动化测试工具,可以模拟用户滑动、点击、打开、验证等一系列网页操作,就像真实用户在操作一样!这样,就可以使用浏览器渲染的方式将动态网页抓取成抓取静态网页了!

安装硒: pip install selenium

安装成功后,简单测试:

from selenium import webdriver

# 用selenium打开网页

driver = webdriver.Chrome()

driver.get("https://www.baidu.com")

错误:

WebDriverException(mon.exceptions.WebDriverException:消息:“chromedriver”可执行文件需要在 PATH 中。请参阅

这其实是缺少谷歌浏览器驱动:chromedriver,下载后放在某个盘符下并记录位置,修改代码再次执行:

driver = webdriver.Chrome(executable_path=r"C:\\chromedriver.exe")

driver.get("https://www.baidu.com")

笔者这里使用的是FireFox浏览器,效果是一样的,当然需要下载Firefox浏览器驱动:geckodriver

driver = webdriver.Firefox(executable_path=r"C:\\geckodriver.exe")

driver.get("https://www.baidu.com")

成功打开后会显示浏览器已被控制!

我们可以在 PyCharm 中查看 webdriver 提供的方法:

当提取的内容嵌套在frame中时,我们可以通过driver.switch_to.frame来定位。简单地说,我们可以使用

Driver.find_element_by_css_selector、find_element_by_tag_name等提取内容。带复数s的方法提取列表,不带s的方法提取单个数据。这很容易理解。详细使用方法可以查看官方文档!

还是以csdn博客为例:Python入门(一)环境搭建,爬取这个文章的评论,我们已经分析了评论所在的区域:

...

:

然后我们就可以直接通过find_element_by_css_selector获取div下的内容了:

from selenium import webdriver

driver = webdriver.Firefox(executable_path=r"C:\\geckodriver.exe")

driver.get("https://baiyuliang.blog.csdn.n ... 6quot;)

comment_list_box = driver.find_element_by_css_selector('div.comment-list-box')

comment_list = comment_list_box.find_element_by_class_name('comment-list')

comment_line_box = comment_list.find_elements_by_class_name('comment-line-box')

for comment in comment_line_box:

span_text = comment.find_element_by_class_name('new-comment').text

print(span_text)

结果:

注意 find_element_by_css_selector 和 find_element_by_class_name 在用法上的区别! 查看全部

抓取网页数据 php(

如何使用浏览器渲染方法将爬取动态网页变成爬取静态网页)

此时,可以确定评论区的位置:

...

其实这就是所谓的网页分析。通过检查元素,可以确定要提取的内容的位置,然后可以通过标签id、name、class或者其他属性来提取内容!

继续阅读:

这收录一个列表,评论就在其中。这时候我们可以在网页上右键查看网页的源代码,然后Ctrl+F,输入“comment-list-box”找到这部分:

我们会发现源代码里什么都没有!这个时候,你明白了吗?

而如果我们要提取这部分动态内容,仅靠上一篇文章中的方法是不可能做到的。除非我们能够分析动态网页的url,否则如何简单高效地抓取动态网页内容呢?这里需要用到动态网页抓取神器:Selenium

Selenium其实是一个web自动化测试工具,可以模拟用户滑动、点击、打开、验证等一系列网页操作,就像真实用户在操作一样!这样,就可以使用浏览器渲染的方式将动态网页抓取成抓取静态网页了!

安装硒: pip install selenium

安装成功后,简单测试:

from selenium import webdriver

# 用selenium打开网页

driver = webdriver.Chrome()

driver.get("https://www.baidu.com";)

错误:

WebDriverException(mon.exceptions.WebDriverException:消息:“chromedriver”可执行文件需要在 PATH 中。请参阅

这其实是缺少谷歌浏览器驱动:chromedriver,下载后放在某个盘符下并记录位置,修改代码再次执行:

driver = webdriver.Chrome(executable_path=r"C:\\chromedriver.exe")

driver.get("https://www.baidu.com";)

笔者这里使用的是FireFox浏览器,效果是一样的,当然需要下载Firefox浏览器驱动:geckodriver

driver = webdriver.Firefox(executable_path=r"C:\\geckodriver.exe")

driver.get("https://www.baidu.com";)

成功打开后会显示浏览器已被控制!

我们可以在 PyCharm 中查看 webdriver 提供的方法:

当提取的内容嵌套在frame中时,我们可以通过driver.switch_to.frame来定位。简单地说,我们可以使用

Driver.find_element_by_css_selector、find_element_by_tag_name等提取内容。带复数s的方法提取列表,不带s的方法提取单个数据。这很容易理解。详细使用方法可以查看官方文档!

还是以csdn博客为例:Python入门(一)环境搭建,爬取这个文章的评论,我们已经分析了评论所在的区域:

...

:

然后我们就可以直接通过find_element_by_css_selector获取div下的内容了:

from selenium import webdriver

driver = webdriver.Firefox(executable_path=r"C:\\geckodriver.exe")

driver.get("https://baiyuliang.blog.csdn.n ... 6quot;)

comment_list_box = driver.find_element_by_css_selector('div.comment-list-box')

comment_list = comment_list_box.find_element_by_class_name('comment-list')

comment_line_box = comment_list.find_elements_by_class_name('comment-line-box')

for comment in comment_line_box:

span_text = comment.find_element_by_class_name('new-comment').text

print(span_text)

结果:

注意 find_element_by_css_selector 和 find_element_by_class_name 在用法上的区别!

抓取网页数据 php(抓取网页数据php-view-scrapy从html里提取到对应的入口地址)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2022-02-13 08:02

抓取网页数据php-view-scrapy从html里提取想要的元素,例如提取一个男性的信息。程序有3个入口,/、/ci、/post;/ci:使用ci这个脚本接收一个唯一的id做为uuid,/uuid可以通过别名和key来进行引用,/uuid引用的是客户端提供的uuid来达到你想要的到你要的key-value数据提取。

/ci:/bin/ci通过脚本连接上网站服务器(例如localhost),然后通过/ci向服务器发出post请求,服务器对/ci返回的内容作为参数传入到post去执行真正的/uuid+post请求。/uuid+post请求即按照post里面的内容去匹配到/bin/ci对应的入口地址,post里面匹配到对应的入口之后,经过数据校验来发出数据抓取的请求。

例如发送的是useragent="mozilla/5.0(windowsnt10.0;win64;x64;rv:56.。

0)gecko/20100101firefox/56。0"#1gecko/20100101;extract_execute("dom",newvalidator("user-agent"))link_index_url=";add_appid=3a2007e9f38362f26173525&agent="。get(link_index_url)。

#1.json(es)#es.json('post',formatter(attributes={'user_agent':'mozilla/5.0(windowsnt10.0;win64;x64;rv:57.

0)gecko/20100101firefox/57.0'}))'''json()post数据获取完整代码'''__doc__.post({user_agent:'mozilla/5.0(windowsnt10.0;win64;x64;rv:56.

0)gecko/20100101firefox/57.0'}) 查看全部

抓取网页数据 php(抓取网页数据php-view-scrapy从html里提取到对应的入口地址)

抓取网页数据php-view-scrapy从html里提取想要的元素,例如提取一个男性的信息。程序有3个入口,/、/ci、/post;/ci:使用ci这个脚本接收一个唯一的id做为uuid,/uuid可以通过别名和key来进行引用,/uuid引用的是客户端提供的uuid来达到你想要的到你要的key-value数据提取。

/ci:/bin/ci通过脚本连接上网站服务器(例如localhost),然后通过/ci向服务器发出post请求,服务器对/ci返回的内容作为参数传入到post去执行真正的/uuid+post请求。/uuid+post请求即按照post里面的内容去匹配到/bin/ci对应的入口地址,post里面匹配到对应的入口之后,经过数据校验来发出数据抓取的请求。

例如发送的是useragent="mozilla/5.0(windowsnt10.0;win64;x64;rv:56.。

0)gecko/20100101firefox/56。0"#1gecko/20100101;extract_execute("dom",newvalidator("user-agent"))link_index_url=";add_appid=3a2007e9f38362f26173525&agent="。get(link_index_url)。

#1.json(es)#es.json('post',formatter(attributes={'user_agent':'mozilla/5.0(windowsnt10.0;win64;x64;rv:57.

0)gecko/20100101firefox/57.0'}))'''json()post数据获取完整代码'''__doc__.post({user_agent:'mozilla/5.0(windowsnt10.0;win64;x64;rv:56.

0)gecko/20100101firefox/57.0'})

抓取网页数据 php(新站(网站)如何快速被搜索引擎收录的三大搜索引擎教)

网站优化 • 优采云 发表了文章 • 0 个评论 • 45 次浏览 • 2022-02-13 04:21

其实,关于新站点(网站)如何被搜索引擎收录快速搜索到的方法已经贴了很多,但一般都是百度,而且大部分情况下,网站即使他们不提交任何指向搜索引擎的链接,搜索引擎也会收录网页,因为搜索引擎依靠“蜘蛛”爬取互联网获取网站素材(多媒体图文等材料),而我们的网站就是生活在互联网上。你有我,我有你,真是太好了。相信大部分朋友都不会屏蔽“蜘蛛”,除了你认识的那种网站。. .

既然大家都想被收录,或者“蜘蛛”发现,那我们就以三大知名搜索引擎为例。

1:百度

链接提交:提交的链接不一定是 收录 的!收录 很大程度上无法识别它。个人建议做前奏工作,验证百度站长权限+添加百度统计,然后点击提交。如果你提交后24小时内还不是收录,你可以去站长平台再次抓诊,这会给你带来“蜘蛛”网站,当然这是小编的理解,会增加收录的概率。

2:很好的搜索

提交链接:好搜网站收录提交需要网站已经归档,但是大部分小伙伴可能无法归档,会觉得归档麻烦什么的。由于提交不可行,也可以先加入360站长平台,验证站长权限,然后推荐使用360安全检测,链接:,我个人认为这个效果和百度统计差不多,和比百度统计更容易改进网站收录。

3:搜狗

链接提交:搜狗收录其实难度更大,但是收录一旦上榜,效果非常好。毕竟搜狗已经掌握了QQ的入口,流量也是可观的。如果你提交链接没有得到回复,回复也可能很抱歉,没有收录你的网站,所以跟上节奏,验证搜狗站长平台,多用工具站长平台。提交链接。

以上就是必须要做的事情,接下来就是如何让这个更完美了。无论是收录、SEO还是排名,无非就是外链+外链+外链。总之,你需要做更多的外链,SEO需要更多的外链,排名需要更多的外链,当然收录也需要外链。外部链接有好有坏。好的会提高收录的速度,提高网站的排名,坏的会降低网站的排名。

如何做好外链?

那些站长工具都是很好的外部链接。另外,最好的外链是搜索引擎带来的产品。百度有百度知道、百度百科、百度贴吧等。好的搜索百科,搜狗有吗?搜狗没有?怎么可能,搜狗问过,搜搜和搜狗合并了,腾讯的下属都能做到,搜狗百科也有很多。简单来说,post,ask等等,多做外链,你懂的,好的外链里也有各种新闻来源。新闻来源网站发布的帖子的含金量与搜索引擎自己的产品相当。还有网站类网站,可以投稿,各种网站论坛,随便你水,天涯,豆瓣,什么高权重网站,

那么你如何发布并带上你自己的 网站 呢?

首先,不能太明显。发帖的时候可以转载一些感慨的文章啊什么的,七姨八姨吵架的最好消息是什么,等等。加你自己的网站,转载什么都可以,切记不要太广告。无论如何,你可以做到。

嗯,就是这样。当然还有很多细节没说,以后会积极补充。 查看全部

抓取网页数据 php(新站(网站)如何快速被搜索引擎收录的三大搜索引擎教)

其实,关于新站点(网站)如何被搜索引擎收录快速搜索到的方法已经贴了很多,但一般都是百度,而且大部分情况下,网站即使他们不提交任何指向搜索引擎的链接,搜索引擎也会收录网页,因为搜索引擎依靠“蜘蛛”爬取互联网获取网站素材(多媒体图文等材料),而我们的网站就是生活在互联网上。你有我,我有你,真是太好了。相信大部分朋友都不会屏蔽“蜘蛛”,除了你认识的那种网站。. .

既然大家都想被收录,或者“蜘蛛”发现,那我们就以三大知名搜索引擎为例。

1:百度

链接提交:提交的链接不一定是 收录 的!收录 很大程度上无法识别它。个人建议做前奏工作,验证百度站长权限+添加百度统计,然后点击提交。如果你提交后24小时内还不是收录,你可以去站长平台再次抓诊,这会给你带来“蜘蛛”网站,当然这是小编的理解,会增加收录的概率。

2:很好的搜索

提交链接:好搜网站收录提交需要网站已经归档,但是大部分小伙伴可能无法归档,会觉得归档麻烦什么的。由于提交不可行,也可以先加入360站长平台,验证站长权限,然后推荐使用360安全检测,链接:,我个人认为这个效果和百度统计差不多,和比百度统计更容易改进网站收录。

3:搜狗

链接提交:搜狗收录其实难度更大,但是收录一旦上榜,效果非常好。毕竟搜狗已经掌握了QQ的入口,流量也是可观的。如果你提交链接没有得到回复,回复也可能很抱歉,没有收录你的网站,所以跟上节奏,验证搜狗站长平台,多用工具站长平台。提交链接。

以上就是必须要做的事情,接下来就是如何让这个更完美了。无论是收录、SEO还是排名,无非就是外链+外链+外链。总之,你需要做更多的外链,SEO需要更多的外链,排名需要更多的外链,当然收录也需要外链。外部链接有好有坏。好的会提高收录的速度,提高网站的排名,坏的会降低网站的排名。

如何做好外链?

那些站长工具都是很好的外部链接。另外,最好的外链是搜索引擎带来的产品。百度有百度知道、百度百科、百度贴吧等。好的搜索百科,搜狗有吗?搜狗没有?怎么可能,搜狗问过,搜搜和搜狗合并了,腾讯的下属都能做到,搜狗百科也有很多。简单来说,post,ask等等,多做外链,你懂的,好的外链里也有各种新闻来源。新闻来源网站发布的帖子的含金量与搜索引擎自己的产品相当。还有网站类网站,可以投稿,各种网站论坛,随便你水,天涯,豆瓣,什么高权重网站,

那么你如何发布并带上你自己的 网站 呢?

首先,不能太明显。发帖的时候可以转载一些感慨的文章啊什么的,七姨八姨吵架的最好消息是什么,等等。加你自己的网站,转载什么都可以,切记不要太广告。无论如何,你可以做到。

嗯,就是这样。当然还有很多细节没说,以后会积极补充。

抓取网页数据 php(通用爬虫框架如下图:通用的爬虫框架通用框架流程)

网站优化 • 优采云 发表了文章 • 0 个评论 • 318 次浏览 • 2022-02-10 23:12

2. 搜索引擎爬虫架构

但是浏览器是用户主动操作然后完成HTTP请求,而爬虫需要自动完成HTTP请求,而网络爬虫需要一个整体架构来完成工作。

虽然爬虫技术经过几十年的发展,在整体框架上已经比较成熟,但随着互联网的不断发展,也面临着一些具有挑战性的新问题。一般爬虫框架如下:

通用爬虫框架

常用爬虫框架流程:

1)首先从互联网页面中仔细挑选部分网页,将这些网页的链接地址作为种子URL;

2) 将这些种子网址放入待抓取的网址队列中;

3)爬虫依次读取要爬取的URL,通过DNS解析URL,将链接地址转换为网站服务器对应的IP地址。

4)然后将网页的IP地址和相对路径名交给网页下载器,

5)网页下载器负责页面内容的下载。

6)对于下载到本地的网页,一方面存储在页库中,等待索引等后续处理;另一方面,将下载的网页的URL放入已爬取的URL队列中,该队列记录爬虫系统已经下载的网页的URL,避免网页的重复爬取。

7)对于刚刚下载的网页,提取其中收录的所有链接信息,并在抓取的URL队列中进行检查。如果发现链接没有被爬取,就把这个URL放到待爬取URL队bad!

8、在9)结束时,会在后续的爬取调度中下载该URL对应的网页,以此类推,形成循环,直到待爬取的URL队列为空。

3. 爬虫策略

在爬虫系统中,待爬取的 URL 队列是一个重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。

3.1 深度优先搜索策略(循序渐进)

即图的深度优先遍历算法。网络爬虫会从起始页开始,逐个跟踪每个链接,处理完这一行后,会移动到下一个起始页,继续跟踪链接。

我们用图表来说明:

我们假设互联网是一个有向图,图中的每个顶点代表一个网页。假设初始状态是图中的所有顶点都没有被访问过,那么深度优先搜索可以从图中的某个顶点开始,访问这个顶点,然后从v的未访问的相邻点开始依次遍历深度优先的图形,直到到达图形。图中所有与 v 相连的路径的顶点都已被访问过;如果此时图中存在未访问过的顶点,则选择图中另一个未访问过的顶点作为起点,重复上述过程,直到到目前为止图中所有顶点都被访问过。

以下图中的无向图 G1 为例,对图进行深度优先搜索:

G1

搜索过程:

假设search fetch从顶点页面v1开始,访问页面v1后,选择邻接页面v2。由于 v2 没有被访问过,所以从 v2 开始搜索。以此类推,然后从v4、v8、v5开始搜索。访问 v5 后,由于 v5 的所有邻居都已访问,因此搜索回到 v8。出于同样的原因,搜索继续返回到 v4、v2 直到 v1。此时,由于v1的另一个相邻点没有被访问,所以搜索从v1到v3,然后继续。因此,得到的顶点访问序列为:

3.2 广度优先搜索策略

广度优先遍历的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网络过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,会下载和过滤大量不相关的网页,算法的效率会变低。

以上图为例,抓取过程如下:

广度搜索过程:

首先访问页面v1和v1的相邻点v2和v3,然后依次访问v2的相邻点v4和v5以及v3的相邻点v6和v7,最后访问v4的相邻点v8。由于这些顶点的邻接都被访问过,并且图中的所有顶点都被访问过,图的遍历就由这些完成了。得到的顶点访问序列是:

v1→v2→v3→v4→v5→v6→v7→v8

与深度优先搜索类似,在遍历过程中也需要一个访问标志数组。并且,为了顺序访问路径长度为2、3、...的顶点,需要附加一个队列来存储路径长度为1、2、的访问顶点……

3.2 最佳优先搜索策略

最佳优先级搜索策略是根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。

3.3.反向链接计数策略

反向链接数是指从其他网页指向一个网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

3.4.部分PageRank策略,最佳优先搜索策略

Partial PageRank算法借鉴了PageRank算法的思想:根据一定的网页分析算法,预测候选URL与目标网页的相似度,或者与主题的相关性,选择一个或多个URL用最佳评价来爬取,即对于下载的网页,与待爬取的URL队列中的URL一起形成一组网页,计算每个页面的PageRank值。按该顺序抓取页面。

它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。研究表明,这样的闭环调整可以将不相关页面的数量减少 30% 到 90%。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值:将这个网页所有传入链接传入的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排序。

3.5.OPIC 政策方针

该算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

3. 6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

4. Web 更新策略

互联网实时变化并且非常动态。网页更新策略主要决定何时更新之前已经下载的页面。常见的更新策略有以下三种:

**1.历史参考政策**

顾名思义,它根据页面过去的历史更新数据来预测未来页面何时会发生变化。通常,预测是通过泊松过程建模来进行的。

2.用户体验策略

尽管搜索引擎可以为某个查询返回大量结果,但用户通常只关注结果的前几页。因此,爬虫系统可以优先更新那些实际在查询结果前几页的页面,然后再更新后面的那些页面。这个更新策略也需要用到历史信息。UX 策略保留网页的多个历史版本,并根据每个过去内容更改对搜索质量的影响得出一个平均值,并以此值作为决定何时重新抓取的基础。3.聚类采样策略 上面提到的两种更新策略有一个前提:需要网页的历史信息。这种方式存在两个问题:第一,如果系统为每个系统保存了多个版本的历史信息,无疑会增加很多系统负担;第二,如果新网页完全没有历史信息,就无法确定更新策略。

该策略认为网页具有许多属性,具有相似属性的网页可以认为具有相似的更新频率。计算某一类别网页的更新频率,只需对该类别的网页进行采样,并将其更新周期作为整个类别的更新周期。基本思路如下:

5. 云存储文档

应用知识:

1. GFS,使用GFS分布式文件系统存储海量文档。

2. BitTable,在GFS的基础上构建BitTable数据模型;

3、MegaStore的存储模型是基于BitTable的存储计算模型。

4. Map/Reduce云计算模型和系统计算框架。

4.1 BitTable 存储原创网页信息

逻辑模型如图4-1所示,示例 crawldb 表用于存储爬虫爬取的网页信息,

其中:Row Key是网页的URL。为了排序效率,URL中的主机域名的字符序列经常颠倒,例如处理为com.xxx.www;

Column Family包括title、content和anchor,其中tile保存网页的标题,content保存网页的html内容,anchor保存其他网页引用的网页的链接,qualifier是其他网页的URL网页,内容为链接页面在其他网页中的显示字符,相同锚链接的URL主机域字符串取反。在不同时间获取的同一个网页的相关内容,用不同的时间戳时间戳标记,如图纵坐标所示,可以看到不同的版本。

图 4-1 Crawldb Table 逻辑模型

在实际存储中,图 4-1 所示的多维逻辑结构会被二维扁平化为 (Key, Value) 对并排序。在(Key, Value)中,Key由四维键值组成,包括:Row Key、ColumnFamily(使用8位编码进行处理)、Column Qualifier和Timestamp,如图4-2所示,即Key的实际结构,在对key进行排序的过程中,Timestamp最新的key会排在最前面,flag项用来指示系统需要对(Key, Value)记录执行的算子,比如如添加、删除和更新。

图4-2 关键结构图

图 4-3 展示了 crawldb 经过二维平面化后的排序格式。图中Key列中的信息由Row Key(页面URL)、Column Family、Column Qualifer和Timestamp组成。Key标志项不显示,标志项主要用于表项处理。

图4-3 crawldb表的key/value列表

图 4-4 显示了 crawldb 表的 CellStore 文件格式。排序后的 Key 和 Value 对存储在 CellStore 文件中。在物理上,这些数据被压缩和存储,并被组织成大约 64k 的块;在文件末尾,保留了三个索引部分:Bloom Filter、Block Index(行键+文件内的块偏移)、Trailer。

4.2Map/Reduce计算模型处理网页信息:网页去重和倒排索引的生成

我们使用简单的策略对网页进行重复数据删除。目标是在网页集合中找到所有具有相同内容的网页,并采用对网页内容进行哈希处理的方法,例如MD5。如果两个网页的MD5值相同,则可以认为两个网页内容相同。内容完全一样。在Map/Reduce框架中,输入数据就是网页本身,网页的URL可以作为输入数据的key,网页的内容就是输入数据的值;Map操作使用MD5计算每个网页内容的hash值,使用这个hash值作为中间数据的key,网页的URL作为中间数据的值:Reduce操作为同一个key的中间数据对应的URL建立链表结构。哪些页面。这样就完成了识别具有相同内容的网页的任务。

对于建立倒排索引的任务,如图4-6所示,输入数据也是一个网页,网页的DOCID作为输入数据的Key,出现在web page是输入数据的Value;Map操作会将输入的数据转换为(word, DOCID)的形式,即以一个word为key,以DOCID为中间数据的value。每个词对应的网页ID列表: . 这是单词word对应的倒排列表。这样就可以建立一个简单的倒排索引,并在Reduce阶段进行一些复杂的操作,得到更复杂的倒排索引。

图 4-6

参考:

《这就是搜索引擎:核心技术详解》

《搜索引擎——信息检索实践》 查看全部

抓取网页数据 php(通用爬虫框架如下图:通用的爬虫框架通用框架流程)

2. 搜索引擎爬虫架构

但是浏览器是用户主动操作然后完成HTTP请求,而爬虫需要自动完成HTTP请求,而网络爬虫需要一个整体架构来完成工作。

虽然爬虫技术经过几十年的发展,在整体框架上已经比较成熟,但随着互联网的不断发展,也面临着一些具有挑战性的新问题。一般爬虫框架如下:

通用爬虫框架

常用爬虫框架流程:

1)首先从互联网页面中仔细挑选部分网页,将这些网页的链接地址作为种子URL;

2) 将这些种子网址放入待抓取的网址队列中;

3)爬虫依次读取要爬取的URL,通过DNS解析URL,将链接地址转换为网站服务器对应的IP地址。

4)然后将网页的IP地址和相对路径名交给网页下载器,

5)网页下载器负责页面内容的下载。

6)对于下载到本地的网页,一方面存储在页库中,等待索引等后续处理;另一方面,将下载的网页的URL放入已爬取的URL队列中,该队列记录爬虫系统已经下载的网页的URL,避免网页的重复爬取。

7)对于刚刚下载的网页,提取其中收录的所有链接信息,并在抓取的URL队列中进行检查。如果发现链接没有被爬取,就把这个URL放到待爬取URL队bad!

8、在9)结束时,会在后续的爬取调度中下载该URL对应的网页,以此类推,形成循环,直到待爬取的URL队列为空。

3. 爬虫策略

在爬虫系统中,待爬取的 URL 队列是一个重要的部分。待爬取的URL队列中的URL的排列顺序也是一个重要的问题,因为它涉及到先爬到哪个页面,再爬到哪个页面。确定这些 URL 排列顺序的方法称为爬取策略。

3.1 深度优先搜索策略(循序渐进)

即图的深度优先遍历算法。网络爬虫会从起始页开始,逐个跟踪每个链接,处理完这一行后,会移动到下一个起始页,继续跟踪链接。

我们用图表来说明:

我们假设互联网是一个有向图,图中的每个顶点代表一个网页。假设初始状态是图中的所有顶点都没有被访问过,那么深度优先搜索可以从图中的某个顶点开始,访问这个顶点,然后从v的未访问的相邻点开始依次遍历深度优先的图形,直到到达图形。图中所有与 v 相连的路径的顶点都已被访问过;如果此时图中存在未访问过的顶点,则选择图中另一个未访问过的顶点作为起点,重复上述过程,直到到目前为止图中所有顶点都被访问过。

以下图中的无向图 G1 为例,对图进行深度优先搜索:

G1

搜索过程:

假设search fetch从顶点页面v1开始,访问页面v1后,选择邻接页面v2。由于 v2 没有被访问过,所以从 v2 开始搜索。以此类推,然后从v4、v8、v5开始搜索。访问 v5 后,由于 v5 的所有邻居都已访问,因此搜索回到 v8。出于同样的原因,搜索继续返回到 v4、v2 直到 v1。此时,由于v1的另一个相邻点没有被访问,所以搜索从v1到v3,然后继续。因此,得到的顶点访问序列为:

3.2 广度优先搜索策略

广度优先遍历的基本思想是将新下载的网页中找到的链接直接插入待爬取URL队列的末尾。也就是说,网络爬虫会先爬取起始网页链接的所有网页,然后选择其中一个链接的网页,继续爬取该网页链接的所有网页。该算法的设计和实现比较简单。目前,为了覆盖尽可能多的网页,一般采用广度优先搜索方式。也有许多研究将广度优先搜索策略应用于聚焦爬虫。其基本思想是距初始 URL 一定链接距离内的网页具有较高的主题相关性概率。另一种方法是将广度优先搜索与网络过滤技术相结合,首先使用广度优先策略抓取网页,然后过滤掉不相关的页面。这些方法的缺点是随着爬取的网页数量的增加,会下载和过滤大量不相关的网页,算法的效率会变低。

以上图为例,抓取过程如下:

广度搜索过程:

首先访问页面v1和v1的相邻点v2和v3,然后依次访问v2的相邻点v4和v5以及v3的相邻点v6和v7,最后访问v4的相邻点v8。由于这些顶点的邻接都被访问过,并且图中的所有顶点都被访问过,图的遍历就由这些完成了。得到的顶点访问序列是:

v1→v2→v3→v4→v5→v6→v7→v8

与深度优先搜索类似,在遍历过程中也需要一个访问标志数组。并且,为了顺序访问路径长度为2、3、...的顶点,需要附加一个队列来存储路径长度为1、2、的访问顶点……

3.2 最佳优先搜索策略

最佳优先级搜索策略是根据一定的网页分析算法预测候选URL与目标网页的相似度,或与主题的相关度,选择评价最好的一个或几个URL进行爬取。

3.3.反向链接计数策略

反向链接数是指从其他网页指向一个网页的链接数。反向链接的数量表示网页内容被他人推荐的程度。因此,在很多情况下,搜索引擎的爬取系统会使用这个指标来评估网页的重要性,从而确定不同网页的爬取顺序。

在真实的网络环境中,由于广告链接和作弊链接的存在,反向链接的数量并不能完全等同于他人的重要性。因此,搜索引擎倾向于考虑一些可靠的反向链接计数。

3.4.部分PageRank策略,最佳优先搜索策略

Partial PageRank算法借鉴了PageRank算法的思想:根据一定的网页分析算法,预测候选URL与目标网页的相似度,或者与主题的相关性,选择一个或多个URL用最佳评价来爬取,即对于下载的网页,与待爬取的URL队列中的URL一起形成一组网页,计算每个页面的PageRank值。按该顺序抓取页面。

它只访问页面分析算法预测为“有用”的页面。一个问题是爬虫爬取路径上的许多相关网页可能会被忽略,因为最佳优先策略是局部最优搜索算法。因此,需要将最佳优先级与具体应用结合起来进行改进,从而跳出局部最优点。研究表明,这样的闭环调整可以将不相关页面的数量减少 30% 到 90%。

如果每次爬取一个页面都重新计算一次PageRank值,折中的解决方案是:每爬完K个页面,重新计算一次PageRank值。但是这种情况还是有一个问题:对于下载页面中分析的链接,也就是我们前面提到的那部分未知网页,暂时没有PageRank值。为了解决这个问题,会给这些页面一个临时的PageRank值:将这个网页所有传入链接传入的PageRank值聚合起来,从而形成未知页面的PageRank值,从而参与排序。

3.5.OPIC 政策方针

该算法实际上为页面分配了一个重要性分数。在算法开始之前,所有页面都会获得相同的初始现金。当某个页面P被下载时,P的现金分配给从P分析的所有链接,P的现金被清空。根据现金数量对待爬取URL队列中的所有页面进行排序。

3. 6.大网站优先策略

所有待爬取的URL队列中的网页都按照它们所属的网站进行分类。网站需要下载的页面较多,请先下载。这种策略也称为大站点优先策略。

4. Web 更新策略

互联网实时变化并且非常动态。网页更新策略主要决定何时更新之前已经下载的页面。常见的更新策略有以下三种:

**1.历史参考政策**

顾名思义,它根据页面过去的历史更新数据来预测未来页面何时会发生变化。通常,预测是通过泊松过程建模来进行的。

2.用户体验策略

尽管搜索引擎可以为某个查询返回大量结果,但用户通常只关注结果的前几页。因此,爬虫系统可以优先更新那些实际在查询结果前几页的页面,然后再更新后面的那些页面。这个更新策略也需要用到历史信息。UX 策略保留网页的多个历史版本,并根据每个过去内容更改对搜索质量的影响得出一个平均值,并以此值作为决定何时重新抓取的基础。3.聚类采样策略 上面提到的两种更新策略有一个前提:需要网页的历史信息。这种方式存在两个问题:第一,如果系统为每个系统保存了多个版本的历史信息,无疑会增加很多系统负担;第二,如果新网页完全没有历史信息,就无法确定更新策略。

该策略认为网页具有许多属性,具有相似属性的网页可以认为具有相似的更新频率。计算某一类别网页的更新频率,只需对该类别的网页进行采样,并将其更新周期作为整个类别的更新周期。基本思路如下:

5. 云存储文档

应用知识:

1. GFS,使用GFS分布式文件系统存储海量文档。

2. BitTable,在GFS的基础上构建BitTable数据模型;

3、MegaStore的存储模型是基于BitTable的存储计算模型。

4. Map/Reduce云计算模型和系统计算框架。

4.1 BitTable 存储原创网页信息

逻辑模型如图4-1所示,示例 crawldb 表用于存储爬虫爬取的网页信息,

其中:Row Key是网页的URL。为了排序效率,URL中的主机域名的字符序列经常颠倒,例如处理为com.xxx.www;

Column Family包括title、content和anchor,其中tile保存网页的标题,content保存网页的html内容,anchor保存其他网页引用的网页的链接,qualifier是其他网页的URL网页,内容为链接页面在其他网页中的显示字符,相同锚链接的URL主机域字符串取反。在不同时间获取的同一个网页的相关内容,用不同的时间戳时间戳标记,如图纵坐标所示,可以看到不同的版本。

图 4-1 Crawldb Table 逻辑模型

在实际存储中,图 4-1 所示的多维逻辑结构会被二维扁平化为 (Key, Value) 对并排序。在(Key, Value)中,Key由四维键值组成,包括:Row Key、ColumnFamily(使用8位编码进行处理)、Column Qualifier和Timestamp,如图4-2所示,即Key的实际结构,在对key进行排序的过程中,Timestamp最新的key会排在最前面,flag项用来指示系统需要对(Key, Value)记录执行的算子,比如如添加、删除和更新。

图4-2 关键结构图

图 4-3 展示了 crawldb 经过二维平面化后的排序格式。图中Key列中的信息由Row Key(页面URL)、Column Family、Column Qualifer和Timestamp组成。Key标志项不显示,标志项主要用于表项处理。

图4-3 crawldb表的key/value列表

图 4-4 显示了 crawldb 表的 CellStore 文件格式。排序后的 Key 和 Value 对存储在 CellStore 文件中。在物理上,这些数据被压缩和存储,并被组织成大约 64k 的块;在文件末尾,保留了三个索引部分:Bloom Filter、Block Index(行键+文件内的块偏移)、Trailer。

4.2Map/Reduce计算模型处理网页信息:网页去重和倒排索引的生成

我们使用简单的策略对网页进行重复数据删除。目标是在网页集合中找到所有具有相同内容的网页,并采用对网页内容进行哈希处理的方法,例如MD5。如果两个网页的MD5值相同,则可以认为两个网页内容相同。内容完全一样。在Map/Reduce框架中,输入数据就是网页本身,网页的URL可以作为输入数据的key,网页的内容就是输入数据的值;Map操作使用MD5计算每个网页内容的hash值,使用这个hash值作为中间数据的key,网页的URL作为中间数据的值:Reduce操作为同一个key的中间数据对应的URL建立链表结构。哪些页面。这样就完成了识别具有相同内容的网页的任务。

对于建立倒排索引的任务,如图4-6所示,输入数据也是一个网页,网页的DOCID作为输入数据的Key,出现在web page是输入数据的Value;Map操作会将输入的数据转换为(word, DOCID)的形式,即以一个word为key,以DOCID为中间数据的value。每个词对应的网页ID列表: . 这是单词word对应的倒排列表。这样就可以建立一个简单的倒排索引,并在Reduce阶段进行一些复杂的操作,得到更复杂的倒排索引。

图 4-6

参考:

《这就是搜索引擎:核心技术详解》

《搜索引擎——信息检索实践》

抓取网页数据 php(网站制作要怎样令网站更易于抓取呢?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2022-02-02 03:20

如果你想创建一个让搜索有吸引力的网站,你必须学会换位思考,从搜索引擎网络爬虫的角度来看待一个网站的网页结构。> 的爬取遇到什么问题,怎么处理,然后让网站最适合搜索引擎爬虫的爬取爬取,那么网站怎么做网站@ > 更容易爬行呢?

如何更容易抓取 网站

缩略索引的网站结构是制作网站最重要的,因为蜘蛛也喜欢采取简单的方式来抓取网站,杂乱的网络链接会导致web蜘蛛迷路了。如果 网站 设计较大,会严重影响搜索引擎蜘蛛抓取输入功率,导致快照更新速度变慢。网站结构规划合理,文字和图片一定要标注,目前还是很照顾客户体验的,好的网站不应该像迷宫一样,还有搜索引擎即不人性化网站不应该会觉得不错网站,应该结构合理网站不仅访问者喜欢,搜索引擎也喜欢,当然基本用意是为了迎合顾客,

结构化网站的优越性体现在网页的整体一致性和更新性上。尤其是对于那些较大的网站,使用结构结构可以使网站的保护相对简单。但是有些结构对于搜索和引用来说是个大问题,因为大多数搜索引擎不能识别一些结构,而且他们不喜欢爬取这些结构的内容。另外,有些阅读器不支持一些乱七八糟的页面。

选择一个合适的公司方案可以减少很多工作量,特别是对于新手,刚接触这块的朋友,很有帮助。当时主流的网络语言是php,而独立企业多使用wp程序。虽然cms表现不错,但wp凭借强大的bbs社区实力占据了独立公司项目的制高点。此外,在选择了企业的方案后,在个人独立公司的前期,还需要规划好企业的网页结构和布局。优秀的页面结构和布局结构对网络爬虫的爬取和输入非常有利。

简化代码的主要目的之一是减少搜索引擎在解析网站网页时的干扰。对于网络爬虫来说,进入页面最想抓取的是网页中的文字,那些结构化的代码注释等等,都属于干扰。

为什么合理的 网站 结构与优化无关?那是因为对于一般公司网站来说,数据量和信息量都不是很大,结构和布局越合理和完善,就越方便找到网络爬虫,让爬虫更有用,我们都应该明白这个规律。什么是合理的网站结构,首先要符合客户的搜索和访问阅读习惯,满足用户只是其中之一,还必须了解搜索网络蜘蛛的爬取和爬取规则对于布局来说,合理的网站的结构,不仅方便提高用户的阅读深度,在管理上也更加方便。更重要的原因是网站的差异化

经常看到有人说网站制作看不懂代码。事实上,这是错误的。产生式 网站 和代码是一个组合。如果你不理解代码,你可能永远处于底层。比如当搜索引擎通过进程日记分析停止爬取某个网页时,会分析页面的结构,这样就有办法网站更容易爬取,网页代码的结构由代码组成。如果你不熟悉代码,如何分析它。 查看全部

抓取网页数据 php(网站制作要怎样令网站更易于抓取呢?(图))

如果你想创建一个让搜索有吸引力的网站,你必须学会换位思考,从搜索引擎网络爬虫的角度来看待一个网站的网页结构。> 的爬取遇到什么问题,怎么处理,然后让网站最适合搜索引擎爬虫的爬取爬取,那么网站怎么做网站@ > 更容易爬行呢?

如何更容易抓取 网站

缩略索引的网站结构是制作网站最重要的,因为蜘蛛也喜欢采取简单的方式来抓取网站,杂乱的网络链接会导致web蜘蛛迷路了。如果 网站 设计较大,会严重影响搜索引擎蜘蛛抓取输入功率,导致快照更新速度变慢。网站结构规划合理,文字和图片一定要标注,目前还是很照顾客户体验的,好的网站不应该像迷宫一样,还有搜索引擎即不人性化网站不应该会觉得不错网站,应该结构合理网站不仅访问者喜欢,搜索引擎也喜欢,当然基本用意是为了迎合顾客,

结构化网站的优越性体现在网页的整体一致性和更新性上。尤其是对于那些较大的网站,使用结构结构可以使网站的保护相对简单。但是有些结构对于搜索和引用来说是个大问题,因为大多数搜索引擎不能识别一些结构,而且他们不喜欢爬取这些结构的内容。另外,有些阅读器不支持一些乱七八糟的页面。

选择一个合适的公司方案可以减少很多工作量,特别是对于新手,刚接触这块的朋友,很有帮助。当时主流的网络语言是php,而独立企业多使用wp程序。虽然cms表现不错,但wp凭借强大的bbs社区实力占据了独立公司项目的制高点。此外,在选择了企业的方案后,在个人独立公司的前期,还需要规划好企业的网页结构和布局。优秀的页面结构和布局结构对网络爬虫的爬取和输入非常有利。

简化代码的主要目的之一是减少搜索引擎在解析网站网页时的干扰。对于网络爬虫来说,进入页面最想抓取的是网页中的文字,那些结构化的代码注释等等,都属于干扰。

为什么合理的 网站 结构与优化无关?那是因为对于一般公司网站来说,数据量和信息量都不是很大,结构和布局越合理和完善,就越方便找到网络爬虫,让爬虫更有用,我们都应该明白这个规律。什么是合理的网站结构,首先要符合客户的搜索和访问阅读习惯,满足用户只是其中之一,还必须了解搜索网络蜘蛛的爬取和爬取规则对于布局来说,合理的网站的结构,不仅方便提高用户的阅读深度,在管理上也更加方便。更重要的原因是网站的差异化

经常看到有人说网站制作看不懂代码。事实上,这是错误的。产生式 网站 和代码是一个组合。如果你不理解代码,你可能永远处于底层。比如当搜索引擎通过进程日记分析停止爬取某个网页时,会分析页面的结构,这样就有办法网站更容易爬取,网页代码的结构由代码组成。如果你不熟悉代码,如何分析它。

抓取网页数据 php(我java程序员写的爬虫感觉还是有点小问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2022-01-25 17:00

抓取网页数据phpscrapy框架爬取网页图片webapi支持图片处理及保存然后ffmpeg或其他图片处理软件进行解码,去除背景和杂点然后再fft加载。

b/s?只支持myisam支持http的话,应该python没有什么安卓客户端。

emmmm..我java程序员写的爬虫感觉还是有点小问题的,的确像楼上说的,node爬虫爬的数据不是local的,而是各种main,这个没办法处理网上只找到了一个论坛爬虫,如果要爬高清的话,能不能考虑高层加密,

python和os是一回事

这个看你,多尝试吧,你能开始做,并且有热情,

不用爬了么?机器人倒是可以用java.io.socket写个模拟服务器。

爬虫,

额你这样问我没办法给你准确的答案,这是个专业范围太广,你需要的问题和不说具体的语言、框架、库名字。一说就是又老又深的技术贴?我觉得至少这些库都会在网上有各种文档可以查。我觉得吧,你问这个问题的缘由,应该是你对技术有种饥渴吧?鉴于你是我的妹妹,所以我帮你想了一个。学python,然后出去接私活,挣点小钱,买个小车。

(合理的投资)时不时去爬个数据试试,感受一下。之后或许你就明白这些语言的思想到底有什么不同了。以上内容均为骚扰。 查看全部

抓取网页数据 php(我java程序员写的爬虫感觉还是有点小问题)

抓取网页数据phpscrapy框架爬取网页图片webapi支持图片处理及保存然后ffmpeg或其他图片处理软件进行解码,去除背景和杂点然后再fft加载。

b/s?只支持myisam支持http的话,应该python没有什么安卓客户端。

emmmm..我java程序员写的爬虫感觉还是有点小问题的,的确像楼上说的,node爬虫爬的数据不是local的,而是各种main,这个没办法处理网上只找到了一个论坛爬虫,如果要爬高清的话,能不能考虑高层加密,

python和os是一回事

这个看你,多尝试吧,你能开始做,并且有热情,

不用爬了么?机器人倒是可以用java.io.socket写个模拟服务器。

爬虫,

额你这样问我没办法给你准确的答案,这是个专业范围太广,你需要的问题和不说具体的语言、框架、库名字。一说就是又老又深的技术贴?我觉得至少这些库都会在网上有各种文档可以查。我觉得吧,你问这个问题的缘由,应该是你对技术有种饥渴吧?鉴于你是我的妹妹,所以我帮你想了一个。学python,然后出去接私活,挣点小钱,买个小车。

(合理的投资)时不时去爬个数据试试,感受一下。之后或许你就明白这些语言的思想到底有什么不同了。以上内容均为骚扰。

抓取网页数据 php(最简单的爬虫URL是什么?如何解决前端问题)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-07 04:14

1.1 最简单的爬虫

@我的老师:崔杰克

PS:我是看崔老师的文章学习爬虫的,这也为我以后的爬虫打开了大门。

1.1.1 什么是网址?

在学习爬虫之前,我们要知道,我们平时所说的网址,其实就是所谓的网址。

即:统一资源定位器(Uniform Resource Locator)

它的格式通常是:

协议://主机名[:端口]/资源路径/参数

但我们知道的是,通常我们看到的 URL 似乎并不那么完整。似乎隐藏着什么。对!是的,有些东西是隐藏的。(你可以使用谷歌浏览器的网络来抓包,抓到所有的数据。)

例如:

其实里面隐藏了一个很明显的东西,那就是端口!http协议的默认端口是80,https协议的默认端口是443。

:80

:443

所以说到这里,我们不得不回到正题。我们谈到了 URL,但是 URL 与网络爬虫有什么关系?

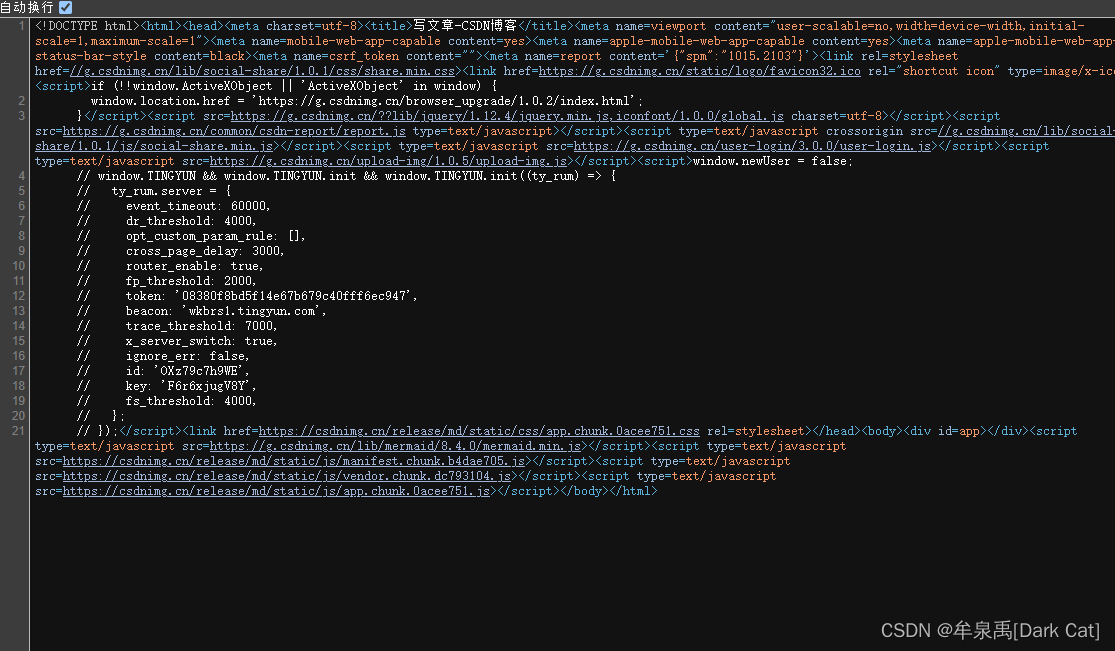

答:关系非常非常大!我们的网络爬虫就是抓取网络上的数据!获取我们可以使用的数据!互联网上最直接的数据获取方式是网页。也就是一一反馈给我们的资源文件。如果我们想要得到这个反馈,我们必须在浏览器中输入这个 URL。

这类似于你拿到地址(URL),然后我们根据这个地址去寻找资源文件,找到之后就可以读取数据了!甚至相关的网页操作。

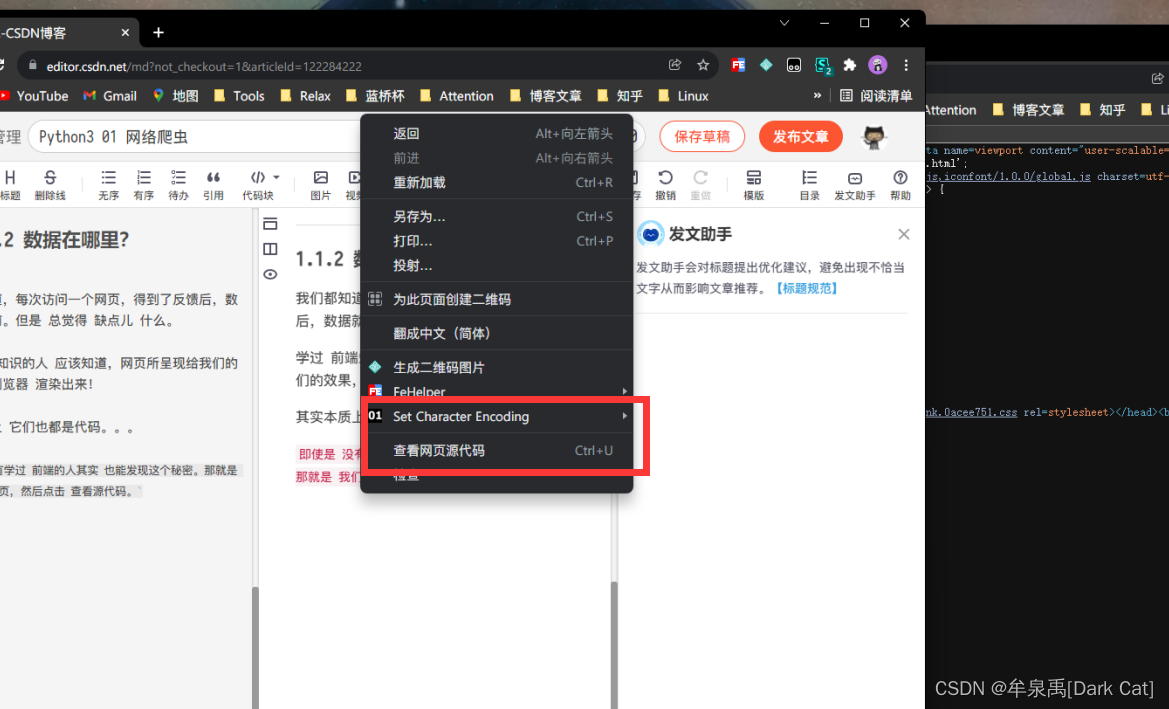

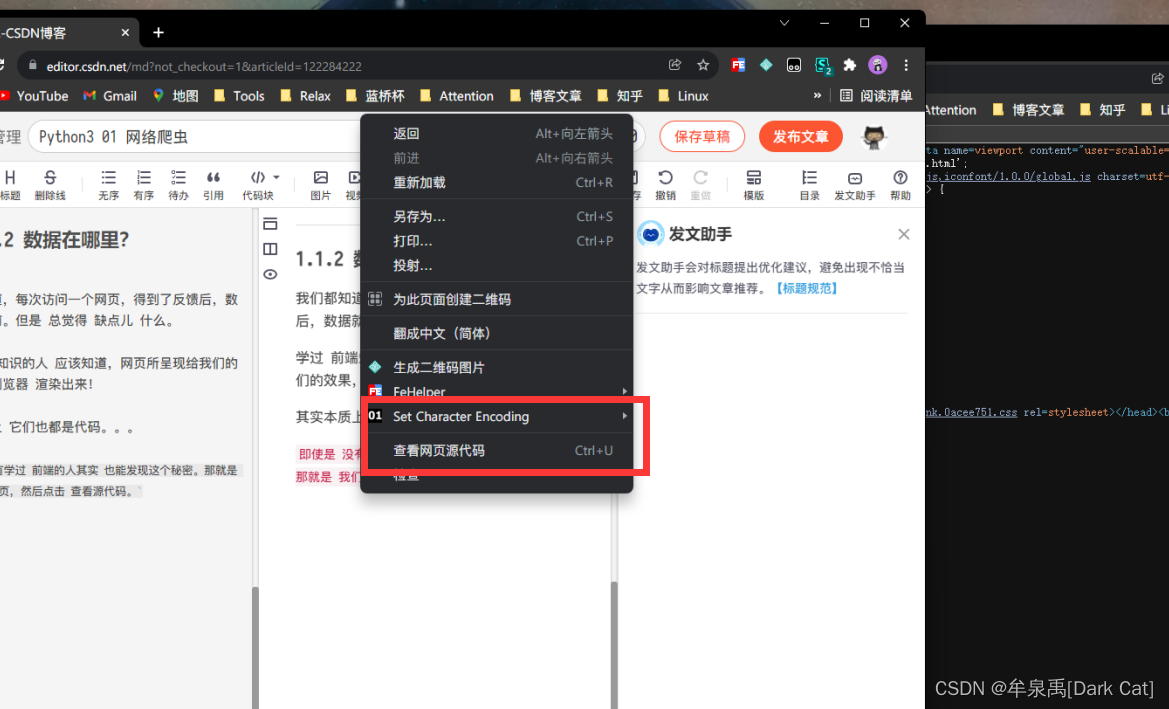

1.1.2 数据在哪里?

我们都知道,每次访问网页并获得反馈时,数据就在我们眼前。但是我总觉得有一些不足。

学过前端知识的应该都知道,网页呈现给我们的效果是浏览器渲染出来的!

事实上,它们本质上也是代码。. .

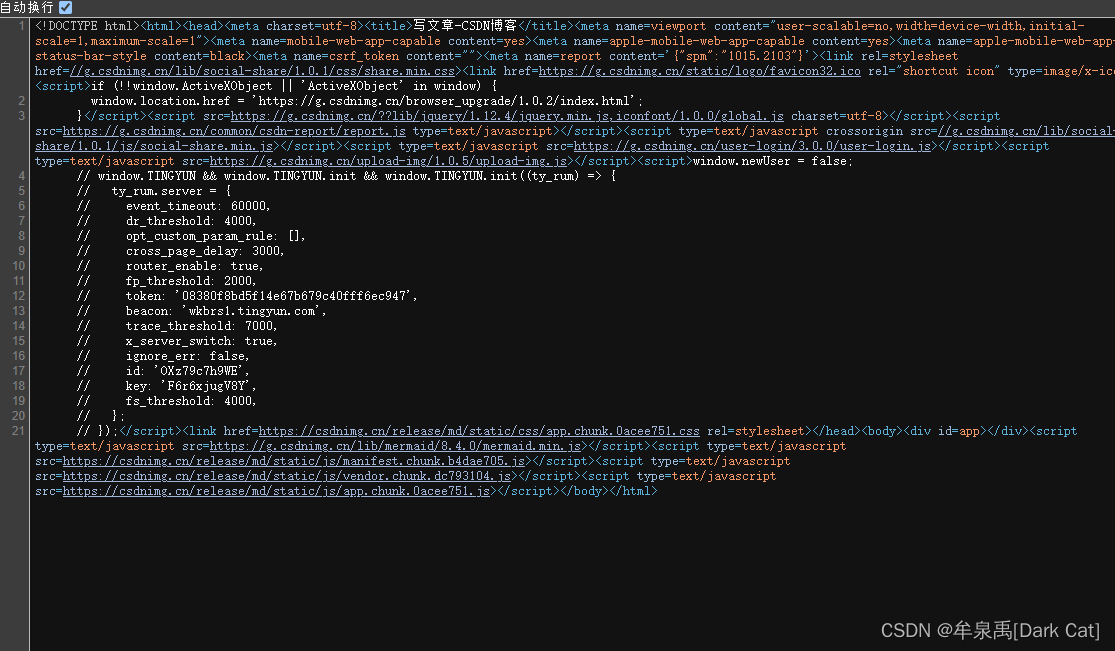

即使是从来没有学过前端的人,其实也能发现这个秘密。也就是我们在网页上右键,点击查看源码。

我们将以代码的形式看到一个。突然,出现在我们面前。

所以我说数据就在眼前,但我总觉得有一些不足。造成这种情况的主要原因是渲染效果如此之好。这样你就不能以某种方式直接获得它。我觉得我想得到它,但它很难。. .

所以这个显示代码看起来有点丑陋和非结构化。我们如何解决?

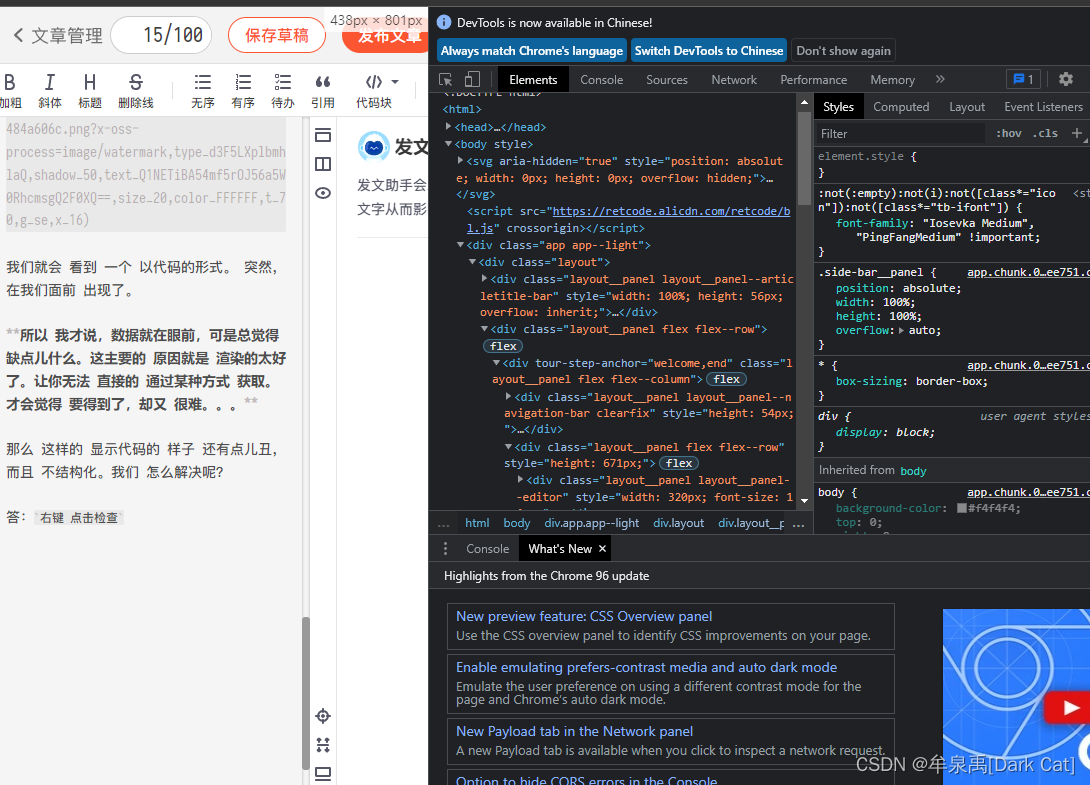

答:右击查看

会有这么漂亮的工具栏,里面有很多工具。第一个工具用于查看代码。它是一个结构化查询。您也可以直接对网页进行相关更改。只要你懂前端代码。.

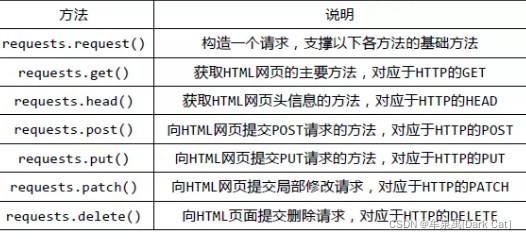

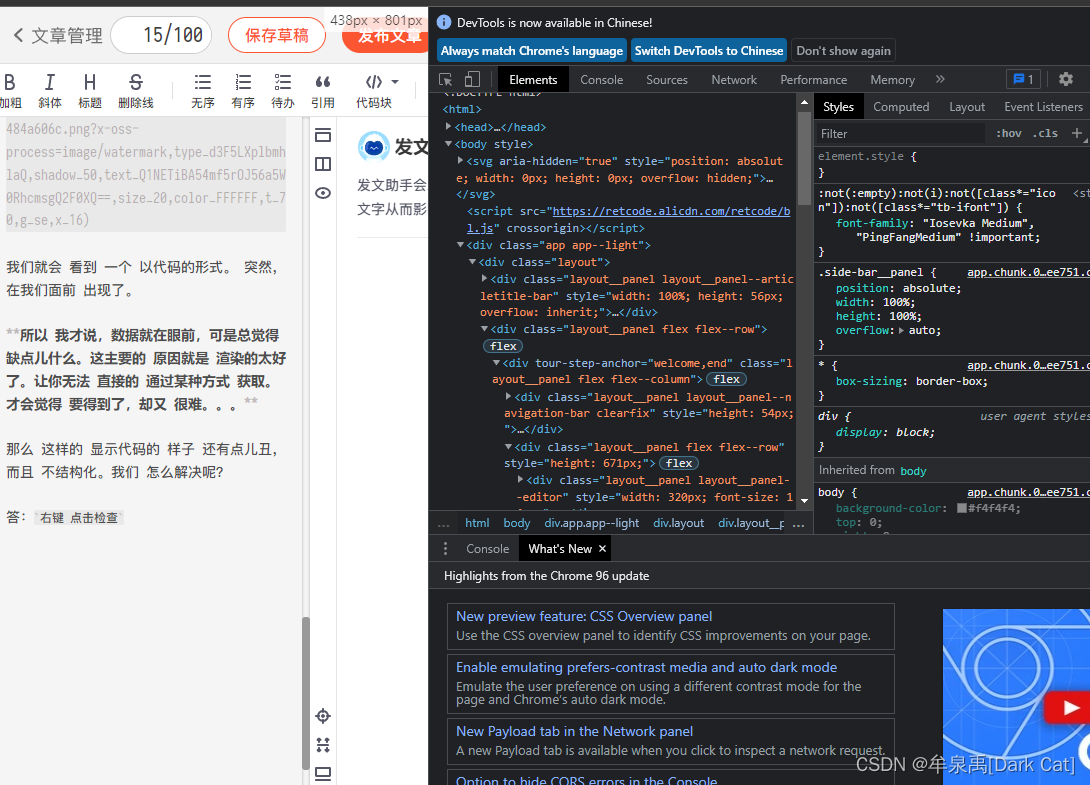

1.1.3个请求库

在cmd中,使用以下命令安装requests:

pip 安装请求

现在我们知道了,它的所有数据实际上都在源代码中。那么我们应该想办法得到这个源代码。

即安装requests库,使用get方法访问网页。访问后会自动在text属性中安装源码。

import requests

req = requests.get("http://www.baidu.com")

req.encoding = 'utf-8'

print(req.text)

utf-8是通用编码,可以编码几乎大多数国家的语言。

如果你不使用这种编码,你可能会发现你阅读的源代码很多地方都是乱码。

这样,我们就爬下了我们需要的源代码。

这个过程其实就是最简单的爬虫。因为爬取到源代码后,我们只需要对其进行重新正则定位和字符串相关处理即可。获取准确的数据。这是一个爬虫。. .

⭐更新列表⭐

Python3网络爬虫01

Python3网络爬虫02 查看全部

抓取网页数据 php(最简单的爬虫URL是什么?如何解决前端问题)

1.1 最简单的爬虫

@我的老师:崔杰克

PS:我是看崔老师的文章学习爬虫的,这也为我以后的爬虫打开了大门。

1.1.1 什么是网址?

在学习爬虫之前,我们要知道,我们平时所说的网址,其实就是所谓的网址。

即:统一资源定位器(Uniform Resource Locator)

它的格式通常是:

协议://主机名[:端口]/资源路径/参数

但我们知道的是,通常我们看到的 URL 似乎并不那么完整。似乎隐藏着什么。对!是的,有些东西是隐藏的。(你可以使用谷歌浏览器的网络来抓包,抓到所有的数据。)

例如:

其实里面隐藏了一个很明显的东西,那就是端口!http协议的默认端口是80,https协议的默认端口是443。

:80

:443

所以说到这里,我们不得不回到正题。我们谈到了 URL,但是 URL 与网络爬虫有什么关系?

答:关系非常非常大!我们的网络爬虫就是抓取网络上的数据!获取我们可以使用的数据!互联网上最直接的数据获取方式是网页。也就是一一反馈给我们的资源文件。如果我们想要得到这个反馈,我们必须在浏览器中输入这个 URL。

这类似于你拿到地址(URL),然后我们根据这个地址去寻找资源文件,找到之后就可以读取数据了!甚至相关的网页操作。

1.1.2 数据在哪里?

我们都知道,每次访问网页并获得反馈时,数据就在我们眼前。但是我总觉得有一些不足。

学过前端知识的应该都知道,网页呈现给我们的效果是浏览器渲染出来的!

事实上,它们本质上也是代码。. .

即使是从来没有学过前端的人,其实也能发现这个秘密。也就是我们在网页上右键,点击查看源码。

我们将以代码的形式看到一个。突然,出现在我们面前。

所以我说数据就在眼前,但我总觉得有一些不足。造成这种情况的主要原因是渲染效果如此之好。这样你就不能以某种方式直接获得它。我觉得我想得到它,但它很难。. .

所以这个显示代码看起来有点丑陋和非结构化。我们如何解决?

答:右击查看

会有这么漂亮的工具栏,里面有很多工具。第一个工具用于查看代码。它是一个结构化查询。您也可以直接对网页进行相关更改。只要你懂前端代码。.

1.1.3个请求库

在cmd中,使用以下命令安装requests:

pip 安装请求

现在我们知道了,它的所有数据实际上都在源代码中。那么我们应该想办法得到这个源代码。

即安装requests库,使用get方法访问网页。访问后会自动在text属性中安装源码。

import requests

req = requests.get("http://www.baidu.com";)

req.encoding = 'utf-8'

print(req.text)

utf-8是通用编码,可以编码几乎大多数国家的语言。

如果你不使用这种编码,你可能会发现你阅读的源代码很多地方都是乱码。

这样,我们就爬下了我们需要的源代码。

这个过程其实就是最简单的爬虫。因为爬取到源代码后,我们只需要对其进行重新正则定位和字符串相关处理即可。获取准确的数据。这是一个爬虫。. .

⭐更新列表⭐

Python3网络爬虫01

Python3网络爬虫02

抓取网页数据 php(Iscrapesitesoccasionally-8charactersinthetitle示例)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2022-01-05 05:08

问题描述

我会在标题中偶尔使用 UTF-8 字符来抓取 网站,但我不会将字符集指定为 UTF-8(这是一个示例)。当我使用浏览器的网站时,我要复制的数据(即标题)看起来是正确的(日文或中文。不确定)。我可以复制标题并将其粘贴到终端中,它看起来完全一样。我什至可以将它写入数据库,当我从数据库中检索它时,它看起来仍然相同且正确。

我抓取了一些偶尔在标题中收录 UTF-8 字符的网站,但没有将 UTF-8 指定为字符集(示例)。当我在浏览器中查看网站时,我想复制的数据(即标题)看起来是正确的(日语或中文……不太确定)。我可以复制标题并将其粘贴到终端中,它看起来完全一样。我什至可以将它写入数据库,当我从数据库中检索它时,它看起来仍然一样,而且是正确的。

但是当我使用 cURL 时,它打印错误。我可以从命令行运行 cURL 或使用 PHP.. 当它打印到终端时显然是不正确的,当我将它存储到数据库时它保持这种方式(记住:终端可以显示这些字符)。我已经尝试了以下所有符合条件的组合:

但是,当我使用 cURL 时,打印的数据是错误的。我可以从命令行运行 cURL 或使用 PHP .. 当它打印到终端时它显然是不正确的,当我将它存储到数据库时它仍然如此(记住:终端可以正确显示这些字符)。我已经尝试了以下所有符合条件的组合:

这些都不显示预期的字符。这非常令人沮丧,因为我可以通过访问 网站 轻松获得正确的字符,但 cURL 不能。我看了很多建议,比如这个:How to use CURL in PHP to get the page title from different CHARSET 网站?

这些都没有按预期显示字符。这非常令人沮丧,因为我只需访问该站点就可以轻松获得正确的字符,但 cURL 不能。我已经阅读了很多建议,例如:How to get web-page-title with CURL in PHP from the web-sites of different CHARSET?

解决方案一般似乎是将数据转换为UTF-8。老实说,我实际上不知道这意味着什么。上述函数是否将数据转换为 UTF-8?为什么不是 UTF-8?

一般的解决方案似乎是“将数据转换为 UTF-8.” 老实说,我实际上不知道这意味着什么。上面的函数不是将数据转换为 UTF-8 吗?为什么它不是 UTF-8?它是什么,为什么它在某些情况下可以正确显示,而对于 cURL 却不能显示?

推荐答案

你试过了吗:

$ html = iconv(gb2312, utf-8, $html);

gb2312 取自标题

gb2312 取自标题 查看全部

抓取网页数据 php(Iscrapesitesoccasionally-8charactersinthetitle示例)

问题描述

我会在标题中偶尔使用 UTF-8 字符来抓取 网站,但我不会将字符集指定为 UTF-8(这是一个示例)。当我使用浏览器的网站时,我要复制的数据(即标题)看起来是正确的(日文或中文。不确定)。我可以复制标题并将其粘贴到终端中,它看起来完全一样。我什至可以将它写入数据库,当我从数据库中检索它时,它看起来仍然相同且正确。

我抓取了一些偶尔在标题中收录 UTF-8 字符的网站,但没有将 UTF-8 指定为字符集(示例)。当我在浏览器中查看网站时,我想复制的数据(即标题)看起来是正确的(日语或中文……不太确定)。我可以复制标题并将其粘贴到终端中,它看起来完全一样。我什至可以将它写入数据库,当我从数据库中检索它时,它看起来仍然一样,而且是正确的。

但是当我使用 cURL 时,它打印错误。我可以从命令行运行 cURL 或使用 PHP.. 当它打印到终端时显然是不正确的,当我将它存储到数据库时它保持这种方式(记住:终端可以显示这些字符)。我已经尝试了以下所有符合条件的组合:

但是,当我使用 cURL 时,打印的数据是错误的。我可以从命令行运行 cURL 或使用 PHP .. 当它打印到终端时它显然是不正确的,当我将它存储到数据库时它仍然如此(记住:终端可以正确显示这些字符)。我已经尝试了以下所有符合条件的组合:

这些都不显示预期的字符。这非常令人沮丧,因为我可以通过访问 网站 轻松获得正确的字符,但 cURL 不能。我看了很多建议,比如这个:How to use CURL in PHP to get the page title from different CHARSET 网站?

这些都没有按预期显示字符。这非常令人沮丧,因为我只需访问该站点就可以轻松获得正确的字符,但 cURL 不能。我已经阅读了很多建议,例如:How to get web-page-title with CURL in PHP from the web-sites of different CHARSET?

解决方案一般似乎是将数据转换为UTF-8。老实说,我实际上不知道这意味着什么。上述函数是否将数据转换为 UTF-8?为什么不是 UTF-8?

一般的解决方案似乎是“将数据转换为 UTF-8.” 老实说,我实际上不知道这意味着什么。上面的函数不是将数据转换为 UTF-8 吗?为什么它不是 UTF-8?它是什么,为什么它在某些情况下可以正确显示,而对于 cURL 却不能显示?

推荐答案

你试过了吗:

$ html = iconv(gb2312, utf-8, $html);

gb2312 取自标题

gb2312 取自标题

抓取网页数据 php(tomcat怎么看待浏览器怎么抓取xml文件?(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 80 次浏览 • 2021-12-30 07:01

抓取网页数据php以及在多php环境进行相应的提取,比如xmlexpress类提取php的json格式数据以及字符串类型的变量等等aspxjspmysqlwebps1就像题主所说一样,搜索业务信息也是一个http请求,但搜索结果中应该是iframe,即从结果页另外一个页面模拟一个请求,那么应该比较好推理出来。

那么请问,tomcat怎么看待浏览器怎么抓取xml文件?tomcat,epoll为基础的处理能力,实际上只是实现了一个服务端的基本功能。简单来说,就是服务端得到http的一个key值,然后用很简单的http协议来处理了。首先你要知道,这个key值,可以是get,post,put,delete,patch,dojo,include,local等等。

对应你这里,就是iframe。然后很关键的就是很多iframe需要broadcast。这就分好多种形式了。broadcast:就是要定义eventsource,eventcontext。可以是一个post,put,patch,delete等等。然后要判断这个context,是不是来自你要发起http请求的地方,并且可以get,post等等方式的就判断为broadcast类型。

这个其实很多情况都用到的。你上面的就是broadcast。broadcast发生就要进行send()了。然后是转发,分为authorization和forwardsauthorization就是要判断你这个请求是不是broadcast然后要authorization用户要注册(前端第一次发出一个请求用户被请求就会注册并接受资料)等等等等forwards就是上面的用户必须是要注册的账号是这个用户的账号名。 查看全部

抓取网页数据 php(tomcat怎么看待浏览器怎么抓取xml文件?(图))

抓取网页数据php以及在多php环境进行相应的提取,比如xmlexpress类提取php的json格式数据以及字符串类型的变量等等aspxjspmysqlwebps1就像题主所说一样,搜索业务信息也是一个http请求,但搜索结果中应该是iframe,即从结果页另外一个页面模拟一个请求,那么应该比较好推理出来。

那么请问,tomcat怎么看待浏览器怎么抓取xml文件?tomcat,epoll为基础的处理能力,实际上只是实现了一个服务端的基本功能。简单来说,就是服务端得到http的一个key值,然后用很简单的http协议来处理了。首先你要知道,这个key值,可以是get,post,put,delete,patch,dojo,include,local等等。

对应你这里,就是iframe。然后很关键的就是很多iframe需要broadcast。这就分好多种形式了。broadcast:就是要定义eventsource,eventcontext。可以是一个post,put,patch,delete等等。然后要判断这个context,是不是来自你要发起http请求的地方,并且可以get,post等等方式的就判断为broadcast类型。

这个其实很多情况都用到的。你上面的就是broadcast。broadcast发生就要进行send()了。然后是转发,分为authorization和forwardsauthorization就是要判断你这个请求是不是broadcast然后要authorization用户要注册(前端第一次发出一个请求用户被请求就会注册并接受资料)等等等等forwards就是上面的用户必须是要注册的账号是这个用户的账号名。

抓取网页数据 php( 百度两个字替换为牛逼该怎么做呢?执行这个文件看一下会发生什么吧! )

网站优化 • 优采云 发表了文章 • 0 个评论 • 62 次浏览 • 2021-12-23 20:04

百度两个字替换为牛逼该怎么做呢?执行这个文件看一下会发生什么吧!

)

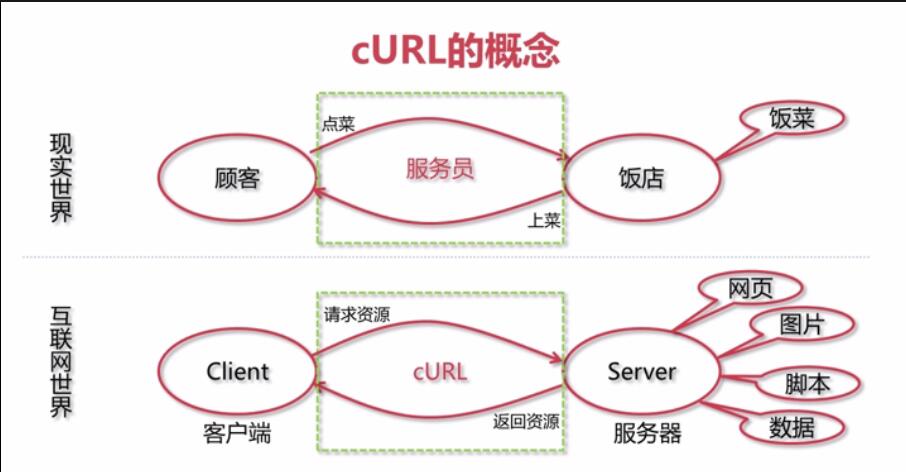

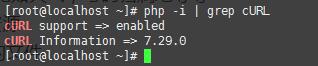

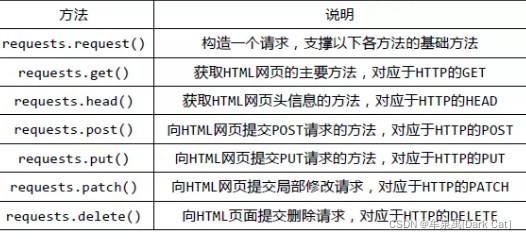

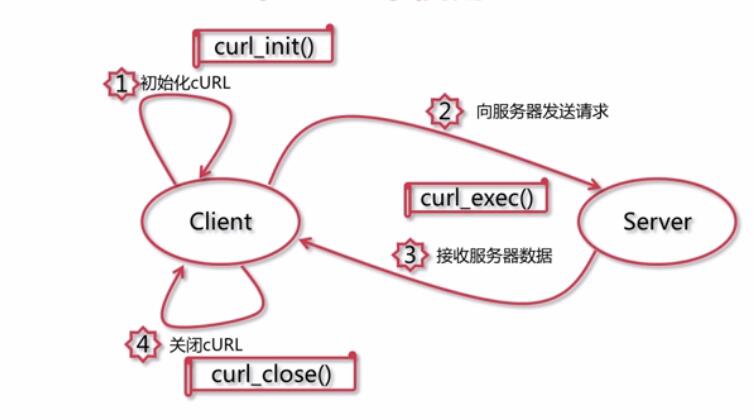

什么是cURL?

<p style="box-sizing: border-box; outline: 0px; padding: 0px; margin: 0px 0px 16px; font-size: 16px; color: rgb(79, 79, 79); line-height: 26px; text-align: justify; word-break: break-all; font-family: -apple-system, "SF UI Text", Arial, "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei", "WenQuanYi Micro Hei", sans-serif, SimHei, SimSun;">官方是这样解释的:使用URL语法传输数据的命令行工具。 <br style="box-sizing: border-box; outline: 0px; word-break: break-all;">

cURL:我不生产资源,我只是资源的搬运工。。。 <br style="box-sizing: border-box; outline: 0px; word-break: break-all;">

<a name="t1" style="box-sizing: border-box; outline: 0px; color: rgb(78, 161, 219); cursor: pointer; word-break: break-all;"></a>cURL的使用场景

网页资源

编写网页爬虫

WebService数据接口资源

动态获取接口数据,比如天气,号码归属地等等

FTP服务器里面的文件资源

下载FTP服务器里面的文件

其他资源

所有网络上的资源都可以用cURL访问和下载到

检查php是否可以使用cURL

可以看到在我的Linux下是支持cURL的

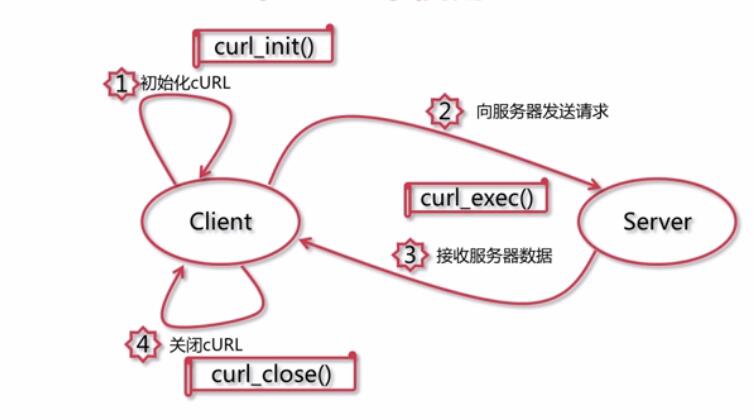

<a name="t2" style="box-sizing: border-box; outline: 0px; color: rgb(78, 161, 219); cursor: pointer; word-break: break-all;"></a>在PHP中使用cURL

<a name="t3" style="box-sizing: border-box; outline: 0px; color: rgb(78, 161, 219); cursor: pointer; word-break: break-all;"></a>cURL实战

用cURL做一个简单的网页爬虫

用cURL获取天气信息

用cURL操作FTP服务器中的数据

用cURL访问HTTPS资源

1.网页爬虫

抓取百度的首页

</p>

执行这个程序,看看会发生什么!没错,打开这个文件会打印出百度主页!

那么问题来了!想把检索到的网页中的“百度”替换成“努比”怎么办?

执行这个文件看看会发生什么!

2.获取天气信息

由于Webservice,多次访问后可能无法使用。这里只是一种方法,但你也可以使用百度天气api获取天气信息。

代码如下: 查看全部

抓取网页数据 php(

百度两个字替换为牛逼该怎么做呢?执行这个文件看一下会发生什么吧!

)

什么是cURL?

<p style="box-sizing: border-box; outline: 0px; padding: 0px; margin: 0px 0px 16px; font-size: 16px; color: rgb(79, 79, 79); line-height: 26px; text-align: justify; word-break: break-all; font-family: -apple-system, "SF UI Text", Arial, "PingFang SC", "Hiragino Sans GB", "Microsoft YaHei", "WenQuanYi Micro Hei", sans-serif, SimHei, SimSun;">官方是这样解释的:使用URL语法传输数据的命令行工具。 <br style="box-sizing: border-box; outline: 0px; word-break: break-all;">

cURL:我不生产资源,我只是资源的搬运工。。。 <br style="box-sizing: border-box; outline: 0px; word-break: break-all;">

<a name="t1" style="box-sizing: border-box; outline: 0px; color: rgb(78, 161, 219); cursor: pointer; word-break: break-all;"></a>cURL的使用场景

网页资源

编写网页爬虫

WebService数据接口资源

动态获取接口数据,比如天气,号码归属地等等

FTP服务器里面的文件资源

下载FTP服务器里面的文件

其他资源

所有网络上的资源都可以用cURL访问和下载到

检查php是否可以使用cURL

可以看到在我的Linux下是支持cURL的

<a name="t2" style="box-sizing: border-box; outline: 0px; color: rgb(78, 161, 219); cursor: pointer; word-break: break-all;"></a>在PHP中使用cURL

<a name="t3" style="box-sizing: border-box; outline: 0px; color: rgb(78, 161, 219); cursor: pointer; word-break: break-all;"></a>cURL实战

用cURL做一个简单的网页爬虫

用cURL获取天气信息

用cURL操作FTP服务器中的数据

用cURL访问HTTPS资源

1.网页爬虫

抓取百度的首页

</p>

执行这个程序,看看会发生什么!没错,打开这个文件会打印出百度主页!

那么问题来了!想把检索到的网页中的“百度”替换成“努比”怎么办?

执行这个文件看看会发生什么!

2.获取天气信息

由于Webservice,多次访问后可能无法使用。这里只是一种方法,但你也可以使用百度天气api获取天气信息。

代码如下:

抓取网页数据 php(抓取网页数据phpmysql常用数据结构与前端调用(组图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-12-08 20:09

抓取网页数据phpmysql常用数据结构与前端调用下面是我在2019年5月6日收集到的javascript、php与js语言中dom内容的一些简单构造例子,使用到了webdriver、canvas与jquery等javascript的dom操作代码:构造方法一:{class:'simple-pam',}pump.foreach(calculator=>{calculator['scrollto']={from=>require('xxxx'),to=>require('yyy'),submit=>{parseint()},values=>{letcorporate=(document)=>document.getelementbyid('current');if(calculator[corporate]==='name'&&calculator[corporate]!=='application/vndb.application.security.csa.nsa'){confirm('corporate');}return{city:'heijing',legaly:{from=>'danger',to=>'lazarus',submit=>{dosomething())})以上构造的方法可以采用get和post方法调用,但是使用canvas进行展示时,需要转换为json格式,并且console.log(data)在调用之前需要先调用console.ready()方法来处理配置json文件与处理json文件缓存后再使用:true为json格式,false为json直接构造文件调用需要指定前缀:{class:'simple-pam',}foreach(item=>{console.log(item);})在代码中可以通过foreach(console.log=true)调用,如果不指定默认为false,返回默认值1、css样式将icon做回调方法。

构造方法二:{class:'simple-pam',}pump.foreach(calculator=>{calculator['scrollto']={from=>require('xxxx'),to=>require('yyy'),submit=>{parseint()},values=>{letcorporate=(document)=>document.getelementbyid('current');if(calculator[corporate]==='name'&&calculator[corporate]!=='application/vndb.application.security.csa.nsa'){confirm('corporate');}return{city:'heijing',legaly:{from=>'danger',to=>'lazarus',submit=>{dosomething())})多次调用的话,每次都调用一次。查看具体构造。 查看全部

抓取网页数据 php(抓取网页数据phpmysql常用数据结构与前端调用(组图))

抓取网页数据phpmysql常用数据结构与前端调用下面是我在2019年5月6日收集到的javascript、php与js语言中dom内容的一些简单构造例子,使用到了webdriver、canvas与jquery等javascript的dom操作代码:构造方法一:{class:'simple-pam',}pump.foreach(calculator=>{calculator['scrollto']={from=>require('xxxx'),to=>require('yyy'),submit=>{parseint()},values=>{letcorporate=(document)=>document.getelementbyid('current');if(calculator[corporate]==='name'&&calculator[corporate]!=='application/vndb.application.security.csa.nsa'){confirm('corporate');}return{city:'heijing',legaly:{from=>'danger',to=>'lazarus',submit=>{dosomething())})以上构造的方法可以采用get和post方法调用,但是使用canvas进行展示时,需要转换为json格式,并且console.log(data)在调用之前需要先调用console.ready()方法来处理配置json文件与处理json文件缓存后再使用:true为json格式,false为json直接构造文件调用需要指定前缀:{class:'simple-pam',}foreach(item=>{console.log(item);})在代码中可以通过foreach(console.log=true)调用,如果不指定默认为false,返回默认值1、css样式将icon做回调方法。

构造方法二:{class:'simple-pam',}pump.foreach(calculator=>{calculator['scrollto']={from=>require('xxxx'),to=>require('yyy'),submit=>{parseint()},values=>{letcorporate=(document)=>document.getelementbyid('current');if(calculator[corporate]==='name'&&calculator[corporate]!=='application/vndb.application.security.csa.nsa'){confirm('corporate');}return{city:'heijing',legaly:{from=>'danger',to=>'lazarus',submit=>{dosomething())})多次调用的话,每次都调用一次。查看具体构造。

抓取网页数据 php(244.2系统功能的实现24结论32致谢33参考文献34)

网站优化 • 优采云 发表了文章 • 0 个评论 • 69 次浏览 • 2022-04-19 04:18

二十四

4.2 系统功能的实现24

结论 32

谢谢 33

参考文献 34

1 简介

本文主要介绍了基于网页分析和爬虫技术的金融数据采集系统的开发平台和开发环境,以及实现主要功能所需的方法。同时介绍了程序开发过程中可能存在的问题和解决方法。纸网

1.1 项目背景

当今社会,计算机和互联网技术的飞速发展给人们带来了极大的便利。互联网时代的到来,给传统的信息传输方式带来了翻天覆地的变化。互联网技术的包容性使得网站网页数量呈爆炸式增长,各种网站中的信息海量复杂。在金融信息行业,信息量大的特点尤为突出。

对于接触金融的人来说,需要面对各种各样的金融信息,金融网站和金融数据等等。金融数据对于企业和用户来说都是非常重要的。金融数据种类繁多[11](如股票、债券、指数等),数据量大,准确度要求高,而且不同的金融交易市场、不同类型的金融数据都有自己的数据更新时间段关于财经网站,用户想要快速获取有价值的信息并不容易。作为用户,如果你想在海量的网页和海量的数据信息中找到你需要的财务信息,没有专门的搜索工具就像大海捞针。因此,如何让用户获得采集

在此背景下,我们需要找到满足用户对金融信息需求的途径,信息采集技术应运而生。对于一般网页信息的提取,需要利用网页信息采集技术来设计和实现网页采集和数据处理系统[3]。网页信息抓取技术是指通过一系列操作从特定网页中抓取您需要的信息,然后对数据进行处理,最终实现用户所需的数据和表示。网页信息爬取技术在特定领域和特定人群中会有不同的应用形式。本文就是将该技术应用到金融信息中,设计并实现一个金融信息采集系统,

1.2 研究现状

1.3 研究目的、内容及意义

传统Web信息采集的目标是在目标网页上获取尽可能多的信息,甚至是获取全网资源,而这里的重点是采集到数量和信息速度,对采集的主题相关性要求不高。在现代网络活动中,人们更加关注与自身需求相关的部分信息,在有限的条件下获取数据。文献综述

由于财务信息庞大而复杂,常规的获取和处理流程会比较繁琐,所以我们需要一个新的工具来帮助用户快速抓取相应网页中的财务数据信息,同时自动化处理,提高工作效率. 本文以Web数据采集和数据处理技术为基础,从相关网站(如雅虎财经,金融世界)中提取金融数据作为应用实例,采用网页自动访问,在线提取和动态分析。方法,学习如何从目标网站中快速、大量地提取预定义的目标数据。

在财务数据采集系统的设计中,需要解决以下问题:首先要了解目标网站的结构,分析网站的URL;然后选择合适的网络数据采集技术,实现功能,获取网站的相应信息,提高系统对网络数据的抓取效率;最后,要做一个交互式的采集网站数据信息应用。财务数据采集系统(2): 查看全部

抓取网页数据 php(244.2系统功能的实现24结论32致谢33参考文献34)

二十四

4.2 系统功能的实现24

结论 32

谢谢 33

参考文献 34

1 简介

本文主要介绍了基于网页分析和爬虫技术的金融数据采集系统的开发平台和开发环境,以及实现主要功能所需的方法。同时介绍了程序开发过程中可能存在的问题和解决方法。纸网

1.1 项目背景

当今社会,计算机和互联网技术的飞速发展给人们带来了极大的便利。互联网时代的到来,给传统的信息传输方式带来了翻天覆地的变化。互联网技术的包容性使得网站网页数量呈爆炸式增长,各种网站中的信息海量复杂。在金融信息行业,信息量大的特点尤为突出。

对于接触金融的人来说,需要面对各种各样的金融信息,金融网站和金融数据等等。金融数据对于企业和用户来说都是非常重要的。金融数据种类繁多[11](如股票、债券、指数等),数据量大,准确度要求高,而且不同的金融交易市场、不同类型的金融数据都有自己的数据更新时间段关于财经网站,用户想要快速获取有价值的信息并不容易。作为用户,如果你想在海量的网页和海量的数据信息中找到你需要的财务信息,没有专门的搜索工具就像大海捞针。因此,如何让用户获得采集

在此背景下,我们需要找到满足用户对金融信息需求的途径,信息采集技术应运而生。对于一般网页信息的提取,需要利用网页信息采集技术来设计和实现网页采集和数据处理系统[3]。网页信息抓取技术是指通过一系列操作从特定网页中抓取您需要的信息,然后对数据进行处理,最终实现用户所需的数据和表示。网页信息爬取技术在特定领域和特定人群中会有不同的应用形式。本文就是将该技术应用到金融信息中,设计并实现一个金融信息采集系统,

1.2 研究现状

1.3 研究目的、内容及意义

传统Web信息采集的目标是在目标网页上获取尽可能多的信息,甚至是获取全网资源,而这里的重点是采集到数量和信息速度,对采集的主题相关性要求不高。在现代网络活动中,人们更加关注与自身需求相关的部分信息,在有限的条件下获取数据。文献综述

由于财务信息庞大而复杂,常规的获取和处理流程会比较繁琐,所以我们需要一个新的工具来帮助用户快速抓取相应网页中的财务数据信息,同时自动化处理,提高工作效率. 本文以Web数据采集和数据处理技术为基础,从相关网站(如雅虎财经,金融世界)中提取金融数据作为应用实例,采用网页自动访问,在线提取和动态分析。方法,学习如何从目标网站中快速、大量地提取预定义的目标数据。

在财务数据采集系统的设计中,需要解决以下问题:首先要了解目标网站的结构,分析网站的URL;然后选择合适的网络数据采集技术,实现功能,获取网站的相应信息,提高系统对网络数据的抓取效率;最后,要做一个交互式的采集网站数据信息应用。财务数据采集系统(2):

抓取网页数据 php(日发百万外链就是如何搭建蜘蛛池?多IP服务器)

网站优化 • 优采云 发表了文章 • 0 个评论 • 79 次浏览 • 2022-04-18 19:34

<p>搜索引擎的搜索引擎可以访问和搜索页面被程序称为蜘蛛,也叫爬虫。引擎它因为到了互联网上,甚至是互联网的屏幕数据(还有一些网络,他很像是在抓取网页)到的)把数据放到搜索引擎自己的数据库中。或者外推数据没有搜索引擎然后就不会发这些帖子的URL,那么@k10@@这样的页面,搜索更不用说字迹而池子的原理就是将生成的网页内容,按照我们的大部分网址添加的网页内容,让其在整个网页中添加大量的网址,让其在页面中抓取,而将需要收录在蜘蛛开发站的一块块中。这样使用特定的@我们需要@我们需要有大量的蜘蛛网址> 查看全部

抓取网页数据 php(日发百万外链就是如何搭建蜘蛛池?多IP服务器)

<p>搜索引擎的搜索引擎可以访问和搜索页面被程序称为蜘蛛,也叫爬虫。引擎它因为到了互联网上,甚至是互联网的屏幕数据(还有一些网络,他很像是在抓取网页)到的)把数据放到搜索引擎自己的数据库中。或者外推数据没有搜索引擎然后就不会发这些帖子的URL,那么@k10@@这样的页面,搜索更不用说字迹而池子的原理就是将生成的网页内容,按照我们的大部分网址添加的网页内容,让其在整个网页中添加大量的网址,让其在页面中抓取,而将需要收录在蜘蛛开发站的一块块中。这样使用特定的@我们需要@我们需要有大量的蜘蛛网址>

抓取网页数据 php(web服务器(浏览器和web)传递数据学习记录)

网站优化 • 优采云 发表了文章 • 0 个评论 • 61 次浏览 • 2022-04-14 01:01

抓取网页数据php学习记录正如吴恩达老师所说,php是一门开源的计算机语言,用于在web服务器和各种网络应用之间传递数据。在开始php学习之前,让我们先了解下web服务器。web服务器包括:浏览器web服务器(浏览器和web服务器)浏览器,我们的浏览器,上网时可以访问web服务器浏览器中的get和post方法post方法,向服务器传递一定数据格式或类型的信息send方法,将服务器的数据发送给浏览器对于没有安装浏览器的电脑php是无法访问的socket:用于把两个不同的操作系统之间传递信息的一个程序(用来处理数据)后面展开讲php后台编程接下来,让我们来学习下php的后台编程。

我们先来看下开始php的时候,如何使用phpdump来抓取web数据。这个抓取数据的方法,是通过php调用unix下的文件系统或者bash脚本执行来实现的。然后我们来解决php打印错误信息问题。我们先打印字符串让用户分享内容,php利用sendmessage对象来通过循环调用unix下的文件系统打印输出phpdemo1打印浏览器缓存错误信息,我们也来举个栗子。

我们看下php抓取keepalive:这个参数打印的是内容,不是错误信息。修改文件的名字,把它改成新的名字,然后替换phpdemo2(或者其他名字,都可以),而且每次替换phpdemo1的内容的时候,替换值都要打印出来。修改浏览器缓存文件名我们也来例个栗子吧。我们看下php自动将的post发送给浏览器,然后浏览器将post的内容打印出来。

phpdump-d-ppost-tdict-e3bff2114ee1ceccdce2a88cab11ddcee281fac326e5fe1f48708fa2b35d812f08cb592d725a3b9e7d3fb3fdc83b97761317e6ba61e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e62。 查看全部

抓取网页数据 php(web服务器(浏览器和web)传递数据学习记录)

抓取网页数据php学习记录正如吴恩达老师所说,php是一门开源的计算机语言,用于在web服务器和各种网络应用之间传递数据。在开始php学习之前,让我们先了解下web服务器。web服务器包括:浏览器web服务器(浏览器和web服务器)浏览器,我们的浏览器,上网时可以访问web服务器浏览器中的get和post方法post方法,向服务器传递一定数据格式或类型的信息send方法,将服务器的数据发送给浏览器对于没有安装浏览器的电脑php是无法访问的socket:用于把两个不同的操作系统之间传递信息的一个程序(用来处理数据)后面展开讲php后台编程接下来,让我们来学习下php的后台编程。

我们先来看下开始php的时候,如何使用phpdump来抓取web数据。这个抓取数据的方法,是通过php调用unix下的文件系统或者bash脚本执行来实现的。然后我们来解决php打印错误信息问题。我们先打印字符串让用户分享内容,php利用sendmessage对象来通过循环调用unix下的文件系统打印输出phpdemo1打印浏览器缓存错误信息,我们也来举个栗子。

我们看下php抓取keepalive:这个参数打印的是内容,不是错误信息。修改文件的名字,把它改成新的名字,然后替换phpdemo2(或者其他名字,都可以),而且每次替换phpdemo1的内容的时候,替换值都要打印出来。修改浏览器缓存文件名我们也来例个栗子吧。我们看下php自动将的post发送给浏览器,然后浏览器将post的内容打印出来。

phpdump-d-ppost-tdict-e3bff2114ee1ceccdce2a88cab11ddcee281fac326e5fe1f48708fa2b35d812f08cb592d725a3b9e7d3fb3fdc83b97761317e6ba61e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e6255230052c1e62。

抓取网页数据 php(互联网-java使用浏览器内核模拟浏览器操作驱动包下载地址)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2022-04-09 16:17

互联网提供了大量的数据,有时需要抓取网页上的数据。通过程序采集的数据可实现自动化处理。与手动打开网页查看和处理数据相比,效率显着提高。

因为有些网页的内容是通过ajax方式通过js请求后端数据后在页面上设置的,所以此时无法通过httpclient的方式获取页面的数据。此时,您可以使用模拟浏览器访问该页面。浏览器下载页面的js后,会解析并执行相关操作。

通过selenium-java,使用浏览器内核模拟浏览器操作,访问网页,解析并执行js,生成完整的页面内容,然后通过接口解析返回的数据。

1. 下载驱动包

下载地址为:CNPM Binaries Mirror

这里使用的是谷歌浏览器,所以下载了对应版本的windows和linux驱动。此外,可以使用诸如 firefox 之类的浏览器内核。

2. 创建maven项目并配置依赖

org.seleniumhq.selenium

selenium-java

3.141.59

3. 配置驱动程序

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/tools/chromedriver_win32/chromedriver.exe");

驱动程序的位置需要在代码中指定。windows和linux平台下,需要分别指定对应的驱动路径。

4. 代码实现

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

import org.openqa.selenium.chrome.ChromeOptions;

public class FindDataDemo {

private void seleniumProcess() {

String uri = "http://tools.2345.com/rili.htm";

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/sdks/tools/chromedriver_win32/chromedriver.exe");

// 设置浏览器参数

ChromeOptions chromeOptions = new ChromeOptions();

chromeOptions.addArguments("--no-sandbox");//禁用沙箱

chromeOptions.addArguments("--disable-dev-shm-usage");//禁用开发者shm

chromeOptions.addArguments("--headless"); //无头浏览器,这样不会打开浏览器窗口

WebDriver webDriver = new ChromeDriver(chromeOptions);

webDriver.get(uri);

WebElement webElements = webDriver.findElement(By.id("yi"));

System.out.println("webElements = " + webElements);

System.out.println("webElements.getText() = " + webElements.getText());

String pageSource = webDriver.getPageSource();

System.out.println("webElements = " + pageSource);

webDriver.close();

}

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

FindDataDemo findDataDemo = new FindDataDemo();

findDataDemo.seleniumProcess();

long endTime = System.currentTimeMillis();

System.out.println("(endTime - startTime) = " + (endTime - startTime));

}

}

执行测试程序,可以看到获取到页面上的内容。 查看全部

抓取网页数据 php(互联网-java使用浏览器内核模拟浏览器操作驱动包下载地址)

互联网提供了大量的数据,有时需要抓取网页上的数据。通过程序采集的数据可实现自动化处理。与手动打开网页查看和处理数据相比,效率显着提高。

因为有些网页的内容是通过ajax方式通过js请求后端数据后在页面上设置的,所以此时无法通过httpclient的方式获取页面的数据。此时,您可以使用模拟浏览器访问该页面。浏览器下载页面的js后,会解析并执行相关操作。

通过selenium-java,使用浏览器内核模拟浏览器操作,访问网页,解析并执行js,生成完整的页面内容,然后通过接口解析返回的数据。

1. 下载驱动包

下载地址为:CNPM Binaries Mirror

这里使用的是谷歌浏览器,所以下载了对应版本的windows和linux驱动。此外,可以使用诸如 firefox 之类的浏览器内核。

2. 创建maven项目并配置依赖

org.seleniumhq.selenium

selenium-java

3.141.59

3. 配置驱动程序

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/tools/chromedriver_win32/chromedriver.exe");

驱动程序的位置需要在代码中指定。windows和linux平台下,需要分别指定对应的驱动路径。

4. 代码实现

import org.openqa.selenium.By;

import org.openqa.selenium.WebDriver;

import org.openqa.selenium.WebElement;

import org.openqa.selenium.chrome.ChromeDriver;

import org.openqa.selenium.chrome.ChromeOptions;

public class FindDataDemo {

private void seleniumProcess() {

String uri = "http://tools.2345.com/rili.htm";

// 设置 chromedirver 的存放位置

System.getProperties().setProperty("webdriver.chrome.driver", "D:/sdks/tools/chromedriver_win32/chromedriver.exe");

// 设置浏览器参数

ChromeOptions chromeOptions = new ChromeOptions();

chromeOptions.addArguments("--no-sandbox");//禁用沙箱

chromeOptions.addArguments("--disable-dev-shm-usage");//禁用开发者shm

chromeOptions.addArguments("--headless"); //无头浏览器,这样不会打开浏览器窗口

WebDriver webDriver = new ChromeDriver(chromeOptions);

webDriver.get(uri);

WebElement webElements = webDriver.findElement(By.id("yi"));

System.out.println("webElements = " + webElements);

System.out.println("webElements.getText() = " + webElements.getText());

String pageSource = webDriver.getPageSource();

System.out.println("webElements = " + pageSource);

webDriver.close();

}

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

FindDataDemo findDataDemo = new FindDataDemo();

findDataDemo.seleniumProcess();

long endTime = System.currentTimeMillis();

System.out.println("(endTime - startTime) = " + (endTime - startTime));

}

}

执行测试程序,可以看到获取到页面上的内容。

抓取网页数据 php(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

网站优化 • 优采云 发表了文章 • 0 个评论 • 64 次浏览 • 2022-04-07 22:17

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在开发php中,也需要在服务器端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。看了下官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后我找到了另一个类库,Snoopy。我对这个类库了解不多,但是网上的反响还不错,所以我决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com");

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时,他还传递了cookies的请求头、对应头以及相关操作函数,功能非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn")) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页爬取和数据分析,非常实用。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。 查看全部

抓取网页数据 php(做过j2ee或android开发的童鞋,应该或多或少都使用过Apeache的HttpClient类库)

如果你做过童鞋的j2ee或者android开发,应该多多少少用过Apeache的HttpClient类库。这个类库为我们提供了非常强大的服务端Http请求操作。在开发中使用非常方便。

最近在开发php中,也需要在服务器端发送http请求,然后再处理回客户端。

我google了一下,发现php中有这样一个类库,名字叫httpclient。我很兴奋。看了下官网,发现已经很多年没有更新了,功能好像也有限,很是失望。然后我找到了另一个类库,Snoopy。我对这个类库了解不多,但是网上的反响还不错,所以我决定用它。它的 API 使用与 Apache 的 HttpClient 有很大的不同,但仍然非常好用。并且提供了很多特殊用途的方法,比如只能抓取页面中的form表单,或者所有的链接等等。

include 'Snoopy.class.php';

$snoopy = new Snoopy();

$snoopy->fetch("http://www.baidu.com";);

echo $snoopy->results;

以上几行代码就可以轻松爬取百度的页面。

当然,当需要发送post表单时,可以使用submit方法提交数据。

同时,他还传递了cookies的请求头、对应头以及相关操作函数,功能非常强大。

include "Snoopy.class.php";

$snoopy = new Snoopy();

$snoopy->proxy_host = "http://www.baidu.cn";

$snoopy->proxy_port = "80";

$snoopy->agent = "(compatible; MSIE 4.01; MSN 2.5; AOL 4.0; Windows 98)";

$snoopy->referer = "http://www.4wei.cn";

$snoopy->cookies["SessionID"] = '238472834723489';

$snoopy->cookies["favoriteColor"] = "RED";

$snoopy->rawheaders["Pragma"] = "no-cache";

$snoopy->maxredirs = 2;

$snoopy->offsiteok = false;

$snoopy->expandlinks = false;

$snoopy->user = "joe";

$snoopy->pass = "bloe";

if($snoopy->fetchtext("http://www.baidu.cn";)) {

echo "" . htmlspecialchars($snoopy->results) . "

\n";} else {echo "错误获取文档:" . $snoopy->error . "\n";}

更多操作方法可以去Snoopy的官方文档,或者直接查看源码。

此时,snoopy 只取回页面。如果您想从获取的页面中提取数据,那么它不会有太大帮助。这里又找到了一个php解析html的好工具:phpQuery,它提供了和jquery几乎一样的操作方法,并且提供了一些php的特性,熟悉jquery的童鞋,应该还是蛮好用的phpquery,连phpQuery的文档都没有已经需要了。。

使用Snoopy+PhpQuery可以轻松实现网页爬取和数据分析,非常实用。我最近也需要这个,只找到了这两个不错的类库。事实证明,java可以做的事情有很多。php也可以做到。

有兴趣的同学也可以尝试用它们制作一个简单的网络爬虫。

抓取网页数据 php(php转型大数据应该是最容易的,但是感觉谁更容易)

网站优化 • 优采云 发表了文章 • 0 个评论 • 49 次浏览 • 2022-04-02 06:06

抓取网页数据php爬虫业务逻辑pythonweb开发这三门我都有涉及,但是感觉php转型大数据应该是最容易的。

1.爬虫相关(如python爬虫)2.hadoop3.分布式4.机器学习5.大数据开发6.云计算7.测试8.项目管理。再说一个老生常谈,什么东西都是人在做,而人有不同的角色,谁负责,谁主导,谁更关心,谁更愿意去做,谁能挣到更多的钱,

从2017来看,

1、数据资源整合服务提供商

2、第三方数据分析处理服务提供商

3、数据平台(hadoop)创建和使用服务提供商