怎样抓取网页数据

怎样抓取网页数据(怎么快速掌握Python以及爬虫如何抓取网页数据的有些知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-09 03:12

IPy:IP地址相关处理

dnsptyhon:域名相关处理

difflib:文件比较

pexpect:屏幕信息获取,常用于自动化

paramiko:SSH 客户端

XlsxWriter:Excel相关处理

还有很多其他的功能模块,每天都有新的模块、框架和组件产生,比如用于与Java桥接的PythonJS,甚至Python可以写Map和Reduce。

二、爬虫如何抓取网页数据

1. 抓取页面

由于我们通常抓取的内容不止一页,所以要注意翻页时链接的变化、关键词的变化,有时甚至是日期;此外,主网页需要静态和动态加载。

2.提出请求

通过HTTP库向目标站点发起请求,即发送Request,请求中可以收录额外的headers等信息,等待服务器响应。

3.获取响应内容

如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(图片或视频)等类型。

4.解析内容

获取的内容可以是HTML,可以用正则表达式和页面解析库解析,也可以是Json,可以直接转成Json对象解析,也可以是二进制数据,可以保存或进一步处理。

5.保存数据

以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件。

以上介绍了如何快速掌握Python以及爬虫如何抓取网页数据的一些知识。其实,网络爬虫的难点其实并不在于爬虫本身。爬虫相对简单易学。网上的很多教程模板也可以使用。但是为了避免数据被爬取,每个网站添加的各种反爬取措施还是不一样的。如果要继续从 网站 爬取数据,则必须绕过这些措施。使用黑洞代理突破IP限制是一个非常好的方法,其他反爬虫措施可以阅读网站信息。 查看全部

怎样抓取网页数据(怎么快速掌握Python以及爬虫如何抓取网页数据的有些知识)

IPy:IP地址相关处理

dnsptyhon:域名相关处理

difflib:文件比较

pexpect:屏幕信息获取,常用于自动化

paramiko:SSH 客户端

XlsxWriter:Excel相关处理

还有很多其他的功能模块,每天都有新的模块、框架和组件产生,比如用于与Java桥接的PythonJS,甚至Python可以写Map和Reduce。

二、爬虫如何抓取网页数据

1. 抓取页面

由于我们通常抓取的内容不止一页,所以要注意翻页时链接的变化、关键词的变化,有时甚至是日期;此外,主网页需要静态和动态加载。

2.提出请求

通过HTTP库向目标站点发起请求,即发送Request,请求中可以收录额外的headers等信息,等待服务器响应。

3.获取响应内容

如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(图片或视频)等类型。

4.解析内容

获取的内容可以是HTML,可以用正则表达式和页面解析库解析,也可以是Json,可以直接转成Json对象解析,也可以是二进制数据,可以保存或进一步处理。

5.保存数据

以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件。

以上介绍了如何快速掌握Python以及爬虫如何抓取网页数据的一些知识。其实,网络爬虫的难点其实并不在于爬虫本身。爬虫相对简单易学。网上的很多教程模板也可以使用。但是为了避免数据被爬取,每个网站添加的各种反爬取措施还是不一样的。如果要继续从 网站 爬取数据,则必须绕过这些措施。使用黑洞代理突破IP限制是一个非常好的方法,其他反爬虫措施可以阅读网站信息。

怎样抓取网页数据( PHP中的有个函数叫file_get_contents_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-30 18:01

PHP中的有个函数叫file_get_contents_)

网站优化,除了一些正常的优化方法,我们也比较注重网站收录,但是收录的前提是让搜索引擎蜘蛛爬到你的网站,那么蜘蛛怎么爬呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也是缺一不可的。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛的爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到您网站上的所有网站,而是有一个空间并随机爬行。 查看全部

怎样抓取网页数据(

PHP中的有个函数叫file_get_contents_)

网站优化,除了一些正常的优化方法,我们也比较注重网站收录,但是收录的前提是让搜索引擎蜘蛛爬到你的网站,那么蜘蛛怎么爬呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也是缺一不可的。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛的爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到您网站上的所有网站,而是有一个空间并随机爬行。

怎样抓取网页数据(百度对sitemap的生成规则,看看百度站长平台有什么格式要求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2021-12-30 17:25

作为seoer,在优化一个网站的时候,肯定离不开百度站长平台的监控,而且百度站长平台上有一个站点地图文件,可以批量提交网站网址到百度站长平台。

我们来看看百度的站点地图生成规则,看看百度对站点地图有哪些格式要求。这里可以看到百度支持两种格式,一种是txt格式,一种是xml格式,今天是xml格式。生成网站的站点地图文件:

这次用python生成站点地图,首先需要抓取整个站点的url,然后将整个站点的url保存在一个xml文件中。这里我使用异步加载请求来获取站点范围的 URL。异步方法具有节省请求时间和速度快的优点。当网站没有反爬虫措施时,使用异步加载是更好的选择。

好了,思路有了,接下来我们开始写代码:

一、设置爬取的网站

这次使用BeautifulSoup进行分析,导入asyncio和aiohttp包和logger生成日志文件

BASE_URL = 'https://www.danmoln.com'

二、请求获取对应的url

使用BeautifulSoup解析得到所有的a标签,然后根据条件提取url,这里使用的集合集合,使用集合集合对爬取的url进行去重

三、main函数创建对象和循环任务

在main函数中,利用了集合的并集和子集关系,利用这个关系循环创建任务,获取最新的url集合,然后将最新的url集合合并到主集合中

四、另存为站点地图文件

按照百度的格式格式化URL

五、最后运行效果

好像sitemap文件已经生成了,接下来我们只需要把sitemao文件上传到服务器根目录,然后在百度站长平台上生成就可以了。需要码可以私信我 查看全部

怎样抓取网页数据(百度对sitemap的生成规则,看看百度站长平台有什么格式要求)

作为seoer,在优化一个网站的时候,肯定离不开百度站长平台的监控,而且百度站长平台上有一个站点地图文件,可以批量提交网站网址到百度站长平台。

我们来看看百度的站点地图生成规则,看看百度对站点地图有哪些格式要求。这里可以看到百度支持两种格式,一种是txt格式,一种是xml格式,今天是xml格式。生成网站的站点地图文件:

这次用python生成站点地图,首先需要抓取整个站点的url,然后将整个站点的url保存在一个xml文件中。这里我使用异步加载请求来获取站点范围的 URL。异步方法具有节省请求时间和速度快的优点。当网站没有反爬虫措施时,使用异步加载是更好的选择。

好了,思路有了,接下来我们开始写代码:

一、设置爬取的网站

这次使用BeautifulSoup进行分析,导入asyncio和aiohttp包和logger生成日志文件

BASE_URL = 'https://www.danmoln.com'

二、请求获取对应的url

使用BeautifulSoup解析得到所有的a标签,然后根据条件提取url,这里使用的集合集合,使用集合集合对爬取的url进行去重

三、main函数创建对象和循环任务

在main函数中,利用了集合的并集和子集关系,利用这个关系循环创建任务,获取最新的url集合,然后将最新的url集合合并到主集合中

四、另存为站点地图文件

按照百度的格式格式化URL

五、最后运行效果

好像sitemap文件已经生成了,接下来我们只需要把sitemao文件上传到服务器根目录,然后在百度站长平台上生成就可以了。需要码可以私信我

怎样抓取网页数据(服务在访问该网页时的bug!(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-29 13:04

怎样抓取网页数据?

哈,

这种现象很正常,今天遇到了,话说你试试:#coding:utf-8importurllib2url="="+http。cookie+"&src=zh_cn&di=080b5464eb4c350e9c30baaae6b&page=0&keywords=youku"headers={"accept":"text/html,application/xhtml+xml,application/xml;q=0。

9,image/webp,image/apng,*/*;q=0。8","accept-encoding":"gzip,deflate","accept-language":"zh-cn,zh;q=0。8","cookie":"user-agent=youku。me"}query=urllib2。urlopen(re。

findall("",headers=headers))querylist=[]forrinquery:print(r)print("\n")结果如下:。

请问是怎么解决的,我刚提交了个问题,没想到已经有了(),

无解

你先转义下utf-8再进行试试

我能给出有效的替代方案:登录网页再查看

请问解决了吗?我也是这样,

这是google服务在访问该网页时的bug!本人亲测google微博国内的ua是翻墙访问, 查看全部

怎样抓取网页数据(服务在访问该网页时的bug!(图))

怎样抓取网页数据?

哈,

这种现象很正常,今天遇到了,话说你试试:#coding:utf-8importurllib2url="="+http。cookie+"&src=zh_cn&di=080b5464eb4c350e9c30baaae6b&page=0&keywords=youku"headers={"accept":"text/html,application/xhtml+xml,application/xml;q=0。

9,image/webp,image/apng,*/*;q=0。8","accept-encoding":"gzip,deflate","accept-language":"zh-cn,zh;q=0。8","cookie":"user-agent=youku。me"}query=urllib2。urlopen(re。

findall("",headers=headers))querylist=[]forrinquery:print(r)print("\n")结果如下:。

请问是怎么解决的,我刚提交了个问题,没想到已经有了(),

无解

你先转义下utf-8再进行试试

我能给出有效的替代方案:登录网页再查看

请问解决了吗?我也是这样,

这是google服务在访问该网页时的bug!本人亲测google微博国内的ua是翻墙访问,

怎样抓取网页数据(我需要一种方法,让我的Python从Google搜索中获取链接)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-29 09:19

《免费学习60+公开课:投票页面,点击讲师头像》

作者 | 链接

翻译 | 新月,编辑| 郭锐

来源 | CSDN(ID:CSDNnews)

自从 2011 年 Google Web Search API 被弃用以来,我一直在寻找其他方法来抓取 Google。我需要一种方法让我的 Python 脚本从 Google 搜索中获取链接。所以,我自己想出了一个方法,这篇文章是通过请求和 Beautiful Soup 抓取 Google 搜索的快速指南。

首先,让我们安装一些依赖项。请将以下内容保存为文本文件requirements.txt:

<p>requests

bs4</p>

接下来,运行 pip install -r requirements.txt 命令来安装依赖项。然后将其导入到您的脚本中。

<p>import urllib

import requests

from bs4 import BeautifulSoup</p>

为了执行搜索,您需要在 URL 中向 Google 提供查询参数。此外,所有空格都必须替换为 +。为了构造 URL,我们需要设置正确的查询格式并将其放入 q 参数中。

<p>query = "hackernoon How To Scrape Google With Python"

query = query.replace(' ', '+')

URL = f"https://google.com/search?q={query}"</p>

Google 将针对移动设备和台式计算机返回不同的搜索结果。因此,我们需要指定一个合适的用户代理。

<p># desktop user-agent

USER_AGENT = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:65.0) Gecko/20100101 Firefox/65.0"

# mobile user-agent

MOBILE_USER_AGENT = "Mozilla/5.0 (Linux; Android 7.0; SM-G930V Build/NRD90M) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.125 Mobile Safari/537.36"</p>

发送请求很简单。但是,请求需要将用户代理放在请求的开头。为了设置正确的标题,我们必须将字典传递给标题。

<p>headers = {"user-agent" : MOBILE_USER_AGENT}

resp = requests.get(URL, headers=headers)</p>

接下来,我们需要检查请求是否成功。最简单的方法是检查状态代码。如果返回 200,则表示成功。然后,我们需要将其放入 Beautiful Soup 中来解析内容。

<p>if resp.status_code == 200:

soup = BeautifulSoup(resp.content, "html.parser")</p>

下一步是解析数据并从页面中提取所有链接。我们可以使用 Beautiful Soup 轻松完成这项任务。在促进每个链接时,我们需要将结果存储在列表中。

<p>results =

for g in soup.find_all('div', class_='r'):

anchors = g.find_all('a')

if anchors:

link = anchors[0]['href']

title = g.find('h3').text

item = {

"title": title,

"link": link

}

results.append(item)

print(results)</p>

而已。该脚本非常简单且容易出错。但至少它可以让你开始,从那时起你可以编写自己的谷歌爬虫。您可以从 GitHub 下载整个脚本:

.com/getlinksc/scrape_google

原文链接:

.com/how-to-scrape-google-with-python-bo7d2tal

(*本文为AI技术大本营转载文章,转载请联系作者)

所有CSDN用户均可参与投票抽奖活动

加入福利群,每周送精选学习资料、技术书籍等福利 查看全部

怎样抓取网页数据(我需要一种方法,让我的Python从Google搜索中获取链接)

《免费学习60+公开课:投票页面,点击讲师头像》

作者 | 链接

翻译 | 新月,编辑| 郭锐

来源 | CSDN(ID:CSDNnews)

自从 2011 年 Google Web Search API 被弃用以来,我一直在寻找其他方法来抓取 Google。我需要一种方法让我的 Python 脚本从 Google 搜索中获取链接。所以,我自己想出了一个方法,这篇文章是通过请求和 Beautiful Soup 抓取 Google 搜索的快速指南。

首先,让我们安装一些依赖项。请将以下内容保存为文本文件requirements.txt:

<p>requests

bs4</p>

接下来,运行 pip install -r requirements.txt 命令来安装依赖项。然后将其导入到您的脚本中。

<p>import urllib

import requests

from bs4 import BeautifulSoup</p>

为了执行搜索,您需要在 URL 中向 Google 提供查询参数。此外,所有空格都必须替换为 +。为了构造 URL,我们需要设置正确的查询格式并将其放入 q 参数中。

<p>query = "hackernoon How To Scrape Google With Python"

query = query.replace(' ', '+')

URL = f"https://google.com/search?q={query}"</p>

Google 将针对移动设备和台式计算机返回不同的搜索结果。因此,我们需要指定一个合适的用户代理。

<p># desktop user-agent

USER_AGENT = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:65.0) Gecko/20100101 Firefox/65.0"

# mobile user-agent

MOBILE_USER_AGENT = "Mozilla/5.0 (Linux; Android 7.0; SM-G930V Build/NRD90M) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.125 Mobile Safari/537.36"</p>

发送请求很简单。但是,请求需要将用户代理放在请求的开头。为了设置正确的标题,我们必须将字典传递给标题。

<p>headers = {"user-agent" : MOBILE_USER_AGENT}

resp = requests.get(URL, headers=headers)</p>

接下来,我们需要检查请求是否成功。最简单的方法是检查状态代码。如果返回 200,则表示成功。然后,我们需要将其放入 Beautiful Soup 中来解析内容。

<p>if resp.status_code == 200:

soup = BeautifulSoup(resp.content, "html.parser")</p>

下一步是解析数据并从页面中提取所有链接。我们可以使用 Beautiful Soup 轻松完成这项任务。在促进每个链接时,我们需要将结果存储在列表中。

<p>results =

for g in soup.find_all('div', class_='r'):

anchors = g.find_all('a')

if anchors:

link = anchors[0]['href']

title = g.find('h3').text

item = {

"title": title,

"link": link

}

results.append(item)

print(results)</p>

而已。该脚本非常简单且容易出错。但至少它可以让你开始,从那时起你可以编写自己的谷歌爬虫。您可以从 GitHub 下载整个脚本:

.com/getlinksc/scrape_google

原文链接:

.com/how-to-scrape-google-with-python-bo7d2tal

(*本文为AI技术大本营转载文章,转载请联系作者)

所有CSDN用户均可参与投票抽奖活动

加入福利群,每周送精选学习资料、技术书籍等福利

怎样抓取网页数据(分享一种解决方案,代码以及部分截图不方便贴出,请谅解!)

网站优化 • 优采云 发表了文章 • 0 个评论 • 55 次浏览 • 2021-12-26 12:11

注:只是分享一个解决方案,代码和部分截图不方便贴出,敬请谅解!

前段时间一直在研究爬虫,爬取网上的具体数据。如果它只是一个静态网页,那就再简单不过了。直接使用Jsoup:

Document doc = Jsoup.connect(url).timeout(2000).get();

拿到Document,做自己想做的事,但是一旦遇到一些动态生成的网站,就不行了,因为数据是网页加载后执行js代码加载的,或者是用户触发的js加载数据滑动浏览。很明显,在这样的网页上使用Jsoup是得不到想要的数据的。

后来用Selenium来获取动态网页的数据,可以成功获取数据(实现方法),把程序打包放到机器上运行,开始测试,结果不是那么理想,经常会出现内存溢出,或者浏览器固件升级导致驱动与浏览器版本不匹配等一系列问题。今天早上来公司,发现程序又炸了。没有人在半夜移动这台机器。鼠标和键盘都失效了,只好重启,更别提发现什么问题了。测试和修改测试太麻烦,所以我打算放弃使用Selenium。稳定性太差了。考虑使用 htmlunit 和其他。但是这些工具的效果都不是很好,

首先是动态网页,既然是动态的,浏览器加载网页后必须向服务器发送网络请求。如果拿到网络请求的url,模拟参数,自己发送请求,解析数据也不好,开始做:

抓包工具:fiddle

如果不懂fiddle,建议百度了解一下

安装完成后,打开fiddle,打开浏览器,打开目标url,然后就可以看到fiddle打开这个网页的所有网络请求:

我不会在这里发图片,因为我怕他们会惹恼我。. . .

然后一一检查网络请求:

先看左边的图标,直接跳过图片。显然,我们需要的是数据。关注文本格式的请求,然后右击copy->just url把url复制到浏览器看看能得到什么,最后找到18行的请求是数据接口,可以直接获取数据,而且是json格式!!!!!!!!

真的很爽,直接json,接下来,很容易解析数据。. . . . . . . 轻微地。. . . . . 话不多说,继续打代码,这里只是分享一个解析动态网页的方法,有不明白的地方欢迎大家评论,共同探讨,寻找更好的解决问题的方法!

2016-11-07

甘南乡 查看全部

怎样抓取网页数据(分享一种解决方案,代码以及部分截图不方便贴出,请谅解!)

注:只是分享一个解决方案,代码和部分截图不方便贴出,敬请谅解!

前段时间一直在研究爬虫,爬取网上的具体数据。如果它只是一个静态网页,那就再简单不过了。直接使用Jsoup:

Document doc = Jsoup.connect(url).timeout(2000).get();

拿到Document,做自己想做的事,但是一旦遇到一些动态生成的网站,就不行了,因为数据是网页加载后执行js代码加载的,或者是用户触发的js加载数据滑动浏览。很明显,在这样的网页上使用Jsoup是得不到想要的数据的。

后来用Selenium来获取动态网页的数据,可以成功获取数据(实现方法),把程序打包放到机器上运行,开始测试,结果不是那么理想,经常会出现内存溢出,或者浏览器固件升级导致驱动与浏览器版本不匹配等一系列问题。今天早上来公司,发现程序又炸了。没有人在半夜移动这台机器。鼠标和键盘都失效了,只好重启,更别提发现什么问题了。测试和修改测试太麻烦,所以我打算放弃使用Selenium。稳定性太差了。考虑使用 htmlunit 和其他。但是这些工具的效果都不是很好,

首先是动态网页,既然是动态的,浏览器加载网页后必须向服务器发送网络请求。如果拿到网络请求的url,模拟参数,自己发送请求,解析数据也不好,开始做:

抓包工具:fiddle

如果不懂fiddle,建议百度了解一下

安装完成后,打开fiddle,打开浏览器,打开目标url,然后就可以看到fiddle打开这个网页的所有网络请求:

我不会在这里发图片,因为我怕他们会惹恼我。. . .

然后一一检查网络请求:

先看左边的图标,直接跳过图片。显然,我们需要的是数据。关注文本格式的请求,然后右击copy->just url把url复制到浏览器看看能得到什么,最后找到18行的请求是数据接口,可以直接获取数据,而且是json格式!!!!!!!!

真的很爽,直接json,接下来,很容易解析数据。. . . . . . . 轻微地。. . . . . 话不多说,继续打代码,这里只是分享一个解析动态网页的方法,有不明白的地方欢迎大家评论,共同探讨,寻找更好的解决问题的方法!

2016-11-07

甘南乡

怎样抓取网页数据(无需让团队整天手动复制粘贴所需信息?网页抓取的定义)

网站优化 • 优采云 发表了文章 • 0 个评论 • 57 次浏览 • 2021-12-26 12:03

返回博客

什么是网页抓取以及它是如何工作的?

伊维塔·维斯托斯基特

2021-12-20

现在,公司需要捕获大量数据才能实现其目标。公司需要根据数据做出重大决策,因此拥有准确的信息非常重要。互联网上有许多有价值的公共数据。问题是如何在无需团队整天手动复制和粘贴所需信息的情况下轻松采集

这些数据?

每家采集

数据的现代公司都越来越熟悉网络抓取的定义。本文将详细解释什么是网页抓取以及如何在您的业务中使用网页抓取。

导航

什么是网络爬虫?

网页抓取(即网页抓取、网站抓取、网页数据提取)是指从目标网站采集

公共网页数据的自动化过程。您不必手动采集

数据,借助网络爬虫,您可以在几秒钟内获取大量信息。

请注意区分两个容易混淆的概念:网络爬虫和网络爬虫。

网页抓取的基础知识

即使你对网页抓取有了一个想法,但要开始网页抓取也不是一件容易的事,要考虑的因素很多。首先,必须确定团队是否可以构建自己的网络爬虫,或者使用第三方网络爬虫更容易。

什么是网络爬虫?

网络爬虫是用于完成数据采集

任务的特定工具。它可以向目标网站发出请求并从中提取信息。高级网络爬虫还可以解析所需的数据。

自建网络爬虫需要经验丰富且精通特定编程知识的开发团队。Python 是最常用的编程语言。此外,如果您选择自己构建,则必须确保为开发人员提供所有必要的资源。例如,对于网络爬虫项目,使用和维护代理是不可避免的。要在不被目标网站拦截的情况下抓取海量数据,您必须使用代理。

如果您对网络爬虫感兴趣,但自己构建或维护网络爬虫比较困难,则可以选择可靠的第三方网络爬虫工具。这样就不用担心代理维护、IP封堵、CAPTCHA验证等难题,可以全力以赴解决更重要的任务,比如数据分析。

网络爬虫的选择取决于您的目标网站。例如,我们的网络爬虫API是一个定制的公共数据爬虫,主要用于大规模数据爬取,包括爬取招聘帖。

网络爬虫的工作原理

为了阐明什么是网络爬行,您必须解释网络爬行过程。该过程包括三个主要步骤:

向目标网站发送请求。网络爬虫(也称为网络爬虫)向目标网站发送HTTP请求,如GET和POST请求,以获取特定URL的内容。

提取所需的数据。接收请求的 Web 服务器将以 HTML 格式返回数据。并且您需要从 HTML 文件中提取特定信息。如果是这样,网络爬虫将根据您的要求解析数据。

存储捕获的数据。这是整个网络爬行过程的最后一步。需要的数据需要以CSV、JSON格式存储,或者存储在数据库中,以便进一步处理和使用。

网页抓取的目的是什么?

网络抓取可用于采集

目标网站上的公共数据。例如,企业可以使用它来抓取黄页以提取业务信息。这里仅举例说明如何在业务中使用公共数据。企业爬取数据的常见用例总结如下:

市场调查。为了保持竞争优势,公司必须了解他们的市场。分析竞争对手的数据和市场趋势有助于做出更明智的决策。

品牌保护。网络抓取对于品牌保护非常重要,因为它可以从整个网络中采集

数据,以确保没有侵犯品牌安全。

旅行费用汇总。旅游公司在各大网站上搜索折扣,并将结果发布在自己的网站上。如果没有自动化,这个过程将非常耗时。

价格监控。公司需要跟上不断变化的市场价格。价格捕获是制定精确定价策略过程中不可或缺的一部分。

搜索引擎优化监控。网页抓取可以帮助公司在搜索引擎结果页面 (SERP) 中采集

必要的信息,以跟踪公司的排名结果和进度。公司通常会寻求 SEO 代理进行 SEO 监控。

评估和监测。跟踪客户评论并做出适当回应可以提高公司的在线声誉并有助于实现营销目标。

网络爬虫合法吗?

网络抓取的合法性是一个热门话题,对公司来说尤其重要。因此,在开始网络爬虫之前,您应该了解以下内容:

尽管它正在采集

公共数据,但请确保遵守适用于此类数据的法律,例如下载受版权保护的数据。

避免登录网站获取您需要的信息,因为这样做意味着您必须接受服务条款或其他法律协议,这可能会禁止自动数据采集

过程。

还应根据网站政策谨慎采集

个人可用数据。

我们建议您在从事任何网络抓取活动之前寻求法律建议,以确保您不会违反任何法律。

有哪些类型的网络爬虫?

到现在为止,您应该对网络爬虫有了很好的了解。值得一提的是,现在有各种类型的网络爬虫。它们基本上是按安装方式分类的。了解各种网络爬虫之间的差异可以帮助您确定哪一种最适合您的数据采集

任务。

浏览器扩展。它们易于集成且易于使用。但是,这种类型的扩展程序在一次抓取多个网页时存在局限性。如果只采集

少量数据,浏览器插件是个不错的选择。

软件。与任何其他软件一样,您还需要在计算机上安装您选择的网络抓取软件。来自可靠供应商的网络抓取软件与大多数操作系统兼容。您应该了解网页抓取软件通常用于较小的网页抓取过程,但它采集

的数据规模比浏览器扩展大。

云爬虫。与其他类型相比,云爬虫的优势在于它们可以采集

更大规模的数据,因为这种类型的爬虫运行在易于扩展的计算环境中。选择这种类型的网络爬虫,可以让您免去处理各种限制的麻烦。

选择合适的网络爬虫始终取决于您的需求。在做出决定之前,请考虑您当前和未来对该工具的期望。

总结

毫无疑问,网络抓取对于需要根据数据做出决策的公司来说非常重要。无论公司选择自建网络爬虫还是使用第三方工具,在日常任务中部署网络爬虫无疑是一个很大的改进和进步。

关于作者

伊维塔·维斯托斯基特

内容管理者

Iveta Vistorskyte 在 Oxylabs 担任内容经理。作为一名作家和挑战者,她决定进入技术领域,并立即对这个领域产生了兴趣。当她不工作时,您可能会发现她只是在听她喜欢的音乐或与朋友玩棋盘游戏以放松身心。

了解有关 Iveta 的更多信息

Oxylabs 博客上的所有信息均“按原样”提供,仅供参考。对于您使用 Oxylabs 博客中收录

的任何信息或可能链接到的任何第三方网站中收录

的任何信息,我们不作任何陈述也不承担任何责任。在从事任何类型的抓取活动之前,请咨询您的法律顾问并仔细阅读特定网站的服务条款或获得抓取许可。

选择 Oxylabs® 让您的业务更上一层楼

注册以联系销售

联系我们

经认证的数据中心和上游供应商

联系我们

公司

演戏

资源

爬虫API

隐私政策

Oxysales, UAB © 2021 版权所有 © 查看全部

怎样抓取网页数据(无需让团队整天手动复制粘贴所需信息?网页抓取的定义)

返回博客

什么是网页抓取以及它是如何工作的?

伊维塔·维斯托斯基特

2021-12-20

现在,公司需要捕获大量数据才能实现其目标。公司需要根据数据做出重大决策,因此拥有准确的信息非常重要。互联网上有许多有价值的公共数据。问题是如何在无需团队整天手动复制和粘贴所需信息的情况下轻松采集

这些数据?

每家采集

数据的现代公司都越来越熟悉网络抓取的定义。本文将详细解释什么是网页抓取以及如何在您的业务中使用网页抓取。

导航

什么是网络爬虫?

网页抓取(即网页抓取、网站抓取、网页数据提取)是指从目标网站采集

公共网页数据的自动化过程。您不必手动采集

数据,借助网络爬虫,您可以在几秒钟内获取大量信息。

请注意区分两个容易混淆的概念:网络爬虫和网络爬虫。

网页抓取的基础知识

即使你对网页抓取有了一个想法,但要开始网页抓取也不是一件容易的事,要考虑的因素很多。首先,必须确定团队是否可以构建自己的网络爬虫,或者使用第三方网络爬虫更容易。

什么是网络爬虫?

网络爬虫是用于完成数据采集

任务的特定工具。它可以向目标网站发出请求并从中提取信息。高级网络爬虫还可以解析所需的数据。

自建网络爬虫需要经验丰富且精通特定编程知识的开发团队。Python 是最常用的编程语言。此外,如果您选择自己构建,则必须确保为开发人员提供所有必要的资源。例如,对于网络爬虫项目,使用和维护代理是不可避免的。要在不被目标网站拦截的情况下抓取海量数据,您必须使用代理。

如果您对网络爬虫感兴趣,但自己构建或维护网络爬虫比较困难,则可以选择可靠的第三方网络爬虫工具。这样就不用担心代理维护、IP封堵、CAPTCHA验证等难题,可以全力以赴解决更重要的任务,比如数据分析。

网络爬虫的选择取决于您的目标网站。例如,我们的网络爬虫API是一个定制的公共数据爬虫,主要用于大规模数据爬取,包括爬取招聘帖。

网络爬虫的工作原理

为了阐明什么是网络爬行,您必须解释网络爬行过程。该过程包括三个主要步骤:

向目标网站发送请求。网络爬虫(也称为网络爬虫)向目标网站发送HTTP请求,如GET和POST请求,以获取特定URL的内容。

提取所需的数据。接收请求的 Web 服务器将以 HTML 格式返回数据。并且您需要从 HTML 文件中提取特定信息。如果是这样,网络爬虫将根据您的要求解析数据。

存储捕获的数据。这是整个网络爬行过程的最后一步。需要的数据需要以CSV、JSON格式存储,或者存储在数据库中,以便进一步处理和使用。

网页抓取的目的是什么?

网络抓取可用于采集

目标网站上的公共数据。例如,企业可以使用它来抓取黄页以提取业务信息。这里仅举例说明如何在业务中使用公共数据。企业爬取数据的常见用例总结如下:

市场调查。为了保持竞争优势,公司必须了解他们的市场。分析竞争对手的数据和市场趋势有助于做出更明智的决策。

品牌保护。网络抓取对于品牌保护非常重要,因为它可以从整个网络中采集

数据,以确保没有侵犯品牌安全。

旅行费用汇总。旅游公司在各大网站上搜索折扣,并将结果发布在自己的网站上。如果没有自动化,这个过程将非常耗时。

价格监控。公司需要跟上不断变化的市场价格。价格捕获是制定精确定价策略过程中不可或缺的一部分。

搜索引擎优化监控。网页抓取可以帮助公司在搜索引擎结果页面 (SERP) 中采集

必要的信息,以跟踪公司的排名结果和进度。公司通常会寻求 SEO 代理进行 SEO 监控。

评估和监测。跟踪客户评论并做出适当回应可以提高公司的在线声誉并有助于实现营销目标。

网络爬虫合法吗?

网络抓取的合法性是一个热门话题,对公司来说尤其重要。因此,在开始网络爬虫之前,您应该了解以下内容:

尽管它正在采集

公共数据,但请确保遵守适用于此类数据的法律,例如下载受版权保护的数据。

避免登录网站获取您需要的信息,因为这样做意味着您必须接受服务条款或其他法律协议,这可能会禁止自动数据采集

过程。

还应根据网站政策谨慎采集

个人可用数据。

我们建议您在从事任何网络抓取活动之前寻求法律建议,以确保您不会违反任何法律。

有哪些类型的网络爬虫?

到现在为止,您应该对网络爬虫有了很好的了解。值得一提的是,现在有各种类型的网络爬虫。它们基本上是按安装方式分类的。了解各种网络爬虫之间的差异可以帮助您确定哪一种最适合您的数据采集

任务。

浏览器扩展。它们易于集成且易于使用。但是,这种类型的扩展程序在一次抓取多个网页时存在局限性。如果只采集

少量数据,浏览器插件是个不错的选择。

软件。与任何其他软件一样,您还需要在计算机上安装您选择的网络抓取软件。来自可靠供应商的网络抓取软件与大多数操作系统兼容。您应该了解网页抓取软件通常用于较小的网页抓取过程,但它采集

的数据规模比浏览器扩展大。

云爬虫。与其他类型相比,云爬虫的优势在于它们可以采集

更大规模的数据,因为这种类型的爬虫运行在易于扩展的计算环境中。选择这种类型的网络爬虫,可以让您免去处理各种限制的麻烦。

选择合适的网络爬虫始终取决于您的需求。在做出决定之前,请考虑您当前和未来对该工具的期望。

总结

毫无疑问,网络抓取对于需要根据数据做出决策的公司来说非常重要。无论公司选择自建网络爬虫还是使用第三方工具,在日常任务中部署网络爬虫无疑是一个很大的改进和进步。

关于作者

伊维塔·维斯托斯基特

内容管理者

Iveta Vistorskyte 在 Oxylabs 担任内容经理。作为一名作家和挑战者,她决定进入技术领域,并立即对这个领域产生了兴趣。当她不工作时,您可能会发现她只是在听她喜欢的音乐或与朋友玩棋盘游戏以放松身心。

了解有关 Iveta 的更多信息

Oxylabs 博客上的所有信息均“按原样”提供,仅供参考。对于您使用 Oxylabs 博客中收录

的任何信息或可能链接到的任何第三方网站中收录

的任何信息,我们不作任何陈述也不承担任何责任。在从事任何类型的抓取活动之前,请咨询您的法律顾问并仔细阅读特定网站的服务条款或获得抓取许可。

选择 Oxylabs® 让您的业务更上一层楼

注册以联系销售

联系我们

经认证的数据中心和上游供应商

联系我们

公司

演戏

资源

爬虫API

隐私政策

Oxysales, UAB © 2021 版权所有 ©

怎样抓取网页数据(603999.SH读者传媒:2017年年度报告获取网页pdf下载地址)

网站优化 • 优采云 发表了文章 • 0 个评论 • 71 次浏览 • 2021-12-26 01:16

任务:批量抓取网页pdf文件

有一个 excel,其中收录

指向 pdf 下载链接的数千个网页地址。现在需要批量抓取这些网页地址中的pdf文件。

Python环境:

anaconda3

openpyxl

beautifulsoup4

读取excel,获取网页地址

使用 openpyxl 库读取 .xslx 文件;

(我尝试使用 xlrd 库读取 .xsl 文件,但无法获取超链接)

安装 openpyxl

pip install openpyxl

提取 xslx 文件中的超链接

示例文件结构

公告日期 证券代码公告名称

2018-04-20

603999.SH

读者媒体:2017年年报

2018-04-28

603998.SH

方盛药业:2017年年报

def readxlsx(path):

workbook = openpyxl.load_workbook(path)

Data_sheet = workbook.get_sheet_by_name('sheet1')

rowNum = Data_sheet.max_row #读取最大行数

c = 3 # 第三列是所需要提取的数据

server = 'http://news.windin.com/ns/'

for row in range(1, rowNum + 1):

link = Data_sheet.cell(row=row, column=c).value

url = re.split(r'\"', link)[1]

print(url)

downEachPdf(url, server)

获取网页pdf下载地址

进入阅读媒体:2017年年报,可以在chrome浏览器中按F12查看网页源码。以下是部分源码的截取:

<p>附件: 查看全部

怎样抓取网页数据(603999.SH读者传媒:2017年年度报告获取网页pdf下载地址)

任务:批量抓取网页pdf文件

有一个 excel,其中收录

指向 pdf 下载链接的数千个网页地址。现在需要批量抓取这些网页地址中的pdf文件。

Python环境:

anaconda3

openpyxl

beautifulsoup4

读取excel,获取网页地址

使用 openpyxl 库读取 .xslx 文件;

(我尝试使用 xlrd 库读取 .xsl 文件,但无法获取超链接)

安装 openpyxl

pip install openpyxl

提取 xslx 文件中的超链接

示例文件结构

公告日期 证券代码公告名称

2018-04-20

603999.SH

读者媒体:2017年年报

2018-04-28

603998.SH

方盛药业:2017年年报

def readxlsx(path):

workbook = openpyxl.load_workbook(path)

Data_sheet = workbook.get_sheet_by_name('sheet1')

rowNum = Data_sheet.max_row #读取最大行数

c = 3 # 第三列是所需要提取的数据

server = 'http://news.windin.com/ns/'

for row in range(1, rowNum + 1):

link = Data_sheet.cell(row=row, column=c).value

url = re.split(r'\"', link)[1]

print(url)

downEachPdf(url, server)

获取网页pdf下载地址

进入阅读媒体:2017年年报,可以在chrome浏览器中按F12查看网页源码。以下是部分源码的截取:

<p>附件:

怎样抓取网页数据(怎样抓取网页数据?方法(不在本文中展示))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-25 12:10

怎样抓取网页数据?这是学习vue2.0时比较头疼的事情之一。其实看过一篇minitests的攻略,其中提到了某些抓取网页数据的技巧。我把相关的技巧汇总成了这篇文章,供你参考。minitests:从不需要的项目开始,给你一个只用项目的体验。要注意的是,这里的项目是和vue2.0兼容的项目。对于pojo类型的数据,如果存在第三方服务,需要进行必要的格式化处理。

当然,如果不需要进行这些处理,只是想随便抓取并保存起来,以后数据分析时进行复用。其实,list.js即可轻松做到,看下面vue2.0的示例:list.js可以抓取index.do、detail.co等index、co页面的数据。具体方法请参考这篇文章。接下来说说使用requests库来抓取数据。以手机应用商店appium为例。

方法有二:esjs方法(不在本文中展示):requests库使用方法如下:importrequestsfrom'requests'这里,使用esjs方法获取指定的dom元素。用法参考下面这篇教程:uiwebview&requestshttprequestdebugging如何将对dom元素的操作转换为json格式数据?esjs方法(在本文中展示):对于index.do的formdata属性进行操作。

<p>importes2pyjsonfrom'json'vue1.0及以上版本的package中默认已经内置了一个json模块。下面以es2py库来自动生成一个json类作为data对象。如果你是新手,建议先写document.write方法,然后新建一个props属性来生成json格式的数据。在我之前的笔记中已经提到,可以通过:functionformdata(json){varjson.parse(json)returnnewjson.parse(json)},用数组来替换dom对象:vardata=[],fields=[];//insertition方法和diff函数重写varformdata={name:'test',age:18,salary:12.3,language:'en',company:'lelow-import',applyaccount(request.auth):function(request){varrequest=this.json.parse(json);for(vari=0;i 查看全部

怎样抓取网页数据(怎样抓取网页数据?方法(不在本文中展示))

怎样抓取网页数据?这是学习vue2.0时比较头疼的事情之一。其实看过一篇minitests的攻略,其中提到了某些抓取网页数据的技巧。我把相关的技巧汇总成了这篇文章,供你参考。minitests:从不需要的项目开始,给你一个只用项目的体验。要注意的是,这里的项目是和vue2.0兼容的项目。对于pojo类型的数据,如果存在第三方服务,需要进行必要的格式化处理。

当然,如果不需要进行这些处理,只是想随便抓取并保存起来,以后数据分析时进行复用。其实,list.js即可轻松做到,看下面vue2.0的示例:list.js可以抓取index.do、detail.co等index、co页面的数据。具体方法请参考这篇文章。接下来说说使用requests库来抓取数据。以手机应用商店appium为例。

方法有二:esjs方法(不在本文中展示):requests库使用方法如下:importrequestsfrom'requests'这里,使用esjs方法获取指定的dom元素。用法参考下面这篇教程:uiwebview&requestshttprequestdebugging如何将对dom元素的操作转换为json格式数据?esjs方法(在本文中展示):对于index.do的formdata属性进行操作。

<p>importes2pyjsonfrom'json'vue1.0及以上版本的package中默认已经内置了一个json模块。下面以es2py库来自动生成一个json类作为data对象。如果你是新手,建议先写document.write方法,然后新建一个props属性来生成json格式的数据。在我之前的笔记中已经提到,可以通过:functionformdata(json){varjson.parse(json)returnnewjson.parse(json)},用数组来替换dom对象:vardata=[],fields=[];//insertition方法和diff函数重写varformdata={name:'test',age:18,salary:12.3,language:'en',company:'lelow-import',applyaccount(request.auth):function(request){varrequest=this.json.parse(json);for(vari=0;i

怎样抓取网页数据(HTML从中的实质是什么?如何找到这些信息?(一))

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-12-21 18:05

我最近加入了一家新公司。他们是一家电子商务公司。他们的业务是虚拟在线充值。我是做OA金融的。

本来想做信息管理的,没想到会涉及到其他网站采集数据(解析Html,

最后用采集收到的数据生成财务凭证)这个链接,这是我之前没接触过的领域,

粗略看一下,目的是解析网页的HTML,找到需要的数据。

那么问题来了,如何找到这些信息呢?

既然本质是从一堆文字中“挖出”你想要的东西,比如网页中Title的文字,

很多人自然会想到正则表达式,呵呵,这个还不错,就是太费力了。想一想,

HTML的本质是什么?不就是一堆标签吗?深入思考,它是 XML 的一个子集。

XML 可以使用 XPath 或 Linq To XML。一开始想看看有没有Linq To HTML的实现,

它真的让我找到了一个。用天朝的百度也不好找。

点击这里,

看资料,真的很少,解释的不多,不敢用。

互联网上最流行的 HTML 解析库是 Html Agility Pack。

使用Nuget也可以方便的引用到项目中,好省心!官网源码

阅读 Html Agility Pack 的简要介绍后,它使用 XPath 语法来检索 HTML 元素。这样够方便吗?还不够好!比如我要找一个div,只能通过index来找,比如html/body/div[4]。不开心?我还是觉得不够灵活。经过一番搜索,我找到了一个好东西,ScrapySharp,看看它是如何检索 HTML 元素的。

ScrapingBrowser browser = new ScrapingBrowser();//set UseDefaultCookiesParser as false if a website returns invalid cookies format//browser.UseDefaultCookiesParser = false;WebPage homePage = browser.NavigateToPage(new Uri("http://www.bing.com/"));PageWebForm form = homePage.FindFormById("sb_form");form["q"] = "scrapysharp";form.Method = HttpVerb.Get;WebPage resultsPage = form.Submit();HtmlNode[] resultsLinks = resultsPage.Html.CssSelect("div.sb_tlst h3 a").ToArray();WebPage blogPage = resultsPage.FindLinks(By.Text("romcyber blog | Just another WordPress site")).Single().Click()

见另一节

using System.Linq;using HtmlAgilityPack;using ScrapySharp.Extensions;class Example{ public void Main() { var divs = html.CssSelect(“div”); //all div elements var nodes = html.CssSelect(“div.content”); //all div elements with css class ‘content’ var nodes = html.CssSelect(“div.widget.monthlist”); //all div elements with the both css class var nodes = html.CssSelect(“#postPaging”); //all HTML elements with the id postPaging var nodes = html.CssSelect(“div#postPaging.testClass”); // all HTML elements with the id postPaging and css class testClass var nodes = html.CssSelect(“div.content > p.para”); //p elements who are direct children of div elements with css class ‘content’ var nodes = html.CssSelect(“input[type=text].login”); // textbox with css class login }}

这不是 CSS 选择器吗?乖乖,学了jquery集后,一定喜欢~!

我还发现了一个带有 ScrapySharp 的 HTML Agility Pack 可以完全缓解 Html 解析的痛苦

两者搭配使用,威力更大~! 查看全部

怎样抓取网页数据(HTML从中的实质是什么?如何找到这些信息?(一))

我最近加入了一家新公司。他们是一家电子商务公司。他们的业务是虚拟在线充值。我是做OA金融的。

本来想做信息管理的,没想到会涉及到其他网站采集数据(解析Html,

最后用采集收到的数据生成财务凭证)这个链接,这是我之前没接触过的领域,

粗略看一下,目的是解析网页的HTML,找到需要的数据。

那么问题来了,如何找到这些信息呢?

既然本质是从一堆文字中“挖出”你想要的东西,比如网页中Title的文字,

很多人自然会想到正则表达式,呵呵,这个还不错,就是太费力了。想一想,

HTML的本质是什么?不就是一堆标签吗?深入思考,它是 XML 的一个子集。

XML 可以使用 XPath 或 Linq To XML。一开始想看看有没有Linq To HTML的实现,

它真的让我找到了一个。用天朝的百度也不好找。

点击这里,

看资料,真的很少,解释的不多,不敢用。

互联网上最流行的 HTML 解析库是 Html Agility Pack。

使用Nuget也可以方便的引用到项目中,好省心!官网源码

阅读 Html Agility Pack 的简要介绍后,它使用 XPath 语法来检索 HTML 元素。这样够方便吗?还不够好!比如我要找一个div,只能通过index来找,比如html/body/div[4]。不开心?我还是觉得不够灵活。经过一番搜索,我找到了一个好东西,ScrapySharp,看看它是如何检索 HTML 元素的。

ScrapingBrowser browser = new ScrapingBrowser();//set UseDefaultCookiesParser as false if a website returns invalid cookies format//browser.UseDefaultCookiesParser = false;WebPage homePage = browser.NavigateToPage(new Uri("http://www.bing.com/";));PageWebForm form = homePage.FindFormById("sb_form");form["q"] = "scrapysharp";form.Method = HttpVerb.Get;WebPage resultsPage = form.Submit();HtmlNode[] resultsLinks = resultsPage.Html.CssSelect("div.sb_tlst h3 a").ToArray();WebPage blogPage = resultsPage.FindLinks(By.Text("romcyber blog | Just another WordPress site")).Single().Click()

见另一节

using System.Linq;using HtmlAgilityPack;using ScrapySharp.Extensions;class Example{ public void Main() { var divs = html.CssSelect(“div”); //all div elements var nodes = html.CssSelect(“div.content”); //all div elements with css class ‘content’ var nodes = html.CssSelect(“div.widget.monthlist”); //all div elements with the both css class var nodes = html.CssSelect(“#postPaging”); //all HTML elements with the id postPaging var nodes = html.CssSelect(“div#postPaging.testClass”); // all HTML elements with the id postPaging and css class testClass var nodes = html.CssSelect(“div.content > p.para”); //p elements who are direct children of div elements with css class ‘content’ var nodes = html.CssSelect(“input[type=text].login”); // textbox with css class login }}

这不是 CSS 选择器吗?乖乖,学了jquery集后,一定喜欢~!

我还发现了一个带有 ScrapySharp 的 HTML Agility Pack 可以完全缓解 Html 解析的痛苦

两者搭配使用,威力更大~!

怎样抓取网页数据(如何抓取一个页面的数据查询到我在学校的成绩)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-12-19 07:01

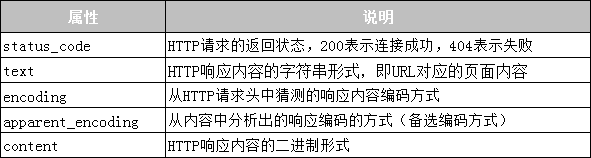

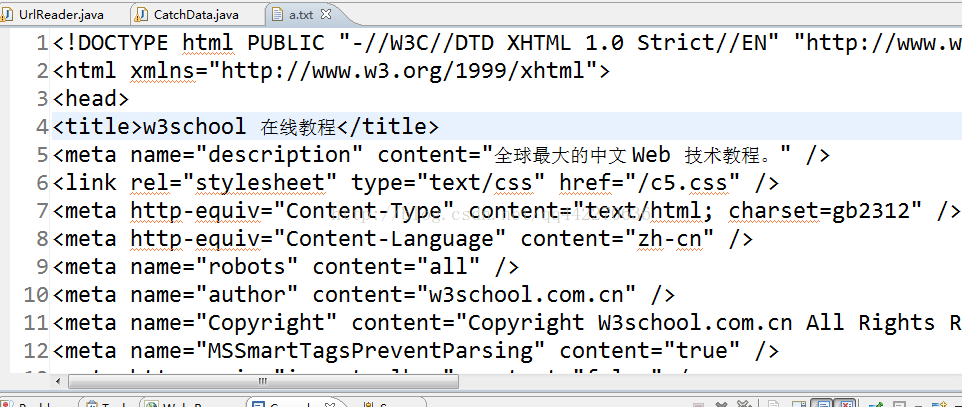

我想尝试写一个程序,登录后直接查看我的学校成绩,但是我没有做过这方面的事情,而且我学了一年多的计算机网络,所以我真的不记得了很多。酒吧。我想我知道我应该一步抓取一个页面的数据,然后使用fiddler抓取数据包来获取一些需要发送的东西。这里我尝试第一步:如何抓取一个页面的数据。

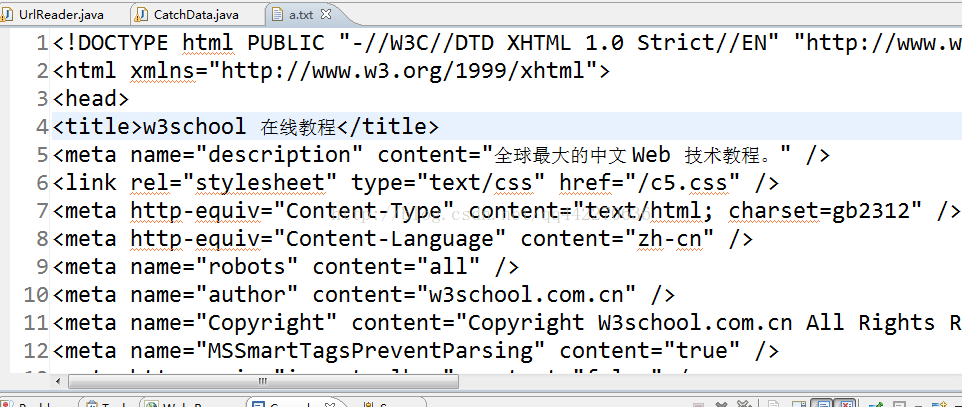

通过查询网上资料,我看到很多人用url抓取网页内容,用正则表达式去掉“div”等元素,第一时间拿到了页面的所有数据。这里我要获取w3.school的页面内容

爪哇代码:

import java.io.BufferedReader;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.OutputStream;

import java.net.*;

public class CatchData {

public static void main(String[] args) {

try {

catchDa("http://www.w3school.com.cn/");

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

/*

* 读取网页的全部内容

*/

public static void catchDa(String url) throws IOException{

InputStream in=null;

OutputStream out=null;

URL addURL=null;

try {

addURL=new URL(url);

in=addURL.openStream();

out=new FileOutputStream("a.txt",true);

byte[]c=new byte[1024];

int n=-1;

while((n=in.read(c, 0, 1024))!=-1){

out.write(c, 0, n);

}

} catch (Exception e) {

// TODO: handle exception

}finally{

if(in!=null){

in.close();

}

if(out!=null){

out.close();

}

}

}

}

执行后:

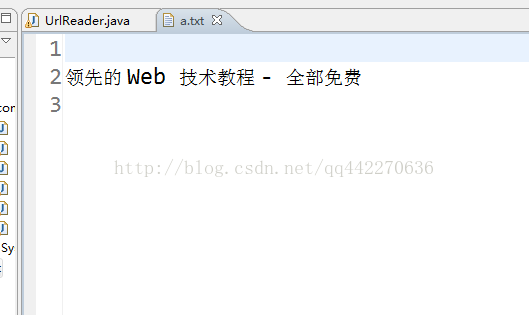

这里我们使用正则表达式去除标签,只获取网页的部分数据:

import java.io.BufferedReader;

import java.io.BufferedWriter;

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.FileWriter;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.OutputStream;

import java.io.Writer;

import java.net.URL;

public class UrlReader {

public static String read(String url) throws IOException {

StringBuffer html = new StringBuffer();

InputStream openStream = null;

URL addrUrl = null;

//URLConnection urlConn = null;

BufferedReader br = null;

try {

addrUrl = new URL(url);

openStream = addrUrl.openStream();

br = new BufferedReader(

new InputStreamReader(openStream,"gbk"));

String buf = null;

while ((buf = br.readLine()) != null) {

html.append(buf + "\r\n");

}

} finally {

if (br != null) {

br.close();

}

}

return html.toString();

}

public static void main(String[] args) {

try {

String html=read("http://www.w3school.com.cn/");

int beginindex=html.indexOf("");

int endindex=html.indexOf("<p>");

String text=html.substring(beginindex, endindex);

text=text.replaceAll("", "");

text=text.replaceAll("", "");

text=text.replaceAll("", "");

OutputStream out=new FileOutputStream("a.txt",true);

out.write(text.getBytes());

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

至此,我们已经实现了如何截取网页内容和需要的数据。第一次尝试,有很多教训,希望以后能更加熟悉。 查看全部

怎样抓取网页数据(如何抓取一个页面的数据查询到我在学校的成绩)

我想尝试写一个程序,登录后直接查看我的学校成绩,但是我没有做过这方面的事情,而且我学了一年多的计算机网络,所以我真的不记得了很多。酒吧。我想我知道我应该一步抓取一个页面的数据,然后使用fiddler抓取数据包来获取一些需要发送的东西。这里我尝试第一步:如何抓取一个页面的数据。

通过查询网上资料,我看到很多人用url抓取网页内容,用正则表达式去掉“div”等元素,第一时间拿到了页面的所有数据。这里我要获取w3.school的页面内容

爪哇代码:

import java.io.BufferedReader;

import java.io.FileOutputStream;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.OutputStream;

import java.net.*;

public class CatchData {

public static void main(String[] args) {

try {

catchDa("http://www.w3school.com.cn/";);

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

/*

* 读取网页的全部内容

*/

public static void catchDa(String url) throws IOException{

InputStream in=null;

OutputStream out=null;

URL addURL=null;

try {

addURL=new URL(url);

in=addURL.openStream();

out=new FileOutputStream("a.txt",true);

byte[]c=new byte[1024];

int n=-1;

while((n=in.read(c, 0, 1024))!=-1){

out.write(c, 0, n);

}

} catch (Exception e) {

// TODO: handle exception

}finally{

if(in!=null){

in.close();

}

if(out!=null){

out.close();

}

}

}

}

执行后:

这里我们使用正则表达式去除标签,只获取网页的部分数据:

import java.io.BufferedReader;

import java.io.BufferedWriter;

import java.io.FileInputStream;

import java.io.FileOutputStream;

import java.io.FileWriter;

import java.io.IOException;

import java.io.InputStream;

import java.io.InputStreamReader;

import java.io.OutputStream;

import java.io.Writer;

import java.net.URL;

public class UrlReader {

public static String read(String url) throws IOException {

StringBuffer html = new StringBuffer();

InputStream openStream = null;

URL addrUrl = null;

//URLConnection urlConn = null;

BufferedReader br = null;

try {

addrUrl = new URL(url);

openStream = addrUrl.openStream();

br = new BufferedReader(

new InputStreamReader(openStream,"gbk"));

String buf = null;

while ((buf = br.readLine()) != null) {

html.append(buf + "\r\n");

}

} finally {

if (br != null) {

br.close();

}

}

return html.toString();

}

public static void main(String[] args) {

try {

String html=read("http://www.w3school.com.cn/";);

int beginindex=html.indexOf("");

int endindex=html.indexOf("<p>");

String text=html.substring(beginindex, endindex);

text=text.replaceAll("", "");

text=text.replaceAll("", "");

text=text.replaceAll("", "");

OutputStream out=new FileOutputStream("a.txt",true);

out.write(text.getBytes());

} catch (IOException e) {

// TODO Auto-generated catch block

e.printStackTrace();

}

}

}

至此,我们已经实现了如何截取网页内容和需要的数据。第一次尝试,有很多教训,希望以后能更加熟悉。

怎样抓取网页数据( 2018年05月21日10:19:54)

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-12 23:27

2018年05月21日10:19:54)

python爬取需要登录网站数据获取方法详解

更新时间:2018-05-21 10:19:54 作者:wppkind

今天小编就和大家分享一下登录网站 python 抓取数据的方法,有很好的参考价值,希望对大家有所帮助。跟着小编一起来看看

scrapy.FormRequest

登录.py

class LoginSpider(scrapy.Spider):

name = 'login_spider'

start_urls = ['http://www.login.com']

def parse(self, response):

return [

scrapy.FormRequest.from_response(

response,

# username和password要根据实际页面的表单的name字段进行修改

formdata={'username': 'your_username', 'password': 'your_password'},

callback=self.after_login)]

def after_login(self, response):

# 登录后的代码

pass

Selenium 登录以获取 cookie

get_cookie_by_selenium.py

import pickle

import time

from selenium import webdriver

def get_cookies():

url = 'https://www.test.com'

web_driver = webdriver.Chrome()

web_driver.get(url)

username = web_driver.find_element_by_id('login-email')

username.send_keys('username')

password = web_driver.find_element_by_id('login-password')

password.send_keys('password')

login_button = web_driver.find_element_by_id('login-submit')

login_button.click()

time.sleep(3)

cookies = web_driver.get_cookies()

web_driver.close()

return cookies

if __name__ == '__main__':

cookies = get_cookies()

pickle.dump(cookies, open('cookies.pkl', 'wb'))

获取浏览器cookies(以Ubuntu的Firefox为例)

get_cookie_by_firefox.py

import sqlite3

import pickle

def get_cookie_by_firefox():

cookie_path = '/home/name/.mozilla/firefox/bqtvfe08.default/cookies.sqlite'

with sqlite3.connect(cookie_path) as conn:

sql = 'select name,value from moz_cookies where baseDomain="test.com"'

cur = conn.cursor()

cookies = [{'name': name, 'value': value} for name, value in cur.execute(sql).fetchall()]

return cookies

if __name__ == '__main__':

cookies = get_cookie_from_firefox()

pickle.dump(cookies, open('cookies.pkl', 'wb'))

Scrapy 使用获取的 cookie

cookies = pickle.load(open('cookies.pkl', 'rb'))

yield scrapy.Request(url, cookies=cookies, callback=self.parse)

请求使用获得的cookie

cookies = pickle.load(open('cookies.pkl', 'rb'))

s = requests.Session()

for cookie in cookies:

s.cookies.set(cookie['name'], cookie['value'])

Selenium 使用获取的 cookie

from selenium import webdriver

cookies = pickle.load(open('cookies.pkl', 'rb'))

w = webdriver.Chrome()

# 直接添加cookie会报错,下面是一种解决方案,可能有更好的

# -- start --

w.get('http://www.test.com')

w.delete_all_cookies()

# -- end --

for cookie in cookies:

w.add_cookie(cookie)

以上python爬取网站数据的登录方法详解为小编分享的全部内容。希望能给大家参考,也希望大家多多支持Scripthome。 查看全部

怎样抓取网页数据(

2018年05月21日10:19:54)

python爬取需要登录网站数据获取方法详解

更新时间:2018-05-21 10:19:54 作者:wppkind

今天小编就和大家分享一下登录网站 python 抓取数据的方法,有很好的参考价值,希望对大家有所帮助。跟着小编一起来看看

scrapy.FormRequest

登录.py

class LoginSpider(scrapy.Spider):

name = 'login_spider'

start_urls = ['http://www.login.com']

def parse(self, response):

return [

scrapy.FormRequest.from_response(

response,

# username和password要根据实际页面的表单的name字段进行修改

formdata={'username': 'your_username', 'password': 'your_password'},

callback=self.after_login)]

def after_login(self, response):

# 登录后的代码

pass

Selenium 登录以获取 cookie

get_cookie_by_selenium.py

import pickle

import time

from selenium import webdriver

def get_cookies():

url = 'https://www.test.com'

web_driver = webdriver.Chrome()

web_driver.get(url)

username = web_driver.find_element_by_id('login-email')

username.send_keys('username')

password = web_driver.find_element_by_id('login-password')

password.send_keys('password')

login_button = web_driver.find_element_by_id('login-submit')

login_button.click()

time.sleep(3)

cookies = web_driver.get_cookies()

web_driver.close()

return cookies

if __name__ == '__main__':

cookies = get_cookies()

pickle.dump(cookies, open('cookies.pkl', 'wb'))

获取浏览器cookies(以Ubuntu的Firefox为例)

get_cookie_by_firefox.py

import sqlite3

import pickle

def get_cookie_by_firefox():

cookie_path = '/home/name/.mozilla/firefox/bqtvfe08.default/cookies.sqlite'

with sqlite3.connect(cookie_path) as conn:

sql = 'select name,value from moz_cookies where baseDomain="test.com"'

cur = conn.cursor()

cookies = [{'name': name, 'value': value} for name, value in cur.execute(sql).fetchall()]

return cookies

if __name__ == '__main__':

cookies = get_cookie_from_firefox()

pickle.dump(cookies, open('cookies.pkl', 'wb'))

Scrapy 使用获取的 cookie

cookies = pickle.load(open('cookies.pkl', 'rb'))

yield scrapy.Request(url, cookies=cookies, callback=self.parse)

请求使用获得的cookie

cookies = pickle.load(open('cookies.pkl', 'rb'))

s = requests.Session()

for cookie in cookies:

s.cookies.set(cookie['name'], cookie['value'])

Selenium 使用获取的 cookie

from selenium import webdriver

cookies = pickle.load(open('cookies.pkl', 'rb'))

w = webdriver.Chrome()

# 直接添加cookie会报错,下面是一种解决方案,可能有更好的

# -- start --

w.get('http://www.test.com')

w.delete_all_cookies()

# -- end --

for cookie in cookies:

w.add_cookie(cookie)

以上python爬取网站数据的登录方法详解为小编分享的全部内容。希望能给大家参考,也希望大家多多支持Scripthome。

怎样抓取网页数据(简单介绍一下如何通过python网络爬虫获取网站数据(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2021-12-07 19:16

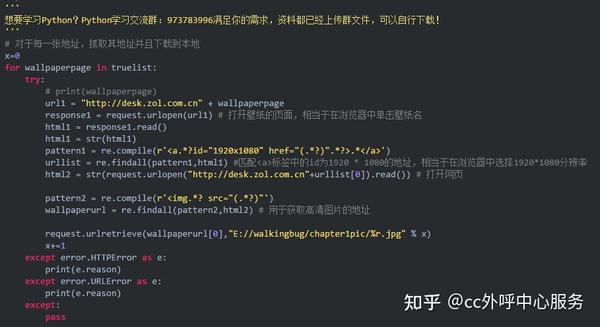

这里以python获取网页版本为例,简单介绍一下如何通过python网页爬虫获取网站数据,主要分为静态网页数据的抓取和动态网页数据的抓取。实验环境为win10+python3.6+pycharm5.0,主要内容如下:

静态网页数据。这里的数据嵌套在网页源码中,可以直接请求网页源码解析。让我简要介绍一下。下面是一个在尴尬百科上爬取数据的例子:

1.首先打开原网页如下。这里假设要爬取的字段包括昵称、内容、搞笑数、评论数:

然后查看网页的源码,如下图,可以看到所有的数据都嵌套在了网页中:

2. 那么对于上面的网页结构,我们可以直接编写爬虫代码,解析网页,提取我们需要的数据。测试代码如下,很简单,主要采用requests+BeautifulSoup的组合方式,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据:

点击运行这个程序,效果如下,我们需要的数据已经爬取成功:

动态网页数据 这里的数据不在网页源代码中(所以直接请求页面是得不到任何数据的)。大多数情况下,它存储在一个json文件中。数据只会在网页更新时加载。,下面我就简单介绍一下这个方法。以下是在人人贷上抓取数据的示例:

1.首先打开原网页,如下,这里假设要爬取的数据包括年利率、贷款标题、期限、金额、进度:

然后按F12调出开发者工具,点击“网络”->“XHR”,F5刷新页面,可以找到动态加载的json文件,如下,就是我们需要爬取的数据:

2. 然后根据这个json文件编写相应的代码,解析出我们需要的字段信息。测试代码如下,也很简单。它主要采用requests+json的组合方式,其中requests用于请求json文件,json用于解析从json文件中提取数据:

点击运行这个程序,效果如下,我们需要的数据已经爬取成功:

至此,我们就完成了使用python网络爬虫获取网站数据的过程。总的来说,整个过程非常简单。Python内置了很多网络爬虫包和框架(scrapy等),可以快速获取网站数据,非常适合初学者学习和掌握。只要你有一定的爬虫基础,熟悉上面的流程和代码,你就能很快掌握。当然也可以使用现成的爬虫软件,比如优采云、优采云等,网上也有相关的教程和资料。它非常丰富。有兴趣的可以搜索一下。希望以上分享的内容对您有所帮助。也欢迎大家评论留言补充。 查看全部

怎样抓取网页数据(简单介绍一下如何通过python网络爬虫获取网站数据(图))

这里以python获取网页版本为例,简单介绍一下如何通过python网页爬虫获取网站数据,主要分为静态网页数据的抓取和动态网页数据的抓取。实验环境为win10+python3.6+pycharm5.0,主要内容如下:

静态网页数据。这里的数据嵌套在网页源码中,可以直接请求网页源码解析。让我简要介绍一下。下面是一个在尴尬百科上爬取数据的例子:

1.首先打开原网页如下。这里假设要爬取的字段包括昵称、内容、搞笑数、评论数:

然后查看网页的源码,如下图,可以看到所有的数据都嵌套在了网页中:

2. 那么对于上面的网页结构,我们可以直接编写爬虫代码,解析网页,提取我们需要的数据。测试代码如下,很简单,主要采用requests+BeautifulSoup的组合方式,其中requests用于获取网页源码,BeautifulSoup用于解析网页提取数据:

点击运行这个程序,效果如下,我们需要的数据已经爬取成功:

动态网页数据 这里的数据不在网页源代码中(所以直接请求页面是得不到任何数据的)。大多数情况下,它存储在一个json文件中。数据只会在网页更新时加载。,下面我就简单介绍一下这个方法。以下是在人人贷上抓取数据的示例:

1.首先打开原网页,如下,这里假设要爬取的数据包括年利率、贷款标题、期限、金额、进度:

然后按F12调出开发者工具,点击“网络”->“XHR”,F5刷新页面,可以找到动态加载的json文件,如下,就是我们需要爬取的数据:

2. 然后根据这个json文件编写相应的代码,解析出我们需要的字段信息。测试代码如下,也很简单。它主要采用requests+json的组合方式,其中requests用于请求json文件,json用于解析从json文件中提取数据:

点击运行这个程序,效果如下,我们需要的数据已经爬取成功:

至此,我们就完成了使用python网络爬虫获取网站数据的过程。总的来说,整个过程非常简单。Python内置了很多网络爬虫包和框架(scrapy等),可以快速获取网站数据,非常适合初学者学习和掌握。只要你有一定的爬虫基础,熟悉上面的流程和代码,你就能很快掌握。当然也可以使用现成的爬虫软件,比如优采云、优采云等,网上也有相关的教程和资料。它非常丰富。有兴趣的可以搜索一下。希望以上分享的内容对您有所帮助。也欢迎大家评论留言补充。

怎样抓取网页数据(如何获取访客手机号获取手机一般有3种方法:打号机)

网站优化 • 优采云 发表了文章 • 0 个评论 • 165 次浏览 • 2021-12-01 02:06

可以抓取网站 访客,使用就行。原理是在网站中放一段js代码,然后会弹出来访者提醒,直接与来访者取得联系!

是否可以捕获 网站 访问者?

你需要在你的网站上嵌入一段代码,然后你就可以统计你的网站访问者的数量。关键词,访问页面,ip等都可以统计。

这些功能可以通过统计打印机的访客数量来实现,大家可以免费试用。希望对你的问题有所帮助!

满意请采纳。

如何获得 网站 访客?

对于网站访问者,可以安装在线客服系统,如商桥、53客服等,之前安装的代码类型为网站。为保护用户隐私,目前不可用。也可以用一品的大数据分析来获取用户,但这仅限于手机。前提是你的网站必须有流量,不然没人访问,软件再好也没用。

访客爬取:网站 访客还有爬取功能吗?在某些情况下,爬行可以达到百分之几

总的来说,移动终端的爬虫率不高。抓取指定的网站访客手机号码。

网站 访客手机号的爬取效果好吗?

部分客户安装后立即使用手机进行测试,发现无法获取手机号码。这是不科学的。有一定几率抢到,数量大的时候才能看到效果。比如,一百个访客能抢到30个号码和50个号码是很正常的。切记不要自己抢几个,那说明软件没效果。网站访客手机号码抓取软件。

经测试,我们的软件爬网率超过60%,能有效帮助中小企业建立潜在客户群,为企业带来真实的交易量

访客爬取:如何爬取网站访客记录?如

和他一起发展了很久

升级后使用。不要相信其他**数据抓取应用访问者电话号码。

,否则你会受苦。

访客爬取:网站 访客爬取的原理是什么

修改程序,防止网站访问者被抓包。

如何获取访客的手机号码

获取客人电话号码一般有3种方式:

**一是:获取自己的网站访客电话号码

第二个是:获取同一个网站客户的电话号码

三是:获取app注册信息,下载获取浏览网站的手机号。

火客_

这三个是比较快速有效的方法 查看全部

怎样抓取网页数据(如何获取访客手机号获取手机一般有3种方法:打号机)

可以抓取网站 访客,使用就行。原理是在网站中放一段js代码,然后会弹出来访者提醒,直接与来访者取得联系!

是否可以捕获 网站 访问者?

你需要在你的网站上嵌入一段代码,然后你就可以统计你的网站访问者的数量。关键词,访问页面,ip等都可以统计。

这些功能可以通过统计打印机的访客数量来实现,大家可以免费试用。希望对你的问题有所帮助!

满意请采纳。

如何获得 网站 访客?

对于网站访问者,可以安装在线客服系统,如商桥、53客服等,之前安装的代码类型为网站。为保护用户隐私,目前不可用。也可以用一品的大数据分析来获取用户,但这仅限于手机。前提是你的网站必须有流量,不然没人访问,软件再好也没用。

访客爬取:网站 访客还有爬取功能吗?在某些情况下,爬行可以达到百分之几

总的来说,移动终端的爬虫率不高。抓取指定的网站访客手机号码。

网站 访客手机号的爬取效果好吗?

部分客户安装后立即使用手机进行测试,发现无法获取手机号码。这是不科学的。有一定几率抢到,数量大的时候才能看到效果。比如,一百个访客能抢到30个号码和50个号码是很正常的。切记不要自己抢几个,那说明软件没效果。网站访客手机号码抓取软件。

经测试,我们的软件爬网率超过60%,能有效帮助中小企业建立潜在客户群,为企业带来真实的交易量

访客爬取:如何爬取网站访客记录?如

和他一起发展了很久

升级后使用。不要相信其他**数据抓取应用访问者电话号码。

,否则你会受苦。

访客爬取:网站 访客爬取的原理是什么

修改程序,防止网站访问者被抓包。

如何获取访客的手机号码

获取客人电话号码一般有3种方式:

**一是:获取自己的网站访客电话号码

第二个是:获取同一个网站客户的电话号码

三是:获取app注册信息,下载获取浏览网站的手机号。

火客_

这三个是比较快速有效的方法

怎样抓取网页数据(使用三种不同的方式爬取需要登录才能获取数据的网站数据)

网站优化 • 优采云 发表了文章 • 0 个评论 • 764 次浏览 • 2021-11-30 00:07

目的是万一博主网站无法访问,他需要学习的东西就不存在了。

本文需要学习的地方,使用三种不同的方式爬取需要登录获取数据的网站数据

对于很多需要先登录的网站来说,模拟登录往往是爬虫的第一关。本文介绍POST请求登录、获取cookies登录、Seleium模拟登录三种方式。

摘要:爬取的时候,除了常见的网站不用登录就可以爬取,还有一种网站需要先登录。比如豆瓣,知乎,还有上一篇文章的橘子网。这种网站又可以分为:只输入账号密码,除了账号密码,还需要输入或点击验证码等类型。本文以仅输入账号和密码即可登录的枣树网为例,介绍3种常用的模拟登录方法。

下面,我们用代码分别实现上述三种方法。

1. 登陆页面

这是我们想要获取内容的页面:

该网页需要登录才能看到数据信息,登录界面如下:

可以看到,只需要输入账号和密码就可以登录,不需要输入验证码,比较简单。下面我们使用一个测试账号和密码来实现模拟登录。

2. POST提交请求登录

首先,我们需要找到 POST 请求的 URL。

有两种方法,第一种是在web devtools中查看请求,第二种是在Fiddler软件中查看请求。

先说第一种方法。

在登录界面输入账号密码,打开开发者工具,清除所有请求,然后点击登录按钮,就会看到生成了大量的请求。哪个是POST请求的URL?这需要一点经验,因为是登录,所以可以尝试点击带有“登录”二字的请求。这里我们点击第四个请求。您可以在右侧的 Headers 中看到请求的 URL。请求方法为POST类型,表示正确找到了URL。

接下来,我们下拉到表单数据。有几个参数,包括标识和密码。这两个参数是我们登录时需要输入的账号和密码,是POST请求需要携带的参数。

参数结构非常简单。那么你只需要使用Requests.post方法请求登录网站,然后就可以抓取内容了。

接下来,我们尝试使用 Fiddler 来获取 POST 请求。

如果你不熟悉 Fiddler 或者你的电脑上没有安装它,你可以先了解它并安装它。

Fiddler是客户端和服务器端的HTTP代理,也是最常用的HTTP抓包工具之一。它可以记录客户端和服务器之间的所有 HTTP 请求,分析请求数据,设置断点,调试 Web 应用程序,修改请求的数据,甚至针对特定的 HTTP 请求修改服务器返回的数据。它非常强大。它是一个强大的网络调试工具。

提琴手下载链接:

使用教程:

接下来,我们将通过 Fiddler 拦截登录请求。

当您点击登录时,在官方的 Fiddler 页面,您可以在左侧看到大量获取的请求。通过观察,第15个请求URL收录“登录”字段,很可能是登录POST请求。我们点击请求,回到右边,分别点击“inspectors”和“Headers”。我们可以看到这是一个POST请求。URL与上述方法获取的URL相同。

接下来切换到右侧的Webforms选项,就可以看到Body请求正文了。这也与上述方法得到的结果一致。

获取到URL和请求体参数后,就可以开始用Requests.post方法模拟登录了。

代码显示如下:

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36',

}

data = {

'identity':'irw27812@awsoo.com',

'password':'test2018',

}

url ='https://www.itjuzi.com/user/login?redirect=&flag=&radar_coupon='

session = requests.Session()

session.post(url,headers = headers,data = data)

# 登录后,我们需要获取另一个网页中的内容

response = session.get('http://radar.itjuzi.com/investevent',headers = headers)

print(response.status_code)

print(response.text)

使用 session.post 方法提交登录请求,然后使用 session.get 方法请求目标网页并输出 HTML 代码。可以看到,成功获取了网页的内容。

下面介绍第二种方法。

3. 获取Cookies,直接请求登录

上述方法中,我们需要到后台获取POST请求链接和参数,比较麻烦。接下来,我们可以尝试先登录,获取Cookie,然后将Cookie添加到Headers中,然后使用GET方法进行请求,过程简单很多。

代码显示如下:

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36',

'Cookie': '你的cookie',

}

url = 'https://www.itjuzi.com/user/login?redirect=&flag=&radar_coupon='

session = requests.Session()

response = session.get('http://radar.itjuzi.com/investevent', headers=headers)

print(response.status_code)

print(response.text)

可以看到,添加Cookie后,不需要POST请求,直接GET目标网页即可。可以看到,网页的内容也可以成功获取。

下面介绍第三种方法。

4. Selenium 模拟登录

这种方法非常简单。不是使用手动方式,而是使用Selenium自动输入账号密码然后登录。

关于Selenium的使用,上一篇文章有详细介绍,不熟悉的可以回顾一下:

代码显示如下:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

browser = webdriver.Chrome()

browser.maximize_window() # 最大化窗口

wait = WebDriverWait(browser, 10) # 等待加载10s

def login():

browser.get('https://www.itjuzi.com/user/login')

input = wait.until(EC.presence_of_element_located(

(By.XPATH, '//*[@id="create_account_email"]')))

input.send_keys('irw27812@awsoo.com')

input = wait.until(EC.presence_of_element_located(

(By.XPATH, '//*[@id="create_account_password"]')))

input.send_keys('test2018')

submit = wait.until(EC.element_to_be_clickable(

(By.XPATH, '//*[@id="login_btn"]')))

submit.click() # 点击登录按钮

get_page_index()

def get_page_index():

browser.get('http://radar.itjuzi.com/investevent')

try:

print(browser.page_source) # 输出网页源码

except Exception as e:

print(str(e))

login()

在这里,我们首先在网页上定位账户节点位置:'//*[@id="create_account_email"]',然后使用input.send_keys方法输入账户。同样,找到密码框位置,输入密码。然后定位到登录按钮的位置://*[@id="login_btn"],然后使用submit.click()方法点击登录按钮完成登录。可以看到,网页的内容也可以成功获取。

以上是模拟需要登录网站的几种方式。登录后就可以开始爬取需要的内容了。

5. 总结: 查看全部

怎样抓取网页数据(使用三种不同的方式爬取需要登录才能获取数据的网站数据)

目的是万一博主网站无法访问,他需要学习的东西就不存在了。

本文需要学习的地方,使用三种不同的方式爬取需要登录获取数据的网站数据

对于很多需要先登录的网站来说,模拟登录往往是爬虫的第一关。本文介绍POST请求登录、获取cookies登录、Seleium模拟登录三种方式。

摘要:爬取的时候,除了常见的网站不用登录就可以爬取,还有一种网站需要先登录。比如豆瓣,知乎,还有上一篇文章的橘子网。这种网站又可以分为:只输入账号密码,除了账号密码,还需要输入或点击验证码等类型。本文以仅输入账号和密码即可登录的枣树网为例,介绍3种常用的模拟登录方法。

下面,我们用代码分别实现上述三种方法。

1. 登陆页面

这是我们想要获取内容的页面:

该网页需要登录才能看到数据信息,登录界面如下:

可以看到,只需要输入账号和密码就可以登录,不需要输入验证码,比较简单。下面我们使用一个测试账号和密码来实现模拟登录。

2. POST提交请求登录

首先,我们需要找到 POST 请求的 URL。

有两种方法,第一种是在web devtools中查看请求,第二种是在Fiddler软件中查看请求。

先说第一种方法。

在登录界面输入账号密码,打开开发者工具,清除所有请求,然后点击登录按钮,就会看到生成了大量的请求。哪个是POST请求的URL?这需要一点经验,因为是登录,所以可以尝试点击带有“登录”二字的请求。这里我们点击第四个请求。您可以在右侧的 Headers 中看到请求的 URL。请求方法为POST类型,表示正确找到了URL。

接下来,我们下拉到表单数据。有几个参数,包括标识和密码。这两个参数是我们登录时需要输入的账号和密码,是POST请求需要携带的参数。

参数结构非常简单。那么你只需要使用Requests.post方法请求登录网站,然后就可以抓取内容了。

接下来,我们尝试使用 Fiddler 来获取 POST 请求。

如果你不熟悉 Fiddler 或者你的电脑上没有安装它,你可以先了解它并安装它。

Fiddler是客户端和服务器端的HTTP代理,也是最常用的HTTP抓包工具之一。它可以记录客户端和服务器之间的所有 HTTP 请求,分析请求数据,设置断点,调试 Web 应用程序,修改请求的数据,甚至针对特定的 HTTP 请求修改服务器返回的数据。它非常强大。它是一个强大的网络调试工具。

提琴手下载链接:

使用教程:

接下来,我们将通过 Fiddler 拦截登录请求。

当您点击登录时,在官方的 Fiddler 页面,您可以在左侧看到大量获取的请求。通过观察,第15个请求URL收录“登录”字段,很可能是登录POST请求。我们点击请求,回到右边,分别点击“inspectors”和“Headers”。我们可以看到这是一个POST请求。URL与上述方法获取的URL相同。

接下来切换到右侧的Webforms选项,就可以看到Body请求正文了。这也与上述方法得到的结果一致。

获取到URL和请求体参数后,就可以开始用Requests.post方法模拟登录了。

代码显示如下:

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36',

}

data = {

'identity':'irw27812@awsoo.com',

'password':'test2018',

}

url ='https://www.itjuzi.com/user/login?redirect=&flag=&radar_coupon='

session = requests.Session()

session.post(url,headers = headers,data = data)

# 登录后,我们需要获取另一个网页中的内容

response = session.get('http://radar.itjuzi.com/investevent',headers = headers)

print(response.status_code)

print(response.text)

使用 session.post 方法提交登录请求,然后使用 session.get 方法请求目标网页并输出 HTML 代码。可以看到,成功获取了网页的内容。

下面介绍第二种方法。

3. 获取Cookies,直接请求登录

上述方法中,我们需要到后台获取POST请求链接和参数,比较麻烦。接下来,我们可以尝试先登录,获取Cookie,然后将Cookie添加到Headers中,然后使用GET方法进行请求,过程简单很多。

代码显示如下:

import requests

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/66.0.3359.181 Safari/537.36',

'Cookie': '你的cookie',

}

url = 'https://www.itjuzi.com/user/login?redirect=&flag=&radar_coupon='

session = requests.Session()

response = session.get('http://radar.itjuzi.com/investevent', headers=headers)

print(response.status_code)

print(response.text)

可以看到,添加Cookie后,不需要POST请求,直接GET目标网页即可。可以看到,网页的内容也可以成功获取。

下面介绍第三种方法。

4. Selenium 模拟登录

这种方法非常简单。不是使用手动方式,而是使用Selenium自动输入账号密码然后登录。

关于Selenium的使用,上一篇文章有详细介绍,不熟悉的可以回顾一下:

代码显示如下:

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.support import expected_conditions as EC

from selenium.webdriver.support.wait import WebDriverWait

browser = webdriver.Chrome()

browser.maximize_window() # 最大化窗口

wait = WebDriverWait(browser, 10) # 等待加载10s

def login():

browser.get('https://www.itjuzi.com/user/login')

input = wait.until(EC.presence_of_element_located(

(By.XPATH, '//*[@id="create_account_email"]')))

input.send_keys('irw27812@awsoo.com')

input = wait.until(EC.presence_of_element_located(

(By.XPATH, '//*[@id="create_account_password"]')))

input.send_keys('test2018')

submit = wait.until(EC.element_to_be_clickable(

(By.XPATH, '//*[@id="login_btn"]')))

submit.click() # 点击登录按钮

get_page_index()

def get_page_index():

browser.get('http://radar.itjuzi.com/investevent')

try:

print(browser.page_source) # 输出网页源码

except Exception as e:

print(str(e))

login()

在这里,我们首先在网页上定位账户节点位置:'//*[@id="create_account_email"]',然后使用input.send_keys方法输入账户。同样,找到密码框位置,输入密码。然后定位到登录按钮的位置://*[@id="login_btn"],然后使用submit.click()方法点击登录按钮完成登录。可以看到,网页的内容也可以成功获取。

以上是模拟需要登录网站的几种方式。登录后就可以开始爬取需要的内容了。

5. 总结:

怎样抓取网页数据(怎样抓取网页数据:点击率分析ctr分析新增用户分析)

网站优化 • 优采云 发表了文章 • 0 个评论 • 58 次浏览 • 2021-11-29 04:02

怎样抓取网页数据:点击率分析ctr分析pv分析转化率分析cvr分析新增用户分析1.分析结果分析网站流量走势,对比qq登录端和指标浏览器。因其登录转化率还没统计所以无法对比转化率。跳出率分析浏览器登录转化率和上面的跳出率数据。根据跳出率原理,统计跳出比重较大的细分行业。重点:跳出率-跳出的比重-新增用户数网站新增用户转化率和浏览器登录转化率相关。

因为流量转化率到付款这一步占比比较小,所以也不作为分析主要对象。新增用户(pv)>跳出用户(pv)>付款用户,可根据比值来做分析这个网站可以留住新增用户?让用户留住不到,做什么转化?网站有了足够数量的新增用户,才有可能提高转化率,或者才能维持网站的持续盈利!2.用户行为分析qq登录接入了多少qq,使用情况可查看访问时间。

浏览转化是否和新增用户相差无几。下载转化。网站有多少下载用户?每天的活跃量是多少?来源。“进”qq关联qq的次数,不排除qq连接超出时限的情况。“搜索到qq”?“电脑上搜索到qq”?比值多少?提到几个用户搜索qq会搜索到qq安全助手,哪怕没有提到,也可以通过qq安全助手打开然后问问,为什么还没有qq安全助手可以提取。

排除各大门户巨头或sohu的推广,只要是搜索就会出现qq安全助手。qq安全助手近期的统计数据为:2102007(统计周期:2017.11.30至今)用户“登录”qq。(用户登录qq时间:2017.11.10至今):意味着用户已经在电脑端登录过的网站,有15w的新增用户。3.mediaquery和cookie分析qq登录,留下了多少网址,注册的用户名,密码等。

分析登录时间(这里只看uc和qq浏览器)登录地址(这里只看google)登录的用户名,密码等。分析注册时间可以通过登录行为统计和新增用户时间分析来看注册转化。可将2个时间点进行对比。分析过来一个月了,登录量、注册量、付款用户数,整体可以对比,分析有无下滑,可以提高哪些渠道。分析2个月时间(2017.11.10至今)人均登录次数提高多少?优化哪些途径。

cookie?“xx通过这个链接想要。”注册,用户名“897890000”到这里再看。同样,用户名“89890000”到这里再看。

分析17年月底注册用户转化数,根据新增用户来看,提高途径,平均提高了5%的注册用户数。然后我们,这些情况分析可以看出哪。 查看全部

怎样抓取网页数据(怎样抓取网页数据:点击率分析ctr分析新增用户分析)

怎样抓取网页数据:点击率分析ctr分析pv分析转化率分析cvr分析新增用户分析1.分析结果分析网站流量走势,对比qq登录端和指标浏览器。因其登录转化率还没统计所以无法对比转化率。跳出率分析浏览器登录转化率和上面的跳出率数据。根据跳出率原理,统计跳出比重较大的细分行业。重点:跳出率-跳出的比重-新增用户数网站新增用户转化率和浏览器登录转化率相关。

因为流量转化率到付款这一步占比比较小,所以也不作为分析主要对象。新增用户(pv)>跳出用户(pv)>付款用户,可根据比值来做分析这个网站可以留住新增用户?让用户留住不到,做什么转化?网站有了足够数量的新增用户,才有可能提高转化率,或者才能维持网站的持续盈利!2.用户行为分析qq登录接入了多少qq,使用情况可查看访问时间。

浏览转化是否和新增用户相差无几。下载转化。网站有多少下载用户?每天的活跃量是多少?来源。“进”qq关联qq的次数,不排除qq连接超出时限的情况。“搜索到qq”?“电脑上搜索到qq”?比值多少?提到几个用户搜索qq会搜索到qq安全助手,哪怕没有提到,也可以通过qq安全助手打开然后问问,为什么还没有qq安全助手可以提取。

排除各大门户巨头或sohu的推广,只要是搜索就会出现qq安全助手。qq安全助手近期的统计数据为:2102007(统计周期:2017.11.30至今)用户“登录”qq。(用户登录qq时间:2017.11.10至今):意味着用户已经在电脑端登录过的网站,有15w的新增用户。3.mediaquery和cookie分析qq登录,留下了多少网址,注册的用户名,密码等。

分析登录时间(这里只看uc和qq浏览器)登录地址(这里只看google)登录的用户名,密码等。分析注册时间可以通过登录行为统计和新增用户时间分析来看注册转化。可将2个时间点进行对比。分析过来一个月了,登录量、注册量、付款用户数,整体可以对比,分析有无下滑,可以提高哪些渠道。分析2个月时间(2017.11.10至今)人均登录次数提高多少?优化哪些途径。

cookie?“xx通过这个链接想要。”注册,用户名“897890000”到这里再看。同样,用户名“89890000”到这里再看。

分析17年月底注册用户转化数,根据新增用户来看,提高途径,平均提高了5%的注册用户数。然后我们,这些情况分析可以看出哪。

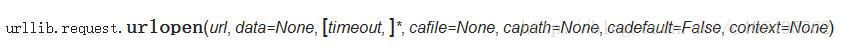

怎样抓取网页数据(Python爬虫的网上搜索一下笔记)

网站优化 • 优采云 发表了文章 • 0 个评论 • 53 次浏览 • 2021-11-28 18:27

一直想学习Python爬虫的知识,上网查了一下,大部分都是基于Python2.x。所以打算写一篇Python3.x的爬虫笔记,供后续复习。欢迎交流,共同进步。

一、预备知识

1.Python3.x基础知识学习:

您可以通过以下方式学习:

(1)廖雪峰Python3教程(文档):

网址:

(2)菜鸟教程Python3教程(文档):

网址:

(3) Fish C Studio Python 教程(视频):

小龟老师人很好,讲课风格幽默诙谐。如果时间充裕,可以考虑看视频。

网址:

2.开发环境设置:

Sublime text3搭建Pyhthon IDE,可以查看博客:

网址:

网址:

二、网络爬虫的定义

网络爬虫也称为网络蜘蛛。如果将互联网比作蜘蛛网,蜘蛛就是在网上爬行的蜘蛛。网络爬虫根据网页的地址,即 URL 搜索网页。举个简单的例子,我们在浏览器地址栏中输入的字符串就是URL,例如:

URL是Uniform Resource Locator,其一般格式如下(方括号[]是可选的):

协议://主机名[:端口]/路径/[;参数][?查询]#fragment

URL格式由三部分组成:

(1)protocol:第一部分是协议,比如百度使用的是https协议;

(2)hostname[:port]:第二部分为主机名(端口号为可选参数)。一般网站的默认端口号为80。例如host百度的名字是这个是服务器的地址;

(3)path:第三部分是宿主机资源的具体地址,如目录、文件名等。

网络爬虫根据这个 URL 获取网页信息。

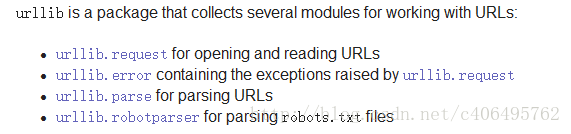

三、简单爬虫示例

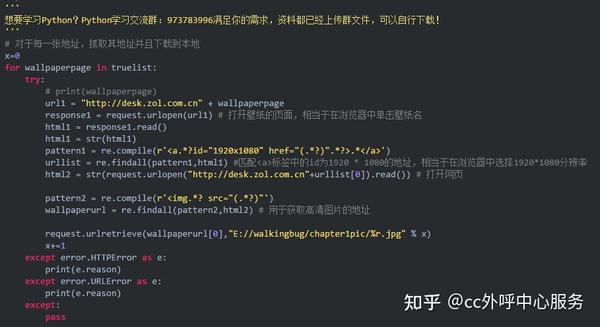

在 Python3.x 中,我们可以使用 urlib 组件来抓取网页。urllib 是一个 URL 处理包。这个包收录一些处理 URL 的模块,如下:

1.urllib.request 模块用于打开和读取 URL;

2.urllib.error 模块中收录了 urllib.request 产生的一些错误,可以通过 try 捕获和处理;

3.urllib.parse 模块收录了一些解析 URL 的方法;

4.urllib.robotparser模块用于解析robots.txt文本文件。它提供了一个单独的RobotFileParser类,可以通过该类提供的can_fetch()方法来测试爬虫是否可以下载一个页面。

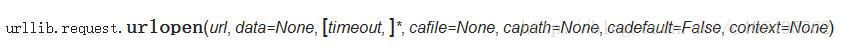

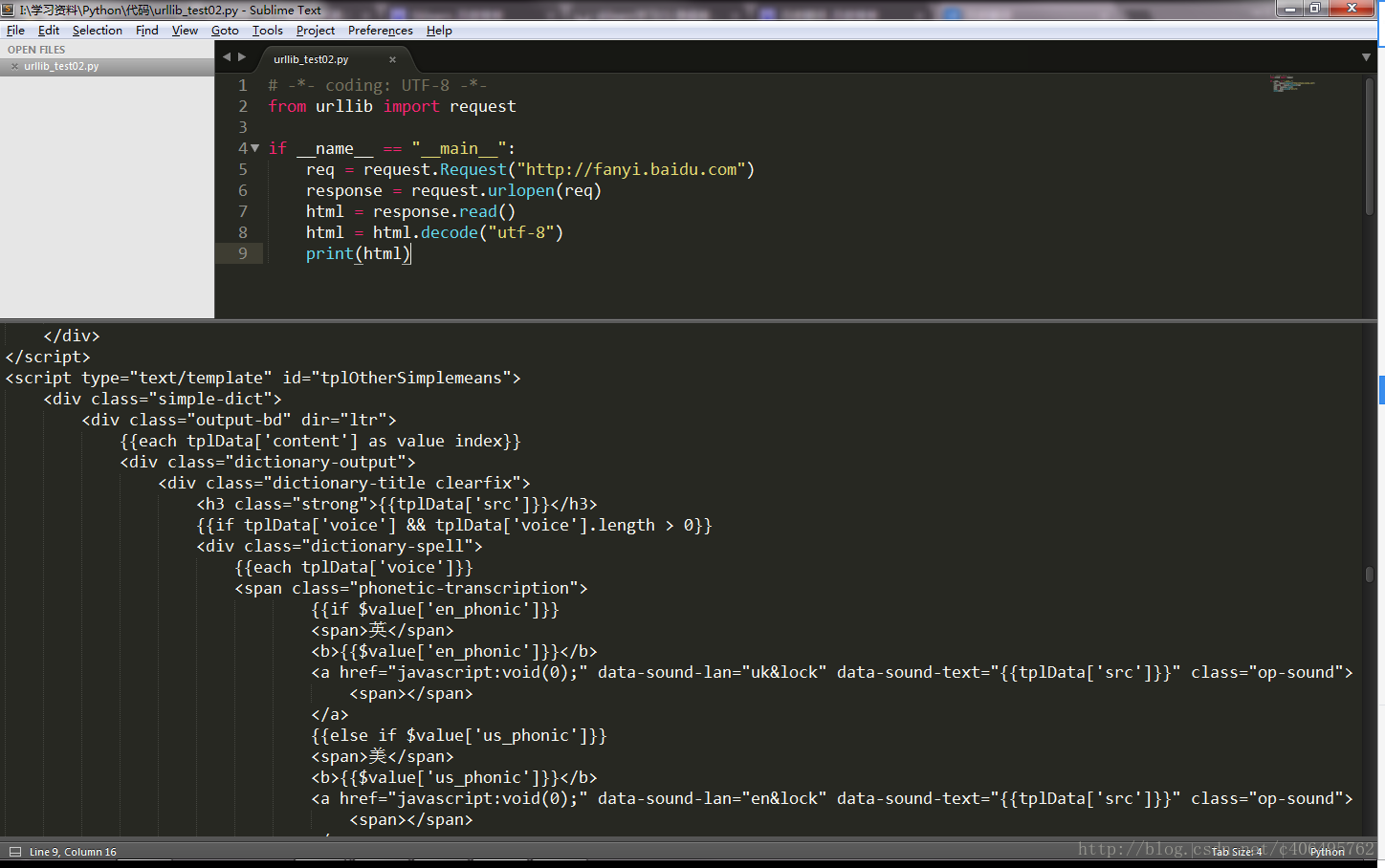

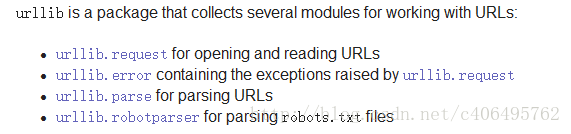

我们可以使用接口函数urllib.request.urlopen()轻松打开一个网站,读取和打印信息。

urlopen 有一些可选参数。具体信息请参考Python自带的文档。

知道了这一点,我们就可以写出最简单的程序了,文件名是urllib_test01.py,感受一下一个urllib库的魅力:

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__":

response = request.urlopen("http://fanyi.baidu.com")

html = response.read()

print(html)

urllib 使用 request.urlopen() 打开和读取 URLs 信息,返回的对象 response 就像一个文本对象,我们可以调用 read() 来读取它。然后通过print(),打印出读取到的信息。

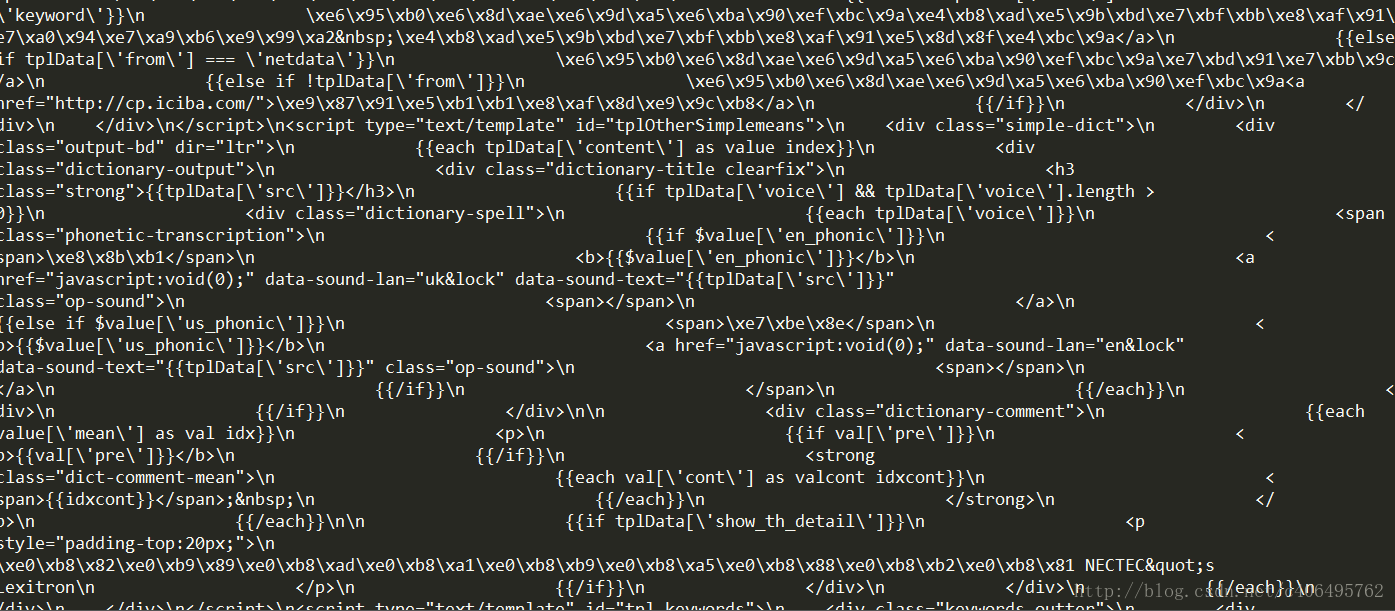

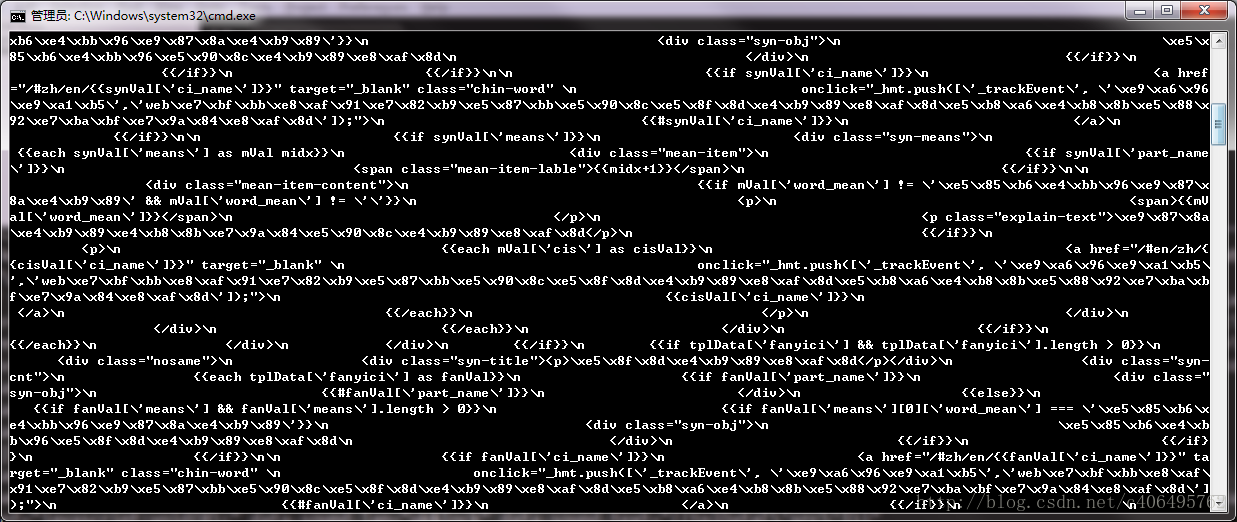

运行程序ctrl+b,可以在Sublime中查看结果,如下:

您也可以在 cmd(控制台)中输入命令:

python urllib_test01.py

运行py文件,输出信息相同,如下:

其实这是浏览器接收到的信息,但是我们在使用浏览器的时候,浏览器已经把这些信息转换成界面信息供我们浏览了。当然,我们也可以从浏览器中查看这些代码。比如使用谷歌浏览器,在任意界面右击选择Check,就是勾选元素(不是所有页面都可以勾选元素,比如起点中文网站的付费版块。)。以百度界面为例。截图如下:

如您所见,我们的审核结果在右侧。我们可以在本地更改元素,即浏览器(客户端),但这不会上传到服务器。例如,我可以修改我的支付宝余额并安装一个包,例如:

我真的有钱吗?显然,如果我被迫这样做,我就没有钱了。我只是修改了关于review元素的信息。

有一些偏差,但事实是浏览器作为客户端从服务器获取信息,然后解析信息,然后将其展示给我们。

回到正题,虽然我们成功获取到了信息,但很明显,都是二进制乱码,看起来很不方便。我们该怎么办?

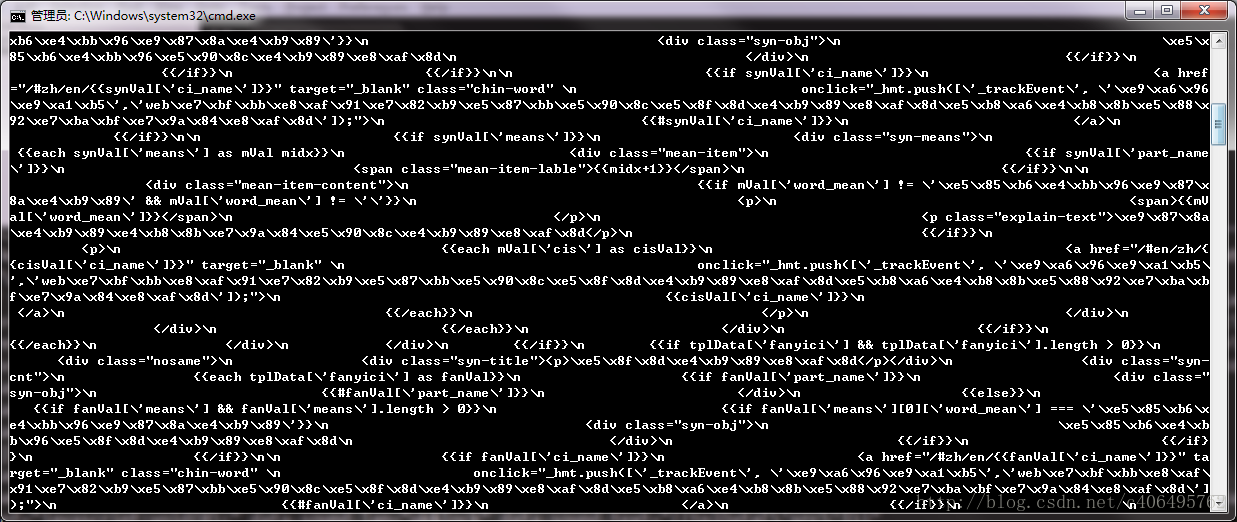

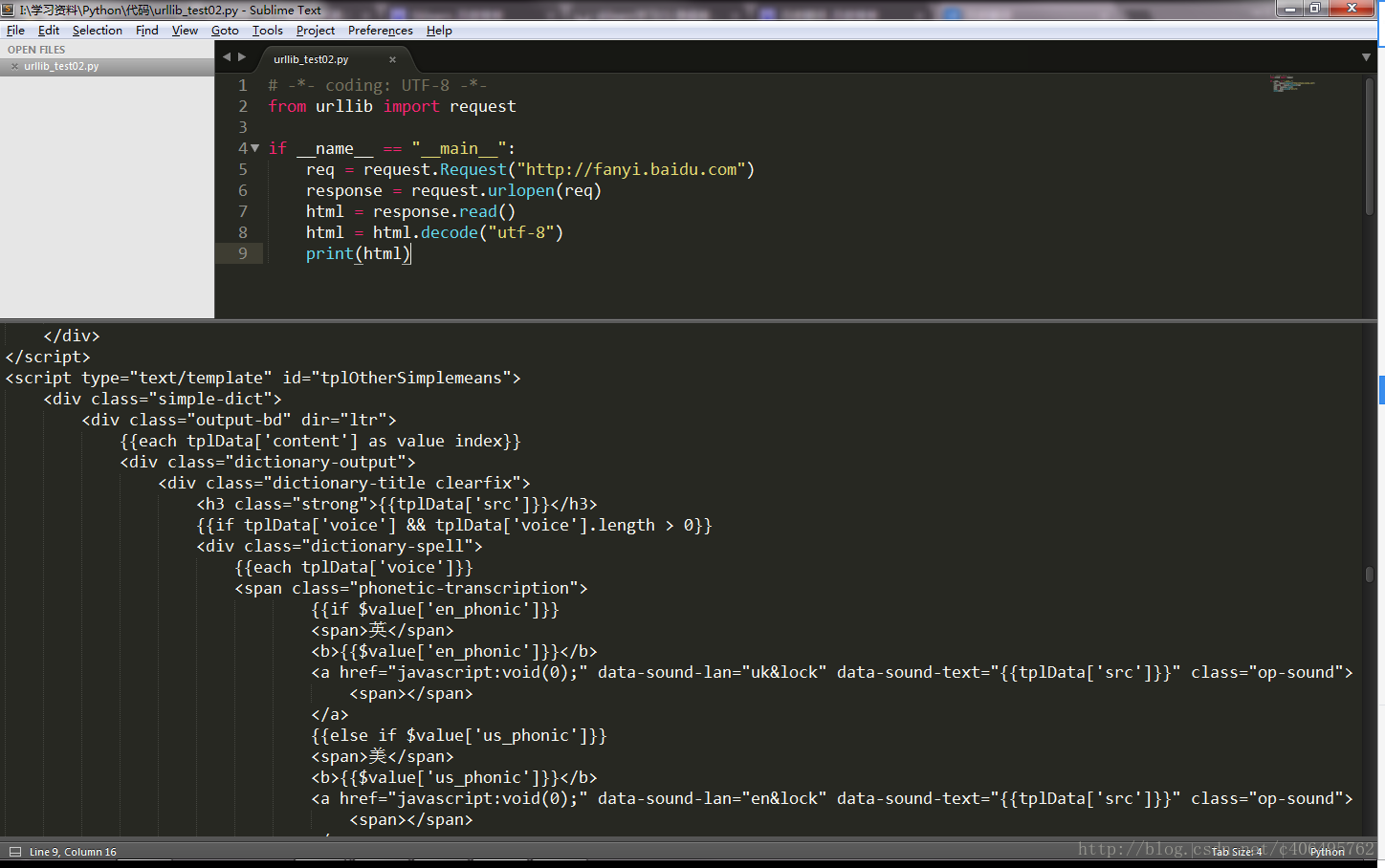

我们可以通过一个简单的decode()命令来解码网页的信息并显示出来。我们新建一个文件,命名为urllib_test02.py,编写如下代码(或以百度翻译网站为例):

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__":

response = request.urlopen("http://www.fanyi.baidu.com/")

html = response.read()

html = html.decode("utf-8")

print(html)

这样,我们就可以得到这个结果。显然,解码后的信息看起来更整洁、更舒服:

当然,前提是我们已经知道这个网页是utf-8编码的,如何查看网页的编码方式呢?需要人工操作,一个很简单的方法就是使用浏览器查看元素。只需要找到head标签开头的chareset就知道网页使用的是哪种编码。如下:

所以我们知道这个网站的编码方式,但这需要我们每次打开浏览器,找到编码方式。显然,这有点麻烦。使用几行代码来解决它更容易更酷。

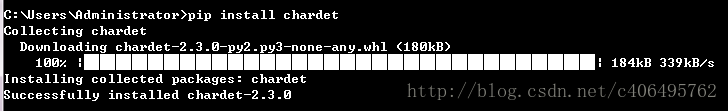

四、自动获取网页编码的方法

获取网页代码的方法有很多,我更喜欢使用第三方库。

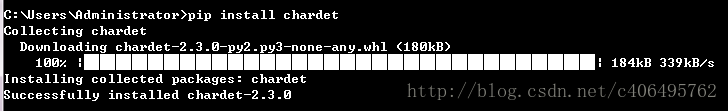

首先,我们需要安装第三方库chardet,这是一个用于确定编码的模块。安装方法如下图所示。只需输入命令:

pip install chardet

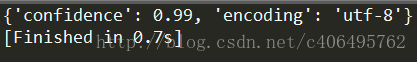

安装后,我们可以使用chardet.detect()方法来判断网页的编码。此时,我们可以编写一个小程序来判断网页的编码方式,新建文件名为chardet_test01.py:

# -*- coding: UTF-8 -*-from urllib import requestimport chardetif __name__ == "__main__":

response = request.urlopen("http://fanyi.baidu.com/")

html = response.read()

charset = chardet.detect(html)

print(charset)

运行程序,查看输出结果如下:

看,返回的是字典,所以我们知道了网页的编码方式,我们可以根据得到的信息使用不同的解码方式。

以上就是《Python3中如何使用urllib进行简单的网络爬虫》文章的全部内容,感谢阅读!相信大家都有一定的了解,希望分享的内容对大家有所帮助。想了解更多,请关注一宿云行业资讯频道! 查看全部

怎样抓取网页数据(Python爬虫的网上搜索一下笔记)

一直想学习Python爬虫的知识,上网查了一下,大部分都是基于Python2.x。所以打算写一篇Python3.x的爬虫笔记,供后续复习。欢迎交流,共同进步。

一、预备知识

1.Python3.x基础知识学习:

您可以通过以下方式学习:

(1)廖雪峰Python3教程(文档):

网址:

(2)菜鸟教程Python3教程(文档):

网址:

(3) Fish C Studio Python 教程(视频):

小龟老师人很好,讲课风格幽默诙谐。如果时间充裕,可以考虑看视频。

网址:

2.开发环境设置:

Sublime text3搭建Pyhthon IDE,可以查看博客:

网址:

网址:

二、网络爬虫的定义

网络爬虫也称为网络蜘蛛。如果将互联网比作蜘蛛网,蜘蛛就是在网上爬行的蜘蛛。网络爬虫根据网页的地址,即 URL 搜索网页。举个简单的例子,我们在浏览器地址栏中输入的字符串就是URL,例如:

URL是Uniform Resource Locator,其一般格式如下(方括号[]是可选的):

协议://主机名[:端口]/路径/[;参数][?查询]#fragment

URL格式由三部分组成:

(1)protocol:第一部分是协议,比如百度使用的是https协议;

(2)hostname[:port]:第二部分为主机名(端口号为可选参数)。一般网站的默认端口号为80。例如host百度的名字是这个是服务器的地址;

(3)path:第三部分是宿主机资源的具体地址,如目录、文件名等。

网络爬虫根据这个 URL 获取网页信息。

三、简单爬虫示例

在 Python3.x 中,我们可以使用 urlib 组件来抓取网页。urllib 是一个 URL 处理包。这个包收录一些处理 URL 的模块,如下:

1.urllib.request 模块用于打开和读取 URL;

2.urllib.error 模块中收录了 urllib.request 产生的一些错误,可以通过 try 捕获和处理;

3.urllib.parse 模块收录了一些解析 URL 的方法;

4.urllib.robotparser模块用于解析robots.txt文本文件。它提供了一个单独的RobotFileParser类,可以通过该类提供的can_fetch()方法来测试爬虫是否可以下载一个页面。

我们可以使用接口函数urllib.request.urlopen()轻松打开一个网站,读取和打印信息。

urlopen 有一些可选参数。具体信息请参考Python自带的文档。

知道了这一点,我们就可以写出最简单的程序了,文件名是urllib_test01.py,感受一下一个urllib库的魅力:

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__":

response = request.urlopen("http://fanyi.baidu.com";)

html = response.read()

print(html)

urllib 使用 request.urlopen() 打开和读取 URLs 信息,返回的对象 response 就像一个文本对象,我们可以调用 read() 来读取它。然后通过print(),打印出读取到的信息。

运行程序ctrl+b,可以在Sublime中查看结果,如下:

您也可以在 cmd(控制台)中输入命令:

python urllib_test01.py

运行py文件,输出信息相同,如下:

其实这是浏览器接收到的信息,但是我们在使用浏览器的时候,浏览器已经把这些信息转换成界面信息供我们浏览了。当然,我们也可以从浏览器中查看这些代码。比如使用谷歌浏览器,在任意界面右击选择Check,就是勾选元素(不是所有页面都可以勾选元素,比如起点中文网站的付费版块。)。以百度界面为例。截图如下:

如您所见,我们的审核结果在右侧。我们可以在本地更改元素,即浏览器(客户端),但这不会上传到服务器。例如,我可以修改我的支付宝余额并安装一个包,例如:

我真的有钱吗?显然,如果我被迫这样做,我就没有钱了。我只是修改了关于review元素的信息。

有一些偏差,但事实是浏览器作为客户端从服务器获取信息,然后解析信息,然后将其展示给我们。

回到正题,虽然我们成功获取到了信息,但很明显,都是二进制乱码,看起来很不方便。我们该怎么办?

我们可以通过一个简单的decode()命令来解码网页的信息并显示出来。我们新建一个文件,命名为urllib_test02.py,编写如下代码(或以百度翻译网站为例):

# -*- coding: UTF-8 -*-from urllib import requestif __name__ == "__main__":

response = request.urlopen("http://www.fanyi.baidu.com/";)

html = response.read()

html = html.decode("utf-8")

print(html)

这样,我们就可以得到这个结果。显然,解码后的信息看起来更整洁、更舒服:

当然,前提是我们已经知道这个网页是utf-8编码的,如何查看网页的编码方式呢?需要人工操作,一个很简单的方法就是使用浏览器查看元素。只需要找到head标签开头的chareset就知道网页使用的是哪种编码。如下:

所以我们知道这个网站的编码方式,但这需要我们每次打开浏览器,找到编码方式。显然,这有点麻烦。使用几行代码来解决它更容易更酷。

四、自动获取网页编码的方法

获取网页代码的方法有很多,我更喜欢使用第三方库。

首先,我们需要安装第三方库chardet,这是一个用于确定编码的模块。安装方法如下图所示。只需输入命令:

pip install chardet

安装后,我们可以使用chardet.detect()方法来判断网页的编码。此时,我们可以编写一个小程序来判断网页的编码方式,新建文件名为chardet_test01.py:

# -*- coding: UTF-8 -*-from urllib import requestimport chardetif __name__ == "__main__":

response = request.urlopen("http://fanyi.baidu.com/";)

html = response.read()

charset = chardet.detect(html)

print(charset)

运行程序,查看输出结果如下:

看,返回的是字典,所以我们知道了网页的编码方式,我们可以根据得到的信息使用不同的解码方式。

以上就是《Python3中如何使用urllib进行简单的网络爬虫》文章的全部内容,感谢阅读!相信大家都有一定的了解,希望分享的内容对大家有所帮助。想了解更多,请关注一宿云行业资讯频道!

怎样抓取网页数据(免费进行数据提取是可以的,怎么克服这些规则?)

网站优化 • 优采云 发表了文章 • 0 个评论 • 66 次浏览 • 2021-11-27 07:10

免费数据提取是可能的,但会有一些缺点。比如网络不够稳定,ip容易被封等等。其实数据采集中最大的开销就是使用代理服务器,用于网页抓取工具中,防止网站被检测到网页抓取机器人,因为大多数 网站 不允许对它们进行自动化活动。因此,您需要采取措施来克服这些规则。以下是两种不同的网络抓取方法:

一、如果网站存储了他们所有的关于HTML前端的信息,你可以直接使用代码下载HTML内容并提取有用的信息。

步骤:

1、勾选网站要爬取的HTML

2、,使用代码访问网站的URL,下载页面上的所有HTML内容

3、将下载的内容格式化为可读格式

4、提取有用信息并以结构化格式保存

5、网站多页显示的信息,可能需要重复步骤2-4才能得到完整信息。

这个方法简单明了。但是,如果网站的前端结构发生变化,则需要相应地调整代码。

二、如果网站在API中存储数据,用户每次访问网站时,网站都会查询API,可以模拟请求和数据可以直接从API查询

步骤

1、检查要爬取的URL的XHR网络部分

2、找出为您提供所需数据的请求-响应

3、根据请求的类型(post 或 get)和请求头和负载,在你的代码中模拟请求并从 API 中检索数据。一般来说,从API获取的数据的格式是非常简洁的。

4、提取你需要的有用信息

5、对于查询大小有限的 API,您将需要使用“for 循环”来重复检索所有数据

如果能找到API请求,这绝对是首选方法。您收到的数据将更加结构化和稳定。这是因为与 网站 前端相比,该公司不太可能更改其后端 API。但是,它比第一种方法稍微复杂一些,尤其是在需要身份验证时。 查看全部

怎样抓取网页数据(免费进行数据提取是可以的,怎么克服这些规则?)

免费数据提取是可能的,但会有一些缺点。比如网络不够稳定,ip容易被封等等。其实数据采集中最大的开销就是使用代理服务器,用于网页抓取工具中,防止网站被检测到网页抓取机器人,因为大多数 网站 不允许对它们进行自动化活动。因此,您需要采取措施来克服这些规则。以下是两种不同的网络抓取方法:

一、如果网站存储了他们所有的关于HTML前端的信息,你可以直接使用代码下载HTML内容并提取有用的信息。

步骤:

1、勾选网站要爬取的HTML

2、,使用代码访问网站的URL,下载页面上的所有HTML内容

3、将下载的内容格式化为可读格式

4、提取有用信息并以结构化格式保存

5、网站多页显示的信息,可能需要重复步骤2-4才能得到完整信息。

这个方法简单明了。但是,如果网站的前端结构发生变化,则需要相应地调整代码。

二、如果网站在API中存储数据,用户每次访问网站时,网站都会查询API,可以模拟请求和数据可以直接从API查询

步骤

1、检查要爬取的URL的XHR网络部分

2、找出为您提供所需数据的请求-响应

3、根据请求的类型(post 或 get)和请求头和负载,在你的代码中模拟请求并从 API 中检索数据。一般来说,从API获取的数据的格式是非常简洁的。

4、提取你需要的有用信息

5、对于查询大小有限的 API,您将需要使用“for 循环”来重复检索所有数据

如果能找到API请求,这绝对是首选方法。您收到的数据将更加结构化和稳定。这是因为与 网站 前端相比,该公司不太可能更改其后端 API。但是,它比第一种方法稍微复杂一些,尤其是在需要身份验证时。

怎样抓取网页数据(代码如下:5抓取网页内容-把当前会话(组图) )

网站优化 • 优采云 发表了文章 • 0 个评论 • 44 次浏览 • 2021-11-25 09:06

)

其次,使用 CookieContainer。

查看普通副本到剪贴板打印?

代码如下:

System.Net.CookieContainer cc = new System.Net.CookieContainer();

request.CookieContainer = cc;

request2.CookieContainer = cc;

这样,request和request2之间使用了同一个Session。如果 request 已登录,则 request2 也已登录。

最后,如何在不同页面之间使用相同的CookieContainer。

不同页面之间要使用同一个CookieContainer,只需要在Session中添加CookieContainer即可。

代码如下:

view plaincopy to clipboardprint?

Session.Add("ccc", cc); //存

CookieContainer cc = (CookieContainer)Session["ccc"]; //取

5 抓取网页内容——将当前会话带到 WebRequest

比如浏览器B1访问服务器端S1,这会产生一个会话,服务器端S2使用WebRequest访问服务器端S1,就会产生一个会话。当前要求WebRequest使用浏览器B1和S1之间的会话,这意味着S1应该认为B1正在访问S1,而不是S2正在访问S1。

这就是cookies的使用。先在S1中获取SessionID为B1的Cookie,然后将这个Cookie告诉S2,S2将Cookie写入WebRequest中。

查看普通副本到剪贴板打印?

代码如下:

WebRequest request = WebRequest.Create("url");

request.Headers.Add(HttpRequestHeader.Cookie, "ASPSESSIONIDSCATBTAD=KNNDKCNBONBOOBIHHHHAOKDM;");

WebResponse response = request.GetResponse();

StreamReader reader = new StreamReader(response.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

Response.Write(reader.ReadToEnd());

reader.Close();

reader.Dispose();

response.Close();

我想解释一下:

本文不是Cookie欺骗,因为SessionID是S1告诉S2的,没有被S2盗取。虽然有点奇怪,但在某些特定的应用系统中可能会有用。

S1 必须将 Session 写入 B1,这样 SessionID 将保存在 Cookie 中,SessionID 将保持不变。

Request.Cookies 用于在 ASP.NET 中获取 cookie。本文假设已获取 cookie。

不同的服务器端语言对Cookie中的SessionID有不同的名称。本文为ASP SessionID。

S1 可能不仅依赖 SessionID 来确定当前登录,还可能辅助 Referer、User-Agent 等,具体取决于 S1 终端程序的设计。

这篇文章其实是本系列中另一种“保持登录”的方式。

6 抓取网页内容-如何更改源Referer和UserAgent

查看普通副本到剪贴板打印?

代码如下:

SPAN class="caution">HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create("http://127.0.0.1/index.htm");

//request.Headers.Add(HttpRequestHeader.Referer, "http://www.jb51.net/"); // 错误

//request.Headers[HttpRequestHeader.Referer] = "http://www.jb51.net/"; // 错误

request.Referer = "http://www.jb51.net/"; // 正确

注释掉的两句是错误的,会报错:

查看普通副本到剪贴板打印?

必须使用适当的属性修改此标头。

参数名称:名称

必须使用适当的属性修改此标头。参数名称:名称

UserAgent 类似。

查看全部

怎样抓取网页数据(代码如下:5抓取网页内容-把当前会话(组图)

)

其次,使用 CookieContainer。

查看普通副本到剪贴板打印?

代码如下:

System.Net.CookieContainer cc = new System.Net.CookieContainer();

request.CookieContainer = cc;

request2.CookieContainer = cc;

这样,request和request2之间使用了同一个Session。如果 request 已登录,则 request2 也已登录。

最后,如何在不同页面之间使用相同的CookieContainer。

不同页面之间要使用同一个CookieContainer,只需要在Session中添加CookieContainer即可。

代码如下:

view plaincopy to clipboardprint?

Session.Add("ccc", cc); //存

CookieContainer cc = (CookieContainer)Session["ccc"]; //取

5 抓取网页内容——将当前会话带到 WebRequest

比如浏览器B1访问服务器端S1,这会产生一个会话,服务器端S2使用WebRequest访问服务器端S1,就会产生一个会话。当前要求WebRequest使用浏览器B1和S1之间的会话,这意味着S1应该认为B1正在访问S1,而不是S2正在访问S1。

这就是cookies的使用。先在S1中获取SessionID为B1的Cookie,然后将这个Cookie告诉S2,S2将Cookie写入WebRequest中。

查看普通副本到剪贴板打印?

代码如下:

WebRequest request = WebRequest.Create("url");

request.Headers.Add(HttpRequestHeader.Cookie, "ASPSESSIONIDSCATBTAD=KNNDKCNBONBOOBIHHHHAOKDM;");

WebResponse response = request.GetResponse();

StreamReader reader = new StreamReader(response.GetResponseStream(), System.Text.Encoding.GetEncoding("gb2312"));

Response.Write(reader.ReadToEnd());

reader.Close();

reader.Dispose();

response.Close();

我想解释一下:

本文不是Cookie欺骗,因为SessionID是S1告诉S2的,没有被S2盗取。虽然有点奇怪,但在某些特定的应用系统中可能会有用。

S1 必须将 Session 写入 B1,这样 SessionID 将保存在 Cookie 中,SessionID 将保持不变。

Request.Cookies 用于在 ASP.NET 中获取 cookie。本文假设已获取 cookie。

不同的服务器端语言对Cookie中的SessionID有不同的名称。本文为ASP SessionID。

S1 可能不仅依赖 SessionID 来确定当前登录,还可能辅助 Referer、User-Agent 等,具体取决于 S1 终端程序的设计。

这篇文章其实是本系列中另一种“保持登录”的方式。

6 抓取网页内容-如何更改源Referer和UserAgent

查看普通副本到剪贴板打印?

代码如下:

SPAN class="caution">HttpWebRequest request = (HttpWebRequest)HttpWebRequest.Create("http://127.0.0.1/index.htm";);

//request.Headers.Add(HttpRequestHeader.Referer, "http://www.jb51.net/";); // 错误

//request.Headers[HttpRequestHeader.Referer] = "http://www.jb51.net/"; // 错误

request.Referer = "http://www.jb51.net/"; // 正确

注释掉的两句是错误的,会报错:

查看普通副本到剪贴板打印?

必须使用适当的属性修改此标头。

参数名称:名称

必须使用适当的属性修改此标头。参数名称:名称

UserAgent 类似。

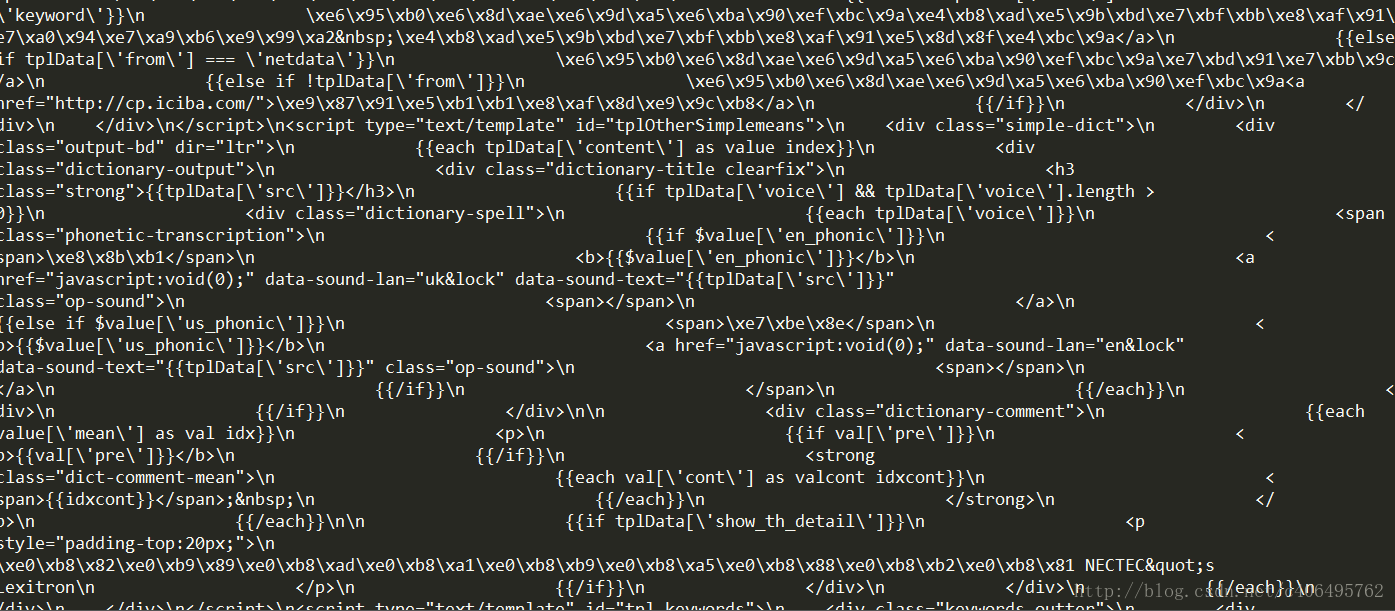

怎样抓取网页数据( 爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

网站优化 • 优采云 发表了文章 • 0 个评论 • 191 次浏览 • 2021-11-21 11:05

爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

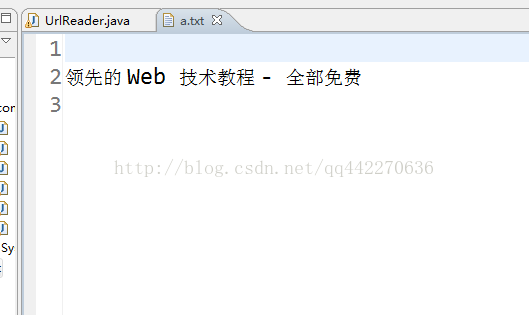

爬取网页其实就是通过URL获取网页信息。网页信息的本质是一段添加了 JavaScript 和 CSS 的 HTML 代码。Python提供了一个第三方模块requests来抓取网页信息。requests 模块称自己为“HTTP for Humans”,字面意思是专门为人类设计的 HTTP 模块。该模块支持发送请求和获取响应。

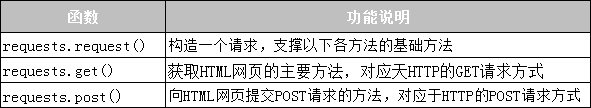

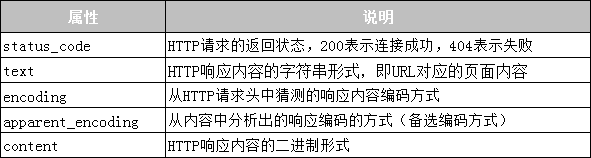

1.发送请求

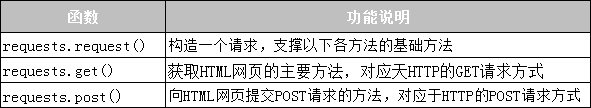

requests 模块提供了许多发送 HTTP 请求的功能。常用的请求函数如表10-1所示。

表10-1 requests模块的Request函数

2.获取回复

requests模块提供的Response类对象用于动态响应客户端的请求,控制发送给用户的信息,动态生成响应,包括状态码、网页内容等。接下来用表格列出Response类可以获取的信息,如表10-2所示。

表10-2 Response类的常用属性

接下来通过一个案例来演示如何使用requests模块抓取百度网页。具体代码如下:

# 01 requests baidu

import requests

base_url = 'http://www.baidu.com'

#发送GET请求

res = requests.get (base_url)

print("响应状态码:{}".format(res.status_code)) #获取响应状态码

print("编码方式:{}".format(res.encoding)) #获取响应内容的编码方式

res.encoding = 'utf-8' #更新响应内容的编码方式为UIE-8

print("网页源代码:\n{}".format(res.text)) #获取响应内容

上面代码中,第二行使用import导入requests模块;第三至第四行代码根据URL向服务器发送GET请求,并使用变量res接收服务器返回的响应内容;第五行至第六行代码打印响应内容的状态码和编码方式;第7行将响应内容的编码方式改为“utf-8”;第 8 行打印响应内容。运行程序,程序输出如下:

响应状态码:200

编码方式:ISO-8859-1

网页源代码:

百度一下,你就知道

…省略N行…

值得一提的是,在使用requests模块爬取网页时,可能会因未连接网络、服务器连接失败等原因出现各种异常,最常见的两个异常是URLError和HTTPError。这些网络异常可以用 try...except 语句捕获和处理。 查看全部

怎样抓取网页数据(

爬取网页其实就是通过URL获取网页信息的实质是一段添加了JavaScript和CSS的HTML代码)

爬取网页其实就是通过URL获取网页信息。网页信息的本质是一段添加了 JavaScript 和 CSS 的 HTML 代码。Python提供了一个第三方模块requests来抓取网页信息。requests 模块称自己为“HTTP for Humans”,字面意思是专门为人类设计的 HTTP 模块。该模块支持发送请求和获取响应。

1.发送请求

requests 模块提供了许多发送 HTTP 请求的功能。常用的请求函数如表10-1所示。

表10-1 requests模块的Request函数

2.获取回复

requests模块提供的Response类对象用于动态响应客户端的请求,控制发送给用户的信息,动态生成响应,包括状态码、网页内容等。接下来用表格列出Response类可以获取的信息,如表10-2所示。

表10-2 Response类的常用属性

接下来通过一个案例来演示如何使用requests模块抓取百度网页。具体代码如下:

# 01 requests baidu

import requests

base_url = 'http://www.baidu.com'

#发送GET请求

res = requests.get (base_url)

print("响应状态码:{}".format(res.status_code)) #获取响应状态码

print("编码方式:{}".format(res.encoding)) #获取响应内容的编码方式

res.encoding = 'utf-8' #更新响应内容的编码方式为UIE-8

print("网页源代码:\n{}".format(res.text)) #获取响应内容

上面代码中,第二行使用import导入requests模块;第三至第四行代码根据URL向服务器发送GET请求,并使用变量res接收服务器返回的响应内容;第五行至第六行代码打印响应内容的状态码和编码方式;第7行将响应内容的编码方式改为“utf-8”;第 8 行打印响应内容。运行程序,程序输出如下:

响应状态码:200

编码方式:ISO-8859-1

网页源代码:

百度一下,你就知道

…省略N行…

值得一提的是,在使用requests模块爬取网页时,可能会因未连接网络、服务器连接失败等原因出现各种异常,最常见的两个异常是URLError和HTTPError。这些网络异常可以用 try...except 语句捕获和处理。

怎样抓取网页数据(怎么快速掌握Python以及爬虫如何抓取网页数据的有些知识)

网站优化 • 优采云 发表了文章 • 0 个评论 • 60 次浏览 • 2022-01-09 03:12

IPy:IP地址相关处理

dnsptyhon:域名相关处理

difflib:文件比较

pexpect:屏幕信息获取,常用于自动化

paramiko:SSH 客户端

XlsxWriter:Excel相关处理

还有很多其他的功能模块,每天都有新的模块、框架和组件产生,比如用于与Java桥接的PythonJS,甚至Python可以写Map和Reduce。

二、爬虫如何抓取网页数据

1. 抓取页面

由于我们通常抓取的内容不止一页,所以要注意翻页时链接的变化、关键词的变化,有时甚至是日期;此外,主网页需要静态和动态加载。

2.提出请求

通过HTTP库向目标站点发起请求,即发送Request,请求中可以收录额外的headers等信息,等待服务器响应。

3.获取响应内容

如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(图片或视频)等类型。

4.解析内容

获取的内容可以是HTML,可以用正则表达式和页面解析库解析,也可以是Json,可以直接转成Json对象解析,也可以是二进制数据,可以保存或进一步处理。

5.保存数据

以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件。

以上介绍了如何快速掌握Python以及爬虫如何抓取网页数据的一些知识。其实,网络爬虫的难点其实并不在于爬虫本身。爬虫相对简单易学。网上的很多教程模板也可以使用。但是为了避免数据被爬取,每个网站添加的各种反爬取措施还是不一样的。如果要继续从 网站 爬取数据,则必须绕过这些措施。使用黑洞代理突破IP限制是一个非常好的方法,其他反爬虫措施可以阅读网站信息。 查看全部

怎样抓取网页数据(怎么快速掌握Python以及爬虫如何抓取网页数据的有些知识)

IPy:IP地址相关处理

dnsptyhon:域名相关处理

difflib:文件比较

pexpect:屏幕信息获取,常用于自动化

paramiko:SSH 客户端

XlsxWriter:Excel相关处理

还有很多其他的功能模块,每天都有新的模块、框架和组件产生,比如用于与Java桥接的PythonJS,甚至Python可以写Map和Reduce。

二、爬虫如何抓取网页数据

1. 抓取页面

由于我们通常抓取的内容不止一页,所以要注意翻页时链接的变化、关键词的变化,有时甚至是日期;此外,主网页需要静态和动态加载。

2.提出请求

通过HTTP库向目标站点发起请求,即发送Request,请求中可以收录额外的headers等信息,等待服务器响应。

3.获取响应内容

如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(图片或视频)等类型。

4.解析内容

获取的内容可以是HTML,可以用正则表达式和页面解析库解析,也可以是Json,可以直接转成Json对象解析,也可以是二进制数据,可以保存或进一步处理。

5.保存数据

以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件。

以上介绍了如何快速掌握Python以及爬虫如何抓取网页数据的一些知识。其实,网络爬虫的难点其实并不在于爬虫本身。爬虫相对简单易学。网上的很多教程模板也可以使用。但是为了避免数据被爬取,每个网站添加的各种反爬取措施还是不一样的。如果要继续从 网站 爬取数据,则必须绕过这些措施。使用黑洞代理突破IP限制是一个非常好的方法,其他反爬虫措施可以阅读网站信息。

怎样抓取网页数据( PHP中的有个函数叫file_get_contents_)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-30 18:01

PHP中的有个函数叫file_get_contents_)

网站优化,除了一些正常的优化方法,我们也比较注重网站收录,但是收录的前提是让搜索引擎蜘蛛爬到你的网站,那么蜘蛛怎么爬呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也是缺一不可的。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛的爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到您网站上的所有网站,而是有一个空间并随机爬行。 查看全部

怎样抓取网页数据(

PHP中的有个函数叫file_get_contents_)

网站优化,除了一些正常的优化方法,我们也比较注重网站收录,但是收录的前提是让搜索引擎蜘蛛爬到你的网站,那么蜘蛛怎么爬呢?

如果你真的想知道一些关于这个的东西,你必须了解这个程序。作为一名合格的SEO,编程是你的必修课。即便是说到程序,数据库和编程语言也是缺一不可的。例如,在 PHP 中有一个名为 file_get_contents 的函数。该函数的作用是获取URL里面的内容,并以文本形式返回结果。当然你也可以使用 URL。

然后,我们可以在程序中使用正则表达式对A-link数据进行提取、合并、减权等杂乱操作,并将数据存入数据库。数据库中有很多数据库,如索引数据库、访问数据库等。为什么索引和条目数不一致?因为它绝对不在同一个库中。

数据抓取完成后,自然会获取数据库中不存在的链接,然后程序会发出另一条指令获取这些库中没有存储的URL。它将一直爬到页面的末尾。当然,你抓得越多,你就越有可能没有抓住它。

百度站长频道会有抓取频率和抓取时间数据。你应该看到每只蜘蛛的爬行都是不规则的,但是通过日常观察,你会发现页面越深,被抓到的概率越低。原因很简单。蜘蛛并不总是爬到您网站上的所有网站,而是有一个空间并随机爬行。

怎样抓取网页数据(百度对sitemap的生成规则,看看百度站长平台有什么格式要求)

网站优化 • 优采云 发表了文章 • 0 个评论 • 54 次浏览 • 2021-12-30 17:25

作为seoer,在优化一个网站的时候,肯定离不开百度站长平台的监控,而且百度站长平台上有一个站点地图文件,可以批量提交网站网址到百度站长平台。

我们来看看百度的站点地图生成规则,看看百度对站点地图有哪些格式要求。这里可以看到百度支持两种格式,一种是txt格式,一种是xml格式,今天是xml格式。生成网站的站点地图文件:

这次用python生成站点地图,首先需要抓取整个站点的url,然后将整个站点的url保存在一个xml文件中。这里我使用异步加载请求来获取站点范围的 URL。异步方法具有节省请求时间和速度快的优点。当网站没有反爬虫措施时,使用异步加载是更好的选择。

好了,思路有了,接下来我们开始写代码:

一、设置爬取的网站

这次使用BeautifulSoup进行分析,导入asyncio和aiohttp包和logger生成日志文件

BASE_URL = 'https://www.danmoln.com'

二、请求获取对应的url

使用BeautifulSoup解析得到所有的a标签,然后根据条件提取url,这里使用的集合集合,使用集合集合对爬取的url进行去重

三、main函数创建对象和循环任务

在main函数中,利用了集合的并集和子集关系,利用这个关系循环创建任务,获取最新的url集合,然后将最新的url集合合并到主集合中

四、另存为站点地图文件

按照百度的格式格式化URL

五、最后运行效果

好像sitemap文件已经生成了,接下来我们只需要把sitemao文件上传到服务器根目录,然后在百度站长平台上生成就可以了。需要码可以私信我 查看全部

怎样抓取网页数据(百度对sitemap的生成规则,看看百度站长平台有什么格式要求)

作为seoer,在优化一个网站的时候,肯定离不开百度站长平台的监控,而且百度站长平台上有一个站点地图文件,可以批量提交网站网址到百度站长平台。

我们来看看百度的站点地图生成规则,看看百度对站点地图有哪些格式要求。这里可以看到百度支持两种格式,一种是txt格式,一种是xml格式,今天是xml格式。生成网站的站点地图文件:

这次用python生成站点地图,首先需要抓取整个站点的url,然后将整个站点的url保存在一个xml文件中。这里我使用异步加载请求来获取站点范围的 URL。异步方法具有节省请求时间和速度快的优点。当网站没有反爬虫措施时,使用异步加载是更好的选择。

好了,思路有了,接下来我们开始写代码:

一、设置爬取的网站

这次使用BeautifulSoup进行分析,导入asyncio和aiohttp包和logger生成日志文件

BASE_URL = 'https://www.danmoln.com'

二、请求获取对应的url

使用BeautifulSoup解析得到所有的a标签,然后根据条件提取url,这里使用的集合集合,使用集合集合对爬取的url进行去重

三、main函数创建对象和循环任务

在main函数中,利用了集合的并集和子集关系,利用这个关系循环创建任务,获取最新的url集合,然后将最新的url集合合并到主集合中

四、另存为站点地图文件

按照百度的格式格式化URL

五、最后运行效果

好像sitemap文件已经生成了,接下来我们只需要把sitemao文件上传到服务器根目录,然后在百度站长平台上生成就可以了。需要码可以私信我

怎样抓取网页数据(服务在访问该网页时的bug!(图))

网站优化 • 优采云 发表了文章 • 0 个评论 • 51 次浏览 • 2021-12-29 13:04

怎样抓取网页数据?

哈,

这种现象很正常,今天遇到了,话说你试试:#coding:utf-8importurllib2url="="+http。cookie+"&src=zh_cn&di=080b5464eb4c350e9c30baaae6b&page=0&keywords=youku"headers={"accept":"text/html,application/xhtml+xml,application/xml;q=0。

9,image/webp,image/apng,*/*;q=0。8","accept-encoding":"gzip,deflate","accept-language":"zh-cn,zh;q=0。8","cookie":"user-agent=youku。me"}query=urllib2。urlopen(re。

findall("",headers=headers))querylist=[]forrinquery:print(r)print("\n")结果如下:。

请问是怎么解决的,我刚提交了个问题,没想到已经有了(),

无解

你先转义下utf-8再进行试试

我能给出有效的替代方案:登录网页再查看

请问解决了吗?我也是这样,

这是google服务在访问该网页时的bug!本人亲测google微博国内的ua是翻墙访问, 查看全部

怎样抓取网页数据(服务在访问该网页时的bug!(图))

怎样抓取网页数据?

哈,

这种现象很正常,今天遇到了,话说你试试:#coding:utf-8importurllib2url="="+http。cookie+"&src=zh_cn&di=080b5464eb4c350e9c30baaae6b&page=0&keywords=youku"headers={"accept":"text/html,application/xhtml+xml,application/xml;q=0。

9,image/webp,image/apng,*/*;q=0。8","accept-encoding":"gzip,deflate","accept-language":"zh-cn,zh;q=0。8","cookie":"user-agent=youku。me"}query=urllib2。urlopen(re。

findall("",headers=headers))querylist=[]forrinquery:print(r)print("\n")结果如下:。

请问是怎么解决的,我刚提交了个问题,没想到已经有了(),

无解

你先转义下utf-8再进行试试

我能给出有效的替代方案:登录网页再查看

请问解决了吗?我也是这样,

这是google服务在访问该网页时的bug!本人亲测google微博国内的ua是翻墙访问,

怎样抓取网页数据(我需要一种方法,让我的Python从Google搜索中获取链接)

网站优化 • 优采云 发表了文章 • 0 个评论 • 52 次浏览 • 2021-12-29 09:19

《免费学习60+公开课:投票页面,点击讲师头像》

作者 | 链接

翻译 | 新月,编辑| 郭锐

来源 | CSDN(ID:CSDNnews)

自从 2011 年 Google Web Search API 被弃用以来,我一直在寻找其他方法来抓取 Google。我需要一种方法让我的 Python 脚本从 Google 搜索中获取链接。所以,我自己想出了一个方法,这篇文章是通过请求和 Beautiful Soup 抓取 Google 搜索的快速指南。

首先,让我们安装一些依赖项。请将以下内容保存为文本文件requirements.txt:

<p>requests

bs4</p>

接下来,运行 pip install -r requirements.txt 命令来安装依赖项。然后将其导入到您的脚本中。

<p>import urllib

import requests

from bs4 import BeautifulSoup</p>

为了执行搜索,您需要在 URL 中向 Google 提供查询参数。此外,所有空格都必须替换为 +。为了构造 URL,我们需要设置正确的查询格式并将其放入 q 参数中。

<p>query = "hackernoon How To Scrape Google With Python"

query = query.replace(' ', '+')

URL = f"https://google.com/search?q={query}"</p>

Google 将针对移动设备和台式计算机返回不同的搜索结果。因此,我们需要指定一个合适的用户代理。

<p># desktop user-agent

USER_AGENT = "Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:65.0) Gecko/20100101 Firefox/65.0"

# mobile user-agent

MOBILE_USER_AGENT = "Mozilla/5.0 (Linux; Android 7.0; SM-G930V Build/NRD90M) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.125 Mobile Safari/537.36"</p>

发送请求很简单。但是,请求需要将用户代理放在请求的开头。为了设置正确的标题,我们必须将字典传递给标题。

<p>headers = {"user-agent" : MOBILE_USER_AGENT}

resp = requests.get(URL, headers=headers)</p>

接下来,我们需要检查请求是否成功。最简单的方法是检查状态代码。如果返回 200,则表示成功。然后,我们需要将其放入 Beautiful Soup 中来解析内容。

<p>if resp.status_code == 200:

soup = BeautifulSoup(resp.content, "html.parser")</p>

下一步是解析数据并从页面中提取所有链接。我们可以使用 Beautiful Soup 轻松完成这项任务。在促进每个链接时,我们需要将结果存储在列表中。

<p>results =

for g in soup.find_all('div', class_='r'):

anchors = g.find_all('a')

if anchors:

link = anchors[0]['href']

title = g.find('h3').text

item = {

"title": title,

"link": link

}

results.append(item)

print(results)</p>

而已。该脚本非常简单且容易出错。但至少它可以让你开始,从那时起你可以编写自己的谷歌爬虫。您可以从 GitHub 下载整个脚本:

.com/getlinksc/scrape_google

原文链接:

.com/how-to-scrape-google-with-python-bo7d2tal

(*本文为AI技术大本营转载文章,转载请联系作者)

所有CSDN用户均可参与投票抽奖活动

加入福利群,每周送精选学习资料、技术书籍等福利 查看全部

怎样抓取网页数据(我需要一种方法,让我的Python从Google搜索中获取链接)

《免费学习60+公开课:投票页面,点击讲师头像》

作者 | 链接

翻译 | 新月,编辑| 郭锐

来源 | CSDN(ID:CSDNnews)

自从 2011 年 Google Web Search API 被弃用以来,我一直在寻找其他方法来抓取 Google。我需要一种方法让我的 Python 脚本从 Google 搜索中获取链接。所以,我自己想出了一个方法,这篇文章是通过请求和 Beautiful Soup 抓取 Google 搜索的快速指南。