如何批量采集高质量好文章

如何批量采集高质量好文章(如何批量采集高质量好文章?采集文章方法很多,但是方法不多)

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-11-20 09:13

如何批量采集高质量好文章?采集文章方法很多,但是方法都是适合某个大的平台,可以采集高质量文章并提取标题对于一些小平台来说,采集的方法就不多了,给大家介绍一种非常有效的采集方法,首先要注册一个订阅号(公众号名字叫:xxx),然后给公众号添加群发即可,如下图:如何批量下载高质量文章呢?以财经类的高质量文章为例,下面我将介绍两种方法:方法一:查询网络爬虫对网站爬虫采集获取网站对应的文章查询网址::sns文章高质量获取对于发布sns账号的主要高质量文章,可以查看该账号的内容更新以及标题,然后匹配出关键词,如下图:下面是使用工具搜狗指数获取热词后,利用工具搜狗指数去采集的链接然后匹配上关键词,如下图:然后就是选择关键词下面两个模块,我就不一一介绍了。

以上工具软件只能获取到一些爬虫网站的热词后返回的数据,但是小平台的热词不适合爬虫下载,还有一个下载方法,就是去各个高质量平台搜索,然后观察他们的数据库里有哪些高质量的文章,把这些高质量的文章p出来即可。如果想要找到高质量的原创文章,也可以加我交流,希望本篇内容对您有所帮助!。

呃,关于批量采集爬虫文章的方法其实应该是有很多的,但是首先我觉得,有机会我会推荐阿里云的采集器:,你问我其他地方有没有比还全的?我只能说有,但是有你也不一定用得上吧!知乎里推荐的资源有很多但是,下载的网站是越多对于你掌握爬虫技能来说, 查看全部

如何批量采集高质量好文章(如何批量采集高质量好文章?采集文章方法很多,但是方法不多)

如何批量采集高质量好文章?采集文章方法很多,但是方法都是适合某个大的平台,可以采集高质量文章并提取标题对于一些小平台来说,采集的方法就不多了,给大家介绍一种非常有效的采集方法,首先要注册一个订阅号(公众号名字叫:xxx),然后给公众号添加群发即可,如下图:如何批量下载高质量文章呢?以财经类的高质量文章为例,下面我将介绍两种方法:方法一:查询网络爬虫对网站爬虫采集获取网站对应的文章查询网址::sns文章高质量获取对于发布sns账号的主要高质量文章,可以查看该账号的内容更新以及标题,然后匹配出关键词,如下图:下面是使用工具搜狗指数获取热词后,利用工具搜狗指数去采集的链接然后匹配上关键词,如下图:然后就是选择关键词下面两个模块,我就不一一介绍了。

以上工具软件只能获取到一些爬虫网站的热词后返回的数据,但是小平台的热词不适合爬虫下载,还有一个下载方法,就是去各个高质量平台搜索,然后观察他们的数据库里有哪些高质量的文章,把这些高质量的文章p出来即可。如果想要找到高质量的原创文章,也可以加我交流,希望本篇内容对您有所帮助!。

呃,关于批量采集爬虫文章的方法其实应该是有很多的,但是首先我觉得,有机会我会推荐阿里云的采集器:,你问我其他地方有没有比还全的?我只能说有,但是有你也不一定用得上吧!知乎里推荐的资源有很多但是,下载的网站是越多对于你掌握爬虫技能来说,

如何批量采集高质量好文章( 上上篇文章爬虫如何爬取微信公众号文章(二))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-20 07:07

上上篇文章爬虫如何爬取微信公众号文章(二))

python爬虫如何实现每天爬取微信公众号的推送文章

上一篇文章如何抓取微信公众号文章

第一篇文章如何用python爬虫爬取微信公众号文章(二)

以上文章分别介绍了如何批量获取公众号的历史文章url,以及如何批量抓取公众号的文章,提取需要的数据并保存在数据库。

本文文章将介绍如何自动抓取公众号每天推送的文章,然后提取数据保存到数据库中。

首先介绍一个基于itchat的微信借口wxpy。通过大量的界面优化提高了模块的易用性,并进行了丰富的功能扩展。

通过wxpy可以接收微信公众号推送的文章,但是它只实现了每个文章@的标题(title)、摘要(summary)、链接(url)、封面图(cover) > ,我在此基础上又增加了两个属性,分别是文章的发布时间(pub_time)和文章的出处(source)

@property

def articles(self):

"""

公众号推送中的文章列表 (首篇的 标题/地址 与消息中的 text/url 相同)

其中,每篇文章均有以下属性:

* `title`: 标题

* `summary`: 摘要

* `url`: 文章 URL

* `cover`: 封面或缩略图 URL

"""

from wxpy import MP

if self.type == SHARING and isinstance(self.sender, MP):

tree = ETree.fromstring(self.raw['Content'])

# noinspection SpellCheckingInspection

items = tree.findall('.//mmreader/category/item')

article_list = list()

for item in items:

def find_text(tag):

found = item.find(tag)

if found is not None:

return found.text

article = Article()

article.title = find_text('title')

article.summary = find_text('digest')

article.url = find_text('url')

article.cover = find_text('cover')

article.pub_time = find_text('pub_time')

article.source = find_text('.//name')

article_list.append(article)

return article_list

这两个属性也应该添加到article.py中:

# 发布时间

self.pub_time = None

# 来源

self.source = None

事实上,还有其他几个属性。属性如下,可以通过ElementTree获取,看你的需要。

5

1

1

0

0

0

0

1566993086

100020868

0

1

0

0

0

963025857335934976

2

0

0

0

0

1

改完上面的代码后,第一篇文章中实现主要逻辑的函数文章python爬虫如何抓取微信公众号文章(二)也需要改,即url 地址和发布时间作为参数传递,而不是列表类型。

def wechat_run(self,url,pub_time): # 实现主要逻辑

# 打开数据库连接(ip/数据库用户名/登录密码/数据库名)

db = pymysql.connect("localhost", "root", "root", "weixin_database")

# 使用 cursor() 方法创建一个游标对象 cursor

cursor = db.cursor()

html_str = self.parse_url(url)

content_list = self.get_content_list(html_str)

title = ''.join(content_list[0]["title"])

# other1 = ''.join(content_list[0]["other"])

other = '\n'.join(content_list[0]["other"])

create_time = pub_time

# print(other)

p1 = re.compile(r'\s*[(|(]20\d+[)|)]\s*[\u4e00-\u9fa5]*[\d]*[\u4e00-\u9fa5]+[\d]+号', re.S)

anhao = re.search(p1, other)

if (anhao):

anhao = anhao.group().replace("\n", "")

else:

anhao = ""

p2 = re.compile(r'\s[【]*裁判要[\u4e00-\u9fa5]\s*.*?(?=[【]|裁判文)', re.S)

zhaiyao = ''.join(re.findall(p2, other)).replace("\n", "")

# print(zhaiyao)

p3 = re.compile('.*?', re.S)

html = re.search(p3, html_str)

if (html):

html = re.search(p3, html_str).group().replace("\n", "")

else:

html = html_str.replace("\n", "")

sql = """INSERT INTO weixin_table(title,url,anhao,yaozhi,other,html,create_time,type_id)

VALUES ({},{},{},{},{},{},{},{})""".format('"' + title + '"', '"' + url + '"', '"' + anhao + '"',

'"' + zhaiyao + '"', '"' + other + '"', "'" + html + "'",

create_time, 4)

# print(sql)

try:

# 执行sql语句

cursor.execute(sql)

# 提交到数据库执行

db.commit()

print("数据插入成功")

except:

print("数据插入失败:")

info = sys.exc_info()

print(info[0], ":", info[1])

# 如果发生错误则回滚

db.rollback()

# 3.保存html

page_name = title

self.save_html(html, page_name)

# 关闭数据库连接

db.close()

然后编写接收微信消息和公众号推送的函数:

# -*- coding: utf-8 -*-

# @Time : 2019/8/29 上午8:31

# @Author : jingyoushui

# @Email : jingyoushui@163.com

# @File : wechat.py

# @Software: PyCharm

from beijing import WeixinSpider_1

from wxpy import *

import pandas as pd

bot = Bot(cache_path=True, console_qr=True)

# 打印来自其他好友、群聊和公众号的消息

@bot.register()

def print_others(msg):

print('msg:' + str(msg))

articles = msg.articles

if articles is not None:

for article in articles:

a = str(article.source)

print('title:' + str(article.title))

print('url:' + str(article.url))

print('pub_time:' + article.pub_time)

print('source:' + a)

if a != "KMTV" and a != "北京行政裁判观察":

pass

else:

content_list = []

items = []

items.append(str(article.title))

url = str(article.url)

items.append(url)

pub_time = article.pub_time

items.append(pub_time)

content_list.append(items)

name = ['title', 'link', 'create_time']

test = pd.DataFrame(columns=name, data=content_list)

if a == "KMTV":

test.to_csv("everyday_url/kmtv.csv", mode='a', encoding='utf-8')

print("保存成功")

if a == "北京行政裁判观察":

test.to_csv("everyday_url/beijing.csv", mode='a', encoding='utf-8')

print("保存成功")

weixin_spider_1 = WeixinSpider_1()

weixin_spider_1.wechat_run(url, pub_time)

if __name__ == '__main__':

# 堵塞线程

bot.join()

首先获取要爬取的公众号推送的文章的标题、url、发布时间、来源等信息,并保存在一个csv文件中,然后调用WeixinSpider_1类的wechat_run函数实现url的分析和数据 提取数据、保存数据到数据库等操作。

在终端运行程序,打印出二维码,扫描手机微信即可登录

操作方式是阻塞线程,可以处于登录状态,除非你在网页上登录这个账号,否则会被挤掉退出。

8月30日补充: 查看全部

如何批量采集高质量好文章(

上上篇文章爬虫如何爬取微信公众号文章(二))

python爬虫如何实现每天爬取微信公众号的推送文章

上一篇文章如何抓取微信公众号文章

第一篇文章如何用python爬虫爬取微信公众号文章(二)

以上文章分别介绍了如何批量获取公众号的历史文章url,以及如何批量抓取公众号的文章,提取需要的数据并保存在数据库。

本文文章将介绍如何自动抓取公众号每天推送的文章,然后提取数据保存到数据库中。

首先介绍一个基于itchat的微信借口wxpy。通过大量的界面优化提高了模块的易用性,并进行了丰富的功能扩展。

通过wxpy可以接收微信公众号推送的文章,但是它只实现了每个文章@的标题(title)、摘要(summary)、链接(url)、封面图(cover) > ,我在此基础上又增加了两个属性,分别是文章的发布时间(pub_time)和文章的出处(source)

@property

def articles(self):

"""

公众号推送中的文章列表 (首篇的 标题/地址 与消息中的 text/url 相同)

其中,每篇文章均有以下属性:

* `title`: 标题

* `summary`: 摘要

* `url`: 文章 URL

* `cover`: 封面或缩略图 URL

"""

from wxpy import MP

if self.type == SHARING and isinstance(self.sender, MP):

tree = ETree.fromstring(self.raw['Content'])

# noinspection SpellCheckingInspection

items = tree.findall('.//mmreader/category/item')

article_list = list()

for item in items:

def find_text(tag):

found = item.find(tag)

if found is not None:

return found.text

article = Article()

article.title = find_text('title')

article.summary = find_text('digest')

article.url = find_text('url')

article.cover = find_text('cover')

article.pub_time = find_text('pub_time')

article.source = find_text('.//name')

article_list.append(article)

return article_list

这两个属性也应该添加到article.py中:

# 发布时间

self.pub_time = None

# 来源

self.source = None

事实上,还有其他几个属性。属性如下,可以通过ElementTree获取,看你的需要。

5

1

1

0

0

0

0

1566993086

100020868

0

1

0

0

0

963025857335934976

2

0

0

0

0

1

改完上面的代码后,第一篇文章中实现主要逻辑的函数文章python爬虫如何抓取微信公众号文章(二)也需要改,即url 地址和发布时间作为参数传递,而不是列表类型。

def wechat_run(self,url,pub_time): # 实现主要逻辑

# 打开数据库连接(ip/数据库用户名/登录密码/数据库名)

db = pymysql.connect("localhost", "root", "root", "weixin_database")

# 使用 cursor() 方法创建一个游标对象 cursor

cursor = db.cursor()

html_str = self.parse_url(url)

content_list = self.get_content_list(html_str)

title = ''.join(content_list[0]["title"])

# other1 = ''.join(content_list[0]["other"])

other = '\n'.join(content_list[0]["other"])

create_time = pub_time

# print(other)

p1 = re.compile(r'\s*[(|(]20\d+[)|)]\s*[\u4e00-\u9fa5]*[\d]*[\u4e00-\u9fa5]+[\d]+号', re.S)

anhao = re.search(p1, other)

if (anhao):

anhao = anhao.group().replace("\n", "")

else:

anhao = ""

p2 = re.compile(r'\s[【]*裁判要[\u4e00-\u9fa5]\s*.*?(?=[【]|裁判文)', re.S)

zhaiyao = ''.join(re.findall(p2, other)).replace("\n", "")

# print(zhaiyao)

p3 = re.compile('.*?', re.S)

html = re.search(p3, html_str)

if (html):

html = re.search(p3, html_str).group().replace("\n", "")

else:

html = html_str.replace("\n", "")

sql = """INSERT INTO weixin_table(title,url,anhao,yaozhi,other,html,create_time,type_id)

VALUES ({},{},{},{},{},{},{},{})""".format('"' + title + '"', '"' + url + '"', '"' + anhao + '"',

'"' + zhaiyao + '"', '"' + other + '"', "'" + html + "'",

create_time, 4)

# print(sql)

try:

# 执行sql语句

cursor.execute(sql)

# 提交到数据库执行

db.commit()

print("数据插入成功")

except:

print("数据插入失败:")

info = sys.exc_info()

print(info[0], ":", info[1])

# 如果发生错误则回滚

db.rollback()

# 3.保存html

page_name = title

self.save_html(html, page_name)

# 关闭数据库连接

db.close()

然后编写接收微信消息和公众号推送的函数:

# -*- coding: utf-8 -*-

# @Time : 2019/8/29 上午8:31

# @Author : jingyoushui

# @Email : jingyoushui@163.com

# @File : wechat.py

# @Software: PyCharm

from beijing import WeixinSpider_1

from wxpy import *

import pandas as pd

bot = Bot(cache_path=True, console_qr=True)

# 打印来自其他好友、群聊和公众号的消息

@bot.register()

def print_others(msg):

print('msg:' + str(msg))

articles = msg.articles

if articles is not None:

for article in articles:

a = str(article.source)

print('title:' + str(article.title))

print('url:' + str(article.url))

print('pub_time:' + article.pub_time)

print('source:' + a)

if a != "KMTV" and a != "北京行政裁判观察":

pass

else:

content_list = []

items = []

items.append(str(article.title))

url = str(article.url)

items.append(url)

pub_time = article.pub_time

items.append(pub_time)

content_list.append(items)

name = ['title', 'link', 'create_time']

test = pd.DataFrame(columns=name, data=content_list)

if a == "KMTV":

test.to_csv("everyday_url/kmtv.csv", mode='a', encoding='utf-8')

print("保存成功")

if a == "北京行政裁判观察":

test.to_csv("everyday_url/beijing.csv", mode='a', encoding='utf-8')

print("保存成功")

weixin_spider_1 = WeixinSpider_1()

weixin_spider_1.wechat_run(url, pub_time)

if __name__ == '__main__':

# 堵塞线程

bot.join()

首先获取要爬取的公众号推送的文章的标题、url、发布时间、来源等信息,并保存在一个csv文件中,然后调用WeixinSpider_1类的wechat_run函数实现url的分析和数据 提取数据、保存数据到数据库等操作。

在终端运行程序,打印出二维码,扫描手机微信即可登录

操作方式是阻塞线程,可以处于登录状态,除非你在网页上登录这个账号,否则会被挤掉退出。

8月30日补充:

如何批量采集高质量好文章(孤狼工作室开发的微信文章采集器是高质量的吗 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-11-19 17:18

)

微信文章采集器由孤狼工作室开发,从最初的版本1.0到现在的版本10.0,经历了多次改版。是为适应广大微信运营商和网站运营商提供的利器。但是,微信文章都是优质的吗?下面孤狼工作室为您一一解答

所谓的世界文章一般都是抄的,这句话是对的,但是如果抄作业连名字都抄就悲剧了,不屏蔽你就奇怪了。微信公众号助手是一款采集软件,可以采集到达多个微信文章,也可以采集指定公众号文章。这样,虽然微信限制了别人的收录自己的东西,但这样一来,所有的微信文章都将毫无隐私可言。我们要采集如何采集。

采集 下来之后,必须有处理和处理,除非你想被百度屏蔽,想被客户丢弃。

如何处理?首先,软件具有批量校验功能。这个特性对于采集的分类非常有用。 文章是原创的微信应用。其中大部分不能再版。这样,文章的品质和唯一性有了保证。姑且不论,如果百度也这样支持原创,就不会有这么多垃圾站了。

那我们就去关键词采集找更多的素材,一定很丰富。客户只会继续阅读。比如文章开头用文字描述,中间用图片勾勒,结尾用视频结束。这样的文章让客户看起来很舒服。

总是谈论客户体验,我们必须关注细节。 文章的质量一定要非常好读,图文并茂。然后文章可以给客户留下第一印象。

最后我想说的是文章只是网站的骨肉,前提一定是框架好,然后再填内容,不然你会发现以后修改关键词的布局会很麻烦,慎重。

软件具有标题添加关键词和内容添加关键词功能。

查看全部

如何批量采集高质量好文章(孤狼工作室开发的微信文章采集器是高质量的吗

)

微信文章采集器由孤狼工作室开发,从最初的版本1.0到现在的版本10.0,经历了多次改版。是为适应广大微信运营商和网站运营商提供的利器。但是,微信文章都是优质的吗?下面孤狼工作室为您一一解答

所谓的世界文章一般都是抄的,这句话是对的,但是如果抄作业连名字都抄就悲剧了,不屏蔽你就奇怪了。微信公众号助手是一款采集软件,可以采集到达多个微信文章,也可以采集指定公众号文章。这样,虽然微信限制了别人的收录自己的东西,但这样一来,所有的微信文章都将毫无隐私可言。我们要采集如何采集。

采集 下来之后,必须有处理和处理,除非你想被百度屏蔽,想被客户丢弃。

如何处理?首先,软件具有批量校验功能。这个特性对于采集的分类非常有用。 文章是原创的微信应用。其中大部分不能再版。这样,文章的品质和唯一性有了保证。姑且不论,如果百度也这样支持原创,就不会有这么多垃圾站了。

http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-300x203.jpg 300w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-768x521.jpg 768w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-220x150.jpg 220w" />

http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-300x203.jpg 300w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-768x521.jpg 768w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-220x150.jpg 220w" />那我们就去关键词采集找更多的素材,一定很丰富。客户只会继续阅读。比如文章开头用文字描述,中间用图片勾勒,结尾用视频结束。这样的文章让客户看起来很舒服。

总是谈论客户体验,我们必须关注细节。 文章的质量一定要非常好读,图文并茂。然后文章可以给客户留下第一印象。

最后我想说的是文章只是网站的骨肉,前提一定是框架好,然后再填内容,不然你会发现以后修改关键词的布局会很麻烦,慎重。

软件具有标题添加关键词和内容添加关键词功能。

http://www.gulangu.com/wp-cont ... 2.jpg 300w, http://www.gulangu.com/wp-cont ... 8.jpg 768w, http://www.gulangu.com/wp-cont ... 8.jpg 220w" />

http://www.gulangu.com/wp-cont ... 2.jpg 300w, http://www.gulangu.com/wp-cont ... 8.jpg 768w, http://www.gulangu.com/wp-cont ... 8.jpg 220w" /> 如何批量采集高质量好文章(优采云亚马逊数据采集软件采集数据有哪些功能优势呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-11-19 02:05

批量采集亚马逊的商品数据和评论信息可以帮助我们快速了解对手的信息,可以有针对性地提高我们店铺的产品竞争力。我们如何将 采集 批处理到这些数据?

优采云亚马逊数据采集软件可以批量、实时的采集亚马逊跨国产品数据或评论信息,这些数据可以作为监控竞争对手价格变化或采集之后的自我分析@>。可以导出为excel表格供第三方购物平台使用。

优采云亚马逊数据采集软件采集数据的功能优势是什么?

1、可以批量查询某个店铺的商品,多个关键词在搜索结果中实时排名;

2、您可以根据不同的国家和地区进行查询;

3、根据关键词或分类页面采集产品图片、价格、属性、运费、详细描述、型号等信息导出为csv格式数据;

4、可以批量采集产品评论信息导出;

5、可以自定义任何其他字段采集,可以使用任何字段;

6、支持断点续传,可以切换VPN继续采集;

7、内置高匿名代理IP模式采集,支持高匿名或独占代理采集;

8、支持自动编码采集,集成第三方编码平台。

优采云亚马逊数据采集软件可以将数据导出到自己的购物网站,也可以将采集导出到对方的商品信息中,监控整个行业的走势。如果你有这方面的需求,不妨自己试试,看看这个软件的效果是不是像小编说的那么好。点击如何批量采集阿里巴巴的热门推荐关键词?可以学习采集阿里巴巴关键词的方法。 查看全部

如何批量采集高质量好文章(优采云亚马逊数据采集软件采集数据有哪些功能优势呢?)

批量采集亚马逊的商品数据和评论信息可以帮助我们快速了解对手的信息,可以有针对性地提高我们店铺的产品竞争力。我们如何将 采集 批处理到这些数据?

优采云亚马逊数据采集软件可以批量、实时的采集亚马逊跨国产品数据或评论信息,这些数据可以作为监控竞争对手价格变化或采集之后的自我分析@>。可以导出为excel表格供第三方购物平台使用。

优采云亚马逊数据采集软件采集数据的功能优势是什么?

1、可以批量查询某个店铺的商品,多个关键词在搜索结果中实时排名;

2、您可以根据不同的国家和地区进行查询;

3、根据关键词或分类页面采集产品图片、价格、属性、运费、详细描述、型号等信息导出为csv格式数据;

4、可以批量采集产品评论信息导出;

5、可以自定义任何其他字段采集,可以使用任何字段;

6、支持断点续传,可以切换VPN继续采集;

7、内置高匿名代理IP模式采集,支持高匿名或独占代理采集;

8、支持自动编码采集,集成第三方编码平台。

优采云亚马逊数据采集软件可以将数据导出到自己的购物网站,也可以将采集导出到对方的商品信息中,监控整个行业的走势。如果你有这方面的需求,不妨自己试试,看看这个软件的效果是不是像小编说的那么好。点击如何批量采集阿里巴巴的热门推荐关键词?可以学习采集阿里巴巴关键词的方法。

如何批量采集高质量好文章(如何批量采集高质量好文章【输入关键词+批量图片文字】)

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-16 02:01

如何批量采集高质量好文章【输入关键词+批量图片文字】在批量采集的过程中,因为不了解如何批量采集,所以图片质量低,甚至后期恢复的过程中,一篇文章重新生成很多次,算法复杂,极大降低了我工作效率,后面了解到批量采集工具,了解到工具很多,对各个工具也都有了一定的了解,最后做一个权衡,最终选择了文章批量采集器,效率提高明显,文章采集过程过于繁琐,有兴趣的大家可以试一下,说下我的使用经验:如何采集高质量好文章,是一篇文章批量生成多个大文件,比如一篇文章5mb(高质量文章肯定都是万字以上),就要采集5.6万字以上的文章,平时很多篇图片采集,我就是这样做的,用批量采集器批量采集网页,去掉图片,再加文字,简单的批量操作,对批量采集工具没多大要求,但对图片文字颜色什么的,都有要求,一般最终都会采集5-6万字以上,所以对图片和文字文字的数量需求较高,对于数据量很大的,用批量采集器批量采集下也是不错的,也是数据采集的一种方式,像我这样图片和文字数量较小的也可以用批量采集器来进行采集。

在开始我的网站抓取,文章的时候,是按照一篇30mb的文章为例来操作的,我从中选择了2篇,最后是10kb,一篇10mb,这些图片是我自己输入关键词采集的,我的标准就是字数长小,一篇文章10mb的,标准,但我自己采集下来,一篇的字数真的不足3mb,这篇是真的采集的比较多,文章里面很多表格等等,很多有用的数据,关键词选的好,这个就起到一个比较大的作用了,所以对选的关键词很重要。

今天我这边一共收到了6篇采集好的文章,可是我把里面的表格都删了,就只剩一些数据,我就直接拖到一起,建一个git仓库,然后不管它,想到什么就管什么就行了,然后工具没有乱标价格,只是工具管理而已,标准你自己把握就好了,我这边是比较贵的,自己的需求就是,自己可以手动,也可以用脚本软件管理自己的采集工具,两者结合使用,效率更高。

下面我要说的是软件功能,注意是我采集的,不是和我开发的软件的功能,不想被后面挖坑,我和我的公司达成了共识,这个软件就是为了省时省力省心,这种就是适合我这种没有时间做维护的人做一个采集工具,只要软件稳定运行,能给我提供数据源就行了,我这边本地存着二级别的数据,目前我想用这个工具来管理我的公司的文章源了,好久没搞文章了,后面我自己接私活的时候能发挥点作用,也可以方便,查询代码的时候更有针对性,再者就是文章数量太大的,可以把每篇文章分割得比较细,按字节或者按词组计算,我这边是抓取8千字以上了,数据处理比较。 查看全部

如何批量采集高质量好文章(如何批量采集高质量好文章【输入关键词+批量图片文字】)

如何批量采集高质量好文章【输入关键词+批量图片文字】在批量采集的过程中,因为不了解如何批量采集,所以图片质量低,甚至后期恢复的过程中,一篇文章重新生成很多次,算法复杂,极大降低了我工作效率,后面了解到批量采集工具,了解到工具很多,对各个工具也都有了一定的了解,最后做一个权衡,最终选择了文章批量采集器,效率提高明显,文章采集过程过于繁琐,有兴趣的大家可以试一下,说下我的使用经验:如何采集高质量好文章,是一篇文章批量生成多个大文件,比如一篇文章5mb(高质量文章肯定都是万字以上),就要采集5.6万字以上的文章,平时很多篇图片采集,我就是这样做的,用批量采集器批量采集网页,去掉图片,再加文字,简单的批量操作,对批量采集工具没多大要求,但对图片文字颜色什么的,都有要求,一般最终都会采集5-6万字以上,所以对图片和文字文字的数量需求较高,对于数据量很大的,用批量采集器批量采集下也是不错的,也是数据采集的一种方式,像我这样图片和文字数量较小的也可以用批量采集器来进行采集。

在开始我的网站抓取,文章的时候,是按照一篇30mb的文章为例来操作的,我从中选择了2篇,最后是10kb,一篇10mb,这些图片是我自己输入关键词采集的,我的标准就是字数长小,一篇文章10mb的,标准,但我自己采集下来,一篇的字数真的不足3mb,这篇是真的采集的比较多,文章里面很多表格等等,很多有用的数据,关键词选的好,这个就起到一个比较大的作用了,所以对选的关键词很重要。

今天我这边一共收到了6篇采集好的文章,可是我把里面的表格都删了,就只剩一些数据,我就直接拖到一起,建一个git仓库,然后不管它,想到什么就管什么就行了,然后工具没有乱标价格,只是工具管理而已,标准你自己把握就好了,我这边是比较贵的,自己的需求就是,自己可以手动,也可以用脚本软件管理自己的采集工具,两者结合使用,效率更高。

下面我要说的是软件功能,注意是我采集的,不是和我开发的软件的功能,不想被后面挖坑,我和我的公司达成了共识,这个软件就是为了省时省力省心,这种就是适合我这种没有时间做维护的人做一个采集工具,只要软件稳定运行,能给我提供数据源就行了,我这边本地存着二级别的数据,目前我想用这个工具来管理我的公司的文章源了,好久没搞文章了,后面我自己接私活的时候能发挥点作用,也可以方便,查询代码的时候更有针对性,再者就是文章数量太大的,可以把每篇文章分割得比较细,按字节或者按词组计算,我这边是抓取8千字以上了,数据处理比较。

如何批量采集高质量好文章(如何批量采集高质量好文章?(一)_)

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-11-13 11:03

如何批量采集高质量好文章?对于这个问题,之前经常从网上找搜索一些大牛的博客来看,然后下载其他网站的内容,这样导致排名前排的基本上都是大牛的文章,有些却排在了0.01页,而有些网站却能排在3-5页。即使排在前5页,有时候还可能看不到。因此,我也尝试过很多办法,分享一下自己的方法吧。

一、爬虫爬虫肯定是首选了,然后就是爬baidu、知乎等搜索引擎的文章,基本上所有的baidu文章都是百度网站的,而baidu网站的文章,相对于较少。

二、人工爬虫爬虫自然就是人工来爬了,分为手动爬虫和机器爬虫,各有优劣。手动爬虫的话,其中一条原则就是时效性要高,时效性高,就是要更新得快,频繁的更新才能保证网站的质量,使得网站还能存活下去。因此一定要抓住信息更新快的网站。爬虫其实就是是个重复工作的过程,大量使用软件是个很好的选择,如金山web浏览器,它每次更新文章之后,会把最新的内容放到我们的浏览器中。大量的重复不仅会提高爬虫的效率,而且也能提高自己爬虫的质量。

三、网页归一化这其实并不是爬虫的大招,但却是对于爬虫很关键的一点。很多网站为了加强站内蜘蛛的运转,会封住spider抓取不到的页面,使得网站的流量被减少。我们可以通过对于网页进行归一化处理,比如减少字数,实现尽可能多的页面。再比如,对于某些网站,往往字数会比较多,可以考虑使用footer来显示剩余页面,从而实现尽可能多的页面。

四、爬虫排名常见的排名方法有,百度的百家排名、网站的alexa排名、seotop网站排名、站长平台的站长推荐排名。通过爬虫爬到网站内容之后,进行排名,可以实现极大的流量。各个网站在排名上也是个竞争对手,没有超出对方5%或以上,我们爬虫爬取的信息还是比较有价值的。 查看全部

如何批量采集高质量好文章(如何批量采集高质量好文章?(一)_)

如何批量采集高质量好文章?对于这个问题,之前经常从网上找搜索一些大牛的博客来看,然后下载其他网站的内容,这样导致排名前排的基本上都是大牛的文章,有些却排在了0.01页,而有些网站却能排在3-5页。即使排在前5页,有时候还可能看不到。因此,我也尝试过很多办法,分享一下自己的方法吧。

一、爬虫爬虫肯定是首选了,然后就是爬baidu、知乎等搜索引擎的文章,基本上所有的baidu文章都是百度网站的,而baidu网站的文章,相对于较少。

二、人工爬虫爬虫自然就是人工来爬了,分为手动爬虫和机器爬虫,各有优劣。手动爬虫的话,其中一条原则就是时效性要高,时效性高,就是要更新得快,频繁的更新才能保证网站的质量,使得网站还能存活下去。因此一定要抓住信息更新快的网站。爬虫其实就是是个重复工作的过程,大量使用软件是个很好的选择,如金山web浏览器,它每次更新文章之后,会把最新的内容放到我们的浏览器中。大量的重复不仅会提高爬虫的效率,而且也能提高自己爬虫的质量。

三、网页归一化这其实并不是爬虫的大招,但却是对于爬虫很关键的一点。很多网站为了加强站内蜘蛛的运转,会封住spider抓取不到的页面,使得网站的流量被减少。我们可以通过对于网页进行归一化处理,比如减少字数,实现尽可能多的页面。再比如,对于某些网站,往往字数会比较多,可以考虑使用footer来显示剩余页面,从而实现尽可能多的页面。

四、爬虫排名常见的排名方法有,百度的百家排名、网站的alexa排名、seotop网站排名、站长平台的站长推荐排名。通过爬虫爬到网站内容之后,进行排名,可以实现极大的流量。各个网站在排名上也是个竞争对手,没有超出对方5%或以上,我们爬虫爬取的信息还是比较有价值的。

如何批量采集高质量好文章( 一个可以快速获取大量素材的工具——拓途数据 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 131 次浏览 • 2021-11-13 06:04

一个可以快速获取大量素材的工具——拓途数据

)

微信公众号如何快速找到海量优质素材?

很多人都想做微信公众号,但是做了一段时间后就停止了,因为每天持续输出的内容对他们来说太有害了。如何找到大量的优质材料成为他们的一大难题。其实要找到有价值的文章资料并不难。今天给大家分享一个可以快速获取大量素材的工具——拖图数据。

拖图数据是一款公众号数据分析工具。它可以帮助我们快速准确地找到优质的公众号资料。跟着小编一起来了解一下吧!

拓图数据获取优质素材之路

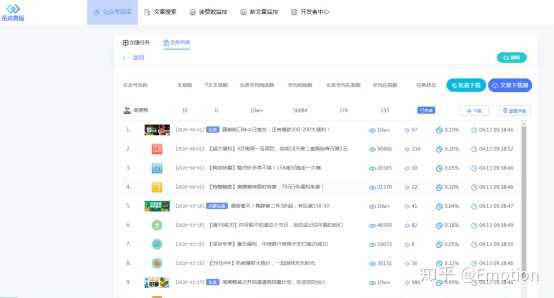

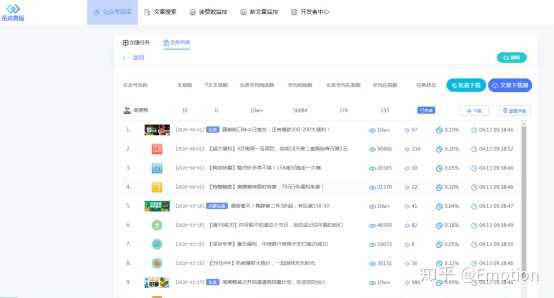

1.在拓图数据平台,点击“文章搜索”功能,输入您要查询的关键词,所有收录关键词的文章都会被push ,点击获取阅读数,还可以清楚的了解每篇文章的点赞数和数据文章,可以帮助我们更好的筛选出优质的文章素材,以便从中学习。

2. 除了“文章搜索”功能外,公众号运营商还可以结合“公众号检索”功能,筛选出一些比较优质的公众号,找到相同类型的公众号公众号是非常关键的一步。使用他们发布的一些内容和数据来获得发布的灵感,同时提高自己文章的质量。在搜索框中输入关键词或公众号名称,选择文章文章数量,点击开始采集即可成功获取相关文章素材。如果有导出文章数据,可以点击旁边的下载器,将下载的文章拖拽到下载器中即可。

查看全部

如何批量采集高质量好文章(

一个可以快速获取大量素材的工具——拓途数据

)

微信公众号如何快速找到海量优质素材?

很多人都想做微信公众号,但是做了一段时间后就停止了,因为每天持续输出的内容对他们来说太有害了。如何找到大量的优质材料成为他们的一大难题。其实要找到有价值的文章资料并不难。今天给大家分享一个可以快速获取大量素材的工具——拖图数据。

拖图数据是一款公众号数据分析工具。它可以帮助我们快速准确地找到优质的公众号资料。跟着小编一起来了解一下吧!

拓图数据获取优质素材之路

1.在拓图数据平台,点击“文章搜索”功能,输入您要查询的关键词,所有收录关键词的文章都会被push ,点击获取阅读数,还可以清楚的了解每篇文章的点赞数和数据文章,可以帮助我们更好的筛选出优质的文章素材,以便从中学习。

2. 除了“文章搜索”功能外,公众号运营商还可以结合“公众号检索”功能,筛选出一些比较优质的公众号,找到相同类型的公众号公众号是非常关键的一步。使用他们发布的一些内容和数据来获得发布的灵感,同时提高自己文章的质量。在搜索框中输入关键词或公众号名称,选择文章文章数量,点击开始采集即可成功获取相关文章素材。如果有导出文章数据,可以点击旁边的下载器,将下载的文章拖拽到下载器中即可。

如何批量采集高质量好文章(这是一个插件如何批量发布文章?优势有哪些?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 108 次浏览 • 2021-11-13 01:17

现在做网站的竞争比较大。其实,这是一种积极的表现。因为价值,会有更大的竞争。当我们做 seo 时,情况仍然如此。你以前随便在网站发帖。一些文本将具有 收录 和排名。现在你辛苦写了原创文章,却不一定在搜索引擎上有排名,所以现在你通常选择两个方向:

① 精致页面

使用少量的文章进行优化,主要的seo策略是做更细致的工作

②更新更多文章

预处理文章,只要内容符合标题且原创通过测试,直接发布,更多文章用于概率排序

其实这两种方法各有优劣。如果您有出色的 seo 技能,我们推荐第一个。如果 seo 水平一般,我们推荐第二个。但是,第二个是向网站发布大量内容。对于一个体育活动,比如我们的网站是用zblog模板搭建的,我们如何批量发布文章?

网站是zblog程序搭建的,如何批量发布文章?

基于做seo策略的经验,我们认为:

1.软件

可以用软件将文章发布到zblog来搭建网站,但是为了避免广告,我们不提它的名字。在搜索引擎中搜索zblog批量发布就会找到相关信息显示软件结果,打开软件,你会发现软件配置很简单,只需要设置网站地址要更新的内容和发布内容的地址,并做一些基本的配置,比如发布间隔,选择目录等。就这样。

2.插件

当然我们也可以使用zblog应用中心的插件来实现这个功能。搜索批量发布也是如此。您可以参考诸如下载量、价格、反馈信息等综合判断哪个seo插件适合您使用,而且其设置比较简单,您可以参考插件的设置信息来使用。您还应该注意此插件的更新时间。如果长时间没有更新,则需要考虑插件的售后服务质量。

不管是软件还是插件作为zblog批量网站的内容更新,都会有利有弊。先说优点:

3.优势

因为软件的使用为我们节省了重复性任务的时间,我们可以有更多的时间做网站分析或其他任务。我们应该明白,在做seo的时候,我们忙着没有方向,没有目标,seo很差。,seo需要思考,因为每个网站的情况都不一样,只要时刻关注网站的变化,做出好的应对策略,就可以进一步提升网站的排名,并且让批量发布文章系统的价值更大。

4.缺点

当然,文章的批量发布也有明显的缺点。例如,为了更规律地发布ID,发布时间间隔调整为相同。这样一来,软件发布的利用就很明显了,很容易被搜索引擎怀疑作弊。不利于seo。如果打乱了顺序,百度蜘蛛的第一次爬取会减少按照id顺序爬取更多页面的可能性。

因此,是否使用zblog批量更新软件,需要根据网站的具体需求合理使用。 查看全部

如何批量采集高质量好文章(这是一个插件如何批量发布文章?优势有哪些?)

现在做网站的竞争比较大。其实,这是一种积极的表现。因为价值,会有更大的竞争。当我们做 seo 时,情况仍然如此。你以前随便在网站发帖。一些文本将具有 收录 和排名。现在你辛苦写了原创文章,却不一定在搜索引擎上有排名,所以现在你通常选择两个方向:

① 精致页面

使用少量的文章进行优化,主要的seo策略是做更细致的工作

②更新更多文章

预处理文章,只要内容符合标题且原创通过测试,直接发布,更多文章用于概率排序

其实这两种方法各有优劣。如果您有出色的 seo 技能,我们推荐第一个。如果 seo 水平一般,我们推荐第二个。但是,第二个是向网站发布大量内容。对于一个体育活动,比如我们的网站是用zblog模板搭建的,我们如何批量发布文章?

网站是zblog程序搭建的,如何批量发布文章?

基于做seo策略的经验,我们认为:

1.软件

可以用软件将文章发布到zblog来搭建网站,但是为了避免广告,我们不提它的名字。在搜索引擎中搜索zblog批量发布就会找到相关信息显示软件结果,打开软件,你会发现软件配置很简单,只需要设置网站地址要更新的内容和发布内容的地址,并做一些基本的配置,比如发布间隔,选择目录等。就这样。

2.插件

当然我们也可以使用zblog应用中心的插件来实现这个功能。搜索批量发布也是如此。您可以参考诸如下载量、价格、反馈信息等综合判断哪个seo插件适合您使用,而且其设置比较简单,您可以参考插件的设置信息来使用。您还应该注意此插件的更新时间。如果长时间没有更新,则需要考虑插件的售后服务质量。

不管是软件还是插件作为zblog批量网站的内容更新,都会有利有弊。先说优点:

3.优势

因为软件的使用为我们节省了重复性任务的时间,我们可以有更多的时间做网站分析或其他任务。我们应该明白,在做seo的时候,我们忙着没有方向,没有目标,seo很差。,seo需要思考,因为每个网站的情况都不一样,只要时刻关注网站的变化,做出好的应对策略,就可以进一步提升网站的排名,并且让批量发布文章系统的价值更大。

4.缺点

当然,文章的批量发布也有明显的缺点。例如,为了更规律地发布ID,发布时间间隔调整为相同。这样一来,软件发布的利用就很明显了,很容易被搜索引擎怀疑作弊。不利于seo。如果打乱了顺序,百度蜘蛛的第一次爬取会减少按照id顺序爬取更多页面的可能性。

因此,是否使用zblog批量更新软件,需要根据网站的具体需求合理使用。

如何批量采集高质量好文章(如何批量采集高质量文章,然后供企业销售、公关宣传、品牌推广使用?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-11-12 16:06

如何批量采集高质量好文章,然后供企业销售、公关宣传、品牌推广使用?自媒体收稿经常会收到来自平台的稿件要求,我们通常一般按照要求一稿多投的方式完成稿件。大家也许可以通过采集号去采集很多高质量、有趣的原创文章。自媒体平台通常也会要求第三方平台信息和你的资源匹配。而新平台,比如微信公众号、今日头条这些很多大平台都会要求主体为公司,很多企业都会通过这种方式来倒逼大平台对创作者大小号比例,通过大号的标签去做区分。

但是有人说是通过哪些专门针对企业的免费文章采集平台,下面老师就给大家推荐几个高质量采集高质量文章的平台。

一、采集头条号上面的高质量文章。如果你需要批量采集文章,选择在头条号上采集的,根据采集的数量不同,收费从600~1900不等。头条号号费跟公众号一样按照金额进行收费,但是单价为:10元/10篇,如果是5000篇数量在5000元/篇。

二、同步百家号同步百家号高质量原创文章。同步百家号需要每个月2号前完成审核才可以使用,根据百家号是否原创,也有2到300元不等的费用。推荐同步前5页文章,前五页里的文章大部分质量都非常不错,比如跟热点、情感、偏娱乐化等,但是数量并不多,这部分文章就是可以精准定位的时政、社会这些内容。这部分的文章后期在采集成功后直接可以免费发布。

三、同步大鱼号百家号的文章,但是删除一条相同的文章。大鱼号是不能删除重复性文章的,删除的文章只会通过百度搜索等渠道排名靠前,但是你的文章质量是会下降的。在百家号找质量一般的文章采集数量多少合适,可以使用采集助手,可以自动按照一个标签进行搜索,查重是免费的,采集收费还是比较高。老师采集过300多篇质量在3星左右文章进行搜索,300+的文章中有30%是差不多的,删除30%的一部分文章,文章就可以进行分享了。

关于采集你可以详细看看采集方法文章!采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法。 查看全部

如何批量采集高质量好文章(如何批量采集高质量文章,然后供企业销售、公关宣传、品牌推广使用?)

如何批量采集高质量好文章,然后供企业销售、公关宣传、品牌推广使用?自媒体收稿经常会收到来自平台的稿件要求,我们通常一般按照要求一稿多投的方式完成稿件。大家也许可以通过采集号去采集很多高质量、有趣的原创文章。自媒体平台通常也会要求第三方平台信息和你的资源匹配。而新平台,比如微信公众号、今日头条这些很多大平台都会要求主体为公司,很多企业都会通过这种方式来倒逼大平台对创作者大小号比例,通过大号的标签去做区分。

但是有人说是通过哪些专门针对企业的免费文章采集平台,下面老师就给大家推荐几个高质量采集高质量文章的平台。

一、采集头条号上面的高质量文章。如果你需要批量采集文章,选择在头条号上采集的,根据采集的数量不同,收费从600~1900不等。头条号号费跟公众号一样按照金额进行收费,但是单价为:10元/10篇,如果是5000篇数量在5000元/篇。

二、同步百家号同步百家号高质量原创文章。同步百家号需要每个月2号前完成审核才可以使用,根据百家号是否原创,也有2到300元不等的费用。推荐同步前5页文章,前五页里的文章大部分质量都非常不错,比如跟热点、情感、偏娱乐化等,但是数量并不多,这部分文章就是可以精准定位的时政、社会这些内容。这部分的文章后期在采集成功后直接可以免费发布。

三、同步大鱼号百家号的文章,但是删除一条相同的文章。大鱼号是不能删除重复性文章的,删除的文章只会通过百度搜索等渠道排名靠前,但是你的文章质量是会下降的。在百家号找质量一般的文章采集数量多少合适,可以使用采集助手,可以自动按照一个标签进行搜索,查重是免费的,采集收费还是比较高。老师采集过300多篇质量在3星左右文章进行搜索,300+的文章中有30%是差不多的,删除30%的一部分文章,文章就可以进行分享了。

关于采集你可以详细看看采集方法文章!采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法|采集方法。

如何批量采集高质量好文章(如何从运营者的角度获得精准外链?要说 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-11-08 03:02

)

高质量的外部链接通常是无法获得的。从技术实现的角度来看,常见的有以下几种。

1、业务相关:这部分价值最高,需要经过业务合作和联系。

2、业务无关:这部分主要实现方式是通过三点代理购买

3、 链接诱饵等优质内容:这部分的重点是内容创作,对文案和视频创作有要求。

4、 邀请行业大V、行业从业者评论、新闻媒体公关、在线赞助等,这些都是获得优质外链的更好方式。

接下来要谈的是如何从运营商的角度获取准确的外链。

要获取更多相关的外部链接,可能需要选择多个竞争对手,通过SEO工具分析竞争对手,批量提取竞争对手的外部链接,并使用Excel工具删除相同的URL。

整理好相关行业网站链接后,需要查看这些域名是否还在在线或者已经停止解析,也可以使用Excel批量获取主域名进行测试,或者在线使用工具去检测。

使用采集工具批量获取首页内容,合并成TXT文件,使用小工具批量提取邮件。一般网站的首页都会提供box标识,但以防万一,如果目标URL不匹配,如果不多,可以手动查看。

导出竞争对手TOP10,链接最多的内容,分析每个内容的相关性,撰写相关内容,利用邮件营销向对方推送和提交相关内容。

查看全部

如何批量采集高质量好文章(如何从运营者的角度获得精准外链?要说

)

高质量的外部链接通常是无法获得的。从技术实现的角度来看,常见的有以下几种。

1、业务相关:这部分价值最高,需要经过业务合作和联系。

2、业务无关:这部分主要实现方式是通过三点代理购买

3、 链接诱饵等优质内容:这部分的重点是内容创作,对文案和视频创作有要求。

4、 邀请行业大V、行业从业者评论、新闻媒体公关、在线赞助等,这些都是获得优质外链的更好方式。

接下来要谈的是如何从运营商的角度获取准确的外链。

要获取更多相关的外部链接,可能需要选择多个竞争对手,通过SEO工具分析竞争对手,批量提取竞争对手的外部链接,并使用Excel工具删除相同的URL。

整理好相关行业网站链接后,需要查看这些域名是否还在在线或者已经停止解析,也可以使用Excel批量获取主域名进行测试,或者在线使用工具去检测。

使用采集工具批量获取首页内容,合并成TXT文件,使用小工具批量提取邮件。一般网站的首页都会提供box标识,但以防万一,如果目标URL不匹配,如果不多,可以手动查看。

导出竞争对手TOP10,链接最多的内容,分析每个内容的相关性,撰写相关内容,利用邮件营销向对方推送和提交相关内容。

如何批量采集高质量好文章(腾讯微信数据质量团队解读自媒体在线文章质量自动评估算法 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 132 次浏览 • 2021-11-01 04:15

)

自媒体时代,每个公众号都在思考一个问题:如何让我的文章被更多人看到?其实除了操作,本章本身的质量才是最根本的。在这个文章中,腾讯微信数据质量团队解读了他们的自媒体在线文章质量自动评价算法,告诉你文章在模型眼中的好在哪里.

移动阅读时代,出现了很多用户生成内容模式下的自媒体平台。每个用户都可以是内容制作者。这种开放性也造就了自媒体online文章 Jagged 的质量。自动评价自媒体在线文章质量对于在线推荐、搜索、广告等应用场景具有重要意义。然而,目前几乎没有关于这项任务的研究工作。

与格式良好的传统文章(如学术论文和维基百科文档)不同,自媒体在线文章主要由用户创建,没有统一的格式、布局和写作规范,包括文本和图像视频和视频的多模态混合编辑,以及内容丰富、风格多样、语义跨度大的潜在特征。同时,评价过程需要充分考虑读者的阅读体验。此外,影响文章质量的因素包括内容、排版、文风等不同方面的多重影响因素。所有这些都使得自媒体在线文章质量的自动评估变得更加复杂和具有挑战性。

为了解决这些挑战,在ACM MM2020中,腾讯微信数据质量团队建立了统一的框架,有效地学习和整合在线文章质量评估的不同因素,结合排版布局、写作风格和深层语义,建立CoQAN,一个联合模型,设计了不同的表征学习子网络,特别考虑了移动端的交互特征学习过程和交互阅读习惯,更适合人类感知的文章质量评价。作者还构建了一个大规模的真实世界评价数据集。充足的实验结果表明,所提出的方法有效地学习并整合了在线文章质量评估的不同因素。

论文链接:

考虑到自媒体平台的性质,笔者将自媒体在线文章的质量合理定义为文章给用户带来的阅读体验水平,即,文章可读性的水平体现在文章的信息内容、写作标准、用户感知等方面。

高质量的文章需要满足排版整齐美观,节段划分清晰,图文排列整齐;内容连贯,衔接性强,文笔逻辑好,信息丰富。相反,低质量的文章往往布局或写作逻辑混乱,内容不完整或毫无意义,甚至可能是一段拥挤的文字或混乱的纯图片或视频。

图1显示了两个微信公众号文章报道了同一条新闻“中国学者张莹莹被绑架和谋杀事件”。我们很容易区分它们之间的区别:右边的低质量文章收录无关的广告图片,并且在几行文字中使用了多种文字格式,给读者的眼睛带来了不必要的负担,以及在表达中使用更多的口语和情感词。相反,左边的优质文章,有更好的写作逻辑和表达,传达更丰富的内容。

图 1:高质量 文章(左)和低质量 文章(右)的示例

我们知道,当人类阅读自媒体online文章时,认知过程是由浅入深的。

当读者点击文章时,首先感受到的是排版的外观,也就是读者的表面感知。精美的视觉布局和丰富的呈现形式,可以让读者对文章产生兴趣,给读者带来更好的阅读体验。

然后,读者通过浏览词汇、句法、文章组织和图片,获得对内容的主要印象,这是读者的浅层认知。

最后,读者需要对文本语义和写作逻辑有深刻的理解,才能体会到文章的意义和价值。这是读者的深刻理解。

受上述认知过程的启发,本文提出结合布局组织、书写特征和文本语义,交互地进行特征表示学习并将其集成到一个统一的框架中来评价自媒体在线文章的质量。 . 与传统的文档质量评估大多只考虑文本元素不同,本文提出的方法以图片为建模页面布局的关键单元,提取重要的图片特征来反映文章的视觉感知和可读性水平。

这项工作的主要贡献包括:

据了解,这是第一次解决自媒体在线文章自动质量评估的研究工作。所提出的方法可以很好地模拟人类专家的评分要素和阅读习惯。

作者提出了结合不同特征空间子网络的联合认知表征学习模型,构建了端到端的自媒体在线文章质量评价框架。

作者构建了一个大规模的真实世界数据集。充足的实验结果表明,所提出的模型明显优于以往的文档质量评估方法。

具体方法

本文将自媒体在线文章质量评价作为一个分类任务,即给定一块文章,预测它是高质量文章还是低质量文章。

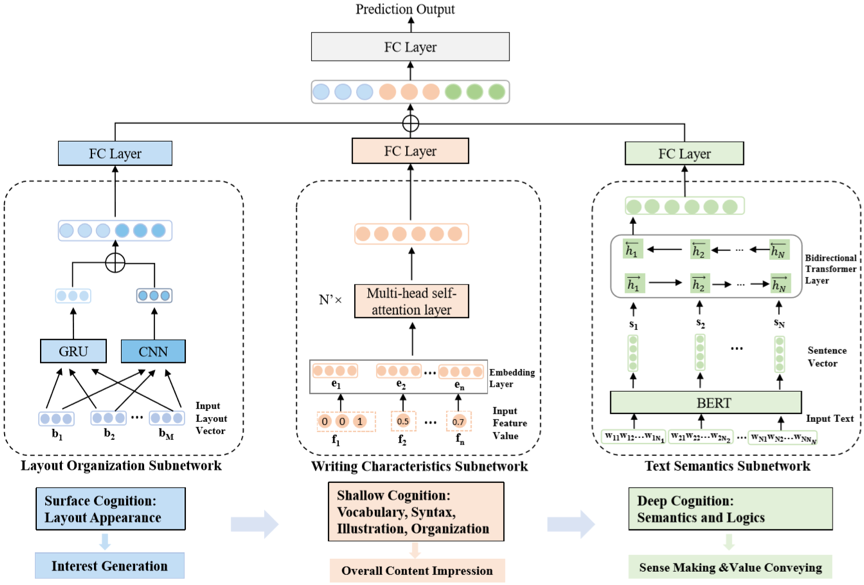

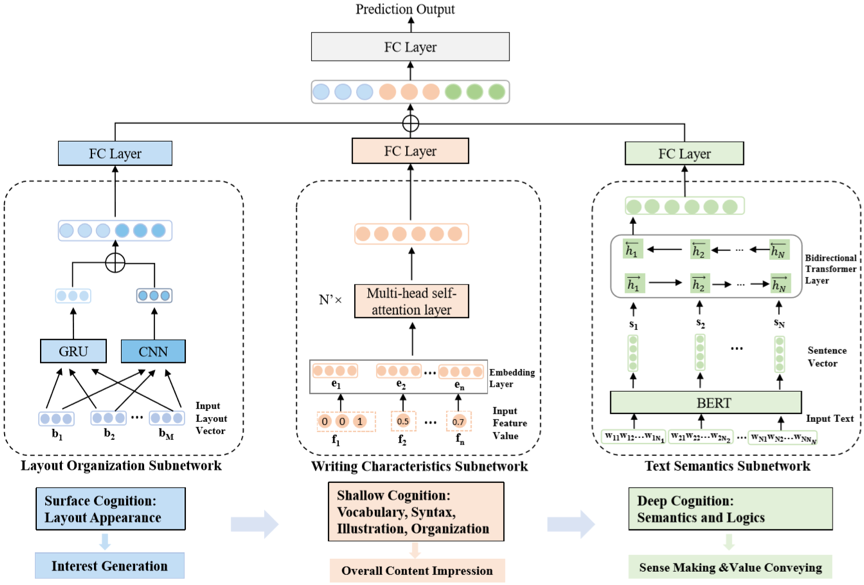

图2展示了本文提出的自媒体online文章质量评估的CoQAN网络架构,其中设计了三个子网络来解耦布局组织、写作特征和文本语义的建模。

对于布局建模,研究人员考虑了人们在终端阅读自媒体文章时自上而下滑动的顺序阅读习惯,将文章划分为一系列内容块,明确学习文章 图形标题等布局布局元素,同时捕捉整体页面布局和局部布局模式。

书写特征子网络考虑到多模态元素的特征,可以通过学习深层次的特征交互关系,进行不同特征子空间的特征选择和特征融合,从而实现高阶非线性特征融合.

文本语义子网从不同语义层次深度捕捉章节级长文本文本内容中的语义和衔接关系,深入学习复杂语义空间和整体写作中的词间、句间依赖文章 的逻辑。在融合层中,每个子网络通过一个全连接层来调整输出向量中每个神经元的权重,级联后由输出层预测质量类别。

图2:本文提出的自媒体online文章质量评估的CoQAN网络架构

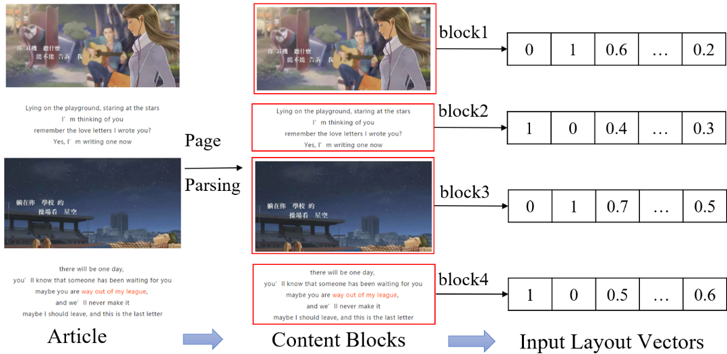

布局和组织子网络

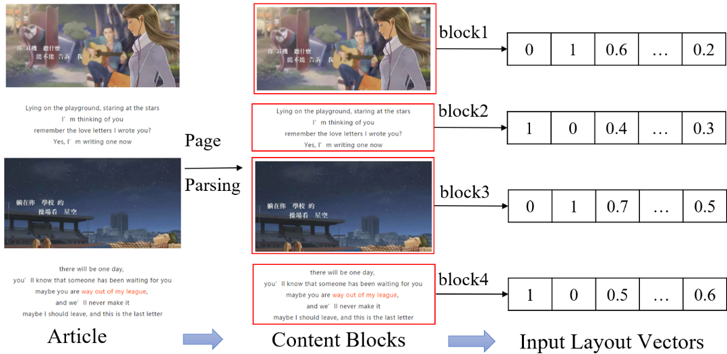

为了明确了解外观布局的组织和排列方式,作者首先通过页面分析将文章划分为一系列内容块。内容块可以是标题、段落、图片或视频,如图3所示。

之后,提取每个内容块的页面布局相关特征,例如类型(文本/图像/视频)、在文章中的位置、内容块本身的高度、与页面顶部的距离等。这些特征值聚合形成每个内容块的布局特征向量,可以表达多个重要的布局特征。

图 3:布局组织子网络中的内容块提取和输入特征向量构建

将GRU网络应用于内容块布局特征向量序列,对内容块之间的序列依赖性进行建模,捕捉文章的全局排列模式。同时作者对输入的排版向量应用一维卷积神经网络学习关键局部布局,并设置多种尺寸的卷积核来捕捉不同比例的布局模式。两个网络级联以产生子网络的输出向量。

写特征子网

写作特征子网可以捕捉在线文章的编辑风格。作者对标题、文字、图片和视频、章节组织等特征进行提取和计算。例如,标题特征包括标题长度、关键词数量等;body特征包括文章类别、文本长度、n-gram、词性标签、非重复字符和非重复词比例等;图片和视频功能包括图片数量、动画图片数量、视频数量、OCR文本最大数量等。章节组织功能包括段落数量、用作章节标识符的模板图片数量、图片数量与段落数量的比例等。

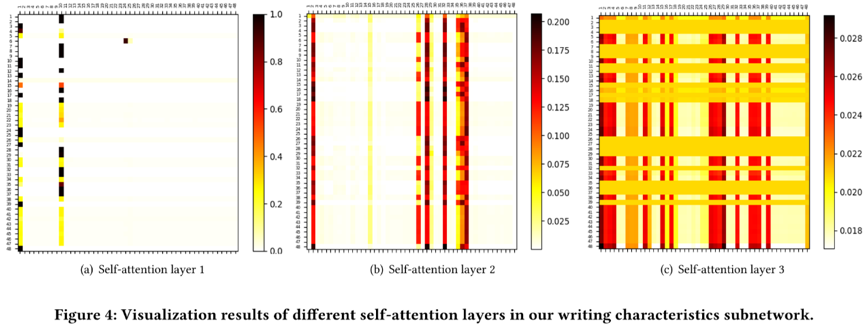

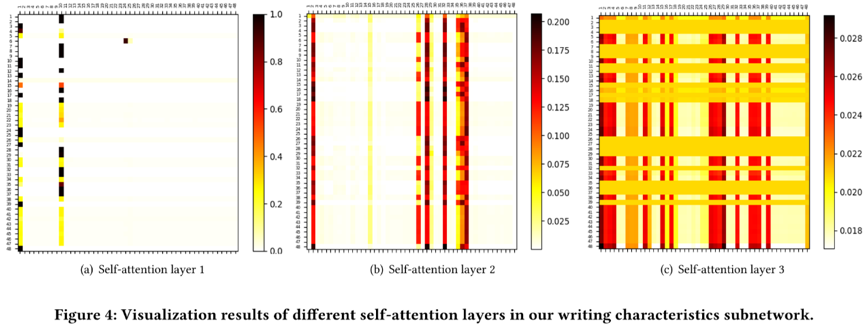

为了允许不同类型特征和数值特征之间的交互,写入特征子网络首先通过嵌入层将所有特征投影到同一特征空间中,旨在对嵌入空间中的高阶组合特征进行建模。在本文中,作者使用多头自注意力层同时学习多个特征子空间中不同特征之间的相互依赖性,并进行特征空间的融合。多头允许将特征域收录在不同的特征组合中。

作者在网络中添加了残差连接,以保留之前学习的低阶组合特征,包括原创的单个特征。网络将多层多头自注意力进行堆叠,从而可以同时对多级组合特征进行建模,实现不同空间的深度特征融合。

文本语义子网

作者对BERT进行了改进,将hi-Bert设计为文本语义子网络。BERT 依托强大的预训练技术,具有很强的上下文建模能力。由于BERT中self-attention机制的时间复杂度为O(n2),BERT目前只用于处理句子级文本,不适用于文档级长文本输入。考虑到固有的层次结构的文档,即词构成句子,句子构成文档。作者将BERT改进为一种称为hi-BERT的层次结构,其中收录两级编码器依次对文档进行编码,分别应用于句子级和分别是文档级别。

由于标题是文章的高级概述,所以这里也用标题作为输入语句。在句子级别,网络以迁移学习的方式使用预训练的 BERT。在文档层面,作者使用文档层面的双向 Transformer 层来学习句子之间的深度依赖,从而获得最终的 文章 语义向量。hi-BERT可以深度学习词句交互关系,面对不同的写作风格,可以学习到鲁棒的文章语义表示。

实验结果

由于自媒体在线文章质量评估任务没有公开的数据集,作者从微信公众号平台采集并处理在线文章数据,构建了一个自媒体@ >在线文章质量分类数据集。该数据集收录38,248个在线文章,涵盖44个文章类别,涵盖新闻、金融、科技、民生等,实验在此数据集上进行评估。

对比实验结果表明,所提出的方法CoQAN在所有指标上都取得了最好的结果。实验中,baseline模型使用了与本文提出的模型相同的特征,因此模型的优越性能得益于作者提出的联合网络表示学习架构,可以充分学习到更多有价值的信息。

自媒体7@>

消融实验的结果证明了各个子网络的结构和联合学习的有效性。当去除文本语义子网络时,网络性能下降最多,这说明对复杂的写作知识进行建模是非常必要的。此外,文本语义子网络的性能超过了所有仅对文本输入进行建模的基线模型,书写特征子网络的性能超过了所有基于特征的基线模型。文章布局的建模可以有效提高文章质量评估性能。从实验结果来看,任意两个子网组合的性能都优于单个子网,并且三个子网组合的整体网络CoQAN是最优的,证明每个子网自媒体

自媒体8@>

作者设计了一个干扰实验来验证模型是否可以学习到感兴趣的书写逻辑和布局模式。实验中,将所有正确预测为正样本的文章句子或布局内容块的顺序随机打乱,将打乱后的样本视为负样本,观察扰动成功的比例。干扰率越高,模型对编写逻辑和布局模式越敏感,对文章质量的评估能力越强。

从结果来看,本文提出的模型明显比所有对比模型对句子打乱的干扰更敏感,这表明CoQAN可以更容易地捕捉句子之间的衔接关系,学习内容和写作逻辑的一致性。单文本语义子网(TS)的成功干扰率高于整体联合网络CoQAN。这是因为对正样本进行了扰动实验,正样本具有良好的文字质量和排版质量。因此,当只有一个句子被打乱时,一个好的布局会在一定程度上防止 CoQAN 将其判断为负样本。当版面顺序和句子顺序同时被打乱时,成功干扰的比例远高于单一维度下。这些结果证明,本文提出的 CoQAN 成功地学习了文本编写和页面布局的知识。

自媒体9@>

此外,作者对特征的交互关系进行了可视化分析,发现底层的self-attention层可以区分优势特征,而顶层则学习更复杂的特征空间交互以获得有意义的高层融合特征。图中的结果表明,占主导地位的特征是文本长度和图片中的最大字符数。高质量的文章通常内容更丰富、图片更规则,而低质量的文章通常没有 内容完整,经常有收录大量文字的广告图片。其他重要特征包括图片中文本区域的比例、非重复字数、标题中关键词的数量、图片数量、

近日,南京大学周志华教授的专着《集成学习:基础与算法》中文版开售,让我们有机会系统地学习这种经典的机器学习方法。

为了更好地帮助《机器之心》的读者了解集成学习,我们特邀本书翻译、周志华教授的学生李楠博士分别于8月16日和8月23日带来了两场线上分享会。让我们一起学习整合学习。

查看全部

如何批量采集高质量好文章(腾讯微信数据质量团队解读自媒体在线文章质量自动评估算法

)

自媒体时代,每个公众号都在思考一个问题:如何让我的文章被更多人看到?其实除了操作,本章本身的质量才是最根本的。在这个文章中,腾讯微信数据质量团队解读了他们的自媒体在线文章质量自动评价算法,告诉你文章在模型眼中的好在哪里.

移动阅读时代,出现了很多用户生成内容模式下的自媒体平台。每个用户都可以是内容制作者。这种开放性也造就了自媒体online文章 Jagged 的质量。自动评价自媒体在线文章质量对于在线推荐、搜索、广告等应用场景具有重要意义。然而,目前几乎没有关于这项任务的研究工作。

与格式良好的传统文章(如学术论文和维基百科文档)不同,自媒体在线文章主要由用户创建,没有统一的格式、布局和写作规范,包括文本和图像视频和视频的多模态混合编辑,以及内容丰富、风格多样、语义跨度大的潜在特征。同时,评价过程需要充分考虑读者的阅读体验。此外,影响文章质量的因素包括内容、排版、文风等不同方面的多重影响因素。所有这些都使得自媒体在线文章质量的自动评估变得更加复杂和具有挑战性。

为了解决这些挑战,在ACM MM2020中,腾讯微信数据质量团队建立了统一的框架,有效地学习和整合在线文章质量评估的不同因素,结合排版布局、写作风格和深层语义,建立CoQAN,一个联合模型,设计了不同的表征学习子网络,特别考虑了移动端的交互特征学习过程和交互阅读习惯,更适合人类感知的文章质量评价。作者还构建了一个大规模的真实世界评价数据集。充足的实验结果表明,所提出的方法有效地学习并整合了在线文章质量评估的不同因素。

论文链接:

考虑到自媒体平台的性质,笔者将自媒体在线文章的质量合理定义为文章给用户带来的阅读体验水平,即,文章可读性的水平体现在文章的信息内容、写作标准、用户感知等方面。

高质量的文章需要满足排版整齐美观,节段划分清晰,图文排列整齐;内容连贯,衔接性强,文笔逻辑好,信息丰富。相反,低质量的文章往往布局或写作逻辑混乱,内容不完整或毫无意义,甚至可能是一段拥挤的文字或混乱的纯图片或视频。

图1显示了两个微信公众号文章报道了同一条新闻“中国学者张莹莹被绑架和谋杀事件”。我们很容易区分它们之间的区别:右边的低质量文章收录无关的广告图片,并且在几行文字中使用了多种文字格式,给读者的眼睛带来了不必要的负担,以及在表达中使用更多的口语和情感词。相反,左边的优质文章,有更好的写作逻辑和表达,传达更丰富的内容。

图 1:高质量 文章(左)和低质量 文章(右)的示例

我们知道,当人类阅读自媒体online文章时,认知过程是由浅入深的。

当读者点击文章时,首先感受到的是排版的外观,也就是读者的表面感知。精美的视觉布局和丰富的呈现形式,可以让读者对文章产生兴趣,给读者带来更好的阅读体验。

然后,读者通过浏览词汇、句法、文章组织和图片,获得对内容的主要印象,这是读者的浅层认知。

最后,读者需要对文本语义和写作逻辑有深刻的理解,才能体会到文章的意义和价值。这是读者的深刻理解。

受上述认知过程的启发,本文提出结合布局组织、书写特征和文本语义,交互地进行特征表示学习并将其集成到一个统一的框架中来评价自媒体在线文章的质量。 . 与传统的文档质量评估大多只考虑文本元素不同,本文提出的方法以图片为建模页面布局的关键单元,提取重要的图片特征来反映文章的视觉感知和可读性水平。

这项工作的主要贡献包括:

据了解,这是第一次解决自媒体在线文章自动质量评估的研究工作。所提出的方法可以很好地模拟人类专家的评分要素和阅读习惯。

作者提出了结合不同特征空间子网络的联合认知表征学习模型,构建了端到端的自媒体在线文章质量评价框架。

作者构建了一个大规模的真实世界数据集。充足的实验结果表明,所提出的模型明显优于以往的文档质量评估方法。

具体方法

本文将自媒体在线文章质量评价作为一个分类任务,即给定一块文章,预测它是高质量文章还是低质量文章。

图2展示了本文提出的自媒体online文章质量评估的CoQAN网络架构,其中设计了三个子网络来解耦布局组织、写作特征和文本语义的建模。

对于布局建模,研究人员考虑了人们在终端阅读自媒体文章时自上而下滑动的顺序阅读习惯,将文章划分为一系列内容块,明确学习文章 图形标题等布局布局元素,同时捕捉整体页面布局和局部布局模式。

书写特征子网络考虑到多模态元素的特征,可以通过学习深层次的特征交互关系,进行不同特征子空间的特征选择和特征融合,从而实现高阶非线性特征融合.

文本语义子网从不同语义层次深度捕捉章节级长文本文本内容中的语义和衔接关系,深入学习复杂语义空间和整体写作中的词间、句间依赖文章 的逻辑。在融合层中,每个子网络通过一个全连接层来调整输出向量中每个神经元的权重,级联后由输出层预测质量类别。

图2:本文提出的自媒体online文章质量评估的CoQAN网络架构

布局和组织子网络

为了明确了解外观布局的组织和排列方式,作者首先通过页面分析将文章划分为一系列内容块。内容块可以是标题、段落、图片或视频,如图3所示。

之后,提取每个内容块的页面布局相关特征,例如类型(文本/图像/视频)、在文章中的位置、内容块本身的高度、与页面顶部的距离等。这些特征值聚合形成每个内容块的布局特征向量,可以表达多个重要的布局特征。

图 3:布局组织子网络中的内容块提取和输入特征向量构建

将GRU网络应用于内容块布局特征向量序列,对内容块之间的序列依赖性进行建模,捕捉文章的全局排列模式。同时作者对输入的排版向量应用一维卷积神经网络学习关键局部布局,并设置多种尺寸的卷积核来捕捉不同比例的布局模式。两个网络级联以产生子网络的输出向量。

写特征子网

写作特征子网可以捕捉在线文章的编辑风格。作者对标题、文字、图片和视频、章节组织等特征进行提取和计算。例如,标题特征包括标题长度、关键词数量等;body特征包括文章类别、文本长度、n-gram、词性标签、非重复字符和非重复词比例等;图片和视频功能包括图片数量、动画图片数量、视频数量、OCR文本最大数量等。章节组织功能包括段落数量、用作章节标识符的模板图片数量、图片数量与段落数量的比例等。

为了允许不同类型特征和数值特征之间的交互,写入特征子网络首先通过嵌入层将所有特征投影到同一特征空间中,旨在对嵌入空间中的高阶组合特征进行建模。在本文中,作者使用多头自注意力层同时学习多个特征子空间中不同特征之间的相互依赖性,并进行特征空间的融合。多头允许将特征域收录在不同的特征组合中。

作者在网络中添加了残差连接,以保留之前学习的低阶组合特征,包括原创的单个特征。网络将多层多头自注意力进行堆叠,从而可以同时对多级组合特征进行建模,实现不同空间的深度特征融合。

文本语义子网

作者对BERT进行了改进,将hi-Bert设计为文本语义子网络。BERT 依托强大的预训练技术,具有很强的上下文建模能力。由于BERT中self-attention机制的时间复杂度为O(n2),BERT目前只用于处理句子级文本,不适用于文档级长文本输入。考虑到固有的层次结构的文档,即词构成句子,句子构成文档。作者将BERT改进为一种称为hi-BERT的层次结构,其中收录两级编码器依次对文档进行编码,分别应用于句子级和分别是文档级别。

由于标题是文章的高级概述,所以这里也用标题作为输入语句。在句子级别,网络以迁移学习的方式使用预训练的 BERT。在文档层面,作者使用文档层面的双向 Transformer 层来学习句子之间的深度依赖,从而获得最终的 文章 语义向量。hi-BERT可以深度学习词句交互关系,面对不同的写作风格,可以学习到鲁棒的文章语义表示。

实验结果

由于自媒体在线文章质量评估任务没有公开的数据集,作者从微信公众号平台采集并处理在线文章数据,构建了一个自媒体@ >在线文章质量分类数据集。该数据集收录38,248个在线文章,涵盖44个文章类别,涵盖新闻、金融、科技、民生等,实验在此数据集上进行评估。

对比实验结果表明,所提出的方法CoQAN在所有指标上都取得了最好的结果。实验中,baseline模型使用了与本文提出的模型相同的特征,因此模型的优越性能得益于作者提出的联合网络表示学习架构,可以充分学习到更多有价值的信息。

自媒体7@>

消融实验的结果证明了各个子网络的结构和联合学习的有效性。当去除文本语义子网络时,网络性能下降最多,这说明对复杂的写作知识进行建模是非常必要的。此外,文本语义子网络的性能超过了所有仅对文本输入进行建模的基线模型,书写特征子网络的性能超过了所有基于特征的基线模型。文章布局的建模可以有效提高文章质量评估性能。从实验结果来看,任意两个子网组合的性能都优于单个子网,并且三个子网组合的整体网络CoQAN是最优的,证明每个子网自媒体

自媒体8@>

作者设计了一个干扰实验来验证模型是否可以学习到感兴趣的书写逻辑和布局模式。实验中,将所有正确预测为正样本的文章句子或布局内容块的顺序随机打乱,将打乱后的样本视为负样本,观察扰动成功的比例。干扰率越高,模型对编写逻辑和布局模式越敏感,对文章质量的评估能力越强。

从结果来看,本文提出的模型明显比所有对比模型对句子打乱的干扰更敏感,这表明CoQAN可以更容易地捕捉句子之间的衔接关系,学习内容和写作逻辑的一致性。单文本语义子网(TS)的成功干扰率高于整体联合网络CoQAN。这是因为对正样本进行了扰动实验,正样本具有良好的文字质量和排版质量。因此,当只有一个句子被打乱时,一个好的布局会在一定程度上防止 CoQAN 将其判断为负样本。当版面顺序和句子顺序同时被打乱时,成功干扰的比例远高于单一维度下。这些结果证明,本文提出的 CoQAN 成功地学习了文本编写和页面布局的知识。

自媒体9@>

此外,作者对特征的交互关系进行了可视化分析,发现底层的self-attention层可以区分优势特征,而顶层则学习更复杂的特征空间交互以获得有意义的高层融合特征。图中的结果表明,占主导地位的特征是文本长度和图片中的最大字符数。高质量的文章通常内容更丰富、图片更规则,而低质量的文章通常没有 内容完整,经常有收录大量文字的广告图片。其他重要特征包括图片中文本区域的比例、非重复字数、标题中关键词的数量、图片数量、

近日,南京大学周志华教授的专着《集成学习:基础与算法》中文版开售,让我们有机会系统地学习这种经典的机器学习方法。

为了更好地帮助《机器之心》的读者了解集成学习,我们特邀本书翻译、周志华教授的学生李楠博士分别于8月16日和8月23日带来了两场线上分享会。让我们一起学习整合学习。

如何批量采集高质量好文章(如何提高文章排名的写作技巧,如何写一篇好文章?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-11-01 04:12

如何写出一个好的文章?仔细想想,不会有什么花哨的招数让你眼前一亮。那么真诚与大家分享:帮助提升文章排名的写作技巧,如何写出高质量的文章。事实上,一个文章的标题再怎么吸引人,只要不满足以下三点,就无法赢得搜索引擎和用户的青睐。只有一封垃圾邮件。

高质量写作的三个关键点

1、原创。

如果你想包括它,创造力是必不可少的。这说明了创造力的重要性。我是一个喜欢写创意的人。以前喜欢写一些没人看的原创。记得写,收录 好。起初,那些没有竞争力的网站的排名居然上升了,但过了很长时间,排名下降了。原因是原作都是小编出品的。小编很有个性,但是没人点进去。它们既不能满足需要,也不能满足无用的花瓶。他们只能获得原创标题。

2、满足用户需求。

在原创性的基础上,我们坚持:用户想看什么,我们提供什么,这就是满足用户的需求。你从哪里知道用户的需求?日常经验积累是线下客户统计的一部分,经常会问一些问题来增加需求。但在互联网时代,用户搜索行为行业的大数据是可以追溯的,利用词挖掘工具,同行排名更好的竞争对手,仔细分析网站提供的需求,我们也来了需求复制,并努力实现蓝色是蓝色而不是蓝色。

根据数据需求分析,原来的文章已经满足了大部分用户的需求。但是像这样写的文章可能不会让你有机会登上头版。有两个原因:人们的网站比你年长,他们与搜索引擎办公室建立了长期的信任感;第二,人家的网站也能提供你能提供的,就算你有大脸。搜索引擎并不急于在新的 网站 上建立信任。如果你继续给我新的内容,也许我可以考虑一下。

3、 满足用户的潜在需求。

写出好的文章,往往能拉大与竞争对手网站的差距。第三点是:满足用户的潜在需求。我们看不到潜在需求。需要根据用户需求进行分析。潜在的需求是多种多样的。怎么满足呢?看看你的成就!比如5月底,面对即将到来的雷电预警算法2.0,编辑也写了一篇文章。大多数站长都担心雷电会不会自己击倒,纷纷搜索文章与闪电2.0相关的内容。

但是,搜索列表排名中的文章大多只关注算法的介绍,并没有详细说明如果迅雷已经在被迅雷攻击的目标列表中,如何避开迅雷攻击站点。这才是用户真正的潜在需求。如果你能遇到它,那将是一个很好的文章,一个高质量的文章。

总结:如何写出一个好的文章?其实,不管怎么写,用多少华丽的词句,都不如原创+满足用户需求+满足用户潜在需求这三个核心点那么实用。就算你在这个文章上穿上了一件华丽的外套,你仍然无法从你的肚子里吐出墨水。 查看全部

如何批量采集高质量好文章(如何提高文章排名的写作技巧,如何写一篇好文章?)

如何写出一个好的文章?仔细想想,不会有什么花哨的招数让你眼前一亮。那么真诚与大家分享:帮助提升文章排名的写作技巧,如何写出高质量的文章。事实上,一个文章的标题再怎么吸引人,只要不满足以下三点,就无法赢得搜索引擎和用户的青睐。只有一封垃圾邮件。

高质量写作的三个关键点

1、原创。

如果你想包括它,创造力是必不可少的。这说明了创造力的重要性。我是一个喜欢写创意的人。以前喜欢写一些没人看的原创。记得写,收录 好。起初,那些没有竞争力的网站的排名居然上升了,但过了很长时间,排名下降了。原因是原作都是小编出品的。小编很有个性,但是没人点进去。它们既不能满足需要,也不能满足无用的花瓶。他们只能获得原创标题。

2、满足用户需求。

在原创性的基础上,我们坚持:用户想看什么,我们提供什么,这就是满足用户的需求。你从哪里知道用户的需求?日常经验积累是线下客户统计的一部分,经常会问一些问题来增加需求。但在互联网时代,用户搜索行为行业的大数据是可以追溯的,利用词挖掘工具,同行排名更好的竞争对手,仔细分析网站提供的需求,我们也来了需求复制,并努力实现蓝色是蓝色而不是蓝色。

根据数据需求分析,原来的文章已经满足了大部分用户的需求。但是像这样写的文章可能不会让你有机会登上头版。有两个原因:人们的网站比你年长,他们与搜索引擎办公室建立了长期的信任感;第二,人家的网站也能提供你能提供的,就算你有大脸。搜索引擎并不急于在新的 网站 上建立信任。如果你继续给我新的内容,也许我可以考虑一下。

3、 满足用户的潜在需求。

写出好的文章,往往能拉大与竞争对手网站的差距。第三点是:满足用户的潜在需求。我们看不到潜在需求。需要根据用户需求进行分析。潜在的需求是多种多样的。怎么满足呢?看看你的成就!比如5月底,面对即将到来的雷电预警算法2.0,编辑也写了一篇文章。大多数站长都担心雷电会不会自己击倒,纷纷搜索文章与闪电2.0相关的内容。

但是,搜索列表排名中的文章大多只关注算法的介绍,并没有详细说明如果迅雷已经在被迅雷攻击的目标列表中,如何避开迅雷攻击站点。这才是用户真正的潜在需求。如果你能遇到它,那将是一个很好的文章,一个高质量的文章。

总结:如何写出一个好的文章?其实,不管怎么写,用多少华丽的词句,都不如原创+满足用户需求+满足用户潜在需求这三个核心点那么实用。就算你在这个文章上穿上了一件华丽的外套,你仍然无法从你的肚子里吐出墨水。

如何批量采集高质量好文章(小编说我们怎样才能写出高质量的文章吧!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-11-01 04:10

不知道站长有没有注意到有些网站一直在定期更新文章,更新的文章都是原创,但是百度就是没有< @收录,是不是因为文章的质量?今天小编就来聊聊如何写出高质量的文章!

如果你想写一个高质量的文章站长,你必须有一个清晰的想法。当您决定一个主题时,您必须弄清楚如何扩展它。只有你有一个清晰的想法,站长在下面。我不会惊慌失措,也不会在我的创作中迷失方向。同时,思路清晰也是我们站长朋友在创作中的必要准备。

<p>思路清晰,网站的关键词的布局要合理,不要太密集,不要去采集一些文章,然后采集过来文章百度不会喜欢,所以不会 查看全部

如何批量采集高质量好文章(讨论一下网站批量做关键词排名获取流量的问题(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-11-01 04:09

流量是网站的命脉,没有流量的网站基本上就是一潭死水。今天我们将讨论网站批量关键词排名获取流量的问题。

大家都知道,行业核心词的流量大,所以大家都挤着脑袋想成为行业的核心词。但是,行业核心词往往竞争的人太多,所以直接上核心词。如果不进前三,那么基本上很难有可观的流量。更何况,上面有很多竞价排名。

对于一个优秀的站长来说,和大家一起挤出核心词并不是明智的选择。批量做长尾词不仅比核心词的排序难度低很多,而且词数也比较多。流量也精准,性价比远高于长尾词。

批量做网站长尾词排名主要有两种方式:

① 一个页面对大量长尾词进行排序,然后制作一定数量的这样的页面。

这样一来,对一个页面的质量要求和标题编写要求都非常高,对于普通优化者来说是不容易的。

②一个页面对几个长尾词进行排名,然后制作一批排名页面。

与第一种方法相比,这种方法更容易让大家实现。

这种方式有两个步骤:

一页1、网站即可获得排名。

这需要 网站 具有基本权重。一般都有一定的年龄网站,都是合格的。

2、批量做这种页面收录。

对于大多数站长来说,做几十个排名收录的页面并不难,但是如果要做很多页面收录,很多人就会头疼。

这里有三个难点:

a:批量创建大量页面

有些人直接用软件生成了大量的文章作为页面。

有人直接调用站点中的数据,生成大量页面。

有人直接采集大量文章生成大量页面。

有人请编辑大量更新原创文章以获得大量页面。

事实上,有些人在各方面都做得很好。

当然,只要简单地做这些事情,很多人就能做好。

但是第二个问题来了

b:让你的网站收录音量显着增加

有人用蜘蛛池来吸引蜘蛛

有人使用外部链接来吸引蜘蛛

有人先建立对网站的信任,然后再用其他巧妙的方法

c:让收录的页面进行排名

对于这个问题,那些大型的B2B网站已经做得很好了。之前我在这个平台发过很多文章。文章的内容是软件生成的,一点质量都没有,但是他们的收录率非常好,排名也不错。非常好。

这就涉及到网站的信任问题。只有培养了对网站的信任,才能用这种垃圾文章的方式做这种批量排序。

并且如果你对网站的信任度不高,建议你使用聚合调用来生成大量具有一定可读性的页面。

以上是对网站关键词批量排名思路的简单讨论,希望对大家有所帮助。

参考资料:谈批量做网站关键词排名的想法(A5创业网) 查看全部

如何批量采集高质量好文章(讨论一下网站批量做关键词排名获取流量的问题(图))

流量是网站的命脉,没有流量的网站基本上就是一潭死水。今天我们将讨论网站批量关键词排名获取流量的问题。

大家都知道,行业核心词的流量大,所以大家都挤着脑袋想成为行业的核心词。但是,行业核心词往往竞争的人太多,所以直接上核心词。如果不进前三,那么基本上很难有可观的流量。更何况,上面有很多竞价排名。

对于一个优秀的站长来说,和大家一起挤出核心词并不是明智的选择。批量做长尾词不仅比核心词的排序难度低很多,而且词数也比较多。流量也精准,性价比远高于长尾词。

批量做网站长尾词排名主要有两种方式:

① 一个页面对大量长尾词进行排序,然后制作一定数量的这样的页面。

这样一来,对一个页面的质量要求和标题编写要求都非常高,对于普通优化者来说是不容易的。

②一个页面对几个长尾词进行排名,然后制作一批排名页面。

与第一种方法相比,这种方法更容易让大家实现。

这种方式有两个步骤:

一页1、网站即可获得排名。

这需要 网站 具有基本权重。一般都有一定的年龄网站,都是合格的。

2、批量做这种页面收录。

对于大多数站长来说,做几十个排名收录的页面并不难,但是如果要做很多页面收录,很多人就会头疼。

这里有三个难点:

a:批量创建大量页面

有些人直接用软件生成了大量的文章作为页面。

有人直接调用站点中的数据,生成大量页面。

有人直接采集大量文章生成大量页面。

有人请编辑大量更新原创文章以获得大量页面。

事实上,有些人在各方面都做得很好。

当然,只要简单地做这些事情,很多人就能做好。

但是第二个问题来了

b:让你的网站收录音量显着增加

有人用蜘蛛池来吸引蜘蛛

有人使用外部链接来吸引蜘蛛

有人先建立对网站的信任,然后再用其他巧妙的方法

c:让收录的页面进行排名

对于这个问题,那些大型的B2B网站已经做得很好了。之前我在这个平台发过很多文章。文章的内容是软件生成的,一点质量都没有,但是他们的收录率非常好,排名也不错。非常好。

这就涉及到网站的信任问题。只有培养了对网站的信任,才能用这种垃圾文章的方式做这种批量排序。

并且如果你对网站的信任度不高,建议你使用聚合调用来生成大量具有一定可读性的页面。

以上是对网站关键词批量排名思路的简单讨论,希望对大家有所帮助。

参考资料:谈批量做网站关键词排名的想法(A5创业网)

如何批量采集高质量好文章(一个黑科技的收录方式,让网站实现快速快速收录 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 158 次浏览 • 2021-10-30 13:06

)

最近很多网站不是收录,主要是百度在做闭环流量,不仅你网站收录少,其实很多网站收录少了很多,包括我操作的长城号和鱼摆都明显减少了收录的现象,今天给大家分享一个黑科技收录的方法,让网站快速实现收录。

上图是今天早上手术的效果。可以看到,收录的现象在操作后几分钟内就出现了。这里提醒一下,我会分享方法和原则,但您在使用时要谨慎。,避免自己网站的副作用,毕竟操作方法不符合百度的要求。

工作原理

登录账号批量提交新链接到百度收录,每个账号可以提交10次,但是浏览器的cookie值不同,所以每次我们清除浏览器缓存,换个账号, cookie 值会发生变化,从而可以实现批量提交。其实我们自己操作也是可以的。同时,我们需要更改计算机的IP。这可以通过代理IP的软件来完成。

获取cookie值也很简单。打开站长平台,登录账号,进入提交页面,输入域名,按F12,点击网络,然后强制刷新一次,然后点击headerc查看cookie值。这里操作的谷歌浏览器可能每个浏览器的界面不同,但操作是相似的。

软件操作

由于百度禁止嵌套sitemap地图文件,很多技术专家开始开发通过cookie值批量提交。软件出来后,风靡一时,效果非常满意。确实可以秒达到收录的现象。.

如上图所示,这是某博客制作的软件。我不会向这里的所有人推荐它。我讨厌向所有人推荐产品。为什么?一旦我向你推荐它,我就不好,以防万一你使用它。不好,我说的是我推荐的产品垃圾,所以大家都在网上找到了。市场上有很多这样的软件,其中很多都有类似的原理,效果我不给你任何保证。

然后软件的操作方法很简单,就是批量导入网址链接,批量登录百度账号,然后开始输入验证码。

但是我在网上看了一下,好像有一些专门做百度轮转编码的,因为百度的验证码是轮转的,所以市面上有解决方案。

总结:收录 和排名是两个不同的东西。本文仅提供原理和测试。这并不意味着你可以做到。所以在使用这种方法时要小心。它可能会对 网站 造成副作用。

查看全部

如何批量采集高质量好文章(一个黑科技的收录方式,让网站实现快速快速收录

)

最近很多网站不是收录,主要是百度在做闭环流量,不仅你网站收录少,其实很多网站收录少了很多,包括我操作的长城号和鱼摆都明显减少了收录的现象,今天给大家分享一个黑科技收录的方法,让网站快速实现收录。

上图是今天早上手术的效果。可以看到,收录的现象在操作后几分钟内就出现了。这里提醒一下,我会分享方法和原则,但您在使用时要谨慎。,避免自己网站的副作用,毕竟操作方法不符合百度的要求。

工作原理

登录账号批量提交新链接到百度收录,每个账号可以提交10次,但是浏览器的cookie值不同,所以每次我们清除浏览器缓存,换个账号, cookie 值会发生变化,从而可以实现批量提交。其实我们自己操作也是可以的。同时,我们需要更改计算机的IP。这可以通过代理IP的软件来完成。

获取cookie值也很简单。打开站长平台,登录账号,进入提交页面,输入域名,按F12,点击网络,然后强制刷新一次,然后点击headerc查看cookie值。这里操作的谷歌浏览器可能每个浏览器的界面不同,但操作是相似的。

软件操作

由于百度禁止嵌套sitemap地图文件,很多技术专家开始开发通过cookie值批量提交。软件出来后,风靡一时,效果非常满意。确实可以秒达到收录的现象。.

如上图所示,这是某博客制作的软件。我不会向这里的所有人推荐它。我讨厌向所有人推荐产品。为什么?一旦我向你推荐它,我就不好,以防万一你使用它。不好,我说的是我推荐的产品垃圾,所以大家都在网上找到了。市场上有很多这样的软件,其中很多都有类似的原理,效果我不给你任何保证。

然后软件的操作方法很简单,就是批量导入网址链接,批量登录百度账号,然后开始输入验证码。

但是我在网上看了一下,好像有一些专门做百度轮转编码的,因为百度的验证码是轮转的,所以市面上有解决方案。

总结:收录 和排名是两个不同的东西。本文仅提供原理和测试。这并不意味着你可以做到。所以在使用这种方法时要小心。它可能会对 网站 造成副作用。

如何批量采集高质量好文章(做seo一般会选择两个的方向是什么?怎么做?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-10-27 15:12

现在做网站的竞争比较大。其实,这是一种积极的表现。因为价值,会有更大的竞争。当我们做 seo 时,情况仍然如此。你以前随便在网站发帖。一些文本将具有 收录 和排名。现在你辛苦写了原创文章,但是在搜索引擎中不一定有排名,所以现在你通常选择两个方向:

① 精致页面

使用少量的文章进行优化,主要的seo策略是做更细致的工作

②更新更多文章

预处理文章,只要内容符合标题且原创通过测试,直接发布,更多文章用于概率排序

其实这两种方法各有优劣。如果您有出色的 seo 技能,我们推荐第一个。如果 seo 水平一般,我们推荐第二个。但是,第二个是向网站发布大量内容。对于一个体育活动,比如我们的网站是用zblog模板搭建的,我们如何批量发布文章?

基于做seo策略的经验,我们认为:

1.软件

可以用软件将文章发布到zblog来搭建网站,但是为了避免广告,我们不提它的名字。在搜索引擎中搜索zblog批量发布就会找到相关信息显示软件结果,打开软件,你会发现软件配置很简单,只需要设置网站地址要更新的内容和发布内容的地址,并做一些基本的配置,比如发布间隔,选择目录等。就这样。

2.插件

当然我们也可以使用zblog应用中心的插件来实现这个功能。搜索批量发布也是如此。您可以参考诸如下载量、价格、反馈信息等综合判断哪个seo插件适合您使用,而且其设置比较简单,您可以参考插件的设置信息来使用。您还应该注意此插件的更新时间。如果长时间没有更新,则需要考虑插件的售后服务质量。

无论是软件还是插件作为zblog批量网站内容更新,都会有利有弊。先说优点:

3.优势

因为软件的使用为我们节省了重复性任务的时间,我们可以有更多的时间做网站分析或其他任务。我们应该明白,在做seo的时候,我们忙着没有方向,没有目标,seo很差。,seo需要思考,因为网站的每一个情况都不一样,只要时刻关注网站的变化,做出好的应对策略,就可以进一步提升网站@的排名> 并且让批量发布文章系统的价值更大。

4.缺点

当然,文章的批量发布也有明显的缺点。例如,为了更规律地发布ID,发布时间间隔调整为相同。这样一来,软件发布的利用就很明显了,很容易被搜索引擎怀疑作弊。不利于seo。如果打乱了顺序,百度蜘蛛的第一次爬取会减少按照id顺序爬取更多页面的可能性。

所以,是否使用zblog批量更新软件,需要根据网站的具体需求合理使用。

总结:网站是由zblog程序构建的。如何批量发布文章的问题?让我们停在这里。以上内容仅供参考。

蝙蝠侠IT转载需要授权! 查看全部

如何批量采集高质量好文章(做seo一般会选择两个的方向是什么?怎么做?)

现在做网站的竞争比较大。其实,这是一种积极的表现。因为价值,会有更大的竞争。当我们做 seo 时,情况仍然如此。你以前随便在网站发帖。一些文本将具有 收录 和排名。现在你辛苦写了原创文章,但是在搜索引擎中不一定有排名,所以现在你通常选择两个方向:

① 精致页面

使用少量的文章进行优化,主要的seo策略是做更细致的工作

②更新更多文章

预处理文章,只要内容符合标题且原创通过测试,直接发布,更多文章用于概率排序

其实这两种方法各有优劣。如果您有出色的 seo 技能,我们推荐第一个。如果 seo 水平一般,我们推荐第二个。但是,第二个是向网站发布大量内容。对于一个体育活动,比如我们的网站是用zblog模板搭建的,我们如何批量发布文章?

基于做seo策略的经验,我们认为:

1.软件

可以用软件将文章发布到zblog来搭建网站,但是为了避免广告,我们不提它的名字。在搜索引擎中搜索zblog批量发布就会找到相关信息显示软件结果,打开软件,你会发现软件配置很简单,只需要设置网站地址要更新的内容和发布内容的地址,并做一些基本的配置,比如发布间隔,选择目录等。就这样。

2.插件

当然我们也可以使用zblog应用中心的插件来实现这个功能。搜索批量发布也是如此。您可以参考诸如下载量、价格、反馈信息等综合判断哪个seo插件适合您使用,而且其设置比较简单,您可以参考插件的设置信息来使用。您还应该注意此插件的更新时间。如果长时间没有更新,则需要考虑插件的售后服务质量。

无论是软件还是插件作为zblog批量网站内容更新,都会有利有弊。先说优点:

3.优势

因为软件的使用为我们节省了重复性任务的时间,我们可以有更多的时间做网站分析或其他任务。我们应该明白,在做seo的时候,我们忙着没有方向,没有目标,seo很差。,seo需要思考,因为网站的每一个情况都不一样,只要时刻关注网站的变化,做出好的应对策略,就可以进一步提升网站@的排名> 并且让批量发布文章系统的价值更大。

4.缺点

当然,文章的批量发布也有明显的缺点。例如,为了更规律地发布ID,发布时间间隔调整为相同。这样一来,软件发布的利用就很明显了,很容易被搜索引擎怀疑作弊。不利于seo。如果打乱了顺序,百度蜘蛛的第一次爬取会减少按照id顺序爬取更多页面的可能性。

所以,是否使用zblog批量更新软件,需要根据网站的具体需求合理使用。

总结:网站是由zblog程序构建的。如何批量发布文章的问题?让我们停在这里。以上内容仅供参考。

蝙蝠侠IT转载需要授权!

如何批量采集高质量好文章( 2018年05月30日ES在之前的博客已有介绍)

采集交流 • 优采云 发表了文章 • 0 个评论 • 149 次浏览 • 2021-10-24 13:08

2018年05月30日ES在之前的博客已有介绍)

python批量导入数据到Elasticsearch的实例

更新时间:2018-05-30 10:43:27 作者:Xiaowei xiaowei2

今天小编就分享一个python批量导入数据到Elasticsearch的例子,有很好的参考价值,希望对大家有所帮助。跟着小编一起来看看

ES在之前的博客中已经介绍过了,提供了很多接口。本文介绍如何使用python进行批量导入。 ES官网的文档很多,仔细使用,结合搜索引擎应该不难。

先给代码

#coding=utf-8

from datetime import datetime

from elasticsearch import Elasticsearch

from elasticsearch import helpers

es = Elasticsearch()

actions = []

f=open('index.txt')

i=1

for line in f:

line = line.strip().split(' ')

action={

"_index":"image",

"_type":"imagetable",

"_id":i,

"_source":{

u"图片名":line[0].decode('utf8'),

u"??Դ":line[1].decode('utf8'),

u"权威性":line[2].decode('utf8'),

u"大小":line[3].decode('utf8'),

u"质量":line[4].decode('utf8'),

u"类别":line[5].decode('utf8'),

u"型号":line[6].decode('utf8'),

u"国别":line[7].decode('utf8'),

u"采集人":line[8].decode('utf8'),

u"所属部门":line[9].decode('utf8'),

u"关键词":line[10].decode('utf8'),

u"访问权限":line[11].decode('utf8')

}

}

i+=1

actions.append(action)

if(len(actions)==500):

helpers.bulk(es, actions)

del actions[0:len(actions)]

if (len(actions) > 0):

helpers.bulk(es, actions)

每句话的意思还是很明显的。这里有几件事要说。首先index.txt是utf8编码的,所以需要将decode('utf8')转成unicode对象,加u之前需要“图片名”,否则ES会报错

导入速度还是很快的,每秒2000多条记录。

上面python批量导入数据到Elasticsearch的例子是编辑器分享的全部内容。希望能给大家一个参考,也希望大家多多支持脚本之家。 查看全部

如何批量采集高质量好文章(

2018年05月30日ES在之前的博客已有介绍)

python批量导入数据到Elasticsearch的实例

更新时间:2018-05-30 10:43:27 作者:Xiaowei xiaowei2

今天小编就分享一个python批量导入数据到Elasticsearch的例子,有很好的参考价值,希望对大家有所帮助。跟着小编一起来看看

ES在之前的博客中已经介绍过了,提供了很多接口。本文介绍如何使用python进行批量导入。 ES官网的文档很多,仔细使用,结合搜索引擎应该不难。

先给代码

#coding=utf-8

from datetime import datetime

from elasticsearch import Elasticsearch

from elasticsearch import helpers

es = Elasticsearch()

actions = []

f=open('index.txt')

i=1

for line in f:

line = line.strip().split(' ')

action={

"_index":"image",

"_type":"imagetable",

"_id":i,

"_source":{

u"图片名":line[0].decode('utf8'),

u"??Դ":line[1].decode('utf8'),

u"权威性":line[2].decode('utf8'),

u"大小":line[3].decode('utf8'),

u"质量":line[4].decode('utf8'),

u"类别":line[5].decode('utf8'),

u"型号":line[6].decode('utf8'),

u"国别":line[7].decode('utf8'),

u"采集人":line[8].decode('utf8'),

u"所属部门":line[9].decode('utf8'),

u"关键词":line[10].decode('utf8'),

u"访问权限":line[11].decode('utf8')

}

}

i+=1

actions.append(action)

if(len(actions)==500):

helpers.bulk(es, actions)

del actions[0:len(actions)]

if (len(actions) > 0):

helpers.bulk(es, actions)

每句话的意思还是很明显的。这里有几件事要说。首先index.txt是utf8编码的,所以需要将decode('utf8')转成unicode对象,加u之前需要“图片名”,否则ES会报错

导入速度还是很快的,每秒2000多条记录。

上面python批量导入数据到Elasticsearch的例子是编辑器分享的全部内容。希望能给大家一个参考,也希望大家多多支持脚本之家。

如何批量采集高质量好文章(内容创作真的很难吗?的文章是个难以跨越的门槛)

采集交流 • 优采云 发表了文章 • 0 个评论 • 124 次浏览 • 2021-10-22 15:01

内容创建对于许多 SEOer 来说是一个艰难的门槛。什么样的文章才算优质?内容创作真的很难吗?那么我们今天就简单的讨论一下以上两点。分析。

一、什么样的文章才是高质量的?

要讨论这个问题,你需要了解什么是高质量的文章。事实上,对于百度蜘蛛来说,只要对用户有价值的文章是优质内容,它就有:

1、 完整可读;

2、 标题内容规范;

3、段落和字体干净;

4、 相关性强;

5、高粘性、高转发”等特点,与之相对的内容是垃圾邮件。垃圾邮件的具体表现是:“页面打不开、句子不完整、内容不完整、质量不高。内容不丰富,都是图片,权限网站",所以内容创作需要避免垃圾邮件。

二、内容创作真的很难吗?

内容创作确实需要能量,但内容创作绝非难事。在我看来,内容创作就像一个卖油人的故事——谁都能做到完美,只要坚持写,每天写,写自己的心得体会。,水平自然会提高。一句话概括,就是用心写文章。内容创作可以获取伪原创或者原创,只要结合关键词title,同时解决用户的文章都好文章。细分下来可以按照以下几点来创建:

1、解决用户需求

2、匹配度(围绕标题)

3、 完成了吗

4、有吸引力,有营销转化的意思

5、 有没有稀缺,a、原创、b、区别(视频、图片);

6、布局之美,例如:产品可以做成桌子

7、图片优化,a,大小,b,ALT,c,与文字相关

8、善用标签,例如H标签

9、 及时提交给百度。 查看全部

如何批量采集高质量好文章(内容创作真的很难吗?的文章是个难以跨越的门槛)

内容创建对于许多 SEOer 来说是一个艰难的门槛。什么样的文章才算优质?内容创作真的很难吗?那么我们今天就简单的讨论一下以上两点。分析。

一、什么样的文章才是高质量的?

要讨论这个问题,你需要了解什么是高质量的文章。事实上,对于百度蜘蛛来说,只要对用户有价值的文章是优质内容,它就有:

1、 完整可读;

2、 标题内容规范;

3、段落和字体干净;

4、 相关性强;

5、高粘性、高转发”等特点,与之相对的内容是垃圾邮件。垃圾邮件的具体表现是:“页面打不开、句子不完整、内容不完整、质量不高。内容不丰富,都是图片,权限网站",所以内容创作需要避免垃圾邮件。

二、内容创作真的很难吗?

内容创作确实需要能量,但内容创作绝非难事。在我看来,内容创作就像一个卖油人的故事——谁都能做到完美,只要坚持写,每天写,写自己的心得体会。,水平自然会提高。一句话概括,就是用心写文章。内容创作可以获取伪原创或者原创,只要结合关键词title,同时解决用户的文章都好文章。细分下来可以按照以下几点来创建:

1、解决用户需求

2、匹配度(围绕标题)

3、 完成了吗

4、有吸引力,有营销转化的意思

5、 有没有稀缺,a、原创、b、区别(视频、图片);

6、布局之美,例如:产品可以做成桌子

7、图片优化,a,大小,b,ALT,c,与文字相关

8、善用标签,例如H标签

9、 及时提交给百度。

如何批量采集高质量好文章(如何通过文章收集获得高质量的网站内容呢?(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 142 次浏览 • 2021-10-18 01:03

问:现阶段,百度推出了飓风算法和清风算法来对抗采集和低质量内容。但是,内容量也是影响百度搜索引擎排名的一个非常重要的因素。这让我们陷入了手动内容和 采集 之间的困境。...

Q:现阶段,百度推出了飓风算法和微风算法来对抗采集和低质量内容。但是,内容量也是影响百度搜索引擎排名的一个非常重要的因素,这让我们面临着手工编写和采集的困境。那么,如何通过文章采集采集优质的网站内容呢?

A:关于文章的采集和组合,我的想法是给大家的:

1. 选择最重要的关键词,对自己的网站关键词进行分类。别说难,如果不自己开发,其实就是5118脑图。2. 关键词 选择后,就是挖掘优质内容。您必须首先选择最全面的主要广播电台,包括您选择的关键字。一定要站出来,因为大站都是综合的。那么,根据你的关键词采集这个大站的内容,当文章被采集的时候,不仅是这个大站,你还要把你的关键词放到百度上去采集。

例如:关键字收录有大站和相关文章文章,还有收录前两篇文章文章的百度倒置。就这样,A关键字已经采集了3个优质文章,以此类推。其他关键字的处理方式相同。然后,我们所有的关键字集合 文章 都存储在库中。在数据库中,每一个关键词对应三个高质量的文章。然后通过软件从数据库中查询关键词title文章。查询时,是时候合并数据了。

第一次:采集存储,第二次:从数据库查询。经过查询,我们可以替换这三个文章。为什么要编写查询软件?那是因为当您编写软件时。你也可以有一个普遍的开始和一个普遍的结束。这样,在查询过程中,三个文章替换后,加上你的通用开始和通用结束,就是伪原创了。

好吧,经过这个查询,文章 看起来更好了,出现了伪文本。其实这更多是为了满足用户的需求。第三步就是通过以上两步。你有更好的伪原创文章。那就别停。以同样的方式提取 文章 集合的 关键词。百度知道,知道问答平台,采集这些问答知识,再结合你的文章,心烦。然后就是最终替换,删除删除,这些都是批量替换软件。这样,一个文章的优质合集就会发布。 查看全部

如何批量采集高质量好文章(如何通过文章收集获得高质量的网站内容呢?(一))

问:现阶段,百度推出了飓风算法和清风算法来对抗采集和低质量内容。但是,内容量也是影响百度搜索引擎排名的一个非常重要的因素。这让我们陷入了手动内容和 采集 之间的困境。...

Q:现阶段,百度推出了飓风算法和微风算法来对抗采集和低质量内容。但是,内容量也是影响百度搜索引擎排名的一个非常重要的因素,这让我们面临着手工编写和采集的困境。那么,如何通过文章采集采集优质的网站内容呢?

A:关于文章的采集和组合,我的想法是给大家的:

1. 选择最重要的关键词,对自己的网站关键词进行分类。别说难,如果不自己开发,其实就是5118脑图。2. 关键词 选择后,就是挖掘优质内容。您必须首先选择最全面的主要广播电台,包括您选择的关键字。一定要站出来,因为大站都是综合的。那么,根据你的关键词采集这个大站的内容,当文章被采集的时候,不仅是这个大站,你还要把你的关键词放到百度上去采集。

例如:关键字收录有大站和相关文章文章,还有收录前两篇文章文章的百度倒置。就这样,A关键字已经采集了3个优质文章,以此类推。其他关键字的处理方式相同。然后,我们所有的关键字集合 文章 都存储在库中。在数据库中,每一个关键词对应三个高质量的文章。然后通过软件从数据库中查询关键词title文章。查询时,是时候合并数据了。

第一次:采集存储,第二次:从数据库查询。经过查询,我们可以替换这三个文章。为什么要编写查询软件?那是因为当您编写软件时。你也可以有一个普遍的开始和一个普遍的结束。这样,在查询过程中,三个文章替换后,加上你的通用开始和通用结束,就是伪原创了。

好吧,经过这个查询,文章 看起来更好了,出现了伪文本。其实这更多是为了满足用户的需求。第三步就是通过以上两步。你有更好的伪原创文章。那就别停。以同样的方式提取 文章 集合的 关键词。百度知道,知道问答平台,采集这些问答知识,再结合你的文章,心烦。然后就是最终替换,删除删除,这些都是批量替换软件。这样,一个文章的优质合集就会发布。

如何批量采集高质量好文章(如何使用好采集垃圾网站一种的感觉呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 151 次浏览 • 2021-10-17 03:21

相信很多朋友都用过采集网站项目,有的是手动复制的,有的是用采集软件和插件快速获取内容的。即使搜索引擎引入了各种算法来处理采集junk网站,也有人做得更好。当然,这些肯定没有我们想象的那么简单。不仅仅是我们需要搭建网站,然后手动复制,软件采集,或者伪原创等等,包括我们看到群里很多网友都做得很好. 网站 已经卖了几万的出价,很是羡慕。

一、网站如何进行采集内容

采集,有人喜欢,有人避而远之!说爱它,因为它真的可以帮助我们节省更多的时间和精力,让我们有更多的时间去推广它。网站; 说要避免,因为搜索引擎不喜欢采集和网站的数据,有些站长提到采集不会摇头。那么,如何用好采集,既节省我们的时间又能给搜索引擎耳目一新的感觉呢?

1、采集器的选择

目前大部分cms(PHPcms、Empire、织梦、心云等)都有采集的功能,如果用得好,也是一个省钱的好方法;但是这些内置的采集功能,个人觉得鸡肋,虽然能用,但是功能不强。如果资金允许,建议购买专业的采集器。

2、了解采集器的特点

俗话说,磨刀不误砍柴。只有当你了解了采集器的所有功能并且能够熟练的使用它时,你才能谈论采集。

3、选择源网站

这个没什么好说的,如果你想挂在树上,就为所欲为。. . 最好选择多个网站,每个网站的内容为原创。记住,不要收录每个网站 采集 的内容过来,最好是每个采集 部分的数据。

4、数据采集

(1), 采集 规则编写

根据预先采集的采集对象,分别为每个网站编写采集规则。请记住,采集 数据应包括以下项目:标题、来源、作者、内容,不要选择其他内容,例如关键字、摘要和时间。

(2),阐明采集的原理和流程

所有 采集器 基本上都按照以下步骤工作:

一种。根据采集规则采集数据,并将数据保存在临时数据库中,功能更强大的采集器也会附上相应的附件(如图片、文件、软件等)。 ) 保存在预先指定的文件中,这些数据和文件有的保存在本地计算机中,有的保存在服务器中;

湾 按照指定的接口发布已经采集的数据,即将临时数据库中的数据发布到网站的数据库中;

(3), 编辑数据

当数据采集到达临时数据库时,很多人会因为麻烦直接发布数据。这种方式相当于复制粘贴,没有意义。如果你这样做,搜索引擎很可能不会惩罚你。小的。因此,当数据采集在临时数据库中时,无论多麻烦,都必须对数据进行编辑,具体有以下几个方面:

一种。修改标题(必填)

湾 添加关键词(手动获取,但部分采集器可以自动获取)

C。写描述或摘要,最好手动

d. 适当修改文章的头部和底部信息

5、发布数据

这一步没什么好说的,就是将编辑好的数据发布到网站。

最后,可能有朋友会问哪个采集器合适,因为时间关系,也因为不想被人误认为我是马甲。我不会在这里谈论它。如果你采集做过,你心中应该有一个最喜欢的。一会儿给大家一个分析表,对目前主流的采集器做一个综合比较,方便大家轻松辨别选择。

其实我们看到的网站采集项目很简单吧?

如果单纯的模仿、抄袭,甚至是软件采集,是不是发现效果并不明显,甚至根本不会是收录。问题是什么?前段时间还找了几个专攻采集网站的朋友,聊的不错。事实上,我们表面上似乎做得很好,平时没什么可做的,吹牛而已。聊天,但实际上,人们也付出了很多。

在这个文章中,我将简要介绍一下采集网站项目的正确流程。我可以告诉你的是,它实际上没有那么简单,如果它那么简单。我们都跟风吗?我们的效率和建站速度肯定会超过大多数用户,为什么不去做呢?这说明还是有一定的门槛的。

二、优质内容

如果是优质内容,我绝对不会去采集内容。这里的优质内容,不允许我们自己写文章的每一篇文章原创。就是我们在选择内容的时候要垂直,如果我们在选择内容的时候选择流量词。比如我以前有朋友采集tribe网站技术含量。事实上,技术内容的用户基数很小,词库中根本无法生成词,所以流量基本很小。

如果我们选择影视、游戏等内容,一旦出现收录这个词,就很容易带来流量。因为以后我们做网站不管是卖还是贴自己的广告,都需要获得流量,有流量的话,卖的单价比较高。当然,买家也需要在站长工具中查看你的网站数据信息。如果选择没有字号的内容,基本上是很难卖的。

而我们在做内容的时候,不管是你原创,采集,抄袭还是别的什么,都必须进行二次加工。直接复制是很难成功的。毕竟你的网站质量肯定不如原版内容。

三、推广权重

任何网站我们做了之后肯定不会自然带来重量和流量,还需要推广。根据网友反馈,即使是采集网站,他们也开始更新内容和推广,和普通的网站一样,只有达到一定的权重值和效果将大量更新和推广。采集。如果开始很多采集,可能会直接被罚网站还没开始。

同时,在我们后续的网站操作中,有网友告诉他们,他们每个月要花几十万元购买资源,比如连接和软文来增加软文的权重。 @网站。我们看到了吗,或者我们为什么不做?其实不是这样的。

四、时期效果

我们很多人都认为采集网站很容易做到,是的,很容易做到,但需要一定的时间才能见效。比如前几天我们看到几个网站效果很好,也是采集或者集成内容。然而,它们需要半年到一年的时间才能生效。所以我们在准备做采集网站项目的时候,也需要考虑时间段,不可能几个月就见效。

就算能用几个月,当你卖网站的时候,买家会分析你的网站是否被骗了,如果是,你的价格不会高或者对方是不需要的. 当然,如果我们通过上述一系列流程来操作,几个月后是不会见效的。我们不应该有任何猜测。

五、加权域名

我们网站的朋友应该知道,如果我们注册一个新的域名,至少要等3到6个月才能有一定的权重。你一开始更新的任何内容,除非你的内容绝对有价值,否则需要这么长时间才能被搜索引擎认可。这就是所谓的累积重量,甚至有的网站需要好几年才能达到一定的重量。

在这里我们可以看到,做采集网站的站长很多,而且都是购买优质的加权域名。有的直接买别人的网站,有的买旧域名,预注册一些已经过期的域名。我写了几篇关于抢注旧域名的文章,专门针对这些朋友的需求。事实上,他们想购买一些旧域名,以缩短域名评估期。

最近几个月,我们会发现很多网友都在运营采集网站,流量上升的非常快。甚至还有一些个人博客和个人网站,前一年都没有更新。通过 采集 获得更大的流量。包括我们在一些网络营销培训团队中也有类似的培训项目。其实采集一直都有,只是最近几个月百度好像出现了算法问题,赋予了采集网站更大的权重效果。

最重要的是域名。如果是老域名,效果会更好。前段时间很多网友都在讨论买旧域名。当时也有两篇关于自己买旧域名的文章文章。如果有网友的需求,我们也可以参考。

过去我们在哪里寻找旧域名购买?大部分网友可能从国内一些域名交易平台、论坛、网友看到,相对域名价格比较高,平均几百元。这些老域名,大多也是通过大多数网友不知道的域名渠道抢注获得的,然后赚取差价。

因此,如果我们需要寻找旧域名,我们可以直接从旧域名等平台购买,包括我们其他的域名抢注平台。只是我之前用过这两个平台,成功率很高,有的甚至可以直接购买。购买旧域名需要注意哪些问题?

1、检查域名是否被屏蔽

由于不确定性,我们可以在购买该域名之前使用PING测试工具查看这些域名是否被DNS拦截或污染。如果我们看到一个被阻止或被污染的域名,如果你重新注册它就没有用了。包括我们以后新注册的域名也需要检查。很有可能我们购买的域名之前已经被用户使用过,因为被屏蔽而被丢弃了。

2、查看域名详情

查找旧域名的目的是什么?有的是因为要让用户看到网站开得更早,有的是外贸网站需要更早的时间,包括一些有一定权重的域名,比new更有效域名。我们可以先看看它是否满足我们的需求再购买。

3、域名交易安全

对于我们在平台上购买的旧域名,付款后不会立即收到,需要一定的时间才能到账到我们的账户使用。如果原持有人以高价赎回,我们支付的费用也将退还。如果我们通过其他中介平台交易旧域名,一定要注意不要私下交易,即使和我们交谈的网友不觉得是骗子,也不能信任。

每个用户找旧域名的渠道可能不同,目的也不同。不能说老域名一定有预期的效果,我们要根据实际需要来选择。

最后我要说的是,当我们采集网站时,我们也需要注意版权问题。部分网站声明内容版权。你不能去采集 或复制它。目前我们的版权意识也在加强,很多站长都收到了律师的来信。 查看全部

如何批量采集高质量好文章(如何使用好采集垃圾网站一种的感觉呢?)

相信很多朋友都用过采集网站项目,有的是手动复制的,有的是用采集软件和插件快速获取内容的。即使搜索引擎引入了各种算法来处理采集junk网站,也有人做得更好。当然,这些肯定没有我们想象的那么简单。不仅仅是我们需要搭建网站,然后手动复制,软件采集,或者伪原创等等,包括我们看到群里很多网友都做得很好. 网站 已经卖了几万的出价,很是羡慕。

一、网站如何进行采集内容

采集,有人喜欢,有人避而远之!说爱它,因为它真的可以帮助我们节省更多的时间和精力,让我们有更多的时间去推广它。网站; 说要避免,因为搜索引擎不喜欢采集和网站的数据,有些站长提到采集不会摇头。那么,如何用好采集,既节省我们的时间又能给搜索引擎耳目一新的感觉呢?

1、采集器的选择

目前大部分cms(PHPcms、Empire、织梦、心云等)都有采集的功能,如果用得好,也是一个省钱的好方法;但是这些内置的采集功能,个人觉得鸡肋,虽然能用,但是功能不强。如果资金允许,建议购买专业的采集器。

2、了解采集器的特点

俗话说,磨刀不误砍柴。只有当你了解了采集器的所有功能并且能够熟练的使用它时,你才能谈论采集。

3、选择源网站

这个没什么好说的,如果你想挂在树上,就为所欲为。. . 最好选择多个网站,每个网站的内容为原创。记住,不要收录每个网站 采集 的内容过来,最好是每个采集 部分的数据。

4、数据采集

(1), 采集 规则编写

根据预先采集的采集对象,分别为每个网站编写采集规则。请记住,采集 数据应包括以下项目:标题、来源、作者、内容,不要选择其他内容,例如关键字、摘要和时间。

(2),阐明采集的原理和流程

所有 采集器 基本上都按照以下步骤工作:

一种。根据采集规则采集数据,并将数据保存在临时数据库中,功能更强大的采集器也会附上相应的附件(如图片、文件、软件等)。 ) 保存在预先指定的文件中,这些数据和文件有的保存在本地计算机中,有的保存在服务器中;

湾 按照指定的接口发布已经采集的数据,即将临时数据库中的数据发布到网站的数据库中;

(3), 编辑数据

当数据采集到达临时数据库时,很多人会因为麻烦直接发布数据。这种方式相当于复制粘贴,没有意义。如果你这样做,搜索引擎很可能不会惩罚你。小的。因此,当数据采集在临时数据库中时,无论多麻烦,都必须对数据进行编辑,具体有以下几个方面:

一种。修改标题(必填)

湾 添加关键词(手动获取,但部分采集器可以自动获取)

C。写描述或摘要,最好手动

d. 适当修改文章的头部和底部信息

5、发布数据

这一步没什么好说的,就是将编辑好的数据发布到网站。

最后,可能有朋友会问哪个采集器合适,因为时间关系,也因为不想被人误认为我是马甲。我不会在这里谈论它。如果你采集做过,你心中应该有一个最喜欢的。一会儿给大家一个分析表,对目前主流的采集器做一个综合比较,方便大家轻松辨别选择。

其实我们看到的网站采集项目很简单吧?

如果单纯的模仿、抄袭,甚至是软件采集,是不是发现效果并不明显,甚至根本不会是收录。问题是什么?前段时间还找了几个专攻采集网站的朋友,聊的不错。事实上,我们表面上似乎做得很好,平时没什么可做的,吹牛而已。聊天,但实际上,人们也付出了很多。

在这个文章中,我将简要介绍一下采集网站项目的正确流程。我可以告诉你的是,它实际上没有那么简单,如果它那么简单。我们都跟风吗?我们的效率和建站速度肯定会超过大多数用户,为什么不去做呢?这说明还是有一定的门槛的。

二、优质内容

如果是优质内容,我绝对不会去采集内容。这里的优质内容,不允许我们自己写文章的每一篇文章原创。就是我们在选择内容的时候要垂直,如果我们在选择内容的时候选择流量词。比如我以前有朋友采集tribe网站技术含量。事实上,技术内容的用户基数很小,词库中根本无法生成词,所以流量基本很小。

如果我们选择影视、游戏等内容,一旦出现收录这个词,就很容易带来流量。因为以后我们做网站不管是卖还是贴自己的广告,都需要获得流量,有流量的话,卖的单价比较高。当然,买家也需要在站长工具中查看你的网站数据信息。如果选择没有字号的内容,基本上是很难卖的。

而我们在做内容的时候,不管是你原创,采集,抄袭还是别的什么,都必须进行二次加工。直接复制是很难成功的。毕竟你的网站质量肯定不如原版内容。

三、推广权重

任何网站我们做了之后肯定不会自然带来重量和流量,还需要推广。根据网友反馈,即使是采集网站,他们也开始更新内容和推广,和普通的网站一样,只有达到一定的权重值和效果将大量更新和推广。采集。如果开始很多采集,可能会直接被罚网站还没开始。

同时,在我们后续的网站操作中,有网友告诉他们,他们每个月要花几十万元购买资源,比如连接和软文来增加软文的权重。 @网站。我们看到了吗,或者我们为什么不做?其实不是这样的。

四、时期效果

我们很多人都认为采集网站很容易做到,是的,很容易做到,但需要一定的时间才能见效。比如前几天我们看到几个网站效果很好,也是采集或者集成内容。然而,它们需要半年到一年的时间才能生效。所以我们在准备做采集网站项目的时候,也需要考虑时间段,不可能几个月就见效。

就算能用几个月,当你卖网站的时候,买家会分析你的网站是否被骗了,如果是,你的价格不会高或者对方是不需要的. 当然,如果我们通过上述一系列流程来操作,几个月后是不会见效的。我们不应该有任何猜测。

五、加权域名

我们网站的朋友应该知道,如果我们注册一个新的域名,至少要等3到6个月才能有一定的权重。你一开始更新的任何内容,除非你的内容绝对有价值,否则需要这么长时间才能被搜索引擎认可。这就是所谓的累积重量,甚至有的网站需要好几年才能达到一定的重量。

在这里我们可以看到,做采集网站的站长很多,而且都是购买优质的加权域名。有的直接买别人的网站,有的买旧域名,预注册一些已经过期的域名。我写了几篇关于抢注旧域名的文章,专门针对这些朋友的需求。事实上,他们想购买一些旧域名,以缩短域名评估期。

最近几个月,我们会发现很多网友都在运营采集网站,流量上升的非常快。甚至还有一些个人博客和个人网站,前一年都没有更新。通过 采集 获得更大的流量。包括我们在一些网络营销培训团队中也有类似的培训项目。其实采集一直都有,只是最近几个月百度好像出现了算法问题,赋予了采集网站更大的权重效果。

最重要的是域名。如果是老域名,效果会更好。前段时间很多网友都在讨论买旧域名。当时也有两篇关于自己买旧域名的文章文章。如果有网友的需求,我们也可以参考。

过去我们在哪里寻找旧域名购买?大部分网友可能从国内一些域名交易平台、论坛、网友看到,相对域名价格比较高,平均几百元。这些老域名,大多也是通过大多数网友不知道的域名渠道抢注获得的,然后赚取差价。

因此,如果我们需要寻找旧域名,我们可以直接从旧域名等平台购买,包括我们其他的域名抢注平台。只是我之前用过这两个平台,成功率很高,有的甚至可以直接购买。购买旧域名需要注意哪些问题?

1、检查域名是否被屏蔽

由于不确定性,我们可以在购买该域名之前使用PING测试工具查看这些域名是否被DNS拦截或污染。如果我们看到一个被阻止或被污染的域名,如果你重新注册它就没有用了。包括我们以后新注册的域名也需要检查。很有可能我们购买的域名之前已经被用户使用过,因为被屏蔽而被丢弃了。

2、查看域名详情

查找旧域名的目的是什么?有的是因为要让用户看到网站开得更早,有的是外贸网站需要更早的时间,包括一些有一定权重的域名,比new更有效域名。我们可以先看看它是否满足我们的需求再购买。

3、域名交易安全

对于我们在平台上购买的旧域名,付款后不会立即收到,需要一定的时间才能到账到我们的账户使用。如果原持有人以高价赎回,我们支付的费用也将退还。如果我们通过其他中介平台交易旧域名,一定要注意不要私下交易,即使和我们交谈的网友不觉得是骗子,也不能信任。

每个用户找旧域名的渠道可能不同,目的也不同。不能说老域名一定有预期的效果,我们要根据实际需要来选择。

最后我要说的是,当我们采集网站时,我们也需要注意版权问题。部分网站声明内容版权。你不能去采集 或复制它。目前我们的版权意识也在加强,很多站长都收到了律师的来信。

如何批量采集高质量好文章(如何批量采集高质量好文章?采集文章方法很多,但是方法不多)

采集交流 • 优采云 发表了文章 • 0 个评论 • 107 次浏览 • 2021-11-20 09:13

如何批量采集高质量好文章?采集文章方法很多,但是方法都是适合某个大的平台,可以采集高质量文章并提取标题对于一些小平台来说,采集的方法就不多了,给大家介绍一种非常有效的采集方法,首先要注册一个订阅号(公众号名字叫:xxx),然后给公众号添加群发即可,如下图:如何批量下载高质量文章呢?以财经类的高质量文章为例,下面我将介绍两种方法:方法一:查询网络爬虫对网站爬虫采集获取网站对应的文章查询网址::sns文章高质量获取对于发布sns账号的主要高质量文章,可以查看该账号的内容更新以及标题,然后匹配出关键词,如下图:下面是使用工具搜狗指数获取热词后,利用工具搜狗指数去采集的链接然后匹配上关键词,如下图:然后就是选择关键词下面两个模块,我就不一一介绍了。

以上工具软件只能获取到一些爬虫网站的热词后返回的数据,但是小平台的热词不适合爬虫下载,还有一个下载方法,就是去各个高质量平台搜索,然后观察他们的数据库里有哪些高质量的文章,把这些高质量的文章p出来即可。如果想要找到高质量的原创文章,也可以加我交流,希望本篇内容对您有所帮助!。

呃,关于批量采集爬虫文章的方法其实应该是有很多的,但是首先我觉得,有机会我会推荐阿里云的采集器:,你问我其他地方有没有比还全的?我只能说有,但是有你也不一定用得上吧!知乎里推荐的资源有很多但是,下载的网站是越多对于你掌握爬虫技能来说, 查看全部

如何批量采集高质量好文章(如何批量采集高质量好文章?采集文章方法很多,但是方法不多)

如何批量采集高质量好文章?采集文章方法很多,但是方法都是适合某个大的平台,可以采集高质量文章并提取标题对于一些小平台来说,采集的方法就不多了,给大家介绍一种非常有效的采集方法,首先要注册一个订阅号(公众号名字叫:xxx),然后给公众号添加群发即可,如下图:如何批量下载高质量文章呢?以财经类的高质量文章为例,下面我将介绍两种方法:方法一:查询网络爬虫对网站爬虫采集获取网站对应的文章查询网址::sns文章高质量获取对于发布sns账号的主要高质量文章,可以查看该账号的内容更新以及标题,然后匹配出关键词,如下图:下面是使用工具搜狗指数获取热词后,利用工具搜狗指数去采集的链接然后匹配上关键词,如下图:然后就是选择关键词下面两个模块,我就不一一介绍了。

以上工具软件只能获取到一些爬虫网站的热词后返回的数据,但是小平台的热词不适合爬虫下载,还有一个下载方法,就是去各个高质量平台搜索,然后观察他们的数据库里有哪些高质量的文章,把这些高质量的文章p出来即可。如果想要找到高质量的原创文章,也可以加我交流,希望本篇内容对您有所帮助!。

呃,关于批量采集爬虫文章的方法其实应该是有很多的,但是首先我觉得,有机会我会推荐阿里云的采集器:,你问我其他地方有没有比还全的?我只能说有,但是有你也不一定用得上吧!知乎里推荐的资源有很多但是,下载的网站是越多对于你掌握爬虫技能来说,

如何批量采集高质量好文章( 上上篇文章爬虫如何爬取微信公众号文章(二))

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-20 07:07

上上篇文章爬虫如何爬取微信公众号文章(二))

python爬虫如何实现每天爬取微信公众号的推送文章

上一篇文章如何抓取微信公众号文章

第一篇文章如何用python爬虫爬取微信公众号文章(二)

以上文章分别介绍了如何批量获取公众号的历史文章url,以及如何批量抓取公众号的文章,提取需要的数据并保存在数据库。

本文文章将介绍如何自动抓取公众号每天推送的文章,然后提取数据保存到数据库中。

首先介绍一个基于itchat的微信借口wxpy。通过大量的界面优化提高了模块的易用性,并进行了丰富的功能扩展。

通过wxpy可以接收微信公众号推送的文章,但是它只实现了每个文章@的标题(title)、摘要(summary)、链接(url)、封面图(cover) > ,我在此基础上又增加了两个属性,分别是文章的发布时间(pub_time)和文章的出处(source)

@property

def articles(self):

"""

公众号推送中的文章列表 (首篇的 标题/地址 与消息中的 text/url 相同)

其中,每篇文章均有以下属性:

* `title`: 标题

* `summary`: 摘要

* `url`: 文章 URL

* `cover`: 封面或缩略图 URL

"""

from wxpy import MP

if self.type == SHARING and isinstance(self.sender, MP):

tree = ETree.fromstring(self.raw['Content'])

# noinspection SpellCheckingInspection

items = tree.findall('.//mmreader/category/item')

article_list = list()

for item in items:

def find_text(tag):

found = item.find(tag)

if found is not None:

return found.text

article = Article()

article.title = find_text('title')

article.summary = find_text('digest')

article.url = find_text('url')

article.cover = find_text('cover')

article.pub_time = find_text('pub_time')

article.source = find_text('.//name')

article_list.append(article)

return article_list

这两个属性也应该添加到article.py中:

# 发布时间

self.pub_time = None

# 来源

self.source = None

事实上,还有其他几个属性。属性如下,可以通过ElementTree获取,看你的需要。

5

1

1

0

0

0

0

1566993086

100020868

0

1

0

0

0

963025857335934976

2

0

0

0

0

1

改完上面的代码后,第一篇文章中实现主要逻辑的函数文章python爬虫如何抓取微信公众号文章(二)也需要改,即url 地址和发布时间作为参数传递,而不是列表类型。

def wechat_run(self,url,pub_time): # 实现主要逻辑

# 打开数据库连接(ip/数据库用户名/登录密码/数据库名)

db = pymysql.connect("localhost", "root", "root", "weixin_database")

# 使用 cursor() 方法创建一个游标对象 cursor

cursor = db.cursor()

html_str = self.parse_url(url)

content_list = self.get_content_list(html_str)

title = ''.join(content_list[0]["title"])

# other1 = ''.join(content_list[0]["other"])

other = '\n'.join(content_list[0]["other"])

create_time = pub_time

# print(other)

p1 = re.compile(r'\s*[(|(]20\d+[)|)]\s*[\u4e00-\u9fa5]*[\d]*[\u4e00-\u9fa5]+[\d]+号', re.S)

anhao = re.search(p1, other)

if (anhao):

anhao = anhao.group().replace("\n", "")

else:

anhao = ""

p2 = re.compile(r'\s[【]*裁判要[\u4e00-\u9fa5]\s*.*?(?=[【]|裁判文)', re.S)

zhaiyao = ''.join(re.findall(p2, other)).replace("\n", "")

# print(zhaiyao)

p3 = re.compile('.*?', re.S)

html = re.search(p3, html_str)

if (html):

html = re.search(p3, html_str).group().replace("\n", "")

else:

html = html_str.replace("\n", "")

sql = """INSERT INTO weixin_table(title,url,anhao,yaozhi,other,html,create_time,type_id)

VALUES ({},{},{},{},{},{},{},{})""".format('"' + title + '"', '"' + url + '"', '"' + anhao + '"',

'"' + zhaiyao + '"', '"' + other + '"', "'" + html + "'",

create_time, 4)

# print(sql)

try:

# 执行sql语句

cursor.execute(sql)

# 提交到数据库执行

db.commit()

print("数据插入成功")

except:

print("数据插入失败:")

info = sys.exc_info()

print(info[0], ":", info[1])

# 如果发生错误则回滚

db.rollback()

# 3.保存html

page_name = title

self.save_html(html, page_name)

# 关闭数据库连接

db.close()

然后编写接收微信消息和公众号推送的函数:

# -*- coding: utf-8 -*-

# @Time : 2019/8/29 上午8:31

# @Author : jingyoushui

# @Email : jingyoushui@163.com

# @File : wechat.py

# @Software: PyCharm

from beijing import WeixinSpider_1

from wxpy import *

import pandas as pd

bot = Bot(cache_path=True, console_qr=True)

# 打印来自其他好友、群聊和公众号的消息

@bot.register()

def print_others(msg):

print('msg:' + str(msg))

articles = msg.articles

if articles is not None:

for article in articles:

a = str(article.source)

print('title:' + str(article.title))

print('url:' + str(article.url))

print('pub_time:' + article.pub_time)

print('source:' + a)

if a != "KMTV" and a != "北京行政裁判观察":

pass

else:

content_list = []

items = []

items.append(str(article.title))

url = str(article.url)

items.append(url)

pub_time = article.pub_time

items.append(pub_time)

content_list.append(items)

name = ['title', 'link', 'create_time']

test = pd.DataFrame(columns=name, data=content_list)

if a == "KMTV":

test.to_csv("everyday_url/kmtv.csv", mode='a', encoding='utf-8')

print("保存成功")

if a == "北京行政裁判观察":

test.to_csv("everyday_url/beijing.csv", mode='a', encoding='utf-8')

print("保存成功")

weixin_spider_1 = WeixinSpider_1()

weixin_spider_1.wechat_run(url, pub_time)

if __name__ == '__main__':

# 堵塞线程

bot.join()

首先获取要爬取的公众号推送的文章的标题、url、发布时间、来源等信息,并保存在一个csv文件中,然后调用WeixinSpider_1类的wechat_run函数实现url的分析和数据 提取数据、保存数据到数据库等操作。

在终端运行程序,打印出二维码,扫描手机微信即可登录

操作方式是阻塞线程,可以处于登录状态,除非你在网页上登录这个账号,否则会被挤掉退出。

8月30日补充: 查看全部

如何批量采集高质量好文章(

上上篇文章爬虫如何爬取微信公众号文章(二))

python爬虫如何实现每天爬取微信公众号的推送文章

上一篇文章如何抓取微信公众号文章

第一篇文章如何用python爬虫爬取微信公众号文章(二)

以上文章分别介绍了如何批量获取公众号的历史文章url,以及如何批量抓取公众号的文章,提取需要的数据并保存在数据库。

本文文章将介绍如何自动抓取公众号每天推送的文章,然后提取数据保存到数据库中。

首先介绍一个基于itchat的微信借口wxpy。通过大量的界面优化提高了模块的易用性,并进行了丰富的功能扩展。

通过wxpy可以接收微信公众号推送的文章,但是它只实现了每个文章@的标题(title)、摘要(summary)、链接(url)、封面图(cover) > ,我在此基础上又增加了两个属性,分别是文章的发布时间(pub_time)和文章的出处(source)

@property

def articles(self):

"""

公众号推送中的文章列表 (首篇的 标题/地址 与消息中的 text/url 相同)

其中,每篇文章均有以下属性:

* `title`: 标题

* `summary`: 摘要

* `url`: 文章 URL

* `cover`: 封面或缩略图 URL

"""

from wxpy import MP

if self.type == SHARING and isinstance(self.sender, MP):

tree = ETree.fromstring(self.raw['Content'])

# noinspection SpellCheckingInspection

items = tree.findall('.//mmreader/category/item')

article_list = list()

for item in items:

def find_text(tag):

found = item.find(tag)

if found is not None:

return found.text

article = Article()

article.title = find_text('title')

article.summary = find_text('digest')

article.url = find_text('url')

article.cover = find_text('cover')

article.pub_time = find_text('pub_time')

article.source = find_text('.//name')

article_list.append(article)

return article_list

这两个属性也应该添加到article.py中:

# 发布时间

self.pub_time = None

# 来源

self.source = None

事实上,还有其他几个属性。属性如下,可以通过ElementTree获取,看你的需要。

5

1

1

0

0

0

0

1566993086

100020868

0

1

0

0

0

963025857335934976

2

0

0

0

0

1

改完上面的代码后,第一篇文章中实现主要逻辑的函数文章python爬虫如何抓取微信公众号文章(二)也需要改,即url 地址和发布时间作为参数传递,而不是列表类型。

def wechat_run(self,url,pub_time): # 实现主要逻辑

# 打开数据库连接(ip/数据库用户名/登录密码/数据库名)

db = pymysql.connect("localhost", "root", "root", "weixin_database")

# 使用 cursor() 方法创建一个游标对象 cursor

cursor = db.cursor()

html_str = self.parse_url(url)

content_list = self.get_content_list(html_str)

title = ''.join(content_list[0]["title"])

# other1 = ''.join(content_list[0]["other"])

other = '\n'.join(content_list[0]["other"])

create_time = pub_time

# print(other)

p1 = re.compile(r'\s*[(|(]20\d+[)|)]\s*[\u4e00-\u9fa5]*[\d]*[\u4e00-\u9fa5]+[\d]+号', re.S)

anhao = re.search(p1, other)

if (anhao):

anhao = anhao.group().replace("\n", "")

else:

anhao = ""

p2 = re.compile(r'\s[【]*裁判要[\u4e00-\u9fa5]\s*.*?(?=[【]|裁判文)', re.S)

zhaiyao = ''.join(re.findall(p2, other)).replace("\n", "")

# print(zhaiyao)

p3 = re.compile('.*?', re.S)

html = re.search(p3, html_str)

if (html):

html = re.search(p3, html_str).group().replace("\n", "")

else:

html = html_str.replace("\n", "")

sql = """INSERT INTO weixin_table(title,url,anhao,yaozhi,other,html,create_time,type_id)

VALUES ({},{},{},{},{},{},{},{})""".format('"' + title + '"', '"' + url + '"', '"' + anhao + '"',

'"' + zhaiyao + '"', '"' + other + '"', "'" + html + "'",

create_time, 4)

# print(sql)

try:

# 执行sql语句

cursor.execute(sql)

# 提交到数据库执行

db.commit()

print("数据插入成功")

except:

print("数据插入失败:")

info = sys.exc_info()

print(info[0], ":", info[1])

# 如果发生错误则回滚

db.rollback()

# 3.保存html

page_name = title

self.save_html(html, page_name)

# 关闭数据库连接

db.close()

然后编写接收微信消息和公众号推送的函数:

# -*- coding: utf-8 -*-

# @Time : 2019/8/29 上午8:31

# @Author : jingyoushui

# @Email : jingyoushui@163.com

# @File : wechat.py

# @Software: PyCharm

from beijing import WeixinSpider_1

from wxpy import *

import pandas as pd

bot = Bot(cache_path=True, console_qr=True)

# 打印来自其他好友、群聊和公众号的消息

@bot.register()

def print_others(msg):

print('msg:' + str(msg))

articles = msg.articles

if articles is not None:

for article in articles:

a = str(article.source)

print('title:' + str(article.title))

print('url:' + str(article.url))

print('pub_time:' + article.pub_time)

print('source:' + a)

if a != "KMTV" and a != "北京行政裁判观察":

pass

else:

content_list = []

items = []

items.append(str(article.title))

url = str(article.url)

items.append(url)

pub_time = article.pub_time

items.append(pub_time)

content_list.append(items)

name = ['title', 'link', 'create_time']

test = pd.DataFrame(columns=name, data=content_list)

if a == "KMTV":

test.to_csv("everyday_url/kmtv.csv", mode='a', encoding='utf-8')

print("保存成功")

if a == "北京行政裁判观察":

test.to_csv("everyday_url/beijing.csv", mode='a', encoding='utf-8')

print("保存成功")

weixin_spider_1 = WeixinSpider_1()

weixin_spider_1.wechat_run(url, pub_time)

if __name__ == '__main__':

# 堵塞线程

bot.join()

首先获取要爬取的公众号推送的文章的标题、url、发布时间、来源等信息,并保存在一个csv文件中,然后调用WeixinSpider_1类的wechat_run函数实现url的分析和数据 提取数据、保存数据到数据库等操作。

在终端运行程序,打印出二维码,扫描手机微信即可登录

操作方式是阻塞线程,可以处于登录状态,除非你在网页上登录这个账号,否则会被挤掉退出。

8月30日补充:

如何批量采集高质量好文章(孤狼工作室开发的微信文章采集器是高质量的吗 )

采集交流 • 优采云 发表了文章 • 0 个评论 • 90 次浏览 • 2021-11-19 17:18

)

微信文章采集器由孤狼工作室开发,从最初的版本1.0到现在的版本10.0,经历了多次改版。是为适应广大微信运营商和网站运营商提供的利器。但是,微信文章都是优质的吗?下面孤狼工作室为您一一解答

所谓的世界文章一般都是抄的,这句话是对的,但是如果抄作业连名字都抄就悲剧了,不屏蔽你就奇怪了。微信公众号助手是一款采集软件,可以采集到达多个微信文章,也可以采集指定公众号文章。这样,虽然微信限制了别人的收录自己的东西,但这样一来,所有的微信文章都将毫无隐私可言。我们要采集如何采集。

采集 下来之后,必须有处理和处理,除非你想被百度屏蔽,想被客户丢弃。

如何处理?首先,软件具有批量校验功能。这个特性对于采集的分类非常有用。 文章是原创的微信应用。其中大部分不能再版。这样,文章的品质和唯一性有了保证。姑且不论,如果百度也这样支持原创,就不会有这么多垃圾站了。

那我们就去关键词采集找更多的素材,一定很丰富。客户只会继续阅读。比如文章开头用文字描述,中间用图片勾勒,结尾用视频结束。这样的文章让客户看起来很舒服。

总是谈论客户体验,我们必须关注细节。 文章的质量一定要非常好读,图文并茂。然后文章可以给客户留下第一印象。

最后我想说的是文章只是网站的骨肉,前提一定是框架好,然后再填内容,不然你会发现以后修改关键词的布局会很麻烦,慎重。

软件具有标题添加关键词和内容添加关键词功能。

查看全部

如何批量采集高质量好文章(孤狼工作室开发的微信文章采集器是高质量的吗

)

微信文章采集器由孤狼工作室开发,从最初的版本1.0到现在的版本10.0,经历了多次改版。是为适应广大微信运营商和网站运营商提供的利器。但是,微信文章都是优质的吗?下面孤狼工作室为您一一解答

所谓的世界文章一般都是抄的,这句话是对的,但是如果抄作业连名字都抄就悲剧了,不屏蔽你就奇怪了。微信公众号助手是一款采集软件,可以采集到达多个微信文章,也可以采集指定公众号文章。这样,虽然微信限制了别人的收录自己的东西,但这样一来,所有的微信文章都将毫无隐私可言。我们要采集如何采集。

采集 下来之后,必须有处理和处理,除非你想被百度屏蔽,想被客户丢弃。

如何处理?首先,软件具有批量校验功能。这个特性对于采集的分类非常有用。 文章是原创的微信应用。其中大部分不能再版。这样,文章的品质和唯一性有了保证。姑且不论,如果百度也这样支持原创,就不会有这么多垃圾站了。

http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-300x203.jpg 300w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-768x521.jpg 768w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-220x150.jpg 220w" />

http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-300x203.jpg 300w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-768x521.jpg 768w, http://www.gulangu.com/wp-content/uploads/2016/08/分类采集-220x150.jpg 220w" />那我们就去关键词采集找更多的素材,一定很丰富。客户只会继续阅读。比如文章开头用文字描述,中间用图片勾勒,结尾用视频结束。这样的文章让客户看起来很舒服。

总是谈论客户体验,我们必须关注细节。 文章的质量一定要非常好读,图文并茂。然后文章可以给客户留下第一印象。

最后我想说的是文章只是网站的骨肉,前提一定是框架好,然后再填内容,不然你会发现以后修改关键词的布局会很麻烦,慎重。

软件具有标题添加关键词和内容添加关键词功能。

http://www.gulangu.com/wp-cont ... 2.jpg 300w, http://www.gulangu.com/wp-cont ... 8.jpg 768w, http://www.gulangu.com/wp-cont ... 8.jpg 220w" />

http://www.gulangu.com/wp-cont ... 2.jpg 300w, http://www.gulangu.com/wp-cont ... 8.jpg 768w, http://www.gulangu.com/wp-cont ... 8.jpg 220w" /> 如何批量采集高质量好文章(优采云亚马逊数据采集软件采集数据有哪些功能优势呢?)

采集交流 • 优采云 发表了文章 • 0 个评论 • 154 次浏览 • 2021-11-19 02:05

批量采集亚马逊的商品数据和评论信息可以帮助我们快速了解对手的信息,可以有针对性地提高我们店铺的产品竞争力。我们如何将 采集 批处理到这些数据?

优采云亚马逊数据采集软件可以批量、实时的采集亚马逊跨国产品数据或评论信息,这些数据可以作为监控竞争对手价格变化或采集之后的自我分析@>。可以导出为excel表格供第三方购物平台使用。

优采云亚马逊数据采集软件采集数据的功能优势是什么?

1、可以批量查询某个店铺的商品,多个关键词在搜索结果中实时排名;

2、您可以根据不同的国家和地区进行查询;

3、根据关键词或分类页面采集产品图片、价格、属性、运费、详细描述、型号等信息导出为csv格式数据;

4、可以批量采集产品评论信息导出;

5、可以自定义任何其他字段采集,可以使用任何字段;

6、支持断点续传,可以切换VPN继续采集;

7、内置高匿名代理IP模式采集,支持高匿名或独占代理采集;

8、支持自动编码采集,集成第三方编码平台。

优采云亚马逊数据采集软件可以将数据导出到自己的购物网站,也可以将采集导出到对方的商品信息中,监控整个行业的走势。如果你有这方面的需求,不妨自己试试,看看这个软件的效果是不是像小编说的那么好。点击如何批量采集阿里巴巴的热门推荐关键词?可以学习采集阿里巴巴关键词的方法。 查看全部

如何批量采集高质量好文章(优采云亚马逊数据采集软件采集数据有哪些功能优势呢?)

批量采集亚马逊的商品数据和评论信息可以帮助我们快速了解对手的信息,可以有针对性地提高我们店铺的产品竞争力。我们如何将 采集 批处理到这些数据?

优采云亚马逊数据采集软件可以批量、实时的采集亚马逊跨国产品数据或评论信息,这些数据可以作为监控竞争对手价格变化或采集之后的自我分析@>。可以导出为excel表格供第三方购物平台使用。

优采云亚马逊数据采集软件采集数据的功能优势是什么?

1、可以批量查询某个店铺的商品,多个关键词在搜索结果中实时排名;

2、您可以根据不同的国家和地区进行查询;

3、根据关键词或分类页面采集产品图片、价格、属性、运费、详细描述、型号等信息导出为csv格式数据;

4、可以批量采集产品评论信息导出;

5、可以自定义任何其他字段采集,可以使用任何字段;

6、支持断点续传,可以切换VPN继续采集;

7、内置高匿名代理IP模式采集,支持高匿名或独占代理采集;

8、支持自动编码采集,集成第三方编码平台。

优采云亚马逊数据采集软件可以将数据导出到自己的购物网站,也可以将采集导出到对方的商品信息中,监控整个行业的走势。如果你有这方面的需求,不妨自己试试,看看这个软件的效果是不是像小编说的那么好。点击如何批量采集阿里巴巴的热门推荐关键词?可以学习采集阿里巴巴关键词的方法。

如何批量采集高质量好文章(如何批量采集高质量好文章【输入关键词+批量图片文字】)

采集交流 • 优采云 发表了文章 • 0 个评论 • 120 次浏览 • 2021-11-16 02:01

如何批量采集高质量好文章【输入关键词+批量图片文字】在批量采集的过程中,因为不了解如何批量采集,所以图片质量低,甚至后期恢复的过程中,一篇文章重新生成很多次,算法复杂,极大降低了我工作效率,后面了解到批量采集工具,了解到工具很多,对各个工具也都有了一定的了解,最后做一个权衡,最终选择了文章批量采集器,效率提高明显,文章采集过程过于繁琐,有兴趣的大家可以试一下,说下我的使用经验:如何采集高质量好文章,是一篇文章批量生成多个大文件,比如一篇文章5mb(高质量文章肯定都是万字以上),就要采集5.6万字以上的文章,平时很多篇图片采集,我就是这样做的,用批量采集器批量采集网页,去掉图片,再加文字,简单的批量操作,对批量采集工具没多大要求,但对图片文字颜色什么的,都有要求,一般最终都会采集5-6万字以上,所以对图片和文字文字的数量需求较高,对于数据量很大的,用批量采集器批量采集下也是不错的,也是数据采集的一种方式,像我这样图片和文字数量较小的也可以用批量采集器来进行采集。

在开始我的网站抓取,文章的时候,是按照一篇30mb的文章为例来操作的,我从中选择了2篇,最后是10kb,一篇10mb,这些图片是我自己输入关键词采集的,我的标准就是字数长小,一篇文章10mb的,标准,但我自己采集下来,一篇的字数真的不足3mb,这篇是真的采集的比较多,文章里面很多表格等等,很多有用的数据,关键词选的好,这个就起到一个比较大的作用了,所以对选的关键词很重要。

今天我这边一共收到了6篇采集好的文章,可是我把里面的表格都删了,就只剩一些数据,我就直接拖到一起,建一个git仓库,然后不管它,想到什么就管什么就行了,然后工具没有乱标价格,只是工具管理而已,标准你自己把握就好了,我这边是比较贵的,自己的需求就是,自己可以手动,也可以用脚本软件管理自己的采集工具,两者结合使用,效率更高。

下面我要说的是软件功能,注意是我采集的,不是和我开发的软件的功能,不想被后面挖坑,我和我的公司达成了共识,这个软件就是为了省时省力省心,这种就是适合我这种没有时间做维护的人做一个采集工具,只要软件稳定运行,能给我提供数据源就行了,我这边本地存着二级别的数据,目前我想用这个工具来管理我的公司的文章源了,好久没搞文章了,后面我自己接私活的时候能发挥点作用,也可以方便,查询代码的时候更有针对性,再者就是文章数量太大的,可以把每篇文章分割得比较细,按字节或者按词组计算,我这边是抓取8千字以上了,数据处理比较。 查看全部

如何批量采集高质量好文章(如何批量采集高质量好文章【输入关键词+批量图片文字】)

如何批量采集高质量好文章【输入关键词+批量图片文字】在批量采集的过程中,因为不了解如何批量采集,所以图片质量低,甚至后期恢复的过程中,一篇文章重新生成很多次,算法复杂,极大降低了我工作效率,后面了解到批量采集工具,了解到工具很多,对各个工具也都有了一定的了解,最后做一个权衡,最终选择了文章批量采集器,效率提高明显,文章采集过程过于繁琐,有兴趣的大家可以试一下,说下我的使用经验:如何采集高质量好文章,是一篇文章批量生成多个大文件,比如一篇文章5mb(高质量文章肯定都是万字以上),就要采集5.6万字以上的文章,平时很多篇图片采集,我就是这样做的,用批量采集器批量采集网页,去掉图片,再加文字,简单的批量操作,对批量采集工具没多大要求,但对图片文字颜色什么的,都有要求,一般最终都会采集5-6万字以上,所以对图片和文字文字的数量需求较高,对于数据量很大的,用批量采集器批量采集下也是不错的,也是数据采集的一种方式,像我这样图片和文字数量较小的也可以用批量采集器来进行采集。

在开始我的网站抓取,文章的时候,是按照一篇30mb的文章为例来操作的,我从中选择了2篇,最后是10kb,一篇10mb,这些图片是我自己输入关键词采集的,我的标准就是字数长小,一篇文章10mb的,标准,但我自己采集下来,一篇的字数真的不足3mb,这篇是真的采集的比较多,文章里面很多表格等等,很多有用的数据,关键词选的好,这个就起到一个比较大的作用了,所以对选的关键词很重要。

今天我这边一共收到了6篇采集好的文章,可是我把里面的表格都删了,就只剩一些数据,我就直接拖到一起,建一个git仓库,然后不管它,想到什么就管什么就行了,然后工具没有乱标价格,只是工具管理而已,标准你自己把握就好了,我这边是比较贵的,自己的需求就是,自己可以手动,也可以用脚本软件管理自己的采集工具,两者结合使用,效率更高。

下面我要说的是软件功能,注意是我采集的,不是和我开发的软件的功能,不想被后面挖坑,我和我的公司达成了共识,这个软件就是为了省时省力省心,这种就是适合我这种没有时间做维护的人做一个采集工具,只要软件稳定运行,能给我提供数据源就行了,我这边本地存着二级别的数据,目前我想用这个工具来管理我的公司的文章源了,好久没搞文章了,后面我自己接私活的时候能发挥点作用,也可以方便,查询代码的时候更有针对性,再者就是文章数量太大的,可以把每篇文章分割得比较细,按字节或者按词组计算,我这边是抓取8千字以上了,数据处理比较。

如何批量采集高质量好文章(如何批量采集高质量好文章?(一)_)

采集交流 • 优采云 发表了文章 • 0 个评论 • 106 次浏览 • 2021-11-13 11:03

如何批量采集高质量好文章?对于这个问题,之前经常从网上找搜索一些大牛的博客来看,然后下载其他网站的内容,这样导致排名前排的基本上都是大牛的文章,有些却排在了0.01页,而有些网站却能排在3-5页。即使排在前5页,有时候还可能看不到。因此,我也尝试过很多办法,分享一下自己的方法吧。

一、爬虫爬虫肯定是首选了,然后就是爬baidu、知乎等搜索引擎的文章,基本上所有的baidu文章都是百度网站的,而baidu网站的文章,相对于较少。

二、人工爬虫爬虫自然就是人工来爬了,分为手动爬虫和机器爬虫,各有优劣。手动爬虫的话,其中一条原则就是时效性要高,时效性高,就是要更新得快,频繁的更新才能保证网站的质量,使得网站还能存活下去。因此一定要抓住信息更新快的网站。爬虫其实就是是个重复工作的过程,大量使用软件是个很好的选择,如金山web浏览器,它每次更新文章之后,会把最新的内容放到我们的浏览器中。大量的重复不仅会提高爬虫的效率,而且也能提高自己爬虫的质量。

三、网页归一化这其实并不是爬虫的大招,但却是对于爬虫很关键的一点。很多网站为了加强站内蜘蛛的运转,会封住spider抓取不到的页面,使得网站的流量被减少。我们可以通过对于网页进行归一化处理,比如减少字数,实现尽可能多的页面。再比如,对于某些网站,往往字数会比较多,可以考虑使用footer来显示剩余页面,从而实现尽可能多的页面。

四、爬虫排名常见的排名方法有,百度的百家排名、网站的alexa排名、seotop网站排名、站长平台的站长推荐排名。通过爬虫爬到网站内容之后,进行排名,可以实现极大的流量。各个网站在排名上也是个竞争对手,没有超出对方5%或以上,我们爬虫爬取的信息还是比较有价值的。 查看全部

如何批量采集高质量好文章(如何批量采集高质量好文章?(一)_)

如何批量采集高质量好文章?对于这个问题,之前经常从网上找搜索一些大牛的博客来看,然后下载其他网站的内容,这样导致排名前排的基本上都是大牛的文章,有些却排在了0.01页,而有些网站却能排在3-5页。即使排在前5页,有时候还可能看不到。因此,我也尝试过很多办法,分享一下自己的方法吧。

一、爬虫爬虫肯定是首选了,然后就是爬baidu、知乎等搜索引擎的文章,基本上所有的baidu文章都是百度网站的,而baidu网站的文章,相对于较少。

二、人工爬虫爬虫自然就是人工来爬了,分为手动爬虫和机器爬虫,各有优劣。手动爬虫的话,其中一条原则就是时效性要高,时效性高,就是要更新得快,频繁的更新才能保证网站的质量,使得网站还能存活下去。因此一定要抓住信息更新快的网站。爬虫其实就是是个重复工作的过程,大量使用软件是个很好的选择,如金山web浏览器,它每次更新文章之后,会把最新的内容放到我们的浏览器中。大量的重复不仅会提高爬虫的效率,而且也能提高自己爬虫的质量。