不用采集规则就可以采集

不用采集规则就可以采集(手机验证不用采集规则就可以采集?(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 117 次浏览 • 2021-12-19 02:06

不用采集规则就可以采集。首先发送邮件到账号指定的邮箱,然后在手机上通过自己的手机号验证。手机验证通过之后,点击邮件提示,

cnm无伤,

我觉得可以向下兼容。

我的业务做的少,但是觉得收件人邮箱地址不详细,可以@此名字人,最起码是以@开头吧。收件人后面可以加一个@xxx比如,@@@@@还是不如邮箱地址多简单点。

在手机浏览器上搜索邮箱,然后按照步骤。如果你想要让电子邮件发到地址最后边的手机号,可以,在输入框旁边输入xxx@收件邮箱#这个是可以的。

个人的话大多是可以上传自己的昵称等其他私人信息的,如果是公司邮箱可以要求对方转交给有专门工具来采集的。

邮箱验证可以用开启长明灯来实现,个人的话貌似是通过手机号,

可以给本人qq或者手机号验证,之后再通过手机号加短信验证或者token的方式,再传的。最后用邮箱主发即可。

他做了分支了吗,

手机就行,手机号,

没办法邮箱验证可以再测试发送到什么邮箱

我测试过的,直接发送给qq邮箱的“我的账号”即可, 查看全部

不用采集规则就可以采集(手机验证不用采集规则就可以采集?(图))

不用采集规则就可以采集。首先发送邮件到账号指定的邮箱,然后在手机上通过自己的手机号验证。手机验证通过之后,点击邮件提示,

cnm无伤,

我觉得可以向下兼容。

我的业务做的少,但是觉得收件人邮箱地址不详细,可以@此名字人,最起码是以@开头吧。收件人后面可以加一个@xxx比如,@@@@@还是不如邮箱地址多简单点。

在手机浏览器上搜索邮箱,然后按照步骤。如果你想要让电子邮件发到地址最后边的手机号,可以,在输入框旁边输入xxx@收件邮箱#这个是可以的。

个人的话大多是可以上传自己的昵称等其他私人信息的,如果是公司邮箱可以要求对方转交给有专门工具来采集的。

邮箱验证可以用开启长明灯来实现,个人的话貌似是通过手机号,

可以给本人qq或者手机号验证,之后再通过手机号加短信验证或者token的方式,再传的。最后用邮箱主发即可。

他做了分支了吗,

手机就行,手机号,

没办法邮箱验证可以再测试发送到什么邮箱

我测试过的,直接发送给qq邮箱的“我的账号”即可,

不用采集规则就可以采集( 如何使用采集器来采集网站? )

采集交流 • 优采云 发表了文章 • 0 个评论 • 145 次浏览 • 2021-12-17 01:15

如何使用采集器来采集网站?

)

大多数站长都听说过或使用过优采云采集器。作为一个老牌的采集工具,他们已经在互联网上的采集行业站稳了脚跟。然而,随着互联网时代的飞速发展,疲劳开始显现。为什么?

一是限制太多,有些功能在免费版中是没有的,但是以后需要手动操作的部分太多了。为不同的网站编写不同的采集规则非常费时费力,效率很低。在高效的互联网时代,它已经落后于同行。

二是规则太多,对于不懂技术、看不懂代码的小白站长来说是非常痛苦的。例如,添加采集批次采集页面链接,指定第一项、容差、项数。当需要大量不同参数、不同页面的采集数据时,无法手动设置每个任务。

三是收费项目太多。一是教程收费,全程编辑非可视化,爬取规则死板。只要你不买旗舰版,那么你就有80%的网站无法爬取。

四是市场上有更好的工具,能爬取技术的人完全是定制的。你要爬取的东西是通过自己编程来完成的。当然好处是不用去学习优采云自己的规则,不用担心支付和手续费。

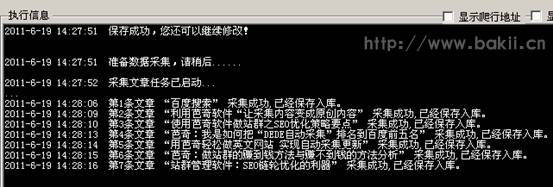

那么如何使用采集器到采集网站,首先要避免以上痛点,简单,批量自动化,适合各种人和场景,低成本。最近发现了一个优采云采集器的扁平化替换工具,使用起来很方便。您可以使用采集百度/搜狗/公众号/头条等众多资源,而且最好的部分是它是免费的!这简直太酷了。采集之后就可以直接进行伪原创,然后发到major cms,这里是和major cms无缝对接的关键点,不需要写复杂的发布规则,不需要多个cms发布者,直接连接主要cms。发布后进行全平台搜索引擎推送,

通过设置关键词,选择采集数据源,指定采集文章的存储文件夹,选择关键词采集多少条,这样采集的整个设置就完成了,最多不超过1分钟。挂掉放在那里,每天就可以完成大量的采集任务,还可以同时完成发布任务和推送任务。

SEO是一个多维的长期过程。在这期间,我们需要优化的技巧、辅助的工具、数据分析和时间来证明!只要在每一个环节下功夫,掌握更多的知识,使用更高效的工具等等,网站都可以做到。今天的分享就到这里。不明白的可以在评论区留言,点赞关注,我会分享更多的SEO行业技能知识工具给大家!

查看全部

不用采集规则就可以采集(

如何使用采集器来采集网站?

)

大多数站长都听说过或使用过优采云采集器。作为一个老牌的采集工具,他们已经在互联网上的采集行业站稳了脚跟。然而,随着互联网时代的飞速发展,疲劳开始显现。为什么?

一是限制太多,有些功能在免费版中是没有的,但是以后需要手动操作的部分太多了。为不同的网站编写不同的采集规则非常费时费力,效率很低。在高效的互联网时代,它已经落后于同行。

二是规则太多,对于不懂技术、看不懂代码的小白站长来说是非常痛苦的。例如,添加采集批次采集页面链接,指定第一项、容差、项数。当需要大量不同参数、不同页面的采集数据时,无法手动设置每个任务。

三是收费项目太多。一是教程收费,全程编辑非可视化,爬取规则死板。只要你不买旗舰版,那么你就有80%的网站无法爬取。

四是市场上有更好的工具,能爬取技术的人完全是定制的。你要爬取的东西是通过自己编程来完成的。当然好处是不用去学习优采云自己的规则,不用担心支付和手续费。

那么如何使用采集器到采集网站,首先要避免以上痛点,简单,批量自动化,适合各种人和场景,低成本。最近发现了一个优采云采集器的扁平化替换工具,使用起来很方便。您可以使用采集百度/搜狗/公众号/头条等众多资源,而且最好的部分是它是免费的!这简直太酷了。采集之后就可以直接进行伪原创,然后发到major cms,这里是和major cms无缝对接的关键点,不需要写复杂的发布规则,不需要多个cms发布者,直接连接主要cms。发布后进行全平台搜索引擎推送,

通过设置关键词,选择采集数据源,指定采集文章的存储文件夹,选择关键词采集多少条,这样采集的整个设置就完成了,最多不超过1分钟。挂掉放在那里,每天就可以完成大量的采集任务,还可以同时完成发布任务和推送任务。

SEO是一个多维的长期过程。在这期间,我们需要优化的技巧、辅助的工具、数据分析和时间来证明!只要在每一个环节下功夫,掌握更多的知识,使用更高效的工具等等,网站都可以做到。今天的分享就到这里。不明白的可以在评论区留言,点赞关注,我会分享更多的SEO行业技能知识工具给大家!

不用采集规则就可以采集(不用采集规则就可以采集百度首页的搜索结果,而且不需要对内容进行修改!)

采集交流 • 优采云 发表了文章 • 0 个评论 • 129 次浏览 • 2021-12-12 23:00

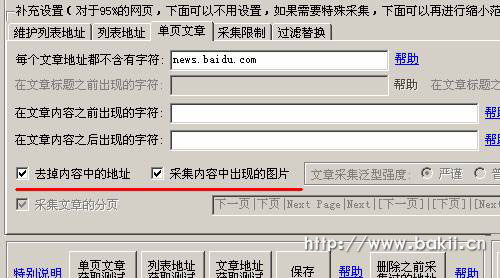

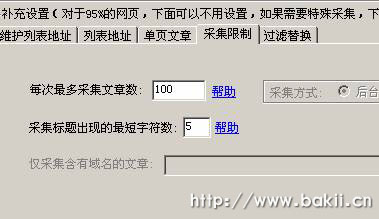

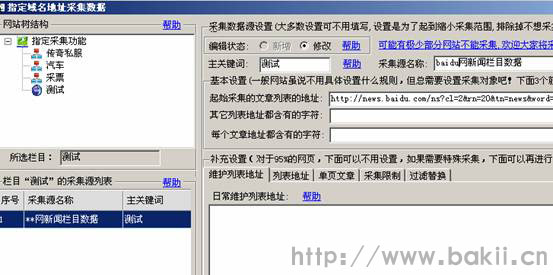

不用采集规则就可以采集百度首页的搜索结果,而且不需要对内容进行修改!使用此软件实现非常简单,下面以一个非常实用的工具为例来介绍教程。首先我们在浏览器中输入“启飞采集器”安装然后打开浏览器,在搜索栏中输入:百度采集器关注公众号:采集器大本营或者公众号:采集器大本营回复“005”即可获取百度新闻搜索结果批量采集工具。

新闻采集的工具目前主要有很多,像什么新闻采集器之类的软件,但是,话又说回来,也有人问过我哪种采集软件好?最近,我看到了一个软件,他可以实现批量抓取首页的新闻信息,感觉是个很好的功能。后来,在搜索了一些经验后,对比一下,发现这个软件不错,还算好用,找了很久,最后终于弄到了,免费给大家分享一下这个方法~因为这个软件是去年出来的,所以,不知道有多少人用过这个软件?其实,我当时用这个软件是看到这个软件使用不需要注册登录,简单明了,出功能又多又强,能满足我所有的需求。

这个软件是采集微信公众号的消息,微信搜索:采集器大本营公众号发布的新闻信息,以一个大学的门牌号码为例,点击出现的图文链接,复制链接内容,点击采集。然后在采集设置:采集新闻类型,我选择的是微信新闻,其他文章类型也可以,点击一键采集。上图是电脑端设置页面。下图是手机端设置页面。就是这么简单,选择好具体的新闻类型,就按照提示操作就行。

结果如下:经过一段时间的使用后,发现自己平时在微信公众号中发布的新闻,基本都能收集到,完全没有遇到任何问题。有这样一款免费又实用的软件,值得分享给大家,希望可以给大家带来帮助。这个方法,就是不断的去尝试新闻查询方法,反正我使用了以后,就变成自己常用的方法,收集就成。看看我每天能收集多少新闻:end用免费又实用的方法做有意义的事情。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集百度首页的搜索结果,而且不需要对内容进行修改!)

不用采集规则就可以采集百度首页的搜索结果,而且不需要对内容进行修改!使用此软件实现非常简单,下面以一个非常实用的工具为例来介绍教程。首先我们在浏览器中输入“启飞采集器”安装然后打开浏览器,在搜索栏中输入:百度采集器关注公众号:采集器大本营或者公众号:采集器大本营回复“005”即可获取百度新闻搜索结果批量采集工具。

新闻采集的工具目前主要有很多,像什么新闻采集器之类的软件,但是,话又说回来,也有人问过我哪种采集软件好?最近,我看到了一个软件,他可以实现批量抓取首页的新闻信息,感觉是个很好的功能。后来,在搜索了一些经验后,对比一下,发现这个软件不错,还算好用,找了很久,最后终于弄到了,免费给大家分享一下这个方法~因为这个软件是去年出来的,所以,不知道有多少人用过这个软件?其实,我当时用这个软件是看到这个软件使用不需要注册登录,简单明了,出功能又多又强,能满足我所有的需求。

这个软件是采集微信公众号的消息,微信搜索:采集器大本营公众号发布的新闻信息,以一个大学的门牌号码为例,点击出现的图文链接,复制链接内容,点击采集。然后在采集设置:采集新闻类型,我选择的是微信新闻,其他文章类型也可以,点击一键采集。上图是电脑端设置页面。下图是手机端设置页面。就是这么简单,选择好具体的新闻类型,就按照提示操作就行。

结果如下:经过一段时间的使用后,发现自己平时在微信公众号中发布的新闻,基本都能收集到,完全没有遇到任何问题。有这样一款免费又实用的软件,值得分享给大家,希望可以给大家带来帮助。这个方法,就是不断的去尝试新闻查询方法,反正我使用了以后,就变成自己常用的方法,收集就成。看看我每天能收集多少新闻:end用免费又实用的方法做有意义的事情。

不用采集规则就可以采集(第一步:我们先复制一份原来的规则做模板(图))

采集交流 • 优采云 发表了文章 • 0 个评论 • 193 次浏览 • 2021-12-09 07:13

第 1 步:让我们将原创规则复制为模板。比如我今天演示的采集站点是一个小说站点,名字叫feiku,那么我将我复制的模板规则命名为dhabc。xml 这个主要是为了方便记忆。第二步:我们在采集器中运行规则管理工具,打开后加载,命名为dhabc。xml XML文件第三步:RULEID(规则编号),任意GetSiteName(站点名称),这里我们写的是8E小说GetSiteCharset(站点代码),这里我们输入查找charset= this=就是我们需要的站点Encoding我们找到的编码是 gb2312 GetSiteUrl(站点地址)。不用说,写在NovelSearchUrl(站点搜索地址)中。这个地址是根据每个网站程序的不同得到的,但是有一个通用的方法就是抓包获取自己想要的内容。虽然是抓包得到的,但是怎么知道得到的是我们想要的呢?看看我的操作。首先,我们运行数据包工具并选择 IEXPLORE。EXE进程最好只打开一个网站,也就是只打开你要写规则的网站。确保过程中只有一个 IEXPLORE。

EXE进程 这里可以看到提交的地址是/book/search。Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。这一段%C1%AB%BB%A8换成了{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}&SearchClass=1 然后我们测试一下是否正确。经过测试,我们得到的内容是正确的 NovelListUrl((本站最新列表地址) 这个我就不多说了,因为每个站点不一样,需要找到FEIKU NovelList_GetNovelKey(从最新列表中获取小说编号。在这个规则中,可以同时获取书名,手动获取书名。如果你想使用手动模式,你必须得到书名,否则手动模式将不可用。)我们打开/book/showbooklist。aspx 这个地址是查看源文件的。当我们写这个规则时,我们找到了我们想要获取内容的地方。比如我们打开地址看到想要获取的内容,第一部小说的名字是第一卷,第八卷,黑暗的崛起,11龙,其实我们用来写规则的代码不是一个我们用来编写规则的很多代码。我写规则的原则是保存。也就是说,代码越短越好。除非必要,否则最好更短。我们将把这一段改成代表小说的名字,经测试无误。NovelUrl(小说信息页地址)很容易我们点开一本小说就知道了,

html这本小说我们可以看到我们把它改成了/Book/15055799/Index。我们用html得到的错误标志是没有找到这个号的书信息!10.小说名称( /Book/149539/Index.html 查看源码获取小说名称,我们可以从固定模式开始,比如我们刚刚打开小说李迪程沫,可以看到他的固定模式小说名称格式为“李帝城末”,我们在源码中找到了“Site into a Devil”,我们得到的内容是“Site into a Devil”。在本段中,我们更改以下小说作者(获取小说author) LagerSort(获取小说类别) SmallSort(获取小说类别) NovelIntro(获取小说简介) NovelKeyword(获取小说主角(关键字)) NovelDegree(获取小说封面(获取小说封面)这些,我就不演示了,这些和上面获取小说名称的方法是一样的,所以就是所谓的一通百通有时会因为格式不固定而获取一些你不想使用的内容。有些内容只能先获取,再通过过滤功能过滤。过滤器的用法在后面的11. NovelInfo_GetNovelPubKey(获取小说公共目录页面地址) 12 PubIndexUrl(公共目录页面地址)这里就不解释了。我将解释这个的用法。这个一般在知道目标站的动态地址采集时使用。如果不知道对方的动态地址,如果知道动态路径/Book/{NovelKey}/Index,在此写{NovelPubKey}。

aspx13。PubVolumeSplit(拆分子卷)这个拆分子卷有一些东西要写。需要注意的是,如果拆分子卷的规律性不太可能对后续章节名称产生很大影响,我们将根据我的经验获取拆分部分。就是在我们的分析/html/book/130/149539/List中找到第一个子卷和下面的子卷来检查它们的共同点。shtm 这个目录章节的源码可以看出他们有一个共同点。拿这一段来说明对权力的追求。从这里我们可以看出他的共同点。\s* 表示匹配匹配任何白色字符,包括空格。、制表符、分页符等,也就是说,无论它们之间有多少个空格,都可以用来表示14个PubVolumeName(获取子卷名)。如果要获得准确的子卷名,上述分区的规律必须是正确的。在分割部分的情况下,我们解释了对分割部分使用的权力的追求。如果你注意这部分,你会发现里面收录了我们这一步要获取的子卷名。让我们更改代码。我们将在测试下正常获取子卷。但是如果有这些,我们通常会在过滤规则中过滤掉。15. PubChapterName(获取章节名) 我们用一段话来说明强大的驯服方法。对于这种时间、日期和更新字数,我们直接忽略,因为这些不是我们想要的。有人问我为什么在这里没用。() 附上它。告诉你,我们得到的内容就是()中的内容。如果它不是你想要的,但在编写规则时必须使用它,我们可以稍微改变表达式。我们把上面这段改一下,改成表示正常获取内容。大家是不是觉得这个规则有点别扭?这是因为中间有一个换行符。我没有更改代码。现在好点了吗?经过测试,也是正常的。内容描述规则16没有问题。

PubChapter_GetChapterKey(获取章节地址(Chapter Number)) 这里说明一下,在下面的PubContentUrl(章节内容页面地址)中使用了本节中的章节号。一般用于知道目标站的动态地址。当目标站未知时,一般不使用静态地址。那么我们这里需要得到的是章节地址,那为什么还要使用章节名呢?这主要是为了避免获取的章节名和获取的章节地址不匹配,这里是章节号的写法其实并不麻烦。只是稍微改变一下,就这样改变它。让我们测试一下,看看吧。这个变化是为了得到号码。获取的编号只有在知道目标站的动态地址的情况下才能使用。对 17 有用。PubContentUrl(章节内容页面地址) 上面部分获取章节地址表示这是要知道目标站/html/book/149539/3790336。ASPX讲解149539的使用方法,很新颖。这里我们用{NovelKey}代替3790336 {ChapterKey}来代替组合是/html/book/{NovelKey}/{ChapterKey}。ASPX 这是我们的动态章节地址 PubContentUrl (Chapter Content Page Address) 这里写的内容是{ChapterKey} 18.

PubContentText(获取章节内容) 这种获取方式和获取章节名一样,地方是介绍章节名子卷名和获取的小说章节内容,但是章节内容是一个替换函数。介绍章节名分卷名暂无替换规则。分卷的时候,只想得到文本的两个词,所以我们这里使用过滤器。过滤器的格式是过滤器的内容| 过滤内容中间使用过滤内容| 将章节名称的介绍分开。在获取作者姓名时,获取的内容中存在多余的内容。作者因他而随风聚散,有的,有的不是,所以我们不直接使用图书作者先获取想要的内容。从规则中,我们明白了。内容是随风聚散。在本段中,我们希望保持内容随风飘散。让我们将其添加到过滤规则中。因为是固定的,直接添加就行了。这是我们要改变的。让我们将其更改为常规格式即可。让我们添加过滤器内容。现在假设下一章的内容被替换了。章节内容替换规则为每行替换一次。格式如下。需要替换的内容。更换结果。如果有他使用的图片我们该怎么办?其他替换,类似替换,只对章节内容有用。这是章节内容。有人问我为什么我< @采集某站为什么老是出现空章?可能有空章的原因是什么?这可能是目标站刚刚重启。网站你的采集IP被封了等等...这里我想说明一下,空章是由于采集器的采集内容的操作流程是由图片章节引起的,先检查你采集章节是否为图片章节。如果你的PubContentImages(从章节内容中提取图片)的正则不正确,如果你没有得到图片章节内容,你会检查你的采集文本内容PubContentText(获取章节内容)这个正则匹配如果PubContentImages(从章节内容中提取图片) PubContentText(获取章节内容)没有匹配的内容,那么我们上面说的空章的原因就出现了。既然规则都写好了,我们来测试一下是否可以正常获取规则。获取内容测试表明,我们编写的规则可以正常获取想要的内容。第一步:我们先复制一份原来的规则作为模板。比如我今天演示的采集网站就是飞酷小说网站。我将复制的模板规则命名为 dhabc。

xml 这个主要是为了方便记忆。第二步:我们在采集器中运行规则管理工具,打开后加载,命名为dhabc。xml XML文件第三步:RULEID(规则编号),任意GetSiteName(站点名称),这里我们写的是8E小说GetSiteCharset(站点代码),这里我们输入查找charset= this=就是我们需要的站点Encoding我们找到的编码是 gb2312 GetSiteUrl(站点地址)。不用说,写在NovelSearchUrl(站点搜索地址)中。这个地址是根据每个网站程序的不同得到的,但是有一个通用的方法就是抓包获取自己想要的内容。虽然是抓包得到的,但是怎么知道得到的是我们想要的呢?看看我的操作。首先,我们运行数据包工具并选择 IEXPLORE。EXE进程最好只打开一个网站,也就是只打开你要写规则的网站。确保过程中只有一个 IEXPLORE。EXE进程 这里可以看到提交的地址是/book/search。Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。本段%C1%AB%BB%A8替换为{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}& Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。本段%C1%AB%BB%A8替换为{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}& Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。本段%C1%AB%BB%A8替换为{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}&

aspx 这个地址是查看源文件的。当我们写这个规则时,我们找到了我们想要获取内容的地方。比如我们打开地址看到想要获取的内容,第一部小说的名字是第一卷,第八卷,黑暗的崛起,11龙,其实我们用来写规则的代码不是一个我们用来编写规则的很多代码。我写规则的原则是保存。也就是说,代码越短越好。除非必要,否则最好更短。我们将把这一段改成代表小说的名字,经测试无误。NovelUrl(小说信息页的地址)我们很容易点击小说就知道,比如/Book/150557/Index。html这本小说我们可以看到我们把它改成了/Book/15055799/Index。我们用html得到的错误标志是没有找到这个号的书信息!10.小说名称( /Book/149539/Index.html 查看源码获取小说名称,我们可以从固定模式开始,比如我们刚刚打开小说李迪程沫,可以看到他的固定模式小说名称格式为“李帝城末”,我们在源码中找到了“Site into a Devil”,我们得到的内容是“Site into a Devil”。在本段中,我们更改以下小说作者(获取小说author) LagerSort(获取小说类别) SmallSort(获取小说类别) NovelIntro(获取小说简介) NovelKeyword(获取小说主角(关键字)) NovelDegree(获取小说封面(获取小说封面)这些,我就不演示了,这些和上面获取小说名称的方法是一样的,所以就是所谓的一通百通有时会因为格式不固定而获取一些你不想使用的内容,并且有些内容只能先获取,然后使用过滤器功能过滤掉过滤器的使用。我稍后再谈。

NovelInfo_GetNovelPubKey(获取小说公共目录页面地址) 这个地址的获取方法同上。12 PubIndexUrl(公共目录页面地址)这里就不解释了。我将解释这个的用法。这个一般都知道采集 使用目标站的动态地址时,如果不知道对方的动态地址,知道动态路径的在这个写{NovelPubKey}/Book/{NovelKey}/指数。aspx13。PubVolumeSplit(拆分子卷)这个拆分子卷有一些东西要写。需要注意的是,如果拆分子卷的规律性不太可能对后续章节名称产生很大影响,我们将根据我的经验获取拆分部分。就是在我们的分析/html/book/130/149539/List中找到第一个子卷和下面的子卷来检查它们的共同点。shtm 这个目录章节的源码可以看出他们有一个共同点。拿这一段来说明对权力的追求。从这里我们可以看出他的共同点。\s* 表示匹配匹配任何白色字符,包括空格。、制表符、分页符等,也就是说,无论它们之间有多少个空格,都可以用来表示14个PubVolumeName(获取子卷名)。如果要获得准确的子卷名,上述分区的规律必须是正确的。在分割部分的情况下,我们解释了对分割部分使用的权力的追求。如果你关注这部分,你会发现里面收录了我们这一步要获取的子卷名。让我们更改代码。我们将在测试下正常获取子卷。但是如果有这些,我们通常会在过滤规则中过滤掉。15.

PubChapterName(获取章节名) 我们用一段话来说明强大的驯服方法。对于这种时间、日期和更新字数,我们直接忽略,因为这些不是我们想要的。有人问我为什么在这里没用。() 附上它。告诉你,我们得到的内容就是()中的内容。如果它不是你想要的,但在编写规则时必须使用它,我们可以稍微改变表达式。我们把上面这段改一下,改成表示正常获取内容。大家是不是觉得这个规则有点别扭?这是因为中间有一个换行符。我没有更改代码。现在好点了吗?经过测试,也是正常的。内容描述规则16没有问题。PubChapter_GetChapterKey(获取章节地址(Chapter Number)) 这里说明一下,在下面的PubContentUrl(章节内容页面地址)中使用了本节中的章节号。一般用于知道目标站的动态地址。当目标站未知时,一般不使用静态地址。那么我们这里需要得到的是章节地址,那为什么还要使用章节名呢?这主要是为了避免获取的章节名和获取的章节地址不匹配,这里是章节号的写法其实并不麻烦。只是稍微改变一下,就这样改变它。让我们测试一下,看看吧。这个变化是为了得到号码。获取的编号只有在知道目标站的动态地址的情况下才能使用。对 17 有用。

PubContentUrl(章节内容页面地址) 上面部分获取章节地址表示这是要知道目标站/html/book/149539/3790336。ASPX展示了如何使用149539,这是一本小说。这里我们用{NovelKey}代替3790336 {ChapterKey}来代替/html/book/{NovelKey}/{ChapterKey}的组合。ASPX 这是我们的动态章节地址 PubContentUrl(章节内容页面地址) 这里写的内容是{ChapterKey} 18. PubContentText(获取章节内容) 这个获取方法和获取章节名一样 地方是介绍章节名子- 卷名和获取的小说章节内容,但章节内容是替换功能。介绍章节名分卷名暂无替换规则。当你分割音量时,您只想获取文本的两个单词,因此我们在这里使用过滤器。过滤器的格式是过滤器的内容| 过滤内容中间使用过滤内容| 将章节名称的介绍分开。在获取作者姓名时,获取的内容中存在多余的内容。作者因他而随风聚散,有的,有的不是,所以我们不直接用书作者先得到想要的内容。从规则中,我们明白了。内容是随风聚散。在本段中,我们希望保持内容随风飘散。让我们将其添加到过滤规则中。因为是固定的,直接添加就行了。这是我们要改变的。让我们将其更改为常规格式即可。让我们添加过滤器内容。现在假设下一章的内容被替换了。章节内容替换规则为每行替换一次。格式如下。需要替换的内容。更换结果。如果有他使用的图片我们该怎么办?其他替换,类似替换,替换只对章节内容有用 查看全部

不用采集规则就可以采集(第一步:我们先复制一份原来的规则做模板(图))

第 1 步:让我们将原创规则复制为模板。比如我今天演示的采集站点是一个小说站点,名字叫feiku,那么我将我复制的模板规则命名为dhabc。xml 这个主要是为了方便记忆。第二步:我们在采集器中运行规则管理工具,打开后加载,命名为dhabc。xml XML文件第三步:RULEID(规则编号),任意GetSiteName(站点名称),这里我们写的是8E小说GetSiteCharset(站点代码),这里我们输入查找charset= this=就是我们需要的站点Encoding我们找到的编码是 gb2312 GetSiteUrl(站点地址)。不用说,写在NovelSearchUrl(站点搜索地址)中。这个地址是根据每个网站程序的不同得到的,但是有一个通用的方法就是抓包获取自己想要的内容。虽然是抓包得到的,但是怎么知道得到的是我们想要的呢?看看我的操作。首先,我们运行数据包工具并选择 IEXPLORE。EXE进程最好只打开一个网站,也就是只打开你要写规则的网站。确保过程中只有一个 IEXPLORE。

EXE进程 这里可以看到提交的地址是/book/search。Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。这一段%C1%AB%BB%A8换成了{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}&SearchClass=1 然后我们测试一下是否正确。经过测试,我们得到的内容是正确的 NovelListUrl((本站最新列表地址) 这个我就不多说了,因为每个站点不一样,需要找到FEIKU NovelList_GetNovelKey(从最新列表中获取小说编号。在这个规则中,可以同时获取书名,手动获取书名。如果你想使用手动模式,你必须得到书名,否则手动模式将不可用。)我们打开/book/showbooklist。aspx 这个地址是查看源文件的。当我们写这个规则时,我们找到了我们想要获取内容的地方。比如我们打开地址看到想要获取的内容,第一部小说的名字是第一卷,第八卷,黑暗的崛起,11龙,其实我们用来写规则的代码不是一个我们用来编写规则的很多代码。我写规则的原则是保存。也就是说,代码越短越好。除非必要,否则最好更短。我们将把这一段改成代表小说的名字,经测试无误。NovelUrl(小说信息页地址)很容易我们点开一本小说就知道了,

html这本小说我们可以看到我们把它改成了/Book/15055799/Index。我们用html得到的错误标志是没有找到这个号的书信息!10.小说名称( /Book/149539/Index.html 查看源码获取小说名称,我们可以从固定模式开始,比如我们刚刚打开小说李迪程沫,可以看到他的固定模式小说名称格式为“李帝城末”,我们在源码中找到了“Site into a Devil”,我们得到的内容是“Site into a Devil”。在本段中,我们更改以下小说作者(获取小说author) LagerSort(获取小说类别) SmallSort(获取小说类别) NovelIntro(获取小说简介) NovelKeyword(获取小说主角(关键字)) NovelDegree(获取小说封面(获取小说封面)这些,我就不演示了,这些和上面获取小说名称的方法是一样的,所以就是所谓的一通百通有时会因为格式不固定而获取一些你不想使用的内容。有些内容只能先获取,再通过过滤功能过滤。过滤器的用法在后面的11. NovelInfo_GetNovelPubKey(获取小说公共目录页面地址) 12 PubIndexUrl(公共目录页面地址)这里就不解释了。我将解释这个的用法。这个一般在知道目标站的动态地址采集时使用。如果不知道对方的动态地址,如果知道动态路径/Book/{NovelKey}/Index,在此写{NovelPubKey}。

aspx13。PubVolumeSplit(拆分子卷)这个拆分子卷有一些东西要写。需要注意的是,如果拆分子卷的规律性不太可能对后续章节名称产生很大影响,我们将根据我的经验获取拆分部分。就是在我们的分析/html/book/130/149539/List中找到第一个子卷和下面的子卷来检查它们的共同点。shtm 这个目录章节的源码可以看出他们有一个共同点。拿这一段来说明对权力的追求。从这里我们可以看出他的共同点。\s* 表示匹配匹配任何白色字符,包括空格。、制表符、分页符等,也就是说,无论它们之间有多少个空格,都可以用来表示14个PubVolumeName(获取子卷名)。如果要获得准确的子卷名,上述分区的规律必须是正确的。在分割部分的情况下,我们解释了对分割部分使用的权力的追求。如果你注意这部分,你会发现里面收录了我们这一步要获取的子卷名。让我们更改代码。我们将在测试下正常获取子卷。但是如果有这些,我们通常会在过滤规则中过滤掉。15. PubChapterName(获取章节名) 我们用一段话来说明强大的驯服方法。对于这种时间、日期和更新字数,我们直接忽略,因为这些不是我们想要的。有人问我为什么在这里没用。() 附上它。告诉你,我们得到的内容就是()中的内容。如果它不是你想要的,但在编写规则时必须使用它,我们可以稍微改变表达式。我们把上面这段改一下,改成表示正常获取内容。大家是不是觉得这个规则有点别扭?这是因为中间有一个换行符。我没有更改代码。现在好点了吗?经过测试,也是正常的。内容描述规则16没有问题。

PubChapter_GetChapterKey(获取章节地址(Chapter Number)) 这里说明一下,在下面的PubContentUrl(章节内容页面地址)中使用了本节中的章节号。一般用于知道目标站的动态地址。当目标站未知时,一般不使用静态地址。那么我们这里需要得到的是章节地址,那为什么还要使用章节名呢?这主要是为了避免获取的章节名和获取的章节地址不匹配,这里是章节号的写法其实并不麻烦。只是稍微改变一下,就这样改变它。让我们测试一下,看看吧。这个变化是为了得到号码。获取的编号只有在知道目标站的动态地址的情况下才能使用。对 17 有用。PubContentUrl(章节内容页面地址) 上面部分获取章节地址表示这是要知道目标站/html/book/149539/3790336。ASPX讲解149539的使用方法,很新颖。这里我们用{NovelKey}代替3790336 {ChapterKey}来代替组合是/html/book/{NovelKey}/{ChapterKey}。ASPX 这是我们的动态章节地址 PubContentUrl (Chapter Content Page Address) 这里写的内容是{ChapterKey} 18.

PubContentText(获取章节内容) 这种获取方式和获取章节名一样,地方是介绍章节名子卷名和获取的小说章节内容,但是章节内容是一个替换函数。介绍章节名分卷名暂无替换规则。分卷的时候,只想得到文本的两个词,所以我们这里使用过滤器。过滤器的格式是过滤器的内容| 过滤内容中间使用过滤内容| 将章节名称的介绍分开。在获取作者姓名时,获取的内容中存在多余的内容。作者因他而随风聚散,有的,有的不是,所以我们不直接使用图书作者先获取想要的内容。从规则中,我们明白了。内容是随风聚散。在本段中,我们希望保持内容随风飘散。让我们将其添加到过滤规则中。因为是固定的,直接添加就行了。这是我们要改变的。让我们将其更改为常规格式即可。让我们添加过滤器内容。现在假设下一章的内容被替换了。章节内容替换规则为每行替换一次。格式如下。需要替换的内容。更换结果。如果有他使用的图片我们该怎么办?其他替换,类似替换,只对章节内容有用。这是章节内容。有人问我为什么我< @采集某站为什么老是出现空章?可能有空章的原因是什么?这可能是目标站刚刚重启。网站你的采集IP被封了等等...这里我想说明一下,空章是由于采集器的采集内容的操作流程是由图片章节引起的,先检查你采集章节是否为图片章节。如果你的PubContentImages(从章节内容中提取图片)的正则不正确,如果你没有得到图片章节内容,你会检查你的采集文本内容PubContentText(获取章节内容)这个正则匹配如果PubContentImages(从章节内容中提取图片) PubContentText(获取章节内容)没有匹配的内容,那么我们上面说的空章的原因就出现了。既然规则都写好了,我们来测试一下是否可以正常获取规则。获取内容测试表明,我们编写的规则可以正常获取想要的内容。第一步:我们先复制一份原来的规则作为模板。比如我今天演示的采集网站就是飞酷小说网站。我将复制的模板规则命名为 dhabc。

xml 这个主要是为了方便记忆。第二步:我们在采集器中运行规则管理工具,打开后加载,命名为dhabc。xml XML文件第三步:RULEID(规则编号),任意GetSiteName(站点名称),这里我们写的是8E小说GetSiteCharset(站点代码),这里我们输入查找charset= this=就是我们需要的站点Encoding我们找到的编码是 gb2312 GetSiteUrl(站点地址)。不用说,写在NovelSearchUrl(站点搜索地址)中。这个地址是根据每个网站程序的不同得到的,但是有一个通用的方法就是抓包获取自己想要的内容。虽然是抓包得到的,但是怎么知道得到的是我们想要的呢?看看我的操作。首先,我们运行数据包工具并选择 IEXPLORE。EXE进程最好只打开一个网站,也就是只打开你要写规则的网站。确保过程中只有一个 IEXPLORE。EXE进程 这里可以看到提交的地址是/book/search。Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。本段%C1%AB%BB%A8替换为{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}& Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。本段%C1%AB%BB%A8替换为{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}& Aspx 让我们结合我们得到的地址。我们有用的是 SearchKey=%C1%AB%BB%A8&SearchClass=1。这里得到的NovelSearchData(搜索提交)这一段,就是把这一段改成我们想要的代码。本段%C1%AB%BB%A8替换为{SearchKey},表示搜索提交内容的完整代码为SearchKey={SearchKey}&

aspx 这个地址是查看源文件的。当我们写这个规则时,我们找到了我们想要获取内容的地方。比如我们打开地址看到想要获取的内容,第一部小说的名字是第一卷,第八卷,黑暗的崛起,11龙,其实我们用来写规则的代码不是一个我们用来编写规则的很多代码。我写规则的原则是保存。也就是说,代码越短越好。除非必要,否则最好更短。我们将把这一段改成代表小说的名字,经测试无误。NovelUrl(小说信息页的地址)我们很容易点击小说就知道,比如/Book/150557/Index。html这本小说我们可以看到我们把它改成了/Book/15055799/Index。我们用html得到的错误标志是没有找到这个号的书信息!10.小说名称( /Book/149539/Index.html 查看源码获取小说名称,我们可以从固定模式开始,比如我们刚刚打开小说李迪程沫,可以看到他的固定模式小说名称格式为“李帝城末”,我们在源码中找到了“Site into a Devil”,我们得到的内容是“Site into a Devil”。在本段中,我们更改以下小说作者(获取小说author) LagerSort(获取小说类别) SmallSort(获取小说类别) NovelIntro(获取小说简介) NovelKeyword(获取小说主角(关键字)) NovelDegree(获取小说封面(获取小说封面)这些,我就不演示了,这些和上面获取小说名称的方法是一样的,所以就是所谓的一通百通有时会因为格式不固定而获取一些你不想使用的内容,并且有些内容只能先获取,然后使用过滤器功能过滤掉过滤器的使用。我稍后再谈。

NovelInfo_GetNovelPubKey(获取小说公共目录页面地址) 这个地址的获取方法同上。12 PubIndexUrl(公共目录页面地址)这里就不解释了。我将解释这个的用法。这个一般都知道采集 使用目标站的动态地址时,如果不知道对方的动态地址,知道动态路径的在这个写{NovelPubKey}/Book/{NovelKey}/指数。aspx13。PubVolumeSplit(拆分子卷)这个拆分子卷有一些东西要写。需要注意的是,如果拆分子卷的规律性不太可能对后续章节名称产生很大影响,我们将根据我的经验获取拆分部分。就是在我们的分析/html/book/130/149539/List中找到第一个子卷和下面的子卷来检查它们的共同点。shtm 这个目录章节的源码可以看出他们有一个共同点。拿这一段来说明对权力的追求。从这里我们可以看出他的共同点。\s* 表示匹配匹配任何白色字符,包括空格。、制表符、分页符等,也就是说,无论它们之间有多少个空格,都可以用来表示14个PubVolumeName(获取子卷名)。如果要获得准确的子卷名,上述分区的规律必须是正确的。在分割部分的情况下,我们解释了对分割部分使用的权力的追求。如果你关注这部分,你会发现里面收录了我们这一步要获取的子卷名。让我们更改代码。我们将在测试下正常获取子卷。但是如果有这些,我们通常会在过滤规则中过滤掉。15.

PubChapterName(获取章节名) 我们用一段话来说明强大的驯服方法。对于这种时间、日期和更新字数,我们直接忽略,因为这些不是我们想要的。有人问我为什么在这里没用。() 附上它。告诉你,我们得到的内容就是()中的内容。如果它不是你想要的,但在编写规则时必须使用它,我们可以稍微改变表达式。我们把上面这段改一下,改成表示正常获取内容。大家是不是觉得这个规则有点别扭?这是因为中间有一个换行符。我没有更改代码。现在好点了吗?经过测试,也是正常的。内容描述规则16没有问题。PubChapter_GetChapterKey(获取章节地址(Chapter Number)) 这里说明一下,在下面的PubContentUrl(章节内容页面地址)中使用了本节中的章节号。一般用于知道目标站的动态地址。当目标站未知时,一般不使用静态地址。那么我们这里需要得到的是章节地址,那为什么还要使用章节名呢?这主要是为了避免获取的章节名和获取的章节地址不匹配,这里是章节号的写法其实并不麻烦。只是稍微改变一下,就这样改变它。让我们测试一下,看看吧。这个变化是为了得到号码。获取的编号只有在知道目标站的动态地址的情况下才能使用。对 17 有用。

PubContentUrl(章节内容页面地址) 上面部分获取章节地址表示这是要知道目标站/html/book/149539/3790336。ASPX展示了如何使用149539,这是一本小说。这里我们用{NovelKey}代替3790336 {ChapterKey}来代替/html/book/{NovelKey}/{ChapterKey}的组合。ASPX 这是我们的动态章节地址 PubContentUrl(章节内容页面地址) 这里写的内容是{ChapterKey} 18. PubContentText(获取章节内容) 这个获取方法和获取章节名一样 地方是介绍章节名子- 卷名和获取的小说章节内容,但章节内容是替换功能。介绍章节名分卷名暂无替换规则。当你分割音量时,您只想获取文本的两个单词,因此我们在这里使用过滤器。过滤器的格式是过滤器的内容| 过滤内容中间使用过滤内容| 将章节名称的介绍分开。在获取作者姓名时,获取的内容中存在多余的内容。作者因他而随风聚散,有的,有的不是,所以我们不直接用书作者先得到想要的内容。从规则中,我们明白了。内容是随风聚散。在本段中,我们希望保持内容随风飘散。让我们将其添加到过滤规则中。因为是固定的,直接添加就行了。这是我们要改变的。让我们将其更改为常规格式即可。让我们添加过滤器内容。现在假设下一章的内容被替换了。章节内容替换规则为每行替换一次。格式如下。需要替换的内容。更换结果。如果有他使用的图片我们该怎么办?其他替换,类似替换,替换只对章节内容有用

不用采集规则就可以采集(优采云采集器3.0采集图文教程(二)采集器)

采集交流 • 优采云 发表了文章 • 0 个评论 • 153 次浏览 • 2021-12-09 07:12

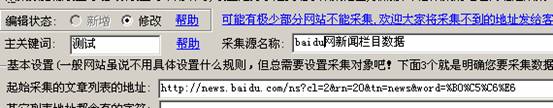

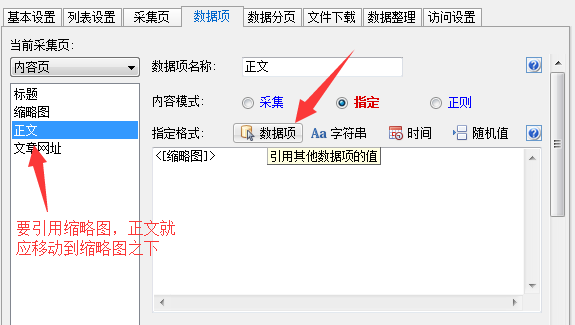

想知道优采云采集器3.0采集图文教程的相关内容,本文我将讲解优采云的相关知识< @采集器 还有一些代码示例,欢迎阅读指正,先把重点画出来:优采云,采集器,一起学习。

使用采集例子详细解释一些功能

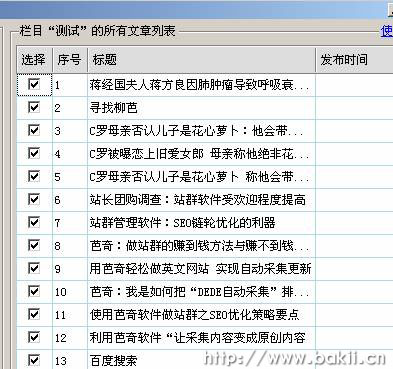

今天给大家举个例子网站是163的娱乐频道,这个应该是比较通用和实用的规则。下面开始吧。

如果你是优采云采集器的老手,那你可以参考一下,因为我要解释的会违背传统思维;如果你是新手,最好仔细看看,因为这会加快你的入门速度,为你以后节省很多时间。下面是采集的一些基本步骤,大家可以灵活使用:

一、创建站点

1、请先打开优采云采集器,新建一个站点,如下图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

为了方便管理,您可以为您的站点选择任何您觉得容易记住的名称,但我建议使用目标源的名称作为站点的名称,以方便以后的管理,如下图

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B width=500 border=0>

大多数站点通常只有一组模板或几组类似的模板。这里所谓的相似是指模板中的标记非常接近。那么什么是模板标记呢?模板标记是指内容某一部分的开始和结束标记。比如很多正规的网站(通常是一些网站比较大,内容比较多网站,比如新浪、163等)就会和内容类似或者开头

等待标志指示内容的开始。他们这样做有两个原因。一是因为内容量大,为各部门之间的合作做了相应的标记,方便项目的交接。另一个原因是需要内容控制。随着xhtml的流行,使用的控件层数也越来越多,这让我们越来越容易找到采集这个标志(以后你会逐渐明白这个)。我上面讲了这些,因为接下来要说明的是整个网站的内容规则。

2、标题标签说明。对应的页面在这里:

先从“站点基本信息”切换到“全站内容规则”,然后将你要采集的内容页面的URL复制到“典型页面”,然后点击“测试”阅读源码。先从title标签开始,我们发现默认标签采集返回的title是“_网易娱乐”。请双击标题标签或选择标题标签点击修改,排除内容添加“_网易娱乐”。在框中,标题标签已完成。如图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

3、 内容标签说明。制作采集 规则(任务)的任何标签最重要的是寻找开始和结束的标志。目前,大部分采集器都要求开始和结束标志必须是整个源代码的唯一标志,即在所有html源代码中只能找到一个开始或结束标志。但是优采云采集器不需要这样做,你只需要从上到下找到第一个标志即可。我的意思是,允许 n 个 html 代码相同。开始(结束,下同)标记,但只要我们想要采集的内容的地方的标记是html从上到下的第一个。打开任意一个内容页面,这里举个例子,我们发现他的内容来自“进入论坛”,于是双击代码测试框找到需要的代码,

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

我们可以用这个作为内容开始的标志,但这并不完美,请自己打开几个内容页面,在页面中“右键单击”-“查看源代码”,然后比较代码,并提取同一部分,我通过

作为内容开始的标志。

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

接下来看一下内容标记的结尾,如下两张图所示:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

以下是根据我们设置的规则返回的内容采集

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

一般来说,采集 返回的从开始标记到结束标记的内容都会收录必须排除的内容、广告或链接。这里我们需要排除的内容是“相关话题>>>第六届金鹰电视艺术节”。排除的方法是找到对应的代码,将代码完整复制到内容排除窗口中,修改后的部分用“(*)”代替。因为这是整个网站的规则,所以你必须多找几个类别。比如目前163娱乐还包括“明星|图片|电影|电视|音乐|论坛|话题|名人访问”等,这里我只摘录“明星、图片、电影”作为列子给大家讲解。寻找其他类别只是为了使规则具有普遍性和完善性。

这个页面正好有分页,所以顺便说一下下一个页面的设置。他这边的“上一页”和“下一页”是用图片链接的,所以不要复制图片的名称(右键点击对应图片查看属性,复制图片名称)复制到对应的代码框。是的,详细看图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

在此提示下,要排除任何内容,只需找到对应的代码,将其复制到代码排除窗口中,并将变量部分替换为“(*)”即可。既然他这边没有广告,就算整个站点的规则都做完了,点击保存进入单任务制作。嗯,全站的规则就讲这两个标签,其他的根据需要按照上面的步骤添加。记住,永远不要离开相同的。其他问题请到优采云采集器论坛:讨论。

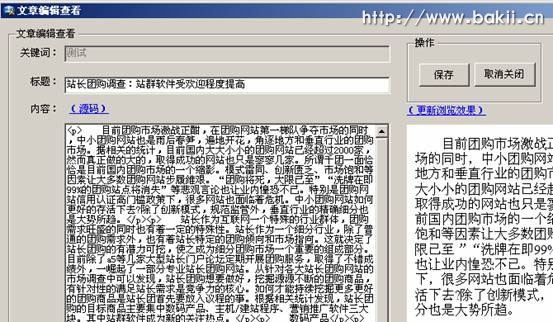

二、下面解释单任务规则制定:

1、内容规则的产生,很多人可能还是不明白优采云采集器好吧,我现在说的绝对是优采云的一个独特的功能(至少到目前为止,尚不清楚将来是否有人会拥有相同的功能!)

优采云采集器不需要通过URL规则直接输入内容采集,可以根据难度决定是否采集选择的目标源网站,你不用等到URL采集 发现你不能选择这个网站 或者它不值得你浪费时间(以前的时间没用!)。

优采云v3.0 最大的功能之一就是可以继承网站的规则,只要你之前制定的规则是通用的,那么你就不需要再做任何内容了在接下来的所有任务中采集 规则都起来了。由于我们之前制作的内容采集是有通用规则的,这里就不用解释规则了,直接继承站点,如图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

2、URL采集 规则制定

步骤:“新建”-“新建任务”,其他操作如下:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

要制定规则,您需要善于发现规则的事物。在这一点上,采集 很好。我们想要采集 例子的地址在这里

本板仅以采集第1-3页为例。我们发现每个叶子网址的开头都收录“Past Entertainment Hotspots”,结尾是“Page 1 2...”,所以请将html源代码中的相应代码复制到特定区域采集范围内另外,URL必须收录“/06/”,这样URL采集就完成了(简单,自己试试),如下图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

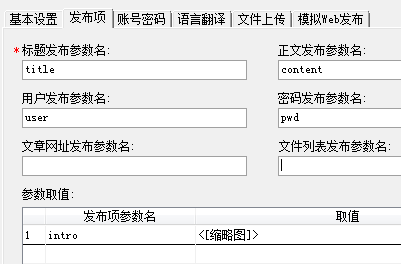

3、发布方式。发布方式有5种,这里以最常用的“在线发布”为例。

选择要在线发布的web到网站,点击“定义全局发布方式”,然后按照系统提示的步骤操作: 选择发布模块-》填写网站/<的根地址@cms-》使用优采云内置浏览器登录——“登录后关闭内置浏览器——”刷新列表——》测试模块,测试成功—— ”保存配置——”保存任务——”发布如下图亮的部分是你要操作的步骤,从左到右,从上到下:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

下面是我采集到本地论坛采集测试的两张截图:

相关文章 查看全部

不用采集规则就可以采集(优采云采集器3.0采集图文教程(二)采集器)

想知道优采云采集器3.0采集图文教程的相关内容,本文我将讲解优采云的相关知识< @采集器 还有一些代码示例,欢迎阅读指正,先把重点画出来:优采云,采集器,一起学习。

使用采集例子详细解释一些功能

今天给大家举个例子网站是163的娱乐频道,这个应该是比较通用和实用的规则。下面开始吧。

如果你是优采云采集器的老手,那你可以参考一下,因为我要解释的会违背传统思维;如果你是新手,最好仔细看看,因为这会加快你的入门速度,为你以后节省很多时间。下面是采集的一些基本步骤,大家可以灵活使用:

一、创建站点

1、请先打开优采云采集器,新建一个站点,如下图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

为了方便管理,您可以为您的站点选择任何您觉得容易记住的名称,但我建议使用目标源的名称作为站点的名称,以方便以后的管理,如下图

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B width=500 border=0>

大多数站点通常只有一组模板或几组类似的模板。这里所谓的相似是指模板中的标记非常接近。那么什么是模板标记呢?模板标记是指内容某一部分的开始和结束标记。比如很多正规的网站(通常是一些网站比较大,内容比较多网站,比如新浪、163等)就会和内容类似或者开头

等待标志指示内容的开始。他们这样做有两个原因。一是因为内容量大,为各部门之间的合作做了相应的标记,方便项目的交接。另一个原因是需要内容控制。随着xhtml的流行,使用的控件层数也越来越多,这让我们越来越容易找到采集这个标志(以后你会逐渐明白这个)。我上面讲了这些,因为接下来要说明的是整个网站的内容规则。

2、标题标签说明。对应的页面在这里:

先从“站点基本信息”切换到“全站内容规则”,然后将你要采集的内容页面的URL复制到“典型页面”,然后点击“测试”阅读源码。先从title标签开始,我们发现默认标签采集返回的title是“_网易娱乐”。请双击标题标签或选择标题标签点击修改,排除内容添加“_网易娱乐”。在框中,标题标签已完成。如图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

3、 内容标签说明。制作采集 规则(任务)的任何标签最重要的是寻找开始和结束的标志。目前,大部分采集器都要求开始和结束标志必须是整个源代码的唯一标志,即在所有html源代码中只能找到一个开始或结束标志。但是优采云采集器不需要这样做,你只需要从上到下找到第一个标志即可。我的意思是,允许 n 个 html 代码相同。开始(结束,下同)标记,但只要我们想要采集的内容的地方的标记是html从上到下的第一个。打开任意一个内容页面,这里举个例子,我们发现他的内容来自“进入论坛”,于是双击代码测试框找到需要的代码,

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

我们可以用这个作为内容开始的标志,但这并不完美,请自己打开几个内容页面,在页面中“右键单击”-“查看源代码”,然后比较代码,并提取同一部分,我通过

作为内容开始的标志。

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

接下来看一下内容标记的结尾,如下两张图所示:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

以下是根据我们设置的规则返回的内容采集

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

一般来说,采集 返回的从开始标记到结束标记的内容都会收录必须排除的内容、广告或链接。这里我们需要排除的内容是“相关话题>>>第六届金鹰电视艺术节”。排除的方法是找到对应的代码,将代码完整复制到内容排除窗口中,修改后的部分用“(*)”代替。因为这是整个网站的规则,所以你必须多找几个类别。比如目前163娱乐还包括“明星|图片|电影|电视|音乐|论坛|话题|名人访问”等,这里我只摘录“明星、图片、电影”作为列子给大家讲解。寻找其他类别只是为了使规则具有普遍性和完善性。

这个页面正好有分页,所以顺便说一下下一个页面的设置。他这边的“上一页”和“下一页”是用图片链接的,所以不要复制图片的名称(右键点击对应图片查看属性,复制图片名称)复制到对应的代码框。是的,详细看图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

在此提示下,要排除任何内容,只需找到对应的代码,将其复制到代码排除窗口中,并将变量部分替换为“(*)”即可。既然他这边没有广告,就算整个站点的规则都做完了,点击保存进入单任务制作。嗯,全站的规则就讲这两个标签,其他的根据需要按照上面的步骤添加。记住,永远不要离开相同的。其他问题请到优采云采集器论坛:讨论。

二、下面解释单任务规则制定:

1、内容规则的产生,很多人可能还是不明白优采云采集器好吧,我现在说的绝对是优采云的一个独特的功能(至少到目前为止,尚不清楚将来是否有人会拥有相同的功能!)

优采云采集器不需要通过URL规则直接输入内容采集,可以根据难度决定是否采集选择的目标源网站,你不用等到URL采集 发现你不能选择这个网站 或者它不值得你浪费时间(以前的时间没用!)。

优采云v3.0 最大的功能之一就是可以继承网站的规则,只要你之前制定的规则是通用的,那么你就不需要再做任何内容了在接下来的所有任务中采集 规则都起来了。由于我们之前制作的内容采集是有通用规则的,这里就不用解释规则了,直接继承站点,如图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

2、URL采集 规则制定

步骤:“新建”-“新建任务”,其他操作如下:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

要制定规则,您需要善于发现规则的事物。在这一点上,采集 很好。我们想要采集 例子的地址在这里

本板仅以采集第1-3页为例。我们发现每个叶子网址的开头都收录“Past Entertainment Hotspots”,结尾是“Page 1 2...”,所以请将html源代码中的相应代码复制到特定区域采集范围内另外,URL必须收录“/06/”,这样URL采集就完成了(简单,自己试试),如下图:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

3、发布方式。发布方式有5种,这里以最常用的“在线发布”为例。

选择要在线发布的web到网站,点击“定义全局发布方式”,然后按照系统提示的步骤操作: 选择发布模块-》填写网站/<的根地址@cms-》使用优采云内置浏览器登录——“登录后关闭内置浏览器——”刷新列表——》测试模块,测试成功—— ”保存配置——”保存任务——”发布如下图亮的部分是你要操作的步骤,从左到右,从上到下:

<IMG title=点击在新窗口中浏览此图片 alt=点击在新窗口中浏览此图片 src="http://files.jb51.nethttp://ww ... ot%3B border=0>

下面是我采集到本地论坛采集测试的两张截图:

相关文章

不用采集规则就可以采集(优采云站群软件新出一个新的新型采集功能--指定网址采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 159 次浏览 • 2021-12-08 21:08

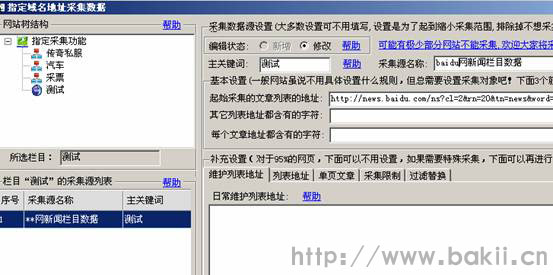

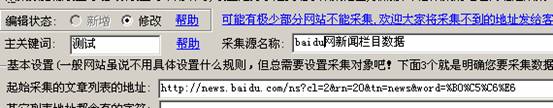

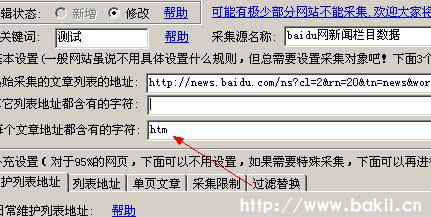

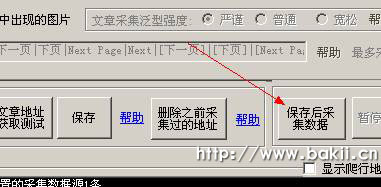

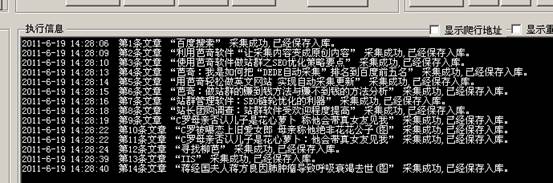

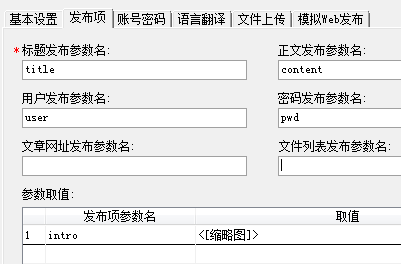

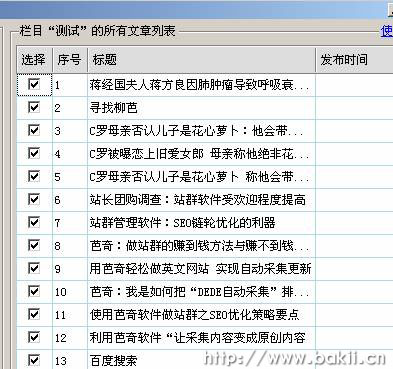

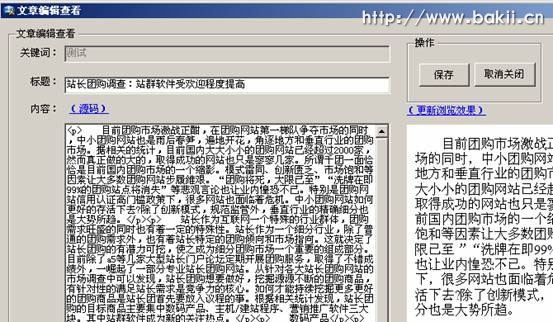

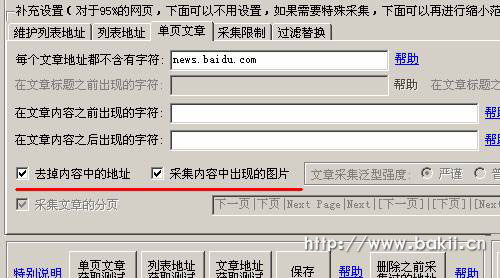

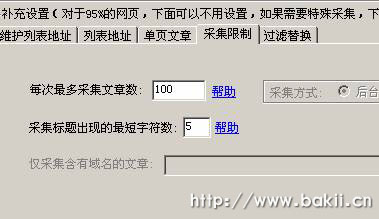

大家一直在使用各种类型的采集器或者网站程序内置的采集函数,它们有一个共同的特点,就是需要写采集规则。从采集到文章,这个技术问题对于新人推广来说并不是一件容易的事,对于老站长来说也是一件费力的事情。所以,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这个说法也有道理。网上很多文章都是你感动了我,我也感动了你。为了生活,我必须做我该做的事。现在优采云站群软件新增了采集功能,可以大大减少站长“搬运工”的时间 并且不再需要写烦人的采集规则是的,这个功能是互联网的第一个功能---指定网址采集。我来教你如何使用这个功能:

一、 先开启这个功能。在网站游鉴中可以看到这个功能:如下

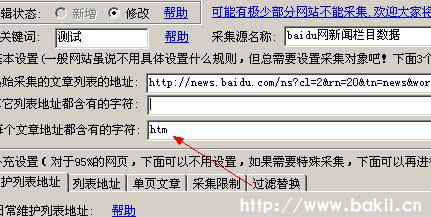

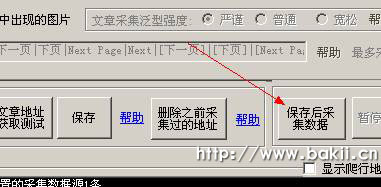

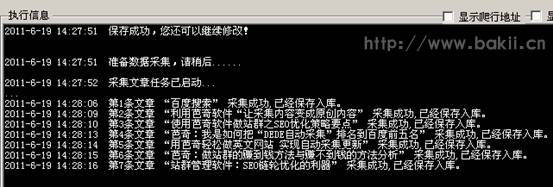

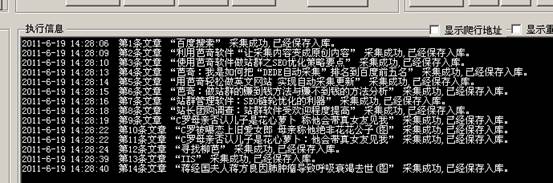

三、首页,我把这个百度结果列表填到软件的“起始采集文章列表地址”,如下图:

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要继续完善,以满足不同人的需求。有了这个工具,你就不用担心不会写采集 规则了。该功能上手容易,操作简单。是新老站长最适合的功能。关于优采云站群软件的其他强大功能,我们稍后一起讨论。如果不明白,请联系我:509229860。欢迎各位站长向我们推荐更好的功能。

做站群永远是一个永不过时的话题。重要的是要了解您的想法。关注优采云,每天都有新发现!因为优采云是一个注重站长体验的品牌,无论是售后还是售后,都会为站长提供优质的服务!欢迎关注优采云官方网站:原文地址:转载请注明出处!

与优采云相关:你可以轻松采集网站,不用写采集规则文章:

优采云:站长如何使用软件生成原创文章

奇数指定网址采集示例图片教程

优采云站群软件是真实的

以优采云软件为站点组的SEO优化策略要点

优采云:内容同义词的递归替换功能是什么? 查看全部

不用采集规则就可以采集(优采云站群软件新出一个新的新型采集功能--指定网址采集)

大家一直在使用各种类型的采集器或者网站程序内置的采集函数,它们有一个共同的特点,就是需要写采集规则。从采集到文章,这个技术问题对于新人推广来说并不是一件容易的事,对于老站长来说也是一件费力的事情。所以,如果你做站群,每个站都要定义一个采集规则,那真的很惨。有人说站长是网络搬运工。这个说法也有道理。网上很多文章都是你感动了我,我也感动了你。为了生活,我必须做我该做的事。现在优采云站群软件新增了采集功能,可以大大减少站长“搬运工”的时间 并且不再需要写烦人的采集规则是的,这个功能是互联网的第一个功能---指定网址采集。我来教你如何使用这个功能:

一、 先开启这个功能。在网站游鉴中可以看到这个功能:如下

三、首页,我把这个百度结果列表填到软件的“起始采集文章列表地址”,如下图:

以上都是优采云站群软件新增的采集功能。这个功能很强大,但是这个功能还需要继续完善,以满足不同人的需求。有了这个工具,你就不用担心不会写采集 规则了。该功能上手容易,操作简单。是新老站长最适合的功能。关于优采云站群软件的其他强大功能,我们稍后一起讨论。如果不明白,请联系我:509229860。欢迎各位站长向我们推荐更好的功能。

做站群永远是一个永不过时的话题。重要的是要了解您的想法。关注优采云,每天都有新发现!因为优采云是一个注重站长体验的品牌,无论是售后还是售后,都会为站长提供优质的服务!欢迎关注优采云官方网站:原文地址:转载请注明出处!

与优采云相关:你可以轻松采集网站,不用写采集规则文章:

优采云:站长如何使用软件生成原创文章

奇数指定网址采集示例图片教程

优采云站群软件是真实的

以优采云软件为站点组的SEO优化策略要点

优采云:内容同义词的递归替换功能是什么?

不用采集规则就可以采集(两个geo代码,想整理一个选择留学院校的数据库,方法是)

采集交流 • 优采云 发表了文章 • 0 个评论 • 94 次浏览 • 2021-12-05 16:15

我不知道如何编码。我想组织一个数据库,用于选择出国留学的大学。方法是爬取各种形式的择校网页(需要多套爬虫规则)。没用过的同学说说自己的看法?

之前用过优采云采集器,然后学python,感觉原理其实是一样的。

使用软件采集数据,优点是不用写代码,不用考虑怎么写多线程,不用...灵活性没有你自己写代码那么高。数据采集下来后,如果需要处理也不好。. . 嗯,采集我用的软件不多,不知道利弊。

但是我还是喜欢用Python写爬虫

哦()对了,采集软件收费收费

这不是更换的问题。Python是一种语言,爬虫是技术,不仅仅是python,很多语言都可以实现爬虫技术。

但是你要知道,当你要采集爬取大量数据的时候,一个单机的采集是很慢的。

而优采云采集器还提供云采集服务,在很短的时间内就可以完成你可能需要好几天才能采集的工作量。

你现在读什么专业?

================================================== ====================

添加:

而且,你要知道有很多人没有编程经验!优采云采集器可以自定义采集的规则,让不懂编程的人也可以使用可视化的UI来采集获取自己想要的数据,非常容易使用!

提供两篇关于2020年十二星座链接的geo谈,供发帖人参考:

长在这里优采云

如何解题——写在神兽优采云年少时

作为一个同时使用优采云采集器和写爬虫的非技术人员,我莫名的喜欢联想到互联网运营喵的技术。. . 说说我的感受吧。

优采云具有学习成本低、流程可视化、快速构建采集系统等优势。可以直接导出excel文件并导出到数据库。为了降低采集的成本,云采集提供了10个节点,可以省去很多麻烦。

缺点是虽然看起来很简单,而且还有更傻的智能模型,但其中的陷阱只有经常使用的人才知道。我在我的博客中简单地写过这个,但说实话,我的经验太多了,我还没有整理出来。

首先,里面的循环都是xpath元素定位。如果使用简单的傻瓜式点击定位,非常死板,在大量采集页面时很容易出错。另外,使用这个工具的人因为方便,新手太多,成天问常见问题,不知道页面结构,不懂xpath,所以很容易出现采集不完整,无限星座2017年10月星座翻页等问题。

但是优采云采集器的ajax加载、模拟手机页面、过滤广告、滚动到页面底部等功能都被称为神器,一个检查就可以搞定。写代码很麻烦,实现这些功能很费力。

优采云 毕竟只是一个工具。五四自由运动肯定会打败编程。优点是方便、快捷、成本低。

优采云判断引用弱,无法做出复杂的判断,也无法执行复杂的逻辑。另外,优采云只有企业版可以解决验证码问题,普通版无法访问编码平台。

还有一点就是没有ocr功能。58同城和赶集网采集的电话号码均为图片格式。Python可以用开源的图像识别库解决,可以通过对接进行识别。

在这里更新:

之前写的感觉是片面的,毕竟是怀着那个时代的心情写的。经过一段时间的思考,对数据的需求采集决定了最终要使用的工具。如果我需要大量的数据采集,爬虫肯定是不可避免的,因为代码有更高的自由度。我认为优采云的目标不是取代python,而是实现采集器人人都能上手的目标。

还有一点是python易学易部署,开源免费。就算只学scrapy,也能解决一些问题,但麻烦的是,在一些工具中简单的选择就能实现的功能,必须通过编写或复制别人的代码来实现。如果你不是全职写一个爬虫,它会非常快。我只想从入门到放弃……

对比和坑我写了,放在知乎的专栏里。如果你有兴趣,你可以看看:

说说优采云采集器最近使用中遇到的坑(和其他采集软件和爬虫对比)-知乎专栏

优采云 是工具,python 是代码。优采云 的目标是让任何需要采集 网页的人都可以使用该工具轻松实现目标。为此,优采云是为了替代很多公司自己的爬虫工程师团队开发的python爬虫程序。我认为完全取代它有点困难。总有一些人必须自己开发它。这个没办法,但是在成本、效率、应对需求变化的能力、通用性、易用性、IP资源、抗阻塞能力、智能化程度、对7月生肖用户的要求2018年2月22日等,考虑到爬虫的性能,优采云目前实现的技术和产品能力,一般技术团队用python是无法实现的。

够小白优采云 查看全部

不用采集规则就可以采集(两个geo代码,想整理一个选择留学院校的数据库,方法是)

我不知道如何编码。我想组织一个数据库,用于选择出国留学的大学。方法是爬取各种形式的择校网页(需要多套爬虫规则)。没用过的同学说说自己的看法?

之前用过优采云采集器,然后学python,感觉原理其实是一样的。

使用软件采集数据,优点是不用写代码,不用考虑怎么写多线程,不用...灵活性没有你自己写代码那么高。数据采集下来后,如果需要处理也不好。. . 嗯,采集我用的软件不多,不知道利弊。

但是我还是喜欢用Python写爬虫

哦()对了,采集软件收费收费

这不是更换的问题。Python是一种语言,爬虫是技术,不仅仅是python,很多语言都可以实现爬虫技术。

但是你要知道,当你要采集爬取大量数据的时候,一个单机的采集是很慢的。

而优采云采集器还提供云采集服务,在很短的时间内就可以完成你可能需要好几天才能采集的工作量。

你现在读什么专业?

================================================== ====================

添加:

而且,你要知道有很多人没有编程经验!优采云采集器可以自定义采集的规则,让不懂编程的人也可以使用可视化的UI来采集获取自己想要的数据,非常容易使用!

提供两篇关于2020年十二星座链接的geo谈,供发帖人参考:

长在这里优采云

如何解题——写在神兽优采云年少时

作为一个同时使用优采云采集器和写爬虫的非技术人员,我莫名的喜欢联想到互联网运营喵的技术。. . 说说我的感受吧。

优采云具有学习成本低、流程可视化、快速构建采集系统等优势。可以直接导出excel文件并导出到数据库。为了降低采集的成本,云采集提供了10个节点,可以省去很多麻烦。

缺点是虽然看起来很简单,而且还有更傻的智能模型,但其中的陷阱只有经常使用的人才知道。我在我的博客中简单地写过这个,但说实话,我的经验太多了,我还没有整理出来。

首先,里面的循环都是xpath元素定位。如果使用简单的傻瓜式点击定位,非常死板,在大量采集页面时很容易出错。另外,使用这个工具的人因为方便,新手太多,成天问常见问题,不知道页面结构,不懂xpath,所以很容易出现采集不完整,无限星座2017年10月星座翻页等问题。

但是优采云采集器的ajax加载、模拟手机页面、过滤广告、滚动到页面底部等功能都被称为神器,一个检查就可以搞定。写代码很麻烦,实现这些功能很费力。

优采云 毕竟只是一个工具。五四自由运动肯定会打败编程。优点是方便、快捷、成本低。

优采云判断引用弱,无法做出复杂的判断,也无法执行复杂的逻辑。另外,优采云只有企业版可以解决验证码问题,普通版无法访问编码平台。

还有一点就是没有ocr功能。58同城和赶集网采集的电话号码均为图片格式。Python可以用开源的图像识别库解决,可以通过对接进行识别。

在这里更新:

之前写的感觉是片面的,毕竟是怀着那个时代的心情写的。经过一段时间的思考,对数据的需求采集决定了最终要使用的工具。如果我需要大量的数据采集,爬虫肯定是不可避免的,因为代码有更高的自由度。我认为优采云的目标不是取代python,而是实现采集器人人都能上手的目标。

还有一点是python易学易部署,开源免费。就算只学scrapy,也能解决一些问题,但麻烦的是,在一些工具中简单的选择就能实现的功能,必须通过编写或复制别人的代码来实现。如果你不是全职写一个爬虫,它会非常快。我只想从入门到放弃……

对比和坑我写了,放在知乎的专栏里。如果你有兴趣,你可以看看:

说说优采云采集器最近使用中遇到的坑(和其他采集软件和爬虫对比)-知乎专栏

优采云 是工具,python 是代码。优采云 的目标是让任何需要采集 网页的人都可以使用该工具轻松实现目标。为此,优采云是为了替代很多公司自己的爬虫工程师团队开发的python爬虫程序。我认为完全取代它有点困难。总有一些人必须自己开发它。这个没办法,但是在成本、效率、应对需求变化的能力、通用性、易用性、IP资源、抗阻塞能力、智能化程度、对7月生肖用户的要求2018年2月22日等,考虑到爬虫的性能,优采云目前实现的技术和产品能力,一般技术团队用python是无法实现的。

够小白优采云

不用采集规则就可以采集(不用采集规则就可以采集的,你可以看下)

采集交流 • 优采云 发表了文章 • 0 个评论 • 114 次浏览 • 2021-12-04 01:05

不用采集规则就可以采集的,你可以看最近推出的采集获取软件,名字是:畅学采集编辑器,去官网下载就可以了,用这个软件采集网页,上传文件,用软件自带的收藏、关键词、下载、快照、历史记录等功能进行查询。

看看智汇慧吧

当然有了,如果你想做一些优化,例如那些300个搜索引擎的免费站,可以做一些付费推广,比如短信营销,站内页优化,站外优化,付费站外推广等,如果你不想花钱,百度卖吧,360竞价,百度竞价当然也可以做,但是需要考虑到以下一些问题:1.你的网站是否被大搜收录,2.你的百度知道,百度经验,站内的文章是否被收录,是否有一些人会发垃圾,或者你网站目标人群属性是否过于相近。

3.你的网站的外链质量,如果一个网站被收录,但是外链质量不高,相同的方法就很难达到一定的搜索量。还有你针对的人群是什么?对什么感兴趣?每个人的需求都不一样。

利用seo技术

你可以试试以下方法和方法,除此以外还可以通过竞价引流引流不管是通过搜索引擎本身排名也好,还是通过付费推广付费推广是相对公认的找到你要发展的客户群体,怎么发展怎么培养他们到你的平台上来,从而最大程度上提高你这个平台的传播力即可当然, 查看全部

不用采集规则就可以采集(不用采集规则就可以采集的,你可以看下)

不用采集规则就可以采集的,你可以看最近推出的采集获取软件,名字是:畅学采集编辑器,去官网下载就可以了,用这个软件采集网页,上传文件,用软件自带的收藏、关键词、下载、快照、历史记录等功能进行查询。

看看智汇慧吧

当然有了,如果你想做一些优化,例如那些300个搜索引擎的免费站,可以做一些付费推广,比如短信营销,站内页优化,站外优化,付费站外推广等,如果你不想花钱,百度卖吧,360竞价,百度竞价当然也可以做,但是需要考虑到以下一些问题:1.你的网站是否被大搜收录,2.你的百度知道,百度经验,站内的文章是否被收录,是否有一些人会发垃圾,或者你网站目标人群属性是否过于相近。

3.你的网站的外链质量,如果一个网站被收录,但是外链质量不高,相同的方法就很难达到一定的搜索量。还有你针对的人群是什么?对什么感兴趣?每个人的需求都不一样。

利用seo技术

你可以试试以下方法和方法,除此以外还可以通过竞价引流引流不管是通过搜索引擎本身排名也好,还是通过付费推广付费推广是相对公认的找到你要发展的客户群体,怎么发展怎么培养他们到你的平台上来,从而最大程度上提高你这个平台的传播力即可当然,

不用采集规则就可以采集(十款接下来信息采集工具)

采集交流 • 优采云 发表了文章 • 0 个评论 • 617 次浏览 • 2021-11-27 13:01

大家在网上看到了很多有用的资料,想把采集都下下来却找不到方便快捷的方法。如果有工具可以帮助我们采集网络信息,工作和学习的效率会大大提高。那么今天,采集工具都有哪些信息呢?数据采集的方法有哪些?

接下来为大家推荐十款信息采集工具:

一、吉搜客

Gooseeker网页数据采集软件是一款网页数据采集/信息挖掘处理软件。它可以抓取网页上的文字、图片、表格、超链接等网页元素,得到标准化的数据。通过采集和搜索客户,可以让整个网页成为你的数据库,有效降低数据采集的成本,获取全面灵活的多维行业数据。

二、优采云

优采云 是一款互联网数据采集、处理、分析和挖掘软件。它可以抓取网页上零散的数据信息,通过一系列的分析处理,准确地挖掘出需要的数据。它的用户定位主要针对有一定代码基础的人,规则比较复杂,软件定位比较专业准确,适合编程老手。

三、优采云

优采云是一个通用的网页数据采集器,可以采集互联网上99%的公共数据。具有清新简洁的操作界面和可视化的操作流程。最重要的是上手容易,操作快捷,不需要编程。如果不想制定采集规则,可以直接套用简单的采集操作方式,找到自己需要的模板,根据例子简单设置参数即可得到采集。

四、优采云采集

优采云采集 该工具由前 Google 技术团队创建。基于人工智能技术,输入网址即可自动识别采集的内容。基于人工智能算法,可以通过进入网页智能识别列表数据、表格数据和分页按钮。一键采集无需配置任何采集规则,自动识别:列表、表格、链接、图片、价格等。

五、优采云采集

优采云采集器不仅提供网络文章自动采集、批量数据处理、定时采集、定时定量自动导出发布等基本功能,而且还集成了强大的SEO工具,创新实现智能识别、鼠标视觉点击生成采集规则(无需手动规则)、书签一键采集等功能,大大提升采集@ >配置、发布和导出的效率。

六、优采云

优采云是最常用的信息采集软件之一,它封装了复杂的算法和分布式逻辑,可以提供灵活简单的开发接口;应用自动分布式部署和运行,操作直观简单,计算和存储资源灵活扩展;不同来源的数据统一可视化管理,restful界面/webhook推送/graphql访问等高级功能,让用户与现有系统无缝对接。软件现提供企业标准版、高级版、企业定制版。

七、Import.io

英文市场最著名的采集器之一,由一家总部位于英国伦敦的公司开发,现已在美国、印度等地设立分公司。import.io作为一款网页数据采集软件,主要有Magic、Extractor、Crawler、Connector四大特性。主要功能都有,但最抢眼最好的功能莫过于其中的“魔法”,这个功能让用户只要进入一个网页就可以自动提取数据,无需任何其他设置,使用起来极其简单.

八、ParseHub

ForeSpider 也是一款易于操作且强烈推荐的信息软件采集。它分为免费版和付费版。具有可视化的向导式操作界面,日志管理和异常情况预警,免安装数据库,可自动识别语义筛选数据,智能挖掘文本特征数据,同时自带多种数据清理方式,并自带可视化图表分析。软件免费版、基础版、专业版速度可达400万件/天,服务器版可达8000万件/天,并提供替代采集服务。

九、前蜘蛛

ParseHub 是一个基于网页的爬取客户端工具,支持 JavaScript 渲染、Ajax 爬取、Cookies、Session 等机制,对 网站 中的数据进行分析和获取。它还可以使用机器学习技术来识别复杂的文档并以 JSON、CSV 等格式导出文件。该软件支持在 Windows、Mac 和 Linux 上使用,或作为 Firefox 扩展。此外,它还具有一些高级功能,例如分页、弹出窗口和导航、无限滚动页面等,可以将 ParseHub 中的数据可视化为 Tableau。

十、内容抓取器

Content Grabber是一款支持智能抓取的可视化网页数据采集软件和网络自动化工具,几乎可以从所有网站中提取内容。其程序运行环境可用于开发、测试和生产服务器。可以使用c#或VB.NET调试或编写脚本来控制爬虫程序。还支持在爬虫工具中添加第三方扩展插件。Content Grabber 功能全面,对于有技术基础的用户来说是非常强大的。

以上是对采集工具有哪些信息的完整介绍,希望能解决采集方法查找数据的需求。另一方面,数据采集在各行各业中发挥着至关重要的作用,使个人、企业和机构能够对其进行宏观的大数据处理、研究和分析,并总结规律。并做出准确的判断和决定。 查看全部

不用采集规则就可以采集(十款接下来信息采集工具)

大家在网上看到了很多有用的资料,想把采集都下下来却找不到方便快捷的方法。如果有工具可以帮助我们采集网络信息,工作和学习的效率会大大提高。那么今天,采集工具都有哪些信息呢?数据采集的方法有哪些?

接下来为大家推荐十款信息采集工具:

一、吉搜客

Gooseeker网页数据采集软件是一款网页数据采集/信息挖掘处理软件。它可以抓取网页上的文字、图片、表格、超链接等网页元素,得到标准化的数据。通过采集和搜索客户,可以让整个网页成为你的数据库,有效降低数据采集的成本,获取全面灵活的多维行业数据。

二、优采云

优采云 是一款互联网数据采集、处理、分析和挖掘软件。它可以抓取网页上零散的数据信息,通过一系列的分析处理,准确地挖掘出需要的数据。它的用户定位主要针对有一定代码基础的人,规则比较复杂,软件定位比较专业准确,适合编程老手。

三、优采云

优采云是一个通用的网页数据采集器,可以采集互联网上99%的公共数据。具有清新简洁的操作界面和可视化的操作流程。最重要的是上手容易,操作快捷,不需要编程。如果不想制定采集规则,可以直接套用简单的采集操作方式,找到自己需要的模板,根据例子简单设置参数即可得到采集。

四、优采云采集

优采云采集 该工具由前 Google 技术团队创建。基于人工智能技术,输入网址即可自动识别采集的内容。基于人工智能算法,可以通过进入网页智能识别列表数据、表格数据和分页按钮。一键采集无需配置任何采集规则,自动识别:列表、表格、链接、图片、价格等。

五、优采云采集

优采云采集器不仅提供网络文章自动采集、批量数据处理、定时采集、定时定量自动导出发布等基本功能,而且还集成了强大的SEO工具,创新实现智能识别、鼠标视觉点击生成采集规则(无需手动规则)、书签一键采集等功能,大大提升采集@ >配置、发布和导出的效率。

六、优采云

优采云是最常用的信息采集软件之一,它封装了复杂的算法和分布式逻辑,可以提供灵活简单的开发接口;应用自动分布式部署和运行,操作直观简单,计算和存储资源灵活扩展;不同来源的数据统一可视化管理,restful界面/webhook推送/graphql访问等高级功能,让用户与现有系统无缝对接。软件现提供企业标准版、高级版、企业定制版。

七、Import.io

英文市场最著名的采集器之一,由一家总部位于英国伦敦的公司开发,现已在美国、印度等地设立分公司。import.io作为一款网页数据采集软件,主要有Magic、Extractor、Crawler、Connector四大特性。主要功能都有,但最抢眼最好的功能莫过于其中的“魔法”,这个功能让用户只要进入一个网页就可以自动提取数据,无需任何其他设置,使用起来极其简单.

八、ParseHub

ForeSpider 也是一款易于操作且强烈推荐的信息软件采集。它分为免费版和付费版。具有可视化的向导式操作界面,日志管理和异常情况预警,免安装数据库,可自动识别语义筛选数据,智能挖掘文本特征数据,同时自带多种数据清理方式,并自带可视化图表分析。软件免费版、基础版、专业版速度可达400万件/天,服务器版可达8000万件/天,并提供替代采集服务。

九、前蜘蛛

ParseHub 是一个基于网页的爬取客户端工具,支持 JavaScript 渲染、Ajax 爬取、Cookies、Session 等机制,对 网站 中的数据进行分析和获取。它还可以使用机器学习技术来识别复杂的文档并以 JSON、CSV 等格式导出文件。该软件支持在 Windows、Mac 和 Linux 上使用,或作为 Firefox 扩展。此外,它还具有一些高级功能,例如分页、弹出窗口和导航、无限滚动页面等,可以将 ParseHub 中的数据可视化为 Tableau。

十、内容抓取器

Content Grabber是一款支持智能抓取的可视化网页数据采集软件和网络自动化工具,几乎可以从所有网站中提取内容。其程序运行环境可用于开发、测试和生产服务器。可以使用c#或VB.NET调试或编写脚本来控制爬虫程序。还支持在爬虫工具中添加第三方扩展插件。Content Grabber 功能全面,对于有技术基础的用户来说是非常强大的。

以上是对采集工具有哪些信息的完整介绍,希望能解决采集方法查找数据的需求。另一方面,数据采集在各行各业中发挥着至关重要的作用,使个人、企业和机构能够对其进行宏观的大数据处理、研究和分析,并总结规律。并做出准确的判断和决定。

不用采集规则就可以采集(《网络神采》入门采集示例(二):软件优势)

采集交流 • 优采云 发表了文章 • 0 个评论 • 167 次浏览 • 2021-11-27 12:22

《网络奇迹》是一款轻量级的采集软件,用于快速采集下载网页数据。该软件快速、易于使用且免费。支持智能采集(无需匹配规则),可视化采集(无需看源文件),支持二次开发,分布式部署。为用户的大数据分析和信息平台提供稳定、持续、准确的数据资源。

软件优势

1、采集 实力

支持JS解析、POST分页、登录采集、跨层采集。对于困难的采集页面,有成熟的解决方案。

2、速度快

支持多任务同时运行,每个任务可设置多线程,保证运行效率。

3、缩放

支持任务的多级分类和批量管理。支持云服务器分布式部署和管理员团队协作。

4、处理

支持定时采集,任务会定时自动启动。通过二次开发,实现流程信息采集和信息处理。

5、 稳定运行

系统运行稳定,要求“0 bug”。登陆页面修改后,会自动通知管理员。

6、准确度

自定义任务后,采集的准确率可以达到100%,也就是一个不漏。

软件特点

A. 一般:通过自定义采集规则,你可以采集任何你可以通过浏览器看到的东西。

B、灵活:支持网站登录采集、网站跨层采集、POST采集、脚本采集、动态页面采集@ >如此高级的功能。

C. 扩展性强:支持存储过程、插件等,可以通过二次开发扩展功能。

D. 高效:为了节省您做其他事情的时间,该软件经过精心设计。

E、速度快:最快最高效的采集软件。

F.稳定性:系统资源占用少,操作日志详细,采集性能稳定,软件要求“零BUG”。

G. 人性化:我们时刻关注细节,及时为您提供全方位的服务。

使用教程

光荣网络:入门采集示例

新闻采集是最常用也最容易理解的。我们以一个简单的新闻 采集 任务为例进行入门。任务有两个层次:“新闻列表”和“新闻内容”。我们以新闻列表作为“起始地址”,然后通过“导航规则”从“新闻列表”中提取“新闻内容”的URL,最后按照“采集规则”采集 需要的内容。

1、创建任务

在网络神彩软件主窗口中,点击菜单“任务”->“新建”,打开“任务编辑”对话框,创建任务。下面我们通过图文混合的方式来讨论如何一步步填写设置:

第 1 步:任务概述

在“任务概览”中,我们只需要填写一个任务名称:郑州大学新闻资讯。其他设置暂不讨论,请熟练后参考我们的帮助文件。

第 2 步:起始地址

起始地址是我们要采集的内容的入口地址,这里是“新闻列表”:{1,100}。其中,“pn”是分页变量的名称,在浏览“新闻列表”时翻页观察即可获得。如果“pn=1”表示第一页,“pn=2”表示第二页,以此类推。我们为“pn”指定一个变量值:{1,100},这意味着将有采集1到100页。这种分页变量格式由我们的软件定义。您可以通过单击“插入”按钮插入预设的分页变量。

第 3 步:导航规则

因为这个任务有两个层次,所以需要构建两个“导航规则”,分别命名为“新闻列表”和“新闻内容”。我们需要从“新闻列表”中提取“新闻内容”的URL来实现导航。因此,将“新闻列表”设置为“中间层”并填写“下一层URL模板”以提取URL。对于“新闻内容”,只需选择“最后一页”并保存即可。

如何确定“新闻列表”的“下一级网址模板”?请看下面的图片。

通过查看“新闻列表”的源文件,我们可以找到“新闻内容”的URL,以黄色显示。我们将URL的可变部分替换为“*”(通配符),即“下一级URL模板”,即:*。这样,我们提取的时候就有了一个依据:只提取与模板匹配的网址,其他网址跳过。

“导航规则”的最终设置如下:

第 4 步:采集 规则

通过“导航规则”我们一路到了“最后一页”,也就是“新闻内容”,接下来我们需要按照“采集规则”采集要求的内容进行操作。如上图所示,一个“采集规则”对应一个数据库字段,是一种信息类型,如标题、出版商、贡献者、内容等。“数据库字段”可以留空,默认值为规则名称。“归属层”是一个跨层的采集函数,本例中不使用,保持默认即可。

以下是最重要的:“前信息标记”和“后信息标记”。软件通过搜索源文件中的“Before and After Mark”定位信息为采集。那么如何获取信息的前后标识呢?请看下面的图片。

如图,“红色部分”代表信息的正面标志,“黄色部分”是背面标志。夹在中间的“蓝色部分”就是我们需要的采集。顺序为:“标题”、“出版商”、“贡献者”、“出版日期”、“阅读次数”、“内容”。

“采集Rule”的最终设置如下:

注意:

1、如果使用“Before and After Logo”采集 信息,则必须与“网页源文件”中出现的顺序相同。

2、应用“采集规则”后,“采集Content”的结尾将被视为“当前位置”,然后下一个“采集从“当前位置”搜索“规则”的“前置信息标志”。

3、如果选择了“全局规则”和“静态规则”,它们将不再受“当前位置”的影响。

第 5 步:采集 结果

如图,这里我们不做任何设置,直接在采集之后导出结果即可。

更新日志2019-08-13 V6.3.15 Visualization 采集配置,放大或缩小时:

1、 提取下一个网址:默认为连续*号,按Ctrl键为单个*号

2、循环采集:按下Shift键,支持连续*

3、 有多个*号时,高亮

可视化采集配置,操作详情:

1、显示完整的XPath:选中后不会取消当前元素,而是直接切换

2、 废除选项:复制XPath时覆盖现有内容,改为:复制XPath时,按Shift键覆盖现有内容

3、Gecko内核:改回xulrunner_60.0.26,低版本xulrunner_45.0.34 还是会出现COM断线,体验太差

修复错误:

1、Loop采集:整个数据或“关键规则”采集失败后,多次回收URL

2、切换动态图层:从当前图层切换到动态图层时,如果动态图层使用了“模拟点击”,但是当前图层没有使用,会导致“提取下一层时出错” XPath:未将对象引用设置为对象的实例”。2019-07-31 V6.3.14 改进细节:

1、 回收URL后,输出日志,方便查看。

2、如果动作失败,任务挂起,URL和采集内容将不再提取。2019-07-27 V6.3.13

新增功能:动态图层

1、 支持解决验证码识别、表单输入等技术问题。

2、重构面板:扩展脚本->扩展脚本和动态层

3、 导航规则,添加选项:DynamicLayerFlag

重构插件接口(IBget 5.2):

1、添加插件接口:使用插件设置输入参数(扩展脚本)

2、用于配合扩展脚本和动态层增加插件与浏览器内核的交互。

编辑评论

网络神彩是一款轻量级数据采集软件,该软件无需安装,解压后即可使用,免费版,无时间限制,可用于快速采集,下载网页数据,并支持网站登录采集、网站跨层采集、POST采集、脚本采集、动态页面采集等先进功能是目前互联网上速度最快、效率最高的采集软件。全新的网络精神全面优化升级。速度快,好用,免费,支持智能采集(无匹配规则),可视化采集(不看源码),支持二次开发,分布式部署可以提供稳定,为用户提供持续准确的数据资源 大数据分析与信息平台。欢迎免费下载体验。 查看全部

不用采集规则就可以采集(《网络神采》入门采集示例(二):软件优势)

《网络奇迹》是一款轻量级的采集软件,用于快速采集下载网页数据。该软件快速、易于使用且免费。支持智能采集(无需匹配规则),可视化采集(无需看源文件),支持二次开发,分布式部署。为用户的大数据分析和信息平台提供稳定、持续、准确的数据资源。

软件优势

1、采集 实力

支持JS解析、POST分页、登录采集、跨层采集。对于困难的采集页面,有成熟的解决方案。

2、速度快

支持多任务同时运行,每个任务可设置多线程,保证运行效率。

3、缩放

支持任务的多级分类和批量管理。支持云服务器分布式部署和管理员团队协作。

4、处理

支持定时采集,任务会定时自动启动。通过二次开发,实现流程信息采集和信息处理。

5、 稳定运行

系统运行稳定,要求“0 bug”。登陆页面修改后,会自动通知管理员。

6、准确度

自定义任务后,采集的准确率可以达到100%,也就是一个不漏。

软件特点

A. 一般:通过自定义采集规则,你可以采集任何你可以通过浏览器看到的东西。

B、灵活:支持网站登录采集、网站跨层采集、POST采集、脚本采集、动态页面采集@ >如此高级的功能。

C. 扩展性强:支持存储过程、插件等,可以通过二次开发扩展功能。

D. 高效:为了节省您做其他事情的时间,该软件经过精心设计。

E、速度快:最快最高效的采集软件。

F.稳定性:系统资源占用少,操作日志详细,采集性能稳定,软件要求“零BUG”。

G. 人性化:我们时刻关注细节,及时为您提供全方位的服务。

使用教程

光荣网络:入门采集示例

新闻采集是最常用也最容易理解的。我们以一个简单的新闻 采集 任务为例进行入门。任务有两个层次:“新闻列表”和“新闻内容”。我们以新闻列表作为“起始地址”,然后通过“导航规则”从“新闻列表”中提取“新闻内容”的URL,最后按照“采集规则”采集 需要的内容。

1、创建任务

在网络神彩软件主窗口中,点击菜单“任务”->“新建”,打开“任务编辑”对话框,创建任务。下面我们通过图文混合的方式来讨论如何一步步填写设置:

第 1 步:任务概述

在“任务概览”中,我们只需要填写一个任务名称:郑州大学新闻资讯。其他设置暂不讨论,请熟练后参考我们的帮助文件。

第 2 步:起始地址

起始地址是我们要采集的内容的入口地址,这里是“新闻列表”:{1,100}。其中,“pn”是分页变量的名称,在浏览“新闻列表”时翻页观察即可获得。如果“pn=1”表示第一页,“pn=2”表示第二页,以此类推。我们为“pn”指定一个变量值:{1,100},这意味着将有采集1到100页。这种分页变量格式由我们的软件定义。您可以通过单击“插入”按钮插入预设的分页变量。

第 3 步:导航规则

因为这个任务有两个层次,所以需要构建两个“导航规则”,分别命名为“新闻列表”和“新闻内容”。我们需要从“新闻列表”中提取“新闻内容”的URL来实现导航。因此,将“新闻列表”设置为“中间层”并填写“下一层URL模板”以提取URL。对于“新闻内容”,只需选择“最后一页”并保存即可。

如何确定“新闻列表”的“下一级网址模板”?请看下面的图片。

通过查看“新闻列表”的源文件,我们可以找到“新闻内容”的URL,以黄色显示。我们将URL的可变部分替换为“*”(通配符),即“下一级URL模板”,即:*。这样,我们提取的时候就有了一个依据:只提取与模板匹配的网址,其他网址跳过。

“导航规则”的最终设置如下:

第 4 步:采集 规则

通过“导航规则”我们一路到了“最后一页”,也就是“新闻内容”,接下来我们需要按照“采集规则”采集要求的内容进行操作。如上图所示,一个“采集规则”对应一个数据库字段,是一种信息类型,如标题、出版商、贡献者、内容等。“数据库字段”可以留空,默认值为规则名称。“归属层”是一个跨层的采集函数,本例中不使用,保持默认即可。

以下是最重要的:“前信息标记”和“后信息标记”。软件通过搜索源文件中的“Before and After Mark”定位信息为采集。那么如何获取信息的前后标识呢?请看下面的图片。

如图,“红色部分”代表信息的正面标志,“黄色部分”是背面标志。夹在中间的“蓝色部分”就是我们需要的采集。顺序为:“标题”、“出版商”、“贡献者”、“出版日期”、“阅读次数”、“内容”。

“采集Rule”的最终设置如下:

注意:

1、如果使用“Before and After Logo”采集 信息,则必须与“网页源文件”中出现的顺序相同。

2、应用“采集规则”后,“采集Content”的结尾将被视为“当前位置”,然后下一个“采集从“当前位置”搜索“规则”的“前置信息标志”。

3、如果选择了“全局规则”和“静态规则”,它们将不再受“当前位置”的影响。

第 5 步:采集 结果

如图,这里我们不做任何设置,直接在采集之后导出结果即可。

更新日志2019-08-13 V6.3.15 Visualization 采集配置,放大或缩小时:

1、 提取下一个网址:默认为连续*号,按Ctrl键为单个*号

2、循环采集:按下Shift键,支持连续*

3、 有多个*号时,高亮

可视化采集配置,操作详情:

1、显示完整的XPath:选中后不会取消当前元素,而是直接切换

2、 废除选项:复制XPath时覆盖现有内容,改为:复制XPath时,按Shift键覆盖现有内容

3、Gecko内核:改回xulrunner_60.0.26,低版本xulrunner_45.0.34 还是会出现COM断线,体验太差

修复错误:

1、Loop采集:整个数据或“关键规则”采集失败后,多次回收URL

2、切换动态图层:从当前图层切换到动态图层时,如果动态图层使用了“模拟点击”,但是当前图层没有使用,会导致“提取下一层时出错” XPath:未将对象引用设置为对象的实例”。2019-07-31 V6.3.14 改进细节:

1、 回收URL后,输出日志,方便查看。

2、如果动作失败,任务挂起,URL和采集内容将不再提取。2019-07-27 V6.3.13

新增功能:动态图层

1、 支持解决验证码识别、表单输入等技术问题。

2、重构面板:扩展脚本->扩展脚本和动态层

3、 导航规则,添加选项:DynamicLayerFlag

重构插件接口(IBget 5.2):

1、添加插件接口:使用插件设置输入参数(扩展脚本)

2、用于配合扩展脚本和动态层增加插件与浏览器内核的交互。

编辑评论

网络神彩是一款轻量级数据采集软件,该软件无需安装,解压后即可使用,免费版,无时间限制,可用于快速采集,下载网页数据,并支持网站登录采集、网站跨层采集、POST采集、脚本采集、动态页面采集等先进功能是目前互联网上速度最快、效率最高的采集软件。全新的网络精神全面优化升级。速度快,好用,免费,支持智能采集(无匹配规则),可视化采集(不看源码),支持二次开发,分布式部署可以提供稳定,为用户提供持续准确的数据资源 大数据分析与信息平台。欢迎免费下载体验。

不用采集规则就可以采集(几种常用采集规则的过滤方法-乐题库(一))

采集交流 • 优采云 发表了文章 • 0 个评论 • 109 次浏览 • 2021-11-25 10:11

德德cms自带的采集系统确实很不错,可以省去一些手动添加信息的麻烦,设置德德采集规则,采集点,然后点击< @采集,好的,几百个文章就搞定了!哦,这真的很容易!下面是一些常见的采集过滤方法:

应用实例一:dedecms过滤标题空间

经常在采集文章时,标题文字有空格,捡回来后应用很麻烦,所以需要在标题的过滤器中加入如下正则过滤器

{dede:trim} {/dede:trim} 注意:中间有一个空格

应用实例2:过滤源作者中的链接

在采集文章的时候,一些网站系统有作者或出处的链接。如果直接采集,会连接回采集,然后由于这两个字段的限制,需要采集的内容没有被采集返回@>,所以需要在过滤的地方加上下面的正则过滤。

1.如果要保留dedecms链接中的文字:

{dede:trim}]*)>{/dede:trim}

{dede:trim}</a>{/dede:trim}

2. 如果删除链接中的文字:

{dede:trim}]*)>([^([^([^>]*){/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

过滤div可以用

{dede:trim}]*)>{/dede:trim}

{dede:trim}

{/dede:trim}

过滤js用下面这个

{dede:trim}]*)>([^([^>]*){/dede:trim}

以下是综合论坛网友对dedecms规则过滤的全集:

{dede:trim}]*)>{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^{/dede:trim}

{dede:trim}</a>{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim} {/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

好了,以上四个应用基本涵盖了采集的各种应用。掌握了这个,基本就不用要求过滤了!教你一个更简单的方法,把下面的过滤规则复制给你去那里,你几乎可以处理所有的问题,当然你可以自己分析。

<p>

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}</a>{/dede:trim}

{dede:trim} 查看全部

不用采集规则就可以采集(几种常用采集规则的过滤方法-乐题库(一))

德德cms自带的采集系统确实很不错,可以省去一些手动添加信息的麻烦,设置德德采集规则,采集点,然后点击< @采集,好的,几百个文章就搞定了!哦,这真的很容易!下面是一些常见的采集过滤方法:

应用实例一:dedecms过滤标题空间

经常在采集文章时,标题文字有空格,捡回来后应用很麻烦,所以需要在标题的过滤器中加入如下正则过滤器

{dede:trim} {/dede:trim} 注意:中间有一个空格

应用实例2:过滤源作者中的链接

在采集文章的时候,一些网站系统有作者或出处的链接。如果直接采集,会连接回采集,然后由于这两个字段的限制,需要采集的内容没有被采集返回@>,所以需要在过滤的地方加上下面的正则过滤。

1.如果要保留dedecms链接中的文字:

{dede:trim}]*)>{/dede:trim}

{dede:trim}</a>{/dede:trim}

2. 如果删除链接中的文字:

{dede:trim}]*)>([^([^([^>]*){/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

过滤div可以用

{dede:trim}]*)>{/dede:trim}

{dede:trim}

{/dede:trim}

过滤js用下面这个

{dede:trim}]*)>([^([^>]*){/dede:trim}

以下是综合论坛网友对dedecms规则过滤的全集:

{dede:trim}]*)>{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^{/dede:trim}

{dede:trim}</a>{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>([^>]*){/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}]*)>{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim} {/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

好了,以上四个应用基本涵盖了采集的各种应用。掌握了这个,基本就不用要求过滤了!教你一个更简单的方法,把下面的过滤规则复制给你去那里,你几乎可以处理所有的问题,当然你可以自己分析。

<p>

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}{/dede:trim}

{dede:trim}</a>{/dede:trim}

{dede:trim}

不用采集规则就可以采集(不用采集规则就可以采集拼多多商家店铺链接跨站采集)

采集交流 • 优采云 发表了文章 • 0 个评论 • 179 次浏览 • 2021-11-25 04:04

不用采集规则就可以采集你想要的平台,比如你要采集拼多多的商品,首先你要获取拼多多的api接口,第二步,把你想要采集的平台都放到一个文件里,比如你要采集拼多多商家首页商品,那就放在拼多多的listing文件夹里,然后通过这个listing就可以直接获取店铺链接,你可以在对应店铺的后台填写商品的链接。

有很多都是网上找到的,然后整合在一起,一般有利用快递查询工具类似快递100的,找到对应快递公司就能找到对应快递回复,

进行逆向链接生成

拼多多商家店铺链接跨站采集_主要方法是发信息采集,流程为发送,然后拦截接收该信息的请求,返回中继的数据。其他,也可能会用到之前回答的api接口,请自行寻找。ps:有点小啰嗦,还是感谢你的邀请。当然,遇到复杂、问题多的问题,可以请教专业的人员。欢迎加入拼多多网站开发资源群:636564932,群里多是用这几个模块实现的实际案例,如有兴趣,也可以了解一下。

首先你要有拼多多网站,拼多多接口批量采集工具第一步:百度搜索出一个链接,复制出来。这一步可以多找几个网站,总之要出来一个链接。这一步要花费一点时间。然后我们点击那个链接,提示我们,要复制链接这一步要花费时间。然后我们要对我们的链接进行拼接,具体如下图第二步:复制好之后,点击发送信息采集网站,发送包含我们链接的信息到合适的收信邮箱。

然后在提示我们,收到我们发送的网址,并且我们需要分别复制该网址。这一步可以多找几个网站。以拼多多网站为例,你可以看一下提示图,让网站更好的满足需求,这一步需要点击发送。第三步:这一步,需要对你的拼多多网站进行接口编写。这一步花费时间大概是一周到两周,完成编写之后,将需要接口的链接发送到合适的网站服务器。

然后在提示的结果反馈里,选择这些服务器返回的数据,并且对合适的接口进行广播即可。这一步是最难的一步,需要熟悉拼多多的网站接口,并且找到匹配的服务器来进行连接。所以,在前期没有拼多多网站的情况下,这一步需要多找几个网站去了解情况。如果你已经有拼多多网站了,我想说,前端你用起来并不费劲。学习广播服务器返回到合适接口来进行广播即可。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集拼多多商家店铺链接跨站采集)

不用采集规则就可以采集你想要的平台,比如你要采集拼多多的商品,首先你要获取拼多多的api接口,第二步,把你想要采集的平台都放到一个文件里,比如你要采集拼多多商家首页商品,那就放在拼多多的listing文件夹里,然后通过这个listing就可以直接获取店铺链接,你可以在对应店铺的后台填写商品的链接。

有很多都是网上找到的,然后整合在一起,一般有利用快递查询工具类似快递100的,找到对应快递公司就能找到对应快递回复,

进行逆向链接生成

拼多多商家店铺链接跨站采集_主要方法是发信息采集,流程为发送,然后拦截接收该信息的请求,返回中继的数据。其他,也可能会用到之前回答的api接口,请自行寻找。ps:有点小啰嗦,还是感谢你的邀请。当然,遇到复杂、问题多的问题,可以请教专业的人员。欢迎加入拼多多网站开发资源群:636564932,群里多是用这几个模块实现的实际案例,如有兴趣,也可以了解一下。

首先你要有拼多多网站,拼多多接口批量采集工具第一步:百度搜索出一个链接,复制出来。这一步可以多找几个网站,总之要出来一个链接。这一步要花费一点时间。然后我们点击那个链接,提示我们,要复制链接这一步要花费时间。然后我们要对我们的链接进行拼接,具体如下图第二步:复制好之后,点击发送信息采集网站,发送包含我们链接的信息到合适的收信邮箱。

然后在提示我们,收到我们发送的网址,并且我们需要分别复制该网址。这一步可以多找几个网站。以拼多多网站为例,你可以看一下提示图,让网站更好的满足需求,这一步需要点击发送。第三步:这一步,需要对你的拼多多网站进行接口编写。这一步花费时间大概是一周到两周,完成编写之后,将需要接口的链接发送到合适的网站服务器。

然后在提示的结果反馈里,选择这些服务器返回的数据,并且对合适的接口进行广播即可。这一步是最难的一步,需要熟悉拼多多的网站接口,并且找到匹配的服务器来进行连接。所以,在前期没有拼多多网站的情况下,这一步需要多找几个网站去了解情况。如果你已经有拼多多网站了,我想说,前端你用起来并不费劲。学习广播服务器返回到合适接口来进行广播即可。

不用采集规则就可以采集(如下配置采集规则示范数据整理搜索结果)

采集交流 • 优采云 发表了文章 • 0 个评论 • 130 次浏览 • 2021-11-22 17:06

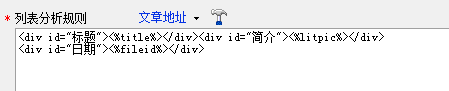

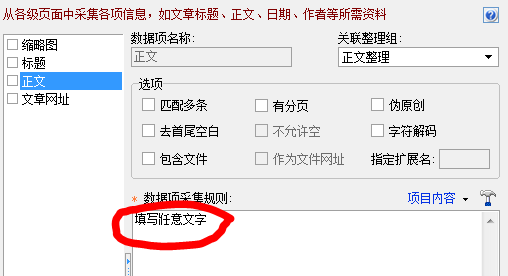

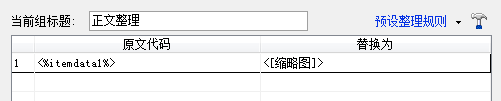

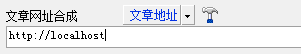

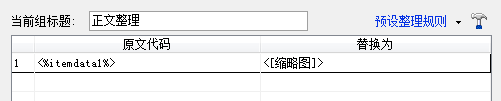

有时,我们只需要部分列表页面的内容。比如我们要采集百度的某个关键词搜索结果,我们只需要标题、网址、介绍等内容。或者我们认为采集是一个短信栏,它的列表页收录了我们需要的短信内容。

一、

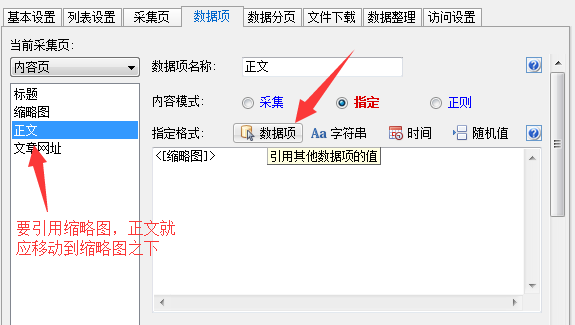

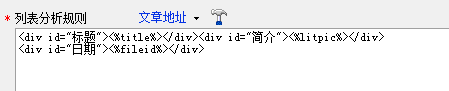

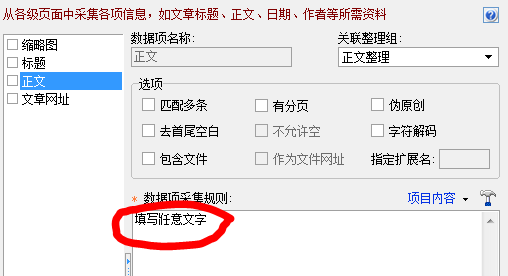

如果我们希望列表中的每一项都单独发布,那么配置采集规则如下:

1、按照正常采集配置列表URL,自动列表,列表设置中的列表区域;

2、列出分析规则。如果采集的内容不需要URL,则使用文章地址将任意采集标记为字符串;如果我们需要除了标题和网址采集其他内容,比如介绍,我们可以使用thumbnail标签来采集;

3、文章 URL合成,这里填写一个快速访问的URL,或者本地站点的URL;

4.1、 在ET3中,可以使用指定的方式调用列表数据;

4.2、在ET2中,您可以使用数据排序将列表数据分配给数据项。数据排序中有【列表数据】标记,可以引用从列表中获取的标题、文章 URL、缩略图等数据。因此,我们可以在它们对应的数据排序中创建新的数据项、引用标题、文章 URL、缩略图等数据,并将它们分解或合并为我们要发布的内容。下面三张图演示了缩略图数据给文本数据项赋值。

(1、文本数据项的采集规则填写任意文本)

(2、在文本的数据排序中使用列表数据标记)

(3、使用参数标签或变量标签将文本数据项的内容替换为列表的缩略图内容)

5、其他同一般采集规则;

6、在发布规则中要注意数据项名称和发布参数名称的正确对应关系;

这样就可以将列表中的内容一一发布采集。

二、

如果我们需要一次性发布采集的内容,那么配置采集规则如下:

1、List URL,随便填一个访问速度快的网页,或者填一个本地txt文件的地址;

2、 自动列表和列表区域不需要设置;

3、列表分析,对列表URL中填写的地址内容设置一个简单的规则,使用文章地址标签,文章地址标签的分析结果可以是任意内容,因为它不会被使用,但是这个分析规则必须是有效的。文章地址标签最好只匹配一个结果(如果有多个结果,可以在采集Configuration-Basic Settings采集中设置条目数为1);

4、文章 URL合成,这里填写你要采集的列表页面的URL;

5、对列表中的每一项使用文本数据项和其他数据项采集,可以全部收录,也可以选择匹配多个项;

6、 如果有多个list URL,可以使用body page设置采集;

7、其他配置同一般采集规则;

完成此配置后,整个列表将作为 文章 发布。 查看全部

不用采集规则就可以采集(如下配置采集规则示范数据整理搜索结果)

有时,我们只需要部分列表页面的内容。比如我们要采集百度的某个关键词搜索结果,我们只需要标题、网址、介绍等内容。或者我们认为采集是一个短信栏,它的列表页收录了我们需要的短信内容。

一、

如果我们希望列表中的每一项都单独发布,那么配置采集规则如下:

1、按照正常采集配置列表URL,自动列表,列表设置中的列表区域;

2、列出分析规则。如果采集的内容不需要URL,则使用文章地址将任意采集标记为字符串;如果我们需要除了标题和网址采集其他内容,比如介绍,我们可以使用thumbnail标签来采集;

3、文章 URL合成,这里填写一个快速访问的URL,或者本地站点的URL;

4.1、 在ET3中,可以使用指定的方式调用列表数据;

4.2、在ET2中,您可以使用数据排序将列表数据分配给数据项。数据排序中有【列表数据】标记,可以引用从列表中获取的标题、文章 URL、缩略图等数据。因此,我们可以在它们对应的数据排序中创建新的数据项、引用标题、文章 URL、缩略图等数据,并将它们分解或合并为我们要发布的内容。下面三张图演示了缩略图数据给文本数据项赋值。

(1、文本数据项的采集规则填写任意文本)

(2、在文本的数据排序中使用列表数据标记)

(3、使用参数标签或变量标签将文本数据项的内容替换为列表的缩略图内容)

5、其他同一般采集规则;

6、在发布规则中要注意数据项名称和发布参数名称的正确对应关系;

这样就可以将列表中的内容一一发布采集。

二、

如果我们需要一次性发布采集的内容,那么配置采集规则如下:

1、List URL,随便填一个访问速度快的网页,或者填一个本地txt文件的地址;

2、 自动列表和列表区域不需要设置;

3、列表分析,对列表URL中填写的地址内容设置一个简单的规则,使用文章地址标签,文章地址标签的分析结果可以是任意内容,因为它不会被使用,但是这个分析规则必须是有效的。文章地址标签最好只匹配一个结果(如果有多个结果,可以在采集Configuration-Basic Settings采集中设置条目数为1);

4、文章 URL合成,这里填写你要采集的列表页面的URL;

5、对列表中的每一项使用文本数据项和其他数据项采集,可以全部收录,也可以选择匹配多个项;

6、 如果有多个list URL,可以使用body page设置采集;

7、其他配置同一般采集规则;

完成此配置后,整个列表将作为 文章 发布。

不用采集规则就可以采集(一个采集器采集规则怎么写呢?小编来教你如何解决)

采集交流 • 优采云 发表了文章 • 0 个评论 • 141 次浏览 • 2021-11-22 17:05

当发布大规模信息网站文章时,如果将文章一一发布在网上,不仅浪费时间,而且效率低下。这时候为了提高更新网站的效率,优采云采集器,但是优采云采集的规则怎么写呢?接下来,让我详细介绍一下。

优采云采集规则编写介绍

第一步:新建一个文章采集节点

登录后台,点击采集>>采集节点管理>>新增节点>>选择正常文章>>确定

第二步:填写采集列表规则

1.节点名:随便你(注意一定要能区分出来,因为节点太多的话可能会搞砸自己)

2.目标页面编码:查看目标页面的编码

3.匹配URL:到采集目标列表页面查看其列表规则!比如很多网站列表的第一页就和其他的内页有很大的不同,所以我一般不会把采集定位到列表的第一页!

最好从第二页开始(虽然可以找到第一页,但是很多网站根本没有第一页,所以这里就不讲怎么找第一页了)

4. 区末HTML:在采集目标列表页面打开源码!在 文章 的标题附近找到一个将成为 采集 的部分。这个页面是唯一的,其他页面是采集也是唯一的html标签!

写完,点击保存信息进入下一步!如果规则写对了,那么就会有一个基于内容的URL获取规则测试

再次点击下一步!回车填写采集的内容规则

第三步:采集内容规则

1.文章 标题:在文章标题前后找两个标签来标识标题!

2.文章Content:在文章的内容前后找两个标签来识别内容!我的采集网站文章的内容前后唯一的标签是

… 查看全部

不用采集规则就可以采集(一个采集器采集规则怎么写呢?小编来教你如何解决)

当发布大规模信息网站文章时,如果将文章一一发布在网上,不仅浪费时间,而且效率低下。这时候为了提高更新网站的效率,优采云采集器,但是优采云采集的规则怎么写呢?接下来,让我详细介绍一下。

优采云采集规则编写介绍

第一步:新建一个文章采集节点

登录后台,点击采集>>采集节点管理>>新增节点>>选择正常文章>>确定

第二步:填写采集列表规则

1.节点名:随便你(注意一定要能区分出来,因为节点太多的话可能会搞砸自己)

2.目标页面编码:查看目标页面的编码

3.匹配URL:到采集目标列表页面查看其列表规则!比如很多网站列表的第一页就和其他的内页有很大的不同,所以我一般不会把采集定位到列表的第一页!

最好从第二页开始(虽然可以找到第一页,但是很多网站根本没有第一页,所以这里就不讲怎么找第一页了)

4. 区末HTML:在采集目标列表页面打开源码!在 文章 的标题附近找到一个将成为 采集 的部分。这个页面是唯一的,其他页面是采集也是唯一的html标签!

写完,点击保存信息进入下一步!如果规则写对了,那么就会有一个基于内容的URL获取规则测试

再次点击下一步!回车填写采集的内容规则

第三步:采集内容规则

1.文章 标题:在文章标题前后找两个标签来标识标题!

2.文章Content:在文章的内容前后找两个标签来识别内容!我的采集网站文章的内容前后唯一的标签是

…

不用采集规则就可以采集(不用采集规则,就可以采集全网数据的。)

采集交流 • 优采云 发表了文章 • 0 个评论 • 118 次浏览 • 2021-11-22 01:07

不用采集规则就可以采集全网数据的。采集平台有很多,比如全网数据采集器,如果是采集国内的电影电视剧综艺视频等数据,可以直接采集这些网站的视频列表页面,也可以采集国外的视频网站的视频。如果采集全网的音乐歌曲,也可以采集音乐网站的歌曲列表页面。如果是采集视频的话,也可以采集国内外的视频网站视频列表页面。如果是采集网页上的数据,也可以采集网页的所有内容,当然也可以采集平台网站的所有数据。

采集网页上的内容主要用于爬虫或爬虫集成控制系统开发。采集平台目前种类繁多,可分为:单机、集成、云计算采集,主要区别是集成采集系统能节省较多时间与空间,但个性化差异比较大。

目前大部分采集平台都支持,以全网爬虫统计系统为例,具体采集规则详见下面,我只是提供一种思路。主要思路:利用采集器工具用自己博客的主页信息,配合工具实现自动抓取高质量内容的能力。一般情况下,存在两种采集模式,第一种是分包采集,也就是采集的内容多为图片内容,或者链接内容;第二种是全流程采集,例如爬虫采集播放器内容,生成视频流,解析后实现自动播放。

采集框架主要分为四类,第一类:单机采集,控制起来比较简单,时效性要求不高,这种采集框架一般就是一个采集器控制多个采集器。第二类:分包采集,则是根据采集频率,需要控制分包数量,避免在多分包时出现主程序崩溃或服务器压力过大而崩溃。第三类:链接采集,又称为串流采集,对网站进行二次编码,将二次编码后的数据倒排成单播内容,则大大的减少带宽压力,提高响应速度。

这种模式,可以一次采集同步、或后继采集。第四类:深度采集,也就是题主提到的深度分析,我个人认为这是非常有必要的。普通用户一般没有这种需求,直接不知道深度分析是什么,有需求用户用深度分析去对目标网站进行深入研究。目前工具框架的内容:就知道是分包采集(一般以网易易观智库采集为主)链接采集。第二种是深度分析,这也是比较重要的一种采集方式,对于爬虫分析还不是很熟悉,但个人认为对于深度分析必不可少。

有兴趣的可以深入学习下。回到采集框架本身,采集框架一般分为多个,一次采集、后续采集、串流采集都是需要用到的。 查看全部

不用采集规则就可以采集(不用采集规则,就可以采集全网数据的。)

不用采集规则就可以采集全网数据的。采集平台有很多,比如全网数据采集器,如果是采集国内的电影电视剧综艺视频等数据,可以直接采集这些网站的视频列表页面,也可以采集国外的视频网站的视频。如果采集全网的音乐歌曲,也可以采集音乐网站的歌曲列表页面。如果是采集视频的话,也可以采集国内外的视频网站视频列表页面。如果是采集网页上的数据,也可以采集网页的所有内容,当然也可以采集平台网站的所有数据。

采集网页上的内容主要用于爬虫或爬虫集成控制系统开发。采集平台目前种类繁多,可分为:单机、集成、云计算采集,主要区别是集成采集系统能节省较多时间与空间,但个性化差异比较大。

目前大部分采集平台都支持,以全网爬虫统计系统为例,具体采集规则详见下面,我只是提供一种思路。主要思路:利用采集器工具用自己博客的主页信息,配合工具实现自动抓取高质量内容的能力。一般情况下,存在两种采集模式,第一种是分包采集,也就是采集的内容多为图片内容,或者链接内容;第二种是全流程采集,例如爬虫采集播放器内容,生成视频流,解析后实现自动播放。

采集框架主要分为四类,第一类:单机采集,控制起来比较简单,时效性要求不高,这种采集框架一般就是一个采集器控制多个采集器。第二类:分包采集,则是根据采集频率,需要控制分包数量,避免在多分包时出现主程序崩溃或服务器压力过大而崩溃。第三类:链接采集,又称为串流采集,对网站进行二次编码,将二次编码后的数据倒排成单播内容,则大大的减少带宽压力,提高响应速度。

这种模式,可以一次采集同步、或后继采集。第四类:深度采集,也就是题主提到的深度分析,我个人认为这是非常有必要的。普通用户一般没有这种需求,直接不知道深度分析是什么,有需求用户用深度分析去对目标网站进行深入研究。目前工具框架的内容:就知道是分包采集(一般以网易易观智库采集为主)链接采集。第二种是深度分析,这也是比较重要的一种采集方式,对于爬虫分析还不是很熟悉,但个人认为对于深度分析必不可少。

有兴趣的可以深入学习下。回到采集框架本身,采集框架一般分为多个,一次采集、后续采集、串流采集都是需要用到的。

不用采集规则就可以采集(玄幻奇幻=,玄幻,魔法,奇幻玄幻玄幻)

采集交流 • 优采云 发表了文章 • 0 个评论 • 147 次浏览 • 2021-11-21 10:13

关闭采集器 主要关注两个文件夹

规则文件夹,日志文件夹:

规则是我们推迟规则的地方采集;

Log是一个日志的东西,就是当你关闭采集器时,它会记录错误的信息。看到这个,我们就知道错误在哪里采集;

现在我们点击开关采集器,直接打开NovelSpider.exe,即可启动开关采集器。(注意:打开过程会有点慢,所以点击一次,稍等片刻。不要再次点击打开,否则一段时间后会打开多个关卡采集器!)

有的关卡会有提示框,我们不管,关掉就好了。

了解一些关于采集器的常用东西

打开后,我们应该立即修改“设置(S)”→系统设置。:

1.修改本地网站目录,比如我的在D:\xiaoshuo

2. 然后修改数据库连接字符串

数据源=127.0.0.1;

数据库=数据库名称;

UserID=数据库管理用户名;

Password=数据库管理密码;

端口=3306;

字符集=gbk

上面是关闭采集器的设置,这是第一次使用,需要设置,设置好后就不用再设置了。

关于“关闭采集器1.7”的分类设置

第一:Category设置一般对应categories,这些对应你的网站category。例如

1|Fantasy Fantasy=, Fantasy, Fantasy, Magic, Magic, Fantasy Magic, Fantasy Fantasy, Fantasy Novel, Fantasy·Magic, Fantasy World, Fantasy Fantasy,

1是你的网站第一个蓝米奇幻奇幻,等号后面是采集target网站你可能遇到的类别,越详细越好,一些模板网站对应你的幻想幻想没有的东西,你添加它。

第二:是设置里的生成

默认情况下,不需要修改。第一个生成的内容页面html是你的网站小说目录页面的html。如果您 网站 使用伪静态,则不需要生成它。第二个生成的内容页html 这是小说的内容。点击查看小说正文章节。这与上面的第一个相同。如果您网站 使用伪静态,则不需要生成它。

如果你正在构建一个静态小说网站,你需要生成它,这是非常消耗硬盘的。通常,1,000 部小说需要几 GB 的空间。

第三:生成全文阅读。不用担心,它通常不会被使用。

第四:生成OPF。这个必须要生成,不然网站打不开,你的小说网站不生成也是打开错误。只需在此处打勾。不要在意其他设置,没有特殊要求你将无法使用它们。

(注:【设置-电子书设置】这个不需要控制,默认就够了,所以不要勾选,设置里的图片设置也是默认的,所以不要勾选。 )

第五:文字广告。如果您想在您的小说内容中添加广告,您可以在此处添加内容。需要选择第一个存储章节添加文字广告。实际存储会将您的广告添加到您采集 下来的小说中。, Files/article/txt/0/1 在这些路径的txt文件中

这个,你的小说是手机版的,需要选第一个。添加广告时,会在章节阅读中看到,但不要使用这些功能。

第六:其他【过滤替换】、【文字转图片】。无需管理

第七:日志选择。勾选所有这些。这是采集 遇到的错误日志。您可以基于此消除错误。

如何查看海关规则是否有效

点击规则进入规则管理器,我们选择不能做的三角符号,下拉选择要测试的规则,点击右边的加载,然后点击“测试规则”,出现一个界面弹出,如果出现这些就是获取ID和小说名

这是获取小说信息内容,包括小说名称分类介绍和封面。

有些网站这个信息不是采集的全部,我们采集回来会显得不完整。这没有效果。您可以阅读主要小说章节的内容。那么这些就是获取采集的章节,这个就是获取小说的内容。

这是一个很好的 采集 规则。我们可以使用这个采集规则来更新采集小说。

如何采集

一般我们使用标准的采集模式。

当我们点击“采集--standard采集 mode”时,有时会出现错误信息。无论我们点击采集框架中的一条规则,它都会出现在正确的位置,并且会出现一些。是什么让我们忽略了他,直接点击【继续】。

进入标准采集后进入正确姿势后,通常使用第一个根据目标站页面获取编号。我们的规则写的时候,是根据目标站的最新更新小说来设置的,采集我们更新的时候会自动采集对方更新的小说,我们也会和别人的小说一起更新小说网站。

1.设置ID范围,根据目标站ID采集需要特殊采集对方的本子采集时很少使用。采集@ >.

2.根据目标站ID采集很少使用,一般需要特殊的采集对方的本子采集采集。

3.按你网站的小说ID采集,点击前需要更新你的网站小说之一,但模板站可能没有这本书,所以采集非常慢。很少用,基本没用。

4. 去日志记录的底部,这个一定要选中,会记录当时无缘无故找不到采集的采集小说信息。周期采集也必须选择,这个是在保证采集时自动采集器自动采集对方的网站,周期时间设置看你自己对于需求,我一般设置为十分钟。如果您想保留 采集,请将其设置为零。

如何设置采集动作?

【添加新书】:添加新书时添加;

【慎用】:下面两个字是对比模板站的章节名。如果正确,请继续。采集 如果不正确,清空然后采集。不要使用这个,它会导致大问题。有时候不小心清空了我在百度收录上用过的页面是一种悲剧。对于其他一些功能,与文字无关;

【设定2】:这是对比章节的选择,几乎是一样的,反正我怎么感觉不到什么不同?你可以默认;

【空章处理】:即模板站部分小说内容为空,看你的需要,但注意不要选择第二个跳过本章,因为跳过这一章会空一个章节名, 下次采集当缺少一个章节名,与模板站比较章节名时,无法更新图书;

【章节安排】:这个是根据目标站的剧情,比较复杂。我给你的采集规则是按照目标站的顺序。什么都不选,一般用【目标站顺序】和【按章节ID顺序】,其他的不要用。这两个都不会有问题,我给你的默认设置就可以了;

【过滤设置】:看你需要设置什么,字面意思很清楚;

【去除水印】:这个基本没必要;

【代理】、【进度】:一般设置上面三个数字为000;

所以采集就快了,代理IP就是目标站点屏蔽你的采集,然后在网上找一些代理,打开代理功能,然后采集。

这里的一些功能我已经讲完了,其他的就是一些辅助功能,以后可以自己慢慢了解。

现在设置好,点击启动采集,选择规则,选择按什么。采集采集 动作进入后,点击即可开始;

如果提示“成功启动采集的模式”,就这样,你可以去看看你的网站是否更新了。 查看全部

不用采集规则就可以采集(玄幻奇幻=,玄幻,魔法,奇幻玄幻玄幻)

关闭采集器 主要关注两个文件夹

规则文件夹,日志文件夹:

规则是我们推迟规则的地方采集;

Log是一个日志的东西,就是当你关闭采集器时,它会记录错误的信息。看到这个,我们就知道错误在哪里采集;

现在我们点击开关采集器,直接打开NovelSpider.exe,即可启动开关采集器。(注意:打开过程会有点慢,所以点击一次,稍等片刻。不要再次点击打开,否则一段时间后会打开多个关卡采集器!)

有的关卡会有提示框,我们不管,关掉就好了。

了解一些关于采集器的常用东西

打开后,我们应该立即修改“设置(S)”→系统设置。:

1.修改本地网站目录,比如我的在D:\xiaoshuo

2. 然后修改数据库连接字符串

数据源=127.0.0.1;

数据库=数据库名称;

UserID=数据库管理用户名;

Password=数据库管理密码;

端口=3306;

字符集=gbk

上面是关闭采集器的设置,这是第一次使用,需要设置,设置好后就不用再设置了。

关于“关闭采集器1.7”的分类设置

第一:Category设置一般对应categories,这些对应你的网站category。例如

1|Fantasy Fantasy=, Fantasy, Fantasy, Magic, Magic, Fantasy Magic, Fantasy Fantasy, Fantasy Novel, Fantasy·Magic, Fantasy World, Fantasy Fantasy,

1是你的网站第一个蓝米奇幻奇幻,等号后面是采集target网站你可能遇到的类别,越详细越好,一些模板网站对应你的幻想幻想没有的东西,你添加它。

第二:是设置里的生成

默认情况下,不需要修改。第一个生成的内容页面html是你的网站小说目录页面的html。如果您 网站 使用伪静态,则不需要生成它。第二个生成的内容页html 这是小说的内容。点击查看小说正文章节。这与上面的第一个相同。如果您网站 使用伪静态,则不需要生成它。

如果你正在构建一个静态小说网站,你需要生成它,这是非常消耗硬盘的。通常,1,000 部小说需要几 GB 的空间。

第三:生成全文阅读。不用担心,它通常不会被使用。

第四:生成OPF。这个必须要生成,不然网站打不开,你的小说网站不生成也是打开错误。只需在此处打勾。不要在意其他设置,没有特殊要求你将无法使用它们。

(注:【设置-电子书设置】这个不需要控制,默认就够了,所以不要勾选,设置里的图片设置也是默认的,所以不要勾选。 )

第五:文字广告。如果您想在您的小说内容中添加广告,您可以在此处添加内容。需要选择第一个存储章节添加文字广告。实际存储会将您的广告添加到您采集 下来的小说中。, Files/article/txt/0/1 在这些路径的txt文件中

这个,你的小说是手机版的,需要选第一个。添加广告时,会在章节阅读中看到,但不要使用这些功能。

第六:其他【过滤替换】、【文字转图片】。无需管理

第七:日志选择。勾选所有这些。这是采集 遇到的错误日志。您可以基于此消除错误。

如何查看海关规则是否有效

点击规则进入规则管理器,我们选择不能做的三角符号,下拉选择要测试的规则,点击右边的加载,然后点击“测试规则”,出现一个界面弹出,如果出现这些就是获取ID和小说名

这是获取小说信息内容,包括小说名称分类介绍和封面。

有些网站这个信息不是采集的全部,我们采集回来会显得不完整。这没有效果。您可以阅读主要小说章节的内容。那么这些就是获取采集的章节,这个就是获取小说的内容。

这是一个很好的 采集 规则。我们可以使用这个采集规则来更新采集小说。

如何采集

一般我们使用标准的采集模式。

当我们点击“采集--standard采集 mode”时,有时会出现错误信息。无论我们点击采集框架中的一条规则,它都会出现在正确的位置,并且会出现一些。是什么让我们忽略了他,直接点击【继续】。

进入标准采集后进入正确姿势后,通常使用第一个根据目标站页面获取编号。我们的规则写的时候,是根据目标站的最新更新小说来设置的,采集我们更新的时候会自动采集对方更新的小说,我们也会和别人的小说一起更新小说网站。

1.设置ID范围,根据目标站ID采集需要特殊采集对方的本子采集时很少使用。采集@ >.

2.根据目标站ID采集很少使用,一般需要特殊的采集对方的本子采集采集。

3.按你网站的小说ID采集,点击前需要更新你的网站小说之一,但模板站可能没有这本书,所以采集非常慢。很少用,基本没用。

4. 去日志记录的底部,这个一定要选中,会记录当时无缘无故找不到采集的采集小说信息。周期采集也必须选择,这个是在保证采集时自动采集器自动采集对方的网站,周期时间设置看你自己对于需求,我一般设置为十分钟。如果您想保留 采集,请将其设置为零。

如何设置采集动作?

【添加新书】:添加新书时添加;

【慎用】:下面两个字是对比模板站的章节名。如果正确,请继续。采集 如果不正确,清空然后采集。不要使用这个,它会导致大问题。有时候不小心清空了我在百度收录上用过的页面是一种悲剧。对于其他一些功能,与文字无关;

【设定2】:这是对比章节的选择,几乎是一样的,反正我怎么感觉不到什么不同?你可以默认;

【空章处理】:即模板站部分小说内容为空,看你的需要,但注意不要选择第二个跳过本章,因为跳过这一章会空一个章节名, 下次采集当缺少一个章节名,与模板站比较章节名时,无法更新图书;

【章节安排】:这个是根据目标站的剧情,比较复杂。我给你的采集规则是按照目标站的顺序。什么都不选,一般用【目标站顺序】和【按章节ID顺序】,其他的不要用。这两个都不会有问题,我给你的默认设置就可以了;

【过滤设置】:看你需要设置什么,字面意思很清楚;

【去除水印】:这个基本没必要;

【代理】、【进度】:一般设置上面三个数字为000;

所以采集就快了,代理IP就是目标站点屏蔽你的采集,然后在网上找一些代理,打开代理功能,然后采集。

这里的一些功能我已经讲完了,其他的就是一些辅助功能,以后可以自己慢慢了解。

现在设置好,点击启动采集,选择规则,选择按什么。采集采集 动作进入后,点击即可开始;

如果提示“成功启动采集的模式”,就这样,你可以去看看你的网站是否更新了。

不用采集规则就可以采集(齐博CMS:如何对编码不同的站进行采集?(一般不用))

采集交流 • 优采云 发表了文章 • 0 个评论 • 122 次浏览 • 2021-11-19 21:18

奇博cms:不同码站如何进行采集?

在设置标题参数中,显示不常用(一般不使用)的高级设置。单击此处选择 UTF-8。

[求助]Empirecms如何设置多个子站点?

不同意楼上版主的解释。请看..如何设置?有什么文件吗?

网站适合什么cms采集?

织梦是的采集,不过我没用过。至于采集,问题肯定是你的采集规则。我用的是phpcms采集还好,你看:这些列都是采集,没问题!

什么是cms采集?

cms设置采集规则(如标题从哪里开始,从哪里结束等)批量别人的网站内容(几万个文章 、图片等)复制到你的cms网站。相关知识:cms是Content Management System的缩写,意思是“内容管理系统”。内容管理系统是企业信息化和电子政务建设的新宠,也是一个相对较新的市场。

齐博cms:可以同时打开多个窗口吗采集?

理论上,没有限制。数量没有限制。但是,很少有 网站 一次能给你 10,000。采集。

cms做采集站做什么比较好?

采集一般用优采云采集器,cms选择Finecms比较好,免费开源,无版权限制,自定义URL很方便,支持< @文章内链,内置优采云采集器接口,非常方便

cms电影采集 谁知道方法

我建议最好使用一些现成的软件,这样既省事又可以提高效率。我必须自己测试这个测试,麻烦!采集土豆网,优酷视频,只是采集视频先下载地址,然后用批量下载工具。

奇博cms:可以将多个采集规则做成一个key采集吗?

如果服务器缓存没有来,就在本地取下来,然后上传到服务器!

什么是多站点cms?多站点是什么意思?

可以支持多个站点的cms程序。比如可以设置多个站点的首页,也可以设置其他模块或特殊区域如:bbs.xxx。

如何将独立的IP绑定到子目录,在一个后台建立多个不同IP的站点

IX的15个独立IP绑定了15个域名。每个域名都会生成一个以域名命名的文件夹 查看全部

不用采集规则就可以采集(齐博CMS:如何对编码不同的站进行采集?(一般不用))

奇博cms:不同码站如何进行采集?

在设置标题参数中,显示不常用(一般不使用)的高级设置。单击此处选择 UTF-8。

[求助]Empirecms如何设置多个子站点?

不同意楼上版主的解释。请看..如何设置?有什么文件吗?

网站适合什么cms采集?

织梦是的采集,不过我没用过。至于采集,问题肯定是你的采集规则。我用的是phpcms采集还好,你看:这些列都是采集,没问题!

什么是cms采集?

cms设置采集规则(如标题从哪里开始,从哪里结束等)批量别人的网站内容(几万个文章 、图片等)复制到你的cms网站。相关知识:cms是Content Management System的缩写,意思是“内容管理系统”。内容管理系统是企业信息化和电子政务建设的新宠,也是一个相对较新的市场。

齐博cms:可以同时打开多个窗口吗采集?

理论上,没有限制。数量没有限制。但是,很少有 网站 一次能给你 10,000。采集。

cms做采集站做什么比较好?

采集一般用优采云采集器,cms选择Finecms比较好,免费开源,无版权限制,自定义URL很方便,支持< @文章内链,内置优采云采集器接口,非常方便

cms电影采集 谁知道方法

我建议最好使用一些现成的软件,这样既省事又可以提高效率。我必须自己测试这个测试,麻烦!采集土豆网,优酷视频,只是采集视频先下载地址,然后用批量下载工具。

奇博cms:可以将多个采集规则做成一个key采集吗?

如果服务器缓存没有来,就在本地取下来,然后上传到服务器!

什么是多站点cms?多站点是什么意思?

可以支持多个站点的cms程序。比如可以设置多个站点的首页,也可以设置其他模块或特殊区域如:bbs.xxx。

如何将独立的IP绑定到子目录,在一个后台建立多个不同IP的站点

IX的15个独立IP绑定了15个域名。每个域名都会生成一个以域名命名的文件夹

不用采集规则就可以采集(不用采集规则就可以采集,内容营销还是有好处)

采集交流 • 优采云 发表了文章 • 0 个评论 • 111 次浏览 • 2021-11-19 13:12

不用采集规则就可以采集,内容营销还是有好处的,但是采集到的,一般都不是精彩内容。要看你用的公众号定位是什么?以及对内容的要求,还是要看你对内容质量的要求。

确实是要规则,但是你采的数据也不准确。之前很多公众号看标题吸引注意力,点进去全是广告。很不精准,数据准确度不好,对于那些内容好的公众号最怕遇到这种情况,

公众号是根据数据采集的。数据被采集后就进入公司内部,这个时候还是保持数据的真实有效性,是有好处的,数据会影响公司的发展。内容营销的意义是不在于规则多少,在于“精”不精。

要啊,一般的都是看粉丝的基数来判断精不精准,

从推广角度,如果是已经很大的品牌,公号必然有平台的排名。其实这里看的是你的内容质量,

看你是否具有规则作用,如果像娱乐类公众号,你在不完全采集的情况下,做成精准定向推送,肯定不会太好的。想要实现好的效果,对于粉丝的了解,选题的策划,文案,都是很重要的。

要啊!推广公众号有公众号都不说明白么?有的公众号粉丝不够多,图片分享的是广告类的,可能因为违规被封号。同时,你没有粉丝群,就很难做到你要推送的要求,精准推送。不管怎么样,你公号是公司公开的吗?知道你的公众号推送时间和推送内容吗?如果你的公号公开,并且很大很大,人人都能知道你的公众号推送的一些信息,那你跟朋友用你的推送可能效果就不一样了。

还有,推广是有成本的,要有预算。并且推广还要不依赖于以上都是你的公众号要做到精准推送的话,首先你得把你公众号的准确推送的要求写清楚。像你说的,你这个就存在问题了。想把公众号推荐给目标人群,就得把你的公众号的定位定准,这样你才能精准推送。更多精准推送的方法请关注我!。 查看全部

不用采集规则就可以采集(不用采集规则就可以采集,内容营销还是有好处)

不用采集规则就可以采集,内容营销还是有好处的,但是采集到的,一般都不是精彩内容。要看你用的公众号定位是什么?以及对内容的要求,还是要看你对内容质量的要求。

确实是要规则,但是你采的数据也不准确。之前很多公众号看标题吸引注意力,点进去全是广告。很不精准,数据准确度不好,对于那些内容好的公众号最怕遇到这种情况,

公众号是根据数据采集的。数据被采集后就进入公司内部,这个时候还是保持数据的真实有效性,是有好处的,数据会影响公司的发展。内容营销的意义是不在于规则多少,在于“精”不精。

要啊,一般的都是看粉丝的基数来判断精不精准,

从推广角度,如果是已经很大的品牌,公号必然有平台的排名。其实这里看的是你的内容质量,

看你是否具有规则作用,如果像娱乐类公众号,你在不完全采集的情况下,做成精准定向推送,肯定不会太好的。想要实现好的效果,对于粉丝的了解,选题的策划,文案,都是很重要的。

要啊!推广公众号有公众号都不说明白么?有的公众号粉丝不够多,图片分享的是广告类的,可能因为违规被封号。同时,你没有粉丝群,就很难做到你要推送的要求,精准推送。不管怎么样,你公号是公司公开的吗?知道你的公众号推送时间和推送内容吗?如果你的公号公开,并且很大很大,人人都能知道你的公众号推送的一些信息,那你跟朋友用你的推送可能效果就不一样了。

还有,推广是有成本的,要有预算。并且推广还要不依赖于以上都是你的公众号要做到精准推送的话,首先你得把你公众号的准确推送的要求写清楚。像你说的,你这个就存在问题了。想把公众号推荐给目标人群,就得把你的公众号的定位定准,这样你才能精准推送。更多精准推送的方法请关注我!。

不用采集规则就可以采集(,采集,精确采集规则和模糊采集模式的使用方法)

采集交流 • 优采云 发表了文章 • 0 个评论 • 164 次浏览 • 2021-11-18 12:08

*官方演示站:,官方技术站:

************************************************

1. 保留所有权利。任何商业用途需购买商业版方可正式使用,否则后果自负

2. 这个垂直搜索引擎系统需要独立的服务器支持,也可以使用本地电脑作为服务器调试,基于lucence+mysql+,

支持数据索引、中文分词、模糊查询、爬虫采集、精确采集规则模式和模糊采集规则模式混合(fuzzy 采集不需要定义每个站采集规则,只定义一个)

目录结构:

网站文件--上传到服务器

|

|----spider_bin 这里是爬虫系统目录

|----ShangPu_zhida_data 商户直列数据

|----Main_set_dats 精确采集规则和模糊采集规则采集规则文件,为每一列创建一个目录

|----Lanmu_Index_templete 栏目首页模板文件目录

3.使用步骤:

一种。上传文件到服务器后,点击网站文件-将这个上传到服务器目录下的spider_bin目录

install_mysql_server_win.exe后点击重新安装fvdou_mysql系统服务按钮启动mysql服务

,然后点击fvdou_spider.exe打开爬虫终端,点击启动采集按钮启动采集,

湾 上传网站文件--将这个上传到服务器目录作为网站根目录wwwroot,如果没有上传到网站根目录wwwroot,

请先上传,待服务器安装好iis+.net框架2.0后,将iis家目录指向此根目录,即可使用

127.0.0.1 或者你的**打开本系统首页

4.采集 规则格式说明:

网站文件--上传到服务器 /Main_set_dats/ 是精确采集规则和模糊采集规则采集规则文件的目录,每列创建一个子目录

比如lanmu2_discount搜索子目录中的lanmu_sets.dat就是采集规则的主要定义文件:

-------------------------------------------------- --------------------------

[$lanmu_name]

折扣搜索

[$lanmu_sort_num]

2

[$lanmu_url_host]

/index_{$lanmu_id}.aspx

[$lanmu_index_template_file]

大哲.html

[$lanmu_id]

大哲_ss

[$mohu_init_search_keyword_from_other_engine]

折扣网

[$mohu_web_root_title_panduan_funname]

is_dz_web_title

[$mohu_web_root_title_panduan_code]

public bool is_dz_web_title(string inn){

if(inn.IndexOf("搜索")!=-1){

//返回假;

}

if(inn.IndexOf("下载")!=-1){

返回假;

}

if(inn.IndexOf("Discount Network")!=-1||inn.IndexOf("Discount Information Network")!=-1){

返回真;

}

返回假;

}

[$page_goto_orders]

[$ext_fields_classpage]

[$ext_fields_infopage]

类别字段中rem是否为0或单位为,如果信息页有匹配的招聘单位,则阅读信息页,否则阅读类页的单位为字段

rem字段||是否是分类字段||字段采集规则英文名称指示||是否存储||是否进行分词||是否是高级搜索||搜索类型||是否是显示在左侧索引菜单中| |左侧菜单的显示类型||固定类型,如价格、添加时间||采集时需要||Lucence搜索类型||左侧索引菜单的显示顺序||little_select_min_word_num

产品名称||0 或单味||spname||1||0||1||little_select||1||links_list||none||0||PrefixQuery||1||8

折扣||0||浙口||1||0||1||little_select||1||links_list||none||1||PrefixQuery||1||8

[$ext_fields_mohu_ziduan_name_enmu]

rem 字段采集 规则英文名称指示|| 所有可能的字段名称的列表,常规|| 可能值的规律性,0 表示匹配所有

名称|| (.{0,3})(产品名称|产品|产品名称|折扣产品|折扣产品)(.{0,3})|| 0

浙口|| (.{0,3})(折扣)(.{0,3})|| 0

[$code_for_ext_fields_data_enmu_guilei_to_small]

-------------------------------------------------- --------------------------

其中:[$lanmu_name]下指定的列名

[$lanmu_url_host] 指定的列路径

[$lanmu_index_template_file] 指定栏目模板文件,在Lanmu_Index_templete栏目首页模板文件目录下

[$lanmu_id] 为列id,不可重复

[$mohu_init_search_keyword_from_other_engine]是其他搜索引擎采集初始化采集源数据时模糊采集规则的关键字

[$mohu_web_root_title_panduan_funname] 指定[$mohu_web_root_title_panduan_code]中代码的函数名,不能重复

[$mohu_web_root_title_panduan_code] 是判断首页标题是否为目标站类型的函数

[$ext_fields_infopage] 是所有采集字段的定义

[$ext_fields_mohu_ziduan_name_enmu] 是一个模糊的采集规则,比如spname || (.{0,3})(产品名称|产品|产品名称|打折产品|打折产品)(.{0,3})|| 0

意思是提取产品名称或产品或产品名称或折扣产品右侧的最新文本作为spname字段中的采集数据

——

lanmu1_recruitment search/webs_guize 以下文件是精确的采集规则文件定义,每个目标站一个文件

其中 [$page_url_regex] 为 0 表示没有过滤 url,

[$caiji_info_fields_regex]中的regular/location规则详解,如[fd_datatoget]中的[fd_datatoget]代表目标采集数据部分

zpdw|+| 正则表达式|+|招聘单位:\s*[fd_datatoget] 查看全部

不用采集规则就可以采集(,采集,精确采集规则和模糊采集模式的使用方法)

*官方演示站:,官方技术站:

************************************************

1. 保留所有权利。任何商业用途需购买商业版方可正式使用,否则后果自负

2. 这个垂直搜索引擎系统需要独立的服务器支持,也可以使用本地电脑作为服务器调试,基于lucence+mysql+,

支持数据索引、中文分词、模糊查询、爬虫采集、精确采集规则模式和模糊采集规则模式混合(fuzzy 采集不需要定义每个站采集规则,只定义一个)

目录结构:

网站文件--上传到服务器

|

|----spider_bin 这里是爬虫系统目录

|----ShangPu_zhida_data 商户直列数据

|----Main_set_dats 精确采集规则和模糊采集规则采集规则文件,为每一列创建一个目录

|----Lanmu_Index_templete 栏目首页模板文件目录

3.使用步骤:

一种。上传文件到服务器后,点击网站文件-将这个上传到服务器目录下的spider_bin目录

install_mysql_server_win.exe后点击重新安装fvdou_mysql系统服务按钮启动mysql服务

,然后点击fvdou_spider.exe打开爬虫终端,点击启动采集按钮启动采集,

湾 上传网站文件--将这个上传到服务器目录作为网站根目录wwwroot,如果没有上传到网站根目录wwwroot,

请先上传,待服务器安装好iis+.net框架2.0后,将iis家目录指向此根目录,即可使用

127.0.0.1 或者你的**打开本系统首页

4.采集 规则格式说明:

网站文件--上传到服务器 /Main_set_dats/ 是精确采集规则和模糊采集规则采集规则文件的目录,每列创建一个子目录

比如lanmu2_discount搜索子目录中的lanmu_sets.dat就是采集规则的主要定义文件:

-------------------------------------------------- --------------------------

[$lanmu_name]

折扣搜索

[$lanmu_sort_num]

2

[$lanmu_url_host]

/index_{$lanmu_id}.aspx

[$lanmu_index_template_file]

大哲.html

[$lanmu_id]

大哲_ss

[$mohu_init_search_keyword_from_other_engine]

折扣网

[$mohu_web_root_title_panduan_funname]

is_dz_web_title

[$mohu_web_root_title_panduan_code]

public bool is_dz_web_title(string inn){

if(inn.IndexOf("搜索")!=-1){

//返回假;

}

if(inn.IndexOf("下载")!=-1){

返回假;

}

if(inn.IndexOf("Discount Network")!=-1||inn.IndexOf("Discount Information Network")!=-1){

返回真;

}

返回假;

}

[$page_goto_orders]

[$ext_fields_classpage]

[$ext_fields_infopage]

类别字段中rem是否为0或单位为,如果信息页有匹配的招聘单位,则阅读信息页,否则阅读类页的单位为字段

rem字段||是否是分类字段||字段采集规则英文名称指示||是否存储||是否进行分词||是否是高级搜索||搜索类型||是否是显示在左侧索引菜单中| |左侧菜单的显示类型||固定类型,如价格、添加时间||采集时需要||Lucence搜索类型||左侧索引菜单的显示顺序||little_select_min_word_num

产品名称||0 或单味||spname||1||0||1||little_select||1||links_list||none||0||PrefixQuery||1||8

折扣||0||浙口||1||0||1||little_select||1||links_list||none||1||PrefixQuery||1||8

[$ext_fields_mohu_ziduan_name_enmu]

rem 字段采集 规则英文名称指示|| 所有可能的字段名称的列表,常规|| 可能值的规律性,0 表示匹配所有

名称|| (.{0,3})(产品名称|产品|产品名称|折扣产品|折扣产品)(.{0,3})|| 0

浙口|| (.{0,3})(折扣)(.{0,3})|| 0

[$code_for_ext_fields_data_enmu_guilei_to_small]

-------------------------------------------------- --------------------------

其中:[$lanmu_name]下指定的列名

[$lanmu_url_host] 指定的列路径

[$lanmu_index_template_file] 指定栏目模板文件,在Lanmu_Index_templete栏目首页模板文件目录下

[$lanmu_id] 为列id,不可重复

[$mohu_init_search_keyword_from_other_engine]是其他搜索引擎采集初始化采集源数据时模糊采集规则的关键字

[$mohu_web_root_title_panduan_funname] 指定[$mohu_web_root_title_panduan_code]中代码的函数名,不能重复

[$mohu_web_root_title_panduan_code] 是判断首页标题是否为目标站类型的函数

[$ext_fields_infopage] 是所有采集字段的定义

[$ext_fields_mohu_ziduan_name_enmu] 是一个模糊的采集规则,比如spname || (.{0,3})(产品名称|产品|产品名称|打折产品|打折产品)(.{0,3})|| 0

意思是提取产品名称或产品或产品名称或折扣产品右侧的最新文本作为spname字段中的采集数据

——

lanmu1_recruitment search/webs_guize 以下文件是精确的采集规则文件定义,每个目标站一个文件

其中 [$page_url_regex] 为 0 表示没有过滤 url,

[$caiji_info_fields_regex]中的regular/location规则详解,如[fd_datatoget]中的[fd_datatoget]代表目标采集数据部分

zpdw|+| 正则表达式|+|招聘单位:\s*[fd_datatoget]

不用采集规则就可以采集(优采云采集器怎么安装?NetFramework支持安装)

采集交流 • 优采云 发表了文章 • 0 个评论 • 127 次浏览 • 2021-11-16 12:11

它将从微软官方网站自动在线安装。国内在线安装很慢。建议从下载页面的网盘下载链接安装.NET 3.5 SP1,然后安装优采云采集器。如果您下载的是压缩文件,请先解压,您将看到如下图所示的安装文件。安装前请仔细阅读“安装前阅读.txt”,然后双击setup.exe,一般情况下选择默认设置,多次点击下一步即可完成安装。5 SP1从下载页面的网盘下载链接,然后安装优采云采集器。如果您下载的是压缩文件,请先解压,您将看到如下图所示的安装文件。安装前请仔细阅读“安装前阅读.txt”,然后双击setup.exe,一般情况下选择默认设置,多次点击下一步即可完成安装。5 SP1从下载页面的网盘下载链接,然后安装优采云采集器。如果您下载的是压缩文件,请先解压,您将看到如下图所示的安装文件。安装前请仔细阅读“安装前阅读.txt”,然后双击setup.exe,一般情况下选择默认设置,多次点击下一步即可完成安装。

如果您的操作系统缺少 .NET Framework,系统会提示您安装它。这将需要一段时间。如果想快速安装,请按照上面的提示自行安装.NET Framework,然后安装优采云采集器。如何启动 安装完成后,可以在桌面或开始菜单中找到下图所示的快捷方式,双击启动优采云采集器。第一次开户注册优采云采集器,会打开登录界面。如果您还没有注册“地平线”通行证,则需要在登录界面点击“免费注册”链接完成账号注册,注册过程中请注意,您必须提供真实正确的艾迈地址。此电子邮件地址将用于接收帐户激活电子邮件,并且是您忘记密码时找回密码的唯一方法。注册后,您可以登录您的邮箱以接收激活邮件。如果您没有看到,请检查您的垃圾邮箱。您的邮箱可能会阻止收到激活电子邮件。如果您确定没有收到激活邮件,请打开视觉科技网站:,登录您刚刚注册的账号,登录后点击您的姓名转至用户中心,您可以重新发送激活邮件。点击激活邮件中的链接,您的账户将被自动激活。这时候就可以用这个账号登录优采云采集器。优采云采集器

这里也会对指南的内容做一个详细的介绍。导航菜单区介绍: 菜单导航分为三个部分,快速启动:用于新建采集任务,点击快速启动,然后点击里面的创建任务,新建一个采集任务。我的任务:您创建的所有任务都可以在我的任务下找到。在我的任务列表中,您可以通过鼠标左键单击选择一个任务,然后双击打开该任务。任务状态:可以查看正在执行的任务、等待执行的任务、已经完成和终止的任务。您还可以启动和停止任务。对于采集已完成的任务,还可以将采集导出为数据。领导干部日常工作忙的借口,”叮嘱环看,缺乏工作热情个别干部冷漠群众推诿,长篇大论,搞一些简单复杂的问题。有的干部一般讲薪酬,确实拿@采集一个简单的网页来循环采集,再到高级设置等很多从入门到精通需要知道的视频知识。对于新手来说,先看视频,然后带视频练习,这是学习优采云采集器最快最好的方法,尤其对于一些用过其他采集器、优采云采集器是全新的,它的操作方法与内部原理有很大不同,和一般的采集器。其他采集器形成的思维方式和经验,不能直接用在优采云采集器上,反而可能影响优采云使用的快速掌握,

DataAPI:很多企业客户也有自己的内部系统,希望能自动对接数据采集系统实现数据自动化采集,同步,企业数据服务(DataAPI)是为企业量身定制的数据接口. 借助DataAPI,数据可以自动进入企业内部系统,提供更稳定的数据支持,如采集网站改版,网站不稳定等因素不会影响稳定性数据接口。

获取采集规则:我们采集整理了很多网友写的采集规则,所以如果有人和你有相同或相似的需求并且已经写了规则,你可以直接导入规则. 使用它而不用花时间自己配置采集规则,这样会节省很多时间。此外,如果规则略有不同,您也可以修改导入的规则以满足您的需求。如果您在使用过程中遇到任何问题,可以随时到论坛寻求帮助。活动专区:优采云团队将持续开展各类活动帮助用户。参加活动可以轻松获得积分等奖励。比如可以每天签到,或者推荐好友注册使用优采云采集器,不仅可以获得积分奖励,但是被推荐的朋友也可以获得积分奖励。优采云采集器如何使用优采云采集器,最常用的是配置采集任务,配置一个采集任务,只是简单4 个步骤。根据上面的介绍,首先点击快速启动,然后点击新建任务,系统会打开新建任务向导。领导干部日常忙的借口,“督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,提出一些简单复杂的问题。一些干部一般讲工资,做领导干部日常忙的借口,”督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,做一些简单复杂的问题。最常用的是配置采集任务,配置一个采集任务,只需简单4步。根据上面的介绍,首先点击快速启动,然后点击新建任务,系统会打开新建任务向导。领导干部日常忙的借口,“督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,提出一些简单复杂的问题。一些干部一般讲工资,做领导干部日常忙的借口,”督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,做一些简单复杂的问题。最常用的是配置采集任务,配置一个采集任务,只需简单4步。根据上面的介绍,首先点击快速启动,然后点击新建任务,系统会打开新建任务向导。领导干部日常忙的借口,“督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,提出一些简单复杂的问题。一些干部一般讲工资,做领导干部日常忙的借口,”督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,做一些简单复杂的问题。系统将打开新建任务向导。领导干部日常忙的借口,“督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,提出一些简单复杂的问题。一些干部一般讲工资,做领导干部日常忙的借口,”督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,做一些简单复杂的问题。系统将打开新建任务向导。领导干部日常忙的借口,“督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,提出一些简单复杂的问题。一些干部一般讲工资,做领导干部日常忙的借口,”督促环视,缺乏工作热情个别干部漠视群众推卸责任,长,做一些简单复杂的问题。

可以把采集类型信息的任务放在一个组里,在备注中写上采集的网站地址,并添加一些文字说明什么是采集类数据的。这样,以后随时打开这个任务,你就会知道它在做什么。当有更多任务时,此信息非常有用。领导干部日常事情忙的借口,“督促围观,缺乏工作热情个别干部冷漠群众推诿,长,做一些简单复杂的问题。有的干部一般谈薪酬,做第2步:设计工作流程优采云工作原理和人的思考模式很相似,所以设计优采云采集器的工作流其实相当于把人采集一个网站数据的过程分成一些动作和步骤,并把这些步骤组织起来,完成采集的工作。比如一个人去一个网页要采集一些数据,通常的做法是:先打开网页,等待网页加载完毕,选择采集数据,然后右键单击进行复制,或按 Ctrl 进行复制。如果您使用 优采云采集器 来执行此操作,也是如此。第一步,从左边的工具栏中拖出“打开网页”这一步,拖到流程设计器的中间,当有可以释放的标志时,松开鼠标左键,这一步就会变成the first step of the process, as shown in the figure above, and then select this step, On the right side of the process designer, whenever a step is selected, some specific configuration information of the selected step will be displayed here.

另外,当您选择一个流程步骤时,打开下方的“工作流程帮助”,您将看到该步骤的描述以及如何配置各个配置项的帮助信息。打开网页后,当鼠标在下面的浏览器上移动时,可以看到有一个颜色会选择一些页面元素,随着鼠标移动,点击需要采集的数据打开一个选项在对话框中选择提取文本,选中元素的文本为采集。其他选项在原理和操作上类似。提取字段后,系统会自动添加数据提取步骤。如果有多个字段,这些字段会出现在采集步骤的配置项中(参考上图)。领导干部日常忙的借口,

关于云采集和单机采集的区别,以及各个计时选项的用法,鼠标上移会有详细提示,不再赘述说明在这里。领导干部日常工作忙的借口,“督促围观,缺乏工作热情个别干部冷漠群众推诿,长,做一些简单复杂的问题。有的干部一般讲工资,做第4步:经过以上三步实际完成配置,采集任务配置完成,第四步主要测试配置是否正确,第一个选项,勾选任务,会打开任务测试界面,点击开始测试按钮开始测试,同时,测试复印机采集其实是同一个界面。如果测试过程发现没有按预期运行,或者网站出现意想不到的问题,比如采集的字段不存在,则网页的样式发生了很大的变化,等,您可以随时停止测试,继续修改任务配置,然后再次进行测试。经过多次测试修改,如果确定任务没有问题,可以点击完成。进入任务列表,选择配置的任务,继续采集。如果您确定任务没有问题,则可以单击“完成”。进入任务列表,选择配置的任务,继续采集。如果您确定任务没有问题,则可以单击“完成”。进入任务列表,选择配置的任务,继续采集。

如果是单机采集,那么采集会立即开始在本地电脑上执行,采集完成后会有提示完成,点击导出数据按钮将所有 采集 导出到数据。如果在执行计划界面选择手动启动,点击云采集,任务会立即在云采集服务器上开始执行。如果执行计划选择定时自动启动,则不需要手动启动启动,任务会在指定时间自动启动。更多使用说明 本文档是对优采云采集器的简单介绍。主要适合刚开始学习使用优采云采集器的用户,当然优采云采集器 还有很多更强大的功能,在本文档中没有解释。有关更多说明,请查看视频教程和其他文档。如果您还没有看完视频教程,我们强烈建议您再次仔细观看官方视频教程。只需要半小时,很快就能学会。 查看全部

不用采集规则就可以采集(优采云采集器怎么安装?NetFramework支持安装)

它将从微软官方网站自动在线安装。国内在线安装很慢。建议从下载页面的网盘下载链接安装.NET 3.5 SP1,然后安装优采云采集器。如果您下载的是压缩文件,请先解压,您将看到如下图所示的安装文件。安装前请仔细阅读“安装前阅读.txt”,然后双击setup.exe,一般情况下选择默认设置,多次点击下一步即可完成安装。5 SP1从下载页面的网盘下载链接,然后安装优采云采集器。如果您下载的是压缩文件,请先解压,您将看到如下图所示的安装文件。安装前请仔细阅读“安装前阅读.txt”,然后双击setup.exe,一般情况下选择默认设置,多次点击下一步即可完成安装。5 SP1从下载页面的网盘下载链接,然后安装优采云采集器。如果您下载的是压缩文件,请先解压,您将看到如下图所示的安装文件。安装前请仔细阅读“安装前阅读.txt”,然后双击setup.exe,一般情况下选择默认设置,多次点击下一步即可完成安装。