excel抓取多页网页数据(“WebScraper”插件制作了第一个爬虫程序(Element))

优采云 发布时间: 2021-10-03 12:18excel抓取多页网页数据(“WebScraper”插件制作了第一个爬虫程序(Element))

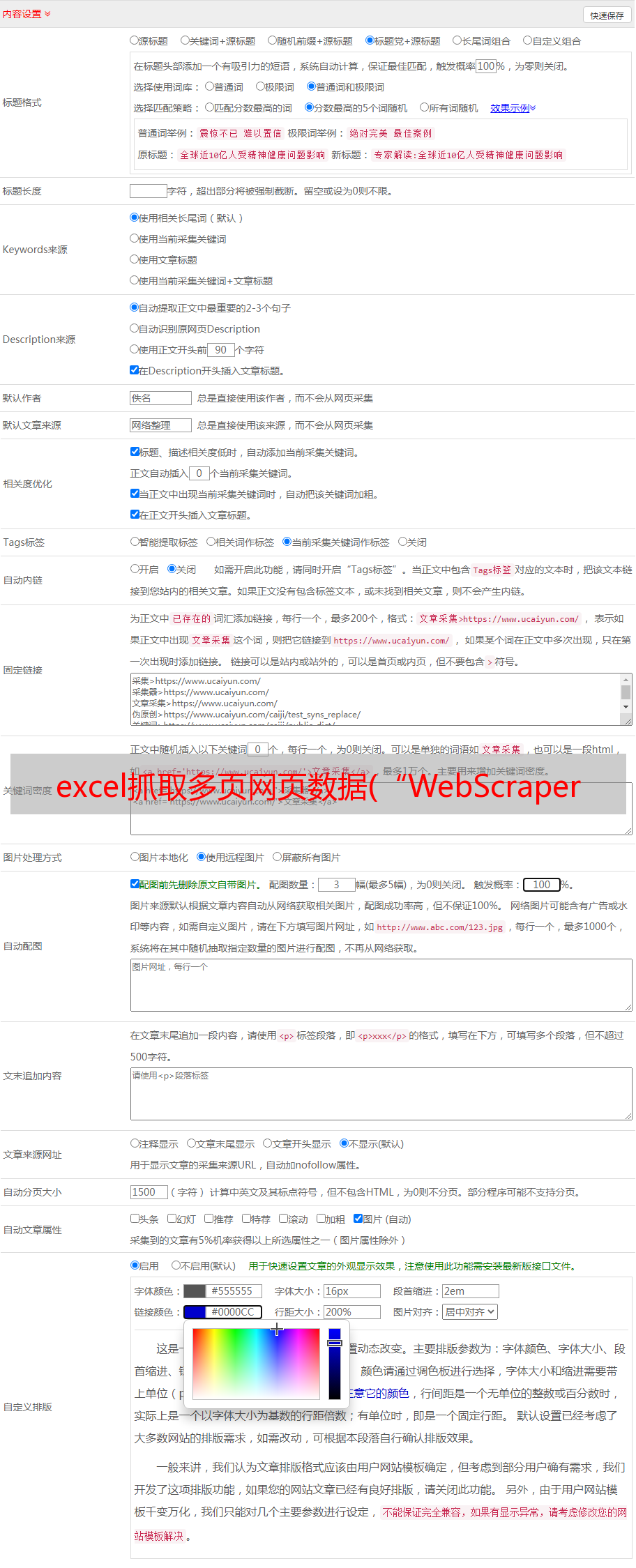

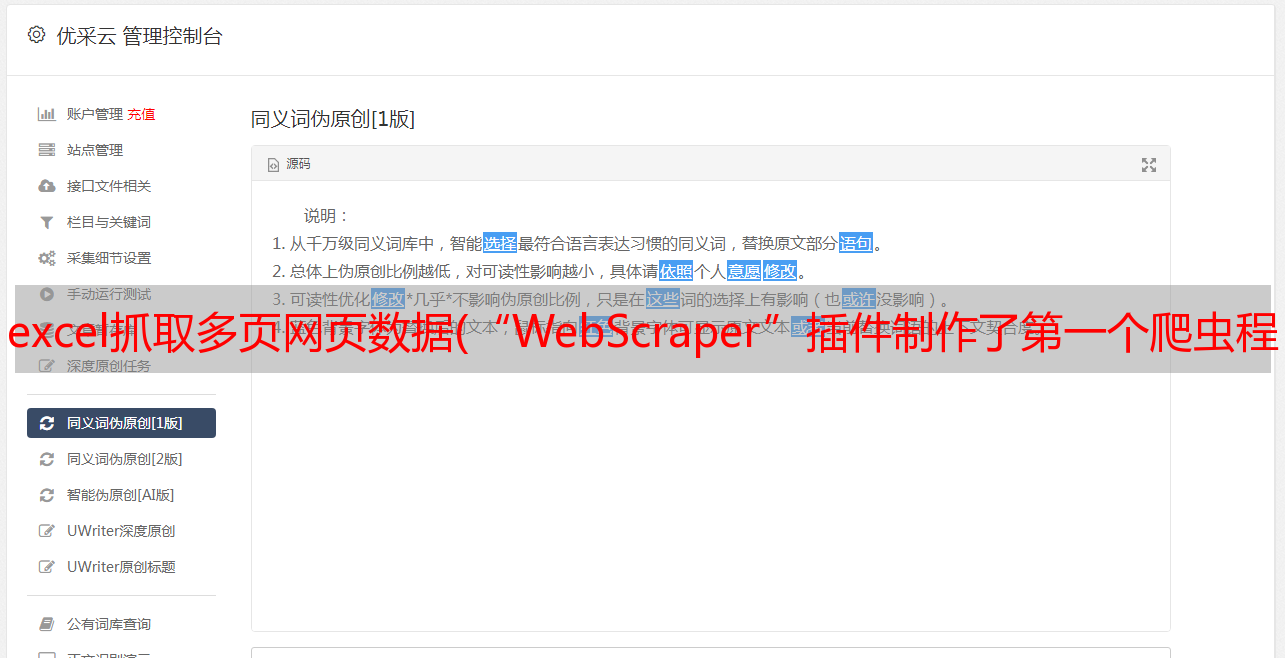

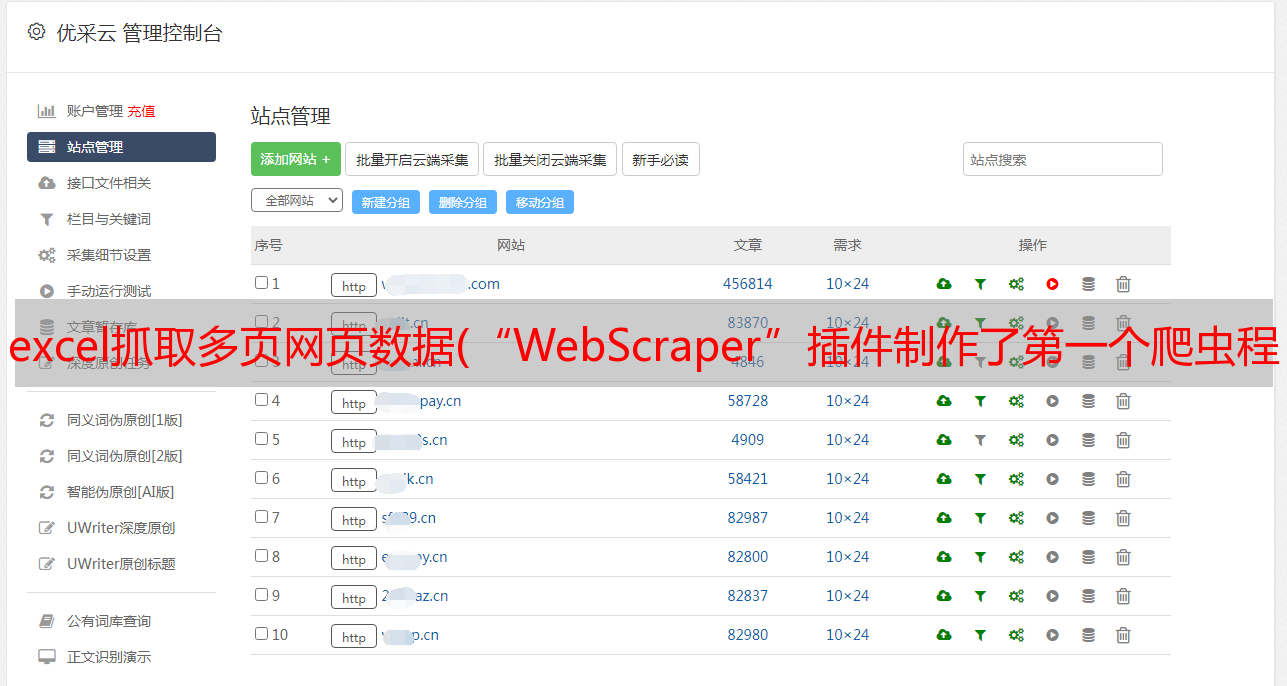

在上一篇文章中,我们使用了“Web Scraper”插件来制作我们的第一个爬虫。() 今天,我们将升级我们的爬虫程序,以同时抓取网页的多个元素并抓取二级页面的信息。

在开始之前,我们需要了解元素集(Element)的概念,元素集是一个收录多个元素(带类)的集合,如果你在捕获信息时需要采集不同类型的元素而不是想要不同类型的元素 如果你混淆了它们,你必须使用元素集。

一、首先我们创建一个新的站点地图

1.打开网页,按F12打开控制台,打开控制台点击“Web Scraper”,点击“创建新站点地图”创建新站点地图,点击“创建站点地图”创建新站点.

2.然后在“站点地图名称”中输入自定义的站点地图名称,在“起始网址”中输入目标网址(编辑进入我的知乎“我关注的人”页面),点击创建确认按钮的站点地图。

二、创建一个新的选择器

1.点击“添加新选择器”来创建一个新的选择器。

2. 新建一个Element类型的选择器,勾选Multiple选项按钮,然后点击“Select”开始选择和抓取元素。

三、 获取元素集

1.如图,将鼠标悬停在元素集边界的位置,等待绿框内收录一个用户的所有信息采集,点击鼠标左键将此用户信息作为元素集。

2. 同理,选择第二个用户的元素集,程序会自动确定所有相同类型的元素集并锁定为红色,然后点击“完成选择”。最后点击Save Selector保存爬虫规则。

四、保存爬虫规则后,需要创建二级选择器。

1. 点击刚刚创建的爬虫规则“关注”。

2.进入_root/following路径后,点击“添加新选择器”,新建一个二级选择器。

3.将此二级选择器命名为“用户名”,注意不要勾选此处的多个按钮。当你点击选择按钮采集元素时,你会发现只能在*敏*感*词*框内进行选择,这是因为刚才一级选择器已经选择了元素集的范围。让我们点击*敏*感*词*框中的用户名,然后

4. 然后我们用同样的方法点击“添加新选择器”,然后新建一个名为“desc”的二级选择器,点击“选择”,选择用户的个人描述信息,

五、开始采集数据

1.二级选择器的设置保存后,点击“_root”返回根节点。

2.点击“数据预览”可以预览数据的结果采集。

3.为了方便理解,我们还可以点击插件中的“Selector graph”查看我们的选择器和二级选择器的数据结构。

选择器和二级选择器的数据结构

六、 抓取二级页面

1. 我们以上市公司公告为抓取对象,尝试抓取二级页面的信息。首先,我们新建一个站点地图,并将我们准备的列表页面的URL设置为采集上市公司公告(编辑选择了“贵州茅台”的页面,金融股票网站 "Xueqiu") 作为“起始 URL”。

2.接下来,我们要定义我们想要采集的元素集

需要注意的是,雪球个股页面的“公告”栏需要鼠标点击才能切换,所以“公告”的类型应选择为“元素点击”。创建一个新的选择器,其类型为 Element Click 并随意命名为“notice click”。

首先,我们想让爬虫程序模拟鼠标点击“公告”栏,点击“点击选择器”的“选择”选择鼠标点击的位置,然后将鼠标移动到“公告”栏,单击,然后单击“完成选择!”保存鼠标单击的位置。然后勾选“多个”勾选按钮,勾选“丢弃点击前可用的初始元素”按钮。

3.接下来,点击“Selector”的“Select”,开始选择要获取的元素集。注意,在开始选择元素集之前,必须先用鼠标点击网页上的“公告”,才能将网页切换到公告栏,开始选择!选择元素集时,当公司公告在整个选择框内时,用鼠标单击,然后用同样的方法选择第二个元素集,程序会自动确定所有相同类型的元素集并锁定红色,然后单击“完成选择”。最后点击Save Selector保存爬虫规则。

4.接下来我们将创建二级选择器。

点击notice点击进入_root/notice点击路径,点击“添加新选择器”创建二级选择器。我们以上市公司公告的标题作为第一个二级选择器要抓取的内容。

5.第二个二级选择器,我们要采集公司公告PDF文件的网址,也就是二级页面的链接。注意这个二级选择器的Type应该选择“Link”,然后点击“Select”,点击元素集中的超链接(我选择的网页叫“网页链接”)。

6.返回根目录,点击“数据预览”预览采集的结果,点击“站点地图”的“开始抓取”开始抓取数据,程序运行后,数据抓取将结果显示在控制台上。在控制台点击“Sitemap”中的“Export data as CSV”,将抓取到的结果保存为excel可以打开的CSV格式,方便以后的信息存储和数据挖掘。

7.打开刚才保存的CSV文件,可以看到我们要抓取的二级页面上市公司公告的PDF文件地址已经在抓取结果中了,我们可以复制这些抓取文件的地址,可以使用迅雷等下载软件批量下载上市公司公告,以便进一步分析。

下一篇文章,我们将继续讲网络爬虫进阶教程,不规则分页的信息抓取以及网站反爬虫的对策。

粉丝福利:关注公众号“晨宇程序员学习笔记”,在公众号对话框回复关键词“爬虫”,小编会给你“用Python编写网络爬虫”的下载地址!

-结尾-

过往回顾