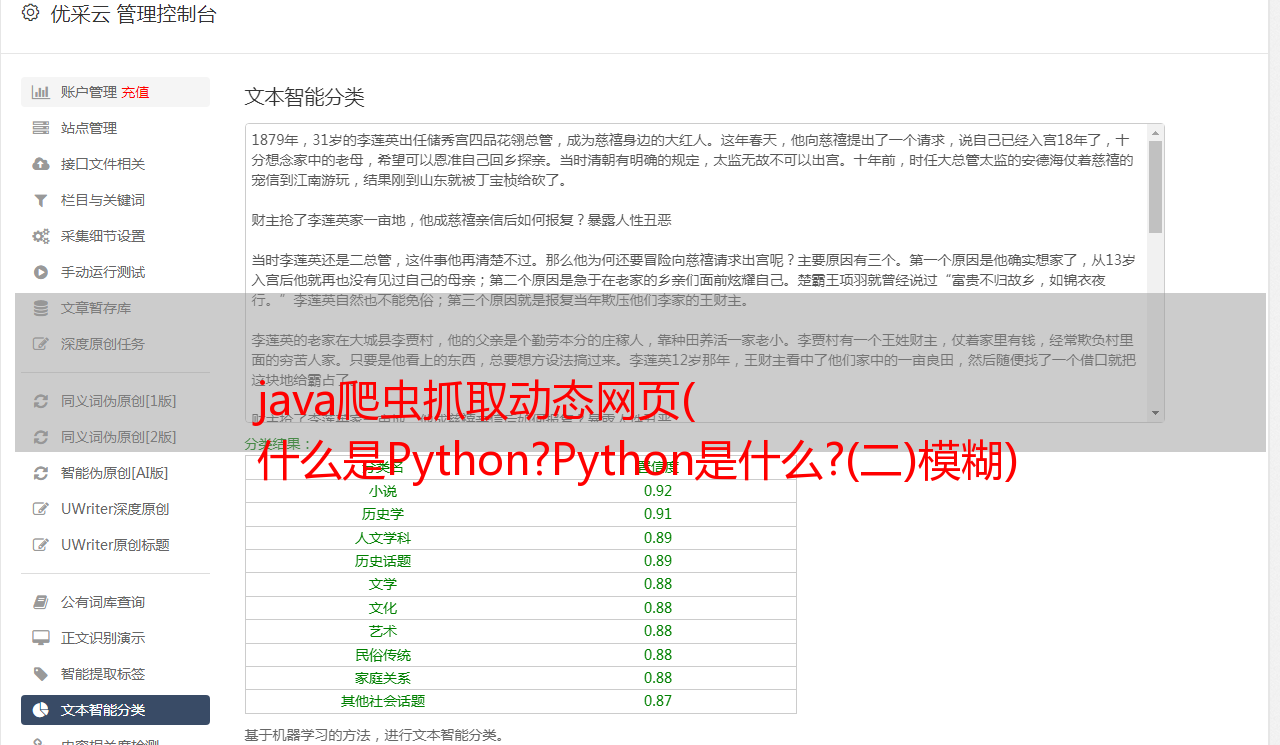

java爬虫抓取动态网页( 什么是Python?Python是什么?(二)模糊)

优采云 发布时间: 2021-10-01 20:09java爬虫抓取动态网页(

什么是Python?Python是什么?(二)模糊)

今天听到有人问:为什么Python叫爬虫?我脑子里的第一反应不是答案,而是为什么有人问这个问题。我觉得大家对Python的概念有点模糊,把Python和爬虫混为一谈,所以今天问请解释一下。

什么是 Python?什么是 Python?

如果你在英文字典里查Python,他会给你下Python是大蟒蛇的定义,读成这样:英语[ˈpaɪθən],美国[ˈpaɪθɑ:n],Python就是大名鼎鼎的“龟叔”Guido van Rossum在 1989 年圣诞节期间,为了度过无聊的圣诞节而编写的一种编程语言。Python 是一种计算机编程语言。是一种动态的、面向对象的脚本语言,最初是为编写自动化脚本(shell)而设计的,随着版本的不断更新和新语言功能的加入,越来越多的被用于独立的、大型的项目开发。

Python 是一种解释性脚本语言,可用于以下领域:

1、Web 和 Internet 开发

2、科学计算和统计

3、教育

4、桌面界面开发

5、软件开发

6、后端开发

什么是爬虫?什么是网络爬虫?

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常见的是网络追逐)是按照某些规则自动抓取万维网上信息的程序或脚本。其他不太常用的名称是蚂蚁、自动索引、模拟器或蠕虫。

随着互联网的飞速发展,万维网已经成为海量信息的载体。如何有效地提取和利用这些信息成为一个巨大的挑战。

搜索引擎,如传统的通用搜索引擎 AltaVista、Yahoo! 谷歌等作为辅助人们检索信息的工具,成为用户访问万维网的门户和指南。但是,这些通用的搜索引擎也有一定的局限性,例如:

(1)不同领域、不同背景的用户往往有不同的检索目的和需求。一般搜索引擎返回的结果中含有大量用户不关心的网页。

(2)通用搜索引擎的目标是最大化网络覆盖。有限的搜索引擎服务器资源和无限的网络数据资源之间的矛盾将进一步加深。

(3) 随着万维网上数据形式的丰富和网络技术的不断发展,图片、数据库、音频、视频、多媒体等不同数据大量出现,一般的搜索引擎往往无能为力。这些具有密集信息内容和一定结构的数据。很好地发现和获取。

(4)大多数通用搜索引擎都提供基于关键字的检索,难以支持基于语义信息的查询。

为了解决上述问题,针对相关网络资源进行针对性抓取的聚焦爬虫应运而生。Focus Crawler 是一个自动下载网页的程序。它根据建立的爬取目标有选择地访问万维网上的网页和相关链接,以获取所需的信息。与通用网络爬虫不同,聚焦爬虫不追求大的覆盖范围,而是将目标设定为抓取与特定主题内容相关的网页,并为面向主题的用户查询准备数据资源。

Python和爬虫有什么关系?

爬虫一般是指对网络资源的爬取。由于python的脚本特性,python易于配置,对字符的处理也非常灵活。另外python有丰富的网络捕捉模块,所以两者经常联系在一起。只需使用python自带的urllib库即可;使用python编写搜索引擎,搜索引擎是一个复杂的爬虫。从这里您将了解什么是 Python 爬虫。是一种基于Python编程创建的网络资源爬取方法。Python 不是爬虫。

为什么Python适合一些爬虫?

1) 抓取网页本身的界面

与java、c#、C++、python等其他静态编程语言相比,抓取网页文档的界面更加简洁;相对于其他动态脚本语言,如 perl、shell、python,urllib2 包提供了更完整的 Web 文档 API 访问。(当然*敏*感*词*也是不错的选择)

另外,爬取网页有时需要模拟浏览器的行为,很多网站都是为了生硬爬取而被屏蔽的。这就是我们需要模拟用户代理的行为来构造合适的请求的地方,比如模拟用户登录,模拟session/cookies的存储和设置。python中有很好的第三方包帮你搞定,比如Requests,mechanize

2)网页爬取后的处理

抓取到的网页通常需要进行处理,如过滤html标签、提取文本等。Python的beautifulsoap提供了简洁的文档处理功能,可以用很短的代码完成大部分文档处理。

什么是爬虫代理?

在爬行的过程中,如果你的爬行频率过快,不符合人类的操作方式。一些网站反爬虫机制检测到你的IP异常,访问频率过高。您将被阻止 IP。目前,专门从事代理IP服务的第三方平台比较多。

【相关学习建议】

1. Python爬虫视频教程

2. Python爬虫入门教程

如果想尝试爬取数据实践,可以试试下面爬虫专用代理ip,支持https、http、socks5、地址: