输入关键字 抓取所有网页( 临渊羡鱼退而结网创作不易,持续干货输出,有趣的灵魂值得你关注 )

优采云 发布时间: 2021-09-19 06:02输入关键字 抓取所有网页(

临渊羡鱼退而结网创作不易,持续干货输出,有趣的灵魂值得你关注

)

1、需求分析

需求:在上一节中,我们已经了解了requests模块的基本用法,并对搜狗搜索主页的页面信息进行了爬网。在本节中,我们希望通过编译器命令行输入关键字,搜索关键字,爬网并将结果页保存到文件中

分析:

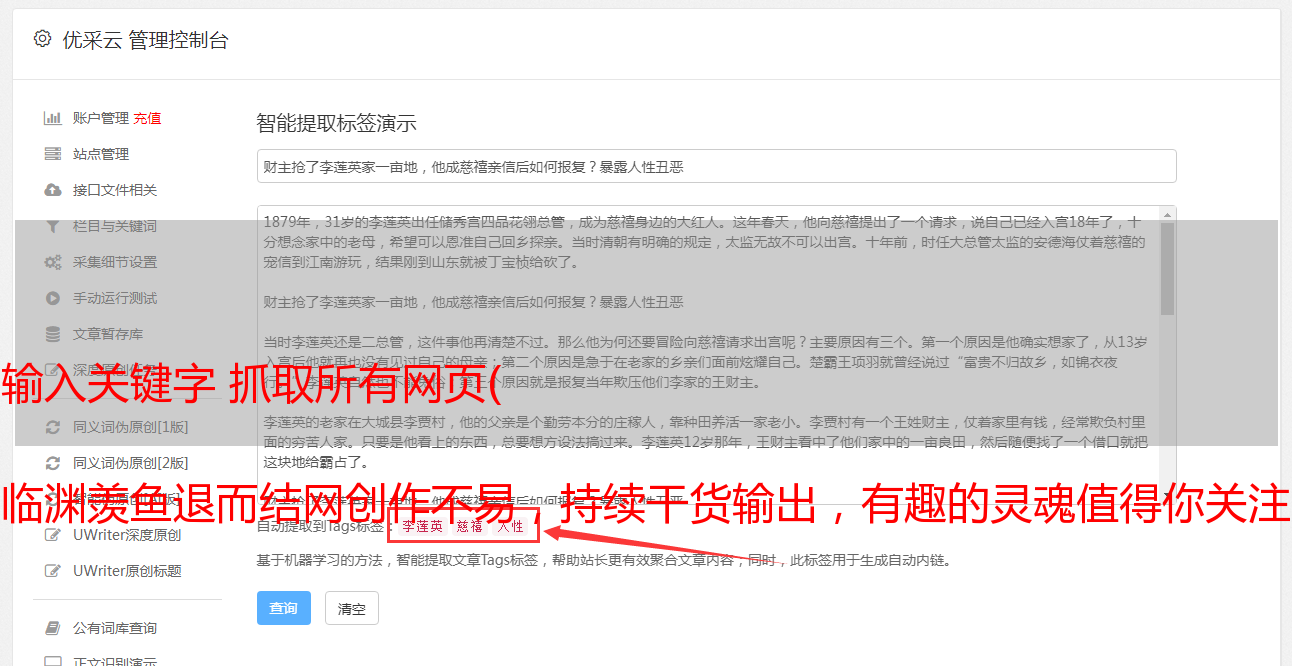

如下图所示,搜狗首页关键字搜索后会出现相应的搜索结果。可以发现,浏览器搜索的URL实际上是根路径下添加的查询参数

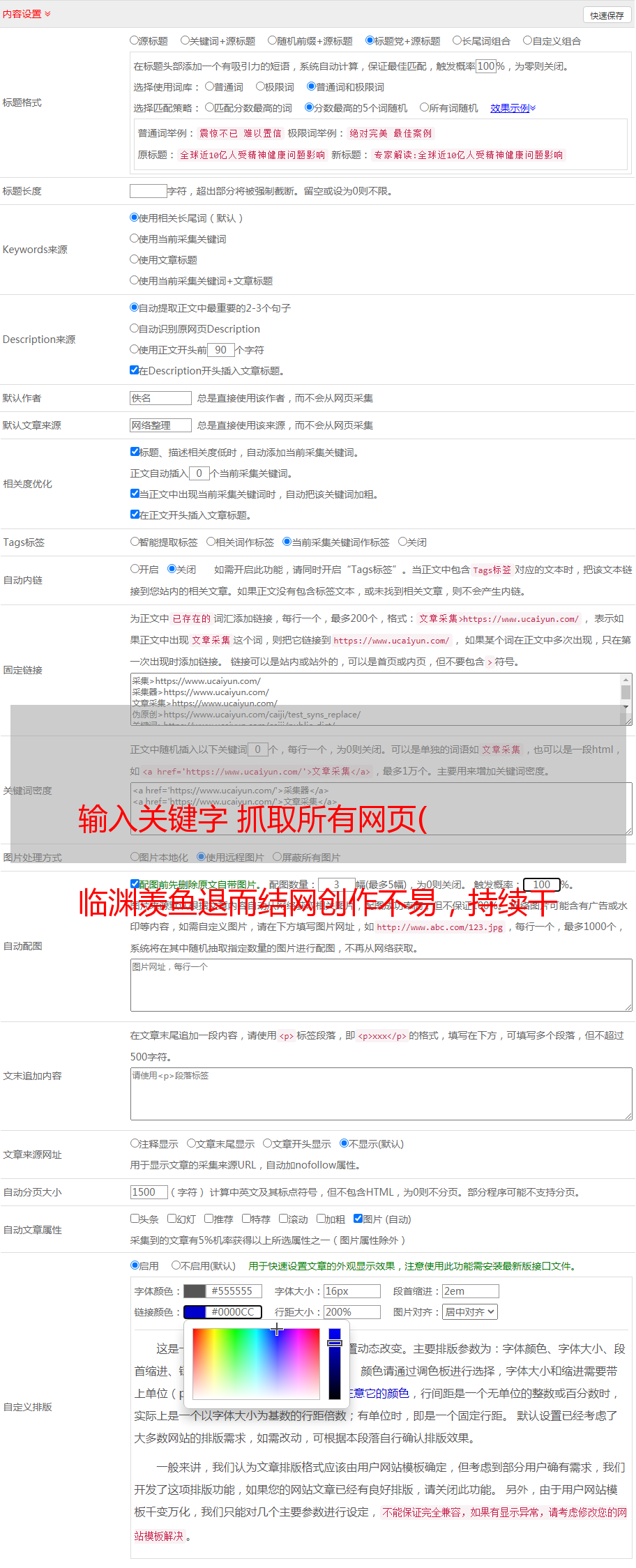

因此,您可以通过编译器输入要搜索的关键字(例如rain cold CSDN),然后将其拼接到初始URL(),然后形成一个完整的URL(rain cold CSDN),该URL可以用作请求中的URL参数。Get()方法请求访问该页。当然,您可以使用主页URL(),然后将搜索关键字封装到字典形式params={'query':keyword}中,它可以作为参数输入get()方法2、code中

# coding : utf-8

# fun : 根据关键字爬取搜狗搜索页面信息

# @Author : Labyrinthine Leo

# @Time : 2021.01.30

import requests

import json

def sougou_spider(url=None, keyword='百度'):

"""

根据关键字爬取搜狗搜索页面信息

:param url: 搜索链接

:param kw: 关键字

:return:

"""

if url is None:

print("url should not be None!")

return

# 1.指定url

url = url

# 2.UA伪装

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36'

}

# 3.参数设置

params = {

'query':keyword

}

# 4.发送请求

response = requests.get(url=url, params=params, headers=headers)

response.encoding = response.apparent_encoding # 矫正编码

# 5.获取响应的页面

page_text = response.text

# 6.持久化存储

fileName = keyword + '.html'

with open(fileName,'w',encoding='utf-8') as fp:

fp.write(page_text)

print("{}信息爬取成功!".format(keyword))

if __name__ == '__main__':

# 设置网页url

url = "https://www.sogou.com/web"

# 用户输入关键字

keyword = input("enter your key word:")

sougou_spider(url,keyword)

与其嫉妒一条鱼,不如退却并织一张网

这不容易创造。如果你认为这篇文章文章对你有用,你可以赞美它。可以说是对作者的支持和鼓励!这是Leo的博客城堡,以Python为核心,ML&;DL是主要使用的,它是各种各样的。我失去了一些浅薄的见解,拍了一张转瞬即逝的照片,讲了三两个故事。最好撤退,形成一个网络,继续出口干货。有趣的灵魂值得你关注

可以在作者的GitHub主页上查看原创文本(如果可以,可以单击star,呵呵)