网页中flash数据抓取(网络爬虫可分为通用爬虫和聚焦爬虫两种..)

优采云 发布时间: 2021-09-17 14:16网页中flash数据抓取(网络爬虫可分为通用爬虫和聚焦爬虫两种..)

根据使用场景,网络爬虫可以分为普通爬虫和聚焦爬虫

通用履带

通用网络爬虫是搜索引擎捕获系统(百度、谷歌、雅虎等)的重要组成部分。主要目的是在本地下载Internet上的网页,以形成Internet内容的镜像备份

通用搜索引擎的工作原理

普通网络爬虫从互联网上采集网页、采集信息。这些网页用于为搜索引擎建立索引以提供支持。它决定了整个发动机系统的内容是否丰富,信息是否实时。因此,它的性能直接影响到搜索引擎的效果

步骤1:抓取网页

搜索引擎网络爬虫的基本工作流程如下:

首先,选择一些*敏*感*词*URL并将其放入要获取的URL队列中;取出要爬网的URL,解析DNS获取主机IP,下载URL对应的网页,存储在下载的网页库中,将这些URL放入爬网URL队列。分析已爬网URL队列中的URL,分析其他URL,并将该URL放入要爬网的URL队列中,以进入下一个周期

搜索引擎如何获得新URL网站:

新的网站网站主动提交给搜索引擎:(如百度/linksubmit)/

在其他网站上设置新的网站*敏*感*词*内)

搜索引擎和DNS解析服务提供商(如DNSPod)合作,新的网站域名将很快被捕获

然而,搜索引擎爬行器的爬行是按照一定的规则输入的,它需要符合一些命令或文件的内容,例如标记为nofollow的链接或robots协议

> Robots协议(也叫爬虫协议、机器人协议等),全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取,例如:

淘宝网:https://www.taobao.com/robots.txt

腾讯网: http://www.qq.com/robots.txt

复制代码

步骤2:数据存储

搜索引擎通过爬虫抓取的网页将数据存储在原创页面数据库中,页面数据与用户浏览器获取的HTML完全相同

搜索引擎蜘蛛在抓取页面时也会进行一些重复内容检测。一旦它们遇到大量抄袭、采集或在网站上复制的内容且访问权重较低,它们很可能会停止抓取

步骤3:预处理

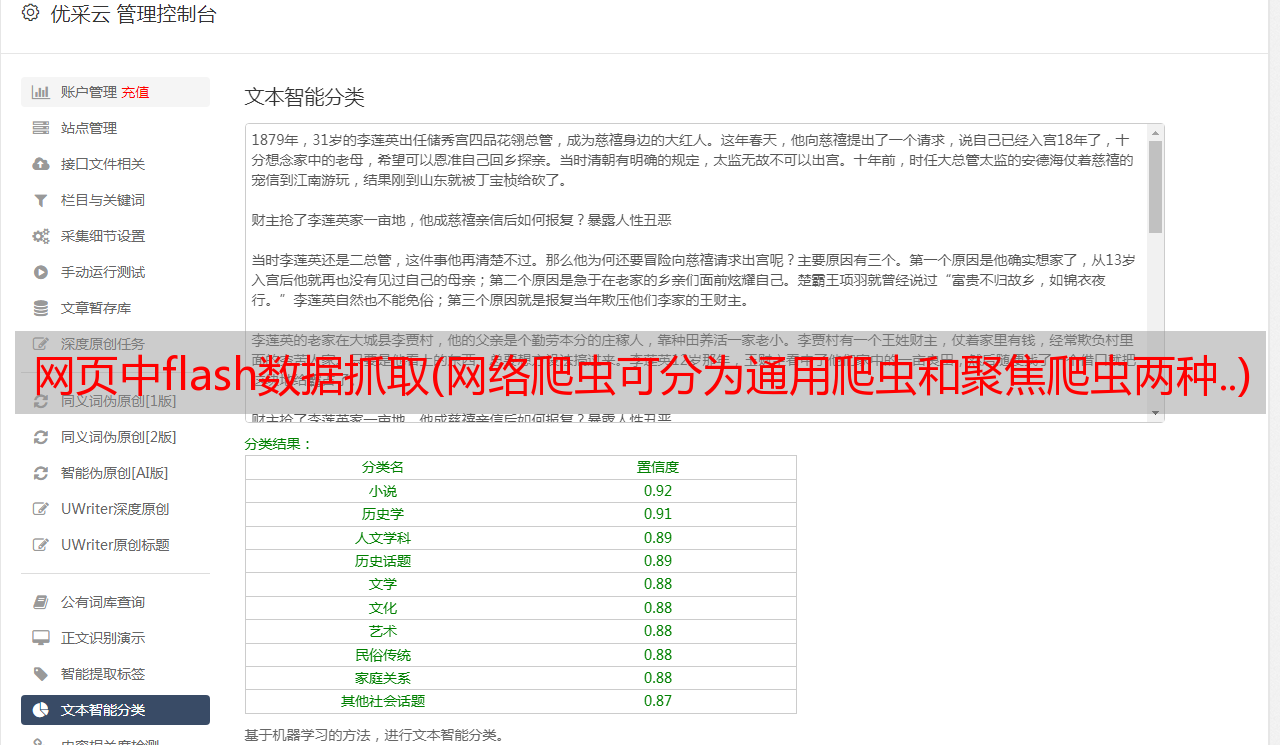

搜索引擎通过不同的步骤对爬虫捕获的页面进行预处理

除了HTML文件,搜索引擎通常可以捕获和索引各种基于文本的文件类型,如PDF、word、WPS、xls、PPT、txt文件等。我们经常在搜索结果中看到这些文件类型

然而,搜索引擎不能处理图片、视频和flash等非文本内容,也不能执行脚本和程序

第四步:提供检索服务和网站rank

在组织和处理信息后,搜索引擎为用户提供关键字检索服务,并将用户检索到的相关信息显示给用户

同时,网站将根据页面的PageRank值(链接访问的排名)进行排名,这样排名值高的网站在搜索结果中的排名会更高。当然,你也可以直接用钱购买搜索引擎的网站排名,简单而粗糙

但是,这些通用搜索引擎也有一些局限性:

针对这些情况,聚焦爬虫技术得到了广泛的应用

焦点爬虫

Focus crawler是一个“面向特定主题需求”的网络爬虫程序,它与一般搜索引擎爬虫的区别在于,Focus crawler在实现网页爬网时会对内容进行处理和过滤,并尽量确保只捕获与需求相关的网页信息

我们将来要学习的网络爬虫是聚焦爬虫

我是白有白一,一个喜欢分享知识的程序元❤️

如果一个没有接触编程的朋友看到这个博客,发现他不能编程或想学习,他可以留言+私人我~[非常感谢你的表扬、采集、关注和评论,一键四链接支持]