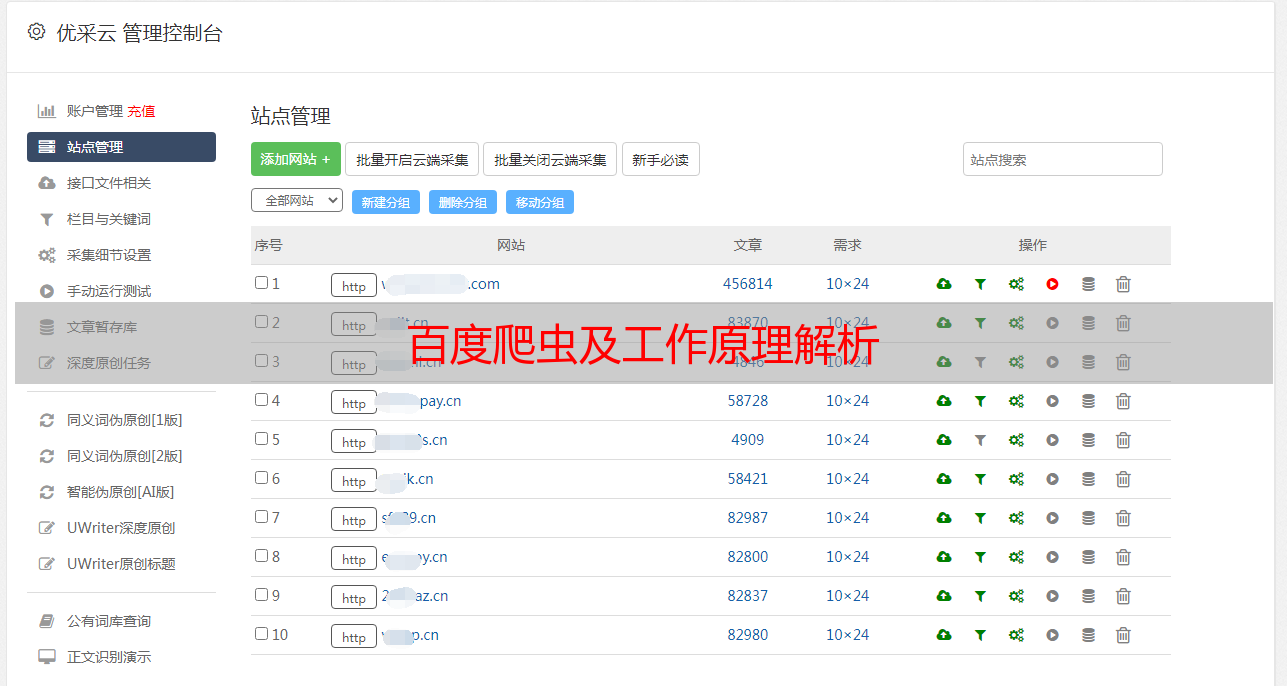

百度爬虫及工作原理解析

优采云 发布时间: 2020-05-16 08:07

俗话说知己知彼能够百战不殆,互联网时代也不例外,想要关键词获取好的排行,想要网站有大量的流量,想要做好搜索引擎优化,那么一定要了解搜索引擎的工作原理,毕竟访问者想要获取信息优选选择的都是搜索引擎,百度作为全球的英文搜索引擎,百度爬虫就是它重要的程序之一。

百度爬虫又被称为百度蜘蛛,是一种网路机器人,按照一定的规则,在各个网站上爬行,访问搜集整理网页、图片、视频等内容,分类别构建数据库,呈现在搜索引擎上,使用户通过搜索一些关键词,能查看到企业网站的页面、图片、视频等。

通俗的说它可以访问,抓取,整理互联网上的多种内容,从而分门别类的构建一个索引数据库,使用户可以通过百度这个搜索引擎在互联网上找到自己想找寻的信息。它主要的工作就是发觉网站,抓取网站,保存网站,分析网站和参与网站。我们所做的一切网站优化,都是为了使爬虫抓取、收录网站的。那么,什么是百度爬虫?它工作原理是哪些呢?

1、发现网站:百度爬虫每晚还会在各个网站上爬,抓取无数的网站与页面,进行评估与初审,优质的内容都会被收录。一个新网站一般都须要一周左右就会被爬虫发觉,只要坚持不断更新网站,内容优质,一定会被发觉的。

2、抓取网站:百度爬虫通常是先按照预先设定的初始网页的URL开始,然后根据一定的规则爬取网页。爬虫沿着网页中的各类链接,从一个页面爬到另一个页面,通过链接剖析连续爬行访问,抓取更多的页面。被抓取的网页就是“百度快照”。

3、保存网站:百度爬虫的喜好跟我们人类的喜好是一样的,喜欢新鲜的、独一无二的东西。如果网站经常更新,内容质量特别高,那么爬虫就喜欢待在这里,顺着链接来回爬,欣赏这独一无二的景色,并且会保存出来。如果网站的内容都是剽窃来的,或其他网站上早就有了,爬虫就觉得是垃圾内容,便会离开网站。

4、分析网站:百度爬虫抓取到网站之后,要提取关键词,建立索引库和索引,同时还要剖析内容是否重复,判断网页的类型,分析超链接,计算网站的重要程度等大量的工作百度爬虫,分析完毕以后,就能提供检索服务。

5、参与网站:当爬虫觉得网站的内容符合它的喜好了,通过一系列的估算工作以后,就被收录上去,当用户输入关键词并进行搜索的时侯,就能从搜索引擎中找到该关键词相关的网站,从而被用户查看到。

详细点来说就是百度爬虫爬行到网站上选购网站中的优质URL(指资源的地址) ,然后将这种优质URL倒入待抓取URL队列,再从待抓取URL队列提取过滤掉重复的URL,解析网页链接特点,得到主机IP并将URL对应的网页信息下载出来存入索引库,然后等待用户搜索提取。当然,已下载的URL仍然会放到已抓取URL队列,再剖析其中的其他URL,然后再倒入待抓取URL的队列,在步入下一个循环。

在这里就不得不提及网站地图了,百度爬虫特别喜欢网站地图,因为网站地图将网站上所有的链接汇总上去,可以便捷蜘蛛的爬行抓取,让爬虫清晰了解网站的整体结构,增加网站重要页面的收录。

当今时代是互联网的时代,互联网时代是一个全新的信息化时代,当然,互联网上的内容也是实时变化,不断更新换旧的,想要信息排行愈发的靠前,只有充分把握搜索引擎的工作原理,并善用每位细节,才能使网站获取更多更好的诠释百度爬虫,毕竟成大业若烹小鲜,做大事必重细节。