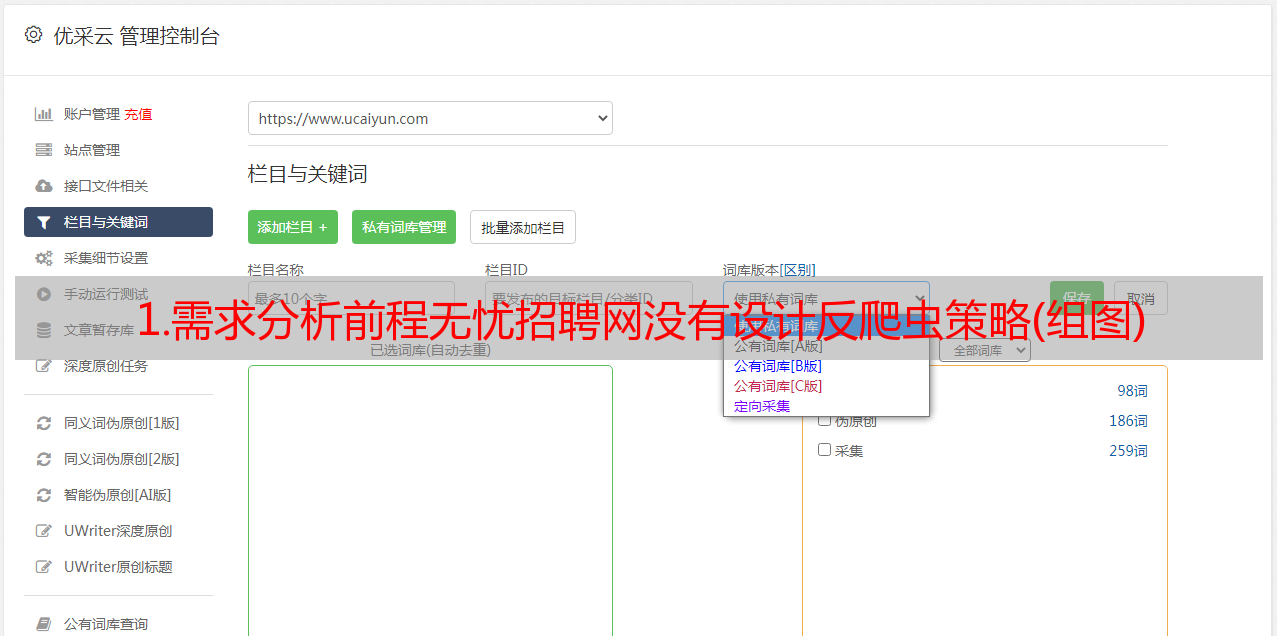

1.需求分析前程无忧招聘网没有设计反爬虫策略(组图)

优采云 发布时间: 2021-08-09 06:271.需求分析前程无忧招聘网没有设计反爬虫策略(组图)

抓取文件

原则:

1.需求分析

Worry-free 没有设计反爬虫策略。它只需要使用开发者工具来分析页面的数据源和分页规则。 的求职列表页面和详情页面如图所示。

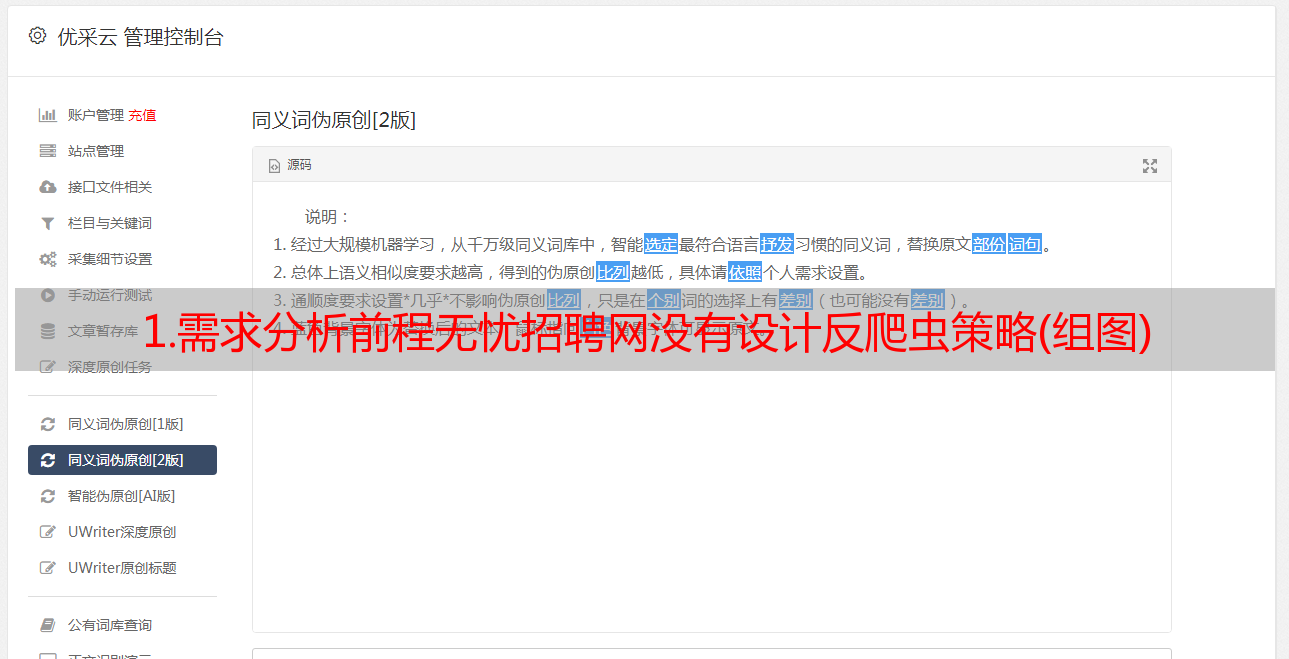

2.Crawler 数据存储设计

对于爬虫来说,最重要的就是爬取到的数据,所以爬虫项目在开发前需要考虑数据的存储格式和保存的数据项。估计网站爬取的数据不到10万,数据量较小,考虑使用CSV或MySQL数据库等文本格式存储。

如果使用CSV文本格式存储,在数据清洗前还需要考虑数据合并。

结合需求分析中的数据分析目标,对51job、猎聘、智联招聘三个招聘网站职位的数据进行分析,确定数据采集项。使用数据库中的表结构设计形式展示每个数据项的含义和功能。

最后设计好数据库,在mysql数据库中创建表。

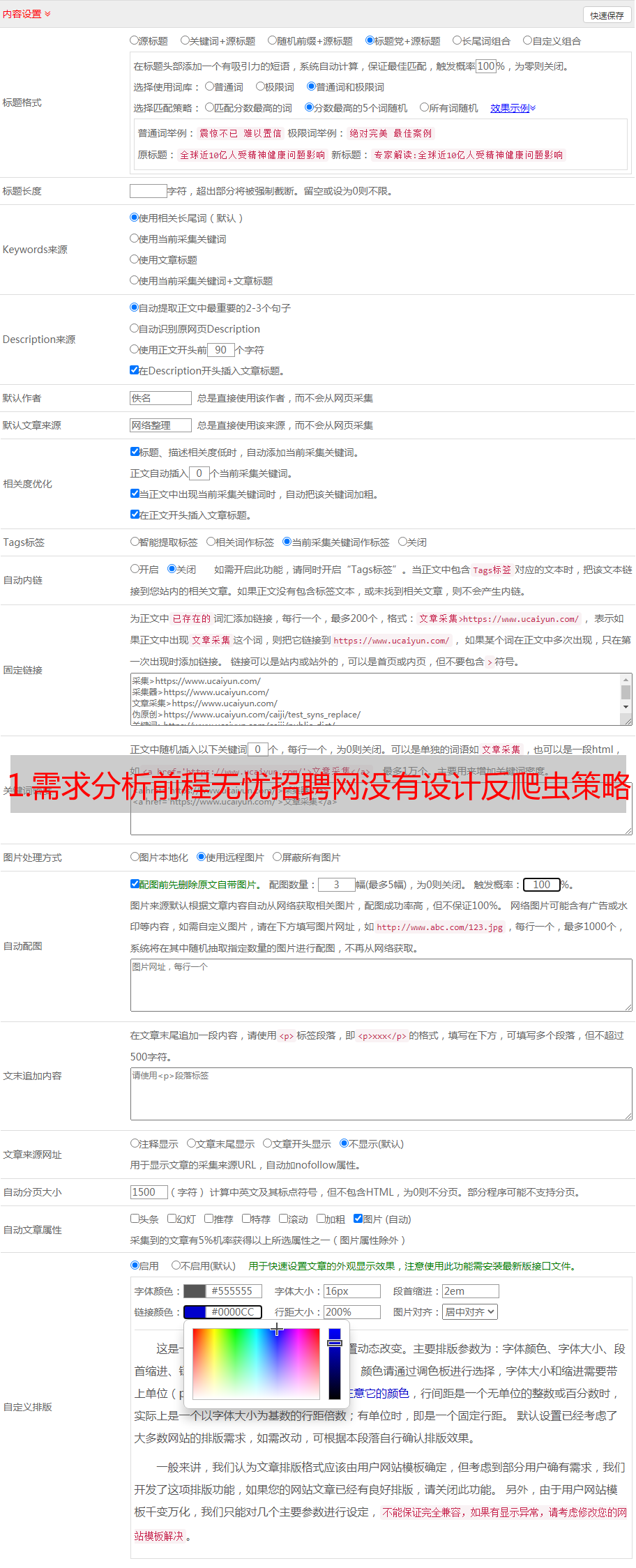

内容:

1.分析每条招聘信息的内容,确定爬虫数据项,以数据库表结构的形式展示。

2.确定数据存储格式,在scrapy项目中编写数据存储相关代码。

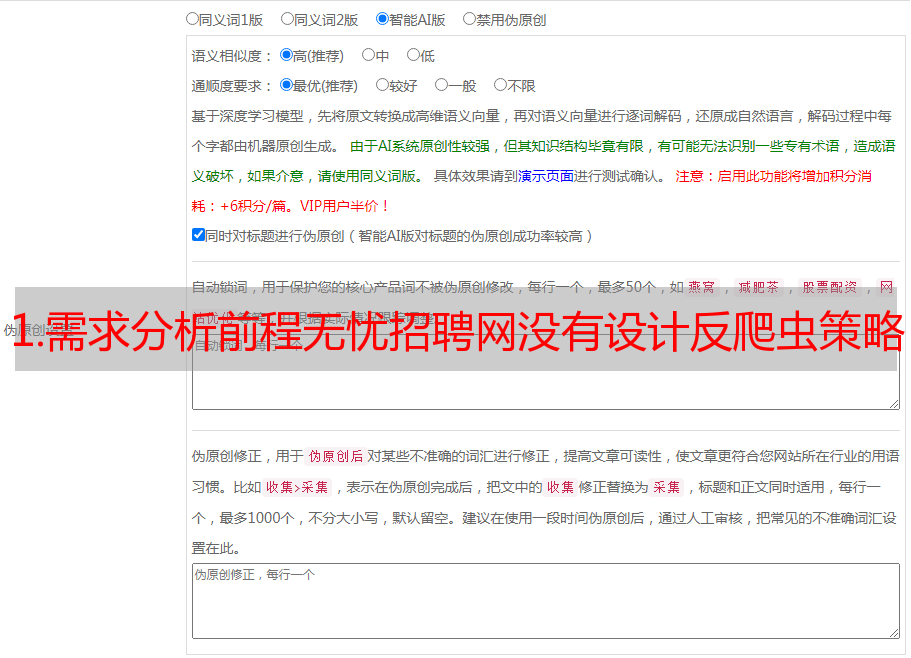

1.page 分析

在搜索列表页面,右击选择“查看网页源代码”,观察html页面结构。在html页面中,发现检索到的job数据混合在一个JavaScript脚本中,数据格式为json。可以通过代码提取“window.SEARCH_RESULT=”后的json并解析。

接下来分析分页规则,通过点击分页的数字按钮,可以确定“.html?”之前的数字。在 URL 地址中是页码。因为请求的URL地址太长,尽量去掉多余的参数。测试发现URL地址中问号后的请求参数可以省略。最简单的url地址格式为“,000000,0000,00,9,99,搜索关键字,2,页码.html”。

2.crawler 写作

在正式写爬虫之前,需要思考几个问题,形成一个基本的爬虫写作思路。问题如下:

如何处理多个搜索关键词,如“大数据开发”、“算法”、“爬虫”等

如何处理多页数据的分页和爬取

如何保存关键字检索关键字

数据库显示