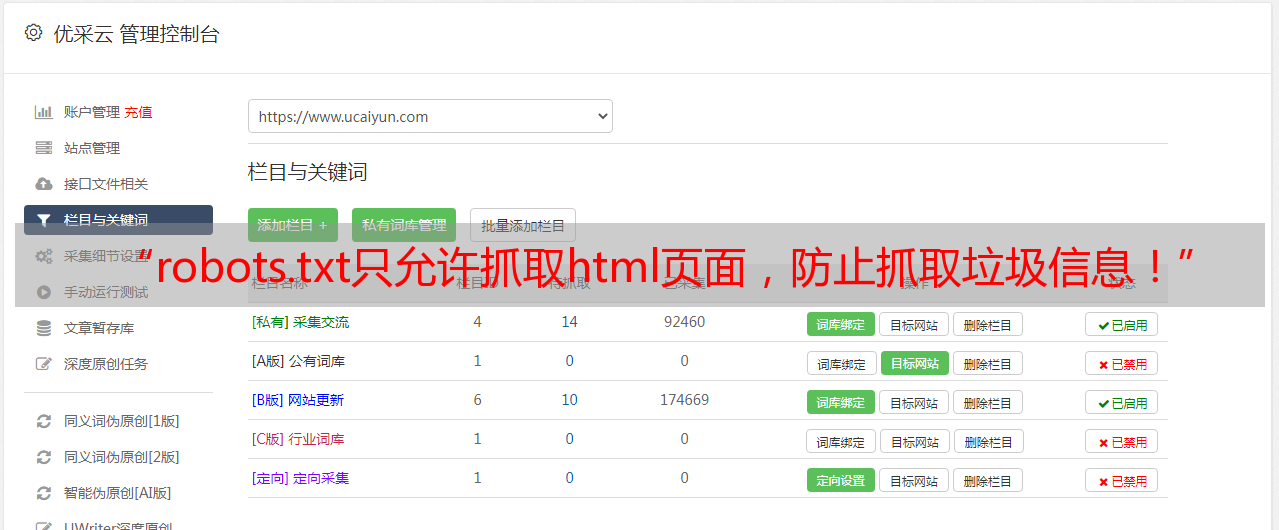

“robots.txt只允许抓取html页面,防止抓取垃圾信息!”

优采云 发布时间: 2021-08-03 20:12“robots.txt只允许抓取html页面,防止抓取垃圾信息!”

今天给大家详细讲解“robots.txt只允许抓取html页面,防止垃圾邮件!”在网站过去的几年里,我们经常遇到客户。 网站被挂马,原因是不利于维护网站,或者使用市面上开源的cms,直接下载源码安装使用,不管有没有漏洞和后门,所以造成,后来被挂马入侵,产生大量垃圾非法页面,被百度抓取。

一些被挂马的人很惊讶,为什么他们的网站正常内容不是收录,而是百度收录垃圾页面的非法内容很大。事实上,这很简单。在哪些非法页面,蜘蛛池链接,这会导致这个问题。即使我们解决了网站被挂马的问题,网站上的垃圾页面也会继续被百度抓取,死链需要很长时间才能生效。这个时候我该怎么办?我们可以使用robots.txt来解决这个问题。

实现原理:

我们可以使用robots.txt来限制用户只能抓取HTMl页面文件,我们可以限制指定目录中的HTML,阻止指定目录中的HTML文件。让我们为robots.txt制作一个写入方法。你可以自己研究一下。实际上将它应用到你的网站。

可以解决的挂马形式:

这个robots写规则主要是针对上传类型的挂马,比如添加xxx.php?=dddd.html;xxxx.php;上传不会被百度抓取,降低网络监控风险。

#适用于所有搜索引擎

用户代理:*

#Allow homepage root directory/ 并且不带斜杠,例如

允许:/$

允许:$

#File 属性设置为禁止修改(固定属性,入口只能是index.html/index.php)

允许:/index.php

允许:/index.html

#允许抓取静态生成的目录,这里是允许抓取页面中的所有html文件

允许:/*.html$

#禁止所有带参数的html页面(禁止爬马挂马的html页面)规则可以自己定义

禁止:/*?*.html$

禁止:/*=*.html$

#Single entry is allowed, only allowed, with?不能。index,其他的html,带符号,是不允许的。

允许:/index.php?*

#允许资源文件,允许网站上,图片截取。

允许:/*.jpg$

允许:/*.png$

允许:/*.gif$

#除上述内容外,禁止抓取网站中的任何文件或页面。

禁止:/

比如我们网站挂了的时候,邮戳通常是一样的。 php?unmgg.html,或 dds=123.html。这种,只要收录网址?当然,你可以在,= 的符号中添加更多的格式,比如带下划线“_”,你可以使用“Disallow:/_*.html$”来防御。

再比如:马的链接是一个目录,一个普通的URL,比如“seozt/1233.html”,可以加一条禁止规则“Disallow:/seozt/*.html$”,这个规则是告诉搜索引擎,只要是seozt目录下的html文件,都是爬不出来的。你听得懂么?其实很简单。你只需要熟悉它。

这种写法的优点是:

首先,蜘蛛会爬取你的核心目录、php目录和模板目录。会浪费大量的目录资源。对了,如果我们屏蔽目录,就会在robots.txt中暴露我们的目录,其他人就可以分析了。我们正在使用什么样的程序,对吧?这时候我们采用反向模式操作,直接允许html,拒绝其他一切,这样就可以有效的避免暴露目录的风险,对,好吧,今天就解释到这里,希望大家能理解。