维基百科:Web搜寻器开发的免费开放源代码(图)

优采云 发布时间: 2021-07-08 22:52维基百科:Web搜寻器开发的免费开放源代码(图)

来自维基百科

网络爬虫(有时称为蜘蛛)是互联网机器人,通常系统地浏览网络索引以进行网络索引。

网络爬虫从要访问的 URL 列表(称为*敏*感*词*)开始。当爬虫访问这些 URL 时,它会识别页面中的所有超链接,并将它们添加到要访问的 URL 列表中。如果爬虫正在执行网站的归档,它会复制并保存信息。存档称为存储库,旨在存储和管理网页集合。存储库类似于任何其他存储数据的系统,例如现代数据库。

让我们开始吧! !

Metasploit

这个辅助模块是一个模块化的网络爬虫,可以与wmap(有时)或独立使用。

使用辅助/爬虫/msfcrawler

msf 辅助(msfcrawler)> 设置 rhosts

msf 辅助(msfcrawler)> 漏洞利用

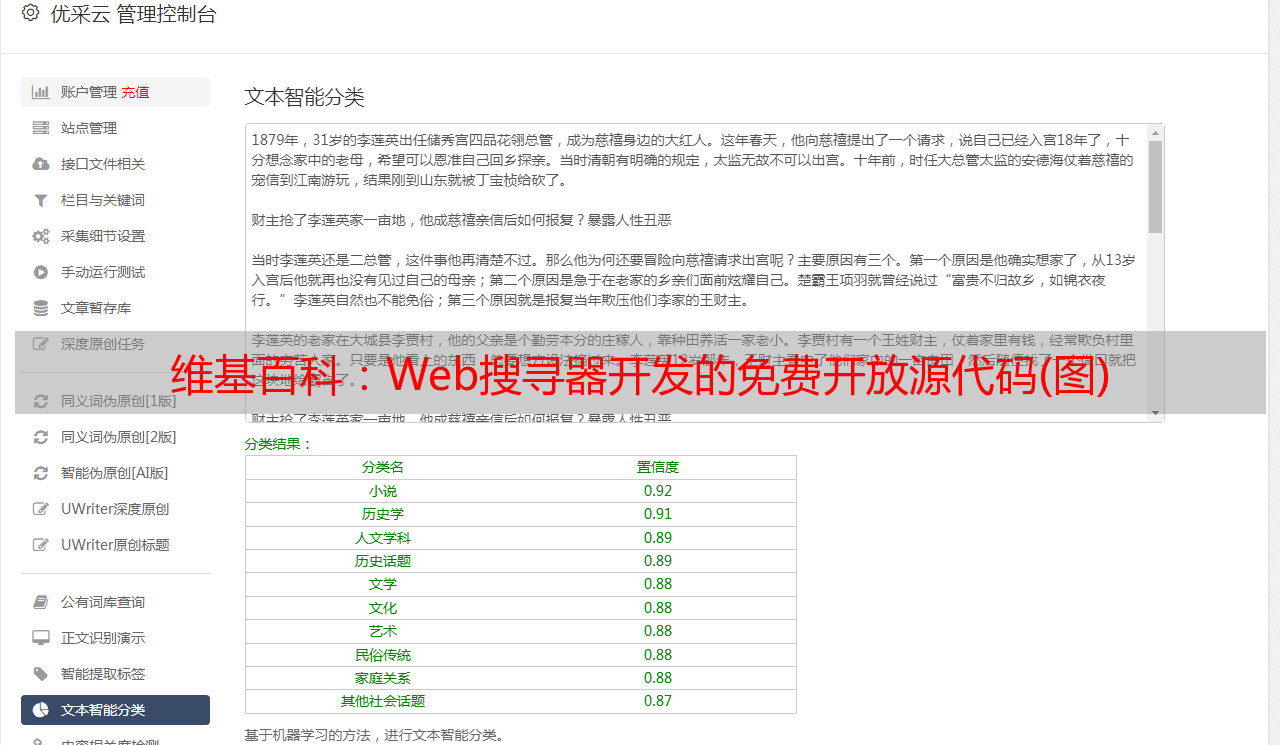

从截图中可以看到截图已经加载了搜索引擎,这样就可以对任何网站准确隐藏文件,比如about.php、jquery联系表单、html等,同时使用浏览器无法准确隐藏网站。为了采集任何网站信息,我们可以使用它。

Httrack

HTTrack 是 Xavier Roche 开发的免费开源网络搜索器和离线浏览器

它可以让你将网上的wanwei网站dots下载到本地目录,递归构建所有目录,从服务器获取HTML、图片等文件到电脑。 HTTrack 整理原站的相对链接结构。

在终端输入以下命令

httrack –O /root/Desktop/file

它将输出保存在给定的目录 /root/Desktop/file 中。

从给定的屏幕截图中,您可以观察到这一点,它使网站 信息包括 html 文件以及 JavaScript 和 jquery 变得愚蠢

黑寡妇

此Web Spider实用程序检测并显示用户选择的网页的详细信息,并提供其他网络工具。

BlackWidow 干净、合乎逻辑的标签式界面足够简单,适合中级用户,但在底部足以满足高级用户的需求。只需输入您选择的 URL,然后按 Go。 BlackWidow 使用多线程快速下载所有文件和测试链接。对于小网站,这个操作只需要几分钟。

您可以从这里下载。

在地址字段中输入您的 URL,然后按 Go。

点击开始按钮开始扫描左边的网址,然后选择一个文件夹来保存输出文件按钮。

从截图中可以看出,我浏览了 C:\Users\RAJ\Desktop\tptl 以便将输出文件存储在其中。

打开目标文件夹tptl,会得到网站图片或内容的完整数据,html文件、php文件和JavaScript都存储在里面。

网站开膛手复印机

Website Ripper Copier (WRC) 是一种通用高速网站downloader 软件,用于保存网站 数据。 WRC 可以将网站 文件下载到本地驱动器进行离线浏览,提取特定大小和类型的网站 文件,例如图像、视频、图片、电影和音乐,并充当具有恢复支持的下载管理器 检索大量的文件和镜像站点。 WRC 还是站点链接验证器、资源管理器和选项卡式反弹网页/离线浏览器。

Website Ripper Copier 是唯一可以从 HTTP、HTTPS 和 FTP 连接恢复中断下载、访问受密码保护的 网站、支持 Web Cookie、分析脚本、更新检索到的 网站 或文件并启动 50 @K14 的下载用于多个检索线程的@downloader 工具

您可以从这里下载。

选择“离线浏览网站(网站)”选项。

输入网站URL 并点击下一步。

提取目录路径保存输出结果,然后点击立即运行。

当你打开选定的文件夹 tp 时,你会在其中看到 CSS、php、html 和 js 文件。

Burp Suite Spider

Burp Spider 是一款自动抓取 Web 应用程序的工具。通常最好手动映射应用程序,但对于非常大的应用程序或时间不足的情况,可以使用 Burp Spider 来部分自动化此过程。

欲了解更多详情,请从这里阅读我们之前的文章。

从给定的截图中,您可以观察到我获得的http请求;现在它在“Operation”标签的帮助下发送给Spider。

Target网站 已添加到站点地图中“目标”选项卡下的位置,作为网络爬行的新范围。从截图中可以看出,它启动了对目标网站 的网络爬虫。在这个网站中,它以php、html和js的形式采集了网站信息。

作者:Aarti Singh 是 Hacking Articles(信息安全顾问、社交媒体爱好者和小工具)的研究员和技术作家。入侵