Robots协议能更好的辅助搜索引擎蜘蛛抓取网站提高效率

优采云 发布时间: 2021-07-08 00:11Robots协议能更好的辅助搜索引擎蜘蛛抓取网站提高效率

robots.txt是搜索引擎蜘蛛访问网站时首先查看的文件,会根据robots.txt文件网站的内容进行爬取,上网网站刚,或者网站改版在工作中,也是一个很重要的环节。今天格网就和大家分享:如何写robots文件以及robots文件在网站optimization上的作用

Robots 协议可以更好的辅助搜索引擎蜘蛛爬取我们的网站,提高爬取效率。如果网站当天上线没有修改完成,可以使用Disallow:/来屏蔽整个站点。

robots.txt 是网站 根目录下的一个文件。不是给用户看的,而是给搜索引擎看的。 robots的意思可以翻译成搜索引擎robots,即搜索引擎发送的爬取网站页面的蜘蛛,而robots文件是蜘蛛爬取网站时首先需要经过的。您可以通过 robots 文件来澄清自己。访问权。图片的解读可以看作是限制某些蜘蛛进入网站,限制进入网站的蜘蛛访问网站内容权限。从某种意义上说,它的任务之一就是引导蜘蛛爬行,减少搜索引擎蜘蛛的工作量。

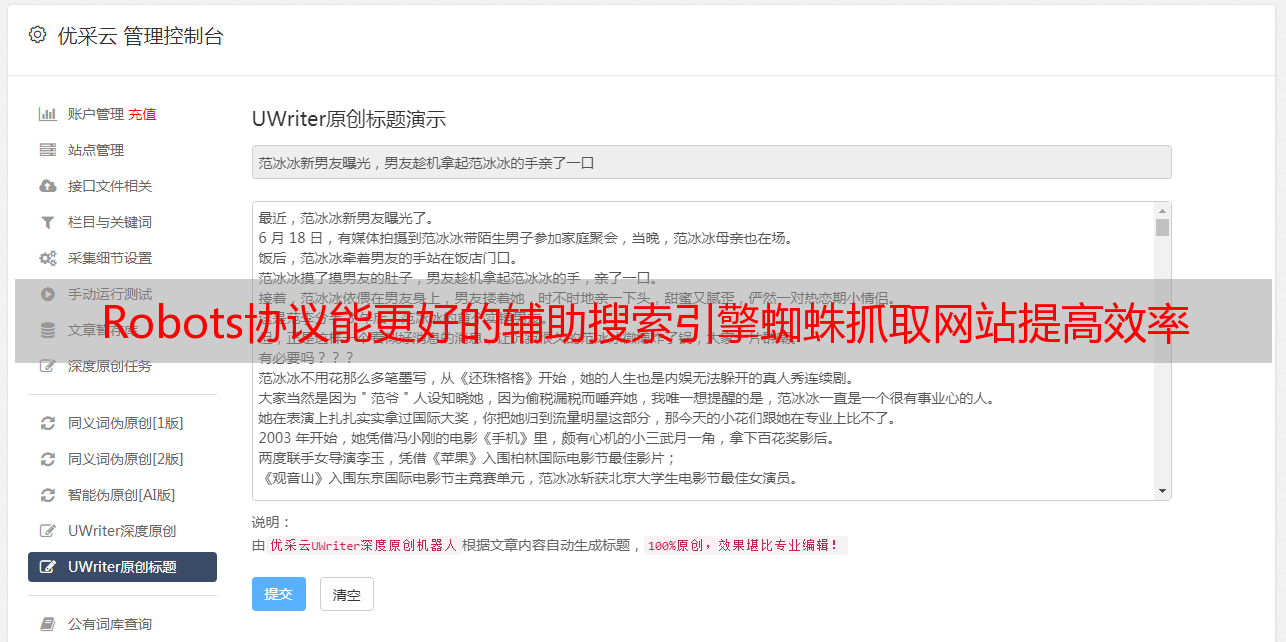

下图显示了我们网站robots 文件的内容。 User-agent: * 第一行表示后面的Disallow命令是针对所有搜索引擎的,也可以改为单个搜索引擎。 Disallow后的内容不允许搜索引擎抓取收录内容。

1、自定义搜索引擎:

使用User-agent:定义搜索引擎,其中*表示全部。百度蜘蛛名:Baiduspider,谷歌蜘蛛名:Googlebot

User-agent: * 表示定义所有蜘蛛

User-agent:Baiduspider 表示这个爬取命令是针对百度蜘蛛的

User-agent:Googlebot 表示此抓取命令针对的是 Google 蜘蛛

2、Forbidden 并允许访问:

禁止所有搜索引擎访问:

用户代理:*

禁止:/

======华丽的分割线======

允许所有搜索引擎访问:

用户代理:*

允许:/

注意::前/后有一个英文空格,空格必须在那里,而且必须是英文

3、禁止搜索引擎访问爬虫询问网站中的一些目录:

假设[abc]是我网站根目录下的一个文件夹,写法如下:

用户代理:*

禁止:/abc

禁止搜索引擎访问abc文件夹和abc文件夹下的所有文件

======华丽的分割线======

用户代理:*

禁止:/abc/

禁止搜索引擎访问abc文件夹下的所有文件,但允许访问abc文件夹

4、 禁止搜索引擎爬虫访问某些类型的文件:

比如我们要禁止搜索引擎蜘蛛访问css、js、php等文件,可以这样写:

用户代理:*

禁止:/*.css$

禁止:/*.js$

禁止:/*.php$

注:*表示全部,$表示结束

我知道robots文件怎么写,但是robots文件对网站seo优化有什么用呢?推动网站优化推广主要有以下五个方面。因为robots文件是给搜索引擎用的,用好可以增加搜索引擎爬取网站的体验,从而增加网站收录的数量。

1.屏蔽网站的空链接和死链接

由于网站内容的修改和删除,很容易导致网站中的一些内部链接失效,变成空链接或死链接。通常我们会定期检查网站的空链接和死链接,将这些链接提取出来写入robots文件,防止搜索引擎爬取链接,间接提升搜索引擎体验。这种方法是有效的,因为当收录的内容被修改时,搜索引擎会再次抓取修改后的网页,并判断是否再次进行收录。如果收录不继续,那你就得试试Up。

2. 防止蜘蛛爬取网站duplicate 内容

因为网站很多动态页面搜索引擎无法收录,所以很多时候我们需要为这些动态页面开发一个静态页面来帮助搜索引擎收录。这时候让搜索引擎不要抓取某些重复的内容,可以减少网站上关键词weight的竞争。

3.防止蜘蛛爬取无意义的内容,浪费服务器资源

网站上有很多内容都是无意义的内容,比如网站的各种脚本代码,css文件和php文件等等,这些文件对网站优化毫无意义,爬取这些网站不仅不会收录,还会浪费服务器资源。上图中很多被禁止的内容就是这种无意义的文件目录。

4.protect网站隐私内容

网站 有很多具有一定隐私性的页面,比如用户收到的推送或者购物车等,这些链接虽然在一个页面中,但显然不希望搜索引擎抓取内容.

5. 适合网站debugging

网站初期上线,或者网站改版前,会有一定的错误。需要一段时间的调试,然后打开抓取到搜索引擎。调试时可以将robots文件设置为所有的搜索引擎都处于拒绝爬取状态,所有错误解决后可以修改robots文件。

需要注意的是:每次修改robots文件都需要向搜索引擎站长平台提交robots文件更新提醒,因为搜索引擎更新@k14的状态需要一定的时间@,只能手动提交。让更新后的 robots 文件立即生效。

robots文件怎么写,以及robots文件对网站优化的作用——格网分享就到这里。 robots文件在网站刚上线或者网站修改时很重要,对于网站optimization的作用很明显,希望对大家有帮助。如果您有更好的SEO优化建议,或者您的网站想获得更好的关键词排名,格网欢迎您交流。