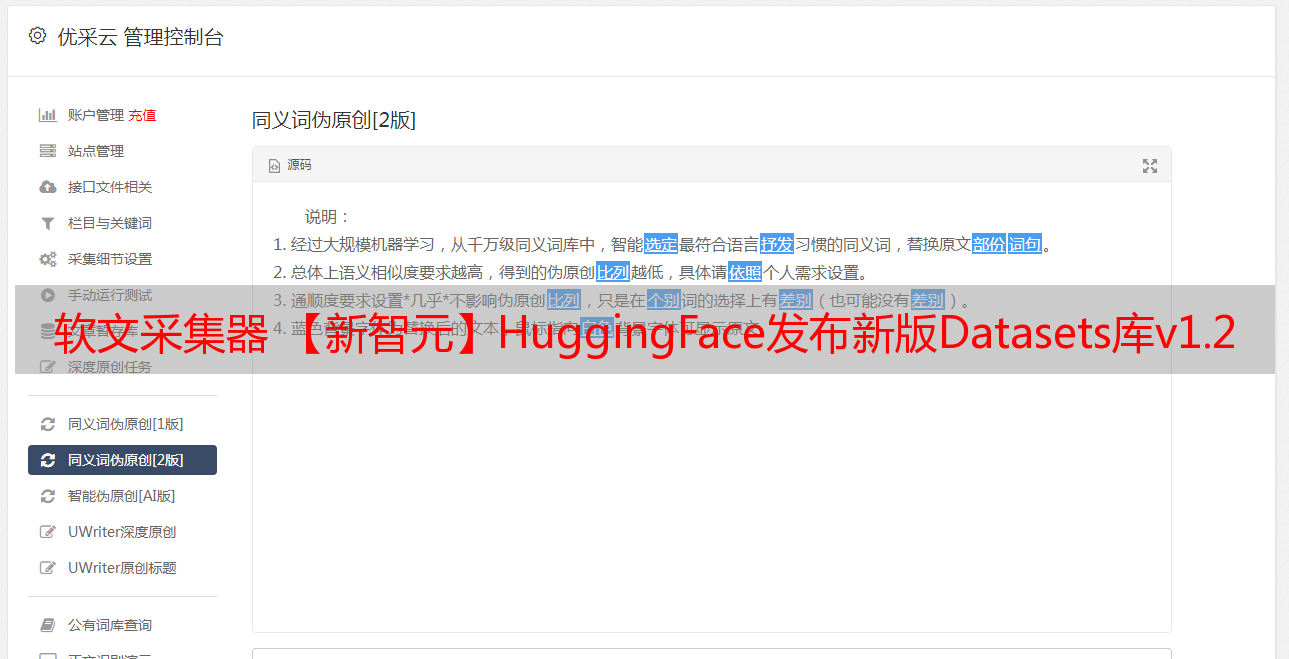

软文采集器 【新智元】HuggingFace发布新版Datasets库v1.2

优采云 发布时间: 2021-07-01 22:36软文采集器 【新智元】HuggingFace发布新版Datasets库v1.2

【致远新攻略】HuggingFace最近发布了新版Datasets库v1.2,收录611个文本数据集,一行python即可下载使用;涵盖467种语言,其中99种至少收录10个A数据集;当使用非常大的数据集(默认为内存映射)时,高效的预处理可以让用户摆脱内存限制。

说起 Hugging Face,熟悉 NLP 的人可能都不知道。

Hugging Face 是一家领先的 NLP 创业公司,有超过一千家公司在使用他们的产品库,包括 Bing、Apple、Monzo 等。

它有一个庞大的开源社区,尤其是transformer库。 Transformers 是一个基于 Python 的库,它公开了一个 API 以使用许多著名的转换器架构,例如 BERT、RoBERTa、GPT-2 或 DistilBERT。这些架构可以为各种 NLP 任务获得 SOTA 结果,例如文本分类和信息提取、问答和文本生成。

这些架构都是通过预训练加权的。可以通过pip命令安装:

更新的数据集是一个轻量级的库,提供两个主要功能:

单行程序处理:这是一个单行程序(使用 467 种语言和方言),用于下载和预处理任何主要公共数据集,可在 HuggingFace Datasets Hub 中获得。

使用简单的命令,例如:

小队_数据集=加载_数据集(“小队”)

可以得到这些数据集中的任何一个,可以用来训练/评估数据中的ML模型采集器(

Numpy/Pandas/PyTorch/TensorFlow/JAX)。

高效的数据预处理:简单、快速、可重现的数据预处理,可用于上述以CSV/JSON/text编写的公共数据集和本地数据集。使用简单的命令,例如:tokenized_dataset = dataset.map(tokenize_exemple),可以有效地准备数据集用于测试和ML模型评估和训练。

Datasets 还提供了超过 15 个评估指标,旨在让社区可以轻松添加和分享新的数据集和评估指标。

数据集还有许多其他有趣的特性:

将用户从RAM内存限制中解放出来,所有数据集都使用有效的零序列化开销后端(Apache Arrow)进行内存映射;

智能缓存:无需多次等待数据处理;

使用透明和pythonic API(多处理/缓存/内存映射)实现轻量级和快速;

与 NumPy、pandas、PyTorch、Tensorflow 2 和 JAX 的内置互操作性。

安装和使用

数据集可以从 PyPi 安装,并且必须安装在虚拟环境中(例如 venv 或 conda):

pip 安装数据集

如果要使用Datasets和PyTorch(1.0+)、TensorFlow(2.2+)或Pandas等,还需要安装相应版本的框架和库。

Datasets 使用起来非常简单,主要方法有:

1.datasets.list_datasets() 列出可用的数据集

2.datasets.load_dataset(dataset_name, **kwargs) 实例化一个数据集

3.datasets.list_metrics() 列出可用的指标

4.datasets.load_metric(metric_name, **kwargs) 实例化一个指标

举个简单的例子:

更详细的信息可以查看文档中的快速浏览页面: