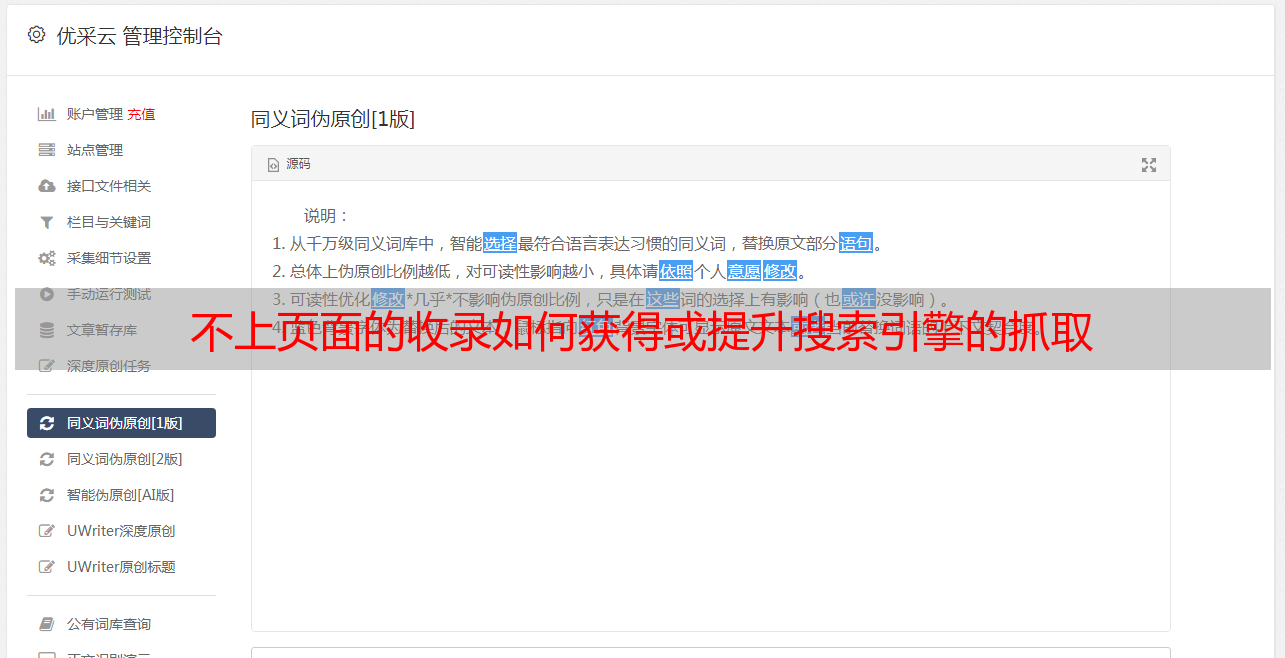

不上页面的收录如何获得或提升搜索引擎的抓取

优采云 发布时间: 2021-06-19 02:05不上页面的收录如何获得或提升搜索引擎的抓取

【SEO基础】如何系统地做SEO-web爬虫。如果你没有爬虫,那你就不能在页面上谈论收录。如何获取或提高搜索引擎的抓取?

页面创建完成后,接下来面临搜索引擎的就是提交sitemap文件,蜘蛛会通过提交文件进行爬取。然后你就可以通过网站的访问日志观察有哪些搜索引擎抓取了你的页面。每天抓取频率的状态码状态。

对于百度蜘蛛,可以从百度站长工具中的异常抓取和抓取频率中看出。建议每天检查一次。比如抓取频率的增减虽然不会直接影响你的流量变化,但还是有间接关系的。抢得越多,越有利于增加收录的数量。当然,这里还有一个前提:页数要尽可能多。毕竟,一个收录5000 的页面要获取 1000 次是不可能的。

在提升爬虫方面,针对页面访问速度和合理的站点链接交叉推荐,让更新的、相关性更强或更有效的文章更频繁地出现在自己的站点中以提高爬虫,收录非常很有帮助。

上图主要介绍了蜘蛛抓取网页的过程:一般蜘蛛抓取网页分为主动抓取和异地引导两种路径。这里特别提醒一下,百度还有自动推送和主动推送功能,用于提交自己页面的URL地址给百度。

无论采用何种推送方式,目的都是希望蜘蛛能够过来主动抓取我们的网站页面。说一下主动爬取和异地引导的爬取过程:

蜘蛛主动抓取页面时,会先输入网站。这时候就需要判断是否有robots文件。机器人文件是基于互联网社区盛行的道德规范,蜘蛛必须遵守机器人原则。这个文件的作用是告诉蜘蛛是否可以爬取网站,可以爬取网站的哪些页面。机器人发布后,蜘蛛首先会找到网站的站点地图文件。现有的sitemap文件可以有效提高蜘蛛的爬行效率,降低爬行成本。如果没有sitemap,蜘蛛就会开始在你的网站目录中寻找文件(一般按照robots指定的规则)。蜘蛛找到文件后,会通过页面内的链接一一往下爬。

异地引荐和主动爬取的区别在于,蜘蛛爬到你在第三方网站上的网站链接,然后输入你的网站进行爬取,第一步是找到robots文件,下面的过程基本相同。

原创文章,作者:凌格SEO,如转载请注明出处: