处理待下载网页,如何处理可知但未可知网页。

优采云 发布时间: 2021-06-16 19:14处理待下载网页,如何处理可知但未可知网页。

处理要下载的网页;广度优先遍历策略;目标策略;大网站优先;更新下载的网页;历史参考;用户体验;抓取不可知的网页;丰富的信息查询模板;单词组合

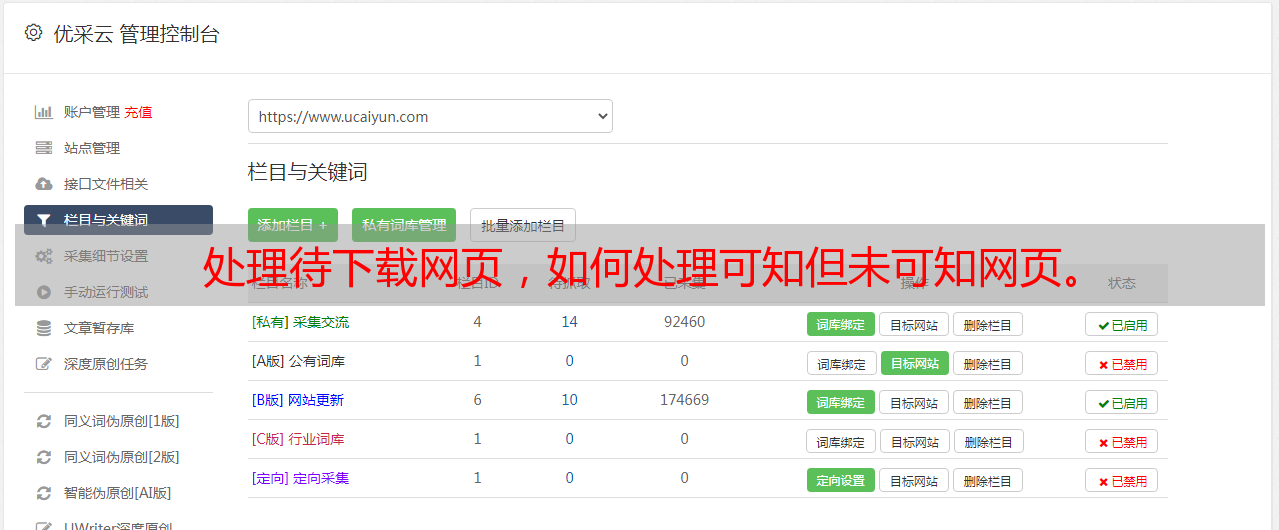

图片11322-1:

最近在看一本书,发现没有实践就直接看原理很枯燥乏味,但是当我们在实践后看原理的时候,我们会感到很多道理,很多感悟。 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .拿我当负面教科书,说我是搜索引擎优化工作者。不了解搜索引擎的工作方式、基本的爬取原理、更新策略。你呢?下面分享一下我的阅读笔记,仅供识字新手。

在介绍搜索引擎爬虫之前,先了解一下爬虫对网页的分类,有四种:

1、过期网页和下载网页

2、要下载的页面

3、知道网页

4、未知网页

下面我将详细讲解搜索引擎如何更新已下载的网页,如何下载需要下载的网页,如何处理已知但未抓取的网页,以及如何抓取不可知的网页。

一个。处理要下载的网页

爬取策略:在一堆已知的网页中,搜索引擎会提取要爬取的网页的网址,爬虫将网页的网址排列成一个队列。调度器每次都会从队列的头部取出某个 URL。 , 将其发送到网页下载器进行内容下载,每个新下载的页面中收录的URL都会被追加到抓取队列的末尾,形成一个循环。这是最基本的算法。但这不是唯一的方法。

这纯粹是为了抓取,但是搜索引擎一般都会选择重要的页面先抓取。网页的重要性主要是根据网页流行度来获取的。对于网页的流行度,谷歌的官方说法是指曝光,通俗地说就是反向链接。 (这就是为什么有这么多人在做外链)

选择重要页面一般有四种选择:宽度优先遍历策略、非完全pagerank(非谷歌pr值)策略、ocip策略、大站点优先策略

1、Width-first traversal 策略:将新下载的网页中收录的链接直接追加到 url 队列的末尾进行爬取。看起来很机械,但实际上收录了一些优先级策略:如果链接越多,越容易被广度优先遍历策略所捕获。链接的数量显示了网页的重要性。 (这就是为什么我们需要制作一个好的站点链接)

2、不全pagerank:上一个是数量,这个是质量。

初始算法:将下载的网页加入到要下载的URL队列中,形成一个网页集合,计算这个集合中的pr,然后根据pr重新排列队列进行抓取,然后按照这个顺序抓取。

(每次下载新网页后重新计算排序效率太低)

每次保存 k 页时重新计算。但问题是:新提取的网页在计算pr后没有pr值,其重要性可能比已经在队列中的要高。我该怎么办?

解决方案:为每次新抽奖分配一个临时 pr。这个临时 pr 是基于传入链中的 pr 值的汇总值。这样,在计算之下,如果高于队列,就限制抢他了。这是不完整的pr

(更高的pr会先被抓取,收录multi-ranking排名更高的几率会更高,所以会有很多人提高spr)

3、ocip(在线页面重要性计算)策略:在线页面重要性计算,改进pr算法。

在算法开始之前,每个页面都会获得相同数量的*敏*感*词*。当这个页面被下载时,*敏*感*词*被平均分配到他导出的页面上,而他自己的则被清空。这些导出的页面被放入有抓取的队列中,根据*敏*感*词*的多少先抓取。

pr和pr的区别:pr的前一页没有清零,每次都要重新计算,但是这次清零不重新计算。而且pr有一个没有连接关系的跳转,只要没有连接就不会转移*敏*感*词*。

4、大站优先:抢队列中网站多的先抢。 (所以网站应该页面丰富,内容丰富)

二、更新下载的网页

以上是搜索引擎的爬取策略。抓取的页面会添加到下载的页面中。下载的页面需要不断更新,那么搜索引擎如何更新?

一般网页更新策略:历史参考策略、用户体验策略、聚类抽样策略

1、History 参考:过去更新频繁的,现在也可能更新频繁。使用模型来预测未来的更新时间。忽略导航栏和广告的频繁更新,所以导航的频繁更新没用,重点在内容上(现在我知道为什么要继续更新内容了吧?)

2、用户体验:即使网页已经过时,需要更新,如果我更新了,如果不影响用户体验,搜索引擎也会更新。算法是:网页更新对搜索引擎搜索质量的影响(一般以排名为准),影响大就尽快更新。因此,他们会保存多个历史网页,并根据上次更新的影响来判断更新对搜索引擎质量的影响。

以上两个缺点:依赖历史,需要保存大量历史数据,增加负担。如果没有历史,就不准确。

3、Clustering 抽样策略:对网页进行分类,根据同一类别网页的更新频率,更新该类别的所有网页。取最有代表性的一个,看它的更新频率,未来同行业都会遵循这个频率。

三、抓取未知网页

不可知的网页是暗网,搜索引擎很难使用常规方法捕获数据。例如网站,未连接的数据库。例如,对于产品库存查询,您可能需要输入产品名称、地区和型号等一系列文本来查询库存数量。搜索引擎很难抓取。这有查询组合和 isit 算法。

先介绍下两个概念:

1、 丰富的信息查询模板:比如一个查询系统,我设置了一个查询模板,每个文本框输入信号、地区、产品名称等,形成不同的查询组合。不同组合差异较大,信息查询模板丰富。

这个模板是如何确定的?爬虫从一维模板开始。例如输入区域而不是输入,看看它是否是一个信息丰富的查询模板。如果是,就会展开成二维模板,比如region+model。以这种方式增加维度,直到没有新模板。

2、词的组合:也许你会疑惑,爬虫怎么知道在这个输入框中输入什么,是地区,产品名称,还是时间?所以爬虫开始需要人工提示,人工提供一些初始查询*敏*感*词*表。爬虫用这个表单查询下载页面,然后分析页面,自动挖掘新的关键词,形成新的查询列表,然后将结果提交给搜索引擎,直到没有新内容为止。

这样就完成了对暗网的爬取。

以上只是对爬虫的爬取更新框架的简单介绍。具体的算法要复杂得多。等我慢慢研究后再分享。