事实:坚持原创但是还是没有排名 怎么破

优采云 发布时间: 2022-12-25 20:00事实:坚持原创但是还是没有排名 怎么破

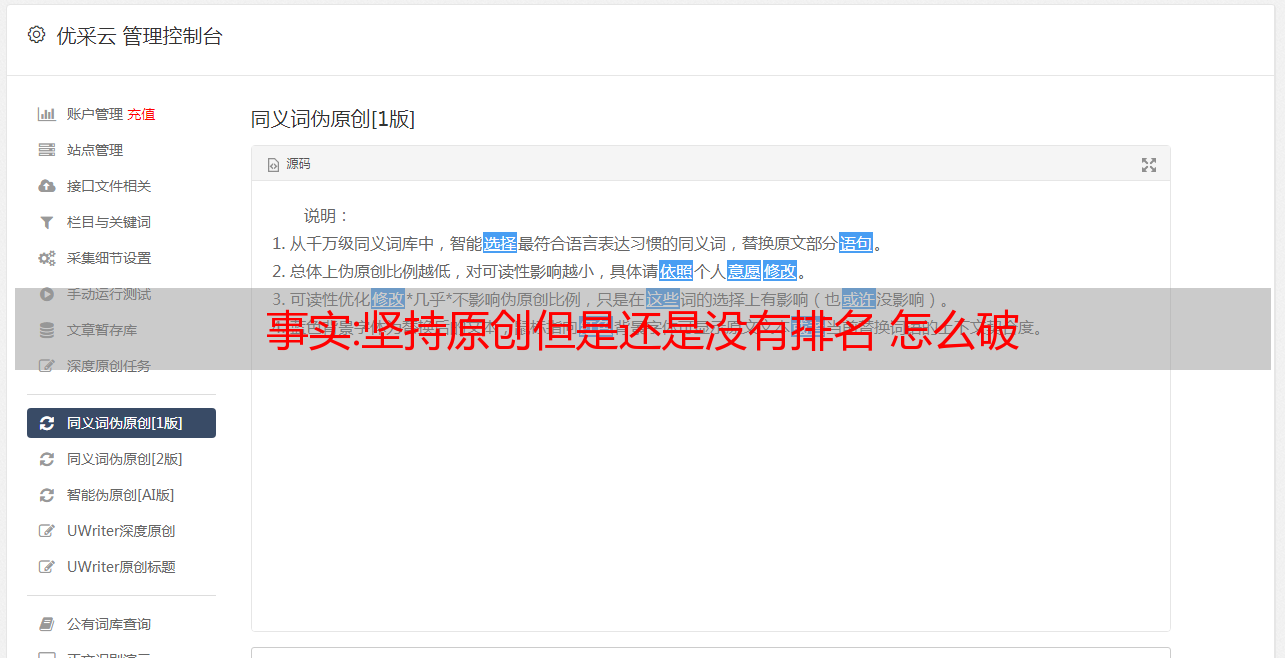

很多易友seo优化人员苦恼的一件事是,自己一直苦心写原创文章,网站的优化排名却提不上去,而那些非原创文章的网站排名很好,而文章不被引擎搜索收录,不能给网站带来流量,但有人认为,能增加网站流量和权重的不仅仅是原创文章。 排名靠前的网站很多,这些网站的内容都不是很原创。 相反,还有大量的转载和伪原创内容。

SEO原创文章

对于这一点,很多人强行划清了原创和伪原创的界限,进一步模糊了网站的目的。 我们希望用户通过关键词访问我们的网站,并给予他们权威可信的信息反馈。 并且我们可以在第一时间将时效原创和伪原创的内容发布到我们自己的网站上。 这就是网站伪原创的来源。 内容页留了很多,反之亦然,但是如果你原创的内容总是收不收录,你就应该反思整改的原因了。 可以从以下几个方面找到问题的根源。

网站质量差

1、网站整体质量差

如果内容太差,收录时搜索引擎会提出更高的要求,但也不排除文章收录不发布。 一旦网站被存储在沙箱中,它就会对网站进行观察并等待它。 检查之后,文章自然会有展示的机会,而且这种可能性占比非常高。

2.广告弹窗

所谓的广告弹窗主要分为两种情况,一种是自愿弹窗,一种是主动弹窗,所以从理论上讲,无论你是做什么行为的弹窗,上窗。 即使你有优质的原创内容,如果让用户体验变差,也会相应地影响网站的好评,网站的排名肯定不会有理想的位置,甚至会造成实力下降。

3.交通概化

所谓流量泛化,就是原创文章不排名最容易被忽视的问题。 主要是指网站的垂直度。 如果你的网站结构过大,各个栏目之间的相关性不高,很容易造成网站内容专业,无法被搜索引擎很好的定位。 而你的原创内容比较宽泛,会造成页面权重无法集中的问题。 因此,即使要创建多个栏目,我们通常也不建议在网站之初就启用更多的站点栏目,而是建议在后期一点一点地扩充。

4、搜索引擎算法更新

现在是互联网内容泛滥的时代,真正的原创并没有统一的标准。 网络上出现了大量的文章,难免有些重复的句子。 搜索引擎毕竟是机器,很难做到。 以绝对准确的标准来说,有时候误杀误判是在所难免的,所以即使你的原创文章质量很高,也难免掉进这么小的漏洞。

搜索引擎优化内容

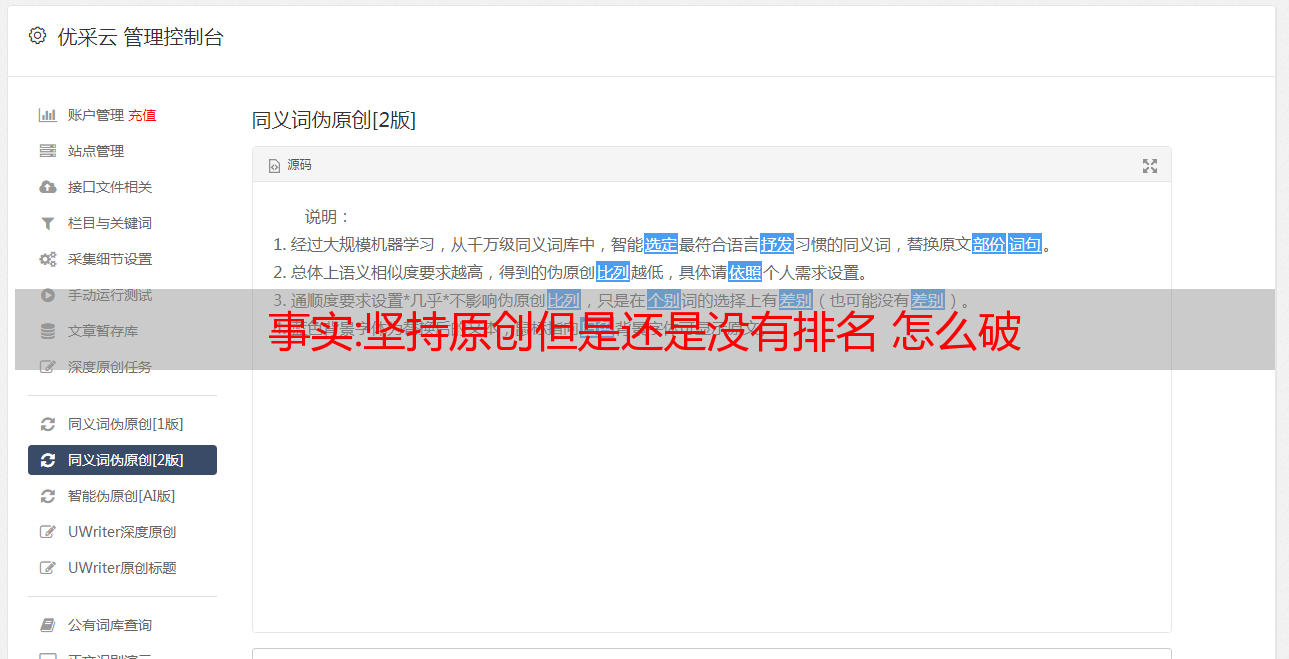

5.不要强行定义文章的原创概念

会收录原创文章吗? 伪原创文章会不会被收录? 答案是否定的,如果是你自己想出来的原创内容,但是如果文章的观点与其他网站雷同或雷同,可读性不强,没有时效性,相应的受众就会小,你的文章可能会被判断为低质量的原创文章。 这样的文章对搜索引擎来说价值极低,被收录的可能性也很低。

相反,如果是伪原创文章,你修改标题,加图片,加评论,文章周围出现相关推荐,那你的伪原创文章内容就会出现“收获”。 对于这样的伪原创文章内容,搜索引擎没有收录不收录。 确定一件事:真正能给用户带来价值的内容,搜索引擎收录该页面的概率更高。

因此,优质原创内容的不断注入,辅以内容增益的伪原创内容和转载内容,才能打造出对搜索引擎友好的优质站点,相应的网站排名也会随之上升,所以站长们只能坚持长期高质量的内容更新才更有利于我们网站的优化。

大事件:python 简单爬取今日头条热点新闻(

今日头条在自媒体领域算是比较有实力的。 今天就带大家使用python爬取今日头条的热点新闻。 理论上可以无限爬行;

在浏览器中打开今日头条的链接,选择左侧的热点,在浏览器开发者模式网络中快速找到一个带有'?category=new_hot...'字样的文件,查看该文件可以找到该文件的数据新闻内容全部存储在data中,可以查到数据类型为json; 如下所示:

这样就简单了,只要找到这个文件的requests url,就可以通过python requests来爬取网页了;

查看请求的url,如下图:

找到的链接是:

一共有9个参数,对照下表:

其中获取到的json数据中获取了max_behot_time,具体数据如下截图所示:

在网上找了大佬对as和cp算法的解析,发现js文件中有两个参数:home_4abea46.js。 具体算法如下:

!function(t) {

var e = {};

e.getHoney = function() {

var t = Math.floor((new Date).getTime() / 1e3)

, e = t.toString(16).toUpperCase()

, i = md5(t).toString().toUpperCase();

if (8 != e.length)

return {

as: "479BB4B7254C150",

cp: "7E0AC8874BB0985"

};

for (var n = i.slice(0, 5), a = i.slice(-5), s = "", o = 0; 5 > o; o++)

s += n[o] + e[o];

for (var r = "", c = 0; 5 > c; c++)

r += e[c + 3] + a[c];

return {

as: "A1" + s + e.slice(-3),

cp: e.slice(0, 3) + r + "E1"

}

}

,

t.ascp = e

}(window, document),

复制

python获取as和cp值的代码如下:(代码参考博客:)

def get_as_cp(): # 该函数主要是为了获取as和cp参数,程序参考今日头条中的加密js文件:home_4abea46.js

zz = {}

now = round(time.time())

print(now) # 获取当前计算机时间

e = hex(int(now)).upper()[2:] #hex()转换一个整数对象为16进制的字符串表示

print('e:', e)

a = hashlib.md5() #hashlib.md5().hexdigest()创建hash对象并返回16进制结果

print('a:', a)

a.update(str(int(now)).encode('utf-8'))

i = a.hexdigest().upper()

print('i:', i)

if len(e)!=8:

zz = {'as':'479BB4B7254C150',

'cp':'7E0AC8874BB0985'}

return zz

n = i[:5]

a = i[-5:]

r = ''

s = ''

for i in range(5):

s= s+n[i]+e[i]

for j in range(5):

r = r+e[j+3]+a[j]

zz ={

'as':'A1'+s+e[-3:],

'cp':e[0:3]+r+'E1'

}

print('zz:', zz)

<p>

return zz</p>

复制

这样就形成了完整的链路。 还有一点就是:去掉_signature参数也可以得到json数据,这样请求的链接就完成了; 完整的代码附在下面:

import requests

import json

from openpyxl import Workbook

import time

import hashlib

import os

import datetime

start_url = 'https://www.toutiao.com/api/pc/feed/?category=news_hot&utm_source=toutiao&widen=1&max_behot_time='

url = 'https://www.toutiao.com'

headers={

'user-agent':'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/71.0.3578.98 Safari/537.36'

}

cookies = {'tt_webid':'6649949084894053895'} # 此处cookies可从浏览器中查找,为了避免被头条禁止爬虫

max_behot_time = '0' # 链接参数

title = [] # 存储新闻标题

source_url = [] # 存储新闻的链接

s_url = [] # 存储新闻的完整链接

source = [] # 存储发布新闻的公众号

media_url = {} # 存储公众号的完整链接

def get_as_cp(): # 该函数主要是为了获取as和cp参数,程序参考今日头条中的加密js文件:home_4abea46.js

zz = {}

now = round(time.time())

print(now) # 获取当前计算机时间

e = hex(int(now)).upper()[2:] #hex()转换一个整数对象为16进制的字符串表示

print('e:', e)

a = hashlib.md5() #hashlib.md5().hexdigest()创建hash对象并返回16进制结果

print('a:', a)

a.update(str(int(now)).encode('utf-8'))

i = a.hexdigest().upper()

print('i:', i)

if len(e)!=8:

zz = {'as':'479BB4B7254C150',

'cp':'7E0AC8874BB0985'}

return zz

n = i[:5]

a = i[-5:]

r = ''

s = ''

for i in range(5):

s= s+n[i]+e[i]

for j in range(5):

r = r+e[j+3]+a[j]

zz ={

'as':'A1'+s+e[-3:],

'cp':e[0:3]+r+'E1'

}

print('zz:', zz)

return zz

def getdata(url, headers, cookies): # 解析网页函数

r = requests.get(url, headers=headers, cookies=cookies)

print(url)

data = json.loads(r.text)

<p>

return data

def savedata(title, s_url, source, media_url): # 存储数据到文件

# 存储数据到xlxs文件

wb = Workbook()

if not os.path.isdir(os.getcwd()+'/result'): # 判断文件夹是否存在

os.makedirs(os.getcwd()+'/result') # 新建存储文件夹

filename = os.getcwd()+'/result/result-'+datetime.datetime.now().strftime('%Y-%m-%d-%H-%m')+'.xlsx' # 新建存储结果的excel文件

ws = wb.active

ws.title = 'data' # 更改工作表的标题

ws['A1'] = '标题' # 对表格加入标题

ws['B1'] = '新闻链接'

ws['C1'] = '头条号'

ws['D1'] = '头条号链接'

for row in range(2, len(title)+2): # 将数据写入表格

_= ws.cell(column=1, row=row, value=title[row-2])

_= ws.cell(column=2, row=row, value=s_url[row-2])

_= ws.cell(column=3, row=row, value=source[row-2])

_= ws.cell(column=4, row=row, value=media_url[source[row-2]])

wb.save(filename=filename) # 保存文件

def main(max_behot_time, title, source_url, s_url, source, media_url): # 主函数

for i in range(3): # 此处的数字类似于你刷新新闻的次数,正常情况下刷新一次会出现10条新闻,但夜存在少于10条的情况;所以最后的结果并不一定是10的倍数

ascp = get_as_cp() # 获取as和cp参数的函数

demo = getdata(start_url+max_behot_time+'&max_behot_time_tmp='+max_behot_time+'&tadrequire=true&as='+ascp['as']+'&cp='+ascp['cp'], headers, cookies)

print(demo)

# time.sleep(1)

for j in range(len(demo['data'])):

# print(demo['data'][j]['title'])

if demo['data'][j]['title'] not in title:

title.append(demo['data'][j]['title']) # 获取新闻标题

source_url.append(demo['data'][j]['source_url']) # 获取新闻链接

source.append(demo['data'][j]['source']) # 获取发布新闻的公众号

if demo['data'][j]['source'] not in media_url:

media_url[demo['data'][j]['source']] = url+demo['data'][j]['media_url'] # 获取公众号链接

print(max_behot_time)

max_behot_time = str(demo['next']['max_behot_time']) # 获取下一个链接的max_behot_time参数的值

for index in range(len(title)):

print('标题:', title[index])

if 'https' not in source_url[index]:

s_url.append(url+source_url[index])

print('新闻链接:', url+source_url[index])

else:

print('新闻链接:', source_url[index])

s_url.append(source_url[index])

# print('源链接:', url+source_url[index])

print('头条号:', source[index])

print(len(title)) # 获取的新闻数量

if __name__ == '__main__':

main(max_behot_time, title, source_url, s_url, source, media_url)

savedata(title, s_url, source, media_url)</p>

复制

简单的一百行代码就可以爬取今日头条和热点新闻并存储到本地。 同理,也可以抓取其他渠道的新闻; 本次爬取过程结束。 抓取新闻,主要抓取公众号最近10条新闻或图文的粉丝数、阅读量和评论数; 请期待...

最后送上程序运行截图和数据存储表截图:

---------------------------------------------- ------

欢迎大家留言交流,共同进步。