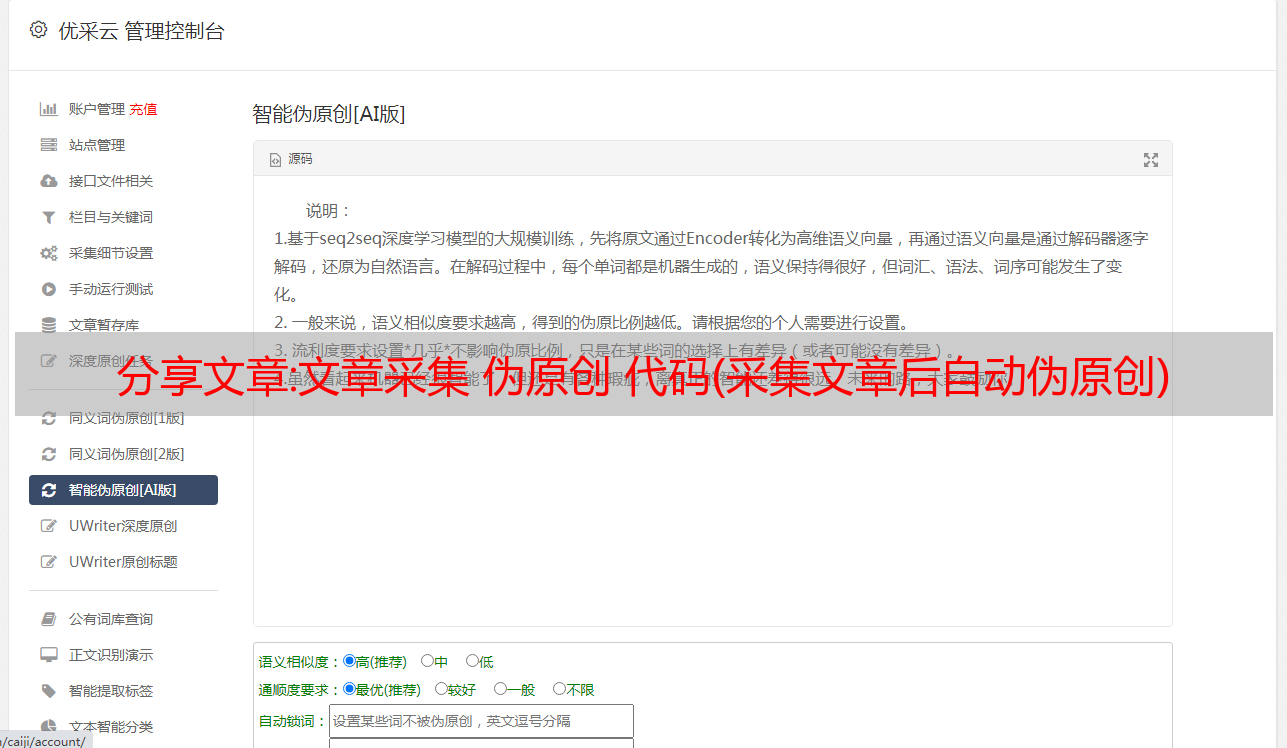

分享文章:文章采集 伪原创 代码(采集文章后自动伪原创)

优采云 发布时间: 2022-12-19 04:08阅读本文提示词:采集文章自动在伪原创之后,文章采集源代码,伪原创文章采集软件

文章采集 伪原创 代码:

1.首段总结法:自己写首段,就像介绍一样。有精力就把全文看完,做个总结,放在首页。如果没时间看,也很简单:自己编,一定要融入自己的网站关键词;

2、在正文中插入链接锚文本:想必大家都知道锚文本的作用,它可以帮助提高相关关键词的排名,或者在别人采集你的数据时将锚文本链接一起采集起来,相当于添加了一个外部链接:你收了我,我就用你,公平。每200-300字可适当添加2-3个锚文本链接;

3 结束总结法:对整个文章进行总结。其实,对于搜索引擎优化,不仅要注意这些内容,还有一些小技巧是必须要注意的。玩搜索引擎是一项细致的工作,所以不仅要做,还得想一想,举一反三,才能进步神速;SEO 修改了 文章 的日期。

4. 文章关键词 中的自然外观

SEO添加文章内容:网站title文章如何做SEO优化?5. 文章自然出现在标题中关键词

6、图片ALT属性aLT属性aLT属性c是告知搜索引擎蜘蛛这个关键词;

7、适当降低原创文章的比例

1. 原创文章:文章标题必须收录关键词;seo how to find文章。

2、关键词必须出现在标题的前面;

3、文章中间部分,关键词必须布局;在文章的最后一节中,关键词必须出现;

4. 文章在最后总结全文。

5、在文章结尾,对全文进行总结。

注意文章,内容不要太多,容易被百度收录;

文章、关键词应与文章内容相关,产品分类中的文章应与相应内容相关。

6、规范文章描述:文章的描述不是一堆或者关键词目录,而是对文章内容的概括,引导用户点击继续浏览;

文章的内容排版要求图文并茂,图片周围必须有关键词;

文章的关键词出现在ALT标签的文章中;

7. 关键词 密度:在 文章 中,键 文章采集 伪原创 代码

2012年,同事A在站长网站上发了一个技巧。他们的网站被抄袭了,他们关于百度排名的文章都被百度收录传了过去。同时,他们给 文章添加了链接。然后他们直接放了这个链接。我不知道什么样的 文章 有资格做 seo。不知道你有没有注意到谷歌对SEO优化的重视程度。

首先,让我们谈谈SEO的价值。其实SEO是网络营销的一种,主要是通过网络营销来提高一个行业的知名度、美誉度和忠诚度。我们都知道,在搜索引擎优化网站的过程中,网站的排名往往由搜索引擎主导,优化成本由搜索引擎优化决定。搜索引擎优化文章采集器

特别是在网站搜索您的网站时,更有效的加密技术让您轻松找回。这就是相关性。在谷歌上搜索肯定会保护原创性,此时我们正在考虑原创文章。当然,这也是必要的。但是,您需要确保您的原创性取向。ecshop文章搜索引擎优化。

其次,当搜索引擎对 原创文章 进行排名时,您需要确保您的 网站 内容具有一定的 原创 相关性。您可以在 网站 中购买其他 网站 内容。如果只是修改网站的内容,那么这种修改是非常困难的。一般来说,下一个网站有两个内容。

首先是内容的原创真实性。如果您的 采集 内容是拼凑而成或乱七八糟的,它将不会被搜索引擎收录。这样的文章更新也会很慢。

二是伪原创内容的质量。由于这些是伪原创 文章,所以 收录 的比率不会很高,但要有高质量的 原创文章 肯定不容易。毕竟,如果 伪原创 得到 收录,但是 伪原创文章 一定是高质量的,而 网站 的权重很低,所以 文章通常可以包括在内。

另外,如果你只是修改了一些网站的内容,或者没有与其他人的文章进行比较,这个文章的收录将不会很好地工作。因此,从 伪原创 的角度来看,搜索引擎更喜欢 原创文章,因为它们是 原创文章。

三、有趣

相关文章

干货教程:wordpress采集插件教程无需撰写代码规则

如何使用wordpress采集让网站快速收录和关键词排名,相信做SEO的朋友都知道网站优化是一个长期的-术语过程,坚持不懈 最好的办法是 网站 坚持更新和 SEO 优化技术。今天给大家讲解下如何使用wordpress采集工具让网站自动更新以及优化不当导致网站不被收录排名不上的注意事项。

1.通过wordpress采集工具自动完成网站优化过程

这个wordpress采集工具可以实现自动采集伪原创发布和主动推送到搜索引擎。操作简单,不需要学习更多的专业技能。只需几个简单的步骤即可轻松获取采集内容数据,用户只需要在wordpress采集上进行简单的设置,设置完成后wordpress会准确的采集文章,采集的文章可以保存到本地或自动伪原创发布,方便快捷的内容采集和快速的内容制作伪原创。

和其他wordpress采集相比,这个wordpress采集基本没有任何规则,更不用说花很多时间学习正则表达式或者html标签了,一分钟就可以上手,输入关键词可以实现采集(wordpress采集也自带关键词采集功能)。一路挂!设置任务自动执行采集伪原创发布并主动推送到搜索引擎。

可以统一管理数十万个不同的cms网站。一个人维护数百个网站文章更新不是问题。这个wordpress采集工具还自带了很多SEO功能,通过采集伪原创软件发布的时候也可以提高很多SEO优化。

1. 网站主动推送(让搜索引擎更快的发现我们的网站)

2.自动配图(文章如果内容中没有图片,会自动配置相关图片)设置自动下载图片保存到本地或第三方(这样内容就不再有外部链接来自另一方)。

3、自动内链(让搜索引擎更深入地抓取你的链接)

4.在内容或标题前后插入段落或关键词(标题和标题可以选择插入相同的关键词)

5、网站内容插入或随机作者、随机阅读等成为“身高原创”。

6. 定时发布(定时发布文章让搜索引擎及时抓取你的网站内容)

使用这些 SEO 功能提高 网站 页面 原创 性能并提高 网站 的 收录 排名。通过工具上的监控和管理查看文章采集发布和主动推送(百度/360/搜狗神马),而不是每天登录网站后台查看。直接在工具上自动完成SEO内容优化。目前博主亲测软件免费,可直接下载使用!

2. 网站为什么要更新内容

当你优化网站时,你会更新网站的内容。你知道我们为什么定期更新 网站 吗?网站更新的理由是什么?如果不更新会有什么后果?

网站为什么定期更新

1.增加收录

搜索引擎收录越多,得到的流量就越多,网站收录就像一个商店,产品越多,用户群越广,两家超市,一家超市有100件商品, 另一家超市有 1,000 件商品。第二家超市的客流量肯定更大。这就是大型超市更受欢迎的原因。

2.为了满足搜索引擎索引

如果一个网站长时间没有更新,它会被搜索引擎认为是一个非托管的网站。为了对用户负责,这个网站会慢慢降级的措施,就像之前关系很好的两个人一样。久了不交流,感情就会淡化,慢慢就会变成陌生人。因此,站长应该学会与引擎索引交互。

3.为了满足客户的需求

用户不仅需要优质的内容,更需要不断更新的内容,尤其是老用户,这个网站会慢慢离开,没有更多的新内容,不管是什么行业网站都必须提供全面的up -最新的行业信息,满足客户需求。

4.持续更新可以形成良性循环

站长们一定要养成一个好习惯,自己定一个更新周期,天天更新,或者两天更新一次,这样搜索引擎蜘蛛才能形成规律的访问你的网站的习惯>。

5.网站更新失败将导致权重或排名下降

有的网站排名或者权重还不错,但是如果网站长时间不更新内容,肯定会导致关键词排名下降,而网站的权重网站 也会下降。因为搜索引擎喜欢抓新鲜的内容,如果长时间不更新,蜘蛛就抓不到新的内容,也就不会来网站抓取了。我觉得很自然网站的权重或排名会下降。

6、影响企业形象

如果公司的网站长期不更新,会让人觉得网站无人管理,网站的信息都是很久以前的了,这就让人客户猜测该公司是否已经消失,或者不再营业。

2.网站没有收录和网站排名不好的原因

1. 网站tdk肆意修改

相信有经验的SEO优化人员肯定不会犯这种错误,是新手会犯的一些错误。网站Title关键词Description 必须经常修改它是一个严重的问题。一般网站tdk不做改动,尤其是新站在百度评估期的时候,如果给百度留下不好的印象,优化起来会很困难。

2.网站的定位和关键词的设置

一定要选择网站的定位,关键词的设置,不要堆砌,不要密集排列,关键词不要选择冷门的。学会正确安排 关键词。

3. 关键词的选择和发布

在选择关键词的时候,选择一些简单易优化的词,词不要太大众化。并且关键词不要过于密集发布,否则百度蜘蛛会认为关键词在爬取时积累,导致网站体验不佳,严重时网站会被降级, ETC。 。

4.文章图文更新

现在信息时代的内容不是靠几张图就能解决的,图文并茂,文章的更新一定要定时。搜索引擎蜘蛛喜欢有规律的东西,你每天都可以做。更新文章,很容易赢得搜索引擎的喜爱,那么网站在百度有一个好的排名就不是难事了。

5. 友情链接太多不容易,不要交换不合适的友情链接

友链的数量一般设置在30个左右,友链的质量也需要注意。兑换时需要查看对方的快照、收录情况和网站排名位置,减少不必要的麻烦,做网站和做人的道理是一样的。你必须有道德。如果在交换友情链接时,详细查看对方网站的基本信息,查看快照时间,网站采集的信息,网站的排名位置,其他< 网站 是k还是降级等等。

6.设置阻止搜索引擎蜘蛛抓取

相信很多程序员都知道robots.txt文件,这是一个告诉搜索引擎蜘蛛不要爬行的设置文件。当搜索引擎蜘蛛第一次访问我们的 网站 时,由于个人错误,他们将 robots.txt 文件设置为不抓取整个文件。像这样的错误会对 网站 造成很大的损害,并且通常会将 网站 内容排除在百度 收录 之外。

以上就是博主给大家带来的一些关于SEO优化的实用技巧。如果你需要更多关于SEO优化的技巧,请继续关注我,每周不定期更新实用的SEO技巧!