解决方案:如何在网页文章采集器中有效处理网页复杂结构?

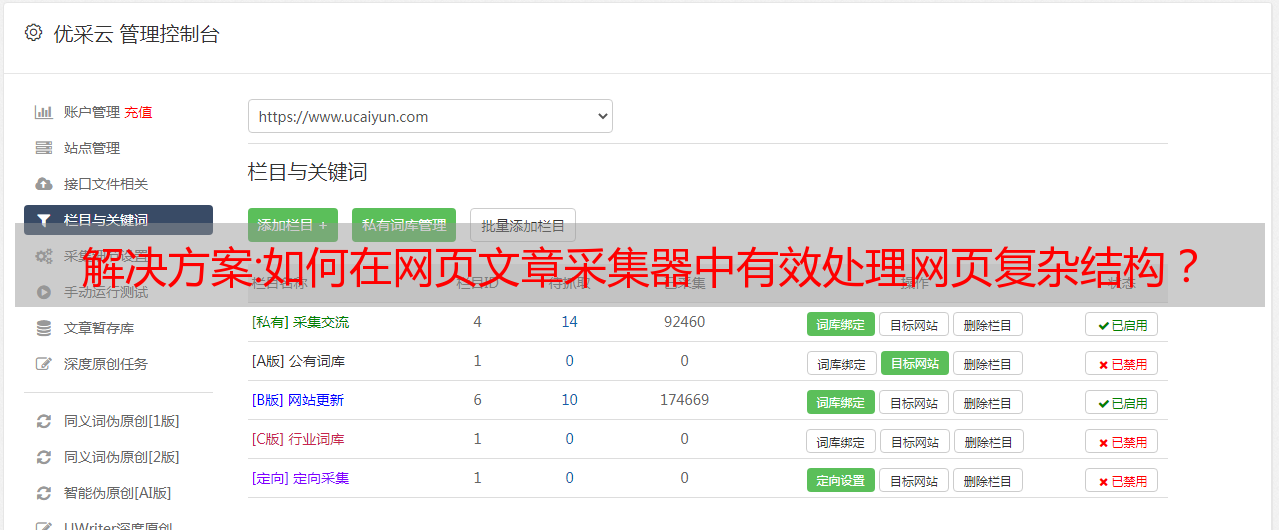

优采云 发布时间: 2022-12-13 10:34解决方案:如何在网页文章采集器中有效处理网页复杂结构?

网页文章采集器,采集网页下载代码,支持python。

1、安装requests库和beautifulsoup,3.6.1。需要提前下载好。可以去迅雷极速版里面下载。

2、安装selenium。打开命令行运行,在命令行输入命令:pipinstallselenium。如果你出现了如下图所示的结果说明已经安装成功了。这是selenium官方仓库对网页的抓取可视化的一个解释:pythonextensionpackagesforwebapplications以下是selenium和python代码对应的地址。

3、安装xlrd库,并建立sql数据库连接,并设置sql连接池。

4、在selenium的搜索框中输入/,输入要抓取的网页,比如我这次抓取搜狐的信息,只要12个/。

5、返回相应的model,selenium已经把抓取到的每一个网页的地址,并且实时返回给你。

6、抓取网页中所有的信息,把字段提取出来,例如title、url、page数据都会提取出来,如下图所示。也可以提取某个时间段或某个页面,因为数据抓取很频繁,我们可以按时间段或时间段去抓取数据。抓取到的数据可以用来保存,也可以用来标记数据。

很多资源都有的,提供一个网页数据的爬虫,

采集网页文章即使是自动化软件都有这么强大的支持,然而很多自动化爬虫大神在编写自动化流程时,无法处理复杂的网页结构,那么问题来了,我们该如何在编写爬虫代码时,有效处理网页复杂结构?这就是我们所要讨论的问题。高手们都是如何解决这个问题的?高手们有个很有意思的理论,叫做弱知识带宽论。什么意思呢?在软件工程中,模块是有边界的,边界一旦过了,模块上的东西无法处理了,那么它就必须换个地方去处理这些“边界上的东西”。

比如模块的空间范围是1个page,结果你的爬虫处理了6个页面,其中5个页面已经到边界了,那么自然处理不了这5个页面了。对于大部分自动化爬虫来说,页面的边界并不是很明确,比如《豆瓣》页面有500页,《百度》又有400页,等等。那么这些就称为弱知识带宽,并且它是很难做到优化的。比如如果有个功能需要爬1万页,1万页以上都会被自动处理,1万页以下就没办法处理了。

所以我们要想办法优化它。一些程序员也想解决这个问题,而大部分程序员,他们会用一些特殊的技巧去做,比如用load_urls()函数,或者用图形界面处理等等。其实这些方法都非常难优化。那么我们该怎么解决呢?答案就是使用“弱知识带宽论”。弱知识带宽论指的是一个“弱知识带宽”,它并不仅仅是模块的边界很弱,实际上它的边界是任何一个可被爬虫。