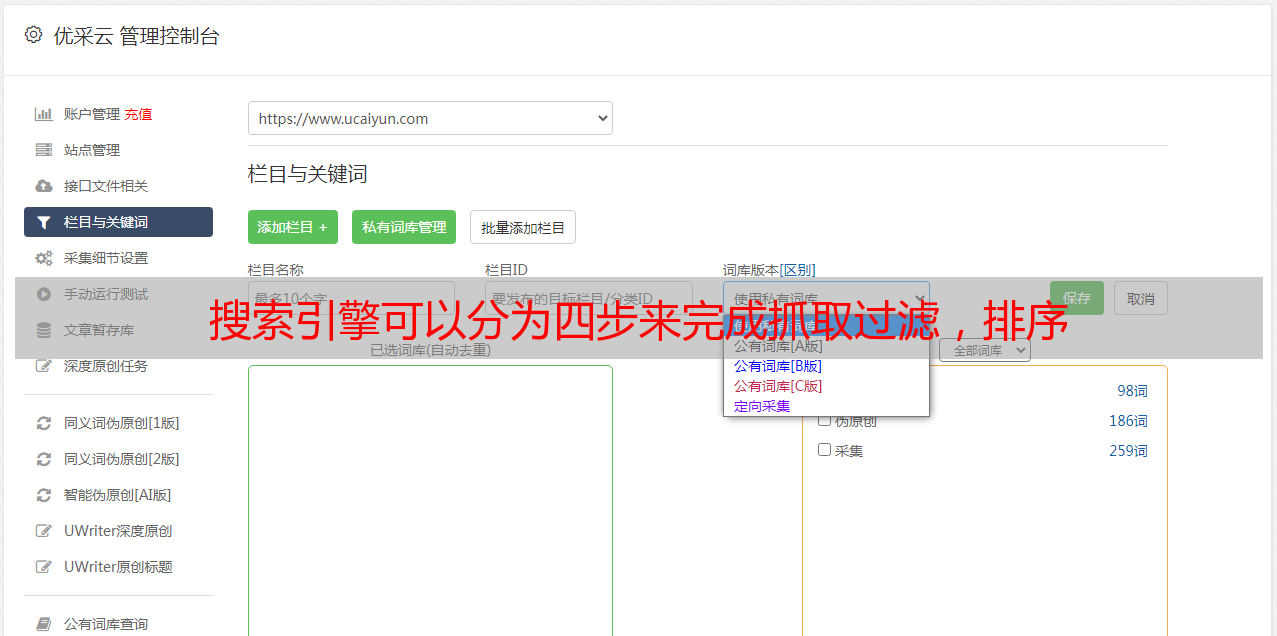

搜索引擎可以分为四步来完成抓取过滤,排序

优采云 发布时间: 2021-05-28 21:09搜索引擎可以分为四步来完成抓取过滤,排序

搜索引擎是一种程序,该程序会自动从Internet采集信息,并在进行某些排序后为用户提供查询系统。搜索引擎可以分为:百度蜘蛛:Baiduspider,360蜘蛛:360spider,谷歌蜘蛛:geoglebot等。

通常来说,搜索引擎的工作原理可以分为四个步骤:爬网,过滤,访问和排序。

1.进行爬网,搜索引擎按照网页中的超链接在Internet上找到它,搜索网页信息,然后在其中进行爬网。从爬网方法的角度来看,它可以分为深度爬网和广泛爬网。深度抓取是指搜索引擎沿着网站的内部结构进行抓取,例如首先抓取页面,然后抓取部分页面,然后抓取详细信息页面,就像树状结构一样,先爬到主干,然后到分支,然后稍微分支。总体结构超过三层,不利于搜索引擎爬网。不利于搜索引擎的抓取,并且内容具有JS,图片,视频,iframe框架和多层嵌套。

2.过滤。搜索引擎获取网页上的信息后,会将数据存储在临时数据库中。然后,搜索引擎会过滤掉一些低质量的页面,例如采集中的页面,内容不丰富的页面以及文本不正确的页面。将它们当作垃圾处理掉。

3.存储,搜索引擎将一些高质量,有价值且用户体验的内容存储在数据库中。为了方便用户的搜索查询,可以随时对其进行检索。

4.排序,搜索器根据用户输入的查询的关键词快速在索引数据库中检出文档,评估文档和查询的相关性,并对要输出的结果进行排序。当我们发现在搜索引擎中看到的只是一个很好的结果时,搜索引擎会根据各种算法在页面位置显示一定的关键词。