分享:优采云采集构建原创文章的三种方法

优采云 发布时间: 2022-11-07 05:12分享:优采云采集构建原创文章的三种方法

优采云采集软件是非常好的文章采集软件,那么它能产生原创内容吗?是的,但质量原创略低。今天,Bug 博客 () 分享了“构建原创文章优采云采集三种方法”。希望对大家有所帮助。

1. 优采云和原创

优采云本身没有原创的能力,但通过优采云确实可以创建原创内容,错误的博客首先介绍了三种使用优采云创建原创文章的方法,当然还会有更多方法,这取决于大家的头脑风暴。

1.英译中插件

采集一些英文网站 文章,然后使用优采云的英译中插件,可以得到大量的伪原创文章,这样的文章甚至可以称为原创,但可能不够流畅,但原创还可以,除非两个人采集相同的英文文章,否则,在这种模式下得到的内容收录率是可以的。这个网站有一些谷歌搜索引擎优化文章这就是它获得的方式。

目前这类插件一般是收费的,可以找免费插件,但通常必须拿到百度翻译API,如果超过免费使用量,需要单独付费。

2. 伪原创插件

伪原创插件基本上都是一些从事网伪原创的人做的,大部分都是收费的,毕竟这是大量的伪原创,一定程度上也消耗了对方的服务器资源。

对于伪原创,

错误的博客不是特别推荐的,毕竟这个东西的可读性真的很差,而且搜索引擎也不友好,你网站好友善的前提下,即使没有太多的文字也能收录,但伪原创内容未必收录。

此外,大多数伪原创被同义词和

同义词,市面上基本没有AI伪原创,如果真的存在,那就直接给关键词,剩下的自己写。市场上大多数伪原创提供商都替换同义词和同义词,因此最好不要这样做。

3. 构建文章

使用大量单词来构建文章,例如

作为10万个相关单词做成文章页面的表格,通过对单词和句子进行布局,使其看起来没有矛盾感,这种方法也看到了很多网站获得了大量的流量,而错误的博客本身也收到了数以万计的此类收录。

第二,优采云建立文章

优采云构建文章的方法很简单,错误的博客会一一告诉您。

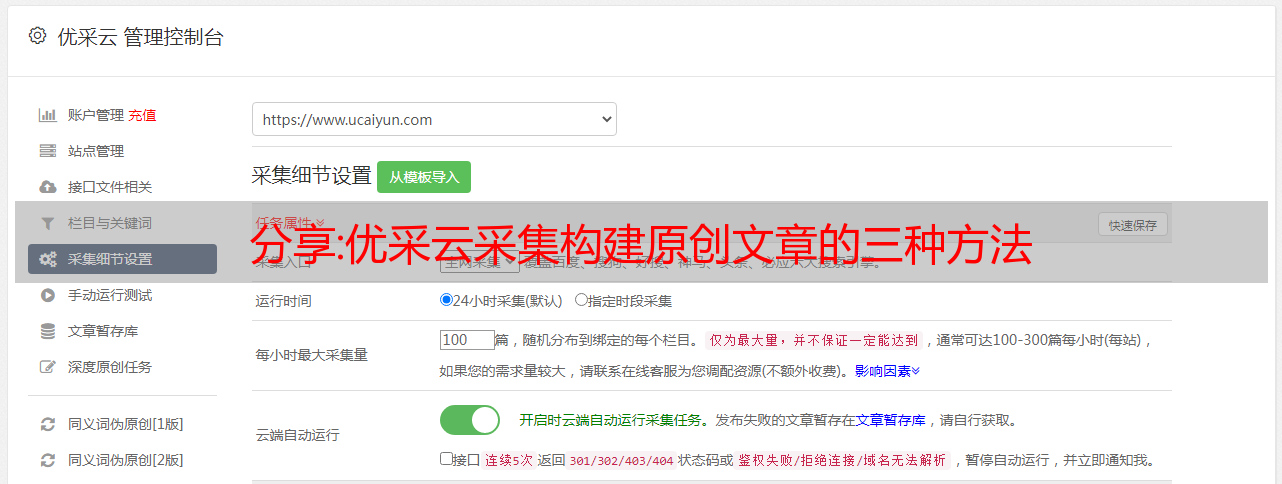

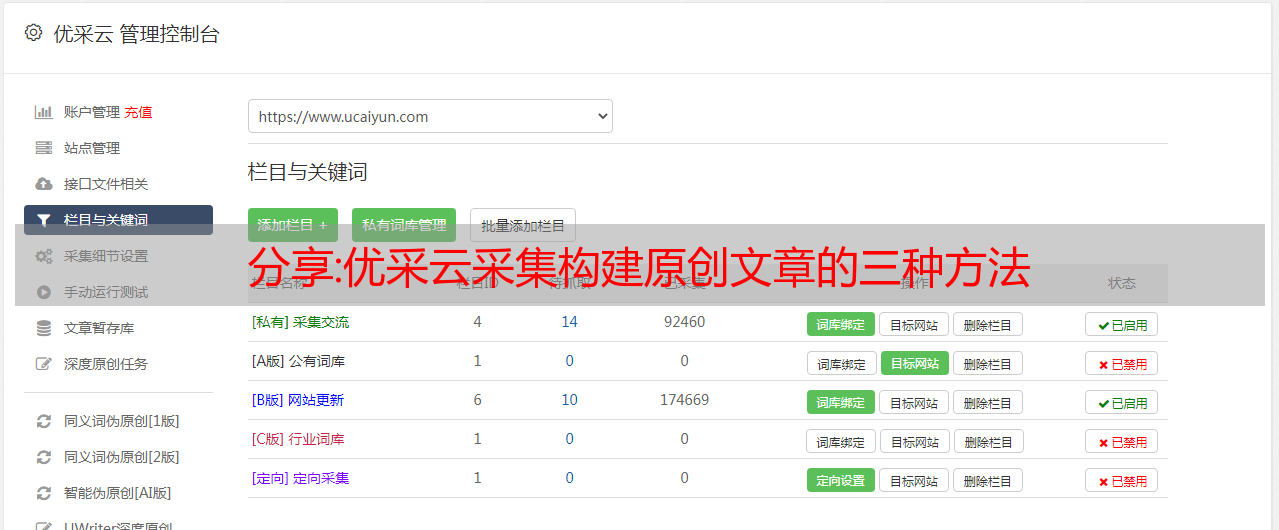

1. 优采云导入模板

下载优采云,即优采云采集,创建一个字符列表组,右键单击该组,然后导入准备好的“.ljobx”文件,该文件是优采云采集的模板。

2. 内容采集规则

导入后双击打开,直接跳过“URL采集规则”,直接进入“内容采集规则”,然后,我们需要为原创构建标题、页面关键词、页面描述、作者、缩略图、标签等内容,这些内容都来自TXT文档,而TXT文档内存中有数万行数据, 这样才能实现构建原创文章。当然,这只是一个模型,想要有更好的收录效果,需要考虑如何使用这个模型来创造更好的内容,或者改变模型来产生更多类似原创的内容。

这就是错误博客()分享的“构建原创文章优采云采集三种方法”的内容。感谢您的阅读。有关更多信息原创文章请搜索“错误博客”。

总结:从头开始构建,DeepMind新论文用伪代码详解Transformer

伪代码比滚动 1000 行源代码更简洁明了。

Transformer 诞生于 2017 年,由谷歌在《Attention is all you need》一文中介绍。本文摒弃了以往深度学习任务中使用的 CNN 和 RNN。这一开创性的研究颠覆了以往的序列建模和RNN等值的思路,现已广泛应用于NLP。流行的 GPT、BERT 等都是建立在 Transformer 之上的。

自从引入 Transformer 以来,研究人员提出了许多变体。但是大家对Transformer的描述,似乎都是口头上、图形上等方式来介绍架构的。可用于变形金刚的伪代码描述的材料很少。

正如下面一段话所表达的: 一位在人工智能领域非常有名的研究人员曾经给一位著名的复杂性理论家发了一篇他认为写得很好的论文。而理论家的回答:我在论文中找不到任何定理,也不知道论文是关于什么的。

对于从业者来说,一篇论文可能足够详细,但理论家通常需要更精确。出于某种原因,DL 社区似乎不愿意为其神经网络模型提供伪代码。

目前看来,DL社区存在以下问题:

DL 出版物缺乏科学的准确性和细节。深度学习在过去 5 到 10 年间取得了巨大的成功,每年发表的论文数以千计。许多研究人员只是非正式地描述了他们如何改变以前的模型,而大约 100 多页的论文只收录几行非正式的模型描述。充其量是一些高级图表,没有伪代码,没有方程式,没有提到模型的精确解释。甚至没有人为著名的 Transformer 及其编码器/*敏*感*词*变体提供伪代码。

源代码和伪代码。开源源代码非常有用,但与数千行真实源代码相比,精心制作的伪代码通常不到一页,但仍基本完整。这似乎是一项没有人愿意做的艰苦工作。

解释训练过程同样重要,但有时论文甚至没有提到模型的输入和输出以及潜在的副作用是什么。论文的实验部分通常不会解释在算法中输入什么以及如何输入。如果方法部分有一些解释,通常与实验部分描述的内容脱节,可能是由于不同作者写的部分不同。

有人会问:真的需要伪代码吗?伪代码有什么用?

DeepMind 的研究人员认为,提供伪代码有很多用途,它将所有重要的东西浓缩在一个页面上,并且比阅读 文章 或滚动 1000 行实际代码更容易开发新的变体。为此,他们最近发表的论文,Formal Algorithms for Transformers,文章 以完整、数学准确的方式描述了 Transformer 架构。

论文简介

本文涵盖了 Transformer 是什么、如何训练 Transformer、Transformer 用于什么、Transformers 的关键架构组件以及更著名的模型的预览。

论文地址:

但是,要阅读本文,读者应该熟悉基本的 ML 术语和简单的神经网络架构,例如 MLP。对于读者来说,在了解了正文的内容之后,就对Transformer有了扎实的把握,并且可以使用伪代码来实现自己的Transformer变种。

本文的主要部分是第 3-8 章,介绍了 Transformer 及其典型任务、标记化、Transformer 的架构组成、Transformer 训练和推理以及实际应用。

论文中几乎完整的伪代码长约 50 行,而实际的真正源代码则有数千行。本文介绍的算法伪代码适用于需要紧凑、完整和精确公式的理论研究人员,适用于从头开始实施 Transformer 的实验研究人员,以及使用正式的 Transformer 算法扩充论文或教科书。

论文中的伪代码示例

对于熟悉基本 ML 术语和 MLP 等简单神经网络架构的初学者,本文将帮助您打下坚实的 Transformer 基础,并使用伪代码模板实现自己的 Transformer 模型。

关于作者

这篇论文的第一作者是今年 3 月正式加入 DeepMind 的研究员 Mary Phuong。毕业于奥地利科技学院,获博*敏*感*词*,主要从事机器学习理论研究。

该论文的另一位作者是 DeepMind 的高级研究员、澳大利亚国立大学 (ANU) 计算机科学学院 (RSCS) 的名誉教授 Marcus Hutter。

Marcus Hutter 多年来一直致力于人工智能的数学理论。该研究领域基于若干数学和计算科学概念,包括强化学习、概率论、算法信息论、优化、搜索和计算理论等。他的著作《Artificial General Intelligence: Sequential Decision Making Based on Algorithmic Probability》于 2005 年出版,是一本非常技术性和数学性的书。

2002 年,Marcus Hutter 与 Jürgen Schmidhuber 和 Shane Legg 一起提出了 AIXI,这是一种基于理想化代理和奖励强化学习的人工智能数学理论。2009 年,Marcus Hutter 提出了特征强化学习理论。