推荐文章:网站如何更新原创内容与伪原创内容

优采云 发布时间: 2022-11-05 00:37推荐文章:网站如何更新原创内容与伪原创内容

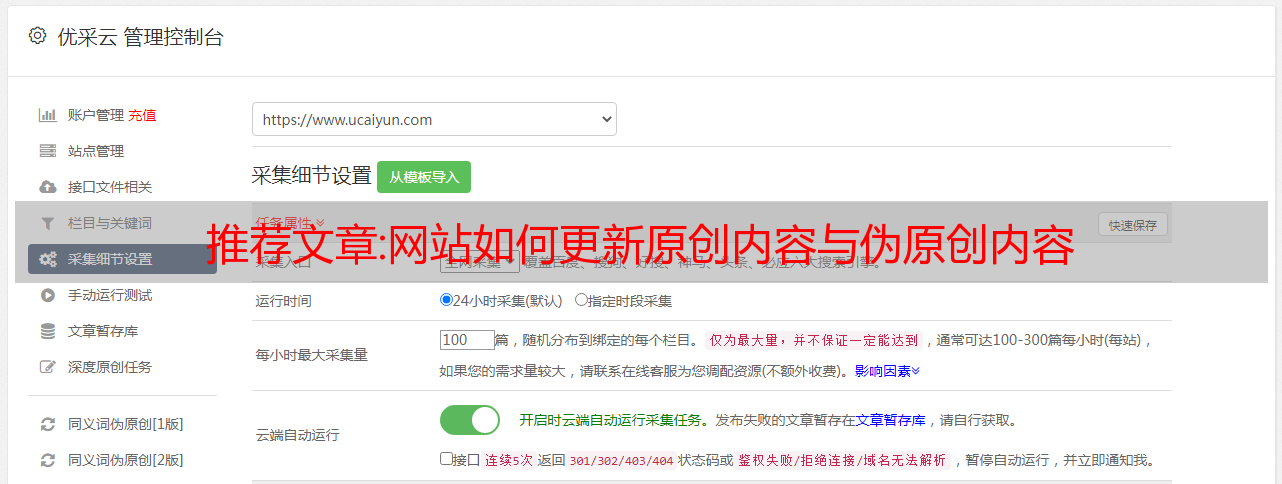

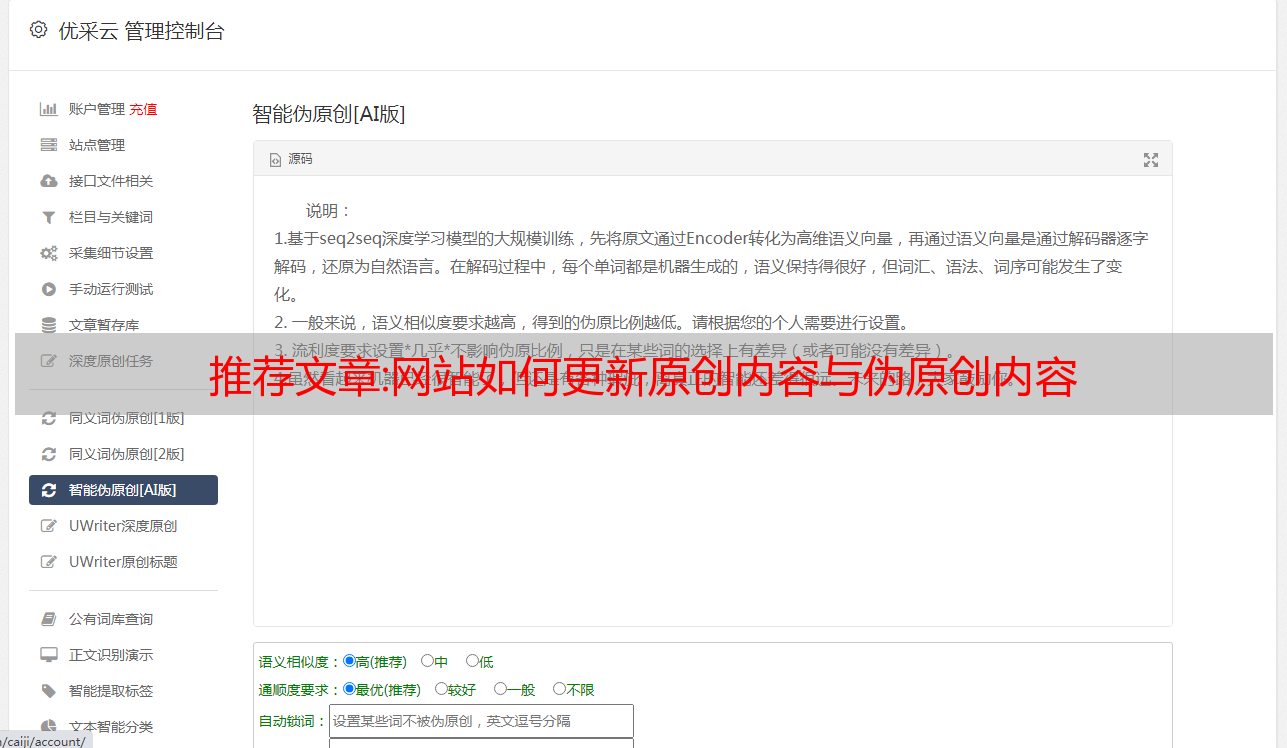

首先,更新网站的内容有一定的要求。虽然大家都在提倡内容为王,但不能直接用优采云一键采集对吧?像这样直接将数千个文章导入到网站对网站没有任何好处,因为你无法控制文章的内容,你可以'不准确文章的定位、关键词的布局等相关因素,很多大尺度的网站流量都是通过长尾关键词获得的,它们的整体流量可以达到100% 60左右,占一半以上,长尾关键词是利用文章的内容,通过布局和控制关键词的内容文章关键词 整体密度和突出度,从而达到排名的目的,所以好好利用这个文章非常重要。第一:原创原创的内容对网站的权重起着非常重要的作用,只有原创的内容才能控制其关键词的密度和其他因素,只有原创的内容才能让你的长尾关键词获得更好的排名,所以我们更新内容的时候,每天一张原创是必不可少的。同时,原创的内容可以给网站带来更好的权重评价。其他人可以使用 伪原创 来丰富网站。不要用采集软件,如果我用采集软件更新网站内容,那我宁愿三天更新一个原创文章。第二:伪原创伪原创

分享的内容:seo日志分析(网站seo日志分析工具)

对于那些做 seo 的人来说,一个必须学习的技能是网站日志分析。因为我们只能从网站日志和百度账号管理的后台数据中了解我们的网站seo优化。如何调整整体趋势,不是所谓的一手网站优化。

准备提醒:

[安装和下载的工具有 Cygwin、Notepad++ 和 Excel,以及一个日志文件。】

网上还有一个不错的网站日志分析工具,可以在web端在线分析。具体使用方法很简单,输入你的网站 URL(这里刚刚填写),然后导入你的网站日志文件,然后点击“分析”即可。在这里,您可以查看您的 网站 的哪些搜索引擎收录 被蜘蛛抓取、多久和何时?并判断要抓哪些低重量和高重量的蜘蛛等等。可以看得很清楚。

但唯一的缺点是无法一键导出数据。对于大型 网站 来说,内容过多可能会很麻烦。如果是博客之类的小网站,手动复制粘贴很快。并且不能保证检测到的数据是 100% 准确的。总体而言,cygwin分析的数据更加准确和专业。

网站404错误页面爬取

以下是Cygwin是什么,根据百度百科的解释:Cygwin是一个运行在windows平台上的类UNIX仿真环境,是cygnus Solutions开发的一款免费软件。它对于学习 UNIX/Linux 操作环境,或者将应用程序从 UNIX 移植到 Windows,或者做一些特殊的开发工作,尤其是使用 GNU 工具集在 Windows 上开发嵌入式系统非常有用。随着嵌入式系统开发在中国的日益普及,越来越多的开发者对 Cygwin 感兴趣。好吧,听太多官员的话是没有用的。我们可以用它来做网站日志分析,以及如何做。

在使用此工具之前,您需要下载并安装它。貌似目前不支持苹果电脑的安装,windows系统是允许的。

具体安装步骤在此不再赘述。下一步是安装步骤。具体来说,您可以搜索引擎以获取安装说明。这方面有很多教程。下面介绍如何直接使用该工具。

下载工具后会提示以下文件会在你下载保存的某个路径下,都是缺一不可的,就这几个文件:

打开cygwin工具后,不知道这些文件在哪里。您可以通过输入“pwd”命令查看存储路径:

我把它放在系统托盘里。

好吧,知道了这一点,我们的目的是分析 网站 日志。首先,下载你的 网站 日志,先命名。我这里的名字是 1.log,我把下载的 1.log 日志文件和这五个文件放在一起:

这是第一步。下载日志文件后,我们将使用它来提取网站的404错误页面,搜索引擎蜘蛛抓取的任何404错误页面。我们以“百度”为例,写成“Baiduspider”。

提取过程如下,这里有几个步骤需要注意:

第一步:

首先,分离百度的蜘蛛。先把它分成5段,看看效果,看能不能提取成功。输入是:

cat 1.log|grep 'Baiduspider'|head -5 第 2 步:

发现正常输出显示百度搜索引擎蜘蛛已经来爬取我们的网站。OK,接下来将百度搜索引擎蜘蛛爬取的所有信息提取出来,并将提取出来的信息命名为带后缀的文件。文本。为了确认,将其命名为“baidu.txt”并输入以下命令:

cat 1.log|grep '百度蜘蛛'>>baidu.txt

输入命令后按回车键,在存放1.log的目录文件中会多出一个baidu.txt文件,如下图:

第三步:

好了,我们提取了百度搜索引擎蜘蛛爬取的所有页面,包括404、200、301状态码,因为我们只需要提取404状态码的页面。

这时候要想找到对应状态码的位置,就需要知道它在baidu.txt文件的哪一段,解压前还要数一数。一起来分析一下。

先用记事本++工具打开baidu.txt文件,结果是密密麻麻的数字:

懂的别着急,我们来“数羊”。

该段数计为每个空网格一个段。我们要查找一行中所有状态码的个数,正好是第 9 段的个数。

知道段数后,就知道状态码是什么,段数有多少,就能更了解当前网站的具体情况。让我们使用这串命令提取所有状态代码页的信息。这些命令如下:

cat baidu.txt|awk '

'|排序|唯一-c

进入后,终端会显示网站的所有状态码和对应的数字,如下图所示:

第四步:

所以再次判断404情况:只能统计状态码的输入指令:

cat baidu.txt|grep '404'>>404.txt

这里提醒一下,直接把404状态码分开,保存为404.txt文件确认即可。同样,这个 404.txt 文件被添加到文件中。

当然,这一步是不完整的,因为提取出来的数据还是整行404状态码。我们的目的是提取网站404页面的链接,所以我们要提取这个block的链接,找到一行对应的链接数?连续找到第 7 个:

第五步:

然后输入命令提取链接:

猫 404.txt|awk '

'>>baidu404.txt

注意:因为要提取哪个文件,所以必须提取哪个文件。以下是 404.txt 文件的摘录。

按回车键后,发现文件中多了一个baidu404.txt文件。为了知道百度抓取的是404页面,为了方便识别,将其命名为baidu404.txt。

但是这些链接以 404 状态码打开:

一般我们在向百度网站后台提交404错误页面时,会将所有404页面放在一个文件中,比如404.txt文件,然后再提交给百度。这时候如果你的网站非常大,就无法避免404页,甚至是几万、几十万的数据。前面提到的使用loghao的网页版不符合要求。一个是无法导出的函数,提取是否100%准确是不确定的。在使用这个cygwin工具的时候,虽然过程有点复杂,但是很靠谱。对于一些新手 SEOers,他们可以使用它。他们有成就感吗?

如果超过404页,我们使用Excel表格合并,我最好虚拟化URL。例如,具体实现过程如下:

首先,把提取出来的404链接放到Excel的B列,把你的网站的真实URL写在A列,然后拼接。拼接命令是在C列输入“=”,然后Ctrl+A,然后“&”,再Ctrl+B,最后回车,拼接的链接地址就变成了。

最后,在C列拼接的数据单元格中,鼠标悬停片刻,出现一个“+”。双击它以拼接所有它们。

如果有成千上万的数据,这种方法是否更有效?然后剩下的就可以交给复制粘贴了。相信做seo的人都知道怎么提交到百度后台。

最后一点:

做 seo 优化是充满活力的。如果你想查看一个链接被搜索引擎蜘蛛重复爬取的次数,因为你知道哪些页面被重复爬取,你可以做一些相应的操作,在网站链接中添加nofollow属性来避免多次爬行。为了获得更多机会和数量,让它爬取其他页面。输入以下命令:

cat baidu.txt|awk '

'|排序|唯一-c

注意:只有“/”代表首页,前面的数字代表被爬取的次数。

如果你想通过“hlw”栏下的内容查看你的某个栏目抓取了哪些页面,比如百度搜索引擎蜘蛛抓取了哪些页面,可以输入命令:

cat baidu.txt|awk '/hlw/'|sort|uniq -c

然后按回车,结果会显示有多少条记录。

以后如果出现网站no收录的问题,可以用这个查询方法来解决你的网站问题的根本原因,而不是一味的优化网站 . 用这个cygwin分析网站log和百度网站后端索引量,制定自定义规则,看看哪些列内容没有被索引,哪些索引掉的严重。网站做了什么?

只有分析自己每天所做的事情的统计数据,才能有针对性地解决问题,就像知道病因在哪里,才能对症下药,才能治好病。