教程:详解如何用python批量抓取亚马逊商品销售数据

优采云 发布时间: 2022-10-31 00:49教程:详解如何用python批量抓取亚马逊商品销售数据

随着传统外贸渠道的疲劳,跨境电商的发展目前异常火爆。跨境电商很可能成为未来外贸出口的主流模式,成为推动我国外贸经济发展的重要突破口。跨境电商主要分为跨境*敏*感*词*和跨境出口。主流跨境电商平台各有特色。

作为美国最大的在线电子商务公司,亚马逊是最早在互联网上开展电子商务的公司之一。它已成为全球商品种类最多的在线零售商和全球第二大互联网公司。在中国,大量的卖家在亚马逊开店开展跨境电商业务,因为亚马逊上的数据对买卖双方都具有重要意义和价值,那么我们如何获取这些数据呢?? 有没有软件可以帮助我们免费获取这些数据?

优采云就是这样一个爬虫采集软件,帮助亚马逊买家和卖家免费获取数据。完整数据采集无需配置,是业界第一款支持Windows、Mac、Linux三种操作系统的采集工具。同时,它是真正免费的数据采集软件,对采集结果的导出没有任何限制,没有编程基础的新手也能轻松实现数据采集 要求。

那么如何使用这个软件采集亚马逊的资料,现在我们以亚马逊的书籍为切入点为大家演示。

首先,打开官网注册并安装最新版本的软件。

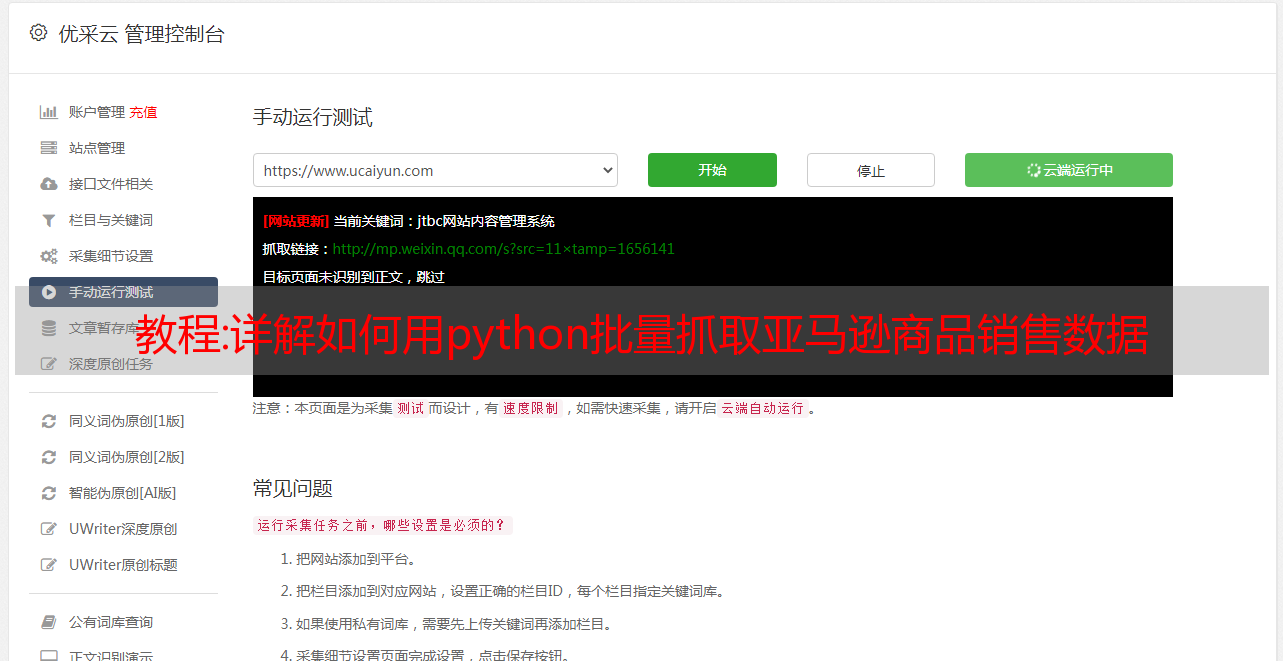

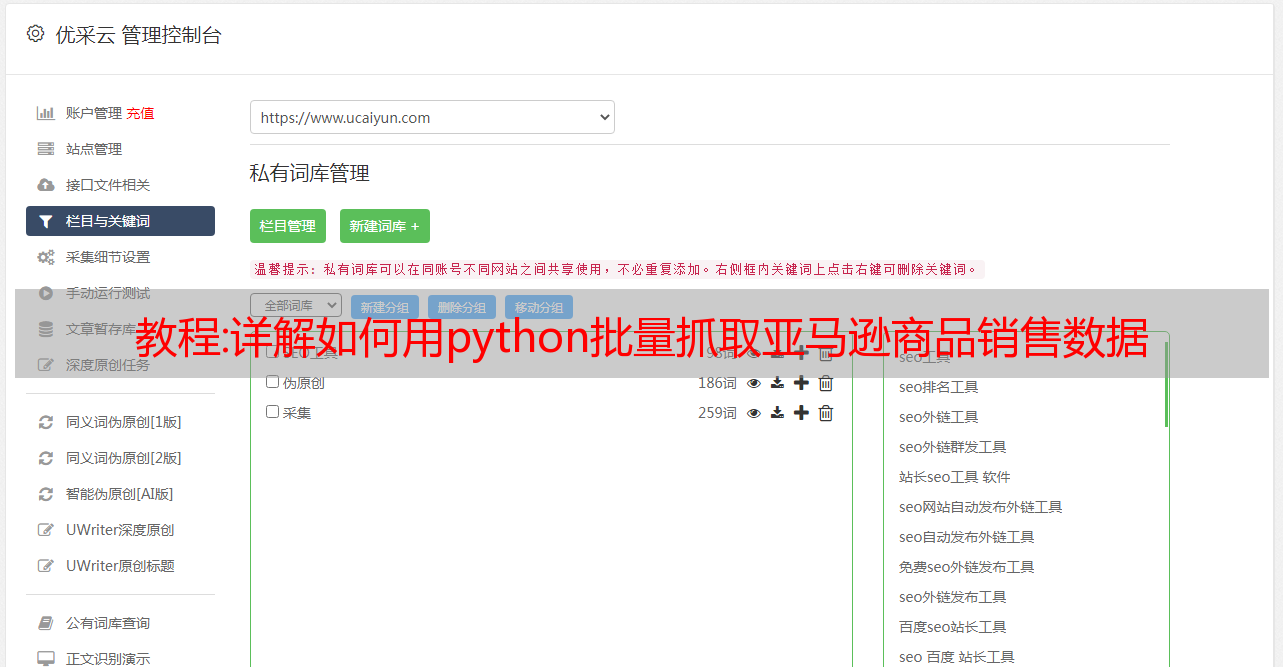

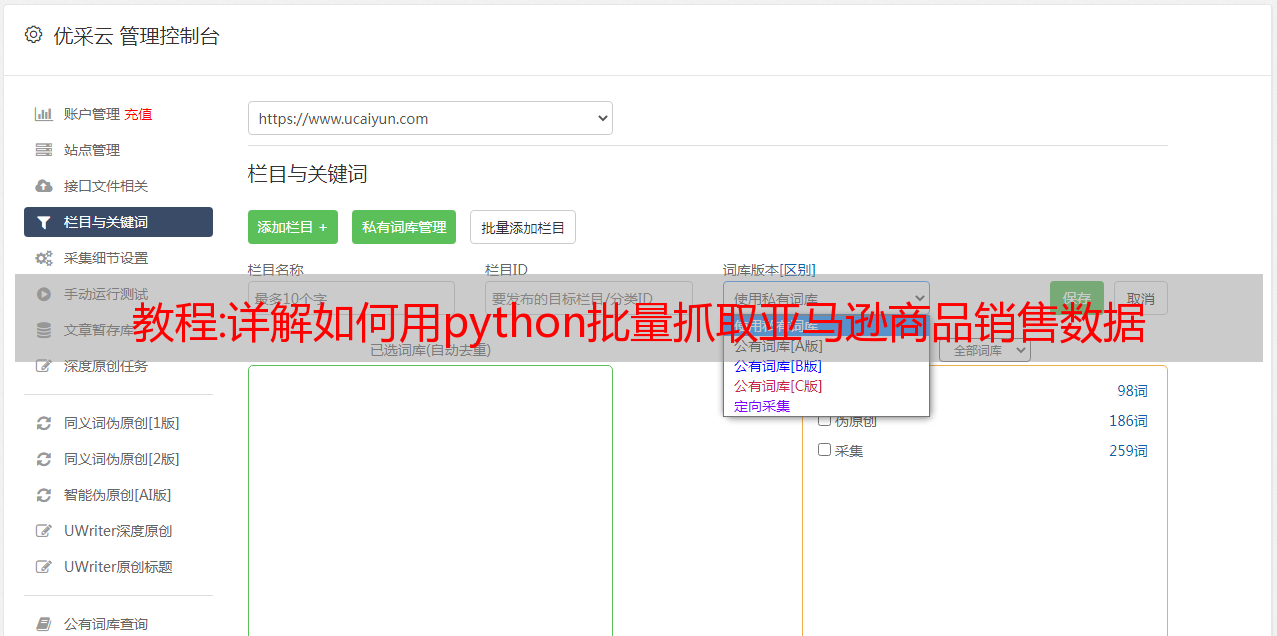

然后在软件中输入网址,新建一个智能采集任务。

然后配置 采集 规则。我们可以右键字段进行相关设置,包括修改字段名、增减字段、处理数据等. .

然后我们启动 采集 任务并开始抓取数据。

数据被抓取后,我们将数据导出。

让我们导出一个 excel 表的数据,看看 采集 的效果如何。关键是它是完全免费的。快来试试吧。

来自“ITPUB博客”,链接:如需转载,请注明出处,否则追究法律责任。

转载于:

教程:Python网页信息采集:使用PhantomJS采集淘宝天猫商品内容

1 简介

最近一直在看Scrapy爬虫框架,尝试用Scrapy框架写一个可以实现网页信息的简单小程序采集。在尝试的过程中遇到了很多小问题,希望大家多多指教。

本文主要介绍如何结合PhantomJS采集天猫产品内容使用Scrapy。文本为需要用js加载的采集动态网页内容自定义了一个DOWNLOADER_MIDDLEWARES。看了很多DOWNLOADER_MIDDLEWARES的资料,总之,好用,但是会阻塞框架,所以性能不好。有资料提到自定义DOWNLOADER_HANDLER或者使用scrapyjs可以解决框架阻塞的问题。有兴趣的小伙伴可以研究一下,这里就不多说了。

2. 2.1、环境要求的具体实现

准备 Python 开发和运行环境需要以下步骤:

- Python——官网下载安装部署环境变量(本文使用Python 3.5.1版本)

-lxml- 从官网库中下载对应版本的.whl文件,然后在命令行界面执行“pip install .whl文件路径”

- Scrapy – 在命令行界面执行“pip install Scrapy”,具体请参考“Scrapy的首次运行测试”

- selenium - 执行“pip install selenium”的命令行界面

- PhantomJS – 官网下载

以上步骤展示了两种安装方式: 1. 将下载好的wheel包安装到本地;2、使用Python安装管理器进行远程下载安装。注意:包的版本需要与python版本相匹配

2.2、开发测试流程

首先找到需要采集的网页,这里是一个简单的天猫产品,网址,页面如下:

然后开始写代码,下面的代码默认在命令行界面执行

1)、创建scrapy爬虫项目tmSpider

E:\python-3.5.1>scrapy startproject tmSpider

2)、修改settings.py配置

配置如下:

DOWNLOADER_MIDDLEWARES = {

'tmSpider.middlewares.middleware.CustomMiddlewares': 543,

'scrapy.contrib.downloadermiddleware.useragent.UserAgentMiddleware': None

}

3)、在项目目录下创建middlewares文件夹,然后在文件夹中创建middleware.py文件,代码如下:

# -*- coding: utf-8 -*-

from scrapy.exceptions import IgnoreRequest

from scrapy.http import HtmlResponse, Response

import tmSpider.middlewares.downloader as downloader

class CustomMiddlewares(object):

def process_request(self, request, spider):

url = str(request.url)

dl = downloader.CustomDownloader()

content = dl.VisitPersonPage(url)

return HtmlResponse(url, status = 200, body = content)

def process_response(self, request, response, spider):

if len(response.body) == 100:

return IgnoreRequest("body length == 100")

else:

return response

4)、使用selenium和PhantomJS编写一个网页内容下载器,同样在上一步创建的middlewares文件夹下创建downloader.py文件,代码如下:

# -*- coding: utf-8 -*-

import time

from scrapy.exceptions import IgnoreRequest

<p>

from scrapy.http import HtmlResponse, Response

from selenium import webdriver

import selenium.webdriver.support.ui as ui

class CustomDownloader(object):

def __init__(self):

# use any browser you wish

cap = webdriver.DesiredCapabilities.PHANTOMJS

cap["phantomjs.page.settings.resourceTimeout"] = 1000

cap["phantomjs.page.settings.loadImages"] = True

cap["phantomjs.page.settings.disk-cache"] = True

cap["phantomjs.page.customHeaders.Cookie"] = 'SINAGLOBAL=3955422793326.2764.1451802953297; '

self.driver = webdriver.PhantomJS(executable_path='F:/phantomjs/bin/phantomjs.exe', desired_capabilities=cap)

wait = ui.WebDriverWait(self.driver,10)

def VisitPersonPage(self, url):

print('正在加载网站.....')

self.driver.get(url)

time.sleep(1)

# 翻到底,详情加载

js="var q=document.documentElement.scrollTop=10000"

self.driver.execute_script(js)

time.sleep(5)

content = self.driver.page_source.encode('gbk', 'ignore')

print('网页加载完毕.....')

return content

def __del__(self):

self.driver.quit()</p>

5)创建爬虫模块

在工程目录E:\python-3.5.1\tmSpider,执行如下代码:

E:\python-3.5.1\tmSpider>scrapy genspider tmall 'tmall.com'

执行后会在项目目录E:\python-3.5.1\tmSpider\tmSpider\spiders中自动生成tmall.py程序文件。该程序中的parse函数对scrapy下载器返回的网页内容进行处理。采集网页信息的方法可以是:

- 使用 xpath 或常规方式 采集 response.body 中的必填字段,

- 通过gooseeker api获取的内容提取器,实现所有字段的一站式转换,无需手动编写xpath进行转换(内容提取器的获取方法请参考python使用xslt提取网页数据) ,代码如下:

# -*- coding: utf-8 -*-

import time

import scrapy

import tmSpider.gooseeker.gsextractor as gsextractor

class TmallSpider(scrapy.Spider):

name = "tmall"

allowed_domains = ["tmall.com"]

start_urls = (

'https://world.tmall.com/item/526449276263.htm',

)

<p>

# 获得当前时间戳

def getTime(self):

current_time = str(time.time())

m = current_time.find('.')

current_time = current_time[0:m]

return current_time

def parse(self, response):

html = response.body

print("----------------------------------------------------------------------------")

extra=gsextractor.GsExtractor()

extra.setXsltFromAPI("31d24931e043e2d5364d03b8ff9cc77e", "淘宝天猫_商品详情30474","tmall","list")

result = extra.extract(html)

print(str(result).encode('gbk', 'ignore').decode('gbk'))

#file_name = 'F:/temp/淘宝天猫_商品详情30474_' + self.getTime() + '.xml'

#open(file_name,"wb").write(result)</p>

6)、启动爬虫

执行E:\python-3.5.1\tmSpider项目目录下的命令

E:\python-3.5.1\simpleSpider>scrapy crawl tmall

输出结果:

需要说明的是,上述命令一次只能启动一个爬虫。如果你想同时启动多个呢?然后需要自定义一个爬虫启动模块,在spiders下创建模块文件runcrawl.py,代码如下

# -*- coding: utf-8 -*-

import scrapy

from twisted.internet import reactor

from scrapy.crawler import CrawlerRunner

from tmall import TmallSpider

...

spider = TmallSpider(domain='tmall.com')

runner = CrawlerRunner()

runner.crawl(spider)

...

d = runner.join()

d.addBoth(lambda _: reactor.stop())

reactor.run()

执行 runcrawl.py 文件并输出结果:

三、展望

以自定义DOWNLOADER_MIDDLEWARES调用PhantomJs的方式实现爬虫后,被框架阻塞的问题纠结了很久,一直在想解决办法。以后我们会研究scrapyjs、splash等方式调用浏览器,看看能不能有效解决这个问题。

四、相关文件

一、Python即时网络爬虫:API说明

5. Jisouke GooSeeker开源代码下载源

1. GooSeeker开源Python网络爬虫GitHub源码

6.文档修改历史

1、2016-07-06:V1.0