分享文章:PbootCMS伪原创优化,PB文章采集发布伪原创

优采云 发布时间: 2022-10-30 13:17分享文章:PbootCMS伪原创优化,PB文章采集发布伪原创

如何优化Pbootcms伪原创,我们的Pbootcms伪原创优化网站的目的是什么?这是我们在优化 Pbootcms 之前需要考虑的问题。无论我们是单纯的分享还是盈利,建立网站肯定是希望更多的用户通过网站了解我们展示的信息来获得口碑或流量转化。

pbootcms伪原创优化也可以说是一项全面而长期的工作。无论是从服务器选择、网站结构布局到内容创建,都需要我们自己来做。通过不断的关键词优化和排名网站,我们可以获得好的流量,然后通过优质的内容留住用户,实现流量转化。

成功的 网站 需要增加流量以及更好的内容和服务。收录其网站尤为重要。当用户找到我们的 网站 时,大多数是通过搜索引擎找到的。收录的网站个数越大,我们的内容被搜索到的概率就越大。如何优化Pbootcms伪原创,根据我的个人经验,这里有几个Pbootcms伪原创的优化技巧。

保持 网站 定期更新

在 Pbootcms伪原创 优化的早期,当 网站 更新时,我们看不到集合或快照的变化,我们必须坚持下去。搜索引擎有一个沙盒时期。我们可以观察 网站 空间日志来了解蜘蛛是如何爬行的。如果蜘蛛爬行正常,那么我们需要保持更新,因为沙盒期过后收益会增加。

网站内容质量

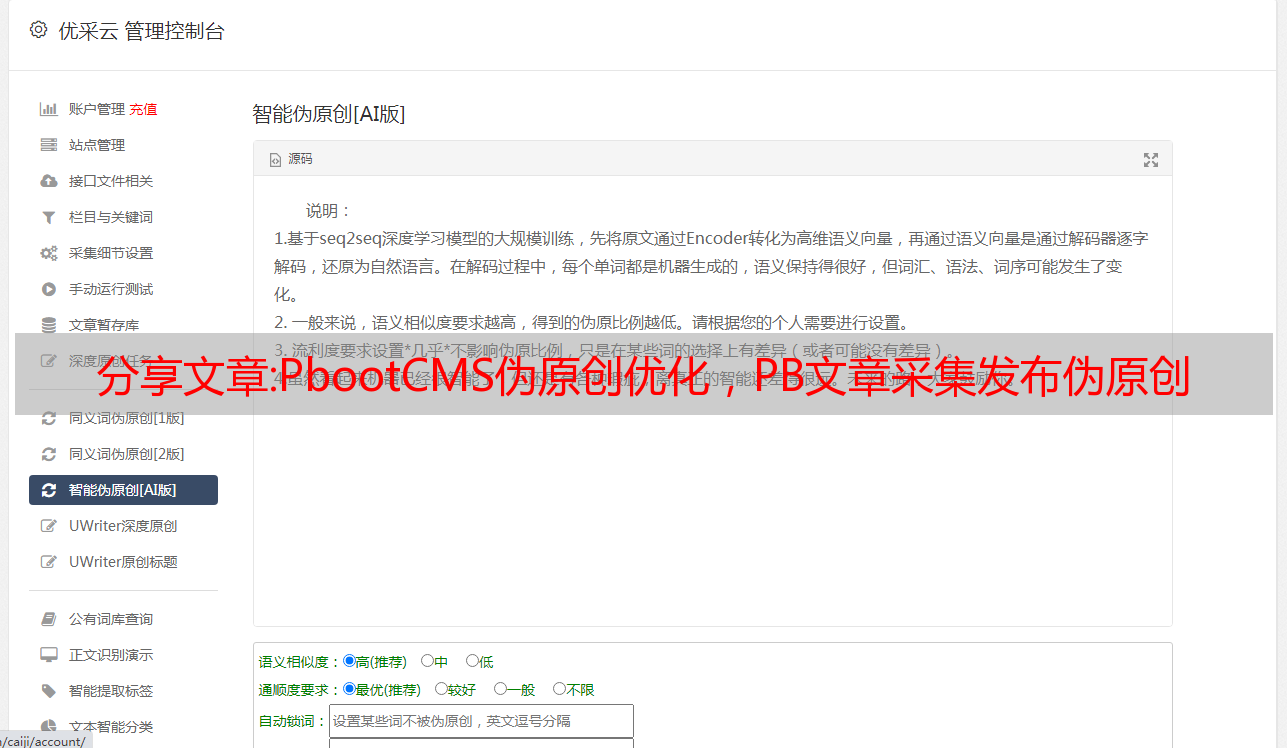

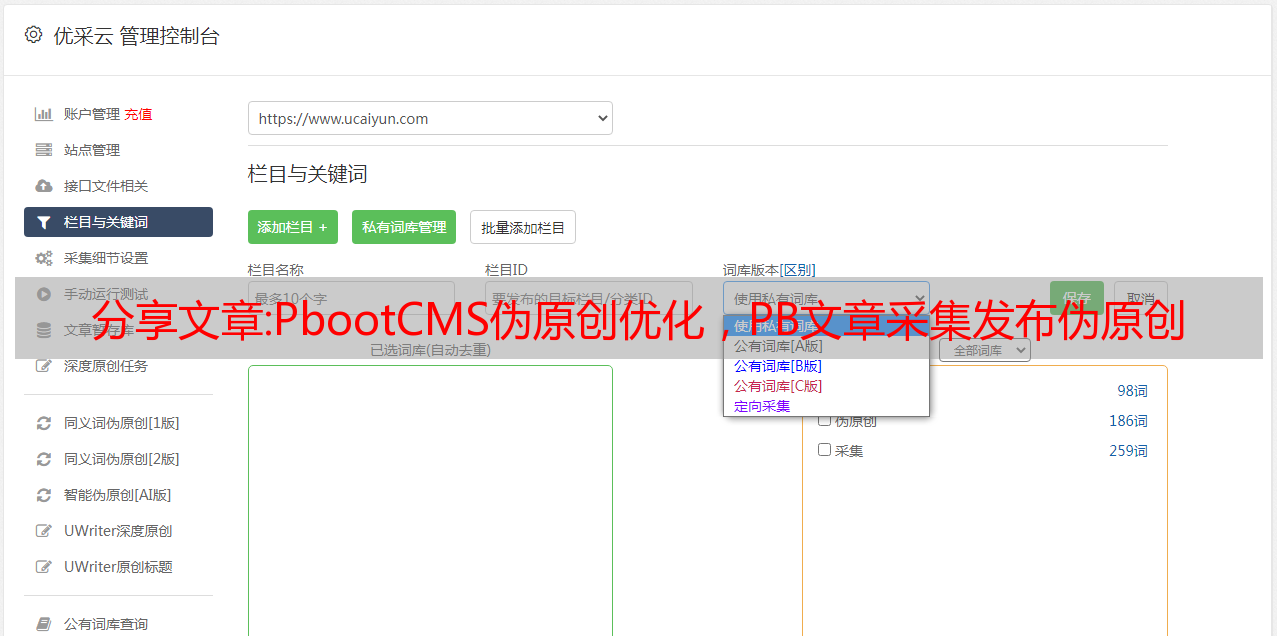

网站内容最好是原创,Pboot的质量cms伪原创优化原创比谁都知道。如果朋友说他不会写 文章 怎么办?我们也可以利用图中的软件实现网站内容的高质量更新,全网搜集素材,然后发布到本地伪原创最后通过文章自动发布>、Pbootcms 伪原创优化不需要输入复杂的参数,相关内容可以定时更新,支持图片替换、关键词密度、照片水印等。Pbootcms 伪原创优化不仅更像我自己写的,还提高了效率,提高了我们的

向搜索引擎提交的频率

在Pbootcms伪原创优化过程中,我们可以通过Pbootcms伪原创优化插件自动将链接推广到各大搜索引擎,缩短链接提交时间也可以算是提高我们收录概率的一个小技巧。

检查网站空间的稳定性

如果我们在Pbootcms伪原创优化中看不到spider爬取,那么我们需要考虑网站是否由于网站的影响而不受收录的影响空间。我们可以定期查看主机网站在同一IP下的收录情况。如果大面积出现问题,那么我们的网站就需要搬家了。

外部链接

这不是我们的能力。我们需要考虑 网站 的质量。一些友好的链接网站开始一个好的开始。几个月后,我们看到他们的 网站 没有更新、挂广告和销售链接。我建议删除这些网站,而不是给我们质量,它会拖累我们的网站。因此,Pbootcms伪原创优化应该经常检查友好链接的导出、快照、采集,以及外部链接的导出。如果没有,可以及时删除。

pbootcms伪原创优化插件观察日志

我们通过Pbootcms伪原创优化插件可以看到蜘蛛的爬行规律,一般都有时间模式。我们需要保证网站的空间稳定性,并在蜘蛛来之前更新内容,所有这些都需要在蜘蛛来之前完成。

网站推广贴士

pbootcms伪原创优化网站基础要扎实,也需要外推。推广技巧有很多。我们可以根据自己的优势去推广,各方面都可以做到最好,但我们还是根据自己擅长的资源去经营。如果我们擅长编写文章,我们就会有更多,如果我们擅长资源和友好的链接,那也很好。如果同样的推广方法是完美的,它就会成功。

Pbootcms伪原创优化不是一蹴而就的,需要长期维护。链接交换和 网站 更新都需要有计划的维护。在Pbootcms伪原创优化中,我们可以酌情使用Pbootcms伪原创优化插件来减轻我们的强度,无论是采集还是release还是伪原创,都有非常成熟的技术。当然,Pbootcms伪原创的优化不限于以上几项。有很多细节需要我们注意。每个网站都有自己的特点和自己的优化方向。pbootcms伪原创的优化只有注意总结和分析才能更好的完成。Pbootcms伪原创优化的分享到此结束。

技术文章:「从零开始学爬虫」采集站长之家文章数据

l 采集网站

【场景描述】采集站长之家文章数据。

【来源介绍网站】

站长之家(中国站长站)提供全面的站长资讯、源代码程序下载、海量建站素材、强大的搜索优化辅助工具、网络产品设计和运营理念,为个人站长和企业网络提供一站式服务。网络解决方案,我们为中文网站赋能十年。

【使用工具】在嗅探ForeSpider数据采集系统之前,免费下载:

【入口网址】

【采集内容】

采集站长电商分类中文章的数据,采集字段:标题、发布时间、来源平台、文字内容等。

【采集效果】如下图:

l 思想分析

配置思路概述:

l配置步骤

1.新建采集任务

选择【采集配置】,点击任务列表右上方的【+】号新建采集任务,在【】中填写采集入口地址采集Address]框,[Task Name]可以自定义,点击Next。

2.获取翻页链接

①在浏览器上打开页面,翻页,发现是瀑布流翻页。点击F12打开NetWork界面,继续翻页,找到翻页请求,如下图:

② 观察这些翻页请求的header,发现header中的请求链接和path参数随着翻页次数的变化而变化,如下图所示:

③编写脚本,拼接链接,具体脚本如下:

脚本文本:

<p>url u;

for(i=0;i