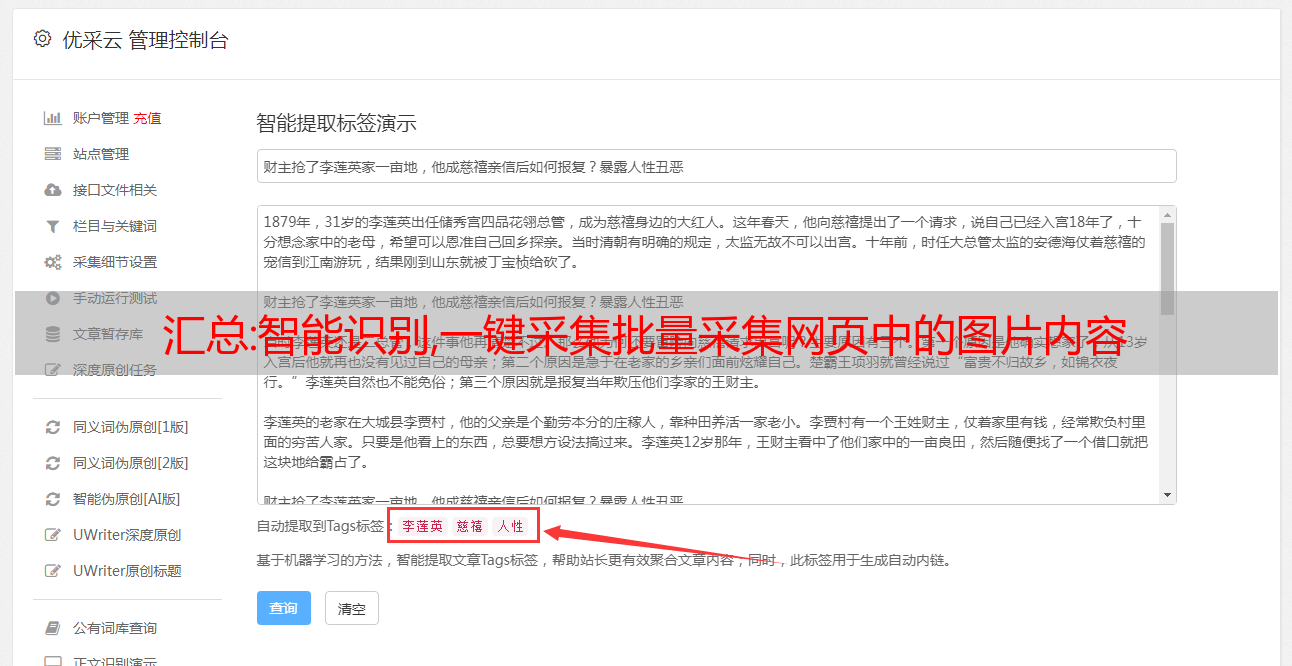

汇总:智能识别,一键采集批量采集网页中的图片内容

优采云 发布时间: 2022-10-29 02:10汇总:智能识别,一键采集批量采集网页中的图片内容

智能识别,一键采集,批量采集网页中的图片内容.请采用知己知彼,百战不殆的原则。

豆瓣的图片千千万万,1亿张肯定不止。这里说的不是图片数量,而是url。

1)爬虫去读豆瓣首页的爬虫地址就是你的图片url(类似这样的,

2)爬虫去爬爬虫还需要对图片进行归档,

3)下载图片时需要重新进行二次上传下载图片后需要整理成一个m5.5格式的文件(gif,jpg,png).

4)豆瓣图片全集下载按方法1,3已经整理成很大的文件了。接下来要把文件在浏览器中播放,进行比对。

5)上传图片时发现是jpg格式需要变成mp4格式然后再一个个上传。

6)文件删除完毕。

7)传播搜索。

8)爬虫还需要对图片进行标签编码,比如将"all"变成"all556"这样搜索的结果会更快。总的来说就是,多人搜索多人转发,不断爬新图片,不断的重复。

每张图片都提取api,其中一个id。在每个id下split,标有自己需要的文件。

泻药那么多图片,不可能直接的把api调用头给发送过去,毕竟首页存在n多图片,其中也有不少是爬虫爬的,所以还是要先整理一下后,再发出去,或者是专门爬这些。正常的流程是爬虫()爬这些api获取的url和文件,然后通过解析这些url获取图片,如果有图片文件的话。在后期有特殊需求的话,还要对图片文件进行解析和编码。

这些就要人工处理了。以上是正常流程,还有其他方法,想到了再更。最好玩的还是弄个java来,爬虫在前期就要做好,后期就可以任性。以上。