详细资料:邮箱提取器

优采云 发布时间: 2022-10-18 15:15详细资料:邮箱提取器

对于需要采集Email,如果没有好的软件,采集起来会很麻烦。在这里,小编给大家介绍一个Maxprog eMail Extractor邮箱地址采集提取工具,可以快速帮你从各种文件中提取邮箱地址。提取电子邮件地址并将可用地址输出到文件。

使用说明:知识兔

Maxprog eMail Extractor 可以从 网站 或 HTML 文件中抓取电子邮件,并将继续沿着超链接网页抓取。可以设置扫描的深度,或者忽略条件等,支持多路复用加载网页,也支持代理,可以通过命令行参数自动执行。

备注:这是一个电子邮件地址采集工具。Maxprog MaxBulk Mailer Pro官方中文注册版,本公司的另一款邮件群发工具,听听就完美了。

快速海量采集邮箱的小窍门 Knowledge Rabbit

1.采集网站邮件地址软件。通过扫描网页和相关链接,不断搜索网页上发布的电子邮件地址。我强烈推荐一虎邮件扫描大师、FastEmailSpider和商州邮箱采集大师。这些软件对于采集行业电子邮件地址很有用。建议您先采集一些行业的网址网站,然后使用这些软件搜索这些网站(例如:在BAIDU搜索,然后会出现一个很长的BAIDU网站,用那个网站搜索),可以得到很多活跃度比较高的邮箱。

2.搜索服务器邮箱软件。使用字典文件直接从邮件服务器采集电子邮件地址。我们强烈推荐电子邮件地址浏览器和一美捕手。知识兔整理了中国邮件服务器和国际邮件服务器的综合列表,以及字典文件。如果觉得知识渊博,如果兔子分享的邮箱不够用,可以用这个搜索软件自己搜索服务器邮箱。

3、搜索硬盘、光盘邮件地址软件。在计算机硬盘、CD 和软盘中的文本文件、Web 文件和 *.eml 格式文件中快速搜索电子邮件地址。重点推荐:小补店邮箱地址提取器和科兰邮箱地址搜索工具。基于本软件的用途,您还可以使用teleport等网站下载软件将供求信息BBS信息“拉回”到您的电脑,然后使用本软件搜索邮箱,您可以获得大量信息 一个有效的电子邮件地址。

如何从网站中的采集邮箱获取知识兔

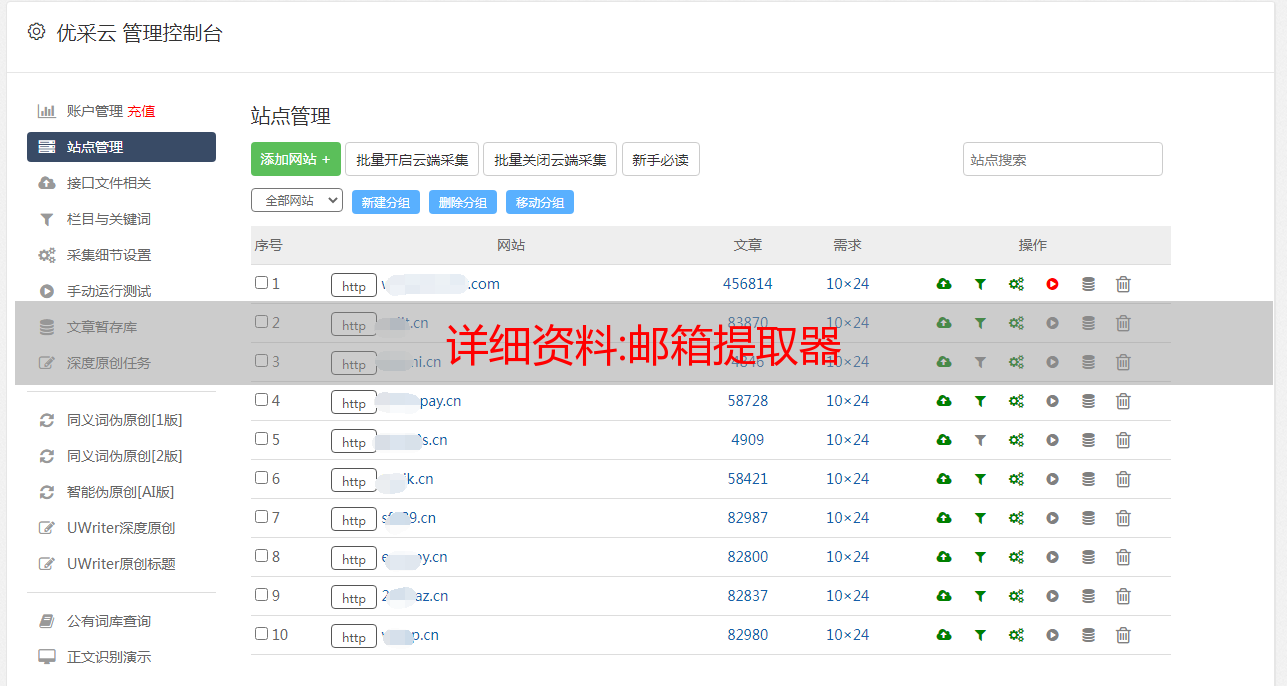

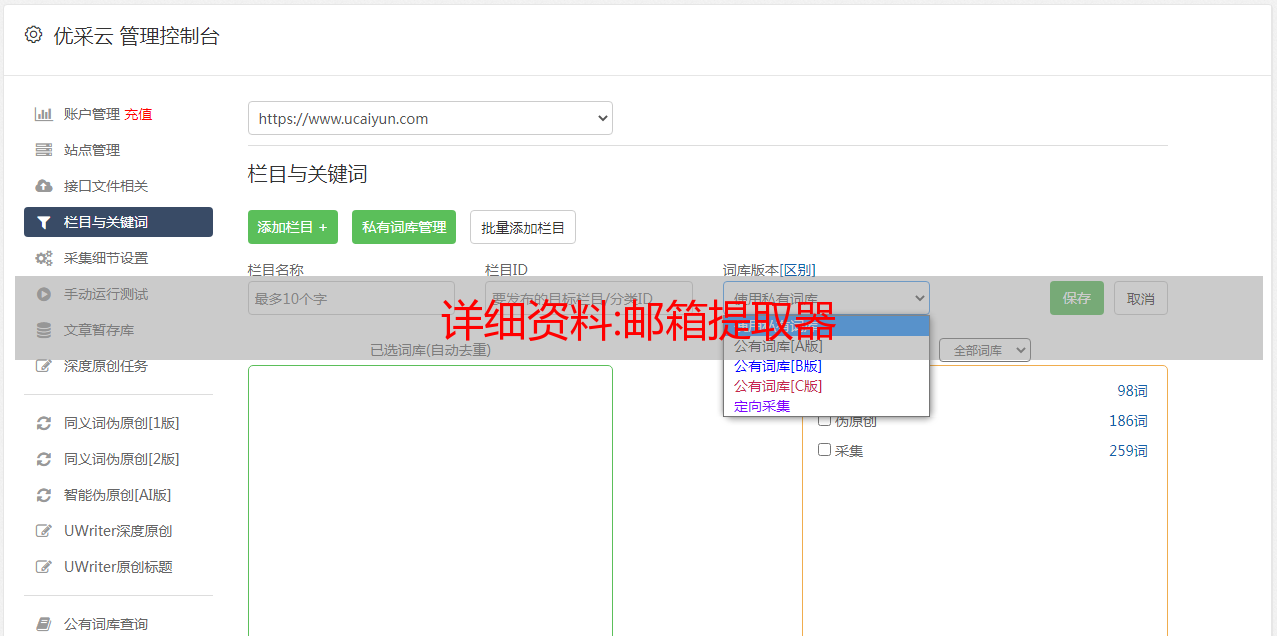

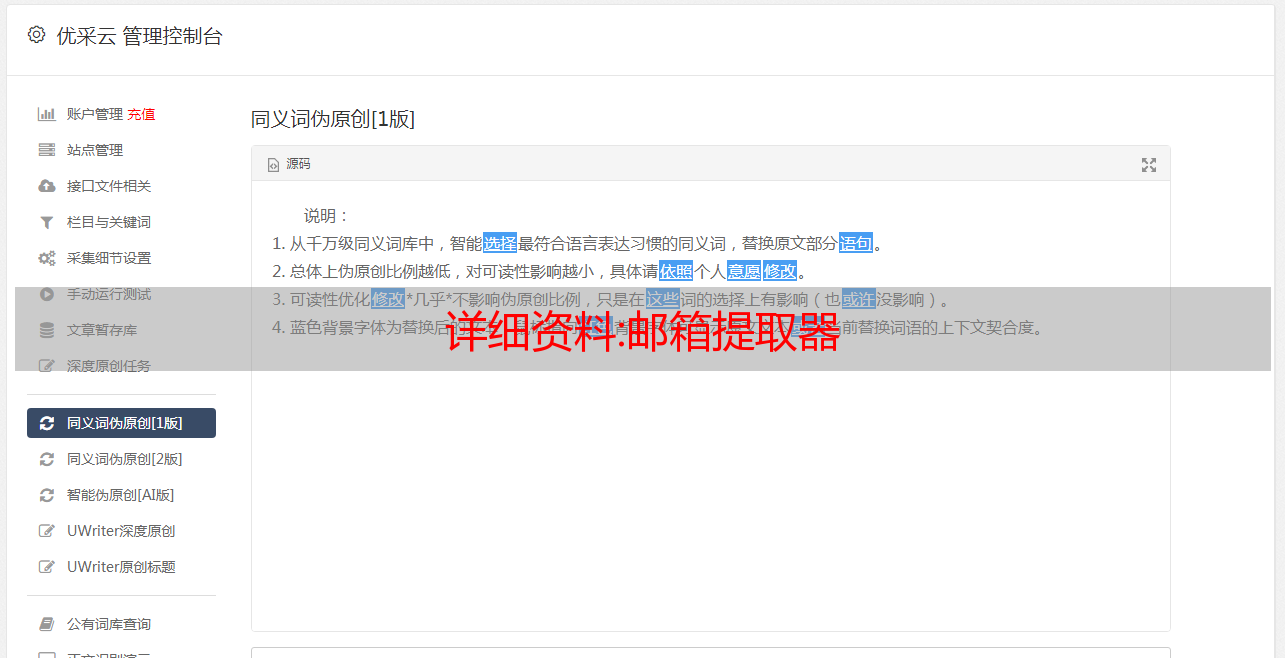

推荐优采云采集器软件,操作很简单,不用写采集规则,不用正则表达式,不用关心网页源码,新通用采集软件,全过程可视化操作,面向非网络专业技术人员。支持多种模板,支持网页深度嵌套访问,支持多库表单联合存储,支持多页内容合并采集。网站免费版本可供下载。优采云采集器是一个通用的采集软件,可用于采集邮件地址。

邮件营销知识兔

1. 什么是电子邮件营销?简单来说,营销是通过邮件进行的,可以分为许可邮件营销和非许可邮件营销。

2.邮件营销第一步:获取客户邮件地址。

3. 电子邮件营销 第 2 步:创建营销电子邮件。

4、邮件营销的第三步:群发。

5. 电子邮件营销 第 4 步:跟踪批量发送结果。

创世*敏*感*词*邮箱批量获取工具(创世贴吧邮件批量发件人) v2.0 免费绿色版

类型:Email 大小:1.2M 语言:中文时间:4-22 评分:5.0

点击下载

下载体验

点击下载

教程:PyHacker编写URL批量采集器

PyHacker 写入 URL 批处理采集器

更新时间:2022-05-14 14:34:02 作者:西安四海

本篇文章主要介绍SpringBoot集成VueEasyExcel导入导出数据。有需要的朋友可以借鉴。我希望它会有所帮助。祝你进步更大,早日升职加薪。

目录

喜欢用Python写脚本的朋友可以一起写。

编写环境:Python2.x

00x1:要使用的模块

所需模块如下:

import requests

import re

本文将使用re正则进行讲解,如果使用Xpath,还可以

00x2:选择搜索引擎

首先,我们需要选择一个搜索引擎(其他搜索引擎的原理都是一样的)

以必应为例:

先分析bing翻页机制:

https://cn.bing.com/search?q=内容&first=0 第一页

https://cn.bing.com/search?q=内容&first=10 第二页

https://cn.bing.com/search?q=内容&first=20 第三页

页数=首页*10

分析完,我们要求看看

def req():

url = 'https://cn.bing.com/search?q=小陈&first=0'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64; rv:60.0) Gecko/20100101 Firefox/60.0'}

req = requests.get(url,headers=headers)

html = req.content

print html

好的,没问题

00x3:分析需要采集的url

分析需要采集的url在哪里

获取常规:(.*?)

正则表达式学习:(百度搜索:python正则表达式)

def reurl():

urlr = r'(.*?)'

reurl = re.findall(urlr,html)

print reurl

当我请求第二页时发现问题

可以看到请求内容和首页一样,有某种验证机制

一般的验证机制,代表特定参数

经过多次测试,发现缺少cookie:_EDGE_V=1;

请求正常,快完成了

接下来,你只需要给 关键词 和页码变量就可以了

00x4:搜索

再次搜索网站:又出问题了

所以修改正则为:

'target="_blank" href="(http.*?\..*?\..*?)" h="'

有很多我们不想要的结果,我们来遍历采集的url

做一些处理

常规是:

(http[s]?://.*?)/

代码是:

def url():

for url in urls:

urlr = r'(http[s]?://.*?)/'

url = re.findall(urlr,url)

print url

将 print url 更改为 print url[0] 并再次处理

可以看到下面有重复的url,重复url

def qc():#去重复

for url in url_ok:

if url in url_bing:

continue

url_bing.append(url)

00x5:自动保存

接下来我们要他自动保存到url_bing.txt

with open('url_bing.txt','a+')as f:

for url in url_bing:

print url

f.write(url+"\n")

print "Save as url_bing.txt"

00x6:完整代码

#!/usr/bin/python

#-*- coding:utf-8 -*-

import requests

import re

urls = []

<p>

url_ok = []

url_bing=[]

def req(q,first):

global html

url = 'https://cn.bing.com/search?q=%s&first=%s'%(q,first)

print url

headers = {

'Host':'cn.bing.com',

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/65.0.3314.0 Safari/537.36 SE 2.X MetaSr 1.0',

'Cookie': '_EDGE_V=1;'

}

req = requests.get(url,headers=headers)

html = req.content

def reurl():#正则匹配url

urlr = r'target="_blank" href="(http.*?\..*?\..*?)" h="'

reurl = re.findall(urlr,html)

for url in reurl:

if url not in urls:

urls.append(url)

def url():#url二次处理

for url in urls:

urlr = r'(http[s]?://.*?)/'

url = re.findall(urlr,url)

url_ok.append(url[0])

def qc():#去重复

for url in url_ok:

if url in url_bing:

continue

url_bing.append(url)

if __name__ == '__main__':

q = raw_input('\nkey:')

page = input('page:')

for first in range(0, page):

req(q, first * 10)

reurl()

url()

qc()

with open('url_bing.txt','a+')as f:

for url in url_bing:

print url

f.write(url+"\n")

print "Save as url_bing.txt"</p>

以上就是PyHacker编写的URL批处理采集器的详细内容。更多关于PyHacker的URL批处理采集的信息,请关注脚本之家文章的其他相关话题!