技巧:免费英文翻译成中文的工具-英文批量翻译中文的工具-各大语言互译工具

优采云 发布时间: 2022-10-17 14:16技巧:免费英文翻译成中文的工具-英文批量翻译中文的工具-各大语言互译工具

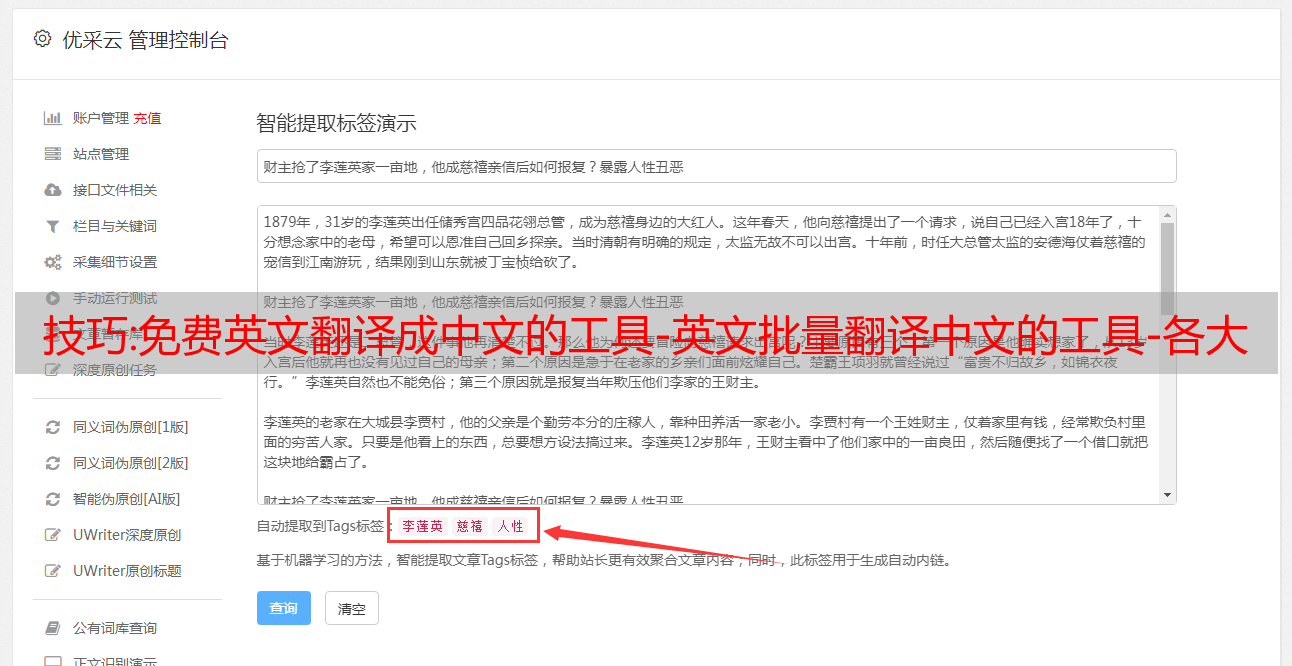

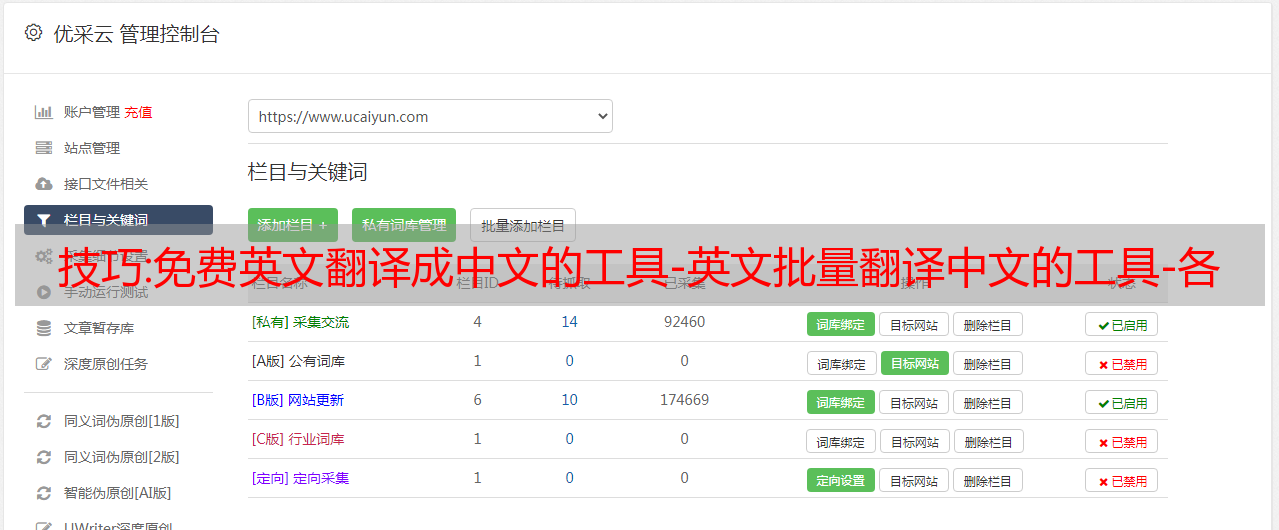

免费的英译汉翻译软件,什么样的免费英译汉翻译软件才能称得上好翻译软件?首先第一点是翻译质量高,第二点可以批量翻译,第三点是保持翻译前的格式。第四点支持采集翻译。今天给大家分享一款支持以上所有功能的免费英汉翻译软件。详情请参考以下图片!!!

1.免费英译中软件介绍

1. 支持多种优质翻译平台(批量百度翻译/谷歌翻译/有道翻译,让内容质量更上一层楼)。

2.只需要批量导入文件即可实现自动翻译,翻译后保留原版面格式

3、同时支持文章互译:从中文翻译成英文再翻译回中文。

4.支持采集翻译(可以直接翻译采集英文网站)

5个被忽视的真正重要的SEO技术

SEO技术在当今瞬息万变的世界中不断变化,大多数人可能没有意识到免费的英文到中文翻译软件。

一年前起作用的黑客不仅在今天已经过时,它们还会损害您的 网站 搜索引擎排名,特别是如果它们受到 Google 的惩罚。

在 SEO 中保持更新非常重要,这样当搜索引擎结果页面 (SERP) 中的竞争超过您时,您就不会落后。

今天使用了几种 SEO 技术来帮助 网站所有者和营销人员提高他们的排名,同时增加自然流量。

谷歌排名如何运作

当人们在线搜索信息时,他们会键入或说出与他们正在寻找的内容相关的词。

这些被称为关键字,它们通常有助于填充最佳搜索结果,但它们并不是决定您的 网站 是否会在第 1 页上排名的唯一因素。

搜索引擎排名还关注网站信息的质量,检查页面目的、权威、专业知识以及作者和内容的可信度等因素。

它还考虑了关于 网站 和作者或内容创建者的内容和信息的质量和数量以及他们的声誉。

基于这些因素,搜索引擎将首先提供最相关、高质量的结果,其余的将出现在连续的页面上。

但是,不能保证在第 1 页上的排名。

由于 SEO 的复杂性,许多 网站 所有者和营销人员选择在围绕它们制定策略时坚持他们理解的规则。

这意味着他们忽略了其他排名因素,当他们的页面未能在搜索引擎上排名时,他们最终会感到沮丧,因为谷歌的算法每两年都会改变他们的排名因素。

我们搜索了今天仍然很重要的经常被忽视的 SEO 策略,以下是我们发现的概述:

检查页外标题和元描述

无论您的业务规模或 网站 或您的预算大小,免费的英译中翻译软件都是最大化您的 SEO 努力的重要因素。

优化页面标题和元描述不需要高级专业知识,但它确实有助于提高搜索引擎结果的点击率。

针对正确的关键字进行优化

在 SEO 方面,公司往往过度投资并主要关注关键字,而免费的英汉翻译软件是该过程的重要组成部分。

但是,他们忽略了正确关键字的关键字优化,这可能会影响他们的工作。

免费的英汉翻译软件无需查找、关注和投资大量关键字,而是列出您认为描述您的网站或业务的关键字和短语。

许多人可能正在搜索这些确切的单词,并且由于搜索量很大,您可能很难将它们带到最热门的结果之一。

扎实、优质的内容

内容是 SEO 的基础,并且通常投资不足,免费的英译中翻译软件,因为人们正在寻找噱头让谷歌更喜欢他们的内容。

相反,您需要创建可靠、高质量的内容,同时引用 网站 上的其余内容。这不仅为搜索引擎提供了有关您的专家的更多信息,而且还有助于您的 网站 对更相关的术语和所需的初始关键字进行排名。

技巧:【零基础学爬虫】第一章:了解python中的requests库

目录

前言

从今天开始,博主不会写15篇左右的文章文章来带领大家学习爬虫。爬行其实并不难。如果你坚持学习这个博客,你就可以开始做项目了!

需要注意的是,建议您熟练使用谷歌浏览器,并学习查看后台源码和抓包程序,这是学习爬虫必不可少的过程。如果没有,你可以和我讨论!

本文主要介绍爬虫的一些基本概念,教大家如何编写最简单的爬虫程序。由于篇幅有限,我们将重点总结经验。如有任何问题,欢迎在评论区留言讨论!看过的朋友,不要关注+点赞+采集!

一、爬行动物简介 1、什么是爬行动物?

一般来说,爬虫是通过编写程序模拟浏览器上网,然后让它从网上获取数据的过程。(模拟浏览器上网就是后面用User-Agent伪装)

当然,很多人说学习爬虫是从入门到坐牢。爬虫本身并不违法,但不要利用这种技术做违法的事情。

2.爬行动物的分类

- 万能爬虫:爬虫系统的重要组成部分。它抓取一整页数据。(本节介绍)

- 聚焦爬虫:基于一般爬虫。爬取是页面的特定部分内容。

- 增量爬虫:检测 网站 中的数据更新。只会捕获 网站 中最新更新的数据。

三、爬虫注意事项

①部分网站具有反爬功能,需要伪装后才能被爬取。

②robots.txt协议:君子协议。指定网站中哪些数据可以被爬虫爬取,哪些数据不能被爬取。

③ 常用请求头信息

- User-Agent:请求载体的身份

- 连接:请求完成后,是断开连接还是保持连接

④ 通用响应头信息

- Content-Type:服务器响应回客户端的数据类型

二、requests模块 1.简介

我们在使用python爬虫时,需要模拟和发起网络请求。使用的主要库是 requests 库和 python 内置的 urllib 库。urllib模块比较老旧,操作繁琐复杂。所以推荐使用requests,它是对urllib的重新封装。,他们使用的主要区别:

请求可以直接构建和发起常见的 get 和 post 请求。urllib 一般会先构建 get 或 post 请求,然后再发起请求。

2.requests模块的编码过程

- 指定网址

- 用户代理 (UA) 伪装

- 处理请求参数

- 发起请求(获取或发布请求)

- 获取响应数据

- 持久存储(保存到 excel 或数据库)

下面我将通过几个例子来演示在requests模块中爬取整个网页的get和post请求的过程。

三、案例一、需求:爬取搜狗首页的页面数据

这是最基本的爬虫。它爬取的是整个静态html网页的源码,response一般用在response中。

#- 需求:爬取搜狗首页的页面数据

import requests

if __name__ == "__main__":

#step_1:指定url

url = 'https://www.sogou.com/'

#step_2:发起请求

#get方法会返回一个响应对象

response = requests.get(url=url)

#step_3:获取响应数据.text返回的是字符串形式的响应数据

page_text = response.text

print(page_text) # 输出的就是该网页的源码

#step_4:持久化存储

with open('./sogou.html','w',encoding='utf-8') as fp:

fp.write(page_text)

print('爬取数据结束!!!')

2.爬取搜狗上指定入口对应的搜索结果页面(简单网页采集器)

①首先我们需要介绍UA:User-Agent(请求载体的标识)

-UA检测:门户网站的服务器会检测相应请求的运营商ID。如果检测到请求的运营商ID是某个浏览器,则说明该请求是正常请求。但是,如果检测到请求的载体标识不是基于某个浏览器的,则说明该请求是异常请求(爬虫),服务器端很可能拒绝该请求。

-UA伪装:让爬虫对应的请求载体身份伪装成浏览器。

-UA搜索:通过查看浏览器背景可以找到自己的UA。

②ajax动态请求

这个案例是一个ajax动态请求。Ajax是一种浏览器通过js异步发起请求并在本地更新页面的技术。对于ajax请求的部分更新,浏览器地址栏不会改变,部分更新不会丢弃原页面的内容。

import requests

if __name__ == "__main__":

#UA伪装:将对应的User-Agent封装到一个字典中

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'

}

url = 'https://www.sogou.com/web'

<p>

#处理url携带的参数:封装到字典中

kw = input('enter a word:')

param = {

'query':kw

}

#对指定的url发起的请求对应的url是携带参数的,并且请求过程中处理了参数

response = requests.get(url=url,params=param,headers=headers)

page_text = response.text

fileName = kw+'.html'

with open(fileName,'w',encoding='utf-8') as fp:

fp.write(page_text)

print(fileName,'保存成功!!!')</p>

3.破解百度翻译

import requests

import json

if __name__ == "__main__":

#1.指定url

post_url = 'https://fanyi.baidu.com/sug'

#2.进行UA伪装

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'

}

#3.post请求参数处理(同get请求一致)

word = input('enter a word:')

data = {

'kw':word

}

#4.请求发送

response = requests.post(url=post_url,data=data,headers=headers)

#5.获取响应数据:json()方法返回的是对象(如果确认响应数据是json类型的,才可以使用json())

dic_obj = response.json()

#持久化存储

fileName = word+'.json'

fp = open(fileName,'w',encoding='utf-8')

json.dump(dic_obj,fp=fp,ensure_ascii=False)

print('over!!!')

4.爬取豆瓣电影分类列表中的电影详情数据

import requests

import json

if __name__ == "__main__":

url = 'https://movie.douban.com/j/chart/top_list'

param = {

'type': '24',

'interval_id': '100:90',

'action':'',

'start': '0',#从库中的第几部电影去取

'limit': '20',#一次取出的个数

}

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'

}

response = requests.get(url=url,params=param,headers=headers)

list_data = response.json()

fp = open('./douban.json','w',encoding='utf-8')

json.dump(list_data,fp=fp,ensure_ascii=False)

print('over!!!')

5.爬取肯德基餐厅查询中指定位置的餐厅数据

滚动到底部并单击“餐厅搜索”

import requests

if __name__ == '__main__':

post_url = 'http://www.kfc.com.cn/kfccda/ashx/GetStoreList.ashx?op=keyword'

word = input('input a word:')

param ={

'cname': '',

'pid': '',

'keyword': word,

'pageIndex': '1',

'pageSize': '10',

}

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36"

}

response = requests.post(url=post_url, data=param, headers=headers)

data = response.text # 字符串类型 str

print(type(data))

print(data)

6.根据《中华人民共和国化妆品生产许可证》抓取国家药品监督管理局相关资料:81/xk/

这道题是本节综合题,难度有点大。因为是笔记总结,我就不过多描述了。

这个问题有点套娃的意思,因为不是网页中的所有信息都是静态展示的,所以在爬取内容的时候要注意是否有ajax动态请求的网页。

而如果要爬取几页信息,就需要创建一个for循环。

import requests

import json

if __name__ == "__main__":

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.88 Safari/537.36'

}

id_list = [] # 存储企业的id

all_data_list = [] # 存储所有的企业详情数据

#批量获取不同企业的id值

url = 'http://125.35.6.84:81/xk/itownet/portalAction.do?method=getXkzsList'

#参数的封装

for page in range(1,6):

page = str(page)

data = {

'on': 'true',

'page': page,

'pageSize': '15',

'productName':'',

'conditionType': '1',

'applyname':'',

'applysn':'',

}

json_ids = requests.post(url=url,headers=headers,data=data).json()

for dic in json_ids['list']:

id_list.append(dic['ID'])

#获取企业详情数据

post_url = 'http://125.35.6.84:81/xk/itownet/portalAction.do?method=getXkzsById'

for id in id_list:

data = {

'id':id

}

detail_json = requests.post(url=post_url,headers=headers,data=data).json()

# print(detail_json,'-------------ending-----------')

all_data_list.append(detail_json)

#持久化存储all_data_list

fp = open('./allData.json','w',encoding='utf-8')

json.dump(all_data_list,fp=fp,ensure_ascii=False)

print('over!!!')