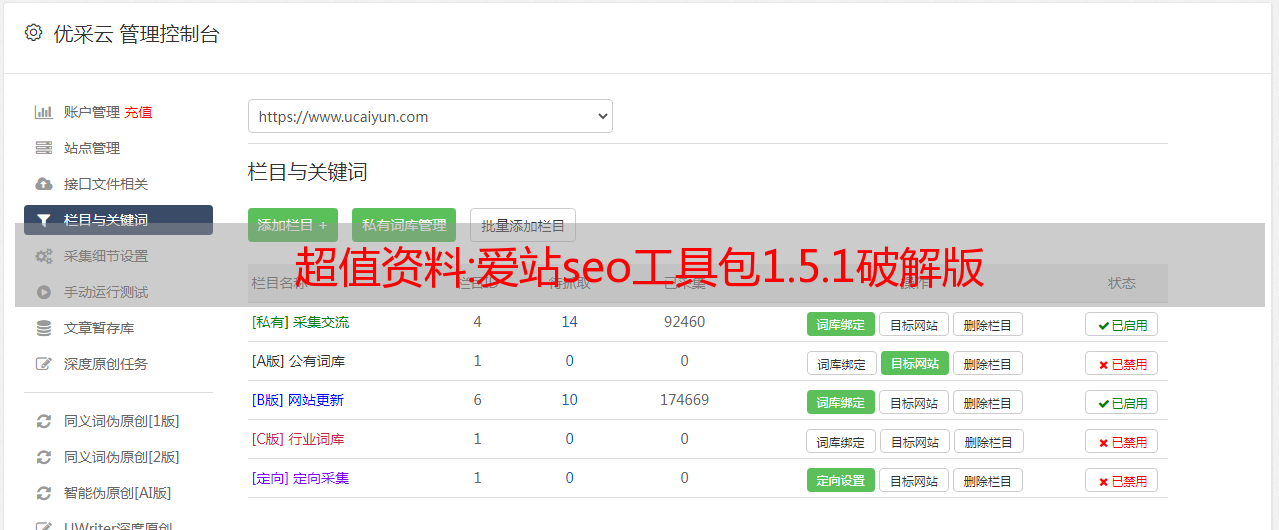

超值资料:爱站seo工具包1.5.1破解版

优采云 发布时间: 2022-10-16 23:11超值资料:爱站seo工具包1.5.1破解版

爱站seo toolkit破解版下载,爱站seo工具是一个网站数据查询应用软件。爱站工具包涵盖seo诊断、关键词搜索、收录费率查询等实用功能,为广大网站工作者提供了非常方便的便利。欢迎需要此软件的朋友下载使用。

【软件功能】

1、SEO诊断:快速发现网站SEO状态,自动给出评分和优化方向,方便网站及时改进。

2、关键词监控:带关键词实时排名查询、关键词索引查询、关键词排名变化监控、关键词历史排名、关键词 排名数据分析等

3、收录率/死链接查询:爱站SEO工具包可以快速抓取网址,准确查询网站的收录率和死链接。

4、站群查询:爱站SEO Toolkit站群查询工具的查询内容包括:收录、权重、PR、快照、反向链接、网站IP 、导出链接、建站时间、ICP备案等查询功能,可批量查询站群的SEO状态。

5.网站日志分析:该工具可以自动识别IIS、Apache、Nginx日志格式的访问次数、停留时间、总爬取量、状态码,供不同的搜索引擎蜘蛛分析数据、统计和统计生成图表。

6、关键词查询:爱站SEO工具包的关键词查询工具原名爱站开发的飞达路长尾查询工具。经过技术升级,新版本的体验比飞达路更好。它可以高效地挖掘长尾词并查询 关键词 索引。

7、百度外链处理:百度外链助手工具是辅助站长处理百度拒绝外链的神器。,快速生成需要拒绝的外部链接。

8、综合查询:爱站SEO工具包的综合查询工具是一个综合查询工具,包括

百度权重、百度快照、谷歌公关、预计百度访问、爱站外部链接、出站链接、首页内部链接、24小时收录、一周收录、一月收录 , 以及各大搜索引擎(百度、谷歌、360搜索、搜狗)的收录数量和反向链接的综合查询工具。

9、关键词远程排名查询:远程排名查询是查询域名关键词所属区域的搜索引擎排名。

10、其他工具:网站监控、好友链查询、关键词密度检测、机器人检测/生产、加密工具、转码工具

【使用说明】

1. 点击综合查询,输入要查询的网址,点击查询。

2、一键全面查询(收录在此工具中)所有数据一目了然,失败可重新检查,查询结果如下:

分享:一文给你源码直接爬取百度图片收集数据集

作为一个AI新手,短时间内不可能直接掌握爬虫,但苦于数据集不足,又懒惰,不想一个个下载。我应该怎么办?

别着急,小编整理了一套简单粗暴的百度图片爬取源码

简单易用,一手掌握

话不多说,上源码,爬取百度图片

import re

import requests

from urllib import error

from bs4 import BeautifulSoup

import os

num = 0

numPicture = 0

file = ''

List = []

def Find(url):

global List

print('正在检测图片总数,请稍等.....')

t = 0

i = 1

s = 0

while t < 4000:

Url = url + str(t)

try:

Result = requests.get(Url, timeout=7)

except BaseException:

t = t + 60

continue

else:

result = Result.text

pic_url = re.findall('"objURL":"(.*?)",', result, re.S) # 先利用正则表达式找到图片url

s += len(pic_url)

if len(pic_url) == 0:

break

else:

List.append(pic_url)

t = t + 60

return s

<p>

def recommend(url):

Re = []

try:

html = requests.get(url)

except error.HTTPError as e:

return

else:

html.encoding = 'utf-8'

bsObj = BeautifulSoup(html.text, 'html.parser')

div = bsObj.find('div', id='topRS')

if div is not None:

listA = div.findAll('a')

for i in listA:

if i is not None:

Re.append(i.get_text())

return Re

def dowmloadPicture(html, keyword):

global num

# t =0

pic_url = re.findall('"objURL":"(.*?)",', html, re.S) # 先利用正则表达式找到图片url

print('找到关键词:' + keyword + '的图片,即将开始下载图片...')

for each in pic_url:

print('正在下载第' + str(num + 1) + '张图片,图片地址:' + str(each))

try:

if each is not None:

pic = requests.get(each, timeout=7)

else:

continue

except BaseException:

print('错误,当前图片无法下载')

continue

else:

string = file + r'\\' + keyword + '_' + str(num) + '.jpg'

fp = open(string, 'wb')

fp.write(pic.content)

fp.close()

num += 1

if num >= numPicture:

return

if __name__ == '__main__': # 主函数入口

word = input("请输入搜索关键词(可以是人名,地名等): ")

#add = 'http://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=%E5%BC%A0%E5%A4%A9%E7%88%B1&pn=120'

url = 'http://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=' + word + '&pn='

tot = Find(url)

Recommend = recommend(url) # 记录相关推荐

print('经过检测%s类图片共有%d张' % (word, tot))

numPicture = int(input('请输入想要下载的图片数量 '))

file = input('请建立一个存储图片的文件夹,输入文件夹名称即可')

y = os.path.exists(file)

if y == 1:

print('该文件已存在,请重新输入')

file = input('请建立一个存储图片的文件夹,)输入文件夹名称即可')

os.mkdir(file)

else:

os.mkdir(file)

t = 0

tmp = url

while t < numPicture:

try:

url = tmp + str(t)

result = requests.get(url, timeout=10)

print(url)

except error.HTTPError as e:

print('网络错误,请调整网络后重试')

t = t+60

else:

dowmloadPicture(result.text, word)

t = t + 60

print('当前搜索结束,感谢使用')

print('猜你喜欢')

for re in Recommend:

print(re, end=' ')</p>

其背后的原理就不多解释了。如果你非要问我源码是什么,网上有很多资料,大家可以系统学习一下,等你真正学会爬虫,自然就能掌握了~

你可以直接使用它,不管你要爬什么图片。

是不是很神奇~