汇总:自动采集文章 自动采集文章小程序

优采云 发布时间: 2022-10-04 16:12汇总:自动采集文章 自动采集文章小程序

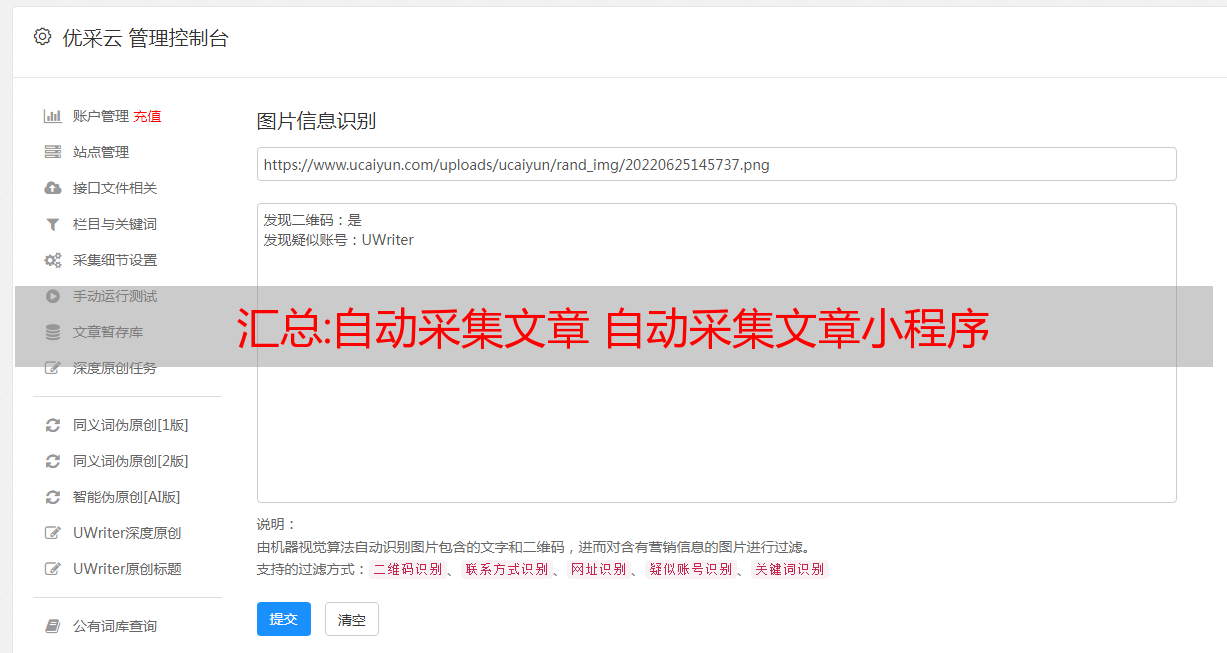

自动采集文章、自动采集文章小程序、自动采集文章.net

自动采集文章看到6.5采集的采集库中有一个字段到了,在数据库中可以查看,但是无法导入主数据库,我该怎么办?

采集 时我想调用的 文章 的地址在我 采集 的 文章 中

自动采集文章网站优化是通过对网站功能、网站结构、网页布局、网站的合理设计来配合网络内容等元素 营销网站资金。来源,网站进行优化以符合搜索引擎检索习惯,从而提高关键词在搜索引擎中的排名。

用乐思软件做采集,可以自动采集easy收录和流行的文章根据搜索引擎或者主流网站,这样做SEO,效果也一样会好的

全网热点话题:

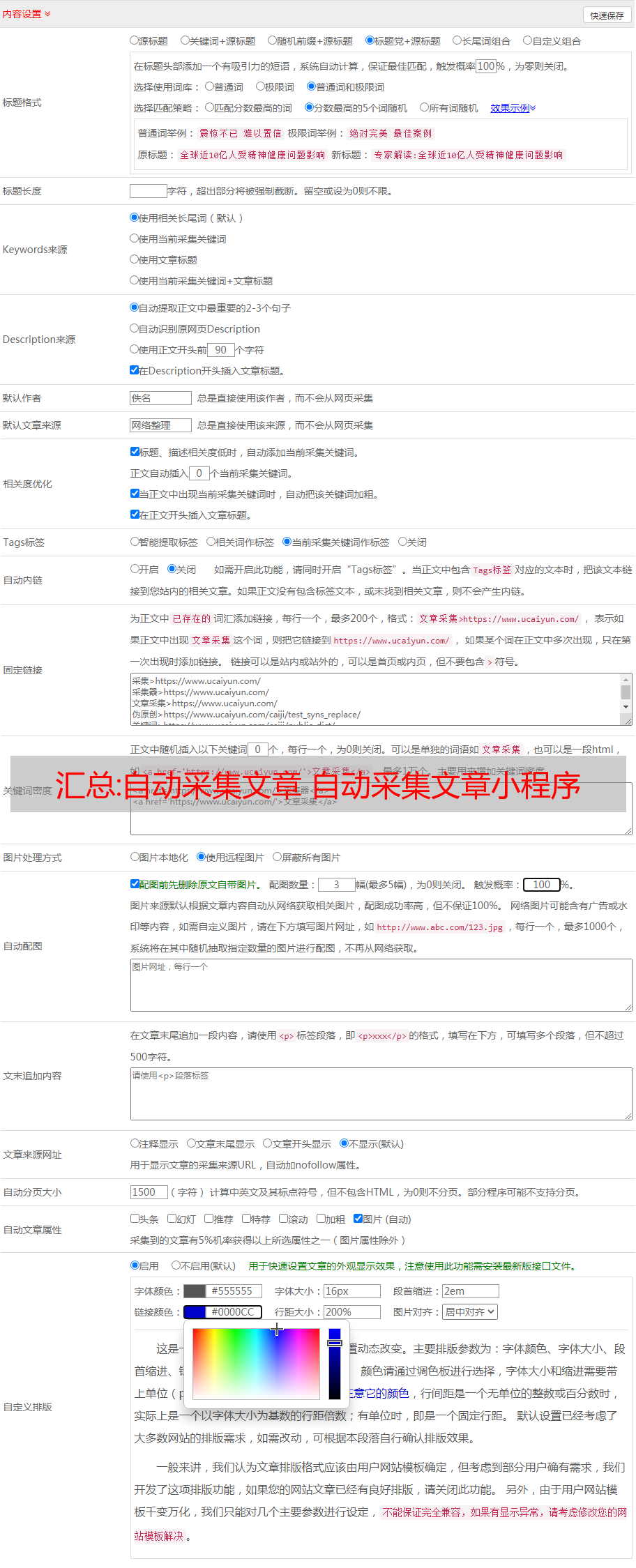

1楼,自动采集文章怎么做:可以自动批量关键词采集可以设置3个采集都在具体的URL频道目录下文章内容(比如简单,贴吧百度),智能系统匹配,不用写复杂

2楼,自动采集文章发送:自动采集文章内容和发布内容经历了几个月的敲打,自动采集文章内容与自动发布文章内容已上线,简单易用的操作面板,

3楼,自动采集文章获取方法:今天为大家带来微信公众号文章采集教学微信公众号采集现在网上很多有各种方法和软件,免费和付费,但质量各不相同

即将到来的节日:9月中秋节放假3天!不管多忙,都要对自己好一点!

自动采集文章自动采集文章小程序完成!

技术文章:用shell实时分析网站seo日志,随意且方便

网站分析

日志,也是SEO的工作数据监控,网站日志分析主要是分析百度爬虫访问网站服务器信息,包括访问ip、访问蜘蛛信息、访问页面和访问等信息,通过这些信息,我们可以分析我们网站的情况,并做出以下SEO优化方向。

分析网站日志,

互联网上有很多日志工具,光年日志工具,SEO框等都有分析日志的功能。如果可以对命令进行外壳处理,则分析日志将变得简单而任意。我们来简要分析一下网站日志百度流量和百度抓取页面

首先,我们找到日志文件的路径

在 linux 服务器中: /www/wwwlogs/xxxx.log 这是服务器的日志文件,我们可以在其中找到那些访问我们服务器的互联网,以及访问了哪些页面。

1. 百度访问网站日志

基本命令:

awk '/Baiduspider/{x++} END{print "百度访问量:",x}' mufen.log

使用此命令,您可以过滤百度访问日志,并通过计算查看百度访问总量

2. 网站访问页面

awk '/Baiduspider/{print "百度访问页面:",$7}' mufen.log | sort | uniq -c

此命令可以查看网站百度访问的页面信息,其中排序:排序 uniq:重复数据删除

在这里,我们将简单地分析这两点,然后我们可以将这两个命令写入shell文件,并且shell命令运行的文件以.sh结束,因此我们可以这样编写它。

这里只是简单地修改了一下,再加上实时日期,这样您就可以获得当天的实时日志数据。这样,在运行bash log.sh 将打印当天的数据

在运行 log.sh 时,每次切换到相应的目录还是很麻烦的,所以我们可以把运行文件路径放到PATH环境变量中。路径=$PATH:/万维/万维日志很好。