汇总:可视化数据采集器import.io与集搜客评测对比

优采云 发布时间: 2022-10-01 06:09汇总:可视化数据采集器import.io与集搜客评测对比

大数据企业报告:大数据产品、大数据解决方案、

大数据数字

分享大数据干货:大数据书籍、大数据报告、

大数据视频

本文是为大数据做出贡献的人的集合。欢迎更多优质原创文章大数据人士投稿:

摘要:国外大数据软件采集Import.io最近很火。在获得90万美元天使轮融资后,最近又获得了1300万美元的A轮融资,吸引了很多我也在使用和体验import.io神奇功能的投资者。我是中国大数据采集软件合集GooSeeker的老用户,所以喜欢把两者放在一起比较。印象最深的功能对比讲解,分别对应import.io的四大功能:Magic、Extractor、Crawler、Connector,分别评价。

对data采集比较感兴趣的朋友,希望能起到吸点新意的作用,一起来分析data采集的技术亮点。

1.Magic (Import.io) VS 天眼千面 (Jizouke)

魔法 -

正如magic这个词的原意是“魔法”一样,import.io赋予了Magic一个神奇的功能。只要用户输入 URL,Magic 工具就可以神奇的将网页中的数据整齐、标准地抓取。

如图1所示,输入58同城租房信息URL后,Magic会自动采集网页数据,操作简单。但是可以看到可能会漏掉一些栏目,每页都需要点击“下一页”进行采集,无法自动翻页。当然,还有很多页面几乎没有采集可以下载,比如新浪微博。

总之,我觉得很神奇:

1)他怎么知道我想要什么信息?

2) 是不是有人在后台预先制作的?

3)有些网址输入后等待时间短,有些网址输入后等待时间长。真的有人在后台执行 采集 规则吗?

图 1:Magic Autocrawl 示例

上图是import.io的Magic功能截图。它是一个纯网页界面,使用起来非常方便,无需安装额外的软件。综上所述:

优点:适应任何URL,操作非常简单,自动采集、采集结果可视化。

缺点:不能选择具体数据,不能自动翻页采集(没用吗?)。

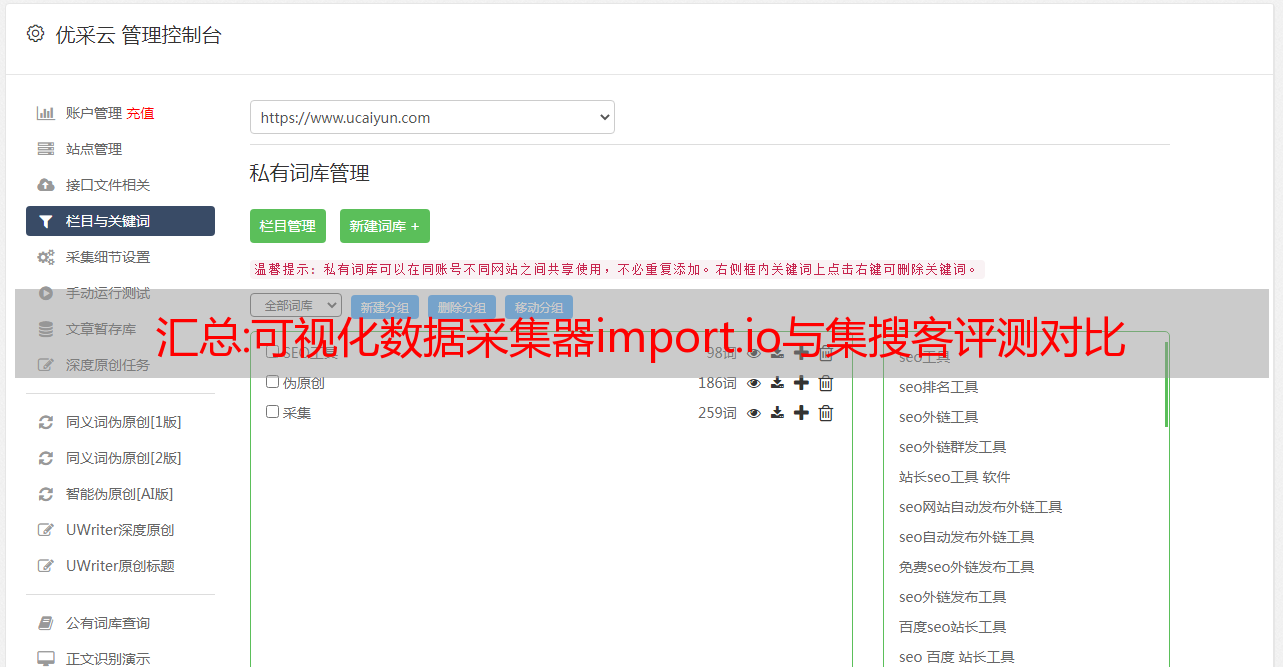

GooSeeker的天眼和千面系列——

极量客的天眼和千面分别为电商和微博发布的数据提供了便捷的GUI界面。只要输入网址,就可以整齐地采集下载目标数据。

如图2:显示博主的采集工具(微博各种数据都有采集管理界面),进入博主首页的链接,可以调度爬虫,给博主首页下的信息为采集,如微博内容、转发、评论等数据。

图2:GooSeeker微博博主采集界面示例

界面也很简单。与 Import.io 相比,最大的不同是用户自己运行爬虫组。已结构化和转换的 XML 格式的结果文件。

优点:操作非常简单,可以自动翻页采集,微博上能看到的重要字段都采集了。

缺点:采集数据字段有限,只有采集GooSeeker官方限定网站。

从上面的分析可以看出,Magic和GooSeeker的天眼和千面操作非常简单,基本上都是纯傻瓜式操作,非常适合只想专注于业务问题而做不想被技术问题分心。用户也是纯小白学习数据采集和使用数据结果的良好起点。但是,Magic 在采集 的结果可视化方面比天眼和千眼具有更广泛的适用性。缺点是采集数据量大的场景不可控,而天眼和千面专注几个主流网站,优点主要体现在能够完成大量数据采集,例如,

2.Extractor (import.io) VS Organizer (Jizouke)

提取器——

提取器是翻译中的提取器。如果从实体的角度来理解,它就是一个小程序(可能是一组脚本),从一个 URL 中提取出你想要的信息;如果你从采集目标的角度去理解,那就是采集特定网页结构的规则。与Magic不同的是,import.io的Extractor(以及后面的另外两个功能)是一个可以独立运行的软件,具有非常直观的可视化界面,可以直观的展示提取出来的信息。

如图 3:import.io 的 Extractor 非常类似于修改后的浏览器。在工具栏中输入网址,网页显示出来后,在浏览器中选择要抓取的数据,然后单页就可以将结构的整列规范依次往下采集。

图 3:Extractor 提取数据的示例

优点:灵活采集,操作简单,可视化程度高。

缺点:采集数据的结构化程度很高,对于结构化程度较差的数据,采集不能很好的表现。

GooSeeker 组织者 -

Jisouke 声称是“构建一个盒子并将你想要的内容放入其中”。这个箱子就是所谓的分拣箱。其原理是将需要提取的信息一一拖入框内,映射到排序框。客户端程序可以自动生成提取器(脚本程序),提取器自动存储在云服务器中,可以分发给世界各地的网络爬虫进行提取。

如图4所示,import.io顶部的一个工具栏在GooSeeker中展开成一个工作台,在工作台上创建一个盒子,然后通过映射操作将网页上的内容扔到盒子里。把你想要的东西扔进盒子里。原理看似简单,但面对大盒子界面和众多HTML节点,对于新手来说有点压力。当然,界面复杂,以换取能够处理更复杂的情况,因为有更多的控件可用。

图 4:分类 bin 提取数据的示例

优点:提取精度可以微调,提取领域灵活,也适合比较复杂的网页

缺点:可视化效果一般,需要掌握简单html的基础知识

综上所述,Extractor和排序框都具有提取信息字段的功能。Extractor操作起来比较简单直观,适用于一些简单结构化的URL,但是对于一些稍微复杂的URL,Extractor会出现无法提取的问题。这时候就突显了吉搜克排序框的优势,特别复杂的情况下,可以使用自定义的xpath来定位数据。

3.Crawler (import.io) VS Crawler Route (GooSeeker)

履带式——

爬虫字面意思是网络爬虫。顾名思义,就是在深度和广度上进行扩展,以便采集更多的数据。Crawler在Extractor的基础上实现了自动翻页功能。假设你想要采集100页的网页数据,通过import.io的爬虫功能可以一键下载100页信息采集,那么具体的采集@是什么> 过程?为了实现,笔者带大家简单了解一下爬虫的采集流程。

如图5所示,以同城58的租房信息为例,搜索关键词后,共找到N页租房信息,以提取租房信息。爬虫的操作如下:

(1)采集样本数据,在首页提取需要采集的数据(图5),采集原理和Extracor一样,所以我不会在这里重复。

图 5:爬取提取数据示例

(2)训练数据集,进入第二页(图6),爬虫会自动采集第二页数据(提取出来的字段和第一页一样),然后翻到下一页),由于网页的结构没有改变,爬虫也会自动采集,循环这个训练过程,当爬虫认为已经采集到足够的训练集时(据说支持up到5个样本)(如图7),训练完成,点击结束,保存,即可成功采集所有页面数据。

图 6:爬取添加页面示例

图 7:已完成的爬网训练样本

Import.io 的爬虫训练过程的操作确实非常简单易懂。你只需要选择几个结构相同的页面进行测试,相当于告诉爬虫我只想采集这些相似的页面。信息、爬虫 了解了这些需求后,同样结构的信息可以采集下来,但是也会有一些小问题,当有些字段稍微变化的时候,因为之前的训练需要采集如果数据不同,会漏掉这个信息,所以爬虫比较适合结构很固定的页面。

综上所述:

优点:灵活采集,操作简单,采集过程可视化

缺点:继承Extractor的缺点,对数据结构要求高

GooSeeker 爬虫路线 -

吉索克的爬虫路线的实现是基于分拣箱的。原理与爬虫基本类似,但适应性更广,负面影响是操作相对复杂。

让我们首先回顾一下组织盒子的概念。GooSeeker 一直声称“造一个盒子,把你需要的内容放进去”。这个概念非常简单。您可以直观地挑选出所需的网页内容并将其存储在一个盒子中。

如图8所示,以采集京东的手机信息为例,如果要采集手机信息的所有页面,操作如下:

(1)创建一个排序框,把要提取的数据丢进去,抓取规则就会自动生成。不过,操作可不是这句话那么简单,而是:

a) 创建一个排序框,这个很简单,点击“新建”按钮

b) 在排序框中创建字段,这些字段称为“抓取内容”,即页面上的内容要拖放到这些字段中

c) 在 DOM 树上选择要抓取的节点,并将其映射到一个字段。

既然它说“建立一个盒子并放入你需要的东西”,你为什么不真的在视觉上这样做呢?这个地方需要改进,敬请期待即将到来的新版本中提供的直观注释功能。

(2)构造爬虫路线,将“下一页”映射为标记线索(如图8),设置完成后,保存后可自动获取所有页面的信息采集@ >.this虽然过程说起来简单,但是操作起来相比Crawer还是有点不直观,需要做几个简单的映射,就是告诉爬虫:“这里是我要点击的”、“这里是我要提取的”,如下图,主要操作是针对HTML DOM的个数做的,用户最好有一个简单的HTML基础,这样才能准确定位到DOM节点,而不是仅限于可见文本。

图8:爬虫路由转向原理页面示例

优点:采集精度高,适用范围广。

缺点:可视化效果一般,需要学习实践才能上手。

综上所述,Import.io的Crawler和GooSeeker的爬虫路由主要完成了扩展网络爬虫的爬取范围和深度的任务。上面我们只以翻页为例,大家可以自行实践和体验分层爬取。爬虫的操作相对简单,但适配性也比较窄,对网站的结构一致性要求高,而爬虫路由功能相对强大,可以适应各种复杂的网站,但操作也比较复杂。

4.连接器 (import.io) VS 连续点击 (Jizou Ke)

连接器 -

import.io的Connector是对网页进行动作,主要是为了URL没有变化,但是信息在深层页面。需要做完才可以显示,但是页面的url没有变化,大大增加了采集数据的难度,因为即使配置了规则,爬虫进入的页面也是初始的页面,不能采集@采集来定位信息,Connector的存在就是为了解决此类问题。连接器可以记录这个点击过程,然后采集到目标页面信息。也以58同城租房信息为例,测试Connector功能的可操作性。

(1)通过点击可以找到你需要的信息采集所在的页面。如图9所示,Connector可以记录用户每次的点击行为。

图 9:连接器操作示例

(2)在目标页面上创建规则并提取信息。到达目标页面后,需要做的操作和前面一样,提取需要采集的信息。

通过动手实践发现,连续点击的失败率比较高。如果是搜索,这个动作很容易被记录,但如果只是点击动作,则很难记录成功。如果可能的话,读者可以自己尝试一下,看看究竟是什么原因造成的。

有没有似曾相识的感觉?没错,它有点像网络测试工具。它记录动作并回放它们。用户体验非常好。录制有时会失败。似乎有一些代价。估计还是定位不准的问题。当你用Later进行录制时,当网页的HTML DOM稍有变化时,动作可能会做错地方。

优点:操作简单,采集过程完全可视化。

缺点:点击动作最多只能点击10次,功能比较单一。同时,从使用上来看,连接器的录音功能故障率高,操作失败的情况很多,这可能是直观可视化的代价。

GooSeeker 不断点击——

Jisouke连续点击的功能和它的名字一模一样。实现点击和采集的功能,结合爬虫路线,可以产生更强大的采集效果,这是一个比较高级的收客功能,可以产生很多意想不到的采集 @>方式,这里是一个简单的例子。

如图10所示,到采集微博个人相关信息,因为这些数据必须通过将鼠标放在人物头像上来显示,都需要使用吉索客的连续点击功能。操作如下:

(1)采集目标字段,先定位网页,采集这些字段为采集,方法同上,不再赘述。

(2)设置连续动作,在执行采集之前,可以做一系列动作,所以叫“连续”。不是直观记录那么简单,需要点击“ Create”按钮,创建一个动作,指定点击的位置(一个web节点,用xpath表示),并指定它是什么类型的动作,根据需要设置一些高级选项。

(3)如图11所示,GooSeeker也相当于记录了一组动作,也可以重新排序或添加或删除。如图11所示,没有类似记录的界面如此亲民的工艺,再一次看到GooSeeker的特点:严谨的生产工具

图 10:连续点击操作示例

图 11:连续动作的编排界面

优点:强大,采集有能力。

缺点:上手比较困难,操作比较复杂。

综上所述,import.io 的连接器在操作上还是坚持了一贯的风格,简单易用,同时Jisouke 也再次给人一种“生产工具”的感觉。在连续动作的功能上,两者基本相同。

通过以上对比,相信大家对大数据采集软件import.io和Jisouke有了一个直观的了解。从各种功能的对比来看,特点主要体现在可视化、易学、操作简单。集搜客的特点主要体现在半可视化、功能齐全、采集能力强,致力于为用户提供完整强大的数据采集功能。总之,两者各有千秋,都是非常不错的数据采集软件。

最后,有兴趣的读者可以去深入体验和研究一下,因为两者所宣称的价值其实不仅仅是一个软件工具,而是“互联网数据结构化转换,把网络变成所有人的数据库”的目标。希望以后有机会分享这种经验。

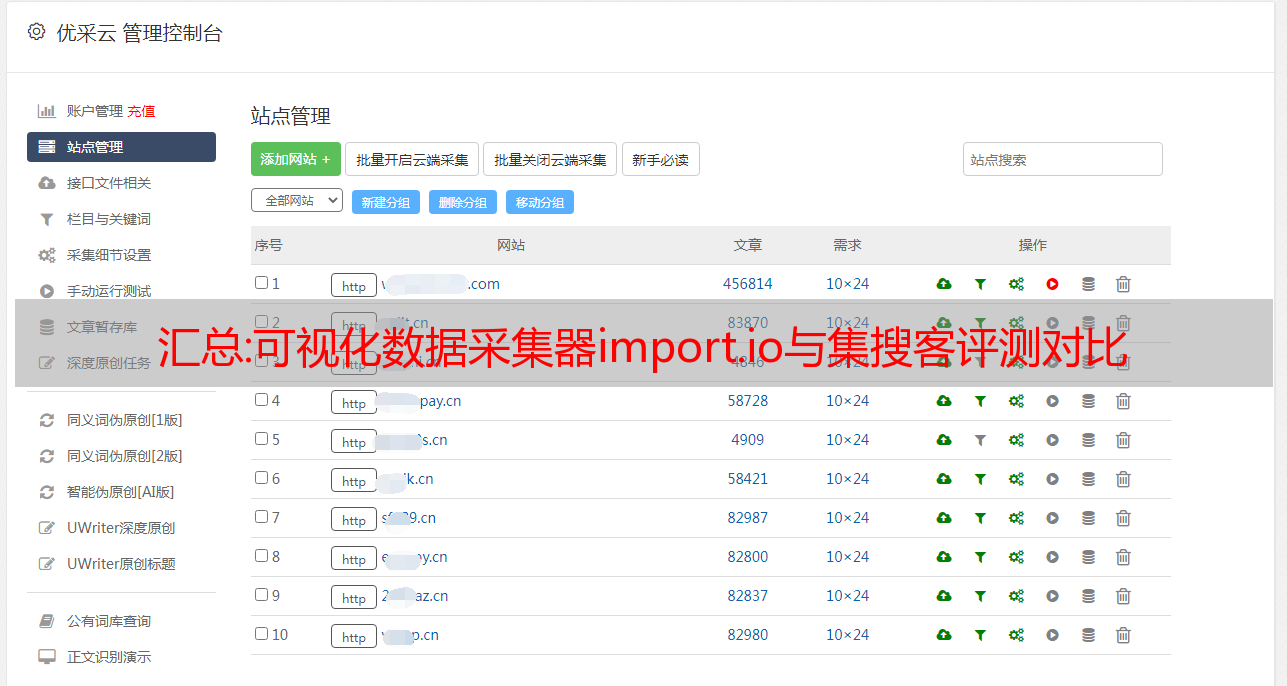

汇总:屌丝SEO分析网站数据常用的SEO工具推荐

作为一名合格的站长,每天的网站数据分析是必不可少的。毕竟SEOer靠网站数据吃饭(数据对于网站优化很重要),每天花几分钟阅读网站数据可以让你更好的了解网站的现状。在日常的数据分析中,需要使用各种SEO工具来提高工作效率,所以本文文章武汉SEO将推荐一些日常分析中常用的SEO工具和站长网站数据工具说说思琪seo的使用习惯以及对这些工具的看法。

掉丝SEO分析网站数据常用SEO工具推荐

一、站长之家

网址:

作为比较老牌的SEO分析网站,站长之家的SEO工具一直拥有相当多的用户,功能也比较齐全,尤其是在网站关键词统计和关键词排名的可信度比较高,这也是为什么大部分站长在更换好友链时都会看重站长权重的原因。但是站长工具只统计索引关键词,也就是说一些可能没有索引但有一定搜索量的关键词是不能统计的。

这几年站长工具也在不断的改进,无论是网页加载速度还是功能上,也增加了一些需要登录才能使用的功能,比如提交网站不算关键词@ >、监控收录在各个搜索引擎的网站量等。另外,我们经常使用站长之家查看网站好友链的状态。

二、爱站网

网址:

爱站net其实和站长之家的大部分功能都差不多,资料也和站长之家有相同的参考意义,也比较常用。其中,使用爱站进行分析时,要多注意网站的发起IP和760查询。

值得一提的是,爱站推出的爱站SEO工具包相当不错,强烈推荐大家使用。只需注册一个爱站账号登录即可使用工具包中的所有功能,并且可以添加和管理多个网站。其中,比较常用的功能包括网站日志分析、网站好友链检测、制作sitamap文件、检查网站收录等。

有一个功能会在 网站 失败时通过电子邮件或短信通知,但前提是 爱站 工具包正在运行。

三、5118 工具

网址:

5118工具相比之前的两款工具,功能更加全面。除了网站数据分析工具,它还包括其他站长日常使用的其他工具。在网站的数据分析方面,我们经常关注5118个工具的关键词统计数量。与站长之家和爱站net相比,5118个工具的关键词统计数量更加具体。,因为它的关键词可能还收录一些没有索引的单词,5118的网站关键词折线图更直观。

四、百度搜索资源平台

网址:

前三个工具可以让你快速了解网站的大致情况,而百度站长平台可以更精细的了解网站的数据。

这里,查看频率高的数据包括索引量、爬取频率、爬取异常、流量和关键词,但优先考虑索引量、流量和关键词。通过指数成交量大致了解网站的收录情况以及是否存在降级问题;通过流量和关键词大致了解昨天的点击和呈现,分析一些关键词是否符合用户需求,修改不符合用户需求的文章或者考虑添加一个新的 文章。至于站长后台给出的其他一些数据,大家也可以关注一下,这里不再赘述。

五、工具

网址:

该工具可能不会被很多人看到。该工具采用国外SEO工具界面,可以查询域名历史、挖掘旧域名等。以上SEO工具所没有的功能,你一定会爱上它。

总结:以上就是分析网站优化数据常用的四种SEO工具。前三个SEO工具虽然有很多相同的功能,但也有各自比较好的功能。毕竟,工具之间肯定存在差异。会使用它。当然,以上只是对各个站长工具的看法和使用习惯的简单介绍。除了上面的功能介绍,还有其他比较好的功能,学着用起来肯定会对网站的优化起到不凡的作用,比如关键词词库挖掘,学习同行网站 的优化技巧等等。