教程:phpcms用户白皮书Word文件格式下载.docx

优采云 发布时间: 2022-09-24 09:12教程:phpcms用户白皮书Word文件格式下载.docx

phpcms用户白皮书下载Word文件格式.docx

《phpcms用户白皮书下载Word文件格式.docx》由会员共享,可在线阅读。更多“phpcms用户白皮书下载Word文件格式.docx(31页采集版)”,请搜索冰点库。

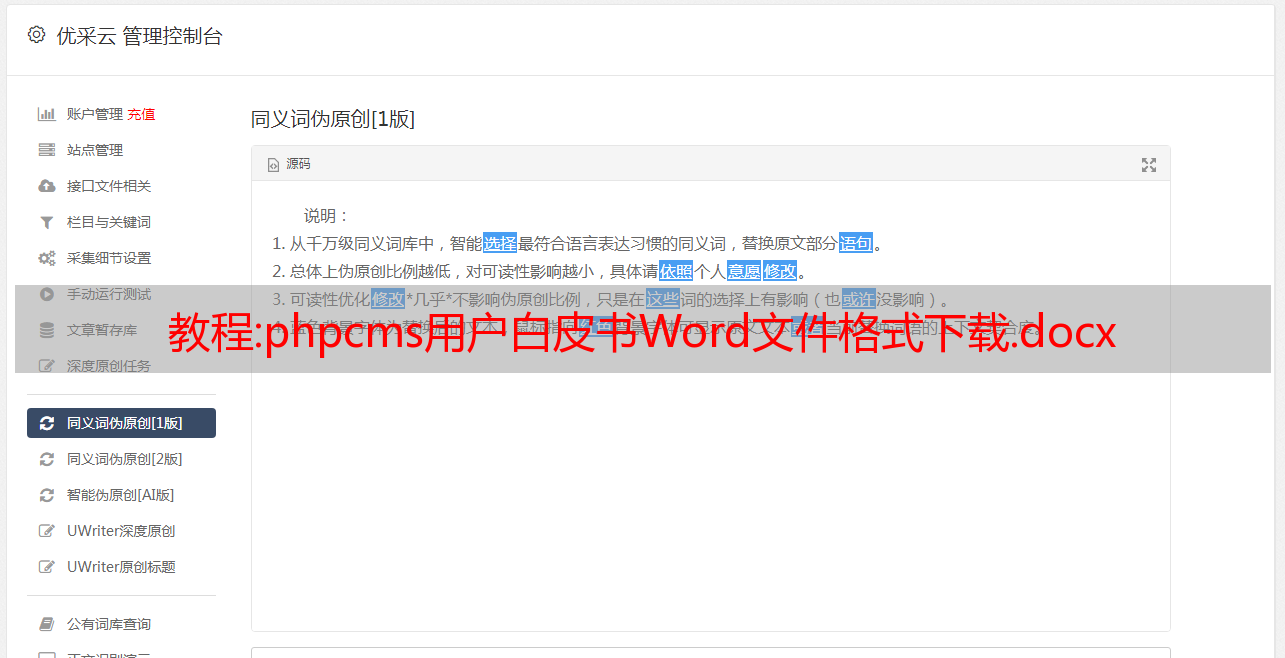

1、让你轻松享受二次开发带来的便利,不再为官方升级而烦恼。2.2 站群系统所谓站群是指建立在统一标准和统一技术框架的基础上,分级管理和维护,信息可以共享并根据特定权限呈现网站 集合。不是很多网站可以一起调用站群,必须统一,分级管理,信息共享,单点登录。站群统一的技术标准,互联互通,集群化管理,相对一致的网站运营和服务规范。率先引入站群系统,仅供大型门户网站网站使用,进入开源系统。为了安全控制,保证各个站点的权限相互独立,操作互不影响。它的出现解决了以下问题:1.站群系统站点数量多,需要多台服务器分布式部署;2.子站点独立,子站点独立于文档

2、文件存储完全独立于数据库结构。3.站点之间的单点登录和信息共享等。2.3 多个发布点提供了单个站点发布到多个服务器的能力。可以轻松实现强大的负载均衡。RDcms内置发布点功能,可以将多个站点安排在不同的服务器上,通过子站点域名指向站点内容所属的目录或服务器,轻松实现多域名访问和服务器集群安排。实现强大的负载均衡。将数据推送到不同的服务器(或同一服务器上的不同目录)2.4 模块化开发和扩展方便将模块化开发理念引入系统,内置功能模块可以自由安装和卸载,专门设计的二次开发扩展方式,在不改变核心程序本身代码的同时,还可以自定义或开发新功能,扩展新功能。1. 灵活的功能模块管理系统,内置部分功能模块

3、版本,您可以根据自己的需要,通过系统管理后台随时安装或卸载。这些功能的增减不会影响整个核心系统功能的正常使用。功能模块自由安装卸载2. 完善的二次开发接口考虑到各用户需求的差异,系统提供了基本的核心功能,还增加了非常标准化的二次开发接口。用户或第三方插件开发者只需按照我们提供给他们的技术接口规范手册进行操作,即可轻松快速地按需开发新的功能模块。可见,只要你能想到实用的功能,你或者我们大家都可以这样实现。<

4、以上情况,性能瓶颈都在数据库。这不应该归咎于数据库。毕竟任何数据库要满足大量的访问量确实是很大的压力,无论是商业数据库Oracle、MS SQL Server、DB2等,还是开源的MySQL、PostgreSQL,都是很大的挑战。解决方法很简单,就是将数据分散在不同的数据库中。为了实现去中心化的数据库压力。数据模型功能允许用户将不同的数据表分离到不同的数据库服务器。为了实现负载分离,更符合大流量网站的需求。为用户提供更好的用户体验。数据库分离2.5 强大的内容模型内容模型的组成变得更加合理,使模型的负载能力更高。强大的自定义模型和字段功能最大限度地提高了系统的灵活性,无需

5、编程实现各种信息发布和检索。系统内置三种内容模型:文章、图片组、下载。并提供常用的字段类型,只需使用鼠标点击,即可轻松扩展您的模型内容字段。网站运营商可以根据实际需要组合这些模型,也可以创建不同形式和类型的站点,比如区域门户,需要新闻信息、分类信息、会员图片。您可以使用相应的模型进行组合。同一个 IT 门户需要新闻、软件下载和产品,所以可以使用我们的新闻、下载和商品模型进行组合,非常灵活。2.6 模板创建很方便。MVC系统用于设计其模板引擎。简单易懂的模板引擎让艺术家可以独立完成模板创建和数据调用。执行。多种工具

6、Box,可以方便的调用其他系统的数据。2.7 优秀的用户体验,后台管理系统更简洁,结构更合理,上手更简单,操作更简单。精心选择多种颜色,保护您的眼睛,让您心情愉快。2.8000万级数据量的承载能力是基于RDcms团队多年的开发经验,从缓存技术、数据库设计、代码优化。可存储文本,支持千万级数据量,充分保障大中型应用和长期发展。对于全文索引,使用了来自*敏*感*词*的开源全文搜索引擎软件 Sphinx。单个索引最多可以收录 1 亿条记录。1000 万条记录的查询速度为 0.x 秒(毫秒)。Sphinx创建索引的速度是:创建100万条记录的索引只需要34分钟,创建1000万条记录的索引只需要34分钟。

7、记录的索引可以在50分钟内完成,而仅收录最新100,000条记录的增量索引只需几十秒即可重建。3 功能模块 3.1 文章 文章功能是系统的主要内容模型之一,系统在之前的RDcms SP的基础上进一步优化系列系统功能和功能创新,简化了文章发布时的部分操作流程。在后台内容列表中,可以对内容进行单独或批量操作和管理。文章在文章的内容模型中增加了管理列表(后端),同时也增加了对其他模型的支持。它还提供了灵活的调用方式,比如增加了与用户交互的投票功能,集成评论模块等,可以轻松应用。添加投票到文章(后台)文章调用投票显示(前端)基于提供自动提取关键词,同时也可以用来自定义通用字段制作一对网站优化关键词

8、链接、延伸阅读等(如下图)大大增加了每一页内容的相关性。与其他cms自动关联文章相比,对搜索引擎优化更有效。友好,更有效。在前端展示方面,内容的附加功能包括情感投票、评论等与访客互动的元素,也为内容的展示增添了更丰富的元素。可以搜索并添加相关文章(更准确,更好的搜索SEO优化)前台文章展示页面(投票、延伸阅读、心情、评论等元素)3.2是什么话题 话题是通过采集某个事物的相关内容而形成的,通常是指网络上的游戏话题或新闻话题。通常在门户网站中,话题是新闻聚合中不可缺少的一种形式,可以方便快捷地聚焦和分析某个事件或某个条目。特色功能不仅提高了网站整体内容的可读性,也让特色变得更容易

9、话题话题吸引新用户群。RDcms专题模块 RDcms专题模块可以轻松帮助您生成和管理特殊页面。在特殊页面,可以方便的创建文章、图片等信息,即可以调用RDcms系统中的原创信息,也可以连接到站外。RDcms自带的分片系统,让您可以随时添加新内容,无需修改模板,保证您的网站内容发布的及时性。通过话题的后台管理设置,可以选择或设置话题评论和话题投票。更容易与用户互动。1.自由创建新话题 系统提供简单指南,引导您轻松创建新话题。主题创建向导2.灵活的针对不同主题的信息聚合,根据需要添加信息分类,并在网站上搜索和导入信息。灵活扩展信息,轻松导入。

10、 允许您充分利用现有数据来创建更具吸引力的主题内容。也可以手动添加新信息。根据需要创建信息分类,无限数据聚合(数据导入到创建的分类中)3.门户级分片管理,自定义页面内容无需更改模板即可自由定义页面分片区内容4.增强用户交互功能,内置投票和评论功能。以及后台控制和管理。在投票前台选择要使用的投票效果3.3 评论是网站的一个重要功能,给网页添加更多的交互元素,对增强用户粘性有很好的效果,RD cms借鉴各大门户的评论功能,它带来了流行的技术和表示方法,例如 AJAX 和构建到评论中。1. 可以独立设置是否允许评论,系统更灵活。设置评论开关2. 评论建筑物3. 是非法的

11、字过滤。根据后台非法和敏感词的设置,可以对提交的评论进行过滤,以维护网站评论的合法性。3.4 投票系统的投票功能提供两种投票方式。首先是单选投票。二是多选投票。网站编辑可以根据实际需要选择类型。操作。1.添加多个投票选项网站编辑可以在发布投票时随意添加或删除选项。2、对刷票的限制 投票系统必须保证投票的公平公正。系统在这方面对每个前端用户的投票,记录了他的IP地址。网站编辑可以设置一个IP地址在多长时间内不能重复投票。以及是否允许游客投票。3. 调用方法生成的投票可以在多个地方调用。系统集成了3种常用调用方式

12、。它们是主页/主题调用、内容页面调用和 JS 调用。只需将对应的代码复制到对应的位置即可。当然,用户也可以定义自己的投票模板。在不同的位置放置不同的调用代码3.5 广告管理是网站在网站运营过程中必不可少的基本功能。多种内置广告类型让您无需编写代码即可快速轻松地添加和管理网站广告。添加多种内置广告类型(背景)广告的流程如下: 1、首先添加一个广告空间,根据网站的具体情况填写相关配置项。2.选择槽位,添加广告,选择要添加的广告位,添加广告信息3.

请看下图中对应的附件,也会被删除。删除文章时,会自动判断是否在别处调用了对应的附件。如果没有调用,则直接删除。如果有来电,文件不会被删除。在附件管理功能模块中,可以查看附件对应模块、使用情况、在线预览等操作。同时查看/清除未使用的 在线预览等操作。同时查看/清除未使用的 在线预览等操作。同时查看/清除未使用的

14、附件。节省服务器空间,可以查看附件对应的模块,并进行预览搜索更侧重于让用户快速找到本站的内容信息,提供千万级的毫秒级数据检索,为您提供专业高效的现场搜索。选择添加搜索类别搜索模块配置3.8 会员系统是网站的一个组成部分,随着网站会员功能的开发。隶属函数的存在是为了网站提高网站本身对用户的粘性。随着会员功能的逐步发展,会员功能的开发已经不仅仅是支持会员注册、会员登录、会员密码修改,会员密码找回。现在已经发展成为一个复杂实用的系统,可以支持多系统集成,支持多种会员模型的存在。

15、 的模块。可与Ucenter、PHPWIND、Dvbbs等产品集成,实现会员系统集成,并可通过系统内置的SSO模块进行单点登录。在多个应用系统中实现,用户只需登录一次,即可访问所有相互信任的应用系统。- 关于 SSO 的详细信息,请参阅下一章(SSO)介绍。1.自定义满足您需求的成员组配置。可以自由添加并分配到不同的组。会员可以自助会员升级,定制各种会员群。后台搭建好,前端成员可以进行自助升级。2.自由添加和定义不同的会员模型,系统内置多种字段类型供使用。会员模型可以针对不同的模型进行自定义,增加必填字段(内置多种字段类型供使用)3.9 站群函数站群是什么?所谓站群是指建立统一的标准和统一的技术

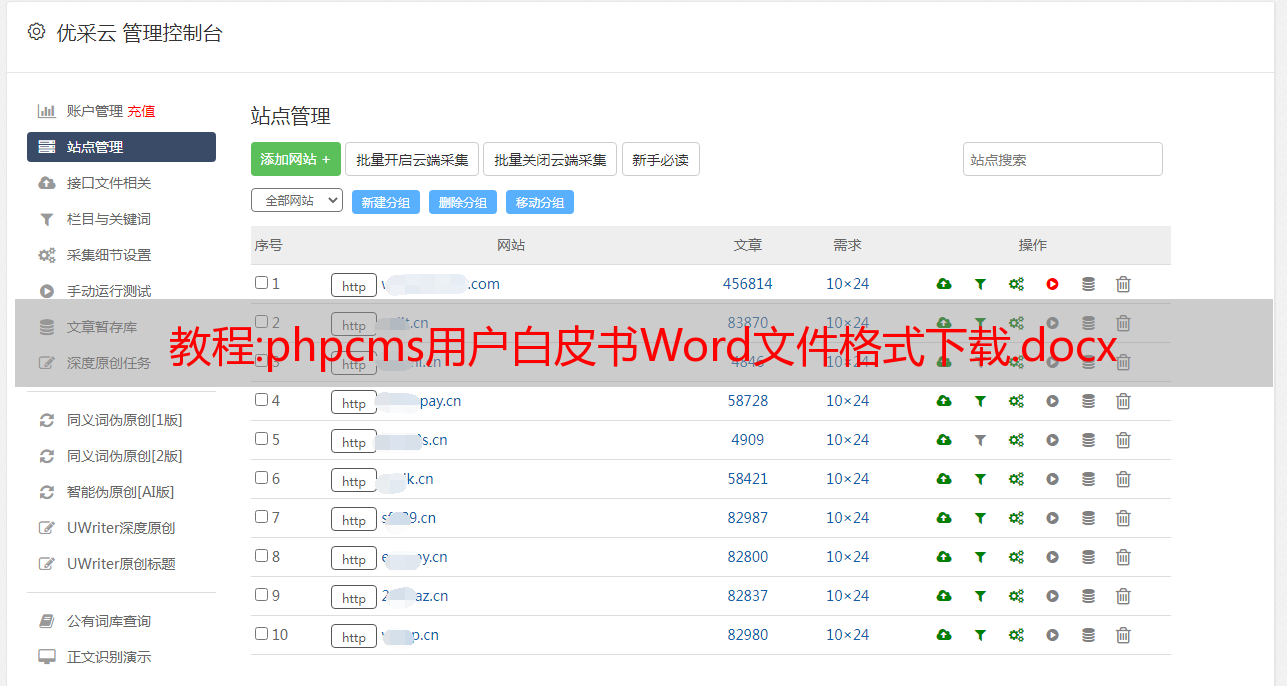

16、基于技术框架,分层管理,分层维护,耦合度低,信息可以基于特定的权限集网站集合进行共享和呈现。不是很多网站可以一起调用站群,必须统一,分级管理,信息共享,单点登录。站群统一的技术标准,互联互通,集群化管理,相对一致的网站运营和服务规范。率先将只供大型门户网站网站使用的站群系统引入开源系统。这样就实现了一套cms系统多站点独立管理功能,具有升级成本低、部署简单、和方便的管理。并且为了安全控制,各个站点的权限相互独立,操作互不影响。广泛适用于大型多站点网站、机构多站点应用等需求领域。站群系统具有以下功能和特点: 1.多站点统一管理

17、群组功能建立不同站点2.每个站点独立权限设置利用系统角色管理,可以为不同站点分配不同的管理员权限,每个站点可以独立设置,互不影响。通过为子站点管理员分配角色权限,子站点管理员登录后,界面只能显示其拥有的内容和栏目菜单。系统角色管理分站权限设置为分站管理员分配栏目管理权限3.支持分布式部署,独立网站,独立数据库,独立服务器系统内置发布点功能和网站设置,可以将子站点分配到不同的服务器上,轻松实现服务器集群部署。通过数据模型功能,允许用户将不同的数据表分离到不同的数据库服务器上。为了实现负载分离,更符合大流量网站的需求。为用户提供更好的用户体验。发布点管理 创建发布点,为独立变电站指定发布者

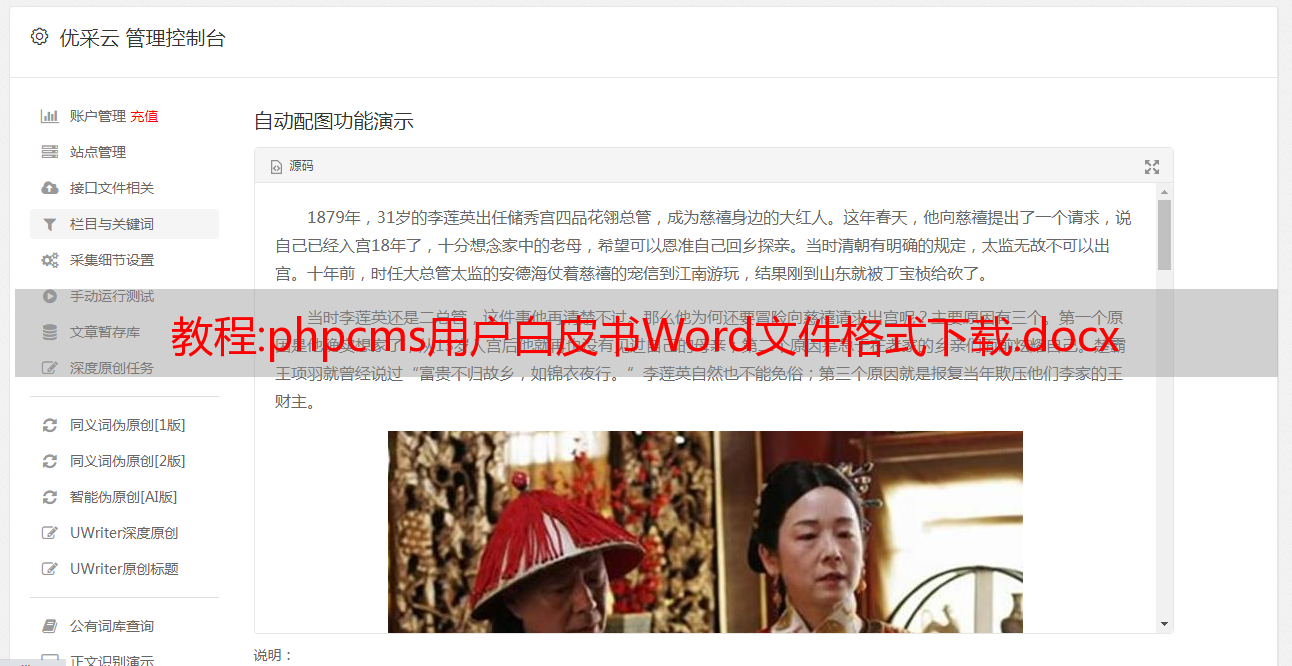

18、分发积分,发布到不同的服务器4.统一用户认证系统可以配合SSO统一用户认证系统,实现多站点的用户统一登录和访问资源的控制和管理,实现一键登录,全网漫游。轻松解决以往不同站点成员系统独立集成的问题。3.10 多点发布系统内置的发布点功能结合站群功能,通过发布点可以将各个子站的内容发布到不同的服务器,轻松实现服务器集群部署。为了实现负载分离,更符合大流量网站的需求。为用户提供更好的用户体验。3.11 信息采集 文章的采集功能是通过程序远程获取目标网页的内容,解析后存入服务器数据库处理本地规则。文章采集系统颠覆了传统的采集模式和流程,采集规则与采集界面分离,规则设置更简单,只需需要基本的技术知识

19、知道的人制定相关规则。编辑不需要了解太详细的技术规则,只需要选择自己想要的文章列表采集,就可以像发布一样轻松完成数据文章采集 操作。1、方便简洁的采集规则配置对于需要采集功能的网站来说,简单方便的规则配置是易用性的体现。技术人员只需要非常基础的网页知识,就可以随意编写采集规则。编写规则后,可以实时显示采集的内容是否正确。通过此功能,您可以轻松测试内容的可用性。采集点设置2.重复使用采集规则对于采集 已编写好的规则,系统会自动将其添加到规则列表中以备后用。每个规则都可以根据需要重复使用和修改。3、智能判断采集信息是否重复,使用采集规则,系统会

20、自动判断采集 URL是否已经存在,自动过滤重复URL。对于采集 内容,只有采集 最新的没有采集 的内容不会重复采集 已有的URL。自动过滤重复URL3.12 数据备份数据库是任何网站最重要的数据之一,如何有效保护现有数据库并及时进行备份。如何轻松简单的恢复数据成为广大网站运营商最关心的事情。系统内置在线数据备份和在线数据库恢复功能,为您的网站操作保驾护航。带走你的烦恼。在线备份数据库在线恢复数据3.13 SSO SSO英文全称是Single Sign On,单点登录。SSO是在多个应用系统中,用户只需登录一次,即可访问所有相互信任的应用系统。它包括将此主要登录映射到其他应用程序的能力

21、使用同一用户登录的机制。它是企业业务集成中比较流行的解决方案之一。随着互联网的飞速发展,WEB应用几乎统治了大部分的软件应用系统,因此WEB-SSO是SSO应用中最为流行的。随着网站的发展,必然会引入更多不同的应用系统,但是不同的系统有不同的认证,所以会有不同的账号名和密码,尤其是针对不同的应用系统。, 网站 拥有大量用户。这个问题尤为突出。问题的原因不是系统的开发,而是缺乏整体规划,缺乏统一的用户登录平台。正是使用SSO技术来解决这些问题。

22、输入用户名和用户密码,不需要记住多组用户名和用户密码。单点登录平台可以提高用户使用应用系统的体验。(2) 管理员管理用户账号方便。系统管理员只需要维护一套统一的用户账号,方便简单。相比之下,以前系统管理员需要管理多组用户每个应用系统都有一套用户帐号,不仅给管理带来不便,而且容易出现管理漏洞。(3)简化应用系统开发在开发新的应用系统时,可以直接使用单点登录平台服务的用户认证,简化开发流程。单点登录平台通过提供统一的认证平台实现单点登录。因此,应用系统不需要开发用户认证程序。RDcms 率先引入SSO概念,实现用户统一认证管理,协同发布。

23、用户多应用管理系统之间的集成问题。PHPSSO 配置phpsso可以集成ucenter,实现用户与uc集成,实现与uc应用同步注册登录。UCenter配置4技术架构4.1运行环境LAMP(linux+apache+mysql+php),以低廉的建设成本、高效的运行性能和良好的可维护性,经典的开源WEB开发运行平台,近年来,吸引了大量*敏*感*词*互联网公司的使用和推广,包括知名的GOOGLE、FACEBOOK、网易、百度、新浪等大型网站。由于众多开发者和爱好者的推广和使用,其安全性和稳定性强于其他平台,它有更快的业务解决方案。RDcms就是基于这样一个强大的开源平台开发的。基本操作框架采用OOP(面向对象)方式RDcms操作环境规格表项目描述操作系统推荐Linux,兼容Windows Web服务器推荐Apache/Nginx,兼容常见服务器数据库如作为IIS,Mysql 5.0或更高版本程序支持PHP5.2.0或更新版本

推荐文章:刘连康:网站robots.txt文件怎么写?

网站robots.txt 文件对 SEO 非常重要。如果你参加过正规的 SEO 培训,你就会知道,当一个搜索引擎蜘蛛第一次来拜访你时网站,它首先要做的就是看看你的网站中是否有 robots.txt 文件。 网站根目录。

如果你的 网站 有 robots.txt 文件,那么搜索引擎蜘蛛会按照 robots.txt 文件中的协议工作;如果你的 网站 没有 robots.txt 文件,那么搜索引擎蜘蛛会随意抓取你的 网站 内容。

有很多SEOer,工作多年,连网站robots.txt文件都写不出来。这些人真的很多。

也有做事比较粗心的SEOer。在构建网站之前,他们总是喜欢在robots.txt文件中写一个禁止任何搜索引擎蜘蛛的命令,然后等网站构建完成后,往往会忘记解除禁止,导致 网站 迟到收录。我已经搜索了所有出现问题的地方,但我只是不知道问题出在哪里。

当然,我们做网站SEO的时候,目的是为了让搜索引擎收录,从而更好的增加网站的流量。

不过个别行业也有网站,比如对安全性要求较高的银行和企业的内部管理系统等,他们的网站会有更高的安全性和隐私性,这绝对不是案子。希望随意公开数据。

不管是什么需求,我们都需要正确编写网站robots.txt文件。今天康哥给大家分享一下网站robots.txt文件怎么写?应该注意什么?

1、如果我们想让所有的搜索引擎访问我们所有的网站内容,那么我们可以在网站的根目录下创建一个名为robots.txt的空白文本文档,就是这样,robots。 txt 的写法如下:

用户代理: *

不允许:

或者

用户代理: *

允许: /

2、如果我们阻止所有搜索引擎访问 网站 的所有内容,那么 网站robots.txt 可以这样写:

用户代理: *

不允许: /

3、如果我们需要禁止某个搜索引擎爬取我们的网站,比如百度搜索引擎,网站robots.txt可以这样写:

用户代理:百度蜘蛛

不允许: /

4、如果我们想阻止谷歌爬取我们的网站,其实和之前一样,我们只需要把User-agent:头文件的蜘蛛名字改成谷歌的Googlebot即可,机器人。txt 的写法如下:

用户代理:Googlebot

不允许: /

5、如果我们要防止其他搜索引擎爬取我们的网站而不是Google,那么我们的网站robots.txt可以这样写:

用户代理:Googlebot

不允许:

用户代理: *

不允许: /

6、如果要禁止除百度以外的其他搜索引擎爬取我们的网站,robots.txt可以这样写:

用户代理:百度蜘蛛

不允许:

用户代理: *

不允许: /

7、如果我们需要禁止任何搜索引擎蜘蛛访问某个目录,比如我们想禁止搜索引擎蜘蛛爬取admin、css、images等目录,可以写robots.txt像这样:

用户代理: *

禁止:/css/

禁止:/admin/

禁止:/图像/

8、如果我们允许搜索引擎蜘蛛访问我们的 网站 目录之一中的某些特定 URL,robots.txt 可以这样写:

用户代理: *

允许:/css/my

允许:/admin/html

允许:/图像/索引

禁止:/css/

禁止:/admin/

禁止:/图像/

9、我们在做SEO优化的时候,会经常浏览别人的优秀网站,取长补短。当您在某些网站robots.txt 文件中看到Disallow 或Allow 时,会出现很多符号,例如:问号或星号。

不要惊讶,其实这也是网站robots.txt文件的一种写法,并没有什么问题。

如果使用“*”,主要是为了限制对某个后缀的域名的访问。

废话不多说,我们直接上干货。如果我们想阻止任何搜索引擎蜘蛛访问 网站/html/ 目录(当然包括子目录)中所有以“.htm”为后缀的 URL。robots.txt 可以这样写:

用户代理: *

禁止:/html/*.htm

10、如果我们看到一些网站robots.txt文件使用“$”,那么他们的意思是它们只允许搜索引擎蜘蛛访问某个目录下具有某个后缀的文件。

robots.txt 需要这样写:

用户代理: *

允许:.asp$

不允许: /

11、如果我们要阻止搜索引擎蜘蛛访问网站中的所有动态页面(即带有“?”的URL,比如index.asp?id=1)robots. txt 的写法如下:

用户代理:* 禁止:/*?*

当你优化了很多网站 SEO,并且有丰富的SEO实战经验,特别是那些搜索引擎蜘蛛经常访问的大型网站优化,你会发现我们的服务器每天。一定压力很大。

所以这个时候,为了节省服务器资源,我们需要禁止各种搜索引擎爬取我们网站上的图片。这里的方法是使用“Disallow: /images/”直接屏蔽该文件夹。另外,我们也可以采取直接屏蔽图片后缀名的方法。

12、如果我们禁止谷歌搜索引擎蜘蛛抓取我们网站上的所有图片(注意:如果你的网站使用了其他后缀的图片名,你也可以在这里直接添加) robots.txt 的写法如下:

用户代理:Googlebot

禁止:.jpg$

禁止:.jpeg$

禁止:.gif$

禁止:.png$

禁止:.bmp$

13、如果我们禁止百度搜索引擎蜘蛛爬取我们网站上的所有图片,robots.txt可以这样写:

用户代理:百度蜘蛛

禁止:.jpg$

禁止:.jpeg$

禁止:.gif$

禁止:.png$

禁止:.bmp$

14、除了百度搜索引擎蜘蛛和谷歌搜索引擎蜘蛛,你要禁止其他搜索引擎蜘蛛抓取你的网站图片(注:这是为了让大家看得更清楚,我们用比较笨的方法,针对单个搜索引擎单独定义。)robots.txt的写法如下:

用户代理:百度蜘蛛

允许:.jpeg$

允许:.gif$

允许:.png$

允许:.bmp$

用户代理:Googlebot

允许:.jpeg$

允许:.gif$

允许:.png$

允许:.bmp$

用户代理: *

禁止:.jpg$

禁止:.jpeg$

禁止:.gif$

禁止:.png$

禁止:.bmp$

15、我们只允许百度搜索引擎蜘蛛抓取网站上的“jpg”格式文件,只需要修改搜索引擎的蜘蛛名称即可。

网站robots.txt 文件可以这样写:

用户代理:百度蜘蛛

允许:.jpg$

禁止:.jpeg$

禁止:.gif$

禁止:.png$

禁止:.bmp$

16、我们要单独禁止百度搜索引擎蜘蛛爬取网站上的“jpg”格式文件,robots.txt可以这样写:

用户代理:百度蜘蛛

禁止:.jpg$

17、如果?表示一个会话 ID,那么我们可以排除所有收录该 ID 的 URL,以确保 Google 的搜索引擎蜘蛛不会抓取重复页面。

但是,以 ? 结尾的 URL 可能是您 网站 收录的页面版本。

在这种情况下,我们可以将它与 Allow 指令一起使用。robots.txt 的写法如下:

用户代理:*

允许:/*?$

不允许:/*?

在这里我们可以看到 Disallow:/*? 命令将阻止收录 ? 的 URL。具体来说,它将阻止所有以您的 网站 域名开头、后跟任何字符串、然后是问号 (?) 和任何字符串的 URL。

好吧,Allow: /*?$ 行将允许任何以 ? 结尾的 URL。也就是说,它将允许任何以您的 网站 域名开头的 URL,后跟任何字符串,后跟问号 (?),问号后面不带任何字符。

18、如果我们想禁止搜索引擎蜘蛛访问某些目录或某些URL,可以截取URL部分的名称。

robots.txt 可以这样写:

用户代理:*

禁止:/plus/feedback.php?

网站Robots.txt文件写法康给大家分享的很详细,不管是哪一种网站,以上18种robots.txt文件写法,总有一款适合你。

但是康哥要提醒大家,robots.txt文件不需要写得太复杂,封杀一些不需要参与SEO排名的乱七八糟的东西,例如:网站css、js、 网站安装路径和网站后台路径等

对了,文章康一开始就已经告诉你了:当搜索引擎蜘蛛第一次来拜访你时网站,它首先会看你网站 @网站根目录下有robots.txt文件吗?

由于搜索引擎蜘蛛首先要访问的是我们的网站中的robots.txt文件,那么此时我们可以把网站的地图链接地址放到这个robots.txt文件中。

例如,我们可以这样写: Sitemap: /sitemap.xml

这样一来,我们的很多网站内页URL就可以被搜索引擎蜘蛛快速发现和爬取。