教程:结合案例教你如何做好SEO搜索引擎优化?

优采云 发布时间: 2022-09-23 14:09教程:结合案例教你如何做好SEO搜索引擎优化?

HTTPS 将逐渐取代 HTTPseo 与搜索引擎之间的对话。虽然目前还不是很流行,但是很多搜索引擎已经明确告诉站长,HTTPS的网站会优先考虑收录的排名。

三、数据分析

数据分析对于百度排名非常重要。数据分析不仅仅是分析网站的内部数据,还要分析百度给出的数据,这是一个很重要的工作,

比如百度指数需求图,用户搜索这个词后,他会很清楚的告诉你他的需求是什么。这些数据对您的优化非常重要。你网站提供的内容就是用户需要的,

那么您就不需要谈论您的用户体验、用户喜欢它,搜索引擎也是如此。这个详细操作可以参考:百度排名只需要分析关键词的数据即可。

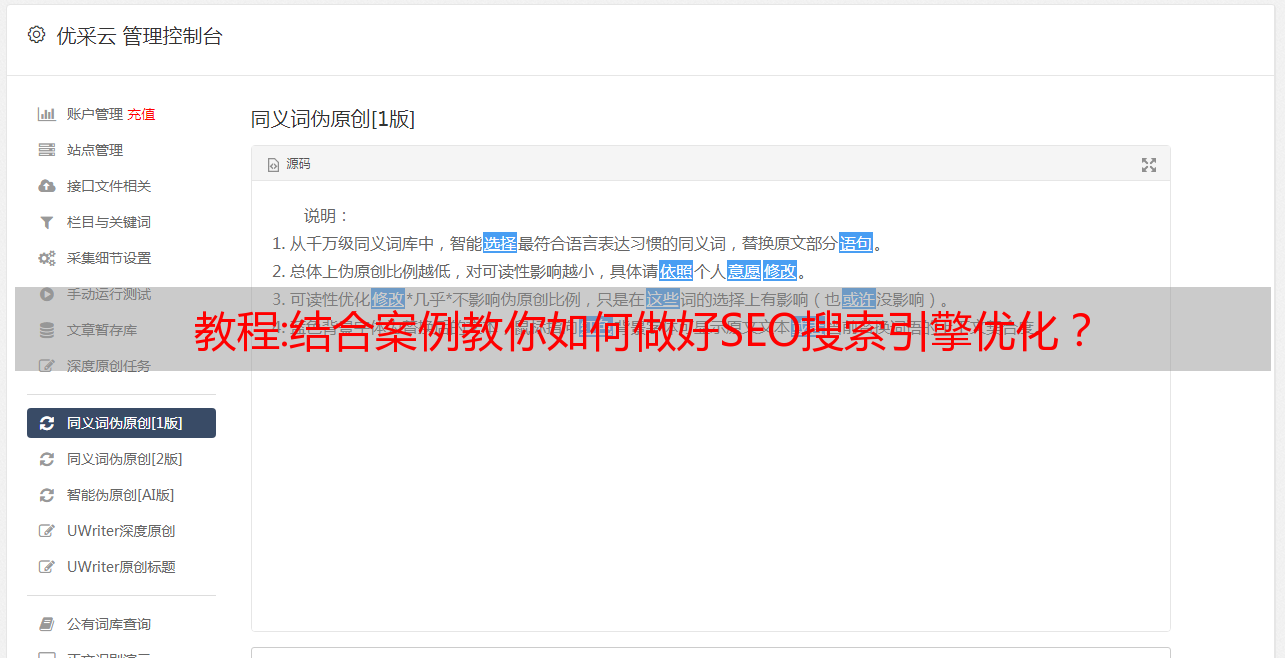

四、原创内容

原创内容很喜欢搜索引擎。新站点对原创内容的排名影响不大,但对收录很有帮助。

@原创内容在网上经常找不到。为了补充数据库,搜索引擎会优先考虑收录。当有相关搜索时,将优先显示。对于老网站原创内容的优势就更大了。

五、添加外部链接

增加外链会对网站的排名产生显着影响,但是外链的增加也需要循序渐进、循环往复。所占的比例还是很大的。大家都听说搜索引擎对外部链接的权重有所减弱,但大家要明白,减重并没有消失。

假设外部链接原来的权重占所有因素的20%,现在已经减弱了3倍,还有8%的SEO对话与搜索引擎,那么它可能仍然是众多排名因素中最高的七试之后,外链的重要性还是很关键的。

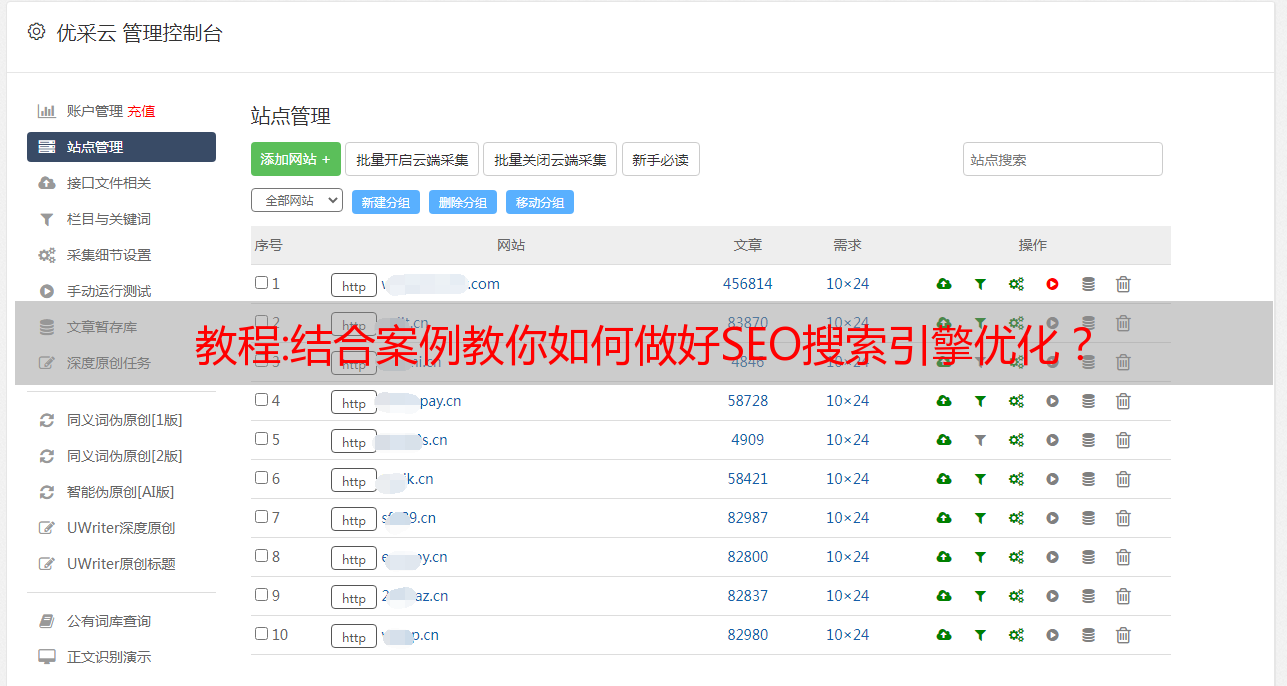

网站案例

这个,这个 网站 是我在 6 月 7 日推出的。在那之前,公司的一个小女孩整容了网站。 @收录一打,我只是想拿来测试一下,

所以我就按照上面说的步骤,换了几个友情链接,没有加几个外链,而且收录的更新内容和数量也很少,大家可以看看我现在是什么排名,如下图:

总结:

对于 SEO 优化,您所做的每一项工作都是锦上添花。搜索引擎不会通过一两个因素来判断排名。它是许多因素的组合。并不是你可以在某个步骤之后进行排名。你上升了多少,但你工作的每一个细节都锦上添花,为你稳定的最高排名做出了贡献。

好的,文章的这个内容营销圈就分享到这里。对线上推广创业感兴趣的可以加微信:Dao8484 备注:营销圈引流学习,我拉你进直播课程学习群,每周135晚,有实用干货推广引流免费分享技术课程!

看过这篇文章的人也看过以下内容: 搜索引擎优化方案:如何结合案例做SEO搜索引擎优化?如何优化搜索引擎SEO,教你如何做好SEO搜索引擎优化的5个步骤?如何增加外链以及添加外链时要注意的3件事?什么是疯狂的seo,什么是seo! ? SEO排名优化方法有哪些,教你3种SEO排名优化方法?

解读:搜索引擎优化规则有哪些,搜索引擎优化规则介绍?

一个搜索引擎从用户搜索到最终搜索结果展示的步骤是(以百度为例):

爬,百度不知道你的网站,你怎么排?所以要让百度知道你,首先要经过爬取这一步;

过滤,过滤掉低质量的页面内容;

索引,只存储符合条件的页面;

处理,处理搜索词,如中文专用分词,去除停用词,判断是否需要启动综合搜索,判断是否有拼写错误或错别字。

排名,向用户展示优质页面;

蜘蛛:

由搜索引擎发送的用于在 Internet 上发现和抓取新网页的程序称为蜘蛛。它从一个已知的数据库开始,像普通用户的浏览器一样访问这些网页,并按照网页中的链接访问更多的网页,如果网页很多,这个过程称为爬取;

蜘蛛对站点的遍历和爬取策略分为深度优先和广度优先两种。

蜘蛛爬行的基本流程:

根据爬取的目标和范围,可以分为

批量爬虫:清除爬取目标和范围,到达时停止;

增量爬虫:为了响应网页不断更新的状态,爬虫需要及时响应,一般商业引擎一般都是这种类型;

垂直爬虫:只针对特定字段的爬虫,根据主题过滤;

百度官方蜘蛛爬取过程中的策略

1、爬取友好性,同一站点在一段时间内的爬取频率和爬取流量不同,即错开正常用户访问高峰,不断调整,避免过度影响正常用户访问行为被抓的网站。

2、常用返回码,如503、404、403、301等;

3、各种url重定向的识别,如http 30x、meta refresh重定向和js重定向,Canonical标签也可以看作是变相的重定向;

4、抢优先分配,如深度优先遍历策略、广度优先遍历策略、pr优先策略、反链策略、大站点优先策略等;

5、重复url过滤,包括url规范化识别,例如一个url收录大量无效参数但实际上是同一个页面;

6、暗网数据的获取,搜索引擎暂时无法抓取的数据,比如存在于网络数据库中,或者由于网络环境,网站本身不符合规范、孤岛等问题导致无法爬取,比如百度的“阿拉丁”计划;

7、爬虫防作弊,爬虫过程中经常遇到所谓的爬虫黑洞或者面临大量低质量页面,这就需要爬虫系统也设计一套完整的爬虫防作弊-作弊系统。如分析url特征、分析页面大小和内容、分析爬取规模对应的站点规模等;

蜘蛛感兴趣的页面有 3 类:

1.一个从未被抓取过的新页面。

2.内容修改后的抓取页面。

3.已抓取但现已删除的页面。

蜘蛛不能/不喜欢抓取的内容:

1.被机器人屏蔽的页面;

2.flash 中的图片、视频和内容;

3.js、iframe框架、表格嵌套;

4.蜘蛛被服务器拦截;

5.岛屿页面(无任何导入链接);

6.登录后才能获取内容;

四种近似的重复页面类型:

1.完全重复的页面:内容和布局格式没有区别;

2.重复页面:内容相同,但布局格式不同;

3.布局重复页面:部分重要内容相同,布局格式相同;

4.部分重复页面的重要内容相同,但布局格式不同;

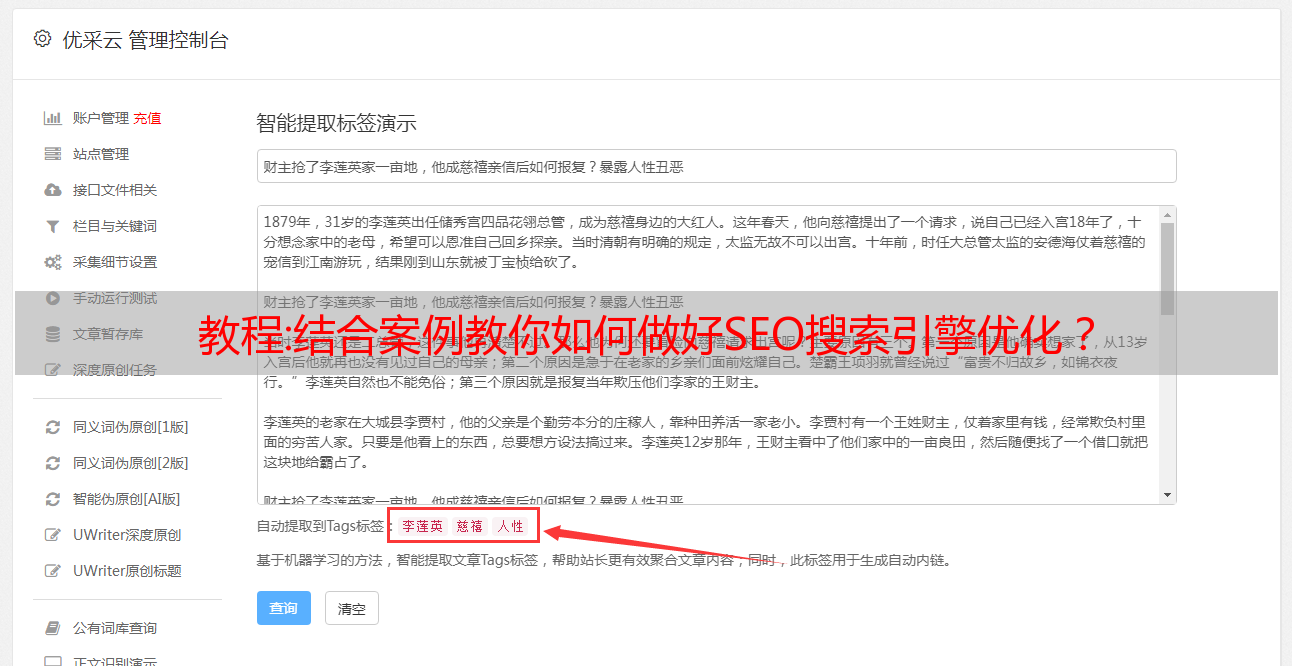

典型的网页去重算法:特征提取、文档指纹生成、相似度计算

低质量的内容页面:

1.多个URL地址指向同一个网页和镜像站点,如带www和不带www并解析为一个网站;

2.网页内容重复或接近重复,如采集内容、文字错误或垃圾邮件;

没有丰富的内容,如纯图片页面或页面内容搜索引擎无法识别;

过滤 - 如何处理重复文档:

1.已删除低质量内容

2.高质量的重复文档优先分组展示(高重复表示欢迎)

好的,文章的这个内容营销圈就分享到这里。对线上推广创业感兴趣的可以加微信:Dao8484 备注:营销圈引流学习,我拉你进直播课程学习群,每周135晚,有实用干货推广引流免费分享技术课程!

看过这篇文章的人还看过以下内容:男士手表十大知名品牌,十大手表?君子兰浇水配方,君子兰花浇水要记住? que的拼音,一年级的拼音期中试卷?李敖在北大演讲,李敖在北大演讲的后果?营销策划是做什么的?营销策划和广告策划概述?