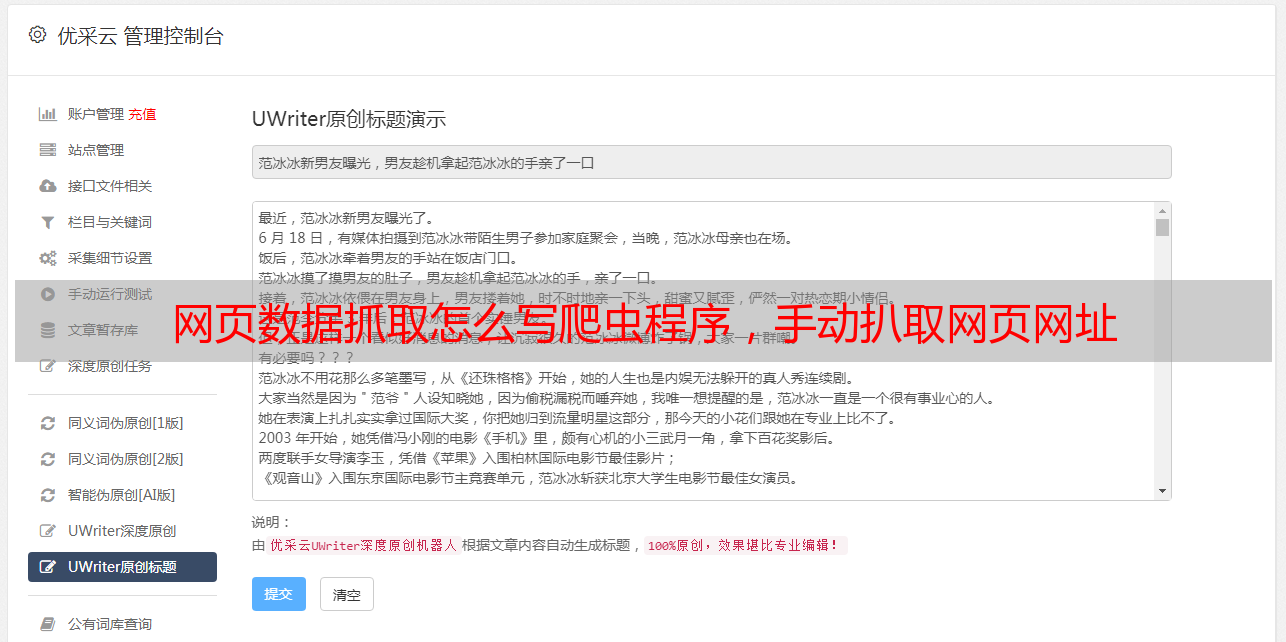

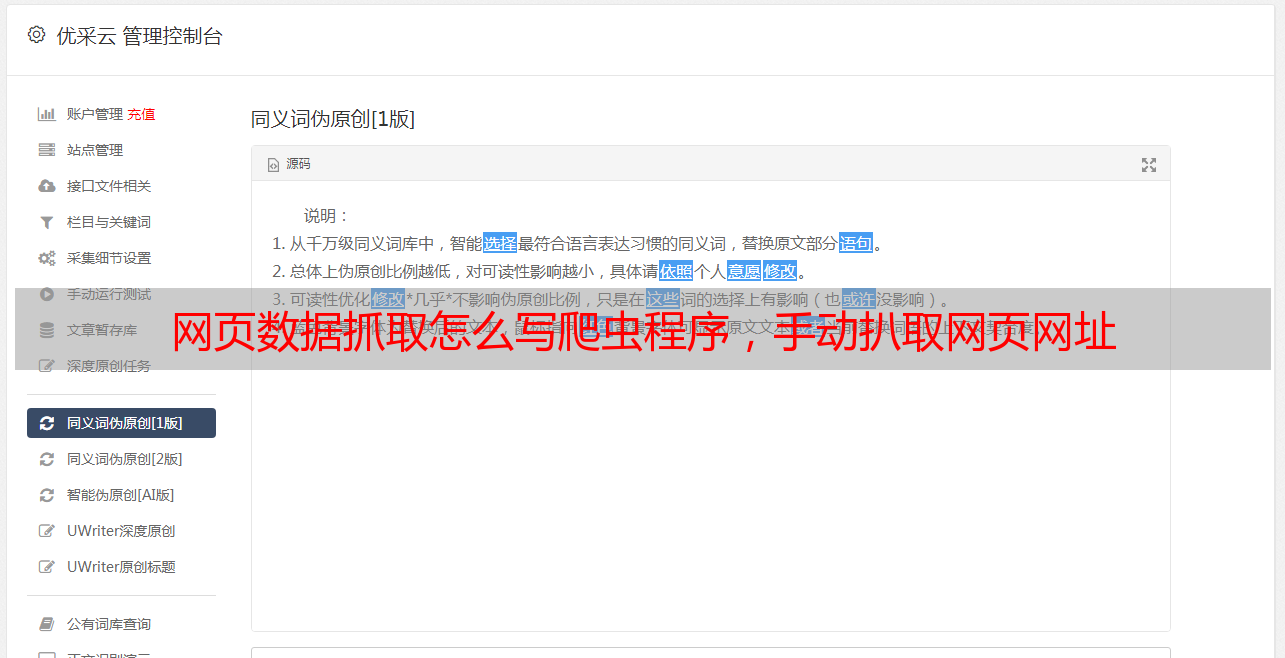

网页数据抓取怎么写爬虫程序,手动扒取网页网址

优采云 发布时间: 2022-09-20 20:15网页数据抓取怎么写爬虫程序,手动扒取网页网址

网页数据抓取怎么写爬虫程序,手动扒取网页网址,怎么程序化的把页面的各个小站点都抓取下来?①爬虫获取网页,并将抓取数据传递给数据库进行整理②定时抓取小站点进行处理③对抓取下来的数据进行字符串分析数据字典分析数据库的设计先定好这样一些的需求最终的方案是,让网页分析爬虫进行爬取下来之后的数据,再转化为xml格式的表格,然后,用python进行处理,生成数据库。

(比如说,最终需要一个json,格式化之后用json.loads进行解析处理最终才能输出真正的数据库。)设计数据库构建数据库的时候,建议暂时只用一个中间表,将整个网页分为多张表格,用于后续的处理。先构建一个html页面,用于数据查询,接着,将字段组合进去,建立一个csv文件,用于collections导入数据输出自定义表格示例代码为了保证有前后顺序,我们使用循环匹配的方式将每页的相同字段进行匹配。

实现细节#代码为保证有前后顺序,这里假设需要从多个页面进行查询#导入库fromrequestsimportrequestfromlxmlimportetreefromxml.parserimportxmltextjoinfromxml2.xmlutilsimportnewrategrelfromcontent2dimportparsefromsqlalchemy.migrateimportmigrateimporttime#指定datas和schema列表t={'user-agent':'mozilla/5.0(windowsnt6.1;win64;x64)applewebkit/537.36(khtml,likegecko)chrome/62.0.3325.110safari/537.36','post':'{'post':'{"post":"{to":"[.*]"}"}'}','put':'{'post':'{"post":"{"[.*]"}"}'}','delete':'{'post':'{"post":"{"[.*]"}"}'}'}match=[]#生成{"to":"[.*]"}中的to属性#获取字段名称t=s.findall(match,t)print('t[{"to":"[.*]"}"]find出来的字段{}[{"to":"[.*]"}"]'.format(t,t))ts=t.group(3)print('t[{"to":"[.*]"}"]find出来的字段{}[{"to":"[.*]"}"]'.format(ts,t))t=fitch(ts)print('t[{"to":"[.*]"}"]find出来的字段{}[{"to":"[.*]"}"]'.format(t,t))ts=fitch(ts)print('t[{"to":"[.*]"}"]find出来的字段{}[{"to":"[.*]"}"]'.format(ts,t))。