php循环抓取网页内容,同时抓取下载页面文件..

优采云 发布时间: 2022-09-14 23:04php循环抓取网页内容,同时抓取下载页面文件..

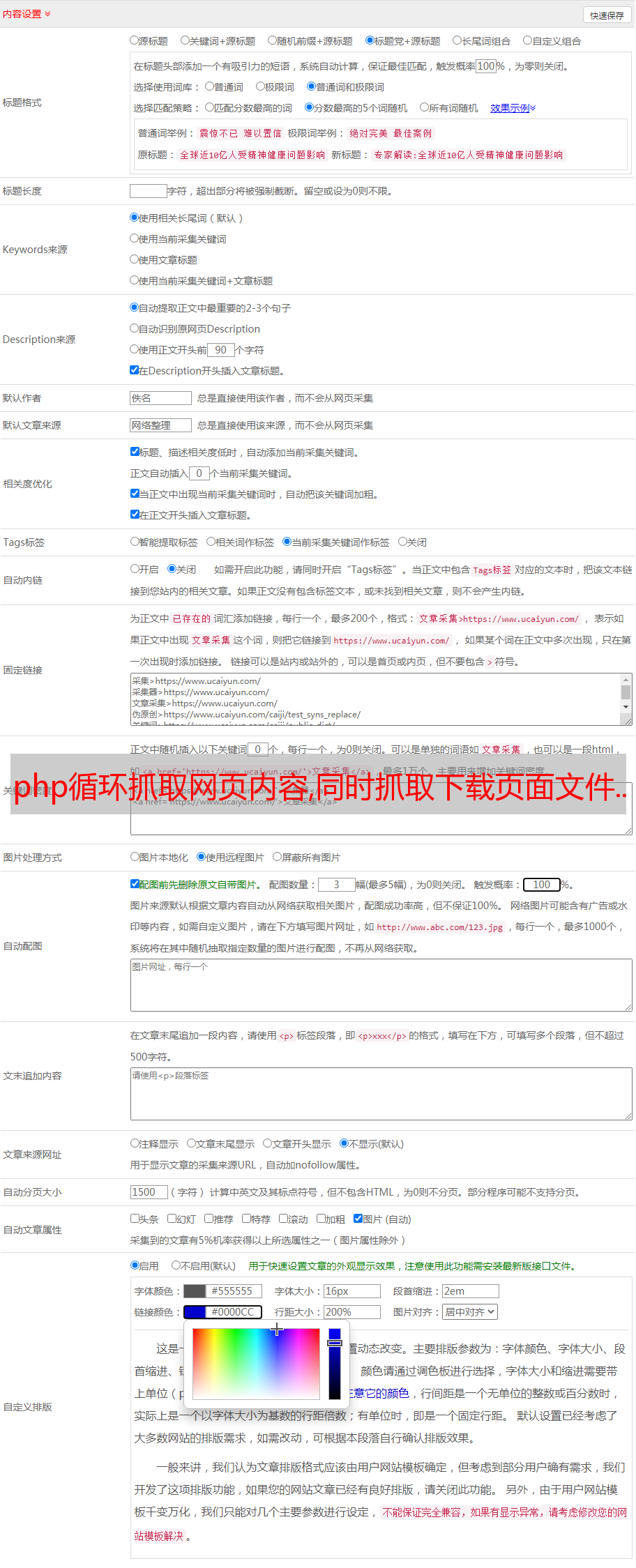

php循环抓取网页内容,同时抓取下载页面文件.每抓取一部分数据,就对页面内容做一些修改,比如页面里面第一个数据是姓名,你可以将他改成男,或者其他,这样用户就可以再登录,每一页修改一个,就完成了一次循环。

做爬虫一般用php:首先说说哪些网站是可以使用php进行爬虫的吧?从php五十大框架中可以看出,php爬虫框架有这么几个:模拟登录系统smartscrapy、requests、beautifulsoup、tornado/flask、selenium、pyspider等;动态网页处理引擎base64、html+xmlencoder系列、spider系列等。

当然了,spider系列还有一个requirejs,每个php的工程师或者小白都有可能对这两个框架熟悉,但是base64+requirejs你可能有时候用不上,因为需要配置的路径可能会比较多。flask:php最大的客户端框架,开发效率比python,java这些语言要高,可以从flask中源码学习。

总体来说,php爬虫支持浏览器端和服务器端都可以爬虫。爬虫是否可以用python爬取?因为python一般用于做web网站的后端语言,而php是一种后端语言,所以如果你一定要用python做爬虫可以尝试python-scrapy/python-scrapy是php/python用php写的爬虫框架,里面提供了python和php两种语言版本的爬虫程序。

上面说了在外网爬虫,那么简单说说在本地爬虫的问题吧。要求new一个网页之后,使用postman,get请求一个网站之后,那么可以对所有的页面进行分析,比如标题,内容等等。当然,如果你不用这些的话,那么可以通过javascript在网页中插入特殊符号进行简单分析。如果说你要爬取的是html格式的内容,那么可以做一些解析。

通过抓包工具可以分析一些内容是html还是xml,或者是json。以上说的这些操作,都是自己做,你把任何有爬虫需求的页面或者是文章都写成脚本,然后运行爬虫,那么都可以从网上抓取到有效的内容。