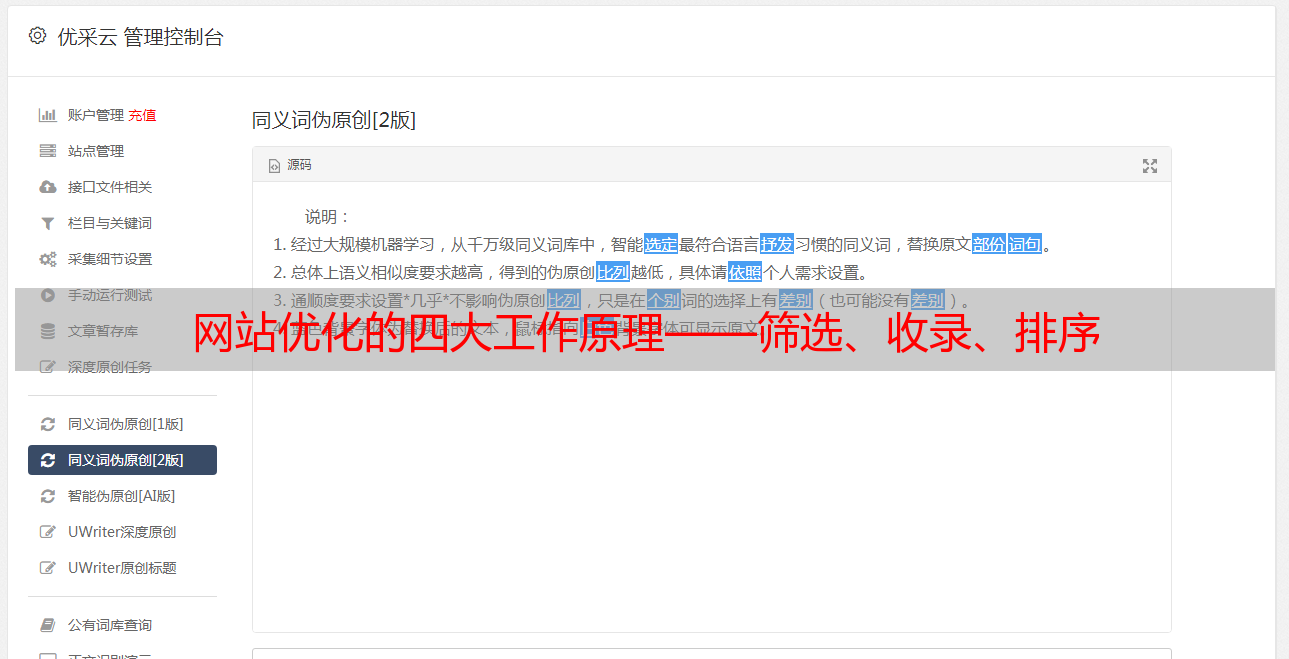

网站优化的四大工作原理——筛选、收录、排序

优采云 发布时间: 2021-05-23 20:19网站优化的四大工作原理——筛选、收录、排序

每天,无数的人通过搜索引擎搜索各种信息资源。每次用户搜索时,都有成千上万的信息供我们选择和参考。为什么我可以在搜索平台上找到这么多的信息材料?它主要依赖于蜘蛛机器人爬虫技术,该技术一天24小时不睡觉就爬虫网站。对于网站优化,搜索引擎就像一个挑剔的美食家。只有真正了解搜索引擎的偏好时,您才能让这个美食家对自己产生幻想。为了有机会出现在搜索引擎列表中,我们需要了解其四个主要工作原理-爬行,过滤,收录和排序。

1、获取信息

搜索引擎将通过互联网发送“蜘蛛”来抓取网页,然后抓取工具将遵循网页的超链接来连续地从一个网页到另一个网页或从另一个网页抓取每个网页网站移至另一个网站。

2、过滤器信息

当搜索引擎抓取网页时,它将对网页进行整体分析。此时,需要大量数据处理工作来提供检索服务。最重要的是从网页中提取关键词以建立索引库。在网站 URL 收录之前,必须将URL的主页提交给搜索引擎,以告知它有新的内容信息。当搜索引擎收到提交的信息时,它将发送一个蜘蛛来抓取该网页。每次抓取网页时,都会将其发送到索引中的“添加和更新网站”信息。 网站只需要提供顶级网页,而不是提交单个网页,爬行的蜘蛛可以通过站点内的链接找到其他网页。只要它是按照相关标准提交的URL,就会在一段时间收录内根据搜索引擎的条件对其进行排序。

3、 收录信息

在搜索引擎过滤出通过技术分析获得的信息中的某些垃圾邮件之后,它将处理已被分析并判断为高质量内容信息收录的网站内容。此时,用户可以在搜索平台上搜索您的收录 网站内容。

4、信息排序

当用户找到某个要搜索的关键词时,它将执行复杂的算法处理,然后根据与搜索关键词的相关程度按顺序排列结果。相关性越高,排名越高。

搜索引擎将对网站进行全面的分析和处理。通常,高质量和高权重的网站在搜索引擎中更受欢迎,并且爬虫相对频繁地爬网。此评级标准不是我们的SEO 网站优化器。通过该工具查询的结果是搜索平台的一个非常私有的评估系统。

因此,如果您想让蜘蛛抓取收录 网站,最简单的方法就是提高网站的内容质量。您还可以使用一些重量较大的原创 网站来引导蜘蛛通过链接来访问网站获取信息。

通常,搜索引擎的核心是满足用户需求并在用户面前展示用户所需的知识。这也是我们优化广州网站时需要注意的事情,一切都从满足用户需求开始。