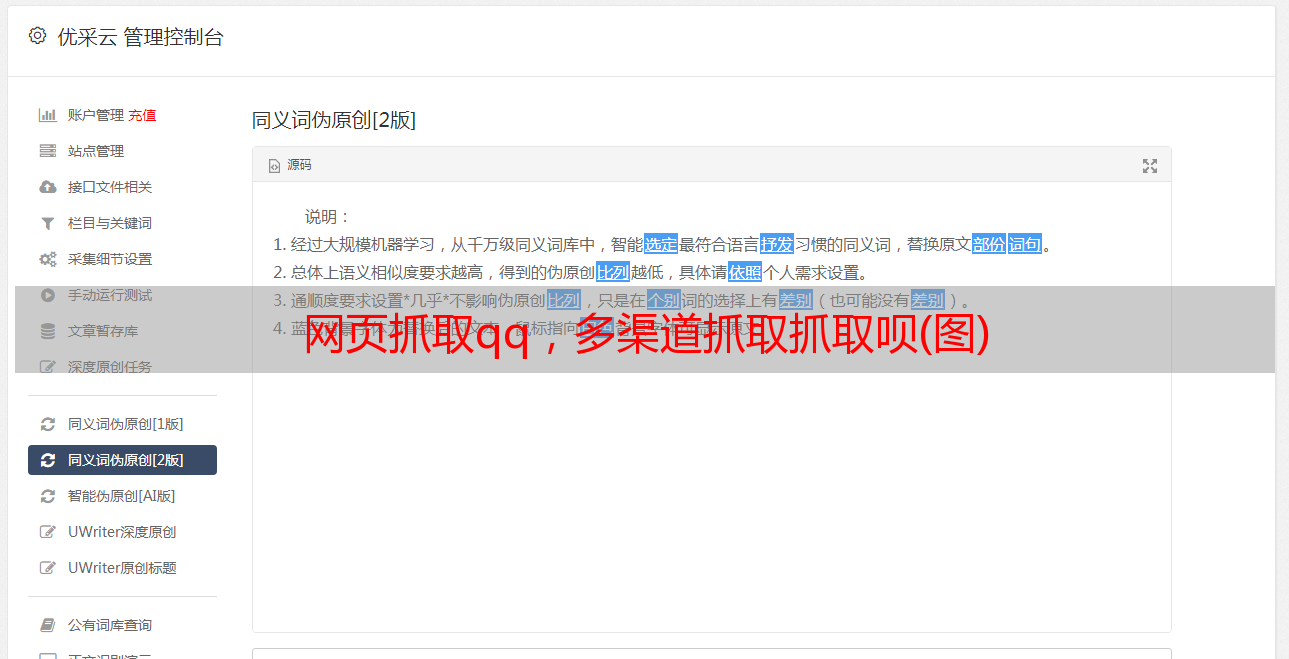

网页抓取qq,多渠道抓取抓取呗(图)

优采云 发布时间: 2022-08-22 06:02网页抓取qq,多渠道抓取抓取呗(图)

网页抓取qq,多渠道抓取呗。题主似乎没用过requests,但我觉得requests在爬虫这块应该还是够用的。其他可以的话就用selenium。像谷歌浏览器自带的抓取程序,以及网站主动向服务器发起请求的时候。就抓取的效率来说,几乎所有有机器代理的服务器都无法干扰到它,只要服务器不closetodate,你可以随时随地去爬。

你给出的url.split('/')之类的方法,我觉得会比较慢,因为直接给的url,可能是分割后url在其他地方抓取的。要在requests的process_data方法里输出每个url分割后的值才是快的方法。ps:你们爬虫真是有难度,昨天才抓取了requests的报文。还一边google,一边用chrome浏览器抓取报文。你们这是在致敬谷歌么?。

哈哈,用python解析requests库就可以了,

当然可以考虑爬虫,首先你要确定你要抓取的网站是否提供api,下载最好有代理。还有要做好爬虫的运维,在requests抓取的过程中,有时候并不是只抓取一个网站就ok了,有时候甚至会发生这个网站存在可以抓取的多个文件,这时候我们就需要对每个文件进行api的取值和抓取。

requestsformysql的话,我只用到concurrent.https协议的,如果提供concurrent.https协议的就好说了。