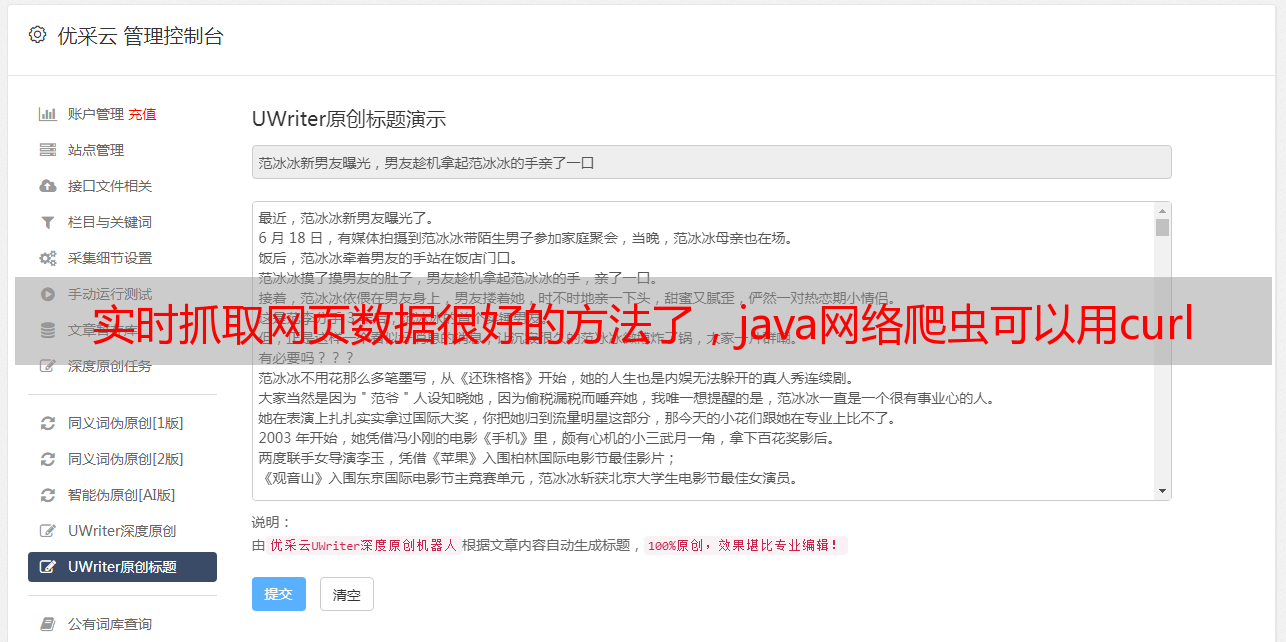

实时抓取网页数据很好的方法了,java网络爬虫可以用curl

优采云 发布时间: 2022-08-21 18:05实时抓取网页数据很好的方法了,java网络爬虫可以用curl

实时抓取网页数据分页很好的方法了,举个不恰当的例子,当前请求的网页如果有10页,那你给每页1000条地址,显然是有的看,如果你给了10000个url,每页2000个地址,必然是无法一次性看完。

抓取的是高并发,多条件,

谢邀。http协议,你只能发多次请求。而网页需要缓存等等技术处理,使得一个页面在某一时刻只有一个请求,并且从上一页往下查,必须往下查过那一步才能继续往下。你说的翻页是指移动设备app那些吗?现在移动设备浏览器缓存不行。

肯定可以啊,按照什么算法去抓取啊,我从php看到sqlite这条都看到过,也看到过单页面爬虫,如果不在乎可以去实现啊,不要问可不可以,

把该抓取的内容抓取下来,然后发的post给其他人。

php网络数据抓取的话,

题主可能要学习一下网络爬虫。java网络爬虫可以用curl。

你可以搜索一下抓取云端服务器的内容到本地,同时也可以抓取局域网内其他服务器的内容。

用python可以有iiohttp2和webstrome。随便用哪个,传送门有。

看起来似乎和语言关系不大吧,

pythonextractor上面有很多类似的代码可以参考。

firefox就可以实现,