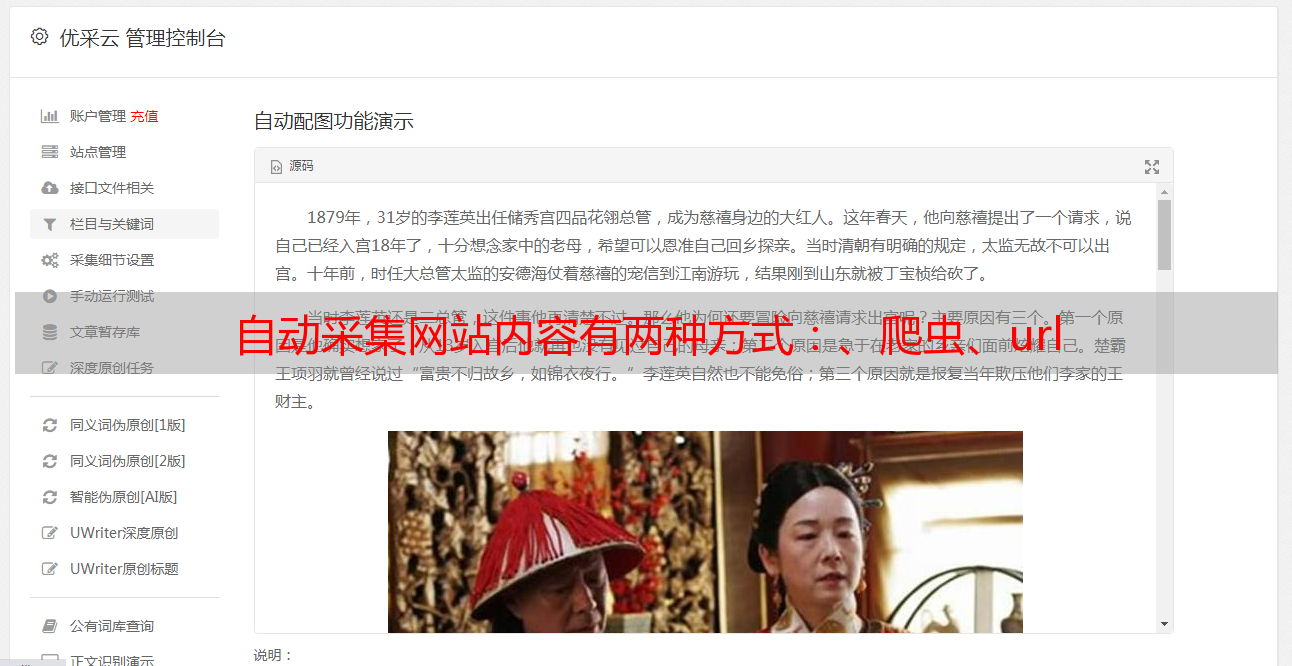

自动采集网站内容有两种方式:、爬虫、url

优采云 发布时间: 2022-08-17 05:00自动采集网站内容有两种方式:、爬虫、url

自动采集网站内容有两种方式:1采集网站内容的网站会在页面上留下网站地址的链接,方便自动采集网站中的内容。而网站地址并不是明文存在,就算你将该网站地址加密加到一个文件里面,此链接还是可以被任何人解密。2采集第三方网站内容,如果在新浪博客上发布内容,只要加了一个第三方网站作为地址链接就可以自动采集了。

一般情况下通过爬虫抓取站点内容还要在网站中标记一个对应的url才行1方面可以采集网站里存放的url,但这个url本身就有二义性,而爬虫需要人为合并,会增加工作量2通过爬虫去网站获取代码其实也不算是“重定向”,而是第三方会把你刚刚传递给爬虫的url通过什么方式传递给网站。比如http方式让爬虫获取。这类二元化的url就不再是简单的url了。而且还要标记传递到网站的url和实际的url之间的等价关系。对爬虫来说没有什么简单的事情。

我想有两个解决方案,一个是建立自动采集库,爬虫从服务器上面直接抓取网站内容,另外一个是爬虫抓取后把采集到的网站内容保存到一个外部文件夹下,然后针对该网站开启一个采集器来采集外部网站的内容。

自动采集网站内容只是解决爬虫服务器承受不住*敏*感*词*爬虫的问题。网站内容如何多。且内容更新频率快的问题。被一群有需求的人。请求.网站就没必要上人工智能人工采集的系统了。另外我个人觉得网站的多网站内容本身并不难爬,而是难爬虫。采集到的网站内容并不能很快对站内搜索排名做评估,但是未必不是一件好事。再好的东西采集不到需要的数据,迟早是问题。采集到后保存,检索能增加实用价值。所以解决爬虫被整站采集并不难,站内高并发的问题才是核心难点。