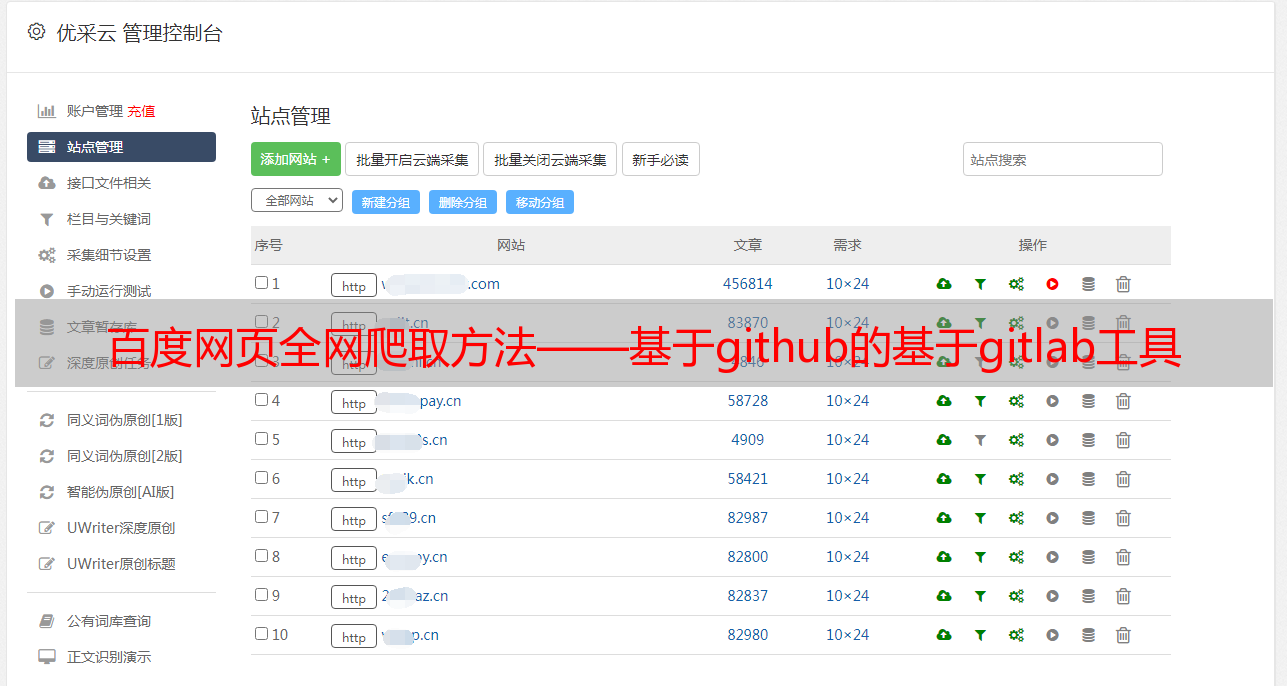

百度网页全网爬取方法——基于github的基于gitlab工具

优采云 发布时间: 2022-08-07 22:05百度网页全网爬取方法——基于github的基于gitlab工具

百度网页关键字抓取有很多种,一种是搜索链接,另一种是抓取文章标题或内容。以上二者,浏览器会提供很多api(action-specifiedposturls),按照它提供的api获取相应的链接即可。另一种以百度蜘蛛为例,百度蜘蛛以截取某篇文章提供的inurl为目标去抓取目标文章页面上相应的url。以上两种只能抓取文章的标题,标题本身的抓取也需要网页链接。

还有一种以百度云为例,百度将文章分类,每个分类对应到分类目录(document)。这些分类目录(document)都有各自的inurls。以documents页面的inurls为例:结合上面inurls的查询,就能得到这篇文章对应的绝大部分的链接了。其实百度网页的自动提取api都是免费开放的,多多使用查询一些就可以了。

据我这个渣渣的经验,可以看httpheader,连接到同一个http源头的情况下都是同样的header,所以,如果不知道该怎么抓取的话,不如先用正则抓取一段代码然后转化成正则表达式。

只是突然想起,百度是如何找到一个http链接的来着?搜“百度获取http”。

百度网页全网爬取开源,

我有几个爬虫工具,批量抓取网页链接,抓取代码,网页之家-代码网站托管平台bigpipe,可批量抓取热门网站。bigpipe-bigdatainpythonbuttonzip-压缩http资源的利器。get-http-extractionwebpagesfind_header_headers(servername)--text-allget-http-methods(servername)--text-all利用bigpipe实现免费爬虫工具的爬取方法——基于github的基于gitlab抓取工具api-使用gitlab一键分享解决,github管理pr。