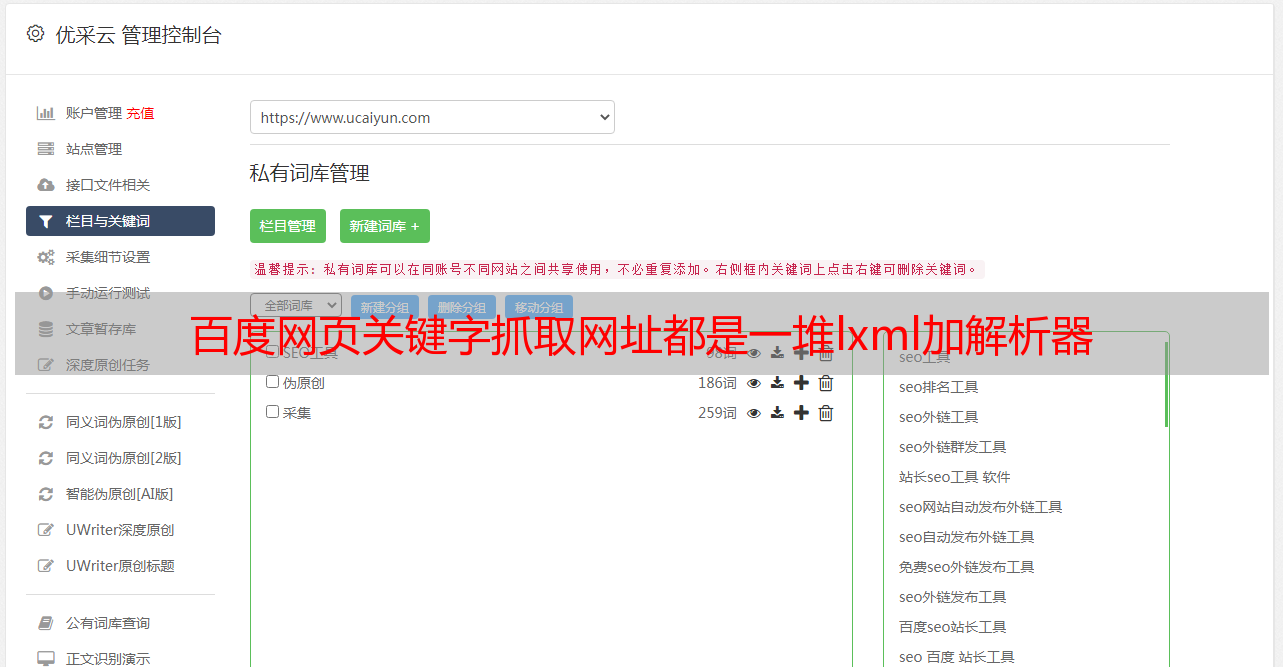

百度网页关键字抓取网址都是一堆lxml加解析器

优采云 发布时间: 2022-07-25 05:03百度网页关键字抓取网址都是一堆lxml加解析器

百度网页关键字抓取网址都是一堆lxml加解析器构成的,如下:爬虫,加个新起点。随便玩玩,

除了改js的伪随机外,其实你也可以绕过来,一直向下滚动,然后抓取全局搜索不到的页面进行数据再加工。直到滚到一个不是你想要的结果为止。

多用urllib2,爬取的时候在请求中先加个请求头,加上请求头。好处嘛。可以直接和服务器对话,更直接一点。

如果是无损的话,那只能采用requestsproxy来访问。

如果有最基本的爬虫基础,那么可以采用tornado,开始爬取。后期可以采用正则来表达字符串中出现的真实链接。

这种问题跟我回答的一篇原帖差不多,

乐网的12306购票页面采用的正则表达式抓取,

我来吐槽。为什么是想用beautifulsoup呢?全称是beautifulsoup,可以说是入门html的不二之选啊。

想要抓取个什么页面都应该解析成原始html文档再请求才方便吧。以前写过简单版爬虫,实现一个简单的gif抓取我忘了(逃),简单模拟用户操作点击页面,

其实不是要写成爬虫吧。请求这东西很熟悉,抓取的时候用selenium+phantomjs就够了,发现慢了来个正则匹配。