通用网络爬虫的实现原理及实现过程与基本原理详解

优采云 发布时间: 2021-05-19 23:21通用网络爬虫的实现原理及实现过程与基本原理详解

01网络抓取工具实现原理的详细说明

不同类型的Web采集器具有不同的实现原理,但是这些实现原理之间存在许多共性。在这里,我们将以两个典型的Web爬网程序为例(即一般的Web爬网程序和聚焦的Web爬网程序)分别说明Web爬网程序的实现原理。

1.通用网络抓取工具

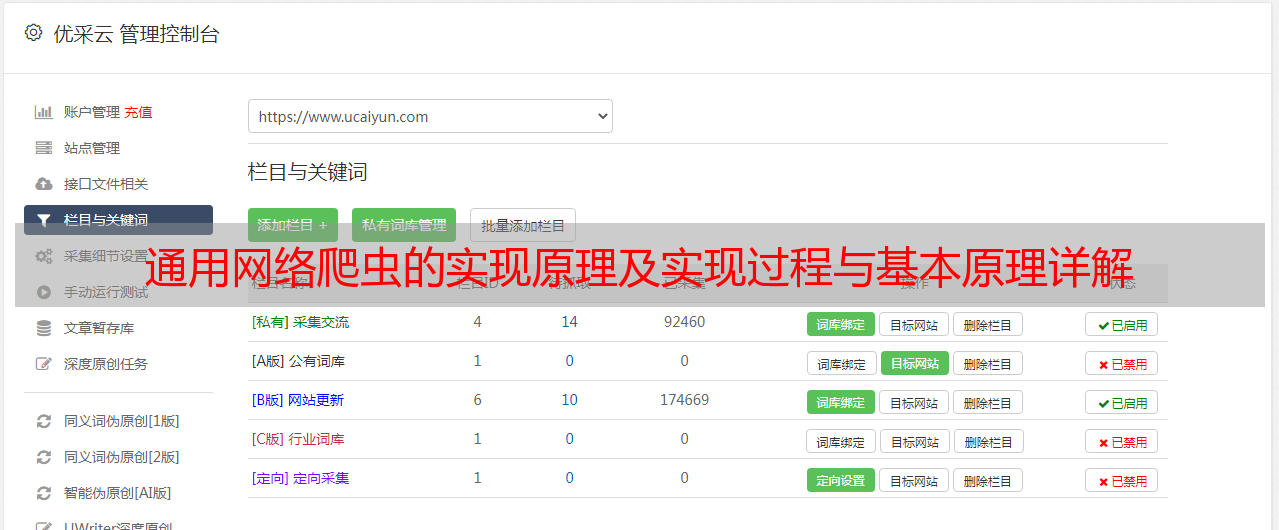

首先,让我们看一下一般Web采集器的实现原理。通用Web爬虫的实现原理和过程可以概括如下(见图3- 1)。

▲图3-1通用Web爬虫的实现原理和过程

获取初始URL。初始URL地址可以由用户手动指定,也可以由用户指定的一个或几个初始爬行网页来确定。根据初始URL爬网页面并获得新的URL。获取初始URL地址后,首先需要在相应的URL地址中对网页进行爬网。在将网页抓取到相应的URL地址后,将该网页存储在原创数据库中,然后在抓取该网页时发现新的URL。同时,将抓取的URL地址存储在URL列表中以进行重复数据删除和判断爬行过程。将新的URL放入URL队列中。在步骤2中,在获得下一个新的URL地址之后,新的URL地址将被放置在URL队列中。从URL队列中读取新URL,根据新URL对网页进行爬网,同时从新网页中获取新URL,并重复上述爬网过程。当满足采集器系统设置的停止条件时,搜寻将停止。编写采集器时,通常会设置相应的停止条件。如果未设置停止条件,则爬网程序将继续爬网,直到无法获取新的URL地址为止。如果设置了停止条件,则在满足停止条件时,爬虫将停止爬网。

以上是一般Web爬网程序的实现过程和基本原理。接下来,我们将为所有人分析针对性的Web爬网程序的基本原理和实现过程。

2.专注于网络爬虫

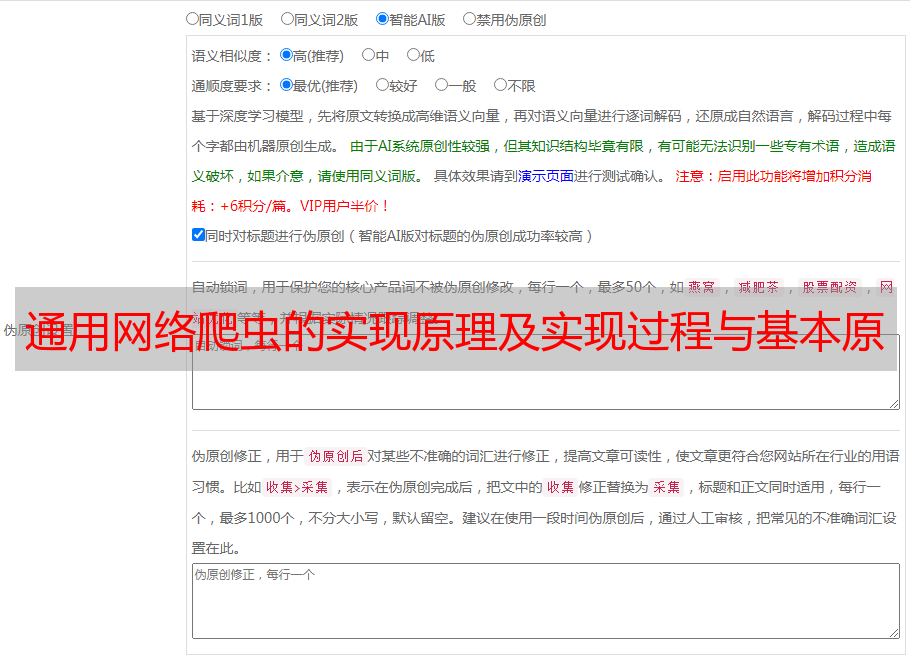

关注网络爬虫。因为它们需要有目的地爬网,所以对于一般的Web爬网程序,有必要增加目标的定义和过滤机制。具体来说,这时,其执行原理和过程需要比一般的要多。Web采集器还有三个步骤,即目标的定义,不相关链接的过滤以及在要搜寻的URL地址中的选择。下一步,如图3-2所示。

▲图3-2着重介绍Web爬网程序的基本原理及其实现过程

搜寻目标的定义和描述。在集中式Web爬网程序中,必须首先根据爬网要求定义集中式Web爬虫的爬网目标,并进行相关描述。获取初始URL。根据初始URL爬网页面并获得新的URL。从新URL筛选出与爬网目标不相关的链接。由于目标网页爬虫对网页的爬网是有目的的,因此与目标无关的网页将被过滤掉。同时,还必须将爬网的URL地址存储在URL列表中,以进行重复数据删除和判断爬网过程。将过滤的链接放入URL队列。根据搜索算法,从URL队列中确定URL的优先级,并确定下一步要爬网的URL地址。在一般的Web爬网程序中,下一个要爬网的URL地址并不重要,但是在有针对性的Web爬网程序中,由于其目的,下一个要爬网的URL地址相对重要。对于有针对性的Web采集器,不同的搜寻顺序可能会导致采集器的执行效率不同。因此,我们需要根据搜索策略确定下一步需要爬网的URL地址。从下一步要爬网的URL地址中,读取新的URL,然后根据新的URL地址对网页进行爬网,并重复上述爬网过程。当满足系统中设置的停止条件时,或者无法获取新的URL地址时,爬网将停止。

现在,我们已经初步了解了Web爬网程序的实现原理和相应的工作流程,下面让我们了解一下Web爬网程序的爬网策略。

02爬行策略

在Web爬网程序爬网过程中,要爬网的URL列表中可能有许多URL地址。然后,采集器应首先搜寻哪个URL地址,然后再搜寻哪个URL地址?

在一般的Web爬网程序中,尽管爬网的顺序并不那么重要,但是在许多其他爬网程序(例如聚焦的Web爬网程序)中,爬网的顺序非常重要,并且爬网的顺序通常由爬网策略确定。我们将向您介绍一些常见的抓取策略。

抓取策略主要包括深度优先抓取策略,广度优先抓取策略,大站点优先抓取策略,反链策略,其他抓取策略等。我们将在下面分别介绍它们。

如图3-3所示,假设有一个网站,ABCDEFG是该站点下的网页,图中的箭头表示网页的层次结构。

▲图3-3 网站网页层次结构*敏*感*词*

如果此时所有网页ABCDEFG都在爬网队列中,则根据不同的爬网策略,爬网顺序将有所不同。

例如,如果您按照深度优先的爬网策略进行爬网,则将首先对网页进行爬网,然后将对该网页的下层链接进行深度爬网,然后返回到上一级爬行。

因此,如果使用深度优先爬网策略,则图3-3中的爬网顺序可以是:A→D→E→B→C→F→G。

如果根据广度优先爬网策略进行爬网,则将首先对相同级别的网页进行爬网,并且在对所有相同级别的网页进行爬网之后,将选择下一个级别的网页进行爬网,例如,在上面的网站中,如果按照广度优先爬网策略进行爬网,则爬网顺序可以为:A→B→C→D→E→F→G。

除了以上两种爬网策略外,我们还可以使用大网站爬网策略。我们可以根据相应网页所属的网站进行分类。如果某个网站中有许多网页,则我们称其为大型网站。按照这种策略,网站拥有的网页越多,则其规模就越大,然后,首先在大网站中抓取该网页的URL地址。

网页的反向链接数是指该网页被其他网页指向的次数。该次数表示该网页在一定程度上被其他网页推荐的次数。因此,如果您遵循反链策略进行爬网,那么哪个网页上的反链更多,那么哪个页面将首先被爬网。

但是,在实际情况下,如果仅通过反链策略确定网页的优先级,则可能会有很多作弊行为。例如,做一些垃圾站群并将这些网站彼此链接。如果是这样,每个站点都会获得更高的反链,从而达到作弊的目的。

作为爬虫项目的参与者,我们当然不希望被这种作弊所打扰。因此,如果使用反向链接策略进行爬网,通常会考虑使用可靠数量的反链。

除了上述爬网策略外,实践中还有许多其他爬网策略,例如OPIC策略,Partial PageRank策略等。

03网页更新策略

网站网页经常更新。作为采集器,网页更新后,我们需要重新爬网这些网页。那么什么时候才是适当的爬行时间呢?如果网站的更新速度太慢,并且爬网程序的爬网频率太高,它将不可避免地增加爬网程序和网站服务器的压力。如果网站快速更新,但是抓取间隔更长,我们将抓取的内容版本太旧,这不利于抓取新内容。

很显然,网站的更新频率与爬虫访问网站的频率越近,效果越好。当然,当爬虫服务器资源有限时,爬虫还需要根据相应的策略制作不同的网页。不同的更新优先级,优先级更高的网页更新,将获得更快的爬网响应。

具体来说,主要有三种常见的网页更新策略:用户体验策略,历史数据策略,聚类分析策略等。我们将在下面分别进行解释。

当搜索引擎查询某个关键词时,将显示排名结果。在排名结果中,通常会有大量网页。但是,大多数用户只关注排名靠前的网页,因此,在采集器服务器资源有限的情况下,采集器将优先更新排名最高的网页。

这种更新策略,我们称其为用户体验策略,然后在这种策略中,爬网程序何时会爬网这些排名靠前的网页?此时,相应网页的多个历史版本将保留在爬网中,并将根据内容更新,搜索质量影响,用户体验以及这些多个网页的其他信息,执行相应的分析以确定这些网页的爬网周期。历史版本。

此外,我们还可以使用历史数据策略来确定更新和爬网网页的周期。例如,我们可以通过泊松过程建模等方法,基于某个网页的历史更新数据,来预测该网页的下一次更新时间,从而确定该网页的下一次爬网时间,即确定该更新时间。循环。

以上两种策略都需要历史数据作为基础。有时,如果网页是新网页,则将没有相应的历史数据,并且如果分析是基于历史数据,则爬网程序服务器需要保存相应网页的历史版本信息,这无疑会带到爬网程序服务器更大的压力和负担。

如果要解决这些问题,则需要采用新的更新策略。更常用的是聚类分析策略。那么什么是聚类分析策略?

在生活中,我相信每个人都已经熟悉分类。例如,当我们去大型购物中心时,大型购物中心中的商品通常被分类,方便顾客选择相应的商品。此时,产品分类的类别是固定的。 ,已经起草了。

但是,如果商品数量巨大并且无法提前对其进行分类,或者换句话说,将不知道将拥有哪种商品。这时候应该如何解决商品分类问题?

这时,我们可以使用聚类方法解决问题。根据产品之间的相似性,我们将分析具有共同特征的产品。此时,产品集群的类别数量并不一定。但是可以保证的是,聚集在一起的商品之间必须有一定的共通性,即要基于“事物聚集在一起”的思想来实现。

类似地,在我们的聚类算法中,会有类似的分析过程。

使用爬网程序更新网页上的聚类分析算法,我们可以做到这一点,如图3-4所示。

▲图3-4网页更新策略的聚类算法

首先,经过大量研究,发现网页可能具有不同的内容,但是一般而言,具有相似属性的网页具有相似的更新频率。这是在爬网程序网页更新中使用的聚类分析算法的先决条件指导思想。借助1中的指导思想,我们可以首先在大量网页上执行聚类分析。聚类后,将形成多个类别。每个类别中的网页具有相似的属性,即它们通常具有相似的更新频率。 。聚类完成后,我们可以对同一聚类中的网页进行采样,然后计算采样结果的平均更新值以确定每个聚类的爬网频率。

以上是使用采集器搜寻网页时的三种常见更新策略。掌握了算法思想之后,当我们对爬虫的实际开发进行跟进时,编译后的爬虫的执行效率将会更高。而且执行逻辑将更加合理。

04 Web分析算法

在搜索引擎中,爬网相应的网页后,爬网程序会将这些网页存储在服务器的原创数据库中。然后,搜索引擎将分析这些网页并确定每个网页的重要性,这将影响用户搜索的排名结果。

因此,在这里,我们需要对搜索引擎网络分析算法有一个简单的了解。

搜索引擎的网络分析算法主要分为三类:基于用户行为的网络分析算法,基于网络拓扑的网络分析算法和基于网络内容的网络分析算法。接下来,我们将分别解释这些算法。

1.基于用户行为的网页分析算法

基于用户行为的网页分析算法相对容易理解。在此算法中,将根据用户对这些网页的访问行为来评估这些网页。例如,基于用户访问网页的频率,用户访问网页的时间长度以及用户的点击率评估等信息来集成网页。

2.基于网络拓扑的网页分析算法

基于网络拓扑的网页分析算法是一种依靠链接关系,结构关系,已知网页或网页数据对网页进行分析的算法。所谓拓扑,就是简单的结构关系。

基于网络拓扑的网页分析算法也可以分为三种:基于页面粒度的分析算法,基于页面块粒度的分析算法和基于网站粒度的分析算法。

PageRank算法是基于网页粒度的典型分析算法。我相信我的许多朋友都听说过Page-Rank算法。它是Google搜索引擎的核心算法。简而言之,它基于网页之间的链接关系来计算网页的权重,并且可以依靠这些计算出的权重。页面排名。

当然,有很多特定的算法细节,因此在此不再赘述。除了PageRank算法,HITS算法还是基于页面粒度的常见分析算法。

基于网页粒度的分析算法也依赖于网页之间的链接关系进行计算,但是计算规则不同。

<p>我们知道一个网页通常收录多个超链接,但通常它指向的外部链接中并非所有链接都与网站主题相关,或者这些外部链接对于该网页很重要。不同,因此,如果要基于页面块的粒度进行分析,则需要在网页中划分这些外部链接的级别,并且不同级别的外部链接对网页的重要性也不同。