网页爬虫抓取百度图片(什么是爬虫?网络爬虫的本质模拟浏览器的基本流程)

优采云 发布时间: 2022-04-04 03:09网页爬虫抓取百度图片(什么是爬虫?网络爬虫的本质模拟浏览器的基本流程)

一、什么是爬虫?

网络爬虫(也称为网络蜘蛛、网络机器人,在 FOAF 社区中,更常被称为网页追逐者)是根据一定的规则自动爬取万维网上信息的程序或脚本。其他不太常用的名称是 ant、autoindex、emulator 或 worm。

其实通俗的说,就是通过程序在网页上获取你想要的数据,也就是自动抓取数据。

您可以抓取女孩的照片并抓取您想观看的视频。. 等待你要爬取的数据,只要你能通过浏览器访问的数据就可以通过爬虫获取

二、爬行动物的本质

模拟浏览器打开网页,获取网页中我们想要的部分数据

在浏览器中打开网页的过程:

当你在浏览器中输入地址,通过DNS服务器找到服务器主机,向服务器发送请求,服务器解析并将结果发送给用户的浏览器,包括html、js、css等文件内容,浏览器解析它并最终呈现它给用户在浏览器上看到的结果

因此,用户看到的浏览器的结果都是由 HTML 代码组成的。我们的爬虫就是获取这些内容,通过对HTML代码的分析和过滤,获取我们想要的资源(文字、图片、视频...)

三、爬虫基本流程

发出请求

通过HTTP库向目标站点发起请求,即发送Request,请求中可以收录额外的headers等信息,等待服务器响应

获取响应内容

如果服务器能正常响应,就会得到一个Response。Response的内容就是要获取的页面的内容。类型可以是 HTML、Json 字符串、二进制数据(图片或视频)等。

解析内容

获取的内容可以是HTML,可以用正则表达式和页面解析库解析,也可以是Json,可以直接转成Json对象解析,也可以是二进制数据,可以保存或进一步处理

保存数据

以多种形式保存,可以保存为文本,也可以保存到数据库,或者以特定格式保存文件

四、什么是请求

Requests 是基于 urllib 用 python 编写,使用 Apache2 Licensed 开源协议的 HTTP 库

如果你看过之前的文章文章关于urllib库的使用,你会发现urllib其实很不方便,而且Requests比urllib方便,可以为我们省去很多工作。(使用requests之后,你基本就舍不得用urllib了。)总之,requests是python实现的最简单最简单的HTTP库。建议爬虫使用 requests 库。

默认安装python后,requests模块没有安装,需要通过pip单独安装

五、Requests 库的基础知识

Requests 库的 7 个主要方法

我们通过调用Request库中的方法获取返回的对象。它包括两个对象,请求对象和响应对象。

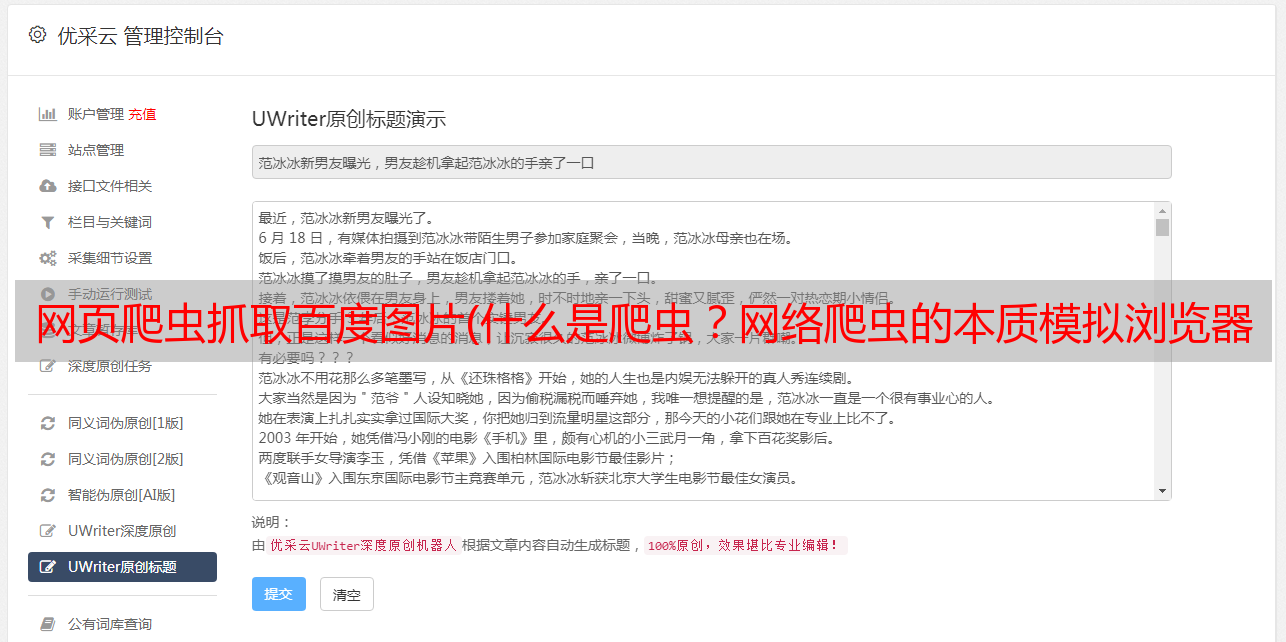

请求对象就是我们要请求的url,响应对象就是返回的内容,如图:

Request 库的两个重要对象

六、安装请求

1.强烈建议您使用pip进行安装:pip insrall requests

2.Pycharm安装:文件-》默认设置-》项目解释器-》搜索请求-》安装包-》ok

七、Requests库的操作示例

1、京东商品爬虫-普通爬虫框架

导入请求