网页表格抓取( 如何用几行代码爬下所需数据?答案在这里!)

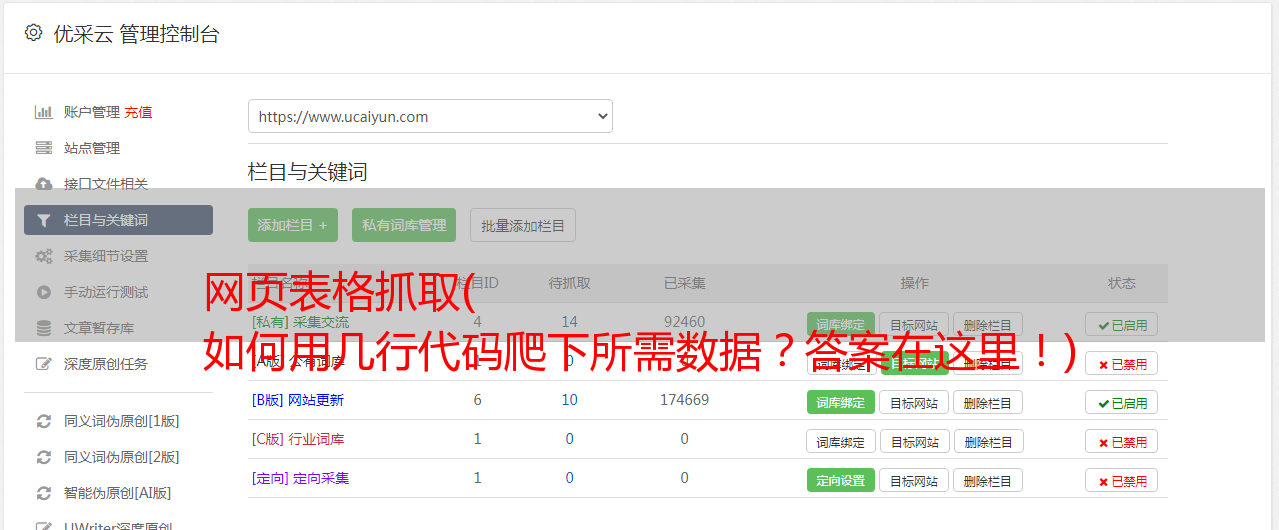

优采云 发布时间: 2022-04-02 23:02网页表格抓取(

如何用几行代码爬下所需数据?答案在这里!)

众所周知,一般的爬虫套路无非就是构造请求、解析网页、提取元素、存储数据这几个步骤。requests 库主要用于构造请求,xpath、bs4、css、re 用于提取元素。对于一个完整的爬虫来说,代码量可以从几十行到上百行不等。初学者的学习成本相对较高。

那么,有没有什么办法只用几行代码就可以爬取所需的数据呢?答案是熊猫。自从J哥知道这件神器后,他尝试爬取了多个网页,并赢得了许多战斗。他再舒服不过了!这家伙也太适合初学者玩爬虫了!

本文目录如下:

定义

pandas 中的函数 pd.read_html() 非常强大,可以很方便的抓取表格数据。无需掌握正则表达式或xpath等工具,只需几行代码即可抓取网页数据。

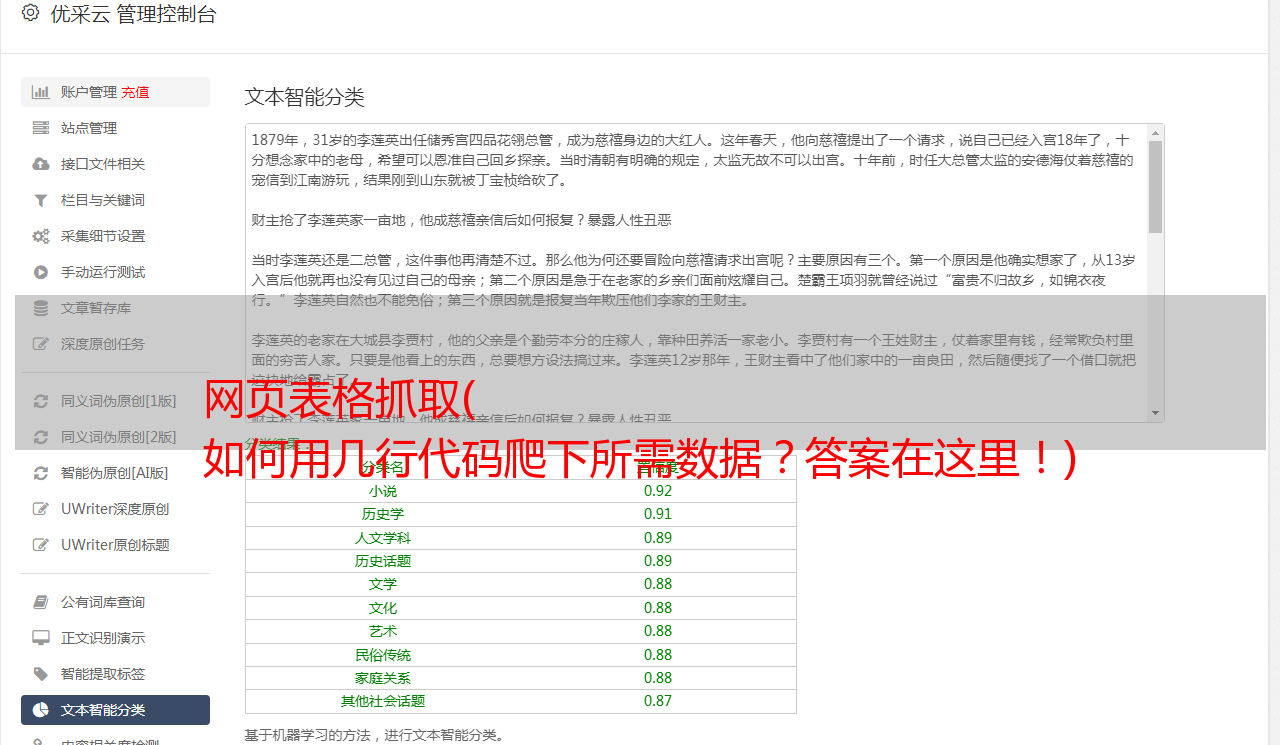

原理表表格数据网页结构

pandas适合抓取表格数据,所以我们首先要知道什么样的网页有表格数据结构(有html基础的大佬可以自行跳过这部分)。

我们先来看一个简单的例子。(快捷键F12可以快速查看网页的HTML结构)

从上面网站可以看出,数据存放在一个table表中,thread是表头,tbody是表数据,tbody中的一个tr对应表中的一行,一个td对应到表中的一个元素。

让我们看另一个例子:

或许你找到规律了,Table结构中展示的表格数据,一般网页结构如下:

...

...

...

...

...

...

...

只要网页有以上结构,就可以尝试用pandas抓取数据。

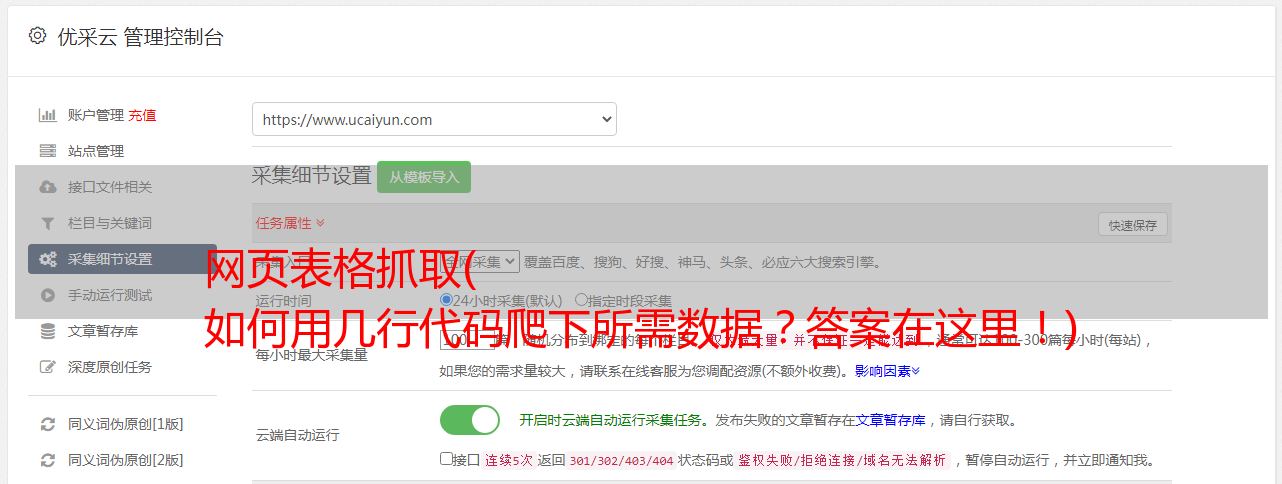

pandas请求表数据流程

对于网页结构相似的表格数据,pd.read_html可以捕获网页上的所有表格数据,并以DataFrame的形式以列表的形式返回。

pd.read_html 语法和参数

基本语法:

pandas.read_html(io,match='.+',flavor=None,header=None,index_col=None,skiprows=None, attrs=None,

parse_dates=False, thousands=', ', encoding=None, decimal='.', converters=None, na_values=None,

keep_default_na=True, displayed_only=True)

主要参数:

参数解释

io

接收 URL、文件、字符串

解析日期

解析日期

味道

解析器

标题

标题行

跳过

跳过的行属性,例如 attrs = {'id': 'table'}

实战案例一:爬取世界大学排名(1页数据)

import pandas as pd

import csv

url1 = 'http://www.compassedu.hk/qs'

df1 = pd.read_html(url1)[0] #0表示网页中的第一个Table

df1.to_csv('世界大学综合排名.csv',index=0)

没错,5行代码,几秒钟就搞定了,我们来预览一下爬取的数据:

案例二:抓取新浪财经基金重仓股数据(6页数据)

import pandas as pd

import csv

df2 = pd.DataFrame()

for i in range(6):

url2 = 'http://vip.stock.finance.sina.com.cn/q/go.php/vComStockHold/kind/jjzc/index.phtml?p={page}'.format(page=i+1)

df2 = pd.concat([df2,pd.read_html(url2)[0]])

print('第{page}页抓取完成'.format(page = i + 1))

df2.to_csv('./新浪财经数据.csv',encoding='utf-8',index=0)

没错,8行代码就搞定了,还是那么简单。不了解翻页爬虫的可以查看公众号历史“蔡J学Python”原创文章《实战|教你如何使用Python爬虫(附详细源代码)”,如果不能合并DataFrame可以理解,可以查看公众号历史原创文章《Basic|Pandas常用知识点总结(四)》)。

让我们预览爬取的数据:

案例3:抓取证监会披露的IPO数据(217页数据)

import pandas as pd

from pandas import DataFrame

import csv

import time

start = time.time() #程序计时

df3 = DataFrame(data=None,columns=['公司名称','披露日期','上市地和板块','披露类型','查看PDF资料']) #添加列名

for i in range(1,218):

url3 ='http://eid.csrc.gov.cn/ipo/infoDisplay.action?pageNo=%s&temp=&temp1=&blockType=byTime'%str(i)

df3_1 = pd.read_html(url3,encoding='utf-8')[2] #必须加utf-8,否则乱码

df3_2 = df3_1.iloc[1:len(df3_1)-1,0:-1] #过滤掉最后一行和最后一列(NaN列)

df3_2.columns=['公司名称','披露日期','上市地和板块','披露类型','查看PDF资料'] #新的df添加列名

df3 = pd.concat([df3,df3_2]) #数据合并

print('第{page}页抓取完成'.format(page=i))

df3.to_csv('./上市公司IPO信息.csv', encoding='utf-8',index=0) #保存数据到csv文件

end = time.time()

print ('共抓取',len(df3),'家公司,' + '用时',round((end-start)/60,2),'分钟')

这里注意过滤抓取到的Table数据,主要使用iloc方法。详情请参考公众号上一期原创文章《基础|Pandas常用知识点总结(三)》另外我还加了一个程序时序,就是方便查看爬行速度。

2分14秒爬下217页,4334条数据,相当不错。让我们预览爬取的数据:

需要注意的是,并不是所有的表格都可以用pd.read_html爬取,有的网站表面上看起来是表格,但是在网页的源码中,并不是表格格式,而是列表格式。这种形式不适合read_html爬取,必须使用selenium等其他方法。