网页爬虫抓取百度图片(Python全栈免费解答.裙(BFE9)(组图))

优采云 发布时间: 2022-04-01 22:19网页爬虫抓取百度图片(Python全栈免费解答.裙(BFE9)(组图))

经过前期的大量学习和准备,我们需要开始编写第一个真正的爬虫。这次我们要爬的网站是:*敏*感*词*,一个很适合新手练习的地方,所以开始吧。

这次想爬贴吧Yes>,西部世界是一部我一直很喜欢的美剧。我通常有时间去看看我的朋友们在谈论什么。所以这次我选择了这个酒吧作为实验材料。注意:很多人在学习Python的过程中会遇到各种烦恼,无人回答很容易放弃。为此,小编特意搭建了Python全栈免费答案。裙子:时间长了,改造后(数字谐音)就可以找到了,有老司机解决你不明白的问题。还有最新的 Python 教程。下载,让我们互相监督,共同进步!

贴吧地址:

%E8%A5%BF%E9%83%A8%E4%B8%96%E7%95%8C&ie=utf-8

Python 版本:3.6

浏览器版本:Chrome

目标分析:

由于它是第一个实验爬虫,我们没有太多工作要做。我们需要做的就是:

1、从网络上爬取特定页面

2、对被爬取的页面内容进行简单过滤分析

3、查找每个帖子的标题、海报、日期、楼层和跳转链接

4、将结果保存为文本。

前期准备:

看到贴吧的url地址,你是不是觉得一头雾水?有一大串无法识别的字符?

其实这些都是汉字。

%E8%A5%BF%E9%83%A8%E4%B8%96%E7%95%8C

后面的代码是:西部世界。

链接末尾:&ie=utf-8 表示链接采用utf-8编码。

windows的默认编码是GBK。在处理这个连接时,我们需要在 Python 中手动设置,才能成功使用。

与Python2相比,Python3对编码的支持有了很大的提升。默认情况下,全局使用 utf-8 编码。所以建议还在学习Python2的朋友赶紧投身Python3的怀抱,真的是省了老大的功夫。

然后我们转到贴吧的第二页:

网址:

`url: https://tieba.baidu.com/f?kw=%E8%A5%BF%E9%83%A8%E4%B8%96%E7%95%8C&ie=utf-8&pn=50`

注意没有,在连接的末尾多了一个参数&pn=50,

这里我们很容易猜到这个参数与页码的关系:

现在我们可以通过简单的url修改来实现翻页的效果。

chrome开发者工具的使用:

要编写爬虫,我们必须能够使用开发工具。说起来,这个工具是为前端开发者准备的,但是我们可以用它来快速定位我们要爬取的信息,找到对应的规则。

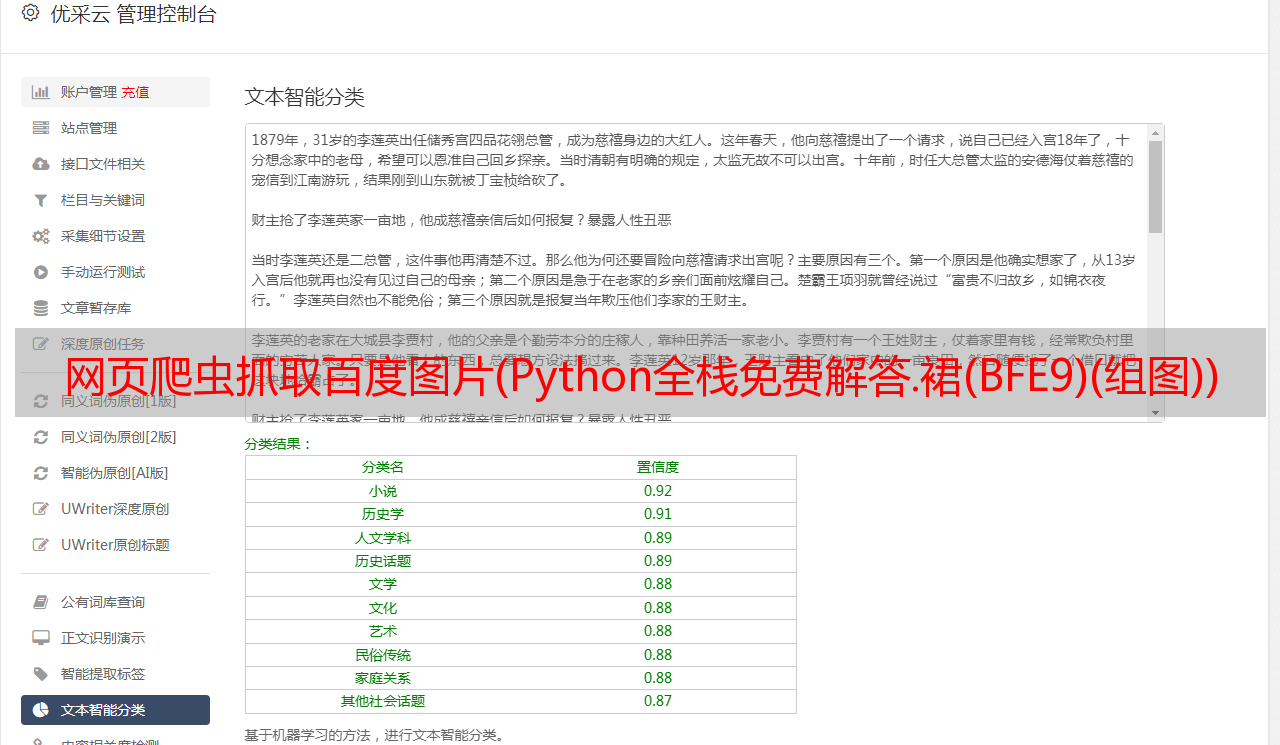

图片

图片

我们仔细一看,发现每篇文章的内容都被一个 li 标签包裹着:

这样,我们只需要快速找到所有符合规则的标签,

在进一步分析内容,最后过滤掉数据就可以了。

开始写代码?我们先写一个函数来抓取页面上的人:

这是前面介绍的爬虫框架,以后会经常用到。

import requests

from bs4 import BeautifulSoup

# 首先我们写好抓取网页的函数

def get_html(url):

try:

r = requests.get(url,timeout=30)

r.raise_for_status()

#这里我们知道*敏*感*词*的编码是utf-8,所以手动设置的。爬去其他的页面时建议使用:

# r.endcodding = r.apparent_endconding

r.encoding='utf-8'

return r.text

except:

return " ERROR "

然后我们提取细节:

一个大的 li 标签包裹了许多 div 标签

我们想要的信息在这些 div 标签中:

# 标题&帖子链接

<a span class="token attr-name"relspan class="token attr-value"span class="token punctuation"=span class="token punctuation""noreferrerspan class="token punctuation"" span class="token attr-name"hrefspan class="token attr-value"span class="token punctuation"=span class="token punctuation""/p/5803134498span class="token punctuation"" span class="token attr-name"titlespan class="token attr-value"span class="token punctuation"=span class="token punctuation""【高淸】西部世界1-2季,中英字,未❗️删❕减.任性给span class="token punctuation"" span class="token attr-name"targetspan class="token attr-value"span class="token punctuation"=span class="token punctuation""_blankspan class="token punctuation"" span class="token attr-name"classspan class="token attr-value"span class="token punctuation"=span class="token punctuation""j_th_tit span class="token punctuation""span class="token punctuation">【高淸】西部世界1-2季,中英字,未❗️删❕减.任性给

#发帖人:

"user_id<a span class="token attr-name"classspan class="token attr-value"span class="token punctuation"=span class="token punctuation""icon_tbworld icon-crown-super-v1span class="token punctuation"" span class="token attr-name"hrefspan class="token attr-value"span class="token punctuation"=span class="token punctuation""/tbmall/tshowspan class="token punctuation"" span class="token attr-name"data-fieldspan class="token attr-value"span class="token punctuation"=span class="token punctuation""{span class="token entity" title=""">"user_id

#回复数量:

822

#发帖日期:

7-20

经过分析,我们可以通过soup.find()方法轻松得到我们想要的结果

具体代码实现:

'''

抓取*敏*感*词*---西部世界吧的基本内容

爬虫线路: requests - bs4

Python版本: 3.6

OS: mac os 12.13.6

'''

import requests

import time

from bs4 import BeautifulSoup

# 首先我们写好抓取网页的函数

def get_html(url):

try:

r = requests.get(url, timeout=30)

r.raise_for_status()

# 这里我们知道*敏*感*词*的编码是utf-8,所以手动设置的。爬去其他的页面时建议使用:

# r.endcodding = r.apparent_endconding

r.encoding = 'utf-8'

return r.text

except:

return " ERROR "

def get_content(url):

'''

分析贴吧的网页文件,整理信息,保存在列表变量中

'''

# 初始化一个列表来保存所有的帖子信息:

comments = []

# 首先,我们把需要爬取信息的网页下载到本地

html = get_html(url)

# 我们来做一锅汤

soup = BeautifulSoup(html, 'lxml')

# 按照之前的分析,我们找到所有具有‘ j_thread_list clearfix’属性的li标签。返回一个列表类型。

liTags = soup.find_all('li', attrs={'class': ' j_thread_list clearfix'})

# 通过循环找到每个帖子里的我们需要的信息:

for li in liTags:

# 初始化一个字典来存储文章信息

comment = {}

# 这里使用一个try except 防止爬虫找不到信息从而停止运行

try:

# 开始筛选信息,并保存到字典中

comment['title'] = li.find(

'a', attrs={'class': 'j_th_tit '}).text.strip()

comment['link'] = "http://tieba.baidu.com/" + \

li.find('a', attrs={'class': 'j_th_tit '})['href']

comment['name'] = li.find(

'span', attrs={'class': 'tb_icon_author '}).text.strip()

comment['time'] = li.find(

'span', attrs={'class': 'pull-right is_show_create_time'}).text.strip()

comment['replyNum'] = li.find(

'span', attrs={'class': 'threadlist_rep_num center_text'}).text.strip()

comments.append(comment)

except:

print('出了点小问题')

return comments

def Out2File(dict):

'''

将爬取到的文件写入到本地

保存到当前目录的 TTBT.txt文件中。

'''

with open('TTBT.txt', 'a+') as f:

for comment in dict:

f.write('标题: {} \t 链接:{} \t 发帖人:{} \t 发帖时间:{} \t 回复数量: {} \n'.format(

comment['title'], comment['link'], comment['name'], comment['time'], comment['replyNum']))

print('当前页面爬取完成')

def main(base_url, deep):

url_list = []

# 将所有需要爬去的url存入列表

for i in range(0, deep):

url_list.append(base_url + '&pn=' + str(50 * i))

print('所有的网页已经下载到本地! 开始筛选信息。。。。')

#循环写入所有的数据

for url in url_list:

content = get_content(url)

Out2File(content)

print('所有的信息都已经保存完毕!')

base_url = 'https://tieba.baidu.com/f?kw=%E8%A5%BF%E9%83%A8%E4%B8%96%E7%95%8C&ie=utf-8'

# 设置需要爬取的页码数量

deep = 3

if __name__ == '__main__':

main(base_url, deep)

代码中有详细的注释和想法。如果看不懂,多读几遍。

这是爬升的结果:

图片

小结注:很多人在学习Python的过程中会遇到各种各样的烦恼,没人回答就很容易放弃。为此,小编特意搭建了Python全栈免费答案。裙子:时间长了,改造后(数字谐音)就可以找到了,有老司机解决你不明白的问题。还有最新的 Python 教程。下载,让我们互相监督,共同进步!

本文文字和图片来源于网络和自己的想法,仅供学习交流,不具备任何商业用途。版权归原作者所有。如有任何问题,请及时联系我们进行处理。