集搜客网页抓取软件(开源Python即时网络爬虫源7文档修改历史若有疑问 )

优采云 发布时间: 2022-03-31 08:16集搜客网页抓取软件(开源Python即时网络爬虫源7文档修改历史若有疑问

)

1 简介

《Scrapy的架构初探》一文中提到的Spider是整个架构中定制化程度最高的组件。蜘蛛负责提取网页内容,不同数据采集目标的内容结构不同。课程页面是定制的。我们有个想法:能不能做一个更通用的Spider,进一步隔离定制的部分?

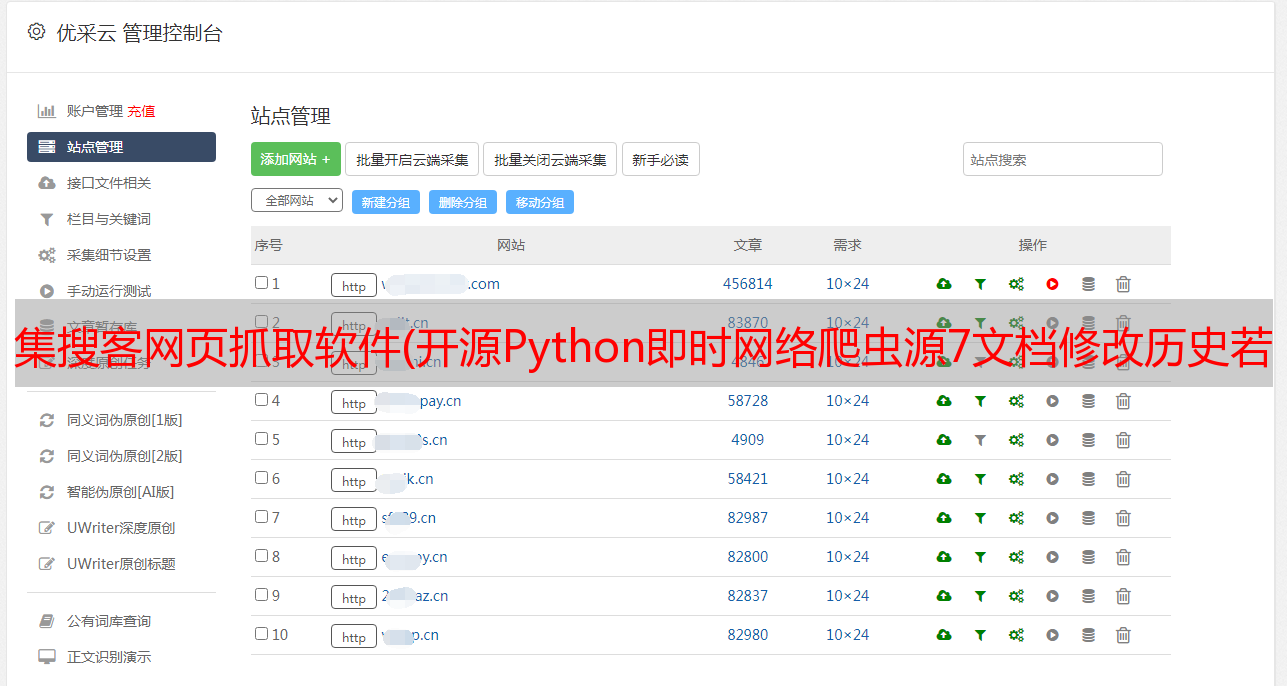

GooSeeker 具有爬虫群模式。从技术实现的角度来看,其实就是把爬虫软件做成一个被动接受任务的执行单元,交给他什么任务他就做什么,也就是说同一个执行单元可以爬出更多不同的网站. 分配的任务是GooSeeker会员中心的爬虫指南针,实现集中管理,分布式执行。

开源的 Python 实时网络爬虫项目也应该尽量通用。主要抓以下两点:

下面我们将进一步讲解实现原理,帮助读者阅读源码。

2.爬虫群模式*敏*感*词*

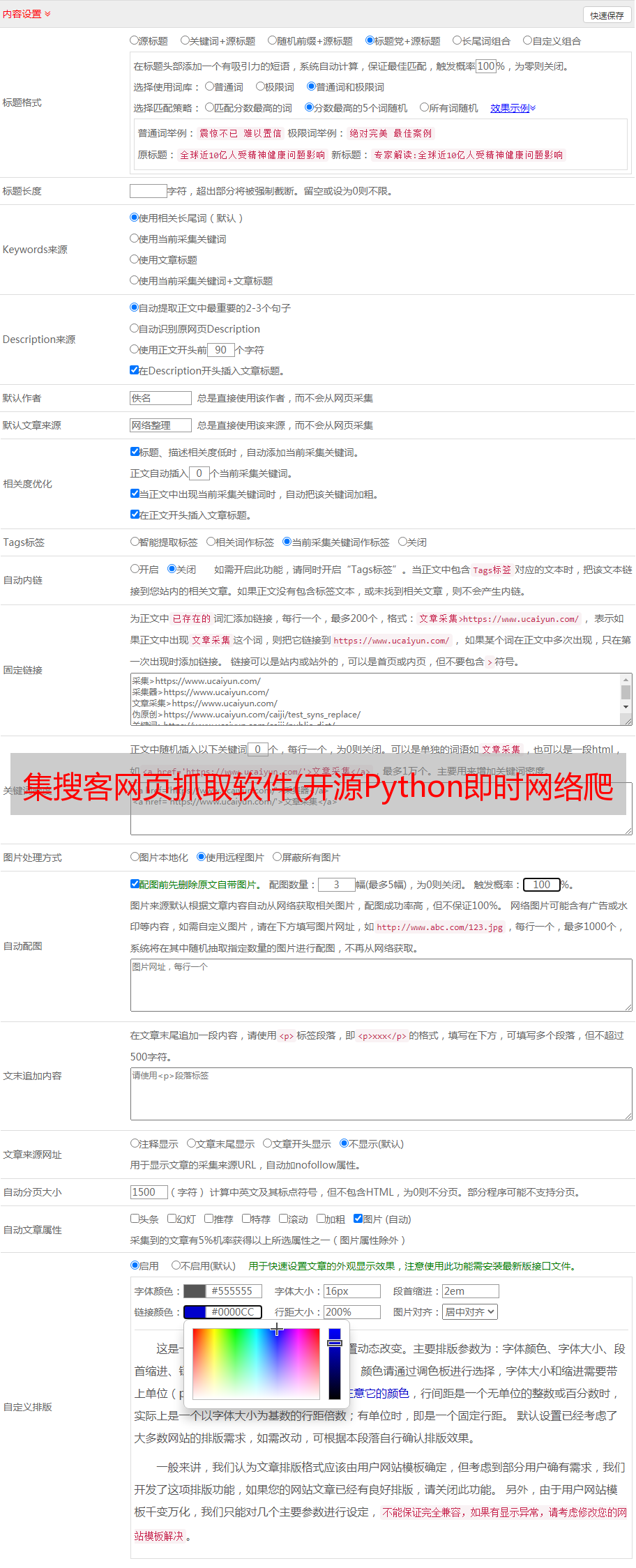

中间蓝色部分是GooSeeker会员中心的地址库和爬虫指南针。URL和提取规则本来应该是硬编码到蜘蛛里面的,现在都被会员中心隔离和管理了,所以蜘蛛可以很方便的用于一般用途。

3、一般Spider的主要功能

在地址库和提取规则隔离后,Scrapy的Spider可以专注于以下流程:

4.接下来的工作

根据以上假设编写调试Scrapy的通用Spider研究,是否可以更通用,将GooSeeker的爬虫组调度引入Spider中,即在通过第一个API获取抽取器之前,再添加一个获取爬虫组调度任务。这样一来,整个过程将所有Spider变成被动接受任务的工作模式,每个Spider没有固定的抓取规则。

5.相关文档 Python Instant Web Crawler项目:Content Extractor Scrapy的定义:python3下的第一次运行测试

如有疑问,您可以或